Futuro tecnologico

(Il futuro tecnologico: (Michio kaku))

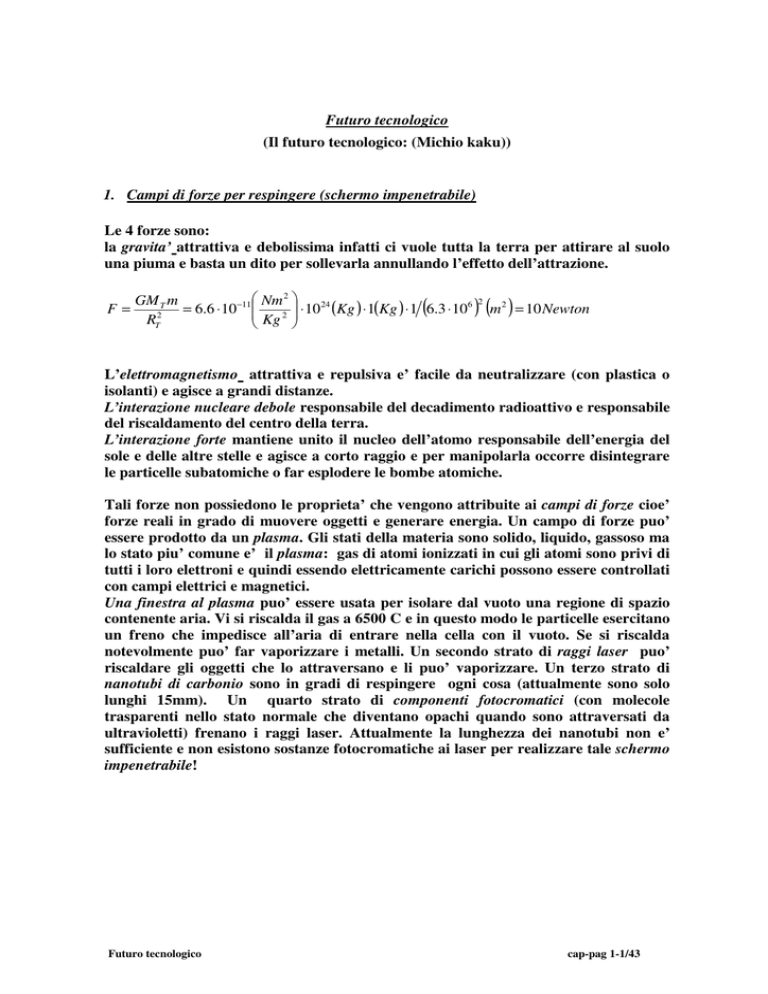

1. Campi di forze per respingere (schermo impenetrabile)

Le 4 forze sono:

la gravita’ attrattiva e debolissima infatti ci vuole tutta la terra per attirare al suolo

una piuma e basta un dito per sollevarla annullando l’effetto dell’attrazione.

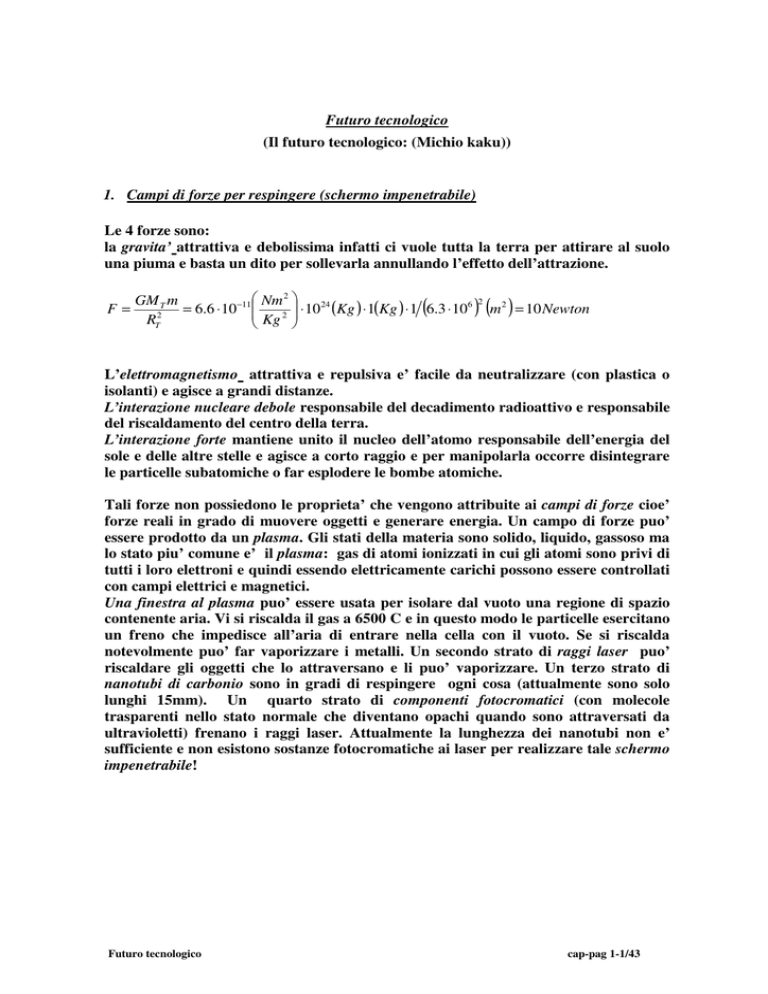

F=

2

GM T m

−11 Nm

24

6

=

6

.

6

⋅

10

Kg 2 ⋅ 10 (Kg ) ⋅ 1(Kg ) ⋅ 1 6.3 ⋅ 10

RT2

(

) (m ) = 10 Newton

2

2

L’elettromagnetismo attrattiva e repulsiva e’ facile da neutralizzare (con plastica o

isolanti) e agisce a grandi distanze.

L’interazione nucleare debole responsabile del decadimento radioattivo e responsabile

del riscaldamento del centro della terra.

L’interazione forte mantiene unito il nucleo dell’atomo responsabile dell’energia del

sole e delle altre stelle e agisce a corto raggio e per manipolarla occorre disintegrare

le particelle subatomiche o far esplodere le bombe atomiche.

Tali forze non possiedono le proprieta’ che vengono attribuite ai campi di forze cioe’

forze reali in grado di muovere oggetti e generare energia. Un campo di forze puo’

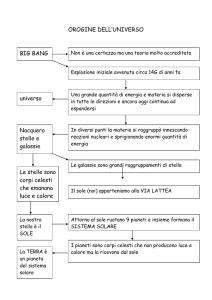

essere prodotto da un plasma. Gli stati della materia sono solido, liquido, gassoso ma

lo stato piu’ comune e’ il plasma: gas di atomi ionizzati in cui gli atomi sono privi di

tutti i loro elettroni e quindi essendo elettricamente carichi possono essere controllati

con campi elettrici e magnetici.

Una finestra al plasma puo’ essere usata per isolare dal vuoto una regione di spazio

contenente aria. Vi si riscalda il gas a 6500 C e in questo modo le particelle esercitano

un freno che impedisce all’aria di entrare nella cella con il vuoto. Se si riscalda

notevolmente puo’ far vaporizzare i metalli. Un secondo strato di raggi laser puo’

riscaldare gli oggetti che lo attraversano e li puo’ vaporizzare. Un terzo strato di

nanotubi di carbonio sono in gradi di respingere ogni cosa (attualmente sono solo

lunghi 15mm). Un quarto strato di componenti fotocromatici (con molecole

trasparenti nello stato normale che diventano opachi quando sono attraversati da

ultravioletti) frenano i raggi laser. Attualmente la lunghezza dei nanotubi non e’

sufficiente e non esistono sostanze fotocromatiche ai laser per realizzare tale schermo

impenetrabile!

Futuro tecnologico

cap-pag 1-1/43

2. Levitazione magnetica (macchine volanti, ombrello per pioggia)

Per far levitare oggetti di ogni genere si utilizza l’energia di un campo di forza

magnetico (poli positivi si attraggono e opposti si respingono). I Maglev sono treni

sospesi su binari utilizzando magneti ordinari e cuscini d’ aria per eliminare l’ attrito

a circa 500 km/h. I materiali superconduttori sono raffreddati a temperature

prossime allo zero assoluto e perdono la resistenza elettrica (le vibrazioni casuali

degli atomi ostacolano il flusso degli elettroni e riducendo la temperatura

diminuiscono le oscillazioni). I superconduttori sono ceramiche stratificate che

permettono la circolazione libera di elettroni. In tal modo il trasporto di energia

elettrica avrebbe costi quasi nulli non perdendo energia nel trasporto e una spira

superconduttrice percorsa da corrente diventerebbe un magnete potentissimo per

sollevare grosse dimensioni! Immergere un magnete di grandi dimensioni in un

contenitore di liquido super raffreddato e’ molto costoso: servono impianti di

raffreddamento enormi con costi proibitivi. Occorrono superconduttori a temperatura

ambiente. Attualmente esistono superconduttori ad alta temperatura a 138K cioe’ 135C (lontani dalla temperatura ambiente) che potrebbero essere raffreddati a costi

contenuti mediante azoto liquido che si liquefa a 77K. Una proprieta’ del

superconduttore e’ l’effetto Meissner: un magnete sopra un superconduttore levita

perche’ i campi magnetici non riescono a penetrare all’interno di un superconduttore

e quest’ultimo ne espelle le linee di forza. Se le strade si fanno con materiali

superconduttori e le gomme o i vestiti delle persone con materiale magnetico si

potrebbe levitare!

Esistono materiali non magnetici che diventano tali in presenza di campi magnetici

esterni. Le sostanze paramagnetiche sono attratte da un campo magnetico esterno

mentre le sostanze diamagnetiche ne sono respinte. L’acqua e’ una sostanza

diamagnetica pertanto tutte le creature viventi possono levitare con campi magnetici

potenti di circa 15tesla cioe’ 30000 volte piu’ grande del campo magnetico terrestre.

Con i superconduttori a temperatura ambiente si potrebbero far levitare oggetti non

magnetici di grandi dimensioni sfruttando le proprieta’ diamagnetiche….

Futuro tecnologico

cap-pag 2-2/43

3.

Invisibilita’(mantello invisibile, ologramma)

I campi magnetici si trasformano in campi elettrici e viceversa e i campi viaggiano in

onde che si propagano alla velocita’ della luce. In un solido gli atomi sono vicinissimi

mentre in un liquido/gas la distanza tra molecole e’ grande. I solidi sono opachi

perche’ i raggi luminosi non riescono ad attraversare il muro degli atomi. I

liquidi/gas sono trasparenti perche’ la luce attraversa gli spazi che separano gli atomi

( d spazio ⟩ λlucevisibi le ). Un solido puo’ diventare trasparente se si porta a temperature

elevate e poi si raffredda velocemente (es. vetro). Per rendere invisibile un solido

occorre: liquefare-bollire-evaporare-cristallizzare-riscaldare-raffreddare….

I metamateriali sono sostanze con componenti microscopici che deviano le onde e.m.

(es. circuiti elettrici all’interno di strisce di rame concentriche) e rendono l’oggetto

totalmente invisibile a quella radiazione. La velocita’ luce c e’ costante nel vuoto ma

in un mezzo interagisce con miliardi di atomi e rallenta: piu’ il mezzo e’ denso piu’

l’indice di rifrazione aumenta

indicerifrazione=velocitavuoto/velocitamezzo

(indicerifrazionevuoto=1;indicerifrazionearia=1.0003; indicerifrazionevetro=1.5).

Nel vetro la luce viene deflessa e poi continua a viaggiare in linea retta. Se si potesse

controllare l’indice rifrazione in un metamateriale in modo da portare la luce a

muoversi intorno a un oggetto quest’ultimo diventerebbe invisibile. Il metamateriale

ha indicerifrazione<0 e le strutture da inserire in un metamateriale devono avere

d spazio ⟨ λradiazione per non essere attraversate.

Es. λmicroonde = 3cm; λluceverde = 500nm; λlucerossa = 780nm ; 1nm contiene 5 atomi.

Per rendere invisibile un materiale occorre agire sui singoli atomi per rendere la

distanza piu’ piccola della radiazione. Per deflettere la luce visibile occorre

metamateriale con d < λlucevisibile = 380 ÷ 760nm addirittura distanza<50nm.!! Con la

tecnica di incisione Etching su wafer di silicio immersi in ultravioletti si e’ raggiunto i

100nm e con questa tecnica si e’ realizzato un metamateriale attivo sulla luce rossa

(indicerifrazione=-0.6). Attualmente con la fotolitografia dei componenti per pc su un

wafer di silicio si raggiungono i 30nm per ciascun componente.

I metamateriali servono per sostituire il chip di silicio che utilizza l’elettricita’ con

chip che utlilizzano la luce. Chip di questo tipo non hanno bisogno di raffreddarsi!!

I cristalli fotonici in un chip si realizzano incidendo su un wafer componenti

piccolissime ognuna delle quali porta a un indice di rifrazione differente.

I metalli conducono la corrente elettrica perche’ il legame tra gli elettroni e gli atomi

di un metallo e’ debole e gli elettroni si muovono liberamente lungo il reticolo

cristallino. I plasmoni sono realizzati dalla vibrazione degli elettroni con un fascio

luminoso incidente. I plasmoni si possono strizzare per avere la stessa frequenza e

lunghezza onda inferiore e possono essere messi su un nanofilo. Si dovrebbero usare

strati di meta materiali ciascuno con frequenza diverse. Il problema e’ infatti quello

che ogni metamateriale ha un suo indice di rifrazione fisso e piu’ che un mantello

invisibile ora si potrebbe realizzare un cilindro invisibile…

Futuro tecnologico

cap-pag 3-3/43

La nanotecnologia e’ iniziata con il microscopio a scansione ad effetto tunnel che

opera sui singoli atomi mediante una sonda appuntita elettricamente carica

(piccolissima delle dimensioni di 1 atomo) che agisce sull’atomo da analizzare. La

corrente che attraversa la punta cresce e diminuisce e le sue variazioni vengono

registrate. Per effetto quantistico in un primo tempo gli elettroni non hanno

abbastanza energia per passare dalla sonda al substrato attraverso il materiale da

analizzare ma grazie al principio di indeterminazione esiste una probabilita’ piccola

ma finita che gli elettroni penetrino e spostino gli atomi sottostanti! Lo spostamento

di atomi puo’ permettere di realizzare macchine atomiche non troppo complesse!! Un

po’ come gli organismi unicellulari che si muovono in tutte le direzioni e mediante

filamenti.

L’invisibilita’ puo’ essere raggiunta anche con l’ologramma cioe’ fotografando lo

sfondo alle spalle di una persona e proiettando l’immagine cosi’ ottenuta su uno

schermo olografico posto davanti alla persona. La luce laser e’ coerente cioe’ tutte le

onde che la compongono vibrano all’unisono e per produrre un ologramma si divide

un fascio laser in due: meta’ va ad illuminare una pellicola mentre l’altra si dirige su

un oggetto ne viene riflessa e finisce sulla stessa pellicola della prima. Quando i due

fasci si incontrano si genera una figura di interferenza che contiene in forma

codificata tutte le informazioni relative all’immagine di partenza. Sulla pellicola per

osservare il 3D occorre dirigere un fascio laser (vd dopo)!. Problemi sono: avere una

fotocamera olografica che faccia 30scatti/sec, problema elaborazione e

memorizzazione informazioni, proiezione immagine sullo schermo che sembri

realistica

Futuro tecnologico

cap-pag 3-4/43

Figura: Olografia

Fonte: La scienza: Vol.1 L’universo. La biblioteca di Repubblica

Futuro tecnologico

cap-pag 3-5/43

4. Laser

L’elettrone e’ onda-corpuscolo e obbedisce all’equazione di Schrodinger mediante la

quale si calcolano le proprieta’ degli atomi. Gli elettroni si muovono su orbite discrete

secondo Bohr e nel saltare da un guscio esterno a uno piu’ interno (con energia

inferiore) emettono un quanto di energia cioe’ un fotone. Quando un elettrone

assorbe un fotone di un’energia ben precisa, salta da un guscio interno a uno piu’

esterno.

Un laser funziona mediante un mezzo di trasmissione di raggi come un gas speciale,

un cristallo o un diodo. Tale mezzo viene alimentato da energia come elettricita’,

onde radio, luce o reazione chimica. L’energia eccita gli atomi del mezzo facendo

assorbire fotoni dagli elettroni che saltano su livelli piu’ esterni. In questo stato

eccitato il mezzo e’ instabile e se lo si colpisce con un fascio luminoso, i fotoni di

quest’ultimo si scontreranno con gli atomi facendoli ritornare a un livello energetico

piu’ basso e causando l’emissione di uno o piu’ fotoni. Alla fine si ha un decadimento

a cascata emettendo migliaia di miliardi di fotoni che vibrano all’unisono cioe’ sono

coerenti .

Il laser a gas e’ formato da un tubo che contiene elio-neon a cui viene inviato della

corrente che eccita gli atomi. L’emissione immediata di tale energia immagazzinata

porta alla generazione di un fascio di luce coerente. Due specchi alle estremita’ fanno

rimbalzare il fascio amplificandolo. Uno dei due specchi e’ semiriflettente cioe’ ogni

volta che il fascio lo colpisce una parte della luce riesce ad attraversarlo sfuggendo

all’esterno e generando cosi’ il fascio laser finale. Ci sono laser alimentati da reazioni

chimiche per scopi militari o a semiconduttori per tagliare,saldare o leggere i codici a

barre.

I laser chimici sono alimentati mediante reazione chimica ad esempio la combustione

di un getto di etilene. Sono laser potenti utilizzati per scopi militari (abbattono in volo

missili a corto raggio).

I laser a eccimeri sono alimentati da reazioni chimiche che coinvolgono un gas inerte

(argo, krypton, xeno), del fluoro o del cloro. Utilizzati nell’industria dei

semiconduttori o in campo medico

I laser a stato solido con un cristallo di zaffiro drogato con atomi di cromo insieme a

sostanze chimiche come ittrio, olmio, tullio. Sono usati per generare impulsi

ultracorti ad alta energia.

I laser a semiconduttori sono i diodi che generano fasci intensi per tagliare e saldare o

per leggere i codici a barre

I laser a coloranti utilizzano coloranti organici come mezzo di amplificazione per

impulsi luminosi ultracorti

Il primo problema dei laser e’ l’instabilita’ del mezzo che non puo’ essere

sovraccaricato per evitare un surriscaldamento o la distruzione o il monuso nel caso

di laser a esplosioni. Il secondo problema e’ la necessita’ di alimentatori che non

esistono cosi’ potenti e portatili per garantire l’alimentazione necessaria. Tale

problema potra’ essere risolto con la nanotecnologia. Riguardo alla spada laser e’

impossibile solidificare la luce e farla arrestare a mezz’aria. Si possono creare torce al

plasma: un tubo telescopico che si innesta nell’impugnatura con plasma generato

all’interno lasciato libero di uscire dal tubo da una serie di fori. Si ha un lungo tubo

di gas brillante cosi’ caldo da riuscire a fondere l’acciaio. Anche in questo caso

occorre connettere un alimentatore.

Futuro tecnologico

cap-pag 4-6/43

5. Fusione-fissione(arma a grande raggio in grado di distruggere pianeti)

La fissione nucleare e’ il fenomeno per cui il nucleo di un atomo di uranio si scinde in

due nuclei di massa leggermente inferiore liberando una quantita’ notevole di energia

secondo la formula E= ∆m c2: dove ∆m e’ la differenza tra la massa del nucleo e la

somma delle singole masse

Figura: La fissione nucleare .

Fonte: L’universo in un guscio di noce Stephen Hawking

La fusione si verifica quando l’H compresso dalla gravita’ si riscalda raggiungendo

temperature tra 50 106 e 100 106 C sufficienti a far scontrare i nuclei di H e

provocare la fusione in nuclei di He. La massa si converte in energia secondo l’eq E=

∆m c2 .

Futuro tecnologico

cap-pag 5-7/43

Figura: Formazione di una stella.

Fonte: La scienza: Vol.1 L’universo. La biblioteca di Repubblica

Figura: Fusione nucleare in una stella di dimensioni minore (a sinistra) e maggiore

(a destra) del Sole

Fonte: Wikipedia

Si realizza la fusione a confinamento inerziale quando in una batteria di laser a

cristallo di neodimio si sparano i fasci ad alta energia in un lungo tunnel. Al termine i

fasci incidono su specchi disposti a formare una sfera che fanno convergere i fasci su

una pallina ricca di H come il deuteruro di litio che non pesa piu’ di 10mg e ha le

dimensioni di una capocchia di spillo. La scarica vaporizza la superficie della pallina

e provoca il collasso di quest’ultima. Si raggiungono temperature di alcuni 106 C e i

nuclei di H si fondono in He come in una bomba di H. Secondo il Criterio di Lawson il

processo si innesca se i valori T, densita’ e tempo di sconfinamento sono attuati in

intervalli ben precisi. L’energia emessa e’ sottoforma di neutroni e il Deuteruro di

Futuro tecnologico

cap-pag 5-8/43

Litio raggiunge T di 100 106 C e densita’ maggiore di quella del piombo che vengono

assorbiti dal rivestimento della camera di fusione che si riscalda. Il calore viene

utilizzato nella produzione di vapore che fa girare una turbina per produrre

elettricita’. Si sono realizzati Shiva costruito al LLNL california nel 1978, Nova, Nif

ha 192 fasci e genera potenza di 7 1014 watt (una centrale nucleare produce solo 109

watt). Si realizza la fusione a confinamento magnetico quando una grossa ciambella

al cui interno circola H gassoso e la cui superficie e’ avvolta da bobine di cavo

elettrico. Si raffreddano le bobine per farle divenire superconduttrici e si inietta

corrente elettrica generando un campo magnetico che confina il plasma all’interno

della ciambella e lo riscalda a T stellare. La sorgente di energia e’ economica: il

combustibile viene dall’acqua del mare ricca di H. il problema sta nel comprimere

l’H fino a formare una sfera perfetta. Il progetto piu’ avanzato e’ ITER al sud

Francia Cadarache in cui il reattore porta il plasma di H gassoso a T=100 106 C e

potenza di 500Mwatt/500 sec.

Nella fusione inerziale i fasci laser devono essere perfettamente uniformi e questo

presenta difficolta’ insormontabili.

Nella fusione magnetica i campi magnetici hanno polarita’ +/- ed e’ estremamente

difficile esercitare sul gas una compressione sferica uniforme (ogni volta che si

schiaccia a un’estremita’ si provoca un rigonfiamento sull’estremita’ opposta).

I vantaggi sarebbero la mancanza di scorie nucleari.

I laser a raggi X a innesto nucleare sono una batteria di laser a raggi X capaci di

controllare e di focalizzare l’energia prodotta da un’arma nucleare e potrebbe

distruggere un intero pianeta. Un pezzo di Uranio come una palla distrusse una citta’

intera nonostante la massa convertita in energia rappresentava 1/100 massa totale. I

laser a raggi X con piccolissima lungh onda li rende adatti allo studio di oggetti come

l’atomo. Una bomba H emette quantita’ enorme di energia sottoforma di di raggi X

pertanto un laser X si puo’ alimentare con il nucleare. La bomba Teller genera

un’onda d’urto sferica formata da raggi X energetici. Questi attraversano le sbarre di

rame presenti nel laser che fungono da mezzi di amplificazione e concentrano

l’energia dei raggi X in fasci ad alta intensita’. Il problema e’ che il dispositivo puo’

essere utilizzato solo una volta. Con la stessa logica se si vuole costruire un ordigno

nucleare di potenza arbitraria basta utilizzare una bomba a fissione che sfrutta

energia liberata da U per generare un impulso di raggi X (Hiroshima). Una frazione

di secondo prima che l’onda d’urto prodotta dalla bomba atomica distrugga tutto,

l’impulso sferico di raggi X viene riflesso e focalizzato sul combustibile primario

della bomba (deuteruro di litio). I raggi X lo fanno collassare e lo portano a una

T=106C . La conseguenza e’ una nuova esplosione molto piu’ potente della prima. Il

processo prosegue cosi’ a cascata producendo energia inimmaginabile. Per

distruggere un pianeta occorrerebbero migliaia di laser a raggiX lanciati nello spazio

che sparassero insieme.

Le sorgenti a impulso gamma presenti nella rotazione di una stella se si potessero

controllare, prima che la stella collassi e generi una supernova, si potrebbero

indirizzare verso un punto qualsiasi dello spazio. Le sorgenti gamma emettono

impulsi la cui durata va da pochi secondi a qualche minuto e poi scompaiono. Dopo

che un satellite ne individua la posizione, ne segnala le coordinate esatte alla terra.

Tali coordinate vengono trasmesse a telescopi ottici o radio che si posizionano per

puntare verso la sorgente gamma.

Gli impulsi gamma sono ipernove che danno origine a buchi neri. I buchi neri

ruotano come trottole e connettono due getti di radiazione al polo nord e al polo sud.

Futuro tecnologico

cap-pag 5-9/43

Se la sorgente si trovasse nella nostra porzione di galassia e il getto fosse diretto verso

il nostro pianeta, la sua energia sarebbe sufficiente a distruggere tutto il pianeta. La

prima conseguenza sarebbe la generazione di impulsi elettromagnetici che

metterebbero fuori uso tutti i dispositivi elettronici presenti sul pianeta. I raggi X e

gamma danneggerebbero l’atmosfera terrestre distruggendo lo strato di ozono. Si

innalzerebbe la temperatura della superficie del pianeta provocando incendi di

proporzioni giganteschi. Se non riuscisse ad esplodere il pianeta lo renderebbe arido e

sterile. Basta solo puntare un buco nero su un bersaglio dando un’inclinazione ben

precisa alla traiettoria dei pianeti e delle stelle di neutroni dirette verso la stella

morente un attimo prima del suo collasso. La deviazione sarebbe sufficiente a

cambiare l’asse di rotazione della stella e consentirebbe di puntarla in una direzione

ben determinata.

Futuro tecnologico

cap-pag 5-10/43

6. Teletrasporto

In un atomo c’e’ la probabilita’ che l’elettrone si possa trovare in molti posti allo

stesso tempo. Tali salti quantitativi non possono essere generalizzati a un corpo di

grandi dimensioni come una persona. Gli elettroni sono cosi’ tanti che i loro

movimenti si compensano e quindi a livello macroscopico gli oggetti hanno un aspetto

solido e stabile. A livello atomico si potrebbe cambiare la probabilita’ di qualsiasi

evento quantistico e avere un teletrasporto ma su scala macroscopica occorrerebbe

attendere un tempio maggiore dell’eta’ dell’universo. L’entanglement e’ l’idea per cui

particelle vibrano in maniera coerente e hanno un legame profondo che le unisce.

Prima di effettuare una misura lo spin dell’elettrone non e’ diretto verso il basso ne’

verso l’alto ma e’ in uno stato indeterminato. Non appena si effettua un’osservazione

la funzione d’onda collassa lasciando la particella in uno stato definito. Con

l’esperimento EPR (Einstein, Podolsky, Rosen) si dimostro’ che le onde di due

elettroni che inizialmente vibrano all’unisono in uno stato coerente possono rimanere

sincronizzate anche quando gli elettroni sono a grande distanza l’uno dall’altro,

perche’ c’e’ sempre un’onda di Schroedinger invisibile che li tiene uniti. Se accade

qualcosa a un elettrone l’informazione si trasmette immediatamente all’altro:

entanglement quantistico. Se lo spin totale=0 allora quando lo spin di un elettrone e’ in

un senso, automaticamente l’altro elettrone avra’ lo spin nel senso opposto. Tale

informazione e’ pero’ casuale inutile anche se piu’ veloce della luce. Nel 1993 si

teletrasporto’ tutta l’informazione contenuta in una particella cioe’ fotoni e interi

atomi di Cesio. Si parte da due atomi A e C. Per trasferire l’informazione si prende

un terzo atomo B e si mette in entanglement con C. B e C sono quindi sono in stato

coerente. Se si mette A in contatto con B, l’informazione viene trasferita e quindi si

trovano legati dall’entanglement. Poiche’ l’entanglement e’ tra B e C l’informazione

in A ora si trova sicuramente in C. L’informazione trasportata da A e’ stata distrutta

e non si hanno due copie. L’atomo A non e’ andato ad occupare C: solo

l’informazione di A cioe’ la polarizzazione si e’ trasferita in C. Nel 2004 si sono

trasferiti anche due atomi di berillio e nel 2006 hanno messo in entanglement un

fascio di luce con un gas contenente miliardi di atomi di Cesio a Copenaghen.

Codificarono l’informazione contenuta negli impulsi laser e riuscirono a trasferirla

agli atomi di Cesio a distanza di mezzo metro. Nel 2007 Bradley e il suo gruppo

teletrasporto’ 500 particelle in Australia secondo il metodo di teletrasporto classico e

non quantistico. L’informazione in un fascio di atomi di Rubidio e’ stata trasferita in

un fascio di fotoni che e’ stato poi trasmesso lungo fibra ottica e utilizzato per

ricostruire il fascio di partenza. Si utilizza il condensato di Bose Einsteine (BEC) una

delle sostanze piu’ fredde dell’universo (10-6, 10-9 K, T dello spazio=3K). Quando si

portano tutti i tipi di materia a una T= 0K gli atomi che la compongono precipitano

nello stato di energia minima finendo per vibrare all’unisono in uno stato coerente.

Tutte le funzioni d’onda si sovrappongono e i componenti vibrano in fase. Si prende

un insieme di atomi di rubidio ultrafreddi BEC e lo si fa interagire con un fascio di

materia (ugualmente costituito da rubidio). Gli atomi di rubidio vengono portati

anche essi nello stato di minima energia e emettono l’energia in eccesso sottoforma di

impulso luminoso. Il fascio di fotoni cosi’ generato e’ inviato in una fibra ottica. I

fotoni contengono tutte le informazioni quantistiche per descrivere il fascio di

materia originale. (posizione e velocita’ di ogni suo atomo). Infine il fascio viene

inviato in un altro BEC e il risultato e’ un fascio di materia uguale a quello di

partenza. I BEC sono pero’ difficili da ottenere in laboratorio ma si comportano come

Futuro tecnologico

cap-pag 6-11/43

un gigantesco atomo. Con un simile atomo e’ possibile vedere ad occhio nudo

qualsiasi effetto quantistico. La minima vibrazione puo’ perturbare la coerenza di

due atomi: atomi inizialmente in fase nel corso di qualche secondo perdono la

coerenza. Un’applicazione dei BEC e’ la creazione di laser atomici. Fra una decina di

anni forse si teletrasportera’ una molecola complessa di DNA o un virus. La coerenza

quantistica per corpi macroscopici richiedera’ secoli!!.

Figura: Teletrasporto

Fonte: La trama del cosmo. Brian Greene

Futuro tecnologico

cap-pag 6-12/43

Tra 50 anni si arrivera’ forse ai computer quantistici. I computer si basano sul

calcolo binario (0/1) nel mondo dei quanti invece l’atomo viene descritto dalla somma

di due stati (spin alto/spin basso) e ogni oggetto e’ descritto dalla somma di tutti i suoi

stati possibili. In oggetti macroscopici viventi si somma la funzione d’onda

dell’oggetto vivo con quello morto pertanto l’oggetto non e’ vivo ne’ morto. Se si

considera una fila di atomi allineati in un campo magnetico con gli spin disposti in

un certo modo e si illumina con un fascio laser, tale fascio non sara’ riflesso e in

qualche atomo si verifichera’ una transizione dello spin da uno stato ad un altro.

Misurando la differenza tra il fascio laser entrante e quello uscente si realizza un

calcolo quantistico complesso in cui il numero di spin che hanno cambiato lo stato

puo’ essere elevato. Anche qui il problema e’ la necessita’ di mantenere la coerenza di

un gran numero di atomi. La necessita’ di una nuova generazione di computer sta nel

fatto che la potenza di un computer legato al silicio raggiungera’ il limite fisso nel

2020.

Futuro tecnologico

cap-pag 6-13/43

7. Telepatia (traduttore universale)

La telepatia via radio: il cervello e’ un trasmettitore che diffonde i pensieri sottoforma

di segnali elettrici e onde e.m. I segnali sono estremamente deboli (potenza =mW),

sono disturbati (impossibile distinguerli dal rumore di fondo), non sono in grado di

ricevere msg da altri cervelli (occorrerebbe un’antenna).

La telepatia quantistica: PET (positron emission tomograpy) e MRI (magnetic

resonance imaging).

PET mette nel sangue una quantita’ di zucchero radioattiva che si concentra nelle

aree del cervello coinvolte nel processo del pensiero dove maggiore e’ il bisogno di

energia. Lo zucchero radioattivo emette positroni (elettroni positivi) rilevabili dalla

strumentazione. Ricostruendo l’immagine generata dall’antimateria in un cervello

vivente e’ possibile delineare anche la struttura del pensiero, identificando con

precisione quali parti del cervello sono coinvolte in una determinata attivita’.

MRI in un magnete a forma di ciambella i nuclei degli atomi del cervello si allineano

parallelamente alle linee del campo magnetico. L’invio di un impulso a

radiofrequenza fa oscillare i nuclei e questi nell’orientarsi in un’altra direzione

emettono una eco-radio che puo’ essere misurata e dalla quale si puo’ dedurre la

presenza di una sostanza particolare. Ad esempio si puo’ isolare il processo

concentrando la propria attenzione sulla presenza di sangue ossigenato. A una

maggiore concentrazione di sangue ossigenato in una certa zona del cervello

corrisponde un’attivita’ mentale piu’ intensa. FMRI (MRI funzionale) esamina

porzioni del cervello delle dimensioni di 1m/1sec

MRI serve per la macchina della verita’: secondo la tecnica Langleben

mentire fa aumentare l’attivita’ di diverse zone del cervello (lobo centrale, lobo

temporale, sistema libico).

Fattore positivo:

• nessuno puo’ alterare la struttura dei propri segnali cerebrali.

Fattori negativi:

• Tale tecnica identifica solo l’ansia del soggetto e non distingue la verita’

dall’inganno,

• Necessita di autorizzazioni legali per registrare il flusso del pensiero

• L’incriminazione da una lettura del pensiero puo’ essere considerata

sufficiente/insufficiente.

• Il comportamento e’ legale/illegale nel sentire la mente di un terrorista.

• Esiste la possibilita’ di innestare nella mente falsi ricordi

Un traduttore universale trasmette i pensieri direttamente da una mente ad un’altra.

Le scansioni cerebrali sono troppo primitive per identificare singoli pensieri che

coinvolgono milioni di neuroni simultaneamente. La piu’ piccola porzione di cervello

analizzabile in maniera affidabile e’ detta voxel ma e’ per ora impossibile identificare

i segnali (provenienti dai singoli neuroni). Si puo’ solo isolare la struttura FMRI

generata da entita’ distinte (parole) per poi costruire un dizionario del pensiero.

Questo non e’ un traduttore universale perche’ si deve riconoscere la struttura

FMRI, si deve associarla alle parole inglesi, si deve pronunciarla indirizzandosi al

destinatario. Gli MRI hanno lo svantaggio che sono enormi, costosi e si pensa si

possano sostituire con magnetometri atomici supersensibili. Sukov e Romaks hanno

creato un sensore magnetico basato su vapori di Potassio ad alta T sospesi in Elio.

Dopo aver allineato gli spin degli elettroni del Potassio con un laser viene applicato un

Futuro tecnologico

cap-pag 7-14/43

debole campo magnetico a un campione, si invia un impulso radio nel campione per

far oscillare le molecole. Si produce una sorta di eco che si trasmette agli elettroni di

potassio e poi viene rilevata da un altro fascio laser. Le immagini sono registrate

istantaneamente!

Gli MRI decifrano solo le caratteristiche dei nostri pensieri ma il cervello e’ una

macchina che apprende, una rete neurale che modifica le proprie connessioni ogni

volta che impara ad eseguire un nuovo compito. I pensieri sono diffusi e si potra’ solo

compilare un dizionario di pensiero stabilendo una corrispondenza biunivoca tra certi

pensieri e particolari tracciati di elettroencefalogramma o scansione MRI

Riguardo alla proiezione del pensiero, stimolando elettricamente aree del lobo

temporale si stimola il cervello. Uno speciale casco puo’ inviare al cervello fasci di

onde radio e suscitare emozioni o pensieri ben precisi. Si sta realizzando un progetto

di mappatura neurale per costruire mappe tridimensionali di tutte le loro connessioni.

Si ottiene cosi’ una corrispondenza tra un dato pensiero, la sua espressione MRI e i

neuroni che si attivano. Nel 2006 si e’ trovato una mappatura di 21000 geni a livello

cellulare del topo.

Futuro tecnologico

cap-pag 7-15/43

8. Psicocinesi (levitazone, replicatore)

Psicocinesi serve per influenzare solo con la mente eventi casuali ma il

problema e’ che non si adatta alle leggi fisiche note: la gravitazione e’ esclusivamente

attrattiva e non puo’ essere utilizzata per levitare o respingere oggetti. La f.e.m.

obbedisce alle equazioni di Maxwell ed esclude la possibilita’ di far attraversare una

stanza a un oggetto elettricamente neutro. Le forze nucleari hanno un raggio

d’azione piccolissimo dell’ordine della distanza tra le particelle che compongono il

nucleo. Altro problema e’ che la fonte di energia che il corpo umano puo’ produrre e’

minimo 1/5 cavallo vapore.

Solo l’amplificazione della psicoanalisi mediante onde radio o attraverso l’uso di un

computer e’ una possibilita’ reale. Una persona osserva su uno schermo il proprio

elettroencefalogramma e finisce per imporre a controllare l’andamento delle tracce

osservate attraverso il biofeeedback. Si possono generare con il pensiero sullo

schermo tracciati ben precisi che potrebbero essere inviati a un computer

programmato per il riconoscimento e l’esecuzione di un comando. Donogitue ha

inserito un chip di silicio contenente cento elettrodi nella zona del cervello che

coordina l’attivita’ motoria e penetra a meta’ della corteccia cerebrale (spessa 2mm).

I segnali vengono inviati con fili a un amplificatore e quindi inviato a un computer

per l’elaborazione. Si cerca di rendere il dispositivo portatile e comunicante senza fili.

Se si ricoprissero le pareti di casa con superconduttori a temperatura ambiente.

Inserendo minuscoli elettromagneti all’interno di oggetti ad uso domestico si

potrebbero fa levitare gli oggetti grazie all’effetto Meissner. Se gli elettromagneti

fossero controllati da un computer collegato al cervello allora con il pensiero si

potrebbe attivare il computer e quindi i magneti e si avrebbe la levitazione.

La nanotecnologia costruisce macchine microscopiche a partire da singoli atomi e con

tali macchine si potrebbe modificare la disposizione delle molecole che compongono

un oggetto fino a trasformarlo in oggetti diversi (replicatore). In natura esistono

aminoacidi e proteine (ingredienti), ribosomi (attrezzi) che tagliano e cuciono le

proteine, DNA (schede). Questi si combinano per formare una cellula che ha la

proprieta’ di autoreplicarsi. A causa della struttura della molecola di DNA con la

forma a doppia elica, quando deve riprodursi si scinde nelle due singole eliche e

queste si riproducono catturando le molecole organiche necessarie per ricostruire

l’elica complementare. Si cerca di riprodurre una flotta di nanorobot per manipolare

gli atomi. Con le tecnologia di incisione dell’industria dei semiconduttori si realizzano

circuiti minuscoli con componenti di dimensioni di 30nm che svolgerebbero il ruolo di

cervello. Oppure si potrebbe assemblare nanorobot un atomo per volta con il

microscopio a scansione di sonda che identifica e sposta singoli atomi (10h per

assemblare 50 atomi)

Futuro tecnologico

cap-pag 8-16/43

9. Robot

Secondo alcuni pensieri qualsiasi neurone puo’ essere riprodotto da un insieme di

transistor anche complesso, secondo altri (Penrose) i microtubuli presenti all’interno

di una cellula manifestano un comportamento quantistico che rende impossibile

ridurre il cervello a un insieme di componenti elettrici. Turing a proposito

dell’intelligenza artificiale mise a punto un test: si mette un uomo e una macchina in

due scatole sigillate e si interrogano entrambi. Se risulta impossibile stabilire la

differenza tra le risposte allora la macchina passa il test di Turing. I robot sono in

grado di gestire la sintassi di un linguaggio ma non la semantica. C’e’ una grossa

diatriba se i robot possono pensare: dal riconoscimento delle forme utilizzare cioe’ il

buon senso.

Nell’approccio top-down ci sono stati progetti per l’intelligenza artificiale (CYC=

enciclopedia) ma si sono resi conto che per dare a un computer un senso comune

simile a quello di un bambino occorrono milioni di righe di codice! Nell’approccio

bottom-up si considera il cervello come rete neurale in grado di apprendere (COG

robot con intelligenza di un bambino di 6mesi). Il miglior robot a reti neurali sa

camminare, nuotare ma non saltare, ne’ muoversi rapidamente o muoversi per

cacciare… Le reti neurali di un robot possono essere formate da decine o centinai di

neuroni mentre il nostro cervello e’ formato da 100miliardi di neuroni veri. Il sistema

nervoso di un verme primitivo C.elegans e’ composto da 300 neuroni ma collegati a

loro volta da piu’ di 7000 sinapsi. Pertanto per quanto possa essere semplice il

sistema nervoso e’ cosi’ complesso da non poter essere ricostruito al computer. Forse

bisogna realizzare una sintesi tra i due approcci come fa l’essere umano..

Differenza rispetto uomo:

• Quando si entra in una stanza l’uomo riconosce immediatamente gli oggetti

attraverso miliardi di operazioni e i robot non sanno riconoscere allo stesso modo

gli oggetti: fattore legato all’evoluzione

• Un uomo riconosce il pericolo immediatamente mentre un computer dovrebbe

fare enormi calcoli: fattore legato alla sopravvivenza

• Esistono verita’ che l’uomo acquisisce da bambino interagendo con il mondo reale

e sviluppa attraverso creativita’, originalita’, passione, attitudine… mentre il robot

conosce solo quello per cui e’ stato programmato

• Reagire ai suoni o cogliere la differenza di dimensione, rugosita’ fragilita’ tra un

oggetto e l’altro e’ un compito difficile.

• C’e’ chi afferma che una macchina non potra’ mai provare emozioni perche’

queste rappresentano l’apice dell’evoluzione della specie umana altri affermano

che le emozioni sono un prodotto secondario dell’evoluzione perche’ ci fanno

comodo. Apprezzamento (sesso, amore) di qualcosa ad esempio permette di

selezionare tra tanti oggetti che possono danneggiarci. Vergogna, rimorso,

solitudine etc. sono strumenti per la socializzazione in una tribu’ . Forse i robot

saranno programmati per provare emozioni del resto le emozioni sono cruciali

per prendere delle decisioni!

• La coscienza e’ una serie di pensieri e immagini derivanti da varie zone del

cervello (menti) piu’ elementari che competono per catturare la ns attenzione. Un

animale del resto ha un tipo di coscienza sicuramente non al livello dell’uomo.

Chiedersi se un robot capisca forse e’ irrilevante. Un robot che controlli la sintassi

e capisca quel che gli si dice cioe’ che abbia una padronanza perfetta della sintassi

e’ uguale alla comprensione.

Futuro tecnologico

cap-pag 9-17/43

Se la potenza dei microprocessori raddoppia ogni 18mesi e’ anche vero che tra

qualche anno l’era del silicio potrebbe essere finita. Il processo di miniaturizzazione

che incide sui wafer di sicilio si potra’ interrompere. Ora siamo a spessori di 20atomi

ma quando arrivera’ a 5atomi entrera’ in azione il principio di indeterminazione di

Heisenberg, gli elettroni non si sapra’ dove saranno, la corrente si difoondera’

all’esterno del chip e il computer andra’ in cortocircuito. Il dopo silicio vede

tecnologie come computer quantistici, a DNA, ottici, atomici etc..ma la manipolazione

di atomi e molecole e’ ancora in studio.

Alcuni pensano che se i robot saranno dotati di reti neurali capaci di apprendere a un

ritmo piu’ rapido del nostro potranno creare altri robot.. Altri pensano che invece di

un’estinzione del genere umano potrebbe verificarsi una fusione della tecnologia del

carbonio con quella del silicio cosi’ che la nostra architettura neurale potra’ venire

trasferita direttamente in una macchina e diventeremo immortali… per ogni neurone

tolto si deve creare un neurone duplicato all’interno del robot per poter assistere

all’operazione. Invece di morire in un corpo decrepito ci si puo’ trovare dentro un

corpo immortale con memoria e personalita’ senza mai perdere coscienza.

Futuro tecnologico

cap-pag 9-18/43

10. Extraterrestri

Per la nascita della vita nell’universo occorre:

• acqua allo stato liquido (crea molecole complesse)

• carbonio perche’ ha 4 legami disponibili e puo’ legarsi a 4 atomi distinti (forma

cioe’ molecole complesse), forma inoltre catene lunghe base degli idrocarburi e

della chimica. Miller/Urey presero una soluzione di ammoniaca, metano, altre

soluzioni tossiche che si pensava fossero presenti nell’atmosfera dei primordi.

Sottoposero tale soluzione a una scarica elettrica (per spazzare i legami di

ammoniaca/metano) e dopo una settimana videro che si erano formati aminoacidi

precursori delle proteine. Gli aminoacidi sono presenti nei meteoriti e nelle nubi di

gas interstellare

• molecola autoreplicante di DNA o simile. Le prime molecole e le cellule primordiali

potrebbero avere tutta l’energia per funzionare prima della fotosintesi e della

comparsa delle piante. Non si conoscono altre molecole a base di carbonio in

grado di replicarsi ma e’ probabile che qualsiasi altra molecola autoreplicante

nell’universo assomigli al DNA.

Drake stima che ci possano essere da 100 a 10000 pianeti in grado di accogliere forme

di vita intelligente nella galassia supponendo di avere 1011 stelle nella galassia e 1011

galassie.

L’equazione di Drake e’:

dove:

N è il numero di civiltà extraterrestri presenti oggi nella nostra Galassia con le quali

si può pensare di stabilire una comunicazione

R* è il tasso medio annuo con cui si formano nuove stelle nella Via Lattea

fp è la frazione di stelle che possiedono pianeti

ne è il numero medio di pianeti per sistema solare in condizione di ospitare forme di

vita

fl è la frazione dei pianeti ne su cui si è effettivamente sviluppata la vita

fi è la frazione dei pianeti fl su cui si sono evoluti esseri intelligenti

fc è la frazione di civiltà extraterrestri in grado di comunicare

L è la stima della durata di queste civiltà evolute

R* – tasso di formazione stellare nella Via Lattea

Il valore di R* si ricava da dati sperimentali astronomici noti con ragionevole

precisione, ed è il termine dell'equazione meno discusso. Drake e i suoi colleghi

scelsero un valore R* di 10 stelle nuove all'anno (come media sull'arco di vita della

nostra galassia).

fp – la frazione di tali stelle che possiede pianeti

Il termine fp è meno sicuro, ma è comunque molto meno dubbio dei parametri

seguenti. Si decise di inserire fp = 0,5 (ipotizzando cioè che metà delle stelle possieda

pianeti).

ne – il numero medio di pianeti (o satelliti) per sistema stellare che presentano

condizioni potenzialmente compatibili con la vita

Futuro tecnologico

cap-pag 10-19/43

Il valore di ne venne basato sulle caratteristiche del nostro sistema solare, dato che

negli anni sessanta era quasi impossibile rilevare pianeti terrestri extrasolari, a causa

delle loro ridotte dimensioni. Venne usato ne = 2 (ogni stella con un sistema planetario

possiede due pianeti capaci di supportare la vita).

fl – la frazione di essi che effettivamente sviluppa la vita

Per fl Drake usò il valore 1 (il che significherebbe che tutti i pianeti in grado di farlo

sviluppano la vita); ma questa scelta risulta problematica, sempre in relazione al

nostro sistema solare, perché è in contraddizione con il valore di ne (a meno di non

scoprire che anche Marte ospita o ha ospitato vita intelligente). Inoltre, la scoperta di

numerosi pianeti gioviani (giganti gassosi) in orbite vicine alle loro stelle ha fatto

nascere dei dubbi sul fatto che sia comune che i pianeti terrestri sopravvivano alla

nascita del loro sistema solare. Infine, la maggior parte delle stelle della nostra

galassia sono nane rosse, intorno alle quali risulta improbabile che si sviluppi la vita.

D'altro canto, la possibilità che la vita nasca anche sui satelliti e non solo sui pianeti

può compensare questi fattori, anche se rende più complessa la questione.

Prove geologiche ricavate dallo studio della Terra suggeriscono che fl potrebbe

essere molto alto; la vita sulla Terra sembra essere iniziata quasi nello stesso periodo

in cui si sono presentate le condizioni favorevoli, suggerendo che

l'abiogenesi potrebbe essere relativamente comune laddove le condizioni la rendono

possibile. La stessa idea sembra essere supportata anche dai risultati di esperimenti

come quello di Miller-Urey, che dimostrano che in condizioni adeguate

le molecole organiche possono

formarsi

spontaneamente

a

partire

da elementi semplici. Tuttavia queste prove si basano esclusivamente su dati relativi

alla Terra, cosicché la base statistica è estremamente ridotta; e inoltre sono

influenzate dal principio antropico, nel senso che la Terra può non essere un campione

perfettamente tipico, visto che siamo obbligati a sceglierla come modello perché su di

essa la vita si è effettivamente sviluppata.

fi – la frazione di essi che effettivamente sviluppa vita intelligente e fc – la frazione di

essi che è in grado e decide di comunicare

Difficoltà legate al principio antropico si pongono anche nella stima di fi e fc quando

si considera la Terra come modello. Un'intelligenza capace di comunicare si è

sviluppata su questo pianeta solo una volta in 4 miliardi di anni di storia della vita

sulla Terra: se generalizzata, questa considerazione implica che solo pianeti piuttosto

vecchi possono supportare vita intelligente in grado di tentare comunicazioni

interplanetarie. D'altronde, per quanto riguarda l'uomo, la capacità di intraprendere

tentativi di comunicazione extraterrestre si è sviluppata piuttosto in fretta, appena

100 000 anni dopo la nascita della specie Homo sapiens, e appena 100 anni dopo lo

sviluppo delle capacità tecnologiche necessarie. Si scelse di valutare entrambi i fattori

come 0,01 (il che significa che su un centesimo dei pianeti in cui si sviluppa la vita tale

vita è intelligente, e che un centesimo delle forme di vita intelligenti sviluppa la

capacità di comunicare su distanze interplanetarie).

L – la durata media della fase comunicativa di ognuna di queste civiltà

Anche il fattore L è estremamente difficile da valutare, ma infine si decise che 10 000

anni poteva essere un valore verosimile. Carl Sagan ha sostenuto che è proprio

l'estensione della vita di una civiltà il fattore più importante che determina quanto

grande sia il numero di civiltà nella galassia: egli cioè ha posto con forza l'accento

sull'importanza e sulla difficoltà per le specie tecnologicamente avanzate di evitare

l'autodistruzione. Nel caso di Sagan, l'equazione di Drake è stata un importante

fattore motivante per il suo interesse nei problemi ambientali e per i suoi sforzi di

sensibilizzazione contro la proliferazione nucleare.

I valori di Drake producono un valore

Futuro tecnologico

cap-pag 10-20/43

N = 10 × 0,5 × 2 × 1 × 0,01 × 0,01 × 10 000 = 10.

Ogni variazione dei parametri, anche rimanendo nei limiti della verosimiglianza

scientifica, causa notevoli variazioni nel risultato N, portando a aspre

contrapposizioni tra "ottimisti" e "pessimisti". I valori di N tipicamente proposti

dagli "ottimisti" si aggirano intorno a 600 000, mentre quelli proposti dai

"pessimisti" sono nell'ordine di 0,0000001.

Una lista delle stime più attendibili dei parametri che compaiono nell'equazione di

Drake.

R* – tasso di formazione stellare nella Via Lattea: 7 stelle all'anno.

fp – la frazione di tali stelle che possiede pianeti: il 40% di stelle simili al Sole

possiedono pianeti, e la frazione reale potrebbe essere molto maggiore, poiché solo

pianeti considerevolmente più massivi della Terra possono essere rilevati con la

tecnologia attuale. Osservazioni all'infrarosso dei dischi di polvere intorno a stelle

giovani suggeriscono che il 20-60% delle stelle paragonabili al Sole debbano

possedere pianeti terrestri. Osservazioni di fenomeni di microlenti gravitazionali,

abbastanza sensibili da rilevare pianeti piuttosto lontani dalle loro stelle, vedono

pianeti in circa un terzo dei sistemi esaminati (valore approssimato per difetto, visto

che questo sistema è in grado di rilevare solo una parte dei pianeti). La missione

Kepler, dai dati iniziali, stima che circa il 34% dei sistemi ospiti almeno un pianeta.

ne – il numero medio di pianeti (o satelliti) per sistema stellare che presentano

condizioni potenzialmente compatibili con la vita

La maggior parte dei pianeti osservati ha orbite molto eccentriche, o troppo vicine al

sole per garantire temperature adatte alla vita. Comunque sono noti diversi sistemi

planetari

che

assomigliano

maggiormente

a

quello

solare,

come

HD70642, HD154345, Gliese849 e Gliese581. Nelle zone abitabili intorno a queste

stelle potrebbero anche esserci altri pianeti paragonabili alla Terra ancora da

scoprire. Inoltre, la varietà di sistemi stellari che possono presentare zone di

abitabilità non è limitata esclusivamente alle stelle simili al Sole e ai pianeti simili alla

Terra; attualmente si ritiene che anche pianeti vincolati a nane rosse in modo da

rivolgere alla stella sempre la stessa faccia potrebbero avere zone abitabili, e alcuni

dei grandi pianeti già scoperti potrebbe, potenzialmente, supportare la vita.

All'inizio del 2008, due gruppi di ricerca indipendenti hanno concluso che Gliese581

potrebbe essere abitabile. Poiché sono noti circa 200 sistemi planetari, si può stimare

in modo abbastanza approssimativo che ne > 0,005. Nel 2010, i ricercatori hanno

annunciato la scoperta di Gliese581g, un pianeta di 3,1 volte la massa della

Terra quasi nel centro della zona abitabile di Gliese581, un valido candidato per

essere il primo pianeta extraterrestre abitabile mai scoperto. Data la vicinanza di

Gliese581 e il numero di stelle esaminate con un livello di dettaglio sufficiente a

rilevare pianeti terrestri, la percentuale di stelle che possiedono pianeti simili alla

Terra dovrebbe essere del 10-20%.

La missione Kepler della NASA, partita il 6 marzo 2009, dovrebbe fornire una stima

molto più accurata del numero di pianeti per stella situati in una zona abitabile. Essa

infatti può contare su strumenti assai più sensibili che in passato, in grado di rilevare

pianeti grandi quanto la Terra con periodi orbitali fino a un anno.

Anche noto il numero di pianeti che si trovano in una zona abitabile, comunque,

determinare quanti di essi presentano la giusta combinazione di fattori può essere

difficile. Inoltre, se l'ipotesi della rarità della Terra è valida, l'insieme di

Futuro tecnologico

cap-pag 10-21/43

caratteristiche verificate sulla Terra potrebbe non essere per niente comune, e il

numero ne potrebbe essere estremamente basso, fino a tendere a zero.

fl – la frazione di essi che effettivamente sviluppa la vita: Nel 2002, Charles H.

Lineweaver e Tamara M. Davis (dell'Università del Nuovo Galles Del Sud e

dell'Australian Centre for Astrobiology) hanno usato un ragionamento statistico

basato sul tempo impiegato per svilupparsi dalla vita terrestre per stimare fl,

ottenendo che esso deve essere maggiore di 0,13 sui pianeti più vecchi di un miliardo

di anni.

fi – la frazione di essi che effettivamente sviluppa vita intelligente: Questo valore

rimane particolarmente controverso. Coloro che si esprimono in favore di un valore

basso, come il biologo Ernst Mayr, evidenziano che dei miliardi di specie che sono

esistite sulla Terra solo una è diventata intelligente. Coloro che sono in favore di

valori più alti sottolineano invece che la complessità degli esseri viventi tende ad

aumentare lungo il corso dell'evoluzione, e ne concludono che l'apparizione di vita

intelligente, prima o poi, sia quasi inevitabile.

fc – la frazione di essi che è in grado e decide di comunicare

Anche se si sono fatte molte speculazioni, su questo parametro non sono disponibili

dati concreti.

L – la durata media della fase comunicativa di ognuna di queste civiltà

In un articolo comparso su Scientific American, lo scrittore scientifico Michael

Shermer ha proposto per L il valore di 420 anni, basando la sua stima sulla durata

media di sessanta civiltà storiche. Utilizzando ventotto civiltà più recenti (successive

all'Impero romano) il valore sarebbe, per le "civiltà moderne", 304 anni. Va però

notato che ai fini dell'equazione di Drake questi valori non sono del tutto

soddisfacenti, perché nella storia dell'umanità in generale si è avuto un progresso

tecnologico abbastanza lineare – cioè ogni civiltà subentrata a una precedente ha

conservato e migliorato le realizzazioni già ottenute. Perciò il valore in anni deve

tener conto non di una singola civiltà nel senso storico e culturale del termine, ma di

una specie nella prospettiva del suo livello di sviluppo tecnologico globale. Nella

versione ampliata dell'equazione che tiene conto dei fattori di ricomparsa, questa

mancanza di specificità nella definizione di "civiltà" non influenza il risultato finale,

poiché il succedersi di diverse culture può essere descritto come un aumento del

fattore di ricomparsa anzi che come un aumento di L: una civiltà si conserva come

una successione di culture.

Altri, come l'astrobiologo David Grinspoon, hanno suggerito che una volta che una

civiltà si è sviluppata essa potrebbe superare tutte le minacce poste alla sua

sopravvivenza, e poi sopravvivere per un periodo indefinito, portando L all'ordine

dei miliardi di anni.

Valori basati sulle stime citate,danno come risultato

N = 7 × 0,5 × 2 × 0,33 × 0,01 × 0,1 × 10 000 = 23,1

Le critiche all'equazione di Drake seguono per la maggior parte dall'osservazione che

molti termini della formula sono in gran parte o completamente congetturali. Perciò

l'equazione non può portare a nessun tipo di conclusione.

Se si suppone siano distribuiti uniformemente in tutta la galassia dovremo aspettarci

di trovarne uno a poche centinaia di a.l. dalla Terra. Si sono messi in cerca di segnali

radio emessi dai pianeti che ospitano tale civilta’. Nel progetto SETI (search for

extraterrestrial intelligence) Cocconi/Morrison scelsero la ricerca di segnali nella

regione delle microonde tra 1 e 10Ghz. Tale frequenza corrisponde alla max

probabilita’ di riuscire a trasmettere una comunicazione. Sotto 1Ghz i segnali sono

Futuro tecnologico

cap-pag 10-22/43

sovrastati dalla radiazione emessa dagli elettroni veloci; al di sopra dei 10Ghz c’e’

interferenza con il rumore di fondo generato nell’atmosfera dalle molecole di O2 e

H2O Scelsero 1.420Ghz perche’ si tratta della frequenza emessa dall’H2 allo stato

gassoso cioe’ dell’elemento piu’ comune dell’universo.

Nel 1960 il progetto OZMA con radiotelescopio di 25m non ha trovato alcun segnale.

Nel 1974 il radiotelescopio gigante a Portorico invio’ un msg in direzione ammasso

globulare M14 a 25000 a.l. ma per un’eventuale risposta occorrono 50000 anni…..

Nel 1995 Taller da’ via al progetto Phoenix sempre nella stessa frequenza con

strumenti sensibili da poter raccogliere segnali emessi da 200 a.l. di distanza. Ha

analizzato piu’ di 1000 stelle simili al Sole (costo 5 106 dollari/anno) senza risultati.

Nel 1999 da Barkeley si e’ passati a scaricare un sw che installato su qualsiasi PC

contribuisce a decodificare una parte di segnali radio ricevuti da un telescopio e si attiva

quando entra lo screen saver del PC per non interferire con le attivita’ utente. Ci sono 5

106 utenti da piu’ di 200 nazioni !!!!

I fallimenti forse sono dovuti:

• la scelta di ricevere esclusivamente segnali solo all’interno di bande di frequenza

precise. Gli alieni potrebbero usare segnali laser invece che radio!.I laser

lavorando a frequenze piu’ alte puo’ trasportare piu’ informazioni di una radio

pero’ e’ altamente direzionale contiene un’unica frequenza e bisognerebbe essere

fortunati a trovare quella giusta.

• Gli alieni potrebbero usare tecniche di compressione e distribuzione su un ampio

spettro di frequenze (come i film in internet).

• La vita puo’ svilupparsi in modi di cui l’equazione di Drake non ne aveva tenuto

conto.

Infatti l’acqua allo stato liquido non si trova solo nella zona detto “Riccioli

d’oro” in cui la distanza tra terra e sole e congeniale: non troppo vicino al Sole

(si avrebbe ebollizione), non troppo lontano (si avrebbe congelamento). Si puo’

trovare anche sotto la coltre di ghiacci che ricopre ad esempio Europa (una

delle lune di Giove). Le forze di marea potrebbero essere abbastanza forti da

sciogliere i ghiacci e formare un oceano liquido. Il fortissimo campo

gravitazionale di Giove puo’deformare Europa che vi gira intorno inducendo

attriti che possono fondere la crosta di ghiaccio. Nel ns sistema solare ci sono

oltre 100 lune che potrebbero ospitare la vita e oltre 250 pianeti forse dotati di

lune gelati. Esistono anche pianeti vaganti senza stelle intorno alla quale

orbitare, non visibili. Il numero di corpi astronomici in grado di ospitare

forme di vita nell’universo nella formula puo’ essere piu’ grande.

La probabilita’ che un pianeta all’interno della zona riccioli d’oro possa

ospitare forme di vita e’ molto piu’ piccola nella formula infatti in un sistema

solare ci vuole un pianeta delle dimensioni di Giove per rispedire nello spazio

le comete e le meteore in transito rendendo possibile lo sviluppo di forme di

vita come accade oggi alla Terra. Senza Giove la Terra sarebbe esposta a

tempeste di meteore ogni 104 anni.

Occorre una Luna di grandi dimensioni grazie alla quale lo spin della Terra e’

stabile in caso contrario per effetto della legge gravitazionale di Newton su

milioni dio anni, l’asse della Terra sarebbe stato instabile e il pianeta avrebbe

potuto capovolgersi con conseguenze enormi sul clima e condizioni avverse per

lo sviluppo di vita. Marte ha ad esempio 2 lune piccole e potrebbe non avere lo

spin stabile.

La nascita e l’evoluzione della vita sono molto instabili infatti in passato la vita

sulla Terra si e’ quasi estinta: 2 miliardi di anni fa era ricoperta di ghiaccio, in

Futuro tecnologico

cap-pag 10-23/43

•

•

•

•

seguito eruzioni vulcaniche e meteoriti hanno messo in pericolo le forme di

vita.

La vita intelligente ha rischiato di estinguersi 105 anni fa : le specie animali

presentano variabilita’ genetica mentre i profili genetici degli esseri viventi

sono tutti molto simili tra loro come se fossero cloni dei ns simili. Tutto come

se si fosse sopravvissuti a stento per le condizioni avverse.

Gli eventi che permettono la vita sulla Terra sono: un campo magnetico intenso

(senza il quale la Terra sarebbe sottoposta al bombardamento dei raggi

cosmici), un’adeguata velocita’ di rotazione del pianeta (se ruotasse lentamente

il lato esposto al Sole si riscalderebbe eccessivamente e il lato opposto si

congelerebbe, se ruotasse velocemente si avrebbero venti e uragani fortissimi),

una giusta distanza dal centro della galassia (troppo vicina sarebbe esposta a

eccessiva radiazione, troppo lontana non ci sarebbero elementi pesanti da

consentire la formazione di molecole di DNA e proteine)

Forse la Terra nella galassia e’ l’unico pianeta popolato da forme di vita animale e

occorrerebbe verificare l’esistenza in altre galassie….

Jakosky gelogo disse: “E’ un momento speciale per la storia del genere umano:

siamo la prima generazione che ha una chance realistica di scoprire la vita su un

altro pianeta”.

I pianeti non essendo individuati direttamente da un telescopio vengono

individuati dalle oscillazioni piccole della stella madre sapendo che le dimensioni

devono essere almeno come Giove. Nessuno dei sistemi solari individuati finora

assomiglia al nostro. Il nostro sistema ha pianeti con orbite circolari: una fascia di

pianeti rocciosi in prossimita’ stella madre, una fascia intermedia di pianeti giganti

gassosi e una fascia estrema popolata di pianeti ghiacciati e comete. Pianeti

gioviani orbitano a distanze ravvicinate oppure seguono orbite ellittiche e cio’ e’

incompatibile con la presenza di un pianeta di tipo terrestre. Un’orbita

ravvicinata e’ dovuta a una migrazione da una zona periferica seguendo una

traiettoria a spirale verso il centro del sistema solare a causa dell’attrito con la

polvere interplanetaria. Se cosi’ fosse tale pianeta si troverebbe sull’orbita del

pianeta piu’ piccolo e lo proietterebbe nello spazio cosmico. Analogamente un

pianeta gioviano con orbita ellittica attraverserebbe regolarmente la zona riccioli

d’oro provocando anche in questo caso l’espulsione del pianeta piu’ piccolo.

I nostri telescopi primitivi possono solo rilevare la presenza di pianeti enormi e

rapidissimi e non sono in grado di rilevare una copia esatta del nostro sistema

solare. Il lancio di 3 satelliti Corot (2006), Keplero (2008), Terrestrial Planet

Finder (2014) cercheranno di misurare la debole variazione di luminosita’ di una

stella dovuta al transito di un pianeta di tipo terrestre e trovarne almeno uno

sarebbe straordinario. Analizzano la luminosita’ di 100000 stelle usando un

coronografo (telescopio speciale che riduce la luce della stella madre di un fattore

1miliardo) e un interferometro (sfrutta l’interferenza delle onde luminose per

ridurre la luce proveniente dalla stella madre di un fattore 1milione). Il SETI

invece di analizzare a caso le stelle vicine si concentrera’ su poche stelle.

Riguardo all’aspetto di un alieno bisogna considerare che la simmetria bilaterale

presente in gran parte dei mammiferi presenti non e’ l’unico possibile per una vita

intelligente. La natura ha sperimentato su piccoli organismi multicellulari una

grande varieta’ di forme: midollo spinale a forma di X,Y, radiale per la

sopravvivenza tra prede e predatori.

Futuro tecnologico

cap-pag 10-24/43

Una vita intelligente richiede per percepire l’ambiente esterno e controllarlo: organi

della vista, pollice opponibile (tentacolo o chele), sistema di comunicazione (non un

aspetto umanoide).

Animali che possiedono doti eccezionali superiori alla necessita’ di sopravvivenza

sono dovute a una loro esigenza di dominare sugli altri. Gli esseri umani hanno un

potere cerebrale in eccesso per la solo sopravvivenza e forse gli antagonisti su cui

dominare furono altri membri della stessa specie.

Animali non si sono evoluti ulteriormente perche’ perfettamente adattati

all’ambiente. Noi ci siamo evoluti dalle scimmie per sfuggire ai cambiamenti

ambientali. Se si considera che i carnivori, i predatori con occhi frontali e visione

stereoscopica sono piu’ astuti delle prede con occhi laterali (che devono solo correre)

e’ possibile che cosi’ siano le altre forme di vita inla telligente. Forse tali forme di vita

si baserebbero su DNA e proteine completamente diverse dalle nostre e quindi non

avrebbero interesse a mangiarci o ad accoppiarsi. Se poi vivono su pianeti di

dimensioni comparabili alla Terra con densita’ simile a quella dell’acqua come gli

organismi che popolano la Terra, e’ improbabile che si tratti di creature enormi a

causa della legge di scala secondo la quale se si modifica la scala di un oggetto

qualsiasi le sue caratteristiche fisiche cambiano drasticamente.

Riguardo alla forma di un alieno il peso aumenta proporzionalmente al volume e la

forza e’ proporzionale all’area della sezione trasversale delle ossa e dei muscoli

forza ∝ (lunghezza ) e peso ∝ (lunghezza )

2

3

Quindi un alieno 10 volte piu’ grande di un uomo sarebbe 100 volte piu’ forte ma

1000volte piu’ pesante e le gambe si potrebbero rompere. Il contenuto di calore di un

animale e’ proporzionale al suo volume e il calore emesso da un animale e’

proporzionale alla superficie.

caloreemesso ∝ (lunghezza ) e contenutocalore ∝ (lunghezza )

2

3

Gli animali di grandi dimensioni quindi perdono calore piu’ lentamente di quelli

piccoli. E’ per questa ragione che si gelano prima le dita e le orecchie perche’ l’area

della loro superficie e’ in proporzione maggiore e che le persone piu’ piccole sentono

freddo prima di quelle piu’ grandi. Se si considera che per una sfera la superficie per

unita’ di massa e’ minima si capisce perche’ le balene che solcano l’oceano Artico

sono rotondeggianti. In un microcosmo la superficie rispetto al volume di un alieno

sarebbe stabile. In un macrocosmo tale superficie rispetto al volume sarebbe piu’

piccola e quindi piu’ pesante e renderebbe l’alieno instabile!!. La legge di scala

implica che le leggi della fisica cambiano man mano che si scende nel microcosmo e

non e’ possibile che in un atomo ci sia un universo molto piu’ grande o e’ impossibile

che ci siano mondi dentro altri mondi…un alieno quindi non puo’ essere un gigante.

Riguardo alle civilta’ aliene possono essere classificate in base ai consumi energetici e

possono esserci 3 civilta’:

civilita’ di tipo I: sfruttano l’energia disponibile su un pianeta utilizzando tutta

l’energia solare incidente e tutte le altre energie

Futuro tecnologico

cap-pag 10-25/43

civilita’ di tipo II: sfruttano l’energia emessa dal loro sole e sono 10miliardi di volte

piu’ potenti della civilta’I. Non vengono distrutte da era glaciale, da comete, da

supernova e sono in grado di migrare verso altro sistema solare.

civilita’ di tipo III: sfruttano l’energia disponibile su scala galattica. Colonizzano

miliardi di sistemi stellari, sanno utilizzare l’energia del buco nero e si spostano

liberamente sulla galassia.

La nostra e’ una civilta’ di tipo 0 in cui si alimentano le macchine con legna, petrolio

etc., si utilizza in minima parte l’energia del Sole, si cerca di aver linguaggio

universale, cultura globale, Internet etc…La transizione da una civilta’ all’altra ad

esmpio dal tipo0 al tipo1 e’ problematica: esistono problemi di settarismo,

fondamentalismo, razzismo, pulsioni religiose etc. Il fatto che non siamo entrati in

contatto con civilta’ di tipoI e’ forse perche’ le civilta’0 si sono autodistrutte prima.

Una civilta’III ha l’energia e le conoscenze per viaggiare nella galassia e quindi

raggiungere la Terra: potrebbe inviare robot autoreplicanti alla ricerca di forma di

vita. Non avrebbero bisogno di conquistarci ne’ di raccogliere minerali in quanto

presenti in abbondanza su pianeti morti. Un esempio di tale civilita’ e’ in “odissea

nello spazio”:

Tale civilta’ invia sulla Terra una sentinella o monolite . Sulla Terra e’

presente una specie inferiore che davanti al monolite manifesta paura, ma

anche curiosita’ e ingegno per l’uso di una clava.

Quando sulla Terra e’ presente una specie evoluta il monolite trasmette

segnali per la direzione di Giove. Gli uomini ormai non hanno paura e vivono

con robot e automazione e lo stesso monolite e’ uno stargate per raggiungere

destinazioni nello spazio.

La specie umana ormai sa vivere nello spazio con l’ibernazione, la robotica

etc. Il computer e’ diventato cosi’ superiore da conoscere la destinazione e

boicottare l’uomo che diventa solo un manutentore. L’astronauta riesce a

liberarsi del supercomputer con l’ingegno utilizzando un cacciavite che e’

l’evoluzione dell’antica clava

La specie umana e’ in grado di viaggiare attraverso la galassia e l’atronauta

solo si dirige a ricercare la verita’ su Giove. Anche qui entra in contatto con il

monolite che sembra inglobarlo.

L’astronauta entra nell’evoluzione di uno spazio tridimensionale e a forte

velocita’ raggiunge una stanza. L’uomo vede se stesso invecchiare e seguire poi

i diversi stadi della propria vita. Allo stato massimo della sua vecchiaia, vede

se stesso con davanti a sé il monolito per poi rinascere in forma di feto

cosmico, il "Bambino-delle-stelle" ("Star-Child" in lingua originale), che in un

istante si riporta nello spazio terrestre scrutando dal cielo la nostra Terra,

cogitabondo. Si intuisce che l'astronauta ha subito una accelerazione evolutiva

diventa un essere superiore estremamente evoluto.

Nel corso degli anni si sono proclamati avvistamenti di alieni la cui validita’ e’ stata

negata spiegandola con le seguenti modalita’

Venere uno degli oggetti piu’ luminosi della volta celeste dopo la Luna: la

Luna e Venere sono cosi’ distanti da non capire se si muovono o no e dunque

danno l’impressione che ci seguano

Emissione di gas naturali (fuochi fatui): quando si verifica un’inversione

termica le emissioni gassose possono ristagnare e far distaccare bolle di gas

Meteoriti: possono dare origine a strisce luminose visibili nel cielo notturno

Futuro tecnologico

cap-pag 10-26/43

Anomalie atmosferiche:fulmini e eventi atmosferici.

Eco radar: le onde radar possono rimbalzare su una montagna e creare una

eco che puo’ manifestarsi su uno schermo radar.

Palloni stratosferici: palloni fuori controllo

Aerei: passaggio di veicoli commerciali e militari

Beffe e imbrogli

Gli avvistamenti di astronavi non rispondono a caratteristiche tecniche valide: le

astronavi non hanno gas di scarico, hanno un’accelerazione almeno cento volte

superiore all’accelerazione gravitazionale della Terra che potrebbe schiacciare

qualsiasi creatura pertanto i piloti possono essere solo meccanici. Se l’astronave fosse

a propulsione magnetica avrebbe 2 poli e un magnete immerso nel campo terrestre

non si librera’ per aria ma comincera’ a ruotare come l’ago di una bussola.

Occorrerebbe un monopolo ma non e’ mai stato trovato niente del genere. I monopoli

dovevano essere presenti al tempo del bigbang ma si sono quasi estinti per effetto

dell’inflazione. Solo il monopolo permetterebbe di sfruttare le linee magnetiche

presenti in prossimita’ di galassie o pianeti senza generare gas di scarico. Con la

nanotecnologia, alieni potrebbero inviare astronavi a esplorare pianeti senza piloti e

robotizzati. Tali astronavi non dovrebbero essere cosi’ grandi. Attualmente i sistemi

di propulsione presi in considerazione prevedono km di diametro: motori a fusione a

reazione, vele a propulsione laser, motori nucleari a impulso. Per sondare tutta la

Luna alla ricerca di eventuali radiazioni anomale segno di una nanonave sul nostro

satellite ci vorra’ ancora un altro secolo. Se fosse rimasta una base permanente da

una visita precedente allora le astronavi non avrebbero bisogno di essere grandi

perche’ potrebbero rifornirsi alla base lunare e gli avvistamenti potrebbero

corrispondere al passaggio di voli di ricognizione in partenza dalla base lunare..

Futuro tecnologico

cap-pag 10-27/43

11. Astronavi

Occorre un altro genere di propulsione per raggiungere le stelle per poter

sopravvivere. La Terra ha avuto un’era glaciale 104 anni fa, l’ultima collisione con

una meteorite di 10km diametro e’ avvenuta 106 anni fa. Il Sole si riscaldera’ tra 109

anni, diventera’ una gigante rossa tra 5*109 anni e diventera’ una nana bianca tra

10*109 anni. La Via Lattea si scontrera’ con Andromeda tra 5*109 anni e i buchi neri

daranno origine a una danza mortale.

Il sistema solare piu’ vicino e’ Alfa Centauri a 4 a.l. e i veicoli attuali raggiungono

60000km/h e occorrono 70000 anni per raggiungerlo.

Si definisce

impulso specifico(in sec)=variazione (in momento)/unita’ massa propellente

momento= forza*spostamento/unita’ tempo.

Piu’ efficiente e’ il motore minore e’ la quantita’ di propellente necessaria per

portarlo nello spazio.

Un razzo a propulsione chimica (impulso specifico =250s) dispone di una spinta pari a

diversi milioni di kg ma tale combustibile dura solo qualche minuto.

Il motore a ioni (impulso specifico =3000s)ha una spinta piu’ debole ma puo’ operare

per anni nello spazio. E’ formato da un filamento caldo infiammato dalla corrente

elettrica che crea un fascio di atomi ionizzati (xeno) espulsi all’estremita’ del razzo.

Un esperimento del 1998 ha funzionato per 678 giorni.

Il motore a ioni a plasma usa onde radio e campi magnetici o radiazione solare o

fissione nucleare(impulso specifico =1000-30000s) per riscaldare i gas di H2 fino a 106

C. Occorre pero’ una grande quantita’ di combustibile.

Le vele solari utilizzano la luce del Sole che esercita una pressione lievissima ma

costante sufficiente a spingere nello spazio una vela enorme. Non e’ stato ancora

realizzato nulla di significativo. Si pensa di costruire sulla Luna un’ampia batteria di

laser capaci di proiettare un intenso fascio laser su una vela solare, ognuno dei quali

capace di emettere incessantemente luce per anni e anni se non decenni. I laser

dovrebbero raggiungere una potenza enorme e per funzionare la vela dovrebbe avere

un diametro di centinaia di km ed essere costruita interamente nello spazio. Potrebbe

raggiungere una velocita’ pari a meta’ di quella della luce. Per tornare sulla Terra

dovrebbe essere spinta da una seconda batteria di laser o potrebbe ruotare

rapidamente attorno alla stella e sfruttare l’effetto fionda. I laser sulla Luna

potrebbero essere impiegati per ridurre la velocita’ di ritorno.

I motori a fusione(impulso specifico =2500-200000s) raccolgono l’ H2 nello spazio, lo

riscaldano a una temperatura di milioni di gradi per attivare la fusione con

conseguente rilascio di energia da reazione termonucleare. Un motore di circa 106 kg

puo’ mantenere una spinta costante di 1g di forza (pari a quella del campo

gravitazionale terrestre nei pressi della superficie del pianeta). Dovrebbe riuscire a

mantenere tale accelerazione per 1anno per raggiungere il 77%c sufficiente a rendere

possibile il viaggio interstellare. Ma occorrerebbe un imbuto con cui raccogliere l’H

di circa 160km di diametro e si potrebbe solo realizzare nello spazio per l’assenza di

Futuro tecnologico

cap-pag 11-28/43

gravita’..All’interno del razzo il tempo rallenterebbe e

raggiungere l’ammasso delle Pleiadi distanti 400a.l. e

raggiungere Andromeda a 2*106a.l.!! Attualmente i reattori

deuterio/trizio che sono molto piu’ rari nell’universo e la

irrealizzabile anche se sviluppa un’energia molto inferiore.

in 11 anni potrebbe

in 23 anni potrebbe

a fusione combinano il

fusione p-p e’ ancora

I motori a propulsione nucleare-elettrica(impulso specifico =800-1000s) utilizzano un

reattore a fissione nucleare in modo tale da riscaldare H e poi provocare l’espulsione

dall’estremita’ del razzo con conseguente spinta. Gli esperimenti compiuti hanno

mandato la navicella in pezzi in seguito alle vibrazioni del motore nucleare. Inoltre i

prototipi potevano provocare reazioni a catena incontrollate usando Uranio

arricchito.

I motori a impulsi nucleari(impulso specifico =10000-1000000s) utilizzano minibombe

nucleari per procurare la propulsione. La navicella cavalca l’onda d’urto

raggiungendo velocita’ prossime a quella della luce.. Il prototipo Orione utilizzando

minibombe a fissione doveva raggiungere il 10%c con un peso di 8*106 tonnellate e un

diametro di 400m alimentata da piu’ di 1000 bombe H ma anche con simili velocita’

occorreva un equipaggio multigenerazionale che avrebbe trascorso l’interera vita

internamente!!! Il rischio sarebbe stato la contaminazione nucleare e il rischio di

tumori a seguito del fallout nucleare…Il prototipo Daedalus utilizzando minibombe a

H con 54000 tonnellate avrebbe raggiunto il 7%c per raggiungere senza equipaggio

la stella di Barnard e IpsilonIndi

Futuro tecnologico

cap-pag 11-29/43

Figura: Stelle piu’ vicine al Sole

Fonte: Wikipedia

Ascensori spaziali. Il costo proibitivo per costruire motori giganteschi nello spazio e’

legato anche al consumo per superare i 160km dell’atmosfera terrestre per la spinta

gravitazionale. Un cavo lungo resterebbe sospeso per aria (come una sfera che ruota

appesa ad un filo) a seguito della forza centrifuga della rotazione terrestre che lo

allontana dal centro della rotazione. La tensione di tale cavo avrebbe pero’ un valore

estremamente alto e quindi irrealizzabile. Se il cavo partisse da una stazione

orbitante a 58000km da terra (stazionario) sarebbe sottoposto a una tensione di 60100 gigaPascal mentre l’acciaio ad esempio ha tensione di 2gigaPascal! I nanotubi di

carbonio (studiati negli anni 50) si ipotizza possano supportare una pressione di

120gigaPascal! Nel 1999 la NASA ha ipotizzato un nastro di 1m diametro e lungo

47000km in grado di innalzare un carico di 15tonnellate per ridurre i costi.

Attualmente mandare mezzo chilo di materiale costa 10000dollari quanto il costo