RSM

RSM t-1

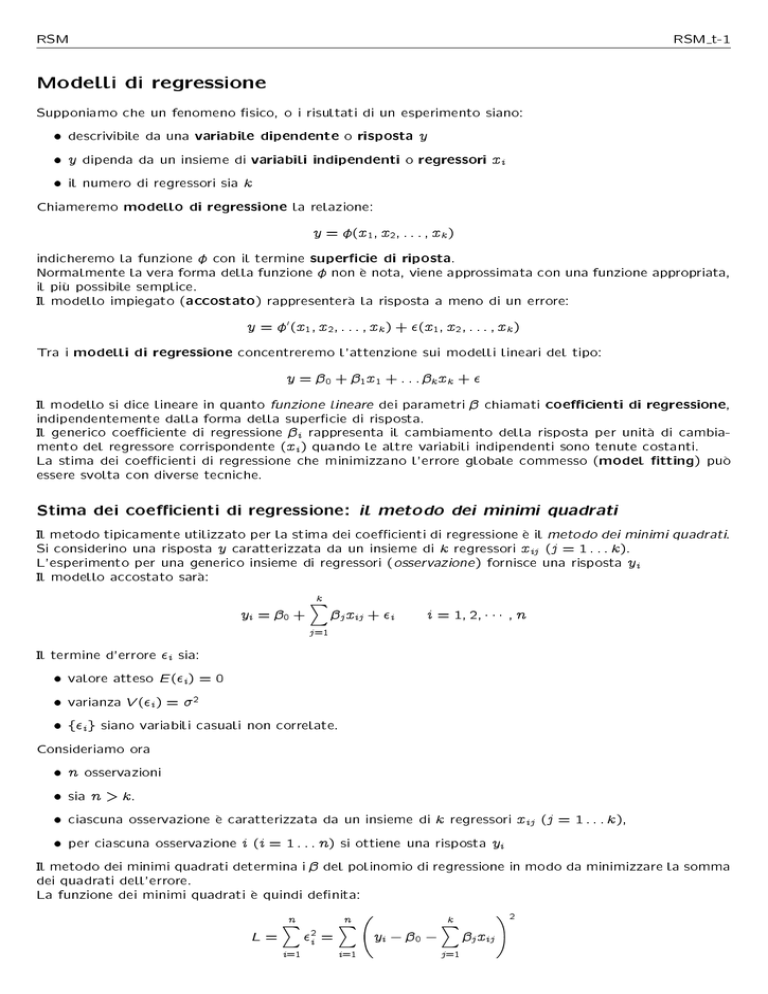

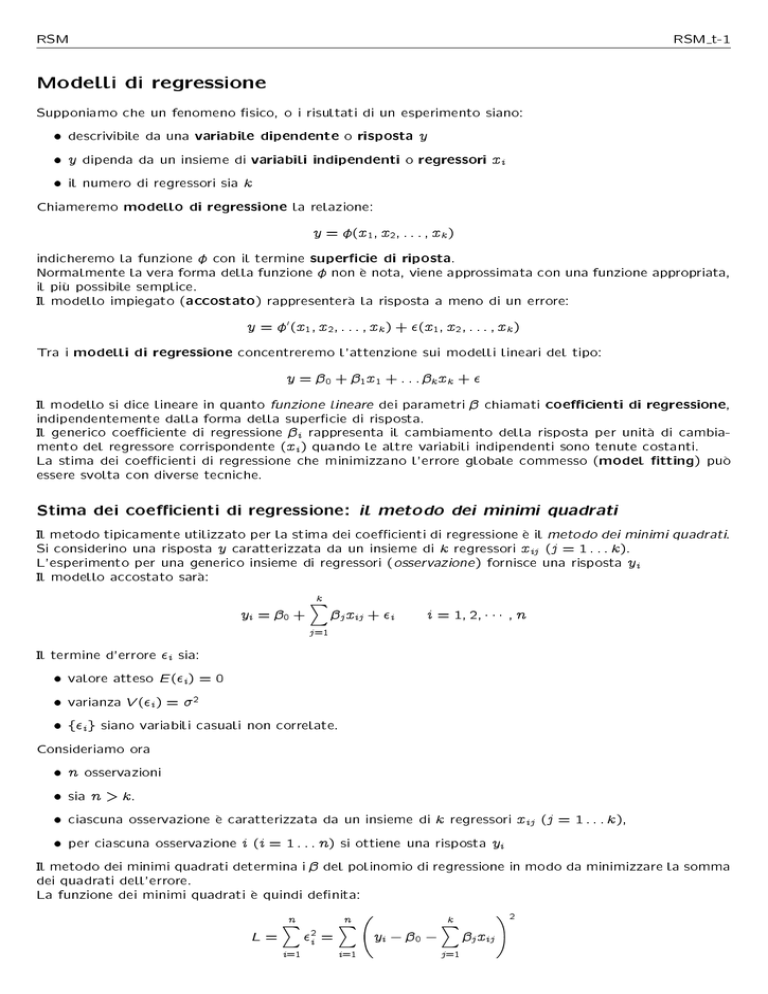

Modelli di regressione

Supponiamo che un fenomeno sico, o i risultati di un esperimento siano:

descrivibile da una variabile dipendente o risposta y

y dipenda da un insieme di variabili indipendenti o regressori xi

il numero di regressori sia k

Chiameremo modello di regressione la relazione:

y = (x1 ; x2 ; : : : ; xk )

indicheremo la funzione con il termine supercie di riposta.

Normalmente la vera forma della funzione non e nota, viene approssimata con una funzione appropriata,

il piu possibile semplice.

Il modello impiegato (accostato) rappresentera la risposta a meno di un errore:

y = 0 (x1 ; x2 ; : : : ; xk ) + (x1 ; x2 ; : : : ; xk )

Tra i modelli di regressione concentreremo l'attenzione sui modelli lineari del tipo:

y = 0 + 1 x1 + : : : k xk + Il modello si dice lineare in quanto funzione lineare dei parametri chiamati coecienti di regressione,

indipendentemente dalla forma della supercie di risposta.

Il generico coeciente di regressione i rappresenta il cambiamento della risposta per unita di cambiamento del regressore corrispondente (xi ) quando le altre variabili indipendenti sono tenute costanti.

La stima dei coecienti di regressione che minimizzano l'errore globale commesso (model tting) puo

essere svolta con diverse tecniche.

Stima dei coecienti di regressione: il metodo dei minimi quadrati

Il metodo tipicamente utilizzato per la stima dei coecienti di regressione e il metodo dei minimi quadrati.

Si considerino una risposta y caratterizzata da un insieme di k regressori xij (j = 1 : : : k).

L'esperimento per una generico insieme di regressori (osservazione) fornisce una risposta yi

Il modello accostato sara:

yi = 0 +

k

X

j=1

j xij + i

i = 1 ; 2; ; n

Il termine d'errore i sia:

valore atteso E (i) = 0

varianza V (i) = 2

fig siano variabili casuali non correlate.

Consideriamo ora

n osservazioni

sia n > k.

ciascuna osservazione e caratterizzata da un insieme di k regressori xij (j = 1 : : : k),

per ciascuna osservazione i (i = 1 : : : n) si ottiene una risposta yi

Il metodo dei minimi quadrati determina i del polinomio di regressione in modo da minimizzare la somma

dei quadrati dell'errore.

La funzione dei minimi quadrati e quindi denita:

L=

n

X

i=1

2i =

n

X

i=1

0

@

yi 0

k

X

j=1

12

j xij A

RSM

RSM t-2

L deve esser minimizzata rispetto 0 ; 1 ; :::k , ossia i ^j risultanti dalla stima ai minimi quadrati (stimatori)

devono soddisfare:

@L (i = 0 : : : k )

@i ^ ;^ ;:::^k = 0

Si ottengono (k + 1) equazioni:

0

1

0

n

k

X

X

@L @ yi

=

2

^0

@0 ^ ;^ ;:::^k

i=1

0

e

0

n

X

@L = 2 @yi ^0

@j ^ ;^ ;:::^k

i=1

0

j=1

1

1

k

X

j=1

1

^j xij A = 0

1

^j xij A xij = 0 j = 1 k

Riorganizzando i termini delle due equazioni otteniamo:

n^0 + ^1

e

^0

n

X

i=1

xi1 + ^1

Scrivendo in forma compatta:

n

X

i=1

n

X

e

^0

n

X

i=1

xij +

k

X

h=1

xi1 + + ^k

i=1

n

X

x2i1 + + ^k

i=1

n^0 +

n

X

k

X

h=1

^j

n

X

i=1

^j

n

X

i=1

xih =

xij xih =

i=1

n

X

i=1

n

X

i=1

xik =

n

X

i=1

xi1 xik =

yi

n

X

i=1

xi1 yi

yi

xij yi

j = 1:::k

si ottiene un totale di p = k + 1 equazioni (una per ogni coeciente della regressione 0 compreso)

dette equazioni normali ai minimi quadrati le cui soluzioni sono gli stimatori ai minimi quadrati dei

coecienti di regressione ^0 ; ^1 ; ; ^k .

Risulta piu agile la risoluzione della stima ai minimi quadrati esprimendo il modello in forma matriciale,

in tal modo si ottiene:

Y = X + con:

2

2

y1 3

1 x11 x12 x1k 3

6 y2 7

6 1 x21 x22 x2k 7

7

6

Y=6

X

=

6 .

7

6 . 7;

..

..

.. 7

4 .. 5

4 ..

.

.

. 5

yn

1 xn1 xn2 xnk

2

6

1

2

3

2

7

6

7

=6

6 . 7;

4 .. 5

k

1

2

3

7

7

=6

6 . 7

4 .. 5

n

ove Y e il vettore (n 1) delle osservazioni, X e la matrice (n p) contenente le variabili indipendenti,

e il vettore (p 1) dei coecienti di regressione e e il vettore (n 1) contenente i termini inerenti

gli errori casuali.

L'intento e determinare il vettore degli stimatori ai minimi quadrati che minimizzino la somma dei quadrati

degli errori, in notazione matriciale e possibile scrivere:

L=

n

X

i=1

2i = 0 = ( Y X ) 0 ( Y X )

= Y0 Y Y0 X 0 X0 Y + 0 X0 X

= Y0 Y 2 0 X0 Y + 0 X0 X

RSM

RSM t-3

in cui si ha ( 0 X0 Y)0 = Y0 X essendo 0 X0 Y una matrice 1 1 (ossia uno scalare).

Gli stimatori devono ancora soddisfare:

@L = 2X0 Y + 2X0 X^ = 0

@ ^

si ottiene:

X0 X^ = X0 Y

che rappresenta la forma matriciale compatta delle equazioni normali ai minimi quadrati.

Scrivendo in dettaglio:

2

6

X0 X = 6

6

4

Pn

Pn

i=1 xik

Pn

Pn i=1

xi1

2

i=1 xi1

i=1 xi1

..

.

xi2 i=1 xi1 xi2 Pn

Pin=1

n

..

.

Pn

i=1 xik xi1

..

.

Pn

i=1 xik xi2

Pn

Pn i=1

xik

i=1 xi1 xik

Pn

..

.

i=1 xik

3

7

7

7

5

2

Si nota come la matrice X0 X sia quadrata (p p) e simmetrica e X0 Y un vettore colonna (p 1).

Si ricava quindi il vettore degli stimatori ai minimi quadrati ^:

^ = (X0 X) 1 X0 Y

Il modello di regressione accostato e:

^y = X^

in notazione scalare:

y^i = ^0 +

k

X

j=1

i = 1 ; 2; ; n

^j xij

La dierenza tra le osservazioni reali yi ed i reciproci valori stimati y^i viene denominata residuo: ei =

yi y^i . Il vettore (n 1) dei residui e:

e = y ^y

Stima della varianza

Se si considera la somma dei quadrati dei residui:

SSE =

Ponendo: e = y

^y = y

i=1

(yi

y^i ) =

2

n

X

i=1

(e2i ) = e0 e

X^ nella relazione appena esposta si ha:

SSE = (y X^0 )(y X^)

essendo X0 X^ = X0 y, si ottiene:

La relazione ha n

n

X

= y0 y

y0 X^

X0 ^0 y + ^0 X0 X^

SSE = y0 y ^X0 y

p gradi di liberta, si puo dimostrare che....

Verica della validita del modello di regressione

Importante, a valle della determinazione del modello di regressione, e la valutazione della bonta del

modello scelto: occorre vericare che il modello si adatti correttamente ai dati a cui verra applicato,

ossia dimostri un certo grado di adabilita.

I Coecienti di determinazione

Si consideri la somma dei quadrati totali SST , e scomponibile in due contributi:

SSR : somma dei quadrati dovuta allo specico modello di regressione scelto,

SSE : somma dei quadrati dovuta all'errore (ai residui)

RSM

RSM t-4

SST = SSR + SSE

Somma dei quadrati dovuti all'errore ottenibile dalla relazione:

SSE =

Ponendo: e = y

^y = y

n

X

i=1

( yi

y^i ) =

2

n

X

i=1

e2i = e0 e

X^ nella relazione appena esposta si ha:

SSE = (y X^0 )(y X^)

= y0 y

essendo X0 X^ = X0 y, si ottiene:

y0 X^

X0 ^0 y + ^0 X0 X^

SSE = y0 y ^X0 y

Somma dei quadrati totali puo esser scritta:

SST =

n

X

i=1

yi

2

(

Pn

i=1 yi )

2

n

= y0 y

(

Pn

i=1 yi )

n

2

Pn

Manipolando l'espressione della somma dei quadrati dei residui sommando e sottraendo il termine ( i=1n yi ) ,

tenendo presente che: SSE = SST SSR ; la somma dei quadrati dovuta alla regressione e esprimibile

come:

P

( ni=1 yi )2

0

0

^

SSR = X y

n

Al ne di vericare l'adeguatezza dei termini inseriti nel modello, una prima valutazione di massima puo

essere compiuta tramite l'utilizzo del coeciente di determinazione multiplo R2 :

SSR = 1

R2 = SS

T

2

SSE

SST

Il coeciente R2 fornisce una misura della stima generale dell'adeguatezza del modello di regressione,

fornisce un'indicazione di massima di quanto della variabilita totale dei dati viene spiegata dal modello

creato: un fattore R2 del valore di 0.8 indica come il modello `spieghi' l'ottanta percento della variabilita

dei dati; valori del coeciente R2 > 0; 8 sono indici di una buona adabilita del modello.

Tuttavia, l'aggiunta di nuovi termini al modello porta sempre ad un aumento di R2 (senza correlazione

col fatto che la variabile aggiunta sia o meno signicativa), da questa osservazione discendono dubbi

sulla completa adabilita del coeciente di determinazione multiplo. L'aggiunta di ulteriori parametri

al modello, infatti, non sempre si traduce in una accresciuta sensibilita del modello, si corrono due rischi

principalmente: in primis l'inserimento di termini che non arrecano conoscenze aggiuntive a quelle gia

possedute ed hanno come unica conseguenza l'appesantimento del modello, non di meno e un rischio

reale la possibilita di integrare nella regressione errori, cosa che inquinerebbe i risultati ottenuti dal

modello creato (condizione denominata overt).

Si preferisce quindi utilizzare la statistica R2 aggiustata (R2 adjusted):

SSE =(n p) = 1 n 1 (1 R2 )

2

Radj

=1

SST =(n 1)

n p

2

Radj

che non aumenta con l'aggiunta di nuove variabili al modello, anzi, se al modello si sommano termini

2

superui Radj

molto spesso decresce, compensando l'aggiunta di nuovi termini con il diminuire dei gradi

2

di liberta. Nel caso che R2 e Radj

dieriscano radicalmente, si hanno elevate probabilita che nel modello

siano stati inclusi termini non signicativi.

Test di signicativita

L'analisi della varianza identica un metodo per vericare l'uguaglianza di piu medie di popolazione. La

relazione fondamentale su cui questa tecnica si basa scompone la variabilita totale del sistema studiato

nella somma della variabilita spiegata dalla regressione e della variabilita residua non spiegata dal modello

RSM

RSM t-5

che viene associata all'errore compiuto nella regressione. Tale relazione e formalizzata tramite le somme

dei quadrati come precedentemente visto:

SST = SSR + SSE

Parallelamente e possibile scrivere un'analoga relazione tra i gradi di liberta (numero degli elementi

indipendenti presenti in ogni somma dei quadrati) del sistema:

GdLT = GdLR + GdLE

Dal rapporto di ogni somma dei quadrati rispetto al relativo grado di liberta e possibile ricavare i quadrati

medi associati alla regressione e all'errore:

SSR

MSR = GdL

R

SSE

MSE = GdL

E

Dalle due `identita notevoli' sopra esposte derivano un insieme di statistiche, che ci si appresta ad introdurre

dei seguenti paragra, nalizzate a guidare all'identicazione dell'adabilita della regressione applicata

ad un insieme di dati; i risultati delle analisi condotte mediante dali statistiche vengono solitamente

riassunte in una tabella di analisi della varianza. Tale tabella pone in ingresso solitamente:

le componenti della variabilita del sistema,

le somme dei quadrati,

i GdL associati alle somme dei quadrati,

i quadrati medi,

test sulla signicativita dei regressori.

Test su singoli coecienti di regressione e su gruppi di coecienti

Si e spesso interessati alla verica di ipotesi su singoli coecienti di regressione al ne di vericare se il

modello possa essere piu ecace con l'inclusione di variabili aggiuntive o con la soppressione di termini

gia presenti nel modello ma inecaci.

L'aggiunta di una variabile al modello porta

incremento della somma dei quadrati della regressione SSR

diminuzione della somma dei quadrati dovuti ai residui SSE

se il regressore e ininuente porta ad un aumento di SSE

Le ipotesi per valutare la signicativita di un singolo coeciente di regressione j sono:

H0 : j = 0

H1 : j 6= 0

Se l'ipotesi H0 risulta valida allora il regressore associato xj puo essere eliso dal modello. La statistica

test per la valutazione di questa ipotesi e il test t :

^

t0 = p 2j

^ Cjj

ove Cjj e l'elemento sulla diagonale di (X0 X) 1 corrispondente a ^j e ^ 2 (stimatore della varianza) e dato

da:

^ 2 = SSE

n p

Si riuta H0 se jt0 j > t=2;n p , ossia: il regressore associato al coeciente su cui si esegue il test risulta

essere signicativo per il modello.

RSM

RSM t-6

Metodo della somma dei quadrati aggiuntiva

E da notare che il test e parziale in quanto il coeciente di regressione ^j dipende anche da tutti gli altri

regressori presenti nel modello.

Si puo tener conto di cio attraverso il metodo della somma dei quadrati aggiuntiva, utilizzabile anche

per valutare il contributo di un sottoinsieme di variabili di regressione al modello.

Si considerino ad esempio i due modelli:

y = 0

y = 0 + 1 x1

Se SSR del secondo modello e `grande' rispetto quello del primo modello, allora l'inclusione del regressore

1 risulta importante.

Il problema che si presenta e introdurre una stima, un metodo che consenta di quanticare il termine

\grande" precedentemente utilizzato relativamente a SSR .

Generalizzando, e possibile vericare se un modello del tipo y = 0 + ki=1 i xi con l'aggiunta dei

termini i accresce la bonta del modello y = 0 , ovvero anche se solo una parte di tali regressori ha

eetti beneci sulla regressione.

P

Per vericare l'importanza dei termini inclusi nel modello si utilizzera un rapporto tra varianze.

L'operatore varianza restituisce un valore non negativo per denizione, essendo un valore elevato al

quadrato, cio fa si che la distribuzione della varianza non sia del tipo normale bens del tipo 2 .

Il test che consente di vericare la dipendenza della regressione da un sottoinsieme di regressori, congurandosi anch'esso come il rapporto di due varianze, ossia come il rapporto di due distribuzioni 2 , avra

una forma del tipo:

2

1 =k1

22 =k2

dove k1 k2 siano i gradi di liberta relativi a 21 e 22 . Il rapporto tra due distribuzioni 2 denisce un nuovo

tipo di distribuzione: Distribuzione-F.

Si consideri il modello con k regressori:

y = X + ove le dimensioni delle matrici sono: y(n 1), X(n p), (p 1), (n 1).

L'intento e di vericare se il sottoinsieme x1 ; x2 ; :::; xr (r < k) e signicativo per il modello di regressione.

A tal ne si scompone il vettore colonna dei coecienti nel seguente modo:

1

= 2

ove le dimensioni dei due vettori sono 1 (r 1) e 2 [(p r) 1].

Le ipotesi che si vogliono valutare sono:

H0 : 1 = 0

H1 : 1 6= 0

E possibile a questo punto riscrivere il modello mettendo in evidenza le due componenti del vettore :

y = X1 1 + X2 2 + ove X1 e X2 rappresentano le colonne di X associate rispettivamente a 1 e 2 .

Per il modello completo (ossia il modello comprendente tutti i k + 1 regressori) vale: ^ = (X0 X) 1 X0 y.

La somma dei quadrati della regressione per tutte le variabili, intercetta compresa (0 ), e:

SSR ( ) = ^0 X0 y

tale somma dei quadrati e detta somma dei quadrati della regressione dovuta a (con p gradi di liberta,

dal momento che viene onsiderata anche l'intercetta). SSR ( ) e legata ai quadrati medi dei residui

tramite:

0

0

^ 0

MSE = SSE = y y X y = y y SSR ( )

n p

n p

n p

Per valutare il contributo di 1 si costruisce il modello considerando vera l'ipotesi H0 : 1 = 0, utilizzando

quindi solo i coecienti appartenenti a 2 ossia i p r coecienti estranei al sottoinsieme di regressori

di cui si vuole valutare la signicativita. Il modello ridotto avente tali caratteristiche si ottiene ponendo

RSM

RSM t-7

1 = 0:

y = X2 2 + Attraverso il metodo dei minimi quadrati e ottenibile lo stimatore ^2 = (X02 X2 ) 1 X02 y, e da questo il

relativo:

SSR (2 ) = ^0 2 X02 y

a cui sono associati p r gradi di liberta. Si hanno ora tutti gli elementi per ricavare la somma dei

quadrati della regressione dovuti ai soli coecienti di regressione appartenenti a 1 (non compresi nel

modello ridotto):

SSR ( 1 j 2 ) = SSR ( ) SSR (2 )

La somma dei quadrati determinata e la somma dei quadrati aggiuntiva dovuta a 1 , con r gradi di liberta.

SSR ( 1 j 2 ) e indipendente da MSE e l'ipotesi H0 puo esser valutata tramite il test F parziale:

F0 = SSR ( 1 j 2 )=r

MSE

Se F0 > F;r;n p H0 viene riutata, ossia: almeno uno dei coecienti di regressione 1 e diverso da zero

e di conseguenza almeno uno dei regressori x1 ; x2 ; :::; xr appartenenti a X1 e signicativo per il modello

di regressione.

0.0.1 Test di signicativita

Consente di vericare la presenza di relazioni lineari fra la variabile di risposta Y ed un sottoinsieme di

variabili indipendenti (regressori) x1 ; x2 ; :::; xk .

Si formulano due ipotesi:

H0 : 1 = 2 = = k = 0

H1 : j 6= 0 per almeno un j

Nel caso H0 sia vericata allora nessuno dei regressori x1 ; x2 ; :::; xk contribuisce signicativamente al modello, viceversa, nel caso risulti vericata H1 almeno una delle variabili indipendenti ha un eetto determinante

sulla variabile di risposta Y .

La procedura per la verica dell'ipotesi H0 si eettua tramite il test-F, il calcolo si compie:

R =k

= MS2R = MSR

F0 = SS SS

=

(

n

p

)

^

MSE

E

ove con MSR e MSE si sono indicati i quadrati medi della regressione e dei residui deniti a partire dalla

somma dei relativi quadrati divisi per i propri gradi di liberta (numero degli elementi indipendenti presenti

in ogni somma dei quadrati). Bisogna quindi denire un termine di confronto per stimare la validita dell'ipotesi compiuta, il parametro di confronto dipende dall'adabilita con cui si intende accettare o confutare

l'ipotesi H0 . Il parametro che fornisce l'adabilita cercata e il termine , ponendo che l'attendibilita

ricercata sia denita come il complemento a 1 di si puo dire come: ricercando una attendibilita del

test pari al 90% (ossia 0,9) il valore di da porre in considerazione sia 0,10. Scelto , si riuta H0 se:

F0 > F;k;n p , ossia: la variabile di risposta Y mostra una dipendenza lineare rispetto ad un sottoinsieme

di regressori. I risultati possono essere ecacemente riassunti in una tabella di analisi della varianza come

la seguente:

Origine della Somma dei

Gradi di

Quadrati

Variabilita

Quadrati

Liberta

Medi

F0

Regressione

SSR

k

MSR MSR =MSE

Errori (Residui)

SSE

n (k + 1) = n p MSE

Totale

SST

n 1