Tecniche di realtà virtuale ed aumentata applicate ad un

microscopio operativo.

Training e supporto per neurochirurghi

A. De Mauro1, M. Aschke1, J. Raczkowsky1, R. Wirtz2, M. Ciucci1, H. Wörn1

for Process Control and Robotics, University of Karlsruhe (TH) , Germany,

2Neurosurgical Department, Clinic University of Heidelberg, Germany

Contacts: [email protected]

1Institute

Abstract

Presso l’Institute for Process Control and Robotics dell’Università di Karlsruhe (Germania) è stato

realizzato un primo prototipo di microscopio in Realtà Aumentata.

In questo articolo presentiamo gli studi attuali orientati ad estendere tale architettura dall’uso operativo

a quello di completo strumento di training per giovani neurochirurghi.

I potenti strumenti offerti dagli ultimi sviluppi della realtà virtuale (interfacce aptiche con ritorno di forze e

modellazioni fisiche) sempre più accurati e performanti garantiscono risultati ottimi nell’apprendimento

del gesto chirurgico e minimizzano i tempi di formazione. E’ il naturale sviluppo del Computer Aided

Surgery (CAS).

Keywords: Realtà Aumentata e Virtuale, Training System, Neurochirurgia, Interfacce Aptiche, Rilevazione

delle Collisioni, Modellazione Fisica, Tracking System, Navigazione.

Introduzione e background ( microscopio 3D in realtà aumentata).

In neurochirurgia, una buona parte degli interventi (approssimativamente il 60% nelle

cliniche della Europa centrale) viene eseguita utilizzando un microscopio per rendere più

accurata la sequenza dei piccoli gesti chirurgici. Attualmente i microscopi commerciali

offrono la possibilità di visualizzare il contorno bidimensionale delle regioni tumorali

sovrapposto alla visione reale. Tali contorni sono ottenuti segmentando le immagini

CT/MRI del paziente durante un minuzioso lavoro radiologico preoperativo.

Questo stato dell’arte risulta limitante per numerosi neurochirurghi poiché delega ad essi

l’arduo compito di immaginare la struttura tridimensionale dei tumori: ciascun medico

deve effettuare il lavoro mentale di ricostruzione 3D da immagini piane. Il livello di

esperienza nonchè quello di stanchezza influiscono pesantemente sui risultati dei delicati

interventi.

Presso l’Institute for Process, Control and Automation dell’ Università di Karlsruhe

(Germania) è stato realizzato un primo prototipo di microscopio in Realtà Aumentata [1].

L’idea è quella di offrire ai neurochirurghi la possibilità di visualizzare le strutture

tridimensionali delle regioni di particolare interesse ai fini dell’intervento in sala

operatoria. Tale visualizzazione non può che essere stereoscopica per una buona

sovrapposizione alla realtà (ovviamente stereo e bi-oculare del microscopio).

Sono richieste due operazioni preliminari per una efficace visualizzazione in AR: la

registrazione e la calibrazione.

Lo scopo della registrazione è quello di trovare un matching tra l’anatomia reale del

paziente e le immagini CT/MRI e relative ricostruzioni 3D. Per far questo, si identificano

dei punti noti sul paziente (il numero è proporzionale al grado di accuratezza voluto) e si

trova la corrispondenza sulle informazioni dell’ambiente virtuale a disposizione.

Una volta ottenuta la relazione tra i vari sistemi di riferimento legati al reale (paziente,

dispositivo di tracking, strumenti chirurgici) e al virtuale (ricostruzioni 3D) si è pronti per

la visualizzazione in real-time.

Ovviamente, questo passo deve essere preceduto dalla calibrazione delle camere per

l’utilizzo dei corretti parametri di visualizzazione e dall’allineamento con le due (una per

oculare) viste virtuali per ottenere l’effetto stereoscopico.

Poiché durante l’effettivo svolgimento dell’operazione il chirurgo si avvale di un sistema

di navigazione a display per capire l’effettiva posizione degli strumenti nell’anatomia

celebrale, il sistema é in fase d’integrazione con 3DSlicer [2], eccellente applicazione

opensource per la navigazione intraoperatoria, del tutto simile ai ben noti prodotti

commerciali (es. BrainLab o Stryker).

Sviluppi attuali e futuri: il simulatore di training neurochirurgico.

L’obiettivo di questa nuovo progetto di ricerca è lo sviluppo di un sistema di training per

giovani neurochirurghi basato sugli strumenti di realtà virtuale e su un vero microscopio

operativo.

Il realismo della simulazione è, in questo caso, strettamente legato al gradi di accuratezza

della modellazione fisica dei tessuti e dell’anatomia celebrale ed, ovviamente, dalla

precisione del ritorno di forze fornito dall’interfaccia aptica (un Phantom Desktop della

Sensable).

Lo stato dell’arte in tema di simulazioni neurochirurgiche è ridotto a pochi studi [3].

Le motivazioni di questa rarità d’esempi sono da ricercarsi sia nella complessità della

modellazione dei tessuti e dell’anatomia del cervello (che è il sistema più complesso

dopo quello cardiaco) e sia nell’utilizzo di strumenti di input visivo (head mounted

displays o semplici monitor) diversi dal microscopio realmente impiegato in sala

operatoria.

Da questa considerazione scaturisce l’idea di riutilizzare una parte dell’architettura

precedentemente descritta per implementare un completo e realistico sistema

d’addestramento basato su microscopio per il ritorno visivo e su interfaccia aptica per

ritorno di forze.

Si tratta quindi di integrare, al sistema già esistente, i moduli per la rilevazione delle

collisioni tra organi e strumenti chirurgici [4], per la modellazione fisica di tessuti e per il

calcolo della forza a valle di una collisione.

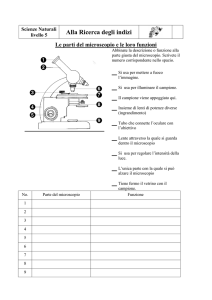

In Figura 1 è riportato l’ architettura funzionale del simulatore.

Figura 1: schema funzionale del simulatore

Nella fase pre-simulazione sarà ricostruito (off-line) l’ambiente virtuale a partire dai dati

del paziente virtuale. Questo implica la creazione dei modelli 3D e l’assegnamento dei

parametri fisici (es. elasticità dei singoli tessuti). In letteratura esistono differenti

metodiche per la modellazione fisica e i principali sono: Finite Element Method (FEM),

Long Element Method (LEM), Mass spring Damper. I primi due sono basati su modelli

matematici continui e quindi sono più robusti e forniscono un elevato realismo a spese di

un fortissimo carico computazionale.

Il metodo delle masse e delle molle invece è meglio classificabile come discreto ma si

sposa meglio con i vincoli di real-time. Tali vincoli sono molto stringenti se si utilizza

un’interfaccia meccanica ad elevato frame rate quale quella aptica e soprattutto se si

considera il normale ritardo dovuto al rendering della scena direttamente negli oculari del

microscopio.

In questa prima fase del progetto abbiamo deciso di adottare quest’ultimo metodo per

focalizzare meglio l’attenzione sulla parte di complessa integrazione tra piattaforma di

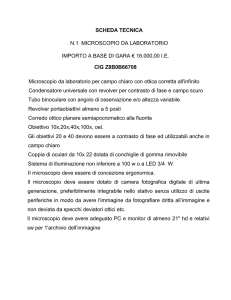

realtá virtuale, interfaccia aptica e microscopio (fig.2).

Durante la simulazione il modello dinamico del tessuto é descritto da un sistema di

equazoni differenziali (1).

r r r

r

r

r r

mi ai + ci vi + ∑ j∈σ (i ) Fij ( xi , x j ) = mi g + Fi ext (1)

r

r

vi

x

i

Dove

é il vettore coordinate del nodo Ni,

e

r

ai

sono i vettori velocitá ed

r

Fi ext

accellerazione rispettivamente, ci é il coefficiente di smorzamento e

é la forza

σ (i )

é il set di indici per i nodi adiacenti a Ni nella mesh

esterna totale applicata su Ni e

3D del modello.

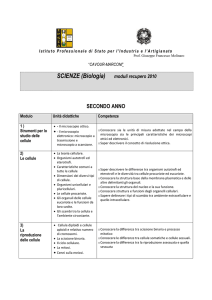

Il cuore di ogni sistema che simuli l’interazione fisica tra oggetti é la rilevazione delle

collisioni. E’ l’abilitá di rilevare quando due oggetti nella scena sono in contatto.

Un fattore chiave dell’intera simulazione é costruire una algoritmo di collision detection

robusto,veloce ed accurato.

Il metodo scelto si basa su partizioni del modello, ossia sulla strategia di suddividere

l’oggetto in sottoinsiemi coerenti computandone, per ciascuno, il volume che lo contiene.

Tale volume dovrebbe quanto piú possibile aderire all’oggetto allo scopo di minimizzare

i test di collisione ad esso riferiti (fig.3).

Se viene rilevato un contatto, posizione e velocitá sono calcolate per ogni punto

interessato nella collisione.

I dati provenienti da questo modulo sono la risposta alle collisioni ovvero la base per il

calcolo della forza da restituire all’utente tramite l’interfaccia aptica.

Figura 2: Interazioni con tessuti deformabili

Figura 3: Rilevazione delle collisioni

(AABB- Axis Aligned Bounding Box)

Nel processo, in tempo reale, di rendering grafico dovranno essere calcolate tutte le

collisioni tra oggetti e strumenti chirurgici.

Affinché la simulazione sia ancora più completa e realistica è possibile visualizzare la

navigazione degli strumenti nella regione intracraniale su un monitor utilizzando lo stesso

sistema di tracking e 3DSlicer (come in precedenza). Questo riflette l’iter adottato in sala

operatoria.

Conclusioni

In questo articolo presentiamo l’architettura e le caratteristiche principali di un sistema di

training integrato in un microscopio operativo. Tali studi si basano su un prototipo di

microscopio in realtà aumentata sviluppato precedentemente che stiamo modificando per

adattarlo alle nuove esigenze estendendolo con nuove funzionalità per una più accurata e

completa navigazione.

Questo lavoro è parte del progetto europeo CompuSurge finanziato nell’ambito del

programma quadro FP6 all’interno della Marie Curie action.

REFERENCES

1.

2.

3.

4.

M. Aschke, C. R. Wirtz, J. Raczkowsky, H. Wörn, S. Kunze, “Augmented Reality in Operating Microscopes

for Neurosurgical Interventions”, 1st International IEEE EMBS Conference on Neural Engineering 2003 Proceedings pp. 652 - 655, 2003, Editor Wolf & Strock.

3DSlicer Project URL: http://www.slicer.org/ [status July 2007]

G. Wiet, J. Bryan, D. Sessanna, D. Streadney, P. Schmalbrock, and B. Welling, "Virtual temporal bone

dissection simulation," in Medicine Meets Virtual Reality 2000, J. D. Westwood, Ed., Amsterdam, The

Netherlands, January 2000, pp. 378– 384, IOS Press.

G. Van den Bergen, “Efficient Collision Detection of Complex Deformable Models using AABB Trees”,

Journal of Graphics Tools, 2(4), 1-13, 1997.