Capitolo VII

La cluster analysis

7.1. Generalità sulla cluster analysis

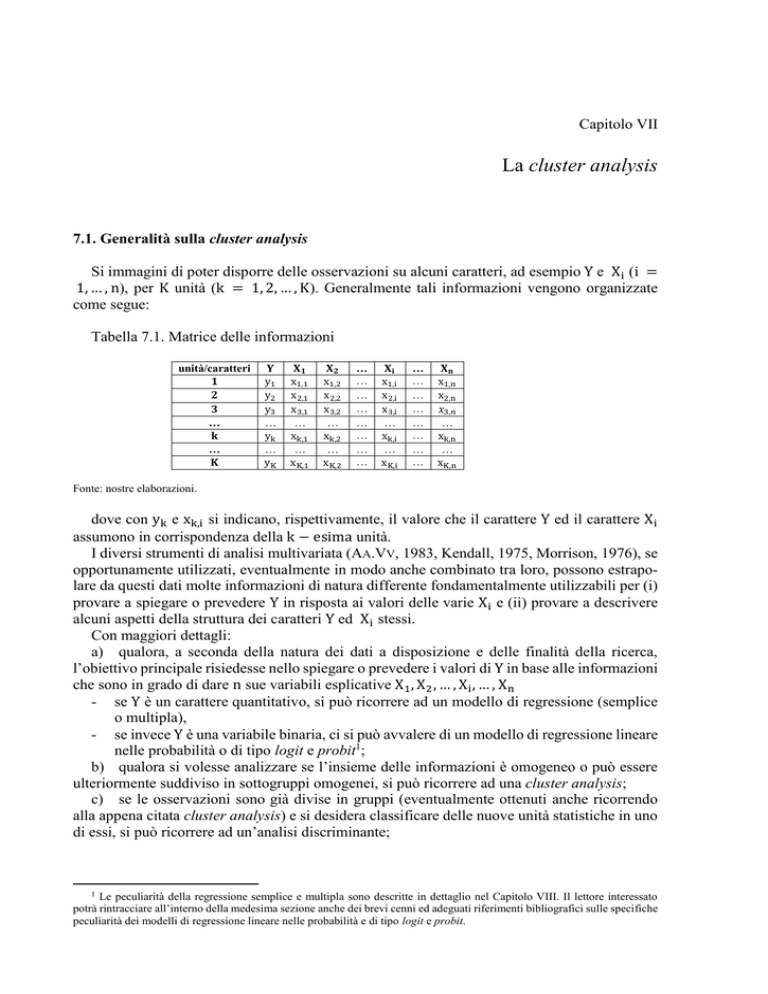

Si immagini di poter disporre delle osservazioni su alcuni caratteri, ad esempio Y e Xi (i =

1, … , n), per K unità (k = 1, 2, … , K). Generalmente tali informazioni vengono organizzate

come segue:

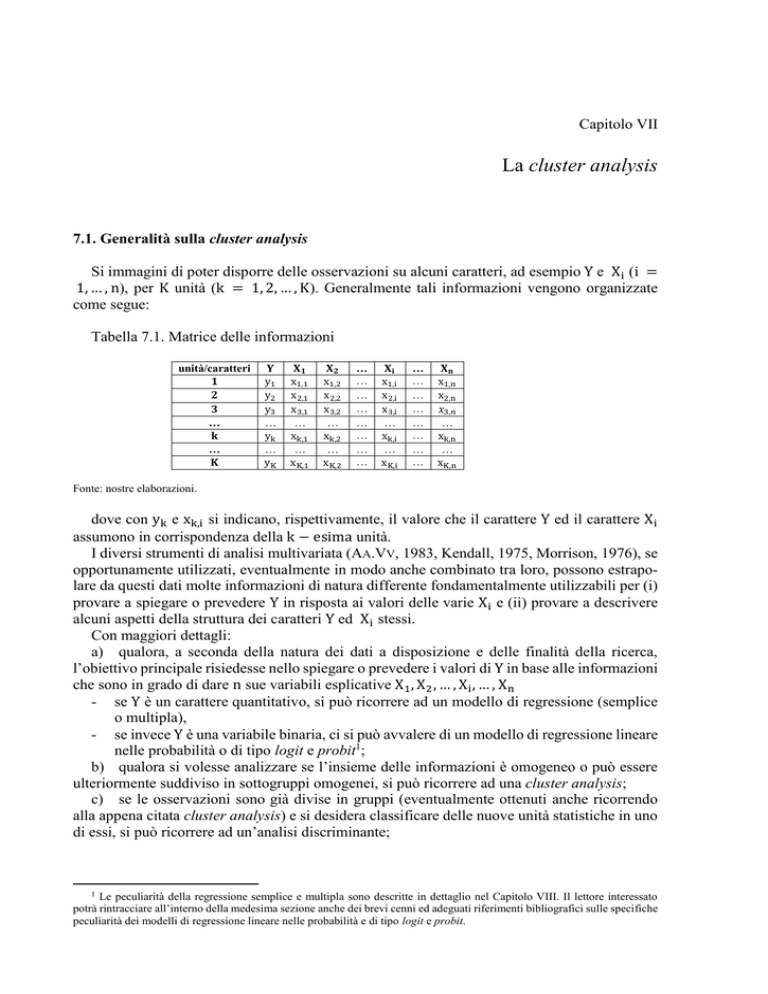

Tabella 7.1. Matrice delle informazioni

unità/caratteri

𝟏

𝟐

𝟑

…

𝐤

…

𝐊

𝐘

y1

y2

y3

…

yk

…

yK

𝐗𝟏

x1,1

x2,1

x3,1

…

xk,1

…

xK,1

𝐗𝟐

x1,2

x2,2

x3,2

…

xk,2

…

xK,2

…

…

…

…

…

…

…

…

𝐗𝐢

x1,i

x2,i

x3,i

…

xk,i

…

xK,i

…

…

…

…

…

…

…

…

𝐗𝐧

x1,n

x2,n

𝑥3,𝑛

…

xk,n

…

xK,n

Fonte: nostre elaborazioni.

dove con yk e xk,i si indicano, rispettivamente, il valore che il carattere Y ed il carattere Xi

assumono in corrispondenza della k − esima unità.

I diversi strumenti di analisi multivariata (AA.VV, 1983, Kendall, 1975, Morrison, 1976), se

opportunamente utilizzati, eventualmente in modo anche combinato tra loro, possono estrapolare da questi dati molte informazioni di natura differente fondamentalmente utilizzabili per (i)

provare a spiegare o prevedere Y in risposta ai valori delle varie Xi e (ii) provare a descrivere

alcuni aspetti della struttura dei caratteri Y ed Xi stessi.

Con maggiori dettagli:

a) qualora, a seconda della natura dei dati a disposizione e delle finalità della ricerca,

l’obiettivo principale risiedesse nello spiegare o prevedere i valori di Y in base alle informazioni

che sono in grado di dare n sue variabili esplicative X1 , X2 , … , Xi , … , Xn

- se Y è un carattere quantitativo, si può ricorrere ad un modello di regressione (semplice

o multipla),

- se invece Y è una variabile binaria, ci si può avvalere di un modello di regressione lineare

nelle probabilità o di tipo logit e probit1;

b) qualora si volesse analizzare se l’insieme delle informazioni è omogeneo o può essere

ulteriormente suddiviso in sottogruppi omogenei, si può ricorrere ad una cluster analysis;

c) se le osservazioni sono già divise in gruppi (eventualmente ottenuti anche ricorrendo

alla appena citata cluster analysis) e si desidera classificare delle nuove unità statistiche in uno

di essi, si può ricorrere ad un’analisi discriminante;

1

Le peculiarità della regressione semplice e multipla sono descritte in dettaglio nel Capitolo VIII. Il lettore interessato

potrà rintracciare all’interno della medesima sezione anche dei brevi cenni ed adeguati riferimenti bibliografici sulle specifiche

peculiarità dei modelli di regressione lineare nelle probabilità e di tipo logit e probit.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

d) se l’intento è quello di provare a sintetizzare i dati a disposizione attraverso la creazione

di nuovi caratteri (ottenuti combinando quelli di partenza) che possano spiegare una buona parte

della variabilità dei dati originari, si può ricorrere all’analisi delle componenti principali;

e) se infine si pensa che i caratteri a disposizione possano dipendere da alcuni fattori latenti

(non osservabili), si può invece indagare tale circostanza facendo riferimento ad un’analisi fattoriale.

La cluster analysis è dunque una tecnica multivariata attraverso la quale è possibile raggruppare delle unità.

Come tutte le metodologie matematico-statistiche, questo approccio ha caratteristiche comuni con altre tecniche di classificazione. Al fine di garantire i risultati più performanti in relazione ai dati di partenza ed agli obiettivi della ricerca, questa metodologia dispone di un'ampia

varietà di algoritmi e misure fra cui è possibile scegliere al fine di ottenere il più adeguato

raggruppamento.

E’ difficile trovare in letteratura un’unica definizione di cluster analysis (Quaranta, 2008).

Generalmente essa viene intesa come uno strumento di classificazione capace di scomporre una

realtà complessa di osservazioni plurime in tipologie specifiche, ma si parla anche di meccanismo di ricerca della coesione interna ed isolamento esterno (Everitt et al., 2001) in modo da

minimizzare la lontananza logica interna a ciascun gruppo e massimizzare quella tra i gruppi

(Sadocchi, 1993). Anderberg (Anderberg, 1973) si riferì alla cluster analysis come al metodo

capace di individuare il più elevato grado di associazione naturale tra gli elementi di un gruppo

e di relativa distinzione tra gruppi differenti, definendo peraltro questi ultimi come sottoinsiemi

del collettivo in analisi che consistono di elementi molto simili rispetto alla rimanente parte dei

dati (Arabie et al., 1996). Secondo Romesburg (Romesburg, 2004) un processo di cluster analysis consiste nel ripartire un insieme di unità elementari in modo che la suddivisione risultante

goda di alcune proprietà ritenute desiderabili. Per altri studiosi classificare delle unità statistiche

significa invece formare dei gruppi in modo che le unità che sono assegnate allo stesso insieme

siano simili tra loro ma al contempo i vari cluster siano il più possibile distinti (Livny et al.,

1996).

In ogni caso, sintetizzando le varia posizioni, è possibile dire che la cluster analysis è una

tecnica esplorativa e descrittiva dei dati di partenza che procede ad una riduzione della complessità delle osservazioni costruendo gruppi omogenei e mutuamente esaustivi di elementi eterogenei rispetto ad uno stesso insieme di caratteri presi in considerazione. Per far questo, come

già accennato, al fine di garantire i risultati più performanti in relazione ai dati di partenza ed

agli obiettivi della ricerca, ci si può avvalere di diversi algoritmi e di differenti procedure per la

misurazione della somiglianza tra le unità statistiche in modo che gli elementi all’interno dei

gruppi siano quanto più possibile somiglianti tra loro ed al contempo non somiglianti a quelli

appartenenti agli altri cluster.

La cluster analysis nacque nel 1939 per opera di Tyron che per primo la presentò come una

variante dell’analisi fattoriale. Grazie al lavoro dei due biologi Sokal e Sneath (Sneath et al.,

1963), la metodologia ricevette un forte impulso negli anni Sessanta del secolo scorso quando

Ward (Ward, 1963) elaborò la sua tecnica di clustering a partire da un problema di classificazione di posizioni occupazionali e Johnson (Johnson, 1967) concepì la cluster analysis coma

una procedura utile per rappresentare la struttura della matrice di similarità fra i casi.

Anche in ambito economico, aziendale e finanziario, le finalità generali per le quali può

essere condotta una cluster analysis sono molteplici (Fabbris, 1989). Accanto alle già citate

esplorazione, sintesi e riduzione della complessità delle informazioni2, meritano di essere ricordate la generazione di ipotesi di ricerca3, l’identificazione di classi omogenee dentro le quali si

A tal proposito si fa notare come l’esplorazione, la sintesi e la riduzione della complessità delle informazioni rivesta un

ruolo di particolare importanza nel facilitare la lettura dei dati rilevati e la presentazione, in forma parsimoniosa ma al contempo

esauriente, dei risultati di un’analisi.

3 A tal proposito si fa notare come per effettuare un’analisi di raggruppamento via cluster analysis non sia necessario avere

in mente preliminarmente alcun modello interpretativo. A differenza di altre tecniche statistiche multivariate (come ad esempio

2

VII. La cluster analysis

possa supporre che le unità statistiche siano mutuamente surrogabili (Green et al., 1967), la

ricerca tipologica delle unità statistiche tale da far risaltare esaurientemente la fisionomia del

sistema osservato, la costruzione di sistemi di classificazione automatica (Jardine et al., 1971),

l’individuazione di strati ai fini di un più opportuno campionamento delle informazioni attinenti

un fenomeno nonché la predizione, validazione di ipotesi ed adattamento di un modello in relazione a particolari gruppi di unità statistiche di un più ampio collettivo di riferimento al fine

di una migliore calibratura delle relazioni funzionali.

7.2. Le fasi di una cluster analysis

E’ già stato detto che una cluster analysis, avvalendosi di procedure diverse, classifica dei

casi4, sui quali sono stati misurati differenti caratteri, in un numero relativamente contenuto di

classi (gruppi, grappoli o cluster). Il risultato è quindi rappresentato dall’individuazione di un

certo numero di gruppi all’interno dei quali il ricercatore è in grado di allocare i diversi casi

osservati5.

Punto di partenza di ogni cluster analysis è pertanto la disponibilità di un collettivo (anche

campionario) di K elementi (o unità statistiche o casi) ognuno rappresentato da un certo numero

n di caratteri6.

Prendendo le mosse dalla matrice di osservazioni di dimensione K × n che rappresenta

quanto appena detto, alcune procedure di cluster analysis (quelle che si diranno di tipo gerarchico) costruiscono una matrice di somiglianza dalla quale partono per pervenire ad una gerarchia di partizioni, mentre altre (quelle che si diranno di tipo non-gerarchico) determinano direttamente attraverso suddivisioni iterative una sola partizione degli elementi considerati in un

numero di gruppi specificato dal ricercatore7.

A differenza di quanto accade, ad esempio, con l’analisi discriminante, si noti che i gruppi

non sono mai determinati a priori sebbene talvolta potrebbe essere necessario fissare il loro

numero8.

Come già accennato, il criterio di assegnazione delle unità statistiche ai vari cluster è composito poiché richiede che i casi all’interno di ogni gruppo siano caratterizzati da un elevato

livello di somiglianza (massima somiglianza delle unità statistiche within group) ed al contempo le diverse classi siano sempre relativamente distinte (massima distinzione between

group).

Una cluster analysis è in grado di produrre risultati robusti se condotta seguendo con rigore

alcune fasi fondamentali che, generalmente, è possibile sintetizzare come segue:

1) selezione dei K elementi appartenenti al collettivo di riferimento;

la già citata analisi discriminante che, come accennato, rende possibile la ripartizione di un insieme di individui in gruppi

predeterminati fin dall'inizio della ricerca in base alle diverse modalità assunte da uno o più caratteri), la cluster analysis non

si basa infatti su alcuna assunzione fatta a priori sulle tipologie fondamentali di unità statistiche presenti in un collettivo. Tale

tecnica ha dunque un ruolo completamente esplorativo nella ricerca delle strutture latenti al fine di desumere la partizione più

probabile e pertanto si caratterizza come metodo puramente empirico di classificazione, quindi in primo luogo come tecnica

induttiva.

4 Anche se accade meno frequentemente, una cluster analysis può in realtà classificare anche i caratteri stessi. In questo

caso si è al cospetto di un’applicazione simile, per i risultati che si possono ottenere, all’analisi fattoriale. Può essere utile

effettuare l’analisi dei cluster sui caratteri in alternativa all’analisi fattoriale quando il livello di misurazione di questi ultimi è

basso (ad esempio se si è in presenza di caratteri qualitativi – nominali - con più di due modalità), o quando ci sono violazioni

della normalità o quando infine il numero delle unità statistiche è particolarmente scarso (Barbaranelli, 2006).

5 O, per quanto appena detto, i diversi caratteri.

6 Con riferimento alla precedente Tabella 7.1., si può dire che ad ognuna delle K unità è associato un vettore di (n + 1)

osservazioni i cui valori sono configurabili come le coordinate dell’unità considerata in uno spazio euclideo a (n + 1) dimensioni.

7 Se implementate con l’ausilio dei più noti software statistici, tutte le procedure di clustering consentono di avere informazioni sul gruppo di appartenenza di ogni caso ed una serie di indici e rappresentazioni grafiche attraverso cui valutare la

bontà della soluzione raggiunta.

8 E’ il caso delle procedure non-gerarchiche.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

2) scelta degli n caratteri in base ai quali operare la classificazione;

3) prae-trattamento dei dati relativi ai caratteri;

4) quando occorre, scelta della misura di somiglianza da usare nell’implementazione;

5) scelta della procedura di cluster analysis ed al suo interno dell’algoritmo (metodo) di

raggruppamento delle unità osservate;

6) identificazione-fissazione del numero dei gruppi;

7) analisi critica, valutazione ed interpretazione dei risultati ottenuti con conseguente connotazione tipologica dei gruppi.

Per quanto attiene gli elementi oggetto di analisi, si fa presente che il collettivo di riferimento

può essere sia una popolazione sia un campione di unità statistiche.

Indipendentemente dal contesto di applicazione, un contributo di ricerca usualmente è il

frutto dell’apporto congiunto di un pool di studiosi. Qualora nell’ambito dell’analisi del fenomeno oggetto d’interesse si rendesse necessario procedere con una cluster analysis, la scelta

dei caratteri in base ai quali operare la classificazione9 elle unità statistiche è naturale che rispecchierà le convinzioni e le idee dei vari ricercatori inevitabilmente evidenziando un elevato

grado di soggettività che discende dall’aver abbracciato specifiche convinzioni teoriche a meno

che, in qualche modo, non esista una certa identità di vedute sul tema che si sta analizzando

nell’ambito della letteratura di riferimento.

Può quindi capitare di non considerare caratteri fortemente selettivi (in questa situazione si

perverrebbe ad una partizione in gruppi poco esaustiva e dunque poco efficace se non addirittura errata) o, sul fronte opposto, di aver incluso caratteri dotati di un’elevata capacità discriminante ma non rilevanti ai fini dell'indagine (anche in questa situazione si perverrebbe a risultati di scarso rilievo pratico). A questa fase della ricerca bisogna quindi che venga dedicata la

necessaria attenzione poiché l’omissione di caratteri significativamente importanti o l’errata

inclusione di informazioni non rilevanti inevitabilmente può condurre a soluzioni improprie.

Generalmente non è possibile elaborare i dati così come arrivano dal sistema di rilevazione

poiché, per almeno tre differenti motivi, è consigliabile che essi passino per un adeguato trattamento preventivo. Gli esempi più comuni di prae-processing sono i seguenti:

a) ripulitura dei dati, consistente nell’eliminazione delle informazioni chiaramente errate

poiché non ragionevolmente consistenti con la maggior parte delle altre o perché provenienti

da eventuali condizioni sperimentali differenti. In questa fase generalmente si fa rientrare anche

la ricerca di possibili outlier;

b) estrazione di caratteri derivati, noti come feature, a partire dai caratteri osservati. Tale

circostanza è di fondamentale importanza in tutti quei casi in cui i dati grezzi possono avere o,

di fatto hanno, un significato nascosto;

c) specifico trattamento/trasformazione delle modalità dei caratteri al fine di rendere l’informazione da essi veicolata completamente non distorsiva in quanto del tutto indipendente

dalla propria metrica - unità di misura ed ordine di grandezza (Morrison, 1967, Matthews,

1979). Molte tecniche statistiche infatti funzionano o funzionano meglio quando i dati sono tutti

sulla stessa scala e quindi, non essendoci anisotropie nello spazio dei dati10, tutti i caratteri

contribuiscono in ugual misura all’ottenimento del risultato finale. Nello specifico, nel caso

della cluster analysis generalmente un’adeguata trasformazione delle informazioni è necessaria

a garantire che tutti i caratteri contribuiscano in ugual misura alla classificazione dato che è

stato più volte notato come differenze di scaling possano di fatto influire pesantemente sulle

soluzioni di una procedura di clustering. Questa operazione si rende quindi necessaria almeno

quando si è al cospetto di (i) caratteri uguali appartenenti a distribuzioni diverse, (ii) caratteri

diversi ma rilevati con la stessa unità di misura ancora (iii) caratteri diversi e rilevati con una

diversa unità di misura/ordine di grandezza.

Si fa notare che potrebbe anche trattarsi di caratteri derivanti dall’applicazione ai dati originali disponibili di una preliminare procedura di analisi delle componenti principali o di tipo fattoriale.

10 Si ricorda che uno spazio che non presenta direzioni preferenziali si dice isotropo.

9

VII. La cluster analysis

Per effettuare questo particolare trattamento dei dati si usano generalmente trasformazioni

algebriche della forma

x ′ = ax + b

[7.1]

che, possibili in uno spazio metrico, corrispondono a cambiare valore di riferimento.

I vari tipi di trasformazione differiscono per la scelta dei parametri a e b.

Per la trasformazione dei valori originali sono solitamente disponibili le seguenti alternative:

• i punteggi 𝑧, ossia la normale procedura di standardizzazione, che genera per ogni unità

k un punteggio standard

̅)

(xk − X

xk′ = zk =

s

[7.2]

con:

̅

X = media dei valori assunti dalla variabile per le varie unità e

𝑠 = deviazione standard dei valori assunti dalla variabile per le varie unità11.

• ampiezza massima di 1, ossia una procedura che divide il valore assunto dalla variabile

in corrispondenza di una specifica unità con il valore massimo del vettore dei valori empirici

registrati, ossia

xk

xk′ =

xMax

[7.3]

in modo tale che il valore massimo ottenibile nel nuovo vettore dei dati trasformati sia 112;

• media 1, ossia una procedura che trasforma i valori in modo che la loro media sia uguale

a 1. Per ottenere tale risultato, il valore assunto dalla variabile in corrispondenza di ogni specifica unità è diviso per la media dei valori assunti dalla variabile per le varie unità ovvero

xk

xk′ =

;

̅

X

[7.4]

• deviazione standard 1, ossia una procedura attraverso la quale il valore assunto dalla

variabile in corrispondenza di ogni specifica unità è diviso per la deviazione standard dei valori

assunti dalla variabile per le varie unità, ovvero

xk′ =

xk

;

s

[7.5]

• intervallo di valori da -1 ad 1, ossia una procedura che trasforma i valori in modo che

il loro intervallo di variazione sia compreso tra -1 ed 1. Per ottenere tale risultato, il valore

assunto dalla variabile in corrispondenza di ogni specifica unità viene diviso per l’intervallo di

variazione delle modalità empiriche registrate dalla variabile, ovvero

xk′ =

xk

;

(xMax − xmin )

11 Questo tipo di trasformazione è anche nota come normalizzazione rispetto a media e varianza ed è una delle trasformazioni più utilizzate. Una volta standardizzati i valori, è possibile dimostrare che la loro media sarà pari a zero, la loro deviazione

standard (scarto tipo e nuova unità di misura) ad 1 (come ovviamente la loro varianza) mentre la loro devianza a K.

Stante che in statistica con normalizzazione si intende essenzialmente il limitare l'escursione di un insieme di valori entro

un certo intervallo predefinito, la standardizzazione viene spesso definita anche doppia normalizzazione. Ogni dato infatti prima

è trasformato nel suo scarto dalla media della distribuzione (prima normalizzazione, che opera una traslazione della distribuzione, la cui forma rimane identica, da una posizione attorno alla media effettiva a quella attorno ad una media 0) e successivamente convertito dall’unità di misura o di conto della variabile originaria in unità del suo scarto-tipo s (seconda normalizzazione, che opera attraverso il miglior coefficiente sintetico). Si ricorre ad s perché al pari dello scarto dalla media è una grandezza lineare.

12 Si fa notare come tale trasformazione possa risultare non del tutto appropriata in presenza di valori negativi.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

[7.6]

• intervallo di valori da 0 ad 1, ossia una procedura che trasforma i valori in modo che il

loro intervallo di variazione sia compreso tra 0 e 1. Per ottenere tale risultato, si sottrae al valore

assunto dalla variabile in corrispondenza di ogni specifica unità il valore minimo del vettore

delle modalità empiriche registrate dalla variabile e dopo si divide il risultato per l’intervallo di

variazione delle modalità empiriche registrate dalla variabile, ovvero

xk′ =

xk − xmin 13

.

xMax − xmin

[7.7]

Per evitare distorsioni di classificazione è poi anche consigliabile tenere sotto controllo

l’eventuale legame esistente fra i caratteri selezionati in modo da limitare al minimo l’utilizzo

di informazione ripetuta che, oltre ad appesantire e rallentare inutilmente l’esecuzione degli

algoritmi, può anche condurre ad una classificazione delle unità nei vari gruppi in qualche maniera non completamente rispondente alla situazione reale.

A seconda della natura dei dati a disposizione, per valutare l’effettivo contributo informativo

dei singoli caratteri generalmente si procede: (i) per i caratteri di natura quantitativa, con l’analisi dei coefficienti di correlazione lineare di Bravais-Pearson e con ulteriori approfondimenti

per la collinearità – a esempio analisi degli indici di Tolleranza e di VIF14 - eventualmente

supportati da analisi fattoriali; (ii) per i caratteri di tipo qualitativo, con l’analisi della forza del

legame esistente tra essi, con la valutazione della correlazione tra ranghi del tipo Spearman e/o

e con la costruzione di coefficienti di cograduazione del tipo Gini e (iii) nel caso di caratteri

misti, con la costruzione di coefficienti di cograduazione del tipo Gini previa sostituzione dei

valori delle variabili con i rispettivi ranghi.

La finalità, come accennato, è sempre la stessa, ossia comprendere quali caratteri è ragionevole da subito considerare contemporaneamente in fase di individuazione dei gruppi, poiché in

grado di fornire delle informazioni effettivamente differenziate sul tema che guida la classificazione, e quali invece escludere dall’analisi, almeno momentaneamente, in quanto significativamente legati a quelli già prescelti. Per valutare l’effettiva possibilità di ottenere un raggruppamento più efficiente ed esplicativo rispetto a quello già raggiunto, nulla vieta - ma anzi è

consigliabile - di poter eventualmente utilizzare i caratteri inizialmente esclusi in un secondo

momento al posto di quelli ad essi fortemente legati prima utilizzati

In relazione alla scelta della misura di somiglianza15, i coefficienti di similarità, che sono

misure della relazione esistente fra due unità rispetto ad un insieme di n caratteri comuni ad

entrambe, possono essere calcolati in presenza di qualsiasi tipo di carattere mentre le misure di

distanza, che quantificano la lontananza tra due unità, possono essere determinate in presenza

di sole variabili metriche.

Per essere tale, una misura di distanza deve possedere le seguenti proprietà:

1) identità, dkk = 0, ossia la distanza di un’unità da sé stessa è nulla;

2) simmetria, dkh = dhk , ossia la distanza tra l’unità k − esima e la h − esima è pari alla

distanza tra l’unità h − esima e quella k − esima;

3) non negatività, dkh ≥ 0, ossia una distanza può essere nulla, ma mai negativa;

4) disuguaglianza triangolare, dkl + dlh ≥ dkh , ossia la somma della distanze tra l’unità

k − esima e l’unità l − esima e quella tra l’unità l − esima e l’unità h − esima è sempre maggiore o uguale alla distanza tra l’unità k − esima e la h − esima.

Esistono vari tipi di distanza (Hartigan, 1975) tra le quali ricordiamo come più utilizzate

- la distanza euclidea

13

Questo tipo di trasformazione è anche nota come normalizzazione tra il minimo ed il massimo.

E’ possibile trovare maggiori dettagli su questi indici per valutare il grado di collinearità nel Capitolo VIII.

15 Le misure di somiglianza si possono calcolare tra due unità statistiche, tra unità statistica ed un gruppo di unità e tra due

gruppi di unità statistiche.

14

VII. La cluster analysis

1⁄

2

n

2

deuclidea,kl = {∑ wi (xk,i − xl,i ) }

i=1

[7.8]

con k ed l che sono due unità, xk,i e xl,i coordinate dei due punti Pk e Pl nello spazio cartesiano sulle variabili Xi (i = 1,2, … , n) e wi peso attribuito alla variabile Xi 16. Essa corrisponde

al concetto geometrico di distanza nello spazio multidimensionale;

- il quadrato della distanza euclidea, qualora si voglia dare un peso progressivamente

maggiore agli oggetti che stanno oltre una certa distanza;

- la distanza assoluta (o city-block o rettilinea o distanza di Manhattan)

dcity block,kl = ∑ |xk,i − xl,i | wi

[7.9]

che è semplicemente la differenza media fra le dimensioni;

- la distanza di Chebychev

dChebychev,kl = max |xk,i − xl,i |

[7.10]

che può essere appropriata nei casi in cui si vogliano definire due oggetti come non somiglianti se sono diversi in ciascuna delle dimensioni;

- la distanza di Mahalanobis, ossia una forma quadratica del tipo

dMahalanobis,kl = (𝐗 k − 𝐗 l )′ 𝐖 −1 (𝐗 k − 𝐗 l )

[7.11]

dove 𝐗 k e 𝐗 l sono i vettori colonna di dimensione (n × 1) contenenti le osservazioni sugli

n caratteri relative agli individui k e l, la notazione “ ’ ” indica l’operazione di trasposizione e

𝐖 è la matrice di varianze-covarianze tra le variabili osservate. Sua caratteristica fondamentale

è il tener anche conto delle interdipendenze esistenti tra le n variabili utilizzate, ridimensionando il peso di quelle portatrici di informazioni eccedenti in quanto già fornite da altre17;

- la distanza di Minkowski,

n

1⁄

r

dMinkowski,kl = {∑ |xk,i − xl,i |r }

i=1

[7.12]

che per r = 2 diventa la distanza euclidea.

In relazione alle scelte previste al punto 5) nel 2004 Romesburg (Romesburg, 2004) sostenne

che le procedure di cluster analysis sono generalmente suddivisibili nelle seguenti grandi categorie18:

- metodi gerarchici, applicabili a dati di qualsiasi tipo. Essi realizzano fusioni o divisioni

successive del data set iniziale. Si tratta di procedimenti che generano un insieme di

partizioni ordinate gerarchicamente, ovvero nelle quali ogni cluster ad un qualunque livello appartiene ad un gruppo più ampio ad un livello successivo-precedente (a seconda

se realizzano fusioni o divisioni) che a sua volta appartiene ad un cluster ancora più

ampio ad un livello di aggregazione superiore-inferiore. Se si è optato per una procedura

16 Si noti che quando le variabili originarie sono correlate tra loro, è improprio utilizzare la distanza euclidea, mentre è

pertinente l'uso della statistica proposta da Mahalanobis descritta in quanto segue.

17 In ogni caso, occorre fare attenzione nell'uso di questa distanza. Se infatti sussiste collinearità tra le variabili, la matrice

𝐖 non è invertibile. Se, pur non essendovi collinearità, è presente una forte correlazione, errori di misura o di calcolo possono

condurre a pesanti distorsioni nei risultati.

18 Sulle prime due categorie forniremo maggiori dettagli nelle sezioni che seguono.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

di tipo agglomerativo che procede per fusioni successive, partendo da K unità si originano quindi delle partizioni ordinate gerarchicamente, visibili peraltro su una struttura

ad albero, con un numero di gruppi da K ad 1. Se si è invece optato per una procedura di

tipo divisivo che procede, appunto, per divisioni successive, partendo da un unico gruppo

contenete tutti i K elementi si giunge progressivamente a K gruppi ognuno contenente un

elemento distinto;

- metodi non gerarchici (anche detti algoritmi di partizionamento o metodi a partizioni

ripetute o per suddivisioni iterative), applicabili esclusivamente a dati di tipo quantitativo. Si tratta di procedimenti che forniscono un’unica partizione finale delle K unità in

G gruppi, con il numero G che deve essere specificato a priori19;

- metodi density-based che, basandosi su connettività e funzioni di densità, fanno aumentare i cluster finché la densità di punti nel vicinato non supera un prefissato limite20;

- metodi grid-based, basati su una struttura a livelli multipli di granularità che forma una

griglia sulla quale vengono eseguite tutte le operazioni21;

- metodi model-based, che ipotizzano un modello per ogni cluster cercando il suo miglior

adattamento con ciascun altro.

In realtà è possibile individuare dei punti di contatto tra le varie procedure di clustering

appena menzionate. Caratteristiche comuni sono infatti almeno la grande mole di elaborazioni,

con conseguente necessità di ricorrere ad un elaboratore elettronico, e l’elevato grado di soggettività nella scelta degli algoritmi da utilizzare.

In quanto segue si analizzeranno con maggiori dettagli esclusivamente le peculiarità dei metodi gerarchici e dei metodi non gerarchici dato che si tratta di quelli al momento ancora più

utilizzati. È peraltro possibile procedere ad una loro implementazione con i più noti software

statistici.

In realtà, i criteri di scelta fra le procedure di tipo gerarchico e non gerarchico non sono stati

ancora ad oggi sufficientemente esplorati. In merito alla necessità di definizione di una regola

finalizzata all’individuazione della procedura di raggruppamento di volta in volta più adatta, in

letteratura vi sono addirittura posizioni molto diversificate. Alcuni autori sostengono che il problema di fatto non sussista poiché molto spesso strategie di raggruppamento diverse conducono

a risultati non dissimili (Rand, 1971, Ohsumi, 1980), mentre altri evidenziano casi concreti di

forti divergenze (Everitt, 1979, Fabbris, 1983).

Nella pratica la ricerca si concentra sulla classe di metodi che si dimostrano più insensibili a

piccole variazioni nei dati analizzati22.

Per grandi linee sembrerebbe possibile asserire che quando si cercano gruppi di unità statistiche caratterizzate da alta omogeneità interna, intesa come forza dei legami tra entità appartenenti ad uno stesso gruppo, le procedure gerarchiche apparirebbero meno efficaci di quelle non

gerarchiche che nel parere di molti fornirebbero peraltro al ricercatore anche una maggiore

flessibilità rispetto alle prime (Andemberg, 1973, Matthews, 1979). Come accennato, però, bisogna ricordare che i metodi non gerarchici non sono sempre applicabili in quanto utilizzabili

solo per caratteri quantitativi.

Per quanto attiene l’identificazione-fissazione del numero dei gruppi in cui suddividere le K

unità, rimandando per maggiori dettagli a quanto diremo nelle successive specifiche sezioni

sulle procedere di cluster analysis di tipo gerarchico e non gerarchico, per il momento si accenna solo al fatto che nel primo caso la valutazione della partizione ottenuta e l’identificazione

In realtà è possibile trovare in letteratura anche procedure di clustering di tipo misto che si caratterizzano per l’utilizzo

di passi di tecniche gerarchiche e non gerarchiche.

20 Tali metodi sono in grado di trovare cluster di forma arbitraria.

21 E’ stato notato che le prestazioni di tali metodi dipendono esclusivamente dal numero di celle della griglia.

22 Ad esempio, si ritiene importante per un metodo di cluster gerarchica se, sottraendo un individuo dall'analisi, l'albero o

i gruppi formati cambiano poco o, preferibilmente, per niente oppure se, ripetendo l'analisi senza un’intera diramazione del

dendrogramma, la struttura degli altri rami resta praticamente invariata. Jardine e Sibson (Jardine et. al., 1971) parlano a questo

proposito di condizioni di unitarietà (fitting togheter).

19

VII. La cluster analysis

del numero ottimale di gruppi avviene facendo dei confronti delle varie partizioni individuate

mediante appropriati indicatori, grafici23 e tabelle, mentre nel secondo il numero dei gruppi,

come già accennato, deve essere fissato a priori.

In merito alla valutazione della procedura di clustering, Silvestri e Hill (Silvestri et al., 1964)

propongono di condurre l’analisi in base ai criteri di (i) oggettività, (ii) stabilità dei risultati e

della classificazione operando su dati equivalenti 24 e (iii) capacità predittiva delle variabili su

un nuovo insieme di dati.

In virtù del primo criterio, ricercatori che lavorano indipendentemente sullo stesso insieme

di dati devono ovviamente giungere ai medesimi risultati, invece al fine di verificare la stabilità

di una specifica soluzione ottenuta, indipendentemente dalla procedura e dall’algoritmo di clustering adottato, è assolutamente consigliabile procedere più volte all’aggregazione utilizzando

dati disposti in ordini casuali diversi al fine di verificare appunto se la soluzione trovata è sempre la stessa.

Nelle due sezioni che seguono si forniranno maggiori dettagli, nell’ordine, sui metodi di

clustering gerarchici e non gerarchici

7.3. I metodi gerarchici

È già stato detto che i metodi gerarchici di cluster analysis sono applicabili a dati di qualsiasi

tipo.

In questo ambito, le fasi fondamentali di una cluster analysis possono essere così sintetizzate:

1) selezione dei K elementi appartenenti al collettivo di riferimento;

2) scelta degli n caratteri in base ai quali operare la classificazione;

3) prae-trattamento dei dati relativi ai caratteri;

4) scelta della misura di somiglianza da usare nell’implementazione e successiva costruzione di una matrice di somiglianza;

5) scelta tra un approccio agglomerativo o divisivo e quindi dell’algoritmo (metodo) di raggruppamento degli elementi osservati;

6) identificazione del numero dei gruppi entro i quali ripartire le unità statistiche;

7) analisi critica, valutazione ed interpretazione dei risultati ottenuti con conseguente connotazione tipologica dei gruppi.

Come già anticipato, quando si effettua una classificazione di tipo gerarchico (Johnson,

1967, Everitt 1979) si genera un insieme di partizioni ordinate gerarchicamente nelle quali ogni

gruppo ad un qualunque livello appartiene ad un cluster più ampio ad un livello successivoprecedente (a seconda se le procedure realizzano fusioni o divisioni) che a sua volta appartiene

ad un gruppo ancora più ampio ad un livello di aggregazione superiore-inferiore.

Se si è optato per una procedura di tipo agglomerativo, che procede per fusioni successive

dei grappoli meno distanti tra loro, il punto di partenza (input) della classificazione sono quindi

K gruppi composti da una singola unità mentre il punto di arrivo è costituito da un certo numero

di partizioni in gruppi di dimensione crescente ordinate gerarchicamente, con un numero di

gruppi che quindi scende da K ad 1 (strategia bottom-up). Se si è invece optato per una procedura di tipo divisivo che procede, appunto, per divisioni successive, il punto di partenza (input)

della classificazione è un unico gruppo contenete tutti i K elementi, suddividendo opportunamente i quali, in modo da diminuire gradualmente la dimensione dei cluster aumentandone il

23 Per quanto attiene i grafici, come vedremo nello specifico, si tratta del dendrogramma o di uno screen plot in cui viene

posto in ordinata il numero di gruppi ed in ascissa la distanza di fusione.

24 Sebbene non sia proprio la stessa cosa, Jones e Needham (Jones et al., 1968) assimilano a questo criterio la proprietà di

robustezza nei confronti della presenza di errori nei dati.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

numero, si giunge progressivamente a K gruppi ognuno contenente un elemento distinto (strategia top-down).

È quindi chiaro che una prima suddivisione delle procedure di clustering gerarchico risulta

essere tra metodi agglomerativi e divisivi.

Caratteristica principale degli algoritmi gerarchici è comunque che le fusioni o divisioni

sono irrevocabili.

Per dettagliare maggiormente l’iter entro il quale si sviluppa una cluster analysis di tipo

gerarchico ci riferiremo da adesso in poi ad una procedura di tipo agglomerativo, potendo in

ogni caso ricavare per analogia cosa accade in presenza di una procedura di tipo divisivo in

virtù della conoscenza della sua peculiarità di partire da un solo gruppo per arrivare fino a K

gruppi distinti e quindi, in tale ottica, di operare in senso inverso rispetto ad una procedura

agglomerativa.

La scelta di riferirsi ad una procedura di questo tipo è stata peraltro motivata dal fatto che

essa è presente nella generalità dei software statistici con i quali è possibile performare delle

cluster analysis, mentre invece gli stessi sono più raramente dotati di algoritmi divisivi anche a

causa delle loro particolari esigenze di natura computazionale25.

In estrema sintesi si può dire che in una cluster analysis di tipo gerarchico di natura agglomerativa (i) si parte dalla matrice K × n (unità per variabili) e si costruisce una matrice di somiglianza tra le K unità; (ii) a seconda dell’algoritmo di raggruppamento prescelto, si aggregano

tra loro le due unità con somiglianza maggiore, ricalcolando dopo una nuova matrice di somiglianza, e procedendo successivamente ad una nuova aggregazione. Questo passaggio viene

eseguito fino ad avere un unico gruppo; (iii) il numero ottimale di gruppi è scelto dal ricercatore

solo alla fine del processo.

Si ribadisce quindi ancora una volta che il prodotto finale dei metodi gerarchici agglomerativi (o divisivi) non è un singolo raggruppamento in un certo numero di cluster delle K unità,

ma una serie di raggruppamenti in un numero variabile di classi. Le varie partizioni possono

essere rappresentate attraverso un grafico ad albero chiamato dendrogramma (costruibile ovviamente anche per una procedura di clustering di tipo divisivo) nel quale generalmente

sull'asse delle ordinate vengono riportate le singole unità, mentre sull'asse delle ascisse viene

riportato il livello di distanza di fusione (divisione, nel caso di una procedura di clustering di

tipo divisivo) verificatosi ad ogni stadio dell’analisi26.

Figura 7.1. Esempio di dendrogramma di una procedura di cluster analysis gerarchica di tipo

agglomerativo.

Fonte: nostre elaborazioni.

In Figura 7.1. si riporta l’immagine di un dendrogramma fornito per una procedura di cluster

analysis gerarchica di tipo agglomerativo da un noto software statistico. Ogni suo ramo (linea

25

Tali algoritmi sono particolarmente esigenti da un punto di vista computazionale soprattutto se per ogni cluster, composto

da t ≤ K oggetti, si considerano a ogni stadio tutte le possibili 2 (𝑡−1) − 1 suddivisioni in sottogruppi.

26 Con maggiori dettagli, un dendrogramma, diagramma ad albero proprio dei una cluster analysis di tipo gerarchico che

fornisce un’immagine delle relazioni specificate fra gli oggetti che vengono raggruppati (casi o caratteri) facendo riferimento

ad una scala di distanza, in relazione ad una procedura di tipo agglomerativo si costruisce partendo dai rami corrispondenti ai

casi iniziali, ognuno dei quali rappresenta un gruppo distinto, sino ad arrivare, per fusioni successive, ad un unico ramo finale

(radice) che rappresenta appunto lo stadio finale in cui tutti i casi sono racchiusi nello stesso gruppo. Le fusioni sono rappresentate dai punti in cui due rami si uniscono.

VII. La cluster analysis

verticale) corrisponde ad un gruppo, mentre la linea di congiunzione (orizzontale) di due o più

rami individua il livello di distanza al quale i vari cluster si fondono.

Per quanto attiene la misura di somiglianza tra le K unità, i più noti software statistici in

grado di effettuare cluster analysis con approccio agglomerativo generalmente propongono27

(i) per i dati di intervallo, la distanza euclidea semplice, euclidea quadratica, city block, di Chebycev e di Minkowski, nonché la similarità calcolata sul coseno e la similarità calcolata sul

coefficiente di correlazione di Pearson, (ii) per i dati di conteggio, la misura del chi quadrato e

del phi quadrato e (iii) per i dati di tipo binario, la distanza euclidea semplice e quadratica

nonché la differenza di dimensione (anche detta distanza di dimensione o size), la distanza di

pattern, la differenza di modello, la varianza, la dispersione, la forma, la corrispondenza semplice, la correlazione phi a quattro punti, il lambda, la D di Anderberg, il coefficiente di Dice,

il coefficiente di Hamann, il coefficiente di Jaccard, le due misure di Kulczynski, la distanza di

Lance e Williams, l’indice di Ochiai e quelli di Rogers e Tanimoto, Russel e Rao, Sokal e

Sneath, nonché la Y e la Q di Yule.

La misura di somiglianza servirà a quantificare le differenze tra i vari elementi che si vogliono raggruppare e quindi per costruire una matrice di somiglianza che verrà sottoposta ad

analisi. Sostanzialmente, i metodi gerarchici di tipo agglomerativo si distinguono al loro interno

per il diverso criterio che regola la fusione successiva. I più noti algoritmi gerarchici proposti

in letteratura sono il

a) metodo del legame singolo (single-linkage), detto anche del vicino più prossimo o del

vicino più vicino (nearest neighbor). In questo caso la distanza tra i gruppi è posta pari

alla più piccola delle distanze costruibili, a due a due, tra tutti gli elementi dei due

gruppi. Con parole più semplici, la distanza tra due gruppi è uguale alla distanza tra gli

elementi dei due gruppi che sono più vicini. Secondo questo metodo quindi, se C e D

sono due gruppi, la loro distanza è definita come la più piccola (il minimo) tra tutte le

distanze che si possono calcolare tra ciascuna unità k di C e l di D, ossia d(C, D) =

min(dkl ), ∀k ∈ C, ∀l ∈ D. Rispetto ad altri algoritmi, l'adozione di questo metodo per la

composizione dei gruppi evidenzia in maniera netta e decisamente più accentuata tutte

le somiglianze tra gli elementi e privilegia la differenza tra i gruppi piuttosto che l'omogeneità degli elementi di ogni gruppo. Come conseguenza della valorizzazione delle

somiglianze, il dendrogramma che rappresenta le varie partizioni associato a questo algoritmo è più compatto e mostra rami molto più corti di quelli ottenuti con altri metodi

di aggregazione;

b) metodo del legame completo (complete-linkage), detto anche del vicino più lontano (furthest neighbor). Secondo questo metodo si considera la maggiore delle distanze costruibili, a due a due, tra tutti gli elementi di due gruppi. Con parole più semplici, la distanza

tra due gruppi è uguale alla distanza tra gli elementi dei due gruppi che sono più lontani

ed avremo quindi che d(C, D) = max(dkl ), ∀k ∈ C, ∀l ∈ D. Evidentemente, si uniscono

i due gruppi che presentano la più piccola distanza così definita. Questo algoritmo di

aggregazione evidenzia in maniera netta le differenze tra elementi e, al contrario del

precedente, privilegia l'omogeneità tra gli elementi del gruppo a discapito della differenziazione netta tra i gruppi. Come conseguenza, il dendrogramma che rappresenta le

varie partizioni associato a questo algoritmo ha i rami molto più lunghi dato che i gruppi

si formano a distanze maggiori e dunque, in uno stesso range di valori, rispetto al metodo del legame singolo gli elementi sono molto meno compatti e più diluiti;

c) metodo del legame medio (average-linkage). Si tratta del valore medio aritmetico delle

distanze tra gli elementi di due gruppi. Nell’ambito di questo metodo possiamo riconoscere due varianti che fondamentalmente differiscono per il considerare esclusivamente

le distanze tra gli elementi che appartengono a gruppi diversi o, unitamente a queste,

27

A tal proposito si confronti ad esempio quanto proposto dal noto SPSS.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

anche quelle tra elementi dello stesso gruppo. Con maggiori dettagli distinguiamo

quindi il

- metodo del legame medio fra i gruppi (bavarage), in base al quale la distanza tra due

gruppi è uguale alla media delle distanze tra ogni coppia di elementi appartenenti a

1

n1

2

∑nl=1

gruppi differenti, ossia d(C, D) = n × n ∑k=1

dkl , ∀k ∈ C, ∀l ∈ D28, ed il

1

2

- metodo del legame medio entro gruppi (wavarage), in base al quale la distanza tra

due gruppi è uguale alla media delle distanze di ogni coppia di elementi che possono

appartenere anche allo stesso gruppo.

In entrambi i casi si uniscono i due gruppi che presentano la più piccola distanza media.

L'adozione di questo algoritmo per la composizione dei gruppi semplifica notevolmente

la struttura dell'albero costruito con l'algoritmo completo. Essendo basato sulla media

delle distanze, i risultati di questo metodo sembrerebbero per molti ricercatori più attendibili ed i gruppi risultanti più omogenei e ben differenziati tra loro di quelli ottenibili

con altri algoritmi di aggregazione;

d) metodo del centroide in base al quale la distanza tra due gruppi è pari a quella tra i

centroidi dei gruppi (cioè i baricentri, ossia le medie delle coordinate di tutti i casi che

ne fanno parte). A tal fine si procede determinando i vettori contenenti i valori medi

degli n caratteri in tutti i gruppi (centroidi) e quindi la distanza tra i gruppi viene assunta

̅C e X

̅ D sono i centroidi avremo che

pari a quella tra i rispettivi centroidi. Se quindi X

̅

̅

d(C, D) = d(XC , XD ). Si uniscono i due gruppi che presentano la più piccola distanza

tra i centroidi;

e) metodo della mediana in base al quale la distanza tra due gruppi è uguale alla distanza

tra i vettori dei valori mediani dei gruppi. Si uniscono i due gruppi che presentano la più

piccola distanza tra i vettori dei valori mediani;

f) metodo di Ward. Questo metodo, differendo in parte dai precedenti, suggerisce di riunire,

ad ogni tappa del processo, i due gruppi dalla cui fusione deriva il minimo incremento

possibile della devianza (e quindi varianza) interna al gruppo. Con altre parole, l’obiettivo di questo algoritmo è quello di minimizzare l’inevitabile incremento della varianza

interna al gruppo (within) che si origina ad ogni successiva fusione e pertanto la distanza

tra due gruppi è una funzione delle devianze tra i due gruppi.

Con maggiori dettagli, partiamo dalla devianza totale

K

n

̅ i )2

DEVTOT = ∑ ∑(xk,i − X

k=1 i=1

[7.13]

̅ i è la media della variabile i − esima con riferimento all’intero collettivo. Data

dove X

una partizione in G gruppi, tale devianza può essere scomposta in una devianza entro i

gruppi

G

ng

n

̅ ig )2 ,

DEVWITHIN = ∑ ∑ ∑(xk,i − X

g=1 k=1 i=1

[7.14]

̅

riferita alle n variabili ed al gruppo g di numerosità ng dove Xig è la media della

variabile i − esima, ed in una devianza tra i gruppi

28 Se ad esempio il gruppo C è formato dagli elementi 1 e 2 ed il gruppo D dagli elementi 3 e 4, la distanza tra C e D si

otterrà come media delle distanze tra 1 e 3, 1 e 4, 2 e 3 e 2 e 4.

VII. La cluster analysis

G

n

2

̅ ig − ̅

DEVBETWEEN = ∑ ∑(X

X i ) ng .

g=1 i=1

[7.15]

Nel passare da (G + 1) a G gruppi (aggregazione) la DEVWITHIN aumenta mentre, essendo DEVTOT = DEVWITHIN + DEVBETWEEN, ovviamente la DEVBETWEEN diminuisce. Con il metodo di Ward ad ogni passo si aggregano quindi tra loro quei gruppi per i

quali vi è il minor incremento della devianza entro i gruppi.

Si fa notare che alcuni metodi, come quelli di legame, possono essere utilizzati indipendentemente dal livello di misurazione dei caratteri mentre altri, come il metodo di Ward e quello

del centroide, possono essere applicati solo a caratteri misurati per lo meno al livello degli intervalli equivalenti. Inoltre, qualora si presentassero le circostanze per una sua applicazione, il

metodo di Ward sembrerebbe particolarmente efficace nella classificazione di caratteri che risultano misurati a livelli più elevati (Barbaranelli, 2006).

La valutazione dei risultati ottenuti con un metodo di tipo gerarchico avviene solo dopo aver

identificato il numero ottimale di gruppi da mantenere. In sostanza ciò accade facendo alcuni

confronti che possono ricorrere a numerosi veri e propri indicatori e/o ad un’ispezione visiva di

grafici e tabelle. Si tratta di una delle fasi più importanti ed al contempo delicate di una cluster

analysis di tipo gerarchico dato che, pur essendo state proposte diverse soluzioni al problema,

ancora oggi non esiste un criterio univoco, e quindi preferibile, per dire quale sia la partizione

migliore.

Tra gli indici proposti per identificare il più correttamente possibile il numero ottimale di

gruppi da mantenere ricordiamo l’indice C, l’indice gamma, la correlazione punto-biseriale,

l’indice G+, la somma degli errori within cluster e la statistica C, non sempre calcolabili attraverso i più noti software statistici e difficili da riprodurre a mano.

Per quanto attiene invece l’ispezione visiva di grafici, che in ogni caso richiede una certa

perizia, si sostanzia fondamentalmente nell’analisi del comportamento della distanza di fusione

e può essere condotta analizzando il dendrogramma e/o il plot delle distanze di fusione.

La distanza di fusione, in termini di distanza riscalata, può infatti essere facilmente evinta

dall'osservazione del dendrogramma. Se nel passaggio da (G + 1) gruppi a G (nel caso di una

procedura di clustering di tipo agglomerativo) si registra un forte incremento della distanza di

fusione è consigliabile fermarsi alla considerazione di (G + 1) gruppi. Il numero più appropriato di cluster si ricava quindi sezionando l’albero all’altezza del massimo salto tra livelli di

distanza ai quali sono avvenute le fusioni in modo da ottenere il minor numero di gruppi con

omogeneità interna massima, ovvero composti da elementi somiglianti (Barbaranelli, 2006).

Sempre utilizzando la distanza di fusione si possono utilizzare degli screen plot, ossia dei

grafici in cui viene posto in ordinata il numero di gruppi ed in ascissa la distanza di fusione.

Si consideri ad esempio lo screen plot in Figura 7.2.

La produttività delle banche. Questioni di metodo, misure ed applicazioni

Figura 7.2. Lo screen plot delle distanze di fusione

Fonte: nostre elaborazioni.

In questo caso il grafico sembrerebbe suggere di mantenere la suddivisione in 4 gruppi. Infatti, nel passaggio a 3 gruppi si registra un consistente incremento della distanza di fusione.

Per valutare più oggettivamente l'entità dell'incremento della distanza di fusione δ si può

anche ricorrere all'incremento relativo ΔG della distanza di fusione che per una procedura di

clustering di tipo agglomerativo è dato da

(δG − δG+1 )

ΔG =

.

δG+1

[7.16]

Verrà scelto il valore di G in corrispondenza del quale ΔG è massimo.

In generale questi metodi di scelta del numero di gruppi si basano comunque sull’osservazione

dei dati per ricercare una loro discontinuità e questo può risultare una procedura azzardata in

quanto molto soggettiva. Sono stati comunque proposti vari test tra i quali ricordiamo il cosiddetto ‘pseudo-F’

DEVBETWEEN

(G − 1)

FG =

.

DEVWITHIN

(K − G)

[7.17]

Un’ispezione visiva di tabelle, a nostro parere veramente poco agevole, può ad esempio essere effettuata analizzando quelle contenenti i cosiddetti programmi di agglomerazione fornite

da alcuni software. Una tabella di questo tipo consente di ripercorrere l’intero processo di fusione tra i vari gruppi dal punto di origine (in cui per una procedura di tipo agglomerativo ogni

elemento rappresentava un distinto cluster) sino al punto di arrivo (in cui per una procedura di

tipo agglomerativo tutti gli elementi appartengono ad un unico gruppo). Essa generalmente

mostra in dettaglio le aggregazioni tra i diversi oggetti nella gerarchia delle partizioni, specificando (i) quali gruppi si aggregano ad ogni stadio, (ii) qual è il valore del coefficiente di agglomerazione (o di fusione) in quello stadio, (iii) qual è lo stadio in cui i due gruppi che in un certo

momento si uniscono erano stati generati e (iv) qual è lo stadio successivo in cui un gruppo

appena composto si fonderà con un altro cluster.

L'applicazione di metodi gerarchici, come tutte le tecniche statistiche, reca con sé limiti e

vantaggi.

I metodi gerarchici presuppongono indirettamente una regola classificatoria sottostante più

o meno rispettata dalle unità, nella quale esse rientrano progressivamente. Ovviamente, se nel

VII. La cluster analysis

contesto d’indagine una tale regola non può essere ipotizzata, l'adozione di metodi gerarchici è

abbastanza limitata in quanto può generare gruppi caratterizzati da errate tipologie.

Gli algoritmi gerarchici di base sembrerebbe mostrare inoltre una tendenza a non rispettare

molti dei requisiti generalmente richiesti dai ricercatori quali la scalabilità29, l’individuazione

di cluster con forma arbitraria, la necessità di minima conoscenza del dominio per determinare

i parametri di input, la robustezza rispetto al rumore ed agli outlier, l'insensibilità all'ordine dei

record in input, la capacità di operare su dati ad alta dimensionalità, l'incorporazione di vincoli

specificati dall'utente e l'interpretabilità ed usabilità dei risultati.

La necessità di ovviare ai limiti degli algoritmi gerarchici tradizionali ha quindi condotto i

ricercatori alla definizione di nuovi metodi per la classificazione che prendono il nome di metodi gerarchici multifase. Tra di essi è molto noto il cosiddetto BIRCH (Balanced Iterative

Reducing and Clustering using Hierarchies)30.

Vantaggi dei metodi gerarchici sono invece indubbiamente legati all’ampia gamma di caratteri che si possono utilizzare ai fini della classificazione delle unità ed al fatto che consentono

di studiare il processo che porta diversi profili ad assimilarsi tra loro.

Data la natura fortemente esplorativa di una cluster analysis di tipo gerarchico si consiglia

in ogni caso di considerare i risultati ottenuti come provvisori fino a quando non vengano confermati da un campione indipendente di osservazioni.

7.4. I metodi non gerarchici

Come già accennato, le procedure di cluster analysis non gerarchica, dette anche procedure

a partizioni ripetute o per suddivisioni iterative, sono riservate a dati di tipo quantitativo (a

livello di intervallo o di rapporto).

Contestualizzando quanto detto in precedenza sulle fasi fondamentali di una cluster analysis,

in questo specifico ambito esse possono essere così sintetizzate:

1) selezione dei K elementi appartenenti al collettivo di riferimento;

2) scelta degli n caratteri in base ai quali operare la classificazione;

3) prae-trattamento dei dati relativi ai caratteri;

4) fissazione del numero dei gruppi ed individuazione dei semi della partizione, ossia dei

casi che costituiscono inizialmente i gruppi rendendo così possibile l’avvio del processo

iterativo di classificazione;

5) scelta dell’algoritmo (metodo) di raggruppamento delle unità statistiche osservate;

29

Con questo termine generalmente si intende la capacità di un sistema di aumentare o diminuire di scala in funzione delle

necessità e delle disponibilità.

30 Si tratta di un metodo di clustering gerarchico integrato e può essere considerato come base di partenza per lo sviluppo

di altri algoritmi del suo genere. In estrema sintesi, il metodo BIRCH introduce due nuovi concetti detti Clustering Feature

(CF) e Clustering Feature Tree (CF-Tree) per comprimere la rappresentazione dei cluster utilizzando strutture dati di riepilogo.

Il primo è una tripla che contiene informazione relativa a sub-cluster. In essa sono registrate in forma compatta misurazioni

fondamentali per il calcolo dei cluster. Il CF-Tree è invece un albero che contiene le Clustering Feature per il clustering

gerarchico. Nei nodi non-foglia sono memorizzate le somme delle CF dei loro nodi figli.

L'algoritmo costruisce in maniera incrementale un CF-Tree per l'esecuzione di clustering multifase e consta dei seguenti

passi:

i dati vengono caricati in memoria e si costruisce un CF-Tree;

i dati vengono condensati in modo ottimale e si costruisce un CFTree più piccolo;

un algoritmo aggregativo viene applicato ai sotto-cluster rappresentati dai vettori CF nelle foglie dell'albero;

si avviano due distinte sotto-fasi nelle quali, rispettivamente, i cluster vengono raffinati mediante redistribuzione dei

dati rispetto ai centroidi dei cluster trovati nella terza fase ed etichettati.

L'algoritmo BIRCH si rivela efficace nel caso di grandi database (numero di unità superiore a 100.000). Il suo costo computazionale è proporzionale alla dimensione del database stesso e con una singola scansione dei dati è già in grado di fornire

un clustering di buona qualità. Esso inoltre consente di rispettare i vincoli sulla quantità di memoria disponibile, minimizzare

i tempi di I/O e regolare la performance basandosi dinamicamente e interattivamente sulla conoscenza del database (Quaranta,

2008).

La produttività delle banche. Questioni di metodo, misure ed applicazioni

6) analisi critica, valutazione ed interpretazione dei risultati ottenuti con conseguente connotazione tipologica dei gruppi.

In estrema sintesi si può dire che si parte da una matrice di dati di dimensione K × n, si

stabilisce subito il numero G dei gruppi nei quali si vogliono suddividere le K unità ottenendo

quindi come risultato una sola partizione degli elementi (Andemberg, 1973).

Fissato il numero G dei gruppi in cui si vuole ripartire il collettivo di partenza, l’appartenenza

dei casi ad ognuno di essi in questo contesto è ottenuta attraverso un percorso che si articola

sostanzialmente in due fasi, ossia (i) la determinazione di una partizione iniziale dei K individui

in 𝐺 gruppi e (ii) lo spostamento successivo delle unità tra i G gruppi in modo da ottenere la

partizione che meglio risponde ai concetti di omogeneità interna ai cluster e di eterogeneità tra

gli stessi.

L'individuazione della suddivisione ottimale comporterebbe a rigore l'esame di tutte le possibili assegnazioni distinte dei K individui ai G gruppi, ma poiché un'operazione di questo genere determinerebbe una grande mole di calcoli, le procedure non gerarchiche propongono di

risolvere il problema attraverso una strategia di raggruppamento che richiede la valutazione

solo di un numero accettabile di possibili suddivisioni alternative. In pratica, una volta stabilita

la suddivisione iniziale, si procede a riallocare le unità in esame tra i diversi gruppi in modo da

ottimizzare una prefissata funzione obiettivo (criterio predefinito). A differenza dei metodi gerarchici quindi l'assegnazione di un oggetto ad un cluster non è irrevocabile, ovvero le unità

vengono riassegnate ad un diverso cluster qualora l'allocazione iniziale risultasse inappropriata.

Algoritmi di tipo non gerarchico, come quelli di McQueen (detto anche delle k-medie) e di

Forgy, ad esempio procedono, data una prima suddivisione, a riallocare le unità al gruppo con

centroide più vicino fino a quando per nessun elemento si verifica che sia minima la distanza

rispetto al centroide di un gruppo diverso da quello a cui esso appartiene (Sadocchi, 2004). Una

tale procedura minimizza implicitamente la devianza entro i gruppi (within) relativamente alle

n variabili.

Si fa notare che gli algoritmi non gerarchici necessitano di iterazioni il cui numero esatto

non è in realtà conosciuto a priori. Per cautelarsi da tale inconveniente molti algoritmi utilizzano

prevalentemente due criteri di convergenza. Il primo aggiorna la struttura iniziale dei dati ad

ogni iterazione fino alla convergenza ad una struttura stabile, mentre il secondo fa comunque

terminare l'algoritmo dopo un numero predeterminato di iterazioni. In ogni caso tutti i metodi

partitivi convergono in un numero solitamente non molto elevato di iterazioni ed in generale

questo ovviamente accade tanto più velocemente quanto più la struttura iniziale si avvicina alla

reale struttura classificatoria.

I più noti algoritmi non gerarchici proposti in letteratura sono:

a) il metodo k-medie, detto anche tecnica di aggregazione intorno a centri mobili. È probabilmente l’algoritmo di tipo non gerarchico più utilizzato. Esso considera dei centroidi

(vettori contenenti le medie dei valori di tutte le variabili considerate in relazione ai casi

che appartengono al gruppo) ed effettua tutti gli spostamenti necessari dei casi in modo

da minimizzare la distanza euclidea semplice dei vari elementi dai centroidi. L’impiego

di questo tipo di distanza è motivata dalla circostanza che riesce a garantire la convergenza della procedura iterativa. Questo algoritmo è in grado di gestire un numero di

elementi molto elevato ed è efficace principalmente perché non calcola le distanze tra

tutte le coppie di casi, a differenza di molti altri algoritmi di raggruppamento. È possibile

riassumere come segue la struttura semplificata di questo algoritmo:

- Inizializzazione: dopo aver scelto in modo ragionato la partizione che si vuole

ottenere, si assumono come centri provvisori i primi G individui, i quali inducono una

prima partizione iniziale in G gruppi delle unità. Per ogni classe della partizione del

passo corrente si calcola un’opportuna rappresentazione che ha lo scopo di precisare

un modello di gruppo per la classe. Nei casi usuali, una rappresentazione di una classe

VII. La cluster analysis

è semplicemente il vettore delle medie della classe. Si calcola inoltre un criterio che

misura la bontà del raggruppamento;

- Primo passo: ottenute G rappresentazioni delle classi, esse vengono ricalcolate

sulla base della minima distanza di un individuo da uno di questi centri;

- Secondo passo: si assumono i baricentri appena calcolati come nuovi centri provvisori. Si ripete il procedimento di allocazione delle unità ai gruppi sulla base della

minima distanza. Si calcolano i nuovi baricentri delle classi (elementi medi);

- Passi successivi: ad ogni iterazione successiva si cancella la partizione ottenuta

in precedenza e si reitera il processo di aggregazione, assumendo come nuovi centri

provvisori i baricentri del passo precedente;

- Stop: si ripete il processo, fino a che ricalcolando la partizione al primo passo

non si hanno più spostamenti di unità da un gruppo ad un altro.

Si può dimostrare che tale algoritmo converge, ossia ad ogni passo fa decrescere il

criterio della devianza entro i gruppi (within). Essendo la devianza entro i gruppi

uguale alla devianza totale delle unità meno la devianza tra gruppi (between), minimizzare la devianza entro i gruppi equivale a massimizzare la devianza tra gruppi ossia

a rendere massima la separazione dei gruppi. A convergenza ottenuta, l'algoritmo si

arresta a un punto di minimo, detto minimo locale.

Si noti che l’algoritmo può portare a soluzioni diverse a seconda della partizione iniziale scelta.

Una limitazione del metodo k-medie consiste nel fatto che per la sua applicazione è

necessario definire la media per gli oggetti da classificare. Ciò comporta inevitabilmente una certa sensibilità al rumore e anche agli outlier in quanto anche un piccolo

numero di essi può influenzare notevolmente il valor medio. È poi stato fatto notare

come la classificazione finale operata da un metodo k-medie possa essere influenzata

dalla scelta dei centri iniziali. L'applicazione di questo metodo presuppone infatti l'individuazione a priori di una suddivisione iniziale ed è evidente come la soluzione trovata potrebbe risultare in qualche misura subordinata a tale scelta, tanto da dover essere

considerata alla stregua di un punto di ottimo locale. Inoltre anche l’ordinamento dei

centri non è ininfluente e pertanto, al fine di ottenere una valutazione della stabilità di

una specifica soluzione è sempre consigliabile confrontare i risultati ottenuti dall’analisi con quelli raggiunti dopo aver effettuato diverse permutazioni dei valori dei centri

iniziali;

b) il metodo delle nubi dinamiche che, invece di un solo punto, ossia il centroide, considera

un nucleo centrale di più elementi considerati rappresentativi. Con altre parole, le nubi

dinamiche prendono come riferimento un nucleo iniziale (seme) attorno al quale vanno

poi raccogliendosi i casi più somiglianti;

c) i metodi basati su una funzione obiettivo da ottimizzare, come ad esempio la minimizzazione della varianza tra i gruppi. In estrema sintesi, questi metodi cercano di realizzare

gli spostamenti dei singoli casi tra i gruppi senza uno specifico riferimento a considerazioni geometriche relative ad una funzione di distanza. Esse infatti tengono conto delle

modifiche che si ottengono nei valori della funzione obiettivo e vengono effettuati solo

gli spostamenti di elementi da un gruppo all’altro che migliorano il valore assunto dalla

funzione obiettivo. Tale processo termina quindi quando non si ottengono ulteriori progressi significativi attraverso un intero ciclo di riclassificazione. Il rapporto tra la devianza between e quella totale

R2 =

DEVBETWEEN

DEVTOT

[7.18]

La produttività delle banche. Questioni di metodo, misure ed applicazioni

viene generalmente utilizzato come indicatore della validità della partizione nei desiderati G

gruppi stabiliti.

I vantaggi dei metodi non gerarchici sono costituiti principalmente dalla velocità di esecuzione dei calcoli e dall'estrema libertà che viene lasciata alle unità di raggrupparsi e allontanarsi

da un certo cluster31. In altri termini, non si suppone che vi sia una qualche tassonomia delle

tipologie alla quale le unità siano costrette in qualche modo ad adeguarsi.

Quest’ultimo aspetto tuttavia, se da un lato costituisce un vantaggio, dall'altro pone la necessità di specificare delle ipotesi a priori sulla struttura del collettivo e ciò indubbiamente costituisce un limite perché costringe a provare più ipotesi alternative. Una soluzione a questo tipo

di problema potrebbe consistere (i) nell’applicare inizialmente ai dati un algoritmo di tipo gerarchico, che in relazione all’individuazione del numero ottimale dei gruppi è effettivamente un

metodo esplorativo, in modo da poter (ii) scegliere, mediante le solite procedure basata sul

confronto di indici e sull’ispezione visiva di grafici e tabelle, un intervallo di valori ragionevoli

per G analizzando l’insieme delle partizioni da esso ottenute per dopo (iii) poter applicare l'algoritmo di tipo non gerarchico varie volte in modo da far variare il valore impostato per G

nell’intervallo dei suoi ragionevoli valori in precedenza individuati ed infine poter (iv) scegliere

la soluzione migliore attraverso l’analisi dei valori assunti nelle varie prove effettuate dall’R2 .

Tra i problemi che si possono avere nell'utilizzo di algoritmi non gerarchici c’è poi da sottolineare che è possibile pervenire a soluzioni instabili sia in presenza di valori anomali32 sia di

una numerosità insufficiente delle osservazioni o qualora effettivamente non sussista una struttura in gruppi nei dati.

Con molti software statistici di tipo commerciale (quali SPSS, SPAD, SAS) nonché con

alcuni strumenti di natura open source facilmente reperibili in rete (tra i quali ad esempio R) è

possibile condurre cluster analysis utilizzando procedure di tipo sia gerarchico sia non gerarchico.

31 A tal proposito si fa nuovamente notare come invece con gli algoritmi gerarchici se due unità vengono fuse all'inizio,

rimangono unite fino alla fine della procedura.

32 Il problema della presenza di valori anomali in ogni caso dovrebbe essere già stato risolto dal prae-trattamento dei dati,

ossia nell’ambito della già descritta fase 3) di ogni cluster analysis.