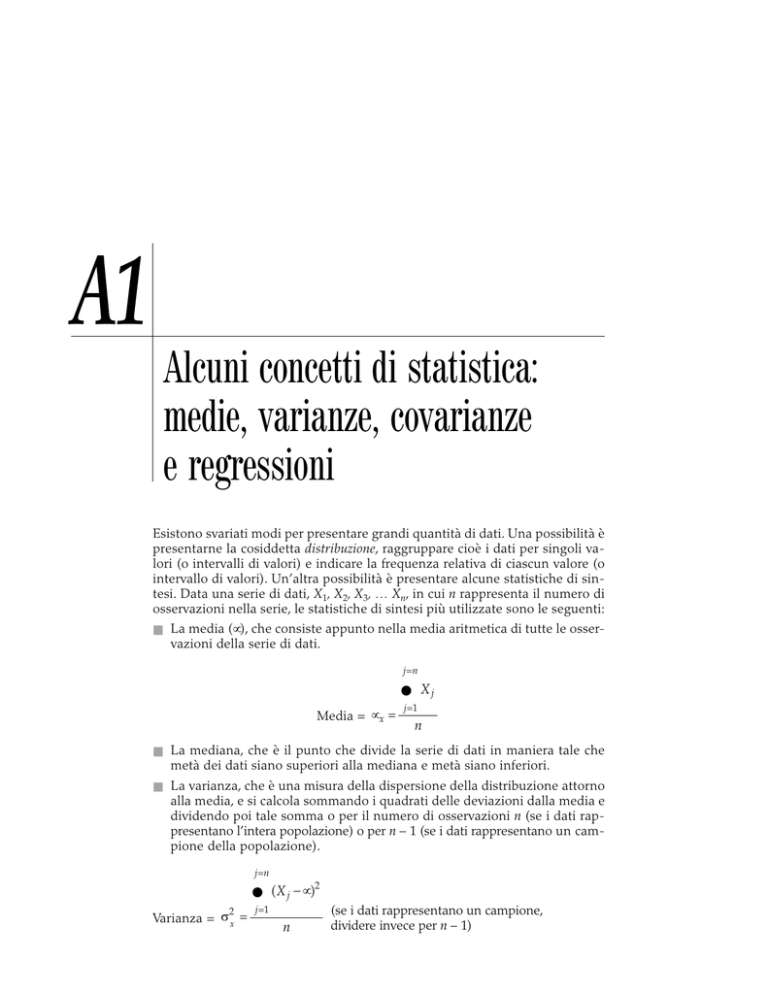

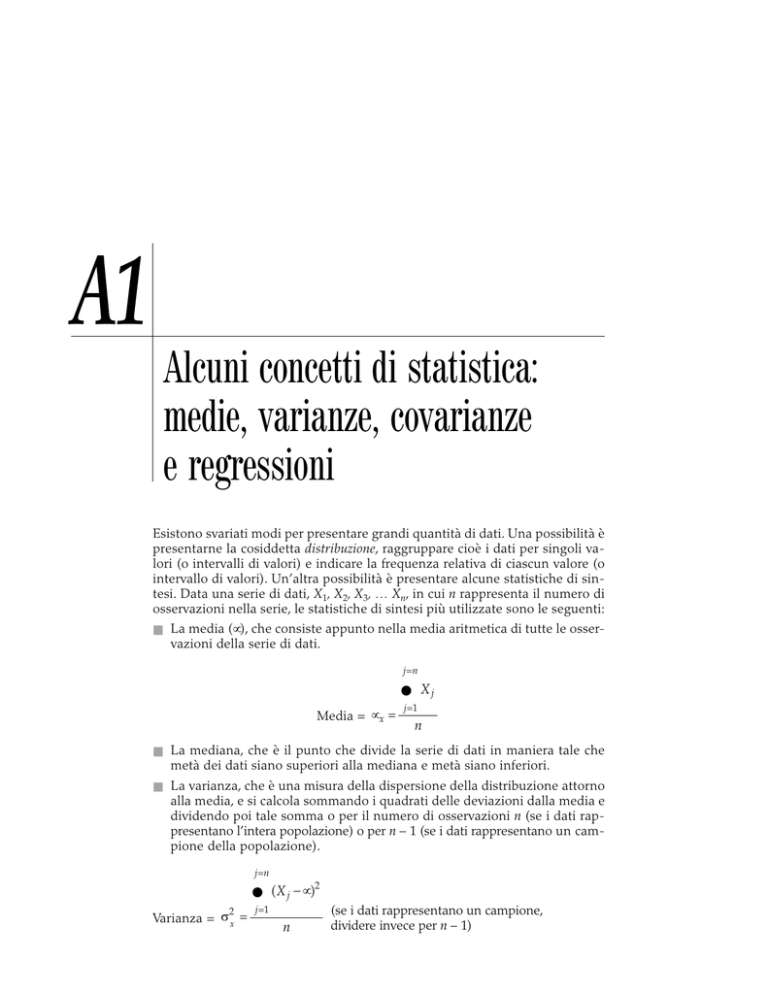

A1

Alcuni concetti di statistica:

medie, varianze, covarianze

e regressioni

Esistono svariati modi per presentare grandi quantità di dati. Una possibilità è

presentarne la cosiddetta distribuzione, raggruppare cioè i dati per singoli valori (o intervalli di valori) e indicare la frequenza relativa di ciascun valore (o

intervallo di valori). Un’altra possibilità è presentare alcune statistiche di sintesi. Data una serie di dati, X1, X2, X3, … Xn, in cui n rappresenta il numero di

osservazioni nella serie, le statistiche di sintesi più utilizzate sono le seguenti:

■ La media (µ), che consiste appunto nella media aritmetica di tutte le osser-

vazioni della serie di dati.

j =n

Media = µ x =

∑X

j

j =1

n

■ La mediana, che è il punto che divide la serie di dati in maniera tale che

metà dei dati siano superiori alla mediana e metà siano inferiori.

■ La varianza, che è una misura della dispersione della distribuzione attorno

alla media, e si calcola sommando i quadrati delle deviazioni dalla media e

dividendo poi tale somma o per il numero di osservazioni n (se i dati rappresentano l’intera popolazione) o per n – 1 (se i dati rappresentano un campione della popolazione).

j =n

∑( X − µ )

j

2

Varianza = σ x =

j =1

n

2

(se i dati rappresentano un campione,

dividere invece per n – 1)

638

Appendice 1

In presenza di due serie di dati, esistono diverse misure statistiche che possono essere utilizzate per quantificare la tendenza delle due serie a muoversi

insieme nel corso del tempo. Le due misure più utilizzate sono la correlazione

e la covarianza. Date due variabili X (X1, X2, …) e Y (Y1, Y2, …), la covarianza

fornisce una misura non standardizzata della loro tendenza a muoversi insieme, e viene stimata sommando il prodotto delle deviazioni dalla media per

ciascuna variabile in ciascun periodo.

j =n

∑( X − µ

j

Covarianza = σ XY =

X

)( Yj − µY )

j =1

n

(se i dati rappresentano un

campione, dividere invece

per n – 1)

Il segno della covarianza indica il tipo di relazione che intercorre fra le due

variabili. Un segno positivo indica che si muovono nella stessa direzione, mentre uno negativo indica che si muovono in direzioni opposte. Inoltre, più stretta è la relazione fra le variabili, maggiore sarà la covarianza. Ma è difficile capire l’intensità della relazione basandosi esclusivamente sulla covarianza, in

quanto non è una misura standardizzata.

Una misura standardizzata della relazione che intercorre fra due variabili è

rappresentata invece dalla correlazione, che può essere così calcolata a partire

dalla covarianza:

j=n

Correlazione = ρ XY = σ XY /σ X σ Y =

( X j − µ X )( Yj − µ Y )

∑

j 1

=

j=n

∑

j 1

=

( X j − µ X )2

j=n

( Yj − µ Y )2

∑

j 1

=

La correlazione non può mai essere superiore a 1 o inferiore a –1. Valori prossimi allo zero indicano che la relazione fra le due variabili è minima. Una correlazione positiva indica che le due variabili si muovono nella stessa direzione; la relazione è tanto più stretta quanto più il valore della correlazione si

avvicina a 1. Una correlazione negativa indica che le due variabili si muovono

in direzioni opposte; in questo caso la relazione è tanto più stretta quanto più

il valore della correlazione si avvicina a –1. Due variabili che sono positivamente perfettamente correlate (ρ = 1) si muovono in perfetta proporzione nella

stessa direzione, mentre due variabili negativamente perfettamente correlate

(ρ = –1) si muovono in perfetta proporzione in direzioni opposte.

La regressione rappresenta un’estensione dei concetti di covarianza e correlazione. Essa mira a spiegare l’andamento di una variabile, chiamata variabile dipendente (Y), con l’andamento di un’altra, chiamata variabile indipendente (X). Inserendo le due variabili in un diagramma, con Y sull’asse verticale

Alcuni concetti di statistica: medie, varianze, covarianze e regressioni

639

e X su quello orizzontale, la regressione consiste nel trovare la retta di interpolazione che minimizzi la somma delle deviazioni dei dati dalla retta medesima

elevate al quadrato; per questo motivo si parla di metodo dei “minimi quadrati” (OLS, ordinary least squares regression).

Una volta ottenuta questa retta, emergono due parametri:

1. Il punto in cui la retta interseca l’asse delle Y, chiamato intercetta della regressione (intercept);

2. L’inclinazione della retta di regressione (slope).

Regressione OLS: Y = a + bX

L’inclinazione (b) della regressione misura sia la direzione che l’intensità della

relazione. Quando le due variabili sono positivamente correlate, l’inclinazione

sarà positiva; quando le variabili sono negativamente correlate, l’inclinazione

sarà negativa. Numericamente, l’inclinazione della regressione può essere così

interpretata: per ogni aumento unitario della variabile indipendente (X), la

variabile dipendente (Y) cambia di b (inclinazione). La stretta connessione fra

inclinazione della regressione e correlazione/covarianza non dovrebbe sorprendere, visto che l’inclinazione viene stimata a partire dalla covarianza:

Inclinazione della regressione = b =

CovarianzaYX σYX

= 2

Varianza di X

σX

640

Appendice 1

L’intercetta a della regressione può essere interpretata in diversi modi: 1) il

valore assunto da Y quando X = 0; 2) la differenza fra il valore medio di Y, e il

valore medio di X corretto per tenere conto dell’inclinazione. Questa seconda

interpretazione discende direttamente dalla formula con cui si calcola l’intercetta:

Intercetta della regressione = a = µY – (b × µX)

I parametri di regressione vengono sempre stimati con un margine di errore,

in parte dovuto al fatto che i dati stessi sono misurati con un margine di errore, e in parte perché il procedimento di stima si basa su un campione di dati.

Questo margine di errore è rappresentato da due dati statistici. Il primo è l’R

quadrato (R-squared) della regressione, che misura la proporzione della variabilità di Y attribuibile alla variabilità di X. L’R quadrato è una funzione diretta

della correlazione fra le due variabili:

R2 = R quadrato della regressione = Correlazione2YX = ρ2YX =

b2σ2X

σ2Y

Un valore dell’R quadrato vicino a 1 indica una stretta correlazione fra le due

variabili, sebbene non indichi se essa sia positiva o negativa. L’altra misura

dell’imprecisione di una regressione è l’errore standard, che misura

la “dispersione” attorno a ciascuno dei due parametri stimati (intercetta e inclinazione). A ciascun parametro è infatti associato un errore standard, così

calcolato:

j =n

( X j )

j =1

∑

Errore standard dell’intercetta = SEa =

2

j =n

∑

( Yj − bX j )2

j =1

j =n

∑( X − µ

( n − 1)

j

X

)2

j =1

Errore standard dell’inclinazione = SEb =

j =n

∑

( Yj − bX j )2

j =1

j =n

∑( X − µ

( n − 1)

j

X

)2

j =1

Se inoltre ipotizziamo che la distribuzione delle stime dell’intercetta e dell’inclinazione sia la distribuzione normale, possiamo combinare la stima dei pa-

Alcuni concetti di statistica: medie, varianze, covarianze e regressioni

641

rametri e l’errore standard per ottenere la cosiddetta t di Student, un test statistico utilizzato per capire se la relazione è statisticamente significativa:

t di Student dell’intercetta = a/SEa

t di Student dell’inclinazione = b/SEb

Per campioni con più di 120 osservazioni, una t di Student maggiore di 1,66

consente di affermare con una confidenza del 95% che la variabile è significativamente diversa da zero, mentre una t di Student maggiore di 2,36 consente

la stessa affermazione con una confidenza del 99%. Per campioni più piccoli, per

avere la stessa confidenza statistica è necessaria una t di Student maggiore.1

La semplice regressione che misura la relazione fra due variabili diventa

una regressione multipla quando più variabili indipendenti (X1, X2, X3, X4 …)

vengono incluse nel tentativo di spiegare la variabile dipendente Y. Sebbene la

presentazione grafica si complichi, la regressione multipla risulta essere

un’estensione della regressione semplice:

Y = a + b X1 + c X2 + d X3 + e X4

Anche in questo caso l’R quadrato misura l’intensità della relazione; però, per

neutralizzare la tendenza dell’R quadrato ad aumentare al crescere del numero delle variabili indipendenti inserite nella regressione, sarà utile calcolare

un’altra statistica, il cosiddetto R quadrato corretto (adjusted R-square). Se nella

regressione ci sono k variabili indipendenti, l’R quadrato corretto sarà:

2

R quadrato corretto = 1 − (1 − R )

1

( n − 1)

(n − k)

I valori necessari possono essere desunti dalla tabella della distribuzione della t di Student.