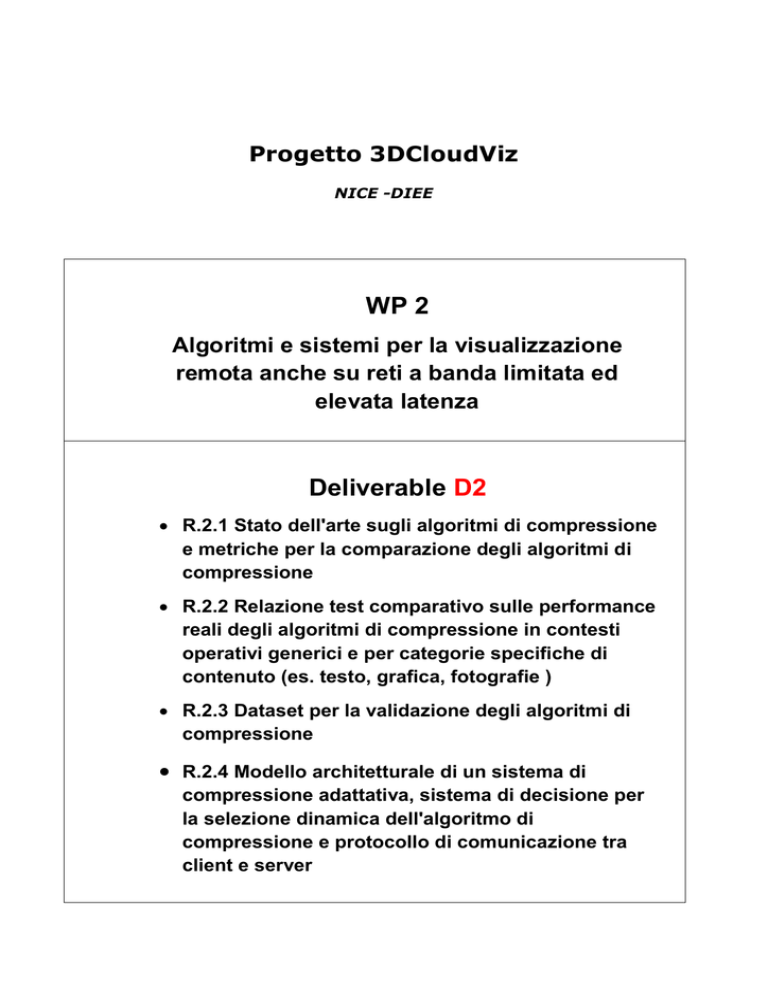

Progetto 3DCloudViz

NICE -DIEE

WP 2

Algoritmi e sistemi per la visualizzazione

remota anche su reti a banda limitata ed

elevata latenza

Deliverable D2

R.2.1 Stato dell'arte sugli algoritmi di compressione

e metriche per la comparazione degli algoritmi di

compressione

R.2.2 Relazione test comparativo sulle performance

reali degli algoritmi di compressione in contesti

operativi generici e per categorie specifiche di

contenuto (es. testo, grafica, fotografie )

R.2.3 Dataset per la validazione degli algoritmi di

compressione

R.2.4 Modello architetturale di un sistema di

compressione adattativa, sistema di decisione per

la selezione dinamica dell'algoritmo di

compressione e protocollo di comunicazione tra

client e server

Pattern Recognition and Applications Lab

DIEE - Università di Cagliari

R2.1

STATO DELL'ARTE SUGLI ALGORITMI DI COMPRESSIONE E

METRICHE PER LA COMPARAZIONE DEGLI ALGORITMI DI

COMPRESSIONE

Progetto 3D CloudWiz

Progetto 3D CloudWiz | ATI NICE - DIEE

Sommario

Sommario..............................................................................................................................................i

Obiettivo del documento......................................................................................................................1

Compressione lossless di immagini in real-time..................................................................................2

Algortimi di compressione dati........................................................................................................3

Codici di Huffman........................................................................................................................4

Codifica aritmetica.......................................................................................................................5

LZ77 – LZ78................................................................................................................................5

LZW(Lempel-Ziv-Welch)............................................................................................................6

RLE – Run Length Encoding.......................................................................................................7

Deflate..........................................................................................................................................7

Algoritmi di compressione lossless per immagini............................................................................8

Lossless JPEG e JPEG-LS............................................................................................................8

JPEG2000 – lossless...................................................................................................................10

JPEG XR.....................................................................................................................................11

Confronti tra i tre algoritmi precedentemente descritti..............................................................12

GIF..............................................................................................................................................13

PNG............................................................................................................................................13

Implementazioni multithread di diverso tipo.................................................................................15

ImageZero...................................................................................................................................15

LZ4.............................................................................................................................................17

Algoritmi di compressione proposti in letteratura..........................................................................17

A Lossless Image Compression Technique using Location Based Approach............................18

Context-based Dictionary Image Compression..........................................................................19

A new Algorithm for Lossless Compression applied to two-dimensional Static Images...........21

Fast Lossless Color Image Compressing Method Using Neural Network.................................22

Conclusioni.....................................................................................................................................24

Bibliografia.....................................................................................................................................25

Compressione di immagini generiche a contenuto eterogeneo (compound images).........................29

Metodi di segmentazione delle componenti di un'immagine.........................................................30

Approccio ad oggetti..................................................................................................................30

Approccio a layer.......................................................................................................................30

Approccio a blocchi....................................................................................................................32

i

Progetto 3D CloudWiz | ATI NICE - DIEE

Approccio ibrido.........................................................................................................................33

Algoritmi proposti in letteratura.....................................................................................................34

Metodi a blocchi.............................................................................................................................34

Metodi a layer.............................................................................................................................39

Metodi ibridi...............................................................................................................................41

Conclusioni.....................................................................................................................................44

Bibliografia.....................................................................................................................................44

Metriche per il confronto fra algoritmi di compressione di immagini...............................................47

Compression ratio...........................................................................................................................47

Tempo di compressione e decompressione....................................................................................47

Mean Squared Error – MSE...........................................................................................................48

Peak Signal to Noise Ratio – PSNR...............................................................................................48

Structural Similarity Index – SSIM................................................................................................49

Bibliografia.....................................................................................................................................50

ii

Progetto 3D CloudWiz | ATI NICE - DIEE

Obiettivo del documento

Scopo di questo documento l’identificazione degli algoritmi più promettenti, tra quelli emergenti,

per la compressione delle informazioni e la definizione di un insieme di metriche che consentano

un efficace confronto dei diversi algoritmi sia nell'utilizzo in contesti generici che nell'applicazione

a particolari categorie di informazioni e di pesare opportunamente la possibilità di modulare dei

parametri di configurazione in modo da poterne modificare dinamicamente il funzionamento in

funzione di contesti operativi (differenti condizioni di banda e latenza).

Il documento è organizzato in diverse sezioni e coprirà i seguenti argomenti:

Compressione lossless di immagini in real-time;

Compressione di immagini generiche a contenuto eterogeneo (compound images);

Metriche per il confronto fra algoritmi di compressione di immagini.

1

Progetto 3D CloudWiz | ATI NICE - DIEE

Compressione lossless di immagini in real-time

In questa sezione del documento si andrà ad analizzare lo stato dell'arte relativo alla codifica e alla

decodifica delle immagini 2D nello specifico caso di algoritmi di tipo lossless, quindi senza perdita

d'informazione, che possano essere utilizzati in un contesto nel quale sia necessaria la loro

applicazione in real time (RT) o near real time.

In letteratura vengono presentati un elevato numero di algoritmi di compressione di tipo lossy,

specialmente facenti uso di DCT (Discrete Cosine Transform) o di DWT (Discrete Wavelet

Transform) e/o loro combinazioni, mentre gli algoritmi di tipo lossless, presenti in numero più

limitato, rimandano a tecniche di compressione più generiche ed universali per tutti i tipi di dati.

All'interno di quest'insieme di algoritmi risulta ancora più complesso andare ad identificare

tecniche che agiscano in real time o near real time.

L'evoluzione degli studi sugli algoritmi di compressione d'immagini viene inoltre condizionata dalla

presenza sul mercato di alcuni algoritmi di COdifica e DECodifica (CODEC) ormai ritenuti degli

standard (ad esempio i vati PNG, JPEG ecc): essi raggiungono dei risultati tali che risulta complessa

la realizzazione di metodologie che possano migliorarne le performance.

In relazione alle specificità richieste, algoritmi di tipo lossless e funzionanti in real time o near real

time, vengono presentate in questo documento tre categorie di algoritmi di compressione:

algoritmi generici di compressione dati;

algoritmi di compressione immagini considerati standard;

algoritmi di compressione immagini proposti nella ricerca.

Per gli algoritmi generici di compressione dati verrà presentato un riepilogo delle tecniche di

compressione dati più comuni (es. codici di Huffman, LZ77, RLE ecc) con una breve descrizione

dell'algoritmo che esse implementano.

Per quanto riguarda gli algoritmi di compressione immagini considerati standard verranno

presentate, anche con tabelle di confronto, quelle metodologie di compressione più diffuse nel

mercato oggetto di studi specialmente nel settore di sviluppo di tipo industriale (es. JPEG-XR, PNG

2

Progetto 3D CloudWiz | ATI NICE - DIEE

ecc).

Per quanto riguarda gli altri algoritmi allo stato dell'arte proposti nella letteratura verrà presentato

un resoconto delle tecniche che appaiono più interessanti dal punto di vista delle performance

promesse.

Algortimi di compressione dati

In questo paragrafo andiamo ad analizzare le tecniche di compressione dei dati senza perdite, o

lossless, che avviene attraverso l'utilizzo di codici, quindi definendo delle corrispondenze tra

simboli d'ingresso e simboli d'uscita. Tali codici agiscono sui dati in ingresso, che possono essere

sequenze di simboli e/o dati, in virtù di un modello statistico della sorgente che genera gli stessi

simboli.

Il modello al quale si fa riferimento può essere adattativo, quindi costruito e/o perfezionato

contestualmente alla codifica dei simboli, oppure sussistere o essere dato a priori, quindi costruito

sui dati stessi in modo globale ad esempio con una pre analisi delle statistiche dei simboli che

occorre codificare.

L'output di queste tecniche sarà quello di generare un bit-stream dal quale è possibile, mediante

l'operazione inversa di decodifica, risalire perfettamente e senza nessuna alterazione o perdita

d'informazione ai dati originali.

Le principali tecniche di compressione dati presenti in letteratura risultano essere:

codici di Huffman;

codifica aritmetica [1];

LZ77 – LZ78;

LZW(Lempel-Ziv-Welch);

RLE – Run Length Encoding.

Altri algoritmi di compressione dati spesso utilizzati sono:

trasformata di Burrows-Wheeler (BWT) [2];

Prediction by Partial Matching (PPM) [3];

3

Progetto 3D CloudWiz | ATI NICE - DIEE

Deflate [4].

Queste compressioni lossless sono assolutamente generiche, adattabili quindi a qualunque

formato dati, ma al variare della tipologia di dati in ingresso esse offrono prestazioni notevolmente

differenti le une dalle altre.

Combinazioni di queste tecniche, o parti di esse sono già utilizzati all'interno di comuni codec per

immagini. Abbiamo ad esempio che LZW viene utilizzato per le immagini GIF, una variante di

Deflate è stata implementata per PNG, mentre LZW e RLE sono utilizzate direttamente nel formato

TIFF.

Codici di Huffman

I codici di Huffman sono tra i primi algoritmi di compressione dell'informazione. Nel 1952 David A.

Huffman pubblicò un articolo [5] in cui mostrava un metodo per la costruzione di codici con criteri

di minima ridondanza, questo metodo si mostra quindi particolarmente adatto alla compressione

lossless dei dati in differenti contesti.

Si può definire il processo di definizione dei codici come segue:

1) si crea una lista ordinata di simboli in base alle occorrenze degli stessi nel messaggio originale;

2) si ripetono i passi 2a, 2b e 2c tante volte finché all'interno della lista non rimane un unico

simbolo;

a) si determinano i due elementi meno frequenti all'interno della lista. Si crea un nodo

“genitore” dell'albero di Huffman avente come nodi “figli” questi due elementi;

b) si assegna la somma delle frequenze dei nodi “figli” al nodo “genitore” e lo si reinserisce

nella lista ordinata;

c) si cancellano i figli dalla lista ordinata;

3) si assegna infine una parola codice ad ogni elemento basandosi sulla sua posizione a partire

dalla radice: in questo modo i simboli più frequenti saranno codificati con parole più corte e

viceversa quelli più rari con parole più lunghe.

4

Progetto 3D CloudWiz | ATI NICE - DIEE

Questo algoritmo di compressione è stato poi adattato e migliorato in differenti modi. I più

conosciuti, qui non presentati, sono:

Codifica adattativa di Huffman [6];

Algoritmo di Huffman con template;

Codifica di Huffman a base n [7];

Codifica con costi per lettera diseguali [8].

Codifica aritmetica

Negli anni '80 sono stati introdotti nuovi tipi di algoritmi statistici che hanno ovviato ad alcuni

problemi che si presentavano con l'algoritmo di Huffman: i codici aritmetici [12].

Il codice di Huffman associa un valore intero ad ogni elemento della sorgente, il che porta ad un

dispendio eccessivo in termini di memoria e proporzionale al numero di simboli all'interno della

sorgente.

I codici aritmetici codificano invece simboli, o gruppi di simboli, con numeri decimali, e permettono

quindi di adoperare per la codifica dei numeri frazionari di bits.

Se esaminiamo un solo simbolo, ovviamente, i risultati ottenuti con le due diverse tecniche

saranno molto simili; ma una volta che esaminiamo una sequenza lunga di dati d'ingresso, la

somma degli arrotondamenti (tali si possono considerare i bits adoperati dalla codifica di Huffman

rispetto a quelli dei codici aritmetici) per la codifica dei singoli simboli porta ad una differenza

netta tra i risultati ottenuti con i codici aritmetici e il codice di Huffman.

LZ77 – LZ78

Altre tipologie di codifica sono quelle descritte dagli algoritmi Lempel-Ziv: di queste esistono

differenti implementazioni.

Nella prima versione (LZ77) [13] la codifica/compressione avviene mediante la sostituzione di parti

di dati già processate. Si utilizza una finestra di scorrimento dei dati avente dimensione fissa:

quando la finestra incontra un dato ripetuto allora tale dato viene sostituito da una coppia

“lunghezza-distanza” che indica l'esigenza di dover copiare una certa porzione di dati, avente una

certa “lunghezza”, da una determinata “distanza”.

5

Progetto 3D CloudWiz | ATI NICE - DIEE

Con questa tipologia di compressione la possibilità di trovare una corrispondenza nel “dizionario”

per la stringa di dati esaminata è quindi dipendente unicamente dai dati contenuti nella finestra di

scorrimento in quell'istante e non si tiene invece conto dei record precedenti.

Per superare questi inconvenienti e aumentare l'efficacia della codifica Lempel e Ziv, un anno dopo,

svilupparono la codifica LZ78 [14]: si costruisce un dizionario dei dati già incontrati e si

sostituiscono le occorrenze dei dati presenti nella finestra con un riferimento ai dati del dizionario.

La decodifica è analoga alla codifica, all'inizio il dizionario contiene solo la stringa vuota e mentre

viene riempito viene anche restituita la codifica originale.

La differenza con il precedente algoritmo è il ridotto numero di confronti tra stringhe di dati e

quindi una maggiore velocità, riguardo al coefficiente di compressione non ci sono rilevanti

differenze.

Anche a questi algoritmi sono stati applicati diversi adattamenti: da essi, ad esempio, derivano

LZW, LZMA(Lempel Ziv Markov chain) [15] e LZSS [16].

LZW(Lempel-Ziv-Welch)

Nel 1984 Terry Welch rivisitò l'algoritmo LZ78 [17] cercando di migliorarlo dal punto di vista della

velocità adottando un dizionario base non vuoto.

L’algoritmo LZW si basa sulla creazione di un dizionario di stringhe ricorrenti in un determinato

insieme di dati utilizzando un dizionario di base che di norma è costituito dai 255 caratteri

derivanti dalla codifica ASCII.

Leggendo un unico carattere alla volta si aggiorna il dizionario mantenendo la sequenza codificata

più lunga incontrata sino a quel momento. La velocità di questo algoritmo, rispetto a LZ78, è tale

che l'ha portato da essere stato scelto e utilizzato in sistemi come:

l'utility UNIX compress/uncompress.

formato grafico TIFF.

formato grafico GIF.

standard V.42 bis per la trasmissione dati.

6

Progetto 3D CloudWiz | ATI NICE - DIEE

Il prezzo da pagare per un incremento di performance in termini di velocità è un fattore di

compressione che risulta non essere elevato.

RLE – Run Length Encoding

L'algoritmo RLE è una forma molto semplice di codifica per la compressione dati.

Esso è basato sul fatto che in ogni flusso di dati sono presenti diversi dati simili, i valori ripetuti

vengono definiti “run”, questi dati ridondanti saranno sostituiti con un contatore e il valore ad esso

associato.

Questo tipo d’algoritmo intuitivo funziona bene con tipologie di dati in cui in cui sono presenti un

largo numero di occorrenze consecutive dello stesso byte pattern: da questo deriva il suo largo

impiego nel settore legato alla compressione di immagini. Ad esempio RLE si presta bene per la

compressione di formati grafici come BMP, PCX, TIFF (basandosi sulla ridondanza spaziale delle

immagini) e viene anche utilizzato in alcune implementazione di formati editoriali come PDF o

nella tecnologia per l'invio di FAX.

Possiamo trovare diverse implementazioni di quest’algoritmo:

RLE a livello di bit: ogni byte codifica sequenze di bit uguali;

RLE a livello di byte: ogni run è codificato da due byte;

RLE a livello di byte misto: si utilizza il concetto di byte di lunghezza, ossia un byte in cui il

bit più indicativo denota il tipo di run (1 = compresso, 0 = non compresso).

Deflate

L'algoritmo Deflate è un algoritmo per la compressione dei dati introdotto dal programma PKZIP, e

quindi formalizzato nella RFC 1951 [18]. Esso utilizza una combinazione dei metodi di

compressione LZ77 e la codifica di Huffman.

Deflate comprime i dati del flusso d'ingresso in blocchi di byte di lunghezza arbitraria massima di

64KB. Ognuno di questi blocchi è compresso separatamente mediante una combinazione di LZ77 e

Huffman secondo il seguente criterio:

gli alberi di Huffman usati per un blocco sono indipendenti da quelli utilizzati per blocchi

precedenti o successivi;

7

Progetto 3D CloudWiz | ATI NICE - DIEE

LZ77 può utilizzare un riferimento a una stringa duplicata vista in precedenza nella

sequenza di input.

La decisione relativa alla modalità di suddivisione in blocchi viene demandata all'utilizzatore finale

in base alle proprie esigenze e in base alla tipologia di dato da andare a comprimere.

Algoritmi di compressione lossless per immagini

In questa sezione vengono presentati i principali algoritmi di compressione e decompressione delle

immagini considerati degli standard.

In particolare si farà riferimento alle alla famiglia di codec lossless appartenenti allo standard JPEG

(Lossless Jpeg / Jpeg-LS, Jpeg2000 e JpegXR), il formato GIF e il formato PNG.

Vengono inoltre presentati ImageZero e LZ4 che, pur non rappresentando una novità in termini di

tecniche di compressione, rappresenta una novità in quanto aggiunge la parallelizzazione delle

operazioni rispetto alle implementazioni dei codec tradizionali al fine di garantire una notevole

velocità di codifica.

Lossless JPEG e JPEG-LS

A partire dal 1993, in seguito al successo della serie degli standard JPEG lossy, la commissione JPEG

(Joint Photographic Experts Group) valutò che fosse necessario adottare una modalità di

compressione lossless nello standard JPEG.

La prima versione del "lossless" JPEG codificava la differenza tra ogni pixel ed il valore "predetto"

per quel pixel. Il valore "predetto" è il risultato di una funzione che usa come parametri i valori dei

pixel che si trovano sopra, sopra a sinistra e immediatamente alla sinistra del pixel in esame. Tale

codifica viene anche chiamata Pulse Code Modulation (DPCM) e veniva utilizzata al posto della

comune DCT utilizzata nel lossy JPEG.

La sequenza di dati ottenuta veniva poi codificata con il metodo di Huffman o con altre codifiche

aritmetiche.

La ricerca di un sostituto che garantisse minore complessità computazionale e aumentasse le

performance in termini di efficienza di compressione portò all'analisi di algoritmi che

continuassero a non utilizzare la DCT – o le trasformazioni tra spazi di colore – ma che altresì

8

Progetto 3D CloudWiz | ATI NICE - DIEE

portassero ad una compressione lossless o quasi lossless. Il risultato di tale ricerca è stato poi

standardizzato in ISO-14495-1/ITU-T.87 con il nome di JPEG-LS.

Il core del JPEG - LS è basato sull'algoritmo LOCO -I [19]di HP che si contraddistingue in quanto la

fase di codifica viene preceduta da due fasi: quella di predizione e quella di modellazione degli

errori.

La bassa complessità di questa tecnica deriva da due fattori:

il fatto che la previsione residuale segue quella che viene chiamata “Discrete Laplace Distribution”;

l'utilizzo, in fase di codifica, di codici come quelli di Golomb-Rice, noti per essere ideali per le

distribuzioni geometriche.

Di seguito una tabella comparativa che illustra i risultati di compressione per un test set di

immagini con l'utilizzo di differenti algoritmi candidati ad appartenere allo standard JPEG-LS

espressi in bits/sample [20]:

Image

LOCO-I

JPEG-LS FELICS LossLess LossLess CALIC

JPEG

JPEG

Arithm

Huffman Arithm

LOCO-A PNG

Bike

3.59

3.63

4.06

4.34

3.92

3.50

3.54

4.06

cafe

4.80

4.83

5.31

5.74

5.35

4.69

4.75

5.28

woman

4.17

4.20

4.58

4.86

4.47

4.05

4.11

4.68

tools

5.07

5.08

5.42

5.71

5.47

4.95

5.01

5.38

bike3

4.37

4.38

4.67

5.18

4.78

4.23

4.33

4.84

cats

2.59

2.61

3.32

3.73

2.74

2.51

2.54

2.82

water

1.79

1.81

2.36

2.63

1.87

1.74

1.75

1.89

finger

5.63

5.66

6.11

5.95

5.85

5.47

5.50

5.81

us

2.67

2.63

3.28

3.77

2.52

2.34

2.45

2.84

chart

1.33

1.32

2.14

2.41

1.45

1.28

1.18

1.40

chart s

2.74

2.77

3.44

4.06

3.07

2.66

2.65

3.21

compound1 1.3

1.27

2.39

2.75

1.50

1.24

1.21

1.37

compound2 1.35

1.33

2.40

2.71

1.54

1.24

1.25

1.46

9

Progetto 3D CloudWiz | ATI NICE - DIEE

aerial2

4.01

4.11

4.49

5.13

4.14

3.83

3.58

4.44

faxballs

0.97

0.90

1.74

1.73

0.84

0.75

0.64

0.96

gold

3.92

3.91

4.10

4.33

4.13

3.83

3.85

4.15

hotel

3.78

3.80

4.06

4.39

4.15

3.71

3.72

4.22

Media

3.18

3.19

3.76

4.08

3.40

3.06

3.06

3.46

JPEG2000 – lossless

Si tratta del successore designato del JPEG, già ufficializzato come standard ISO/ITU che va sotto il

nome di JPEG2000 [21].

La versione completa delle specifiche relative a questo formato è scaricabile dalla pagina web del

JPEG.org [22].

JPEG2000 è completamente diverso dal suo predecessore JPEG: propone prima di tutto il fatto che

uno stesso algoritmo possa essere adatto sia alla codifica lossy che a quella lossless.

La differenza tra i due standard è sostanziale e possiamo brevemente identificarle come segue:

durante la prima trasformazione, quella che in JPEG veniva svolta tramite l'utilizzo di una

DCT (Discrete Cosine Transform), in JPEG2000 si utilizza la DWT (Discrete Wavelet

Transform);

la fase di quantizzazione dei valori è opzionale in JPEG2000 se l'utente desidera ottenere

una compressione senza perdita d'informazione.

JPEG utilizza una versione avanzata della codifica di Huffman, JPEG2000 utilizza un metodo

chiamato Embedded Block Coding with Optimized Truncation (EBCOT) [23].

Queste non sono però le uniche differenze apportate rispetto allo standard JPEG: a causa di questo

i programmi attuali più diffusi (software di grafica, viewer e browser) e l'hardware (ad esempio le

fotocamere digitali) non supportano nativamente il nuovo formato dello standard.

Questo fatto non gioca a favore di JPEG2000 vista l'ampissima diffusione del formato JPEG (oltre

l'80% delle immagini è codificato con lo standard JPEG) per cui il futuro di questo nuovo formato è

ancora molto incerto nonostante le potenzialità che offre.

10

Progetto 3D CloudWiz | ATI NICE - DIEE

Questi i passaggi per la codifica con JPEG2000 lossless:

Passo 1) Preprocessing

Se stiamo comprimendo un'immagine a colori occorre trasformare l'immagine nello spazio

YCbCr e, per ogni canale, sottraiamo 127 ad ogni valore “unsigned” contenuto in esso. In

questo modo avremo una “centratura” dei valori sullo 0.

Passo 2) Trasformazione

Uno dei principali cambiamenti nello standard JPEG2000 è l'uso della Trasformazione

Wavelet Discreta (DWT) invece della DCT. Il risultato di quest’operazione è la decorrelazione

tra le informazioni di bassa e alta frequenza contenute nell’immagine.

La DWT si applica poi ricorsivamente, solitamente 2/3 volte, alla componente delle basse

frequenze. Il risultato finale di tutta l'operazione è che l'intero contenuto informativo

dell'immagine originale è stato segmentato in una serie di trasformazioni successive, che

potranno poi essere compresse in un minimo spazio e poi decompresse in modo

reversibile.

Alla DWT vengono applicati dei filtri per la compressione, nel caso lossless solitamente il

filtro LeGall53 o W5x3. Nel caso lossy i filtri applicati sono differenti.

C'è da fare presente che la complessità della DWT dipende dalla dimensione dei filtri

applicati e dal tipo di filtro. Solitamente essa è computazionalmente più complessa della

DCT e richiede anche una maggiore memoria.

Passo 3) Quantizzazione

Nel caso di codifica lossless non si applica alcun tipo di quantizzazione.

Passo 4) Encoding

Per la compressione senza perdita di dati, usiamo semplicemente la metodologia EBCOT

[24]per codificare gli elementi della trasformazione wavelet.

JPEG XR

JPEG XR [25], precedentemente conosciuto come HD Photo [26], è un formato per la compressione

11

Progetto 3D CloudWiz | ATI NICE - DIEE

delle immagini sviluppato da Microsoft e studiato per superare la limitazione degli 8 bit per canale

del formato JPEG estendendo la profondità del colore a 16 bit o più, supportare un numero

maggiore di di spazi di colore e garantire la possibilità di gestire porzioni di immagine senza dover

decodificare l’intera immagine.

La qualità dell'immagine, percettivamente comparabile a quella del JPEG2000, ha un carico

computazionale più vicino a quello del JPEG offrendo però una compressione superiore anche in

caso di compressione lossless.

L'algoritmo di compressione è molto simile a quello JPEG:

avviene una trasformazione in un differente spazio di colore;

ogni piano di colore viene suddiviso in blocchi di dimensione fissa;

i blocchi vengono trasformati sotto il dominio della frequenza e gli viene applicata una

codifica entropica.

Essendo la trasformazione da RGB a YCbCr leggermente lossy (introduce infatti dei piccoli errori in

fase di arrotondamento), il nuovo standard JPEG XR propone l'adozione della trasformazione dallo

spazio RGB a quello YUV.

La fase di trasformazione nel campo della frequenza avviene su blocchi di dimensioni inferiori e

senza l'utilizzo della trasformata DCT bensì utilizzando, come nel JPEG2000, la DWT (Discrete

Wavelet Transform) utilizzando l'algoritmo con schema “lifting” [27]: esso è un metodo alternativo

per il calcolo dei coefficienti delle wavelet avente un minore costo computazionale e un minore

utilizzo di memoria.

Il vantaggio di questa codifica rispetto a JPEG2000 è il fatto che questa è già supportata dalla gran

parte dei software che utilizzano immagini.

Confronti tra i tre algoritmi precedentemente descritti

In letteratura sono già presenti [28] dei test comparativi tra i tre algoritmi fin'ora trattatati. A puro

titolo d'esempio di seguito vengono riportati brevemente i risultati d'interesse riferiti alle immagini

Lena.bmp, Peppers.bmp, Couple.bmp e Sailboat on Lake.bmp (in alcuni casi si parte da formati

.ppm o .pnm) presenti all'indirizzo http://sipi.usc.edu/database ed utilizzati per avere un PSNR pari

12

Progetto 3D CloudWiz | ATI NICE - DIEE

a 40db (valori in tabella in bpp)

TEST

JPEG-2000

JPEG-XR

JPEG-LS

Lena.bmp

5

4.2

5.5

Peppers.bmp

6.6

6

5.5

Couple.bmp

3.4

3

4.5

Sailboat on Lake.bmp

8

7

6.7

GIF

Il formato GIF (Graphic Interchange Format), diffuso alla fine degli anni 80, usa una forma di

compressione LZW che mantiene inalterata la qualità dell'immagine.

La profondità dei colori delle immagini GIF è di 8 bit, che consente di usare una tavolozza di

massimo 256 colori. Consente inoltre di inserire la trasparenza ad uno dei colori individuati.

Lo schema di compressione LZW è più adatto a comprimere immagini con grossi campi di colore

omogeneo ed è meno efficiente nella compressione di immagini complesse con molti colori e

grane/finiture complesse.

Tale formato è stato superato a partire dal 1995 a causa dello sviluppo del PNG.

PNG

Il formato di codifica PNG [29] (Portable Network Graphics) è un formato grafico di tipo raster

(bitmap) basato sulla compressione deflate. È stato elaborato nel 1995 per fornire un'alternativa

libera al formato GIF per la quale era stato improvvisamente richiesto il pagamento delle royality di

utilizzo.

La compressione proposta con questo formato è una compressione senza perdita (lossless

compression) da 5 a 25% migliore della compressione GIF.

PNG può supportare colori fino a 32 bit. Il formato PNG-8, il primo nato, presenta effettivamente

molte analogie con il formato GIF. Il formato PNG-24 è invece più “simile” a un JPEG e può

supportare la trasparenza anche su più livelli di colore.

Esso possiede solitamente una funzione di intreccio che permette di visualizzare progressivamente

l'immagine.

13

Progetto 3D CloudWiz | ATI NICE - DIEE

La struttura dei file PNG è composta come segue:

una firma in esadecimale del file che identifica il tipo PNG

una serie di chunks dell'immagine

I chunks dell'immagine contengono il contenuto informativo dell'immagine stessa. I più importanti

sono quelli definiti “critical”:

IHDR Image header

PLTE Palette

IDAT Image data

IEND Image trailer

Oltre a questi chunks principali sono poi presenti chunks “accessori”.

I chunks possono essere presenti nel file in qualsiasi ordine ma devono cominciare dal segmento di

titolo (IHDR chunk) e finire dal segmento finale (IEND chunk).

I chunks a loro volta sono suddivisi in quattro parti:

dimensione del chunk, un numero intero di 4 byte

tipo del chunk, un codice di 4 byte di caratteri ASCII alfanumerici che identificano la

tipologia del chunk

i dati del chunk

il CRC (cyclic redundancy check), un codice correttore di 4 byte che permette di verificare

l'integrità del segmento

Di seguito una tabella riepilogativa relativa alla conversione di un'immagine campione che

evidenzia le differenze di compressione tra PNG e le varie compressioni legate al JPEG impostando

la qualità di output pari al 100%.

TEST

BMP

JPEG (Qualità 100%)

JPEG-XR (Qualità 100%) PNG

Butterfly.bmp

668 KB

201 KB

251 KB

267 KB

Questi valori sono stati ottenuti utilizzando il tool di grafica Gimp sulla seguente immagine

14

Progetto 3D CloudWiz | ATI NICE - DIEE

d'esempio avente dimensioni 485x353 reperita gratuitamente sul sito http://pngimg.com/:

Implementazioni multithread di diverso tipo

Come già specificato in fase introduttiva vengono qui di seguito presentati due differenti tools di

compressione, uno specifico per le immagini (ImageZero) e uno più generico (LZ4) che pongono il

loro punto di forza sulla velocità d’esecuzione dell’algoritmo di compressione e decompressione

piuttosto che sui livelli di compressione raggiunti.

Tali performance vengono perseguite adattando gli algoritmi di compressione alle potenze di

calcolo offerte dai moderni processori: in particolare si fa un forte utilizzo del multithreading.

ImageZero

ImageZero [30] nasce nel 2012 da un progetto di Chistoph Feck, sviluppatore di KDE, che ricercava

un codec estremamente veloce, che fosse di tipologia lossless e che offrisse un discreto rapporto di

compressione.

Non avendo trovato quello che cercava ha stabilito di realizzarlo lui stesso. Le piattaforme di

benchmark indipendenti per la valutazione delle prestazioni relative alle procedure di codifica e

decodifica lossless documentano la velocità e la qualità del suo codec [31] [32].

Il codice è attualmente al primo stadio di sviluppo ma è estremamente promettente: rispetto al

PNG comprime un'immagine PPM a 24 bit circa 20 volte più velocemente e la decomprime 2 volte

più velocemente. Il tasso di compressione è estremamente prossimo a quello del PNG.

L'algoritmo utilizzato è molto semplice: la compressione e la decompressione viene realizzata “per

pixel”, senza branches (ad eccezione di un unico branch nel bit coder), in modo che sulle moderne

CPU possa essere eseguito molto velocemente e in parallelo.

Questo tipo di codifica non è adatta per grafici o per immagini in scala di grigi.

15

Progetto 3D CloudWiz | ATI NICE - DIEE

Andando ad utilizzare come immagine campione quella presente all'indirizzo seguente:

http://www.flickr.com/photos/anirudhkoul/3499471010/sizes/o/in/photostream/

questi sono i risultati ottenuti per le varie tipologie di codifica e decodifica:

Metodo

Dimensione del File (KB) Tempo di Compressione (s) Tempo di Decompressione (s)

Originale

46380

-

-

JPEG-LS

14984

6,6

7,3

PNG

16256

42,4

2,4

1,2

1,3

ImageZero 15496

Alcuni interessanti risultati compresi nel “LossLess Photo Compression Benchmark” mostrano i

risultati dei tempi di compressione e decompressione dei sistemi di compressione lossless applicati

su un database di circa 3.46 GB.

Quello che viene evidenziato è che il formato ImageZero, rilasciato con licenza BSD, così come il

codice al quale fa riferimento, è nettamente il codec più veloce e garantisce una notevole velocità

sia di compressione che di decompressione. La tabella seguente fornisce un riepilogo di quanto

emerge.

Software / Codec

Licenza

Dimensione (%)

Compressione (s)

Decompressione (s)

Originale

-

100

-

-

bzip2 -1

bzip2 License

56,3

476

218

PNG

libpng License

42,5

844

72

ImageZero

BSD

41,3

23

21

JPEG-LS

HP License

37,4

107

92

lossless WebP

BSD

35,6

7525

110

Flic

Proprietario

30,0

210

231

Gralic

Proprietario

28,1

1734

1897

16

Progetto 3D CloudWiz | ATI NICE - DIEE

LZ4

LZ4 [33] è un algoritmo di compressione di dati generici, derivante dal filone dei codec LZ77,

particolarmente orientato ad aumentare notevolmente le velocità di compressione e

decompressione.

Attualmente è un progetto presente su google-code [34] e sta avendo un notevole successo in

quanto riesce a garantire velocità di 400MB/s per ogni core dedicato alla compressione.

L'algoritmo è inoltre scalabile con le CPU multi core. I tempi di decompressione ottenuti sono

nell'ordine dei GB/s e raggiungono, nei sistemi multi core, il limite di velocità della ram.

Di seguito, in Tabella 6, viene riportato uno schema comparativo con le performance registrate da

LZ4 rispetto ad altri algoritmi/tools di compressione

Tool

Ratio

Comp. Speed (MB/s)

Decomp. Speed (MB/s)

LZ4 (r101)

2,084

422

1820

LZO 2.06

2,106

414

600

QuickLZ (1.5.1b6)

2,237

373

420

Snappy 1.1.0

2,091

323

1070

LZF

2,077

270

570

Zlib 1.2.8 -6

3,099

21

300

Algoritmi di compressione proposti in letteratura

Di seguito vengono messi in risalto quelli che sembrano essere gli algoritmi di compressione per

immagini più promettenti presenti in letteratura. Il vincolo della ricerca di compressioni lossless (o

near lossless), real time (o near real time) e applicabili a immagini con un contenuto generico ha

portato a un'elevata scrematura dell'offerta scientifica disponibile.

La gran parte degli articoli analizzati è risultata essere non idonea allo scopo del presente

documento. Molte delle pubblicazioni fanno inoltre riferimento a dataset di test non pubblici e/o

comunque di difficile reperibilità o aventi un contenuto molto limitato d'immagini pregiudicando

l'eventuale ripetibilità dei test presentati.

Gli approcci mostrati sono quindi unicamente quelli che presentano delle misure di prestazioni

relative a un dataset di dimensione sufficiente o relative a set di immagini standard.

17

Progetto 3D CloudWiz | ATI NICE - DIEE

A Lossless Image Compression Technique using Location Based Approach

A Lossless Image Compression Technique using Location Based Approach [32] è una tecnica per la

compressione lossless d'immagini basata sulla divisione in blocchi 4x4 dell'immagine originale e in

una loro successiva compressione.

L'algoritmo in oggetto si basa essenzialmente su pochi semplici passi:

1) scomporre l'immagine in blocchi 4x4 non sovrapposti

2) per ogni blocco poi

a) convertire il blocco in un array di 16 elementi con un approccio “da sinistra a destra e

dall'alto in basso”

b) individuare il valore più frequente all'interno dell'array (MFP) e eliminarlo

c) scrivere il valore dell'MFP sul bit stream d'uscita susseguito da 4 bit che indicano il numero

di occorrenze (la frequenza) dell'MFP

d) individuare la frequenza del secondo valore più frequente all'interno dell'array (SMFP): se

occorrono k bit per rappresentare questa frequenza, scrivere k nei successivi 4 bit nel bit

stream d'uscita

e) scrivere quindi il valore dell'SMFP in 8 bit

f) scrivere il numero di occorrenze dell'SMFP

g) scrivere tutte le posizioni delle sue occorrenze in k bit

h) ripetere i passi da e) a g) per tutti i distinti valori di pixel rimasti nell'array

3) ripetere per ogni blocco

per un'immagine a colori occorre ovviamente ripetere l'intero algoritmo per ogni componente di

colore.

Una tabella comparativa dei risultati di compressione, in termini di dimensione dell'immagine in

bit, riportata nell'articolo viene di seguito proposta:

TEST

Non compressa GIF

TIFF

18

PNG

LICTLBA

Progetto 3D CloudWiz | ATI NICE - DIEE

Lena

2097152

443187

521830

387482

252082

Baboon

2097152

654541

535107

501350

196608

Iris

2097152

901120

802816

630784

201583

L'articolo presentato propone un metodo di compressione che sembra dare buoni risultati ma

risulta anomalo il numero ridotto di campioni su cui vengono eseguiti i test. Inoltre esso sembra

presentare dei limiti, ad esempio, il caso in cui tutti i pixel siano diversi comporterebbe un aggravio

in termini di dimensioni dell'immagine, si avrebbero infatti per un singolo blocco 4x4 di un singolo

canale di un'immagine:

8 bit per MFP

bit per la frequenza MFP

4 bit per la rappresentazione di K

8 bit per SMFP

1 bit per la frequenza di SMFP

4 bit per la posizione di SMFP

(8 + 1 + 4)*14 = 182 bit per i restanti valori dei pixel

per un totale di 211 bit di un blocco compresso contro 128 bit del blocco non compresso. L'articolo

stesso specifica però che nei blocchi di test 4x4 analizzati, circa 100.000, solo in una piccola parte

di questi, 79, si è verificato il caso peggiore precedentemente indicato.

Context-based Dictionary Image Compression

Il Context-based Dictionary Image Compression (CDIC) [33] è un algoritmo proposto nel 2012 e che

propone l'applicazione di tecniche di compressione di dati testuali anche nel campo delle

immagini.

In particolare la tecnica di compressione da applicare alle immagini è quella proposta da Nakano e

altri [34] nel 1994, il Classifying to Sub-Dictionaries (CSD), che propone l'idea di combinare

tecniche di compressione basate su dizionari a tecniche di compressione basate sul contesto dei

19

Progetto 3D CloudWiz | ATI NICE - DIEE

dati: in particolare combinando la compressione Lempel-Ziv-Welch (LZW) con lo schema Prediction

by Partial Matching (PPM).

L'algoritmo in questione utilizza un numero elevato di sottodizionari che sono inizialmente presi in

considerazione con tutti i possibili singoli caratteri.

Ogni stringa da codificare viene codificata in base all'ultimo simbolo presente nella precedente

sotto stringa che viene associato al dizionario secondario da utilizzare. Una volta individuato il

dizionario, si utilizza l'algoritmo LZW per la compressione dei dati.

Utilizzando sempre l'ultimo elemento per la codifica di una stringa successiva, viene considerato

[35] come uno schema PPM del primo ordine.

L'applicazione del CSD alle immagini bidimensionali è stata testata e confrontata con le prestazioni

offerte dalla semplice compressione LZW. Per completezza di analisi, per la predizione del corretto

sotto dizionario da andare a utilizzare, sono stati effettuati due differenti test: in un caso veniva

sfruttato il valore del pixel a sinistra, mentre in un secondo caso il valore del pixel superiore.

Quello che viene evidenziato dai test condotti su 9 immagini standard è che mediamente la

codifica LZW riduce lo spazio occupato del 14%, mentre con la codifica CSD si può arrivare fino al

17%. I risultati pubblicati non sono entusiasmanti in termini di compressione anche perché, come

nella maggior parte dei casi, non vengono riportati i tempi di codifica e decodifica delle immagini.

Nella tabella a seguire vengono riportati i risultati ottenuti dai test svolti da El-Sakka dove i valori

sono da intendersi in byte.

TEST

Non Compressa

LZW

CSD (Pixel sinistro)

CSD (Pixel Superiore)

Boats

103680

91183

87215

88816

Camera

65536

54720

51106

52325

Columbia

57600

52350

49666

50845

Crowd

262144

196955

188488

190171

Lake

262144

243225

235806

237016

20

Progetto 3D CloudWiz | ATI NICE - DIEE

Man

262144

227473

220547

212930

Milkdrop

65536

55368

54290

53992

Peppers

65536

64423

63008

62515

Plane

65536

56218

53928

54840

A new Algorithm for Lossless Compression applied to two-dimensional Static Images

A new Algorithm for Lossless Compression applied to two-dimensional Static Images (ALCSI) [36] è

stato proposto nel 2012 e prevede l'utilizzo di una tecnica ibrida per la compressione delle

immagini che sfrutta i concetti introdotti dall'algoritmo INA [37] per la parallelizzazione del

processo.

I risultati sperimentali del metodo INA, dello stesso autore, evidenziano come il metodo indicato

abbia performance superiori alla codifica di Huffman e al JPEG-LS, di seguito un breve schema

riassuntivo nella tabella seguente relativo alla compressione di un'immagine 2048x2048 in cui la

compressione, per il metodo INA è stata ottenuta in 0.105 secondi:

METHODS

COMPRESSION RATIOS

Huffman Coding

4%

Prediction

27%

JPEG-LS (Standard)

54%

INA

58%

Il metodo si compone di tre fasi: una prima fase di segmentazione dell'immagine, una seconda fase

di compressione e una terza di codifica.

Nella prima fase, l'intera immagine viene suddivisa in blocchi di dimensione fissa: ogni blocco

genera due gruppi distinti. Un primo gruppo che identifica la sequenza dei pixel del blocco ordinati

in ordine crescente e l'altro che rappresenta una sequenza formata da pixel organizzati in gruppi di

coppie ordinate. I vantaggi apportati dalla segmentazione dell'immagine, tipicamente in blocchi di

21

Progetto 3D CloudWiz | ATI NICE - DIEE

dimensione 4x4, sono essenzialmente riconducibili all'aumento in termini di velocità, alla riduzione

della memoria richiesta e all'adattamento dei dati stessi per l'utilizzo nell'albero binario.

La seconda fase, quella di compressione, è la novità apportata da questo metodo e si riferisce

all'esecuzione parallela della compressione dei due gruppi ottenuti nella prima fase di

segmentazione tramite l'utilizzo di un albero binario e uno schema di predizione.

Nella terza ed ultima fase viene applicato un codificatore per la generazione del bit stream d'uscita.

I risultati sperimentali pubblicati nella tabella seguente legati a questo metodo sono stati dei lievi

miglioramenti nelle misure del rapporto di compressione e dei bit per punto rispetto al JPEG-LS.

METHODS

COMPRESSION RATIOS

BPP

Methods based on Substitution models

1,03

7,79

Methods based on Arithmetic models

1,11

7,21

Methods based on Dictionary models

1,23

6,53

Methods based on Predictive models

1,57

5,09

Methods based on Transformed models

1,76

4,54

JPEG-LS Standard

1,75

4,57

ALCSI

1,77

4,52

Fast Lossless Color Image Compressing Method Using Neural Network

L'approccio mostrato nel 2002 con la pubblicazione “Fast Lossless Color Image Compressing

Method Using Neural Network” [38] mira a rinunciare alle prestazioni in termini di compressione

per andare invece a migliorare i tempi di compressione dei dati dell'immagine.

Gli autori propongono un algoritmo di tipo predittivo che consta di tre fasi.

Nella prima fase si procede a una trasformazione dello spazio di colore: seguendo gli esempi di

JPEG-LS e JPEG2000 gli autori propongono un loro nuovo spazio di colore. Partendo dalle

componenti originali (denominate genericamente A1, A2 e A3) si ottengono le nuove componenti

secondo queste equazioni:

A1' = floor (0.25A1 + 0.5A2 + 0.25A3)

22

Progetto 3D CloudWiz | ATI NICE - DIEE

A2' = A1 - A2

A3' = A3 - A2

la trasformazione è ovviamente reversibile.

Nella seconda fase si applica invece un modello predittivo: il valore del pixel è predetto pesando i

valori dei quattro pixel in direzione in alto a sinistra. Se il pixel d'interesse è nella prima o

nell'ultima colonna o se è nella prima riga, si utilizza un valore di default per il pixel vicino

mancante. Il pixel k-simo in posizione (i,j) sarà calcolato come:

Pk(i,j) = w1Pk(i,j-1) + w2Pk(i-1,j-1) + w3Pk(i-1,j) +w4Pk(i-1,j+1)

dove i generici w inizialmente assumeranno il valore 0.25.

Nella terza fase viene invece utilizzato una correzione adattativa dei singoli pesi in base

all'algoritmo riportato in [39] attraverso l'utilizzo di una rete neurale a due livelli.

I risultati ottenuti da questo metodo indicano che con questo metodo è possibile ottenere una

compressione nettamente superiore che con il solo utilizzo dei metodi di Huffman o Lzw. Si ottiene

inoltre un rapporto di compressione un po' peggiore rispetto a JPEG-LS ma si riesce, con l'utilizzo

della metodologia proposta, a migliorare i tempi di compressione dell'immagine stessa.

Di seguito sono mostrate due tabelle che riassumono tali prestazioni. Nella prima si fa riferimento

al numero medio di bits per codificare ogni pixel, nella seconda vengono indicati i tempi di

compressione ottenuti per le immagini di test.

I risultati di compressione vengono proposti in termini di bits/pixel:

Image

Huffman

LZW

JPEG-LS

Proposed

Scenery1

2,92

5,01

2,13

2,20

Scenery2

2,27

4,20

1,83

1,89

Aerial

2,65

3,92

1,90

2,22

Computer's

2,47

3,08

2,21

2,55

Peppers

4,67

5,84

3,88

4,28

23

Progetto 3D CloudWiz | ATI NICE - DIEE

Lena

5,12

6,78

4,52

4,76

I tempi di compressione, in termini di secondi, vengono riportati nella seguente tabella:

Image

Huffman

LZW

JPEG-LS

Proposed

Scenery1

6,88

9,87

6,21

5,10

Scenery2

9,35

13,32

8,68

7,27

Aerial

6,83

7,90

6,62

5,55

Computer's

5,24

8,68

4,46

3,89

Peppers

1,18

3,12

0,60

0,51

Lena

2,87

3,89

1,05

0,90

Conclusioni

La letteratura scientifica, in relazione a codec lossless o near lossless che possano essere utilizzati

in real time o in near real time, risulta essere limitata.

Negli ultimi anni la comunità scientifica si è concentrata infatti ad affrontare le problematiche

relative alla compressione e decompressione d'immagini seguendo gli andamenti del mercato: si è

manifestata infatti una proliferazione di studi su specifiche tipologie d'immagine a discapito di

studi legati a immagini generiche (in formato RGB o BGR).

Ad esempio si riscontrano un numero elevato di studi legati alle immagini realizzate secondo il

criterio Bayer CFA [40-42], specifico in particolare per immagini fotografiche ad elevata risoluzione

e dipendente dai filtri implementati nelle fotocamere, come mostrato dagli studi in corso anche in

aziende come Microsoft [43]; si ha anche la ricerca di nuove tecniche di codifica legato a immagini

di tipo medicale [44,45], legato alle immagini astronomiche [46] o più genericamente alle

24

Progetto 3D CloudWiz | ATI NICE - DIEE

tematiche del compound image compression [47,48].

Quello che viene evidenziato è che gli algoritmi e i formati di compressione già presenti sul

mercato (JPEG XR, PNG ecc) sono attualmente considerati stabili e affidabili. Le prestazioni che essi

offrono vengono valutate sufficienti per l'esigenza attualmente manifestata dal mercato: essi

risultano offrire rapporti di compressione molto buoni, superati solo minimamente dai nuovi

algoritmi presentati in letteratura, e tempi di compressione ragionevoli per le più diffuse

applicazioni.

Quello che si evidenzia è inoltre la presenza di una serie di studi e implementazioni che mirano ad

utilizzare le codifiche dati ritenute standard (Huffman, LZ78 ecc) parallelizzandone però il processo

ed adattando quindi queste tecniche al multi threading offerto dai processori oppure andando ad

implementare i medesimi algoritmi al fine di utilizzare la potenza di calcolo presente nella GPU del

sistema.

Ovviamente tali soluzioni non migliorano il rapporto di compressione offerto dagli algoritmi ma si

limitano a migliorare i tempi legati alla compressione e decompressione dei dati.

Bibliografia

1. «http://math.unipa.it/~epifanio/tecnologie/compr07_08.pdf,» [Online].

2. M. Burrows e D. Wheeler, «A block sorting lossless data compression algorithm».

3. «http://compressions.sourceforge.net/PPM.html,» [Online].

4. «http://tools.ietf.org/html/rfc1951,» [Online].

5. D. Huffman, «A method for the construction of minumum-redundancy codes».

6. P. E. Black, «Adaptive Huffman coding,» in Dictionary of Algorithms and Data Structures.

7. P. E. Black, «K-ary Huffman coding,» in Dictionary of Algorithms and Data Structures.

8. M. Golin, C. Kenyon e N. Y. Young, «Huffman Coding with Unequal Letter Costs».

9. I. Witten, R. Neal e J. Cleary, «Arithmetic Coding for Data Compression».

10. J. Ziv e A. Lempel, «A Universal Algorithm for Sequential Data Compression».

11. J. Ziv e A. Lempel, «Compression of Individual Sequences via Variable-Rate Coding».

25

Progetto 3D CloudWiz | ATI NICE - DIEE

12. D. Salomon, «Data Compression: The Complete Reference».

13. J. Storer e T. Szymansky, «Data Compression via Textual Substituion».

14. T. Welch, «A Technique for High-Performance Data Compression».

15. «http://tools.ietf.org/html/rfc1951,» [Online].

16. M. Weinberger, G. Seroussi e G. Sapiro, «The LOCO-I Lossless Image Compression

Algorithm: Principles and Standardization into JPEG-LS».

17. «http://www.hpl.hp.com/research/info_theory/loco/HPL-98-193R1.pdf,» [Online].

18. M. Charrier, D. Santa Cruz e M. Larsson, «JPEG2000, the Next Millenium Compression

Standard for Still Images».

19. «http://www.jpeg.org/jpeg2000/,» [Online].

20. D. Taubman e M. Marcelin, «JPEG2000: Image Compression Fundamentals, Standards and

Practice».

21. AA.VV., «http://www.hpl.hp.com/techreports/2001/HPL-2001-35.pdf,» [Online].

22. AA.VV., «Recommendation T.832 /03/2009, updated 12/2009: Information Technology –

JPEG XR image coding system – Part 2: Image coding specification».

23. AA.VV., «HD Photo: a New Image Coding Technology for Digital Photography».

24. «http://www.dsi.unifi.it/~berretti/download/jpeg-2000.pdf,» [Online].

25. A. Solanki, «Implementation and performance analysis of JPEG2000, JPEG, JPEG-LS, JPEGXR and H.264/AVC Intra frame coding,» [Online].

26. «http://www.ietf.org/rfc/rfc2083.txt?number=2083,» [Online].

27. «http://imagezero.maxiom.de/,» [Online].

28. http://www.squeezechart.com/bitmap.html. [Online].

29. «http://www.imagecompression.info/gralic/LPCB.html,» [Online].

30. «http://fastcompression.blogspot.it/2011/05/lz4-explained.html,» [Online].

31. «https://code.google.com/p/lz4,» [Online].

26

Progetto 3D CloudWiz | ATI NICE - DIEE

32. M. Hasan e K. M. Nur, «A Lossless Image Compression Technique using Location Based

Approach».

33. M. El-Sakka, «Context-based Dictionary Image Compression».

34. AA.VV., «Highly efficient universal coding with classifying to subdictionaries for text

compression».

35. J. Cleary e W. Teahan, «Unbounded length contexts for PPM».

36. J. Larrauri, «A new Algorithm for Lossless Compression applied to two-dimensional Static

Images».

37. J. Larrauri e E. Kahoraho, «A new Method for Real Time Lossless Image Compression

Applied to Artificial Vision».

38. K. Jia, S. Fang e S. Dun, «Fast Lossless Color Image Compressing Method Using Neural

Network».

39. J. Zurada, «Introduction to Artificial Neural System».

40. «http://www.google.it/patents/US3971065,» [Online].

41. K. Chung e Y. Chan, «A Lossless Compression Scheme for Bayer Color Filter Array Images».

42. C. Koh, J. Mukherjee e S. Mitra, «New Efficient Methods of Image Compression in Digital

Cameras with Color Filter Array».

43. H. Malvar e G. Sullivan, «Progressive-to-Lossless Compression of Color-Filter-Array Images

using Macropixel Spectral-Spatial Transformation».

44. C. Flint, «Determining optimal medical image compression: psycometric and image

distortion analysis».

45. J. Janet, D. Mohandass e S. Meenalosini, «Lossless Compression Techniques for Medical

Images in Telemedicine».

46. AA.VV., «Astronomical Image Compression Based on Noise Suppression».

47. T. Lin e P. Hao, «Compound Image Compression for Real-Time Computer Screen Image

Transmission».

27

Progetto 3D CloudWiz | ATI NICE - DIEE

48. AA.VV., «Block-based Fast Compression for Compound Images».

49. C. Taskin e S. Sarikoz, «An Overview of Image Compression Approaches».

50. H. Cai e J. Li, «Lossless Image Compression with Tree Coding of Magnitude Levels».

51. B. Aiazzi, S. Baronti e L. Alparone, «Near Lossless Image Compression By Relaxation Labeled

Prediction».

52. B. Aiazzi, S. Baronti e L. Alparone, «Lossless Image Compression Based on a Fuzzy-Clustered

Prediction».

53. S. Qian, A. Hollinger e Y. Hamiaux, «Study of Real Time Lossless Data Compression for

Hyperspectral Imagery».

54. M. Ciavarella e A. Moffat, «Lossless Image Compression Using Pixel Reordering».

55. AA.VV., «Lossless Image Compression».

56. M. Bhammar e K. Mehta, «Survey of Various Image Compression Techniques».

57. M. Groach e A. Garg, «DCSPIHT: Image Compression Algorithm».

58. M. Ashok e T. Reddy, «Color image compression based on Luminance and Chrominance

using Binary Wavelet Transform and Binary Plane Technique».

59. N. Salam e R. Nair, «An Optimized Real Time Image Codec for Image Data Transmission and

Storage».

60. A. Kaushik e M. Gupta, «Analysis of Image Compression Algorithms».

61. M. Allam e E. Abdel-Ghaffar, «JPEG2000 Performance Evaluation».

28

Progetto 3D CloudWiz | ATI NICE - DIEE

Compressione di immagini generiche a contenuto eterogeneo (compound

images)

Gli algoritmi di compressione illustrati finora applicano lo stesso algoritmo di compressione su

tutto il dato. Questi però, non sono ottimali però nell'applicazione verso le compound image.

Queste ultime sono immagini a contenuto eterogeneo ovvero possono essere composte da diverse

aree contenenti testo, immagini grafiche o fotografie naturali. Due tipici esempi di compound

image sono l'immagine visualizzata nello schermo di un computer ed il sito web di un giornale,

nella figura seguente viene mostrato un semplice esempio.

La compressione di una compound image si basa sul fatto che vengano individuate le varie

29

Progetto 3D CloudWiz | ATI NICE - DIEE

componenti/classi che compongono l'immagine, le quali verranno codificate separatamente

tramite un apposito algoritmo di compressione, differente per ciascuna componente/classe.

Nella prossima sezione verranno presentati i principali approcci proposti in letteratura per

compiere la segmentazione delle compound image.

Metodi di segmentazione delle componenti di un'immagine

Come accennato poco sopra, il primo step da effettuare nella compressione delle compound

image è la classificazione dell'immagine, ovvero l'individuazione di tutte le componenti che

costituiscono la compound image. In relazione a tale classificazione esistono numerosi approcci di

cui i più utilizzati sono i seguenti:

Approccio a oggetti

Approccio a layer

Approccio a blocchi

Approccio ibrido

Approccio ad oggetti

L’approccio a oggetti si propone di suddividere l’immagine in regioni, a loro volta divisibili in oggetti

caratterizzati da bordi perfettamente definiti. Gli oggetti possono essere lettere, fotografie o

elementi grafici. Questo approccio dovrebbe offrire un ottimo rapporto di compressione, in quanto

una volta selezionato correttamente l’oggetto, esso può essere compresso con l’esatto algoritmo

adatto al caso, senza considerare casi in cui la segmentazione non avvenga correttamente. In

pratica la codifica dei bordi delle oggetti risulta essere piuttosto complessa, rendendo poco

vantaggioso questo metodo in quanto fortemente dipendente dallo stato dell'arte attuale delle

tecniche di segmentazione automatica.

Approccio a layer

In questo approccio l'immagine composita viene suddivisa in piani contenenti delle porzioni

dell'immagine di partenza. La ricostruzione avviene attraverso degli layer specifici detti maschere.

Dal punto di vista teorico l'immagine composita può essere suddivisa in un numero di layer che

può dipendere dalla specifica applicazione. Uno dei metodi più diffusi è quello del Mixed raster

30

Progetto 3D CloudWiz | ATI NICE - DIEE

content (MRC) [1] nel quale l'immagine di partenza viene suddivisa nei seguenti layer:

1) Foreground

2) Mask

3) Background

Un semplice esempio può chiarire come viene suddivisa l'immagine composita e come viene

ricostruita nella figura successiva, dove abbiamo un'immagine contenente una porzione di testo di

colore rosa e un'immagine pittorica nella fattispecie un fiore bianco.

Queste tipologie di contenuto sono inserite in uno sfondo azzurro, secondo l'approccio MRC

l'immagine viene suddivisa in tre piani: il primo strato di foreground è costituito da un piano di

colore rosa che quindi conserva l'informazione relativa al colore delle parti di testo.

Esempio di approccio MRC

La maschera è costituita invece da un piano di sfondo bianco con un testo di colore nero che quindi

conserva l'informazione relativa al testo contenuto nell'immagine di partenza. Infine lo strato dello

sfondo è costituito da un piano di colore azzurro nel quale è inserita la componente pittorica, di

conseguenza tale strato conserva l'informazione relativa alla parte pittorica e allo sfondo.

I tre layer ottenuti possono essere quindi compressi separatamente e la ricostruzione può essere

effettuata attraverso la seguente relazione:

I(i, j) = Msk(i, j)FG(i, j) + (1 − Msk(i, j))BG(i, j)

Dove Msk è la maschera contenente il testo mentre FG e BG sono rispettivamente il background e

il foreground.

31

Progetto 3D CloudWiz | ATI NICE - DIEE

La particolare scelta di assimilare l'informazione del colore dello sfondo con la componente

derivante dalle immagini pittoriche deriva dal fatto che la compressione di tali tipologie di

contenuto può avvenire impiegando un singolo compressore.

E' importante soffermarsi su questo aspetto in quanto l'adattamento tra la tipologia di contenuto

del singolo strato ed il metodo di compressione da utilizzare per codificarlo risulta fondamentale in

questo metodo.. In particolare lo scarso adattamento tra metodo di compressione e tipo di dato

gestito può comprometterne l'efficacia, infatti a seconda della stratificazione adottata può capitare

che oggetti di tipo diverso possano risiedere nel medesimo strato che viene compresso attraverso

un singolo metodo di compressione che di fatto risulterà efficace sulla gestione di un solo tipo di

contenuto.

Risulta quindi importante scomporre l'immagine in tipologie di contenuto aventi caratteristiche tali

da sfruttare al meglio le peculiarità dei diversi algoritmi di compressione a disposizione, senza

dimenticare che abbiamo un grado di libertà derivante dalla possibilità di adottare una

stratificazione più o meno profonda. Tale stratificazione ci consente di gestire il giusto contenuto

col giusto metodo di compressione ma va comunque considerato che una suddivisione

dell'immagine di partenza in un numero eccessivo di layer incrementa la complessità e acuisce un

altro aspetto derivante dal fatto che aumentare a dismisura il numero di layer aumenta anche la

ridondanza derivante dalla presenza simultanea di componenti dell'immagine originale in layer

diversi .

Approccio a blocchi

Nella classificazione a blocchi l'immagine di partenza viene analizzata in blocchi di dimensioni

prefissata. Ciascun blocco componente conterrà al suo interno dei punti appartenenti a: testo,

immagini e componenti grafiche.

Quindi ciascun blocco subisce un processo di classificazione nel quale ciascun pixel viene assegnato

ad una tipologia specifica di contenuto. Tale metodo di classificazione ha quindi l'obbiettivo di

identificare le diverse regioni che costituiscono l'immagine composita.

In figura viene mostrato un semplice esempio nel quale si vede chiaramente come l'obbiettivo

della segmentazione sia quello di identificare e separare le regioni dell'immagine di partenza in

32

Progetto 3D CloudWiz | ATI NICE - DIEE

base al contenuto.

Esempio di approccio a blocchi

La conseguenza diretta di tale classificazione è la possibilità di comprimere ciascun tipo di

contenuto con un metodo di compressione specifico consentendo una buona conservazione del

contenuto informativo di partenza. In modo più specifico la classificazione a blocchi ha il vantaggio

di presentare dei metodi di segmentazione tipicamente poco complessi e un buon adattamento tra

metodo di compressione e contenuto gestito.

Lo svantaggio fondamentale risiede nella decomposizione dell'immagine di partenza in blocchi che

non presentano una forma rettangolare e che di conseguenza non consento l'utilizzo di metodi

compressione standard, che tipicamente sono studiati per gestire immagini rettangolari, a meno di

apportare delle modifiche per questo metodo specifico.

Il metodo di classificazione a blocchi rappresenta una buona scelta quando si vogliano costruire dei

compressori, per immagini composite, a bassa complessità.

Approccio ibrido

I metodi di classificazione basati sull'uso congiunto del metodo a blocchi e di quello a layer

risultano relativamente recenti.

Un esempio di approccio ibrido è quello proposto in [2]. Il metodo consiste in un primo passo di

classificazione dell'immagine secondo l'approccio a blocchi, in particolare i blocchi vengono

classificati in:

Sfondo

33

Progetto 3D CloudWiz | ATI NICE - DIEE

Testo

Grafica

Immagini pittoriche

Contenuto misto (overlap)

I blocchi con contenuto misto subiscono un processamento secondo il modello a layer. La sfida

maggiore è ovviamente quella derivante dal blocco di sovrapposizione per il fatto che contiene

contenuti differenti e, quindi, risulta più complessa la gestione in fase di compressione. In

definitiva, tale metodo accomuna le caratteristiche salienti dei metodi di classificazione che lo

compongono e di fatto può rappresentare un miglioramento rispetto a singoli approcci.

Algoritmi proposti in letteratura

In questa sezione verranno mostrate delle applicazioni in relazione ai metodi di segmentazione

analizzati nella precedente sezione, in particolare si cercherà di dare una valutazione di ciascun

metodo in modo da collocarlo in uno specifico ambito applicativo.

Metodi a blocchi

Per prima cosa analizzeremo i metodi proposti in [3], [4] e [5] nei quali viene applicata la

classificazione a blocchi. L’approccio consiste nella suddivisione dell’immagine in un elevato

numero di blocchi rettangolari, i quali verranno quindi singolarmente valutati e classificati come

blocchi di testo, blocchi grafici o blocchi contenenti un’immagine naturale. Il processo di

classificazione dei blocchi viene generalmente svolto utilizzando tre metodi:

Conteggio dei colori

DCT (Discrete cosine transform)

Istogramma

Shape primitive extraction and coding

L'approccio proposto nel 2005 da Tony Lin et al. [3] sfrutta l'analisi a blocchi ed un nuovo

algoritmo chiamato SPEC (Shape primitive extraction and coding). In particolar modo il sistema

ottiene una segmentazione iniziale effettuando il conteggio dei colori in blocchi di 16x16 pixel, e

classificando preliminarmente i blocchi come blocchi di testo o grafici nel caso in cui il numero dei

34

Progetto 3D CloudWiz | ATI NICE - DIEE

colori sia minore di una soglia T1 (gli autori utilizzano 32 come soglia), in caso contrario, il blocco

verrà classificato come blocco fotografico. Viene quindi generato un indice di un byte che viene

associato ai blocchi di testo o grafici. Questa classificazione preliminare risulta essere

estremamente rapida, nonostante alcuni blocchi pittorici siano talvolta catalogati come blocchi

grafici e viceversa. Per questo motivo viene effettuata una seconda segmentazione di rifinitura, in

cui verranno separati i blocchi testuali o grafici erroneamente classificati come blocchi pittorici.

Non viene effettuata la rifinitura per blocchi pittorici classificati come testi, poiché essi non sono

normalmente numerosi, e si tratterebbe solo di una perdita di prezioso tempo computazionale. I

blocchi di tipo testuale/grafico vengono quindi analizzati tramite lo SPEC, algoritmo che consente

di rilevare forme caratterizzate dallo stesso colore. Queste forme verranno analizzate in termini di

grandezza e colore per rilevare possibili elementi testuali o grafici e spostarli quindi fra i blocchi

appositi.

Il seguente schema a blocchi riassume il funzionamento dell’algoritmo SPEC.

35

Progetto 3D CloudWiz | ATI NICE - DIEE

I risultati ottenuti da questo algoritmo sono interessanti, sia in termini di tempo impiegato a

comprimere e decomprimere le immagini, sia in termini di grandezza del file compresso e di

qualità secondo quanto riportato nell’articolo. Due tabelle sono riportate per illustrare i risultati

ottenuti su dieci “Compound Image”.

Per dimostrare la qualità visiva ottenuta dall’algoritmo SPEC viene inoltre riportato nella prossima

figura un paragone fra un’immagine compressa tramite lo SPEC e diversi altri algoritmi.

36

Progetto 3D CloudWiz | ATI NICE - DIEE

Porzione dell'immagine originale (a), compressa tramite JPEG (b), JPEG-2000 (c), DjVu (d), SPEC (e). [3]

Improved block based segmentation and compression techniques for Compound Images

L'approccio presentato in [4] esegue un'analisi a blocchi basata sulla DCT. In particolare una volta

divisa l’immagine in blocchi, viene effettuata la trasformata su ogni blocco singolarmente, e viene

calcolata una variabile chiamata energia dei coefficienti AC (alternate current) nel seguente modo:

37

Progetto 3D CloudWiz | ATI NICE - DIEE

Dove Ys,i è il coefficiente AC del blocco i-esimo. Una volta calcolato tale valore, se esso dovesse

essere minore di una certa soglia, il blocco viene classificato come blocco “regolare”, ovvero un

blocco in cui è presente lo sfondo dell’immagine. Viceversa, il blocco sarà considerato “non

regolare”, e tramite un seguente procedimento di clustering può essere classificato come blocco di

testo/grafico o blocco immagine.

Block-based fast compression for Compound Images

Un metodo, basato su istogramma, è stato proposto da WenpengDing et al. [5] e viene definito BFC

(Block-based fast compression). Anche in questo metodo l’immagine viene suddivisa in blocchi da

16x16 pixel, i quali vengono poi processati per fornire un istogramma raffigurante il gradiente dei

pixel del blocco. In particolar modo, i gradienti vengono suddivisi in base al loro modulo fra “lowgradient”, “mid-gradient” e “high-gradient”.

Un esempio è illustrato nella seguente figura:

Esempio di istogramma di blocco di testo[sinistra], blocco immagine [centro] e blocco ibrido [destra].

Una volta calcolati gli istogrammi, i blocchi potranno essere suddivisi in quattro categorie: blocchi

“regolari”, blocchi di testo, blocchi immagine e blocchi ibridi. Nel caso dei blocchi “regolari”,

l’istogramma sarà caratterizzato principalmente da “low-gradient”. I blocchi di testo avranno dei

picchi nel “low-gradient” e nel “high-gradient”, quelli immagine avranno alti valori di “mediumgradient” e “low-gradient”, mentre i blocchi ibridi avranno entrambe le caratteristiche dei blocchi

di testo e dei blocchi immagine. Una volta classificati i blocchi, essi vengono compressi tramite un

algoritmo specifico asseconda del tipo di blocco. Per quanto riguarda i blocchi “regolari”, essi sono

caratterizzati normalmente da un colore che compare con maggior frequenza, il quale viene

38

Progetto 3D CloudWiz | ATI NICE - DIEE

codificato aritmeticamente, e che riempirà il blocco. Nei blocchi di testo vengono invece rilevati i

quattro colori più frequenti, ed allo stesso modo vengono codificati aritmeticamente, riportando

gli altri pixel con simile colore ad essi. I blocchi immagine vengono compressi tramite JPEG, mentre

quelli ibridi richiedono un algoritmo specifico basato sulla wavelet di Haar, i cui coefficienti

vengono poi compressi algoritmicamente. I rapporti di compressione ottenuti da questo metodo

sono molto elevati, e decisamente migliori di altri algoritmi tradizionali, non adatti alle “Compound

image”. Nella seguente tabella sono riportati i risultati ottenuti dagli autori in termini di fattore di

compressione.

Paragone fra il metodo proposto ed altri metodi di compressione tradizionali. [5]

Metodi a layer

Il metodo proposto in [6], A Layer-based Segmentation Method for Compound Images , si basa

sull'applicazione di filtri per immagini e di operatori morfologici con lo scopo di estrarre il testo

contenuto in immagini composite, in particolare il metodo è concepito per estrarre il testo da

scansioni o riviste.

A tale scopo viene impiegato il metodo MRC (MixedContentRaster), descritto nei paragrafi

introduttivi di questa relazione, che estrae il testo contenuto nell'immagine di partenza

separandola in tre layer: background, foreground e text mask.

I passaggi essenziali effettuati dal metodo per estrarre i tre layer sono i seguenti:

1. L'immagine di partenza viene convertita in scala di grigi.

2. Viene applicato un filtro di Wiener per eliminare rumore di fondo (caso tipico delle

scansioni).

3. Applicazione all'immagine di partenza del binarizzatore di Sauvola che mette in risalto il

39

Progetto 3D CloudWiz | ATI NICE - DIEE

testo.

4. Applicazione all'immagine di partenza dell'operatore di Prewitt che cattura i bordi delle

lettere per ottenere le regioni in cui si trova il testo.

5. Viene applicata un'operazione di dilatazione per aumentare le dimensioni delle aree nel

quale è situato il testo.

6. Vengono applicate delle regole tese ad eliminare aree erroneamente classificate come

testo.

7. Si svolge un'operazione di AND tra l'immagine al punto 3 e quella al punto 6 per estrarre

la maschera di testo.