Mirko Di Bernardo

Complessità e significato nei sistemi biologici

1. La grande domanda

Al libro del 1944 Che cos'è la vita? di Erwin Schrödinger si ascrive il merito di aver ispirato

una generazione di fisici e di biologi alla ricerca della natura fondamentale dei sistemi

viventi. Fu Schrödinger, infatti, ad introdurre in biologia la meccanica quantistica, la

chimica ed il concetto di informazione (in particolar modo a livello embrionale).1 Egli fu

l'antesignano della nostra concezione del DNA e del codice genetico poiché tradusse l'idea

del dire nell'idea del codificare. Dato che un cristallo regolare, pur essendo ordinato, non

può codificare molta informazione, la sostanza del gene, secondo il grande scienziato,

doveva essere una forma di cristallo aperiodico e la forma dell'aperiodicità avrebbe dovuto

contenere una sorta di codice microscopico capace di controllare l'ontogenesi. Inoltre, il

carattere quantistico del solido aperiodico stava a significare che si sarebbero verificati

piccoli cambiamenti discreti: le mutazioni.2

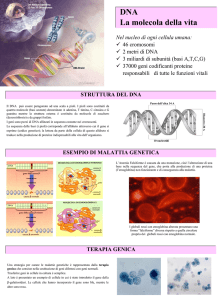

Il 28 febbraio del 1953 Francis Crick entrò nell'Eagle Pub di Cambridge, in Inghilterra,

dichiarando di aver scoperto il segreto della vita. Il 25 aprile dello stesso anno Watson e

Crick pubblicarono sulla rivista Nature un articolo in cui si presentava il modello della

struttura a doppia elica della molecola di DNA.3 Questo modello divenne una sorta di icona

simbolo della rivoluzione scientifica che stava nascendo poiché grazie ad esso fu possibile

comprendere il ruolo e la funzione svolti da questa misteriosa macro-molecola all'interno

della cellula. I due scienziati, infatti, capirono che il DNA, essendo un «archivio di

informazioni» che risiede nel nucleo stesso della cellula, contiene anche le istruzioni

necessarie per potersi auto-replicare. La scoperta della doppia elica del DNA e della sua

particolare proprietà di auto-replicazione, dunque, diedero nascita alla necessità di

giungere ad una delucidazione della natura ultima del codice genetico. Diversi scienziati

lavorarono a questo progetto ambizioso (Watson, Crick, Monod, Gamow, Niremberg e

Wilkins), un progetto che, però, venne realizzato pienamente solo a metà degli anni

sessanta.

Alla fine degli anni sessanta, quindi, fu chiaro che nei sistemi biologici due meccanismi

chiave connettono il linguaggio del DNA con quello delle proteine: la trascrizione dal DNA

all'mRNA e la traduzione dallo mRNA alle proteine. Le originali intuizioni di Schrödinger

erano ormai realtà.

Nasceva così il dogma centrale della biologia molecolare, ovvero la concezione secondo

cui ad ogni gene corrisponde una proteina: il DNA, infatti, codifica le proteine e,

successivamente, le proteine fanno l'organismo. Alla luce di tutto ciò, dunque, possiamo

fare due considerazioni. In primo luogo, è possibile affermare che con la nascita della

biologia molecolare si assiste alla confutazione dell'olismo ingenuo (la prospettiva secondo

cui lo studio delle parti può essere tralasciato poiché il tutto non è riducibile alla somma

delle stesse) e all'apparente vittoria del riduzionismo (la visione secondo cui l'indagine sul

tutto può essere tralasciata poiché quest'ultimo è riducibile alle parti che lo costituiscono) e

del determinismo genetico secondo cui conoscendo le condizioni iniziali di un sistema (in

questo caso i singoli geni di un organismo) è possibile prevederne lo stato finale (nel caso

di un embrione è possibile prevedere con certezza le caratteristiche dell'organismo adulto).

In secondo luogo, risulta opportuno riconoscere il fatto che questa visione nasconde una

forma di materialismo: sotto certi aspetti, infatti, gli organismi viventi e l'uomo sono

semplicemente il risultato della somma dei loro geni i quali, tra l'altro, costituiscono

sequenze di acidi nucleici contenute nei cromosomi (quindi una realtà meramente fisica).

Il DNA, pertanto, rappresenta una semplice molecola costituita da elementi chimici

presenti anche nella materia non vivente.

2. Cibernetica e Biologia

Nel 1970 viene pubblicato dal biologo francese (premio nobel nel 1965) J. Monod il volume

Il caso e la necessità, un testo che avrebbe cambiato il volto della biologia contemporanea.

Il grande biologo francese, infatti, mettendo in stretta relazione la scienza degli automi di

J. von Neumann, la teoria delle macchine di A. M. Turing, la cibernetica di N. Wiener, la

teoria dell'informazione così come elaborata da Shannon e Wiener, la teoria innatistica di

Chomsky e la teoria evoluzionistica di Darwin, di fatto, offre alla biologia la possibilità di

costruire un nuovo paradigma e di individuare un codice per esso. L'intreccio di questi

ambiti di ricerca, dunque, pone le basi per la configurazione della cibernetica come scienza

dell'auto-regolazione in grado di fornire i primi modelli matematici capaci di

«interpretare» la realtà profonda dei processi biologici di auto-organizzazione. Nel suo

volume, inoltre, Monod individua nella teleonomia, nella morfogenesi autonoma e

nell'invarianza riproduttiva le proprietà fondamentali degli organismi viventi, ovverossia

quelle caratteristiche che ci permettono di distinguere con chiarezza ciò che è vivente da

ciò che non lo è.

Qualunque artefatto è il prodotto di un'attività di un essere vivente che esprime in tal modo, e con

particolare evidenza una delle proprietà fondamentali caratteristiche di tutti gli esseri viventi,

nessuno escluso: quella di essere oggetti dotati di un progetto, rappresentato nelle loro strutture e

al tempo stesso realizzato mediante le loro prestazioni, ad esempio la creazione di artefatti.4

Grazie a questa proprietà, ovvero a questa condizione necessaria per definire i viventi a cui

Monod si riferisce con il termine di teleonomia, gli oggetti dotati di un progetto si

differenziano dalle strutture di qualsiasi altro sistema dell'universo. Ciò nonostante, la

teleonomia non è sufficiente a spiegare la differenza tra tali esseri e gli oggetti artificiali,

cioè i prodotti delle loro attività.

Il grande studioso francese allora pone a confronto le strutture e le prestazioni dell'occhio

di un vertebrato con quelle di un apparecchio fotografico e conclude dicendo che se

assumiamo come unico principio di individuazione degli esseri viventi la sola teleonomia

non potremmo che riconoscere tra i due elementi in questione una profonda analogia. Se ci

si limita, infatti, allo studio della struttura di un oggetto e delle sue prestazioni, «possiamo

individuare il progetto ma non l'autore».5 Per cogliere l'autore risulta necessario analizzare

non solo «l'oggetto in sé», ma anche la sua origine e la sua modalità di costruzione. A

questo punto è possibile introdurre la seconda proprietà essenziale che caratterizza un

essere vivente: la morfogenesi autonoma.

La struttura di un essere vivente è il risultato di un processo del tutto diverso (rispetto a quello di

un artefatto), nella misura in cui non deve praticamente nulla all'azione delle forze esterne, mentre

deve tutto, dalla forma generale fino al minimo particolare, a interazioni morfogenetiche interne

all'oggetto medesimo.6

La morfogenesi autonoma è una sorta di determinismo interno degli esseri viventi che

assicura la formazione e la crescita dell'organismo favorendo una «libertà quasi totale»

rispetto alle condizioni esterne. Grazie a questo meccanismo è possibile, secondo Monod,

un parallelismo concreto tra macchine e organismi viventi al punto di definire questi ultimi

«macchine che si costruiscono da sé». Il carattere spontaneo dei processi morfogenetici

degli esseri viventi permette loro di distinguersi dagli oggetti artificiali e dagli oggetti

naturali aventi una morfologia macroscopica dipendente da fattori esterni. Ciò nonostante,

vi è un'eccezione: i cristalli. Tali oggetti naturali sono il frutto di un libero gioco di forze

fisiche alle quali non possiamo attribuire alcun progetto (se si considera valido il principio

cardine su cui si basa la scienza moderna secondo il quale la natura è oggettiva e non

proiettiva) e presentano forme geometriche perfettamente definite poiché la loro struttura

macroscopica riflette direttamente la struttura microscopica semplice e ripetitiva. Così,

in base al solo criterio della morfogenesi autonoma, i cristalli verrebbero classificati tra gli

esseri viventi, mentre gli oggetti artificiali e quelli naturali verrebbero ad essere racchiusi

in un'altra classe perché dipendenti da fattori esterni. Monod, nelle prime pagine del suo

libro, cerca di definire, per mezzo di criteri generali, le proprietà macroscopiche specifiche

che differenziano gli esseri viventi da qualsiasi altro sistema dell'universo, pertanto egli si

immedesima in un programmatore che ignora la biologia occupandosi esclusivamente di

informatica e di informazione. Le strutture complesse degli esseri viventi, infatti,

presentano una cospicua quantità di informazione la cui fonte resta sconosciuta:

Ammettiamo che, proseguendo nella sua indagine, quel programmatore faccia la sua ultima

scoperta, cioè si accorga che l'emittente dell'informazione, che risulta espressa nella struttura di un

essere vivente, è sempre un altro oggetto identico al primo. [...] A questo punto egli ha identificato

la fonte e riconosciuto una terza proprietà notevole di questi oggetti: il potere di riprodurre e di

trasmettere -- ne varietur -- l'informazione corrispondente alla loro struttura. Informazione molto

ricca, poiché descrive un'organizzazione straordinariamente complessa che però si conserva

integralmente da una generazione all'altra. Designeremo questa proprietà con il nome di

riproduzione invariante o, semplicemente, di invarianza. 7

La terza caratteristica essenziale degli esseri viventi è dunque l'invarianza riproduttiva,

grazie ad essa gli organismi viventi e le strutture cristalline si trovano ancora una volta

associati. Nonostante questa stretta somiglianza si deve considerare il fatto che

l'informazione che si trasmette nelle diverse generazioni in tutti gli esseri viventi è

superiore di parecchi ordini di grandezza rispetto a quella contenuta nelle strutture

cristalline; quest'ultimo criterio quantitativo permette di discernere gli organismi viventi

anche dai cristalli. Ma torniamo ad esaminare il concetto di morfogenesi autonoma. Tale

processo misterioso, infatti, secondo Monod, mette in luce l'origine spontanea della forma

dell'organismo, ovvero la sua auto-organizzazione.

A questo punto la domanda è la seguente: quale è la natura delle forze interne che

conferiscono agli esseri viventi la loro struttura microscopica? Le strutture degli organismi

viventi rappresentano una notevole quantità di informazione di cui resta solo da

identificarne la fonte. Ancora una volta, le intuizioni di Schrödinger si sono rivelate,

potremmo dire, «gravide di futuro». Tra la vita e la non vita, infatti, vi è una continuità

quantitativa e materiale (le cellule sono fatte di atomi e molecole), ma anche una

discontinuità qualitativa: la «qualità» dell'informazione fa la differenza. La dottrina

monodiana della morfogenesi autonoma, pertanto, individua nel meccanismo

morfogenetico la base sia della teleonomia, sia dell'invarianza riproduttiva poiché consente

agli organismi viventi la conservazione e la moltiplicazione delle specie. L'organizzazione

globale di un organismo complesso è già contenuta nella struttura dei suoi costituenti e

diviene attuale grazie alle loro interazioni, così, è Monod che parla, la struttura compiuta

non è pre-formata in alcun luogo, ma il suo progetto è presente fin dal concepimento.8 La

struttura compiuta, quindi, si realizza senza immissione di informazioni nuove poiché

l'informazione è presente (ma inespressa) nei costituenti e si rivela solo durante lo

sviluppo. L'essenza dell'auto-organizzazione, quindi, agli occhi del grande biologo, risiede

nel concetto di programma genetico (modello cibernetico applicato alla biologia

molecolare): una guida invisibile in grado di dirigere l'organismo e di spiegarne lo

sviluppo.9 Il Programma genetico, pertanto, viene concepito come un programma di

sviluppo della cellula racchiuso all'interno del genoma. In questo programma scritto con

l'alfabeto dei nucleotidi, dunque, risiedono, per Monod, la fonte e l'apparente finalità dello

sviluppo biologico. Secondo un certo parallelismo è allora possibile paragonare il materiale

genetico di un ovulo al nastro magnetico di un calcolatore. Seguendo questa logica, quindi,

l'organismo vivente viene paragonato ad una macchina: i geni costituiscono l'informazione

genetica presente nel genoma da cui dipende la formazione delle proteine e quella

dell'organismo. Immediatamente dopo il concepimento, infatti, esiste in essenza un

programma completo di sviluppo di un nuovo essere vivente, un programma, vale a dire,

che ha la peculiarità di essere singolare e discriminante di ogni organismo. Da un lato,

quindi, il computer programmato rappresenta, per Monod, un modello perfetto di

macchina finalizzata non cosciente e non intenzionale in grado di realizzare un compito in

maniera perfettamente deterministica, cioè prevedibile, dall'altro la struttura molecolare

del DNA e delle proteine può essere interpretata come un messaggio codificato in cui i

meccanismi di replica del DNA e della sintesi delle proteine sono trattati come casi

specifici di trasmissione dell'informazione lungo canali di comunicazione applicando la

teoria dell'informazione di Shannon: come in un computer, infatti, l'origine delle

determinazioni finalizzate in un organismo vivente si trova in un programma inserito nei

geni.

3. I sistemi complessi

Nel 1963 ha luogo un evento che di lì a poco avrebbe contribuito a cambiare sensibilmente

il modo di guardare la realtà in tutte le scienze, compresa la fisica: Edward Lorenz scopre il

caos deterministico le cui basi erano state poste già da Poincarè nel 1889 con il problema

dei tre corpi.

Lorenz mostrò come per avere un comportamento caotico di un sistema dinamico fosse

sufficiente un modello assai semplice di equazioni differenziali non lineari. In questo caso,

infatti, nonostante il rigoroso determinismo della legge di Newton, ci si trova di fronte ad

un comportamento caotico del sistema provocato dall'estrema sensibilità delle soluzioni

delle equazioni alle condizioni iniziali.

Accade che due stati prossimi quanto si vuole, si allontanano esponenzialmente col tempo.

Dall'impossibilità, non solo pratica, ma di principio, di definire le condizioni iniziali con

precisione infinita, discende dunque una sostanziale imprevedibilità dello stato del sistema

che diventa sempre meno dominabile con il crescere dell'intervallo di tempo trascorso

dall'istante iniziale.

Nascono così in tutte le discipline degli anni 60 e 70 (parallelamente agli studi di Monod)

nuovi linguaggi adatti a rappresentare le proprietà dei sistemi caratterizzati da una

complessità funzionale e strutturale che impedisce di dedurle da quelle dei loro

componenti. Esse si basano sull'insufficienza del riduzionismo come unico metodo

scientifico valido accettando l'irriducibilità dei diversi livelli di organizzazione di tali

sistemi e l'impossibilità di trovare spiegazioni esaurienti delle loro proprietà senza

ricorrere a categorie storico-evolutive (gli organismi biologici, la mente, l'organizzazione

sociale, le economie). Questo nuovo modo di indagare la realtà che è stato definito da

alcuni studiosi la «sfida della complessità» porta a ritenere che i fenomeni semplici,

manifestazioni di leggi naturali universali, che per la scienza classica erano la regola, siano

in realtà rare eccezioni.10 Tutto ciò impone, allora, una nuova caratterizzazione del tempo:

il tempo della meccanica classica e relativistica è una semplice variabile nelle equazioni del

moto, fluisce in modo uniforme, non è apportatore di novità, in quanto tutta

l'informazione è contenuta nelle condizioni iniziali. Oggi, invece, si impone un nuovo

concetto di tempo, poiché la maggioranza dei fenomeni chimici, fisici e biologici non si

spiegano in termini di «leggi» ma di «processi», in cui il tempo è continuamente

apportatore di nuove informazioni, poiché nel tempo si determinano le «scelte» del

sistema, che vanno a costituire la sua «storia», secondo una evoluzione non predicibile a

partire dalle condizioni iniziali.

Ad Ilya Prigogine, premio Nobel nel 1977, si deve l'applicazione dei sistemi complessi in

ambito biologico; in particolare, egli si è occupato dello studio di sistemi ordinati in nonequilibrio. Un esempio di struttura continua in non-equilibrio è dato dalla Grande Macchia

Rossa di Giove che è essenzialmente un sistema di tempeste presente da diversi secoli. Si

tratta di un organizzazione stabile di materia ed energia attraverso cui entrambe fluiscono.

La similitudine con un organismo umano le cui componenti molecolari cambiano molte

volte durante il corso della vita è suggestiva.

I sistemi termodinamici in non equilibrio, quindi, sono alimentati dalla costante

dissipazione di materia ed energia, pertanto vennero chiamati da Prigogine strutture

dissipative, ovvero sistemi in cui il flusso di materia ed energia diviene una forza trainante

in grado di generare ordine:

Questo è uno stato di cose paradossale che sfida la nostra intuizione del comportamento delle

popolazioni numerose. Al caos indifferente dell'equilibrio segue un caos creatore simile a quello

evocato da alcuni presocratici, un caos fecondo, da cui potenzialmente possono uscire differenti

strutture.11

I sistemi viventi, dunque, in accordo a Prigogine, sono strutture dissipative (vortici

metabolici complessi). Le cellule, infatti, sono strutture dissipative in non equilibrio,

ovvero sistemi chimici complessi che metabolizzano di continuo le molecole nutritive per

mantenere la loro struttura interna e riprodursi. Invece, per la maggior parte delle cellule

l'equilibrio corrisponde alla morte. Per Prigogine, quindi, vi è uno stretto legame tra autoorganizzazione e distanza dall'equilibrio, tuttavia la vita costituisce un eccezionale stato

della materia:

Può darsi benissimo che l'ordine, la coerenza si situino in un certo senso tra il caos dell'equilibrio

termico ed il caos turbolento del non-equilibrio. Tuttavia questi due tipi di disordine sono assai

differenti. Nel caos termico che ha luogo nei sistemi in equilibrio, tutte le scale spazio-temporali

caratteristiche sono dell'ordine di grandezza molecolare, mentre nel caos turbolento abbiamo

anche scale spazio-temporali d'ordine macroscopico. Da questo punto di vista, la vita con la sua

coerenza caratteristica sembra appartenere ad un tipo di regime intermedio. La distanza

dall'equilibrio è sufficiente ma non eccessiva, cosicché si evita la distruzione della delicata

configurazione necessaria a mantenere le normali funzioni viventi.12

Lo stato vivente della materia, dunque, è uno stato di transizione tra ordine e caos: la vita,

infatti, emerge proprio sull'orlo del caos, dove cioè la materia diviene in grado di percepire

e comunicare. La vita, pertanto, si trova in uno stato intermedio tra l'ordine del cristallo ed

il disordine dell'anello di fumo, è proprio lì infatti che emergono i comportamenti

complessi. (il cristallo a-periodico di Schrödinger ha anticipato la storia). A partire dagli

studi di Prigogine, quindi, ha inizio quella che alcuni studiosi chiamano la scienza della

complessità, la quale, in ambito biologico, si svilupperà negli anni novanta grazie anche al

notevole contributo offerto dalle ricerche portate avanti presso il Santa Fe Institute dal

biochimico S. Kauffman. Il grande studioso americano, infatti, nel volume del 1995 dal

titolo A casa nell'universo. Le leggi del caos e della complessità così scrive:

Proprio in mezzo, proprio vicino alla transizione di fase, proprio ai confini del caos, possono

verificarsi i comportamenti più complessi: abbastanza ordinati da assicurare una stabilità, ma pieni

di flessibilità e sorprese. Questo è veramente ciò che intendiamo per complessità.13

Nell'ambito della teoria della complessità, pertanto, in accordo con Kauffman, la vita

appare come

un fenomeno emergente che si sviluppa quando la diversità molecolare di un sistema chimico prebiotico supera un dato livello di complessità. Se questo è vero, allora la vita non si trova nelle

proprietà individuali di ogni singola molecola (nei dettagli) ma è una proprietà collettiva di sistemi

di molecole interagenti tra loro. In quest'ottica, la vita è emersa per intero ed è sempre rimasta un

tutt'uno. In quest'ottica, essa non deve essere ricercata nelle sue parti, ma nel complesso delle

proprietà emergenti che creano il tutto. [...] Nel tutto che emerge e si auto-riproduce non è

presente alcuna forza vitale o sostanza estranea. E tuttavia, il sistema complessivo possiede una

sorprendente proprietà che è assente in ognuna delle sue parti: può riprodurre se stesso ed

evolversi. Il sistema complessivo è vivo, mentre le sue parti non sono altro che molecole

chimiche.14

Alla luce di tutto ciò, dunque, possiamo affermare che i sistemi biologici sono sistemi

complessi, non lineari (impredicibili), dissipativi (che scambiano energia con l'esterno),

capaci di generare informazione (dal caos si genera l'ordine): nelle dinamiche caotiche,

infatti, è possibile separare i flussi energetici da quelli informazionali, reciprocamente

indipendenti.15

I sistemi viventi, quindi, sono sistemi complessi che generano costantemente nuova

informazione. La vita, allora, non può essere più spiegata attraverso l'idea monodiana di

un compromesso tra caso e necessità, invarianza e metamorfosi, bensì può essere

«interpretata» come un ordine che, emergendo dal caos, è in grado di auto-assemblarsi in

modi sempre diversi producendo altresì un tipo di informazione non più misurabile

attraverso la tradizionale teoria di Shannon e Wiener basata, cioè, su un tipo di

matematica troppo semplice. A differenza di quanto pensava Monod, infatti, in un sistema

complesso la novità dell'informazione è intrinseca alla dinamica del processo (per esempio

nell'ontogenesi). In altre parole, il sistema ridefinisce continuamente lo spazio delle

alternative e non può essere in alcun modo paragonato ad un programma che, come è noto

a tutti, si basa su regole predefinite a priori. Si passa così dal modello deterministico in cui

tutto è platonicamente prestabilito (es. le idee immutabili presenti nell'Iperuranio),

all'interpretazione del DNA come sistema complesso capace di creare sempre nuovi

significati (informazione qualitativamente sempre differente). La nuova visione, allora,

sarà quella legata non più ad un programma deterministico, bensì ad un fascio di capacità

(possibilità imprevedibili), vale a dire a regole capaci di auto-regolarsi e di mutare in

relazione all'ambiente.

4. La rivoluzione semantica in biologia

Nonostante la scoperta dei sistemi complessi in fisica, fino alla metà degli anni novanta del

Novecento, in biologia la diatriba tra la visione riduzionistica e quella portata avanti dai

teorici della complessità è continuata in modo ininterrotto. Con l'analisi relativa ai risultati

ottenuti dal Progetto Genoma Umano, però, sia il riduzionismo che l'olismo ingenuo (già

confutato nel 1953) vengono definitivamente superati da una nuova sintesi teorica che,

sulla base dei risultati ottenuti dalla scienza della complessità, fa i conti con l'idea di

emergenza del significato in cui le parti ed il tutto interagiscono reciprocamente dando

luogo ad una circolarità sistemica (una nuova visione sistemica che tiene insieme olismo e

riduzionismo).16 Così, il modello monodiano di programma genetico viene sostituito da

quello di programmi distribuiti legati a funzioni di auto-programmazione.

A caratterizzare il bios, dunque, non è più soltanto la teleonomia così come concepita da

Monod (progettualità priva di intenzione), bensì comincia a delinearsi l'idea secondo cui la

vita sia imprescindibilmente legata all'idea di significato, di memoria e di intenzionalità

(es. dalla cellula, al sistema immunitario, agli apparati, fino ad arrivare alla mente). Ma

facciamo un passo indietro. Come abbiamo dinanzi accennato, nel 1990 nasce l'HGP

(Human Genome Project). Il genoma è il complesso dei geni di un individuo. I geni

rappresentano frasi di senso compiuto localizzate e riconosciute da sofisticati software

all'interno della sequenza di basi nucleotidiche. La missione del progetto era quella di

sequenziare il genoma umano e altri organismi con il fine di svelare la mappa genetica che

dice chi siamo; si pensava, cioè, che le sequenze avrebbero fornito tutta l'informazione

necessaria per comprendere l'informazione biologica. Nel 1996 venne sequenziato il lievito

di birra, nel 2000 il moscerino della frutta, nel 2001 il batterio E. Coli ed infine nel 2003 è

toccato all'Homo sapiens (gli ultimi geni codificati risalgono al 2004). I risultati di tali

ricerche, però, anziché dare ragione al riduzionismo, lo mettono definitivamente in

questione segnando così l'inizio di una nuova era: l'essere umano, infatti, non è riducibile

ad una semplice sequenza sintattica di informazioni. Le ricerche hanno evidenziato tre

grandi paradossi su cui vale la pena riflettere. Il primo concerne il numero dei geni, ovvero

l'apparente mancanza di relazione tra il numero dei geni di una determinata specie e quello

che si suppone dovrebbe possedere in relazione alla sua apparente complessità biologica.

Se, dunque, l'uomo (30000 geni) e lo scimpanzé condividono oltre il 98, 5% di geni dove

risiede la differenza tra gli esseri umani e gli altri primati? Il secondo riguarda il numero

delle proteine in relazione al numero dei geni: se, infatti, ad un gene corrisponde una

proteina per quale motivo negli organismi complessi il numero di proteine è del 25% più

grande del numero dei geni? Infine, il terzo fa riferimento ai risultati delle tecniche knockout (tecniche per la distruzione mirata di determinati geni). Tali tecniche permettono di

studiare le funzioni di determinati geni negli organismi viventi. Ad esempio, l'eliminazione

in un mammifero vivo di alcuni geni le cui funzioni sono ritenute essenziali non produce

l'effetto previsto. In alcuni casi la sostituzione di un gene strutturale con una copia

anomala non ha alcun effetto. Per quale ragione? Sulla base dei risultati dell'HGP, gli

studiosi della teoria della complessità biologica sono riusciti a risolvere i paradossi or ora

accennati analizzando: a) la funzione dei singoli geni (costruzione di un enzima) e b)

l'intero genoma (costruzione di un organismo).

Nel primo caso abbiamo che la risposta si trova nella struttura delle reti geniche, nei modi

in cui i geni sono collegati ad altri da meccanismi regolatori complessi che nelle loro

interazioni determinano quando e dove un particolare gene sarà espresso.

Se la genomica strutturale, che studia le sequenze del genoma (fisse) per scoprirne gli

aspetti e le attività di base, ha dato il la all'HGP, oggi tale progetto apre le porte ad una

nuova indagine: la genomica funzionale.

Per quasi cinquant'anni ci siamo illusi che la scoperta delle basi molecolari dell'informazione

genetica avrebbe svelato il segreto della vita, che bastasse decodificare il messaggio nella sequenza

dei nucleotidi del DNA per capire il programma che fa di un organismo ciò che è. Ci stupiva che la

risposta fosse così semplice. [...] Ora che cominciamo a misurarne l'ampiezza, ci stupisce non la

semplicità dei segreti della vita ma la loro complessità.17

La genomica funzionale rappresenta lo studio della vita cellulare nei suoi diversi livelli,

nelle complesse interazioni tra le molte componenti del sistema. In tal senso allora uno

degli assunti della genetica molecolare non è esattamente valido: un gene, infatti, può

essere coinvolto nella sintesi di molte proteine (anche 100), al contrario una proteina può

avere a che fare con più geni ed i frammenti di DNA possono venire riorganizzati e

trascritti in molti modi diversi. (Ecco perché il numero di proteine è più grande del numero

dei geni).

Da quando è stato introdotto il termine gene, la fiducia nella sua realtà fisica è stata sempre

accompagnata dal presupposto che struttura, composizione materiale e funzione erano le proprietà

di un singolo oggetto, infilato come una perla su un filo o segmento di DNA. Oggi quell'unica

identità è crollata: abbiamo imparato che la funzione non è bell'e mappata sulla struttura e non

coincide con un locus prestabilito del cromosoma. Se mai volessimo pensare ancora al gene come

ad un'unità di funzione, possiamo anche chiamarlo gene funzionale. Ma non possiamo più

ritenerlo identico all'unità di trasmissione responsabile della memoria intergenerazionale o

associarlo a essa. Il gene funzionale potrebbe non avere alcuna fissità: spesso ha un'esistenza

transitoria e contingente che dipende fortemente dalla dinamica funzionale dell'intero

organismo.18

Alla luce di tutto ciò, l'antico postulato dei bio-chimici, «un gene, una proteina» non è

esattamente valido: i geni, pur contenendo le informazioni per la sintesi di una sola

molecola proteica, non segnano più il destino di un organismo. Nel complesso ambiente

cellulare le proteine possono essere ripetutamente modificate e questo accade persino nei

batteri. La fonte della stabilità genetica, quindi, non si trova nella «struttura di un'entità

fissa», bensì diviene il risultato di un «processo dinamico». Accanto al gene strutturale

(aspetto sintattico dell'informazione genetica dipendente dalla sequenza del DNA), quindi,

come abbiamo visto, c'è il gene funzionale (aspetto semantico del bios) il quale, non

avendo alcuna fissità, ha un'esistenza transitoria e contingente che dipende dalla dinamica

funzionale dell'intero organismo. Ecco allora che, non potendo ritenere il gene strutturale

(studiato da Monod e dalla genetica molecolare) identico all'unità di trasmissione

responsabile della memoria intergenerazionale, la differenza tra uomo e scimpanzé non

risiede a livello della genomica strutturale, bensì è possibile rintracciarla nella nozione

affascinante di significato biologico.

I risultati accumulati nei decenni scorsi ci costringono a pensare il gene come almeno due entità

ben diverse: una strutturale, il cui mantenimento è affidato al macchinario molecolare della cellula

perché venga trasmesso fedelmente da una generazione all'altra; e una funzionale che emerge

soltanto dall'interazione dinamica tra numerosi giocatori, fra i quali il gene strutturale da cui sono

derivate le sequenze originarie delle proteine. [...] La funzione di un gene strutturale dipende non

soltanto dalla sua sequenza, ma dal suo contesto genetico, dalla struttura cromosomica in cui è

inserito [...], e dal contesto citoplasmico e nucleare specifico di un determinato sviluppo.19

Evelyn Fox Keller, dunque, mettendo in stretta relazione la teoria delle strutture

dissipative di I. Prigogine e lo studio dei sistemi auto-poietici di H. Maturana e F. Varela,

nonché gli studi di cibernetica, di biologia molecolare, la bio-matematica, la bioinformatica e la semantica funzionale, contribuisce ad ampliare l'articolazione della teoria

della complessità facendo vedere come tale teoria non si riferisca più soltanto alla semplice

indagine di fenomeni a carattere dissipativo di stampo markoviano, bensì si allarghi

prendendo in esame anche i fenomeni di trasformazione dell'informazione così come essi

si generano a partire dalla costituzione di un sistema biologico di elaborazione

dell'informazione stessa. I sistemi naturali sono caratterizzati dal fatto che ciò che si autoorganizza al loro interno è la funzione stessa che li determina con il loro significato. Alla

luce di queste considerazioni lo studio della funzionalità del genoma costituisce la vera e

propria chiave di ingresso dell'indagine scientifica all'interno della complessità dei sistemi

biologici.

I biologi parlano di splicing alternativo, a proposito della costruzione, a partire da una singola

trascrizione iniziale, di trascrizioni di mRNA diverse; a loro volta queste trascrizioni mature

portano alla sintesi di proteine diverse. Un terzo dei geni eucaristici sono soggetti a queste letture

variabili, in cui la decisione su come leggere la trascrizione primaria è essa stessa attentamente

regolata in base allo stato e al tipo di cellula. [...] In soldoni, secondo il contesto e lo stadio di

sviluppo dell'organismo in cui la trascrizione primaria si trova, vari suoi pezzi possono essere

tagliati e incollati a formare matrici varie per costruire proteine altrettanto varie. Una variazione

aggiunta può essere generata in primo luogo dalla presenza sulla trascrizione primaria di più di un

sito nel quale la trascrizione matura può iniziare, e in secondo luogo dalla presenza di molteplici

siti nei quali questa trascrizione può essere spezzata. [...] quante proteine diverse possono essere

sintetizzate a partire da una stessa trascrizione primaria? Il numero varia parecchio da un

organismo all'altro, e ogni giorno che passa sembra aumentare. Vent'anni fa le varianti dello

splicing si potevano identificare soltanto attraverso analisi di laboratorio delle trascrizioni del

mRNA e delle proteine, oggi si possono desumere dai dati sulle sequenze forniti dal Progetto

genoma umano. Perciò la quantità delle varie proteine ipoteticamente associate con un

determinato gene è cresciuta rapidamente, e per certi organismi si parla ormai di centinaia.20

Con il termine splicing (saldatura), dunque, in biologia si intende il processo di

eliminazione degli introni da una catena di RNA-immaturo con conseguente giuntura degli

esoni. Gli esoni sono regioni del gene realmente codificanti a differenza degli introni che

non codificano. Durante la fase della trascrizione della sintesi proteica, negli eucarioti, sia

gli esoni che gli introni vengono trascritti in un lungo filamento di RNA-immaturo. Questo

filamento immaturo viene processato dagli spliceosomi, un numero di complessi speciali

proteine-RNA, che hanno il compito di tagliar fuori dalla catena gli introni e ricongiungere

gli esoni, ovvero le zone codificanti. Alcuni introni, definiti self-splicing, sono capaci di

portarsi fuori dalla catena e ricongiungere i due esoni adiacenti. La procedura necessaria

per l'eliminazione degli introni può essere non perfettamente funzionale a causa di un

errato corredo enzimatico che ha il compito di togliere «fisicamente» l'introne dalla catena

o a causa di una errata forma dell'introne che, ad esempio, si presenta con una mutata

sequenza biochimica. Lo splicing alternativo, come abbiamo visto attraverso le parole della

Keller, è il meccanismo con il quale si procede nella maturazione dell'RNA-immaturo e, in

base all'entità della mutazione funzionale dell'apparato trascrittore, può continuare sia

includendo l'introne, che a tutti gli effetti potrebbe portare alla codifica di una proteina, sia

alla delezione dell'introne o alla delezione dell'introne con una parte più o meno ampia

dell'esone.

In alcuni organismi, per esempio, trascrizioni mature si formano unendo gli esoni provenienti da

due trascrizioni primarie distinte. Fatto ancora più clamoroso, perfino la trascrizione reincollata

può essere successivamente modificata dall'inserimento di basi estranee o dalla sostituzione di una

base con un'altra, e dare luogo così a proteine per le quali non esistono corrispondenti sequenze

codificanti nel DNA. [...] Questo ci costringe ad abbandonare l'idea che un gene, e perfino un gene

strutturale, faccia un enzima o una proteina. Un gene può essere usato per fare svariate proteine e

nella letteratura, infatti, l'espressione sempre più usata è «un gene-molte proteine», una formula

che però sottrae al gene gran parte della sua specificità e causalità. Insomma, un gene dovrebbe

fare quale proteina e in quali circostanze? E come fa a scegliere? Non sceglie. La decisione non

spetta al gene ma alla complessa dinamica regolatrice dell'intera cellula. Da questa proviene il

segnale (o i segnali) per determinare la configurazione specifica della trascrizione finale. Districare

la struttura di questa segnaletica è diventato uno degli scopi principali della biologia molecolare

contemporanea e, anche se rimane forte la tentazione di ordinare i percorsi dei segnali come

sequenze lineari di eventi dovuti all'azione di altri geni ancora, i risultati che provengono dai

laboratori rendono quell'allineamento sempre più arduo. Un'alternativa ovvia sarebbe quella di

considerare come il gene «vero» la trascrizione matura del mRNA, dopo revisione e splicing. I

biologi molecolari lo fanno spesso, ma c'è un problema: nello zigote appena formato questi geni

esistono soltanto come possibilità, progettati post hoc. Ci si può aiutare con un'analogia musicale:

nel nostro caso non solo la musica scritta sulla partitura non esiste finché non viene suonata, ma i

suonatori riscrivono la trascrizione del mRNA (la partitura) mentre la eseguono. Inoltre, questi

geni non hanno affatto la permanenza che ci si aspetta solitamente dai geni, sono trascrizioni

riviste di mRNA chiamate ad esistere soltanto quando servono e per breve tempo. In alcuni casi

non stanno nemmeno sul cromosoma e nemmeno nel nucleo. Cioè, la versione finale della

trascrizione può essere assemblata soltanto dopo che la versione originale è penetrata nel

citoplasma.21

Analizzando il genoma umano ci si è accorti che rispetto ai geni codificanti (esoni o geni

strutturali) condivisi quasi totalmente con lo scimpanzé, nell'uomo aumentano i geni

funzionali ed in particolare quello che alcuni studiosi definiscono DNA spazzatura, ovvero

il numero di regioni non codificanti (introni). Recenti studi, confermando le geniali

intuizioni della Keller, hanno mostrato che il numero elevato di proteine prodotte nelle

cellule umane e la maggiore complessità che caratterizza i nostri sistemi dipendono

proprio dal DNA spazzatura che nella nuova visione sistemica diviene fondamentale.22 Gli

esoni costituiscono meno del 2% del nostro genoma, mentre gli introni ne rappresentano

circa il 25%. Fin dal momento della loro scoperta, nel 1978, gli intoni sono stati considerati

DNA spazzatura (insieme alla restante parte di DNA che non contiene geni). In questi

ultimi anni il completamento delle sequenze genomiche di altri organismi (cane,

scimpanzé e topo) ha consentito di confrontarle con quella umana (genomica

comparativa). Ebbene, le sequenze che hanno una funzione vengono conservate, ovvero si

modificano poco tra i diversi organismi durante il processo evolutivo: le sequenze degli

esoni, che servono a codificare proteine, sono risultate, infatti, molto simili alle diverse

specie. Le sequenze degli introni, invece, in accordo con la Keller, non sono inutili, al

contrario contengono informazioni importanti per il funzionamento dei nostri 30000 geni.

Non è, infatti, tanto il numero dei geni quanto il modo in cui il loro funzionamento è

regolato a rendere l'uomo uomo, il cane cane e lo scimpanzé scimpanzé.

Nel secondo caso (analisi della funzione dell'intero genoma) abbiamo che i sistemi

biologici costituiscono il risultato dell'interazione tra le loro molte componenti: geni

(strutturali e funzionali), mRNA e tRNA, proteine e metaboliti. Per sondare la complessità

della dinamica dello sviluppo occorre insistere sul fatto che la sequenza del genoma

dipende dall'uso strumentale dei dati della sequenza stessa. Non esiste più il gene

architetto, non c'è un controllo centralizzato: lo sviluppo dipende dalla complessa

interazione tra le funzioni locali. La genomica funzionale mette in questione l'idea di

programma e propone un'accezione più distribuita del controllo delle funzioni biologiche.

La stabilità del genoma non è, allora, il punto di partenza, bensì costituisce il prodotto

finale di un processo dinamico altamente orchestrato che richiede la partecipazione di un

gran numero di enzimi organizzati in reti metaboliche complesse le quali assicurano sia la

stabilità della molecola di DNA che la sua replicazione fedele.

Proprio nel decennio in cui i biologi molecolari si entusiasmavano per il programma genetico, la

metafora veniva usata in maniera ben diversa, nel senso di programma di sviluppo, dagli

informatici e dai biologi dello sviluppo. Contrariamente al programma genetico, quello di sviluppo

non si trovava in un luogo ben definito (per esempio nel genoma) ma era distribuito in tutto l'ovulo

fecondato.23

Secondo questa prospettiva, quindi, le informazioni non si trovano in luoghi specifici e

determinabili, al contrario il sistema agisce come un insieme dinamico all'interno del quale

ogni particolare diviene indispensabile nel momento in cui entra in interazione con gli altri

dando nascita, così, ad una complessa auto-organizzazione: ecco delinearsi, dunque, la

fondamentale nozione di programmi distribuiti.

Se vogliamo conservare la metafora del calcolatore, potremmo descrivere l'ovulo fecondato con un

massiccio elaboratore multi strati, in cui programmi (o reti) e dati sono distribuiti in parallelo in

tutta la cellula. In questo caso, il ruolo dei dati e del programma sono relativi: ciò che conta come

dati in un programma è spesso il prodotto di un secondo programma, e il prodotto del primo serve

spesso da dati per un terzo oppure proprio per il primissimo programma che ha fornito i dati

iniziali.24

In quest'ottica, dunque, il programma di sviluppo non si trova in un luogo ben definito (nel

genoma), bensì è distribuito in tutta la cellula (ovulo fecondato). L'informazione non

risiede più in luoghi precisi e determinabili, al contrario, il sistema agisce come un sistema

dinamico all'interno del quale ogni particolare diviene indispensabile nel momento in cui

entra in interazione con gli altri dando nascita, così, ad una complessa autoorganizzazione.

Il DNA fornisce le sequenze originali (il codice sorgente, per dirla con gli informatici) usate nella

costruzione di molte delle proteine che partecipano alle interazioni, ma le sequenze rilevanti sono

sparpagliate in tutto il genoma. Inoltre la dinamica dell'interazione tra proteine e siti di legame del

DNA -- per esempio se una proteina funziona da attivatore o da inibitore -- è spesso determinata da

caratteristiche della struttura proteica che sono esse stesse soggette a regolazione cellulare.25

5. La nuova visione sistemica

Secondo questo nuovo modello interpretativo in cui si fanno i conti con le qualità

emergenti, la vita non solo è legata ad un programma scritto nella doppia elica, ma,

soprattutto, alla circolarità di programmi distribuiti legati a funzioni di autoprogrammazione, ovvero all'idea di significato biologico.

I modelli di auto-organizzazione consentono di vedere negli organismi viventi non più una sorta di

automi diretti da un programma determinista fornito dall'esterno, alla maniera dei computer

attuali, bensì dei sistemi auto-organizzatori i cui principi stanno iniziando a diffondersi nelle

ricerche nel campo dell'intelligenza artificiale. In termini assai generali ciò che caratterizza l'autoorganizzazione è uno stato ottimale che si situa fra i due estremi di un ordine rigido, inamovibile,

incapace di modificarsi senza essere distrutto, come è l'ordine del cristallo, e di un rinnovamento

incessante e senza alcuna stabilità, rinnovamento che evoca il caos e gli anelli di fumo.

Evidentemente questo stato intermedio non è fisso, ma consente di reagire a perturbazioni casuali

non previste attraverso mutamenti di organizzazione che non siano una semplice distruzione

dell'organizzazione preesistente, bensì una ri-organizzazione che consenta l'emergenza di nuove

proprietà. Queste nuove proprietà possono essere una nuova struttura, o un nuovo comportamento

condizionato a sua volta da nuove strutture: e le strutture o i comportamenti sono nuovi nel senso

che a priori nulla consentiva di prevederli nei loro particolari e nelle loro specificità. 26

L'informazione genetica dell'organismo, dunque, non risiede nelle condizioni iniziali del

processo dinamico dell'ontogenesi, bensì in programmi distribuiti che governano nuova

informazione e che rendono impossibile, date le condizioni iniziali, la previsione certa dello

stato finale dell'organismo in questione. Oggi siamo a conoscenza del meccanismo

nascosto che permette al DNA, attraverso il codice genetico, di controllare la sintesi delle

proteine: nella dinamica dell'auto-programmazione, infatti, è la stessa funzionalità del

genoma che crea l'informazione genetica.

L'aspetto più importante dei fenomeni di auto-organizzazione è l'auto-creazione del senso, cioè la

creazione di nuovi significati nell'informazione trasmessa da una parte a un'altra parte o da un

livello di organizzazione a un altro livello di organizzazione. [...] Perché dunque una

disorganizzazione sia in grado di produrre una riorganizzazione, è necessario che si trasformi il

significato delle relazioni fra le parti. È questo il motivo per cui la questione della creazione dei

significati si trova al centro dei fenomeni di auto-organizzazione.27

Il segreto dell'auto-organizzazione che sfuggiva a Monod, infatti, porta il nome di

significato biologico, ovvero quella funzione creatrice che genera la sintassi (l'informazione

genetica dei nucleotidi del DNA) e che è alla base della vita. Il significato biologico,

dunque, è il «volto nascosto» dell'informazione genetica, ovvero quella funzione creatrice

ed organizzatrice che risponde ad una matematica per tanti aspetti ancora sconosciuta, una

matematica, ad esempio, dell'infinito che vada oltre i teoremi di Cantor e la stessa teoria

della complessità di Kolmogorov, in grado di dare ragione di quei fenomeni altamente

complessi, non prevedibili e attualmente non completamente spiegabili dalla ragione

umana. Abbiamo attribuito il termine di realtà profonda a questo fondamento della vita

che esiste, ma non è comprensibile, una realtà che sfugge alla biologia, alla matematica,

alla fisica e alla chimica e che, tuttavia, ci consente di studiare la vita come un fenomeno

emergente, ovvero come un ordine gratuito ed irriducibile. La nozione monodiana di

invarianza viene ora rivisitata alla luce di quella di emergenza del significato la quale,

superando il determinismo genetico, la completa.

La vita è un fenomeno emergente legato a sistemi complessi adattativi. Il DNA non è un

programma fisso che dice quello che siamo, bensì costituisce un fascio di capacità: la logica

del bios si fonda, infatti, sul concetto chiave di possibilità. Ecco allora che le modellazioni

matematiche (le catene di Markov e l'algebra di Boole) che consentivano a Monod di

interpretare i processi stocastici dell'espressione genica non sono più sufficienti.28 La

nozione di «caso», secondo il modello di tipo Markoviano, equivale a considerare una

scelta non nota a priori tra alternative già costituite a priori. La contraddizione, allora, è

tutta logico-epistemologica, poiché il caso così concepito non riesce ad essere sufficiente

per spiegare il divenire in natura: se infatti le alternative sono costituite a priori, come si fa

a prevedere l'auto-organizzazione degli organismi? In un sistema complesso, come

abbiamo visto, la novità dell'informazione è intrinseca alla dinamica del processo. In altre

parole, il sistema ridefinisce continuamente lo spazio delle alternative. Alla luce di tutto

ciò, dunque, H. Atlan ed A. Carsetti affermano che «auto-organizzazione significa

permettere al caso di acquisire un significato, a posteriori ed in un determinato contesto di

osservazione.»29 I sistemi biologici, infatti, sono il risultato di complesse interazioni che si

danno al livello della molteplicità immensa delle loro componenti poiché né sono

equivalenti alla somma delle loro parti, né sono determinabili in base alle sole condizioni

iniziali. Dal riduzionismo e dall'olismo ingenuo si giunge, quindi, ad una visione sistemica

secondo cui la vita appare come un fenomeno di transazione, ovvero il risultato di una

serie di accomodamenti che costituiscono e modificano imprevedibilmente le parti del

gioco stesso. La vita è, dunque, a nostro giudizio, un processo di svelamento estatico in cui

il significato si ri-vela nel tempo. Questa nuova visione sistemica inscindibilmente legata

allo studio del significato, dunque, costituisce, tra l'altro, uno degli attuali tentativi di

rispondere alla domanda di Schrödinger, una domanda, che, come abbiamo già detto, ha

inquietato ed entusiasmato al tempo stesso l'essere umano fin dall'alba della nostra civiltà:

basti pensare alle ricerche scientifiche di Anassimandro. Lungo il corso di questa disamina

abbiamo avuto la possibilità di mostrare, sulla scorta dell'opinione di illustri studiosi, come

per fare, oggi, i conti seriamente con la domanda Che cos'è la vita? si sia costretti a non

rinchiudersi nella pura biologia e ad aprirsi, quindi, ad altri saperi, alcuni classici come la

fisica, la chimica e la matematica ed altri, invece, più recenti come, ad esempio, la scienza

dell'informazione, la bioinformatica e la scienza del caos deterministico. Nonostante i passi

da gigante compiuti dalla scienza da trent'anni a questa parte siamo, tuttavia, ancora molto

lontani da una risposta adeguata a questa domanda: a tutt'oggi, infatti, non esiste una

risposta a carattere compiuto, esistono al contrario fasci correlati di ipotesi, agglomerati di

ardite congetture in grado di trasformare lo studio scientifico della vita in

un'interrogazione. Per tali ragioni, i pur enormi progressi della conoscenza umana a livello

della biologia molecolare, al momento, non sono in grado di comprendere pienamente

l'enigmatico linguaggio della vita: traccia di una diacronia irrappresentabile che sfugge

costantemente ad ogni tentativo umano di determinazione completa. Questa dimensione

antinomica del limite è descritta in modo impeccabile da Monod che nella parte finale del

suo volume così si esprime:

Quando si pensa al lunghissimo cammino percorso dall'evoluzione da forse tre miliardi di anni, alla

prodigiosa varietà delle strutture che essa ha creato, alla miracolosa efficacia delle prestazioni degli

esseri viventi, dal batterio all'uomo, diventa spontaneo dubitare che tutte queste manifestazioni

possano essere il risultato di una gigantesca lotteria in cui vengono tirati a sorte dei numeri tra i

quali una cieca selezione designa rari vincenti. [...] Si potrebbe pensare che l'aver scoperto i

meccanismi universali su cui si basano le proprietà essenziali degli esseri viventi abbia permesso di

risolvere il problema delle origini. In realtà tali scoperte, presentando sotto nuova luce tutta la

questione, oggi posta in termini molto più precisi, l'hanno resa ancora più complessa di quanto non

sembrasse prima.30

Alla luce di tutto ciò, dunque, a nostro giudizio, nonostante il raggiungimento di

sorprendenti risultati e l'apertura di nuovi orizzonti di ricerca prima impensabili, la scienza

contemporanea si trova davanti all'impossibilità concreta di poter rispondere in maniera

definitiva alla domanda riguardante l'essenza ultima della vita: la complessità che la

pervade resta, pertanto, intrisa di mistero. Lungi dal farci cadere in una condizione di

sconforto, quest'affermazione, tuttavia apre nuovi orizzonti al nostro sguardo e ci invita a

raccogliere le nostre forze per un balzo in avanti ancora più articolato e profondo. Per

concludere, quindi, possiamo affermare che tramite la nascita del nuovo paradigma

scientifico legato alla scienza della complessità, oggi l'affascinante questione concernente

l'essenza della vita ci addita la necessità di fare riferimento ad una circolarità nuova in

grado di avvicinare una filosofia che scopre sempre più in profondità il ruolo di analisi per

quel che riguarda le grandi domande relative al senso della vita ad una scienza che a sua

volta gradatamente giunge a divenire consapevole della necessità di non smarrire mai,

lungo il corso della ricerca, i profondi interrogativi concernenti il senso. Grazie alla

mediazione della filosofia, inoltre, risulta anche possibile intravedere un dialogo tra

scienza, da un lato, e studi teologici, dall'altro. È questo, a nostro giudizio, un dato

importante su cui occorre laicamente soffermare la nostra attenzione, ma nel rispetto di

quelle che sono le procedure e gli strumenti della scienza e nel rigetto di «scorciatoie»

metodologiche (o ideologiche) tra le quali, sempre, a nostro avviso, va annoverata anche

l'ipotesi del «disegno intelligente».31 È in questo territorio incerto, ma pieno di grandi

speranze, che la scienza può raccogliersi in sé in un silenzio operoso al cui interno, a nostro

giudizio, è forse possibile rintracciare i lineamenti possibili di idee e principi filosofici

nuovi auspice, come abbiamo visto, la teoria contemporanea della complessità.

Copyright © 2010 Mirko Di Bernardo

Mirko Di Bernardo. «Complessità e significato nei sistemi biologici». Dialegesthai. Rivista

telematica di filosofia [in linea], anno 12 (2010) [inserito il 25 ottobre 2010], disponibile su World

Wide Web: <http://mondodomani.org/dialegesthai/>, [65 B], ISSN 1128-5478.

Note

1. S. A. Kauffman, Esplorazioni evolutive, Einaudi, Torino 2005, p. 4.

2. E. Schrödinger, Che cos'è la vita?, Adelphi, Milano 1995, pp. 63-66.

3. J. D. Watson and F. Crick, (1953), «A structure for deoxyribose nucleic acid», Nature, 171,

pp. 737-738.

4. J. Monod, Il caso e la necessità, Mondadori, Milano 1970, p. 14.

5. Ibidem, p. 15.

6. Ibidem, p. 15-16.

7. Ibidem, p. 17.

8. Ibidem, p. 76.

9. F. Jacob and J. Monod, (1961), «Genetic regulatory mechanisms in the synthesis of

proteins», Journal of Molecular Biology, 3, pp. 318-356.

10. G. Bocchi e M. Ceruti, (a cura di), La sfida della complessità, Mondadori, Milano 2007.

11. I. Prigogine e I. Stengers, (1981), La nuova alleanza. Metamorfosi della scienza, Einaudi,

Torino 1999, p.174.

12. Ibidem, p. 164.

13. S. A. Kauffman, (1995), A casa nell'universo. Le leggi del caos e della complessità, Editori

Riuniti, Roma 2001, p. 122.

14. Ibidem, p. 41.

15. Cfr. R. Shaw, (1981), «Strange Attractors, Chaotic Behavior, and Information Flow», Z.

Naturforsch., 36a, pp. 80-112.

16. Per un ulteriore approfondimento di questo tema si veda: H. Atlan, (1990), «The Cellular

Computer DNA: Program or Data», Bulletin of Mathematical Biology, 52 (3), pp. 335-348;

Di Bernardo, M., Per una rivisitazione della dottrina monodiana della morfogenesi

autonoma alla luce dei nuovi scenari aperti dalla post-genomica, Aracne, Roma 2007.

17. E. F. Keller, Il secolo del gene, Garzanti, Milano 2001, p. 9.

18. Ibidem, p. 55. Cor. Nostro.

19. Ibidem, p. 56.

20. Ibidem, pp. 48-49.

21. Ibidem, p. 50.

22. Questi risultati sono stati confermati il 19 aprile 2009 da un articolo apparso su Nature dal

titolo: The regulated retrotransposon transcriptome of mammalian cells. Tale lavoro è il

frutto di una collaborazione internazionale tra il gruppo del Laboratorio di Epigenetica del

Dulbecco Telethon Institute, guidato da Valerio Orlando, il team di Piero Carninci

dell'OMICS Centre di Yokohama Giappone e l'Università di Queensland in Australia. Per un

ulteriore approfondimento si veda: G. J. Faulkner, Y. Kimura, C. O. Daub, S. Wani, C.

Plessy, K. M. Irvine, K. Schroder, N. Cloonan, A. L. Stetoe, T. Lassmann, K. Waki, N.

Horning, T. Arakawa, H. Takahashi, J. Kawai, A. R. Forrest, H. Suzuki, Y. Hayashizakiy, D.

A. Hume, V. Orlando, Grimmond, S. M. and P. Carninci, 2009, «The regulated

retrotrasposon transcriptome of mammalian cells», Nat. Genet., 41, 5, p. 505.

23. Keller, Il secolo del gene, p. 65.

24. Ibidem, p. 79.

25. Ibidem, p. 77.

26. H. Atlan (1985), «Complessità, disordine e auto-creazione del significato», in Bocchi e

Ceruti, (a cura di) La sfida della complessità, Mondadori, Milano 2007, pp. 141-142.

27. Ibidem, p. 143.

28. A. Carsetti, «Modelli cibernetici e biologia molecolare», in Problemi filosofici della biologia,

CNR, Bologna 1972, pp. 5-16; A. Carsetti, (1992), «Meaning and complexity: a non-standard

approach», La Nuova Critica, 19-20, pp. 112-114; A. Carsetti, (1996), «Chaos, natural order

and molecular semantics», La Nuova Critica, 27-28, pp. 83-107.

29. H. Atlan, (1992), «Self-organizing networks: weak, strong and intentional, the role of their

underdetermination», La Nuova Critica, 19-20, pp. 51-71; A. Carsetti, (1993), «Meaning

and complexity: the role of non-standard models», La Nuova Critica, 22, pp. 57-86.

30. Monod, Il caso e la necessità, p. 127.

31. Il 18 febbraio 2006 l'autorevole rivista La Civiltà Cattolica ha preso le sue distanze dalle

tesi dei fondamentalisti americani. Nell'articolo dal titolo Scienza e fede: caso e progetto,

infatti, E. M. C. Pérez afferma testualmente: «Siamo a un punto in cui dobbiamo accettare

che né la scienza, né la teologia offrono una risposta completa al perché e al come

dell'esistenza e dell'evoluzione dell'universo e degli esseri umani all'interno di essi». «Si

tratta -- conclude lo studioso -- di due modi limitati di conoscere una meravigliosa realtà

che va al di là della nostra comprensione in quasi tutti i suoi stadi.». Per un ulteriore

approfondimento si veda: E. M. C. Pérez, (2006), «Scienza e fede: caso e progetto», Civiltà

Cattolica, 3736, pp. 319-331.