Approfondimento 7.6 - La regressione multipla

Al di là dell’aspetto didattico o di casi di ricerca particolari, è abbastanza irrealistico pensare che i

fenomeni possano essere spiegati nei termini di una sola variabile indipendente, soprattutto nel

campo delle scienze sociali, dove la presenza di molti fattori né necessari né sufficienti è la regola, e

niente affatto un’eccezione. Per questo motivo, i modelli di regressione contengono quasi sempre

più di una variabile indipendente o predittore. Quando i predittori in un modello di regressione sono

più di uno si parla di modello di regressione multipla.

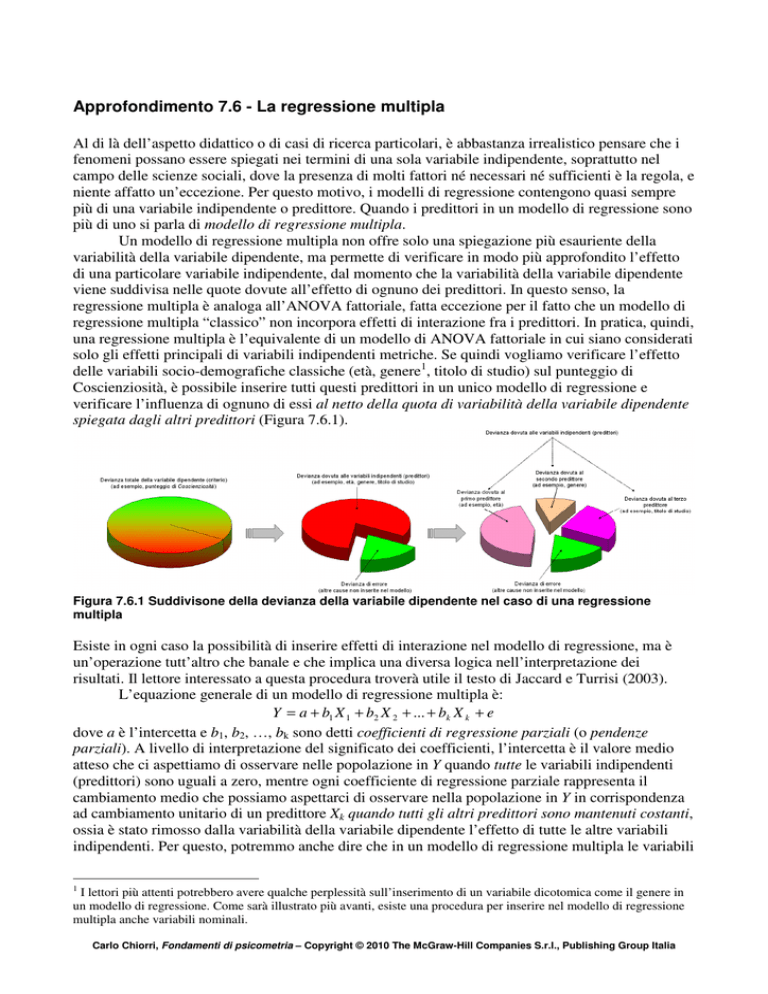

Un modello di regressione multipla non offre solo una spiegazione più esauriente della

variabilità della variabile dipendente, ma permette di verificare in modo più approfondito l’effetto

di una particolare variabile indipendente, dal momento che la variabilità della variabile dipendente

viene suddivisa nelle quote dovute all’effetto di ognuno dei predittori. In questo senso, la

regressione multipla è analoga all’ANOVA fattoriale, fatta eccezione per il fatto che un modello di

regressione multipla “classico” non incorpora effetti di interazione fra i predittori. In pratica, quindi,

una regressione multipla è l’equivalente di un modello di ANOVA fattoriale in cui siano considerati

solo gli effetti principali di variabili indipendenti metriche. Se quindi vogliamo verificare l’effetto

delle variabili socio-demografiche classiche (età, genere1, titolo di studio) sul punteggio di

Coscienziosità, è possibile inserire tutti questi predittori in un unico modello di regressione e

verificare l’influenza di ognuno di essi al netto della quota di variabilità della variabile dipendente

spiegata dagli altri predittori (Figura 7.6.1).

Figura 7.6.1 Suddivisone della devianza della variabile dipendente nel caso di una regressione

multipla

Esiste in ogni caso la possibilità di inserire effetti di interazione nel modello di regressione, ma è

un’operazione tutt’altro che banale e che implica una diversa logica nell’interpretazione dei

risultati. Il lettore interessato a questa procedura troverà utile il testo di Jaccard e Turrisi (2003).

L’equazione generale di un modello di regressione multipla è:

Y = a + b1 X 1 + b2 X 2 + ... + bk X k + e

dove a è l’intercetta e b1, b2, …, bk sono detti coefficienti di regressione parziali (o pendenze

parziali). A livello di interpretazione del significato dei coefficienti, l’intercetta è il valore medio

atteso che ci aspettiamo di osservare nelle popolazione in Y quando tutte le variabili indipendenti

(predittori) sono uguali a zero, mentre ogni coefficiente di regressione parziale rappresenta il

cambiamento medio che possiamo aspettarci di osservare nella popolazione in Y in corrispondenza

ad cambiamento unitario di un predittore Xk quando tutti gli altri predittori sono mantenuti costanti,

ossia è stato rimosso dalla variabilità della variabile dipendente l’effetto di tutte le altre variabili

indipendenti. Per questo, potremmo anche dire che in un modello di regressione multipla le variabili

1

I lettori più attenti potrebbero avere qualche perplessità sull’inserimento di un variabile dicotomica come il genere in

un modello di regressione. Come sarà illustrato più avanti, esiste una procedura per inserire nel modello di regressione

multipla anche variabili nominali.

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

indipendenti fungono da variabili di controllo le une con le altre. Questo ci permette di valutare in

modo molto più preciso l’effetto di un predittore, dato che altre possibili cause della variabilità della

variabile dipendente sono state rimosse (o controllate) statisticamente.

Nella regressione multipla la procedura di stima dei parametri è un’estensione di quella della

regressione bivariata, così come i test di significatività e, in parte, l’interpretazione di R2. Nella

regressione multipla R2 non è la proporzione di variabilità comune fra due variabili, ma è la

proporzione di variabilità comune fra la variabile dipendente e l’insieme (set) delle variabili

indipendenti. In altre parole, è il coefficiente di correlazione multipla al quadrato fra criterio e

predittori e la proporzione di variabilità della variabile dipendente spiegata dall’insieme dei

predittori. Come in tutti gli altri casi che abbiamo visto, è possibile verificare statisticamente che il

valore di R2 sia maggiore di zero. Quando si considera più di un predittore, però, occorre utilizzare

la formula di correzione analoga a quella che abbiamo già visto nel caso della correlazione multipla,

che produce un valore di Adjusted R2 (R2 “aggiustato”),

Adjusted R 2 = 1 −

(n − 1)

(1 − R 2 )

(n − k − 1)

dove n è il numero di soggetti e k il numero di predittori.

Il motivo della necessità dell’aggiustamento di R2 è che, per ragioni legate alla particolare

procedura di calcolo, al ridursi della differenza fra numero di soggetti n e numero di predittori k, il

valore di R2 tende a “gonfiarsi” indipendentemente dal fatto che i predittori del modello

rappresentino effettivamente le maggiori fonti di variazione della variabile dipendente, finché,

quando il numero di predittori è uguale al numero di soggetti meno uno, il valore di R2 è in ogni

caso uguale a 1. Nel caso di una regressione multipla, quindi, è fondamentale consultare questo

indice, e non quello “grezzo”, per valutare la bontà di adattamento del modello di regressione ai dati

osservati.

La significatività di Adjusted R2 viene verificata con un test F esattamente come quella di R2

per la regressione bivariata. In questo caso, però, il valore di F critico va cercato per gradi libertà a

numeratore uguali a numero di predittori (k) e gradi di libertà a denominatore uguali al numero di

soggetti meno il numero di predittori meno uno (n − k − 1):

(n − k − 1) × Adjusted R 2

Fk ,n −k −1 =

k (1 − Adjusted R 2 )

Supponiamo di aver eseguito una regressione multipla con 4 predittori e 200 soggetti, e che il valore

di R2 ottenuto sia ,56. Le ipotesi sono:

H0: Adjusted ρ2 = 0 → il coefficiente di determinazione “aggiustato” nella popolazione è uguale a

zero → i dati osservati non sono coerenti con un modello lineare di regressione multipla

H1: Adjusted ρ2 > 0 → il coefficiente di determinazione “aggiustato” nella popolazione è maggiore

di zero → i dati osservati non sono coerenti con un modello lineare di regressione multipla

Il valore di F critico2 per un livello di significatività α = ,05, k = 4 e n − k − 1 = 200 − 4 − 1 = 195

gradi di libertà è 2,42. Calcoliamo Adjusted R2:

Adjusted R 2 = 1 −

(200 − 1)

(n − 1)

(1−,56) =,55

(1 − R 2 ) = 1 −

(200 − 4 − 1)

(n − k − 1)

A questo punto calcoliamo F:

2

in Excel: =INV.F(,05;4;195)

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

F4,195 =

(n − k − 1) × Adjusted R 2 (200 − 4 − 1)×,55

= 59,58

=

4(1−,55)

k (1 − Adjusted R 2 )

Conclusione: poiché F calcolato > F critico (59,58 > 2,42), è troppo improbabile che quanto

osservato sia il risultato di un’ipotesi nulla vera, per cui la rifiutiamo. Questi risultati suggeriscono

che il coefficiente di determinazione “aggiustato” nella popolazione sia significativamente

maggiore di zero, per cui i dati osservati sono coerenti con un modello lineare di regressione

multipla

In precedenza abbiamo detto che se il numero di predittori è uguale al numero di soggetti meno uno

il valore di R2 risulterà in ogni caso uguale a 1. Nella realizzazione di una regressione multipla,

quindi, occorre considerare attentamente il problema del numero di soggetti ottimale in rapporto al

numero di predittori. Storicamente, vale la rule of thumb di 10 soggetti per predittore (Harris, 1985;

Wampold & Freund, 1987), ma la questione è stata affrontata in modo molto più approfondito da

Green (1991), Maxwell (2000) e Kelley e Maxwell (2003). Questi autori forniscono una trattazione

molto sofisticata del problema, per cui il lettore interessato ad approfondire l’argomento è rinviato

ai loro lavori. Per quanto nell’articolo non appaia proprio lieto di farlo, Maxwell (2000) fornisce

comunque una formula per la stima della dimensione ottimale del campione basata sulla dimensione

dell’effetto f2 che si intende individuare a livello statistico:

nottimale =

7,85

+k

f2

dove k = numero di predittori. Con questa formula è possibile ottenere una dimensione campionaria

che assicuri una potenza del test statistico di ,80, ossia la probabilità di accettare l’ipotesi alternativa

che i coefficienti di regressione siano significativamente diversi da zero è dell’80%. Questo

significa che se prendiamo i valori di f2 che Cohen (1988) considera limite fra un effetto trascurabile

e un effetto piccolo (f2 = 0,02), fra un effetto piccolo e un effetto moderato (f2 = 0,15) e fra un

effetto moderato e un effetto grande (f2 = 0,35; vedi anche Tabella 7.24 del manuale) avremo:

7,85

7,85

nottimale ;effetto piccolo =

+ k = 393 + k , nottimale ;effetto moderato =

+ k = 53 + k ,

0,02

0,15

7,85

nottimale ;effetto grande =

+ k = 23 + k

0,35

Supponiamo però che i soggetti ormai siano stati raccolti e che in base alla loro numerosità le

formule appena mostrate ci rivelino che non sia possibile inserire nel modello di regressione

multipla tutti i predittori a cui avevamo pensato. In questi casi, occorre valutare inizialmente le

correlazioni bivariate fra ogni predittore e il criterio. In genere, conviene inserire nel modello solo

quei predittori che abbiano una correlazione bivariata col criterio di almeno |,20|. Se la limitazione

al numero massimo di predittori che è possibile inserire rispetto all’ampiezza campionaria è

maggiore, si può rendere più severo il cut-off aumentano la correlazione bivariata minima a |,30| o

|,40|.

Strategie di regressione multipla

Una regressione multipla può essere realizzata in un gran numero di modi diversi. Le principali

strategie di regressione multipla sono fondamentalmente tre:

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

1. standard (o simultanea)

2. gerarchica (o sequenziale)

3. statistica

Le tre strategie si differenziano in base a come viene determinato l’ordine di “entrata” dei predittori

nell’equazione di regressione e ai criteri statistici per mantenere o meno nel modello i predittori.

Nel modello standard o simultaneo tutte le variabili indipendenti vengono inserite insieme

nell’equazione di predizione. L’impatto sulla variabile dipendente di ogni variabile indipendente

viene valutato come la variabile indipendente in questione se fosse stata inserita nel modello di

regressione dopo che tutte le altre variabili indipendenti sono già state inserite nel modello. Ogni

variabile indipendente viene quindi valutata in termini di cosa aggiunge alla predizione della

variabile dipendente rispetto alla predizione garantita da tutte le altre variabili indipendenti.

Nella regressione gerarchica o sequenziale, le variabili indipendenti sono inserite

nell’equazione in un ordine specificato dal ricercatore, una alla volta, oppure, più comunemente, a

blocchi. Ogni variabile o blocco di variabili indipendenti viene valutato in termini di cosa aggiunge

alla spiegazione della variabilità della variabile dipendente al momento del suo ingresso. Il

ricercatore di solito assegna l’ordine di entrata delle variabili nel modello in base a considerazioni

di ordine logico o teorico, per cui non esiste una regola fissa. In ogni caso, devono essere inserite

per prime nel modello le variabili di maggiore importanza teorica, e poi le altre. Un caso abbastanza

tipico in psicometria potrebbe essere quello dello studio della validità incrementale di un nuovo test

psicologico. La validità incrementale di un test può essere rappresentata, ad esempio, da quanto

l’inserimento del test in una batteria composta da altri strumenti aggiunge al potere diagnostico

della batteria stessa: la regressione multipla gerarchica permette di rispondere alla domanda “il

punteggio al test da inserire nella batteria aggiunge qualcosa in termini di variabilità spiegata della

variabile dipendente dopo che nel modello sono stati inseriti tutti gli altri strumenti della batteria”?

In questo caso, andremmo a considerare il cambiamento in R2 prodotto dall’inserimento del

punteggio del nuovo test: se è statisticamente diverso da zero, allora il test possiede validità

incrementale e varrà la pena inserirlo nella batteria, altrimenti no. In altri casi, la sequenza più

comune di inserimento sequenziale dei predittori nel modello è la seguente:

I. Variabili esogene (ossia, variabili non psicologiche): sono le variabili, in genere sociodemografiche, sulle quali il soggetto non ha controllo (ad esempio, età, genere, etc.)

II. Variabili esogene sulle quali il soggetto può avere un controllo, più o meno forte (ad esempio,

numero di figli, reddito, scolarizzazione, etc.)

III. Variabili endogene, ossia le variabili psicologiche

La logica della sequenza di inserimento appena presentata non è valida sempre, perché ragioni

teoriche o specifiche per un determinato campo di indagine potrebbero suggerire un ordine di

inserimento diverso. Nondimeno, quando la variabile dipendente è un punteggio ad un test

psicologico è prassi abbastanza comune cercare di rimuovere innanzitutto la variabilità della

variabile dipendente dovuta fattori non psicologici, come l’età o la condizione clinica, e solo dopo

inserire nel modello le altre variabili psicologiche. Questo è il motivo per cui la regressione multipla

viene spesso utilizzata per tarare i punteggi ad un test: in pratica, si cerca di ottenere un punteggio

“ripulito” dall’influenza di alcune variabili del soggetto rilevanti. Nelle batterie neuropsicologiche

per la valutazione dell’efficienza cognitiva degli anziani, il punteggio osservato, ad esempio, nelle

prove di memoria a breve termine viene corretto mediante apposite tavole in base al genere, all’età

e al grado di scolarizzazione del soggetto, poiché è noto come il punteggio osservato in queste

prove sia in relazione con queste variabili. La procedura statistica per individuare i fattori di

correzione prevede l’impiego della regressione multipla.

La regressione statistica è una procedura in cui l’ordine di entrata nel modello delle variabili

è basato unicamente su criteri statistici. Le decisioni circa quali variabili inserire o escludere

dall’equazione di regressione sono basate solo sulle statistiche calcolate nel campione oggetto della

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

ricerca, e per questo motivo i ricercatori più attenti agli aspetti teorici e di generalizzazione dei

risultati non amano particolarmente questa strategia, che è invece è quella prediletta da chi invece

ha come unico scopo dell’analisi quello di individuare il sottoinsieme di predittori che permetta di

predire il punteggio nel criterio con la massima precisione possibile, indipendentemente dalle

implicazioni del risultato sul piano teorico.

Nella regressione multipla statistica le procedure di selezione dei predittori sono

fondamentalmente di tre tipi:

a. Forward Selection (selezione in avanti): l’analisi comincia con l’equazione di regressione

vuota e le variabili indipendenti sono aggiunte una alla volta in base al fatto che soddisfino i

criteri statistici di entrata. Il criterio più semplice di selezione è che il predittore, al momento

dell’inserimento nel modello di regressione, abbia un coefficiente di regressione

significativo almeno ad un livello α = ,05. Una volta inclusa nell’equazione di regressione,

la variabile indipendente selezionata vi rimane anche se con l’aggiunta delle successive il

suo coefficiente di regressione non è più significativo al livello scelto.

b. Backward Deletion (selezione all’indietro): l’analisi comincia con tutte le variabili

indipendenti inserite nell’equazione di regressione, e queste vengono eliminate una alla

volta se non contribuiscono significativamente alla regressione. Anche in questo caso, il

criterio più semplice di esclusione è che il predittore, al momento della verifica statistica,

abbia un coefficiente di regressione non significativo ad un livello, ad esempio, α = ,10. Una

volta esclusa dall’equazione di regressione, la variabile indipendente eliminata non può più

rientrarvi.

c. Stepwise: questa procedura è un compromesso fra la Forward e la Backward Deletion, in

quanto l’analisi comincia con l’equazione di regressione vuota e le variabili indipendenti

sono aggiunte una alla volta se soddisfano un criterio statistico (ad esempio, coefficiente di

regressione significativo ad un livello α = ,05), ma possono essere eliminate in uno

qualunque degli stadi di selezione successivi se non contribuiscono più in modo

significativo (ad esempio, il coefficiente di regressione non è più significativo ad un livello

α = ,10) alla spiegazione della variabilità della variabile dipendente. Questa è considerata la

procedura da scegliere per giungere alla migliore equazione di predizione.

E’ importante notare come le strategie di regressione multipla qui presentate non siano

intercambiabili, ma debbano essere scelte in base alla domanda di ricerca. La Tabella 7.6.1 mostra

un esempio di quali possano essere le strategie di regressione multipla ottimali per diverse domande

di ricerca.

Tabella 7.6.1. Criteri di selezione della strategia di regressione multipla in base alla domanda di

ricerca per un modello che intenda prevedere il Voto all’Esame di Maturità in base al Genere, alla

Media Voto degli Anni Precedenti, alla Motivazione allo Studio (misurata mediante apposito test) e

alle Abilità Cognitive (misurate mediante apposito test).

Domanda di ricerca

Qual è la dimensione della relazione generale fra il voto di

maturità e i suoi predittori?

A quanta parte della relazione contribuisce singolarmente ogni

predittore indipendentemente dagli altri?

L’inserimento nel modello delle variabili psicologiche (motivazione

allo studio e abilità cognitive) aumenta significativamente la

precisione nella predizione del voto di maturità dopo aver

considerato l’influenza delle differenze di genere e della media

voto degli anni precedenti?

Qual è la migliore combinazione lineare dei predittori per predire

con la maggiore precisione possibile il voto di maturità nel

campione?

Strategia di regressione multipla

da scegliere

Standard

Gerarchica

Statistica

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Spesso si tendono ad utilizzare anche strategie miste: ad esempio, si creano blocchi di predittori che

vengono inseriti nel modello mediante una strategia di tipo gerarchico, ma al momento per la

selezione dei predittori all’interno di ogni blocco si adotta una strategia di selezione di tipo

statistico.

Il problema della collinearità

Le assunzioni per l’applicazione di un modello di regressione multipla sono le stesse della

regressione bivariata (si veda Paragrafo 7.3.2 del manuale), più quella dell’assenza di collinearità

dei predittori. Il termine “collinearità” (collinearity) si riferisce alla possibilità che almeno due

variabili indipendenti siano perfettamente correlate fra loro oppure che una variabile indipendente

sia una combinazione lineare3 di alcune o di tutte le altre variabili indipendenti. Il caso più banale di

collinearità è quello in cui si inseriscono nel modello di regressione le variabili “Numero di risposte

corrette”, “Numero di risposte errate” e “Numero di risposte totali”, dove il numero di risposte totali

è la somma del numero di risposte corrette e del numero di risposte errate. In questo caso, il numero

di risposte totali è una combinazione lineare delle altre due variabili indipendenti:

Numero di risposte totale = Numero di risposte corrette + Numero di risposte errate

Il problema è che se esiste una perfetta collinearità fra due o più predittori, è impossibile arrivare ad

una soluzione unica per le stime dei parametri del modello di regressione. Le situazioni di perfetta

collinearità per fortuna sono abbastanza semplici da individuare, per cui difficilmente possono

costituire una reale minaccia per il ricercatore attento. Una minaccia molto più seria è costituita

dall’alta collinearità, ossia una situazione in cui una o più variabili indipendenti sono troppo, per

quanto non perfettamente, correlate fra loro. Nella pratica comune, le variabili indipendenti sono

sempre un po’ correlate fra loro, per cui sono in parte collineari. Quando questa situazione diviene

estrema, si verificano seri problemi di stima dei parametri, che diviene tanto più inattendibile

quanto maggiore è la proporzione di variabilità comune fra i predittori. In questi casi, uno specifico

coefficiente di regressione non può essere confrontato con gli altri nell’equazione così da arrivare

ad una valutazione attendibile degli effetti di ogni variabile indipendente. La stima potrebbe

risultare non statisticamente significativa anche se, in effetti, la variabile indipendente e la variabile

dipendente sono in relazione nella popolazione. In pratica che cosa succede? Poniamo il caso di

utilizzare l’età e il titolo di studio come predittori del livello di coscienziosità. Se età e titolo di

studio sono entrambi correlati con la coscienziosità, ci aspettiamo che ogni predittore si prenda la

sua “parte” di variabilità della variabile dipendente, analogamente a quanto illustrato in Figura

7.6.1, per cui la variabilità dei punteggi di coscienziosità sarà spiegata in parte dall’età e in parte dal

titolo di studio. Se però età e titolo di studio sono eccessivamente correlate fra loro, e quindi

collineari, solo una di esse si riuscirà a “prendersi” (spiegare) una quota sostanziale di variabilità

della variabile dipendente, mentre l’altra rimarrà a bocca asciutta. In pratica, è come se i predittori

collineari costituissero un gruppo di amici seduti attorno ad un tavolo al ristorante: se alla fine della

cena il cameriere porta un solo cioccolatino per tavolo, e lo prende uno dei commensali, tutti i suoi

compagni di tavolo (ossia, tutti coloro che in quel momento sono in stretta in relazione fra loro) non

avranno niente, anche se il cioccolatino è per il tavolo, e non specificamente per la persona che

riesce ad accaparrarselo.

Prima di procedere con l’esecuzione di una regressione multipla, quindi, è sempre bene

esaminare la matrice di correlazione dei predittori. Alcuni manuali suggeriscono di considerare con

sospetto coefficienti di correlazione estremi, come ad esempio ,80, ma chi ha un minimo di

3

Una combinazione lineare è una somma pesata di elementi: l’equazione di regressione multipla è una combinazione

lineare in quanto è una somma di punteggi nelle variabili pesati per i coefficienti di regressione più l’errore.

Nell’esempio successivo del numero di risposte corrette il peso di ogni elemento è assunto essere uguale a 1.

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

esperienza sa benissimo che anche correlazioni più deboli (ad esempio, ,50) sono a rischio

collinearità. Sfortunatamente, però, questa operazione da sola non è sufficiente, per quanto

necessaria, all’individuazione di una situazione di collinearità, in quanto ci permette di verificare

solo l’eventuale presenza di una collinearità fra coppie di predittori, mentre, come abbiamo visto

prima, la collinearità può essere dovuta anche ad una combinazione lineare di alcuni predittori. Il

miglior metodo per individuare la collinearità fra uno o più predittori, quindi, è far regredire ogni

variabile indipendente su tutte le altre ed esaminare l’R2 risultante: se è troppo alto (> ,50), significa

che fra quelle variabili indipendenti vi è collinearità. In pratica, è come se, a turno, ogni predittore

venisse considerato la variabile dipendente di un modello di regressione in cui le variabili

indipendenti sono gli altri predittori. Il valore di R2 di questa analisi è la proporzione di variabilità

comune fra quel predittore e l’insieme di tutti gli altri: se questa proporzione è maggiore del 50%,

c’è ragione di sospettare la collinearità. Realizzare questo tipo di analisi non è immediato come la

produzione di una matrice di correlazione, ma SPSS produce nell’output dell’analisi di regressione

un valore, detto Tolerance (si veda Rimando SPSS 7.5) che rappresenta la proporzione di variabilità

di un predittore che non è spiegata dagli altri predittori: in pratica, è 1 − R2 della regressione di quel

predittore su tutti gli altri. Se non vi è collinearità, questo valore è uguale a 1: ossia, 1 − R2 = 1

poiché l’R2 della regressione di quel predittore sugli altri è uguale a zero: i predittori non hanno

variabilità in comune. Se però questo valore è inferiore a ,50, ad esempio ,35, significa che 1 − R2 =

,65, ossia il predittore in questione condivide con gli altri il 65% della sua variabilità: in questo caso

c’è ragione di sospettare la collinearità. SPSS riporta insieme al valore di Tolerance anche il suo

reciproco, il fattore di inflazione della varianza o Variance Inflation Factor (VIF). Se consideriamo

come valore limite , 50 per la Tolerance, quello del VIF è 1 / ,50 = 2. Se quindi osserviamo un VIF

maggiore di 2, significa che la Tolerance è inferiore a ,50, e quindi i predittori hanno un’eccessiva

quota di variabilità comune.

Nella pratica possono capitare situazioni ambigue, per così dire, per cui non siamo in grado

di stabilire ancor prima di eseguire l’analisi di regressione se ci troviamo effettivamente in una

situazione di collinearità. La collinearità va quindi indagata anche dopo aver eseguito l’analisi,

ispezionando i risultati ottenuti. Lo stesso SPSS, del resto, riporta i valori di Tolerance e di VIF

insieme alla stima dei parametri, e non prima. I “sintomi” principali di collinearità sono

fondamentalmente due:

1. Un R2 alto ma parametri statisticamente non significativi a causa di alti errori standard delle

stime dei parametri. Se l’insieme dei predittori spiega una quota sostanziale di variabilità

della variabile dipendente ma nessuno di essi risulta statisticamente significativo,

evidentemente c’è qualcosa che non quadra. Il motivo potrebbe essere la collinearità, che è

nota produrre stime degli errori standard delle stime dei parametri molto alte: dato che il test

di significatività di un coefficiente di regressione è dato dal rapporto fra la stima del

parametro e il suo errore standard, se l’errore standard è molto alto il valore di t calcolato

tenderà ad essere molto basso, e quindi probabilmente inferiore al t critico, da cui

impossibilità a rifiutare l’ipotesi nulla che nella popolazione quel coefficiente di regressione

sia uguale a zero.

2. Coefficienti di regressione che cambiano in modo sistematico quando alcune variabili

indipendenti sono escluse o incluse nell’equazione. In generale la regressione multipla serve

proprio a capire quanto ogni predittore è importante nella predizione del criterio, per cui può

capitare che un predittore risulti significativo quando è da solo nell’equazione, e cessi di

esserlo quando viene inserito nel modello di regressione multipla un predittore più

importante. Occorre però verificare che questo non sia il risultato del fatto che i predittori

sono collineari. Supponiamo di voler predire il punteggio di coscienziosità. Inseriamo nel

modello l’età e risulta un predittore significativo. Poi inseriamo il titolo di studio, e notiamo

che l’età non è più un predittore significativo, mentre il titolo di studio sì. Se inseriamo un

terzo predittore, ad esempio il genere, è l’età torna ad essere significativa, mentre il titolo di

studio non lo è più, c’è nuovamente qualcosa di strano, perché se vi è assenza di collinearità

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

la significatività dei predittori non cambia in modo così eclatante. Se età e titolo di studio

non fossero collineari, l’aggiunta del genere potrebbe sì modificare in parte la stima dei loro

coefficienti di regressione, ma non in modo tale da invertire le significatività.

Altri sintomi di collinearità, meno discriminanti di quelli appena illustrati, sono l’entità dei

coefficienti, ossia coefficienti inaspettatamente alti o bassi in assoluto o relativamente ad altri

nell’equazione, e coefficienti col segno “sbagliato”, nel senso che fra predittore e criterio risulta una

relazione positiva quando invece in base alla teoria ci aspettavamo una relazione negativa, o

viceversa. Queste due situazioni possono essere di difficile interpretazione, poiché non esistono

linee guida precise per dire che un coefficiente di regressione è troppo maggiore di un altro, né

possiamo sapere con certezza, e in anticipo, quale sarà il segno “giusto” di un coefficiente di

regressione. Per riuscire ad utilizzare questi indizi in modo adeguato occorre una profonda

conoscenza del fenomeno in esame, per cui sono sconsigliati per i meno esperti.

La domanda da un milione di euro, a questo punto, è: se otteniamo una “diagnosi” di

collinearità, che cosa si fa? Purtroppo non c’è una soluzione che va bene sempre. A volte la

collinearità è il risultato di campioni troppo ristretti, per cui l’eccessiva relazione fra una o più

variabili è dovuta all’errore di campionamento e non esiste nella popolazione. In questi casi

aumentare il campione, posto che il campionamento sia eseguito nel modo corretto, può aiutare a

risolvere il problema. Non sempre però questo è possibile, oppure il campione è già

sufficientemente ampio. In questo caso, di solito si prova ad accorpare le variabili collineari in un

solo indicatore. Il problema, però, è che non sempre questo è possibile: se i predittori collineari

fossero due punteggi ottenuti dai soggetti in due diversi test psicologici, si può trasformare questi

punteggi a punti z e sommarli, così da ottenere un unico indice. Oppure si può ricorrere a procedure

statistiche più sofisticate, come l’analisi delle componenti principali. Il punto però è: quando

accorpiamo le variabili, che cosa rappresenta la nuova variabile? Se accorpiamo lerisposte di

frequenza di variabili come “Ascolto della radio”, “Assistere a programmi TV” e “Leggere i

giornali” possiamo ragionevolmente pensare di aver ottenuto una variabile più generale come

“Fruizione di mass-media”, ma se sono collineari genere e titolo di studio che cosa otteniamo

accorpandoli? Si tenga poi presente che qualunque operazione di trasformazione dei predittori va

inevitabilmente a modificare l’interpretazione del coefficiente di regressione ad esso associato. Se

otteniamo nel modo descritto in precedenza un indicatore composito costituito dalla somma dei

punteggi standardizzati di ansia e depressione, il coefficiente di regressione indicherà la variazione

media attesa in Y per una variazione unitaria della “somma dei punteggi standardizzati di ansia e

depressione”. In questi casi, c’è da augurare ogni bene a chi dovrà fornire una spiegazione del

risultato.

Un altro possibile rimedio alla collinearità è considerare l’equazione di regressione solo per

il suo valore predittivo: R2, infatti, può comunque può essere molto alto, al netto della mancanza di

significatività delle stime dei parametri, per cui gli errori di predizione di Y in base ai punteggi delle

variabili indipendenti saranno comunque limitati. Questa soluzione, ad ogni modo, è praticabile

solo in casi in cui la pragmatica della predizione prevalga sulla necessità di trovare una spiegazione

al fenomeno in esame.

Infine, potremmo pensare di eliminare la/e variabile/i problematica/e e confrontare i risultati

dei diversi modelli. Ad esempio, se X1 e X2 risultano collineari, dal modello: Y = a + b1X1 + b2X2 +

e si scarta X2, ottenendo il seguente modello alternativo: Y = a + b1X1 + e*. Questa soluzione, però,

può facilmente condurre all’errore di specificazione, per cui sarebbe meglio stimare anche il

modello in cui è X1 ad essere scartata: Y = a + b2X2 + e**, in modo da valutare in modo completo le

conseguenze dell’eventuale errore di specificazione. Occorre in ogni caso una buona esperienza per

essere in grado di valutare al meglio queste situazioni, e riuscire a decidere quale/i dei predittori

collineari escludere.

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

L’impiego di predittori misurati su scala nominale: le variabili dummy

Le variabili categoriali possono essere inserite in un modello di regressione multipla dopo averle

trasformate in variabili dummy4. Il caso più semplice è quello delle variabili dicotomiche, come il

genere: una categoria viene codificata come 0 (di solito le femmine) e l’altra come 1 (di solito i

maschi), e la variabile così codificata viene inserita nel modello di regressione. Supponiamo di aver

stimato un modello di regressione multipla in cui i predittori della coscienziosità sono l’età e il

genere, e che l’equazione di regressione risultante sia la seguente:

Y = 25,31 + 0,26 X Età + 3,62 X Genere

Il coefficiente di regressione relativo all’età ci informa che, al netto dell’effetto del genere, per ogni

anno in più di vita della persona possiamo aspettarci un aumento medio di coscienziosità di 0.26

punti. Il coefficiente di regressione del genere, invece, ci dice che, a parità di età, l’essere 1

(Maschio) su questa variabile significa ottenere in media un punteggio di coscienziosità 3,62 punti

superiore rispetto a quello di chi è 0 (Femmine). Per dimostrarlo basta sostituire i valori 1 e 0 nella

formula e confrontare i risultati:

Maschio (XGenere = 1):

Femmina (XGenere = 0):

Y = 25,31 + 0,26 X Età + 3,62 × 1 = 25,31 + 0,26 X Età + 3,62

Y = 25,31 + 0,26 X Età + 3,62 × 0 = 25,31 + 0,26 X Età

Il caso dicotomico è il più semplice da gestire. Se però vogliamo inserire nel modello una variabile

politomica, come ad esempio la diagnosi di disturbo di personalità di Cluster A (Paranoide,

Schizoide, Schizotipico), la questione si fa leggermente più complessa. Si genererà un numero di

variabili dummy uguale al numero di categorie della variabile meno una, quindi nel caso che stiamo

considerano 3 − 1 = 2. Chiameremo queste categorie, ad esempio “Essere o meno Paranoide” ed

“Essere o meno Schizoide”. Nella prima variabile dummy codificheremo con 1 i Paranoidi e con

zero tutti gli altri, indipendentemente dalla diagnosi. Nella seconda variabile dummy,

codificheremo con 1 gli Schizoidi e con 0 tutti gli altri, indipendentemente dalla diagnosi. E gli

Schizotipici? Gli Schizotipici saranno coloro che hanno un punteggio zero su entrambe le variabili

dummy, ossia non sono né Paranoidi (0 sulla prima variabile dummy) né Schizoidi (0 sulla seconda

variabile dummy, Tabella 7.6.2).

Tabella 7.6.2 Generazione di variabili dummy per la variabile categoriale Disturbo di Personalità

Cluster A (Paranoide, Schizoide, Schizotipico)

Diagnosi

Paranoide

Schizoide

Schizotipico

Paranoide

Paranoide

Schizoide

Schizotipico

Schizotipico

Schizoide

4

Prima variabile dummy

Essere (1) o non essere (0)

Paranoide

1

0

0

1

1

0

0

0

0

Seconda variabile dummy

Essere (1) o non essere (0)

Schizoide

0

1

0

0

0

1

0

0

1

dummy in inglese significa “manichino”, “fantoccio”

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Supponiamo che le due variabili dummy generate in Tabella 7.6.1 siano inserire in un modello di

regressione multipla per la predizione delle difficoltà interpersonali (Y, misurato mediante apposito

test) insieme all’età, e di ottenere la seguente equazione di regressione:

Y = 33 + 1,20 X Età + 2,10 X Paranoide + 1,50 X Schizoide

In una situazione come questa, le equazioni possibili in base alla diagnosi sono:

Paranoide (XParanoide = 1; XSchizoide = 0):

Y = 33 + 1,20 X Età + 2,10

Schizoide (XParanoide = 0; XSchizoide = 1):

Y = 33 + 1,20 X Età + 1,50

Schizotipico (XParanoide = 0; XSchizoide = 0):

Y = 33 + 1,20 X Età

Il valore del coefficiente di regressione di XParanoide indica che essere Paranoide, a parità di età,

comporta un aumento medio di 2,10 punti nel test sulle difficoltà interpersonali rispetto al non

esserlo (e quindi rispetto ad essere Schizoide o Paranoide), mentre il valore del coefficiente di

regressione di XSchiozide indica che essere Schizoide, al netto dell’età, comporta un aumento medio al

test di 1,50 punti rispetto al non esserlo (e quindi essere Paranoide o Schizotipico). Questi risultati,

però, forniscono indirettamente informazioni anche sulla variazione di punteggio al test di chi è

Schizotipico, perché chi è Schizotipico otterrà al test di difficoltà interpersonali un punteggio di

2,10 punti inferiore rispetto ai Paranoidi e 1,50 punti inferiore rispetto agli Schizoidi.

Confrontare i coefficienti di regressione e valutarne la dimensione dell’effetto

Quando il modello di regressione prevede più di un predittore, occorre verificare quale di essi è più

importante, ossia, mostra la relazione più forte con il criterio al netto delle relazioni col criterio

degli altri predittori. Il problema è che non possiamo basarci sull’entità del coefficiente di

regressione, perché questo dipende dall’unità di misura delle variabili, né sul livello di

significatività, che dipende dal numero di soggetti. Come abbiamo visto nel caso della regressione

bivariata, quindi, possiamo esaminare i coefficienti di regressione standardizzati β, che possono

essere trasformati nella dimensione dell’effetto f2.

Supponiamo di aver realizzato un’analisi di regressione multipla strandard per predire il

punteggio di Coscienziosità in base all’età, al genere (variabile dummy codificata M = 1, F = 0) e

agli anni di scolarizzazione5. Abbiamo raccolto i dati su 200 soggetti e i risultati dell’analisi

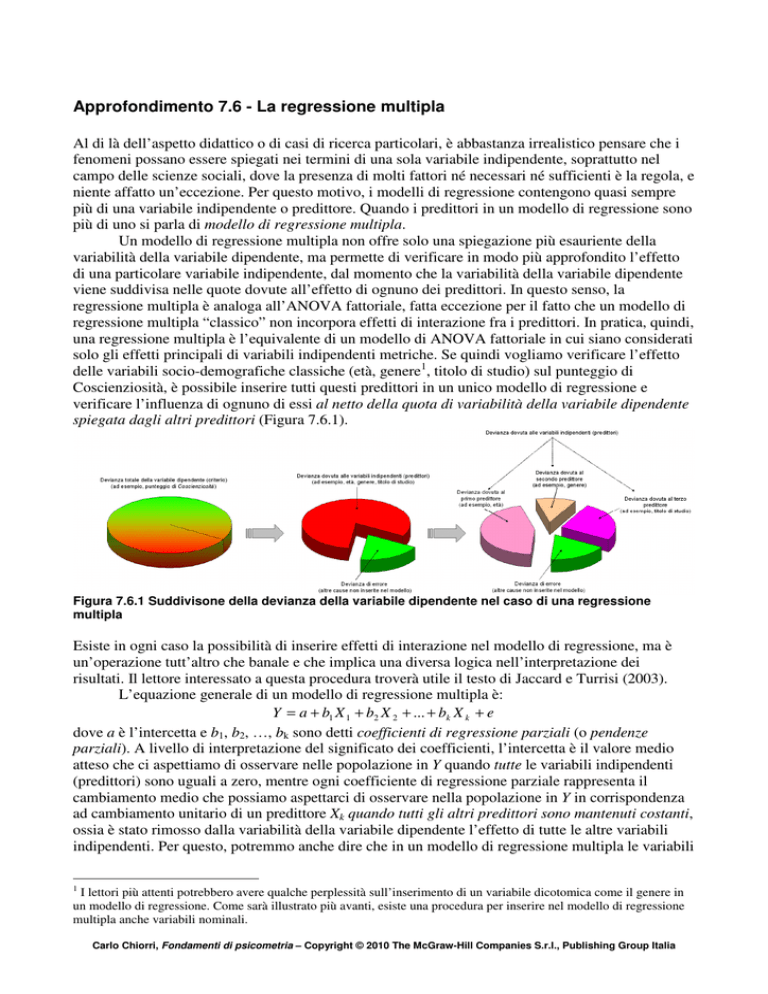

eseguita con SPSS sono quelli riportati in Figura 7.6.2.

Model Summary

Model

1

R

,768a

R Square

,589

Adjusted

R Square

,583

Std. Error of

the Estimate

5,95495

a. Predictors: (Constant), Anni di Scolarizzazione,

Genere, Età

5

Gli anni di scolarizzazione possono essere ottenuti ricodificando il titolo di studio in base al numero di anni di studio

necessari per raggiungere quel titolo: quindi avremo che nessun titolo = 0, licenza elementare = 5, licenza media = 8,

diploma di scuola superiore = 13, laurea triennale = 16, laurea specialistica = 18, dottorato di ricerca /master /

specializzazione = 21,5.

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

ANOVAb

Model

1

Regression

Residual

Total

Sum of

Squares

9979,443

6950,432

16929,875

df

3

196

199

Mean Square

3326,481

35,461

F

93,806

Sig.

,000a

a. Predictors: (Constant), Anni di Scolarizzazione, Genere, Età

b. Dependent Variable: Coscienziosità

Coefficientsa

Model

1

(Constant)

Età

Genere

Anni di Scolarizzazione

Unstandardized

Coefficients

B

Std. Error

5,167

1,852

,222

,024

6,173

,845

1,110

,105

Standardized

Coefficients

Beta

,418

,335

,486

t

2,789

9,064

7,308

10,563

Sig.

,006

,000

,000

,000

Zero-order

,488

,370

,538

Correlations

Partial

,543

,463

,602

Part

,415

,334

,483

Collinearity Statistics

Tolerance

VIF

,986

,996

,989

1,014

1,004

1,011

a. Dependent Variable: Coscienziosità

Figura 7.46 Output di SPSS per un’analisi di regressione multipla standard

Nella prima tabella di Figura 7.6.1, Model Summary, vengono riportati il valore di R, che è la

correlazione del criterio con l’insieme (set) dei predittori (e quindi rappresenta il coefficiente di

correlazione multipla fra criterio e predittori), il valore grezzo di R2 (R Square), il valore di R2

“aggiustato” (Adjusted R Square) e l’errore standard dei punteggi stimati (Std. Error of the

Estimate). Questa tabella mostra come l’insieme dei predittori spieghi nel complesso quasi il 60%

della variabilità della variabile dipendente. Il valore di Adjusted R2 è calcolato come:

Adjusted R 2 = 1 −

(200 − 1)

(n − 1)

(1−,589) =,583

(1 − R 2 ) = 1 −

(200 − 3 − 1)

(n − k − 1)

Per verificare la sua significatività dobbiamo consultare la tabella ANOVA, dove troviamo il valore

di F. Si noti come il rapporto fra la devianza (Sum of Squares) dovuta alla regressione (Regression

= 9979,443) e quella totale (Total = 16929,875) sia uguale al valore di R2 = ,589. La significatività

di F è calcolata su R2 (e non su Adjusted R2) per gradi di libertà a numeratore uguali al numero di

predittori (3) e a denominatore uguali al numero di soggetti meno numero di predittori meno uno (n

− k − 1 = 200 − 3 − 1 = 196):

F3,196 =

(n − k − 1) × Adjusted R 2 (200 − 3 − 1)×,589

=

= 93,81

k (1 − Adjusted R 2 )

3(1−,589)

Nella tabella Coefficients sono riportate tutte le informazioni relative alle stime dei parametri. Il

valore (Constant) è l’intercetta, il cui valore stimato è 5,17, ed è significativamente diversa da zero

(p = ,006, colonna Sig.). Questo significa che quando tutti i predittori sono uguali a zero, il

punteggio medio di Coscienziosità atteso nella popolazione è 5,17. Questo valore in realtà non ci

dice niente perché corrisponde ad un individuo che ha zero anni, è femmina (Genere = 0) e ha zero

anni di scolarizzazione: naturalmente è possibile trovare una donna che non abbia titolo di studio,

mentre è assurdo pensare di aver misurato la coscienziosità in un bambino appena nato.

Nella colonna Unstandardized Coefficients troviamo i valori di b (sottocolonna B) e il loro

errore standard (sottocolonna Std. Error). Se facciamo il rapporto B / Std. Error troviamo il valore

di t nella colonna t, dal quale è calcolata la significatività nella colonna Sig.. Ad esempio, nel caso

dell’età abbiamo ,222 / ,024 = 9,25 (al netto degli errori di approssimazione al terzo decimale).

Tutti e tre i coefficienti di regressione sono statisticamente significativi (Sig. < ,05). Possiamo

quindi scrivere l’equazione di regressione multipla:

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

YˆCoscienziosità = 5,17 + 0,22 X Età + 6,17 X Genere + 1,11X Scolarizzazione

Che informazioni ci danno i coefficienti di regressione parziali? Che, mantenendo tutte le altre

condizioni costanti, quando l’età aumenta di un anno, possiamo attenderci un aumento medio del

punteggio di Coscienziosità di 0,22 punti; che i maschi (Genere = 1) ottengono al test per la misura

della Coscienziosità 6,17 punti in più delle femmine (Genere = 0), e che per ogni anno in più di

scolarizzazione possiamo attenderci un aumento medio di coscienziosità di 1,11 punti. Se

dovessimo indicare quale predittore ha la maggiore influenza sulla variabile dipendente non

potremmo basarci su questi risultati, dato che i tre predittori hanno unità di misura diverse (nel caso

del genere di fatto nemmeno esiste un’unità di misura). Non ha senso utilizzare il livello di

significatività, e in questo caso lo avrebbe ancora meno dato che per tutti i predittori è minore di

,001, per cui rivolgiamo la nostra attenzione alla colonna Standardized Coefficients Beta, dove sono

riportati i coefficienti di regressione parziali calcolati sulle variabili standardizzate. Aver

standardizzato predittori e criterio significa aver riportato tutte le misure sulla stessa scala in cui

media = 0 e deviazione standard = 1, per cui l’intercetta è uguale a zero, ma non significa aver

eseguito una standardizzazione anche dei coefficienti di regressione, che quindi, a differenza di

come molti pensano, possono risultare maggiori di |1.0| (Courville & Thompson, 2001). Se

scrivessimo l’equazione di regressione con i β avremmo:

*

*

*

*

YˆCoscienzio

sità = 0, 418 X Età + 0,335 X Genere + 0, 486 X Scolarizzazione

I β rappresentano la variazione media attesa in Y in termini di numero di deviazioni standard che ci

attendiamo di osservare quando il predittore varia di una deviazione standard. L’interpretazione di

questo dato non è immediata come quella del coefficiente di regressione calcolato sui dati grezzi, e

in ogni caso non è scritto da nessuna parte che la variazione di una deviazione standard nel

punteggio di età sia equivalente alla variazione di una deviazione standard del numero di anni di

scolarizzazione. Ma c’è di più: come fa il genere a variare di una deviazione standard? La sola

considerazione dei β come indici di dimensione dell’effetto è dunque insufficiente e

fondamentalmente fuorviante (Courville & Thompson, 2001). Dobbiamo quindi consultare anche la

sottocolonna Zero-order della colonna Correlations: in questa colonna sono riportati i coefficienti

di correlazione bivariati fra i predittori e il criterio, che nel contesto della regressione multipla sono

detti coefficienti strutturali rS (structure coefficients). E’ interessante notare come la somma dei

prodotti β × rS produca il valore di R2:

R 2 = ∑ β j rSj =,418×,488+,335×,370+,486×,538 =,589

Questo significa che un certo predittore può avere una correlazione con Y (rS) molto alta ma un

coefficiente standardizzato β molto basso, o viceversa, quando i predittori hanno un certo grado di

correlazione fra di loro. Nel caso che stiamo esaminando questo non succede perché i predittori

sono indipendenti fra di loro (si noti come nella colonna Collinearity Statistics tutti i valori di

Tolerance siano prossimi a 1, il che significa che la variabilità spiegata di ogni predittore da parte

degli altri sia praticamente uguale a zero), ma come fanno notare Courville e Thompson (2001)

quello di considerare solo i β è un errore che viene commesso molto spesso, anche in articoli

pubblicati dalle riviste scientifiche. Questa strategia, infatti, è corretta solo se i predittori sono

perfettamente indipendenti fra loro e si è certi di aver specificato il modello di regressione esatto: se

questo non succede, l’aggiunta o l’esclusione di un altro predittore dal modello può radicalmente

alterare i valori del β di uno specifico predittore (Thompson, 1999). L’entità del β infatti dipende

dagli altri predittori inclusi nell’equazione di regressione, per cui è sensibile ai cambiamenti che

avvengono nel numero di predittori (Dunlap & Landis, 1998).

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Per valutare adeguatamente l’impatto di un predittore sulla variabile dipendente, quindi,

dobbiamo tenere conto sia del coefficiente β che del coefficiente strutturale rS calcolando la

dimensione dell’effetto f2. Nel caso della regressione multipla, l’f2 di un predittore si calcola:

f2 =

R 2 − Rk2−1

1− R2

dove R2k-1 è il valore di R2 calcolato senza il predittore del quale si vuole determinare la dimensione

dell’effetto. Calcolare questo valore è semplicissimo perché basta calcolare ΣβjrSj senza il

predittore. Quindi avremo che i tre f2 per i tre predittori sono:

R 2 − Rk2−1 ,589 − (,335×,370+,486×,538)

=,50

=

1−,589

1− R2

R 2 − Rk2−1 ,589 − (,418×,488+,486×,538)

2

f Genere

=

=,30

=

1−,589

1− R2

R 2 − Rk2−1 ,589 − (,418×,488+,335×,370)

2

f Scolarizzazione =

=,64

=

1−,589

1− R2

2

f Età

=

In base alle linee guida della Tabella 7.24 del manuale possiamo considerare questi effetti come

Grande, Moderato e Grande, rispettivamente.

Carlo Chiorri, Fondamenti di psicometria – Copyright © 2010 The McGraw-Hill Companies S.r.l., Publishing Group Italia