REGRESSIONE LINEARE SEMPLICE

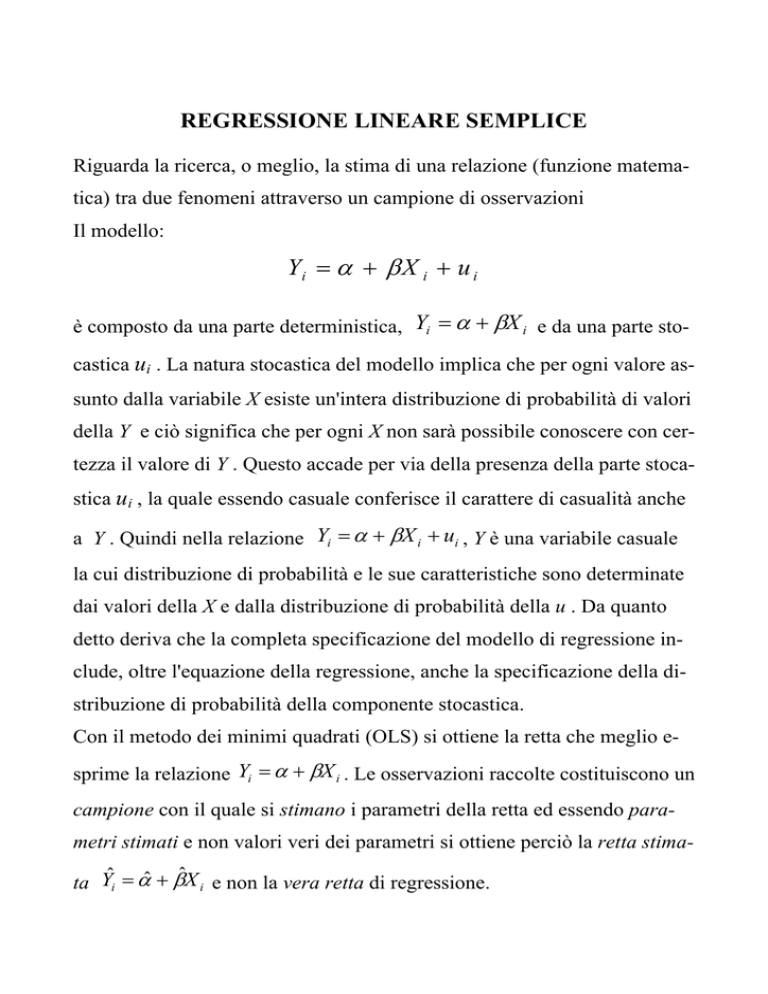

Riguarda la ricerca, o meglio, la stima di una relazione (funzione matematica) tra due fenomeni attraverso un campione di osservazioni

Il modello:

Yi = α + β X i + u i

è composto da una parte deterministica, Yi = α + βX i e da una parte stocastica ui . La natura stocastica del modello implica che per ogni valore assunto dalla variabile X esiste un'intera distribuzione di probabilità di valori

della Y e ciò significa che per ogni X non sarà possibile conoscere con certezza il valore di Y . Questo accade per via della presenza della parte stocastica ui , la quale essendo casuale conferisce il carattere di casualità anche

a Y . Quindi nella relazione Yi = α + βX i + ui , Y è una variabile casuale

la cui distribuzione di probabilità e le sue caratteristiche sono determinate

dai valori della X e dalla distribuzione di probabilità della u . Da quanto

detto deriva che la completa specificazione del modello di regressione include, oltre l'equazione della regressione, anche la specificazione della distribuzione di probabilità della componente stocastica.

Con il metodo dei minimi quadrati (OLS) si ottiene la retta che meglio esprime la relazione Yi = α + βX i . Le osservazioni raccolte costituiscono un

campione con il quale si stimano i parametri della retta ed essendo parametri stimati e non valori veri dei parametri si ottiene perciò la retta stimata Yˆi = αˆ + βˆX i e non la vera retta di regressione.

Le differenze, o scarti, o residui tra i valori Yi e i valori Yˆi stimati vengono

interpretati come realizzazioni ûi della variabile casuale u.

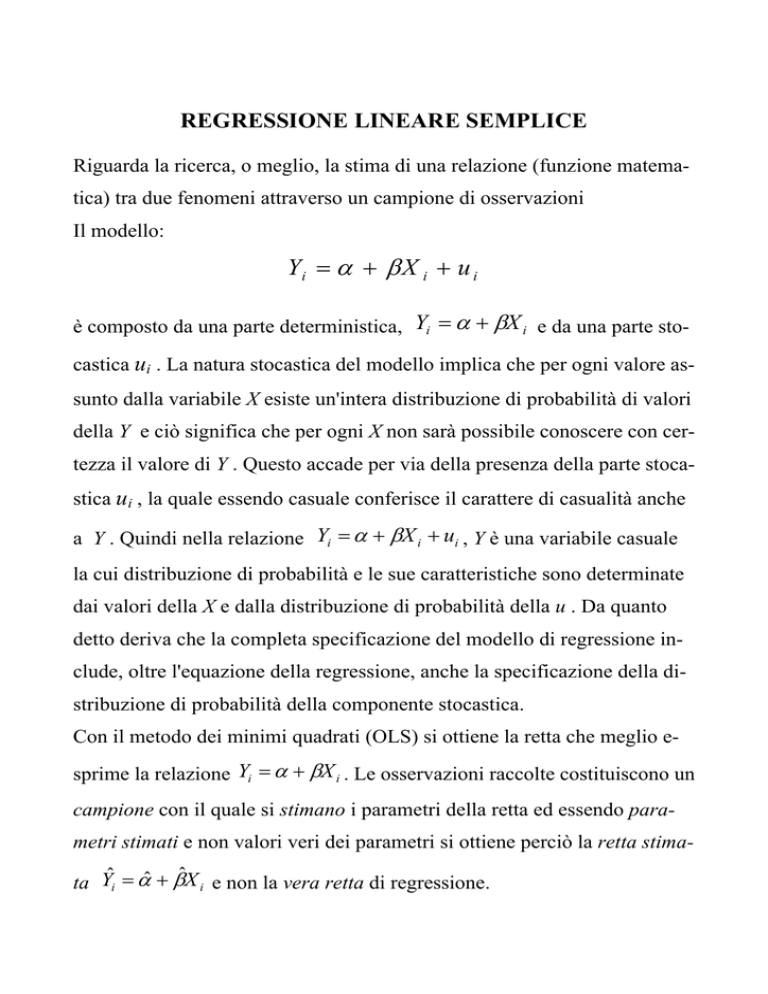

Ogni Yi è una v.c., con una propria distribuzione di probabilità intorno al

valor medio E (Yi X i ) = α + βX i che rappresenta il valore della retta in

corrispondenza di Xi, la cui deviazione casuale è sintetizzata nella v.c. u.

Con il metodo dei minimi quadrati si ottengono quelle stime dei parametri

che rendono minimo il residuo o la deviazione e quindi rende minima la

parte stocastica.

E (Yi X i ) = α + βX

x1

x2

xk

Il grafico mostra come in corrispondenza di ogni osservazione x (variabile indipendente) vi è una v. c. y (variabile dipendente) con distribuzione normale.

Specificazione completa del modello di regressione:

1) Yi = α + βX i + ui ;

2) E (ui ) = 0 ; valor medio nullo

2

3) Var (ui ) = σ ; varianza costante (omoschedasticità)

4) Cov (ui , u j ) = 0 ; indipendenza dei residui

2

5) u ≈ N (0, σ ) ; distribuzione normale

6) X variabile deterministica.

Dato il modello Y i = α + β X i + u i per via dei minimi quadrati (OLS)

si ottengono le stime α e β, cioè:

βˆ =

∑ (x − x )( y − y )

∑ (x − x )

i

αˆ = y − βˆ ⋅ x

i

2

i

ˆ

ˆ

e di conseguenza Yi = αˆ + β ⋅ X i , i valori stimati di Y.

Si considera poi la differenza tra i valori empirici e i valori stimati:

ei = Yi − Yˆi , cioè la stima della parte stocastica u o i residui, e si calcola

l’errore della stima (SEE)

S

2

e

(Y − Yˆ )

∑

=

i

2

i

n−2

∑e

=

2

i

n−2 ,

Se =

∑e

2

i

n−2 .

Inferenza e diagnosi della regressione.

Per i parametri stimati si calcola la statistica (campionaria) T- Student

sulla base dell’ipotesi nulla Ho: β = α = 0 (assenza di relazione)

t0( n − 2) =

αˆ − α

Sα

t1( n−2) =

βˆ − β

Sβ

Dove Sα e Sb sono gli errori standard dei parametri. Si rifiuta l’ipotesi

nulla quando

t c >α t ( n − 2)

oppure si guarda il P-value, la probabilità

P(| t( n−2) |≥ tc ) , aspettandoci che sia un valore più piccolo di α=0.05.

Sia per i parametri stimati che per i valori stimati di Y si hanno gli intervalli di confidenza; per il parametro β l’intervallo è:

P ( βˆ − t α 2 S β ≤ β ≤ βˆ + t α 2 S β ) = 1 − α

Analogamente per α e Yi ; nel caso di Yi = α + βX i l'intervallo è:

-10

-5

0

5

P (Yˆi − t α 2 S y ≤ α + β ⋅ x i ≤ Yˆi + t α 2 S y ) = 1 − α

-10

-5

0

5

x

y

Fitted values

dl

ul

Altro importante indice che va controllato nella diagnosi della regressione

è il coefficiente di adattamento R², detto anche coefficiente di determinazione: dato

∑(y − y) = ∑(y − yˆ ) +∑(yˆ − y)

2

i

2

i

i

2

i

R

2

=

∑ ( yˆ

∑ (y

i

− y )2

i

− y )2

Esso misura quanto è spiegata la variazione di Y con la retta di regressione

(cioè con X [variabile esogena]) ed è 0< R² <1;

ei2 ≈f 0 .

quando R² ~>1,

∑

Prima di affrontare la regressione va però constatato se vi è una relazione

tra X e Y, cioè tra variabile esogena e variabile endogena, calcolando il

coefficiente di correlazione , che nel caso di una sola variabile esogena è:

(xi − x )( yi − y )

cov( x, y )

R=

=

SxS y

(xi − x )2 ( yi − y )2 , −1 ≤ R ≤ 1 ,

∑

∑

∑

mentre quando si hanno più variabili esogene si determina la matrice di

correlazione. Attenzione, il coefficiente R misura una correlazione lineare.