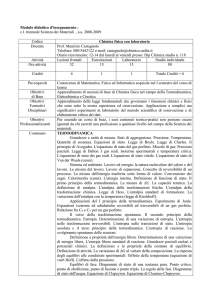

Università degli Studi di Pisa

Facoltà di Scienze Matematiche Fisiche e naturali

Corso di Laurea in Fisica

Anno Accademico 2002-2003

Tesi di Laurea

Formulazione assiomatica della

Termodinamica

Candidato:

Giuseppe De Nittis

Relatore:

Chiar.mo Prof. Enore Guadagnini

Ai miei genitori

Sintesi dei risultati

Uno dei concetti fondamentali della fisica è quello di stato del sistema: lo stato

di un sistema è definito da tutto ciò che serve per caratterizzare completamente

e riproducibilmente la situazione sperimentale osservabile; le quantità che definiscono lo stato di un sistema riguardano, quindi, solo grandezze controllabili e

misurabili. In virtù di ciò, è una situazione molto comune in fisica, ritenere che

lo stato di un sistema possa essere determinato univocamente dai valori assunti

da n variabili reali indipendenti x1 , . . . , xn . Studiare la fisica di un sistema significa indagare le leggi di trasformazione alle quali il sistema deve ubbidire quando

compie una transizione tra due stati. Per comprendere come un sistema possa

evolvere tra due stati “lontani è fondamentale conoscere prima come il sistema

transita tra stati “molto vicini in seguito ad una trasformazione infinitesima.

Se il sistema evolve dallo stato x1 , . . . , xn allo stato x1 + dx1 , . . . , xn + dxn ,

possiamo assumere che la variazione di una generica variabile dipendente F sia

esprimibile cone una sovrapposizione lineare degli spostamenti infinitesimi dxi

nel modo seguente:

δF (x1 , . . . , xn ) =

n

X

gi (x1 , . . . , xn )dxi ,

(1)

i=1

dove i coefficienti gi sono, in genere, funzioni sufficientemente regolari delle

variabili di stato x1 , . . . , xn . Matematicamente l’espressione (1) prende il nome

di 1-forma. Se esiste una funzione a valori reali F = F (x1 , . . . , xn ) tale che

gi = ∂F/∂xi allora la (1) diviene

δF =

n

X

∂F

dxi = dF,

∂x

i

i=1

(2)

ossia la 1-forma è il differenziale esatto della funzione F ; in questo caso si parla

di 1-forma esatta.

In fisica teorica, spesso si è soliti ricondurre le leggi fisiche che determinano

l’evoluzione del sistema ad equazioni differenziali del tipo

δF =

n

X

gi dxi = 0.

(3)

i=1

La (3) prende il nome di equazione di Pfaff; risolvere una tale equazione significa

trovare una curva γ ∈ Rn , parametrizzata da ~x(t) = (x1 (t), . . . , xn (t)), tale che

n

X

dxi gi (~x(t))

δF (~x(t)) =

= 0.

(4)

dt t

i=1

i

Fisicamente la curva γ descrive la successione di stati attraversati dal sistema

durante la trasformazione.

Quando δF è una 1-forma esatta, l’integrale generale dell’equazione (3) è fornito

dalla famiglia di superfici equipotenziali ΣC le quali sono definite dall’equazione

F (x1 , . . . , xn ) = C con C ∈ R. Poiché le superfici ΣC non si possono intersecare

in nessun punto, in questo caso le curve γ, soluzioni dell’equazione di Pfaff

(3), non possono mai connettere due stati che appartengono a superfici diverse.

Fisicamente questo equivale ad affermare che esistono stati infinitamente vicini

allo stato di partenza che non potranno mai essere raggiunti dal sistema in

seguito ad una trasformazione; diremo che un tale sistema è soggetto ad una

condizione di irraggiungibilità.

La condizione di esattezza della 1-forma δF non è la richiesta più generale

affinché l’equazione (3) possa ammettere come soluzione generale delle superfici

equipotenziali. Data una 1-forma δF ′ non esatta, sotto opportune condizioni,

è possibile determinare una funzione a valori reali µ = µ(x1 , . . . , xn ) 6= 0 tale

che µδF ′ = dF è un differenziale esatto; la funzione µ prende il nome di fattore

integrante ed una equazione di Pfaff δF ′ = 0, per cui δF ′ ammette un fattore

integrante, viene detta olonoma. Se

δF ′ =

n

X

gi′ dxi = 0

(5)

i=1

è un’equazione di Pfaff olonoma per cui µδF ′ = dF , allora deve valere anche

che

n

X

µgi′ dxi = dF = 0

(6)

µδF ′ =

i=1

e quindi tutte le curve γ che sono soluzione della (5) devono risolvere anche

la (6) ed in definitiva, devono giacere sulle superfici equipotenziali definite da

F (x1 , . . . , xn ) = C. Ovviamente anche nel caso in cui il sistema fisico sia descritto da un’equazione olonoma, esso è soggetto ad una condizione di irraggiungibilità; punti appartenenti a superfici equipotenziali distinte non possono

essere connessi tra loro.

Sicuramente la condizione di olonomia dell’equazione (3) garantisce che per il

sistema deve valere una condizione di irraggiungibilità; Carathéodory dimostrò

che in realtà vale anche il viceversa. Il I Teorema di Carathéodory afferma che

se vi sono punti infinitamente vicini che non possono essere collegati con una

curva soluzione dell’equazione (3), allora quest’ultima deve essere necessariamente olonoma.

Il I Teorema di Carathéodory trova la sua più naturale applicazione alla termodinamica dei sistemi ad n gradi di libertà. Durante una trasformazione reversibile, il calore infinitesimo che il sistema termodinamico scambia con l’esterno è

dato da

n

X

gi (x1 , . . . , xn ) dxi ,

(7)

δQ =

i=1

quindi è esprimibile in termini di una 1-forma che, generalmente, non è esatta.

Tra tutte le trasformazioni termodinamiche reversibili, quelle che sono anche

adiabatiche devono soddisfare l’equazione di Pfaff

δQ =

n

X

gi dxi = 0.

i=1

ii

(8)

Come conseguenza di ripetute osservazioni sperimentali è lecito postulare che,

infinitamente vicino ad ogni stato di equilibrio di un sistema termodinamico,

vi sono altri stati di equilibrio che non sono raggiungibili tramite trasformazioni adiabatiche 1 ; questa è esattamente una condizione di irraggiungibilità

sull’equazione di Pfaff (8). Se si accetta questa ipotesi, allora, come immediata

conseguenza del Teorema di Carathéodory, deve esistere un fattore integrante

µ che rende esatta la quantità δQ, ossia tale che dS = µδQ; la funzione di

stato S prende il nome di entropia del sistema e come conseguenza della olonomicità della (8), segue che le trasformazioni adiabatiche reversibili giacciono

sopra superfici isoentropiche. Inoltre, richiedendo che in seguito all’accoppiamento termico due sistemi raggiungono la stessa temperatura, è possibile dimostrare 2 che il fattore integrante µ deve essere una funzione universale della

sola temperatura θ del sistema considerato; in questo caso sarà indicato con

µ = 1/T (θ). Per l’arbitrarietà sulla scelta della scala termometrica, è possibile

definire una nuova scala delle temperature, chiamata scala Kelvin, tramite la

relazione T = T (θ). In definitiva, postulando che i sistemi termodinamici siano soggetti ad una condizione di irraggiungibilità adiabatica, come inevitabile

conseguenza delle proprietà delle equazioni di Pfaff, deve esistere la funzione di

stato entropia, definita da dS = δQ/T per trasformazioni reversibili.

I risultati cosı̀ ottenuti non aggiungono nulla di nuovo alle conoscenze della termodinamica “tradizionale, tuttavia il lavoro di Carathéodory sintetizza tutte

le conseguenze fisiche in un’unica, rigorosa teoria matematica; l’esistenza delle

superfici isoentropiche non dipende dalle proprietà dei cicli di Carnot (fondamentali nel lavoro di Clausius), essa è una conseguenza naturale delle proprietà

delle equazioni di Pfaff che sono alla base della descrizione dei fenomeni termodinamici.

Infine, rafforzando il postulato di irraggiungibilità adiabatica 3 , è possibile recuperare la legge dell’aumento dell’entropia includendo, in tal modo, nello schema

matematico di Carathéodory, la descrizione dei fenomeno irreversibili .

1 Come sarà dimostrato nel Paragrafo 3.3, la richiesta di irraggiungibilità è già contenuta

nell’enunciato del II Principio della termodinamica dato da Kelvin e Planck, e come tale non

aggiunge nulla di nuovo alle ipotesi minime che stanno alla base della formulazione classica

della termodinamica.

2 Questo è il contenuto del II Teorema di Carathéodory.

3 Anche la versione “forte del postulato è già contenuta nell’enunciato di Kelvin-Planck.

iii

Prefazione

La termodinamica, come disciplina fisica, nasce ufficialmente con la pubblicazione degli studi di S. Carnot nel 1824. Solo negli anni che vanno dal 1850

al 1856, tuttavia, tale disciplina assume una formulazione coerente e moderna,

soprattutto grazie ai lavori di Clausius e Kelvin (con i quali si rinuncia definitivamente all’idea del calorico). Nel 1890, come risultato degli studi di Planck,

viene riconosciuto il ruolo fondamentale che ha il concetto di entropia nella

comprensione dei fenomeni termodinamici; con questo fatto la termodinamica

riceve la formulazione, pressoché definitiva, tuttora studiata nei vari corsi di fisica. Tuttavia la termodinamica classica (ossia quella nata dai lavori di Clausius,

Kelvin e Planck) si basa su principi di carattere fenomenologico ed ingegneristico, come, ad esempio, appare evidente dagli enunciati del II Principio dati da

Clausius e da Kelvin e Planck. Questo faceva sı̀ che la termodinamica sfuggisse

alla pretesa, tipicamente ottocentesca, di voler ricondurre tutti i fenomeni fisici

a principi semplici e di tipo meccanico-matematico. Inoltre la termodinamica

di Clausius, Kelvin e Planck utilizzava una matematica eccessivamente semplice

rinunciando, quasi totalmente, agli strumenti del calcolo infinitesimale (come

ad esempio l’utilizzo di equazioni differenziali) e questo appariva come un limite

per una più profonda comprensione dei principi termodinamici stessi. Spinto

da queste premesse, nel 1908, M. Born incitò il giovane matematico greco C.

Carathéodory a studiare una nuova formulazione della termodinamica, che desse a questa disciplina una veste puramente teorica. I’impegno di Carathéodory

si concretizzò in un articolo pubblicato 4 nel 1909. In questo lavoro egli apporta

delle importanti innovazioni; per la prima volta si introducono le equazioni differenziali in termodinamica e per la prima volta si formula una teoria fisica in

maniera totalmente assiomatica. In particolare l’enunciato fenomenologico del

II Principio dato da Kelvin viene sostituito da un’ipotesi esclusivamente matematica.

Il proponimento del presente lavoro è quello di esporre, in maniera semplice e

rigorosa, le idee di Carathéodory che stanno alla base della formulazione assiomatica della termodinamica. L’esposizione degli argomenti è stata suddivisa

in tre capitoli: il Cap.1 è di carattere esclusivamente matematico ed è dedicato

all’esposizione dei concetti matematici necessari per comprendere e dimostrare

i due Teoremi di Carathéodory; in particolare si espone la teoria delle equazioni

di Pfaff e si discutono le condizioni di esistenza del fattore integrante fino ad

arrivare a dare una completa caratterizzazione delle equazioni pfaffiane olonome esclusivamente in termini di una condizione di irraggiungibilità; il Cap.2 è

4 C. Carathéodory: Untersuchungen über die Grundlagen der Thermodynamik, Math. Ann.

67, 355 (1909).

iv

dedicato alla formulazione assiomatica della termodinamica che si basa sull’assunzione di alcune semplici ipotesi lavorative alle quali vengono affiancati tre

assiomi basilari (i tre Principi della termodinamica); dall’enunciato di Carathéodory del II Principio, grazie ai due Teoremi di Carathéodory, si dimostra

l’esistenza di superfici isoentropiche e vengono recuperati tutti i risultati propri

della termodinamica classica; nel Cap.3 si confronta l’impostazione classica con

la formulazione assiomatica e tale obbiettivo raggiunto tramite un confronto tra

l’enunciato di Kelvin-Planck ed il Principio di irraggiungibilità di Carathéodory;

al fine di evidenziare le differenze concettuali che intercorrono tra l’approccio

classico e quello assiomatico, verrà esposta, in maniera sintetica, la teoria del

fattore integrante di Clausius, basata sui cicli di Carnot.

G. De Nittis

v

Indice

1 I teoremi di Carathéodory

1.1 Superfici . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.1 Gli insiemi di livello ed il teorema di Dini . . .

1.1.2 Il Piano tangente ad una superficie . . . . . . .

1.2 Curve . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2.1 Definizioni generali . . . . . . . . . . . . . . . .

1.2.2 Curve appartenenti ad una superficie . . . . . .

1.2.3 Differenziazione lungo una curva . . . . . . . .

1.3 Le 1-forme . . . . . . . . . . . . . . . . . . . . . . . . .

1.3.1 Definizione generale . . . . . . . . . . . . . . .

1.3.2 1-forme esatte . . . . . . . . . . . . . . . . . . .

1.3.3 L’integrale di linea . . . . . . . . . . . . . . . .

1.3.4 Il fattore integrante . . . . . . . . . . . . . . .

1.3.5 Cambiamento di coordinate . . . . . . . . . . .

1.3.6 Condizioni per l’esistenza del fattore integrante

1.4 Le equazioni di Pfaff . . . . . . . . . . . . . . . . . . .

1.4.1 Il problema di Pfaff . . . . . . . . . . . . . . .

1.4.2 Interpretazione geometrica . . . . . . . . . . .

1.4.3 I teoremi di Carathéodory . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Gli assiomi della termodinamica

2.1 Concetti introduttivi . . . . . . . . . . . . . . . . . . . . . .

2.1.1 Sistemi termodinamici . . . . . . . . . . . . . . . . .

2.1.2 L’equilibrio termodinamico . . . . . . . . . . . . . .

2.1.3 Variabili intensive e variabili estensive . . . . . . . .

2.1.4 Sistemi accoppiati . . . . . . . . . . . . . . . . . . .

2.2 La temperatura empirica . . . . . . . . . . . . . . . . . . . .

2.2.1 Il principio zero della termodinamica . . . . . . . . .

2.2.2 Il concetto di temperatura . . . . . . . . . . . . . . .

2.3 Lavoro e calore . . . . . . . . . . . . . . . . . . . . . . . . .

2.3.1 Il lavoro per i sistemi termodinamici . . . . . . . . .

2.3.2 Trasformazioni quasi-statiche . . . . . . . . . . . . .

2.3.3 Forze generalizzate e lavoro termodinamico . . . . .

2.3.4 Il primo principio della termodinamica; il concetto di

2.4 L’entropia . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.4.1 Processi reversibili ed irreversibili . . . . . . . . . . .

2.4.2 Il primo principio in forma differenziale . . . . . . .

2.4.3 Il secondo principio della termodinamica; l’entropia .

vi

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

calore

. . .

. . .

. . .

. . .

1

1

1

2

4

4

5

7

8

8

8

10

11

13

16

19

19

20

21

28

28

28

29

29

30

32

32

33

35

35

36

37

39

42

42

43

44

2.5

2.4.4

I cicli

2.5.1

2.5.2

2.5.3

Variazione di entropia nei processi reali

termodinamici . . . . . . . . . . . . . . .

La disuguaglianza di Clausius . . . . . .

Il rendimento di un ciclo . . . . . . . . .

Il ciclo di Carnot . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

47

49

49

51

52

3 Termodinamica classica e termodinamica assiomatica

54

3.1 Gli enunciati classici del II Principio . . . . . . . . . . . . . . . . 54

3.2 La teoria del fattore integrante di Clausius . . . . . . . . . . . . . 54

3.3 Vantaggi di una formulazione assiomatica . . . . . . . . . . . . . 59

Bibliografia

62

vii

Capitolo 1

I teoremi di Carathéodory

1.1

1.1.1

Superfici

Gli insiemi di livello ed il teorema di Dini

Sia A ∈ Rn un generico insieme aperto e connesso 1 ; data una funzione φ : Rn ⊇

A → R, l’equazione

φ(~x) = φ(x1 , . . . , xn ) = C,

C∈R

(1.1)

determina una relazione in Rn . L’insieme ΣC = {~x ∈ A ⊆ Rn | φ(~x) = C}

dei punti di Rn che soddisfano la (1.1) prende il nome di insieme di livello di

φ. L’insieme ΣC è interpretabile come l’intersezione del grafico di y = φ(~x) con

l’iperpiano y = C; al variare di C in R la (1.1) individua una famiglia continua

di insiemi di livello di φ. Se la funzione φ è monodroma in A (ossia se assume

un unico valore nel punto considerato), allora i due generici insiemi di livello

ΣC e ΣC ′ , con C 6= C ′ non avranno alcun punto in comune.

Può succedere, sotto opportune condizioni, che la (1.1) sia esplicitabile (almeno

localmente) rispetto ad una delle n variabili x1 , . . . , xn , che indicheremo con xi ;

quando ciò accade è possibile risolvere la (1.1) ricavando xi in funzione delle

restanti n − 1 variabili x1 , . . . , xi−1 , xi+1 , . . . , xn . In questo caso ΣC coincide

(almeno localmente) con il grafico di una funzione di n − 1 variabili della forma

z ≡ xi = χ(i) (x1 , . . . , xi−1 , xi+1 , . . . , xn ).

(1.2)

Le funzioni tipo χ(i) (il pedice i indica che è stata esplicitata la i-esima variabile) sono definite in modo implicito dall’equazione (1.1). Formalizziamo

quanto detto con una definizione precisa. Sia ~x = (x1 , . . . , xn ) ∈ Rn , indicheremo con ~x = (x1 , . . . , xi−1 , xi+1 , . . . , xn ) ∈ Rn−1 la restrizione del vettore

posizione ~x all’ipersuperfice (n − 1)-dimensionale relativa agli assi coordinati

x1 , . . . , xi−1 , xi+1 , . . . , xn ; possiamo introdurre la seguente

Definizione 1 (funzione implicita) Sia φ : Rn ⊇ A → R. La fuzione z ≡

xi = χ(i) (~x), con ~x ∈ B ⊆ Rn−1 , si dice definita implicitamente dall’equazione

(1.1) se accade che:

1 Nel seguito, salvo avviso contrario, con il simbolo A indicheremo sempre un sottoinsieme

di Rn aperto e connesso.

1

• il grafico di χ(i) è contenuto in A, ossia

Graf [χ(i) ] ⊂ A;

• per ogni ~x ∈ B deve valere che

φ(~x, χ(i) (~x)) = C.

Le condizioni sufficienti a garantire esistenza ed unicità di una funzione implicita

sono contenuti nel seguente, importante

Teorema 1 (delle funzioni implicite) Sia φ : Rn ⊇ A → R; se accade che

• φe

∂φ

∂xi

sono continue in A;

• nel punto ~y = (~y , yi ) ∈ A si ha

φ(~y ) = φ(~y , yi ) = C

e

∂φ 6= 0;

∂xi ~y

allora esiste un intorno B ⊂ Rn−1 di ~y ed un’unica funzione χ(i) tale che

χ(i) (~y ) = yi

e

φ(~x, χ(i) (~x)) = C

∀ ~x ∈ B.

Inoltre, se vale che

• φ è di classe C 1 (A) 2 ;

allora χ(i) è di classe C 1 (B) e, per ogni k 6= i, vale la seguente formula:

∂φ ∂χ(i) ∂xk ∀ ~x ∈ B.

= − ∂φ ∂xk ~x

(1.3)

∂xi (~

x,χ(i) (~

x))

Per una dimostrazione del Teorema delle funzioni implicite si può consultare

[Pagani-Salsa, volume I, pg. 404].

Dall’enunciato del teorema segue che la regolarità della funzione φ si trasferisce

alla funzione χ(i) , ossia se φ ∈ C k (A), allora χ(i) ∈ C k (I).

1.1.2

Il Piano tangente ad una superficie

Il Teorema delle funzioni implicite permette di dare una notevole caratterizzazione degli insiemi di livello ΣC , relativi ad equazioni del tipo (1.1), nel caso in

cui la funzione φ sia almeno di classe C 1 . Nell’intorno dei punti in cui accade

che

∂φ

∂φ

~

6= 0,

(1.4)

,...,

∇φ ≡

∂x1

∂xn

l’insieme ΣC è il grafico di una funzione del tipo (1.2) di classe C 1 . Chiameremo

regolari tutti i punti di Rn che verificano la (1.4) mentre chiameremo singolari

~ = 0. Inoltre, diamo la seguente

quei punti per cui ∇φ

2 La funzione φ è di classe C 1 (A) se tutte le derivate parziali

e sono continue in A.

2

∂φ

∂xk

con k = 1, . . . , n esistono

Definizione 2 (funzione regolare) Sia φ : Rn ⊇ A → R una funzione di

classe C 1 (A); se tutti i punti di A sono regolari per φ, allora diremo che φ è

una funzione regolare su A.

Se ~

y = (~y , yi ) è un punto in cui la funzione φ è regolare allora, poiché χ(i) è C 1 in

un intorno di ~y, la funzione χ(i) deve ammette in tale intorno l’aprossimazione

lineare del primo ordine data da

X ∂χ(i) (xk − yk ) + o(k~x − ~y k).

χ(i) (~x) = χ(i) (~y ) +

(1.5)

∂xk ~y

k6=i

Osserviamo che la funzione

xi = χ(i) (~y ) +

X ∂χ(i) (xk − yk )

∂xk ~y

(1.6)

k6=i

ha come grafico in Rn una iperpiano (n − 1)-dimensionale passante per il punto

~y = (~y , yi ) e la (1.5) equivale ad affermare che essa è la funzione lineare (o meglio

affine) che meglio approssima χ(i) in un intorno di ~y . L’iperpiano affine definito

dall’equazione (1.6) prende il nome di piano tangente al grafico di χ(i) nel punto

~y = (~y , yi ). Quindi, come conseguenza del Teorema delle funzioni implicite,

segue che l’iperpiano affine (1.6) è tangente all’insieme di livello ΣC nel punto

~y ; inoltre ricordando che χ(i) (~y ) = yi ed utilizzando la formula (1.3), l’equazione

(1.6) per il piano tangente può essere riscritta in una forma simmetrica rispetto

a tutte le variabili nel modo seguente:

n

X

∂φ ~ y ) · (~x − ~y) = 0.

(xk − yk ) = ∇φ(~

(1.7)

∂xk y~

k=1

L’equazione (1.7) ci permette di fare le seguenti, importanti, considerazioni:

1. se φ è almeno di classe C 1 (A), allora in tutti i punti regolari per φ l’insieme di livello ΣC è localmente approssimabile con un iperpiano (n −

1)-dimensionale definito dall’equazione (1.7);

~ y ) è

2. se ~y ∈ ΣC è un punto regolare per la funzione φ allora il vettore ∇φ(~

ortogonale al piano tangente in ~y all’insieme di livello ΣC ; in questo caso

~ y ) è ortogonale a ΣC in ~y ;

si usa dire che il vettore ∇φ(~

3. se tutti i punti di ΣC sono regolari per φ, allora ΣC ammette un piano

tangente in ogni punto; diremo in questo caso che l’insieme ΣC è liscio e

chiameremo ΣC superficie equipotenziale o di livello di φ;

4. se la funzione φ : Rn ⊇ A → R è regolare e monodroma in A, allora il

campo vettoriale gradiente definito da

~ : Rn ⊇ A → Rn

∇φ

gode della proprietà di essere ortogonale alle superfici equipotenziali di φ.

3

1.2

1.2.1

Curve

Definizioni generali

Sia γ un sottoinsieme di Rn e supponiamo che esista una funzione continua

~x : [a, b] ⊇ R → Rn , con [a, b] intervallo della retta reale, tale che l’immagine di

~x sia appunto γ; diremo allora che ~x è una parametrizzazione dell’insieme γ. È

evidente che un medesimo insieme γ può avere più di una parametrizzazione.

Definizione 3 (curva e curva chiusa) Chiameremo curva in Rn un sottoinsieme γ ⊂ Rn munito di una parametrizzazione ~x = ~x(t) = (x1 (t), . . . , xn (t))

con t ∈ [a, b] ⊆ R. Diremo che γ è una curva chiusa se accade che ~x(a) = ~x(b).

Chiameremo l’insieme γ sostegno della curva. Una curva, quindi, deve essere

sempre determinata dalla coppia sostegno-parametrizzazione. In accordo alla

Definizione 2 vale la

Definizione 4 (curva regolare) Diremo che la curva γ, parametrizzata da

~x = ~x(t) con t ∈ [a, b], è regolare se:

• ~x è almeno di classe C 1 ([a, b]);

• per ogni t ∈ [a, b]

d~x ~v (t) ≡

6 0.

=

dt t

dx1

dxn

x

Il vettore ~v = d~

prende il nome di vettore tangente alla curva

dt =

dt , . . . , dt

γ o anche vettore velocità. Il nome è giustificato dal fatto che il sottospazio

affine di equazione

d~x ~

ξ(τ ) = ~x(t0 ) + τ

= ~x(t0 ) + τ~v (t0 )

τ ∈R

dt t0

descrive la retta tangente al sostegno della curva nel punto ~x(t0 ).

Definizione 5 (curva integrale) Sia γ una curva regolare parametrizzata da

~x : [a, b] → Rn . Diremo che γ è una curva integrale per il campo vettoriale

F~ : A ⊇ Rn → Rn se, per ogni t ∈ [a, b], sono verificate le seguenti condizioni:

• ~x(t) ∈ A;

• ~v (t) = F~ (~x(t)).

Le proprietà delle curve integrali sono espresse nel seguente

Lemma 1 Se il campo vettoriale F~ = F~ (~x) è di classe C k (A) con k ≥ 1, allora:

1. per ogni punto ~x0 ∈ A passa una ed una sola curva integrale γ(~x0 ; t) del

campo 3 ;

2. sul proprio intervallo di definizione, la parametrizzazione di tale curva è

di classe C k+1 ;

3 Le ipotesi assunte sono sovrabbondanti: per l’esistenza è necessario che il campo F

~ sia

continuo, mentre per l’unicità occorre assumere che esso sia localmente lipschitziano.

4

3. le curve γ(~x0 ; t) sono di classe C 1 rispetto alla variabile ~x0 .

Dimostrazione

Daremo solo un breve accenno della dimostrazione:

1. Consideriamo la curva integrale γ(~x0 ; t) parametrizzata da ~x = ~x(t) tale che

~x0 = ~x(t0 ); per definizione di curva integrale essa deve soddisfare

d~x = F~ (~x(t))

dt t

(1.8)

~x(t ) = ~x .

0

0

Quindi si tratta di un tipico problema di Cauchy con dato iniziale (t0 , ~x0 ) ed

il Teorema di esistenza ed unicità afferma che in un intorno [t0 − δ1 , t0 + δ2 ] la

curva soluzione ~x = ~x(t) esiste ed è unica. In oltre l’intervallo di definizione

può essere sempre prolungato ad un intervallo massimale [a, b]. Indicheremo

con γ(~x0 ; t) la curva soluzione definita sull’intervallo massimale relativa al dato

iniziale ~x0 e parametrizzata nel parametro t.

2. Per ciò che riguarda la regolarita della parametrizzazione ~x = ~x(t) osserviamo che essa deve essere sicuramente continua poiché per ogni t deve esistere la

derivata. Osserviamo che date due funzioni f e h rispettivamente di classe C p

e C q la funzione composta (f ◦ h) sarà di classe C r con r = min{p, q}. Dalla

prima delle (1.8) risulta che se si assume la funzione ~x = ~x(t) di classe C p con

p < k allora al fuzione composta che compare a secondo membro sarà di classe

C p e poiché questa è la derivata della parametrizzazione ~x = ~x(t) risulta che la

parametrizzazione stessa deve essere di classe C p+1 . Possiamo allora iterare il

ragionamento fino a ottenere che se la funzione F~ è di classe C k allora la curva

soluzione ammetterà una parametrizzazione di classe C k+1 .

3. Il Teorema sulla dipendenza continua dai dati iniziali asserisce che se γ(~x0 ; t)

e γ(x~′ 0 ; t) sono due curve soluzione del problema (1.8) parametrizzate rispettivamente da ~x = ~x(t) e x~′ = x~′ (t) con condizioni iniziali x~0 = ~x(t0 ) e x~′ 0 = x~′ (t0 )

allora vale che

||~x(t) − x~′ (t)|| ≤ ||~x0 − ~x′0 || eL(b−a)

∀t ∈ [a, b];

dove L è una opportuna costante. Questo prova che la curva γ(~x0 ; t) è sicuramente continua nel parametro ~x0 . Inoltre è possibile dimostrare che la curva

deve essere anche derivabile con continuità rispetto a ~x0 . ◭

Si può consultare [Pagani-Salsa, volume II, cap. 4] per una dimostrazione

precisa del precedente Lemma . Il Lemma 1 dice che l’insieme A può essere

rappresentato come unione disgiunta di tutte le curve integrali del campo F~ ;

questo si esprime dicendo che la famiglia delle curve integrali costituisce una

fogliazione di A.

1.2.2

Curve appartenenti ad una superficie

Definizione 6 Dato l’insieme di livello ΣC descritto dall’equazione φ(~x) = C,

diremo che la curva parametrizzata da ~x = ~x(t) giace su ΣC se il sostegno γ

della curva è tutto contenuto in ΣC , ossia se

φ(~x(t)) = C

∀ t ∈ [a, b].

5

Consideriamo la superficie di livello ΣC definita da φ(~x) = C e sia γ una

curva regolare appartenente a tale superficie e parametrizzata da ~x = ~x(t)

con t ∈ [a, b]; la restrizione della funzione φ sul sostegno della curva fornisce

un’applicazione dall’intervallo [a, b] in R definita da

[a, b] ∋ t → (φ ◦ ~x)(t) ≡ φ(~x(t)) ∈ R.

Poiché la curva γ giace sulla superficie la funzione composta (φ ◦ ~x) assume

sempre il valore costante C e quindi, usando la regola di derivazioni per funzioni

composte, si ha

n

0=

X ∂φ dxk

d

~ · ~v

(φ ◦ ~x) =

= ∇φ

dt

∂xk dt

∀ t ∈ [a, b].

(1.9)

k=1

Dalla (1.9) si deduce che il vettore velocità ~v = ~v (t) è sempre ortogonale al

~ applicato in ~x = ~x(t) e quindi giace nel piano tangente in quel punto

vettore ∇φ

alla superficie ΣC . Viceversa vale anche la seguente

Proposizione 1 Sia φ : Rn ⊇ A → R una funzione regolare in A. Se la curva

regolare γ ⊂ A, parametrizzata da ~x = ~x(t), soddisfa all’equazione differenziale

n

X

∂φ dxk

~ · ~v = 0

= ∇φ

∂xk dt

(1.10)

k=1

allora γ giace su di una superficie equipotenziale di φ.

Dimostrazione

Basta osservare che il primo membro della (1.10), se valutato lungo la curva ~x =

~x(t), è la derivata rispetto a t della funzione di una variabile (φ◦~x)(t) = φ(~x(t)).

La condizione di annullamento allora equivale a φ(~x(t)) = C con C ∈ R. Ciò

mostra che la curva γ deve appartenere ad una superficie equipotenziale di φ.

◭

Abbiamo visto che il vettore velocità di una curva che giace su di una superficie

equipotenziale ΣC appartiene al piano tangente alla superficie stessa, questo ci

permette di dare una nuova caratterizzazione per il piano tangente. Il piano

tangente in un punto a ΣC è l’insieme di tutti i vettori velocità di tutte le

possibili curve contenute in ΣC che passano per il punto considerato. Quanto

affermato è il contenuto della seguente

Proposizione 2 Sia ~x0 un punto appartenente ad una superficie regolare ΣC

definita da φ(~x) = C; se ~v è un vettore applicato in ~x0 ed appartenete al piano

tangente a ΣC in ~x0 , allora esiste una curva appartenete alla superficie, passante

per ~x0 e che in ~x0 possiede un vettore velocita uguale a ~v .

Dimostrazione

Consideriamo il seguente campo vettoriale

F~ (~x) = ~v −

~ x)

~v · ∇φ(~

~ x)||2

||∇φ(~

6

!

~ x).

∇φ(~

In ogni punto della superficie il campo F~ è ortogonale al campo gradiente (e

quindi giace nel piano tangente), infatti

!

~ x)

~

v

·

∇φ(~

~ x) = ~v · ∇φ(~

~ x) −

~ x)||2 = 0.

F~ (~x) · ∇φ(~

||∇φ(~

~ x)||2

||∇φ(~

~ x0 ) = 0. Poiché il campo F~ è

Inoltre F~ (~x0 ) = ~v poiché, per ipotesi, ~v · ∇φ(~

continuo (in virtù del fatto che φ è, per ipotesi, almeno C 1 e quindi il campo

gradiente è continuo), esso ammetterà una curva integrale ~x = ~x(t) tale che

~x(0) = ~x0 . Allora, in base alla Definizione 5 si ha che:

• la curva ha in ~x0 velocità pari a

d~x = F~ (~x0 ) = ~v ;

dt t=0

• valutando la derivata di (φ ◦ ~x) lungo la curva

d(φ ◦ ~x) ~ x(t)) · d~x = ∇φ(~

~ x(t)) · F~ (~x(t)) = 0.

=

∇φ(~

dt

dt t

t

In particolare si ottiene che l’espressione φ(~x(t)) assume un valore costante lungo

la curva e poiché, per ipotesi, φ(~x0 ) = C il valore di questa costante risulta

essere appunto C. Questo prova che la curva integrale ~x = ~x(t) appartiene alla

superficie equipotenziale ΣC . ◭

1.2.3

Differenziazione lungo una curva

Sia φ : Rn ⊇ A → R una funzione C 1 (A) e sia γ una curva regolare contenuta in

A e parametrizzata da ~x = ~x(t) con t ∈ [a, b]. La restrizione della funzione φ alla

curva γ fornisce un’applicazione da [a, b] in R. Indicando con dφ il differenziale

di questa applicazione 4 si ottiene che

!

n

n

X

X

∂φ

∂φ dxk

dt =

dxk

(1.11)

dφ =

∂xk dt

∂xk

k=1

k=1

k

dove dxk = dx

dt dt è il differenziale della funzione di una variabile xk = xk (t).

L’espressione (1.11) fornisce l’incremento infinitesimo della funzione φ quando

si compie uno spostamento infinitesimo lungo la curva ~x = ~x(t). La (1.11) può

essere scritta nella seguente forma più sintetica

~ · d~x.

dφ = ∇φ

(1.12)

Il vettore d~x = (dx1 , . . . , dxn ) prende il nome di vettore spostamento infinitesimo; esso è un vettore di lunghezza indeterminata (nel senso che rappresenta

una quantità infinitesima) ed indica la direzione lungo la quale si compie la

“ ”

f

differenziale di una funzione f : R 7→ R è definito da df = ddt

dt; questa relazione dice

che l’incremento infinitesimo df della funzione f è proporzionale all’incremento infinitesimo

della variabile indipendente t, con coefficiente di proporzionalità dato dalla derivata di f .

4 Il

7

variazione. Se si valuta la variazione infinitesima della funzione φ lungo una

qualsiasi curva che giace su di una superficie equipotenziale ΣC si ottiene che

dφ = 0 dato che il valore di φ è costante lungo dette curve; questo implica che

~ · d~x = 0.

dφ = ∇φ

(1.13)

Viceversa tutte le curve che soddisfano l’equazione (1.13) devono avere la proprietà che qualunque spostamento infinitesimo lungo esse avviene in direzione

ortogonale al gradiente di φ, ossia tali spostamenti sono sempre contenuti nei

piani tangenti ad una superficie equipotenziale di φ; inoltre, dato che lungo ogni

curva, per definizione vale che d~x = dt ~v , risulta che le equazioni (1.10) e (1.13)

sono perfettamente equivalenti ed ammettono come soluzioni tutte le curve che

giacciono sulle superfici equipotenziali di φ. Tuttavia, poiché come conseguenza

della Proposizione 2 i piani tangenti alle superfici equipotenziali coincidono con

gli insiemi di tutti i vettori velocità di tutte le curve contenute sulla superficie

stessa, e poiché ~v ∝ d~x, il problema della soluzione dell’equazione (1.13) può

essere ricondotto al problema della ricerca di quelle superfici che ammettono in

~

ogni punto piano tangente ortogonale a ∇φ;

tali superfici sono appunto tutte

quelle descritte da φ(~x) = C al variare di C in R, ossia l’intera famiglia di

superfici equipotenziali ΣC .

1.3

1.3.1

Le 1-forme

Definizione generale

Sia ~g : Rn ⊇ A → Rn un campo vettoriale non singolare (ossia che non si annulla

in nessun punto di A) e di classe C 1 (A) 5 . Indicando con d~x = (dx1 , . . . , dxn ) il

vettore spostamento infinitesimo possiamo introdurre la seguente

Definizione 7 (1-forma) Chiameremo forma differenziale lineare o più brevemente 1-forma associata al campo vettoriale ~g l’espressione formale

ω(~x) = ~g (~x) · d~x =

n

X

gk (~x)dxk .

(1.14)

k=1

1.3.2

1-forme esatte

Se il il campo ~g = ~g (~x) è ottenibile come gradiente di una funzione scalare

~ x), diremo che φ è una funzione

φ : Rn ⊇ A → R, ossia se vale che ~g (~x) = ∇φ(~

potenziale per il campo ~g; in tal caso il campo vettoriale prende il nome di campo

conservativo. Osserviamo, banalmente, che se φ è una funzione potenziale per

il campo ~g allora anche la funzione φ′ = φ + c, con c generica costante reale,

è una funzione potenziale per ~g ; se un campo vettoriale ammette una funzione

potenziale, allora essa è sempre definita a meno di una costante arbitraria.

5 Il

campo vettoriale ~g è di classe C 1 (A) se ogni componente gk = gk (~

x) è di classe C 1 (A)

∂gk

ossia se gk ammette in A tutte le derivate parziali ∂x (con i = 1, . . . , n) che devono essere,

i

inoltre, continue. Nel seguito, salvo avviso contrario, supporremo sempre che il generico campo

1

~g sia C (A) e non singolare.

8

Poiché per ipotesi il campo ~g è di classe C 1 (A), affinché φ possa essere una

funzione potenziale per ~g, è necessario almeno che φ sia di classe C 2 (A) 6 .

Definizione 8 (1-forma esatta) Sia ω una 1-forma associata al campo ~g ; se

φ è una funzione potenziale per il campo ~g diremo che ω è una 1-forma esatta.

Dalla Definizione 8 segue che se ω è esatta e se φ è la funzione potenziale

per ~g, allora in accordo alla (1.12) possiamo scrivere

~ · d~x = dφ.

ω = ~g · d~x = ∇φ

Quindi una 1-forma esatta coincide sempre con il differenziale di una funzione

scalare φ che sia almeno di classe C 2 . Una condizione necessaria per l’esattezza

di una 1-forma è espressa dalla seguente

Proposizione 3 Sia ω una 1-forma associata al campo ~g = (g1 , . . . , gn ). Se ω

è una forma esatta, allora in A deve valere che

∂gi

∂gk

=

∂xk

∂xi

∀ i, k = 1, . . . , n.

(1.15)

Dimostrazione

Le n relazioni che si ottengono dalle (1.15) ponendo i = k sono delle banali

identità, quindi supponiamo che i 6= k. poiché per ipotesi ω è esatta, esiste una

funzione potenziale φ ∈ C 2 (A) tale che

gi =

∂φ

∂xi

e

gk =

∂φ

.

∂xk

Poiché φ ∈ C 2 (A), si può applicare il Teorema di Schwarz sull’invertibilità

dell’ordine di derivazione e quindi

∂2φ

∂ 2φ

∂gk

∂gi

=

=

=

.

∂xk

∂xk ∂xi

∂xi ∂xk

∂xi

Ciò prova l’asserto. ◭

Per un fissato n le (1.15) rappresenta un sistema di n(n − 1)/2 equazioni indipendenti, tante quante sono le coppie di indici distinti i 6= k che è possibile

ottenere da un insieme di n indici 7 . Un campo vettoriale che soddisfa le (1.15)

viene detto irrotazionale; l’enunciato della Proposizione 3 può essere riformulato

nel seguente modo; se la 1-forma ω è esatta, allora il campo vettoriale ~g ad essa

associato deve essere irrotazionale. Va tenuto presente che in generale non vale

l’inverso (ameno di fare alcune ipotesi sul dominio di definizione).

Facciamo alcuni esempi:

2

φ

(con i, k =

φ deve ammettere in A tutte le derivate parziali seconde ∂x∂ ∂x

i

k

1, . . . , n) che devono essere, inoltre, continue.

7 Più in generale dato un insieme di n oggetti distinti (ad esempio n indici) siamo interessati

a contare quanti sottoinsiemi di m ≤ n oggetti distinti si possono ottenere. Abbiamo n scelte

per il primo, n − 1 per il secondo e cosı̀ di seguito fino ad avere n − m + 1 scelte per l’ultimo

oggetto. Infine, poiché non siamo interessati a contare sottoinsiemi che differiscono solo per la

permutazione dei m elementi, dobbiamo dividere il risultato del conteggio per m!. In definitiva

n(n−1)...(n−m+1)

il numero dei possibili sottoinsiemi è

.

m!

6 Quindi

9

• In dimensione n = 2 sia ~g(x1 , x2 ) = (g1 , g2 ) un campo vettoriale; le condizioni di irrotazionalità (1.15) si riducono all’unica equazione non banale

∂g1 /∂x2 = ∂g2 /∂x1 .

• In dimensione n = 3 sia ~g (x1 , x2 , x3 ) = (g1 , g2 , g3 ) un campo vettoriale; le tre condizioni di irrotazionalità (1.15) non banali possono essere

~ × ~g = 0.

sinteticamente riassunte dall’equazione vettoriale rot ~g ≡ ∇

1.3.3

L’integrale di linea

Sia ω una 1-forma associata al campo vettoriale ~g e sia γ una curva regolare

contenuta in A e parametrizzata da ~x = ~x(t) con t ∈ [a, b]; possiamo introdurre

la seguente

Definizione 9 Chiameremo integrale curvilineo di ω lungo γ la seguente espressione:

Z b

Z

~g (~x(t)) · ~v (t)dt

(1.16)

ω≡

a

γ

dove ~v = ~v (t) è il campo di velocità della curva γ associato alla parametrizzazione ~x = ~x(t).

Il valore dell’integrale di linea (1.16) non dipende dal tipo di parametrizzazione

data alla curva γ ma solo dal verso di percorrenza di tale curva. Supponiamo che

t sia una funzione continua e strettamente monotona di un nuovo parametro t′ ∈

[c, d], ossia t = t(t′ ) e sia, inoltre, ~y(t′ ) = ~x(t(t′ )) la nuova parametrizzazione.

Vale che

d~x dt ′

d~x

d~y

dt =

dt = ~v dt.

wdt

~ ′ = ′ dt′ =

dt

dt dt′

dt

Se γ è la curva parametrizzata in t mentre γ ′ quella parametrizzata in t′ vale

che

Z

Z

Z

Z

d

γ′

t(d)

~g (~y (t′ )) · w(t

~ ′ )dt′ =

ω=

c

ω,

~g (~x(t)) · ~v (t)dt = ±

t(c)

γ

dove si ha il segno + se t è una funzione strettamente crescente di t′ per cui

t(c) = a e t(d) = b (la curva viene percorsa nello stesso verso secondo ambo le

parametrizzazioni), mentre si ha il segno − se t è strettamente decrescente per

cui t(c) = b e t(d) = a (le due parametrizzazioni si differenziano per il verso di

percorrenza della curva).

Quando l’integrale di linea

H (1.16) viene valutato lungo una curva chiusa γ esso

si indica con il simbolo γ ω.

Proposizione 4 Sia ω una 1-forma esatta che ammette una funzione potenziale φ. Se γ è una curva parametrizzata da ~x = ~x(t) con t ∈ [a, b] e tale che

~x(a) = x~′ e ~x(b) = x~′′ , allora

Z

ω = φ(x~′′ ) − φ(x~′ ),

γ

ossia il valore dell’integrale dipende solo dagli estremi della curva, indipendentemente dalla curva scelta.

10

Dimostrazione

Poiché, per ipotesi, il campo ~g è conservativo ed in particolare coincide con il

campo gradiente di φ si ha che

dφ ~g (~x(t)) · ~v (t) =

.

dt ~

x(t)

Quindi

Z

γ

ω=

Z

b

a

dφ b

dt = φ(~x(t))|a = φ(x~′′ ) − φ(x~′ )

dt ~x(t)

Cio conclude la dimostrazione. ◭

Come ovvia conseguenza della Proposizione appena dimostrata segue che l’integrale di linea di una 1-forma esatta su ogni curva chiusa si annulla identicamente.

Si dimostra che vale anche il viceversa, ossia che se l’integrale di linea di una

1-forma si annulla identicamente su tutte le curve chiuse contenute in A, allora la 1-forma è esatta in A; una dimostrazione di questo asserto è data in

[Pagani-Salsa, volume II, pg. 47].

1.3.4

Il fattore integrante

Sia ω una 1-forma associata al campo vettoriale ~g ∈ C 1 (A);

Definizione 10 (fattore integrante) Se la 1-forma

ω(~x) =

n

X

gk (~x)dxk

k=1

non è esatta e se esiste una funzione µ : Rn ⊇ A → R tale che:

• µ è di classe C 1 (A);

• µ(~x) 6= 0 per ogni ~x ∈ A;

• la forma

ω ′ (~x) = µ(~x)ω(~x) =

n

X

µ(~x)gk (~x)dxk

k=1

è esatta;

allora diremo che la funzione µ è un fattore integrante per la 1-forma ω.

Vediamo a quali condizioni deve obbedire un campo ~g affinché la 1-forma ad

esso associato ammetti un fattore integrante. Se µ è un fattore integrante pre la

1-forma ω = ~g · d~x allora µω è una forma esatta e dalla Proposizione 3 segue che

il campo µ~g deve essere irrotazionale. Applicando le condizioni di irrotazionalità

(1.15) al campo µ~g si ottiene che

∂

(µgi ) =

∂xk

⇓

∂µ

∂gi

+ gi

=

µ

∂xk

∂xk

⇓

∂gk

∂gi

µ

=

−

∂xk

∂xi

∂

(µgk )

∂xi

µ

∂µ

∂gk

+ gk

∂xi

∂xi

gk

∂µ

∂µ

− gi

∂xi

∂xk

11

i, k = 1, · · · , n.

(1.17)

Le (1.17) rappresentano un sistema di n(n − 1)/2 equazioni differenziali indipendenti che devono essere simultaneamente verificate dal fattore integrante µ.

Consideriamo tre indici distinti s, k, i e scriviamo le tre seguenti relazioni

∂gi

∂µ

∂µ

∂gk

gs µ

= gs gk

−

− gs gi

∂x

∂x

∂x

∂x

k

i

i

k

∂gs

∂µ

∂µ

∂gi

gk µ

= gk gi

−

− gk gs

∂xi

∂xs

∂xs

∂xi

∂µ

∂µ

∂gs

∂gk

gi µ

= gi gs

−

− gi gk

∂xs

∂xk

∂xk

∂xs

che sommate membro a membro, ricordando che µ 6= 0, forniscono

∂gi

∂gs

∂gk

∂gk

∂gi

∂gs

+ gk

+ gi

=0

gs

−

−

−

∂xk

∂xi

∂xi

∂xs

∂xs

∂xk

(1.18)

che indicheremo anche con il simbolo

D~xsik [~g] = 0

dove D~xsik ha il significato di operatore differenziale sul campo ~g. Le (1.18)

rappresentano un insieme di n(n − 1)(n − 2)/6 condizioni indipendenti (cfr.

nota 7) per il campo vettoriale ~g, necessarie affinché la 1-forma ad esso associato

ammetti un fattore integrante; per tale motivo esse sono chiamate condizioni

di completa integrabilità. Osserviamo che se ω è una 1-forma esatta relativa

al campo irrotazionale ~g, allora le (1.18) sono banalmente verificate, mentre le

(1.17) si riducono a

gk

∂µ

∂µ

= gi

∂xi

∂xk

i 6= k = 1, . . . , n

che, in modo ovvio, ammettono come soluzione tutte le funzioni del tipo µ(~x) = c

con c costante reale.

Lemma 2 Sia ~g un generico campo vettoriali su A e α ∈ C 1 (A) una funzione

scalare; allora D~xsik si comporta come un operatore omogeneo di grado 1 rispetto

alla moltiplicazione per una funzione scalare.

Dimostrazione

La dimostrazione si riduce ad un conto diretto;

∂α

∂gi

∂α

∂gk

∂(αgi ) ∂(αgk )

= gs gi

+ αgs

.

−

− gk

−

gs

∂xk

∂xi

∂xk

∂xi

∂xk

∂xi

Se si sommano tre termini di questo tipo con gli indici messi a rotazione gli

addendi contenenti le derivate parziali di α si annullano a vicenda e quindi si

ottiene che

D~xsik [α~g ] = αD~xsik [~g ]

(1.19)

Ciò conclude la dimostrazione. ◭

Come immediata conseguenza del Lemma 2 è evidente che se il campo ~g soddisfa

le condizioni di completa integrabilità, allora le soddisfa anche ogni campo della

12

forma µ~g.

Ha senso scrivere le condizioni (1.18) solo nel caso in cui si ha a che fare con

campi vettoriali di dimensione n ≥ 3 (infatti servono almeno tre indici distinti);

come vedremo nel Paragrafo 1.3.6, ciò deriva dal fatto che per n = 2 ogni 1-forma

ammette sempre un fattore integrante e quindi se vi fossero condizioni tipo le

(1.18), esse dovrebbero essere banalmente verificate da ogni campo vettoriale

bidimensionale.

Nel caso n = 3 le (1.18) si riducono ad un’unica condizione non banale sulle

componenti del campo ~g = (g1 , g2 , g3 ) che può essere scritta sinteticamente

~ × ~g ) · ~g = 0.

come (∇

Se una 1-forma ammette un fattore integrante allora essa possiede tutta una

famiglia di fattori integrante; in altre parole la scelta del fattore integrante per

una 1-forma non è univoca. Questo è il contenuto del seguente

Teorema 2 Sia ω una 1-forma relativa al campo vettoriale ~g su A e sia µ un

fattore integrante per ω. Per definizione di fattore integrante il campo vettoriale

µ~g si può esprimere come il gradiente di una funzione potenziale φ. Se Ψ : R →

R è una generica funzione continua che ammette come primitiva la funzione ψ,

allora

µ′ (~x) = Ψ(φ(~x))µ(~x)

è un nuovo fattore integrante per ω ed il campo µ′~g ammetterà come funzione

potenziale

φ′ (~x) = (ψ ◦ φ)(~x) ≡ ψ(φ(~x)).

Dimostrazione

La 1-forma µω è il differenziale della funzione potenziale φ, ossia µω = dφ. Consideriamo la funzione composta φ′ (~x) = (ψ ◦ φ)(~x) ≡ ψ(φ(~x)) dove la funzione

ψ : R → R è definita per ipotesi da

Z

ψ(ξ) = Ψ(ξ)dξ.

Poiché Ψ è continua in R si ha che ψ ∈ C 1 (R) e quindi la funzione composta

φ′ = ψ ◦ φ è sicuramente differenziabile. Per la regola di differenziazione delle

funzioni composte si ottiene che

dφ′ = d(ψ ◦ φ) =

dψ ~

(∇φ · d~x) = Ψ(φ)dφ.

dφ

In definitiva vale che Ψ(φ)µω = Ψ(φ)dφ = dφ′ e ciò mostra che µ′ = Ψ(φ)µ è

un nuovo fattore integrante per ω. ◭

1.3.5

Cambiamento di coordinate

Ogni punto di Rn può essere messo in corrispondenza biunivoca con una nupla di numeri reali; stabilire una tale corrispondenza significa definire quello

che si chiama un sistema di coordinate. Ovviamente i modi in cui è possibile

costruire una sistema di coordinate sono molteplici e può essere interessante

studiare le relazioni che intercorrono tra due diversi sistemi di coordinate. In

questo paragrafo discuteremo brevemente il comportamento delle 1-forme sotto

13

cambiamenti di coordinate. Consideriamo i due sistemi di coordinate X =

{x1 , . . . , xn } ed Y = {y1 , . . . , yn } definiti in un aperto A ⊆ Rn ; chiameremo

cambiamento di coordinate ogni funzione Φ : Y → X che sia biunivoca ed

almeno di classe C 1 insieme alla sua inversa. In genere rappresenteremo un

cambiamento di coordinate nel seguente modo

x1 = x1 (y1 , . . . , yn )

..

..

.

.

xn = xn (y1 , . . . , yn )

o più sinteticamente scrivendo ~x = Φ(~y ). Un campo vettoriale su un sottoinsieme di Rn è un oggetto astratto nel senso che è definito in modo indipendente

dalla particolare scelta di coordinate e questo vale ovviamente anche per le 1forme. Supponiamo che ω = ω(x1 , . . . , xn ) sia una 1-forma rappresentata nel

sistema di coordinate X mentre Ω = Ω(y1 , . . . , yn ) sia la sua rappresentazione

nel sistema di coordinate Y , ossia

ω(x1 , . . . , xn )

q

Pn

g

(x

k=1 k 1 , . . . , xn )dxk

Φ

←→

Ω(y1 , . . . , yn )

q

Pn

G

(y

k=1 k 1 , . . . , yn )dyk

(1.20)

Siamo interessati a determinare la relazione che intercorre tra i campi ~g =

~ = G(y

~ 1 , . . . , yn ) affinché il diagramma (1.20) sia soddisfatto.

~g (x1 , . . . , xn ) e G

Poiché se xk = xk (y1 , . . . , yn ), allora

dxk =

n

X

∂xk

∂ys

s=1

dys

deve valere che

ω(Φ(~y )) =

=

n

X

k=1

n

X

gk (Φ(~y ))dxk =

n

X

gk

k=1

s=1

n

X

k=1

= Ω(~y )

∂xk

gk

∂ys

dove si è posto

Gs (~y ) =

!

n

X

k=1

dys =

n

X

∂xk

s=1

n

X

∂ys

dys

!

Gs (~y)dys

s=1

∂xk gk

.

∂ys Φ(~y)

(1.21)

La (1.21) rappresenta la regola di trasformazione che permette di esprimere lo

stesso campo vettoriale in diversi sistemi di coordinate; essa è la nota legge di

trasformazione dei vettori cartesiani.

~ lo stesso campo vettoriale espresso rispettivamente nei

Lemma 3 Siano ~g e G

sistemi di coordinate X ed Y ; se ~g soddisfa le equazioni (1.18) rispetto alle

~ soddisfa le medesime equazioni rispetto alle coordinate

coordinate X allora G

Y.

14

Dimostrazione

Dalla (1.21) si ottiene

∂Gi

∂yk

!

n

X

∂

∂xt

=

gt

∂yk t=1 ∂yi

X

n n X

∂ 2 xt

∂gt ∂xt

gt

+

.

=

∂yk ∂yi

∂yk ∂yi

t=1

t=1

Allora, eliminando le derivate seconde in virtù del Teorema di Schwarz, vale che

ed osservando che

n X

∂Gi

∂gt ∂xt

∂Gk

∂gt ∂xt

−

=

−

∂yk

∂yi

∂yk ∂yi

∂yi ∂yk

t=1

n

X ∂gt ∂xp

∂gt

=

∂yk

∂xp ∂yk

p=1

possiamo, infine, scrivere

n n

X

X

∂gt ∂xp ∂xt

∂gt

∂Gk

∂xp ∂xt

∂gp ∂xp ∂xt

∂Gi

=

−

=

−

−

.

∂yk

∂yi

∂xp ∂yk ∂yi

∂yi ∂yk

∂xp

∂xt ∂yk ∂yi

t,p=1

t,p=1

Questa relazione esprime la legge di trasformazione di un tensore cartesiano di

rango due. Utilizzando l’ultima equazione, la (1.21) ed il fatto che gli indici di

sommatoria sono muti si ha

! n n

X

∂Gi

∂Gk

∂gp ∂xp ∂xt

∂xm X ∂gt

Gs

=

−

−

gm

∂yk

∂yi

∂ys t,p=1 ∂xp

∂xt ∂yk ∂yi

m=1

n

X

∂gp ∂xm ∂xp ∂xt

∂gt

−

.

=

gm

∂xp

∂xt ∂ys ∂yk ∂yi

m,t,p=1

La precedente relazione è la regola di trasformazione di un tensore cartesiano di

rango tre. Utilizzando il fatto che gli indici m, t, p sono muti, si verifica che

~ =

Dy~sik [G]

n

X

m,t,p=1

∂xm ∂xp ∂xt

D~xmtp [~g]

∂ys ∂yk ∂yi

(1.22)

Per ipotesi gli addendi sotto il segno di sommatoria nel secondo membro della

(1.22) sono tutti nulli e quindi risulta nullo pure il primo membro; questo conclude la dimostrazione. ◭

Il lemma 3 sostanzialmente asserisce che la completa integrabilità di un campo

di vettori è una proprietà indipendente dal particolare sistema di coordinate,

ossia è una caratteristica intrinseca del campo vettoriale stesso. D’altra parte

anche l’ammettere un fattore integrante è una proprietà intrinseca; per i campi che posseggono un fattore integrante il Lemma 3 può essere dedotto come

conseguenza diretta dell’esistenza di un fattore integrante.

15

1.3.6

Condizioni per l’esistenza del fattore integrante

Nel Paragrafo 1.3.4 abbiamo dedotto che le equazioni (1.18) sono condizioni

necessaria affinché la 1-forma ω associata al un campo vettoriale ~g ammetti un

fattore integrante; nel presente paragrafo mostreremo come le (1.18) forniscono

anche una condizione sufficiente per l’esistenza del fattore integrante. Come

premessa a questo risultato generale dimostreremo che tutte le 1-forme in dimensione n = 2 ammettono sempre un fattore integrante; questo è il contenuto

del seguente

Lemma 4 Sia ω(x1 , x2 ) = g1 (x1 , x2 )dx1 + g2 (x1 , x2 )dx2 una 1-forma associata

al campo vettoriale ~g = (g1 , g2 ) : R2 ⊇ A → R2 , allora la 1-forma ω ammette

sempre un fattore integrante µ = µ(x1 , x2 ).

Dimostrazione

Consideriamo la seguente equazione differenziale

ω(x1 , x2 ) = g1 (x1 , x2 )dx1 + g2 (x1 , x2 )dx2 = 0

(1.23)

Cerchiamo una curva soluzione della (1.23) parametrizzata da (x1 (t), x2 (t)). Se

(v1 (t), v2 (t)) è il campo di velocità associato a tale curva l’equazione (1.23)

diviene

g1 (x1 (t), x2 (t))v1 (t) + g2 (x1 (t), x2 (t))v2 (t) = 0.

Quindi le curve soluzioni della (1.23) hanno in ogni punto vettore velocità ortogonale al campo (g1 , g2 ). Se in un sottoinsieme di R2 si definisce un campo vettoriale non singolare, allora in ogni punto di tale sottoinsieme rimane

univocamente determinato il sottospazio unidimensionale ortogonale al campo;

quindi, dato il campo (g1 , g2 ), è possibile costruire in modo univoco (a meno

dell’inversione del verso di tutti i vettori) un campo di versori continuo (v1 , v2 )

ortogonale a (g1 , g2 ) nel modo seguente:

1

(v1 , v2 ) = p

(g2 , −g1 )

(g1 )2 + (g2 )2

(1.24)

A meno di tutte le possibili riparametrizzazioni, tutte le curve soluzioni dell’equazione (1.23) sono tutte e sole le curve integrali del campo (1.24). Inoltre

dalla (1.24) risulta evidente che il campo (v1 , v2 ) è di classe C 1 (A) come il campo

(g1 , g2 ); quindi ci troviamo nelle ipotesi del Lemma 1 che ci assicura che l’insieme

delle curve soluzione dell’equazione (1.23) costituisce una fogliazione di A. Sia

γ(~x ′ ; t) la generica curva soluzione parametrizzata da (x1 , x2 ) = (x1 (t), x2 (t))

con t ∈ [a, b] e passante per il punto ~x ′ = (x′1 , x′2 ) quando t = t0 . Sia Γ una

curva trasversa a tutte le curve soluzione, ossia una curva regolare che interseca tutte le curve soluzione e tale che in nessun punto il suo vettore velocità

è parallelo al campo (v1 , v2 ); indichiamo con ~x = (x1 (s), x2 (s)) con s ∈ [c, d]

la parametrizzazione della curva Γ. Dal Lemma 1 segue che la generica curva

soluzione γ(~x ′ ; t) è di classe C 1 sia rispetto al parametro t che al dato iniziale

~x ′ ; la funzione composta Φ ≡ γ(~x(s); t) tale che Φ : [c, d] × [a, b] → A ⊆ R2

associa in modo biunivoco alla coppia (s′ , t′ ) il punto di coordinate (x1 , x2 ) che

la curva γ(~x(s′ ); t′ ), relativa al dato iniziale ~x(s′ ) ∈ Γ, tocca per t = t′ . La

funzione Φ risulta di classe C 1 rispetto ad entrambe le variabili s e t è quindi

è un cambio di coordinate, differenziabile con continuità, tra le variabili locali

16

(s, t) e le variabili cartesiane (x1 , x2 ) 8 . Nel piano s, t le curve soluzioni γ(~x ′ ; t)

diventano le rette s = r con r costante reale. Sia f : [c, d] × [a, b] → R una

generica funzione almeno di classe C 1 , tale che f (s, t) = f (s). La funzione f

assume valore costante lungo le curve soluzioni; per un cambiamento di variabili

si ottiene

φ(x1 , x2 ) ≡ f (Φ−1 (x1 , x2 )).

(1.25)

Supponiamo che fissato s′ , per ogni t valga che f (s′ , t) = f (s′ ) = C; per la

(1.25) deve accadere che

C = φ(x1 , x2 ) = f (Φ−1 (x1 , x2 )) = f (s′ , t)

∀t ∈ [a, b].

Questo significa che l’insieme dei punti per cui φ(x1 , x2 ) = C è esattamente il

sostegno della curva soluzione γ(~x(s′ ); t). Al variare di C tutte le curve soluzione

possono essere espresse come superfici equipotenziali della funzione φ che per

costruzione è di classe C 1 (A). Segue che il campo (g1 , g2 ) è ortogonale in tutti

i punti alle superfici equipotenziali di φ e quindi è parallelo in ogni punto al

gradiente di φ, ossia

∂φ ∂φ

µ(g1 , g2 ) =

,

∂x1 ∂x2

dove µ = µ(x1 , x2 ) è una opportuna funzione di classe C 1 che non si annulla

mai in A. Questo equivale a dire che il campo (g1 , g2 ) ammette come fattore

integrante µ; ciò conclude la dimostrazione. ◭

Il fattore integrante µ = µ(x1 , x2 ) va determinato risolvendo il sistema di equazioni differenziali (1.17) che per n = 2 si riduce all’unica equazione differenziale

del primo ordine

∂µ

∂µ

∂g1

∂g2

= g1

−

− g2

µ

∂x1

∂x2

∂x2

∂x1

che, in virtù del Lemma 4 deve ammettere una soluzione.

Siamo ora in grado di dimostrare il seguente

Teorema 3 ia ω una 1-forma associata al campo vettoriale ~g : Rn ⊇ A → Rn

di classe C 1 (A). Condizione necessaria e sufficiente affinché ω ammetta un

fattore integrante è che il campo ~g soddisfi il sistema di equazioni (1.18).

Dimostrazione

Nel Paragrafo 1.3.4 il sistema di equazioni (1.18) è stato dedotto come condizione necessaria per l’esistenza del fattore integrante di ω; mostriamo come esso

rappresenti anche una condizione sufficiente. Supponiamo che la 1-forma

ω(x1 , . . . , xn ) =

n

X

gk (x1 , . . . , xn )dxk

(1.26)

k=1

sia tale che il campo ~g = (g1 , . . . , gn ) soddisfi le relazioni (1.18) che qui riscriviamo

∂gi

∂gs

∂gk

∂gk

∂gi

∂gs

gs

+ gk

+ gi

= 0.

−

−

−

∂xk

∂xi

∂xi

∂xs

∂xs

∂xk

8 Si osservi che l’arbitrarietà nella scelta dell’arco tarsverso Γ e della sua parametrizzazione

con s equivale all’arbitrarietà nella scelta di diverse coordinate locali (s, t) nelle quali è possibile

esprimere la fogliazione come insieme di rette s = const.

17

Nell’espressione (1.26) manteniamo costanti le variabili x1 , . . . , xn−2 e facciamo

variare solo le variabili xn−1 , xn ; in altre parole consideriamo la restrizione della

1-forma ω al generico piano bidimensionale xn−1 , xn . Ristretta su tale iperpiano,

la (1.26) diviene

ω(λ, xn−1 , xn ) = gn−1 (λ, xn−1 , xn )dxn−1 + gn (λ, xn−1 , xn )dxn

(1.27)

dove con il parametro λ indichiamo l’insieme delle n − 2 variabili x1 , . . . , xn−2

che manteniamo costanti. La (1.27), per ogni valore del parametro λ, descrive

una 1-forma in due dimensioni; allora per il Lemma 4 esistono sempre un fattore

integrante µ = µ(λ, xn−1 , xn ) ed una funzione φ = φ(λ, xn−1 , xn ) (ovviamente

sia µ che φ devono dipendere dal parametro λ) tali che

µ(λ, xn−1 , xn )ω(λ, xn−1 , xn ) =

∂φ

∂φ

dxn−1 +

dxn .

∂xn−1

∂xn

(1.28)

Se ora consideriamo il parametro λ libero di variare otteniamo che µ e φ sono

funzioni di tutte le n variabili x1 , . . . , xn ed in particolare si ha che

n−2

X ∂φ

∂φ

∂φ

dxn−1 +

dxn = dφ −

dxk .

∂xn−1

∂xn

∂xk

k=1

Inserendo la (1.27) nella (1.28) ed usando la precedente uguaglianza si ottiene

#

"

n−2

X ∂φ

1

dφ −

dxk

gn−1 dxn−1 + gn dxn =

µ

∂xk

k=1

dove, ora, gn−1 , gn , µ e φ vanno considerate come funzioni di tutte le n variabili

x1 , . . . , xn . Facendo uso dell’ultima espressione possiamo riscrivere la (1.26) nel

seguente modo

#

"

n−2

n−2

X

X ∂φ

1

ω=

gk dxk +

dφ −

dxk

µ

∂xk

k=1

da cui

µω =

k=1

n−2

X

k=1

∂φ

µgk −

dxk + dφ.

∂xk

(1.29)

A questo punto è conveniente operare un cambiamento di variabili

(x1 , . . . , xn ) → (y1 , . . . , yn ) definito da

(

yk = yk (x1 , . . . , xn ) = xk

se

k = 1, . . . , n − 2, n

yn−1 = yn−1 (x1 , . . . , xn ) = φ(x1 , . . . , xn ).

In tale modo per gli incrementi infinitesimi si avrà che dyn−1 = dφ mentre

dyk = dxk per k = 1, . . . , n − 2, n. Infine ponendo

∂φ

k = 1, . . . , n − 2

Gk = µgk −

∂xk

la (1.29) assume la forma

Ω = µω =

n−2

X

Gk dyk + dyn−1 .

k=1

18

(1.30)

La 1-forma Ω espressa dalla (1.30) possiede un addendo in meno rispetto alla

1-forma originaria ω definita dalla (1.26); tuttavia, almeno in apparenza, le

funzioni Gk e quindi Ω dovrebbero dipendere da tutte le n variabili y1 , . . . , yn .

Inoltre dalla (1.30) risulta evidente che la la 1-forma ω ammette un fattore

integrante se e solo se lo ammette anche Ω, infatti siamo passati dalla (1.26)

alla (1.30) solo tramite passaggi algebrici. Sempre dalla (1.30) si vede che il

~ = (G1 , . . . , Gn ) si ottiene a partire dal campo vettoriale

campo vettoriale G

µ~g = (µg1 , . . . , µgn ) tramite il cambio di variabili (x1 , . . . , xn ) → (y1 , . . . , yn );

~ soddisfa le relazioni

questo, in base ai Lemmi 2 e 3, ci assicura che il campo G

(1.18) relativamente alle variabili y1 , . . . , yn in quanto, per ipotesi, il campo ~g

le soddisfa relativamente alle variabili x1 , . . . , xn . Scriviamo queste condizioni

~

per il campo G:

∂Gi

∂Gs

∂Gk

∂Gk

∂Gi

∂Gs

Gs

+ Gk

+ Gi

= 0.

(1.31)

−

−

−

∂yk

∂yi

∂yi

∂ys

∂ys

∂yk

Se nella (1.31) poniamo i = n − 1 e k = n, ricordando che in base alla (1.30)

deve essere Gn−1 = 1 e Gn = 0, si ottiene che

∂Gs

=0

∂yn

∀ s = 1, . . . , n

ossia nessuna componente del campo dipende da yn . Questo significa che Ω è

~ : Rn−1 ⊇

una 1-forma di dimensione n − 1 associata ad un campo vettoriale G

n−1

A→R

che continua a soddisfare le condizioni (1.18). Con il procedimento

usato abbiamo ricondotto il problema iniziale n-dimensionale ad un equivalente

problema (n − 1)-dimensionale. Iterando la tecnica n − 2 volte ci si riconduce

ad una 1-forma bidimensionale equivalente a quella di partenza; poiché, per

quanto dimostrato nel lemma 4, una 1-forma in dimensione 2 ammette sempre

un fattore integrante, allora anche la 1-forma di partenza ω deve ammettere

un fattore integrante sotto l’unica condizione di dover soddisfare le (1.18). Ciò

conclude la dimostrazione. ◭

La dimostrazione del Teorema 3 qui riportata ricalca quella data in [Honig, pg.

75].

1.4

1.4.1

Le equazioni di Pfaff

Il problema di Pfaff

Consideriamo su Rn la 1-forma ω relativa al generico campo vettoriale ~g .

Definizione 11 (equazione di Pfaff ) Data la 1-forma ω chiameremo equazione di Pfaff o anche espressione pfaffiana la seguente equazione differenziale:

ω(~x) =

n

X

gk (~x)dxk = 0.

(1.32)

k=1

Il problema di Pfaff consiste nella ricerca di quelle curve regolari γ ⊂ A che

risolvono l’equazione (1.32), ossia di quelle curve γ parametrizzate da ~x = ~x(t)

con t ∈ [a, b] tali che ω(t) = ω(~x(t)) = 0 per ogni valore di t. Data un’equazione

di Pfaff chiameremo curva di Pfaff ogni curva soluzione di tale equazione.

19

1.4.2

Interpretazione geometrica

Supponiamo che la curva γ ⊂ A con parametrizzazione ~x = ~x(t) con t ∈ [a, b]

sia una curva soluzione per l’equazione di Pfaff (1.32), allora deve valere che

!

n

n

X

X

dxk

0 = ω(~x(t)) =

gk (~x(t))

dt =

gk (~x(t))vk (t) dt,

dt

k=1

k=1

ossia ~g (~x(t))·~v (t) = 0 per ogni t ∈ [a, b] dove ~v = ~v (t) è il vettore velocita relativo

alla curva γ. In definitiva le curve di Pfaff relative all’equazione (1.32) sono tutte

e sole le curve che posseggono in ogni punto un vettore velocità ortogonale al

campo di vettori ~g. In effetti l’equazione (1.32), che possiamo riscrivere come

~g · d~x = 0, definisce in ogni punto dell’insieme di definizione A il sottospazio

ortogonale al vettore ~g valutato nello stesso punto; tale sottospazio avrà sempre

dimensione n − 1 poiché per ipotesi il campo ~g è assunto non singolare. Questo

significa anche che l’equazione (1.32) determina in ogni punto di A, n−1 possibili

direzioni indipendenti per gli spostamenti infinitesimi d~x.

L’equazione di Pfaff esatta

Supponiamo che la 1-forma ω che compare nell’equazione di Pfaff (1.32) sia

esatta ossia che il campo vettoriale ~g sia il gradiente di una funzione regolare φ;

in questo caso diremo che l’equazione di Pfaff è esatta e la (1.32) si riduce a

n

X

∂φ

~ · ~x = dφ.

dxk = ∇φ

0=ω=

∂xk

(1.33)

k=1

Per quanto discusso nel Paragrafo 1.2.3 le curve di Pfaff relative ad un’equazione

di Pfaff esatta sono tutte e sole le curve che giacciono sulle superfici equipotenziali ΣC definite dall’equazione φ(~x) = C; quindi nel caso di equazioni esatte il

problema di Pfaff si riduce alla determinazione stessa delle superfici equipoten~ è regolare allora la funzione

ziali ΣC . Poiché per ipotesi il campo vettoriale ∇φ

φ = φ(~x) non può assumere valore costante su tutto un intorno di A, infatti

se ciò accadesse in un tale intorno il gradiente si annullerebbe 9 . Da questo

segue che se ~x0 è un punto appartenente alla superficie equipotenziale ΣC in

ogni intorno di tale punto esistono punti che non appartengono a ΣC e quindi

in ogni intorno (piccolo a piacere) di ~x0 vi sono punti che non possono essere

raggiunti da ~x0 percorrendo una curva di Pfaff soluzione dell’equazione esatta

(1.33).

L’equazione di Pfaff olonoma

Consideriamo ora il caso in cui la 1-forma ω che compare nell’espressione pfaffiana (1.32) ammetti un fattore integrante µ; in questo caso diremo che l’equazione

di Pfaff è olonoma. Se la curva γ è soluzione dell’equazione

ω(~x) =

n

X

gk (~x)dxk = 0

k=1

9 Ciò può essere giustificato ricordando che il gradiente di una funzione di più variabili

punta nella direzione di massima crescita per la funzione.

20

e se µ = µ(~x) è una generica funzione di classe C 1 (A) tale da non annullarsi mai

in A, allora γ sarà anche soluzione dell’equazione

ω ′ (~x) = µ(~x)ω(~x) = µ(~x)

n

X

gk (~x)dxk = 0.

k=1

Ora, se µ è un fattore integrante di ω, ciò significa che il campo µ~g è il gradiente

di una funzione regolare φ e la precedente equazione si riduce ad una espressione

tipo la (1.33). Quindi, in virtù della discussione precedente, la curva γ deve

necessariamente appartenere ad una superficie equipotenziale ΣC della funzione

φ = φ(~x). Quanto affermato ha un’interpretazione geometrica immediata. Una

curva di Pfaff possiede in ogni punto un vettore velocità ortogonale al campo

~g ; se tale campo ammette un fattore integrante significa che esso, a meno di

essere opportunamente riscalato in ogni punto, è fondamentalmente un campo

~

gradiente, ossia ~g = µ−1 ∇φ.

Ora in ogni punto del dominio lo spazio ortogonale

~ e quindi coincide con i piani tangenti alle

a ~g coincide con quello ortogonale a ∇φ

superfici equipotenziali definite da φ(~x) = C; quindi i vettori velocità della curva

γ apparteranno a tali piani tangenti e la curva stessa dovrà necessariamente

giacere su di una superficie equipotenziale. Anche nel caso di equazioni olonome

il problema di Pfaff si riduce alla determinazione stessa di tutte le superfici

equipotenziali ΣC relative ad una determinata funzione φ. Possiamo dimostrare

la seguente

Proposizione 5 Consideriamo il generico punto ~x0 ∈ A, allora in ogni intorno

piccolo a piacere di ~x0 vi sono punti che non possono essere raggiunti da ~x0

percorrendo una curva soluzione di un’equazione di Pfaff olonoma.

Dimostrazione

L’asserto è sicuramente vero per le curve soluzioni di un’equazione esatta; la dimostrazione è conclusa osservando che tutte le curve soluzioni di un’equazione

olonoma sono anche soluzioni di un’opportuna equazione esatta ottenuta moltiplicando la prima per il fattore integrante. ◭

Un’ottima discussione sul significato e sull’interpretazione geometrica delle equazioni di Pfaff si trova in [Afanassjeva, appendice I ].

1.4.3

I teoremi di Carathéodory

In questo paragrafo caratterizzeremo le equazioni di Pfaff in base al comportamento delle curve soluzione; prima di fare questo introduciamo la

Definizione 12 (condizione di irraggiungibilità) Sia ~g un campo di vettori regolare definito nell’aperto A di Rn ; diremo che l’equazione di Pfaff

ω(~x) =

n

X

gk (~x)dxk = 0

(1.34)

k=1

soddisfa la condizione di irraggiungibilità se, comunque scelto un punto ~x0 ed

un suo intorno U ⊂ A piccolo a piacere, vi sono punti appartenenti ad U

che non possono essere raggiunti a partire da ~x0 lungo una curva γ soluzione

dell’equazione (1.34).

21

Grazie alla Proposizione 5 si è visto che se un’equazione di Pfaff è olonoma, o

in particolar modo esatta, allora essa soddisfa la condizione di irraggiungibilità.

Con un lavoro di grande rilievo Carathéodory riuscı̀ a dimostrare che la condizione di irraggiungibilità non è solo necessaria affinché una espressione pfaffiana

sia olonoma, ma costituisce anche una condizione sufficiente; in questo modo

l’irraggiungibilità caratterizza in modo completo le equazioni di Pfaff olonome.

Teorema 4 (I Teorema di Carathéodory) Se l’espressione pfaffiana

(1.34) soddisfa la condizione di irraggiungibilità, allora essa è olonoma, ossia

ammette un fattore integrante.

Dimostrazione

Sia γ una curva soluzione per l’equazione (1.34) parametrizzata da ~x = ~x(t) con

t ∈ [a, b] e siano Pα e Pβ due punti appartenenti a tale curva rispettivamente di

coordinate

~xα = ~x(tα ),

~xβ = ~x(tβ )

a ≤ tα < tβ ≤ b.

Sia ϕ una seconda curva soluzione per la (1.34) tale da intersecare la curva γ

nel punto Pα e che si differenzia da quest’ultima per una quantità infinitesima;

parametrizzeremo ϕ nel seguente modo

~

y (t) = ~x(t) + εξ(t)

~

t ∈ [a, b]

~ è

dove ε > 0 è un parametro formale che assumeremo piccolo mentre ξ~ = ξ(t)

~ α ) = 0. Indicheremo

una parametrizzazione regolare soggetta alla condizione ξ(t

con

d~x

~

v

(t)

=

dt t

d~y ~u(t) =

dt t

dξ~

~

=

w(t)

dt t

i campi di velocità relativi alle diverse parametrizzazioni e deve valere che ~u(t) =

~v (t) + εw(t).

~

Poiché per ipotesi sia γ che ϕ sono soluzioni dell’equazione (1.34)

si avrà che

n

X

gk (~x(t))vk (t) =

0

(1.35)

~

gk (~x(t) + εξ(t))[v

k (t) + εwk (t)] =

0.

(1.36)

k=1

n

X

k=1

Espandiamo in serie di Taylor nel parametro ε la componente gk nella (1.36)

fino al primo ordine in ε.

~

gk (~x(t) + εξ(t))

= gk (~x(t)) + ε

22

n

X

∂gk ξi (t) + o(ε).

∂xi ~x(t)

i=0

Inserendo questa espressione nella (1.36), tenendo conto della (1.35) e esplicitando solo i termini del primo ordine in ε si ha

n

n

X

X

∂gk gk (~x(t))wk (t) + ε

0=ε

ξi (t)vk (t) + o(ε).

∂xi ~x(t)

k,i=0

k=1

Dividendo tutto per ε e facendo il limite per ε → 0 otteniamo il risultato esatto

n

n

X

X

∂gk ξi (t)vk (t) = 0.

(1.37)

gk (~x(t))wk (t) +

∂xi ~x(t)

k=1

k,i=0

La (1.37) è un’equazione per le componenti della funzione ξ~ e quindi esprime

una condizione di dipendenza per una di tale componenti in funzione delle altre.

Se si fissano in modo arbitrario le funzioni ξ1 , . . . , ξn−1 (e quindi le derivate

w1 , . . . , wn−1 ) la (1.37) da la condizione che la componente ξn deve soddisfare.

Per semplificare la notazione rinunceremo ad esplicitare la dipendenza dalle

variabili ricordando che il campo ~g è valutato lungo la curva γ e che le funzioni

~x e ξ~ con le loro derivate ~v e w

~ dipendono dal parametro t. Riscriviamo la (1.37)

nel seguente modo:

!

!

n

n−1

n−1

n

X

X X

X

∂gk

∂gk

dξn

gk wk −

(1.38)

vk ξn = −

vk ξi ;

+

gn

dt

∂xn

∂xi

i=1

k=1

k=1

k=1

quest’ultima è un’equazione differenziale lineare del primo ordine per la funzione

ξn .

Sia λ = λ(t) una generica funzione di classe C 1 (A) e calcoliamo lungo la curva

γ la derivata della funzione λgn ξn ;

!

n

X

dλ

d

dξn

∂gn

vk ξn +

(λgn ξn ) = λgn

+λ

gn ξn .

(1.39)

dt

dt

∂xk

dt

k=1

Possiamo supporre, senza perdere di generalità che lungo la curva γ la componente gk del campo vettoriale non si annulli mai; qualora questo dovesse

accadere potremmo sempre ripetere il ragionamento per un’altra componente

di ~g, infatti poiché il campo è supposto non singolare, lungo ogni tratto di γ vi

è sempre qualche componente di ~g non nulla. Se si impone alla funzione λ di

soddisfare la relazione

n ∂gn

λ X ∂gk

dλ

vk

(1.40)

−

=

dt

gn

∂xn

∂xk

k=1

il secondo membro della (1.39) coincidere con λ-volte il primo membro della

(1.38); quindi se lungo la curva γ la funzione λ soddisfa la condizione (1.40) si

ha che

! #

"n−1

n

n−1

X

X X

d

∂gk

vk ξi .

(λgn ξn ) = −λ

gk wk +

dt

∂xi

i=1