UNIVERSITÀ DEGLI STUDI DI UDINE

FACOLTÀ DI LETTERE E FILOSOFIA

CORSO DI LAUREA DAMS

INDIRIZZO MUSICA

UNA PANORAMICA SULLE BASI DI DATI

ORIENTATE AL MUSIC INFORMATION

RETRIEVAL (MIR)

AN OVERVIEW OF MUSIC INFORMATION

RETRIEVAL (MIR) DATABASES

relatore

Ing. Sergio canazza

laureanda

Federica bressan

Anno Accademico 2002/2003

Italiano

INDICE

Parte 1

La rivoluzione mediale

9

Che cosa sono i nuovi media

11

Mappare i nuovi media: l’organizzazione

18

Come il mezzo influisce sul messaggio: le interfacce culturali

20

La logica del database e l’assenza di narratività

22

Cosa fare per non subire la logica del database

26

Parte 2

Introduzione

29

Struttura di una base di dati

31

Il Data Base Management System orientato agli oggetti (ODBMS)

34

Perché discutere di ODBMS in questa sede?

35

Parte 3

Le basi di dati e i dati multimediali

37

Le basi di dati multimediali

38

Problemi legati alle basi di dati multimediali

39

Le query nelle basi di dati multimediali

45

Parte 4

MIR: Music Information Retrieval

49

Le query by content

50

Musica a livello simbolico e a livello di segnale

51

Extensible Markup Language for Music Information Retrieval

53

Il MIR e la musica contemporanea

55

7

Una nuova metodologia: il Data Mining

56

Parte 5

La ricerca

61

L’ŐFAI di Vienna

62

Dannenberg e gli Stati Uniti

65

L’IRCAM di Parigi

68

Lo SHALAB giapponese

72

Parte 6

Alcune conclusioni

75

Glossario

79

Abbreviazioni

81

Bibliografia

82

Link

85

Indice figure

87

8

Parte 1

La rivoluzione mediale

Il distacco che ha caratterizzato per lungo tempo il contesto

tecnologico e quello delle scienze umane sta lentamente convergendo

verso una nuova visione integrata. Questo percorso diventa urgente e

più complesso secondo il ritmo irresistibile degli eventi che travolgono

la nostra realtà. In questo senso molte coscienze già si trovano unite

nella consapevolezza che sarebbe inutile, e dannoso, ignorare ancora

il quesito fondamentale: “Come si collocano i nuovi media in relazione

a diverse aree di cultura, passate e presenti?”.

9

Lev Manovich, nel libro “Il linguaggio dei nuovi media”♥,

sostiene che nei decenni presenti sia in corso una cambiamento

radicale, simile a quello vissuto nel XIV secolo con l’invenzione della

stampa a caratteri mobili e nel XIX secolo con l’introduzione della

fotografia.

Nondimeno

quella

attuale

potrebbe

rivelarsi

una

rivoluzione a più profondo impatto storico, coinvolgendo in modo

massificato e incondizionato importanti ambiti dello sviluppo della

società e della cultura moderna. Ma in che cosa consiste l’aspetto

fondamentale della “rivoluzione” che stiamo vivendo?

Tutto si può ricondurre in primo luogo ad un termine: il

digitale. Digitale contrapposto ad analogico, a continuo, e persino a

naturale. Non si vuole considerare solo l’aspetto discreto della

codifica digitale, che in questo senso non avrebbe il potere di essere il

motore di una rivoluzione; inoltre, nel suo senso più ampio, il digitale

non è una presenza recente nella cultura e nella società. I complici

che rendono questo elemento capace di turbare profondi e consolidati

equilibri sono le macchine.

Per chiarire il concetto di rivoluzione mediale, e per delineare

degli estremi che segnino cronologicamente il suo manifestarsi,

bisogna

che

vengano

comprese

alcune

sottili

differenze

che

riguardano la natura dei nuovi media e i messaggi che essi veicolano.

Che cosa sono realmente i nuovi media, e quale logica adottano nella

struttura? Perché e in che modo le macchine e il digitale sono

coinvolti nella rivoluzione mediale?

♥

L. Manovich, “Il linguaggio dei nuovi media” Milano, Edizioni Olivares, 2002

10

Che cosa sono i nuovi media

Tra gli esempi più citati sotto questa voce troviamo Internet, i

siti Web, i computer multimediali, i CD-ROM e i DVD, la realtà

virtuale. Ma quali sono le regole che stabiliscono che l’elenco debba

fermarsi qui, e con che ragione questi esempi rientrano nella

definizione di “nuovi media”?

In realtà, per comprendere una questione così delicata (e

complicata dal fatto che si trova in continua evoluzione) è necessaria

una riflessione critica, che esamini nel dettaglio le proprietà di quelli

che si dicono nuovi media, e che giustifichi le ragioni per cui qualcosa

non è un nuovo media.

Ad una prima analisi emerge lampante il fatto che molte delle

caratteristiche legate solitamente ai nuovi media siano proprie anche

di quelli che, per contro, si possono chiamare i “vecchi media”: il

cinema (che ormai vanta una storia più che centennale), la carta

stampata (giornali, riviste, volantini e via discorrendo), la radio e la

televisione via cavo. Prendiamo il fatto che, secondo alcuni criteri

generali e diffusi, i nuovi media siano caratterizzati dall’utilizzo del

computer

per

la

distribuzione

del

prodotto,

anziché

la

sua

realizzazione. In questo senso, dunque, i testi distribuiti sul computer

(via Web e libri elettronici) sono considerati nuovi media, mentre i

testi stampati su carta non lo sono. Analogamente, delle fotografie

digitali che necessitano di un computer per poter essere visualizzate,

non sono più considerate un nuovo media nel momento in cui

vengono stampate su una rivista o un libro. Come escludere, tuttavia,

delle pubblicazioni cartacee realizzate graficamente al computer, o dei

programmi televisivi montati e modificati digitalmente al computer?

11

Analizziamo altri aspetti dei nuovi media: l’interattività è una

tra le qualità specifiche più attribuite ai nuovi media. Nel caso dei

media computerizzati, tuttavia, essa è palesemente una tautologia, in

quanto l’interfaccia uomo-macchina è interattiva per definizione. Ad

azione (input umano) corrisponde reazione (output visualizzato sul

monitor).

Ancora:

“i

media

permettono

l’accesso

random”.

Senza

scomodare apparecchiature sperimentali del XIX secolo (come il

Phenakistiscope, lo Zootrope, lo Zoopraxiscope, il Tachyscope o il

fucile fotografico di Marey), le quali erano praticamente capaci di un

accesso random grazie alla loro struttura a moduli o frammenti

distinti, basta prendere in considerazione un qualsiasi libro: sebbene

vi sia solitamente una logica che conduce dall’inizio fino alla fine

(seguendo l’ordine crescente delle pagine), è una pratica molto

comune quella di consultare solo le parti che sono di interesse.

Grazie alla guida dell’indice, i capitoli o le frasi che si vogliono

raggiungere

sono

dell’organizzazione

facilmente

globale

del

reperibili,

libro.

O

senza

tenere

pensiamo

agli

conto

elenchi

telefonici, o ancora alle raccolte di fotografie. Quindi il libro

rappresenta un ottimo esempio di supporto ad accesso random, e

annulla la premessa che voleva i nuovi media come unici possessori

di questa caratteristica.

“Tutti i media digitali (testo, fermo immagine, dati video, spazi

tridimensionali) hanno in comune lo stesso codice digitale. Ciò

permette di riprodurre vari tipi di media usando una sola macchina,

il computer, che funge da lettore multimediale.” Anche in questo caso

si può facilmente dimostrare come un vecchio medium, il cinema,

possedesse già questa caratteristica: fin dai primi anni del Novecento

12

gli operatori cinematografici erano abituati a combinare testo,

immagini in movimento e musica. Per voler andare ancora più

indietro nella storia: pensiamo ai manoscritti medioevali, che univano

testo, grafica e immagini rappresentative in una presentazione

multimediale a tutti gli effetti.

Come risulta chiaro, queste radicate convinzioni sui nuovi

media non sono sufficienti a definirli. Il rapporto tra nuovi e vecchi

media sembra essere diviso da un confine sfocato; la chiave di questo

paradosso sta nel comprendere la continuità che sussiste tra i media

di ieri e di oggi, e nel cercare delle differenze che possano

discriminare gli uni dagli altri, senza tuttavia separarli del tutto. Se

un testo non viene variato a livello linguistico, ma viene proposto ora

su carta stampata ora su un banner animato, che cosa è a cambiare?

Se un’immagine si muove sul grande schermo della sala di un cinema

o in una piccola cornice sul lato di una pagina Web, che cosa è a

cambiare, se la sequenza di frames è la stessa?

Manovich propone cinque “principi ispiratori” per descrivere i

nuovi

media:

la

rappresentazione

numerica,

la

modularità,

l’automazione, la variabilità e la transcodifica culturale. Questi

principi si trovano in una situazione gerarchia, rappresentata nello

schema che segue:

Figura 1. I principi ispiratori dei nuovi media.

13

Non tutti i nuovi media obbediscono a questi principi, che di

fatto non andrebbero considerati leggi assolute, ma piuttosto

tendenze generali di una cultura che sta vivendo un fase di

computerizzazione che investe strati sempre più profondi della

società.

•

Rappresentazione numerica – Tutti i nuovi media, creati ex novo

su computer, o convertiti da fonti analogiche, sono composti da

un codice digitale; sono quindi rappresentazioni numeriche.

Questo

porta

come

conseguenza

che

un

mezzo

di

comunicazione si può descrivere in termini informatici, ovvero

attraverso una funzione matematica.

•

Modularità – Gli elementi mediali (immagini, suoni, forme o

comportamenti) vengono rappresentati come insiemi organici di

campioni

discontinui

(pixel,

caratteri,

campioni).

Questi

elementi vengono assemblati in strutture di dimensioni più

vaste, ma continuano a mantenere le loro identità separate. E

come molti elementi (paragonabili agli atomi) vengono composti

per

formare

un

medium

(ad

esempio

molti

pixel

per

un’immagine), allo stesso modo molti media possono venire

assemblati in una creazione che ancora una volta non cancella

la loro indipendenza. Ad esempio una pagina Web: grazie al

codice

HTML,

testo,

immagini,

musica

e

video

sono

rappresentati unitamente in un luogo virtuale che li fa apparire

come un’entità singola, mentre in realtà i suoi elementi sono

normalmente files separati. Un altro esempio è costituito da un

documento testuale all’interno del quale sono inserite immagini

grafiche o suoni: la presentazione è quella di un’entità singola,

ma anche in questo caso i files sono indipendenti.

14

Emerge in questa sede la natura composita dei nuovi media:

molto spesso si tratta di elementi semplici che si combinano tra

loro per dare vita a nuove forme (da qui deriva la variabilità dei

media), tuttavia i “grani” degli insiemi organici restano slegati.

•

Variabilità – Un nuovo oggetto mediale non è qualcosa che

rimane identico a se stesso all’infinito, ma è qualcosa che può

essere declinato in versioni molto diverse tra loro. Questa è una

conseguenza dei principi della rappresentazione numerica dei

media e della loro modularità.

In passato la versione definitiva di un filmato, dove musica,

immagini e testo erano stati assemblati, veniva salvata in un

nuovo formato, e restava immutabile nel tempo. Oggi è

possibile assemblare questi elementi creando di fatto un’entità

nuova e in sé finita, come un filmato, il quale però mantiene il

carattere di indipendenza dei propri elementi, e quindi la

possibilità di modificarli in un momento successivo. Un altro

esempio

è

CoolEditPro,

costituito

all’interno

da

una

della

sessione

quale

si

multitraccia

possono

di

gestire

frammenti di forme d’onda che verranno richiamate nella

giusta locazione al richiamo della sessione in qualsiasi altro

momento, e potranno essere editate come files separati. Di

fatto, il file che si crea dall’assemblaggio di diversi elementi non

è altro che una descrizione della posizione o del ruolo degli

elementi all’interno dell’assemblaggio stesso, e non comprende

gli elementi in sé (non a caso si tratta di un file con estensione

.ses, che sta per “sessione”, e non di un file audio, ad esempio

.wav, .mp3, .aif e così via). Per creare un nuovo file musicale

dove i frammenti non sono più indipendenti, è necessario

operare un mix down, ovvero una “fusione” dei frammenti.

15

Altrimenti la sessione verrà salvata come una “scrivania” sulla

quale si continuerà a lavorare il giorno dopo.

Queste premesse rendono possibili dei casi interessanti, alcuni

dei quali saranno trattati più approfonditamente in seguito: a)

gli elementi costitutivi dei media vengono immagazzinati in una

base di dati, b) dagli stessi dati è possibile creare numerose

interfacce diverse, c) gli insiemi organici sono soggetti ad

aggiornamenti periodici, d) è possibile la strutturazione di

ipermedia, ovvero di “percorsi di media” (con molteplici

traiettorie narrative) collegati tra loro attraverso iperlinks.

•

Automazione – Un’altra conseguenza dei principi di modularità

e di codifica numerica dei media è l’automazione di molte

operazioni necessarie per la creazione, la manipolazione e

l’accesso ai media. Questo significa che l’intenzionalità umana

può venire rimossa, almeno in parte, dal processo.

L’“automazione a basso livello” comprende delle operazioni

ormai solitamente incorporate nei più diffusi software che

gestiscono media, ad esempio il ritocco pittorico per le

immagini, o l’aggiunta di riverbero in un file audio, e così via.

Per “automazione ad alto livello” si intendono invece quelle

operazioni riconducibili all’intelligenza artificiale (AI) o alla vita

artificiale

(AL),

cioè

a

sistemi

capaci

di

simulare

la

conversazione umana, di scrivere poesie e racconti, comporre

musiche, e attività simili; in questi casi c’è la necessità che un

computer “capisca”, almeno in parte, i significati insiti nei

prodotti generati, ovvero la loro semantica. Tali operazioni non

sono ancora implementate in software commerciali in quanto il

campo dell’intelligenza artificiale si trova ancora in fase di

ricerca. Tra le altre operazioni ad alto livello, vi è l’apprezzata

idea di “agenti” in grado di indicizzare e organizzare in modo

16

automatico grandi quantità di dati contenute in collezioni di

vario genere, e sicuramente non ultima quella che per

antonomasia sfugge a qualsiasi controllo: Internet.

•

Transcodifica culturale – Come accennato in precedenza, i

media

sono

immagazzinati

sulla

memoria

dei

computer

secondo la codifica digitale, il che significa che un brano

musicale e la fotografia di un quadro sono rappresentati allo

stesso modo a livello di macchina, ovvero con delle catene di

numeri. Ciò nondimeno questo codice è ancora fruibile da un

essere umano, poiché il computer interpreta gli oggetti

codificati e li riproduce sotto forma di suono o di fotografia.

A questo punto si può dire che i nuovi media siano

configurabili secondo due “livelli”, quello informatico e quello

culturale. Al livello informatico corrispondono la struttura dei

dati, la codifica, il tipo di file, le funzioni e le variabili; al livello

culturale corrispondono la fotografia, la canzone, l’enciclopedia,

la tragedia.

Dal momento che i nuovi media nascono al computer, vengono

modificati, distribuiti e archiviati mediante il computer, la

logica

delle

macchine

non

può

che

influenzare

quella

tradizionale dei media.

L’influenza in realtà è reciproca, poiché i software che

supportano i nuovi media vengono sviluppati secondo le

esigenze di questi ultimi; esigenze che si scontrano con i limiti

della tecnologia disponibile. E per quanto la ricerca scientifica

possa procedere e le macchine evolversi, la base ineliminabile

del computer sarà sempre la codifica binaria e le operazioni

complesse saranno sempre costituite da serie di istruzioni

semplici (algoritmi, e quindi programmazione). Sequenze,

calcoli, passi ordinati: aspetti che non sono estranei al modo di

17

ragionare

umano

(problemi

complessi

vengono

risolti

un’operazione alla volta, i pensieri non seguono solo il modello

joyciano dello “stream of consciousness”), ma che non lo

esauriscono.

La computerizzazione della cultura produce gradualmente una

transcodifica analoga di tutte le categorie e di tutti gli oggetti

culturali. Ciò vuol dire che le categorie e i concetti culturali

vengono sostituiti, a livello di significato e di linguaggio, da

nuove categorie e da nuovi concetti che sono propri o derivano

dall’uso del computer. Dunque i nuovi media agiscono come

precursori

di

questo

processo

più

generale

di

riconcettualizzazione culturale.

Dopo questo possibile viaggio attraverso l’essenza e la struttura

dei

nuovi

media,

tentiamo

di

capire

perché

essi

ricoprano

un’importanza fondamentale nella civiltà odierna, e perché muovano

delle problematiche che meritano la nostra attenzione.

Mappare i nuovi media: l’organizzazione

Prima di discutere delle specifiche problematiche sollevate dai

nuovi media e dal processo di computerizzazione “onnivoro”, cioè che

investe ogni tipo di tendenza, informazione, pensiero e azione umana,

soffermiamoci ancora per un momento sulla natura dei nuovi media.

Nuovi studi sono in corso per quanto riguarda la teorizzazione

dei nuovi media, fenomeno recente e in costante evoluzione, ma

importante abbastanza da richiedere una coscienziosa riflessione

critica. Manovich propone delle “categorie” che riassumono degli

18

approcci possibili per un futuro studio metodico dei nuovi media. La

“mappatura” dei nuovi media si riassume nel seguente modo:

1. organizzazione logica e materiale dei nuovi media

2. interfaccia uomo-computer; sistema operativo

3. applicazioni software che sfruttano il sistema operativo, loro

interfacce e operazioni più tipiche

4. forma e nuova logica delle immagini digitali create attraverso le

applicazioni

5. convenzioni più utilizzate per organizzare un nuovo oggetto

mediale nel suo complesso.

Come vediamo, il secondo

e il terzo punto trattano il tema

dell’interfaccia, cui si è già accennato nelle parti relative alla

modularità e alla variabilità dei nuovi media. Con il termine

interfaccia si intende la modalità di interazione tra utente (uomo) e

computer (macchina). L’interfaccia comprende inoltre gli strumenti

che permettono l’input e l’output: lo schermo, la tastiera e il mouse.

Le prime interfacce degli anni Ottanta rispecchiavano il fine per

cui i computer erano stati pensati, cioè per lavorare. A quel tempo il

computer era ancora paragonato ad uno strumento di calcolo, ad un

righello, ad una macchina che servisse in ufficio. Durante gli anni

Novanta la presenza dei computer nelle case dei privati si è

incrementata logaritmicamente, e il suo uso si è ampiamente

modificato, diventando una macchina multimediale universale, sulla

quale comporre, immagazzinare, distribuire e attivare tutti i media.

Poiché la distribuzione di tutte le forme culturali si basa ormai

sul computer, ci stiamo sempre di più “interfacciando” con dei dati

19

prevalentemente culturali: testi, fotografie, film, musiche, ambienti

virtuali. “Interfaccia culturale” indica un’interfaccia uomo-computercultura, ovvero un insieme di modalità con cui il computer presenta i

dati culturali e consente di interagire con essi.

Al giorno d’oggi il computer si può vedere come un archivio di

dati del più disparato genere, capace di presentare questi dati

secondo innumerevoli modalità possibili. Delle riflessioni interessanti

possono prendere spunto da domande quali: “perché il Web è

organizzato secondo questo modo? Perché i designer organizzano i

dati in questo modo e non in un altro?”. Di infinite, o potenzialmente

infinte, possibilità di rappresentazione, in questo momento ci stiamo

relazionando con un certo tipo di interfacce. Perché? E quali sono le

conseguenze?

Come il mezzo influisce sul messaggio: le interfacce

culturali

Per rendere la struttura di un computer più intuitiva e

compatibile alla mente umana, già le prime interfacce tentavano di

richiamare delle situazioni familiari per un utente: sono quindi nate

le metafore della scrivania, delle cartelle, della pagina stampata o

dello schermo cinematografico o televisivo. Con l’andare del tempo, e

con il divenire quotidiano dell’interazione utente-computer, parte

della struttura implicita della “logica della macchina” è emersa e si è

manifestata nelle interfacce. Dal momento che il computer è capace

di supportare più applicazioni contemporaneamente, le finestre sullo

schermo (di per sé una “finestra”) si sono moltiplicate, e di pari passo

si è sviluppata la capacità degli utenti di concepire, per fare un

esempio, una “scrivania a più livelli”. Una tale metafora, una

20

“scrivania a più livelli”, non è qualcosa che richiama un’esperienza

reale, ma riesce ad essere concepita senza eccessiva difficoltà da una

mente umana grazie alla presenza di elementi conosciuti quali la

“scrivania” e l’idea di “livello”. Infondo è possibile figurarsi una sfinge

o una sirena, sebbene queste figure non esistano nella realtà; tuttavia

sono concepibili perché nascono dalla giustapposizione di due

elementi noti.

Per questa ragione è verosimile che la rivoluzione dei nuovi

media stia passando in qualche modo inosservata, e molti “sintomi”

non sono apparentemente riconducibili a chiare cause: i nuovi media

non sono altro che la ristrutturazione, la fusione o l’ibridazione di

forme preesistenti di media. Esaminando i principi ispiratori dei

nuovi media, tuttavia, si è cercato di portare in luce quali siano le

vere differenze che distinguono i nuovi media da ciò che li ha

preceduti.

Anche per quanto riguarda il linguaggio delle interfacce

culturali si può dire che esso sia costituito fondamentalmente da

elementi appartenenti ad altre forme culturali già note. Queste sono il

cinema, la parola stampata e l’interfaccia universale uomo-computer

(HCI, Human-Computer Interface): ognuna di queste tre componenti

ha sviluppato nella sua storia un modo di organizzare le informazioni,

di presentarle, di mettere in correlazione spazio e tempo e di

strutturare l’esperienza umana nell’accesso delle informazioni.

Il cinema contribuisce con il concetto di spazio tridimensionale

in una cornice rettangolare, navigabile da un punto di vista mobile (la

metafora

della

propria

struttura

architettonica

nella

sala

cinematografica: uno schermo piatto trasformato in una finestra

21

spalancata su un altro mondo); la parola stampata porta la maggior

parte delle caratteristiche di organizzazione del testo (colonne,

riquadri, indici); l’interfaccia universale, quella che dei tre elementi

vanta la storia più recente, introduce gran parte degli aspetti più

strettamente

legati

all’“esperienza

computer”:

piccole

unità

significative che col tempo sono entrate tra le consuetudini di

ragionamento umane. Operazioni di copia e incolla, cerca e

sostituisci, i collegamenti ipertestuali, le icone e quant’altro, stanno

condizionando le interfacce culturali di oggi, e allo stesso modo

condizionano il cervello umano. Uno fra i più innocui (forse) esempi

che dimostrano come questo sia vero, è costituito dal fatto che alle

persone che spendono molto tempo davanti al computer riesce

naturale essere tentati di cliccare una parola su… un libro stampato,

o di pensare al layout e al font da utilizzare prima di scrivere una

lettera… a mano. Se all’inizio è stato il nostro mondo a entrare in

quello informatico, ora il percorso è tendenzialmente inverso: le

convenzioni dell’informatica stanno migrando nella nostra realtà

fisica.

Le interfacce culturali sono fondate, dunque, su gruppi di

metafore e strategie di informazione mutuati da diverse e preesistenti

aree culturali. Quali sono le conseguenze di questo fondamento?

La logica del database e l’assenza di narratività

La parola stampata ricopre un ruolo privilegiato nella cultura

del computer; è presente sotto forma di codice (trasparente per

l’utente), costituisce il mezzo essenziale per formulare istruzioni

interpretabili da un computer (linee di testo), è il mezzo tramite il

quale sono codificati tutti gli altri media (le informazioni sui pixel, la

22

formattazione di una pagina HTML, le coordinate di un oggetti

tridimensionale). La forte metafora della pagina, presa a prestito dalle

HCI, tuttavia, si è piegata alle frontiere del computer al punto che

oramai è diventata fluida e instabile: non si riconoscono più i suoi

tratti primari (la forma rettangolare, la sequenzialità con cui le pagine

sono ordinate). Prima con l’allungamento verticale delle pagine

(navigabili con la barra di scorrimento a lato dello schermo), che

hanno attinto all’antico ricordo del papiro da srotolare, e in seguito

con l’invasione dei collegamenti ipertestuali, la logica del libro ha

dovuto soccombere a quella nuova dell’ipertesto.

Una delle conseguenze primarie è che tra le pagine visitabili

non sia più nemmeno rintracciabile una gerarchia. Invece di sedurre

l’utente attraverso un’abile organizzazione di argomenti ed esempi, di

pro e contro, modifiche dei ritmi di offerta delle informazioni, falsi

percorsi e brillanti presentazioni di provocazioni concettuali, le

interfacce culturali bombardano l’utente sparandogli addosso tutti i

dati in una volta. In questo senso sembra più realistico assimilare la

cultura dei nuovi media ad una sterminata superficie piatta sulla

quale i dati sono disposti alla rinfusa, senza un ordine particolare,

piuttosto che a una struttura che abbia inizio e fine, sia essa un libro

o un film.

Tralasciando la forma globale dei nuovi media e concentrando

l’attenzione sui singoli casi, si nota come essi seguano la medesima

logica: molti oggetti mediali non raccontano storie, non hanno un

inizio e una fine e nemmeno uno sviluppo tematico coerente. Gli

elementi non sono organizzati in sequenza, allo stesso modo in cui

non lo sono a livello globale (la superficie piatta con i dati alla

23

rinfusa). Sono, piuttosto, raccolte di elementi individuali, ognuno con

la stessa possibilità di significare.

In questo senso il database assurge a forma culturale a sé

stante. Per il principio della transcodifica (tutti i media si possono

convertire in dati informatici), musei e archivi diventano immensi

database; a qualsiasi ricca collezione di dati culturali si sostituisce

un database. Allo stesso tempo, il database diventa la nuova metafora

che concettualizza la memoria culturale individuale e collettiva: una

raccolta di documenti, oggetti e di altri fenomeni ed esperienze. Lo

schema seguente rappresenta il percorso (un “algoritmo culturale”)

che è stato innescato dall’era del digitale:

Figura 2. L’algoritmo culturale innescato dall’era digitale.

Quello che vale per le interfacce culturali, vale parimenti per i

database: l’influenza dei livelli informatico e culturale è vicendevole.

Si può sospettare con una certa forza che la struttura dei database

(in particolare gli aspetti dell’assenza di gerarchia e della modularità)

influenzi la struttura mentale degli individui della nostra società. In

questo senso il database è eletto nuova forma simbolica dell’era dei

computer.

Analizzando una qualsiasi opera multimediale, si scopre quasi

senza meraviglia che la struttura prediletta è quella del database:

pensiamo ad un CD-ROM che racconti la vita di Leonardo di Vinci. In

questo caso il CD-ROM sarà una collezione di opere, scritti, vicende

biografiche, immagini relativi a Leonardo, raccolti secondo una logica

24

che può avvicinarsi a quella di un museo virtuale. La differenza con

un museo reale consiste nel fatto che nella versione virtuale non vi

sono vincoli fisici che condizionano la visita (non ci sono corridoi e

stanze e muri, o quantomeno non ve ne sono di reali). In tale modo le

opere possono essere visualizzate cronologicamente, per genere,

argomento, e così via. In questo senso, nella logica del database viene

meno il senso della narratività.

In Internet la forma database ha conosciuto il suo massimo

successo. Nella sua programmazione originaria, la pagina HTML è un

elenco sequenziale di elementi separati: blocchi di testo, immagini,

videoclip digitali e link. A qualsiasi elenco può essere aggiunto un

nuovo elemento, senza obblighi di tempo o ordine. Questo significa

che quando un nuovo elemento viene aggiunto ad un corpo più vasto,

questo non vede modificata la sua logica. Tutto questo non può

accadere all’interno di una storia, dove sin dall’inizio le componenti

sono state pensate per dare un contributo funzionale allo svolgimento

della narrazione, che tende ad una catarsi finale (l’eliminazione

arbitraria di un elemento potrebbe essere fatale per un racconto, che

si vedrebbe privato della sua logica).

Secondo la logica del database, il mondo si riduce a due tipi di

oggetti complementari: le strutture dei dati e gli algoritmi. Nell’ottica

del computer, le strutture dei dati e gli algoritmi sono le due metà

dell’ontologia del mondo. La progettazione di tutti i nuovi media può

essere ridotta a questi due approcci: la creazione di nuovi oggetti

mediali si intende come la creazione dell’interfaccia migliore per una

database multimediale o come la definizione di metodi di navigazione

attraverso rappresentazioni spazializzate. I siti Web e i CD-ROM sono

espressione della struttura dei dati, mentre i videogiochi e la

25

narrazione sono espressione dell’algoritmo. Nei primi vi è accesso

random senza regola, nei secondi la consequenzialità è fondante. Dal

momento che il database si fonda sulla struttura dei dati e la

narrazione sugli algoritmi, essi sono fondamentalmente nemici

naturali.

I database sono in grado di sostenere la narrazione, ma non vi è

nella loro logica nulla che ne incentivi la produzione. E la struttura di

un database condiziona il modo in cui l’utente accede ai dati, quindi

influenza il modo in cui esso deve pensare il mondo che ha di fronte

per potervi accedere. Dal momento che la quantità di tempo

impiegata a interpretare interfacce è molto elevato, si può dire che il

database costituisca un modello preciso di mondo, che si instaura

lentamente nella mente umana, modificandone i processi abituali; al

contrario, la narratività cerca di imporre il proprio modello di mondo,

contrapposto a quello dei database. Queste due entità costituiscono

tuttavia un binomio inscindibile: i database supportano una serie di

forme culturali la cui logica è opposta a quella del proprio

contenitore, il database stesso.

Cosa fare per non subire la logica del database

Essere consapevoli dei cambiamenti che porta con sé la

rivoluzione mediale, aiuta a difendersi dall’irreversibilità con cui essa

si manifesta e a sfruttare le risorse della tecnologia a favore

dell’uomo. La posizione di comando e controllo che è propria

dell’uomo si raggiunge “domando” il dilagare della logica del

database. Come per molte altre invenzioni umane, la differenza tra

successo e insuccesso sta nella bontà dell’uso che se ne decide di

fare. I database costituiscono una potente risorsa di conoscenza, ma

26

rappresentano al contempo una forte minaccia in termini di

dispersione, banalizzazione delle esperienze e confusione del sapere.

Nelle successive parti di questo lavoro si cercheranno di

analizzare i percorsi possibili per stabilire un ordine all’interno dei

database che trattano dati multimediali. Non si tratta ovviamente

solo di archivi: alla luce di quanto detto finora, un database sarà un

sito Web, un CD-ROM, un ambiente virtuale e così via. Quello che si

tenterà di fare è una ricerca di traiettorie narrative possibili

all’interno di una vasta e “selvaggia” collezione di media digitali.

27

28

Parte 2

Introduzione

In un mondo informatizzato quale il nostro, le basi di dati

ricoprono un ruolo di fondamentale importanza. Nello svolgimento di

ogni attività, sia a livello individuale sia in organizzazioni di ogni

dimensione, sono essenziali la disponibilità di informazioni e la

capacità di gestirle in modo efficace.

Le basi di dati hanno una storia che risale a prima della

diffusione dei calcolatori elettronici: gli archivi dei tribunali o le

collezioni

delle

biblioteche

sono

presenti

da

diversi

secoli

e

29

costituiscono a tutti gli effetti delle banche dati o sistemi informativi.

La

più

recente

adozione

di

sistemi

informatici,

tuttavia,

ha

rivoluzionato il modo di concepire e impiegare le basi di dati, offrendo

nuove possibilità di catalogare, reperire e consultare i dati.

Una base di dati è molto genericamente una raccolta di dati per

lo più omogenei tra di loro e organizzati secondo determinati criteri. I

tanti elementi ospitati in una base di dati non portano da soli alcuna

informazione, e acquistano significato solo quando vengono messi in

relazione e interpretati da un uomo.

Un esempio: il titolo di un’opera letteraria e una stringa di

numeri sono dei dati che non dicono nulla nella forma in cui si

trovano. Solo nel momento in cui viene chiarito che la stringa

corrisponde ad una collocazione all’interno di una certa biblioteca, mi

è possibile decidere di trovare e leggere l’opera.

Un altro caso, estremo ma quanto mai eloquente, è costituito

dalla stessa rete Internet: tra le molte e incerte definizioni che sono

state formulate a riguardo, vi è anche quella che vuole la rete globale

come

un’immensa

base

di

dati

fortemente

disorganizzata

e

ridondante. E’ esperienza comune l’aver verificato che i risultati di

una ricerca operata con un qualsiasi motore sono quasi sempre

insoddisfacenti, poco coerenti e quantomeno confusi.

Per questo motivo sono di centrale importanza la modalità di

accesso ai dati e la possibilità di manipolarli. Per concludere si può

affermare che la qualità delle informazioni ricavabili da una base di

dati dipende:

30

1) dalla logica con cui sono organizzati i singoli elementi che vi sono

contenuti e

2) dalla varietà e dalla complessità delle richieste che è possibile

operare in essa.

Struttura di una base di dati

Generalmente

la

struttura

di

una

base

di

dati

risulta

trasparente ad un utente che interroghi e riceva risposte direttamente

presso il proprio terminale, rappresentato nella figura (figura 3) da un

computer, sull’estrema destra. Le basi di dati, tuttavia, sono costruite

secondo uno schema complesso, detto anche “a livelli”.

Una grande quantità di dati eterogenei può essere contenuta in

una base di dati; affinché essa diventi una risorsa per la conoscenza,

ha bisogno di essere gestita in modo efficace e ordinato: a questo

scopo è preposto un sistema di gestione, detto DBMS (Data Base

Management System).

Figura 3. Struttura schematica di un database.

Un sistema di gestione di basi di dati è un sistema software in

grado di gestire collezioni di dati che siano grandi, condivise e

31

persistenti, assicurando la loro affidabilità e privatezza. Vediamo nel

dettaglio le caratteristiche che si richiedono ad un DBMS:

•

Le basi di dati sono nella maggior parte dei casi molto “grandi”,

nel senso che le loro dimensioni possono raggiungere le

migliaia di miliardi di byte, e comunque dimensioni di gran

lunga

maggiori

della

memoria

centrale

disponibile.

Di

conseguenza i DBMS devono prevedere una gestione dei dati in

memoria secondaria.

•

I DBMS sono in grado di regolare, secondo opportune modalità,

gli accessi di utenti diversi a dati comuni. In questo senso si

dice che le basi di dati sono condivise; non solo si evita il

problema della ridondanza dei dati (tutti gli utenti accedono ad

un’unica copia del documento e non vi sono così ripetizioni; un

esempio analogo: molti utenti visualizzano la stessa pagina

web, la quale è ospitata una sola volta sul server), ma è

possibile evitare la possibilità di inconsistenza, ovvero la

diversità temporanea tra copie dello stesso dato le quali

ricevono modifiche da utenti diversi nello stesso istante.

•

Le basi di dati sono persistenti, ovvero godono di un tempo di

vita che non è limitato a quello delle singole esecuzioni dei

programmi che le utilizzano.

•

I DBMS devono conservare la base di dati sostanzialmente

intatta, o quantomeno devono permetterne la ricostruzione in

caso di malfunzionamento hardware e software: in questo

consiste l’affidabilità di un DBMS.

•

Da non sottovalutare, i DBMS consentono la privatezza dei

dati. Ciascun utente, riconosciuto in base ad uno UID che è

specificato all’atto di interagire con il DBMS, viene abilitato a

32

svolgere

solo

determinate

azioni

sui

dati,

attraverso

meccanismi di abilitazione.

Lo scopo del DBMS è di mettere a disposizione dell’utente i

comandi per operare sui dati a livello logico, indipendentemente dalla

loro rappresentazione fisica su disco. L’indipendenza dei dati è infatti

una importante proprietà dei DBMS: essa permette di modificare le

modalità di organizzazione dei dati gestiti dal DBMS o la loro

allocazione fisica sui dispositivi di memorizzazione senza influire sui

programmi che utilizzano i dati stessi. Inoltre si possono avere dati

memorizzati in sedi fisiche distaccate (il caso Internet porta

facilmente casi in cui queste sedi sono sparse in tutto il mondo), che

di fatto però costituiscono una virtuale risorsa unica per l’utente che

interroghi il sistema (location transparency).

Infine i dati, la materia prima e la ragione di essere di una base di

dati: potenzialmente non vi è un limite al numero o alle dimensioni

dei dati ospitati in una base di dati. Se un limite esiste, si tratta

solitamente del limite fisico delle dimensioni del dispositivo di

memorizzazione dei dati.

Nel corso del tempo sono stati proposti vari modelli per

organizzare i dati attraverso i DBMS. Con “modello di dati” si intende

un insieme di concetti utilizzati per organizzare i dati di interesse e

descriverne la struttura in modo che essa risulti comprensibile ad un

elaboratore. Tra i principali modelli troviamo:

•

il modello gerarchico ha caratterizzato i primi DBMS, introdotti

verso la metà degli anni Sessanta, ed è tuttora utilizzato in

varie

installazioni.

Nel

modello

gerarchico

i

dati

sono

33

organizzati secondo una struttura ad albero, cioè a livelli, in cui

le relazioni sono sempre tra elementi di livelli adiacenti, mentre

non sono consentite relazioni tra dati dello stesso livello;

•

il modello reticolare, proposto negli anni Settanta, è basato sui

grafi, ovvero su strutture di dati a reticolo;

•

il modello relazionale, ideato anch’esso negli anni Settanta, ha

fatto la sua comparsa nei DBMS commerciali solo negli anni

Ottanta ed è basato sulla strutturazione dei dati mediante

tabelle collegate tra loro;

•

i modelli a oggetti, sviluppati a partire dal 1985, estendono alle

basi di dati alcuni concetti dei linguaggi di programmazione

orientati agli oggetti (object oriented), in cui i dati vengono

rappresentati da oggetti che possono essere manipolati solo

dalle funzioni ad essi associate.

Il Data Base Management System orientato agli oggetti

Il Data Base Management System orientato agli oggetti (o

ODBMS) è il sistema di gestione di basi di dati che sfrutta il tipo di

organizzazione

dei

dati

detto

“ad

oggetti”.

Ogni

oggetto

è

caratterizzato da proprietà e funzioni specifiche, dove per proprietà si

intendono le caratteristiche che distinguono un oggetto da un altro, e

per funzioni si intendono le operazioni consentite per un determinato

oggetto. L’ODBMS è un sistema che si presta bene alla gestione di

basi di dati che contengano file di diversa natura, essendo in grado di

distinguere e trattare separatamente le classi di oggetti che

ragionevolmente hanno caratteristiche ed esigenze distinte.

Perché discutere di ODBMS in questa sede?

34

Gli ODBMS sono in uso da diversi anni e hanno raggiunto un

buon livello di sviluppo. Nuove ricerche, tuttavia, sono in fase di

svolgimento per quanto riguarda la loro applicazione alle basi di dati

multimediali. I tradizionali DBMS, infatti, si sono rivelati inadeguati a

supportare in modo efficace molte nuove operazioni di gestione e

modifica dei dati multimediali.

35

36

Parte 3

Le basi di dati e i dati multimediali

La possibilità di raccogliere in modo informatizzato, ordinato e

condiviso una enorme quantità di dati ha dato vita al sogno di creare

una base di dati che contenga tutti i testi mai scritti, o quasi. A

questa prospettiva, decisamente affascinante, si aggiungono i recenti

studi sui nuovi tipi di formati per l’audio, il video, le animazioni e via

discorrendo, che potrebbero rendere possibile una vera e propria

biblioteca universale dello scibile umano in tutti i suoi aspetti.

37

Non è importante che la meta possa suonare ambiziosa: molti

ricercatori in tutto il mondo hanno da tempo concentrato i loro sforzi

su questo obiettivo comune, per rendere il sogno una realtà.

Al giorno d’oggi, Internet e altri sistemi di network consentono

l’accesso ad una base di dati da parte di un numero vastissimo di

utenti, indipendentemente dal luogo in cui essi si trovino o

dall’allocazione fisica dei dati. Questa realtà motiva molti progetti di

ricerca nell’ambito delle basi di dati che contengano documenti

diversi dal semplice testo (ovvero la musica e il suono in generale, le

immagini statiche e in movimento, e così via).

Tuttavia un così alto numero di dati, e di natura così diversa,

dà adito a una quantità problemi, per lo più legati alle operazioni di

immagazzinamento, reperimento e distribuzione dei dati.

Con ordine, cerchiamo di analizzare la questione nel dettaglio.

Le basi di dati multimediali

Innanzitutto, che cosa si intende per base di dati multimediale?

Si intende una base di dati che contenga tipi di dati appartenenti alla

famiglia dei nuovi media. Tuttavia in questa sede si va al di là del

tentativo di ordinamento teorico sviluppato nella prima parte di

questa tesi, e si estende il significato di “nuovo media” a qualsiasi file

che sia immagazzinato su un computer attraverso la codifica digitale,

e quindi i filmati e le animazioni, la musica nei diversi formati, e via

discorrendo.♠ Questo tipo di dati è diventato di comune uso negli

♠

Per la precisione le definizioni di “multimedia” e di “multimediale” costituiscono un

problema irrisolto tanto quanto quella di “nuovi media”. Riporto, per dimostrare

38

ultimi anni, e nulla fa credere che la sua diffusione si arresterà in

futuro.

Al

contrario:

l’interazione

con

i

nuovi

media

diverrà

un’esperienza quotidiana, e al contempo si vede crescere la necessità

di una tecnologia che li supporti efficacemente.

Per quanto le prospettive future nel campo delle basi di dati

siano affascinanti, ci sono numerose questioni irrisolte legate ai

multimedia. Vediamo quali.

Problemi legati alle basi di dati multimediali

Nel passato i DBMS avevano a che fare con elementi semplici

come le stringhe di dati e così via. Le strutture a campi e record

erano sufficienti a gestire i dati rappresentati. Tuttavia, nel momento

in cui dei documenti multimediali vengono coinvolti, sorgono nuovi

problemi per lo più legati alla natura di questi dati. Filmati e musica,

infatti, hanno ragionevolmente delle esigenze di immagazzinamento,

reperimento e distribuzione diverse dai dati testuali. La base di dati

dovrà dunque essere progettata su misura per questo nuovo tipo di

contenuti, sia per quanto riguarda la memoria dove essi vengono

conservati sia per la loro gestione (DBMS multimediali).

Per

capire

quali

possano

essere

le

esigenze

dei

dati

multimediali, proviamo a vedere nel dettaglio quale sia la loro natura:

•

Testo – Grandi quantità di testo strutturato come nei libri,

ovvero in capitoli, parti, sezioni, sottosezioni e paragrafi.

•

Grafica – I documenti grafici includono disegni e illustrazioni

codificate con un tipo di descrizione ad alto livello, come CGM,

come ciò non sia banale, che sul dizionario informatico on-line

www.dizionarioinformatico.com

mancava

del

tutto

una

definizione

di

“multimediale”, un termine di comune uso e persino abusato; il dizionario on-line

ha accettato e pubblicato un mio suggerimento a riguardo, ed è stato aperto un

forum on-line per discutere la natura del “multimediale”.

39

Pict e PostScript. Questo tipo di dato può essere immagazzinato

in una base di dati in modo strutturato. E’ facilmente

consultabile il suo meta contenuto, tramite richieste quali

“trova tutte le illustrazioni che contengono un cerchio”.

Ovviamente è più difficile trovare oggetti – ad esempio un

pianoforte – che risultano composti di più elementi geometrici

semplici insieme.

•

Immagini – Questo tipo di dato comprende immagini e fotografie

codificate secondo i formati standard come il bitmap, il JPG e

l’MPG. L’immagazzinamento dei dati avviene come una diretta

traslazione dell’immagine stessa, pixel per pixel, e quindi non è

possibile un contenuto concettuale – di linee, cerchi e così via –

come per la grafica. Alcuni formati, come il JPG e l’MPG,

inoltre, comprimono l’immagine in modo da alleggerire il peso

della rappresentazione pixel per pixel. Dal momento che non si

possono descrivere le componenti di un’immagine con elementi

geometrici, è difficile trovare oggetti, sia semplici che complessi,

in un’immagine.

•

Animazioni – Un’animazione è una sequenza di immagini o dati

grafici per la quale sono definiti un ordine e un tempo di

apparizione. Le immagini o i dati grafici sono organizzati e

immagazzinati in modo indipendente. A differenza dei dati

grafici semplici, i quali possono essere reperiti e visualizzati per

un tempo indeterminato, le animazioni hanno dei limiti

temporali per quanto riguarda la loro rappresentazione, in

quanto ogni immagine deve essere visualizzata e poi subito

sostituita dalla successiva. Questo vincolo temporale può

variare da animazione ad animazione (alcune richiedono due

immagini al secondo, altre fino a trenta immagini al secondo).

40

•

Video – I video sono sequenze di dati grafici ordinati

temporalmente. Il dato rappresenta la registrazione di un

evento reale prodotto con apparecchiature quali le telecamere

digitali. I dati sono divisi in unità chiamate frames. Ogni frame

contiene un’immagine fotografica. Nella maggior parte dei casi,

un video contiene dai 24 ai 30 frames al secondo (fps). I vincoli

temporali per una visione ottimale sono dettati dalla velocità

dei frames registrati.

•

Audio strutturato – Come le animazioni, questo tipo di dato

rappresenta una sequenza di componenti indipendenti che

richiedono dei vincoli temporali per la riproduzione. Ogni

componente è rappresentata da una descrizione, come quella di

una nota, di un tono e di una durata. L’ascolto può variare nel

campo temporale, e solitamente è specificato all’atto della

creazione,

oppure

può

appartenere

alla

descrizione

(per

esempio, note da un ottavo).

•

Audio – Un dato audio consiste in una sequenza di elementi

generati

da

una

registrazione

sonora.

La

componente

fondamentale di un dato audio è il campione (sample). Il dato

audio ha dei vincoli temporali che sono dettati dalla frequenza

di campionamento dell’apparecchiatura di registrazione.

•

Tipi di dati compositi – Questo tipo di dati è formato

dall’abbinamento

multimediali

di

dati

complessi.

multimediali

Entrambi

semplici

possono

e

essere

dati

uniti

fisicamente o logicamente. L’unione fisica dà come risultato un

nuovo

tipo

di

dato,

dove

ad

esempio

audio

e

video

interagiscono. L’unione logica, invece, prevede un’interazione

tra tipi di dati diversi, che tuttavia mantengono la loro

indipendenza sia individuale che di immagazzinamento. Ad

esempio, un nuovo tipo di AV o audio-video sarà composto da

41

due parti distinte. Tuttavia, durante la fase di riproduzione, il

sistema dovrà necessariamente distribuire le due parti in modo

sincrono, dando l’illusione che il risultato sia frutto di un solo

tipo di dato. I tipi di dati compositi possono anche contenere

informazioni di controllo modificabili dall’utente riguardanti la

riproduzione dei dati.

•

Presentazioni – Le presentazioni sono oggetti complessi che

descrivono i dati multimediali secondo il fine della loro

elaborazione ed esposizione. Queste orchestrazioni possono

consistere ad esempio in istruzioni che specificano quali video

riprodurre per primo, e quale per secondo, e così via. Oppure le

orchestrazioni possono essere più complesse, specificando

come utente, sistema e applicazioni devono interagire ai fini

della presentazione finale.

E’ chiaro che dati con caratteristiche tali necessitino di sistemi

di gestione adeguati per poter sfruttare in maniera ideale le

informazioni

che

essi

contengono.

Vediamo

quali

sono

le

caratteristiche principali, e quali sono di conseguenza alcuni dei

requisiti di un sistema di gestione che si occupi di dati multimediali:

•

Tipi di dati – A differenza dei sistemi che considerano i dati

come Blobs (Binary Large Objects), senza riconoscere i dati e

quindi senza trattarli in modo specifico, i DBMS multimediali

devono essere in grado di “capire” i dati che vengono

manipolati. Essi devono includere definizioni di classe (ecco il

richiamo

al

raggruppare

linguaggio

più

tipi

orientato

di

dati

agli

oggetti),

multimediali

che

può

oppure

può

considerarli in modo separato, avendo una classe per ogni tipo

di formato, dal JPG al GIF, dall’MPEG al tipo di dati senza

42

vincoli temporali. Ogni classe deve essere associata a delle

operazioni che sono eseguibili sui dati. Queste classi possono

essere parte di una gerarchia più complessa della quale fanno

parte tutti i dati riconducibili alla stessa famiglia (ad esempio il

suono o la grafica). Questo sistema “intelligente” permette di

semplificare e ottimizzare la gestione della grande varietà di

dati multimediali.

•

Dimensioni dei dati – I dati multimediali possono raggiungere

dimensioni considerevoli. Basti ricordare dei comuni esempi:

Figura 4. Esempi di media digitali.

Questo

fatto

può

influenzare

in

modo

sostanziale

la

progettazione hardware e software di un sistema di gestione di

dati multimediali. Le basi di dati possono avere dei limiti per

quanto riguarda le dimensioni dei dati che ospitano: restrizioni

dovute al file system in uso o al fatto che la base di dati non

ospita i dati multimediali veri e propri, ma solo i loro nomi, la

loro allocazione e i relativi metadati. Tuttavia una base di dati e

43

un

DBMS

multimediale

dovrebbero

essere

in

grado

di

immagazzinare e gestire una quantità infinita di dati, dai

gigabytes di oggetti come le immagini ai terabytes dei video e

delle

animazioni.

Solitamente

viene

raccomandato

di

conservare i dati veri e propri su un supporto fisicamente

separato dal luogo in cui si trovano le meta-informazioni

relative ai dati stessi; ad ogni modo questa caratteristica deve

essere contemplata sin dalla fase di progettazione del sistema.

Questo permette di servirsi di una base di dati di dimensioni

contenute e di facile gestione per quanto riguarda gli indici e le

parole chiave, sfruttando un consolidato sistema di gestione

della vecchia generazione, mentre per i dati multimediali ci si

potrà rifare ad un sistema di dischi paralleli con enormi

capacità di immagazzinamento in grado di distribuire i dati in

modo efficace.

•

Riproduzione – Perché dei dati multimediali vengano riprodotti,

è necessario disporre di dispositivi hardware di diverso genere,

ad esempio di uno schermo (nel caso di video e simili), di

altoparlanti (nel caso di audio), di microfoni, di schede

specifiche e così via, e di software in grado di supportare i

formati di dati da riprodurre. Per determinati tipi di dati,

distribuiti via rete, occorre una adeguata larghezza di banda

per soddisfare i vincoli temporali di riproduzione audio e video.

Può venire stabilita una qualità del servizio (QoS), quindi una

libertà di scegliere la qualità del dato richiesto a seconda della

banda a disposizione.

•

Programmazione delle risorse – Un utente potrebbe richiedere

diversi dati in sequenza: per questo è necessario assicurarsi

che il sistema di distribuzione e i dispositivi di registrazione e

44

riproduzione possano funzionare in modo programmato senza

entrare in conflitto.

•

Memoria, bus, CPU – Per gestire dati multimediali un calcolatore

deve disporre di memoria sufficiente per caricare immagini ad

alta qualità o audio non compresso. La potenza di un

calcolatore può influenzare significativamente la progettazione

del sistema di gestione e la qualità del servizio.

•

Query – I dati multimediali devono essere interpretati prima di

poter essere sottoposti ad una query. Per esplorare una base di

dati che contenga una considerevole quantità di dati è

necessario disporre di strumenti efficaci per evitare di operare

ricerche

dispersive,

approssimative

e

insoddisfacenti.

Analizziamo più nel dettaglio questo aspetto.

Le query nelle basi di dati multimediali

Le query (interrogazioni) sono specifici criteri di ricerca

mediante i quali è possibile reperire uno o più dati all’interno di un

database. Le query contengono dei predicati che devono venire

soddisfatti da ogni dato reperito. I predicati solitamente contengono

condizioni parziali o precise, come in “trova tutti i brani musicali che

contengano nel titolo la parola amore”, o range di valori come in

“trova tutti i brani musicali composti tra il 1963 e il 1969”.

A tutt’oggi il sistema più diffuso per indicizzare i dati all’interno

di

un

database

è

quello

delle

parole

chiave

(keywords).

L’immagazzinamento dei dati dà origine a delle descrizioni (le parole

chiave) che vengono associate ai dati stessi, e che costituiscono i

metadati (dati che descrivono dati). Tuttavia questo sistema presenta

dei forti svantaggi per quanto riguarda i nuovi tipi di dati che ormai

45

comunemente sono ospitati in un database. Semplici parole chiave,

per lo più create manualmente da un operatore umano, non sono

sufficienti a descrivere in modo esaustivo le immagini, i suoni e via

discorrendo. In primo luogo le parole chiave sono soggettive, in

quanto stabilite arbitrariamente da un essere umano, e questo fatto

può dare adito ad una errata o imprecisa classificazione. In secondo

luogo, le normali caratteristiche cui si riferiscono le astrazioni delle

parole chiave vanno riviste alla luce dei contenuti dei dati

multimediali: un utente potrebbe voler operare una ricerca inoltrando

una query che specifica il contenuto di un’immagine, oppure la

struttura armonica per quanto riguarda un brano musicale. Per

quanto l’uso delle parole chiave consenta un accesso rapido al

database, supportato peraltro da tutti i tradizionali DBMS, la

tendenza attuale è quella che si orienta sul cosiddetto accesso by

content, per contenuto (CBR, Content Based Retrieval, e CBQ,

Content Based Querying): in questo caso i dati multimediali devono

venire analizzati da algoritmi specializzati in grado di estrarre

informazioni ad alto livello dai dati materiali.

Generalmente questa analisi ha luogo nel momento in cui il

dato viene inserito nel database; essa aiuta a classificare il dato

secondo

criteri

alternativi,

tuttavia

non

ha

ancora

eliminato

completamente l’intervento umano nella fase di indicizzazione. Cosa

si intende per criteri alternativi? Per quanto riguarda le immagini

statiche, ad esempio, l’utente potrebbe inoltrare la query basandosi

sulla gamma di colori impiegata, sul soggetto dell’immagine, sui pixel,

la risoluzione e così via.

Vi è anche un diverso e più interessante modo di concepire le

interrogazioni, il cosiddetto query by example: l’utente fornisce il

46

dettaglio di un’immagine, e ne richiede l’immagine di provenienza, o

altre immagini simili.

Algoritmi sempre più sofisticati vengono costantemente messi a

punto, ma si è ancora lontani dal riconoscere in modo automatico,

per esempio, il contenuto di un filmato in termini di azioni svolte

durante il corso del filmato stesso.

Vediamo più nel dettaglio quale sia la situazione nel campo

della musica, sia a livello simbolico (MIDI) che di segnale (audio).

47

48

Parte 4

MIR: Music Information Retrieval

La storia del Music Information Retrieval non è recente come si

potrebbe pensare: i primi sistemi, infatti, risalgono ai primi anni

Sessanta. Dal momento che le reti non erano nella forma in cui noi le

conosciamo oggi, la maggior parte dei progetti legati al MIR adottava

un proprio standard per rappresentare la musica. Per citarne alcuni:

il DARMS (the Digital Alternate Representation of Music; Columbia

University, dal 1965), lo SCORE (Stanford and Colgate Universities,

dal 1972), il MUSTRAN (Indiana University, dai primi anni Settanta) e

il CERL (Illinois University, dal 1973).

49

Questa quantità di standard (che diventa inopportuno definire

con questo termine), rappresenta una vera e propria Babele di

linguaggi che di certo non viene incontro al tentativo di rendere

uniforme una volta per tutte il MIR. Questo non è da imputare,

ovviamente, solo alla storia del MIR, ma alla stessa natura del suo

oggetto: la musica.

Lo scopo del MIR è quello di processare informazioni musicali e

di setacciare database secondo criteri by content (per contenuto). In

che tipo di query si può concretizzare una ricerca per contenuto?

Le query by content

Fondamentalmente questo tipo di approccio si contrappone a

quello basato sulle parole chiave, che presenta dei limiti non

indifferenti, come accennato nella parte 4 (p.45). Un sistema che sia

in grado di gestire query by content utilizza criteri che non sono più

keywords ma descrizioni o astrazioni relative al contenuto musicale,

quali la struttura armonica, la melodia, e così via. Per fare ciò, è

necessario che si disponga di una tecnologia capace di compiere

questo tipo di astrazioni (poiché da un lato è impensabile processare

la quantità di dati che ragionevolmente farà parte di un database

musicale mondiale per mezzo di operatori umani, e dall’altro lato

molte di queste analisi sono possibili esclusivamente per le macchine,

ad esempio gli spettrogrammi, etc.). La questione non è ostica solo

dal punto di vista tecnologico, tuttavia, in quanto nello stesso campo

musicologico non vi è sempre unanimità nel condurre analisi

armoniche e formali. Quindi, prima di tutto il problema è al livello

50

umano: che dati si vogliono estrarre dalla musica? Come si intende

classificarli?

Affrontare questo problema è tutt’altro che banale, poiché nel

corso dei secoli la musica ha variato profondamente le sue modalità

di espressione, di rappresentazione, e la sua struttura. Codificare

musica polifonica pone problematiche diverse dal codificare una

sonata classica, come ancora è diverso farlo per dei brani del

repertorio gregoriano o per la musica contemporanea. Per questo il

MIR affonda le sue radici nell’Information Retrieval (IR), nella

musicologia e nella psicologia: si è provato che per molti individui

dotati di cultura musicale medio-bassa, sia più comune descrivere un

brano musicale in base a caratteristiche che non si evincono dalla

partitura, bensì dalla performance. Esempi sono il tempo e il vibrato.

Quindi non sarà sufficiente processare le partiture dei brani musicali,

ma occorrerà tenere in considerazione anche la parte legata

all’esecuzione, e quindi all’espressività.

Musica a livello simbolico e a livello di segnale

Processare della musica a livello simbolico o di segnale pone

problemi completamente diversi, giacché questi livelli costituiscono

due mondi a sé stanti (vedi già p.41). Da una lato abbiamo i MIDI

(Music Instruments Digital Interface), un formato che non contiene

informazioni sul suono inteso come onda sonora o vibrazione, bensì

contiene istruzioni che si riferiscono alla durata e all’altezza dei

singoli eventi sonori (note musicali). Il file MIDI si visualizza in un

modo che assomiglia in tutto e per tutto ad una partitura musicale;

in fase di riproduzione, i suoni vengono generati solitamente dalla

scheda audio in dotazione. Per questo motivo il formato MIDI è di

51

dimensioni assai ridotte (non contiene audio ma solo istruzioni) e

gode di buona fortuna sulla rete.

Dall’altro lato troviamo la musica come segnale, ovvero tutto

l’audio rappresentato secondo le caratteristiche dell’onda sonora, sia

essa codificata in modo analogico o digitale. In entrambi i casi il

suono è catturato da un trasduttore elettroacustico che trasforma le

variazioni di pressione dell’aria in impulsi elettrici, che quindi si

riferiscono precisamente al suono fornito in ingresso. Questo tipo di

codifica è molto voluminosa se paragonata al MIDI, e non fornisce

informazioni sulla melodia nel modo in cui farebbe un MIDI, in

quanto sono assenti le componenti di durata e altezza nel codice. In

questo senso si potrebbe compiere una distinzione alternativa,

dividendo il suono in

“audio strutturato” e “non strutturato”: per

audio “non strutturato” si intende quello appena descritto, ovvero

quello dove non compaiono delle informazioni astratte sull’audio

contenuto, mentre per audio “strutturato” si intendono quei formati

dove sono presenti informazioni sul contenuto (quindi vi ritroviamo il

formato MIDI, ma anche i nuovi formati di compressione MPEG-7 ed

MPEG-21, che uniscono queste informazioni al segnale come forma

d’onda). Per estrarre le informazioni che il suono a livello di segnale

non contiene, esso ha bisogno di essere analizzato mediante

opportuni algoritmi.

Ammesso che questi algoritmi vengano sviluppati, e che si trovi

un accordo sul modo di classificare le informazioni evinte, sarà

possibile sbizzarrire la fantasia su tipi di interrogazioni tra le più

variegate: reperimento o confronto e paragone di brani secondo criteri

di somiglianza nello spettro, nell’organico, nell’armonia o anche solo

in una certa sequenza di intervalli. Chi più ne ha più ne metta.

52

Forse

sarà

proprio

questa

la

causa

della

mancata

standardizzazione per quanto riguarda il MIR: la curiosità dell’uomo,

che non si ferma mai alle frontiere cui è giunta, ma si spinge sempre

oltre nel tentare di stabilire relazioni tra oggetti apparentemente

diversi, nel classificare la conoscenza secondo nuovi e personali

criteri. Un numero di possibilità che non può essere quantificata, ma

nemmeno negata in quanto deve essere una libertà degli individui

quella di stabilire le connessioni tra gli oggetti del mondo nel modo

più personale. Un linguaggio, tuttavia, sembra prestarsi ad un

intento di standardizzazione che risponda a molte delle esigenze

sopra esposte, e allo stesso tempo alle esigenze di personalizzazione e

ampliamento delle classificazioni: l’XML.

XML4MIR:

Extensible

Markup

Language

for

Music

Information Retrieval

L’XML è un linguaggio di markup estensibile raccomandato dal

W3C (World Wide Web Consortium) e il cui sviluppo è supportato

dalla

ISO

(International

(Organization

for

the

Standards

Advancement

Organization)

of

Structured

e

la

OASIS

Information

Standards). A dispetto del nome, tuttavia, l’XML non è esattamente

un linguaggio di markup, ma piuttosto un meta-linguaggio: esso ha il

grande pregio di permettere agli utenti la definizione di nuovi tag ad

hoc per le proprie esigenze (a seconda che in XML si vogliano

organizzare la propria discoteca personale o la biblioteca e così via).

Quindi si tratta di un linguaggio flessibile, che in virtù di questa

caratteristica si presta decisamente ad essere un supporto per la

descrizione della musica, così varia e in continua evoluzione.

53

Più che flessibile, l’XML è un linguaggio estensibile: ciò significa

che modifiche e miglioramenti possono essere aggiunti in qualsiasi

momento, senza dover ripensare tutta la struttura del linguaggio.

Inoltre, il codice XML è facilmente leggibile da un essere umano: dal

momento che i tag sono creati su misura per i dati che descrivono, le

righe del codice danno intuitivamente un’idea di quali siano

l’argomento e il fine del file XML. Vediamo un esempio, che lascia

capire come questa intuitività sia palese:

Figura 5. Un esempio di codice XML.

La caratteristica forse più importante dell’XML, non solo per

quanto riguarda la sua applicazione al MIR, è l’indipendenza tra

struttura e contenuto. Essa permette il riutilizzo dei dati per diversi

fini (fruizione umana, pubblicazione, ecc.) mantenendo un solo file

XML; permette l’uso dei dati da parte di più applicazioni (Web

browsers e MIDI players); permette una diversa visualizzazione dei

dati a seconda dei bisogni, grazie all’alto livello di astrazione del

contenuto dei file XML.

54

Infine, l’XML non si presta a descrivere solo i dati musicali. Uno

tra i maggiori vantaggi dell’adottare l’XML per descrivere la musica,

infatti, è la possibilità di integrare i dati con i meta-dati. La figura che

segue illustra con chiarezza la somiglianza tra un file XML che

descrive dati musicali e uno che descrive i relativi meta-dati.

Figura 6. Esempio di somiglianza tra codici XML

che descrivono dati musicali e relativi meta-dati.

Il MIR e la musica contemporanea

Pensiamo alle possibili applicazioni del codice XML ad un tipo

di musica come quella colta contemporanea. Essa pone delle

problematiche che in molti hanno tentato di risolvere, ma che

tuttavia sembrano ancora aperte: nella musica contemporanea

vengono meno quei riferimenti essenziali che orientano l’ascoltatore e

che costituiscono la guida per le analisi tradizionali. Dalla seconda

metà del secolo scorso, venute meno la tonalità e le tecniche

dodecafoniche,

ogni

compositore

che

abbia

voluto

dare

una

fondazione rigorosa al proprio metodo compositivo ha elaborato un

proprio modello, ossia

ha definito una teoria per dare valore di

oggettività al proprio sistema. Il relativismo dei codici è uno degli esiti

del linguaggio nelle arti del ‘900, e in musica il momento

dell’elaborazione teorica è diventata parte integrante del processo

compositivo, nel senso che la teoria rappresenta un metalinguaggio

che viene ad essere integrato in essa.

55

Le classificazioni maggiormente impiegate allo stato attuale non

prevedono organici che differiscano dai tradizionali strumenti (archi,

percussioni, eccetera): questo esclude la musica elettronica da ogni

possibile analisi. Molti brani di musica contemporanea basano la loro

forma su aspetti particolari quali lo spettro armonico di un

determinato strumento o su modelli di vario genere (includo i

quadrati magici, e così via), per cui sono solo apparentemente senza

forma;

tuttavia,

anche

se

vi

è

una

logica

(nascosta)

nell’organizzazione del materiale sonoro, mancano del tutto degli

algoritmi capaci di rintracciare e riconoscere queste regole.

L’XML promette di rispondere molto bene alle esigenze della

musica contemporanea cui ho accennato nei paragrafi precedenti.

Grazie al suo potenziale di adattamento sia nei contenuti che nella

struttura, l’XML potrebbe trovare uno o più modi per codificare in

modo efficace partiture tradizionali e partiture di musica elettronica;

e per quanto riguarda la visualizzazione, l’XML potrebbe essere la

risposta a molte delle esigenze sopra elencate, dalla rappresentazione

grafica di sonogrammi e schemi formali, a quella dell’audio, a quella

di eventuali strumenti di intervento sul materiale sonoro (vedi

l’esempio di una Sound Palette a p.71).

Una nuova metodologia: il Data Mining

Una enorme mole di informazioni potenzialmente utili e

importanti si trova racchiusa nei database: tuttavia la quantità di

dati che essi contengono assomiglia piuttosto ad un paesaggio

caotico, che non fornisce alcuna conoscenza utile. Il Data Mining

(letteralmente “scavare nei dati”, dove i dati sono paragonati ad una

56

miniera) si propone come nuovo tipo di approccio a questo caos,

estraendo le informazioni implicite, già note o potenzialmente

interessanti dai dati grezzi. Per tentare una definizione, si può dire

che il Data Mining consista in “un processo atto a scoprire

correlazioni, relazioni e tendenze nuove e significative, setacciando

grandi quantità di dati immagazzinati nei repository, usando tecniche

di riconoscimento delle relazioni e tecniche statistiche e matematiche”

(Gartner Group). Diverse tecniche di machine learning stanno alla

base del Data Mining: per mezzo di esse i dati vengono analizzati e

qualsiasi logica nel modello sottostante (se un modello vi è) viene

portata alla luce.

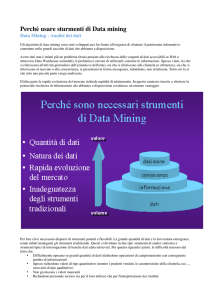

Figura 7. Come il Data Mining differisce da metodi di analisi convenzionali.

Il processo conoscitivo impiegato dal Data Mining differisce da

quello tradizionale in un passo fondamentale (figura 7): nelle ricerche

condotte finora, i dati venivano scandagliati per trovare conferma ad

una ipotesi formulata a priori. In questo modo la probabilità che i

dati venissero interpretati in favore dell’ipotesi era maggiore, poiché

l’idea di partenza guidava nella ricerca delle prove. La figura 7

compara questo modo di procedere con quello del Data Mining: come

57

si può vedere, nel secondo caso l’ipotesi non è il punto di partenza, e

nemmeno precede le analisi. Ciò da cui si parte sono i dati grezzi; su

di essi si stabiliscono relazioni che solo alla fine porteranno alla

formulazione di ipotesi (che guideranno le decisioni per l’azione).

Vediamo ora come si svolge un ciclo vitale di Data Mining, dai

dati all’azione. Esso consta di sei fasi, la cui sequenza non è

predefinita: è opportuno, anzi, che tra le fasi ci si sposti in più

direzioni, a seconda del risultato ottenuto. Al termine, il processo

successivo trarrà vantaggio dalle informazioni portate alla luce dal

precedente. Lo schema di figura 8 mostra le relazioni tra le più

probabili in un ciclo vitale di Data Mining.

Figura 8. Standard per lo sviluppo delle analisi di Data Mining.

1. Problem Understanding: La prima fase consiste nella messa a

fuoco del problema, del tipo di dati che si vuole processare e

degli obiettivi approssimativi che si desiderano raggiungere.

58

Questo passo non corrisponde alla formulazione di ipotesi, ma

alla determinazione di un contesto in cui si vuole operare.

Infatti, per quanto il Data Mining sia un processo volto a

scoprire relazioni tra dati, esso non può e non deve scoprire

relazioni che non esistono. Essendo un momento in cui si

imposta la ricerca, la prima fase aiuta a garantire i requisiti

fondamentali per il conseguimento di buoni risultati, che sono

la coerenza e la pulizia dei dati.

2. Data understanding: Il secondo passo consiste in una rassegna

generale dei dati. Si affronta un primo approccio con essi,

portando in luce le relazioni più evidenti e tentando di capire in

che area vi sia maggiore probabilità di ottenere dei successi.

3. Data preparation: Questa fase consiste in tutte le operazioni di

creazione di tabelle, record, attributi che renderanno i dati

adatti ad essere processati dagli strumenti di analisi.

4. Modeling: In questa fase vengono applicate ai dati diverse

tecniche di analisi (di machine learning); è probabile che ci si

veda costretti a ritornare alla fase precedente anche più di una