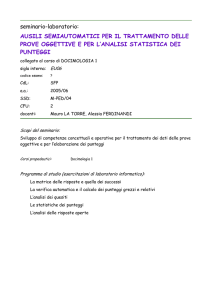

caricato da

common.user17721

Docimologia: Voti a Scuola e Valutazione degli Apprendimenti