LUDOVICO GEYMONAT

Storia

del pensiero

ftlosoftco

e scientifico

VOLUME NONO

Il Novecento (3)

Con specifici contributi di

Bernardino Fantini, Giulio Giorello, Corrado Mangione,

Silvano Tagliagambe, Renato Tisato

GARZANTI

www.scribd.com/Baruhk

I edizione: aprile 1972

Nuova edizione: novembre 1976

Ristampa 1981

©

Garzanti Editore s.p.a., 1972, 1976, 1981

Ogni esemplare di quest'opera

che non rechi il contrassegno della

Società Italiana degli Autori ed Editori

deve ritenersi contraffatto

Printed in Italy

www.scribd.com/Baruhk

SEZIONE UNDICESIMA

Per una nuova concezione del mondo

realistica e razionalistica

www.scribd.com/Baruhk

www.scribd.com/Baruhk

CAPITOLO PRIMO

N ola introduttiva

L'oggetto del presente volume è la contemporaneità, nel senso più pregnante del termine.

In effetti, entro l'amplissimo ventaglio delle scienze odierne, la biologia

e la logica - alle quali sono dedicati i capitoli secondo e terzo, costituenti in

certo senso la prima parte del volume - possono venire a buon diritto considerate le scienze oggi più ricche di novità, le più promettenti per il futuro, le

più feconde di sviluppi originali.

Come è noto, non sono pochi a ritenere che la prima di esse (la biologia)

abbia assunto negli ultimi tempi la posizione di « scienza-guida » occupata fino a qualche anno addietro dalla fisica.

Aggiungiamo che di entrambe vengono analizzati, negli anzidetti capitoli,

gli sviluppi più moderni, come - per la logica - la teoria delle categorie, di

importanza capitale anche per la matematica, e come - per la biologia - la

genetica molecolare che notoriamente si trova alla base del nuovo evoluzionismo nonché degli affascinanti dibattiti che si sono avuti intorno al caso e alla probabilità.

Sia la trattazione della prima sia quella della seconda scienza richiedono,

come il lettore vedrà, il ricorso a qualche tecnicismo; ma tale ricorso verrà tenuto nella minima misura possibile, dato il nostro esplicito intento di porre

in luce, non solo il significato scientifico degli argomenti presi in esame, ma

pure quello filosofico generale.

Il fatto che, nei due capitoli in esame, i legami fra scienza e filosofia rivelino la loro essenzialità per entrambe, acquista un particolare significato nel

presente volume; dimostra infatti che si tratta di legami ancora oggi di grande

attualità, confutando così la pretesa che essi si riducano ormai a poco più che

un ricordo del passato. Confessiamo francamente di scorgere in ciò una chiara

conferma della validità dell'impostazione che abbiamo cercato di dare all'intera nostra opera, imperniata appunto sulla inscindibilità fra pensiero filosofico

e pensiero scientifico.

Né meno attuali o meno significativi risultano gli argomenti trattati nel

7

www.scribd.com/Baruhk

Nota introduttiva

quarto e nel quinto capitolo (che possono considerarsi come costituenti la seconda parte del volume).

Il quarto fornisce infatti un ampio resoconto cr1t1co di uno dei più v1v1

dibattiti che stanno appassionando da circa un decennio la cultura filosofica

e scientifica anglo-americana: il dibattito sul significato della crescita della scienza, sul suo carattere razionale o meno, sui modelli più idonei a farci cogliere

tale razionalità, posto che esista.

Il quinto affronta poi in forma originale il complesso problema, di natura

non solo teorica ma anche politica, dei rapporti tra scienza e filosofia nell'Unione Sovietica. Al fine di farcelo cogliere in tutti i suoi aspetti, ne delinea

la storia a partire dal I 92 I, seguendo ne le alterne vicende durante gli ultimi

anni della vita di Lenin e poi durante la lunga era staliniana per giungere fino ai nostri giorni.

Parecchie pagine del più vivo interesse sono dedicate al « caso Lysenko » e ai

dibattiti intorno all'interpretazione filosofica della meccanica quantistica, studiati - sia quello che questi - su abbondante materiale pressoché sconosciuto

in Occidente.

L'importanza culturale di questi due capitoli è evidente, come è evidente

il nuovo contributo che essi recano alla tesi, poco sopra accennata, circa l'interesse essenziale che presenta ancora oggi, non meno che in passato, il problema dei legami tra scienza e filosofia. Ovviamente questo problema viene

attualmente formulato in termini diversi da quelli usati nei secoli scorsi, ma

ciò non toglie nulla alla sua centralità. Ed è pure rimarchevole che esso possegga

un peso altrettanto grande in due culture così diverse come quella anglo-americana e quella sovietica.

Finora la cosa era relativamente nota per la prima, ma non per la seconda; uno dei meriti incontestabili di Silvano Tagliagambe, autore del quinto

capitolo, sta proprio nell'averci fatto scoprire l'incidenza del problema anche

nell'Unione Sovietica, erroneamente considerata ancora oggi, specialmente in

Italia, come impermeabile a queste raffinatissime indagini.

Quanto all'attualità delle varie questioni discusse nell'ultima parte del volume, cioè nei capitoli sesto e settimo (quali ad esempio la questione della gestione sociale della scuola o quella della neutralità della scienza), non è il caso

di aggiungere parola, tanto essa appare evidente. In effetti, tali capitoli affrontano, in forma teoretica più che storica, alcuni nodi centrali della nostra civiltà

largamente dibattuti in Italia come all'estero. Non già che prescindano da ogni

considerazione storica, ma possono esimersi dal discuterla direttamente, perché

basta loro far riferimento ai numerosi capitoli di specifico argomento storico

contenuti nei volumi precedenti. Possono anzi considerarsi come la conclusione di tali volumi, cioè come il punto di approdo delle indagini ivi

ampiamente svolte.

www.scribd.com/Baruhk

Nota introduttiva

In quanto tali, hanno un carattere non solo teorico ma in certo senso programmatico, perché cercano di enucleare le più profonde esigenze della scuola

e della cultura odierne, e su questa base si sforzano di indicare alcuni impegnativi

suggerimenti, nella convinzione che possano riuscire di qualche utilità a chi

intenda darvi una risposta seria e consapevole.

9

www.scribd.com/Baruhk

CAPITOLO SECONDO

La nuova biologia

DI BERNARDINO FANTINI

I • INTRODUZIONE

Con la trattazione sostanzialmente storica che è stata seguita nei precedenti capitoli di quest'opera dedicati alla biologia, siamo giunti alle soglie di

quella che viene chiamata la « nuova biologia », per sottolineare il carattere

di profonda svolta che si è verificato nelle scienze biologiche, nel loro complesso, intorno al I 9 5o, svolta le cui premesse, come abbiamo visto nel capitolo

IV del volume ottavo, erano già state poste negli anni trenta e quaranta.

Si dovrebbe infatti parlare, più che di svolta, di un momento di sintesi,

di incontro fra filoni di ricerca che sembravano incomunicanti, di unificazione

all'interno di una teoria unitaria di interpretazioni che sembravano contrapposte (come nello studio dell'evoluzione, dove la teoria moderna, che unifica

l'approccio genetico e quello morfologico ed ecologico, non a caso è detta

«sintetica»). La stessa nascita della genetica molecolare che, nel bene e nel

male, ha segnato profondamente tutta la biologia contemporanea, è un momento di sintesi fra conoscenze ed interpretazioni teoriche che erano state raccolte ed avanzate da decenni, una sintesi che prima o poi, per dire così, « doveva esserci ». Ma come sempre nella storia della scienza, un momento di sintesi audace diviene il punto di partenza per nuovi programmi di ricerca, per

una reinterpretazione di vecchie teorie, anche delle più consolidate, per gettare nuova luce su aspetti rimasti ancora non spiegati, per prevedere nuovi risultati sperimentali. Tutto il complesso delle ricerche biologiche nella sua fase

attuale è caratterizzato da questo processo di costruzione di nuove interpretazioni della realtà della vita, basato sulla teoria sintetica della evoluzione da

una parte, sulla biologia molecolare dall'altra e sul loro incontro-confronto.

La « svolta sintetica » non ha portato solo ad un incredibile aumento di

conoscenze ma soprattutto ha permesso di fondare su basi più solide che nel

passato lo sforzo di costruzione di una teoria generale della biologia, anche se

questo sforzo si è spesso limitato ad una più rigorosa chiarificazione dei principali termini esplicativi e metodologici, senza impegnarsi nella costruzione

dello « scheletro logico del sistema esplicativo » (Ernst Nagel).

IO

www.scribd.com/Baruhk

La nuova biologia

Fino agli anni quaranta infatti, se si eccettua, forse, la sola genetica, che sin

dall'inizio aveva assunto una struttura quasi assiomatica, la biologia era rimasta

una scienza puramente descrittiva, che si limitava alla raccolta dei dati ed alla

loro correlazione. Il dibattito teorico era molto vasto ma riguardava i principi primi, era sganciato dalla ricerca militante. La biologia molecolare e la

teoria sintetica dell'evoluzione si pongono invece immediatamente, e prepotentemente, come spiegazioni scientifiche e non prevalentemente speculative dei

fenomeni biologici, dei quali diviene possibile individuare cause e modalità

sulla base di alcuni principi teorici generali. Parliamo di spiegazioni e non di

spiegazione perché, come meglio vedremo in seguito, la teoria dell'evoluzione

e la biologia molecolare si pongono come spiegazioni alternative, l'una sostanzialmente storica e teleologica, l'altra funzionalistica, di un unico oggetto: la complessità coordinata dei sistemi biologici, nella sua multiforme varietà di livelli

di organizzazione.

Sulla base di questa generalizzazione delle proprie capacità esplicative, la

biologia, pur senza raggiungere ancora i livelli teorici sui quali si era mossa

all'inizio del secolo la fisica, si impegna nella assiomatizzazione e formalizzazione

delle teorie, nella elaborazione di modelli generali, nella ridefinizione dei metodi, degli schemi interpretativi, dei principali concetti ed enunciati. Di conseguenza, si estende anche l'interesse per la filosofia della biologia e per la sua

storia, che diviene uno strumento di chiarificazione e di ridefinizione dei fondamenti teorici, parte integrante della stessa costruzione delle teorie scientifiche.

Nostro compito, in questo capitolo, sarà enucleare, dal vasto panorama

delle scienze biologiche nel periodo 1940-70, i filoni di ricerca più rilevanti,

i nodi teorici, i problemi epistemologici aperti, gli aspetti che hanno un maggiore rilievo filosofico e culturale, senza pretendere- non ci basterebbe lo spazio né ci interessa in questa sede - , di fare un resoconto esaustivo. Per ottenere

ciò non potremo, data la vicinanza nel tempo, seguire un criterio di ricostruzione cronologica né crediamo sia facile individuare precise linee di pensiero

fra loro separate da mettere a confronto, a causa della estrema varietà delle

posizioni teoriche e culturali, anche all'interno di singoli settori e talvolta del

singolo autore, e il carattere tuttora aperto del dibattito, continuamente arricchito da nuovi dati e nuove interpretazioni teoriche.

Non crediamo utile nemmeno una trattazione per discipline. La biologia

moderna infatti è abbastanza frastagliata in singoli settori specialistici, ciascuno dei quali ha dato contributi essenziali all'insieme delle conoscenze ed

alla definizione dei nodi teorici, ma che non è possibile, se non si vuol cadere

in un antologismo banale ed inconcludente, seguire nel suo particolare sviluppo.

La multidisciplinarità, quindi, e la varietà delle posizioni teoriche e culturali

che caratterizzano buona parte della biologia, dove un oggetto è affrontato da

Il

www.scribd.com/Baruhk

La nuova biologia

diversi punti di vista, sia sperimentali che interpretativi, che culturali, consiglia di puntare l'attenzione più sull'oggetto stesso che sulle diverse posizioni

che con esso si confrontano. Occorrerà quindi seguire una trattazione per problemi, scegliendo, anche a costo di drastiche esclusioni e di raggruppamenti

che non sempre potranno essere condivisi, quei temi scientifici che hanno avuto

ed hanno maggiore valore euristico e rilievo teorico, culturale e filosofico. Il

tema unificante di questo insieme di problemi, se si vuole trovarlo, potrebbe

essere quello della spiegazione scientifica in biologia, intesa sia come spiegazione

dell'oggetto biologico, sia come spiegazione con concetti e teorie biologiche

di altri aspetti della natura, ed in particolare del comportamento e del pensiero.

Da quanto detto, risulta che il primo problema da affrontare riguarda la

collocazione della biologia nei confronti delle altre scienze, la fisica, la chimica

e la matematica da una parte e la psicologia e le cosiddette scienze umane dall'altra.

Nella nostra trattazione dovremo quindi, innanzitutto, analizzare in dettaglio i rapporti della biologia con le scienze fisico-matematiche, rapporti che,

diversamente dal passato, non sono, specie negli ultimi anni, a senso unico,

basati cioè sull'utilizzazione delle conoscenze e dei metodi fisici e chimici sul

terreno biologico, ma rapporti di scambio estremamente fecondi. Lo prova

l'uso di concetti tipicamente biologici - gerarchia, organizzazione, omeostasi,

selezione naturale - in fisica e viceversa l'ampia utilizzazione di concetti fisici

e matematici in biologia. L'analisi del contributo dato alla biologia dalle scienze

fisiche in questo secolo (in particolare dalla meccanica quantistica, dalla termodinamica, dalla cibernetica e, per entrare direttamente in campo biologico,

dalla biofisica e dalla biochimica) ci fornirà elementi conoscitivi e linguistici

per comprendere le fasi successive della «nuova biologia», che proprio dall'incontro fra scienze fisiche e biologiche ha derivato nuovi concetti.

Passeremo poi ad analizzare, nel loro sviluppo storico e nella loro formulazione attuale, i due pilastri della moderna biologia, e cioè la teoria sintetica

dell'evoluzione e quella che potremo complessivamente chiamare la spiegazione molecolare. Preferiamo parlare di spiegazione molecolare dato che il termine biologia molecolare nell'uso ha acquisito un particolare campo d'azione,

chè non corrisponde al grande tentativo di spiegare il complesso delle funzioni

dei sistemi viventi sulla base delle strutture molecolari e delle loro aggregazioni

meccaniche in livelli gerarchici più elevati. Affronteremo, nell'ambito di questo paragrafo, i due settori che maggiormente hanno beneficiato della trattazione molecolare. Il primo è la genetica, o almeno una parte di essa, che viene

appunto chiamata genetica molecolare, dato che alcune branche genetiche ed

in particolare la genetica di popolazione per la verità molto poco hanno in

comune con la biologia molecolare e tendono invece a collegarsi più stretta12

www.scribd.com/Baruhk

La nuova biologia

mente alla teoria dell'evoluzione (genetica evoluzionistica). Quindi tratteremo

della embriologia, intesa in senso lato, cioè come l'insieme degli studi sui processi ontogenetici che portano dall'uovo fecondato all'individuo maturo.

La teoria dell'evoluzione si pone al centro della biologia moderna, non

solo perché è il quadro di riferimento necessario per ogni teoria biologica,

ma perché costituisce realmente il punto di congiunzione fra le scienze « della

natura » esterne all'uomo e le scienze dell'uomo stesso, della sua struttura al

tempo stesso biologica e psicologica. I rapporti fra l'evoluzione biologica e

l'evoluzione culturale e sociale nell'uomo, ma non solo nell'uomo, si pongono,

in effetti, come una discriminante netta fra diverse concezioni del mondo e

non a caso hanno costituito e costituiscono anche oggi, e forse più di ieri, perché nel frattempo sono di molto aumentate le conoscenze su entrambi i tipi

di evoluzione, un terreno di vivace battaglia culturale e teorica e, in ultima

_

istanza, politica.

A questo stesso filone esplicativo, quello evoluzionistico, si riallacciano

anche le moderne correnti di studio del comportamento animale e umano sviluppatesi rigogliosamente solo dopo gli anni quaranta e presto divenute oggetto

di esaltazioni acritiche e di attacchi altrettanto gratuiti. L'etologia, ossia lo studio

delle basi biologiche del comportamento, ha acquistato, come vedremo, una

propria autonoma collocazione, basata su solide conoscenze sperimentali e su

autonomi principi esplicativi.

Nel penultimo paragrafo dovremo confrontarci con il problema che, insieme con la natura della vita, costituisce la maggiore sfida alla biologia moderna

e alle sue capacità esplicative: la natura del pensiero, le sue basi biologiche,

il rapporto fra il biologico e lo psichico.

Al termine della nostra trattazione, affronteremo i nodi metodologici ed

epistemologici e infine culturali e filosofici che gli sviluppi delle scienze biologiche pongono alla riflessione teorica. A partire dagli anni cinquanta la biologia si pone come oggetto sempre più privilegiato dell'insieme delle riflessioni

teoriche e metodologiche, diviene- il punto di riferimento sul quale misurare

la capacità esplicativa di altre discipline scientifiche. La fisica e la matematica,

in particolare, confrontandosi con l'oggetto biologico, che non possono più

evitare se vogliono costruire teorie generali, elaborano nuovi concetti, nuovi

principi esplicativi.

La biologia si pone oggi al centro della riflessione filosofica e culturale,

ed anche dell'attenzione del grande pubblico, non solo per l'enorme massa di

conoscenze che in pochi anni è riuscita ad accumulare, ma soprattutto perché

rappresenta ciò che rappresentò la fisica all'inizio del secolo: il punto di riferimento costante per la riflessione teorica, il crogiuolo da dove emergono concetti e teorie in grado di modificare in profondità l'immagine che l'uomo ha

del mondo e di se stesso.

www.scribd.com/Baruhk

II

I R A P POR T I C O N L E S C I E N Z E F i S I C O-M A T E M A T I C H E

1) Fisica e biologia

Avremmo forse dovuto chiamare questo paragrafo semplicemente « biofisica ». Così facendo però, ci saremmo imbattuti in una difficoltà tradizionale che

si incontra quando si parla delle cosiddette discipline di confine: quella di darne

una definizione. Del termine biofisica si è fatto e si fa tuttora un ampio uso

(anche per indicare la mera applicazione di tecnologie fisiche allo studio di problemi biologici, se non alla semplice analisi), ma un accordo su cosa debba

rientrare in questa disciplìna non esiste.

Definizioni del tipo «la biofisica è l'insieme dei campi di ricerca sugli organismi viventi che richiedono l'uso di concetti e metodologie tipiche della fisica »

o del tipo « la biofisica si occupa dei problemi al limite fra la fisica e la biologia »,

che spesso si tro.vano nelle prime pagine dei trattati di biofisica; oscillano tra

una concezione totalizzante, per cui la biofisica diviene semplicemente l'applicazione di ogni tipo di metodo e concetto fisico alla biologia ed è quindi solo

della biologia fatta con particolari metodi, e una restrittiva, che però lascia

fuori buona parte della ricerca spesso importante che sotto questo nome si

fa su materiali biologici.l Per definire una scienza non basta individuarne alcune tecniche né isolare dei problemi particolari che non sono specificamente

affrontati dalle discipline « tradizionali», ma occorre definirne i criteri esplicativi e la struttura logica, e vedere se questa è o meno autonoma. Per queste

difficoltà di definizione, preferiamo parlare più in gene>:ale dei rapporti tra fisica e biologia.

Questi rapporti hanno avuto una storia piuttosto complessa. Mentre nell'Ottocento, nell'ambito soprattutto dei programmi meccanicistici, la fisica era

la base e il modello dei criteri esplicativi dei fenomeni biologici, e la fisiologia

è stata il risultato di questa volontà di descrivere fisicamente le funzioni biologiche

fondamentali, all'inizio e fino alla metà di questo secolo vi è stata una frattura

abbastanza netta, a causa di un divergere degli interessi rispettivi dei biologi

e dei fisici. La fisica infatti, con la relatività e la meccanica quantistica, viene

ad occuparsi di oggetti o troppo piccoli o troppo grandi rispetto a quelli bioI Una dimostrazione di tali difficoltà è evidente nella seguente definizione data da M. Ageno:

« La biofisica assume come dati di partenza i principi generali della fisica.e tutte le note conseguenze

che da essi .derivano per via deduttiva, e si pro;:>ane di spiegare in base ad essi la possibilità

dell'insorgere di sistemi materiali quali gli organismi viventi, nonché l'intera fenomenologia

cui questi danno luogo. » Se si interpreta in senso

lato questo tipo di definizione, ogni studio con

metodi fisici ed ogni spiegazione con concetti

fisici dei fenomeni biologici possono rientrarvi;

se la si interpreta in senso stretto si identificherebbe la biofisica con la spiegazione fisica di

processi naturali delimitati nel tempo (in parole

povere l'origine della vita). E questo è certo

per lo meno singolare; sarebbe infatti la prima

volta che una disciplina viene definita non sulla

base dei propri principi teorici, metodologici e

tecnici o dal suo campo di applicazione ma da

un lasso di tempo.

14

www.scribd.com/Baruhk

La nuova biologia

logici, mentre la biologia, dopo il sostanziale fallimento del programma meccanicistico,1 si andava impegnando nella costruzione di un proprio sistema teorico,

basato su concetti autonomi.

Il legame fra la biologia e la fisica si ripristina, più che con l'affermazione

di una nuova disciplina, col diretto passaggio di molti fisici allo studio dei processi vitali; molti di questi infatti, anche per un certo esaurirsi delle problematiche della fisica in senso stretto, scoprono, come dice Max Delbruck, « per la

prima volta i problemi della biologia », divengono semplicemente dei biologi,

portando con loro non tanto l'uso di tecniche fisiche particolari quanto soprattutto un metodo di ricerca ed un rigore teorico allora non molto diffusi nel

mondo biologico.

Dal punto di vista propriamente teorico, i contributi maggiori alla conoscenza biologica da parte della fisica sono venuti dal confronto fra due delle

maggiori teorie fisiche contemporanee, la meccanica quantistica e la termodinamica

statistica, con l'organizzazione biologica e la sua modificazione evolutiva.

a) Meccanica quantistica e biologia. La meccanica quantistica all'inizio si era

praticamente disinteressata dei fenomeni vitali, nonostante che alcuni processi

biologici, come le mutazioni, i processi di regolazione ed i fenomeni di trasporto sembrassero coinvolgere atomi isolati e singole molecole, elettroni delocalizzati ed anche singoli quanti di energia, come nella fotosintesi clorofilliana,

e avrebbero potuto essere trattati con metodi quantomeccanici. Le difficoltà

che si frappongono a questa trattazione, che ridurrebbe almeno parte della

biologia alla meccanica quantistica, risiedono in primo luogo nel fatto che tali

singoli eventi elementari non sono mai isolati ma fanno parte di una lunga catena

di relazioni che comporta in genere aspetti tipicamente macroscopici. La meccanica quantistica, nella sua attuale formulazione, non è in grado di trattare

adeguatamente le interazioni fra micro e macrofenomeni.

L'altra difficoltà per una trattazione quantomeccanica dei fenomeni vitali

consiste nel fatto che i sistemi biologici a livello più semplice, ed in particolare

le proteine e gli acidi nucleici, non possono essere considerati né macroscopici

né microscopici perché il numero di particelle che li compongono è troppo

piccolo per una trattazione macroscopica (nei termini della termodinamica statistica classica) e troppo grande per una trattazione quantomeccanica.

La applicazione dei metodi quantistici ha svolto un· ruolo importante nel

calcolo dei parametri chimici e fisici delle molecole di interesse biologico. Soprattutto grazie al metodo semiempirico di approssimazione LCAo (Liner comI Il programma meccanicistico in biologia,

sviluppatosi negli anni I87o-1920 fu cosa diversa

dal meccanicismo fisico (si veda il voL v). Il

fatto stesso che il meccanicismo biologico si sia

affermato solo quando ormai il programma la-

placiano mostrava ampie crepe, è indice di un

tipo di riduzione che proprio dalla crisi del meccanicismo fisico e dai nuovi principi teorici della

termodinamica e della chimico-fisica traeva stimoli per una impostazione riduzionistica.

www.scribd.com/Baruhk

La nuova biologia

bination oj atomic orbitals) è stato possibile calcolare i valori energetici e gli indici

elettronici delle molecole o dei gruppi funzionali. Tali valori e indici determinano le proprietà chimiche e chimico-fisiche essenziali delle molecole e permettono quindi una interpretazione della loro struttura e del loro comportamento

nelle reazioni. Il frutto più recente di questa tecnica, l'analisi conformazionale,

permette di calcolare la struttura teoricamente più stabile di una molecola, che

confrontata con quella ottenuta sperimentalmente, ad esempio mediante diffrazione ai raggi X, può venire via via affinata sino a raggiungere una elevata

risoluzione, rendendo possibile la predizione del suo comportamento nelle diverse condizioni naturali o sperimentali.

Particolarmente studiato è il fenomeno della delocalizzazione elettronica

lungo la molecola. La quasi totalità delle molecole di interesse biologico, compresi

gli acidi nucleici e le proteine, sono molecole parzialmente o completamente coniugate; contengono cioè molti legami di tipo TI. Ciò renderebbe possibile una

« delocalizzazione elettronica generalizzata in buona parte dalla superficie molecolare » (A. Szent-Gyorgy) in grado di permettere la stabilità strutturale, mediante risonanza, delle molecole ad alto contenuto energetico, e il trasferimento

di energia o di segnali tramite veloci perturbazioni elettroniche.

Come suggerisce H. Frolich, questa delocalizzazione potrebbe dare origine a vibrazioni elettroniche coerenti ad alto contenuto di energia che svolgerebbero il ruolo di stimolo e di segnale (oltre che di immagazzinamento di energia).

Un processo quantistico sarebbe così all'origine di un processo macroscopico,

mediante un meccanismo di tipo « catastrofico » (cioè con rottura totale dell'equilibrio preesistente e comparsa di un nuovo tipo di equilibrio). Si deve

tuttavia notare che: 1) lo stimolo si applica ad una struttura preesistente, la cui

origine non viene spiegata ma presupposta e 2) il corso futuro dell'evento «catastrofico» è determinato da questa struttura (e dal suo «ambiente») e non dall'evento microfisico scatenante.

Una descrizione quantomeccanica dei sistemi biologici potrà quindi es~ere ottenuta solo affrontando il problema della struttura dei sistemi intermedi,

che non può essere descritta con le ordinarie variabili termodinamiche e che

richiede quindi la determinazione di altre osservabili macrofisiche.

Su questa linea si sono mosse le ricerche di due fisici, Gustav Ludwig e

Ilya Prigogine, che hanno elaborato delle teorie generalizzate in grado di spiegare il passaggio dalla microfisica alla macrofisica.

Non possiamo in questa sede occuparci della macrodinamica quantistica

di Ludwig, in quanto si tratta di una teoria prettamente fisica. Dobbiamo invece

esaminare la teoria di Prigogine che si pone come una possibile soluzione della

tradizionale dicotomia fra evoluzione fisica ed evoluzione biologica, cercando

di fornire un substrato rigorosamente fisico alle leggi che regolano la comparsa

e lo sviluppo dell'ordine biologico.

16

www.scribd.com/Baruhk

La nuova biologia

b) Termodinamica e biologia. Nella termodinamica classica l'evoluzione fisica

di un sistema è descritta dal secondo principio della termodinamica che lega

il verificarsi di fenomeni irreversibili all'aumento della funzione di stato entropia, S. Secondo il principio d'ordine di Boltzmann, l'entropia è una misura

del disordine molecolare, della probabilità di esistenza di un certo stato. La

legge di aumento dell'entropia è quindi una legge di progressiva scomparsa di

ordine e di organizzazione. L'evoluzione organica e lo sviluppo ambientale

sembrano andare esattamente nella direzione opposta, verso una maggiore organizzazione, verso l'aumento dell'ordine, verso configurazioni «improbabili».

Superando questo paradosso la teoria di Prigogine si pone come una generalizzazione della termodinamica classica, in grado di spiegare sia la distruzione che

la formazione di strutture.

Innanzitutto, osserva Prigogine, il principio d'ordine di Boltzmann è valido per i sistemi all'equilibrio, ma non per quelli lontani dall'equilibrio termodinamico. Un sistema, se dotato di sufficienti riserve esterne di energia e

di materia, può restare in « un regime costante diverso da quello di equilibrio >>.

Mentre una struttura cristallina è un sistema Ìn equilibrio, incapace di evoluzione, i sistemi lontani dall'equilibrio termodinamico possono generare altri

tipi di strutture, « dissipati ve », « associate ad un principio d'ordine interamente

differente che si potrebbe chiamare ordine attraverso fluttuazioni».

Questo tipo d'ordine tra l'altro non è nuovo in biologia: la genetica delle

popolazioni, gli studi matematici di Vito Volterra, Alfred J. Lotka, John B.S.

Haldane sulle popolazioni e sulla selezione naturale si basavano proprio su sistemi «lontani dall'equilibrio» in cui si raggiunge una stabilità attraverso fluttuazioni (del patrimonio genetico).

In un sistema isolato la seconda legge della termodinamica dS jdt =o

esclude qualunque diminuzione di entropia e quindi qualunque formazione di

strutture ordinate. Ma i sistemi biologici sono sistemi aperti e per questi la

variazione dell'entropia può essere definita come dS = deS

dtS dove deS è

il flusso di entropia proveniente dall'esterno e dtS è la produzione di entropia

associata ai processi irreversibili che avvengono nel sistema. Ora, se nel sistema

vi deve essere una diminuzione di entropia, dato che dtS è sempre positivo o

nullo si deve avere deS < o, cioè il sistema deve ricevere un flusso di entropia

dall'esterno.

Un processo di auto-organizzazione può avvenire, quindi, solo in un sistema aperto, in interazione costante con l'ambiente, in condizioni di non equilibrio (altrimenti deS e dtS sarebbero nulli) e inoltre le subunità che costituiscono il sistema devono essere fortemente accoppiate termodinamicamente, in

quanto solo in questo modo uno dei sottosistemi può evolvere nella direzione

opposta àlla disorganizzazione.

Sulla base di queste caratteristiche Prigogine e P. Glansdorff hanno enun-

+

17

www.scribd.com/Baruhk

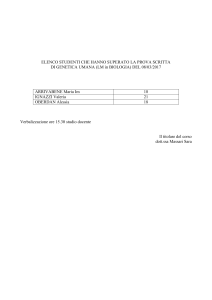

Esempio di struttura dissipativa in idrodinamica: l'instabilità di Bénard. Si scalda dal di sotto un

sottile strato liquido. A causa dell'applicazione di tale vincolo, il sistema si allontana dall'equilibrio

corrispondente al mantenimento di una temperatura uniforme nèllo strato. Per piccoli gradienti di

temperatura, il calore viene trasportato per conduzion.,, ma a partire da un gradiente critico, si osserva

anche un trasporto per convezione. La figura mostra le cellule di convezione fotografate verticalmente.

Si noti la sistemazione regolare delle cellule che hanno una forma esagonale.

dato un teorema termodinamico secondo il quale gli stati stazionari v1ctno all'equilibrio sono asintoticamente stabili, cioè dotati di meccanismi che riportano il sistema al suo stato normale mediante smorzamento dopo una perturbazione.

Tuttavia, al di là di una soglia critica lontana dall'equilibrio (in condizioni

non lineari), gli stati stazionari possono divenire instabili e il sistema può seguire diversi processi di tipo strutturale. In particolare vi può essere una rottura delle simmetrie esistenti con la comparsa di organizzazioni spaziali di ordine più elevato, una comparsa di un regime variabile nel tempo (ad esempio

oscillazioni chimiche) oppure un passaggio da uno stato stazionario ad un altro.

Al di là della instabilità, quindi, il sistema può raggiùngere una configurazione

ordinata. A queste strutture è stato dato il nome di « dissipative » per indicare

18

www.scribd.com/Baruhk

La nuova biologia

che la struttura viene mantenuta grazie ad una dissipazione di energia invece

che dalle forze molecolari (come nei cristalli). Tali strutture richiedono un livello minimo di dissipazione all'interno del sistema, livello che viene mantenuto costante grazie all'azione di opportuni vincoli di non equilibrio. Se tali

vincoli scompaiono il sistema perde la sua organizzazione, seguendo una evoluzione retta dal secondo principio della termodinamica.

L'organizzazione biologica può quindi essere spiegata in base a leggi termodinamiche precise (di una termodinamica generalizzata) e alla conoscenza

dei constraints (vincoli) esterni. L'esistenza di un ordine strutturale e funzionale

in biologia non può essere spiegata ammettendo l'esistenza di leggi fisiche irriducibili, ma associando le condizioni di formazione e di distruzione di strutture a diverse condizioni termodinamiche, rispettivamente lontano e vicino

all'equilibrio termodinamico. Come il principio d'ordine di Boltzmann permetteva di dedurre la struttura di un corpo inanimato, così le strutture dissipative, le successioni di instabilità « ci permettono di sperare che ciò che vi

è di essenziale nei fenomeni della vita sia deducibile da "primi principi" [...]

e non sembra affatto irragionevole pensare che il fenomeno vita sia altrettanto

prevedibile che lo stato cristallino e lo stato liquido» (Prigogine). È questa

una limpida enunciazione di un programma rigidamente monistico, di unificazione di tutta la natura all'interno di una teoria fisica.

Si tratta però di una « riduzione » fondata su di una solida base scientifica

e metodologica, sulla consapevolezza che gli assiomi di una teoria per poter

spiegare fenomeni qualitativamente differenti devono ampliarsi e trasformarsi in

profondità.

La teoria delle strutture dissipative ha trovato ampie conferme, anche

sperimentali, soprattutto nel campo del metabolismo, della « organizzazione

metabolica », per spiegare la quale sono stati elaborati modelli della organizzazione funzionale a livello molecolare. Ma restano ancora da chiarire i rapporti fra strutture dissipative e processi tipicamente biologici, come la differenziazione, la specificità biologica e soprattutto l'origine di quei vincoli che permettono di mantenere il sistema in condizioni termodinamiche adatte alla creazione è alla conservazione dell'ordine biologico, al tempo stesso funzionale

e strutturale.

2) Biochimica

Nello stesso periodo in cui avveniva la frattura fra fisica e biologia, si veniva definendo come scienza la biochimica, che acquistava, mediante autonomi

concetti e metodi specifici, un proprio oggetto: la descrizione dei complessi

cicli metabolici che avvengono all'interno delle cellule e del bilancio energetico

dello stesso metabolismo e di tutta la vita cellulare. In poco più di 30 anni,

dai primi studi sulla catena respiratoria iniziati verso il 1910 sino alla definì-

www.scribd.com/Baruhk

La nuova biologia

zione dei principali cicli metabolici, intorno agli anni quaranta, si compie una

delle più importanti innovazioni, spesso sottovalutata, preludio indispensabile

alla «rivoluzione molecolare ».

La situazione all'inizio del secolo non era delle più facili, la cellula era

considerata niente altro che un sacchetto di enzimi, senza alcuna organizzazione

interna, praticamente inaccessibile ad una analisi causale.l La stessa parola protoplasma (protos in greco significa primo) « era usata non solo per coprire la

nostra ignoranza degli eventi intracellulari, ma anche per suggerire che questi

non erano suscettibili di analisi ulteriore» (J.B.S. Haldane). Insistere sulla

necessità di una organizzazione anche a livello cellulare fu, tra l'altro, un merito

indiscutibile dell' organicismo.

a) La composizione e l'organizzazione. I metodi della biochimica sono sostanzialmente due, uno analitico ed uno analogico. Il primo, un metodo tipicamente

chimico, rompe, attraverso passi via via più drastici, le complicate strutture

cellulari per studiarne le proprietà ed i parametri chimici, classificando le molecole e le aggregazioni molecolari cosl ottenute.

Un primo risultato importante di questo metodo analitico è la dimostrazione della omogeneità chimica di tutta la biosfera. I risultati dell'analisi della

composizione chimica della biosfera mostrano come solo alcuni elementi chimici, situati nei primi periodi della tabella periodica di Mendeleev, si trovano

negli organismi. Su un totale di 92 elementi naturali, infatti, solo 16 sono presenti in tutta la biosfera ed altri 8 in tracce in alcune specie. Questa scelta è

molto ristretta, non è affatto casuale e non risponde alla frequenza relativa degli elementi chimici nell'ambiente in cui gli organismi vivono. Quindi, e questa è una prima conclusione. di notevole importanza, la vita seleziona solo, alcuni

elementi, evidentemente più « adatti » al complesso metabolismo dell' organismo. Tale selezione è probabilmente il risultato di una lunga evoluzione prebiotica, di scelte fatte all'inizio dell'evoluzione biologica. Questa selezione non

è stata però casuale in quanto, sulla base di calcoli stereochimici e quantomeccanici, è possibile mostrare che i quattro elementi fondamentali della vita,

C, H, N, O, che da soli costituiscono fino al 95,5% del peso di un organismo

vivente, formano un gruppo chimico per alcuni aspetti omogeneo. In particolare

si tratta dei quattro più leggeri elementi in grado di formare legami covalenti

stabili e sono i soli che formano legami doppi e tripli (legami 1t) sufficientemente

stabili. Se si accetta 'l'ipotesi della omogeneità fisica e chimica dell'universo,

non è azzardato affermare che qualunque forma di vita esista nell'universo

I « La vita, » scriveva C. Bernard, « contrariamente all'idea di Aristotele, è indipendente

da ogni forma specifica. Essa risiede in una sostanza definita dalla sua composizione, e non dalla

figura, il protoplasma » (Lefons sur /es phenomènes

de la vie, 1885). Ancora negli anni quaranta il

famoso modello di Delbriick e Szilard della regolazione enzimatica si basava su equilibri multipli fra le concentrazioni delle proteine e non sulla

loro struttura.

20

www.scribd.com/Baruhk

La nuova biologia

debba basarsi sui quattro elementi sopra visti, ed essere quindi, esclusival!lmft

dal punto di vista biochimico, in larga parte simile alla nostra.

Al livello superiore di organizzazione, l'analisi biochimica delle molecole

di interesse biologico ha portato a risultati grosso modo simili. Anche qui avviene una scelta, da parte dell'organismo, di un insieme molto ristretto di gruppi

chimici. Ogni specie sceglie all'interno di famiglie chimiche un particolare composto e sempre quello. Così ad esempio, fra l'enorme varietà di aminoacidi

possibili, nelle proteine se ne trovano solo venti ed essi, salvo piccole isolate

modificazioni, sono gli stessi in tutti gli organismi attualmente conosciuti.

Questa sorprendente capacità di selezione si rileva anche nella scelta particolarmente sottile che l'organismo è in grado di fare fra i diversi isomeri ottici (composti chimici identici ma aventi una struttura spaziale differente). Di fronte all'enorme diversità delle forme biologiche, il numero dei composti biochimici è

incredibilmente limitato e diffuso uniformemente. Si può trattare anche in questo caso di una « decisione » presa nei primi passi della evoluzione prebiotica, incorporata nel meccanismo di memoria dell'organismo e quindi perpetuata.

Si può affermare che ogni forma di vita attualmente esistente ha caratteristiche generali comuni, scelte in base ad una rigorosa selezione, e con ogni

probabilità derivate da una origine comune. Questa somiglianza non significa

identità, anzi, anche al livello biochimico, esiste una variabilità molto elevata

nella composizione chimica delle cellule, nella loro configurazione strutturale,

nella attività metabolica. La varianza totale è così elevata che non a torto si può

parlare di «individualità biochimica» (Roger Williams). È caratteristico della

vita che, nonostante questa indeterminazione nelle strutture molecolari e nei

processi metabolici, le cellule di un dato tipo siano molto simili tra loro e soprattutto siano in grado di mantenere la loro individualità invariata per un lungo

periodo di tempo (lungo naturalmente in confronto ai tempi del ricambio chimico).

Il secondo metod~ della biochimica è quello analogico, basato sulla costruzione di modelli dei cicli metabolici da ve:rificare poi in vivo o in vitro.

La critica che veniva rivolta al metodo analitico, cioè di distruggere l' organizzazione del vivente nel momento stesso in cui cominciava a studiarla -- il famoso principio tanatologico avanzato anche da Bohr per sostenere l'irriducibilità della vita alla fisica - , non era fuori luogo. Rompendo la « scatola >> si

può certo vedere « cosa c'è dentro » ma non si può dire niente sul « come é

fatta dentro», qual è la sua struttura e come questa struttura si modifica nel

tempo. La biochimica dovette quindi elaborare delle tecniche particolari con

cui studiare l'organizzazione cellulare e la sua funzione. (Si devono ricordare

la spettroscopia di assorbimento e il metodo isotopico.)

Sebbene tutti i metodi biochimici siano stati importanti, decisivi sono stati

21

www.scribd.com/Baruhk

La nuova biologia

soprattutto la utilizzazione degli enzimi purificati e un metodo dovuto alla

genetica, cioè l'uso di particolari ceppi mutanti di organismi che perdono la

capacità di sintetizzare un dato enzima (auxotrofi). La reazione metabolica si

blocca quindi ad un certo stadio e il prodotto relativo si accumula nell' organismo. In questo modo è stato possibile chiarire nelle grandi linee i principali

cicli metabolici della cellula, soprattutto quelli della catena respiratoria.

Anche qui osserviamo che tutti i processi chimici sono standardizzati e

diffusi in tutta la biosfera. In particolare tutte le principali classi di alimenti

sono catabolizzate formando i radicali acetilici dell'acetil-coenzima A, la cui

completa ossidazione, mediante il ciclo del citrato (ciclo di Krebs), produce anidride carbonica (convergenza catabolica). L'uniformità della biosfera si manifesta

quindi sia al livello della composizione che della cinetica chimica. ·

L'uso degli isotopi, associato con la diretta osservazione delle strutture

subcellulari mediante la microscopia elettronica, ha portato a chiarire definitivamente che la cellula non è un « sacchetto di enzimi » in quanto vi è una distribuzione differenziata e costante nel tempo dei diversi composti nelle strutture cellulari, una precisa disposizione che Marcel Florkin chiama topochimica

cellulare. Il citoplasma è ·la sede delle degradazioni anaerobiche, sui ribosomi

avvengono le sintesi proteiche, la catena respiratoria è localizzata nei mitocondri,

nel nucleo è condensata larghissima parte del materiale ereditario, i lisosomi

tengono ben chiusi e isolati pacchetti di enzimi che potrebbero scindere in

breve tutti gli altri costituenti cellulari. La cellula quindi non è omogenea ma

è spazialmente strutturata; non basta la specificità enzimatica a rendere conto

dell'attività cellulare e ciò dovrebbe portare a notevoli cautele nella conclusione

da più parti avanzata che sia possibile sintetizzare la cellula mescolando insieme i diversi componenti. Ancora una volta è l'organizzazione spazio-temporale

dei sistemi viventi che sembra svolgere un ruolo decisivo. Proprio per la

presenza di questa complessa organizzazione strutturale si è di nuovo e con

forza sviluppata la teoria cellulare, cioè la affermazione che l'unità biologica

minima funzionale è distinta e limitata da una membrana. In natura «tutti i

sistemi biologici funzionanti sono cellulari» (H.J. Morowitz).

Ma questa organizzazione strutturale è tutt'altro che statica. Le ricerche

con gli isotopi hanno confermato una tesi avanzata già dai primi biochimici

e cioè che i costituenti chimici della cellula sono sostituiti con una velocità

di molto superiore a quella con cui vengono distrutte le strutture stesse. Sono

le «forme», gli «schemi» (patterns) a rimanere stabili e non la loro base materiale. L'intera cellula si presenta come un sistema aperto in uno stato stazionario (steat(y state), nel quale vi è continuo scambio di materia e di energia fra

l'ambiente e il sistema.

Le relazioni chimiche sono intercollegate in patterns, in « reti metaboliche »

piuttosto complesse, con molte vie alternative per giungere ad un identico

2.2.

www.scribd.com/Baruhk

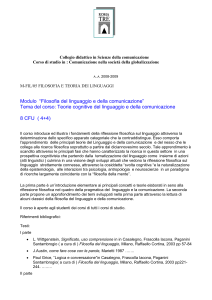

carboidrati

vari amminoacidi

1

anidride carbonica

Convergenza catabolica. Le principali vie secondo le quali avviene il catabolismo convergono a imbuto

sui radicali acetilici delle molecole dì acetilcoenzìma A, che sono quindi ossidati ad anidride carbonica

' '

mediante il ciclo del citrato.

risultato finale, dotate di una precisa sequenza non solo temporale ma probabilmente, come abbiamo visto, anche spaziale. In particolare, la cellula tende

a fissare alcuni cicli insostituibili (quello di Krebs, ad esempio) « prevedendo »

dive!sL. ingressi, meccanismi alternativi per giungervi partendo anche da .diversi prodotti. La ridondanza delle vie metaboliche è quindi un meccanismo

omeostatico per garantire i meccanismi fondamentali' della vita in ogni condizione ambientale.

·

In CC?nclusione sembra che le vecchie idee sulla necessità di un principio

regolatore della vita riprendano forza da questi dati. È l'attività del vivente che

assume comuni elementi chimici e li organizza in un modo funzionale ai propri

,bisogni fisiologici ed ecologici (J ohn Z . Y oung). Si affaccia cqsì l'idea di un

www.scribd.com/Baruhk

La nuova biologia

« programma », di un « piano di organizzazione » che viene trasmesso in ogni

replicazione cellulare.

b) Evoluzione chimica. Presumendo, come sembra prgbabile, una comune

origine degli organismi attuali, l'analisi delle differenze biochimiche può permettere di trovare delle relazioni filogenetiche fra i div~rsi gruppi di organismi.

Così il numero di aminoacidi differenti presenti in due molecole omologhe

presenti in specie diverse (ad es. emoglobina umana e di cavallo) ci dà, approssimativamente, il numero di mutazioni e ci permette quindi di valutare qualitativamente i rapporti evoluzionistici fra le due specie. Un numero scarso di

aminoacidi differenti e quindi un piccolo numero di mutazioni geniche stanno

a dimostrare che le due specie si sono separate in epoca relativamente recente.

Analizzando la struttura primaria di una particolare proteina in varie specie è

possibile costruire un albero filogenetico per mettere in evidenza i rapporti

evoluzionistici fra le diverse specie. Le proteine fungono cioè da « fossili viventi »

per determinare l'« evoluzione chimica».

La proteina maggiormente studiata da questo punto di vista è il citocromo c,

che si trova praticamente in tutte le cellule eucariotiche (dotate cioè di un nucleo

ben delimitato da una membrana), una proteina facilmente isolabile, di piccole

dimensioni, ma dalla storia molto antica. La comparsa del citrocromo (o meglio dei citocromi perché si tratta di un gruppo di enzimi accettori di elettroni)

avvenne infatti all'inizio della storia della vita, fu un passo evolutivo di estrema

importanza perché incrementò di molto le fonti di energia disponibili, permettendo di liberare l'energia ottenuta ossidando lo zucchero non tutta insieme

ma poco alla volta.

Se si prendono i due citocromi c più diversi, quello dell'uomo e quella della

muffa del pane (Neurospora crassa) che differiscono per il 40% dei siti relativi

degli aminoacidi, si vede che alcuni tratti della sequenza primaria sono assolutamente identici e dove si sono avute delle sostituzioni, la selezione naturale le ha permesse solo con aminoacidi molto simili tra loro.

Evidentemente la pressione selettiva sui meccanismi metabolici elementari non è così forte come per gli aspetti morfologici o comportamentali. È

questo un aspetto che ritroveremo parlando dell'evoluzione biologica: la velocità

evolutiva aumenta man mano che cresce il livello di organizzazione. L'evoluzione del citocromo sembra avvenire solo grazie a modificazioni casuali del

gene, indipendentemente dalla pressione selettiva che si esercita nell'intero organismo. È quindi uno strumento utilissimo per chiarire i rapporti fra mutazione, caratteri genotipici ed evoluzione della specie.

c) Endocrinologia. Fino alla fine del secolo xrx si credeva che l'apparato

di regolazione che permetteva all'organismo di mantenere nel tempo le pro-

www.scribd.com/Baruhk

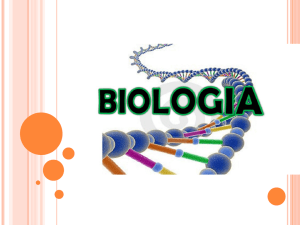

Albero filogenetico, che mostra la derivazione .degli organismi attuali, costruito sulla. base di analisi

al calcolatore delle proteine omologhe del citocromo c, una sostanza complessa che si trova in versioni

similari in specie differeflti. La sequenza di aminoacidi che costituiscono le proteine omologhe è lievemente diversa in ognuno degli organismi indicati al punto terminale dei rami. L'analisi delle differenze mostra le relazioni ancestrali che determinano la topologia dell'albero. I programmi del calcolatore

· tabiliscono le sequenze degli aminoacidi presenti nei nodi dell'albero (numeri nei circo/etti) e calcolano

•ih:lumero di mutazioni che devono essersi verificate durante l'evoluzione (numero sui rami).

-prie funzioni altamente coerenti fosse solo il sistema nervoso, anche se vi erano

già solide evidenze sperimentali riguardo all'azione sulle funzioni del corpo e

sul metabolismo di specifiche sostanze chimiche secrete dalle ghiandole endocrine, che Ernest Starling aveva chiamato nel 1905 «ormoni» o «messaggeri

chimici». La biochimica fra il 1920 e il 1950 isolò in forma cristallina molte

di .queste sostanze, ne descrisse la struttura e i parametri chimici funzionali,

ne chiarì le derivazioni metaboliche e ne sintetizzò molte in laboratorio.

25

www.scribd.com/Baruhk

La nuova biologia

Il carattere omeostatico dell'organismo viene mantenuto da «due sistemi

di comunicazione: il lento sistema postale dei messaggi chimici e il rapido sistema

telegrafico dei nervi» (J.D. Bernal).

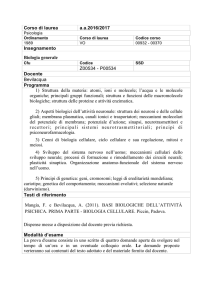

Il sistema endocrino esercita questo controllo con un tipico processo a

feed-back (controreazione) che ha come «calcolatore centrale» l'ipofisi. Questa

ghiandola secerne infatti specifici ormoni che agiscono su altre ghiandole endocrine, regolandone l'attività seèretiva. Gli ormoni prodotti da queste ultime

a loro volta, oltre a svolgere la loro funzione regolatrice su funzioni fisiologiche

e comportamentali (sviluppo e comportamento sessuale, equilibrio idrosalino, l'intero metabolismo ecc.), inibiscono la secrezione ormonale dell'ipofisi.

Si instaura così un delicato equilibrio omeostatico che regola la concentrazione

dei diversi ormoni nel sistema endocrino.

Inoltre, la stessa ipofisi è in interazione bidirezionale con l'ipotalamo grazie

allo scambio di informazioni e nervose e ormonali. L'ipotalamo, una struttura

del sistema nervoso la quale, come è stato dimostrato recentemente, produce

anch'essa degli ormoni, è in grado di disinibire la produzione delle gonadotropine da parte dell'ipofisi. I due meccanismi regolatori del metabolismo dell'organismo, quello nervoso e quello ormonale, vengono quindi ad incontrarsi,

costituendo un'unica rete intricata e coordinata. Esiste quindi un luogo dell'encefalo (incredibilmente vicino alla sede indicata da Cartesio per la ghiandola

pineale che avrebbe dovuto essere il posto di incontro fra l'anima e il corpo)

nel quale avviene l'interazione fra sistema nervoso e sistema endocrino.

d) Genetica chimica. Il successo raggiunto dalla biochimica nel chiarire i

processi metabolici fondamentali dell'organismo, poneva in termini ancora più

drastici un problema da tempo irrisolto, e cioè il modo in cui i geni controllano

il complesso schema di reazioni che è alla base delle principali funzioni biologiche: l'alimentazione, la crescita, la riproduzione.

Il grande risultato della genetica (con Thomas H. Morgan) era stato la dimostrazione che il controllo di larga parte dello sviluppo e del comportamento

attuale dell'organismo era localizzato in determinate porzioni del cromosoma.

Ma come questo controllo si esercitava era ancora molto oscuro. Dato che il

metodo di descrizione più adeguato era allora lo studio della cinetica chimica,

si elaborò un modello dell'azione del gene come una serie di passi di sintesi

chimica, ognuno dei quali catalizzato da un enzima specifico. Si trattava di collegare il gene, studiato dalla genetica, con il carattere fenotipico, sempre più

descrivibile in termini biochimici.

George W. Beadle e il biochimico Edward L. Tatum iniziarono a lavorare

sulla muffa del pane, Neurospora crassa, allo scopo di « determinare se e come i geni

controllano le reazioni biochimiche conosciute». Usando dei mutageni, Beadle

e Tatum provocarono la formazione di mutanti incapaci di sopravvivere in

z6

www.scribd.com/Baruhk

ipofisi

azione morfogenetic~ e differenziamento

regolazione metabolic~ metamorfosi

(aumento del metabolismo basale,

lotta contro il freddo)

l

i

anti-immunitaria

metabolismo organico

particolari terreni di coltura. Tali mutanti crescevano solo se veniva aggiunta

nel loro terreno ':lna particç>lare sostanza chimica. Dato' the la biochimica aveva

dimostrato che H 'metabolismo era sotto il controllo enzimatico, ne conclusero

che <<è Ìl).teramente valido supporre che i geni, che sono essi sfessi una , parte

ael sistema, controllano . ~ règolano le reazioni specifiche o agendo .direttamente

come enzimi (a quel tempp si pensava ancora ·che i geni· fossero di nàtura proteica) oppure detèrminando la specificità degli enzimi». Si formula così la famosa

equazione: un gene

= un .enzima.

.

c

e) Embriologia chimica. L'embriologia aveva avuto un grande sviluppo prima in forma descrittiva e comparata e poi come embriologia sperimentale (o

« cagsale »)alla fine dell'Ottocento e all'inizio del Novecento, acquisendo con-

www.scribd.com/Baruhk

La nuova biologia

cetti t~9rici importanti quali determinazione, regolazione, gradiente e campo

morfogenetico.

Nonostante il tentativo di collegare embriologia e genetica compiuto da

T. H. Morgan, questi due campi restavano separati e non comunicanti, anche

perché gli organismi studiati dal punto di vista genetico erano poco noti dal

punto di vista embriologico e viceversa. Non si poteva supporre nessun meccanismo per spiegare il passaggio dal gene al carattere durante la morfogenesi e i

concetti di regolazione e di determinazione restavano essenzialmente descrittivi.

Sulla base dei successi ottenuti nella caratterizzazione biochimica dei processi fisiologici, gli embriologi, a cominciare da Joseph Needham (Chemical

embriology, 1931 ), cominciarono a studiare chimicamente le varie fasi della morfogenesi. Rapidamente dalla fase puramente compilativa. delle sostanze presenti, l' embriologia chimica cominciò ad individuare processi, strutture sp~zio-temporali.

Si ricercarono in particolare, dopo la prova fornita nel 1932 da H. Bautzmann

che un « organizzatore » ucciso è ancora in grado di indurre la formazione di

un sistema neurale, le possibili sostanze «inducenti». Ma per tali ricerche tuttavia, come afferma Jean Brachet, uno dei protagonisti di questo periodo, << improvvisamente arrivò l'insuccesso e l'eccitazione cessò [... ]dato che l'ectoblasto

poteva reagire allo stesso modo (induzione neurale) a un "grande numet~. di

sostanze chimiche».

3) I modelli in biologia

Il ruolo dei modelli in biologia è stato sempre molto esteso. Anche la difficoltà di descrivere i fenomeni biologici in termini statici, di unificare la vasta

eterogeneità delle forme e delle funzioni, i pericoli del metodo analitico che,

come abbiamo visto nel caso della biochimica, sollevava non poche difficoltà

di ordine teorico e metodologico, hanno favorito in tutta la storia <ielle scienze

biologiche la costruzione di modelli, il cui scopo è stato quello di. ricostruire

analogicamente alcune proprietà o tutto l'insiem(:! dell'organismo, mediante strutture e relazioni note. Si indicano in genere con lo stesso termine « modello »

due procedimenti assai diversi fra loro. Il primo consiste nel ricercare delle corrispondenze analogiche fra un oggetto naturale e un .oggetto artificiale, del tipo

ad esempio degli automi settecenteschi di Vaucauson o dei moderni apparati

bionici che imitano alcune funzioni dell'organismo. Cioè <~ si raffrontano delle

forme analoghe e si inducono degli usi simili» (C. Bernard). Non si simulano

solo determinate funzioni, ma si cerca di ricostruire le relazioni esistenti tra

le strutture che sono legate alle funzioni. Anche se il modello e il sistema reale

sono costruiti con materiali totalmente differenti, il modello ha il compito di

,

stabilire una corrispondenza fra i due diversi insiemi di relazioni.

Il secondo tipo di modello si basa sulla costruzione di un insiemè di definizioni, stabilite in un particolare linguaggio. formale, in generale di tipo maz8

www.scribd.com/Baruhk

La nuova biologia

tematico, che descrive i r4pporti esistenti fra gli elementi costitutivi di un dato

oggetto empirico e la loro descrizione in ter-mini formali: Fra il modéllo formale, astratfo (costituito ad esempio da uri insieme di equazioni differenziali,

0 da una figura geometrica o topologica o da un insieme di relazioni sintattiche o semantiche in un qualsiasi linguaggio formale) e la realtà empirica si

viene quindi a stabilire una corrispondenza biunivoca, di modo che certe strutture

presenti nel modello e le loro modificazioni neftempo corrispondono alle strutture e alle modificazioni reali.

Il valore euristico di un modello consiste nella possibilità che offre di selezionare fra le funzioni e le strutture del reale alcune relazioni particolari che

si considerano caratterizzanti un dato fenomeno. Esso è quindi una versione

semplificata della complessità del reale che permette di isolare alcune relazioni

funZionali e strutturali. La validità di un modello si giudica sulla base della

sua att!tudine a far emergere relazioni e proprietà prima non conosciute.

L'u:l:ilità dei modelli cresce naturalmente con l'aumentare della complessità

del sistema in esame. Se un modello (ad esempio una equazione n".illtematica)

era utile per descrivere certi sistemi semplici, diventa necessario per i sistemi complessi ed in particolare per i sistemi biologici, per semplificarne i caratteri, isolando quelli ritenuti più importanti, in modo da non rischiare di restare aggrovigliati in una congerie di dati e di misure.

'

Nonostante il largo uso che in biologia si è fatto dei model.l(;" esistono

tuttora grossi equivoci di fondo sulla loro reale funzione. In fisica, un modello,

come l'analogia fra una corrente elettrica e un fluido o l'uso dei modelli meccanici macroscopici dell'atomo, svolge la funzione di mediatore fra una teoria

e le osservazioni sperimentali; il formalismo matematico di una teoria serve

da modello per un'altra teoria applicabile in un diverso campo fenomenico,

meno noto o meno soggetto ad una ana:lisi sperimentale. Ma ciò che garantisce

la possibilità di trasferire i risultati ottenuti con ir modello nella spiegazione

del fenomeno meno noto è la corrispondenza che è 'posSibile stabilire fra le leggi

generali, espresse in forma matematica, dei due campi féhomenici. Di qui, anche, l'importanza della matematica come strumento conoscitivo. Ma questo

non avviene in biologia. I modelli biologici, infatti, siano essi meccanici o logici, non si basano sulla possibilità di stabilire una relazione di corrispondenza

fra le leggi generali. Questi modelli stabiliscono delle corrispondenze esclusivamente analogiche fra. le strutture o fra le funzioni, cioè fra realtà concrete e non

sì pongono come un procedimento di astrazione teorica della realtà empirica.

La scarsa consistenza teori~a della più parte delle scienze biologiche fa

sì che rion si possa parlare di biologia matematica nello stesso senso in cui si

parla di fisica matematica. In biologia quindi è presente non solo il rischio di

considerare un modello come una rappresentazione intuitiva del reale, come

accac;leva nel caso dei modelli atomici meccanici, ma anche quello di « conferire

www.scribd.com/Baruhk

La nuova biologia

al modello un valore di rappresentazione» (G. Canguillhem) dimenticando che un

modello non è niente altro che la sua funzione. Si tende a credere che i meccanismi presenti nel modello siano non già una rappresentazione astratta di

quelli reali, ma ne siano una replica, sia concreta che logica.

Il modello diventa l'oggetto stesso, l'organismo è una macchina.

Un'altra riflessione di carattere generale sull'uso e l'abuso dei modelli si

sviluppa quando, « tenendo conto della dinamica storica di quelle mediazioni

fra le teorie (e le progettazioni di esperienze), si vede che la caratteristica più

prégevole di un modello consiste appunto nella possibilità di farne un uso provvisorio e cioè come costrutto flessibile. E si comprende altresì come un modello

possa facilmente trasformarsi in ostacolo per ulteriori sviluppi delle conoscenze,

qualora non se ne faccia quell'uso critico che trae appunto vigore dalla sua

flessibilità» (E. Bellone). Ciò è stato particolarmente evidente ad esempio nel

Settecento, quando il modello dell'animale-macchina cartesiano si tradusse in

un freno alla ricerca biologica, freno che venne superato solo dalla stuoia vitalistica francese la quale, rivendicando una autonomia o meglio una specificità

al vivente, permise di impostare un programma di ricerca sp-erimentale di estrema

importanza per la costituzione della biologia come. scienza·.

a) Modelli cibernetici. Da quando Norbert Wiener scrisse il suo famoso libro

Cybernetics, pubblicato nel 1948, questo termine ha avuto un'ampia fortuna

'ed è stato utilizzato ad indicare una varietà di discipline scientifiche e di tecniche fra loro molto diverse. Ci occuperemo in questo paragrafo s-olo di due aspetti

di questa multiforme varietà e cioè: 1) la cibernetica come strumento, matematico più che fisico, per la costruzione di modelli formali e di simulatori analogici; 2) l'uso di concetti e metodi della teoria matematica dell'informazione

nella spiegazione dei fenomeni biologici, in particolare dell'ereditarietà.

Un modello, si diceva, è una selezione di alcuni aspetti del reale che si considerano particolarmente importanti per la spiegazione della struttura e del

comportamento di un sistema complesso. In cibernetica, il concetto che si pone

alla base di questa costruzione di modelli è quello disistema organizzato, di organizzazione, intesa come l'insieme'' delle relazioni funzionali esistenti fra le diverse parti del sistema e che il sistema tende a mantenere stabili, anthe in pre·

·

senza di disturbi provenienti dall'esterno.

L'organizzazione è intesa in senso astratto, senza alcun riferimento al substrato

materiale di cui è costituita - e per questo si possono studiare in modo simile

sia le macchine che gli animali-, è una « forma ». Fra· diversi sistemi, anche

eterogenei, può esistere un isomorfismo e essi possono quindi essere descritti

con un identico modello cibernetico, in quanto « due modelli sono idèntici se il

rapporto dei loro ordinamenti pùò essere espresso come corrispo!]-deriza biunivoca» (Wiener).

--

www.scribd.com/Baruhk

La nuova biologia

I sistemi complessi sono considerati « scatole nere » (black boxes) di cui si

conosce solo l'ingresso e l'uscita, attraverso la cui modificazione è possibile

studiare il comportamento del sistema. Se sistemi .tra ·loro diversi mostrano

comportamenti simili se ne deduce una analogia di struttura interna. Compito

della cibernetica è quindi costruire dei modelli atti a «descrivere tutti i sistemi

dotati di un certo comportamento» (W. Ross Ashby).

La difficoltà da sempre incontrata dai biologi di collegare determinate organizzazioni a strutture presenti all'interno di esse, viene superata dalla cibernetica con un salto netto, abbandonando qualsiasì tentativo del genere, considerato inutile per una comprensione dell'organizzazione. La cibernetica si indirizza solo allo studio « della " complessità " come argomento a sé stante »

(Ross Ashby); l'organizzazione è un dato primario, irriducibile.

Si tratta quindi di una disciplina di tipo essenzialmente funzionalistico e

comportamentistico; suo oggetto sarà il comportamento di un sistema, indipendentemente dal sp.bstrato materiale o dalle leggi fisiche che lo reggono.

Il turbamento di uno stato iniziale stabile può portare il sistema lontano

dalle condizioni che possono permettere un ritorno all'equilibrio preesistente,

per cui avviene una « catastrofe » e si instaura un nuovo ordine, in genere ad

un livello di complessità, intesa come numero e qualità delle relazioni interne

al sistema, superiore.

.

.

In particolare se il sistema, come ad esempio i sistemi biologici, è dotato

di una proprietà autocatalitica - cioè tale che se ha luogo in qualche punto

del sistema aumenta la probabilità che si verifichi in un'altra parte-, tal~ sistema risulta instabile in assenza di tale proprietà e basta una singola deviazi~ne

dall'equilibrio per dare inizio ad una traiettoria che si allontana sempre più

dallo stato preesistente.

Nonostante la consapevolezza dimostrata dai più rigorosi studiosi di cibernetica del carattere formale, astratto dei mod,elli, anche di quelli fisici che

possono essere costruiti per verificare alcuni comportamenti, molto spesso si

presenta in cibernetica il pericolo di considerare i modelli non come costrutti

teorici, come strumenti euristici, ma come una ricostruzione effettiva della

realtà. Le macchine tecnologicamente avanzatissime costruite per trattare le

informazioni ·e funzionanti grosso modo come macchine cibernetiche hanno

in effetti mostrato di possedere tali funzioni così simili a quelle di un organismo

vivente da far parlare della possibilità di sostituire l'uomo stesso con un suo modello cibernetico (più in particolare il suo cervello con un« cervello elettronico»).

Se ciò ha avuto l'indubbio merito di rigettare fra le posizioni ideali~tiche tutti

i tentativi di stabilire una differenza fra l'uomo e le macchine sulla base di « funzioni irrepetibili » o cose del genere, tuttavia ha portato a grossi rischi di impoverimento dell'analisi sull'uomo, sulla sua natura biologica e culturale, ripristinando in·· forma modernissima i vecchi modelli meccanicistici.

www.scribd.com/Baruhk

La nuova biologia

Fin dalla sua nascita.: la biologia teorica ha oscillato fra due poli opposti.

Da una parte si è sforzata di descrivere riduzionisticamente un sistema sulla

base delle sue parti, avendo come modello la meccanica statistica, la teoria

cinetica dei gas. In questo caso, si potevano ricostruire le proprietà di un sistema

a partire dalla semplice interazione fra i costituenti elementari. Il secondo modello è stato appunto quello della macchina, in cui ogni parte del sistema svolgeva

un compito determinato con diversi livelli di organizzazione (i vari organi).

Come nota René Thom il primo modello è più adatto al calcolo, ma dimentica

l'organizzazione; vi è una enorme ridondanza morfologica e le proprietà del

sistema non mutano se si diminuisce o si aumenta di poco il numero di componenti. Al contrario nel modello meccanico, come ad esempio un orologio o un calcolatore, vi può essere una ripetizione di pezzi, ma non una ridondanza in quanto

anche la rottura di una ruota dentata o di un nucleo di ferrite può arrestare il

meccanismo. Entrambi i modelli rispecchiano alcuni aspetti della realtà biologica e possono quindi essere utili in quanto- tali ma non possono essere assolutizzati. Tra l;altro l'analogia fra organismo e macchina vale per gli animali, almeno al livello degli organi, dato che non vi è ridondanza morfologica,

ma non vale per i vegetali nei quali la ridondanza è regola (semi, frutti, rami

ecc.). « Cosl l'idea di vegetali-macchine è certo un po' bizzarra» (R. Thom).

Passiamo ora ad esaminare l'influenza della cibernetica in biologia, legata

alla utilizzazione generalizzata di alcuni nuovi concetti, in primo luogo, i concetti di inforlflazione e di messaggio che· hanno avuto un successo senza pari, anche in campi dove la loro applicazione non è sufficientemente fondata sul piano

scientifico, ma riveste più spess~ un ruolo sostanzialmente analogico.

La teoria matematica dell'informazione di C. Shannon e W. Weaver è in real- .

tà una teoria della comunicazione, in quanto studia il modo di trasmettere un messaggio entro un canale fisico minimizzando il rumore prodotto dal canale stesso.

Ogni simbolo dell'alfabeto con cui è scritto il messaggio ha la stessa proba' bilità di verificarsi, ogni messaggio ha un proprio « contenuto di informazione » specific;ato da un numero positivo. Quindi i due messaggi « aperto »

o «chiuso», avendo lo stesso numero di lettere, hanno per la teoria della comunicazione lo stesso contenuto di _informazione in quanto il concetto di informazione di Shannon-Weaver è quantitativo e completamente indipendente

dal signtficato del messaggio, dalla sua semantica. Questo tipo di concetto è

stato più Volte applicato in biologia, ad esempio per calcolare il « contenuto

di informazione » di una data catena di DNA. Tuttavia ciò che interessa nella

sequenza di nucleotidi del DNA è l'ordine in cui sono disposti i diversi simboli

. e il significato che si legge in una tripletta di nucleotidi. Per la teoria della comunicazione, che studia statisticamente il processo di propagazione di un messaggio, inteso come una serie di simboli equiprobabili all'intenio di un alfabeto dato, invertire un codone è indifferente. Ma questo è decisivo per l'orga-

www.scribd.com/Baruhk

La nuova biologia

nismo, in quanto può essere sintetizzata una proteina anziché un'altra necessaria.

La stessa evoluzione, se interpretata come evoluzione' del codice genetico, sarebbe

scarsamente significativa dal punto di vista della teoria della. comunicazione

in quanto non fa che scambiare di posto singole lettere all'interno del messaggio: il contenuto di informazione non cambia, ma il significato di tale informazione può cambiare moltissimo. Dunque nell'accezione biologica dell'informazione « il concetto di probabilità è scomparso e l'idea di qualità, di valore specifico fa parte del concetto biologico di informazione genetica» (André Lw:off).

Vediamo ora brevemente un altro concetto che ritroveremo spesso in q_uesta nostra trattazione, quello di programma, mutuato dalla scienza degli elaboratori elettronici ad indiCare il meccanismo interno di un sistema che ne regola il funzionamento, anche se la cibernetica utilizza raramente tale concet~o, in

quanto il suo campo di studio è l'insieme dei fenomeni di regolazione e di controllo, indipendentemente dalla struttura del meccanismo regolatore e della

sua origine; la fonte del controllo può essere sia interna sia esterna al. sistema

e la cibernetica ne prescinde assumendola come un dato di fatto.

Ogni macchina il cui comportamento implica delle discontinuità qualitative,

cioè diversi stati successivi nel tempo, oppure la messa in funzione di diverse

parti del sistema in successione regolare senza intervento dall'esterno, deve avere

un sistema regolatore, che « codifica » tali discontinuità, possiede una « rappresentazione >> della successione degli stati di questa, come un insieme di fori su

una banda di carta o un particolare ordinamento degli stati eccitati dei nuclei

di ferrite nella « memoria » di un elaboratore elettroPico o, latu sensu, la sequenza

di nucleotidi del DNA, che contiene in effetti una rappresentazione del futuro

svilup·po dell'individuo.

11 possesso di un « organo programma » è evidentemente tipico solo di

sistemi dt elevata complessità. Deve infatti esser possibile che una parte del

sistema si separi dal resto del sistema e si specializzi nella attività regolativa.

L'ambizioso tentativo della biologia molecolare è stato quello di attribuire una

base ftsica al concetto di programma, identificandolo con la sequenza nucleotidica del DNA.

Il più elementare meccanismo di interazione fra .il comportamento di un

sistèma e il suo K organo programma » è quello di feed-"back o controreazione,

mediante il quale il comportamento di un sistema viene confrontato con il risultato da conseguire, e se vi è uno scostamento dall'obiettivo da raggiungere

determinati meccanismi sono. in grado di modificare alcuni parametri in modo

da ridurre tale scostamento al minimo. Per i biologi, da sempre alla ricerca

di una teoria giustificativa del comportamento teleonomico degli organismi

viventi, non c'era niente di meglio di una teoria fisica che permettesse di determinare il compbrtamento attuale di un sistema ·sulla base dello « scopo » da

nggiungere. Il comportamento degli animali diviene una serie continua di

33

www.scribd.com/Baruhk

La nuova biologia

feed-back, « la selezione naturale è un processo ~ibernetico, un enorme feedback in grado di rispondere alle sollecitazioni ambientali trasmettendo l'informazione ai geni» (Dobzhansky), i «cicli di reazione organici sono processi di

regolazione e feed-back» (Krebs). Ma, come precisano anche gli stessi cibernetici, ad esempio Ross Ashby, il concetto di feed-back è poco utile al di fuori del

proprio particolare campo di applicabilità. Il criterio di stabilità mediante feedback è applicabile e trattabile scientificamente solo per sistemi semplici e dotati di una particolare struttura (ed è per questo che il concetto di jèed-back ha

poco spazio nella teoria formale della comunicazione). Nell'organismo esistono

certamente strutture e funzioni che possono essere interpretate mediante modelli a controreazione: i riflessi condizionati, determinate relazioni fra cervello

e muscoli, i meccanismi che regolano la temperatura del sangue o la concentrazione di zuccheri e di sali, determinati accoppiamenti di reazioni enzimatiche.

Ma questi sono innanzi tutto solo una piccola parte dell'insieme dei processi biologici, nei quali l'ordine viene realizzato mediante interazioni di tipo dinamico,

in genere grazie alla presenza di stati stazionari, che non possono essere descritti

mediante controreazioni.

Anche per il concetto di feed-back va quindi ripetuto quànto detto a proposito dei modelli; non si tratta di identificare un modello con una certa realtà

ma di descrivere a livello formale i comportamenti dei sistemi ancora non noti

per ottenere maggiori conoscenze l e questo significa la sconfitta del vecchio

sogno meccanicista di considerare gli organismi delle « macchine viventi ». La

cibernetica, infatti, fa uso di concetti (relazione, coordinazione, selezione, apprendimento, omeostasi, sopravvivenza) estranei alla scienza meccanicistica. «Il

vitalismo ha vinto a tal punto che anche i meccanismi corrispondono alla struttura temporale degli organismi» (Wiener). Ma, se si accetta l'impostazione

idealistica della cibernetica confondendo l'analogia formale con l'identità sostanziale, si giunge facilmente, come fa appunto Wiener, ad accomunare alla

sconfitta del meccanicismo metafisica quella del materialismo « diventato poco

più che un cattivo sinonimo di " meccanicismo" ».

b) Modelli matematici. In questi ultimi anni l'applicazione dei metodi matematici alla biologia, che per secoli era limitata all'aritmetica e ad un poco di

I Questo vale in particolare per i meccanismi di regolazione, il cui scopo è di mantenere

determinate variabili essenziali all'interno di un

insieme di valori. E questo può essere fatto a