Sistemi di Elaborazione dell’Informazione

21

Sistemi di Elaborazione dell’Informazione

22

Principali Paradigmi di Apprendimento: Richiamo

Dati

Consideriamo il paradigma di Apprendimento Supervisonato

Dati a nostra disposizione (off-line)

Apprendimento Supervisionato:

Dati

, apprendere

dato in insieme di esempi pre-classificati,

una descrizione generale che incapsula l’informazione contenuta negli esempi

):

Suddivisione tipica (

(regole valide su tutto il dominio di ingresso)

usato alla fine dell’apprendimento per stimare la bontà della soluzione.

dell’insieme di apprendimento)

per le istanze

Test Set

si assume che un esperto (o maestro) ci fornisca la supervisone

(cioè i valori della

usato direttamente dall’algoritmo di apprendimento;

)

predire l’output associato

(dato un nuovo ingresso

Training Set

tale descrizione deve poter essere usata in modo predittivo

Training Set

Find-S è un algoritmo di apprendimento supervisionato

Test Set

Dati

Alessandro Sperduti

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

23

Sistemi di Elaborazione dell’Informazione

24

Errore Ideale

Dati (cont.)

Spazio di Ingresso X

Se

abbastanza grande il Training Set è ulteriormente suddiviso in due

sottoinsiemi (

-

):

f

-

h

+

Training Set’

+

usato direttamente dall’algoritmo di apprendimento;

!

!

Dove f

e h differiscono

usato indirettamente dall’algoritmo di apprendimento.

"

Il Validation Set serve per scegliere l’ipotesi

-

Validation Set

#

$

migliore fra quelle consistenti

Supponiamo che la funzione

da apprendere sia una funzione booleana (concetto):

%

(

rispetto al concetto

7

) di una ipotesi

e la distribuzione di

%

2

76 .

4

45

34

Def: L’Errore Ideale (

-2

-.

,+

*)

'

&%

Training Set

1+

/0)

con il Training Set’

Training Set’

Validation Set

Test Set

classifichi

.

9 2D

BC7 A

92

% .@

76 .

4

45

34

Alessandro Sperduti

:

<4 ? >

; =

2

8

Alessandro Sperduti

7

:

Dati

) è la probabilità che

9

(probabilità di osservare l’ingresso

'

8

probabilità

erroneamente un input selezionato a caso secondo

Sistemi di Elaborazione dell’Informazione

25

Sistemi di Elaborazione dell’Informazione

26

Errore di Apprendimento

PAC learning

Spazio di Ingresso X

E’ possibile sviluppare una teoria che non ha bisogno del Validation Set e che e` in grado di

h2

-

f

dirmi di quanti esempi di apprendimento ho bisogno per ottenere una ipotesi che risponda a

-

h0

+

determinati criteri di qualità ?

h1

+

Per l’apprendimento di concetti una possibile risposta (parziale) è la teoria del PAC Learning

(Probabily Approximately Correct Learning)

-

Dove f

e h differiscono

Assunzioni: tutti gli input ed output sono binari, e i dati non contengono rumore e sono estratti

secondo una distribuzione di probabilità

,

quale scegliere ?

7

4

Vantaggi:

è il numero di esempi

è possibile definire dei bound sul numero di esempi di apprendimento per garantire che

rispetto a

7

) di una ipotesi

7.

4

45

34

Def: L’Errore Empirico (

,

7

7

= Training Set’, pi `u ipotesi possono essere consistenti:

4

Dato

2

-

.

con una certa probabilità un algoritmo di apprendimento è in grado di restituire una

92

:

:

:

se

7

4

ipotesi con errore ideale basso (approssimazione)

tale che

è possibile caratterizzare formalmente la complessità computazionale nell’apprendere

2

2

76 .

4

45

34

2

2

76 .

4

45

34

.

7.

4

45

34

7.

4

45

34

, ma

2

.)

+% .

2

7

è sovraspecializzata (overfit)

4

92

9

7.

4

45

34

7

Def: Una ipotesi

CB7A

92

%.

;

classifica erroneamente:

che

arbitraria ma stazionaria.

8

'

da

determinate classi di concetti

Il Validation Set serve per cercare di selezionare l’ipotesi migliore (evitare overfit).

Alessandro Sperduti

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

27

Sistemi di Elaborazione dell’Informazione

28

PAC learning

di possibili concetti target (funzioni da apprendere) definite su un

Consideriamo una class

'

di lunghezza

insieme di istanze

PAC learning

E’ stato dimostrato che se si assume:

(ad esempio stringhe binarie), ed un algoritmo di

:

che utilizza uno spazio delle ipotesi

.

apprendimento

consistente, cioè restituisce una ipotesi consistente con l’insieme di apprendimento

usando

è PAC-apprendibile da

Definizione:

se per tutti i

(Find-S è un algoritmo consistente)

:

,

,

'

8

restituisce un’ipotesi

:

a patto che il numero di esempi di apprendimento

2

76 .

4

45

34

tale che

7

,

2

.

su

, l’algoritmo di apprendimento

/

allora con probabilità almeno

distribuzioni

soddisfi la seguente disuguaglianza:

,

,

tali che

*

,

*

tali che

,

,

1

22

.

2

.

7

:

2

.

è il logaritmo in base naturale

2

.

2

Alessandro Sperduti

è la cardinalità dello spazio delle ipotesi e

dove

(spazio di

2

3.

,e

,

76 .

4

45

34

,

,

,

, in tempo che e` polinomiale in

memoria che serve per rappresentare ).

Alessandro Sperduti

, .

restituisce un’ipotesi

,

con probabilità almeno

/

l’algoritmo di apprendimento

tale che

Sistemi di Elaborazione dell’Informazione

29

Sistemi di Elaborazione dell’Informazione

30

PAC learning

letterali PAC-apprendibile usando Find-S con

? Si !

E’ la congiunzione di

PAC learning

Usando la disuguaglianza ed altre considerazioni si è potuto dimostrare che alcune classi di

concetti non sono PAC-apprendibili considerando un particolare algoritmo di apprendimento e

Infatti:

spazio delle ipotesi.

letterali è inclusa in

ogni congiunzione di

In particolare si è dimostrato che:

Find-S è un algoritmo consistente

'

non è

1

1

22 .

.

.

22 .

2

.

.

1

,2

1

allora

contiene tutte le funzioni booleane realizzabili su

B

se

,

B

e poichè

PAC-apprendibile da algoritmi consistenti.

,

1

2

1

22

.

.

,2

.

, .

esistono classi di concetti

che non sono apprendibili da algoritmi consistenti che

come spazio delle ipotesi, ma diventano PAC-apprendibili se come spazio

(che non compare)

2

3.

,e

,

,

,

,

è polinomiale in

quindi

utilizzano

Un problema con l’uso della disuguaglianza e` che questa diventa inutile se

) e la dimensione

non è finito

2

3.

l’ipotesi corrente (che è di dimensione maggiore o uguale a

delle ipotesi si usano opportuni

per ogni esempio di apprendimento Find-S esegue una elaborazione che è lineare con

Quello che in realtà interessa è caratterizzare la “potenza” di uno spazio delle ipotesi: la

4

), quindi di nuovo polinomiale, e globalmente polinomiale per

dell’input (

Quindi tutte le condizioni per la PAC-apprendibilità sono soddisfatte!

VC-dimension (Vapnik-Chervonenkis) fornisce una risposta in questa direzione

Alessandro Sperduti

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

31

Sistemi di Elaborazione dell’Informazione

32

VC-dimension

VC-dimension: Esempio

Definizione: Frammentazione (Shattering)

Quale è la VC-dimension di

?

!:

+

!:

+

1

B

%

%

-

2

.

)

.

.

B

,

9

:

:

:

+

92

7 +

7+

9

tale che

2

se e solo se

2

è frammentato (shattered) dallo spazio delle ipotesi

B

,

'

Dato

.

realizza tutte le possibili dicotomie di

)

−

(

Definizione: VC-dimension

La VC-dimension di uno spazio delle ipotesi

'

definito su uno spazio delle istanze

'

dalla cardinalità del sottoinsieme pi `u grande di

cheè frammentato da

è data

f() = −1

:

B

&

2

.

frammenta

f() = +1

B

se

non è limitato

2

.

iperpiano

Alessandro Sperduti

Alessandro Sperduti

w .y + b = 0

+

w

Sistemi di Elaborazione dell’Informazione

33

Sistemi di Elaborazione dell’Informazione

34

VC-dimension: Esempio

?

. Vediamo cosa succede con 3 punti:

,

Quindi

banale. Vediamo cosa succede con 2 punti:

Quale è la VC-dimension di

?

Quale è la VC-dimension di

VC-dimension: Esempio

2

.

2

.

−

+

w

−

−

+

w

+

−

+

−

+

+

+

−

+

+

+

−

+

+

+

+

+

+

−

−

+

+

+

−

−

−

+

w

−

−

−

+

w

−

+

+

w

−

−

+

−

+

−

−

+

−

−

+

−

−

−

−

+

−

Alessandro Sperduti

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

35

Sistemi di Elaborazione dell’Informazione

36

VC-dimension: Esempio

Quale è la VC-dimension di

?

. Cosa succede con 4 punti ? Non si riesce a frammentare 4 punti!!

Quindi

. Cosa succede con 4 punti ?

Quindi

?

Quale è la VC-dimension di

VC-dimension: Esempio

2

.

2

.

Infatti esisteranno sempre due coppie di punti che se unite con un segmento provocano una

intersezione fra i due segmenti e quindi, ponendo ogni coppia di punti in classi diverse, per

B

separarli non basta una retta, ma occorre una curva. Quindi

Alessandro Sperduti

2

.

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

37

Sistemi di Elaborazione dell’Informazione

38

PAC learning

VC-dimension

E’ stato dimostrato che se si assume:

, infatti

$

si ha

può realizzare

$

$

frammenta

tale che

:

Per ogni

consistente, cioè restituisce una ipotesi consistente con l’insieme di apprendimento

$

$

Dimostriamo che

$

$

si ottiene

per cui vale

2

.

Scegliendo un

.

restituisce un’ipotesi

:

a patto che il numero di esempi di apprendimento

, che sono esattamente

,

76 .

4

45

34

7

tale che

, l’algoritmo di apprendimento

/

allora con probabilità almeno

tutte le possibili dicotomie di

(Find-S è un algoritmo consistente)

2

soddisfi la seguente disuguaglianza:

ad entrambi i membri dell’ultima disuguaglianza, possiamo

Quindi, applicando

,

,

$

$

1

22

.

2

.

2

.

, .

concludere che

$

$

Notare che vale

Alessandro Sperduti

Alessandro Sperduti

Sistemi di Elaborazione dell’Informazione

39

Sistemi di Elaborazione dell’Informazione

40

Compiti di Classificazione pi`

u Complessi

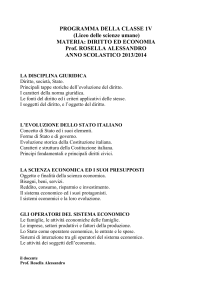

Giocare a Tennis!!

E’ la giornata ideale per giocare a Tennis ?

In molte applicazioni del mondo reale non è sufficiente apprendere funzioni

booleane con ingressi binari.

Gli Alberi di Decisione sono particolarmente adatti a trattare:

istanze rappresentate da coppie attributo-valore;

funzioni target con valori di output discreti (in generale più di 2 valori);

esempi di apprendimento che possono contenere errori e/o avere valori

mancanti.

Inoltre, algoritmi di apprendimento per Alberi di Decisione sono in genere molto

veloci.

Per questi motivi gli Alberi di Decisione sono molto utilizzati in applicazioni pratiche.

Alessandro Sperduti

Alessandro Sperduti

Day

Outlook

Temperature

Humidity

Wind

PlayTennis

D1

Sunny

Hot

High

Weak

No

D2

Sunny

Hot

High

Strong

No

D3

Overcast

Hot

High

Weak

Yes

D4

Rain

Mild

High

Weak

Yes

D5

Rain

Cool

Normal

Weak

Yes

D6

Rain

Cool

Normal

Strong

No

D7

Overcast

Cool

Normal

Strong

Yes

D8

Sunny

Mild

High

Weak

No

D9

Sunny

Cool

Normal

Weak

Yes

D10

Rain

Mild

Normal

Weak

Yes

D11

Sunny

Mild

Normal

Strong

Yes

D12

Overcast

Mild

High

Strong

Yes

D13

Overcast

Hot

Normal

Weak

Yes

D14

Rain

Mild

High

Strong

No