Università di Roma Tor Vergata

LAUREA SPECIALISTICA IN FISICA

Studio dell’Accettanza Geometrica

nei Decadimenti Leptonici

dei Bosoni Vettori Intermedi W e Z

per l’Esperimento ATLAS ad LHC

Candidato

Manuela Venturi

Relatore

Prof. A. Di Ciaccio

Anno Accademico 2007/2008

The discovery of the W and the Z

is not the end − it is the beginning.

dal discorso di G. Ekspong

alla consegna del Premio Nobel per la Fisica

a Carlo Rubbia e Simon van der Meer

(1984).

Indice

Introduzione

vii

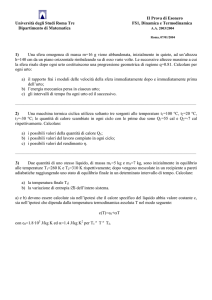

1 L’esperimento ATLAS al collider LHC del CERN

1.1 Il collider LHC . . . . . . . . . . . . . . . . . . . .

1.2 L’esperimento ATLAS . . . . . . . . . . . . . . . .

1.2.1 Caratteristiche generali del rivelatore . . . .

1.2.2 Inner Detector . . . . . . . . . . . . . . . . .

1.2.3 I calorimetri . . . . . . . . . . . . . . . . . .

1.2.4 Il sistema a muoni . . . . . . . . . . . . . .

1.3 Ricostruzione e identificazione dei muoni . . . . . .

.

.

.

.

.

.

.

1

1

3

3

6

7

9

18

.

.

.

.

.

.

.

.

.

.

.

25

25

28

34

36

37

38

41

43

44

47

48

.

.

.

.

.

.

51

51

51

53

55

57

59

2 La Fisica ad LHC

2.1 Il Modello Standard . . . . . . . . . . . . . . . . .

2.2 L’interazione elettrodebole . . . . . . . . . . . . .

2.2.1 Decadimento leptonico di W . . . . . . . .

2.2.2 Decadimento leptonico di Z . . . . . . . .

2.3 Misure del Modello Standard in ATLAS . . . . .

2.3.1 La massa del W . . . . . . . . . . . . . . .

2.3.2 La Fisica del quark top . . . . . . . . . . .

2.3.3 La ricerca del bosone di Higgs . . . . . . .

2.4 Oltre il Modello Standard . . . . . . . . . . . . .

2.4.1 La ricerca della Supersimmetria in ATLAS

2.4.2 Scenari esotici . . . . . . . . . . . . . . . .

3 La Fisica dei bosoni vettori intermedi W e Z

3.1 Il processo Drell-Yan . . . . . . . . . . . . . .

3.1.1 La collisione protone-protone . . . . .

3.1.2 Sezione d’urto a Leading Order . . . .

3.1.3 Correzioni a Next to Leading Order . .

3.1.4 Distribuzione in momento trasverso dei

3.2 Funzioni di distribuzioni partoniche . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . . .

. . . . .

. . . . .

. . . . .

partoni

. . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

iv

INDICE

3.3

3.4

3.5

3.2.1 Fattorizzazione . . . . . . . . . . . . . . . .

3.2.2 Evoluzione . . . . . . . . . . . . . . . . . . .

3.2.3 Violazioni di scaling . . . . . . . . . . . . .

Metodo CTEQ per il fit delle PDF . . . . . . . . .

3.3.1 Il metodo hessiano . . . . . . . . . . . . . .

3.3.2 L’analisi CTEQ 6 . . . . . . . . . . . . . . .

3.3.3 Effetti di massa dei quark: CTEQ 6.5 e 6.6 .

3.3.4 Correlazioni . . . . . . . . . . . . . . . . . .

Neural Network PDF . . . . . . . . . . . . . . . . .

3.4.1 Struttura generale di una rete neurale . . . .

3.4.2 Applicazione al caso delle PDF . . . . . . .

3.4.3 Incertezza sulle quantità derivate . . . . . .

Generatori Monte Carlo . . . . . . . . . . . . . . .

3.5.1 Fattori di forma di Sudakov . . . . . . . . .

3.5.2 Evoluzione backward . . . . . . . . . . . . .

3.5.3 Struttura generale di un generatore di eventi

3.5.4 Herwig . . . . . . . . . . . . . . . . . . . . .

3.5.5 Pythia . . . . . . . . . . . . . . . . . . . . .

3.5.6 Mc@Nlo . . . . . . . . . . . . . . . . . . . . .

4 Studi di accettanza geometrica

4.1 Motivazione per la misura di σW/Z . .

4.1.1 Metodo per la misura di σW/Z

4.2 Descrizione delle simulazioni . . . . .

4.2.1 Analisi delle distribuzioni . .

4.3 Calcolo dell’accettanza . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5 Errori sistematici nel calcolo dell’accettanza

5.1 PDF . . . . . . . . . . . . . . . . . . . . . . .

5.1.1 CTEQ 6.1 . . . . . . . . . . . . . . . .

5.1.2 Confronto con le CTEQ 6 e 6.6 . . . .

5.1.3 Correlazioni . . . . . . . . . . . . . . .

5.1.4 Neural Network PDF . . . . . . . . . .

5.2 Momento trasverso intrinseco dei partoni . . .

5.3 Radiazione di stato iniziale . . . . . . . . . . .

5.4 Correzioni di QED: Photos . . . . . . . . . .

5.5 Correzioni elettrodeboli: Horace . . . . . . . .

6 Conclusioni

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

59

64

65

68

69

74

77

83

85

86

88

90

91

91

93

94

95

97

98

.

.

.

.

.

101

. 101

. 102

. 106

. 109

. 116

.

.

.

.

.

.

.

.

.

121

. 122

. 122

. 128

. 133

. 135

. 139

. 140

. 144

. 147

151

INDICE

A Parametri delle

A.1 Herwig . . .

A.2 Pythia . . .

A.3 Mc@Nlo . . .

A.4 Horace . . .

v

simulazioni

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

153

. 153

. 155

. 155

. 157

Bibliografia

159

Ringraziamenti

167

vi

Introduzione

L’esperimento ATLAS, al collisore protone-protone del CERN di Ginevra,

è stato costruito con lo scopo di estendere le attuali conoscenze della Fisica delle particelle elementari, grazie all’energia nel centro di massa pari a

√

s = 14 TeV e alla luminosità di progetto L = 1034 cm−2 s−1 .

L’obiettivo principale di Fisica è l’elucidazione del meccanismo di rottura

spontanea della simmetria elettrodebole, che si manifesterebbe tramite l’esistenza del bosone di Higgs, oltre alla ricerca di segnali di Nuova Fisica, come

le particelle supersimmetriche.

L’esperimento ATLAS sarà inoltre in grado di eseguire, già nella fase

iniziale, studi di precisione nell’ambito del Modello Standard, grazie alle alte

sezioni d’urto di produzione dei quark bottom e top e dei bosoni vettoriali

intermedi W e Z.

Una delle prime misure che l’esperimento affronterà sarà proprio quella

della sezione d’urto per la produzione ed il decadimento leptonico dei bosoni

vettoriali intermedi, nei canali pp → W → `ν` + X e pp → Z → `+ `− + X,

con ` = e e µ.

Questi processi saranno molto abbondanti ad LHC: per ogni canale leptonico, sono attesi circa 108 bosoni Z all’anno nella fase ad alta luminosità,

e un fattore 10 in più di bosoni W .

Dal punto di vista sperimentale, i decadimenti dei bosoni vettori sono

considerati “candele standard”, e saranno utilizzati fin dalle prime fasi della

presa dati per la calibrazione del calorimetro elettromagnetico (Z → e+ e− ),

per l’allineamento delle tracce nello spettrometro a muoni (Z → µ+ µ− ), e

per monitorare la luminosità del rivelatore, grazie ad una segnatura pulita,

non oscurata da fondi importanti, oltre che semplice da caratterizzare, grazie

viii

INTRODUZIONE

alla presenza di leptoni ad alto impulso trasverso.

Più a lungo termine, l’obiettivo è quello di portare l’errore sulle sezioni

d’urto σW,Z al di sotto dell’1%, che è la soglia raggiunta al momento dal

calcolo teorico al Next to Next to Leading Order.

Lo studio dei decadimenti leptonici dei bosoni vettori, è essenziale anche

perché essi costituiscono il fondo dominante per molti dei canali di Nuova

Fisica che verranno esplorati dall’esperimento ATLAS.

Infine, si potrà estrarre da questi processi una conoscenza accurata delle

funzioni di distribuzioni partoniche (PDF) ad altissimi momenti trasferiti

(Q ≈ (102 ÷ 103 ) GeV).

Per quanto riguarda l’errore atteso sulla sezione d’urto, l’alta statistica raccolta dall’esperimento renderà in breve dominante l’errore sistematico

dovuto all’accettanza geometrica.

Il mio lavoro si è concentrato proprio sulla stima dell’accettanza nei decadimenti leptonici di W e Z, e del suo errore sistematico teorico, stima

effettuata con l’ausilio dei generatori Monte Carlo.

La Tesi è strutturata in cinque Capitoli. Nel primo Capitolo viene descritto l’esperimento ATLAS nelle sue componenti principali – l’Inner Detector, i

calorimetri, lo spettrometro a muoni, le camere per il tracciamento e il trigger

– e nelle sue performance – la risoluzione in impulso trasverso e in energia

mancante, l’efficienza di trigger e di ricostruzione delle tracce delle particelle.

Nel secondo Capitolo, illustrerò brevemente il Modello Standard, la rottura spontanea della simmetria elettrodebole tramite il bosone di Higgs ed

il Modello Standard Supersimmetrico Minimale, per poi volgere l’attenzione

ai traguardi che l’esperimento ATLAS si propone nei vari settori.

Nel terzo Capitolo, viene studiata più in dettaglio la teoria dei processi

Drell-Yan, a Leading e a Next to Leading Order. Poiché le PDF dominano

l’errore sistematico sull’accettanza geometrica, ad esse è dedicato lo spazio

maggiore, in particolare a due dei metodi usati per estrarle dalle misure delle

funzioni di struttura: il metodo hessiano della collaborazione CTEQ ed il

metodo delle reti neurali. In questo Capitolo descriverò anche la struttura generale dei generatori Monte Carlo, soffermandomi sulle caratteristiche

INTRODUZIONE

ix

principali di quelli che ho utilizzato per le simulazioni (Herwig, Pythia ed

Mc@Nlo).

Il quarto Capitolo contiene i risultati del calcolo dell’accettanza, per i vari

processi, sia all’ordine Leading in αs , che a quello Next to Leading.

Nel quinto Capitolo, affronto infine il problema dell’errore sistematico.

Partendo dalla configurazione di default, ho variato tutti i parametri a cui

l’accettanza è sensibile: le PDF, il momento trasverso intrinseco dei partoni,

la quantità di radiazione permessa nello stato iniziale, le correzioni elettromagnetiche e quelle elettrodeboli. La descrizione tecnica delle configurazioni

dei generatori Monte Carlo, è contenuta nell’Appendice.

x

Capitolo 1

L’esperimento ATLAS al

collider LHC del CERN

1.1

Il collider LHC

L’acceleratore circolare Large Hadron Collider (LHC) [29] è stato costruito

al CERN per estendere le frontiere della Fisica delle particelle, grazie alla

sua energia e alla sua luminosità senza precedenti.

É situato nel tunnel di LEP, lungo 27 Km, e accelererà due fasci indipendenti di protoni,√concentrati in pacchetti di 1011 , fino a un’energia nel centro di massa di s = 14 TeV. La frequenza delle collisioni sarà altissima:

4 × 107 collisioni al secondo, corrispondenti alla luminosità di disegno istantanea L = 1034 cm−2 s−1 .

LHC fornirà anche collisioni di ioni pesanti, in particolare nuclei di Piombo

a 5.5 TeV e L = 1027 cm−2 s−1 .

La Figura 1.1 mostra schematicamente il layout del complesso di acceleratori

del CERN. Nell’anello di LHC, i fasci di protoni si incroceranno in quattro

punti, che sono i siti dei quattro esperimenti principali: ATLAS (A Toroidal

LHC ApparatuS) [58] e CMS (Compact Muon Solenoid) [60] sono situati

diametralmente opposti (punti 1 e 5), ALICE (A Large Ion Collider Experiment) [57] nel punto 2, e LHCb [62] nel punto 8.

Mentre ATLAS e CMS potranno esplorare tutto il potenziale di Fisica ad

LHC (sono detti per questo multipurpose), gli altri esperimenti sono specializzati: ALICE studierà le collisioni tra ioni pesanti e la conseguente formazione del plasma gluone-quark, mentre LHCb si dedicherà alla Fisica di

precisione del mesone B. Inoltre, l’esperimento TOTEM [63], situato nella caverna di CMS, ha come obiettivo la misura della sezione d’urto totale

protone-protone.

2

1.1. IL COLLIDER LHC

Come già accennato, ognuno dei due fasci conterrà 2808 pacchetti, costituiti

da 1011 protoni ciascuno. Il primo stadio dell’accelerazione si svolge nel PS

(Proton Synchrotron), in cui i pacchetti vengono portati all’energia di 26

GeV; il secondo stadio consiste nell’iniezione nell’SPS (Super Proton Synchrotron), dove i pacchetti vengono accelerati fino a 450 GeV e poi trasferiti

nell’LHC. Lo spaziamento temporale tra i pacchetti di protoni è di 25 ns,

mentre è di 125 ns per i fasci di ioni di Piombo.

Figura 1.1: Layout del sistema di acceleratori del CERN.

Il sistema dei magneti comprende 1232 dipoli. L’accelerazione verrà impressa

in otto cavità lungo il percorso, raffreddate ad Elio liquido. Su ciascun lato

dei punti di interazione (IP), un tripletto di quadrupoli, ognuno lungo 31 m,

fornirà il focheggiamento dei fasci.

La realizzazione di un progetto ambizioso come LHC ha richiesto il raggiungimento di nuovi traguardi nella realizzazione dei rivelatori, sia per quanto

riguarda la precisione necessaria nel difficile contesto di un’interazione adronica ad altissime energia e frequenza, sia per la protezione dalle alte dosi di

radiazioni generate nelle collisioni.

La schedula per il ripristino delle operazioni − interrotte nel settembre

2008 subito dopo l’avvio a causa di un incidente ai magneti nel settore 3-4, con

conseguente fuoriuscita di Elio liquido − prevede una fase di riparazioni nei

primi mesi del 2009, e una nuova partenza nel settembre dello stesso anno.

Attualmente l’esperimento è in fase di commissioning, ovvero di studio e

calibrazione dei suoi rivelatori tramite l’acquisizione dei dati da raggi cosmici.

Possiamo distinguere due fasi principali per le operazioni con i fasci di

1.2. L’ESPERIMENTO ATLAS

3

protoni [51]. Durante la prima fase − dall’autunno 2009 all’autunno 2010

− l’energia per fascio sarà di 5 TeV e la luminosità L = 1030 cm−2 s−1 : in

questo periodo ci si aspetta di raccogliere tra i 200 e i 300 pb−1 di dati, che

saranno utilizzati da una parte per la calibrazione del rivelatore, gli studi di

performance del trigger e la determinazione delle efficienze, dall’altra per lo

studio di processi ben noti, come la produzione Drell-Yan dei bosoni vettori

W e Z(1 ), e la Fisica del quark top.

Nella fase seguente, in cui la luminosità istantanea salirà a L = 1033 cm−2 s−1 ,

per poi raggiungere quella di disegno, sarà dedicata alla ricerca del bosone

di Higgs e delle particelle supersimmetriche, oltre che all’esplorazione degli

scenari più esotici.

Nel seguito ci soffermeremo sulla descrizione dell’esperimento ATLAS.

Focalizzeremo la nostra attenzione sul sistema dedicato alla misura dei muoni, in quanto essi rappresentano la segnatura di riferimento per molti degli

obiettivi di Fisica di ATLAS.

1.2

1.2.1

L’esperimento ATLAS

Caratteristiche generali del rivelatore

Definiamo innanzitutto il sistema di riferimento.

L’origine delle coordinate risiede nel punto nominale di interazione; l’asse z

è la direzione del fascio, il piano xy è trasverso al fascio, quindi il momento

trasverso è definito come:

q

pT = p2x + p2y

e cosı̀ l’energia trasversa. L’asse x punta verso il centro dell’anello di LHC,

l’asse y punta verso l’alto. Il lato A (C) del rivelatore è quello a z positive

(negative).

L’angolo azimutale φ è misurato intorno all’asse z (0 < φ < 2π), mentre

l’angolo polare θ è misurato a partire dallo stesso asse (0 < θ < π).

La rapidità y e la pseudorapidità η sono definite come:

·

¸

µ ¶

E + pz

θ

1

,

η = − ln tan

y = ln

,

(1.1)

2

E − pz

2

dove la rapidità è approssimata dalla pseudorapidità in caso di particelle di

massa trascurabile. In Figura 1.2 vediamo la variazione di η in funzione del1

Il processo Drell-Yan propriamente detto coinvolge solo la produzione di un fotone;

nel seguito, estendiamo la notazione ad includere anche la produzione ed il decadimento

dei bosoni vettori massivi W e Z.

4

1.2. L’ESPERIMENTO ATLAS

l’angolo polare: pseudorapidità maggiori corrispondono ad angoli più vicini

alla linea del fascio.

Figura 1.2: Andamento della pseudorapidità η in funzione dell’angolo polare θ.

Definiamo infine la distanza ∆R nel piano φ − η, che viene usata per quantificare l’isolamento delle particelle nel rivelatore, e per la definizione dei jet

di QCD:

p

∆R = ∆η 2 + ∆φ2 .

(1.2)

In Figura 1.3 vediamo il disegno complessivo dell’esperimento ATLAS, mentre in Tabella 1.1 sono elencate in dettaglio la risoluzione in impulso e la

copertura angolare del tracciatore centrale e dello spettrometro a muoni.

Figura 1.3: Vista schematica dell’esperimento ATLAS [10].

Da notare che il rivelatore è simmetrico rispetto al punto di interazione.

Il sistema magnetico comprende un solenoide superconduttore intorno all’In-

1.2. L’ESPERIMENTO ATLAS

5

ner Detector (il campo risultante è di 2 T), e tre toroidi superconduttori a

simmetria ottagonale all’esterno dei calorimetri.

L’Inner Detector è circondato da calorimetro elettromagnetico (EM) a

sampling, costituito di Argon liquido (LAr) ad alta granularità e strati di

Piombo. L’Argon liquido è usato anche per i calorimetri adronici, per avere

continuità con quelli elettromagnetici.

Procedendo verso l’esterno, si incontra lo spettrometro a muoni, con tre

strati di camere di tracciamento ad alta precisione, e camere di trigger ad

alta risoluzione temporale ((1.5 ÷ 4) ns).

Componente

Risoluzione

del rivelatore

richiesta

Misura

Trigger

σpT /pT = 0.05% pT ⊕ 1%

√

σE /E = 10%/ E ⊕ 0.7%

±2.5

−

±3.2

±2.5

±3.2

±3.2

3.1 < |η| < 4.9

3.1 < |η| < 4.9

±2.8

±2.4

Tracciamento

Calorimetro EM

Copertura in η

Calorimetro adronico:

Barrel ed end-cap

In avanti

Spettrometro a muoni

√

σE /E = 50%/ E ⊕ 3%

√

σE /E = 100%/ E ⊕ 10%

σpT /pT = 3% a 100 GeV

σpT /pT = 10% a 1 TeV

Tabella 1.1: Risoluzione e copertura in pseudorapidità dei vari rivelatori di

ATLAS [10]. Impulsi ed energie sono in GeV.

La frequenza di interazione protone-protone, alla luminosità di disegno, è approsimativamente 1 GHz, mentre la registrazione dei dati è limitata a 200 Hz.

Occorre quindi un fattore di reiezione di 5 × 106 , che permetta di preservare i

dati potenzialmente interessanti. Il trigger di Livello 1 (L1) diminuisce il rate

degli eventi da salvare a 75 kHz, avvalendosi dell’informazione proveniente

da un sottoinsieme dell’intero apparato; si scende poi fino a 200 Hz tramite

i due livelli di trigger successivi, indicati collettivamente come trigger di alto

livello.

Vediamo in Figura 1.4 il rate di particelle stimato nel rivelatore dopo il trigger

di Livello 1, in funzione della soglia in pT .

Con un taglio in pT a 20 GeV − che è quello usato per esempio per selezionare gli eventi W e Z − il rate totale è di circa 5 Hz, ed è dominato dalla

produzione di quark pesanti.

6

1.2. L’ESPERIMENTO ATLAS

Figura 1.4: Rate di particelle stimato nell’esperimento ATLAS dopo il trigger di

Livello 1, in funzione della soglia in momento trasverso [10].

1.2.2

Inner Detector

L’Inner Detector (ID), un cilindro di dimensioni 2.1 m × 6.2 m che circonda

la beam-pipe (Figura 1.5), è il cuore del rivelatore.

Figura 1.5: Vista schematica dell’Inner Detector [10].

E’ immerso in un campo magnetico solenoidale di 2 T, le cui linee di campo

corrono parallele all’asse del fascio. La funzione principale dell’ID è il tracciamento delle particelle cariche al suo interno, in modo da ricostruirne la

carica, l’impulso, i vertici primari e secondari. Il tracciamento è assicurato

dai tracciatori a pixel e a microstrip di Silicio (SCT, Semi Conductor Trac-

1.2. L’ESPERIMENTO ATLAS

7

king), e dai rivelatori a radiazione di transizione (TRT).

I tracciatori di precisione (pixel e SCT) coprono la regione |η| < 2.5. Come

si vede dalla Figura, quelli nel barrel (corpo centrale del rivelatore, letteralmente “barile”) sono disposti perpendicolarmente a quelli negli end-cap.

L’obiettivo di questi sottorivelatori è di assicurare un’ottima risoluzione in

impulso, oltre che la localizzazione del vertice primario e di quelli secondari,

in condizioni di altissima densità di tracce. La massima granularità è raggiunta intorno all’IP, e decresce gradualmente a distanze crescenti.

La soluzione adottata consiste nel far attraversare ad ogni traccia almeno

quattro strati di strip di Silicio e tre strati di pixel nella zona più interna.

Gli strati di pixel sono segmentati in Rφ e in z, con dimensioni standard di

Rφ × z = 50 × 400 µm2 . I canali di lettura sono circa 80 milioni per i pixel,

6 milioni per le microstrip di Silicio.

Ogni traccia è inoltre registrata dai tracciatori a radiazione di transizione,

con 36 hit per traccia; questi rivelatori provvedono solo l’informazione in

Rφ, fino a |η| = 2.0. Permettono tuttavia di estendere l’informazione sul

tracciamento a grandi distanze, compensando la minor precisione col grande

numero di punti raccolti.

Il tracciamento effettuato nell’Inner Detector è complementare a quello dei

calorimetri elettromagnetici, come vedremo in Sezione (1.3).

1.2.3

I calorimetri

I calorimetri, elettromagnetici e adronici, circondano l’Inner Detector, come

mostrato in dettaglio in Figura 1.6.

Presi nel loro insieme, essi coprono il range |η| < 4.9, che è molto vasto

e comprende quindi zone assai diverse per performance richieste e per dosi

di radiazioni assorbite. In particolare, mentre per il calorimetro elettromagnetico a LAr, che si trova direttamente dopo il rivelatore centrale, c’è la

necessità di avere altissima precisione e quindi una granularità molto fine,

queste richieste possono essere rilassate via via che ci si allontana dall’Inner

Detector.

Caratteristica comune di questi rivelatori, è la capacità di contenimento delle

cascate, adronica ed elettromagnetica. Il calorimetro EM ha spessore maggiore di 22 lunghezze di radiazione (X0 ) nel barrel, e maggiore di 24 X0 negli

end-cap.

In complesso, lo spessore del sistema dei calorimetri di ATLAS è di 11 λ

a η = 0, sufficiente per una buona misura di ETmiss e dei jet altamente

energetici.

8

1.2. L’ESPERIMENTO ATLAS

Figura 1.6: Vista schematica del sistema dei calorimetri [10].

Calorimetro elettromagnetico a LAr

É diviso in una componente di barrel (|η| < 1.47) e due componenti di endcap (1.37 < |η| < 3.2), ognuna racchiusa nel proprio criostato. Il calorimetro

del barrel consiste di due metà identiche (z > 0 e z < 0), separate da una

piccola gap di 4 mm a z = 0, per il passaggio dei cavi e dei servizi. I due

calorimetri degli end-cap sono invece divisi entrambi in due ruote coassiali.

La copertura in φ è pressoché totale, senza zone morte, grazie a una geometria

a fisarmonica: questo permette di avere molti strati attivi in profondità.

La struttura del calorimetro elettromagnetico è a sampling, con strati

alternati di Piombo e Argon liquido: l’Argon è il materiale sensibile, mentre

il Piombo, la cui funzione è l’assorbimento dello sciame, ha uno spessore

variabile in funzione di η.

La scelta dell’Argon liquido è dovuta alla sua risposta intrinsecamente lineare

e stabile nel tempo, e alla sua resistenza alle radiazioni.

La zona di transizione tra barrel ed end-cap è equipaggiata con un presciamatore (uno strato di LAr) che, per 1.5 < |η| < 1.8, corregge per le

perdite di energia in questa zona. Inoltre, il calorimetro forward, FCal, copre

l’intervallo in rapidità 3.1 < |η| < 4.9, cosı̀ da misurare l’energia di fotoni ed

elettroni nella zona più prossima al fascio.

I segnali del calorimetro EM sono amplificati e formati ogni 25 ns, e

immagazzinati in memorie analogiche in attesa del trigger di Livello 1.

1.2. L’ESPERIMENTO ATLAS

9

Calorimetri adronici

Si trovano sulla linea del fascio, subito dopo i calorimetri elettromagnetici.

Sono di due tipi: il tile calorimeter (letteralmente “calorimetro a tegola”) e

quello dell’end-cap.

Il primo usa il Ferro come materiale assorbitore, e una struttura a mattonelle

per la scintillazione. Le particelle ionizzanti che attraversano queste mattonelle inducono la produzione di luce di scintillazione ultravioletta, che viene

poi convertita in luce visibile da uno wavelength shifter, per essere letta dai

fotomoltiplicatori. La copertura è |η| < 1.7, con uno spessore totale di 9.7 λ

a η = 0. La struttura è autoconsistente, e comprende 3 sezioni di 64 moduli

ciascuna.

Il calorimetro adronico dell’end-cap è invece ad Argon Liquido, come quello

elettromagnetico, dietro al quale è immediatamente posizionato, e col quale

condivide il criostato. É formato da due ruote indipendenti per end-cap,

ognuna divisa in due strati; il materiale assorbitore è il Rame.

Il calorimetro forward (FCal) comprende una parte adronica (due moduli

assorbitori di Tungsteno) e una elettromagnetica (un modulo assorbitore di

Rame), entrambe alternate con gap di Argon liquido. L’FCal è accoppiato

con i calorimetri degli end-cap e ne condivide il criostato; questa scelta minimizza le perdite di energia nelle zone di transizione tra i due sottorivelatori.

L’FCal si trova sulla linea del fascio, a 4.7 m dal punto di interazione, per

cui è esposto a flussi intensi di particelle: per ottimizzare la risposta, gli

strati riempiti di Argon liquido dell’FCal sono molto più sottili di quelli dei

calorimetri EM.

1.2.4

Il sistema a muoni

Uno schema dello spettrometro a muoni è mostrato in Figura 1.7, mentre i

suoi parametri principali sono listati in Tabella 1.2.

Lo spettrometro è stato progettato per fornire accurate misure di impulso da pochi GeV fino a vari TeV: se infatti la maggior parte dei processi

interessanti, sia del Modello Standard sia di nuova Fisica, produce tracce ad

alto pT , non possiamo trascurare i muoni a bassa energia come quelli per lo

studio della violazione di CP e per la Fisica del B.

Gli obiettivi di Fisica richiedono quindi performance eccezionali allo spettrometro a muoni:

• Risoluzione in massa e in impulso intorno all’1%, per poter ricostruire

stati finali contententi fino a quattro muoni, in condizioni di alto fondo.

10

1.2. L’ESPERIMENTO ATLAS

Figura 1.7: Vista schematica del sistema dei calorimetri [10].

Monitored Drift Tubes

Copertura

Numero di camere

Numero di canali

Funzione

Cathode Strip Chambers

Copertura

Numero di camere

Numero di canali

Funzione

Resistive Plate Chambers

Copertura

Numero di camere

Numero di canali

Funzione

Thin Gap Chambers

Copertura

Numero di camere

Numero di canali

Funzione

MDT

|η| < 2.7 (strato più interno: |η| < 2.0)

1088 (1150)

339000 (354000)

Tracciamento di precisione

CSC

2.0 < |η| < 2.7

32

31000

Tracciamento di precisione

RPC

|η| < 1.05

544

359000

Trigger e seconda coordinata

TGC

1.05 < |η| < 2.7 (|η| < 2.4 per il trigger)

3588

318000

Trigger e seconda coordinata

Tabella 1.2: Parametri del sistema a muoni di ATLAS [10].

1.2. L’ESPERIMENTO ATLAS

11

• Misura della seconda coordinata, ortogonale alla direzione della deflessione magnetica, con una risoluzione di 5 ÷ 10 mm.

• Grande copertura in pseudorapidità (|η| < 2.7), senza zone morte

(ermeticità).

• Trigger efficiente e flessibile: mentre i processi ad alto pT saranno selezionati con una soglia di 10 ÷ 20 GeV, per i processi rari e poco

energetici la soglia dovrà scendere fino a 5 GeV.

• Identificazione accurata del bunch-crossing: il trigger di primo livello

dovrà avere una risoluzione temporale inferiore a 25 ns.

Il fondo che questo spettrometro si troverà ad affrontare può essere diviso in

due tipi, primario e secondario.

Il fondo primario è dovuto ai muoni prodotti dal decadimento delle particelle

generate nella collisione tra i protoni; un esempio sono i decadimenti semileptonici dei mesoni leggeri (π, K → µX) e dei quark pesanti (c, b, t → µX).

Il fondo secondario invece consiste principalmente di neutroni e fotoni intorno al MeV, prodotti da interazioni secondarie nei calorimetri forward, nel

materiale di schermo dalle radiazioni, eccetera. I neutroni a bassa energia

vengono infatti prodotti in gran numero nei processi adronici, sfuggono agli

assorbitori e producono un gas di fotoni poco energetici attraverso processi

nucleari di cattura neutronica. Questo fondo è isotropo e non è correlato col

bunch-crossing, caratteristica che si sfrutta per ridurlo.

Da notare che il rivelatore è stato disegnato per affrontare un fondo fino a

cinque volte superiore a quello stimato.

Sistema magnetico

Lo spettrometro è basato sulla deflessione delle tracce muoniche nei tre grandi

magneti superconduttori toroidali air-core (Figura 1.8).

Un magnete air-core − che è “vuoto”, per cui la sua induttanza non è dovuta

alla presenza di un materiale ferromagnetico − può operare a frequenze di

diversi GHz, mentre i ferromagneti hanno difficoltà a superare i 100 MHz.

Nella regione |η| < 1.4, la deflessione è assicurata dal toroide del barrel,

mentre negli end-cap (1.6 < |η| < 2.7) sono installati due magneti più piccoli. Nella regione di transizione, 1.3 < |η| < 1.65, è presente invece una

combinazione dei campi precedenti. Questa configurazione magnetica fornisce un campo che è ovunque perpendicolare alle traiettorie, minimizzando

contemporaneamente l’effetto dello scattering multiplo.

12

1.2. L’ESPERIMENTO ATLAS

Figura 1.8: Schema del magnete superconduttore in aria della regione centrale

dello spettrometro a muoni [10].

Camere a muoni per il tracciamento: MDT e CSC

Il sistema delle camere a muoni è ottimizzato in ermeticità ed è strutturato

in modo che ogni traccia attraversi almeno tre camere.

Nel barrel (|η| < 1), le camere sono disposte in tre cilindri, concentrici all’asse del fascio, a raggi di circa 5, 7.5 e 10 m. Le camere degli end-cap,

invece, coprono il range 1 < |η| < 2.7, e sono disposte in quattro dischi,

anch’essi concentrici all’asse del fascio, posti a 7, 10, 14 and 21 m dall’IP. La

combinazione delle camere del barrel e degli end-cap permette di avere una

copertura pressoché totale in pseudorapidità, eccetto che per le aperture in

direzione verticale (η = 0) per il passaggio dei cavi e dei servizi.

Per |η| < 2.0 le tracce vengono misurate, nella direzione della deflessione

magnetica, tramite gli MDT (Monitored Drift Tubes). A grandi rapidità

(2 < |η| < 2.7), in cui il flusso, sia del segnale sia del fondo, è elevatissimo,

gli MDT sono supplementati dalle CSC (Cathode Strip Chambers), che sono

camere proporzionali multifilo con catodi segmentati a strisce.

La struttura degli MDT è proiettiva, le loro dimensioni cioé aumentano con

la distanza dal punto di interazione; per eliminare le zone morte, molte camere sono state sagomate in forme speciali. Alla partenza di LHC, saranno

presenti 1088 MDT, divisi in 18 tipi principali.

L’elemento di base di una camera MDT è un tubo pressurizzato (3 bar)

con un diametro di ∼ 30 mm, riempito dalla miscela di gas Ar/CO2 . Gli

elettroni risultanti dalla ionizzazione sono raccolti da un filo centrale di

Tungsteno-Renio, tenuto a una tensione di 3080 V. L’indipendenza dei singoli

tubi fa sı̀ che il danneggiamento di uno non coinvolga gli altri.

La pressione a cui sono tenuti i tubi riduce l’effetto della diffusione, e in

più il fatto di avere una geometria cilindrica risulta in un campo elettrico

radiale: l’accuratezza della misura, di conseguenza, dipende solo debolmente

1.2. L’ESPERIMENTO ATLAS

13

dall’angolo di incidenza sul piano della camera, in quanto il tempo di deriva

(drift) è lo stesso per tutte le tracce a distanza R dal filo (Figura 1.9(a)),

cosa che non accadrebbe con una geometria rettangolare. Il massimo tempo

di drift è circa 700 ns.

Figura 1.9: (a) Sezione di un tubo a drift. (b) Struttura di una camera MDT.

Entrambi da [10].

Il gas è stato selezionato grazie alle sue proprietà di ageing, infatti in campioni di questa miscela non sono mai stati osservati depositi sui fili, né è

possibile la formazione di polimeri data l’assenza di Idrogeno. Uno svantaggio di questo gas è d’altronde la relazione non lineare tra spazio e tempo

di drift, che causa un degrado della risoluzione spaziale ad alte frequenze di

conteggio. Inoltre Ar/CO2 è abbastanza lento, il doppio di quello gas dalla

risposta lineare come Ar/CH4 .

In Figura 1.9(b) vediamo la generica struttura di una camera MDT: i tubi

sono disposti in piani paralleli, e ogni gruppo di tre o quattro piani (multistrato) è intervallato da uno spaziatore meccanico. Nella regione più interna del

rivelatore ci sono quattro piani di tubi, tre nelle parti esterne. Una struttura

interna di Alluminio permette di dare rigidità alla camera. Per monitorare

la posizione dei tubi è stato aggiunto un sistema di lenti, poste in mezzo

alla camera, che convogliano quattro raggi di allineamento ottico. In questo

modo si possono individuare e correggere deformazioni di pochi µm, come

quelle causate dalle variazioni ambientali (temperatura, pressione, ecc.).

Le camere CSC sono installate nella zona ad alto rate degli end-cap. La

regione di operatività ottimale degli MDT, infatti, è limitata a |η| < 2.0,

dove si raggiunge un rate di conteggi di circa 150 Hz/cm2 ; per rate superiori,

il diametro relativamente largo dei tubi fa sı̀ che si vada in condizione di pile-

14

1.2. L’ESPERIMENTO ATLAS

up. Per questo, fino a |η| = 2.7, gli MDT sono supplementati dalle camere

CSC, che sopportano un rate fino a 1000 Hz/cm2 .

Figura 1.10: (a) Disposizione spaziale delle camere CSC. (b) Struttura di una

camera CSC. Entrambi da [10].

La disposizione delle camere CSC è mostrata in Figura 1.10(a): in complesso

ci sono due dischi, con otto camere per ciascuno, di dimensioni piccole per il

disco interno e grandi per quello esterno. Ogni camera è composta in realtà di

quattro CSC, per un totale di quattro misure indipendenti (η, φ) per traccia.

Come vediamo in Figura 1.10(b), le CSC sono camere proporzionali a

multifilo, con una distanza anodo-catodo d uguale alla distanza tra i fili

anodici (d = S = 5.08 mm). In una tipica camera a multifilo, i √

segnali sono

letti dai fili anodici, limitando cosı̀ la risoluzione spaziale a S/ 12: in una

CSC invece la precisione è molto maggiore, perché quello che si misura è la

distribuzione di carica indotta sul catodo dalla valanga formata sugli anodi.

Entrambi i catodi sono segmentati, uno in strisce perpendicolari ai fili, uno in

strisce parallele, fornendo cosı̀ in contemporanea la misura di due coordinate.

La prima delle due misure menzionate, però, è molto più precisa (60 µm),

mentre nella direzione trasversa alla deflessione la segmentazione del catodo

è meno fitta e quindi la risoluzione ottenibile si ferma a 5 mm.

Le caratteristiche di queste camere, semplici ma precise, sono: capacità

di distinguere tra più tracce, risoluzione temporale di 7 ns per piano, bassa

sensibilità ai neutroni. La miscela di gas scelta è Ar/CO2 come per gli MDT.

Camere a muoni per il trigger: RPC e TGC

Il sistema di trigger di Livello 1 dello spettrometro a muoni, deve fornire al

trigger di Livello 2 la misura della molteplicità e dell’impulso delle tracce che

lo attraversano. Per far questo, deve possedere le caratteristiche seguenti:

1.2. L’ESPERIMENTO ATLAS

15

• Velocità: il trigger deve avere una risoluzione temporale migliore di

25 ns (spaziamento tra i pacchetti di protoni) per poter correttamente

associare trigger e bunch-crossing.

• Precisione nelle soglie in pT : la definizione delle soglie in impulso

trasverso richiede una granularità intorno al cm.

• Misura della seconda coordinata: poiché gli MDT misurano la

coordinata delle tracce lungo la direzione della deflessione, le camere di

trigger devono fornire la coordinata trasversa.

• Uniformità in η e φ: il trigger deve coprire il range di accettanza

|η| ≤ 2.4, e 2π in angolo azimutale.

Commentiamo quest’ultima caratteristica. Tra barrel ed end-cap ci sono

differenze sostanziali. In particolare, fissato pT , p cresce in funzione di η:

mentre a η = 0 si ha p = pT , per |η| = 2.4 si ha per esempio p = 5.8 pT .

Quindi, se la risoluzione in pT deve essere confrontabile tra end-cap e barrel,

la granularità del rivelatore deve essere funzione di η.

Al tempo stesso, bisogna considerare che negli end-cap i livelli di radiazione

sono dieci volte maggiori di quelli nel barrel.

Infine, nella regione di transizione (1.3 ≤ |η| ≤ 1.65), la geometria molto

complessa del campo magnetico genera disomogeneità nel potere di deflessione, che vengono corrette da un apposito algoritmo.

Le richieste fin qui elencate sono soddisfatte, nel modo più efficiente ed

economico, dalla seguente scelta per i rivelatori (si confronti la Figura 1.12):

• RPC (Resistive Plate Chambers) nel barrel (|η| ≤ 1.05),

• TGC (Thin Gap Chambers) negli end-cap (1.05 ≤ |η| ≤ 2.4).

L’RPC (Figura 1.11) è un rivelatore a elettrodi piani paralleli. Il gas è

contenuto tra due piastre resistive, che sono tenute parallele a una distanza

di 2 mm da spaziatori in policarbonato. Tra le piastre è applicato un campo

elettrico costante ed uniforme (4.9 kV/mm); esse sono rivestite esternamente

da uno strato di grafite, la cui alta resistività (ρ ∼ 100 kΩ) permette alla

tensione di distribuirsi uniformemente, senza creare una gabbia di Faraday

che bloccherebbe la trasmissione del segnale.

Il segnale è letto capacitativamente da un piano di strisce metalliche posizionate sulla faccia esterna delle piastre.

Il campo elettrico applicato produce la valanga, moltiplicando gli elettroni e gli ioni primari generati per ionizzazione dalla traccia carica primaria.

16

1.2. L’ESPERIMENTO ATLAS

Figura 1.11: Sezione di una camera RPC.

Gli elettroni driftano verso l’anodo, e il loro numero cresce, per interazioni

secondarie con gli elettroni del mezzo, secondo la legge:

R

N = n0 e

dx α(x)x

dove l’integrale è effettuato sul tratto percorso. α è il primo coefficiente di

Townsend, ed è costante se durante lo sviluppo della valanga il campo elettrico resta uniforme, ovvero se la carica spaziale cosı̀ formatasi non è tanto

intensa da deformarlo. Per molteplicità N/n0 maggiori di una certa soglia

(pari a ∼ 106 per i gas nobili) la valanga diventa saturata, cioé la sua crescita

è rallentata da effetti di carica spaziale.

Il regime di valanga permette agli RPC di ATLAS di mantenere un’alta efficienza anche in presenza di flussi elevati di particelle, come quelli aspettati

nello spettrometro nella fase di alta luminosità di LHC.

La miscela di gas utilizzata è C2 H2 F4 /C4 H10 /SF6 , secondo i rapporti 94.7/5/0.3.

La componente principale è un gas elettronegativo, con alta ionizzazione primaria, ma ridotto cammino libero medio λ per la cattura degli elettroni, in

modo da contenerne la moltiplicazione e restare nel regime di valanga.

Un idrocarburo come l’Isobutano è quello che serve invece per assorbire i

fotoni prodotti dalla ricombinazione degli elettroni con gli ioni, evitando che

questi fotoni diano origine a fotoionizzazione e quindi allo sviluppo laterale

della valanga.

Una piccola quantità di SF6 , infine, estende di molto la regione in cui si può

lavorare in regime di valanga senza rischio di transire allo streamer: alla tensione nominale, un segnale largo 5 ns è generato in regime di streamer con

1.2. L’ESPERIMENTO ATLAS

17

probabilità minore dell’1%.

La risoluzione spaziale che ne risulta è dell’ordine del cm, quella temporale

dell’ordine del ns.

Figura 1.12: Trigger di precisione: camere RPC e TGC [10].

Come vediamo in Figura 1.12, gli RPC sono disposti nel barrel, in tre stazioni:

gli strati RPC1 e RPC2 sono inframmezzati da un MDT, mentre RPC3 è

situato al di sopra (o al di sotto, a seconda della camera) del rispettivo MDT.

Ogni stazione fornisce due misure indipendenti, in η e in φ, per un totale di

sei punti, tra i quali si possono stabilire coincidenze veloci. La stazione

intermedia, RPC2, è presa come riferimento: si traccia la linea retta tra

punto di interazione e hit della traccia sulla camera RPC2 (traiettoria ideale

per particelle di momento infinito), e si misura la deviazione della traiettoria

ricostruita da quella ideale. La ricostruzione viene fatta tramite le misure

nelle stazioni 2 e 1 per i muoni a basso pT , e nelle stazioni 2 e 3 per quelli ad

alto pT .

Per le camere TGC, la stazione di riferimento è TGC3, la più esterna delle

quattro(2 ), come si può vedere ancora in Figura 1.12. Le TGC sono disposte

negli end-cap; operano secondo lo stesso principio delle camere proporzionali

a multifilo, assicurando buona risoluzione temporale e spaziale (quest’ultima

determinata principalmente dalla granularità dei canali di lettura).

La differenza rispetto alle camere a multifilo tradizionali, è che la distanza

2

La camera aggiunta in vicinanza dello strato più interno di tracciamento (TGCI) è

necessaria, a causa dell’intensità del fondo, per ridurre il rischio di false coincidenze, come

quelle ad opera degli elettroni creati dalla conversione dei fotoni e spiraleggianti nel campo

magnetico.

18 1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI

anodo-anodo è maggiore della distanza anodo-catodo; la distanza tra i fili

d’altronde è abbastanza piccola da giustificare l’ottima risoluzione in tempo

(i segnali arrivano entro 25 ns col 99% di probabilità).

Le camere TGC sono fatte operare in regime di valanga quasi-saturata,

con un guadagno di 3 × 105 ottenuto tramite la miscela di gas CO2 /n-C5 H12

(in proporzioni 55/45). Oltre che al trigger, le camere Thin Gap servono alla

misura della coordinata azimutale.

1.3

Ricostruzione e identificazione dei muoni

Come abbiamo visto nella Sezione precedente, la misura dei muoni è una

combinazione dei contributi dello spettrometro e dell’Inner Detector.

Lo spettrometro fornisce la misura più accurata ad alti impulsi trasversi (fino

a 3 TeV), mentre l’Inner Detector lo supplementa a impulsi bassi e medi,

pT ≤ 30 GeV; lo spettrometro serve anche al trigger per |η| < 2.5 e per un

ampio spettro di energie.

Le tracce dello spettrometro sono identificate nelle stazioni più interne, poi

propagate all’indietro fino al punto di interazione, correggendo l’impulso per

la perdita di energia nei calorimetri e nell’Inner Detector.

Risoluzione in pT e perdite di energia

Si definiscono “muoni stand-alone” quelli che vengono ricostruiti usando solo

la traccia nello spettrometro, “muoni combinati” quelli a cui si può associare

anche una traccia nell’ID. Per questi ultimi, l’accettanza geometrica da considerare è quella dell’Inner Detector (|η| < 2.4).

L’utilizzo dei muoni combinati migliora in modo sostanziale la risoluzione

per impulsi sotto i 100 GeV, e permette di identificare i muoni prodotti nei

calorimetri, come quelli dai decadimenti in volo di π e K, poiché essi sono

presenti nello spettrometro ma non nell’ID.

Come già accennato, una traccia ad alto pT tipicamente attraversa tutte e

tre le stazioni del rivelatore, con una misura contemporanea di η e φ, permettendo una risoluzione migliore di 50 µm. In Figura 1.13(a) mostriamo il

numero di stazioni attraversate da una traccia, in funzione della pseudorapidità e dell’angolo azimutale; la risoluzione e l’efficienza di ricostruzione sono

degradate nel caso in cui una o più stazioni non forniscano la misura.

Vediamo in particolare la diminuzione centrata intorno a |η| ≈ 1.2, che è

la regione di transizione barrel/end-cap (nella quale non saranno presenti

camere a muoni nella prima fase dell’esperimento), mentre per |η| ≤ 0.1 non

sono possibili misure a causa della presenza di cavi e strutture di servizio.

1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI 19

(a) Numero

delle

stazioni

MDT+CSC

attraversate

da

una traccia, in funzione di η e φ

[10].

(b) Contributi alla risoluzione in impulso trasverso per i muoni ricostruiti nello

spettrometro [10].

Figura 1.13

La Figura 1.13(b) mostra i diversi contributi alla risoluzione in momento

trasverso per i muoni ricostruiti nello spettrometro, per |η| ≈ 1.5.

A basso pT , la risoluzione è dominata dalle fluttuazioni nella perdita di energia dei muoni nel materiale precedente lo spettrometro; a medio pT è importante l’effetto complessivo dello scattering multiplo; per pT > 300 GeV,

infine, la risoluzione dipende fortemente dalle caratteristiche del rivelatore,

quali allineamento, calibrazione e risoluzione nella misura del singolo hit.

Per quanto riguarda la perdita di energia, notiamo che lo spessore di

materiale attraversato da un muone prima di raggiungere lo spettrometro, è

maggiore di 100 lunghezze di radiazione (X0 ), e in questo percorso i muoni

subiscono deflessioni successive, dovute allo scattering multiplo coulombiano.

La deflessione totale è ben approssimata da una distribuzione gaussiana,

centrata in zero.

La perdita di energia, invece, non è gaussiana; per muoni relativistici, essa

avviene principalmente per via elettromagnetica: ionizzazione, produzione

di coppie e+ e− e bremsstrahlung (le ultime due note collettivamente come

perdite radiative).

Per p . 100 GeV, domina la ionizzazione del mezzo, descritta dall’equazione

di Bethe-Bloch [23] per la generica particella di carica ze e velocità βc:

4π nz 2

dE

=

−

dx

me c2 β 2

µ

e2

4πε0

¶2 · µ

¶

¸

2me c2 β 2

2

ln

−β

I(1 − β 2 )

(1.3)

20 1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI

dove n è la densità di elettroni nel mezzo, e I è il potenziale di eccitazione medio. Per quanto riguarda le perdite radiative, esse possono diventare

dominanti sulla ionizzazione già intorno ai 10 GeV, se i muoni attraversano

materiali ad alto Z. Non sono descrivibili in forma chiusa; l’approssimazione

più usata è quella di Bethe-Heitler.

Le fluttuazioni in dE/dx per ionizzazione in strati sottili di materiale,

seguono la distribuzione di Landau. All’aumentare dell’energia, la coda della

distribuzione si allarga lentamente, rendendo la curva sempre più asimmetrica. Questo si può vedere in Figura 1.14, dove abbiamo la distribuzione

dell’energia persa dai muoni che viaggiano tra la beam-pipe e l’uscita dai

calorimetri, per pT = 10 GeV a sinistra e pT = 1 TeV a destra.

Figura 1.14: Energia persa dai muoni che viaggiano dalla beam-pipe al

calorimetro elettromagnetico, per: (a) pT = 10 GeV, (b) pT = 1 TeV. [10].

Per impulsi nel range 0.5 GeV . pT . 30 GeV, il tracciamento sfrutta

le tracce lasciate nell’Inner Detector. Data la grande quantità di materiale

presente nell’ID, l’efficienza resta però limitata.

In conclusione, per muoni isolati ad alto pT nel barrel, ci si attende una

risoluzione in momento di σ(1/pT ) = 0.34 TeV−1 [59] e una risoluzione in

parametro d’impatto di σ(d0 ) = 10 µm [10].

Efficienza di ricostruzione

L’alta frequenza degli eventi pp → Z → µµ + X ad LHC (più di 108 eventi

all’anno nella fase di alta luminosità) permette di usare questi processi per

stimare l’efficienza di ricostruzione e di trigger dell’intero esperimento.

In Figura 1.15(a) vediamo l’efficienza di ricostruzione per muoni isolati in

funzione della pseudorapidità, per impulsi trasversi di 1, 5 e 100 GeV. Aumentando l’energia del muone, l’efficienza diventa maggiore e più stabile in

funzione di η.

1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI 21

Figura 1.15: Efficienza di ricostruzione in funzione di |η|: (a) per muoni di

impulsi trasversi crescenti, (b) per muoni, pioni ed elettroni di pT = 5 GeV. [10].

In Figura 1.15(b) confrontiamo invece l’efficienza di ricostruzione dei muoni

con quella di pioni ed elettroni, per pT = 5 GeV. Per i pioni dobbiamo considerare l’effetto delle interazioni adroniche, che aumentano in funzione del

materiale presente nell’Inner Detector; gli elettroni, a causa della loro massa leggera, sono molto più soggetti alla bremsstrahlung rispetto ai muoni, e

anche la loro distribuzione riflette la presenza del materiale.

La carica di muoni ed elettroni sarà misurata nell’Inner Detector su tutto

il range di accettanza e per impulsi fino al TeV, con una probabilità di misidentificazione minore di pochi percento. Nel barrel, in particolare, questa

efficienza è maggiore del 98%, e per alti pT diventa maggiore del 99.5% oltre

che praticamente indipendente da η; per pioni ed elettroni invece l’efficienza

di identificazione dipende da η, fluttuando tra 70% e 95%.

Efficienza di trigger

Per stimare l’efficienza di trigger, si usa il metodo Tag & Probe [59]. Gli

eventi sono triggerati richiedendo un leptone ad alto pT (il tag), e contemporaneamente cercando un secondo leptone (probe) che abbia la corrispondenza

con un leptone ricostruito o triggerato, e tale che la massa invariante della

coppia stia all’interno di una data finestra intorno a MZ .

In Figura 1.16 vediamo l’efficienza di identificazione e di trigger, per un

campione simulato di Z → µ+ µ− corrispondente a 50 pb−1 . L’istanza di

trigger in questo caso è la presenza di almeno un muone isolato con pT >

20 GeV (mu20). La verità Monte Carlo a cui ci si riferisce nella Figura è quella

ottenuta simulando i soli muoni combinati. Tag & Probe e simulazione Monte

22 1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI

Figura 1.16: Efficienza di identificazione dei muoni da Z → µ+ µ− col metodo

Tag & Probe, a confronto con la verità Monte Carlo. La luminosità integrata è

50 pb−1 , l’istanza di trigger è mu20 [59].

Carlo sono in ottimo accordo; in particolare tutte le serie di punti presentano

la rapida caduta di efficienza nelle zone morte in η.

Energia trasversa mancante

La misura dell’energia trasversa mancante (ETmiss o E/T) è fondamentale per

la rivelazione di W ; è inoltre la segnatura chiave per la misura della massa

del top (dagli eventi tt in cui uno dei due quark decade semileptonicamente),

e per l’osservazione degli eventi supersimmetrici ed esotici.

Una questione importante da considerare per la misura di ETmiss , è la copertura limitata del rivelatore per grandi pseudorapidità, la risoluzione finita, la

presenza di regioni morte e le diverse fonti di rumore che producono E/TFake ,

delle quali la principale è il rumore del calorimetro.

Una variabile che caratterizza l’energia mancante, è la linearità di E/T

ricostruita in funzione di E/T vera (E/TTrue ):

Linearità = (E/TTrue − E/T)/E/TTrue

(1.4)

dove E/TTrue è definita come la somma di tutte le particelle stabili non interagenti nello stato finale (neutrini e LSP supersimmetriche). La linearità

è minore dell’ 1% per tutti i processi analizzati in [59], una volta che le

celle del calorimetro sono state calibrate globalmente e che si è tenuto conto dell’efficienza di identificazione dei muoni e delle correzioni del criostato

(calibrazione “rifinita”).

True

La risoluzione è stimata dalla larghezza della distribuzione E/x,y−E/x,y

, fittata

1.3. RICOSTRUZIONE E IDENTIFICAZIONE DEI MUONI 23

P

Figura 1.17: Risoluzione di E/T in funzione di

ET , per valori bassi e medi (a

sinistra) e per valori maggiori (a destra). Le curve corrispondono ai best fit. [59].

con una Gaussiana per P

estrarre la deviazione standard σ. La Figura 1.17

mostra σ in funzione di

E/T dopo l’applicazione della calibrazione rifinita.

L’andamento è stocastico, con deviazioni per bassi valori di energia mancante,

dove si sente l’effetto del rumore, e per valori molto alti,

P dove domina la

risoluzione intrinseca del calorimetro. Per p

20PGeV <

ET < 2 TeV la

ET , in cui il parametro a

deviazione standard è fittata con σ = a ·

quantifica la risoluzione: esso varia tra 0.53 (Figura 1.17 a sinistra) e 0.57 (a

destra).

24

Capitolo 2

La Fisica ad LHC

2.1

Il Modello Standard

Il Modello Standard come teoria di gauge

Le forze fondamentali che agiscono tra le particelle elementari − la forza

forte, la forza debole e la forza elettromagnetica − sono tutte esprimibili

tramite teorie di gauge(1 ) [22], [43], [37].

In una teoria di gauge, i campi sono descritti da rappresentazioni di un gruppo

di simmetria; richiedendo che la Lagrangiana della teoria sia invariante sotto

trasformazioni locali arbitrarie dei campi, si genera l’interazione tra i campi

stessi, mediata dai bosoni di gauge.

In particolare, l’interazione elettrodebole − che unifica l’interazione elettromagnetica e quella debole a grandi energie [69] − è invariante sotto il

gruppo SU(2)L × U(1)Y . Il pedice L indica che l’interazione elettrodebole

agisce solo tra fermioni left-handed (e antifermioni right-handed) − per questo è un’interazione di tipo chirale − mentre Y denota la carica elettrodebole,

o ipercarica, una combinazione della carica elettrica e della terza componente

dell’Isospin debole, come vedremo più avanti (equazione (2.26)).

L’interazione forte è invece simmetrica sotto trasformazioni del gruppo SU(3)C ,

dove C indica la carica di colore. Ci sono tre colori per ogni flavour di quark

(indicati convenzionalmente come rosso, verde e blu).

Il Modello Standard delle particelle elementari è dunque descritto da una

1

Abbiamo volontariamente trascurato la forza di gravità, che è invariante sotto trasformazioni locali delle coordinate, e che al momento non è descritta coerentemente nell’ambito

di una teoria quantistica. Si ipotizza l’esistenza di un bosone mediatore a massa nulla e

spin 2, il gravitone, che finora è sfuggito a tutti i tentativi di rivelazione.

26

2.1. IL MODELLO STANDARD

Lagrangiana invariante sotto il gruppo di gauge composto:

GMS = SU(3)C × SU(2)L × U(1)Y .

I bosoni mediatori delle tre forze fondamentali sono N 2 − 1 come i generatori

dei rispettivi gruppi, dove N è la dimensionalità del gruppo, e hanno tutti

spin 1: gli otto gluoni dell’interazione forte, i tre bosoni massivi dell’interazione debole (W ± e Z), il fotone di quella elettromagnetica.

I gruppi SU(2)L e SU(3)C non sono abeliani: i loro generatori non commutano, e questo origina vertici di mutua interazione tra i rispettivi bosoni

mediatori.

I campi fondamentali attualmente noti sono di due tipi: i leptoni, che

non sono soggetti alla forza forte, e i quark. Entrambi sono fermioni −

obbediscono cioè alla statistica di Fermi-Dirac − di spin 1/2.

I quark non sono mai stati osservati come particelle libere, ma sempre come

costituenti degli adroni ; i leptoni sono in generale più leggeri degli adroni e

non formano vicendevolmente stati legati. L’ipotesi è che gli adroni esistano

solo come singoletti di colore, e che i gluoni siano costituiti da un colore e da

un anticolore.

Sia i leptoni sia i quark si presentano in Natura in tre generazioni: la seconda e

la terza sono repliche pesanti della prima; i bosoni vettori infatti si accoppiano

alle diverse generazioni secondo lo stesso meccanismo.

I quark autostati dell’interazione elettrodebole non coincidono con gli

autostati di massa che prendono parte all’interazione forte, ma piuttosto ne

sono una combinazione lineare. Questa idea, proposta da Cabibbo nel 1963

[7], apre la strada al modello attuale per il mixing tra i flavour.

Consideriamo i due quark leggeri, u e d: essi possono essere sistemati in un

doppietto di isospin debole nel modo seguente:

¶

µ ¶ µ

u

u

=

(2.1)

d0

d cos θC + s sin θC

dove θC è l’angolo di mixing di Cabibbo. Mentre il quark d partecipa all’interazione elettrodebole, il suo corrispondente “ruotato” d0 partecipa a quella

forte. Generalizzando questa idea, si giunge alla matrice 3 × 3 di Cabibbo,

Kobayashi e Maskawa (CKM) [30], che descrive il mixing per i quark di tipo

down delle tre generazioni:

0

d

Vud Vus Vub

d

s0 = Vcd Vcs Vcb s .

(2.2)

0

Vtd Vts Vtb

b

b

2.1. IL MODELLO STANDARD

27

L’elemento di matrice Vud , per esempio, quantifica l’accoppiamento di u e d

nel processo d → u + W − .

La matrice CKM è unitaria, con (N − 1)2 parametri liberi, dove N = 3 è il

numero delle generazioni. Di questi quattro parametri, se ne assumono tre

reali (θ12 , θ23 e θ13 ), e si prende una fase immaginaria, δ13 , responsabile della

violazione di CP osservata nelle interazioni deboli.

I valori sulla diagonale principale sono molto maggiori degli altri, e culminano

in |Vtb | = 0.9990 ± 0.0002 [2], che è anche l’elemento noto con più precisione.

Il bosone di Higgs

La richiesta di invarianza di gauge per l’interazione elettrodebole, non permette l’inserimento nella Lagrangiana di termini di massa per i bosoni vettori,

che tuttavia sono osservati sperimentalmente essere massivi.

Per ovviare a questa difficoltà, senza rompere esplicitamente la simmetria

di gauge, è necessario introdurre nel Modello Standard un ulteriore grado di

libertà. Si tratta di un campo scalare complesso, organizzato in un doppietto

di isospin debole:

µ

¶

φa (x)

Φ(x) =

(2.3)

φb (x)

soggetto al potenziale gauge invariante:

V (Φ) = µ2 (Φ† Φ) + λ (Φ† Φ)2 .

(2.4)

Figura 2.1: Potenziale del bosone di Higgs per λ positivi, con µ2 > 0 e µ2 < 0.

Innazitutto dobbiamo richiedere λ > 0 se vogliamo che il potenziale V (Φ) sia

confinante. Dopodiché, come mostra la Figura 2.1, esistono due possibilità:

il caso banale per cui µ2 > 0 − il potenziale presenta un minimo assoluto in

28

2.2. L’INTERAZIONE ELETTRODEBOLE

Φ = 0 − ed il caso interessante, µ2 < 0, nel quale si manifesta il fenomeno

della rottura spontanea della simmetria di gauge.

Per µ2 < 0, infatti, gli stati di minima energia del potenziale (±υ in Figura

2.1) sono degeneri:

|Φ0 (x)|2 = |φ0a |2 + |φ0b |2 =

−µ2

>0

2λ

(2.5)

e il sistema “sceglierà” uno degli infiniti minimi equivalenti, che per semplicità

definiamo essere:

r

υ

−µ2

h0|Φ0 (x)|0i = √

con υ =

∈ R.

(2.6)

λ

2

Lo stato di minima energia rompe dunque la simmetria di gauge. Possiamo

parametrizzare il campo Φ(x) intorno a questo minimo, ed eliminare i gradi di

libertà aggiuntivi tramite l’imposizione della gauge unitaria, in cui il campo

si riduce a:

¶

µ

0

1

.

(2.7)

Φ(x) = √

2 υ + σ(x)

Il campo reale σ descrive le oscillazioni di Φ(x) intorno al minimo, ed è detto

bosone di Higgs.

I numeri quantici del campo Φ(x) (iperacarica e isospin debole) sono scelti

in modo tale che il potenziale a cui esso è soggetto non modifichi il settore

U(1)em , cosı̀ da preservare la massa nulla del fotone.

Come vedremo nella prossima Sezione, il medesimo meccanismo − l’accoppiamento al bosone di Higgs − fornisce la massa a tutte le particelle

elementari; per i fermioni questo avviene tramite termini gauge invarianti,

detti termini di Yukawa.

2.2

L’interazione elettrodebole

Il Modello Elettodebole venne sviluppato negli anni ’60 da Glashow, Salam e

Weinberg [69]: esso teorizza che l’interazione elettromagnetica e l’interazione

debole, che a bassa energia (Q ≈ 1 GeV) hanno accoppiamenti diversi per

quattro ordini di grandezza, siano espressione di un’unica forza che si manifesta a energie ≥ 246 GeV, la scala di rottura spontanea della simmetria

elettrodebole (equazione (2.6)).

Possiamo distinguere tre tipi di interazione elettrodebole:

1. Decadimenti puramente leptonici: i partecipanti sono solo i leptoni, come nel decadimento del µ: µ− −→ e− + ν e + νµ .

2.2. L’INTERAZIONE ELETTRODEBOLE

29

2. Decadimenti semileptonici: vi partecipano sia i leptoni sia gli adroni, come nel decadimento β, che permise la prima osservazione dell’interazione debole e l’ipotesi dell’esistenza del neutrino: n −→ p + e− +

νe .

3. Decadimenti non leptonici: i partecipanti sono tutti adroni, come

nel decadimento delle particelle strane: Λ −→ p + π − .

Vogliamo adesso scrivere la Lagrangiana dell’interazione elettrodebole.

Per farlo, partiamo da quella della QED (Quantum ElectroDynamics):

X

1

µ

LQED = − F µν Fµν +

ψ l (x)(i∂

/ − m) ψl (x) − Jem

(x) Aµ (x)

4

l=e,µ,τ

dove:

µ

Jem

(x) = −e

X

ψ l (x) γ µ ψl (x)

(2.8)

(2.9)

l

è la quadricorrente, sommata sui sapori leptonici l, con e > 0, mentre F µν è

il tensore del campo elettromagnetico:

F µν = ∂ µ Aν − ∂ ν Aµ .

(2.10)

Caratteristica fondamentale della LQED è la conservazione della Parità, in

quanto questa Lagrangiana è costituita da combinazioni scalari di spinori e

matrici γ µ .

Invece, per quanto riguarda l’interazione debole, si osserva sperimentalmente che essa non conserva la Parità: questo suggerisce di costruire la

quadricorrente debole come una combinazione del tipo:

X

J µ (x) = gW

ψ l (x) γ µ (1 − γ 5 ) ψνl (x)

(2.11)

l

dove gW è la costante di accoppiamento, e al campo del leptone carico, ψl ,

abbiamo associato quello del neutrino, ψνl . La matrice γ 5 = iγ 0 γ 1 γ 2 γ 3 ,

anticommuta con tutte le γ µ , {γ µ , γ 5 } = 0.

Al contrario di quanto succede per la QED, la corrente debole (2.11) non

è un operatore Hermitiano, J µ 6= J µ† . Essa è conosciuta storicamente come

V − A perche’ al suo interno possiamo distinguere due termini:

X

X

ψ l (x)γ µ ψνl (x) − gW

ψ l (x)γ µ γ 5 ψνl (x)

J µ (x) = JVµ (x) − JAµ (x) = gW

l

l

(2.12)

30

2.2. L’INTERAZIONE ELETTRODEBOLE

dove V ed A sono rispettivamente la corrente vettoriale della QED e la

corrente assiale. Mentre la componente spaziale della corrente vettoriale

cambia segno sotto Parità, la corrente assiale resta identica a se stessa.

Data la struttura V −A per la corrente, il modo più semplice per costruire

la Lagrangiana d’interazione è il seguente:

LI = Wµ† (x)J µ (x) + Jµ† (x)W µ (x) .

(2.13)

Il fatto che la corrente sia complessa, rende necessaria l’introduzione del

campo di gauge W µ (x), anch’esso complesso e di conseguenza elettricamente

carico; inoltre W µ non è hermitiano, W µ 6= W µ † .

Oltre alla Lagrangiana di interazione (2.13), dobbiamo scrivere la Lagrangiana leptonica libera, nell’approssimazione di massa nulla:

Lψ0 = i

X

[ψ l (x)∂

/ ψνl (x)] .

/ ψl (x) + ψ νl (x)∂

(2.14)

l=e,µ,τ

Ora definiamo i proiettori di elicità, Left e Right, in termini della matrice γ 5 :

1

1

PL = (1 − γ 5 ) e PR = (1 + γ 5 )

2

2

(2.15)

grazie ai quali possiamo scrivere le proiezioni Left e Right degli spinori:

ψlL,R ≡ PL,R ψl = 12 (1 ∓ γ 5 ) ψl

L,R

ψl

≡

(ψlL,R )†

0

γ =

1

2

ψl† (1

5†

(2.16)

0

∓ γ ) γ = ψ l PR,L

e lo stesso vale per i neutrini. Inserendo le espressioni (2.16) nella (2.14), e

L,R

considerando che i termini misti del tipo ψ i /∂ ψiR,L , con i = l, νl , risultano

nulli in quanto contengono i prodotti PL PR = PR PL = 0, si ricava la seguente

espressione per la Lagrangiana libera:

L

R

L

R

Lψ0 = i [ψ l /∂ ψlL + ψ l /∂ ψlR + ψ νl /∂ ψνLl + ψ νl /∂ ψνRl ] .

(2.17)

Torniamo alla corrente V −A: in essa possiamo adesso riconoscere la presenza

del proiettore Left PL :

X

X

ψ l γ µ PL ψνl = 2gW

ψ l γ µ ψνLl .

(2.18)

J µ = 2gW

l

l

Il campo spinoriale ψνLl è lineare nella distruzione di neutrini Left e nella

creazione di antineutrini Right: ciò significa che solo queste particelle par-

2.2. L’INTERAZIONE ELETTRODEBOLE

31

teciperanno all’interazione debole. Lo stesso vale per i leptoni carichi, in

quanto la (2.11) si può scrivere anche:

X

X

X L

J µ = 2gW

ψ l γ µ PL ψνl = 2gW

ψ l γ µ PL PL ψνl = 2gW

ψ l γ µ ψνLl

l

l

l

da cui segue che all’interazione debole partecipano solo leptoni l

antileptoni l+ Right. Adesso definiamo l’isospinore leptonico:

µ L ¶

ψνl (x)

L

L

L

L

=⇒ Ψl (x) = (ψ νl (x) ψ l (x))

Ψl (x) ≡

L

ψl (x)

−

(2.19)

Left e

(2.20)

in termini del quale la Lagrangiana libera (2.14) diventa:

L

R

R

Lψ0 = i [Ψl /∂ ΨLl + ψ l /∂ ψlR + ψ νl /∂ ψνRl ] .

(2.21)

Trasformazione di gauge SU (2)L

Richiediamo che L0 sia invariante sotto una trasformazione di gauge SU (2)L

locale, dove il pedice L sottolinea che essa agisce solo sui campi Left:

·

¸

i

L

L

0

Ψl −→ Ψ l = exp

g αi (x) σi ΨLl

2

+ trasf. spinori aggiunti (2.22)

R

ψlR −→ ψ 0 l = ψlR

R

R

ψνl −→ ψ 0 νl = ψνRl

dove le αi (x) con i = 1, 2, 3 sono tre funzioni reali e derivabili dello spazio

tempo e g è la costante di accoppiamento reale. A questa trasformazione si

associa una carica conservata vettoriale, l’isospin debole I W . In particolare,

la terza componente di questa carica vale:

µ

¶ µ L¶

Z

Z

ψνl

1

1

1 0

3

L† L†

W

=

d x (ψνl ψl )

d3 x (ψνL†l ψνLl − ψlL† ψlL ) .

I3 =

0 −1

2

2

ψlL

(2.23)

Notiamo che I3W contiene solo operatori Left, carichi e non. Ne segue che il

neutrino Left e il leptone carico Left hanno entrambi modulo di isopin debole

I W = 1/2, quindi formano un doppietto di isospin debole, con autovalori

I3W = ±1/2 rispettivamente.

I leptoni Right invece sono neutri sotto SU (2)L , come si deduce dalle (2.22),

ovvero hanno I W = 0 e si comportano come singoletti di isospin debole.

32

2.2. L’INTERAZIONE ELETTRODEBOLE

Sotto le trasformazioni (2.22), la Lagrangiana (2.21) non è più invariante;

per ristabilire l’invarianza dobbiamo sostituire la derivata ordinaria con una

derivata covariante cosı̀ costruita:

∂ µ −→ F µ = ∂ µ + igI W σi Wiµ (x)

(2.24)

dove le σi sono le matrici di Pauli, i = 1, 2, 3, mentre Wiµ (x) sono tre campi

vettoriali reali.

Trasformazione di gauge U (1)Y

Analogamente a quanto fatto per SU (2)L , richiediamo che la Lagrangiana

leptonica libera (2.21) sia invariante sotto la trasformazione U (1) locale:

L,R

0 L,R

ig 0 Y f (x) L,R

ψi

ψi −→ ψ i = e

L,R

ψi

−→ ψ

0 L,R

i

−ig 0 Y f (x)

=e

con i = l, νl

L,R

ψi

(2.25)

dove g 0 è un’altra costante reale e f (x) è una funzione anch’essa reale e

derivabile. La carica conservata adesso è uno scalare, e si chiama ipercarica. In funzione della carica elettrica in unità di e, e della terza componente dell’isospin debole I3W , definiamo l’ipercarica Y secondo la relazione di

Gell-Mann - Nishijima:

Y = Q/e − I3W .

(2.26)

Sotto la trasformazione U (1) di ipercarica, la Lagrangiana libera non è invariante ed anche in questo caso si può ovviare al problema introducendo

la derivata covariante. La situazione è più semplice rispetto al caso SU (2),

infatti basta introdurre il campo vettoriale reale B µ (x), tale che:

∂ µ −→ GµY = ∂ µ + ig 0 Y B µ (x) .

(2.27)

Simmetria SU (2)L × U (1)Y

Introducendo la derivata covariante completa,

∂ µ −→ Dµ = ∂ µ + igI W σi Wiµ (x) + ig 0 Y B µ (x)

(2.28)

la Lagrangiana elettrodebole risulta invariante contemporaneamente sotto

le trasformazioni di gauge (2.22) e (2.25). Sostituiamo Dµ nell’espressione

(2.21) per la Lagrangiana, e otteniamo:

L

R

R

L = i [Ψl D

/ ΨLl + ψ νl D

/ ψνRl + ψ l D

/ ψlR ] .

(2.29)

2.2. L’INTERAZIONE ELETTRODEBOLE

33

In essa possiamo distinguere due termini:

L = Lψ0 + LψB

(2.30)

dove LψB descrive l’interazione tra i campi di materia ΨLl , ψlR e ψνRl e i bosoni

di gauge Wiµ (x) e B µ (x), mentre Lψ0 è il termine libero.

µ

Se ora ruotiamo i campi W1,2

in questo modo:

W1µ (x) − iW2µ (x)

√

W (x) =

2

µ

,

W1µ (x) + iW2µ (x)

√

W (x) =

2

µ†

(2.31)

otteniamo i campi fisici, non hermitiani, W µ e W µ† , che possiamo associare

ai bosoni vettori W ± .

Per quanto riguarda i due campi restanti, W3µ e B µ , li colleghiamo ai bosoni

vettori neutri, Z e γ, introducendo l’angolo di Weinberg θW attraverso la

seguente rotazione:

¶ µ µ¶

µ µ¶ µ

Z

W3

cos θW sin θW

=

.

(2.32)

µ

−

sin

θ

cos

θ

B

Aµ

W

W

Richiediamo che il campo elettromagnetico Aµ non si accoppi con la corrente di SU (2), e che il suo accoppiamento con la corrente elettromagnetica,

J(em)µ /e = JY µ + J3µ , sia pari a −1 in unità della carica elettrica, richieste

che risultano in:

g0

g sin θW = e , tan θW = .

(2.33)

g

Queste relazioni fondamentali collegano le costanti di accoppiamento g, g 0 ed

e con l’angolo di Weinberg.

Dobbiamo aggiungere alla 2.30 anche la Lagrangiana per i campi di gauge

liberi, ovvero i termini cinetici per Aµ , W µ , W µ† e Z µ :

1

1

LB = − Fµνi Fiµν − Bµν B µν .

4

4

(2.34)

Termini di Higgs e di Yukawa

La teoria cosı̀ formulata, è riassunta dalla Lagrangiana totale:

BB

LEW = Lψ0 + LψB + LB

0 +L

(2.35)

BB

sono rispettivamente il termine libero e il termine di autodove LB

0 e L

interazione per i bosoni di gauge.

Questa Lagrangiana descrive coerentemente sia le interazioni deboli che quel-

34

2.2. L’INTERAZIONE ELETTRODEBOLE

le elettromagnetiche, a patto che tutte le particelle siano prive di massa.

Questo discende dal fatto che termini del tipo:

ml ψ l (x)ψl (x),

m2Z Zµ (x)Z µ (x),

...

(2.36)

violerebbero l’invarianza di gauge, supposta fondamentale, e renderebbero la

teoria non rinormalizzabile. Questo problema si supera, come abbiamo visto

in Sezione 2.1, grazie al meccanismo di Higgs, che rompe spontaneamente

la simmetria elettrodebole. Viene dunque introdotta la Lagrangiana LH (x)

di Higgs, invariante sotto trasformazioni di gauge, composta dai seguenti

termini:

• LH

0 (x), che descrive il campo scalare reale σ(x) libero,

• LHB (x), che contiene l’interazione tra l’Higgs ed i bosoni di gauge,

• LHH (x), che è il termine di autointerazione del campo di Higgs,

• i termini di massa dei bosoni vettori, che vengono riassorbiti da LB

0.

Ci ritroviamo dunque con la seguente forma per la Lagrangiana elettrodebole:

BB

HB

+ LH

+ LHH .

LEW = Lψ0 + LψB + LB

0 +L

0 +L

(2.37)

Infine, per dare massa anche ai leptoni, dobbiamo introdurre i termini di

Yukawa, LY (x), che nella gauge unitaria possiamo dividere ancora una volta

in LLH (x), che descrive l’interazione tra i leptoni ed il bosone di Higgs, e nei

termini di massa per i leptoni. In definitiva, chiamando Lψ0 la Lagrangiana

leptonica libera completa dei termini di massa, siamo arrivati a scrivere la

Lagrangiana dell’interazione elettrodebole:

BB

HB

LEW = Lψ0 + LψB + LB

+ LH

+ LHH + LLH .

0 +L

0 +L

2.2.1

(2.38)