AL VIA IL PRIMO MASTER

PER INGEGNERI FORENSI

L’Università Federico II propone un corso unico in Europa

destinato ai professionisti che lavorano in ambito legale

Il programma include 1500 ore di lezione e inizia a gennaio 2009

di Nicola Augenti

“

Arriva in Europa

un nuovo professionista

in grado di coniugare

il Diritto e la Tecnica

come consulente

del giudice

o delle parti in causa

”

L’Ingegneria forense applica i principi

e i metodi specifici dell’Ingegneria alla

soluzione dei problemi tecnici in ambito

giudiziario. Per sua natura, essa coniuga l’Ingegneria con la Giurisprudenza,

ovvero la Tecnica con il Diritto. Al contrario di quanto è accaduto per la Medicina legale, già ampiamente riconosciuta dalla comunità scientifica e da quella

professionale, l’Ingegneria forense (che

potrebbe anche essere definita Ingegneria

legale) ha avuto pieno riconoscimento solamente una ventina d’anni fa negli Stati

Uniti d’America e muove appena i primi

passi in Europa.

L’Ingegnere forense è dunque quel

professionista che, in senso stretto, indaga sulle cause e sulle responsabilità di

un evento dannoso mentre, in senso lato,

opera come consulente tecnico d’ufficio

o di parte, in un procedimento giudiziario. Egli, pertanto, indaga sulle cause più

probabili per cui si è verificata una prestazione diversa da quella attesa e sulle

responsabilità connesse all’accaduto. Il

problema oggetto di indagine può essere

costituito da un dissesto, da un difetto,

da un danno o da un guasto verificatosi

per qualunque tipo di costruzione. Tale

disciplina interessa un po’ tutti i campi dell’Ingegneria: accanto al più noto

settore civile (rivolto ai dissesti, ai crolli,

all’estimo, all’edilizia), esiste un settore

industriale denso di attività forensi importantissime come, ad esempio, quelle

riguardanti l’ambito meccanico, quello

chimico e quello elettrico.

L’Ingegneria forense costituisce tema

molto noto nei Paesi anglosassoni: negli

Usa, in particolare, non solo la professione di Ingegnere forense risulta notevolmente diff usa ma, su sollecitazioni

delle società di assicurazioni e di talune

industrie, si sono sviluppati enti e associazioni che ne promuovono l’evoluzione

e la diff usione.

La materia, affidata per il passato

ad iniziative personali e riguardata alla stregua di arte, è stata recentemente

oggetto di un tentativo di codificazione,

con l’obiettivo di conferirle il lignaggio

di scienza. Nel contempo, una professione appannaggio per il passato di pochi

iniziati che si tramandavano massonicamente le regole del mestiere, diviene

oggetto di insegnamento universitario

per la formazione di nuove figure professionali altamente qualificate, non più

INGEGNERI Ordine di Napoli

5

autoreferenziate ma dotate di credenziali

obiettive e certificate.

In Europa e, segnatamente in Italia,

tale disciplina ha visto la luce solo da

poco tempo, proprio ad opera dell’università degli studi di Napoli “Federico

II” che, con decreto del rettore n. 2784

del 6 agosto 2008 ha istituito un master

di secondo livello in Ingegneria forense,

di cui è coordinatore il professor Nicola

Augenti.

Si tratta di un’iniziativa, unica in

Italia e in Europa, finalizzata a formare una nuova categoria professionale di

ingegneri, civili o industriali, altamente

specializzati nell’attività di Consulenza

tecnica per l’Autorità giudiziaria o di

Consulenza tecnica di Parte.

Il master avrà durata annuale e si conseguirà acquisendo 60 crediti formativi

universitari (Cfu), corrispondenti ad un

totale di 1.500 ore, di cui 408 ore dedicate

alla didattica frontale. Le lezioni saranno

impartite, in lingua italiana, per la durata

complessiva di 36 settimane (con inizio

nel mese di gennaio 2009 e termine entro

il mese di novembre 2009) presso il Dipartimento di Ingegneria strutturale (via

Claudio 21, Napoli), nei giorni di venerdì

e di sabato, rispettivamente con un impegno di otto ore e di quattro ore.

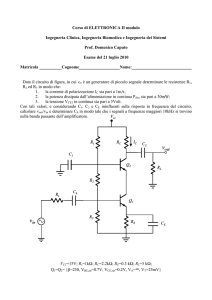

Il corso prevede lezioni impartite da

professori universitari delle Facoltà di Ingegneria o di Giurisprudenza e seminari

tenuti da magistrati o da personalità di

rilievo del mondo professionale.

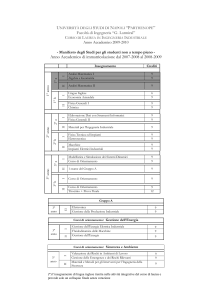

Il master si articolerà in tre periodi

distinti di attività didattiche.

Un primo periodo (per complessive

120 ore di didattica) sarà dedicato agli

insegnamenti giuridici di base, che tratteranno i fondamenti del Diritto civile,

del Diritto penale, del Diritto amministrativo, del Diritto processuale e del Diritto assicurativo. Tale periodo includerà

cinque moduli obbligatori, ciascuno dei

quali articolato in dodici lezioni della durata di 2 ore, che impegneranno dodici

settimane (dal mese di gennaio al mese

di aprile 2009).

Un secondo periodo (per complessive 144 ore di didattica) comprenderà

le attività specialistiche comuni ai due

settori di indirizzo in Ingegneria forense

civile e in Ingegneria forense industriale.

Esso includerà i seguenti insegnamenti:

Consulenza tecnica giudiziaria; Disse-

6

N. 5-6/2008 - PRIMO PIANO

sti e Crolli; Ingegneria della Sicurezza;

Incendi ed Esplosioni; Impiantistica industriale forense; Estimo forense. L’attività didattica si articolerà in sei moduli

obbligatori, ciascuno dei quali suddiviso

in dodici lezioni della durata di due ore,

che impegneranno dodici settimane (dal

mese di aprile al mese di luglio 2009).

Un terzo periodo contemplerà attività

(in parallelo) dedicate alle materie specifiche del settore di specializzazione scelto

e si articolerà in 144 ore complessive di

insegnamento comprendenti sei moduli

obbligatori, ciascuno dei quali suddiviso

in dodici lezioni della durata di due ore,

che impegneranno dodici settimane (dal

mese di settembre al mese di novembre

2009).

L’indirizzo in Ingegneria forense

civile comprenderà i seguenti insegnamenti: Prove e Monitoraggio strutturale;

Ingegneria geotecnica forense; Impianti

tecnici per l’Edilizia; Gestione dei Lavori;

Tecniche di Rilievo e Rappresentazione;

Ingegneria ambientale forense.

L’indirizzo in Ingegneria forense industriale prevede insegnamenti relativi

all’Ingegneria forense meccanica I e II,

all’Ingegneria forense chimica I e II, all’Ingegneria forense elettrica I e II.

A conclusione del master è prevista

l’elaborazione di una tesi di specializzazione la cui discussione avverrà entro il

mese di dicembre 2009.

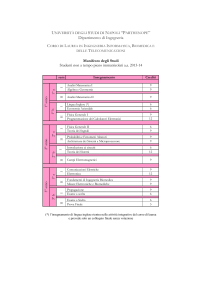

Per poter accedere al master occorre possedere uno dei seguenti titoli di

studio, conseguito entro i termini di

scadenza di presentazione delle domande: laurea di durata quinquennale

in Ingegneria (Edile, Civile, Ambiente

e Territorio, Aeronautica, Aerospaziale, Elettrotecnica, Meccanica, Navale,

Chimica e dei Materiali) oppure laurea

specialistica in Ingegneria (classi 4/S

Edile, 25/S Aerospaziale e astronautica,

27/S Chimica, 28/S Civile, 31/S Elettrica, 34/S Gestionale, 36/S Meccanica, 37/S

Navale, 38/S Ambiente e Territorio, 61/S

dei Materiali) oppure laurea quinquennale (nuovo ordinamento) in Ingegneria

Edile-Architettura (Classe 4/S) oppure

titolo equivalente rilasciato da università straniere. Al corso possono iscriversi

cittadini comunitari ed extracomunitari

(per questi ultimi è richiesto il regolare

permesso di soggiorno in Italia).

L’ammissione al master avverrà per

titoli. Qualora il numero delle domande

superi quello dei posti disponibili, è previsto anche un colloquio.

Il numero massimo di posti a disposizione per la frequenza del master è fissato

in 25 unità, mentre il numero minimo

di iscritti per l’attivazione è stabilito in

10 unità. È richiesta la frequenza obbligatoria a ciascun modulo didattico, con

una percentuale massima di assenze pari

al 20 per cento delle ore di attività, pena

l’esclusione.

La partecipazione al master è a titolo

oneroso. Il contributo di iscrizione ammonta ad € 2.600,00 da versare, per metà

all’atto dell’iscrizione e per l’altra metà

entro il 30 giugno 2009.

Il Dipartimento di Ingegneria strutturale, sede del master, è responsabile della

gestione amministrativa per il funzionamento del corso, mentre la procedura di

iscrizione rimane competenza dell’Ufficio segreteria studenti della Facoltà di

Ingegneria.

Il bando di concorso è in fase di preparazione e potrà essere consultato sul

sito www.dist.unina.it.

Gli interessati a ricevere ulteriori

informazioni potranno inviare un messaggio all’indirizzo di posta elettronica

[email protected] per essere

inseriti nella newsletter.

Obiettivo principale del nuovo master è, in definitiva, quello di far nascere

una nuova figura professionale specificamente qualificata. Ovviamente, accanto

all’informazione tecnico-scientifica e

giuridica, dovrà trovare posto la formazione morale ed etica dei futuri ingegneri

forensi: il rigore, l’equilibrio, l’imparzialità di giudizio e un comportamento eticamente corretto costituiscono, infatti,

requisiti essenziali per l’esercizio di tale

attività.

L’Ingegneria forense è materia, attualmente, poco nota al di fuori dell’ambito

professionale, non appartenendo al novero degli insegnamenti tradizionali ed

essendo trasversale rispetto a discipline

di differente estrazione. A fronte di ciò,

però, sono notevoli le prospettive di inserimento nel mondo del lavoro che tale

attività può off rire: basti pensare che

negli Stati Uniti d’America l’Ingegnere

forense percepisce compensi specifici di

gran lunga superiori a quelli di tutti gli

altri ingegneri.

ANCHE I BIT CHIEDONO

IL RISK MANAGEMENT

In tutte le organizzazioni cresce la tutela dei sistemi informatici

contro le intrusioni fraudolente o gli incidenti fortuiti.

Le norme più recenti sono sia nella Iso 27001 che nelle leggi

di Mattia Siciliano,

Guido Milana

e Nicola Paolino

“

Ciò che è lecito

ha poco sapore:

ha più gusto ciò

che è proibito

(Ovidio)

”

“

I “vecchi” hacker volevano

solo mostrarsi bravi

o sbeffeggiare le aziende.

I nuovi reati informatici

puntano invece

a realizzare truffe

e a provocare danni

”

8

N. 5-6/2008 - SICUREZZA

Nelle applicazioni della tecnologia della comunicazione e dell’informazione

(Ict = Information and Communication

Technology) la sicurezza sta sempre più

assumendo un ruolo centrale. Il valore crescente delle informazioni che le

reti informatiche e di comunicazione

trasportano e la grande diff usione di

internet e delle tecnologie digitali, portano infatti ad aff rontare le tematiche

di sicurezza in modo sistematico e con

ingenti investimenti da parte dei produttori di soft ware e hardware.

Tale scelta si giustifica con l’opportunità di proteggere preventivamente il

valore delle informazioni ma anche con

il notevole aumento degli attacchi informatici, la cui tipologia è andata peraltro

mutando negli ultimi anni.

Al fenomeno degli hacker, generalmente interessati, più che a conseguire

benefici personali, a mostrare la debolezza della rete e delle sue applicazioni o a

procurare danni d’immagine a organizzazioni ben note di cui non condividono

l’operato, si è affiancata l’esecuzione di

veri e propri crimini informatici da parte

di soggetti che sfruttano le vulnerabilità

della rete per attuare truffe o per commettere altri generi di reati che finiscono

per penalizzare, talvolta gravemente, organizzazioni pubbliche e private, nonché

i singoli cittadini (si pensi ad esempio

agli illeciti addebiti sui conti correnti

bancari di soggetti in possesso di carte

di credito, i cui dati sono stati intercettati

via rete).

L’interesse verso i criteri e le metodologie di valutazione della sicurezza,

nato inizialmente in ambito militare e

governativo, si è ormai diff uso anche

al di fuori dei settori in cui aveva avuto

origine. Se in altri Paesi le valutazioni

di sicurezza dei sistemi It sono pratiche

affermate, in Italia questo tipo di attivi-

tà è possibile solo di recente, in seguito

alla pubblicazione, nell’aprile del 2004,

del decreto del Presidente el consiglio

dei Ministri del 30 ottobre 2003 [Dpcm03].

Oltre alle ormai consolidate certificazioni di Sistema/Prodotto IT, le organizzazioni sono più sensibili, anche

a seguito delle sempre più pressanti

leggi in ambito di protezione dei dati (i

decreti legislativi 196/20031, 231/20012,

ecc), all’esigenza di implementare un

sistema di gestione della sicurezza delle

informazioni (Isms). Questo tipo di approccio rappresenta un nuovo modo di

intendere la sicurezza IT, la quale non è

più considerata come un fattore esclusivamente tecnologico ma, appunto, come

una responsabilità gestionale.

Bisogna quindi comprendere bene come la sicurezza nell’ambito Ict identifica

i beni (assets) da proteggere, distinguiamo quindi i seguenti elementi:

◗ l’hardware;

◗ il soft ware;

◗ le informazioni;

◗ i servizi.

Differente è la distinzione per quanto

concerne le informazioni, dove è necessario proteggerne:

◗ la riservatezza (confidentiality):

impedire che le informazioni sia-

1 Codice in materia di protezione dei dati personali

– in particolare l’articolo 31 e l’articolo 15 che

impongono qualora si verifichi un danno ad altri,

attraverso l’uso dei dati personali, di fornire

“l’onere di inversione della prova”, cioè dimostrare di aver adottato misure idonee e preventive

volte ad evitare il danno stesso

2 Tale decreto introduce nell’ordinamento italiano

il concetto di responsabilità delle società nei casi

in cui persone fisiche commettano reati anche

nell’interesse o a vantaggio della società stessa.

no accessibili, volontariamente od

involontariamente, ad individui

che non sono autorizzati a conoscerle.

◗ l’integrità (integrity): impedire

che possano avvenire cancellazioni o modifiche di informazioni immagazzinate in un sistema o

in transito tra sistemi a seguito di

interventi di entità non autorizzate

o del verificarsi di fenomeni non

controllabili

◗ la disponibilità (availability): assicurare che possa essere garantito l’accesso alle informazioni alle

entità autorizzate nonostante si

verifichi un incidente provocato

da altre entità non autorizzate o

del verificarsi di fenomeni non

controllabili del tipo già visto nel

caso dell’integrità.

La protezione attuata secondo le modalità sopra descritte deve consentire il

più possibile di contrastare le minacce

(threats) originate dall’uomo o dall’ambiente, al fine di impedire a coloro che

non siano stati autorizzati l’accesso, la

divulgazione, la modifica delle informazioni stesse, e di garantirne, viceversa,

l’accesso e l’utilizzo a coloro che siano

stati autorizzati, nel contesto in cui il

sistema/prodotto IT è inserito (Sala di

Calcolatori, Rete Informatica, ecc.).

Realizzare la sicurezza Ict in un’organizzazione

Normalmente, quando si parla in generale di “sicurezza Ict” ci si riferisce ad

una molteplicità di aspetti tecnici, organizzativi e procedurali che tendono

a proteggere l’hardware, il soft ware, le

informazioni, i servizi.

In particolare, per quanto riguarda le

informazioni, le caratteristiche principali che devono essere protette sono, come

esposto nel paragrafo precedente, la riservatezza, l’integrità e la disponibilità.

Nella realtà potrebbe essere estremamente complesso se non impossibile garantire, con certezza assoluta, le suddette

caratteristiche.

È pertanto necessario che gli owner

del sistema/prodotto Ict individuino dei

compromessi che tengano conto, tra gli

altri, anche degli aspetti puramente economici della realizzazione della sicurezza

Ict. L’importante è che tali compromessi siano individuati in modo esplicito e

consapevole da parte di ogni soggetto

coinvolto. Ciò può essere ottenuto solamente adottando un metodo organico e

strutturato di analisi e di realizzazione

del processo Ict.

Questo criterio e conosciuto con il

termine Analisi dei Rischi.

La concettualizzazione più generale,

condivisa praticamente da tutte le metodologie, identifica il rischio come l’even-

tualità che una minaccia possa trasformarsi realmente in danno, comportando

così un determinato impatto.

La maggioranza delle metodologie

inoltre utilizza i concetti di:

◗ rischio “potenziale” o “intrinseco” definito come il livello di rischio a prescindere dalle contromisure in essere.

Rtot(n) = A(n) x T(n)

inteso come prodotto scalare della

minaccia T per il valore dell’asset A

su cui la minaccia inferisce.

◗ rischio “effettivo” o “residuo” definito come il livello di rischio tenuto conto

delle contromisure implementate.

Reff(n) = A(n) x Teff(n)

dove Teff è definito come:

Teff(n) = (T(n) – Ceff(n))

inteso come il valore di partenza della

minaccia decurtata del valore risultante della ponderazione dei controlli

in essere. [Cert-ICT]

Per esplicitare meglio i concetti esposti riportiamo di seguito una tabella

esplicativa:

Tabella 1- valutazione del rischio

V(a)

V(t)

R(t)

C(e)

V(te)

R(e)

Value

Threats

value

Total

Risk

R(t) =

V(a)*V(t)

Existing

Controls

Value

Effective

Threats

Value

V(te) =

V(t)*C(e)

Effective

Risk

R(e)=

V(a)*V(te)

Dati e applicativi dei clienti

4,7

0,77

3,61

0,71

0,07

0,31

accepted

Mail

8.0

0,77

6,20

0,82

-0,04

-0,33

accepted

Problem management

10,0

0,77

7,75

0,82

-0,04

-0,41

accepted

Hardware

in uso

7,3

0,77

5,68

0,77

0,00

-0,03

accepted

n = variabile da

considerare

Rtot(n) = rischio totale

A(n) = asset

T(n) = minaccia

Reff(n) = rischio effettivo

Teff(n) = minaccia effettiva

Ceff(n) = valore della minaccia

esistente

V(a) = valore

V(t) = valore della minaccia

C(e) = valore del controllo esistente

V(te) = valore della

minaccia effettiva

R(t) = rischio totale

R(e) = rischio effettivo

Fonte: [CertlCT]

INGEGNERI Ordine di Napoli

9

L’Iso/Iec 27001

Le nuove norme tengono conto degli

ultimi sviluppi nel campo dell’Information technology, e dei nuovi rischi

di sicurezza correlati alla sempre maggiore diff usione dei servizi on-line e

dei modelli di gestione outsourcing dei

sistemi IT.

La gestione di tali nuove tipologie di

rischio potrà essere positivamente influenzata da questo nuovo scenario normativo, che si presenta come un codice

di corretta gestione dell’informazione

nei suoi aspetti legati alla sicurezza, in

qualunque forma essa sia trattata e per

qualunque tipo di organizzazione.

In questo contesto si colloca il nuovo standard Iso/Iec 27001 il quale rappresenta uno strumento per creare un

sistema di gestione che permette di assicurare, monitorare, mantenere e migliorare un documentato Isms (Information

Security Management System).

L’Isms viene defi nito come quell’insieme di responsabilità, ruoli organizzativi, modalità operative, procedure,

istruzioni di lavoro, tecnologie ed ambienti fisici che consentono ad una organizzazione di tenere sotto controllo e di

migliorare la sicurezza delle informazioni, adeguando continuamente le proprie

componenti all’evoluzione tecnologica,

in armonia con la politica di sicurezza

[Cert-Sec].

La creazione di un Isms in base alla

Iso 27001, riassumendo, si basa:

◗ su un approccio per processi;

◗ sulla defi nizione da parte dell’ente

di una politica di sicurezza di alto

livello per defi nire gli obiettivi di

sicurezza che si propone di conseguire per salvaguardare la riservatezza, l’integrità e la disponibilità

delle informazioni;

◗ sull’identificazione e sull’analisi dei

rischi a cui sono soggetti gli asset;

◗ sulla valutazione e sulla gestione

dei rischi;

◗ sull’utilizzo di un modello Pdca;

◗ sull’utilizzo di procedure e strumenti che permettono il monitoraggio e il continuo miglioramento

del sistema stesso;

In sostanza dunque lo standard defi nisce che per una corretta protezione

delle informazioni non è sufficiente la

tecnologia ma la defi nizione di un sistema di gestione della sicurezza delle

informazioni da adottare internamente

nell’organizzazione.

Importante è, inoltre, sottolineare

che la certificazione di un Isms non

implica il raggiungimento di specifici

livelli di sicurezza delle informazioni

ma garantisce che è stata fatta una valutazione dei rischi a cui i dati e le informazioni aziendali possono essere sottoposti e sono stati realizzati controlli

appropriati alle necessità di sicurezza

rilevate nell’analisi dei rischi.

Si dimostra cosi particolare sensibilità nei confronti delle tematiche più recenti per quello che riguarda il business

delle organizzazioni, come ad esempio

l’attenzione nei confronti della sempre

più diff usa prassi di delegare a soggetti

terzi la gestione dei servizi anche fondamentali per un impresa. Ciò per gli

enti vuol dire tanto, in quanto significa

aver in ogni caso la certezza che l’outsourcer rispetti la propria politica di

sicurezza e questo è possibile defi nendo, ad esempio, un controllo che riporti

puntualmente i requisiti di sicurezza

che il servizio offerto dal fornitore deve

garantire.

Un altro punto di innovazione e di

forza della nuova famiglia Iso è quello

di porre maggiore attenzione all’importanza per un ente di defi nire un sistema

di Incident managemen e di “Business

continuity”.

Il promuovere la gestione degli incidenti e garantire la continuità del

business risulta essere sempre più importante, proprio perché ormai è dimostrato che la perdita di produttività

può provocare danni economici e di immagine rilevanti. Nella figura seguente

riportiamo un grafico degli incidenti

alla sicurezza occorsi ad una azienda

in 12 mesi.

Figura 1 Principali

incidenti

occorsi

ad un

ente

Based on 695m respondents of the overall sample - Fonte:[CertICT]

10

N. 5-6/2008 - SICUREZZA

La metodologia proposta dall’Iso risulta essere dunque una soluzione proattiva in quanto, non risulta più sufficiente

monitorare il sistema e arginare le falle

ma, sulla base di una serie storica di

incidenti occorsi, promuovere attività

migliorative del sistema stesso.

Altri cambiamenti interessanti riguardano la maggiore defi nizione del

campo di applicazione dell’Isms definendo la necessità di defi nire precisamente il boundary dell’Isms ed inserirvi

all’interno tutti i processi e i servizi essenziali all’ente.

Inoltre si enfatizza ancora più marcatamente l’importanza della valutazione

dei rischi a cui gli asset aziendali possono essere sottoposti per una sempre più

puntuale defi nizione delle contromisure

da adottare anche in fase di revisione

del piano di gestione del rischio. Sempre

in merito alla valutazione del rischio è

esplicitato che la metodologia di valutazione del rischio deve garantire risultati

compatibili e riproducibili, ossia che i

risultati di valutazione del rischio, in

momenti diversi dell’ente, diano evidenza delle modificazioni eventualmente

avvenute, e che la stessa metodologia

applicata in condizioni simili dia gli

stessi risultati.

Tra le altre cose innovative vanno

segnalate soprattutto:

1. lo Statement of applicability detto

anche Soa il quale deve fornire un

riassunto delle decisioni relative

al trattamento del rischio e viene

anche richiesto di dimostrare, per

ciascun controllo la sua relazione

con i risultati del risk treatment,

con la politica e con gli obiettivi;

questo documento, quindi, non

dovrà più portare solo riferimenti

a procedure o documenti di descrizione in dettaglio del controllo, ma anche una descrizione dei

rischi che va a contrastare. Nel

documento, inoltre, dovranno essere giustificate le motivazioni che

portano alla scelta di un controllo

anziché di un altro.

2. l’introduzione della Misurazione

dell’efficacia dei controlli di sicurezza (Iso 27004). In più punti

dello standard si fa riferimento alla

richiesta di misurare l’efficacia dei

controlli. Questo aspetto rappresenta una delle maggiori innovazioni della norma. In particolare si

potrà fare riferimento a statistiche

sugli incidenti rilevati e gestiti,

ma gli indicatori dovranno essere

individuati dalle singole aziende

sulla base dei dati e dei sistemi di

monitoraggio che hanno a disposizione.

Infi ne, ma non per questo meno importante, la Iso 27001 defi nisce la compatibilità dell’Isms con le altre norme internazionali che disciplinano il controllo

dei processi aziendali (Annex C). Questo

punto ad oggi gode di forte interesse, in

quanto per come descritto fi nora si di-

mostra come la sicurezza totale è raggiungibile solo con la totale integrazione

di tutte le norme che si prefiggono come

scopo quello di garantire la sicurezza, e

ispirandoci al concetto che “la sicurezza

è un processo ma non esiste sicurezza

senza prodotti”, capiamo perché molti

sono gli sforzi profusi atti a superare le

attuali confl ittualità tra le certificazioni

di prodotto/sistema, effettuate secondo i

Common Criteria e la certificazione di

processo secondo lo standard della famiglia 27000; i due standard, pur mantenendo le loro specificità, dovrebbero

essere maggiormente integrati e coordinati, al fi ne di raggiungere un miglioramento complessivo della sicurezza dei

sistemi Ict.

Valore aggiunto della certificazione

Iso/Iec 27001

La normativa Iso 27001 è volontaria,

infatti in assenza di obblighi di legge

espliciti è l’organizzazione che decide

autonomamente di intraprendere un

processo di certificazione della sicurezza

Ict per perseguire dei propri interessi.

Il processo di certificazione risulta essere lungo e sicuramente costoso

infatti analizzando il grafico dei costi

in funzione del livello di sicurezza raggiungibile (fig. 2), si nota che questo

ha un andamento logaritmico con un

asintoto orizzontale corrispondente alla

sicurezza del 100 per cento a testimoniare che un tale livello di sicurezza non è

raggiungibile.

Fonte:[ITSEC_CC]

Figura 2 - Grafico dei costi della sicurezza in rapporto al livello di sicurezza

INGEGNERI Ordine di Napoli

11

Le motivazioni che spingono un organo, privato o pubblico, ad intraprendere

un tale oneroso percorso sono :

◗ ottimizzazione degli investimenti: l’analisi tecnologica essenziale al

processo, identifica le vere priorità

e possibilità aziendali;

◗ l’impatto organizzativo: Il processo

interessa sia il management che il

personale. L’analisi dei rischi gioca

un ruolo proattivo nei gruppi implicati nel processo, raggruppando

funzioni e persone con ruoli eterogenei e mettendole in relazione in

termini di analisi del business;

◗ la creazione di un programma di

security awareness: l’applicazione

del programma di analisi coinvolge

un gran numero di persone, inserendo così il tema della sicurezza

nelle agende di molte riunioni, incrementando il livello di consapevolezza sulla sicurezza all’interno

dell’organizzazione.

Questi sono tutti obiettivi “interni”

raggiungibili con la certificazione dell’Isms, ma forse sono più le spinte “esogene” a far si che un ente intraprenda il

cammino di certificazione:

◗ la protezione dell’immagine aziendale: in un contesto di mercato dove

la fiducia del cliente ha una precisa

valenza economica, la salvaguardia

dell’immagine dell’azienda acquisisce un importanza fondamentale

(banche, enti pubblici). In questo

caso la certificazione assume una

valenza di leva di marketing per

incrementare le vendite;

◗ la protezione del business: quando la sopravvivenza stessa dell’ente

dipende da informazioni proprietarie (brevetti, progetti, ecc) dalla cui

salvaguardia dipende il vantaggio

competitivo con le dirette concorrenti;

◗ la conformità alle leggi ed alle regole: rappresenta un modo per dimostrare a terzi, a fronte di eventuali incidenti Ict, la propria diligenza

nell’attuare in via preventiva tutte

le contromisure ritenute necessarie

per limitare le probabilità di accadimento dell’incidente stesso.

C’è da dire, che sempre più spesso i

clienti finali di un’organizzazione, sia essa pubblica amministrazione o azienda

12

privata, richiedono la certificazione di

terza parte come elemento determinante

per potersi avvalere di quella determinata

organizzazione.

Inoltre c’è da considerare la spinta

ricevuta dalle organizzazioni verso le

certificazioni dell’Isms date dalla normativa del decreto legge 8 giugno 2001 n.

231 che ha introdotto per la prima volta

nel nostro ordinamento la responsabilità

degli enti in sede penale, che si aggiunge

a quella della persona fisica che ha realizzato materialmente il fatto illecito.

L’ampliamento della responsabilità

che mira a coinvolgere nella punizione

di taluni illeciti penali il patrimonio degli

enti e, in definitiva, gli interessi economici dei soci, i quali, fi no all’entrata in

vigore del decreto in esame, non pativano

conseguenze della realizzazione di reati

commessi, con vantaggio della società, da

amministratori e/o dipendenti. Questa

responsabilità sorge soltanto in occasione

della realizzazione di determinati tipi di

reati, in questo la norma è molto precisa,

e nello specifico:

◗ i delitti contro la Pa (quali corruzione, concussione e malvessazione

ai danni dello Stato, truffa ai danni

dello stato e frode informatica ai

danni dello stato, articoli 24 e 25

del decreto legge 231/2001);

◗ reati in tema di “falsità in moneta,

carte di pubblico credito e valori di

bollo” (articolo 25-bis decreto legge

231/2001);

◗ reati societari (false comunicazioni

sociali, falso in prospetto, illecita influenza sull’assemblea, l’aggiotaggio,

etc., articolo 25-ter decreto legge

231/2001);

◗ reati con finalità di terrorismo o di

eversione dell’ordine democratico

(articoli 25-quarter decreto legge

231/2001);

◗ reati contro la personalità individuale (sfruttamento della prostituzione, tratta delle persone e riduzione e mantenimento in schiavitù, etc.

articolo 25-quinquies decreto legge

231/2001).

Gli enti rischieranno sanzioni pecuniarie, sanzioni interdittive quali l’interdizione dall’esercizio dell’attività, la revoca di licenze o autorizzazioni, il divieto di

stipulare contratti con la Pa, l’esclusione

di agevolazioni e finanziamenti, il divieto

N. 5-6/2008 - SICUREZZA

di pubblicizzare beni e prodotti oltre che

la confisca del bene oggetto del reato e la

pubblicazione della sentenza.

Come si può facilmente immaginare che le sanzioni pocansi menzionate

comporterebbero gravissimi danni alle

aziende le quali sono chiamate, per non

incorrere in esse, ad ottemperare a quanto richiesto dall’articolo 6 del decreto legge 231/2001, il quale infatti, contempla

una forma di “esonero” da responsabilità

dell’ente se si dimostra, in occasione di

un procedimento penale per uno dei reati

considerati, di aver adottato ed efficacemente attuato “Modelli di organizzazione e di gestione idonei a prevenire reati

della specie di quello verificatosi”.

L’articolo 6 comma 2 del decreto legge

231/2001 indica le caratteristiche essenziali per la costruzione di un modello di

organizzazione, gestione e controllo:

◗ individuare le attività nel cui ambito

possono essere commessi reati;

◗ individuare specifici protocolli diretti a programmare la formazione e

l’attuazione delle decisione dell’ente

in relazione ai reati da prevenire;

◗ individuare modalità di gestione

delle risorse finanziarie idonee ad

impedire la commissione dei reati;

◗ prevedere obblighi di informazione

nei confronti dell’organismo deputato a vigilare sul funzionamento e

l’osservanza del modello;

◗ introdurre un sistema disciplinare idoneo a sanzionare il mancato

rispetto delle misure indicate nel

modello.

Affinché l’ente sia in grado di sottrarsi

alla responsabilità per il fatto illecito dei

dipendenti e amministratori, è necessario

che siano garantite misure di sicurezza

tali da impedir il compimento di reati se

non mediante il raggiro fraudolento delle

misure di sicurezza.

Come appare chiaro dalla lettura del

decreto, l’effettiva portata esimente di un

sistema organizzativo volto a prevenire

le responsabilità amministrative degli

enti, trova la sua origine nell’effettività e

nella concreta applicazione di standard

comportamentali e di flussi informativi

chiari e verificabili all’interno dell’azienda, ecco quindi che appare chiaro come

un Isms certificato possa rendersi estremamente utile.

Conclusioni

Da quanto fi n qua detto si evince che

le nuove Iso 17799:2005 e la Iso 27001

risultano essere più vicine alle esigenze

del mercato e degli utilizzatori, grazie ai

controlli più dettagliati, alla loro organizzazione più coerente e al loro aggiornamento.

Sicuramente, anche a fronte della richiesta di misurazione dell’efficacia dei

controlli, la norma non perde la sua caratteristica di essere applicabile in tutte

le realtà e sarà compito di ciascun ente

individuare le modalità più adeguate per

avere a disposizione dati utili ai fini del

miglioramento continuo.

Queste norme, poi, dimostrano sempre più di migliorarsi tenendo conto

dell’esperienza di quanti ne hanno utilizzato le precedenti versioni, in modo da

renderle sempre più punto di riferimento

per coloro che si occupano di sicurezza

delle informazioni e dei sistemi di gestione ad essa dedicati. In base a questa

evoluzione si riporta un grafico basato

su fonti Sincert che testimonia come dal

gennaio del 2007 al marzo 2008 le aziende abbiano attuato una netta migrazione

dalla precedente Iso Bs-7799 alla attuale

Iso 27001 (fig. 3).

Bibliografia

[17799] – Iso/IEC FDIS 17799:2005-02-11

- Information techniques – Security

techniques – Code of practice for

information security management,

Standard, 2005.

[27001] – ISO/IEC FDIS 27001:2005

– Information technology – Security

techniques – Information security

management system – Requirements,

Standard, 2005.

[CertICT] – ISCOM; Certificazione della

sicurezza ICT, Linee guida ISCOM,

2006.

[AnRisk] – ISCOM; Network security

from risk analysis to protection strategies, Linee guida ISCOM, 2004.

[Out&Sic] – ISCOM; Outsourcing e sicurezza, Linee guida ISCOM, 2006.

[Fub-1] – Fondazione Ugo Bordoni; Sicurezza ICT e Certificazione, Fondazione Ugo Bordoni, 2004.

[AICQ-1] – AICQ – Comitato Qualità

del Software; Gestione della sicurezza delle Informazioni: guida alla

lettura della norma iso 27001, Quaderno n°22, 2007.

[OCSI-1] – Franchina, L.; Carbonelli, M.;

Gratta, L.; L’OCSI e la certificazione

della sicurezza ICT, La Comunicazione – numero unico, 2005.

ACRONIMI

Ict – Information Communication

Technology

D. Lgs. – decreto Legislativo

D. Leg. – decreto Legge

Isms – Sistema di Gestione della

Sicurezza delle Informazioni

Iso – International Standard

Organizzation

Dpcm – Decreto della Presidenza

del Consiglio dei Ministri

Soa – Statement of Applicability

Cert – Computer Emergency Response

Team

Itsec – wInformation Technology

Security Evaluation

Criteria

[EA-7/03] – EA C5 WG7; EA Guidelines

for the accreditation of Bodies Operating Certification/Registration of

Information Security Management

System,2000.

[Fub-2] – Parrucchini, D.; La sicurezza

globale delle informazioni e la certificazione: ambiti di applicazione,

OCSI-Fondazione Ugo Bordoni.

[Sin-Bia] – Bianconi, R.; ISO 27001:2005

– ISMS Rischi ed opportunità

nell’approccio certificativi, Giornata

di studio sulla sicurezza e il mondo

bancario, Sett. 2006.

[DPCM-02] – D.P.C.M. 11 aprile 2002, Schema nazionale per la valutazione e la certificazione della sicurezza delle tecnologie

dell’informazione, ai fini della tutela delle

informazioni classificate, concernenti la

sicurezza interna ed esterna dello stato,

G.U. n. 131, 6 giugno 2002.

[DPCM-03] – D.P.C.M. 30 ottobre 2003,

Approvazione dello schema nazionale per la valutazione e certificazione

della sicurezza nel settore delle tecnologie dell’informazione, ai sensi

dell’art. 10, comma 1, del decreto

legislativo 23 febbraio 2002, n. 10,

G.U. n. 98, 27 aprile 2004.

[DI-02] – decreto Interministeriale 24

luglio 2002, Istituzione del Comitato tecnico nazionale sulla sicurezza

informatica e delle telecomunicazioni

nelle pubbliche amministrazioni.

[D.Leg.-01] – decreto Legislativo 8 giugno 2001, n. 231, Disciplina della responsabilità amministrativa delle persone giuridiche, delle società e delle

associazioni anche prive di personalità giuridica, a norma dell’articolo 11

della legge 29 settembre 2000, n. 300,

G.U. n. 140 del 19 giugno 2001.

Figura 3 - Grafico delle norme BS-7799 ed ISO 27001 certificate in Italia

INGEGNERI Ordine di Napoli

13

ELETTROMAGNETISMO,

IL PIONIERE ERA GIURISTA

Giandomenico Romagnosi è il padre della Procedura penale

I suoi studi sugli effetti della pila di Volta sono del 1802

ma la scienza ricorda solo quelli del danese Oersted del 1820

di Filippo Manna

Ingegnere

“

Ministro con i francesi

e arrestato dagli austriaci,

è stato l’ispiratore

dell’ordinamento giudiziario

del nuovo Regno d’Italia

e il teorico della scienza

dell’amministrazione

”

Gian Domenico Romagnosi (1761-1835)

(fig. 1/A) è notoriamente annoverato tra i

più eminenti giuristi italiani per potenza

d’intelletto e per vastità di cultura com’è

testimoniato dalla traccia profonda del

sapere da lui lasciato nel campo del diritto. Fu infatti la mente ispiratrice dell’ordinamento giudiziario e amministrativo

del nuovo Regno d’Italia dando piena vita

al Codice di procedura penale, l’unico del

tempo di matrice rigorosamente nazionale.

Oltreacciò con il Giornale di giurisprudenza universale da lui fondato gettò le basi

della scienza dell’amministrazione e trattò

i più interessanti problemi di giurisprudenza. Fu prima avvocato e poi pretore della

città di Trento dal 1787 al 1801 e nel 1799,

dopo l’occupazione francese e il ritorno

della dominazione austriaca, subì 15 mesi

di detenzione sotto l’accusa di abuso nell’esercizio delle funzioni di pretore; liberato

al ritorno dei Francesi nel 1802 fu nominato segretario del governo provvisorio e

l’anno dopo ottenne la cattedra di Diritto

pubblico all’università di Parma. Epperò

nel 1822, coinvolto nel processo contro i

carbonari, fu di nuovo arrestato quantunque non facesse parte della associazione, e

da questa accusa assolto, per mancanza di

prove, soltanto dopo il suo trasferimento

a Bologna. Ma gli fu tolta l’autorizzazione

a insegnare, la qual cosa gli procurò un

trauma che, aggiungendosi ai postumi

d’un attacco di emiplegia che lo aveva colpito nel 1881, ne minò seriamente la fibra.

D’allora in poi visse con il rammarico di

non poter più, nemmeno segretamente,

incoraggiare la restaurazione di un regno

italico indipendente, ed in povertà pressoché assoluta, dando prova, fino all’ultimo

dei suoi giorni, d’una onestà esemplare

vissuta senza che mai s’attenuasse in lui la

fede nella causa nazionale e liberale.

Orbene non tutti sanno che questo

così eminente giurista, ed anche lette-

rato, perché gli si attribuiscono oltre

trenta opere di cui almeno dieci postume, ebbe anche uno spiccato senso fisico

forse derivatogli dall’intenso studio da

lui effettuato delle opere di Condorcet e

di altri filosofi-scienziati che gli avevano

comunicato quel ch’essi consideravano

l’esprit geométrique ravvisabile in tutti i

fenomeni naturali. E fu questa sua facoltà

a fargli intuire una stretta interazione

tra la corrente elettrica ed un magnete e

quindi a scoprire la deviazione del campo

magnetico causata dalla corrente elettrica dopo solo un anno dall’invenzione

della pila e con un anticipo di ben diciotto anni rispetto alla famosa scoperta del

1820 del danese Hans Christian Oersted

(fig. 2/A) ovunque osannata come prova

inconfutabile della coesistenza dei fenomeni di elettricità e di magnetismo in

una unica teoria, quella dell’elettromagnetismo appunto, ch’è alla base della

comprensione e delle applicazioni delle

scienze moderne.

Ne dette prova con la memoria dal

titolo Esperimenta circa effectum conflictus electrici in acum magneticum che

subito tradotto in tutte le lingue europee riversò l’attenzione di quasi tutto

il mondo scientifico sul fi sico danese

ignaro, non sappiamo se per ignoranza

o per partito preso, di ciò che con tanto

anticipo aveva scoperto e divulgato il

Romagnosi.

Ecco infatti quanto in proposito ed a

seguito di una sua esplicita richiesta, venne pubblicato da “La gazzetta di Trento”

nel numero del 3 agosto 1802:

“Il sig. Consigliere Gian Domenico Romagnosi, abitante in questa città, noto

alla Repubblica Letteraria per altre sue

profonde produzioni, si aff retta a comunicare ai fisici d’Europa uno sperimento

relativo al fluido galvanico applicato al

Magnetismo. Preparata la pila del sig.

INGEGNERI Ordine di Napoli

15

Volta, composta di piastrelle rotonde di

rame e zinco alternate con un frapposto

interstizio di flanella umettata con acqua

impregnata di una soluzione di sale ammoniaco, il sig. Consigliere attaccò ad una

delle uscite della medesima un capo di filo d’argento snodato a diversi intervalli a

modo di catena mentre l’altro capo egli

collegò all’altro estremo della pila, non

direttamente ma dopo che aveva attraversato un bottone anch’esso d’argento.

Ciò fatto prelevò da una bussola nautica

un ago calamitato ordinario e lo pose in

bilico su una asse di legno quadrato vicinissimo a detto filo con enorme sorpresa

constatando che l’ago calamitato muovevasi lentamente e con successive pulsazioni a somiglianza d’una sfera di orologio

destinata a segnare i minuti secondi e che

la stessa cosa accadeva ad ogni apertura o

chiusura del circuito realizzate azionando

il detto bottone.”

Come si vede c’è quanto occorre per

identificare pienamente l’esperienza del

Romagnosi con quella dell’Oersted. Ma

non basta perché l’annuncio della scoperta venne replicato con altri ragguagli

dalla Gazzetta di Rovereto del 13 agosto

del 1802.

Epperò, di entrambe queste comunicazioni nella comunità scientifica si parlò

unicamente dopo l’annuncio di Oersted

e ciò nonostante il fatto che il Romagnosi indipendentemente da esse aveva

così scritto nello stesso anno 1802 al suo

amico giornalista Bramieri, pregandolo

di divulgare la notizia:

“Ultimamente ho pubblicato nella

Gazzetta di Rovereto una mia scoperta

sul Galvanismo applicato al magnetismo

della calamita in pari tempo inviando una

16

N. 5-6/2008 - ELETTROMAGNETISMO

copia dell’annuncio alla Accademia delle

Scienze di Parigi”.

Nel 1801 Napoleone aveva istituito un

Prix de Galvanime per incentivare nuove

scoperte sui fenomeni elettrici e perciò

il Romagnosi inviò copia del detto articolo anche al Comitato istituito per tale

premio, ma senza nemmeno riceverne

un segno di ricezione. Tuttavia qualche

attestato di riconoscimento il Romagnosi

lo ricevette perché i fisici Aldini e Izarn,

nel 1804, pubblicarono a Parigi un libro

sul galvanismo ov’è precisato che “Monsieur Romanesi (sic) physicien de Trente a

reconnu que le galvanisme faisait decliner

l’aiguille aimentè”.

Però fu uno dei pochi articoli, se non

il solo, a resocontare tempestivamente e

soprattutto favorevolmente della famosa

invenzione perché fino al 1930 non uno

dei numerosi scienziati cui il lavoro fu

presentato nel 1804 dopo averne dato

notizia anche all’Istitute de France, dette

importanza all’ esperimento che avrebbe

potuto anticipare di ben diciotto anni la

scoperta dell’elettromagnetismo. Qualche

anno più tardi il fisico Silvestro Ghepardi,

commentando l’esperimento del Romagnosi, sentenziò ch’esso non conteneva

nulla che potesse aver influenzato Oerstedt, il quale solo nel su precisato 1830

riconobbe, forse obtorto collo, l’esistenza

d’una prioritaria scoperta del fenomeno.

In un lungo articolo pubblicato sulla Enciclopedia di Edimburgo, nel presentare

una storia dettagliata dell’elettromagnetismo, a pag. 575 dice che “nel suo lavoro Aldini ricorda che un certo Romanesi

avrebbe osservato che il galvanismo produce la deviazione dell’ago magnetico”. Non

una parola in più aggiunse sull’argomento tra l’altro sostenendo che il lavoro del

giurista italiano venne presentato senza

alcun commento a Parigi nel 1804 mentre

com’è arcinoto ciò accadde esattamente

due anni prima, nell’ottobre del 1802.

Ovviamente che l’Oersted si sia servito o pur no di quanto trovato dal Romagnosi per il suo famoso esperimento, non

potrà mai essere accertato e del resto esso

passa per così dire in sottordine rispetto

al silenzio che ancora oggi vige in merito a una priorità di così alta rilevanza

la quale, nel 1950, venne riconosciuta ed

elogiata perfino nell’Unione Sovietica.

Purtroppo, però, di questa evidente priorità non solo le enciclopedie d’ogni ordi-

Fig. 1 – Giandomenico Romagnosi (17611835) e lapide commemorativa dedicatagli

dalla città di Trento

Fig. 2 – Il fisico Christian Oersted (1777-1851)

con alla destra lo schema del suo famoso

esperimento.

ne e grado ma nemmeno i più rinomati

testi di elettrotecnica fanno menzione e

se si riesce a trovare qualche pubblicazione che ne parla non si stenta a riconoscere

nel suo autore il desiderio di attenuarne

l’importanza spesso ricorrente ad immagini del tutto fuorvianti oltre che poco

garbate. È ad esempio il caso del volume

del fisico Dibner pubblicato nel 1962 sotto il titolo Oersted and the discovery of the

electromagnetism che così si chiude: “Like

the parable of the seed, the one (Romagnosi) was an early sowing that fell upon

a stony place, the other (Oersted), made

in the full spring and falling on rich soil,

took root and flowered”.

Evidentemente se il Dibner avesse presa diretta visione delle minute descrizioni

fatte dalle comunicazioni del Romagnosi

ai due citati quotidiani ed all’Assemblea

della Scienze di Francia e confrontato lo

schema descritto dall’ Italiano con quello

originale del Danese da noi rintracciato

alla pagina 115 del volume di Th. Schwartze Licht un Kraft e riportato nella nostra

fig. 2/B, non avrebbe mai parlato di “seme

gettato sulla nuda pietra”, tanto più che

mentre il secondo schema non evidenzia per nulla la sorgente di elettricità cui

Oersted fa ricorso, il Romagnosi descrive

per filo e per segno la pila da lui utilizzata

ch’è esattamente la stessa presentata dal

Volta a Napoleone Bonaparte nel 1801.

Si sarebbe allora tentati di indagare sui

motivi per cui così a lungo il ritrovato del

Nostro conobbe l’oblio, ma se ci si accinge a farlo si rischia d’imboccare un vicolo

cieco. Come abbiamo visto il Romagnosi

fece di tutto per far conoscere a istituzioni

scientifiche e personalità varie quant’aveva

constatato, e del resto la città di Trento

questa priorità volle scolpire nel marmo

dedicandogli un’apposita lapide (fig. 1/B).

Residuano perciò due congetture che non

tutti ovviamente condivideranno e sulle

quali noi stessi abbiamo ponderato prima

di esporle. La prima è che il Romagnosi la

sua scoperta comunicò al mondo scientifico nella sua madrelingua e non come fece

l’Oersted in quella dei dotti, cioè nell’idioma che fino a circa la metà del Novecento

occupava il posto oggi rivestito dall’inglese, il che ovviamente accadde per la fede ed

il patriottismo di cui abbiamo detto presentando la figura del nostro protagonista,

non certo per aver incontrato difficoltà

visto che, come umanista oltre che come

giurista, il Romagnosi conosceva, scriveva e parlava correntemente il latino. Resta

allora l’altra ipotesi, quella per così dire

“limite”, e cioè che il Romagnosi nacque

sotto cattiva stella, tale essendosi questa

rivelata già con le due del tutto immeritate

condanne da noi ricordate. Nel sonetto In

morte di Laura il Petrarca osserva che “sua

ventura ha ciascun dal dì che nasce”. Se

quindi essa ventura sin da tal dì rivelasi

“ria” del tutto inutile è lottare contro il

destino.

INGEGNERI Ordine di Napoli

17

Elettrosmog

Il corso diventa annuale

Dopo il successo della prima edizione sarà ripetuta l’iniziativa

voluta da Ordine e Associazione Ingegneri per formare esperti

nella valutazione dei campi elettromagnetici nell’ambiente.

Si è conclusa nel mese di maggio 2008

la prima edizione del corso di formazione su “Il monitoraggio dei campi elettromagnetici” organizzato dall’Ordine

degli Ingegneri di Napoli in collaborazione con l’Associazione Ingegneri di

Napoli.

Il corso ha visto la partecipazione di

venti colleghi che hanno voluto ampliare il loro spazio professionale a questo

importante e attuale settore della valutazione dei campi elettromagnetici nell’ambiente, il cosiddetto elettrosmog.

La tematica è parte significativa dei

programmi di attività della commissione

Telecomunicazioni del nostro Ordine,

che nello specifico prevedono azioni di

formazione continua ma anche studi e

proposte, come quelle per una diffusione

dei piani regolatori per l’installazione di

sorgenti di campi Em nell’ambiente e la

creazione di un albo regionale specifico

per tecnici del settore.

Il corso, coordinato da Antonella

D’Agata della Commissione Telecomunicazioni, ha avuto la durata di 35 ore ed

ha trattato sia l’area della bassa frequenza

che quello dell’alta frequenza.

Oltre alla parte teorica sono state effettuate anche delle misure sul campo.

Il tutto con il contributo di professori

universitari.

L’esito complessivo dell’iniziativa ha

confermato la necessità non solo di formare tecnici specializzati nel settore, ma

anche di creare una maggiore sensibilità verso una rigorosa applicazione delle

norme vigenti al fine meglio tutelare gli

addetti ai lavori e la popolazione.

È proprio per queste ragioni che si è

deciso di dare al corso una frequenza

annuale e di continuare a promuovere

azioni sinergiche sulla materia con enti

di ricerca, istituzioni pubbliche, produttori e gestori di impianti con sorgenti di

campi Em.

Per ulteriori informazioni si rimanda

al sito www.ordineingegnerinapoli.it .

INGEGNERI Ordine di Napoli

21

ENERGIA, LA LEGGE

IMPONE IL RISPARMIO

Anche l’edilizia deve porsi l’obiettivo di costruire e ristrutturare

adottando soluzioni che aumentano l’efficienza energetica.

I costi salgono solo dell’8 per cento e si recuperano rapidamente.

Adolfo Palombo

Ingegnere

del Dipartimento Energetica,

Termofluidodinamica applicata e

Condizionamenti ambientali dell’Università

Federico II di Napoli

Il 14 gennaio scorso, in Acen, si è

parlato di efficienza energetica in edilizia per sensibilizzare l’imprenditoria

locale sul tema e, ancor più, per renderla edotta degli adempimenti che

gravano sulla categoria.

“

L’obiettivo dei prossimi anni

è di ridurre i consumi

e le emissioni di CO2 .

Per i fabbricati

l’attenzione maggiore

va posta sui sistemi

di condizionamento termico

”

A promuovere l’incontro è stata Paola Marone, vicepresidente dell’Acen e

consigliere dell’Ordine degli Ingegneri,

che ha fornito interessanti dati su fonti

e consumi energetici. Particolarmente

ha rilevato nell’ultimo quinquennio, in

Italia, un aumento continuo dei consumi totali di energia non corrispondente

ad un aumento del Pil. Ancora, dalla

ripartizione delle quote di consumi di

energia per settori di uso finale, risulta

primo il settore residenziale-terziario

con il 32 per cento, seguito da quello

dei trasporti (30 per cento) e da quello

dell’industria (28 per cento). L’aumento

della domanda di energia riguarda infine soprattutto gli usi civili ed è causato

essenzialmente da fattori climatici.

È inoltre intervenuto Pietro Ernesto

De Felice, vicepresidente vicario del

Consiglio Nazionale degli Ingegneri,

che ha riferito che il Cni si è molto

prodigato per l’emanazione dei decreti

attuativi e delle linee guida nazionali

in tema di risparmio energetico, considerata l’importanza del tema e le ripercussioni dello stessa sull’operatività di

professionisti e imprese, oltre che sulla

opportunità dal punto di vista ambientale di muoversi in tale direzione.

A relazionare tecnicamente sul tema è poi intervenuto Adolfo Palombo,

docente del Dipartimento Energetica,

Termofluidodinamica applicata e condizionamenti ambientali dell’Università di Napoli Federico II, di cui di seguito

pubblichiamo l’intervento.

I costi energetici ed il rispetto per

l’ambiente impongono oggi il massimo sforzo per razionalizzare l’uso dell’energia. Attraverso l’attuale quadro

INGEGNERI Ordine di Napoli

23

di legge questo tema diventa di particolare interesse anche nel settore dell’edilizia, dove l’obiettivo dei prossimi

anni sarà quello di ridurre i consumi

energetici e le emissioni di CO2 . Poiché

questi sono dovuti in buona parte alla

climatizzazione ambientale, i vincoli

e le verifiche di legge sull’efficienza

energetica nell’edilizia riguardano per

il momento essenzialmente tale argomento ed in particolare il riscaldamento invernale. Da questo punto di

vista i regolamenti più recenti discendono dalla direttiva europea 2002/91

Ce che in Italia è recepita dal decreto

legislativo 192/05 poi riveduto e corretto dal decreto legislativo 311/06.

I possibili interventi che oggi devono essere presi in considerazione per

migliorare l’efficienza energetica degli

edifici coinvolgono sia l’involucro edilizio che i relativi impianti termici. Aldilà di alcune eccezioni, tali argomenti

riguardano tutti gli edifici nuovi, tutti

i nuovi impianti negli edifici non nuovi (compresa la sostituzione del solo

generatore di calore) e le significative

24

N. 5-6/2008 - INGEGNERIA CIVILE

ristrutturazioni ed ampliamenti del

cospicuo patrimonio edilizio esistente. Per quanto riguarda quest’ultimo

i margini d’intervento sono notevoli,

si pensi infatti che una sua larga fetta

è costituita da fabbricati edificati con

poca o nessuna attenzione all’efficienza energetica.

In seguito sono riassunti brevemente i possibili interventi sull’involucro

edilizio al fine di ridurre il fabbisogno

d’energia primaria per il riscaldamento invernale o per contenere il carico

termico estivo. Successivamente, ai

fini del risparmio energetico, vengono riportate le principali soluzioni

riguardanti gli impianti e le fonti rinnovabili nell’edilizia.

Sugli elementi opachi dell’involucro

edilizio è necessario operare al fine di

limitare il valore della relativa trasmittanza termica, prevedendo in generale un opportuno spessore d’isolante,

da calcolarsi in funzione della zona

climatica in cui è ubicato l’edificio.

In particolare, sulle coperture piane

le tecniche utilizzate sono quella del

classico tetto caldo oppure quella del

tetto rovescio che, come è noto, differiscono essenzialmente per la posizione

dell’isolante rispetto alla guaina impermeabilizzante. Un particolare tetto

rovescio è il cosiddetto tetto verde la

cui peculiarità sta nel fatto che l’isolamento è ottenuto anche attraverso

un opportuno spessore di terreno e la

vegetazione messa a dimora su quest’ultimo. L’isolamento termico della

copertura può essere effettuato anche

dall’interno dell’edificio, eventualmente attraverso l’adozione di un controsoffitto isolante. Per i tetti inclinati le

soluzioni normalmente adottate sono

abbastanza simili a quelle del caso precedente con l’aggiunta del cosiddetto

tetto ventilato. Quest’ultimo consiste

di un’intercapedine che, permettendo

la circolazione naturale dell’aria tra la

gronda ed il colmo, garantisce d’estate minori rientrate di calore verso gli

spazi interni. Nel caso che il locale sottotetto non sia adibito al calpestio, un

ulteriore metodo consiste nel posizionare l’isolante sull’ultimo solaio.

Per quanto riguarda le pareti perimetrali verticali è spesso necessario

isolarle termicamente con il cosiddet-

to cappotto esterno oppure disporre

l’isolante sulle sue superfici interne.

In alternativa l’isolante può essere

posto all’interno della parete. La tecnica del cappotto consiste tipicamente

nell’ancorare dei pannelli di materiale

isolante all’intera superficie verticale esterna dell’edificio e nel coprirli

con intonaci speciali. In alcuni casi la

coibentazione è realizzata direttamente con significativi spessori di malte

bassoconduttive contenenti granuli

sciolti d’isolante. Il cappotto è l’unica

tipologia d’isolamento che consente

di correggere i ponti termici e scongiurare il rischio di condensa; nelle

applicazioni retrofit non interferisce

durante la posa in opera con l’utilizzazione degli ambienti interni e, negli

edifici ad uso continuativo, permette

di conservare una temperatura interna

di benessere anche ad impianto spento

grazie allo sfruttamento dell’inerzia

termica della muratura. Per contro

possono nascere problematiche legate all’aumento di volume dell’edificio.

L’isolamento dall’interno consiste nel

posizionare delle lastre di materiale

isolante sul lato interno delle superfici

disperdenti e nel coprirle d’intonaco.

In alternativa è realizzato attraverso pareti preaccoppiate costituite da

cartongesso incollato su lastre rigide

d’isolante. È tipicamente adottato nel

caso di edifici sottoposti a vincoli architettonici o in quelli adibiti ad uso

discontinuo. Ad impianto spento con

questa soluzione si perdono i benefici

legati all’inerzia termica delle murature mentre, per contro, si ottiene ad

impianto acceso il rapido raggiungimento della desiderata temperatura

ambiente. Negli interventi retrofit è

forte il rischio legato all’interferenza

dei pannelli isolanti con gli impianti elettrici, termici, etc. È semplice la

posa in opera, mentre d’altro canto, si

riduce il volume utile degli ambienti.

L’isolamento posizionato all’interno

delle murature può essere realizzato

sia su manufatti nuovi che in applicazioni retrofit. Nel primo caso consta

nel posizionamento di lastre rigide

d’isolante tra le due pareti di cui è formata la chiusura verticale dell’edificio.

Ovviamente almeno una delle due pareti deve essere di nuova fattura. Nelle

applicazioni retrofit sulle murature a

cassa vuota il riempimento delle intercapedini d’aria è effettuato, per piccoli spessori di quest’ultime, con resine liquide auto indurenti, altrimenti

con materiali isolanti solidi in forma

sciolta. Interessanti sotto il profilo

dei vantaggi legati all’inerzia termica

della parete, sono le applicazioni che

vedono la muratura coperta d’isolante

sia all’interno che all’esterno. I materiali utilizzati più di frequente per

l’isolamento delle superfici opache

sono il polistirene, il polietilene, il

poliuretano, le fibre di vetro, quelle

minerali e quelle di legno mineralizzato. Per tali materiali le conducibilità oscillano tra 0,03 e 0,08 W/mK,

i costi iniziali tra 0,6 e 5 €/m 2 ·cm.

Per le pareti perimetrali degli edifici

nuovi sono spesso utilizzati blocchi

di calcestruzzo aerato autoclavato o

d’argilla espansa. Se gli spessori sono

sufficienti, le pareti costituite da tali

materiali possono avere trasmittanze

già inferiori ai valori limite ammissibili non necessitando dunque dell’adozione d’isolante supplementare. Per

garantire d’estate minori rientrate di

calore verso gli spazi interni si possono adottare pareti con facciata ventilata. La circolazione naturale dell’aria

attraverso l’intercapedine ricavata

tra la muratura e l’esterno permette

qui di evitare eccessive temperature

delle murature verticali. Anche per i

pavimenti verso locali non riscaldati

o verso l’esterno il decreto legislativo 311/06 impone di limitarne le dispersioni. Tale obiettivo è raggiunto

perlopiù attraverso l’adozione di un

opportuno strato di materiale isolante

collocato sotto la pavimentazione.

Anche sugli elementi trasparenti

dell’involucro edilizio è opportuno

operare al fine di limitarne il valore

della trasmittanza. I possibili interventi sulle finestre riguardano i telai,

le vetrate, i cassonetti degli eventuali

avvolgibili e le schermature. In particolare il regolamento vigente impone

dei valori limite alle trasmittanze, sia

delle vetrate che dell’intero componente finestrato, via via più bassi all’aumentare del grado giorno. I telai

in legno hanno buone caratteristiche

d’isolamento, soprattutto se la tenuta

“

La tecnica ha sviluppato

tante soluzioni

per intervenire

sia nelle nuove costruzioni

sia nelle ristrutturazioni.

Le leggi di riferimento

sono la 192/05 e la 311/06

INGEGNERI Ordine di Napoli

”

25

“

Gli interventi possibili

riguardano i pavimenti,

le pareti, i tetti e perfino

le superfici vetrate

e riducono sia

le entrate di calore estivo

che le dispersioni invernali

”

26

per evitare le infiltrazioni è efficiente.

Quelli in metallo necessitano dell’ormai tipico taglio termico. Per quanto

riguarda le vetrate, va detto che i vetri

monolitici semplici, in generale, non

sono più sostenibili. Per limitare il valore delle dispersioni termiche spesso

non basta nemmeno l’adozione delle

vetrocamere semplici. Da questo punto

di vista è possibile operare con differenti soluzioni eventualmente adottabili simultaneamente. Per innalzare

la resistenza convettiva all’interno

dell’intercapedine della vetrocamera

è possibile utilizzare, in luogo della

tipica aria disidratata, gas bassoconduttivi ad alto peso molecolare come

l’argon, il kripton, l’esafloruro di zolfo,

etc.. Per elevare la resistenza radiativa è possibile adottare lastre di vetro

bassoemissive (lowe) con trattamento

superficiale magnetronico o pirolitico.

Queste tecnologie consistono nel depositare su una delle due facce di questi

vetri una pellicola sottilissima costituita da metalli o ossidi metallici che

rendono la superficie selettiva. Il vetro

così trattato rimane trasparente alla luce e, con un certo margine, alla radiazione infrarossa solare mentre evita la

dispersione della radiazione infrarossa

ad alta lunghezza d’onda proveniente

dall’ambiente interno. Un ulteriore

metodo per abbattere la trasmittanza

delle vetrate consiste nell’utilizzare

vetrocamere triple. Per ridurre il carico solare estivo è possibile adottare

vetri a controllo solare. Ne esistono di

differenti tipologie: riflettenti, assor-

N. 5-6/2008 - INGEGNERIA CIVILE

benti, selettivi. Questi ultimi, rispetto

ai selettivi invernali, hanno la peculiarità di tagliare anche la radiazione

infrarossa solare (vicino infrarosso).

Le proprietà di tali vetri possono essere opportunamente combinate in vetrocamere speciali. Le caratteristiche

dei vetri in commercio in termini di

illuminamento, guadagno solare invernale, controllo solare estivo ed estetica

possono in generale contrastare tra loro. La scelta del prodotto ottimale va

in tali casi ponderata in funzione della

destinazione d’uso dell’edificio, della

sua geometria, dell’orientamento delle

superfici finestrate, etc.. I costi iniziali

vanno dai 50 €/m 2 per le vetrocamere

semplici, agli 85 €/m 2 per le vetrocamere con Argon, ad oltre 120 €/m 2 per

quelle con vetro selettivo.

I benefici che si ottengono con le

suddette soluzioni riducono in generale sia le dispersioni invernali che le

rientrate di calore estive. Ritornando

alle superfici opache il regolamento vigente prescrive in alcuni casi ulteriori

accorgimenti per limitare il carico termico estivo. Se il valore medio mensile

dell’irradianza sul piano orizzontale

nel mese di massima insolazione è

maggiore di 290 W/m 2 , la massa superficiale delle pareti opache (verticali, orizzontali e inclinate) deve essere

maggiore di 230 kg/m 2 . In alternativa

si impone di ottenere gli stessi effetti

utilizzando tecnologie e materiali innovativi. Il motivo di tale prescrizione

sta nel fatto che grazie all’inerzia termica della struttura il carico termico

di trasmissione effettivo è attenuato e

sfasato in ritardo rispetto a quello che

si avrebbe se la struttura non avesse capacità termica. Un elevato sfasamento

temporale permette di avere un carico

di trasmissione di picco nelle ore serali

o notturne quando gli edifici commerciali sono in generale chiusi e quando la più bassa temperatura dell’aria

esterna permette di ridurre il carico

termico di quelli residenziali grazie

alla ventilazione (in quelle ore la temperatura esterna è tipicamente minore

di quella interna). Un basso fattore di

attenuazione (elevata attenuazione)

permette in generale di ridurre significativamente il carico termico e quindi la taglia e i consumi degli eventuali

impianti di climatizzazione estiva. In

meglio le condizioni ambientali esterne

e le caratteristiche distributive dell’edificio per ottimizzare la ventilazione

naturale. In assenza di impedimenti gli

edifici nuovi dovrebbero essere orientati con l’asse longitudinale disposto

lungo la direttrice Est – Ovest con una

tolleranza massima di 45°. In tal modo

si ottiene in generale il minimo carico

solare estivo ed il massimo guadagno

solare invernale. Quest’ultimo è ottenuto sulla più ampia superficie sud

dell’edificio poiché d’inverno il sole,

essendo abbastanza basso sull’orizzonte, la colpisce efficacemente (d’estate il

sole che si affaccia sulle pareti a sud è

in generale più alto ed i tipici aggetti

esterni allocati sopra le finestre evitano abbastanza bene l’ingresso della ra-

generale per quanto detto bisognerebbe

che lo sfasamento delle coperture fosse

maggiore di dieci, dodici ore, mentre

per le pareti perimetrali opache fosse

non minore di nove ore (dicei ore per i

climi estivi più impegnativi). Per quanto riguarda il fattore d’attenuazione i

valori ottimali si attestano intorno a

0,15. Tale argomento è ovviamente di

maggior interesse nei casi in cui il carico di trasmissione è preponderante

rispetto alle altre componenti del carico termico.

Per limitare il carico termico estivo per alcuni ambiti d’intervento è

resa obbligatoria la presenza, in corrispondenza delle finestre, di sistemi

schermanti esterni o interni. Va inoltre

verificata la possibilità di sfruttate al

diazione attraverso i vetri). Se si segue

tale raccomandazione, le dimensioni

delle pareti est ed ovest dell’edificio

risultano minori di quella a sud ed il

sole del mattino e del pomeriggio, a

quell’ora basso sull’orizzonte, procura

carichi termici più contenuti. Ovviamente tali osservazioni riguardano

maggiormente gli edifici cosiddetti in

linea e meno quelli che tendono alla

forme a torre. In ogni caso i fabbricati

vicini dovrebbero essere opportunamente distanziati per evitare il mutuo

ombreggiamento e favorire quindi il

guadagno solare invernale.

Per quanto riguarda gli impianti

termici le soluzioni adottabili per favorire il risparmio energetico sono molteplici. È innanzitutto indispensabile

la miglior regolazione dell’impianto

(in modo da tener conto anche degli

apporti di calore gratuiti) e la minor

dispersione termica possibile sia della

rete di distribuzione che dei terminali di scambio termico. In relazione al

riscaldamento invernale la soluzione

maggiormente adoperata consiste nell’utilizzare fluidi termovettori a bassa

temperatura. In quest’ipotesi la produzione di calore può essere effettuata

con generatori più efficienti delle caldaie tradizionali, come le pompe di calore o le caldaie a condensazione. Ovviamente è condizione necessaria che

vengano adottati terminali di scambio

termico anch’essi a bassa temperatura

come ad esempio i pannelli radianti

o i ventilconvettori. L’efficienza del

sistema può essere ulteriormente migliorata attraverso l’ausilio di un impianto solare termico, che d’altro canto l’attuale normativa prescrive per la

produzione di almeno un’aliquota del

fabbisogno d’acqua calda sanitaria

dell’edificio. Anche il fotovoltaico è

ormai oggetto di alcuni obblighi (le

sue caratteristiche impiantistiche e

la normativa relativa al suo impiego

richiedono una specifica trattazione).

Un involucro edilizio ed un impianto

energeticamente efficienti assicurano

in generale un ridotto fabbisogno specifico d’energia primaria dell’edificio.

L’attuale regolamento, per i suddetti

ambiti d’intervento, pone un limite

massimo a tale indice in riferimento

al solo riscaldamento invernale.

Aldilà dei vincoli di legge, e cioè dei

requisiti minimi da considerare nello

scegliere le possibili soluzioni progettuali e costruttive, bisogna considerare

anche i relativi aspetti economici. Da

questo punto di vista recenti studi mostrano che l’aggravio sui costi economici iniziali per ottenere edifici energeticamente efficienti sono compresi,

in funzione della forma dell’edificio,

al massimo tra il 3 e l’8 per cento dell’investimento totale. Nello studio di

fattibilità, che va comunque effettuato

a monte della progettazione, va considerato che il periodo di ritorno dell’investimento relativo al sovraccosto delle

possibili soluzioni innovative può in

alcuni casi superare i normali standard

vista la longevità di tali investimenti.

INGEGNERI Ordine di Napoli

27

I dispositivi individuali oggi dialogano con Erp e intranet

Il Vws aumenta la produttività individuale

Investire nei nuovi modelli di comunicazione e nei nuovi sistemi di gestione dell’informazione

permette a organizzazzioni ed aziende di favorire la mobilità e l’operatività dei propri lavoratori

grazie all’integrazione tra Pde, Smartphone, cellulari e reti informatiche locali e terrestri.

In un recente studio dell’osservatorio (banche e Pubblica amministrazione) si è vista la progressive

integrazione tra le reti intranet

e i sistemi Erp (Enterprise resource planning) e strumenti

di produttività individuale.

Questo nuovo modello

di sistema informativo e di

comunicazione è stato definito il “Vws” dell’organizzazione.

L’analisi è stata condotta

da tre differenti prospettive

1. strategica (obiettivi e

processi supportati,

modelli di business,

progetti Ict, investimenti sostenuti

etc.);

2. tecnologica

(piattaforme

tecnologiche

utilizzate e dinamiche di sviluppo, modelli

di implementazione, etc.);

3. organizzativa (approcci di sviluppo,

soluzioni di gestione impatti

organizzativi, etc.).

Le banche coinvolte sono quelle del

nord e centro sud.

I Vws sono veri e proprio ambienti

di lavoro che offrono alle persone e

agli operatori di settore un supporto

completo alle loro esigenze di operatività e di servizi, comunicazione, e

gestione della conoscenza.

La continua convergenza di tutte

le applicazione di It verso i web per-

mette ai sistemi informativi e quindi alle intranet di essere più incisivi

nei riguardi dei dati immessi e delle

informazioni ricavabili nell’ambito

organizzativo.

Possono essere identificate quattro

dimensioni di un Vws:

1. employee, service space: servizi

di sportello e servizi per le facilities;

2. internal comunication space: ser-

vizi di comunicazione verso gli

stackholder;

3. business community space: accesso ai dati aziendali per sviluppo di aree di affari;

4. operative work space: strumenti

e servizi per la propria attività.

L’impatto organizzativo risulta essere positivo se il Vws è pienamente

integrato. Infatti possiamo avere quattro dimensioni di vantaggio:

1. velocità decisionale per strategie

di innovazione efficaci;

2. maggiore collaborazione tra unità diverse;

3. maggiore versibilità e maggiore

capacità nell’attuare le strategie;

4. maggiore capacità nel supportare

l’attività delle persone consentendo l’accesso ai lavoratori mobili

con dispositivi ad alta portabilità (cellulari, Pde, SmartPhone,

Blackberry).

È facile notare come tali

dimensioni impattino sull’organizzazione aziendale

creando vantaggi sia nella

mobilità e sia nelle capacità

delle persone: si immagini ad

esempio negli ambiti sanitari dove

una risposta veloce può essere importante per la salute di una persona da

soccorrere urgentemente al pronto

soccorso nelle diverse ore della giornata (verificare la possibilità di poter

inviare messaggi a gruppi di medici

della stessa unità operativa e gestione della chiamata unica e verifica di

questa possibilità nelle ambulanze e

nei 118).

Il Vws è un ambiente innovativo

che promuove un’elevata integrazione di strumenti software e pacchetti

INGEGNERI Ordine di Napoli

29

“

Gli ingegneri

che hanno implementato

sistemi di Business

process management

sono coloro che attueranno

una reale configurazione

dei processi aziendali

”

30