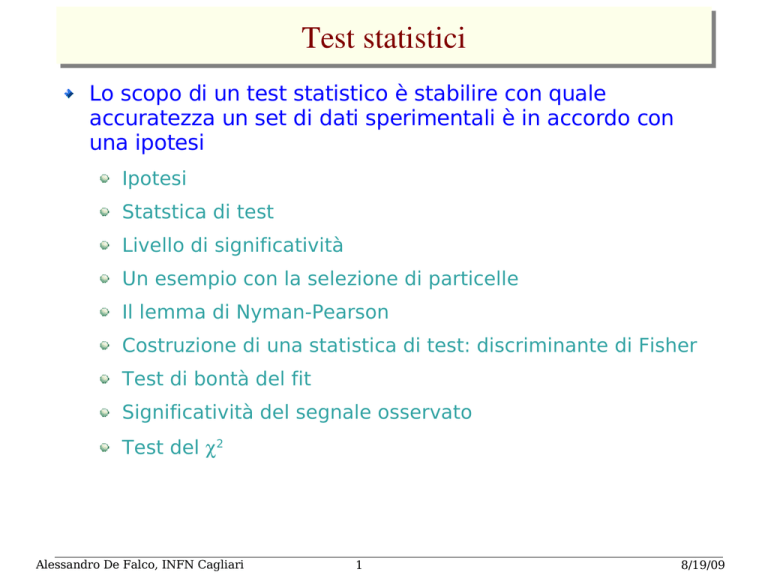

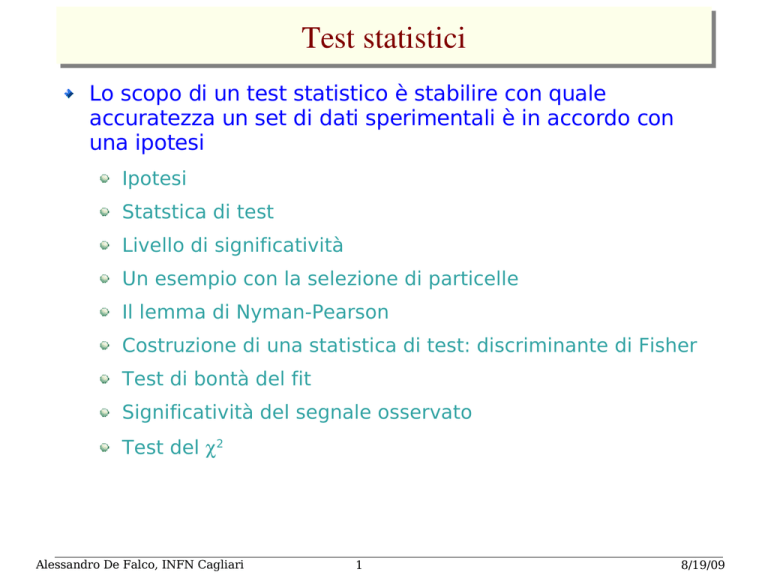

Test statistici

Lo scopo di un test statistico è stabilire con quale

accuratezza un set di dati sperimentali è in accordo con

una ipotesi

Ipotesi

Statstica di test

Livello di significatività

Un esempio con la selezione di particelle

Il lemma di Nyman-Pearson

Costruzione di una statistica di test: discriminante di Fisher

Test di bontà del fit

Significatività del segnale osservato

Test del 2

Alessandro De Falco, INFN Cagliari

1

8/19/09

Ipotesi e statistica di test

Supponiamo che il risultato di una misura sia x = x 1, x 2,. .. , x n

dove le xi sono proprietà dell'evento: es.

x1: molteplicità delle particelle cariche

x2: posizione del vertice primario

x3: energia trasversa

........

La distribuzione di probabilità congiunta di x sarà

caratteristica dell'evento prodotto es. p p J / ,

p p hadrons , ...

La distribuzione di probabilità congiunta è specificata da una

IPOTESI H0, solitamente confrontata con ipotesi alternative

Ipotesi semplice: f x

Ipotesi composita:

f

x∣H 0 , f

x∣H 1 ...

completamente specificata

f

x ,

data con non noto.

Solitamente è complicato trattare la x multidimensionale

Per valutare l'accordo di una data ipotesi coi dati, si costruisce

una statistica di test t(x), solitamente di dimensione minore in

modo da compattare i dati senza perdere la capacità di

discriminazione

Alessandro De Falco, INFN Cagliari

2

8/19/09

Regione critica

La statistica t avrà pdf g t ∣H 0 , g t ∣H 1 ...

Si formula una affermazione sulla

compatibilità tra dati e ipotesi in

termini della decisione di accettare o

rigettare l'ipotesi H0

Rigettiamo gli eventi se

appartengono a una regione critica

(es. t>tcut ) in cui è improbabile che H0

sia verificato

Probabilità di rigettare H0 quando è

vero (errore di 1a specie):

∞

=∫ g t∣H 0 dt

t cut

Probabilità di accettare H0 se è vero H1 t

(errore di 2a specie):

=

cut

∫ gt∣H 1 dt

−∞

Alessandro De Falco, INFN Cagliari

3

Livello di significatività

(1­)=potere di reiezione

8/19/09

Esempio: selezione di particelle

Dobbiamo identificare n particelle distinguendo il segnale dato dagli

elettroni dal fondo dovuto ai pioni, mediante la misura di perdita di

energia in una camera a deriva. (suppongo noto l'impulso). Definiamo:

t: media troncata delle misure.

H0: segnale (elettroni)

H1: fondo (pioni)

Definiamo un taglio t<tCUT che ci permette di selezionare gli elettroni:

t CUT

e = ∫ g t∣e dt=1−

efficienza di selezione per elettroni

= ∫ gt∣ dt=

efficienza di selezione per pioni

−∞

t CUT

−∞

la scelta di tCUT sarà un compromesso tra il valore più alto di e e il più

basso per .

Se la frazione ae di elettroni non è nota, il problema diventa una stima

di parametri: t sarà distribuita secondo la:

f t ; ae =ae gt∣e1−ae gt∣

Alessandro De Falco, INFN Cagliari

4

a=1−ae

8/19/09

Il numero di particelle accettate sarà:

N acc =e N e N =e N e N tot − N e

N e=

N acc − N tot

e −

Mediante il teorema di Bayes possiamo determinare la

probabilità h(e|t) ( h(|t) ) che la particella considerata sia

un elettrone (o un pione) per un determinato valore di t:

h e∣t =

ae g t∣e

h∣t =

a e g t∣ea g t∣

a gt∣

a e g t∣ea gt∣

(nota: secondo l'approccio bayesiano h(e|t) è la probabilità soggettiva, secondo l'approccio frequenzistico è la frazione di elettroni ad un dato t)

La purezza del campione selezionato è data da:

t CUT

p e=

n e con tt CUT

n all con t t CUT

Alessandro De Falco, INFN Cagliari

=t

a e g t∣e dt

∫

−∞

CUT

a e gt∣e1−a e gt∣ dt

∫

−∞

5

t CUT

=

h t∣e f t dt

∫

−∞

t CUT

∫

−∞

f t dt

8/19/09

Il lemma di Neyman­Pearson

Consideriamo una statistica di test

t =t 1, t 2,. .. , t n

Cerchiamo la scelta ottimale dei tagli che permettono di

selezionare il segnale H0 dal fondo H1, ovvero che

permettono di rendere i più piccoli possibile sia α che β.

Il lemma di Neyman-Pearson asserisce che per ottenere la

purezza più alta per una determinata efficienza, si deve

definire la regione di accettanza nello spazio delle t in

modo che:

g t ∣H 0

g

t∣H 1

c

dove c è una costante che determina l'efficienza della

selezione, che va fissata opportunamente per la misura

specifica

Alessandro De Falco, INFN Cagliari

6

8/19/09

Test di Neyman Pearson: un esempio

Diversi siti producono due varietà di diossido di silicio:

g

g

=2.6

Opale:

Quarzo:

=2.2

cm

3

cm 3

Misuriamo la densità con una risoluzione di 0.2 g/cm3

Per quali siti è opportuno eseguire ulteriori scavi?

Ipotizziamo che il campione sia opale.

La probabilità è descritta da una gaussiana con µ=2.2, σ=0.2

Per l'ipotesi alternativa la pdf è ancora gaussiana con µ=2.6, σ=0.2

− x−2.6 / 2

e

10x

Il rapporto tra le gaussiane è:

∝e

− x−2.2 / 2

e

2

2

2

2

Il rapporto cresce con x; un taglio su x permette la determinazione

ottimale di β, fissato α

Se accettiamo solo i campioni con ρ<2.53 (1.64 σ sopra la media)

α=5%: ignoriamo il 5% dei campioni utili; β=36%: analizziamo

inutilmente il 36% dei depositi di quarzo.

Selezioni diverse possono essere effettuate a seconda della necessità

Alessandro De Falco, INFN Cagliari

7

8/19/09

Costruzione di una statistica di test

Esempio:

H 0=e e WW adroni 4 jets

H 1 =e e q q

adroni 2 jets

t

x =

−

f

x∣H 0

f

x∣H 1

−

misuro

x = x 1, x 2,. .. , x n

taglio su t per selezionare WW.

Mi occorre conoscere f x∣H 0 , f x∣H 1

Monte Carlo

generatore

Genero degli eventi, e per ciascuno costruisco x con cui riempio

un istogramma n-dimensionale. Se per ogni dimensione ho M

bins, il numero totale di celle è Mn

Approssimo f(x|H) con la probabilità nella cella singola,

determinando gli Mn parametri.

Per n grande, il numero di celle cresce tanto da rendere

impossibile una generazione MC con sufficiente statistica

Alessandro De Falco, INFN Cagliari

8

8/19/09

Una soluzione di compromesso consiste nel

definire una funzione t(x) con meno parametri

Determinare i parametri col Monte Carlo per ottenere la migliore

discriminazione tra H0 e H1

n

Es.:

T

t x = ∑ ai x i =

a x

i=1

scelgo le ai che massimizzano la separazione tra g(t|H0)

e g(t|H1)

La media e la covarianza per le componenti di x sono:

k i =∫ x i f x∣H k d x

k=0,1

i,j=1,2,...,n

V k ij =∫ x−k i x−k j f x∣H k d x

per t(x):

Richiedo:

T

k =∫ t gt∣H k dt =

a k

2

T

2

k =∫ t −k gt∣H k dt=

a Vk

a

∣ − ∣

grande 0 1

2

2

piccoli 0 , 1

Alessandro De Falco, INFN Cagliari

(pdf concentrate intorno alle medie)

9

8/19/09

Discriminante lineare di Fisher

Definiamo come misura della separazione

2

J

a =

0 −1

2

2

0 1

2

n

n

i , j=1

i , j =1

T

0 −1 = ∑ ai a j 0 −1 i 0−1 j = ∑ ai a j B ij =

a B

a

2

2

n

T

0 1 = ∑ ai a j V 0 V 1 ij =

a W

a

i , j=1

J

a =

T

a B

a

T

a W

a

cerco le ai che massimizzano J:

∂J

∂ ai

=0

a ∝W

−1

0 −1

DISCRIMINANTE LINEARE

DI FISHER (determinato a meno

di una costante)

Nota: ho usato non l'informazione completa su f(x|H0), f(x|

H1) (n-dimensioni*M bins) ma solo i valori medi e le

varianze

Alessandro De Falco, INFN Cagliari

10

8/19/09

Posso generalizzare t(x):

n

t x =a 0 ∑ a i x i

i=1

Uso una scala arbitraria e l'offset a0 per fissare 0, .

In questo caso la massimizzazione di:

2

J

a =

0 −1

2

2

0 1

corrisponde alla minimizzazione di:

2

2

2

2

0 1 =E 0 [t −0 ] E 1 [t−1 ]

Alessandro De Falco, INFN Cagliari

11

8/19/09

Test statistici

Supponiamo che l'ipotesi H predica f(x|H) per qualche

vettore di dati x=(x1,x2,....,xn)

Osserviamo un solo punto: xOBS. Che cosa possiamo dire

della validità di H alla luce dei dati?

Decidiamo quale parte nello spazio delle x rappresenta

una minore compatibilità con H rispetto a xOBS.

Alessandro De Falco, INFN Cagliari

12

8/19/09

Solitamente si costruisce una statistica di test il cui valore

riflette il livello di compatibilità tra x e H, ovvero:

A bassi valori di t corrispondono dati PIU' compatibili con H

Ad alti valori di t corrispondono dati MENO compatibili con H

Supposta nota la p.d.f. f(x|H), si può determinare g(t|H)

Esprimiamo la bontà del fit fornendo un valore che viene

chiamato LIVELLO DI SIGNIFICATIVITA' o P-value.

P è la probabilità di osservare i dati x (o t(x)) che hanno

uguale o minore compatibilità con H rispetto a xOBS.

P non è la probabilità che H sia vero.

Nell'approccio classico non si prova a dare una probabilità

che H sia vero, dato che un'ipotesi non è trattata come una

variabile casuale

Nell'approccio bayesiano:

P H∣t =

P t∣H P H

∫ P t∣H P H dH

è necessario fare un'ipotesi su P(H)

Alessandro De Falco, INFN Cagliari

13

P(H): probabilità a priori di H

8/19/09

Un esempio:

La probabilità di osservare nT teste in N lanci di una moneta è:

f nT , N =

N!

nT ! N −nT !

nT

P T 1− PT

N −n T

Ipotesi H: PT =0.5

Usiamo la statistica t =∣nT − N / 2∣

per verificare la bontà

dell'ipotesi

Supponiamo di lanciare la moneta 20 volte e ottenere 17 volte

testa

t OBS =7

La regione dello spazio delle t con compatibilità uguale o minore

è t>=7

P−value= Pt ≥7=P nT =0,1,2,3,17,18,19,20=0.0026

Ciò non ci dice che l'ipotesi H è falsa, ma ci dà solo la probabilità

di ottenere un livello di incompatibilità con l'ipotesi H maggiore

o uguale rispetto a quello osservato.

Alessandro De Falco, INFN Cagliari

14

8/19/09

Significatività di un segnale osservato

Supponiamo di avere n eventi che possono essere:

nB eventi da processi noti, che costituiscono il fondo

nS eventi da processi nuovi, che costituiscono il segnale

Se nB e nS sono poissoniane con medieB e s, anche n = nB + nS

è poissoniana con B + s

n

P n ; S , B =

S B

n!

e

− S B

Supponiamo di osservare nOBS=5 con B=0.5.

Possiamo affermare di avere osservato l'evidenza per una

scoperta?

Ipotesi H: s=0, ovvero c'è solo fondo.

P−value= P n≥nOBS =

∞

∑

n=n OBS

P n ; S =0, B =1−

nOBS −1

∑

n=0

n

b

n!

e

− B

=1.7⋅10−4

Questa quantità NON è P(s=0), ma la probabilità di ottenere 5 o

più eventi, supposto s=0.

Alessandro De Falco, INFN Cagliari

15

8/19/09

Una nota:

Spesso il risultato di una misura è dato come il valore stimato ±

la sua deviazione standard. In questo caso abbiamo 5± 5

Se sottraiamo il fondo, pari a 0.5, otteniamo

Ovvero solo 2 deviazioni standard dallo 0.

4.5 ± 2.2

Questo è fuorviante perchè in questo modo il risultato dà

l'impressione che non ci sia una grande incompatibilità con

l'osservazione di zero eventi, mentre il P-value suggerisce il

contrario.

Ciò che ci serve in questo caso è la probabilità che il fondo, con

valore medio 0.5, fluttui fino a 5, e non la probabilità che una

variabile con valore medio 5 fluttui fino a 0.5 o meno.

Alessandro De Falco, INFN Cagliari

16

8/19/09

Nota: normalmente B avrà un'incertezza. Se fosse B=0.8,

avremmo:

P−value= P n≥nOBS =

∞

∑

P n ; S =0, B =0.8=1.4⋅10

−3

n=n OBS

un ordine di grandezza più alto del precedente.

E' dunque necessario quantificare l'incertezza sistematica

dovuta al fondo.

La procedura corretta consisterebbe dunque nel riportare un

range di valori di P per una variazione ragionevole di B.Non

esistono delle convenzioni fissate.

Alessandro De Falco, INFN Cagliari

17

8/19/09

Estrazione di un segnale da un picco.

Supponiamo di misurare per ogni

evento una grandezza x, e di saper

valutare il fondo, indicato con la curva

tratteggiata.

11 eventi osservati nei due

bin del picco. Il fondo stimato è pari a B=3.2 eventi

P n≥11 ; B =3.2, S =0=5.0⋅10

−4

Ciò significa che abbiamo effettivamente visto il segnale?

Non sappiamo a priori dove aspettarci il picco.

Se il numero di bins è alto ci saranno delle fluttuazioni che

simuleranno delle discrepanze rispetto all'andamento atteso

(tratteggiato in figura)

✔

Quale è la probabilità di osservare una discrepanza altrettanto

improbabile quanto il picco osservato in due bin adiacenti qualunque

dell'istogramma?

Alessandro De Falco, INFN Cagliari

18

8/19/09

Test del

Test per confrontare i dati osservati ni con i valori di

aspettazione i.

Tracciamo in un istogramma di N bins una variabile x con

una distribuzione determinata.

Supponiamo che i conteggi nel bin i-mo siano ni , e il valore

aspettato i .Se le ni sono poissoniane con valori medi i e

ni>~5, la variabile:

n n − 2

2

=∑

i=1

i

i

i

seguirà una distribuzione del con n gradi di libertà

(indipendentemente dalla distribuzione di x).

La richiesta ni>5 equivale a richiedere che la distribuzione

delle ni sia approssimabile a una gaussiana.

Maggiore è il maggiore la discrepanza col valore atteso

∞

Il P-value sarà:

distribuzione del con P=∫ f x ; n dx

Alessandro De Falco, INFN Cagliari

2

19

n gradi di libertà

E(x)=n

8/19/09

Nel caso in cui il numero di eventi per bin è

piccolo, non si può più assumere che le ni siano

approssimativamente gaussiane, e la variabile

così costruita non seguirà più una distribuzione

del con n gradi di libertà, ma dipenderà dalla

pdf della variabile x.

Nel caso della figura, 2=29.8, n.d.f.=20, ma in

quasi tutti i bins n<5.

Il P-value può essere ottenuto determinando la

distribuzione della statistica col Monte Carlo:

Genero le nI poissoniane con valore medio

i

Calcolo il 2

Reitero il processo N volte fino ad ottenere

una distribuzione del 2 Monte Carlo

Integro questa distribuzione per ottenere il

P-value

In questo modo ottengo P=0.11 (con la

distribuzione del 2 avrei ottenuto P=0.073)

In questo caso il test del non fornisce l'evidenza

per la presenza di un picco.

Alessandro De Falco, INFN Cagliari

20

8/19/09