Appunti di Tecnologie e progettazione

di Sistemi Informatici

e di Telecomuniazioni

terzo anno

quarto anno

Rappresentazione delle informazioni

Modello di un processo di comunicazione

La comunicazione può essere definita come il procedimento per trasmettere e ricevere messaggi.

Gli elementi della comunicazione sono quindi la sorgente fonte del messaggio, il destinatario

che riceve il messaggio ed il canale, cioè il mezzo attraverso cui il messaggio passa dalla

sorgente al destinatario.

messaggio

Il processo di comunicazione può essere sincrono, se la sorgente ed il destinatario utilizzano lo

stesso clock per la trasmissione, asincrona se sorgente e destinatario non hanno un orologio

comune per cui i messaggi sono preceduti da caratteri di controllo che servono alla

sincronizzazione del trasmettitore e del ricevitore. La comunicazione può essere :

Unicast: c’è solo un destinatario

Multicast: i destinatari sono un gruppo specifico (

televisione a pagamento )

Broadcast : i destinatari sono tutti ( televisione )

Per messaggio intendiamo il fatto o la notizia, che ha un significato oggettivo per informazione

ciò che ha un valore soggettivo.

Per meglio comprendere un processo di comunicazione, possiamo usufruire del modello di

Shannon:

Sorgente Fonte del messaggio

CS Codifica di sorgente : si sceglie un codice e si codifica il messaggio, dalla parte del

destinatario vi è la DS ( decodifica di sorgente ) che opera il processo inverso.

CC Codifica di canale : Il messaggio viene inviato con ridondanza, ovvero, vengono aggiunti

dei bit al messaggio, per consentire al destinatario di rilevare ed eventualmente correggere errori,

dalla parte del destinatario vi è la DC ( decodifica di canale ) che opera il processo inverso.

CL Codifica di linea Il messaggio per essere inviato deve passare da una forma simbolica ad

una forma di segnale elettrico per adattarlo al tipo di canale, dalla parte del destinatario vi è la

DL ( decodifica di linea ) che opera il processo inverso.

TX Trasmettitore Il trasmettitore manderà il messaggio sul canale .

Canale Il messaggio arrivato sul canale potrebbe incontrare del noise, cioè rumore che può

alterare il significato del messaggio .

RX Ricevitore : Il messaggio arriva al ricevitore.

DL Decodifica di linea Il messaggio è ritrasformato da segnale elettronico a messaggio in

simboli.

DC Decodifica del canale Viene controllata la ridondanza inviata nel messaggio, per

verificare l’esistenza di eventuali errori.

DS Decodifica del messaggio Il messaggio viene decodificato.

2

Destinatario Riceve il messaggio .

Tipologia dell’informazione

Le principali categorie di informazioni che tratta un’elabotatore sono

numeri e operazioni su di essi;

dati alfanumerici

immagini

filmati

suoni

Con il termine di multimedialità si intende la confluenza di più mezzi di comunicazione ( suoni

immagini, filmati, testo ) su uno stesso strumento informativo ( ipertesto )

I protocolli

Il protocollo è l’insieme delle regole che determinano le modalità con cui

il destinatario si scambiano dati.

il mittente e

Trasmissione parallela, seriale sincrona e seriale asincrona

Abbiamo una trasmissione parallela se i bit che rappresentano i caratteri del messaggio da

trasmettere vengono inviati contemporaneamente su più linee.

Poiché si usa una linea per bit non è possibile usare per la trasmissione la rete telefonica esistente.

La rete telefonica, infatti, è stata realizzata per trasmettere la voce su un solo filo per cui possiamo

trasmettere un bit per volta con una modalità di trasmissione seriale.

La trasmissione parallela è utilizzata per collegamenti di breve distanza, anche se a parità di

condizioni fornisce una maggiore velocità ( nell’ esempio in figura 8 volte ).

Rumore

In un sistema di comunicazione insieme al segnale utile è presente anche un segnale

completamente privo di informazione e che influisce sulla corretta ricezione del messaggio.

Parleremo di

rumore generato dagli stessi apparati elettronici impiegati per la trasmissione; è sempre presente ;

disturbo del tutto casuale determinato da vari fattori quali onde elettromagnetiche provenienti da

eventi naturali ( ad esempio i fulmini ) o artificiali quali accensioni di motori, interferenze fra

circuiti ecc. ecc..

3

Digitale o Binario

Analogico e digitale

In natura tutte le grandezze fisiche seguono un andamento continuo e la loro rappresentazione

grafica spesso, è funzione continua del tempo.

Con segnale analogico si indica la rappresentazone di una grandezza fisica tramite una grandezza

analoga che la desecrive completamente.

La temperatura, la pressione sono grandezze fisiche analogiche e vengono rappresentate

graficamente in funzione del tempo. La rappresentazione numerica di una grandezza analogica è

quasi sempre , istante per istante, rappresentata da un numero reale di precisione infinita ( dopo la

virgola infinite cifre ).

Di un seganle analogico ( quindi che può assumere valori infiniti ) è possibile effettuare

misurazioni in particolari istanti di tempo ( campionamento ) del segnale. In questo modo si passa

da un insieme infinito di valori ad un insieme discreto.

Se misuriamo il segnale precedente a intervalli di tempo prefissati e manteniamo il valore letto per

tutto l’intervallo di tempo fino alla lettura successiva, otteninamo un segnale ad onda quadra

ottenendo così la digitalizzazione del segnale cioè abbiamo trasformato un segnale analogico in uno

digitale.

4

Perché un PC possa elaborare dati analogici è necessario prima un convertitore analogico /

digitale quindi l’il personal computer per elaborare il segnale proveniente dal converitore ed infine

un convertitore digitale / analogico per ottenere nuovamente in segnale analogico elaborato.

I vantaggi dell’elaborazione digitale rispetto a quella analogica sono:

i dati digitali possono essere elaborati da un computer;

e’ possibile integrare diverse fonti ad esempio musica, parole, immagini in un unico

supporto come ad esempio una chiavetta USB;

attraverso internet si possono condividere le informazioni.;

il sistema digitale e semplice, poco costoso e insensibile ai disturbi.

Sistemi di numerazione posizionali

Un sistema di numerazione è l’insieme dei simboli e delle regole che permettono di esprimere i

numeri. Le cifre sono i simboli usati in un sistema di numerazione. Si dice base di un sistema di

numerazione il numero di simboli che si usano per scrivere i numeri.

Un sistema di numerazione si dice posizionale se il valore di una cifra dipende dalla posizione

che essa occupa nella scrittura del numero.

Nel numero decimale 111 è evidente che l’ uno più a destra ha un “peso” minore rispetto a quello

centrale e ancor di più rispetto a quello più a sinistra. Infatti il numero si può rappresentare

secondo la scrittura polinomiale per cui ogni cifra a partire da destra viene moltiplicata per la base

elevata ad una potenza che rappresenta la posizione della cifra cominciando a contare da 0.

111 = 1 * 102 + 1 * 101 * 1 * 100

Sistema decimale

Nel sistema di numerazione decimale si usano i dieci simboli: 0, 1, 2, 3, 4, 5, 6, 7, 8, 9.

Esempio. 7408 = 7 * 10 + 4 * 10 + 0 * 10 + 8 * 10

Un qualsiasi numero reale può essere scritto nella forma polinomiale

Esempio 408,73 = 4 *10 + 0 * 10 + 8 * 10 + 7 * 10-1 + 3 * 10-2

3

2

2

1

1

0

0

Sistema binario

Nel sistema di numerazione binario si usano due simboli, solitamente indicati con 0 e 1.

Conversione di un numero intero da base 2 a 10.

Per trasformare un numero dalla base 2 alla base 10 si scrive il numero nella forma polinomiale e

si calcola il valore dell’espressione ottenuta considerando tutti i numeri come scritti in base 10.

Esempio 1001 = 1*23 + 0*22 + 0*21 + 1*20 = 1*8 + 0*4 + 0*2 + 1*1 = 8 + 1 = 9

Più rapidamente basta porre i pesi sopra ogni cifra a 1 e poi sommarli direttamente. Ad esempio

(2)

64

16

2 1

1 0 1 0 0 1 12 = 64 + 16 + 2 + 1 = 83

5

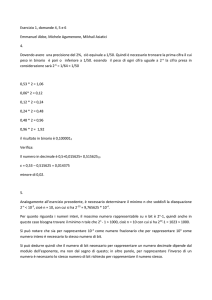

Conversione di un numero intero da base 10 a 2.

Per trasformare un numero da base 10 a base 2 si eseguono le divisioni intere successive del

numero dato per 2, e dei quozienti mano a mano ottenuti sempre dividendo per 2, fino ad avere

come quoziente 0: il numero scritto nella base 2 si ottiene riportando i resti delle divisioni presi in

senso inverso ( dall’ultimo resto al primo ).

Esempio. Convertire in base 2 il numero 55.

quoziente

resto

55 : 2

1

^

27 : 2

1

|

13 : 2

1

|

6 :2

0

|

3 :2

1

|

1 :2

1

|

0

Quindi 55 = 110111(2)

Conversione di un numero reale da base 10 a 2.

Per convertire un numero reale dobbiamo applicare due algoritmi: il primo per la parte intera in

secondo per la parte frazionaria. Per la parte intera l’algoritmo è quello delle divisioni successive

visto nel paragrafo precedente, per la parte frazionaria è quello delle moltiplicazioni successive

che possiamo enunciare così:

1.

si moltiplica per 2 la parte frazionaria;

2.

dal risultato si toglie la parte intera e si ritorna al punto 1. L’algoritmo ha termine

quando la parte frazionaria diventa 0 o si è raggiunto il numero di cifre desiderato.

Esempio

Convertire in base 2 il numero 0,6572

frazione

0,6572

0,3144

0,6288

0,2576

0,5152

*

*

*

*

*

2

2

2

2

2

prodotto

parte intera

1,3144

0,6288

1,2576

0,5152

1,0394

1

0

1

0

1

Il numero decimale 0,6572 = 0 , 101012 ottenuto prendendo le cifre della colonna parte intera.

Addizione nel sistema binario. Si può applicare lo stesso algoritmo dell’addizione nel sistema

decimale, occorre tenere presente che:

0+0

0

0+1

1

1+0

1

1+1

10 0 con riporto di 1

1

1100+

6

110=

-------------1 0 0 1 02

Sottrazione nel sistema binario. Si può applicare lo stesso algoritmo della sottrazione nel

sistema decimale, occorre tenere presente che :

0-0

0

1-1

0

1-0

1

occorre ‘prendere

0-1

in prestito’ una

unità dalla cifra di

ordine superiore

Quindi 111102− 10012=101012

Moltiplicazione nel sistema binario. Si può applicare lo stesso algoritmo che si usa per il

sistema decimale, tenendo presente che :

0*0

0

0*1

0

1*0

0

1*1

1

Esempio. 1112* 1012 = 1000112

Divisione nel sistema binario. Si può eseguire in modo analogo alla divisione nel sistema

decimale.

Esempio. 110102 : 1012 =112 con resto 1

Il sistema binario nell’informatica

L’unità di misura “naturale” dell’informazione per l’elaboratore è il BIT , ovvero una cifra o una

variabile binaria.

Poiché con un solo bit è possibile rappresentare solo due elementi ( associandoli ai due stati 0 e 1 )

dell’alfabeto esterno, per rappresentare un numero maggiore di informazioni si devono

necessariamente impiegare codici binari costruiti con sequenze (ordinate) di bit. Il termine ordinato

7

indica che, se si scambiano i valori (0 e 1) nella sequenza, si ottiene nella decodifica una

informazione diversa.

Una sequenza di n bit, con n numero intero, può assumere 2n configurazioni diverse e quindi

rappresentare altrettante informazioni.

Ad esempio con 8 bit potremo avere 28 = 256 diverse configurazioni e quindi potremo

rappresentare tutti i numeri da 0 a 255.

0

1

2

3

.

.

.

254

255

00000000

00000001

00000010

00000011

…….

…….

…….

11111110

11111111

Essendo il singolo bit un’unità troppo piccola per rappresentare l’informazione, si introducono i

concetti illustrati nella tabella seguente:

semibyte o nibble

sequenza ordinata di 4 bit.

Byte o ottetto (octet)

sequenza ordinata di 8 bit.

parola ( word )

sequenza ordinata di 2, 4 o 8 Byte a seconda del tipo di CPU e di

memoria centrale del calcolatore.

Nelle applicazioni, l’unità di misura bit è rappresentata con la lettera b , mentre il byte con B . Con

un semibyte, ad esempio, si possono rappresentare 24 = 16 simboli elementari diversi dell’alfabeto.

Attualmente, i sistemi di elaborazione devono gestire enormi quantità di informazioni codificate in

binario. La memoria utilizzata per codificare una pagina di testo è di qualche migliaio di byte,

quella usata per una immagine può raggiungere il milione di byte, mentre un lungo filmato può

richiedere miliardi di byte per essere memorizzato.

Si avverte la necessità, come nel sistema metrico decimale, di utilizzare dei simboli per

rappresentare i multipli delle grandezze elementari; nella terminologia informatica sono stati quindi

adottati gli stessi simboli del sistema decimale, ma visto che la misurazione della memoria ha come

sua base principale il 2, il loro significato è leggermente diverso. La tabella che segue riassume i

simboli e i valori dei multipli più usati:

multipl

sigla

valore

o

Kilo

k

210 = 1024

Mega

M

220 = 10242 = 1024 k

Giga

G

230 = 10243 = 1024 M

Tera

T

240 = 10244 = 1024 G

8

Nel campo informatico, per motivi esclusivamente pratici, si preferisce rappresentare sia i numeri

negativi, sia i numeri decimali utilizzando esclusivamente 0 e 1, senza cioè usare i simboli +, - né

la virgola per i numeri decimali.

Sistema esadecimale

Nel sistema esadecimale, abbreviato con esa o hex, si utilizzano i seguenti 16 simboli:

0, 1, 2, 3, 4, 5, 6, 7, 8, 9, A, B, C, D, E, F

Che corrispondono in decimale

0, 1, 2, 3, 4, 5, 6, 7, 8, 9,10,11,12,13,14,15

Conversione da sistema esadecimale a decimale.

Si scrive il numero in forma polinomiale e si eseguono le operazioni, il numero ottenuto è in

forma decimale.

Esempio.

2

1

0

AF316 = A*16 + F*16 + 3*16 = 10*256 + 15*16 + 3*1 = 2560 + 240 + 3 =

2803

Conversione da decimale a esadecimale.

Si divide il numero per 16 ripetutamente fino a ottenere quoziente 0, quindi si riportano i resti in

ordine inverso.

Esempio. Convertire 1204 nel sistema esadecimale

quoziente

resto

1204 : 16 = 75

4 = 416;

75 : 16 = 4

11= B16;

4

: 16 = 0

4 = 416;

0

poiché il quoziente è 0 si interrompe la serie di division1. Quindi 1204 = 4B416

Conversione di un numero intero dalla base 2 alla base 16

L’algoritmo è :

dividere il numero binario in gruppi di 4 cifre partendo da destra verso sinistra

sostituire ad ogni gruppo la corrispondente cifra esadecimale

Esempio. Convertire 10001111102 nel sistema esadecimale

10

0011 11102

2

3

14 = E16

Quindi 10001111102 = 23E16

Conversione di un numero intero dalla base 16 alla base 2

Basta sostituire ad ogni cifra esadecimale il corrispondente valore binario a 4 bit

Esempio. Convertire 3FD16 in base 2

3

F

D

0011 1111 1101 Quindi 3FD16 = 0011 1111 1101

Immagini, suoni e filmati

Queste informazioni sono di natura continua e devono essere trasformate in binario. Questa

trasformazione comporta una certa perdita di dati e a seconda della tecnica usata otteniamo risulati

più o meno fedeli all’originale.

Rappresentazione delle immagini in binario

Esistono diverse tecniche usate per la memorizzazione e l’elaborazione di un’immagine.

9

Immagini bianco nero senza grigi

Cominciamo col considerare un’immagine in bianco e nero, senza alcuna ombreggiatura

o livello di chiaroscuro.

Suddividiamo l’immagine tramite una griglia formata da righe orizzontali e verticali a distanza

costante a formare quindi quadratini tutti uguali. Ogni quadratino prende il nome di PIXEL (picture

element):

immagine

=

griglia di pixel

ad ogni pixel viene fatto corrispondere :

0 per la codifica del bianco quando questo colore è predominante nel pixel;

1 per la codifica del nero se questo colore è predominante nel pixel.

Per convenzione la griglia di pixel viene ordinata dal basso verso l’alto e da sinistra verso destra.

Con questa convenzione otteniamo una rappresentazione della figura di esempio di questo tipo:

il che significa che l’immagine di partenza viene rappresentata dalla stringa binaria

ottenuta leggendo la tabella per righe partendo dalla prima.

Se riconvertiamo la stringa dell’ mmagine sostituendo a ogni 1 un pixel nero e a ogni 0 un pixel

bianco otteniamo:

L’immagine di partenza è “appossimata”. Quindi come già accennato la digitalizzazioner comporta

una perdita di qualità dell’immagine di partenza .

Per migliorare la qualità esistono tecniche per “ingannare l’occhio” e limitare l’effetto a scalini

della visualizzazione a pixel.

10

La rappresentazione sarà più fedele aumentando il numero di pixel. Un’immagine digitale può

essere caratterizzata mediante due dimensioni:

Risoluzione: il numero di pixel che la costituiscono l’immagine espressi in termini di

larghezza per altezza

Profondità: il numero di bit che vengono usati per rappresentare un singolo

pixel dell’immagine, legata al numero di colori rappresentabili.

Nella figura seguente lo stesso cerchi con risoluzioni diverse

Immagini bianco nero con chiaroscuro

Per codificare diversi livelli di grigio con una rappresentazione binaria devo far corrispondere a

ogni livello di grigio una certa sequenza di bit

Ad esempio:

con 4 bit posso rappresentare 24 = 16 livelli di grigio

con 8 bit posso rappresentare 28 = 256 livelli di grigio

quindi nel primo caso per “descrivere” un pixel abbiamo bisogno di 4 bit, nel secondo di 8.

Considerando l’immagine del cerchio di risoluzione 58 x 56 = 3248 pixel, la grandezza

dell’immagine sarà 3248 x4 =12992 bit / 8 = 1624 Byte nel caso di profondità 4, 3248 nel caso di

profondità 8.

Immagini a colori

Per il colore si ha un sistema analogo alla immagine bianco nero con scala di grigi

Si individuare un certo numero di sfumature di colore differenti

Si codifica ogni sfumatura di colore mediante un’opportuna sequenza di bit

Le sfumature di colore vengono individuate attraverso l’uso del sistema RGB (Red, Green, Blu)

secondo cui qualsiasi colore può essere rappresentato componendo Rosso Verde e Blu (colori

primari) Invece che di partire da tanti colori e di rappresentarne diverse sfumature, possiamo

rappresentare molte sfumature a partire dai 3 colori primari, tutti i possibili colori ottenuti dalla

loro combinazione. La codifica RGB prevede che :

A ogni pixel associo una certa combinazione dei 3 gradazioni dei colori primari

La gradazione per ogni colore primario è rappresentata mediante un certo numero di bit

Esempio:

–

con 8 bit per colore primario ottengo 256 possibili gradazioni per colore primario

11

Quindi 256 × 256 × 256 = 16.777.216 colori diversi ( tutte le possibili combinazioni di tutte le

possibili gradazioni di Red, Green e Blu )

–

La codifica di 1 pixel richiede in questo caso 3 byte, quindi avremo una profondità

dell’immagine a 24 bit

R

0

1

2

3

…..

….

253

254

255

G

0

1

2

3

…..

….

253

254

255

B

0

1

2

3

…..

….

253

254

255

Considerando la prima colonna lo 0 rappresenta il colore primario Rosso 1,2,3…., 255 le varie

sfumature del rosso. Così per le colonne del green e del blu.

Questo tipo di codifica dei pixel viene detta codifica bitmap ed il numero di bit utilizzati per

codificare ogni pixel è detta profondità del colore.

Ottimizzazione della dimensione dell’ immagine tramite compressione

Se ad esempio abbiamo un’immagine con risoluzione di 640 x 480 pixel e profondita 24 bit la sua

dimensione sarà :

640 x 480 x 24 = 7.372.800 bit = 921.600 Byte

La codifica bitmap è estremamente costosa in termini di occupazione di spazio di memoria .

Maggiore è la qualità, maggiore sarà lo spazio occupato. Quindi utilizzando una simile codifica

trasmettere in rete l’immagine sarebbe oneroso in termini di tempo. In sintesi

maggiore qualità dell’immagine -> maggiore spazio occupato -> maggiore tempo di trasmissione

Esempio

Un’immagine bitmap con risoluzione 400 ×400 e profondità 24 ha dimensione di circa 480 KB. Ci

metterebbe circa 70 secondi a essere visualizzata per intero in una pagina web, data una

connessione a Internet via modem telefonico, che consente una velocità massima di scaricamento

dei dati di 56kb per secondo

La soluzione a questo inconveniente è ottimizzarla cioè ridurne le dimensioni ( comprimere

l’immagine ) quanto più possibile mantenendo la qualità dell’immagine a livelli accettabili

Vi sono due metodologie di compressione :

lossless : senza perdita di informazione;

lossy : con perdita di informazione ed è il più utilizzato.

Il primo metodo si basa di riconoscere nella rappresentazione binaria dell’immagine di sequenze di

bit che si ripetono con maggiore frequenza e nella loro sostituzione con sequenze più corte, in

modo da rispormiare spazio.

Questo tipo di codifica viene utilizzata per i formati GIF , PNG e TIFF ed è utilizzato dai

programmi di compressione WinZIP e WinRAR.

In particolare il formato GIF viene utilizzato per le applicazioni Internet in quanto offre buona

qualità dell’immagine occupando poco spazio consentendo rapide visualizzazioni di pagine Web.

Un file GIF può contenere più immagini ed uno sfondo, che il browser può visualiuzzare come

animazioni ( GIF animate ). I limiti del sistema GIF sono

Pochi colori : 256

12

Stampa scadente delle immagini.

I metodi lossy si usano per i dati multimediali. Essi sfruttano i limiti delle capacità percettive

dell’occhio umano. Ad esempio la retina dell’occhio è maggiormente insensibile alle variazioni di

luminosità che a quelle di colore: questo permette di trascurare differenze piccole di sfumature di

colore tra pixel vicini riducendo le sfumature e quindi la dimensione dell’immagine. Il formato

JPEG usa questo metodo e consente di visualizzare immagini a 256 colori consentendo anche di

definire la percentuale di compressione. Quindi maggiore compressione minore qualità

dell’immagine. IL metodo lossy viene utilizzato anche per codificare immagini in movimento nei

formati MPEG e WMV.

Immagini vettoriali

Un oggetto grafico bitmap è memorizzato semplicemente come una griglia di pixel a ciascuno dei

quali è associato un colore. Una volta disegnata una linea, essa non è più una “linea” ma solo un

insieme di pixel sullo schermo, pertanto non è più possibile modificarne le coordinate.

Le manipolazioni che si possono fare su un oggetto bitmap ( ad esempio con Photoshop ) si basano

sul concetto di modificare la posizione e il colore di un pixel.

Esiste un altro tipo di approccio alla rappresentazione delle immagini ed è la grafica vettoriale,

utilizzato principalmente quando le immagini sono geometriche ( linee, cerchi rettangoli..). In

questo caso non si registrano le immagini ma il procedimento per costruirle ottenendo due vantaggi:

minima occupazione di spazio;

facile ridimensionamento delle figure.

Ogni oggetto è codificato tramite un identificatore ed alcuni parametri che lo caratterizzano, ad

esempio

Circle 98 66 50 ( 98, 66 ) sono le coordinate del cerchio 50 è il raggio

Polyline 0 48 88 152 88 48 è un poligono con le 3 coordinate deli vertici

Sono esempi di formati per grafica vettoriali :

ai (Adobe Illustrator)

cdr (Corel Draw)

svg (Scalable Vector Graphics)

dwg (AutoCAD etc. - Grafica vettoriale)

dxf (Drawing Interchange (eXchange))

dwf (Autodesk Design Review)

fla (Macromedia Flash)

lfp (Laser file plus)

prt (Vari)

Il processo di di visualizzazione di un’immagine vettoriale e detta rendering o rasterizzazione.

Rappresentazione dei filmati

I filmati o immagini in movimento vengono rappresentati da una serie di immagini fisse ( frame o

fotogrammi ) visualizzati ad una frequenza ( frame rate ) tale da consentire all’occhio umano di

ricostruire il movimento.

Quindi come per le immagini fisse ogni frame deve essere convertito in digitale per poterlo

memorizzare in digitale e quindi riconvertirlo in analogico per riprodurlo.

La codifica comprende

codifica dati audio

codifica dati video

loro sincronizzazione

Sarebbe altamente inefficiente codificare completamente ogni frame e quindi per ovviare a questo

in conveniente viene utilizzata ad esempio la codifica differenziale ( compressione ) che consiste

13

sostanzialmente nel codificare alcuni frame chiave interamente, altri solo nelle parti che

differiscono da quelli adiacenti.

Lo standard di compressione differenziale più conosciuto è l’ MPEG (Movie Picture Experts

Group). I file in questo formato hanno estensione .mpg. Questo formato opera diverse compressioni

compressione spaziale ( all’interno del singolo fotogramma )

compressione temporale (sfrutta componenti comuni fra fotogrammi successivi per

effettuare compressioni su un’intera scena )

Esistono 3 diversi standard appartenenti a questo gruppo: MPEG-1, MPEG-2, M-PEG4

Altri formati video sono Quicktime (Apple), Avi (Microsoft) Real Video: molto usato in

applicazioni di streaming video.

A differenza del classico download dove è necessario attendere lo scaricamento completo di un file

prima di poterlo vedere, lo streamming video consente di visualizzare un filmato mentre i frame

vengono trasmessi continuamente l’uno dopo l’altro ( naturalmente con un piccolo ritardo ); poi

vengono buttati via.

Rappresentazione dei suoni

Anche i suoni possono essere rappresentati in forma digitale Dal punto di vista fisico un suono è

un'alterazione della pressione dell'aria che, quando rilevata dall'orecchio umano, viene trasformata

in un particolare stimolo al cervello. La durata, l'intensità e la variazione nel tempo della pressione

dell'aria sono le quantità fisiche che rendono un suono diverso da ogni altro.

Un suono può essere rappresentato mediante un’onda che descrive la variazione della pressione

dell'aria nel tempo. Sull'asse delle ascisse rappresentiamo il tempo e sull'asse delle ordinate la

pressione corrispondente al suono stesso.

La conversione di un segnale continuo in una successione di numeri viene eseguita con due

successive operazioni elementari:

1. Campionamenti sull’onda: si misura il valore dell’onda a intervalli di tempo costante;

2. Quantizzazione e codifica: ogni campione viene quantizzato ossia convertito in un

numero; la sequenza dei valori numerici ottenuta dai campioni può essere facilmente

codificata in forma digitale.

Quanto più frequentemente viene campionato il valore di intensità dell'onda, tanto più precisa sarà

la rappresentazione dell'onda.

14

Osservazione: Un errore viene comunque introdotto quando si converte il valore analogico di un

campione in un numero con un numero limitato di cifre , quindi la codifica digitale introduce

sempre una perdita di qualità.

Se ad esempio consideriamo un CD musicale si mescolano due registrazioni ( stereofonia= 2

sorgenti di audio);

44.100 campioni al secondo per ogni registrazione;

16 bit per memorizzare l’informazione di ogni campione. Quindi servono:

44.100 campioni × 16 bit × 2 = 1.411.200 bit per ogni secondo di registrazione.

Osservazione

Per calcolare lo spazio occupato da un file di testo, da un’immagine, da un file audio, la tecnica è

sempre la stessa

Si trova quanti bit occupa ogni unità elementare costituente il file (un carattere per il testo,

un pixel per l’immagine, un campione per il file audio )

Si trova il numero di unità elementari che costituiscono il file (il numero di caratteri per il

testo, il numero di pixel per l’immagine -sfruttando la risoluzione, il numero di campioni

per il file audio sfruttando la frequenza di campionamento)

Si moltiplicano queste due quantità

Formati audio

Un formato non compresso è il WAVE con estensione .wav. Un esempio di formato compresso è

l’ MPEG3 (mp3) la cui estensione è .mp3.

formato specializzato per la compressione e la trasmissione di file audio digitali.

Le sue caratteristiche principali sono:

garantisce una fedeltà molto alta ( praticamente indistinguibile dal suono non compresso )

efficienza e grande diffusione: la dimensione del file ottenuto è molto inferiore di quella

originale ( anche un decimo o meno), permette di trasmettere file audio anche con

connessioni molto lente.

L’ MP3 viene utilizzato anche per lo streaming audio che prevede :

compressione dell’audio da parte della sorgente audio ( per esempio una radio su web )

il dato audio compresso viene trasmesso a un destinatario ( per es. ad un PC )

il PC possiede il programma codec per la decodifica del dato e quindi è possibile sentire il

suono man mano che viene trasmesso.

Un requisito importante per lo streamming sia video che audio è una connessioni a larga banda.

15

Codici

L’ alfabeto è l’insieme dei simboli con i quali si costruiscono le parole

La parola è l’oggetto formato da una sequenza di uno o più simboli appartenenti ad un alfabeto.

Si dice alfabeto sorgente T = ( x1, x2, x3 ….,xn ) l’insieme dei valori da rappresentare mentre

l’ alfabeto in codice E= ( e1, e2, e3…, ek ) è l’insieme dei simboli che servono a rappresentare le

parole costruite con l’alfabeto sorgente.

Una parola ( o stringa ) di lunghezza l costruita con l’alfabeto E è definito codifica o

trasformazione.

L’applicazione che associa ad ogni parola di T una parola di E di lunghezza l viene detta codice.

Per costruire un codice bisogna prima

definire il numero dei simboli dell’alfabeto

la lunghezza delle parole.

l

Se abbiamo un alfabeto di n simboli e lunghezza di parola l avremo n parole diverse tra loro.

8

Ad esempio n = 2 l = 8 avremo 2 = 256 parole o stringhe diverse fra loro.

Ogni codice ha una sua lunghezza minima di parola cioè il numero minimo di simboli che

devono avere tutte le parole per non codificare in un modo ambiguo le stringhe costruite con

l’alfabeto sorgente;

lunghezza della parola = lunghezza minima avremo un codice efficiente,

lunghezza della parola > lunghezza minima avremo un codice ridondante

I codici possono codificare solo numeri ed in questo caso avremo codici efficienti numerici e

codici che possono codificare simboli di vario genere ( lettere, cifre, segni di interpunzione ecc..

ecc.. ) detti codici efficienti alfanumerici.

Codici efficienti numerici

Esempi di codici efficienti numerici sono:

• Il codice BCD con S = 2 e L = 4 quindi potremo codificare 24 = 16 parole diverse

• Codice Eccesso 3 con S = 2 e L = 4

Il codice BCD è un codice efficiente e ponderato, efficiente perché per codificare le 10 cifre

decimali utilizza 4 bit ossia una lunghezza uguale a quella minima; ponderato perché ogni bit ha

un valore in base alla sua posizione, per questo motivo il codice viene anche chiamato codice

8421 cioè il valore decimale delle potenze di 2 partendo dal bit più significativo a quello meno

significativo.

Tabella del BCD

Decimale

BCD

0

0000

1

0001

2

0010

3

0011

4

0100

5

0101

16

6

0110

7

0111

8

1000

9

1001

Il codice eccesso 3 è un codice numerico efficiente che codifica le cifre decimali su 4 bit. Ed è un

codice non ponderato, ma autocomplementante, cioè per ottenere il complemento a 9 di una cifra

basta invertire i bit corrispondenti. Il suo nome deriva dal fatto che ogni codifica è ottenuta dalla

corrispondente configurazione binaria sommata a 3.

Tabella codice eccesso 3

decimale

eccesso 3

0

0011

1

0100

2

0101

3

0110

4

0111

5

1000

6

1001

7

1010

8

1011

9

1100

Da notare che per i due codici esaminati delle 16 possibili parole se ne utilizzano 10 soltanto,

cioè il numero delle cifre del sistema numerico decimale.

Codici efficienti alfanumerici

Quando in un processo di comunicazione l’oggetto è un testo costruito non solo da cifre ma anche

da caratteri alfabetici e caratteri speciali, occorre utilizzare i codici alfanumerici, ovviamente

questi codici hanno lunghezza di parola maggiore di 4.

Esempi di codici efficienti alfanumerici sono:

codice

S = numero

simboli

L= lunghezza parola

Codice ASCII

2

7o8

Codice EBCDIC

Codice ISO-8859

2

2

8

8

17

numero parole

7

8

2 =128

o 2 = 256

8

2 = 256

8

2 = 256

Codice Unicode

2

16

16

2 = 65536

Il codice ASCII

Fra i codici alfanumerici è molto usato e può rappresentare un vasto numero di caratteri.

Il codice ASCII nella versione standard è un codice a 7 bit con il quale si possono codificare 128

simboli (oppure se lo si vuole estendere ad 8 bit può codificare 256 simboli) diversi. Esso è

formato da due diverse categorie: i caratteri riproducibili (cioè se digitiamo sulla tastiera le parole

si vedono i suoi effetti) ed i non riproducibili (cioè se premiano sulla tastiera, per esempio, "invio"

non si vedrà nulla tranne il movimento del cursore nella riga successiva).

Il codice EBCDIC

Un altro codice a 8 bit utilizzato è il codice EBCDIC sviluppato da IBM per i propri sistemi di

grandi dimensioni;poiché è utilizzato solo dai sistemi IBM,questo codice rende incompatibili le

macchine IBM con sistemi appartenenti ad altri produttori.

Ogni byte comprende due parti(semibyte o nibble) di quattro bit:

Il semibyte più significativo è detto Zonatura

Il semibyte meno significativo è detto Numerico

I caratteri alfanumerici contigui sono raggruppati in blocchi:

Quattro blocchi principali(le prime 4 zone) da 0000 0000 a 0011 1111 che sono riservati hai

caratteri di controllo

I blocchi da 0100 0000 a 1011 1111 sono per le lettere minuscole

I blocchi da 1100 0000 a 1111 1111 sono utilizzate per le lettere maiuscole e per le cifre

numeriche;mentre i per i numeri i bit di zonatura sono 1111.

Il codice ISO 8859 è una famiglia di 14 diversi codici ognuno dei quali ha un insieme di 256

caratteri.

Il set dei caratteri comprende gli alfabeti di quasi tutte le lingue del mondo; infatti lui identifica

con ISO 8859-n (per n sta il numero che scegliamo per la lingua[per ogni lingua sta un numero]).

Il codice Unicode è un sistema per scambiare , elaborare e visualizzare testo scritto nelle diverse

lingue nel mondo moderno;questo codice a confronto del resto include 34168 caratteri supportate

da 24 lingue diverse, tra le principali nel mondo.

Codici ridondanti

Lo schema del modello di comunicazione comprende la codifica di sorgente, che consiste nel

codificare il messaggio in modo tale da permettere a chi lo riceve di stabilire se il messaggio è

corretto o errato.

Per fare questo si usano i codici ridondanti, cioè codici che hanno una lunghezza di parola

superiore alla lunghezza minima.

Quindi se servono n bit per codificare un messaggio in modo efficiente, si deve utilizzare un

codice con lunghezze di parole m > n + k i k bit aggiuntivi sono detti bit di controllo.

La lunghezza delle parole del codice diventa m = n + k dove n è la lunghezza della parola e k i bit

aggiuntivi.

Si definisce ridondanza R il valore ottenuto dalle seguente formula:

m

R

=

n+k

=

k

= 1 +

n

n

18

n

Pertanto più grande è k e più tempo si impiega a trasmettere il messaggio.

I k bit di controllo non sono disposti in modo causale, ma secondo uno schema preciso che

permetta al destinatario di controllare la correttezza del messaggio ricevuto.

Peso:

il peso di una parola è il numero di bit 1 presenti nella parola stessa.

Distanza tra due parole:

Numero di posizioni in cui le parole hanno bit con valore diverso. Per esempio, se P1 = 10001 e

P2 = 10110, le due parole hanno distanza = 3.

Molteplicità dell’errore:

Distanza tra la parola trasmessa e la parola ricevuta.

Per esempio, si ha errore di molteplicità 2 quando ci sono 2 bit sbagliati nella parola ricevuta.

Distanza minima di hamming di un codice:

La distanza minima di hamming è la minima distanza tra una qualsiasi coppia di parole di un

codice ( si indica con h ).

Si può affermare che i codici efficienti hanno h = 1 e quelli ridondanti h > 1.

Più elevato è h , maggiore è la probabilità di rivelare una parola errata, perché il codice è in grado

di rilevare parole errate con molteplicità dell’errore fino a h-1.

Un codice in grado di rilevare l’errore non è detto che sia anche in grado di correggerlo: per

questo motivo i codici ridondanti si distinguono in codici rilevatori e codici correttori di errori.

I codici rilevatori richiedono meno bit di controllo rispetto ai codici correttori: quindi nel primo

caso la comunicazione è più efficiente rispetto al secondo caso.

In un processo di comunicazione se la comunicazione è bidirezionale (full Duplex) si utilizzano

codici rilevatori e l’errore si risolve con la ritrasmissione del messaggio; se, invece, la

trasmissione è unidirezionale (Simplex) si utilizzano codici correttori visto che il ricevente è

impossibilitato a trasmettere. Nella teoria dei codici si possono utilizzare i seguenti teoremi:

Teorema 1

Condizione necessaria e sufficiente affinché un codice sia in grado di rilevare errori di

molteplicità K è che la distanza minima di Hamming sia almeno K + 1.

Teorema 2

Condizione necessaria e sufficiente affinché un codice sia in grado di correggere errori di

molteplicità K e che la distanza minima di Hamming sia almeno 2K + 1.

Codici rilevatori di errori

Nel seguito sono presentati tre tipi di codici rilevatori di errori.

I primi due sono i più utilizzati nella trasmissione seriale, che può essere asincrona,come nelle porte

seriali del personal computer COM1 e COM2, oppure sincrona, come nelle schede di rete o nei

collegamenti in internet.

Codice a controllo di parità ( partity check )

Questo tipo di codice è costituito aggiungendo ad ogni parola un bit di controllo, come bit più

significativo, in modo da rendere pari ( oppure dispari ) il peso di ogni parola formata da m = n + 1

Bit.

Le caratteristiche di questo codice sono:

Ridondanza: R = m/n = n+1/n = 1+1/n. Distanza minima di Hamming: h = 2

Molteplicità dell’errore dispari, cioè il codice è in grado di rilevare un numero di bit errati di valore

dispari. Il controllo di peso pari e dispari presenta dal punto di vista matematico la stessa robustezza

agli errori. Dal punto di vista pratico è invece consigliabile adottare il controllo di peso dispari in

modo che la configurazione costituita da tutti 0 (assenza di collegamento) sia considerata errore,

situazione non rilevabile utilizzando il codice a controllo di peso pari.

19

Codice ciclico di ridondanza o controllo polinomiale

I codici cilici di ridondanza CRC, detti anche codici a controllo polinomiale,si basano sul fatto

che i bit che formano il messaggio possono essere considerati come coefficienti di un polinomio

completo di grado n-1 in x; n rappresenta il numero dei bit del messaggio. Indichiamo questo

polinomio con T(x).

Si consideri poi un polinomio G(x), detto polinomio generatore, di grado inferiore al polinomio

T(x) e avente il termine noto uguale a 1.

Dalla parte della sorgente si divide il polinomio T(x) per G(x) e si calcola il resto, che indichiamo

con R(x).Il trasmettitore invia il messaggio concatenato al resto R(x) cioè M(x) = T(x):R(x).

Dalla parte del ricevente si deve fare l’operazione inversa: dal messaggio ricevuto M(x)’ =

T’(x):R’(x) si prende la parte T’(x) e la si divide per il polinomio G(x), calcolando il resto R’’(x);

se la trasmissione è corretta, R’’(x) deve essere uguale a R’(x), altrimenti il messaggio deve essere

considerato errato.

Checksum

Checksum, tradotto letteralmente significa somma di controllo. È una sequenza di bit che viene

utilizzata per verificare l'integrità di un dato o di un messaggio che può subire alterazioni.

Ad esempio un algoritmo potrebbe essere :

Suddivido il messaggio in blocchi di lunghezza fissa

Applico lo XOR ai bit di ciascun blocco ( controllo trasversale ) ottenendo T bit

Applico lo XOR ai bit di stessa posizione nei i blocchi (controllo longitudinale) ottenendo B

bit.

Invio insieme al messaggio M , T e B

cioè M:T:B

Il ricevitore calcolerà T’ e B’ se T = T’ e B = B’ allora il messaggio ricevuto è corretto

altrimenti potrò rilevare e in alcuni casi correggere gli errori. Ad esempio:

controllo trasversale

1

1

0

0

0

1

1

1

1

1

0

1

1

1

1

0

1

0

0

1

1

1

0

1

0

0

1

1

1

0

1

0

1

0

1

0

0

0

0

1

1

0

1

0

1

1

1

1

1

0

1

1

1

0

1

0

0

1

0

0

0

1

controllo longitudinale

Il messaggio originale di 48 bit è stato suddiviso in blocchi di 8 bit. E’ stato applicato lo XOR ai

bit di ciascuna riga ( blocco ). Lo Xor è stato applicato ai bit di ogni colonna ( bit di uguale

posizione in ciascun blocco ) i bit così calcolati sono inviati al destinatario insieme al messaggio.

Nota

Ricordiamo la tavola della verità dello xor

a

b

a xor b

0

0

0

0

1

1

1

0

1

1

1

0

Osserviamo che calcolare lo xor su un gruppo di bit equivale a calcolarne il bit di parità pari.

Codici autocorrettori

20

Quando la trasmissione è di tipo Simplex, cioè il destinatario non è in grado di comunicare al

mittente che il messaggio è arrivato in modo coretto, occorre utilizzare i codici correttori,

codici in grado non soltanto di rilevare l’errore,ma anche di individuare la posizione del bit errato.

Il codice è costituito con il controllo longitudinale(ed orizzontale) e trasversale (o verticale) del

peso, pari o dispari, contenuto nel codice dei caratteri da trasmettere.

Per esempio,supponiamo di dover inviare un blocco di 4 caratteri, ognuno dei quali è formato da 4

bit, come illustrato nella tabella seguente:

C1

0 0 1

1

C2

1 0 1

1

C3

1 1 1

0

C4

0 0 0

1

Applicando il controllo di parità dispari sia in verticale che in orizzontale, il blocco da trasmettere

diventa il seguente:

C1

0 0 1 1

1

C2

1 0 1 1

0

C3

1 1 1 0

0

C4

0 0 0 1

0

1 0 0 0

0

Si osservi che il controllo longitudinale è applicato anche ai bit di controllo trasversale.

Supponiamo ora che durante la trasmissione il bit più significativo del carattere C2 venga

alternato passando da 1 a 0. Il ricevente ottiene la seguente tabella:

C1

0 0 1 1

1

C2

0 0 1 1

1

C3

1 1 1 0

0

C4

0 0 0 1

0

0 0 0 0

0

Il ricevente, facendo lo stesso tipo di controlli, rileva un errore nella riga 2 e nella colonna 1:

questo significa che il bit errato si trova all’intersezione della riga e della colonna che non

soddisfano il controllo. Pertanto il bit ricevuto come 0 viene corretto a 1.

Codici a lunghezza variabile

Una sorgente si dice discreta quando i simboli che può emettere sono in numero finito.

Le proprietà che caratterizzano i simboli sono:

• La probabilità di emissione,

• La quantità di informazioni da essi trasporta.

La probabilità di emissione indica la probabilità che un simbolo venga emesso tra gli N elementi

dell’alfabeto. Se i simboli hanno tutti la stessa probabilità di emissione, questa vale P = 1/N

21

Se le probabilità di emissione non è uguale per tutti i simboli, occorre calcolarla in modo empirico

come:

numero di volte che il simbolo si viene emesso

P(si) = ----------------------------------------------------------numero totale dei simboli emessi.

Misura dell’ informazione

Per informazione si intende tutto ciò che serve a togliere incertezza.

Se la sorgente ha un alfabeto di 2 simboli, l’emissione di un simbolo fornisce una maggiore

informazione rispetto alla sorgente precedente: in questo caso è come se una persona rispondesse

“si” o “no” alle domande; la sua risposta toglie incertezza.

La quantità di informazione trasporta da un simbolo è data dalla seguente formula:

l(S(i))=log1/p(S(i))

applicando la proprietà dei logaritmi, per la quale il logaritmo di un rapporto è uguale alla

differenza dei logaritmi, si può scrivere:

l(S(i))=log1-logP(S(i))=0-logP(S(i))=-logP(S(i))

Se i logaritmi sono in base 2, il risultato è espresso in bit.

Possiamo definire il bit come l’unità elementare di informazioni.

Se una sorgente emette simboli tutti con la stessa probabilità, l’informazione associata ad un

simbolo è data da:

I=1/log(2)p

Poiché p = 1/N, allora

I=log(2)1/1/N=log(2)N

Si può notare che più grande è N, maggiore è l’informazione associata ad ogni simbolo che viene

emesso. Nel caso minimo in cui la sorgente emetta 2 simboli, l’informazione vale log(2)=1 bit.

Si possono fare anche le seguenti considerazioni:

L’ informazione associata a un simbolo si misura in bit. Il bit rappresenta l’informazione

associata a un simbolo emesso da una sorgente con un alfabeto di 2 simboli indipendenti ed

equiprobabili. Una sorgente che emette simboli equiprobabili si dice priva di memoria o a

memoria zero.

Maggiore è la probabilità di emissione di un simbolo e minore è il suo contenuto informativo

rispetto ad un altro simbolo che ha probabilità di emissione minore.

Lunghezza media di un codice

Se una sorgente emette S(1),S(2); …S(n) simboli indipendenti, con probabilità p(1),p(2),

…,P(n),codificati con parole lunghe l(1),l(2), …, l(n) bit, la lunghezza media del codice è data

dalla seguente formula:

L = p(1)*l(1) + p(2)*l(2) +…+ P(n)*l(n)

Entropia

Si definisce entropia l’ informazione media di una sorgente S che emette simboli indipendenti in

sequenza.

L’ informazione media della sorgente è :

H(S) = ∑ P(S(i)) * l(S(i)) = ∑ –P(S(i)) * log P(S(i))

22

Essa si misura in bit ed indica il grado di incertezza di ricevere un simbolo tra gli n dell’alfabeto

della sorgente. La massima entropia si ha quando i simboli sono equiprobabili: applicando la

formula in questo caso si ottiene

H(S) = logN.

Codice di Huffman

I codici a lunghezza variabile si usano quando si conosce la probabilità di emissione dei simboli e

questi non hanno la steassa probabilità. In questo caso, per aumentare l’ efficienza della

trasmissione, si assegnano meno bit ai simboli più probabili e viceversa più bit a i simboli

meno probabili.

Il primo codice a lunghezza variabile, che utilizza la diversa probabilità di emissione dei simboli,

è il codice morse, utilizzato in radiotelegrafia e che utilizza due simboli, il punto e la linea, per

codificare i simboli dell’alfabeto e delle cifre numeriche. Nell’ uso dei codici a lunghezza

variabile occorre risolvere il problema della condizione del prefisso: cioè nessuna parola del

codice deve essere prefisso ( parte iniziale ) di una parola più lunga del codice, perché si

potrebbe avere difficoltà in fase di decodifica.

Per esempio, se la sorgente ha quattro simboli codificati con x1 = 1 , x2 = 10 , x3 = 11

E trasmette la sequenza x3 x2, la stringa del messaggio diventa 1110

In ricezione potrebbe essere interpretata come 1 1 10

Cioè x1 x1 x2 diversa da quella trasmessa.

Il codice di huffman risolve il problema attraverso una struttura ad albero, in cui i simboli sono le

foglie,utilizzando il seguente algoritmo.

Algoritmo di generazione del codice

Potremo suddividere l’algoritmo di generazione del codice in 3 fasi:

Prima fase

1.

I simboli vengono ordinati in senso decrescente di probabilità;

2.

I due simboli con minore probabilità vengono “fusi” in un nuovo simbolo con

probabilità somma

delle 2 probabilità dei due simboli componenti;

3.

Si ritorna ad 1) fino a che la tabella ha un numero di simboli

diverso da 1; Se l’unico simbolo rimasto ha probabilità 1 allora

potremo passare alla fase 2. Seconda fase ( costruzione dell’albero )

A questo punto si costruisce l’ albero di Huffman che ha come radice il simbolo finale e come

sotto alberi i simboli che lo hanno generato. Il processo è ricorsivo e termina quando tutte le

foglie sono simboli originari. Si assegna 1 al sottoalbero di destra e 0 al sottoalbero di sinistra.

Terza fase ( generazione del codice )

Per codificare i simboli basta attraversare l ‘ albero dalla radice al simbolo e registrare i bit che

man mano si incontrano.

Esempio:

Prima fase

Simbolo P(S)

Simbolo P(S)

Simbolo

P(S)

Simbolo P(S)

S1

1/2

S1

1/2

S1

1/2

S1

1/2

S2

1/4

S2

1/4

S2

1/4

C

1/2

23

Simbolo

P(S)

D

1

S3

1/8

A

1/8

S4

1/16

S3

1/8

S5

1/16

B

1/4

Attenzione prima di creare una nuova tabella riordinare in modo decrescente di probabilità.

Seconda

fase

D

|

-----------------------0|

|1

S1

C

-----------------------0|

|1

S2

B

-----------------------0|

|1

A

S3

-----------------------0|

|1

S4

S5

Terza fase

Simbolo

Codice

S1

0

S2

10

S3

111

S4

1100

S5

1111

Codici riflessi

I codici riflessi sono usati nei convertitori di segnali analogico/digitali e hanno le parole ordinate

secondo i numeri naturali in modo che ogni parola P abbia distanza 1 dalla parola precedente, P-1, e

dalla successiva P+1. I codici riflessi non sono ponderati e,poiché oltre a quantizzare una grandezza

analogica si deve anche elaborarla,occorre appoggiarsi ad un codice ponderato come i codici binari

puri.

Codice Gray

24

Il codice gray è un codice riflesso che ha la proprietà di avere semplici algoritmi di trasformazione

da codice binario a codice gray e viceversa:per questo motivo è praticamente l’ unico codice

riflesso utilizzato.

La conversione di un numero non viene cifra per cifra ma nel suo complesso. I codici di gray non

sono utilizzati nelle trasmissioni proprio perché, avendo distanza minima di hamming uguale a 1,

non possono utilizzare tecniche di rilevazione o correzione degli errori.

Per convertire una parola binaria a una parola del codice di gray si applica il seguente algoritmo:

1)Procedendo da sinistra verso destra, per ricavare il bit della parola di gray di posto i si esegue

l’operazione di OR esclusivo tra il bit di posto i e il bit i-1 della parola in binario.

2)Il primo bit della parola di gray si ottiene facendo l’ OR esclusivo tra 0 e il bit di posto 1

della

parola binaria.

Esempio

Convertire in codice di Gray i numeri 55, 56, 57 che hanno la seguente codifica binaria:

55= 110111 , 56=111000 , 57=111001

w

n

1

2

3

4

5

6

pb

55

1

1

0

1

1

1

pg

55

1

0

1

1

0

0

pb

56

1

1

1

0

0

0

pg

56

1

0

0

1

0

0

pb

57

1

1

1

0

0

1

pg

57

1

0

0

1

0

1

La prima colonna indica la parola :PB per la parola binaria,Pg per la parola di Gray. La seconda

parola indica il valore decimale del numero. Le altre colonne contengono i bit della codifica.

Ricordando che l’OR esclusivo vale 1 se i due bit sono diversi e zero se sono uguali, nel caso

della conversione dl numero 55:

il primo bit di Gray vale 1 perché il primo bit della parola binaria è 1 e bisogna farne l’OR

esclusivo con lo zero;

il bit 2 di Gray vale 0 perché il bit 1 ed il bit 2 della parola binaria sono entrambi 1;

il bit 3 di Gray vale 1 perché il bit 3 della parola binaria è 0 mentre quello di posto 2 è 1 e cosi

via.

Il procedimento inverso, per convertire una parola dal codice di Gray al codice binario, applica il

seguente algoritmo:

si esamina la parola di Gray da sinistra verso destra : i bit della parola binaria sono uguali a

quelli di Gray fino al primo bit di valore 1 che si incontra.

Dal bit successivo:

se il bit di Gray è 0, il corrispondente bit binario è uguale al bit che immediatamente lo

precede;

se il bit di Gray è 1, il corrispondente bit binario è l’opposto del bit che immediatamente lo

precede.

Come esempio, consideriamo i numeri precedenti in codice di Gray e li riportiamo in binario.

w

n

1

2

3

4

5

6

pg

55

1

0

1

1

0

0

pb

55

1

1

0

1

1

1

pg

56

1

0

0

1

0

0

pb

56

1

1

1

0

0

0

pg

57

1

0

0

1

0

1

pb

57

1

1

1

0

0

1

Per ottenere la parola binaria del numero 55 a partire dalla corrispondente parola di Gray si opera

in questo modo:

il primo bit della parola binaria è 1 perché il primo bit di Gray è 1 ;

il bit 2 della parola binaria è 1 perché il bit 2 di Gray è 0, quindi il bit 2 della parola binaria è

uguale al precedente che è 1.

il bit 3 della parola binaria è 0 perché il terzo bit di Gray è 1 e quindi il terzo bit binario deve

essere l’opposto del suo secondo bit, e cosi via.

Codifica dei numeri

Nel calcolatore la memoria è costituita da un numero finito di celle mentre l’insieme dei valori da

rappresentare è infinito quindi è possibile solo una rappresentazione parziale dell’informazione cioè

non tutti i valori possono essere rappresentati.

Supponendo di avere a disposizione n bit con i quali vogliamo rappresentare i seguenti dati:

un numero naturale ( 0, 1, 2, ...)

un numero relativo (...,-3,-2,-1, 0, +1, +2, +3, ... )

un numero razionale ( 0.0018, 2345.06, 12.0, ... )

Rappresentazione dei numeri naturali

Un numero naturale può essere rappresentato dalla sua notazione in binario.

Esempi :

con n = 8 rappresentare in memoria 10 il risultato sarà 0000 1010

cioè ai 4 bit necessari alla rappresentazione di 10 verranno aggiunti 4 bit a 0 a sinistra

54 verrà rappresentato 0011 0110 anche in questo caso sono stati aggiunti 2 bit a 0.

n

Quanti numeri possiamo rappresentare con n bit in base due ? 2

4

Ad es n = 4 2 = 16 potremo rappresentare 16 combinazioni quindi i naturali da 0 a 15.

Considerando l’esempio precedente se sommiamo a 11112 + 1 = 0000 perché il quinto bit che viene

generato dalla somma viene perso in quanto i bit a disposizione sono solo 4 ( overflow ).

n

Quindi in generale 2 - 1 + 1 = 0 questa proprietà viene detta circolarità della rappresentazione.

Rappresentazione dei numeri relativi

Sono 4 le modalità di rappresentazione dei numeri binari relativi:

• modulo e segno

• complemento a 1

• complemento a 2

• eccesso P

Rappresentazione modulo e segno

In questo formato il bit più significativo rappresenta il segno 0 = segno +

I restanti bit rappresentano il modulo

esempio:

con sequenze di quattro bit ( n = 4 )

1 = segno -

Notiamo che lo 0 viene codificato due volte 0000 e 1000 cioè abbiamo uno 0 postivo e uno

negativo. Questa rappresentazione pone difficoltà nell’esecuzione delle operazioni aritmetiche,

perché il segno va trattato in maniera differente dagli altri bit.

Rappresentazione con il complemento a 1

Ricordando che il complemento a 1 si ottiene invertendo il valore dei bit che costituiscono il

numero ovvero facendone il complemento dei bit.

esempio: 1010 il complemento a 1 sarà 0101

La rappresentazione in memoria di un numero relativo con il metodo del complemento a 1 ( CP1)

avendo a disposizione n bit si effettua nel seguente modo:

• i numeri positivi si rappresentano come i primi 2n-1 numeri naturali

• numeri negativi si rappresentano con il complemento a 1 del corrispondente intero

positivo esempi:

CP1(5) -> 5

= 0101

CP1(-5) -> complemento ( 0101) = 1010

esempio : con sequenze di quattro bit ( n = 4 )

Osserviamo che :

• i numeri positivi iniziano con zero i negativi con 1

• l’intervallo di rappresentazione con n bit è ( -2n-1 + 1, 2n-1 – 1 )

• abbiamo una doppia rappresentazione dello zero

Rappresentazione con il complemento a 2

Ricordiamo che il complemento a 2 di un numero si ottiene

• facendo il complemento a 1 del numero

• al risultato si somma 1

Oppure partendo da destra si lasciano invariate tutte le cifre fino al primo uno ( incluso ) e poi si

invertono tutti i seguenti.

La rappresentazione in memoria di un numero relativo con il metodo del complemento a 1 ( CP2)

avendo a disposizione n bit si effettua nel seguente modo:

• i numeri positivi si rappresentano si rappresentano come i primi 2n-1 numeri naturali;

• numeri negativi si rappresentano con il complemento a 2 del corrispondente intero positivo.

esempio

5 = 0101

-5 = 1010 + 1 = 1011

Osserviamo che

• La prima cifra continua a rappresentare il segno

• Il combiamento di segno i un numero di ottiene con il complemento a 2 el

numero esempio

5 = 0101

-5 = 1011 (ottenuto complementando a due il precedente)

5 = 0101 (ottenuto complementando a due il precedente

• Anche in questo caso vi è circolarità, sempre con 4 bit

Se 1111 +

0000 1

-1 =

0000

Esempi di somme in complemento a 2

Esempi di sottrazioni in complemento a 2

1111

la somma di due numeri relativi di n cifre si esegue come nel caso dei numeri naturali

• l’eventuale riporto sulla cifra n+1 viene ignorato

• se il risultato eccede 2n-1 si ottiene il numero negativo che non corrisponde al risultato

desiderato

• se il risultato è minore di -2n-1 si ottiene un numero positivo che non corrisponde al risultato

desiderato

la sottrazione tra due numeri relativi di n cifre si esegue complementando a due il secondo

numero ed eseguendo la somma

Rappresentazione con Eccesso 2n - 1

Come al solito n rappresenta il numero di bit a disposizione per la codifica.

I numeri in eccesso 2n – 1 si ottengono

• sommando 2n – 1 ( detto bias ) al numero da codificare

• si codifica in binario il numero ottenuto al passo

precedente esempio

Supponiamo che n = 5 quindi 2n – 1 = 2 5-1 = 24 = 16

Il numero da codificare è 6 quindi 6 + 16 = 22 in binario 101102

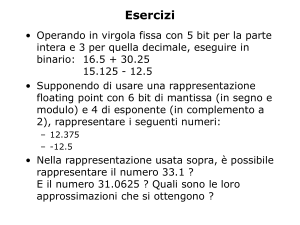

Rappresentazione dei numeri reali in virgola mobile

Una delle rappresentazioni più utilizzate per i reali è quella in virgola mobile, anche detta floating

point. Un qualunque numero razionale può essere riscritto in modo da evidenziare una mantissa

ed un esponente

esempio

•

273.023 = .273023 × 103

( .273023 è la mantissa, 3 è l’esponente )

•

1001001.0101 = .10010010101 ×2+7

Rappresentare un numero reale in virgola mobile consiste nel memorizzare mantissa, esponente e i

segni di mantissa ed esponente del numero espresso in base 2.

segno

segno

mantissa esponente

esponenente

mantissa

Lo standard IEEE 754 prevede che il numero reale venga rappresentato nel seguente modo

S1.xxxxxxx * 2esponente

S = segno della mantissa

x = cifra binaria ( 0 o 1 )

Questa normalizzazione prevede che la virgola venga spostata alla destra del primo 1 ( quello più

significativo, di “peso” maggiore ) che si incontra nel numero reale da rappresentare.

esempi:

101.1112 normalizzato 1.011112 x 22

0.0010102 normalizzato 1.0102 x 2-3

Visto che a destra del punto vi è sempre 1 potremo nella memorizzazione sottointendere la sua

presenza, “guadagnando” così 1 bit. Questa codifica viene detta bit hidden.

In memoria avremo una rappresentazione

segno

esponenente

mantissa

mantissa

L’esponente viene memorizzato secondo la codifica Eccesso P studiata per numeri relativi.

La normativa IEEE 754 sono previsti 3 formati diversi di codifica in virgola mobile

Singola precisione : 32 bit

esponente codificato in eccesso 127 ( 2 8-1 – 1 )

Doppia precisione : 64 bit

esponente codificato in eccesso 1023 ( 2 11-1 – 1 )

Precisione estesa : 80 bit

esponente codificato in eccesso 16383 ( 2 15-1 – 1

)

1bit

8 bit

segno

esponenente

mantissa

1 bit

segno

mantissa

1 bit

segno

mantissa

23 bit

mantissa

11 bit

52 bit

esponenente

mantissa

15 bit

64 bit

esponenente

mantissa

esempio di precision singola

• Codifichiamo -43,125 osserviamo che il numero è negativo quindi il bit del segno è 1

• Convertiamo il numero in binario 101011 . 0012

• Normalizziamo spostando la , di 5 posizioni a sinistra 1 . 010110012 x 25

• Codifichiamo l’esponente in eccesso 127 al quale dobbiamo sommare 5 che è il valore

ottenuto dalla normalizzazione.

5 + 127 = 132 = 100001002

avremo quindi

1 bit

1

8 bit

10000100

23 bit

01011001000000000000000

NOTA: La notazione hidden bit non viene utilizzata per la precisione estesa : in questo caso si

preferisce la “velocità” di esecuzione dei calcoli ( non si deve aggiungere il bit a 1 prima di

effettuare calcoli ), alla maggiore capacità di memorizzazione del numero ottenuta togliendo il bit a

1 alla sinistra del punto decimale.

ARCHITETTURA DI UN SISTEMA A MICROPROCESSORE

Introduzione

Agli inizi degli anni '60 comparvero sul mercato i primi circuiti integrati digitali. Servendosi di

tali dispositivi divenne più semplice la progettazione e la realizzazione di sistemi logici.

Utilizzando la tecnica denominata a logica cablata, i sistemi venivano progettati utilizzando i

circuiti integrati digitali offerti dal mercato ( porte logiche, registri, contatori, ecc.) in funzione

dell'applicazione specifica. Inoltre, aumentando sempre più il numero di componenti integrati su

un unico chip di silicio, ovvero le funzioni logiche che il singolo circuito integrato era in grado di

svolgere, divennero sempre più complesse e sofisticate le funzioni disponibili. Tuttavia il costo

del dispositivo integrato aumentava con la sua complessità, e solo una sua larga diffusione

permetteva l'abbattimento del costo di produzione, cosa non sempre possibile in quanto esso

spesso era rivolto ad utilizzazioni specifiche. Nacque pertanto ben presto la necessità di disporre

di un unico dispositivo che permettesse di essere utilizzato in applicazioni diverse con poche

modifiche. Sulla base di queste motivazioni venne realizzato agli inizi degli anni '70 un circuito

integrato cui fu dato il nome di microprocessore (C.P.U. = Central Process Unit). Tale

dispositivo aveva bisogno di essere programmato, cioè era necessario fornirgli una successione

ordinata di istruzioni sul modo di operare. Il microprocessore può quindi essere considerato un

dispositivo adatto a svolgere funzioni diverse, modificando solo in modo minimo la parte

circuitale ( hardware ) ad esso connessa, ma variando di volta in volta, in base all'applicazione

richiesta, il programma di gestione ( software ). I sistemi realizzati con l'applicazione di una CPU

sono detti a logica programmabile.

Il microprocessore può essere utilizzato in una vastissima gamma di applicazioni che vanno dai

sistemi di controllo, alla strumentazione di misura, dalle apparecchiature domestiche quali

lavastoviglie e televisori a quelle elettromedicali, senza dimenticare una delle più diffuse

applicazioni, ovvero il Personal Computer.

Architettura di un sistema a microprocessore

Un microprocessore in genere, pur contenendo al suo interno tutti i circuiti di calcolo e di

controllo, per poter operare correttamente ha bisogno di essere collegato con altri dispositivi in

base alle applicazioni per cui il processore è impiegato (da solo non è utilizzabile). Al

microprocessore debbono essere collegati sia dei moduli di memoria che i dispositivi per

l’ingresso e l'uscita dei dati. E dunque necessario parlare di sistema a microprocessore e non

semplicemente di microprocessore. Nella figura è riportato un semplice schema di sistema con

memorie e dispositivi di I/O. In esso è evidenziata la funzione di collegamento tra i vari

componenti svolta dai bus dati, bus indirizzi e bus di controllo.

Il sistema è costituito da una CPU da memorie RAM e ROM da uno o più dispositivi d'ingresso

e d'uscita. Lo schema può servire per comprendere come il microprocessore possa scambiare

informazioni con la memoria e con i dispositivi di I/O (Input / Output).

Mediante il BUS INDIRIZZI vengono identificate le locazioni di memoria dove vengono

memorizzati i dati nelle operazioni di scrittura o da cui la CPU riceve i dati (o i codici delle

istruzioni, cioè il programma) nelle operazioni di lettura. Inoltre, sempre per mezzo del bus

indirizzi il microprocessore identifica i dispositivi d'ingresso, ad esempio la tastiera di un

computer, da cui riceve i dati nello operazioni di lettura da periferica o quelli d'uscita, ad esempio

il monitor di un computer, a cui invia i dati nelle operazioni di scrittura su periferica. Il bus dati è

utilizzato per il trasferimento (lettura o scrittura) dei dati dalla CPU con le locazioni di memoria o

con i dispositivi di ingresso / uscita (detti anche periferici o dispositivi di I/O). Il bus controlli,

oltre a funzioni specifiche che non saranno qui esplicitate, è utilizzato dalla CPU per segnalare

alla memoria e ai dispositivi di I/O la direzione del flusso dei dati e il tipo di dispositivo coinvolto

nel trasferimento (memoria o I/O).

L’architettura a BUS presenta diversi vantaggi il principale dei quali è dato dalla modularità del

sistema; è infatti particolarmente semplice ampliare il sistema con l’aggiunta di nuovi componenti

collegandoli ai BUS. Tale vantaggio risulta evidente pensando alle schede madri dei Personal

Computer, dove attraverso gli slot di espansione è possibile ampliare le prestazioni e le

caratteristiche del sistema attraverso nuove schede (es: modem, acquisizione dati, porte parallela)

o nuovi chip di memoria. I diversi “oggetti” sono collegati ai bus con una modalità che consenta

di evitare conflitti e/o indecisioni nella comunicazione che avviene sempre tra due soli

componenti del sistema e quasi sempre uno dei due è il microprocessore.

BUS DATI (bidirezionale)

Bus controllo

Lo schema di figura (dove per semplicità si sono rappresentate solo 4 linee per bus) mette in

evidenza i circuiti di decodifica che, generando dei segnali di chip select, permettono di

selezionare i diversi dispositivi. I segnali CS permettono di togliere il componente dallo stato di

alta impedenza (che corrisponde al virtuale scollegamento del componente dal bus dati)

garantendo la corretta comunicazione solo tra due componenti. Altri segnali particolarmente

importanti per la comunicazione provengono dal BUS CONTROLLI e sono i segnali di READ e

WRITE, pilotati dalla CPU, e specificano la direzione dei dati nel trasferimento.

Elementi caratteristici di una CPU

La CPU costituisce il cuore e l’elemento più importante del sistema; in esso sono rappresentate le

funzioni logiche, di controllo e aritmetiche. La CPU è in grado di prelevare le istruzioni del

programma da svolgere contenute nella memoria (fase di fetch) e di interpretarle ed eseguirle

(fase di execute). Tale istruzioni sono evidentemente in forma binaria. Grazie ai programmi

compilatori è possibile scrivere programmi per Personal Computer utilizzando linguaggi

particolarmente semplici ed intuitivi (linguaggi ad alto livello) che vengono poi tradotti nell’unico

linguaggio interpretato ed eseguito dalla CPU che viene denominato linguaggio macchina. Le

principali caratteristiche di una CPU che ne identificano le peculiarità e la potenza possono essere

cosi sintetizzate:

Set istruzioni, cioè l’insieme delle istruzioni che la CPU è in grado di svolgere;

Velocità di funzionamento ed esecuzione delle istruzioni; si identificano tali caratteristiche

attraverso il clock di sistema (frequenza di funzionamento passata negli anni da qualche MHz a

centina di Mhz) e il MIPS (milioni di istruzioni eseguite in un secondo).

Architettura interna, insieme dei registri di lavoro, coprocessore matematico per svolgere le

operazioni logico aritmetiche di una certa complessità, memoria cache per il reperimento veloce

delle istruzioni

I registri sono memorie di pochi bit ( 8, 16, 32 o 64 ) contenuti fisicamente nella CPU che vengono

utilizzati come memoria di transito per appoggiare provvisoriamente i dati ( indirizi, dati o

istruzioni ). Essi consentono un funzionamento più efficiente della CPU, evitando l’accesso

continuo alla memoria esterna che dovrebbe avvenire tramite i bus e ciò porterebbe ad un impiego

maggiore di tempo.

L'Unità di Controllo. è l'organo o unità che gestisce, controlla e presiede l'esecuzione di tutte le

operazioni di elaborazione per il particolare programma da eseguire ovvero comanda tutte le altre

parti del processore attraverso il pilotaggio dei componenti stessi (ALU ecc..) impartendo a questi

comandi di input e facendo da supervisore; rappresenta la parte a logica sequenziale della

macchina a stati generale che, a sua volta, rappresenta la logica elettronica generale del processore

stesso. Ad essa spetta, ad esempio,

l'interpretazione dell'istruzione che si trova di volta in volta nel registro IR;

abilitare alla lettura ed alla scrittura due registri tra i quali deve avvenire uno

scambio di informazione.

L'unità di controllo scandisce i passi o stati di un'istruzione:

1. fetch: preleva l’ istruzione dalla memoria e determina il tipo di istruzione, i suoi argomenti

2. execute: esegue l’istruzione, memorizza i risultati, e torna a 1.

Tutte le fasi del ciclo del processore avvengono attraverso l'invio ai vari componenti di un

insieme di impulsi di controllo, in una sequenza temporale ben precisa. Più precisamente, ad ogni

colpo di clock le linee di controllo assumono un particolare stato; il susseguirsi dei diversi stati

contribuisce all'esecuzione completa di un'istruzione. Per questo motivo si può dire che una

singola istruzione in linguaggio macchina viene eseguita attraverso la opportuna composizione di

più micro-operazioni.

ALU., l'unità logico-aritmetica, è l'organo deputato allo svolgimento di

operazioni aritmetiche ( somma, sottrazione, moltiplicazione, divisione, cambio di segno );

operazioni logiche ( or, and, xor, not );

confronti;

operazioni di scorrimenti e rotazione a sinistra e a destra di un dato;.

Essa preleva gli operandi tipicamente dai registri generali, così come nei registri generali depone

i risultati dei calcoli. In seguito ad un calcolo l'ALU ha anche il compito di impostare alcuni flag

in modo da tenere traccia di determinati eventi (es. riporto di una somma).

La Memoria. Contiene un numero generalmente molto elevato di celle nelle quali vengono

memorizzati i dati e le istruzioni di un programma. Ogni cella è caratterizzata da un indirizzo

( intero positivo ) specificando il quale è possibile leggere o scrivere nella cella stessa. Il tempo

impiegato per accedere ad una cella di memoria è costante e superiore a quello impiegato per

l'accesso ad uno dei registri del processore. È per questo motivo che, per quanto possibile, si tenta

di utilizzare i registri interni per effettuare le operazioni, limitando gli accessi in memoria allo

stretto necessario. Pur contenendo la memoria un numero molto elevato di celle, in ciascun istante

temporale solo uno di questi è abilitato a partecipare ad operazioni di lettura o scrittura: quello il

cui indirizzo è contenuto nel registro MAR. Per sopperire alla lentezza della memoria RAM è

stata introdotta anche la memoria cache.

Internal Bus. È un canale di comunicazione principale condiviso dai vari componenti ed

attraverso il quale essi possono dialogare scambiandosi informazioni quali comandi di input,

output ecc.. In questo contesto, il dialogo consiste nello scambio di dati binari tra registri secondo

una modalità parallela. Ciò significa che un certo numero di bit viene contemporaneamente

trasferito attraverso il bus da un registro mittente ad un registro destinatario. Durante

un'operazione di trasferimento, i due registri implicati nella comunicazione si trovano in uno stato

di lettura (destinatario) e scrittura (mittente) in modo tale da poter acquisire il dato presente sul

bus e da potercelo scrivere, rispettivamente. Tutti gli altri registri sono in uno stato di “riposo” nel

quale non possono né leggere i dati che circolano sul bus né influenzare lo stato del bus con i dati

che contengono. Il numero di bit contemporaneamente trasferiti indica il parallelismo del bus ed

è pari al numero di bit contenuti in un singolo registro. Esso caratterizza anche il parallelismo

interno del processore.

Il Data Bus e il registro MDR. Il Data Bus è un bus che collega la memoria con il registro MDR

( Memory Data Register ). Esso serve a trasferire dati in entrambi i sensi, sempre secondo una

modalità parallela. Tutti i dati e le istruzioni che dalla memoria devono essere elaborati nel

processore, transitano inoltre attraverso il registro MDR e solo successivamente da questo

raggiungono gli opportuni registri per l'elaborazione vera e propria. Analogamente, tutti i risultati

(output) di un'elaborazione che devono essere immagazzinati in memoria transitano prima per il

registro MDR e solo successivamente da esso raggiungono l'esatta posizione (cella) di memoria.

L'Address Bus e il registro MAR. Durante un accesso alla memoria, sia in fase di lettura che in

fase di scrittura, il registro MAR ( Memory Address Register ) contiene l'indirizzo della cella di

memoria a cui si deve accedere. Questo indirizzo, trasferito all'organo memoria attraverso