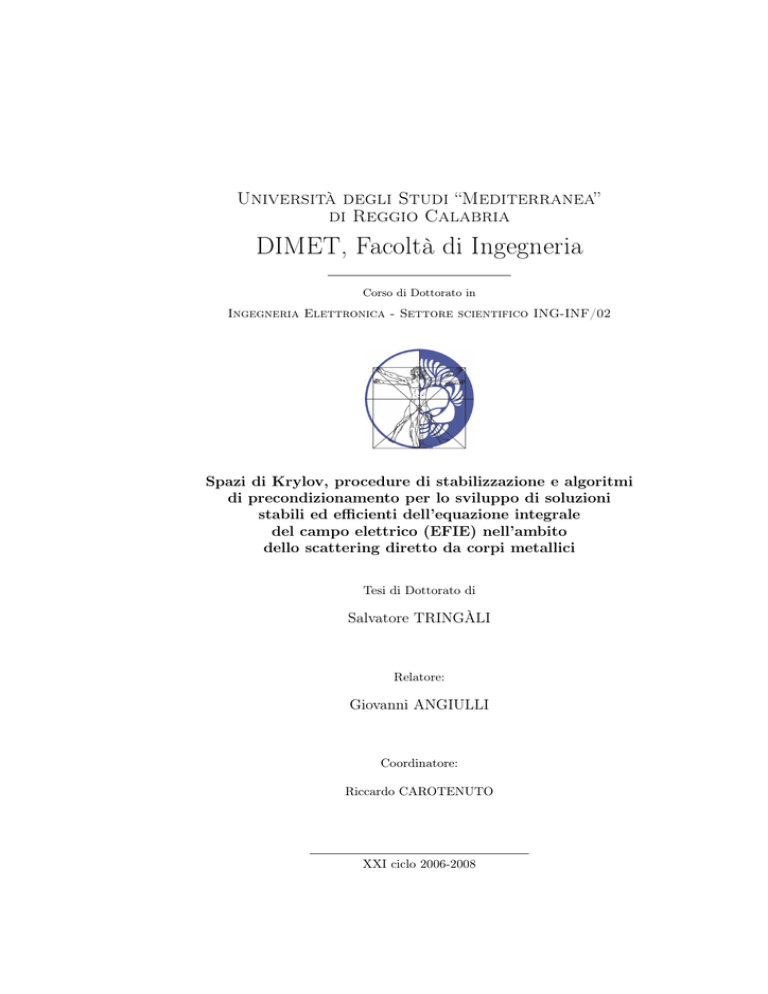

Università degli Studi “Mediterranea”

di Reggio Calabria

DIMET, Facoltà di Ingegneria

Corso di Dottorato in

Ingegneria Elettronica - Settore scientifico ING-INF/02

Spazi di Krylov, procedure di stabilizzazione e algoritmi

di precondizionamento per lo sviluppo di soluzioni

stabili ed efficienti dell’equazione integrale

del campo elettrico (EFIE) nell’ambito

dello scattering diretto da corpi metallici

Tesi di Dottorato di

Salvatore TRINGÀLI

Relatore:

Giovanni ANGIULLI

Coordinatore:

Riccardo CAROTENUTO

XXI ciclo 2006-2008

Indice

Introduzione

vi

Glossario dei simboli

1 Il campo elettromagnetico

viii

1

1.1

Il concetto fisico di campo . . . . . . . . . . . . . . . . . . . . . .

1

1.2

Derivazione naif delle leggi di Maxwell . . . . . . . . . . . . . . .

3

1.2.1

L’elettrostatica e la legge di Coulomb . . . . . . . . . . .

3

. Il campo elettrostatico . . . . . . . . . . . . . . . . . . .

4

La magnetostatica e la legge di Ampère . . . . . . . . . .

5

. Il campo magnetostatico . . . . . . . . . . . . . . . . . .

6

L’elettrodinamica . . . . . . . . . . . . . . . . . . . . . . .

7

. L’equazione di continuità . . . . . . . . . . . . . . . . .

8

. La corrente di spostamento di Maxwell . . . . . . . . .

8

. La forza elettromotrice . . . . . . . . . . . . . . . . . . .

9

. La legge dell’induzione di Faraday . . . . . . . . . . . .

10

La teoria elettromagnetica formale . . . . . . . . . . . . . . . . .

11

1.3.1

Le relazioni costitutive della materia . . . . . . . . . . . .

12

. Isotropia e anisotropia. . . . . . . . . . . . . . . . . . .

13

. Dispersività nel tempo e nello spazio. . . . . . . . . . .

13

. Omogeneità nel tempo e nello spazio. . . . . . . . . . .

14

. Linearità e sovrapposizione degli effetti. . . . . . . . . .

15

Il fenomeno dello scattering . . . . . . . . . . . . . . . . . . . . .

16

. Lo scattering nelle applicazioni . . . . . . . . . . . . . .

18

1.2.2

1.2.3

1.3

1.4

Indice

ii

2 L’EFIE e lo scattering diretto

20

2.1

Le equazioni dello scattering . . . . . . . . . . . . . . . . . . . . .

20

2.2

Il caso del conduttore cilindrico . . . . . . . . . . . . . . . . . . .

22

2.2.1

Il problema diretto . . . . . . . . . . . . . . . . . . . . . .

23

. L’unicità della soluzione . . . . . . . . . . . . . . . . . .

24

. L’EFIE e l’esistenza della soluzione . . . . . . . . . . . .

26

. Il problema delle risonanze . . . . . . . . . . . . . . . .

27

2.3

Le equazioni dello scattering 3D

. . . . . . . . . . . . . . . . . .

28

2.3.1

Formulazione differenziale del problema diretto . . . . . .

29

2.3.2

Una derivazione informale dell’EFIE 3D . . . . . . . . . .

32

3 Localizzazione delle risonanze

34

3.1

Introduzione . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

3.2

Ricerca delle singolarità . . . . . . . . . . . . . . . . . . . . . . .

35

3.2.1

Funzione ausiliaria . . . . . . . . . . . . . . . . . . . . . .

41

QR . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

LU . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

42

CCVL . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

42

LQI . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

DET . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

CONDET . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

CONDEST_QR . . . . . . . . . . . . . . . . . . . . . . .

44

RCOND . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

RCOND_QR . . . . . . . . . . . . . . . . . . . . . . . . .

44

ALGA . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

ALGB . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

Ricerca risonanze - Risultati sperimentali . . . . . . . . .

45

Cubo

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

Sfera . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

53

Stabilizzazione . . . . . . . . . . . . . . . . . . . . . . . . . . . .

61

3.3.1

Natura delle singolarità . . . . . . . . . . . . . . . . . . .

61

3.3.2

Soluzione a norma minima

. . . . . . . . . . . . . . . . .

61

3.3.3

Soluzione OP . . . . . . . . . . . . . . . . . . . . . . . . .

62

3.3.4

Soluzione TSVD . . . . . . . . . . . . . . . . . . . . . . .

62

3.2.2

3.3

Indice

iii

3.3.5

Risultati numerici e conclusioni . . . . . . . . . . . . . . .

4 Sistemi lineari e precondizionatori

4.1

4.2

4.4

4.5

4.6

68

Generalità sulle tecniche di soluzione . . . . . . . . . . . . . . . .

69

4.1.1

Metodi diretti . . . . . . . . . . . . . . . . . . . . . . . . .

70

4.1.2

Metodi iterativi . . . . . . . . . . . . . . . . . . . . . . . .

71

4.1.3

Metodi iterativi stazionari . . . . . . . . . . . . . . . . . .

72

4.1.4

Metodi iterativi stazionari . . . . . . . . . . . . . . . . . .

73

. Gauss-Jacobi. . . . . . . . . . . . . . . . . . . . . . . . .

73

. Gauss-Seidel. . . . . . . . . . . . . . . . . . . . . . . . .

73

. Metodi di rilassamento. . . . . . . . . . . . . . . . . . .

74

I metodi dinamici di Krylov . . . . . . . . . . . . . . . . . . . . .

75

4.2.1

Il gradiente coniugato . . . . . . . . . . . . . . . . . . . .

76

4.2.2

Il metodo dei residui minimi generalizzato . . . . . . . . .

79

. La variante ripartita del GMRES . . . . . . . . . . . . .

80

L’algoritmo BiCG . . . . . . . . . . . . . . . . . . . . . .

81

La onvergenza dei metodi di Krylov . . . . . . . . . . . . . . . .

81

4.3.1

Fattori di influenza dei tassi di convergenza . . . . . . . .

83

4.3.2

Criteri di arresto . . . . . . . . . . . . . . . . . . . . . . .

85

Il precondizionamento . . . . . . . . . . . . . . . . . . . . . . . .

86

4.4.1

Il precondizionatore antihermitiano . . . . . . . . . . . . .

88

4.4.2

Il precondizionatore diagonale . . . . . . . . . . . . . . . .

88

4.4.3

Il precondizionatore ILU . . . . . . . . . . . . . . . . . . .

89

Esperimenti numerici . . . . . . . . . . . . . . . . . . . . . . . . .

90

4.5.1

Simulazione 1 . . . . . . . . . . . . . . . . . . . . . . . . .

92

4.5.2

Simulazione 2 . . . . . . . . . . . . . . . . . . . . . . . . .

96

4.5.3

Simulazione 3 . . . . . . . . . . . . . . . . . . . . . . . . . 101

4.5.4

Simulazione 4 . . . . . . . . . . . . . . . . . . . . . . . . . 108

4.5.5

Simulazione 5 . . . . . . . . . . . . . . . . . . . . . . . . . 111

4.5.6

Simulazione 6 . . . . . . . . . . . . . . . . . . . . . . . . . 111

4.5.7

Simulazione 7 . . . . . . . . . . . . . . . . . . . . . . . . . 118

4.5.8

Simulazione 8 . . . . . . . . . . . . . . . . . . . . . . . . . 120

4.2.3

4.3

63

Conclusioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

Indice

iv

A Formulazioni deboli

125

A.1 L’equazione del calore . . . . . . . . . . . . . . . . . . . . . . . . 125

A.2 Derivate deboli . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

A.2.1 Definizione e alcune proprietà . . . . . . . . . . . . . . . . 128

A.2.2 Un caso concreto . . . . . . . . . . . . . . . . . . . . . . . 130

B Identità notevoli

131

B.1 Identità vettoriali di tipo algebrico . . . . . . . . . . . . . . . . . 131

B.2 Identità vettoriali di tipo differenziale . . . . . . . . . . . . . . . 131

Bibliografia

i

Ai miei genitori, per avermi dato alla vita e regalato parte della loro

A mia sorella, perché senza di lei non avrei mai finito questa tesi

A G, per la sua impagabile amicizia e le nostre sconclusionate discussioni

A V, per essere il mio cielo e l’orizzonte estremo della mia insana ispirazione

Introduzione

In elettromagnetismo, si definisce con il termine “scattering” il problema della

determinazione della perturbazione di un campo introdotta dalla presenza di

un bersaglio. Nella pratica comune, i problemi di scattering coinvolgono gli

oggetti più svariati, dalla forma arbitraria, costituiti da mezzi permeabili o impermeabili alla radiazione elettromagnetica. Tutti si possono, però, descrivere

mediante lo schema logico per cui 1) le sorgenti, assegnate sotto forma di cariche

o correnti impresse, irradiano nello spazio circostante un campo elettromagnetico (c.d. campo incidente); 2) la libera propagazione del campo incidente viene

perturbata dalla presenza di un oggetto (c.d. ostacolo o scatteratore) dotato

di caratteristiche discontinue rispetto all’ambiente ospitante; 3) nell’interazione

con il campo incidente, l’ostacolo si comporta come una sorgente secondaria e

genera intorno a sé un campo diffuso; 4) il campo diffuso si somma al campo

incidente per produrre il campo totale.

Il paradigma comprende, fra le altre possibili, due tipologie fondamentali di

problemi: diretti e inversi. Di fatto, la loro soluzione trova applicazione nei

contesti tecnici e scientifici più disparati, spaziando dall’archeologia [2] all’ingegneria civile, dalla salvaguardia dei beni monumentali al rilevamento di ordigni

inesplosi [3] o di giacimenti sotterranei di petrolio. L’attività di ricerca svolta

nel corso del ciclo di dottorato, in particolare, si è concentrata sullo studio dei

problemi del primo tipo (i.e., diretti), rilevanti, per esempio, nella progettazione

e implementazione di antenne per le telecomunicazioni (terrestri e satellitari),

nella rilevazione radar di oggetti in volo (nel campo dell’aeronautica civile o della

difesa militare) o nella realizzazione di sistemi intelligenti di autodistanziamento

dei veicoli su strada (c.d. sensori FS).

Rispetto all’argomento, questa tesi discute, in particolare, un metodo di

Introduzione

vii

stabilizzazione della soluzione numerica, calcolata a partire dal sistema lineare

prodotto dalla discretizzazione (tramite il metodo dei momenti) dell’equazione integrale del campo elettrico (EFIE) per lo studio dello scattering da corpi

metallici, fondato sulla revisione ed estensione di una tecnica analoga - ma generalmente inefficace - proposta in letteratura da Canning [1]. La descrizione

dell’algoritmo, peraltro tradotto in un’effettiva procedura di calcolo in ambiente Matlab, si completa attraverso un risultato formale, inteso a dimostrare,

attraverso la teoria degli operatori quasi-fredholmiani, che lo spazio nullo dell’operatore integrale implicitamente definito dall’EFIE ha una dimensione algebrica (di Hamel) comunque finita, anche in condizioni di mal posizione (i.e.,

di non unicità della soluzione). Come conseguenza fondamentale, ne risulta la

possibilità, in linea di principio, di “epurare” la soluzione risonante dalle componenti spurie introdotte dalla degenerazione del nucleo operatoriale attraverso

un numero finito di filtraggi (cap. 3).

Al problema del filtraggio viene premessa l’analisi di efficienza (rispetto

ai tempi di processazione) di alcune tecniche numeriche per la localizzazione

delle c.d. risonanze1 , che costituisce allo stato attuale dell’arte un passaggio

necesssario e ineludibile della procedura di filtrazione tout-court (cap. 3).

Un altro fronte di indagine (cap. 4) riguarda l’efficienza del calcolo in ipso

della soluzione numerica dell’EFIE (lontano dalla risonanza) attraverso i c.d.

schemi iterativi di tipo Krylov e la definizione di opportune strategie di precondizionamento, “calibrate” sulle proprietà peculiari del modello analitico, per

accelerarne il rate di convergenza.

Esaurite le indispensabili premesse di carattere generale inerenti alle equazioni di Maxwell, la prima metà della tesi (capp. 1 e 2) è stata interamente

dedicata a revisione formale della teoria coinvolta nella formulazione del problema diretto dello scattering da corpi metallici: il taglio è estremamente formale,

per l’intima volontà, da una parte, di chiarificare alcuni aspetti del problema

troppo spesso trascurati dall’approccio ingegneristico e, dall’altra, per costruire

il background teorico necessario alla dimostrazione della finitezza incondizionata

del kernel dell’EFIE, cui si è accennato in precedenza.

1:

le frequenze discrete per cui l’equazione integrale del campo “degenera” e la sua soluzione

analitica manca di unicità.

Glossario dei simboli

L’elenco dei simboli più ricorrenti nel corso della trattazione, al fine di semplificarne il “riconoscimento” e rendere più agevole la lettura dell’elaborato.

N

l’insieme degli interi non negativi {0, 1, . . .}

N0

l’insieme degli interi positivi, i.e., N − {0}

R

l’insieme dei numeri reali con la usuale struttura di campo

C

l’insieme dei numeri complessi con la usuale struttura di campo

Rn

l’insieme delle n-uple ordinate di numeri reali, con la consueta

struttura di spazio lineare su R e la topologia della norma euclidea

C

n

R

m,n

C

m,n

l’insieme delle n-uple ordinate di numeri complessi, con al consueta

struttura di spazio lineare su C e la topologia della norma euclidea

l’insieme delle matrici rettangolari m × n a ingressi reali con la

consueta struttura di spazio R-lineare e la topologia euclidea

l’insieme delle matrici rettangolari m × n a ingressi complessi con la

consueta struttura di spazio C-lineare e la topologia euclidea

A

t

AH

la trasposta di una generica matrice A ∈ Rm,n oppure ∈ Cm,n

la trasposta coniugata di una generica matrice A ∈ Rm,n oppure ∈ Cm,n

k · kn,p

la norma hölderiana di ordine p ≥ 1 in Rn o Cn

k · kn,∞

la norma dell’estremo superiore in Rn o Cn

k · kX

la norma di uno spazio normato o di Banach X sul campo

scalare dei numeri reali o complessi (secondo il contesto)

h· , ·in

il prodotto scalare di Rn o Cn

h· , ·iX

il prodotto scalare di uno spazio hilbertiano o prehilbertiano X

sul campo reale o complesso (secondo il contesto)

rot

il rotore di un campo vettoriale R3 → R3 o R3 → C3

divn

la divergenza di un campo vettoriale Rm → Rn o Rm → Cn

∇n

il gradiente di un campo scalare Rn → R o Cn → C

∆n

l’operatore di Laplace n-dimensionale

Glossario dei simboli

D̄

la chiusura (topologica) di un insieme D ⊆ Rn

∂D

la frontiera (topologica) di un insieme D ⊆ Rn

C k (D, F)

lo spazio delle funzioni D ⊆ Rn → F

ix

k volte differenziabili con continuità in D

Bn (r0 , r)

la sfera euclidea di raggio r > 0 e centro r0 ∈ Rn

Bn

la sfera euclidea di raggio unitario e centro l’origine in Rn

Lp (Ω, F)

lo spazio F-lineare delle funzioni f (·) : Ω ⊆ Rn → K per cui f p (·)

è integrabile secondo Lebesgue, con p ≥ 1 e F = R oppure F = C

loc

Lp (Ω, K)

lo spazio K-lineare delle funzioni f (·) : Ω ⊆ Rn → K per cui f p (·)

è integrabile secondo Lebesgue in ogni compatto C ⊆ Ω, con

p ≥ 1 e K = R oppure K = C

Dove necessario, nell’elenco dei simboli qui sopra, si assuma che m, n ∈ N0 ; k sia un

intero ≥ 0 e Ω un insieme misurabile dello spazio ambiente euclideo.

Capitolo 1

Il campo elettromagnetico

Nel corso del capitolo si introduce il concetto di campo e si passano in rassegna le

equazioni fondamentali di Maxwell-Lorentz per lo studio delle interazioni fra la materia e le onde1 elettromagnetiche. Quindi, dopo una breve parentesi sulle relazioni

costitutive della materia, si descrivono per grandi linee i due massimi problemi inerenti

allo studio dei cosiddetti fenomeni di scattering, i.e., il problema diretto e il problema inverso, ricostruendo per ciascuno un’amplia bibliografia e rinviando ai capitoli

successivi la derivazione dei modelli a equazioni integrali utilizzati nella pratica per

risolverli in alcuni casi particolari di spiccata rilevanza dal punto di vista applicativo.

1.1

Il concetto fisico di campo

Informalmente, nel linguaggio della fisica moderna, un campo è una funzione definita in ogni punto del cronotopo [10], ancorché, nella pratica, l’intensità di qualsiasi

campo empirico conosciuto si sappia decrescere a zero, all’aumentare della distanza

dalle sorgenti, tanto da poterne restringere il dominio ad una sezione (eventualmente

limitata) dello spazio-tempo. Ad esempio, nella teoria della gravitazione newtoniana

[11], la forza del campo gravitazionale è inversamente proporzionale al quadrato della

distanza dall’oggetto gravitante.

D’altronde, è opportuno sottolineare che la definizione astratta dei campi non

può né deve prescindere dalla constatazione di fatto che gli stessi possiedono una

consistenza fisica. A riguardo John A. Wheeler [12] osserva che «un campo occupa

spazio, contiene energia e la sua presenza impedisce un vuoto vero». Sicché il vuoto è

1:

qui e per il seguito, un’onda è una perturbazione del continuum spazio-temporale che si

propaga attraverso un mezzo di trasmissione, tipicamente con trasporto di energia.

Capitolo 1. Il campo elettromagnetico

2

libero dalla materia, ma non è libero dai campi. Che manifestano la propria presenza

creando «una condizione contingente, per cui una particella posta in un punto risente

dell’azione di una forza». Parole di Feynman.

Una carica elettrica p1 in movimento subisce, in effetti, l’azione di una forza di

reazione vincolare istantanea, acquistando un momento. Ma una seconda carica p2 ,

posta nel vuoto a una certa distanza dalla prima, non ne risente in alcun modo,

almeno fintanto che, viaggiando nel tempo e nello spazio alla velocità della luce, gli

effetti indotti dal moto di p1 , come un’onda d’urto, non la investono, sicché a sua volta

p2 acquista un momento. Dove si trova, però, il momento prima che p2 si metta in

movimento? Per la legge di conservazione del momento, infatti, deve pur essere da

qualche parte. Ebbene, la fisica moderna ha trovato «di grande utilità per l’analisi

delle forze» ammettere che il momento sia contenuto nel campo. «Il fatto che il campo

elettromagnetico sia dotato di un momento e di un’enegia propri lo rende estremamente

reale. [...] Una particella genera un campo, e il campo agisce su un’altra particella e

possiede proprietà comuni alle particelle, come l’energia e il momento». Sono sempre

riflessioni di Feynman, riprese dalle sue celebri lezioni al Caltech Institute [13].

Dal punto di vista dei modelli, un campo è solitamente rappresentato per mezzo di

scalari, di vettori o, più in generale, di tensori, a seconda che, rispettivamente, il suo

valore puntuale sia uno scalare, un vettore o un tensore. E.g., il campo gravitazionale

newtoniano ha una natura vettoriale, perché è necessario punto per punto un vettore

per rappresentare intensità, direzione e verso della forza gravitazionale. La temperatura all’interno di una stanza, invece, è il classico esempio di un campo scalare.

Di fatto, la teoria (fisica) dei campi riguarda la costruzione di un modello mirato a

descrivere le dinamiche di un campo, ovvero il modo in cui un campo evolte e muta, nel

tempo, nello spazio o in funzione di altre componenti. Tipicamente, questo comporta

la definizione di un opportuno funzionale del campo e il suo trattamento in termini

analoghi ad un sistema caratterizzato da un’infinito numero di gradi di libertà, secondo

i due approcci fondamentali della meccanica classica [14] e della meccanica quantistica

[15] [16], di cui, però, non è possibile discutere qui in un maggiore dettaglio.

Si può dire, tuttavia, che l’importanza della nozione di campo nella fisica venne

realizzata, per la prima volta, da Michael Faraday, nel corso delle sue ricerche sui fenomeni magnetici. L’intuizione di Faraday fu che i campi elettrico e magnetico non sono

solo campi di forze, in grado di alterare, eventualmente, lo stato di moto delle particelle (cariche), ma possiedono, come le particelle, una consistenza fisica indipendente,

poiché caratterizzati, per esempio, dalla proprietà di trasportare dell’energia.

Le idee di Faraday e di numerosi altri pionieri della ricerca che gli fecero segui-

Capitolo 1. Il campo elettromagnetico

3

to, portarono James Clerk Maxwell nel 1873 a formulare la prima teoria di campo

unificata nella storia della fisica, con l’introduzione delle sue celebri equazioni per il

campo elettromagnetico, ieri descritto in termini di una coppia (e, h) di vettori - con

il formalismo classico utilizzato nel corso di questa tesi - ed oggi - col formalismo della

fisica del ’900 - mediante un singolo tensore antisimmetrico di rango 2 (l’una e l’altro

variabili nel tempo e nello spazio).

1.2

Derivazione naif delle leggi di Maxwell

In effetti, l’elettromagnetismo moderno nasce con i primi esperimenti di elettrologia

del tardo Illuminismo, collegati allo studio delle interazioni fra cariche elettriche stazionarie o distribuzioni di carica racchiuse all’interno di spazi finiti dotati di frontiere

stazionarie2 . Nasce, cioè, con l’elettrostatica.

1.2.1

L’elettrostatica e la legge di Coulomb

Già nel 1780, nell’ambito delle ricerche dell’elettrostatica, venne dimostrato da Coulomb, per via sperimentale, che le interazioni fra corpi carichi elettricamente si possono

descrivere in termini di forze meccaniche.

Figura 1.1: la geometria della legge di Coulomb per l’elettrostatica, in cui due particelle

cariche puntiformi interagiscono attraverso una forza meccanica.

Si immagini, per semplicità, di considerare due cariche puntiformi nel vuoto q e

q0 , poste, rispettivamente, nei punti r e r0 6= r di un sistema di riferimento cartesiano

ortogonale Oxyz, come illustrato in fig. 1.3.

In base alla legge di Coulomb, q0 (carica sorgente) esercita una forza istantanea

2:

cioè fisse nello spazio e di valore costante nel tempo.

Capitolo 1. Il campo elettromagnetico

F(r) (forza elettrica) su q (carica di test), tale che

µ

¶

r − r0

q0 q

1

q0 q

·

=

−

∇

F(r) =

3

4π²0 kr − r0 k32

4π²0

kr − r0 k2

4

(1.1)

dove ²0 ≈ 8.8542 · 10−12 è la permettività (dielettrica) del vuoto e il gradiente a ultimo

membro è calcolato supponendo r0 fisso e r variabile.

. Il campo elettrostatico

D’altro canto, piuttosto che descrivere l’interazione elettrostatica in termini della

“azione a distanza” di una forza su una carica di prova, come nel caso del sottoparagrafo precedente, è più utile associare a q0 un campo vettoriale (stazionario)

estat

(·) : R3 − {r0 } → R3 (campo elettrostatico) ponendo

0

µ

¶

F(r)

q0

1

estat

(r) := lim

=−

∇3

,

in R3 − {r0 }

0

q→0

q

4π²0

kr − r0 k2

(1.2)

dove il processo al limite “si motiva” con la necessità di garantire che la carica di test

q sia, di fatto, sufficientemente piccola3 da non perturbare il campo prodotto dalla

sorgente. In tal modo, l’espressione puntuale di Estat non dipenderà esplicitamente

da q, ma solo da q0 . Così da poter dire che ogni carica elettrica induce nello spazio

circostante un campo, il cui valore è indipendente dalla presenza di altre cariche.

Nel caso, poi, di un insieme discreto di cariche q1 , q2 , . . ., localizzate, rispettivamente, nei punti r1 , r2 , . . . di uno spazio altrimenti vuoto, l’ipotesi di linearità consente

di sovrapporre l’uno all’altro gli effetti dovuti alle singole sorgenti, di modo che per il

campo elettrostatico totale estat (·) si può scrivere

µ

¶

X stat

1 X

qi

stat

e

(r) =

ei (r) = −

∇3

4π²0 i

kr − ri k2

i

(1.3)

Se, adesso, le cariche discrete q1 , q2 , . . . sono “molte”, sufficientemente piccole e tutte

concentrate in un insieme V chiuso e limitato (i.e., compatto) dello spazio, al punto

da poterne descrivere la distribuzione tramite una funzione ρ(·) : V → R (densità di

carica elettrica), la sommatoria (1.3) si può eventualmente sostituire con un integrale

di volume esteso a V, in un ideale processo al limite per cui il campo elettrostatico

totale estat (·), in definitiva, è descritto dall’equazione

µ

¶

ˆ

ˆ

ρ(r0 )

1

ρ(r0 ) ∇3

−4π²0 estat (r) =

dr30 = ∇3

dr30

kr

−

r

k

kr

−

r

k

0

2

0

2

V

V

(1.4)

dove r ∈ R3 − V e lo scambio formale fra il segno di integrale e l’operatore derivativo

∇3 si giustifica considerando che il gradiente è calcolato sulle coordinate del generico

3:

benché ampiamente utilizzate, argomentazioni informali di quest’ordine, in realtà, sono

prive di ogni senso, dal momento che, al meglio delle conoscenze attuali della fisica, la carica

è quantizzata, per cui renderla arbitrariamente piccola, di fatto, è impossibile.

Capitolo 1. Il campo elettromagnetico

5

punto di osservazione r ∈ Ve := R3 − V, mentre l’integrazione si estende alla posizione

variabile di un arbitrario punto sorgente r0 ∈ V.

Da qui, interpretando gli integrali e le derivate in senso debole distribuzionale e

utilizzando, quindi, l’identità operatoriale secondo cui div3 (∇3 ϕ) = ∆3 ϕ, per ogni

funzione localmente integrabile ϕ(·) : R3 → R, si trova che

µ ˆ

¶

ˆ

ρ(r0 )

ρ(r0 )

−4π²0 div3 estat (r) = div3 ∇3

dr30 = ∆3

dr30

V kr − r0 k2

V kr − r0 k2

µ

¶

1

qualunque sia r ∈ Ve . Sennonché ∆3

= −4πδ(r − r0 ), e perciò

kr − r0 k2

ˆ

ρ(r)

1

∀r ∈ V3 : div3 estat (r) =

ρ(r0 )δ(r − r0 )dr30 =

(1.5)

²0 V

²0

¡

¢

che è la legge di Gauss dell’elettrostatica. D’altronde, siccome rot ∇3 α(r) = 0, per

ogni funzione debolmente derivabile α(·) : Ve → C, è immediato stabilire dalla (1.4)

che il campo elettrostatico è irrotazionale, dacché

µ ˆ

¶

ρ(r0 )

1

rot estat (r) = −

rot ∇3

dr30 = 0

4π²0

V kr − r0 k2

1.2.2

(1.6)

La magnetostatica e la legge di Ampère

Mentre l’elettrostatica attiene allo studio degli effetti prodotti da una distribuzione

di cariche statiche4 , la magnetostatica tratta il caso delle correnti stazionarie5 e delle

interazioni dove queste risultano coinvolte.

Figura 1.2: la geometria della legge di Ampère della magnetostatica, in cui due fili

percorsi da corrente interagiscono attraverso una forza meccanica.

Storicamente, Ampère fu il primo ad osservare che una spira piana Γ1 , in cui scorra

una corrente continua di prova I1 , esercita un’azione a distanza su una seconda spira

piana Γ2 , percorsa da una corrente stazionaria I2 , attraverso una forza meccanica F.

4:

5:

cioè fisse nelle loro posizioni e costanti nel tempo.

cioè di cariche elettriche in movimento con velocità costante nel tempo.

Capitolo 1. Il campo elettromagnetico

6

In particolare, assimilando i circuiti a due curve orientate disgiunte e generalmente

regolari dello spazio e supponendone le dimensioni molto più piccole della loro distanza

reciproca, Ampère potè stabilire empiricamente che6

¶

‰ µ

‰

r1 − r2

µ0 I 1 I 2

t2 ×

t1 ×

d`

d`2

F=

1

4π

kr1 − r2 k32

Γ2

Γ1

(1.7)

dove µ0 = 4π · 10−7 H/m è la permeabilità (magnetica) del vuoto e t̂2 = t̂2 (r2 ) e

t̂1 = t̂1 (r1 ) indicano, rispettivamente, i versori delle tangenti locali a Γ2 e a Γ1 nei

punti r2 ∈ Γ2 e r1 ∈ Γ1 (v. fig. 1.2). Ad un primo sguardo, la relazione (1.7) può

sembrare asimmetrica rispetto ai ruoli di Γ2 e Γ1 , suggerendo un’apparente violazione

del terzo principio della meccanica di Newton. Applicando, tuttavia, l’identità del

triplo prodotto (B.3), si può riscriverla nella forma

µ

¶ ¶

‰ µ

ˆ

µ0 I 1 I 2

1

F=

t̂2 ·

t̂1 · ∇3

d`2 d`1 +

4π

kr1 − r1 k2

Γ2

Γ1

‰ ‰

µ0 I1 I2

r2 − r1

−

t̂ · t̂1 d`1 d`2

3 2

4π

kr

2 − r1 k2

Γ2 Γ1

(1.8)

D’altronde, poiché l’integranda del primo integrale al membro destro dell’ultima equazione è un differenziale esatto, il termine corrispondente svanisce e l’espressione (1.7)

della forza magnetostatica fra le spire assume la forma

‰ ‰

µ0 I1 I2

r2 − r1

F=−

t̂ · t̂1 d`1 d`2

3 2

4π

Γ2 Γ1 kr2 − r1 k2

(1.9)

che manifesta apertamente la simmetria attesa in termini di Γ1 e Γ2 .

. Il campo magnetostatico

In analogia col caso elettrostatico, anziché descrivere l’interazione magnetostatica in

termini di una forza su una corrente stazionaria di prova I, come nel corso del sottoparagrafo precedente, conviene associare a una corrente stazionaria I0 , che scorre

attraverso un circuito elementare di lunghezza d` orientato secondo il versore tangente

t̂ ∈ R3 e localizzato nel punto r0 ∈ R3 , un campo vettoriale bstat

(·) : R3 − {r0 } → R3

0

(induzione magnetica) tale che

dbstat

(r) =

0

6:

µ0 I0

r − r0

,

t̂ ×

4π

kr − r0 k32

per ogni r ∈ R3 − {r0 }

si tratta della legge di Ampère per la magnetostatica.

(1.10)

Capitolo 1. Il campo elettromagnetico

7

Generalizzando al caso di una densità di corrente j(·) : V → R3 (in A/m2 ), tutta

concentrata in un compatto V ⊆ R3 , ne risulta la legge di Biot-Savart, per cui

µ

¶

ˆ

ˆ

µ0

r − r0

−1

µ0

j(r0 ) ×

dr30 =

j(r0 ) × ∇3

dr30 =

bstat (r) =

3

4π V

kr − r0 k2

4π V

kr − r0 k2

µ

¶

ˆ

ˆ

j(r0 )

µ0

µ0

1

=

rot

dr30 −

rot j(r0 ) dr30 =

4π V

kr − r0 k2

4π V kr − r0 k2

ˆ

j(r0 )

µ0

=

rot

dr30 ,

per ogni r ∈ Ve := R3 − V̄

(1.11)

4π

V kr − r0 k2

dove abbiamo usato l’identità (B.9) e il fatto che gradiente e rotore in seno all’integrale

non operano sulle coordinate di integrazione, e perciò rot j(r0 ) = 0, per ogni r0 ∈ V.

Per stabilire le proprietà del campo magnetostatico, proviamo, adesso, a calcolarne

divergenza e rotore. Dalla legge di Biot-Savart

µ

¶

ˆ

j(r0 )

µ0

div3 bstat (r) =

div3 ∇3 ×

dr30 = 0

4π

V kr − r0 k2

(1.12)

in Ve := R3 − V̄, sulla base della (B.15). In modo analogo, applicando l’identità

operatoriale (B.13) e i teoremi di Green, si trova [27] che (al netto dei calcoli)

µ ˆ

¶

j(r0 )

µ0

rot bstat (r) =

rot rot

dr30 = µ0 j(r)

(1.13)

4π

V kr − r0 k2

1.2.3

L’elettrodinamica

La sintesi estrema di quanto si è stabilito nel corso dei paragrafi precedenti è che

le leggi dell’elettrostatica e della magnetostatica si possono riassumere in due paia di

equazioni vettoriali alle derivate parziali disaccoppiate ed indipendenti dal tempo. I.e.,

le equazioni dell’elettrostatica classica

div3 estat (r) = ρ(r)

²0

rot estat (r) = 0

e le equazioni della magnetostatica classica

div3 bstat (r) = ρ(r)

²0

rot bstat (r) = µ0 j(r)

(1.14)

(1.15)

le une e le altre valide (anche in senso debole) nei punti di un qualsiasi aperto Ω esterno al dominio limitato V dello spazio dove si suppongono concentrate le cariche e le

correnti. Poiché non vi è nessun elemento a priori che metta in relazione estat (·) direttamente con bstat (·), l’elettrostatica e la magnetostatica classiche si sono sviluppate,

di fatto, come fossero due teorie indipendenti.

Capitolo 1. Il campo elettromagnetico

8

Quando, tuttavia, si ammette una variazione dei campi dal tempo7 , le due teorie

si unificano nell’elettrodinamica classica. Storicamente, l’unificazione è stata motivata

da due risultati fondamentali suggeriti dall’esperienza:

i) l’equazione di continuità e l’introduzione della corrente di spostamento di Maxwell, a seguito dell’osservazione che la carica (elettrica) è una quantità conservativa e che la corrente (elettrica) è soltanto un trasporto di carica.

ii) la legge dell’induzione di Faraday, per cui si stabilisce che una variazione del

flusso magnetico attraverso una spira induce una corrente nel circuito attraverso

l’azione di una forza elettromotrice.

. L’equazione di continuità

Supponiamo che, punto per punto nel dominio di interesse V ⊆ R3 e istante per istante

nell’intervallo temporale di riferimento (ti , tf ) ⊆ R, la densità di corrente e la densità

di carica osservate varino, rispettivamente, secondo le funzioni j(·) : R3 × (ti , tf ) → R e

ρ(·) : R × (ti , tf ) → R. Allora la legge empirica di conservazione della carica si traduce

nell’equazione di continuità (o di conservazione della carica)

∂ρ(r, t)

+ div j(r, t) = 0,

∂t

per ogni (r, t) ∈ V × (ti , tf )

(1.16)

per cui si stabilisce che la “velocità” di variazione della carica ρ(·) è localmente bilanciata dalla divergenza della densità di corrente j(·).

. La corrente di spostamento di Maxwell

In fine al paragrafo (1.2.2) abbiamo utilizzato implicitamente il fatto che in magnetostatica div j(·) = 0 nei punti di un aperto per stabilire una condizione locale sul

rotore dell’induzione magnetica. Sennonché la relazione deve essere adatta, nel caso

di sorgenti e campi non stazionari, in accordo con l’equazione di continuità (1.16), di

modo che div3 j(r, t) = −∂t ρ(r, t) in V × (ti , tf ).

In tal modo, ripetendo puntualmente i passaggi necessari alla derivazione logica

dell’equazione (1.13), si ottiene il risultato formale per cui

rot b(r, t) = µ0 j(r, t) + ²0 µ0

∂

e(r, t),

∂t

in V × (ti , tf )

(1.17)

dove il termine ²0 ∂t e(·) rappresenta la cosiddetta corrente di spostamento, introdotta

in un lampo di genio da Maxwell [28] per rendere solenoidale il membro di destra della

(1.17) nel momento in cui j(·) rappresenti la densità di corrente elettrica totale in V,

7:

cioè si transita da un regime stazionario a un regime dinamico.

Capitolo 1. Il campo elettromagnetico

9

che si può sempre splittare nelle tre aliquote delle correnti di conduzione, polarizzazione e magnetizzazione. La corrente di spostamento è un extra-termine assimilabile

a una corrente fittizia che fluice attraverso vuoto. Tra le altre conseguenze teoriche,

l’introduzione della corrente di Maxwell nell’equazione (1.17) consente di predire l’esistenza di una radiazione in grado di trasportare energia e momento attraverso lo

spazio-tempo, a grandissime distanze, persino in assenza di materia (i.e., nel vuoto).

. La forza elettromotrice

L’esperienza dimostra che, se un mezzo conduttore è attraversato dalle linee di forza

di un campo elettrico e(·), nel mezzo si induce un flusso di carica netta, e quindi una

densità di corrente elettrica j(·), che parzialmente può essere anche attribuita ad altri

processi (ad es., chimici o idrodinamici). Sotto opportune condizioni e per determinate

tipologie di materiali, è possibile talvolta assumere che, almeno in prima approssimazione, esista una relazione lineare fra j(·) ed e(·). Ossia che valga la cosiddetta legge

di Ohm, per cui

j(·) = σ(·) e(·)

(1.18)

dove σ(·) è la conducibilità (elettrica) del mezzo, eventualmente variabile punto per

punto e istante per istante entro l’intervallo temporale di osservazione. Nel più generale

dei casi, per esempio in un conduttore anisotropo, σ(·) è un tensore.

Ora, se la corrente è interamente dovuta all’azione del campo elettrico e(·), quest’ultimo spenderà un lavoro sulle cariche e, a meno che il mezzo non sia un superconduttore, vi sarà dissipazione di energia per effetto Joule sotto forma di calore. Il

rate con cui tale energia viene dispersa è pari a h j(·), e(·)i3 per ogni unità di volume.

D’altro canto, se e(·) è irrotazionale (quindi conservativo), j(·) tende asintoticamente

a zero con il tempo.

Di conseguenza, in condizioni di stazionarietà della corrente, è necessaria la presenza di un campo elettrico ausiliario eEMF (·) (dovuto, ad es., alla presenza di una

pila), corrispondente ad una forza elettromotrice E capace di mantenere in moto le

cariche. Nel qual caso la legge di Ohm (1.18) si riscrive nella forma

¡

¢

j(·) = σ(·) eEMF (·) + e(·)

(1.19)

da cui è possibile definire la forza elettromotrice E in termini della circuitazione del

campo elettrico totale, cioè ponendo

ˆ

E := heEMF (r, t) + estat (r, t), t̂i3 d`

Γ

ove Γ è un qualsiasi ciclo e t il versore della tangente locale a Γ.

(1.20)

Capitolo 1. Il campo elettromagnetico

10

. La legge dell’induzione di Faraday

Nel corso del sottoparagrafo (1.2.1) abbiamo ricavato le equazioni differenziali del

campo elettrostatico, stabilendo in particolare che estat (·) è irrotazionale, e perciò

conservativo 8 . Ne risulta che l’integrale di estat (·) esteso ad un qualsiasi circuito Γ

(in astratto, una cuva generalmente regolare dello spazio) è nullo. Di conseguenza,

l’equazione (1.20) comporta che

‰

heEMF (r, t), t̂i3 d`

E=

(1.21)

Γ

D’altronde, l’esperienza dimostra che la variazione del flusso magnetico attraverso una

qualunque superficie S concatenata a Γ si manifesta nell’azione di un campo elettrico

non conservativo, cui si associa una forza elettromotrice9 .

Figura 1.3: la variazione temporale del flusso di b(·) dovuta al moto relativo del dipolo

magnetico rispetto alla spira induce nel circuito una corrente misurata dall’amperometro collegato ai suoi estremi, confermando l’esperimento di Faraday.

Nella formulazione generalizzata di Maxwell, questo risultato si traduce nella cosiddetta legge di Faraday-Neumann-Lenz, per cui

‰

d

eEFM (r, t) · t̂ d` = − Φm (t) =

E(t) =

dt

ˆ

ˆΓ

∂b(r, t)

d

=−

b(r, t) · n̂ dS = −

· n̂ dS

dt S

∂t

S

8:

9:

(1.22)

i.e., si può esprimere come il gradiente di un campo scalare (potenziale elettrostatico).

e quindi un corrente, nel caso in cui Γ sia un vero e proprio circuito elettrico.

Capitolo 1. Il campo elettromagnetico

11

dove Φm (·), per l’appunto, è il flusso di b(·) attraverso S. Da qui, per applicazione

del teorema di Stokes, l’equazione integrale (1.22) assume la forma locale

rot3 e(·) = −∂t b(·)

(1.23)

che descrive in modo esplicito il legame esistente, in seno alla teoria maxwelliana, fra

l’elettrologia e il magnetismo ed è valida anche nel limite relativistico in cui la curva

Γ sia in movimento rispetto a un riferimento stazionario.

1.3

La teoria elettromagnetica formale

A questo punto, con uno sforzo di generalizzazione sulla validità delle equazioni stabilite (su base euristica o sperimentale) nel corso del paragrafo precedente, è possibile assiomatizzare la definizione del campo elettromagnetico “osservato” in una certa

regione dello spazio Ω ⊆ R3 , limitatamente all’intervallo di tempo (ti , tf ) ⊆ R, in

termini di qualsiasi coppia (e, b) di funzioni10 Ω × (ti , tf ) → R3 , anche generalizzate

e sufficientemente regolari, tali che

∇3 · d(r, t) = ρ(r, t)

∇3 × e(r, t) = − ∂ b(r, t)

∂t

∀(r, t) ∈ Ω × (ti , tf ) :

∇3 · b(r, t) = 0

∇ × h(r, t) = ∂ d(r, t) + j(r, t)

3

∂t

(1.24)

dove ρ(·) e j(·) sono funzioni Ω × (ti , tf ) → R e Ω × (ti , tf ) → R3 associate, rispettivamente, alle cariche e alle correnti11 presenti nel dominio di interesse e d(·) e h(·),

analogamente, funzioni12 Ω × (ti , tf ) → R3 legate ai campi primari e(·) ed h(·) da

opportune trasformazioni (dette relazioni costitutive) del tipo

d(r, t) = F [e, b](r, t)

,

per ogni (r, t) ∈ Ω × (ti , tf )

h(r, t) = G[e, b](r, t)

(1.25)

la cui forma (generalmente complicata) si fa dipendere, in definitiva, dalla natura

particolare del mezzo materiale che, fisicamente, occupa la regione Ω dello spazio dove

le equazioni di Maxwell si ammettono collocate.

10 :

11 :

dette, rispettivamente, campo elettrico e induzione magnetica

per esempio, correnti impresse dai generatori oppure cariche indotte dall’interazione del

campo elettromagnetico con la materia.

12 : dette, rispettivamente, induzione elettrica e campo magnetico.

Capitolo 1. Il campo elettromagnetico

1.3.1

12

Le relazioni costitutive della materia

Pare chiaro, pertanto, che la solvibilità delle equazioni di Maxwell in Ω×(ti , tf ) presuppone siano state formulate delle ipotesi di modello circa le proprietà elettromagnetiche

locali del mezzo materiale che, in tutto o in parte, occupa il volume di Ω, per il resto

assimilabile al vuoto13 . D’altro canto è del tutto evidente che, se si intende ricavare

una soluzione valida, ad esempio, per il campo prodotto da un antenna satellitare nello

spazio, è assolutamente impensabile considerare legami fra i vari campi in gioco che,

tanto per dire, sarebbero veri nel caso di un dielettrico debole caratterizzato da perdite

per conduzione.

Una consuetudine assai diffusa nell’ambito dell’ingegneria elettromagnetica è di

identificare una classe abbastanza ampia di mezzi ideali per cui le relazioni costitutive

si ammettono note e in cui è interessante, per varie ragioni, studiare le soluzioni delle

equazioni di Maxwell (ad es., perché particolarmente agevoli). L’idea è, quindi, di

approssimare ogni altro materiale del mondo fisico reale alle proprietà dei casi ideali

definiti per questo verso.

Nel vuoto, per esempio, e nei dielettrici assimilabili nelle loro caratteristiche al

vuoto, si ipotizza che i campi e le induzioni (in assenza di conduzione) sia legati da

relazioni di proporzionalità diretta, per cui

d(·) = ²0 ²r (·) e(·)

b(·) = µ0 µr (·) h(·)

j(·) = 0

(1.26)

dove ²0 ' 8.854 · 10−12 F/m e µ0 = 4π · 10−7 H/m (rispettivamente, permettività

dielettrica e permeabilità magnetica del vuoto) sono costanti assolute ed ²r (·) e µr (·)

sono caratteristiche del mezzo preso in considerazione (rispettivamente, permettività

dielettrica e permeabilità magnetica relative).

Più in generale, nel caso che il dielettrico sia caratterizzato da una conducibilità

σ(·) (espressa in f/m), i.e., in presenza di perdite, si ammette

d(·) = ²0 ²r (·) e(·)

b(·) = µ0 µr (·) h(·)

j(·) = σ(·) e(·)

(1.27)

nell’assunzione implicita che il dominio del problema non includa dei generatori di

corrente, e che perciò la densità j(·) sia dovuta tutta e sola all’azione di deriva delle

cariche da parte del campo elettromagnetico.

13 :

dove la trattazione è particolarmente semplificata.

Capitolo 1. Il campo elettromagnetico

13

In una visione più ampia, i mezzi materiali per cui sono valide le relazioni costitutive (1.26) oppure (1.27) devono soddisfare alle proprietà di isotropia, linearità,

omogeneità e non dispersività (nel tempo che nello spazio) definite qui di seguito, limitatamente al legame funzionale che descrive la dipendenza dell’induzione elettrica

d(·) dal campo primario e(·). Le relazioni fra b(·) ed h(·) oppure fra j(·) ed e(·), in

assenza di sorgenti, sono, infatti, del tutto analoghe.

. Isotropia e anisotropia.

Le due proprietà attengono al comportamento del mezzo rispetto alla direzione delle

linee di campo dei vettori coinvolti nelle equazioni di Maxwell. Avviene, infatti, che

la risposta di un certo materiale alle sollecitazioni di un campo elettromagnetico siano

suscettibili di variazione, per esempio, a seconda che il campo incida perpendicolarmente o meno alla sua superficie. È il caso dei mezzi cosiddetti anisotropi, come i

cristalli e le ferriti, cui si contrappongono per dualità i mezzi isotropi, come il vuoto

ed il vetro.

Gli uni e gli altri, nel limite della linearità, si descrivono ammettendo che il legame

fra il campo e l’induzione elettrica e(·) e d(·) si possano esprimere attraverso l’introduzione di una matrice ²(·) di trasformazione 3 × 3 secondo la relazione d(·) = ²(·) e(·), i

cui ingressi sono funzioni scalari a valori reali del tempo e dello spazio. I mezzi isotropi

corrispondono al caso in cui ²(·) è scalare, i.e., esiste ²(·) : Ω × (ti , tf ) → R tale che

²(·) = ²(·)I3 , dove I3 è l’identità 3 × 3.

. Dispersività nel tempo e nello spazio.

Alcuni mezzi rispondono alle sollecitazione del campo elettromagnetico in un punto

particolare (r, t) del cronotopo “integrando” gli effetti prodotti in altri punti, distanti

da (r, t) nel tempo o nello spazio, secondo il comportamento tipico di un sistema I/O

dotato di memoria in cui le uscite le induzioni d(·) o b(·) oppure la densità di corrente

j(·) e gli ingressi i vettori e(·) o h(·).

Da un punto di vista dei modelli, per lo meno in condizioni di linearità, le uscite del

sistema “equivalente” si ottengono attraverso la convoluzione della risposta impulsiva

del mezzo con l’ingresso opportuno. Trattandosi, tuttavia, di grandezze vettoriali, la

matematica si complica notevolmente, poiché la risposta impulsiva del mezzo non è

una semplice funzione scalare, ma una matrice.

Si parla in tal caso di mezzi dispersivi (lineari), nel tempo o nello spazio a seconda

delle circostanze. In pratica, la dispersività comporta che la relazione sussistente,

per esempio, fra d(·) ed e(·) non è una relazione di proporzionalità o il prodotto

Capitolo 1. Il campo elettromagnetico

14

per una matrice, come nei casi esaminati in precedenza, ma richiede un’integrazione

nell’intervallo di tempo (ti , tf ) o sull’insieme Ω che definiscono il dominio del problema

(i.e., delle equazioni di Maxwell).

L’effetto generale, comunque, è che il campo nel mezzo dipende, oltre che dall’istante di osservazione, anche dalla storia” passata; inoltre l’effetto della dispersività è

tanto più forte quanto più il mezzo riesce ad inseguire” le variazioni del campo. Un

effetto effettivamente visibile nello studio della propagazione delle onde magnetiche

sono i cosiddetti pacchetti d’onda, che però esulano dall’argomento del presente, e

riguardano invece le soluzioni delle EdM. Basti dire che in questo caso le varie costanti

dipendono invece dalla frequenza di osservazione, e questo porta ad una modifica, ad

esempio, della velocità con cui si propagano le onde e.m. e la stessa velocità varia con

la frequenza.

Ne risultano notevoli complicazioni dal punto di vista della determinazione analitica delle soluzioni e, di riflesso, la necessità di affidarsi a un approccio alternativo,

attraverso lo sviluppo di codici ad hoc in grado di affrontare e risolvere il problema

per via numerica al calcolatore.

In realtà tutti i mezzi sono dispersivi (persino il vuoto!), quindi si effettua un’approssimazione e si trascura in prima battuta questo effetto, salvo riprendere il problema

a posteriori per “ritoccare” le soluzioni calcolate. In generale, comunque, è possibile

trascurare questo effetto se il campo varia molto più velocemente della risposta del

mezzo.

. Omogeneità nel tempo e nello spazio.

Anche nell’ipotesi che i campi e le induzioni o il campo elettrico e la corrente siano

legati gli uni alle altre dalle relazioni di proporzionalità diretta riassunte nel sistema

(1.27), la permettività ²r (·), la permeabilità µr (·) e la conducibilità σr (·) sono funzioni

scalari sia delle coordinate spaziali che del tempo. Quando, tuttavia, la dipendenza

dalle une o dall’altra è soltanto implicita, ovvero i parametri caratteristici ²r (·), µr (·) e

σr (·) sono costanti in ogni punto del dominio di interesse o in ogni istante dell’intervallo

di osservazione, allora il mezzo si dice, rispettivamente, omogeneo nel tempo o nello

spazio. Un mezzo che sia omogeneo tanto nello spazio quanto nel tempo si dice,

senz’altro, omogeneo.

In effetti, l’ipotesi di omogeneità è una fortissima semplificazione del modello fisico

necessario alla descrizione delle proprietà elettromagnetiche dei materiali, perché è

pacifico, ad esempio, che il segnale elettromagnetico irradiato da un’antenna cellulare

incontra lungo il suo cammino ostacoli di ogni sorta, passando attraverso l’aria e i

Capitolo 1. Il campo elettromagnetico

15

muri delle case oppure riflettendosi sulla superficie degli specchi d’acqua o sugli strati

ionizzati dell’atmosfera. Cioè si propaga in una varietà eterogenea di mezzi materiali,

ognuno dei quali dotato di una permettività, una permeabilità e una conducibilità

diverse dagli altri. Al punto che il modello omogeneo dello spazio non è applicabile.

Sennonché la via perseguita nella pratica consiste, in genere, nella suddivisione del

dominio originale del problema (sia nel tempo che nello spazio) in un certo numero

(finito) di sottodomini, di modo tale che in ciascuno siano pressoché valide le ipotesi

di omogeneità. Quindi si studiano le soluzioni alle equazioni di Maxwell in ciascun

sottodominio e si cerca a posteriori di “incollarle”, forzando condizioni di raccordo

alle interfacce che assicurino il rispetto di tutte le leggi fondamentali, come, ad es.,

l’equazione di continuità (1.16).

. Linearità e sovrapposizione degli effetti.

La diretta generalizzazione della relazione d(·) = ²(·) e(·), con cui si può descrivere,

in alcune circostanza, il legame fra il campo e l’induzione elettrica14 in condizioni di

anisotropia, prevede di assumere che

d(·) =

n

X

²(k) (·) e(·) = ²(·) e(·) + ²(2) (·) e(·) + . . . + ²(n) (·) e(·)

(1.28)

k=1

dove n ∈ N0 è un certo grado di non linearità, introdotto nel modello per tenere conto

degli effetti del secondo, terzo, . . . ordine indotti dal mezzo, con il vantaggio che quanto

più n cresce, tanto più preciso è l’accoppiamento fra d(·) ed e(·) descritto dalla (1.28);

e lo svantaggio che la soluzione (anche numerica) delle equazioni di Maxwell ne risulta

enormemente complicata.

Per queste ragioni, nella pratica, si preferisce quasi sempre utilizzare l’approssimazione del prim’ordine, forzando la linearità del mezzo. In generale, il modello è

accettabile (rispetto al risultato che produce) fintanto che l’intensità dei campi non

è molto elevata o le loro variazioni nel tempo non sono troppo repentine. E allora

il mezzo soddisfa il c.d. principio di sovrapposizione degli effetti, per cui il campo

totale dovuto, ad esempio, alla presenza di n sorgenti distinte in una stessa regione

dello spazio può essere espresso come somma dei campi parziali dovuti ad ogni singola

sorgente in assenza di tutte le altre.

14 :

ovvero fra il campo e l’induzione magnetico oppure il campo elettrico e la densità di

corrente, secondo relazioni del tutto analoghe.

Capitolo 1. Il campo elettromagnetico

1.4

16

Il fenomeno dello scattering

Un’applicazione particolarmente interessante del modello maxwelliano attiene alla cosiddetta teoria dello scattering, che trova applicazioni trasversali nei più disparati

settori della ricerca scientifica e dell’avanzamento tecnologico, dall’implementazione di

apparecchiature di diagnostica tumorale all’impiego del telerilevamento satellitare per

la localizzazione di giacimenti petroliferi o di metalli preziosi negli strati superficiali

della crosta terrestre.

Almeno nei limiti dell’elettromagnetismo, la teoria dello scattering riguarda gli

effetti prodotti dalla presenza di un mezzo disomogeneo sulla propagazione (altrimenti

libera) di un’onda. Nello specifico, supponendo che il campo totale u(·) associato ad

una qualche proprietà radiante del segnale15 si possa scomporre nella somma di un

campo incidente ui (·), associato alle sorgenti, e di un campo diffuso (o scatterato) us (·),

associato alla presenza delle disomogeneità (ovvero di qualche ostacolo), è possibile

definire almeno due tipi di problemi comunemente ascritti alla teoria dello scattering:

i) il problema diretto, per cui si chiede di determinare us (·) dalla consocenza di ui (·)

e delle equazioni che governano la propagazione dell’onda, incluse le relazioni

costitutive del mezzo e la sua geometria;

ii) il problema inverso, per cui si richiede di risalire la natura del mezzo e/o ricostruirne la geometria a partire dalla conoscenza del comportamento asintotico

di us (·), ovvero di ricavare le equazioni del problema e/o il loro dominio di

definizione, ammettendo di conoscerne un certo set di soluzioni.

Al di là della descrizione appena fornita sull’argomento, necessariamente assai semplificata, il topic coinvolge un’immensa mole di concetti fisici e idee matematiche consolidate nel corso di tanti anni di intensa ricerca nell’area. In particolare, per un saggio

sufficientemente completo degli innumerevoli contributi portati allo sviluppo del settore, si raccomandano le monografie di Bleistein [19], Colton e Kress [21], Jones [25],

Lax e Phillips [31], Newton [32], Reed e Simon [33] e Wilcox [35].

In seno alla teoria dello scattering, i problemi più semplici da affrontare riguardano

il caso (scalare) delle cosiddette onde acustiche a dipendenza armonica dal tempo, diffuse da un mezzo disomogeneo e assorbente a supporto compatto oppure da un oggetto

limitato e impenetrabile: oltreché per la loro rilevanza in situazioni realistiche di notevole interesse applicativo (per esempio, nella tomografia acustica e nella diagnostica

non distruttiva), lo studio dei suddetti problemi serve pure da modello per lo studio

di fenomeni di propagazione più complicati, che coinvolgono lo scattering di particelle

15 :

ad es., il campo elettrico o il vettore di Poynting.

Capitolo 1. Il campo elettromagnetico

17

oppure onde elastiche o elettromagnetiche. Dal punto di vista della modellazione matematica, si assume che, limitatamente almeno all’intervallo (ti , tf ) di osservazione, il

campo incidente sia espresso da un’onda piana temporalmente armonica della forma

ui (r, t) := exp(jkhr, di3 − ωt),

per ogni (r, t) ∈ Ω × (ti , tf )

(1.29)

dove d ∈ R3 è il versore della direzione di propagazione, k := ω/c il numero d’onda,

ω è la frequenza (angolare) e c la velocità di riferimento (del segnale) calcolata in una

condizione ideale di completa omogeneità 16 .

Nel caso di un mezzo disomogeneo, il problema diretto comporta, allora, la determinazione (ove possibile) di un campo scalare us (·) : R3 → C tale che

∆3 u(r) + k2 n(r) u(r) = 0

,

per ogni r ∈ R3

u(r) = exp(jkhr, αi3 ) + us (r)

(1.30)

Qui n(·) : R3 → C è una funzione nota, che esprime il rapporto locale fra la velocità

del campo totale u(·) nel mezzo inomogeneo e la velocità di riferimento c dell’onda

incidente. Il problema differenziale (1.30) viene completato abbinandogli una qualche

condizione al contorno sui punti della sfera infinita. Ad esempio, la condizione di

radiazione di Sommerfeld, per cui si richiede che

µ s

¶

∂u (r)

s

lim r ·

− ik u (r) = 0

r→∞

∂r

(1.31)

La condizione al limite (1.31) ha una chiara interpretazione fisica: serve a garantire che

l’onda diffusa, a grande distanza dall’origine, si approssimi a un’onda sferica diretta

radialmente verso l’infinito. D’altro canto, ammettendo che lo scattering sia dovuto ad

un ostacolo sound-soft impenetrabile, tipicamente modellato da un insieme aperto e

connesso D ⊆ R3 , la cui frontiera sia una superficie di classe C 2 oppure, a un livello di

generalizzazione superiore, una superficie di Lyapunov, il problema consiste nel calcolo

di un campo scalare us (·) : Ω → C, con Ω := R3 \ cl(D), tale che

∆3 u(r) + k2 n(r) u(r) = 0

,

per ogni r ∈ Ω

u(r) = exp(jkhr, αi3 ) + us (r)

(1.32)

e u(r) = 0, per ogni r ∈ ∂D (condizione omogenea al contorno di Dirichlet). Come

nel caso precedente, è tipico, poi, completare il modello imponendo che us (·) verifichi

anche la (1.31). Inoltre è possibile che la condizione di bordo per cui u(r) = 0 su ∂D

venga sostituita con altre differenti17 . Comunque sia, resta che gli esempi presentati

16 :

per esempio, nel caso elettromagnetico, ammettendo lo spazio interamente “occupato”

dal vuoto (o da un altro dielettrico omogeneo), in assenza degli scatteratori.

17 : ad esempio, condizioni al contorno di Neumann o di Robin.

Capitolo 1. Il campo elettromagnetico

18

finora rappresentano, nell’ambito della teoria dello scattering diretto, i problemi più

semplici per cui sia possibile trovare una corrispondenza fra il modello matematico e i

fenomeni reali della fisica. Ciò nonostante, tuttavia, non è dato affermare, ancora oggi,

che siano stati del tutto risolti. Tanto che restano un soggetto di enorme attrattiva

scientifica, specialmente dal punto di vista numerico, ossia della loro risoluzione stabile

ed efficiente al calcolatore. Maggiori dettagli vengono forniti nel corso del successivo

cap. 2, dove si fornisce una review molto completa, dal taglio eminentemente formale,

della teoria dello scattering scalare da cilindri metallici.

Il quadro è ulteriormente complicato dall’introduzione del problema dello scattering inverso, di pari interesse, ma in molte circostanze persino più complesso (sotto

il profilo matematico). Per poterne fornire una formulazione rigorosa, serve, anzitutto, riconoscere che il campo diffuso determinato dai problemi diretti (1.30) e (1.32)

possiede un andamento asintotico del tipo

µ ¶

ejkr s

1

us (r) =

u∞ (r̂; k, d) + O 2

r

r

(1.33)

dove r := r̂ · krk, per ogni 0 6= r ∈ R3 , e us∞ (·) è il cosiddetto campo lontano 18 .

Lo studio dello scattering inverso, allora, consiste nel determinare vuoi l’indice di

diffrazione del mezzo disomogeo del problema (1.30) vuoi la geometria dello scatteratore sound-soft del problema (1.32) a partire dalla conoscenza del campo lontano

us∞ = us∞ (r̂; k, α), per ogni (r̂, d) ∈ U ⊆ B22 , ; oltreché, eventualmente, per diversi

valori del numero d’onda k ∈ C.

. Lo scattering nelle applicazioni

Il numero delle applicazioni è esorbitante, al punto che non è pensabile qui fornirne

un elenco estensivo completo. Si spazia, di fatto, dall’ambito militare, dove la teoria

ed i suoi risultati vengono impiegati, per es., nella localizzazione di ordigni sepolti inesplosi, campi minati, tunnel sotterranei; all’ambito aereospaziale, con la realizzazione

di sistemi di sondaggio per l’analisi delle proprietà elettriche del suolo e sottosuolo di

pianeti o satelliti19 .

Lo scattering inverso, in particolare, è alla base del principio di funzionamento della

tecnologia GPR (ground penetrating radar ), utilizzata in geofisica per la determinazione delle stratificazioni nel terreno e di eventuali presenze di cavità o falde acquifere;

o in archeologia per la caratterizzazione preliminare degli scavi nei siti archeologici.

In questi contesti, il vantaggio principale consiste nella possibilità di conoscere con

18 :

19 :

anche noto col nome di ampiezza di scattering.

un sistema del genere fu impiegato nella missione spaziale Apollo 17.

Capitolo 1. Il campo elettromagnetico

19

esattezza l’ubicazione degli obiettivi di interesse in maniera completamente non distruttiva, i.e, senza dover danneggiare lo scenario di indagine procedendo “alla cieca”

con scavi, carotaggi, etc.

Oltreché nel campo geofisico e archeologico, i sistemi GPR vengono utilizzati in

diverse applicazioni ad alta risoluzione, come la ricerca di fratture nascoste in strutture edili particolari (dighe, pilastri, ect.), la rilevazione della velocità e profondità di

diffusione di materiali inquinanti oleosi dispersi a terra, la misurazione di precisione

dello spessore di lastre di ghiaccio, manti stradali, massicciate, ect.; e più in generale

in numerosi campi di indagine inerenti a obiettivi di interesse ambientale.

Estremamente attuali sono, poi, le ricadute nel settore delle scienze biomediche,

dove lo scattering è largamente impiegato nel campo della diagnostica non invasiva,

cui di recente l’autore si è applicato, poiché coinvolto in una serie di ricerche condotte,

nell’ambito dei PRIN20 , dall’IREA21 di Napoli, in collaborazione con il gruppo di

Campi elettromagnetici della Facoltà di Ingegneria dell’Università “Mediterranea” di

Reggio Calabria.

L’attività svolta nel corso del ciclo di dottorato, ad ogni modo, si è incentrata

in prevalenza sullo studio dei problemi diretti e delle tecniche numeriche per la loro

risoluzione, che trovano riscontro, ad esempio, nella progettazione e implementazione di antenne per le telecomunicazioni (terrestri e satellitari), nella rilevazione radar

di oggetti in volo (nell’ambito dell’aeronautica civile o della difesa militare) o nella

realizzazione di sistemi intelligenti di autodistanziamento dei veicoli su strada (c.d.

sensori FS); e inoltre costituiscono, in circostanze ordinarie, un passaggio necessario

nel processo di validazione delle procedure utilizzate per “attaccare” i problemi inversi.

20 :

21 :

Progretti di Rilevante Interesse Nazionale.

Istituto per il Rilevamento Elettromagnetico dell’Ambiente.

Capitolo 2

L’EFIE e lo scattering diretto

Nel corso del capitolo consideriamo un problema al contorno collegato in modo naturale allo studio dello scattering diretto di un’onda piana a dipendenza armonica dal

tempo da parte di un conduttore cilindrico (perfetto o imperfetto). Benché il problema

sia semplice se paragonato ad altri analoghi della teoria dello scattering, la sua risoluzione ha richiesto molti anni di ricerca per essere formalizzata e costituisce, di fatto,

una base sicura per lo sviluppo e il testaggio delle procedure di calcolo implementate

per la risoluzione numerica di problemi generali in cui siano coinvolti dei sistemi più

complessi.

2.1

Le equazioni dello scattering

Consideriamo la propagazione di un’onda elettromagnetica in un mezzo isotropo, omogeneo, non dispersivo e privo di perdite, caratterizzato da permettività dielettrica ² e

permeabilità magnetica µ reali e costanti. Fissata una frequenza ω > 0, ammettiamo

che l’onda si possa descrivere nei termini di una coppia e(·), h(·) di campi R3 ×(−∞, ∞)

tali che

e(r, t) = ²−1/2 E(r) e−jωt

,

h(r, t) = µ−1/2 H(r) e−jωt

in R3 × (−∞, ∞)

(2.1)

3

dove E(·), H(·) sono funzioni vettoriali Lloc

1 (R , C) che risolvono (in un qualche senso

da doversi precisare) il sistema di equazioni alle derivate parziali [18]

rot E(r) − jkH(r) = 0

,

per ogni r ∈ Ve

rot H(r) + jkE(r) = 0

(2.2)

Capitolo 2. L’EFIE e lo scattering diretto

21

√

in cui k := ω ²µ è detto numero d’onda e Ve := R3 − V rappresenta il complementare

della chiusura topologica di un aperto monoconnesso ∅ 6= V ⊆ R3 . Quindi assumiamo

che un’onda piana monocromatica

1

ei (r, t) = Ei (r; d, p) e−jωt =

rot rot p ejkhr,di−jωt

k2

1

rot p ejkhr,di−jωt

hi (r, t) = Hi (r; d, p) e−jωt =

jk

(2.3)

di polarizzazione nota p ∈ R3 , si propaghi attraverso il cronotopo nella direzione

del versore d ∈ R3 e incida su un conduttore elettrico (possibilmente non ideale), e

ne risulti diffusa nello spazio circostante. Assimiliamo il dominio V al volume fisico

occupato dall’ostacolo ed immaginiamo di scomporre puntualmente i fasori E(·) ed

H(·) dei campi totali e(·) ed h(·) secondo una relazione del tipo

E(r) = Ei (r; d, p) + Es (r; d, p)

,

in R3

H(r) = Hi (r; d, p) + Hs (r; d, p)

(2.4)

dove Es (·) e Hs (·) rappresentano i campi scatterati (o diffusi) generati dall’interazione dell’onda incidente con l’ostacolo. Imponiamo, per finire, che la coppia (Es , Hs )

soddisfi la condizione di radiazione di Silver-Müller

¡

¢

lim Hs (r) × r − rEs (r) = 0

(2.5)

r→∞

r

, e l’una o l’altra,

krk2

esclusivamente, fra la condizione al bordo di Dirichlet omogenea

uniformemente rispetto ad ogni direzione dello spazio r̂ :=

E(r) = 0,

per ogni r ∈ ∂V

(2.6)

oppure la condizione al bordo di Robin

¡

¢

n̂ × rot E(r) − jλ(r) n̂ × E(r) × n̂,

per ogni r ∈ ∂V

(2.7)

in cui λ(·) è una funzione positiva ∂V → R impiegata per modellare l’impedenza

superficiale dell’oggetto e n è il versore della normale locale uscente dalla frontiera di

V (che qui si suppone una varietà di classe C 2 ).

Su queste premesse, il problema dello scattering elettromagnetico di onde piane

armoniche nel tempo da parte di un ostacolo metallico consiste, in generale, nella

determinazione di una coppia di soluzioni alle equazioni di Maxwell (2.2) che soddisfino

le relazioni (2.3)-(2.4) e le condizioni al contorno (2.5)-(2.6) o (2.5)-(2.7): parleremo

nel primo caso di scattering da corpi metallici ideali, nel secondo di scattering da

conduttori elettrici imperfetti.

Capitolo 2. L’EFIE e lo scattering diretto

2.2

22

Il caso del conduttore cilindrico

Immaginiamo, adesso, che lo scatteratore del problema definito nel corso del paragrafo precedente non abbia una geometria arbitraria, ma sia un cilindro di sezione

trasversale Ω ed asse parallelo alla direzione ẑ di una base ortonormale destrogira

(x̂, ŷ, ẑ) di R3 , in cui il punto generico r si possa equivalentemente esprimere per

mezzo del sue coordinate rettangolari (x, y, z). Ipotizziamo che Ω, in proiezione sul

piano z = 0, sia un aperto monoconnesso di R2 e poniamo Ωe := R2 − Ω̄. Quindi

assumiamo p = (0, 0, 1) e d = (d1 , d2 , 0) con riferimento alla (2.3) e che il campo EM

sia trasverso magnetico, i.e.

Ei (r) = exp(jkhr, di) ẑ

,

E(r) = Ez (r) ẑ

per ogni r ∈ R3

(2.8)

Sotto queste ipotesi, i campi totali E(·) ed H(·) associati al problema di scattering

(2.2)-(2.5) si dimostrano indipendenti dalla coordinata longitudinale z. Ne risulta

dalla (2.2) che H(r) = Hx (r) x̂ + Hy (r) ŷ in Ve e che le componenti incognite Hx (·),

Hy (·) e Ez (·) di E(·) ed H(·) soddisfano il sistema

∂ E (r) = jkHx (r)

y z

,

per ogni r ∈ Ωe

∂x Ez (r) = −jkHy (r)

∂ H (r) − ∂ H (r) = −jkE (r)

x

y

y

x

(2.9)

z

dove adesso r := (x, y). Da qui, postulando che Ez (·) sia derivabile almeno fino

al secondo ordine oppure interpretando le derivate in senso debole, si deduce che il

campo, in definitiva, è determinato dall’equazione scalare di Helmholtz

∆2 Ez (r) + k2 Ez (r) = 0,

in Ωe

(2.10)

A questo punto si tratta di adattare alla particolare configurazione del problema le

condizioni al contorno richieste nel caso generale.

In tal senso, considerando che Es (·) è allineato con ẑ, i.e., Es (r) = Ezs (r) ẑ in Ve ,

è sufficiente imporre che Ezs (·) verifichi, uniformemente per ogni direzione del piano

r

r̂ :=

, la condizione di radiazione di Sommerfeld

krk2

µ

¶

√

∂Ezs (r)

lim r

− jkEzs (r) = 0

(2.11)

r→∞

∂r

per garantire che la condizione di Silver-Müller (2.5) sia “naturalmente” soddisfatta. D’altro canto, la condizione omogenea di Dirichlet (2.6), valida nel caso di un

conduttore cilindrico perfetto, comporta in tutta evidenza che

Ezs (r) = − exp(jkhr, di),

per ogni r ∈ ∂Ω

(2.12)

Capitolo 2. L’EFIE e lo scattering diretto

23

dove ∂Ω := Ω̄ ∩ Ω̄e è, di fatto, una curva del piano di classe C 2 , per via delle ipotesi

assunte sulla frontiera di V. Mentre la condizione di Robin (2.7) per un cilindro

metallico non ideale assume la forma semplificata

∂Ez (r)

+ jλ(r) Ez (r) = 0,

∂n

per ogni r ∈ ∂Ω

(2.13)

dacché n̂ = (nx , ny , 0) e E(·) = Ez (·) ẑ, nella geometria del problema, e perciò n̂ ×

¢

¡

rot E(r) = −∂n̂ Ez (r) e n̂ × E(r) × n̂ = E(r) su ∂Ω.

Le equazioni (2.10)-(2.11), abbinate ora alla (2.12) ora alla (2.13), definiscono,

di fatto, il modello differenziale utilizzato per lo studio dello scattering elettromagnetico TM da parte di un cilindro metallico, ideale o non ideale, di un’onda piana

monocromatica polarizzata secondo l’asse dello scatteratore.

Per quanto semplice rispetto ad altri problemi di scattering, in cui sono coinvolti

sistemi a n corpi o geometrie singolari e le equazioni di Maxwell o le loro derivazioni

(ad es., l’equazione di Helmholtz) non si “scalarizzano”, manifestando pienamente la

propria natura vettoriale, il caso cilindrico costituisce

• un presupposto e un banco di prova importante per la definizione di un’ampia

varietà di tecniche, analitiche e numeriche, da potersi utilizzare nella risoluzione

di problemi ben più generali [54];

• un modello efficace per ottenere delle ragionevoli stime di prima approssimazione

là dove ogni altro approccio sia precluso o sconveniente1 .

Da qui l’ampio spazio dedicato nel prosieguo del capitolo agli sviluppi della teoria

matematica necessaria per inquadrare all’interno del giusto assetto formale la soluzione

del problema definito nel corso di questo paragrafo.

2.2.1

Il problema diretto

Passiamo adesso a formalizzare i passaggi fondamentali per cui si dimostra che il

problema dello scattering da conduttori cilindrici in presenza di un’eccitazione piana

armonica nel tempo, polarizzata secondo il vettore p = (0, 0, 1), è ben posto (secondo

Hadamard). Nel senso che l’equazione di Helmholtz 2-dimensionale (2.10) possiede

un’unica soluzione (forte) u(·) ∈ C 2 (Ω; C) ∩ C 1 (Ω; C) che dipende con continuità (in

una norma opportuna) dai dati e per cui sono soddisfatte le condizioni al contorno

(2.11) e (2.12) oppure (2.11) e (2.13), a seconda che il conduttore sia perfetto o meno.

1:

alcuni codici utilizzati per la computazione numerica della soluzione dei problemi di

scattering 3D operano iterativamente a partire da una stima iniziale dei termini incogniti, da

cui dipende spesso in modo critico la convergenza tout-court della procedura.

Capitolo 2. L’EFIE e lo scattering diretto

24

Innanzitutto riformuliamo il problema, svincolandolo dal suo rapporto con il fenomeno fisico. Assumiamo astrattamente che Ω 6= ∅ sia un dominio limitato di R2

contenente l’origine con un complemento Ωe := R2 − Ω̄ connesso2 tale che ∂Ω sia

di classe C 2 . L’obiettivo è di sintetizzare la dimostrazione dell’esistenza di un’unica

funzione us (·) ∈ C 2 (Ωe ) ∩ C 1 (Ω̄e ) tale che

∆2 u(r) + k2 u(r) = 0

,

u(r) = exp(jkhr, di) + us (r)

in Ωe

(2.14)

dove k è una costante positiva e us (·) soddisfa la condizione di Sommerfeld

µ s

¶

√

∂u (r, θ)

lim r

− jkus (r, θ) = 0

r→∞

∂r

(2.15)

uniformemente per ogni θ ∈ [0, 2π), dove (r, θ) sono le coordinate polari di un generico

punto r ∈ R2 − {(0, 0)}. Inoltre richiediamo che u(·), come definito dalla (2.14),

verifichi l’una o l’altra fra la condizione di Dirichlet

u(r) = 0

⇐⇒

us (r) = − exp(jkhr, di),

in ∂Ω

(2.16)

o la condizione di impedenza superficiale di Robin

∂u(r)

+ jλ(r)u(r) = 0,

∂ n̂

in ∂Ω

(2.17)

In quest’ultimo caso, ammettiamo che λ(·) sia una funzione continua positiva ∂Ω → R

e che n = n(r) rappresenti il versore locale della normale uscente da Ω nel generico

punto r ∈ ∂Ω. Per dimostrare l’esistenza di una soluzione al problema al contorno così

formulato intendiamo utilizzare la teoria dei potenziali di singolo e doppio strato [36].

. L’unicità della soluzione

Identifichiamo la soluzione fondamentale dell’equazione di Helmholtz in (2.14) nella

funzione Φ(·) : R2 × R2 7→ C definita assumendo

Φ(r, s) :=

1 (1)

jH (kkr − sk2 ),

4 0

per ogni r, s ∈ R2 , r 6= s

(2.18)

(1)

dove H0 (·) indica la funzione di Hankel di prima specie e ordine zero [55]. Quindi

notiamo che Φ(·) soddisfa la condizione di radiazione di Sommerfeld (2.11) rispetto a

entrambi i suoi argomenti e che

Φ(r, s) =

2:

1

1

ln

+ O(1),

2π

kr − sk2

per kr − sk2 → 0+

si osservi che Ω può essere anche molteplicemente connesso.

(2.19)

Capitolo 2. L’EFIE e lo scattering diretto

25

Per inciso, qualunque sia s ∈ R2 , la funzione R2 → C : r 7→ Φ(r, s) è una soluzione

debole (v. appendice A) l’equazione non omogenea

∆2 u + k2 u = δs

dove δs è la massa di Dirac di centro s. In effetti, è interessante come, nell’ambito

della teoria delle funzioni generalizzate, le conclusioni a venire si possano stabilire (per

dualità) con uno sforzo molto più modesto di quanto non avvenga per la formulazione

classica del problema. Il prezzo da pagare è che, nell’approccio distribuzionale, non

è possibile inferire alcuna informazione a priori sulla regolarità delle soluzioni, che

dev’essere, infatti, dedotta a posteriori impiegando alcuni risultati non banali come i

teoremi di immersione di Sobolev.

Detto questo, l’importanza dell’introduzione della soluzione fondamentale (2.18) è

legata, sostanzialmente, al teorema qui di seguito enunciato, per cui risulta che ogni

soluzione sufficientemente regolare del problema esteriore (2.10) si può rappresentare,

attraverso i teoremi di Green, in termini di un integrale di linea sulla frontiera ∂Ω

della sezione 2D trasversale dello scatteratore cilindrico.

¥

Teorema 2.1 Ogni soluzione us (·) di classe C 2 (Ωe ) ∩ C 1 (Ω̄e ) dell’equazione

∆2 us (r) + k2 us (r) = 0,

in Ωe

che soddisfi la condizione di radiazione di Sommerfeld (2.15) è tale che

¶

ˆ µ

∂Φ(r, s)

∂us (s)

us (r) =

us (s)

− Φ(r, s)

d`(s)

∂ n̂(s)

∂ n̂

∂Ω

(2.20)

(2.21)

La dimostrazione utilizza l’ipotesi essenziale che ∂Ω sia una curva liscia del piano di

classe C 2 . Nel caso di profili più irregolari3 la validità della rappresentazione integrale

(2.21) non è più generalmente garantita. Anzi non esistono, al meglio delle nostre

conoscenze, nello spettro della letteratura elettromagnetica dedicata all’argomento,

risultati relativi al caso, del resto assai comune nelle applicazioni, in cui il profilo

superficiale degli scatteratori presenti delle singolarità.

D’altronde, la questione non è affatto irrilevante, se si considera che il teorema

(2.1) costituisce il fondamento di un’ampia varietà di tecniche, analitiche e numeriche,

impiegate per attaccare sia il problema diretto che il problema inverso. Che abbisognerebbero, evidentemente, di una validazione teorica per acquistare dignità scientifica,

nonostante la comunità continui a utilizzarle con una certa disinvoltura, secondo una

prassi quasi del tutto arbitraria e pressoché priva di qualsiasi fondamento. Un tentativo del dottorando in questa direzione è stato di indagare la possibilità di generalizzare

3:

ad es., in presenza di uno o più punti angolosi sulla frontiera di Ω.