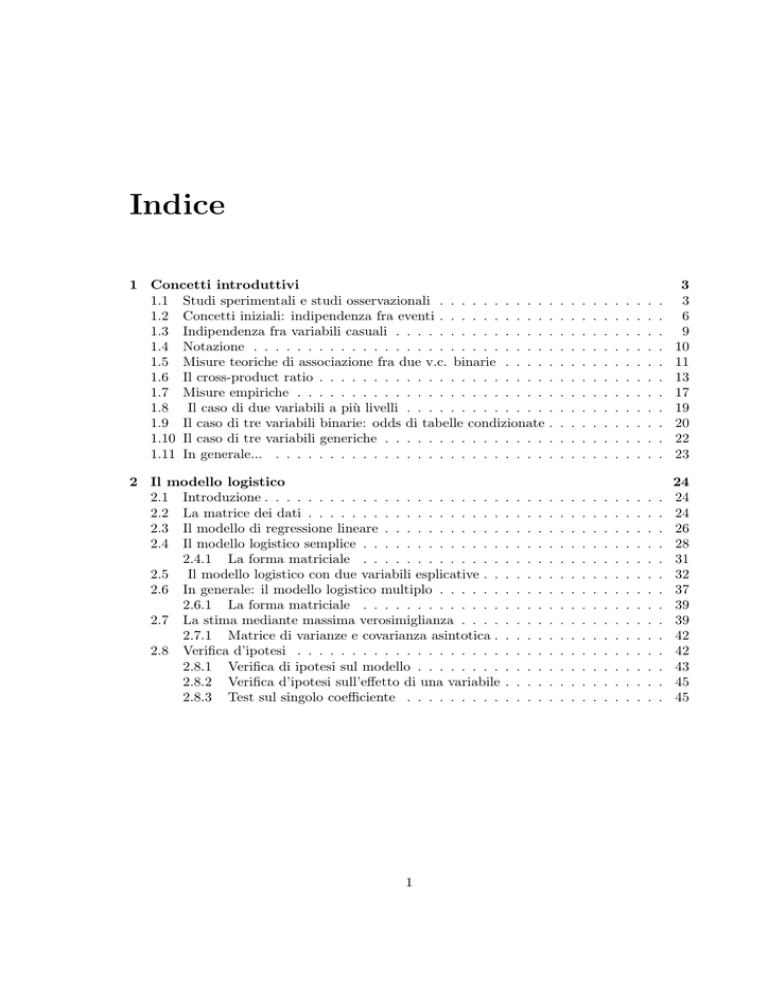

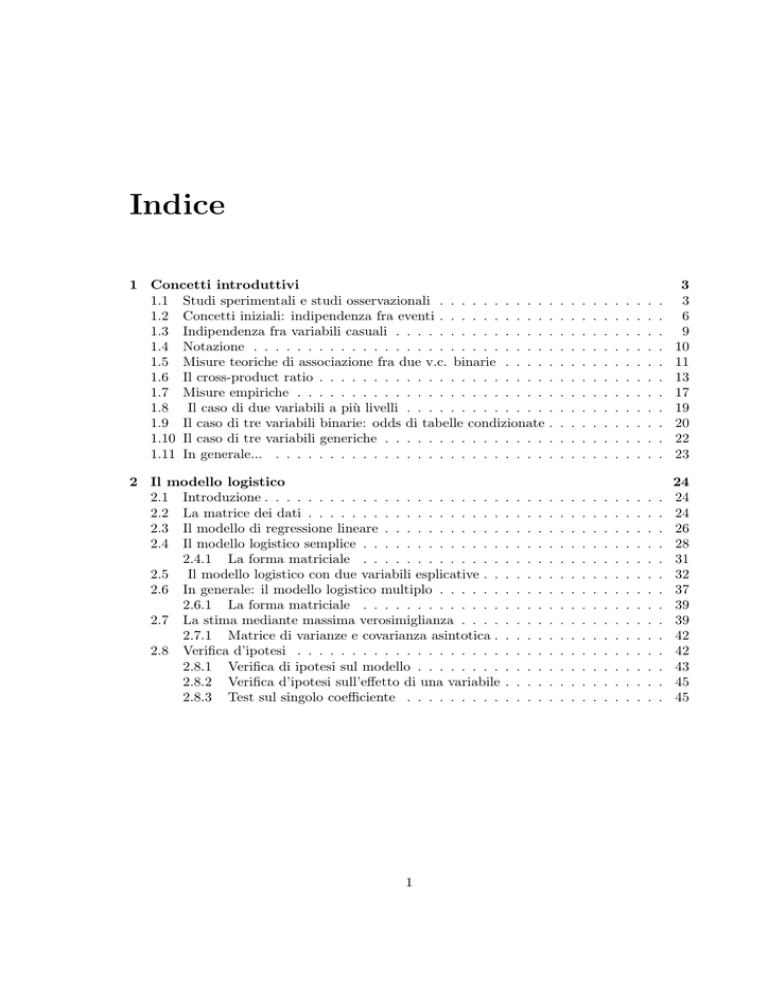

Indice

1 Concetti introduttivi

1.1 Studi sperimentali e studi osservazionali . . . . . . . . . .

1.2 Concetti iniziali: indipendenza fra eventi . . . . . . . . . .

1.3 Indipendenza fra variabili casuali . . . . . . . . . . . . . .

1.4 Notazione . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.5 Misure teoriche di associazione fra due v.c. binarie . . . .

1.6 Il cross-product ratio . . . . . . . . . . . . . . . . . . . . .

1.7 Misure empiriche . . . . . . . . . . . . . . . . . . . . . . .

1.8 Il caso di due variabili a più livelli . . . . . . . . . . . . .

1.9 Il caso di tre variabili binarie: odds di tabelle condizionate

1.10 Il caso di tre variabili generiche . . . . . . . . . . . . . . .

1.11 In generale... . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

6

9

10

11

13

17

19

20

22

23

2 Il modello logistico

2.1 Introduzione . . . . . . . . . . . . . . . . . . . . . .

2.2 La matrice dei dati . . . . . . . . . . . . . . . . . .

2.3 Il modello di regressione lineare . . . . . . . . . . .

2.4 Il modello logistico semplice . . . . . . . . . . . . .

2.4.1 La forma matriciale . . . . . . . . . . . . .

2.5 Il modello logistico con due variabili esplicative . .

2.6 In generale: il modello logistico multiplo . . . . . .

2.6.1 La forma matriciale . . . . . . . . . . . . .

2.7 La stima mediante massima verosimiglianza . . . .

2.7.1 Matrice di varianze e covarianza asintotica .

2.8 Verifica d’ipotesi . . . . . . . . . . . . . . . . . . .

2.8.1 Verifica di ipotesi sul modello . . . . . . . .

2.8.2 Verifica d’ipotesi sull’effetto di una variabile

2.8.3 Test sul singolo coefficiente . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

24

24

24

26

28

31

32

37

39

39

42

42

43

45

45

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Capitolo 1

Concetti introduttivi

1.1

Studi sperimentali e studi osservazionali

Gli studi statistici si possono suddividere in due grandi gruppi: gli studi

sperimentali e quelli osservazionali.

Nei primi, l’analista controlla alcuni dei fattori che ritiene rilevanti,

attraverso ad esempio dosaggi successivi, e può minimizzare gli errori

su quelli che non può controllare, attraverso ad esempio assegnazione

randomizzata dei dosaggi alle unità.

Nei secondi, invece, lo sperimentatore si limita ad osservare i fenomeni

cosı̀ come si manifestano.

Il seguente esempio tratta di un esperimento sulla resistenza alla tossicità delle tarme del tabacco. Gruppi di 20 maschi e 20 femmine di tarma

sono stati esposti per tre giorni ad un tossico a cui le tarme hanno cominciato a mostrare resistenza. La seguente tabella riporta quanti di essi

sono morti.

Esempio 1.1

Dose

Sesso

1 2 4 8 16 32

Maschio 1 4 9 13 18 20

Femmina 0 2 6 10 12 16

L’obbiettivo di questo studio è quantificare gli effetti del tossico, e

verificare se questi effetti sono diversi a seconda del sesso.

2

E.Stanghellini – Dispense di Statistica IV

3

Negli studi puramente osservazionali, non si può controllare nessuna

delle variabili in studio.

La seguente tabella di contingenza è relativa a 661 bambini nati in

Scozia dal 1981 al 1988 e seguiti per almeno un anno dalla nascita. La

variabile Problemi cardiaci vale Sı̀ se la madre ha avuto problemi di

cuore durante la gravidanza. La variabile Complicazioni vale Sı̀ se la

madre ha avuto altri problemi ginecologici, la variabile Fumo vale Sı̀ se

la madre ha fumato almeno una sigaretta al giorno nei primi sei mesi

di gravidanza.

Esempio 1.2

Problemi Cardiaci

Si

No

Complicazioni

Si

No

Si

No

Peso \ Fumo

Si No Si No Si No Si No

≤ 1250 gr.

10 25 12 15 18 12 42 45

> 1250 gr.

7 5 22 19 10 12 202 205

Vi sono vari aspetti che non possono essere tenuti sotto controllo. Ad

esempio è possibile che la popolazione di coloro che fumano sia diversa anche per altre caratteristiche rilevanti da quella di coloro che non

fumano.

In tal caso, l’effetto del fumo viene mascherato da questi ulteriori fattori

non misurati.

4

E.Stanghellini – Dispense di Statistica IV

La distinzione fra i due tipi di studio tuttavia può non essere netta.

Il seguente esempio tratta di uno studio a carattere sperimentale ma

con componenti di natura osservazionale.

Si vuole studiare la relazione fra lo screening con la mammografia e

il cancro al seno. Il seguente studio è relativo a 62.000 donne di cui

31.000 assegnate a caso allo screening e 31.000 controlli. Queste sono

state seguite per 5 anni, registrando le morti per cancro o per altre

cause. Solo una parte di coloro assegnate allo screening accetta di farlo

(vi sono 10.800 rifiuti).

Esempio 1.3

Dimensioni gruppo

Trattamento

Screening

Rifiuti

Totali

Controlli

20.200

10.800

31.000

31.000

Cancro

Altre cause

Num. Tasso Num. Tasso

23

1.1

428

21

16

1.5

409

38

39

1.3

837

27

63

2.0

879

28

Quali tassi debbono essere presi in considerazione?

Se i rifiuti fossero stati casuali, il tasso di mortalità per cancro dei rifiuti

(1.5) dovrebbe essere simile a quello dei controlli (2.0). Invece è molto

inferiore.

Questo fa ritenere che la popolazione dei rifiuti (e di conseguenza dei

non rifiuti, ovvero degli screening) sia ”diversa” per caratteristiche non

misurate (istruzione, tipo di lavoro ecc. ) da quella degli screening.

A conferma di questo, il tasso di mortalità per altre cause è molto di

verso nel gruppo dei rifiuti (e nel gruppo dei controlli, questa volta

molto superiore).

Un’analisi statistica ben fatta deve tenere conto di questi effetti.

E.Stanghellini – Dispense di Statistica IV

1.2

5

Concetti iniziali: indipendenza fra eventi

Sia P la probabilità definita sullo spazio degli eventi associato ad un

esperimento casuale e siano A, B,C, . . ., eventi definiti in quello spazio.

Si indichi con Ā,B̄, . . . l’evento che si verifica se, in ordine, A, B non

si verifica. La probabilità condizionata di A dato B è P (A | B) =

P (A ∩ B)/P (B) ed è definita solo se P (B) > 0.

Definizione.

indipendenti se:

Indipendenza fra eventi.

Due eventi A e B sono

→ P (A ∩ B) = P (A)P (B).

Una definizione alternativa di eventi indipendenti è la seguente:

→ P (A | B) = P (A).

Nel seguito, due eventi A e B indipendenti verrano denotati con

A⊥⊥B. Si noti che se A⊥⊥B allora A⊥⊥B̄. Di conseguenza, la definizione

di indipendenza fra due eventi si estende anche alla negazione degli

eventi su cui è definita, come si dimostra dal seguente esercizio.

ESERCIZIO 1.1 Si verifichi che se A e B sono due eventi indipendenti allora anche A e B̄ sono due eventi indipendenti.

6

E.Stanghellini – Dispense di Statistica IV

Definizione. Indipendenza condizionata fra eventi.

Siano A, B e C tre eventi con P (C) > 0. A e B sono indipendenti

condizionatamente a C se e solo se:

→ P (A ∩ B|C) = P (A|C)P (B|C).

→ P (A|BC) = P (A|C)

Nel seguito due eventi A e B indipendenti condizionatamente a C sono

denotati con A⊥⊥B | C. Questa definizione è una riscrittura della

indipendenza fra eventi con le probabilità condizionate al posto delle

probabilità marginali. Di conseguenza, se A⊥⊥B | C allora A⊥⊥B̄ | C.

Tuttavia, A⊥⊥B | C non implica nè è implicato da A⊥⊥B | C̄. Il

seguente esempio dà un’idea di un fenomeno chepuò generare una tale

situazione. L’esempio è tratto dal credit scoring.

Esempio 1.4 Sia A l’evento {il cliente è solvibilie} B l’evento {il cliente

ha almeno un figlio} e C l’evento {il cliente ha un’età inferiore a 45 anni}. E’ plausibile che per clienti con età superiore a 45 anni, l’essere

solvibili sia indipendente dall’avere figli o meno, mentre tale indipendenza non valga in clienti con età inferiore a 45 anni.

E.Stanghellini – Dispense di Statistica IV

7

Si noti, inoltre, che l’indipendenza fra A e C condizionatamente a

B non implica l’indipendenza marginale fra A e C. Questo fatto ha

una spiegazione intuitiva nel caso in cui, ad esempio, C sia una causa

comune di A e B, oppure B sia un evento che influenza C che a sua

volta influenza A, come nel seguente esempio.

Esempio 1.5 Sia A l’evento {il cliente è solvibile} C l’evento {il cliente

ha una fascia di reddito elevata} e B l’evento il cliente {il cliente è libero

professionista}. Si supponga che un libero professionista ha una probabilità più elevata di posizionarsi su fasce alte di reddito di chi non lo è e,

di conseguenza, di essere un buon cliente. Trascurando l’informazione

sul reddito, si può concludere che i liberi professionisti sono migliori

clienti degli altri. Tuttavia, il fattore determinante della solvibilità è il

reddito.

8

E.Stanghellini – Dispense di Statistica IV

1.3

Indipendenza fra variabili casuali

Come si estende il concetto di indipendenza fra due eventi a quello di

indipendenza fra due variabili casuali?

Siano X1 , X2 , due variabili casuali qualsiasi. Nel seguito, indicheremo

genericamente con f12 (x1 , x2 ) la funzione di densità o di massa di probabilità congiunta. Inoltre, indicheremo con, ad esempio, f12|3 (x1 , x2 | x3 )

la funzione di densità o di massa di probabilità di X1 e X2 condizionata

a X3 (definita solo se f3 (x3 ) > 0).

Nel caso in cui sia specificato dal contesto che le variabili casuali sono

categoriche, allora indicheremo con p12 (x1 , x2 ) la funzione di massa di

probabilità congiunta e con, ad esempio, p12|3 (x1 , x2 | x3 ) la funzione di

massa di probabilità di X1 e X2 condizionata a X3 .

Definizione Indipendenza marginale fra variabili casuali. Due variabili casuali X1 e X2 sono indipendenti se e solo se:

→ f12 (x1 , x2 ) = f1 (x1 )f2 (x2 ) per ogni x1 e x2 .

Una definizione equivalente è la seguente:

→ f1|2 (x1 | x2 ) = f1 (x1 ) per ogni x1 e x2 t.c. f2 (x2 ) > 0

Nel seguito due v.c. indipendenti saranno indicate con X1 ⊥⊥X2 .

E.Stanghellini – Dispense di Statistica IV

9

Definizione Indipendenza condizionale fra variabili casuali. Due

variabili casuali X1 e X2 sono indipendenti condizionatamente a X3 se

e solo se:

→ f12|3 (x1 , x2 | x3 ) = f1|3 (x1 | x3 )f2|3 (x2 | x3 ) per ogni x1 , x2 e per

ogni x3 t.c. f3 (x3 ) > 0.

Equivalenti formulazioni della definizione di indipendenza condizionata

sono le seguenti:

→ f123 (x1 , x2 , x3 ) = f13 (x1 , x3 )f23 (x2 x3 )/f (x3 )

→ f1|23 (x1 , x2 | x3 ) = f1|3 (x1 | x3 )

1.4

Notazione

Siano X1 e X2 due variabili casuale categoriche con livelli I1 e I2 . La loro

distribuzione congiunta può essere sintetizzata attraverso una tabella di

contingenza rettangolare che ha I1 righe e I2 colonne. In questo corso

utilizzeremo la convezione di numerare i livelli delle variabili categoriche

a partire da 0. Ad esempio, se I1 = 2 e I2 = 3 la tabella di contingenza

è la seguente:

X2

Totale

X1

0

1

2

0

p12 (0, 0) p12 (0, 1) p12 (0, 2) p1 (0)

1

p12 (1, 0) p12 (1, 1) p12 (1, 2) p1 (1)

Totale p2 (0)

p2 (1)

p2 (2)

1

in cui, come detto, p12 (0, 0) sta ad indicare P (X1 = 0, X2 = 0), p12 (0, 1)

sta ad indicare P (X1 = 0, X2 = 1) e cosı̀ via. Inoltre, p1 (0) sta ad

indicare P (X1 = 0).

10

1.5

E.Stanghellini – Dispense di Statistica IV

Misure teoriche di associazione fra due v.c. binarie

Sia X1 una variabile casuale binaria con valori {0, 1} e p1 (0) = P (X1 =

0) e p1 (1) = P (X1 = 1). Si definisce odds di X1 il seguente rapporto:

odds(X1 ) =

p1 (1)

p1 (0)

Non è difficile verificare che esso assume valori fra 0 e +∞. Inoltre,

cresce al crescere della p1 (0) e assume valore 1 se gli eventi sono equiprobabili.

In seguito lavoreremo anche sul logaritmo naturale dell’odds, il logit,

che è una trasformazione monotona dell’odds e varia fra −∞ e +∞.

Inoltre, assume inoltre valore 0 se i due eventi sono equiprobabili.

Importante Se l’odds è maggiore di 1, vuole dire che l’evento al numeratore ha probabilità maggiore di 0.5 di verificarsi. Se l’odds è minore

di 1 vuol dire che l’evento al numeratore ha probabilità minore di 0.5

di verificarsi.

E.Stanghellini – Dispense di Statistica IV

11

Siano X1 e X2 due variabili casuali binarie. La distribuzione congiunta

può essere rappresentata dalla seguente tabella:

X2

X1

0

1

0

p12 (0, 0) p12 (0, 1)

1

p12 (1, 0) p12 (1, 1)

Totale p2 (0)

p2 (1)

Totale

p1 (0)

p1 (1)

1

Si definisca adesso l’odds di X1 condizionato a X2 = 0. Ovvero,

odds(X1 | X2 = 0) =

p1|2 (1 | 0)

p1|2 (0 | 0)

Moltiplicando numeratore e denominatore per p2 (0) si può verificare

che:

odds(X1 | X2 = 0) =

p12 (1, 0)

.

p12 (0, 0)

In maniera analoga se definisca adesso l’odds di X1 condizionato a X2 =

1:

odds(X1 | X2 = 1) =

p12 (1, 1)

p12 (0, 1)

12

E.Stanghellini – Dispense di Statistica IV

1.6

Il cross-product ratio

Un confronto interessante è fra i due odds condizionati. Se sono uguali

l’odds di X1 non varia al variare di X2 . Inoltre, se sono uguali, allora

anche gli odds di X2 condizionati a X1 sono uguali. Infatti, se

p12 (1, 0) p12 (1, 1)

=

p12 (0, 0) p12 (0, 1)

allora:

p12 (0, 1)p12 (1, 0) = p12 (0, 0)p12 (1, 1)

da cui

p12 (0, 1)

p12 (1, 1)

=

p1 2(0, 0) p12 (1, 0)

ovvero odds(X2 | X1 = 0) = odds(X2 | X1 = 1). Definiamo il rapporto

degli odds, noto come odds ratio o rapporto dei prodotti incrociati che

indicheremo talvolta anche con cpr dall’inglese cross product ratio:

cpr(X1 , X2 ) =

odds(X1 | X2 = 1) p12 (1, 1)p12 (0, 0)

=

odds(X1 | X2 = 0) p12 (0, 1)p12 (1, 0)

Invertiamo ora il ruolo delle variabili X1 e X2 . Come avviamo visto:

odds(X1 |midX2 = x2 ) =

p12 (1, x2)

.

p12 (0, x2)

Ne segue che se i due odds condizionati sono uguali, allora

p12 (1, 0) p12 (1, 1)

=

,

p12 (0, 0) p12 (0, 1)

e il loro rapporto è pari ad 1. Ma quanto il loro rapporto??? Esso

è esattamente il cpr(X1 , X2 ) scritto sopra.

Da quanto detto, il cpr è una misura non direzionale di associazione.

Essa è anche detta di interazione fra due variabili.

E.Stanghellini – Dispense di Statistica IV

13

Importante Se il cpr è maggiore di 1 vuol dire che l’odds di X1 condizionatamente a X2 = 1 è maggiore dell’odds di X1 condizionatamente

a X2 = 0. Dal momento che X1 e X2 si possono scambiare di ruolo,

allora se il cpr è maggiore di 1 vuol dire che l’odds di X2 condizionatamente a X1 = 1 è maggiore dell’odds di X2 condizionatamente a X1 = 0.

Questo si sintetizza con il dire che vi è una associazione positiva fra le

due variabili casuali binarie.

14

E.Stanghellini – Dispense di Statistica IV

Esempio 1.6 Consideriamo la seguente distribuzione ipotetica di probabilità.

X2

X1

0

1

0

0.05 0.15

1

0.20 0.60

Totale 0.25 0.75

Totale

0.2

0.8

1

Il rapporto degli odds è pari a:

0.05 × 0.6

=1

0.15 × 0.2

Di conseguenza, la probabilità condizionata che X1 sia uguale ad uno

non varia al variare di X2 . Analogamente, la probabilità condizionata

che X2 sia uguale a 1 non varia al variare di X1 . Si può dimostrare,

infatti, che X1 e X2 sono indipendenti.

Teorema 1.1 Siano X1 e X2 due variabili casuali binarie. Se odds(X1 |

X2 = x2 ) = a, x2 = {0, 1}, allora odds(X1 ) = a.

Dimostrazione. Essendo odds(X1 | X2 = 0) = odds(X1 | X2 = 1) = a

allora

p12 (1, 0) = ap12 (0, 0)

p12 (1, 1) = ap12 (0, 1)

Sommando termine a termine le due uguaglianze si ottiene

p1 (1) = ap1 (0)

e il risultato segue.

(1.1)

E.Stanghellini – Dispense di Statistica IV

15

Teorema 1.2 Siano X1 e X2 due variabili casuali binarie. Allora,

cpr(X1 , X2 ) = 1 se e solo se X1 e X2 sono indipendenti.

Dimostrazione. Se sono indipendenti p12 (x1 , x2 ) = p1 (x1 )p2 (x2 ) per

ogni valore di x1 e x2 . Per cui:

cpr =

p12 (0, 0)p12 (1, 1) p1 (0)p2 (0)p1 (1)p2 (1)

=

=1

p12 (0, 1)p12 (1, 0) p1 (0)p2 (1)p1 (1)p2 (0)

Viceversa, se cpr(X1 , X2 ) = 1 allora p(x1 | X2 = 0) = p(x1 | X2 = 1)

per ogni x1 . Infatti:

1 − p(x1 | X2 = 0) 1 − p(x1 | X2 = 1)

=

p(x1 | X2 = 0)

p(x1 | X2 = 1)

da cui

1

1

=

p(x1 | X2 = 0) p(x1 | X2 = 1)

Pertanto:

p(x1 ) =

X

p(x1 | x2 )p(x2 ) = p(x1 | x2 )

x2

per ogni valore di x1 e x2 .

X

x2

p(x2 ) = p(x1 | x2 )

16

1.7

E.Stanghellini – Dispense di Statistica IV

Misure empiriche

Il rapporto degli odds è definito su probabilità . Tuttavia, esso può

essere usato come misura descrittiva della associazione fra due variabili, quando si dispone di un campione di osservazioni. Si consideri la

seguente tabella a doppia entrata, con due righe e tre colonne:

X2

Totale

X1

0

1

2

0

n12 (0, 0) n12 (0, 1) n12 (0, 2) n1 (0)

1

n12 (1, 0) n12 (1, 1) n12 (1, 2) n1 (1)

Totale n2 (0)

n2 (1)

n2 (2)

n

Si ricordi che il rapporto n12 (0, 0)/n1 (0) indica la frequenza relativa delle

unità che hanno X1 = 0 nel gruppo di unità che hanno X2 = 0. Invece,

il rapporto n12 (0, 0)/n2 (0) indica la frequenza relativa delle unità che

hanno X2 = 0 nel gruppo di unità che hanno X1 = 0.

Domanda: Che interpretazione ha la frequenza relativa n12 (0, 2)/n1 (0)?

E la frequenza relativa n12 (0, 2)/n2 (0)?

Il rapporto dei prodotti incrociati si calcola su una tabella di contingenza di dimensioni due per due, come la seguente:

X2

Totale

X1

0

1

0

n12 (0, 0) n12 (0, 1)

1

n12 (1, 0) n12 (1, 1)

Totale n2 (0)

n2 (1)

n1 (0)

n1 (1)

n

Con un ragionamento analogo al precedente possiamo vedere il rapporto

dei prodotti incrociati come un rapporto di frequenze relative, di riga o

di colonna. Tuttavia, data la sua struttura, esso si può calcolare anche

sulle frequenze assolute. Ovvero:

cpr =

n12 (0, 0)n12 (0, 1)

n12 (0, 1)n12 (1, 0)

E.Stanghellini – Dispense di Statistica IV

17

Esempio 1.7 (segue da 1.2) Si calcoli il cpr della tabella a doppia

entrata secondo Problemi cardiaci e Peso. Essa sarà :

Problemi

Peso

No

≤ 1250 gr. 117

> 1250 gr. 429

Totale

546

cardiaci Totale

Sı̀

62

179

53

482

115

661

Il rapporto degli odds in questa tabella, ottenuta come marginale rispetto

alla precedente è pari a:

53 ∗ 117

= 0.233

62 ∗ 429

che denota una elevata associazione fra le due variabili. Come la possiamo interpretare? L’odds osservato che un bambino nasca con un peso

superiore a 1250 gr. dato che la madre ha problemi cardiaci è pari a 0.85

(ovvero 53/62). Questo vuol dire che la frequenza relativa dei nati sottopeso in questo sottogruppo è maggiore della frequenza relativa dei nati

normali. L’odds che un bambino nasca con un peso superiore a 1250

gr. dato che la madre non ha problemi cardiaci è pari a 3.67 (ovvero

429/117). Pertanto il primo odds è 0.233 volte inferiore al secondo.

Questo valore è il rapporto degli odds.

Si noti che la interpretazione direzionale della associazione nell’esempio precedente deriva dalle nostre informazioni a priori sui fenomeni in

studio, secondo cui il fatto che la madre abbia problemi cardiaci è una

variabile potenzialmente esplicativa del peso alla nascita del figlio e non

il viceversa. Vi sono studi che hanno come scopo fare inferenza anche

sulla direzione della associazione. Noi però faremo riferimento solo a

situazioni in cui tal direzione è implicita nel fenomeno di studio.

18

1.8

E.Stanghellini – Dispense di Statistica IV

Il caso di due variabili a più livelli

In questa sezione si estendono le misure di associazione viste in precedenza alla situazione in cui X1 è binaria e e X2 e assume un numero

generico k di livelli.

Siano X1 e X2 due variabili casuali categoriche, con X1 binaria e X2

che assume I2 > 2 valori. Ad esempio, se I2 = 3 la distribuzione doppia

può essere sintetizzata attraverso la seguente tabella a doppia entrata:

X2

Totale

X1

0

1

2

0

p12 (0, 0) p12 (0, 1) p12 (0, 2) p1 (0)

p12 (1, 0) p12 (1, 1) p12 (1, 2) p1 (1)

1

Totale p2 (0)

p2 (1)

p2 (2)

1

Un modo naturale di procedere è quello di scegliere un livello di X2

come riferimento e confrontare gli odds condizionati degli altri livelli

con il livello di riferimento. La convenzione adottata in questo lavoro

è che il livello di riferimento è il livello 0. Questo implica il calcolo di

un odds condizionato e di I2 − 1 oddsratio nelle corrispondenti I2 − 1

sottotabelle 2 × 2 cosı̀ evidenziate:

X2

X1

0

r

0 p12 (0, 0) p12 (0, r)

1 p12 (1, 0) p12 (1, r)

E’ possibile mostrare, in estensione del teorema 1.2, il seguente:

Teorema 1.3 Sia X1 una v.c. binaria e X2 una v.c. categorica con I2

livelli. Se tutti gli I2 − 1 odds ratio sono uguali ad 1, le due variabili

sono indipendenti, e viceversa.

E.Stanghellini – Dispense di Statistica IV

1.9

19

Il caso di tre variabili binarie: odds di tabelle condizionate

Siano X1 , X2 e X3 tre variabili casuali binarie. La distribuzione congiunta può essere sintetizzata attraverso una tabella di contingenza a

tre entrate, come quella seguente:

X2

Totale

X3 = 0

X1

0

1

0

p123 (0, 0, 0) p123 (0, 1, 0) p13 (0, 0)

1

p123 (1, 0, 0) p123 (1, 1, 0) p13 (1, 0)

Totale

p23 (0, 3)

p23 (10)

p3 (0)

X3 =1

X2

Totale

X1

0

1

0

p123 (0, 0, 1) p123 (0, 1, 1) p13 (0, 1)

1

p123 (1, 0, 1) p123 (1, 1, 1) p13 (1, 1)

Totale p23 (0, 1)

p23 (1, 1)

p3 (1)

Si può calcolare per la tabella condizionata, ad esempio ad X3 = 0,

il cross product ratio fra X1 e X2 . Esso sarà cpr(X1 , X2 | X3 = 0).

Analogamente, si può calcolare il cross product ratio fra X1 e X2 per

la tabella con X3 = 1. Esso sarà cpr(X1 , X2 | X3 = 1). In generale, si

indichi con cpr(X1 , X2 | X3 = x3 ) il generico cpr. Esso è cosı̀ dato:

cpr(X1 , X2 | X3 = x3 ) =

p12|3 (1, 1 | x3 )p12|3 (0, 0 | x3 )

p12|3 (0, 1 | x3 )p12|3 (1, 0 | x3 )

ma anche

cpr(X1 , X2 | X3 = x3 ) =

p123 (1, 1, x3 )p123 (0, 0, x3 )

p123 (0, 1, x3 )p123 (1, 0, x3 )

20

E.Stanghellini – Dispense di Statistica IV

Di conseguenza, una naturale estensione della misura di associazione fra

due variabili binarie al caso di tre variabili binarie è il seguente rapporto

di cpr:

cpr(X1 , X2 | X3 = 1) p123 (1, 1, 1)p123 (0, 0, 1)p123 (0, 1, 0)p123 (1, 0, 0)

=

cpr(X1 , X2 | X3 = 0) p123 (0, 1, 1)p123 (1, 0, 1)p123 (1, 1, 0)p123 (0, 0, 0)

Esso è uguale ad 1 se l’odds ratio fra X1 e X2 nella tabella condizionata

di X3 = 0 è uguale all’odds ratio fra X1 e X2 nella tabella condizionata

di X3 = 1. Dalla formulazione precedente, è possibile verificare che:

cpr(X1 , X2 | X3 = 1) cpr(X1 , X3 | X2 = 1) cpr(X2 , X3 | X1 = 1)

=

=

cpr(X1 , X2 | X3 = 0) cpr(X1 , X3 | X2 = 0) cpr(X2 , X3 | X1 = 0)

ovvero anche questa misura è una misura di associazione che considera le

tre variabili sullo stesso piano. Per questo, è detta misura di interazione

del terzo ordine. Si noti che se rapporto odds ratio è pari ad uno, questo

implica che l’interazione fra due delle tre variabili non variabili non varia

al variare della terza.

Si può verificare agevolmente che se cpr(X1 , X2 | X3 = 0) = 1 =

cpr(X1 , X2 | X3 = 1) e allora X1 ⊥⊥X2 | X3 e viceversa.

E.Stanghellini – Dispense di Statistica IV

21

Esempio 1.8 (segue da 1.2). Si calcoli il rapporto degli odds fra Complicazione cardiache e Peso nelle due sottotabelle individuate dai livelli

di Complicazioni.

Complicazioni =No

Problemi cardiaci Totale

Peso

No

Sı̀

≤ 1250 gr.

87

27

114

407

41

448

> 1250 gr.

Totale

494

68

562

Complicazioni =Sı̀

Problemi cardiaci Totale

Peso

No

Sı̀

≤ 1250 gr.

30

35

65

> 1250 gr.

22

12

34

Totale

52

47

99

Il rapporto degli odds nella prima tabella è pari a 0.32, denotando

una maggiore frequenza di nati sottopeso nella popolazione delle madri

con problemi cardiaci anche nel sottogruppo di madri che non hanno

avuto complicazioni. Il rapporto degli odds nella seconda tabella è pari

a 0.47, denotando anche qui una maggiore frequenza di nati sottopeso

da madri con problemi cardiaci anche nel caso di madri che hanno avuto

complicazioni.

Ci possiamo adesso chiedere se vi è una differenza significativa fra i

due valori (0.32 e 0.47). Se non vi è vuol dire che l’effetto dell’avere

problemi cardiaci non varia al variare del quadro delle altre complicazioni. Altrimenti, se vi è , vuol dire che l’effetto varia a seconda del

quadro delle complicazioni. In questo secondo caso si dice che vi è una

interazione.

1.10

Il caso di tre variabili generiche

Siano X1 , X2 , X3 variabili casuali categoriche, con X1 binaria X2 e X3

categoriche con livelli, rispettivamente, I2 > 2 e I3 > 2. In questo caso

si sceglie un livello di riferimento per X3 , per convenzione indicato con

0 (si veda la tabella successiva si è posto I2 = 3).

22

E.Stanghellini – Dispense di Statistica IV

X3 = 0

X2

Totale

X1

0

1

2

0

p123 (0, 0, 0) p123 (0, 1, 0) p123 (0, 2, 0) p13 (0, 0)

1

p123 (1, 0, 0) p123 (1, 1, 0) p123 (1, 2, 0) p13 (1, 0)

Totale

p23 (0, 0)

p23 (1, 0)

p23 (2, 0)

p3 (0)

In questo livello di riferimento si calcola l’odds di X1 condizionato al

livello di riferimento di X2 , ovvero l’odds(X1 | X2 = 0X3 = 0). Inoltre,

si calcolano gli I2 − 1 odds ratio nel modo visto in precedenza. Successivamente si raffrontano queste grandezze, mediante rapporto, con le

analoghe grandezze valutate negli I3 − 1 livelli della terza variabile. I

raffronti non ridondanti da effettuare saranno pertanto (I2 − 1)(I3 − 1).

1.11

In generale...

Nel caso in cui vi siano più di tre variabili causali, la costruzione delle

misure di associazione segue le linee adesso delineate. Nel caso ad

esempio di p = 4 con X1 binaria, i raffronti non ridondanti saranno (I2 − 1)(I3 − 1)(I4 − 1). Relazioni di indipendenza condizionata e

marginale fra variabili potranno essere delineate qualora ad esempio si

trovino determinate configurazioni di sottoinsiemi odds ratio pari ad

uno.

Tuttavia in questo corso lavoreremo sempre con modelli con una risposta binaria. Non considereremo mai il caso di più di tre variabili esplicative.

SOLUZIONE ES. 1.1. Se A e B sono indipendenti, allora P (A∩B) =

P (A)P (B). Essendo A = (A ∩ B̄) ∪ (A ∩ B) con A ∩ B̄ e A ∩ B

incompatibili, avremo P (A) = P (A ∩ B̄) + P (A ∩ B) = P (A ∩ B̄) +

P (A)P (B). Pertanto, P (A ∩ B̄) = P (A)[1 − P (B)] e il risultato segue.

ESERCIZIO 1.2 Siano X1 e X2 due variabili casuali binarie. Si dica

come cambia il cpr(X1 , X2 ) se invertiamo le categorie di X1 .

ESERCIZIO 1.3 Siano X1 e X2 due variabili casuali con X1 binaria

e X2 categorica con più di due livelli. Se gli odds(X1 | X2 = i) sono

uguali fra loro e uguali ad a, quanto vale il odds(X1 ) della marginale di

X1 ?

Capitolo 2

Il modello logistico

2.1

Introduzione

In questo capitolo studieremo modelli in cui una variabile casuale è

considerata dipendente, o di risposta, da altre variabili casuali, dette

esplicative. Utilizzeremo la convenzione di indicare con Y la v.c. dipendente e con X1 , . . . , Xk le variabili esplicative. Le distribuzioni di interesse per la variabile casuale di risposta Y nei modelli che considereremo

sono tipicamente la distribuzione di Bernoulli, la distribuzione binomiale relativa e, per raffronti con il modello di regressione lineare, la

distribuzione normale o di Gauss.

2.2

La matrice dei dati

Si consideri la seguente rappresentazione dei dati dell’esempio 1.1.

23

24

E.Stanghellini – Dispense di Statistica IV

Sesso. Dose Successi Num. totale

0

1

1

20

0

2

4

20

0

4

9

20

13

20

0

8

0

16

18

20

0

32

20

20

0

20

1

1

1

2

2

20

6

20

1

4

1

8

10

20

12

20

1

16

1

32

16

20

Questo secondo modo di rappresentare i dati ci avvicina alla logica

del modello logistico. Infatti, possiamo vedere ogni riga della tabella

precedente formata da configurazioni diverse delle esplicative. Sia X1

la v.c. che descrive il sesso e X2 la v.c. che descrive il dosaggio. Ogni

riga è una configurazione diversa (x1 , x2 ). Inoltre, in ogni riga si sono

effettuate tante ripetizioni di un esperimento di Bernoulliano (in questo

caso il num. delle ripetizioni è costante e pari a 20) e si sono contati i

successi.

L’obiettivo dello studio è vedere come cambia la probabilità di successo

in ogni riga della tabella precedente. Sia Y la v.c. di Bernoulli. Si vuole

mettere in relazione la P (Y = 1 | X1 = x1 , X2 = x2 ) con x1 e x2 .

In modo del tutto analogo, possiamo vedere le righe della tabella precedente come un unico esperimento di una binomiale relativa. Il valore

atteso della binomiale relativa è ancora P (Y = 1 | X1 = x1 , X2 = x2 ).

Possiamo rappresentare i dati dell’esempio 1.2 con la stessa logica. Nella seguente rappresentazione si pone come successo la nascita di un

bambino con peso superiore a 1250gr. Inoltre, si pone ’Fumo’=0 se la

madre non ha fumato e 1 altrimenti; ’Complicazioni’ =0 se la madre

non ha avuto complicazioni e 1 altrimenti; ’Problemi cardiaci’=0 se la

madre non ha avuto problemi cardiaci e 1 altrimenti.

E.Stanghellini – Dispense di Statistica IV

25

Fumo Complicazioni Problemi Successi Num. totale

0

0

0

205

250

1

0

0

202

244

0

1

0

12

24

10

28

1

1

0

0

0

1

19

34

1

0

1

22

34

5

30

0

1

1

1

1

1

7

17

2.3

Il modello di regressione lineare

In questo paragrafo si richiamano alcune nozioni della regressione lineare, necessarie alla comprensione del modello logistico. Sia Y una

variabile di risposta continua e X una variabile continua esplicativa. Il

modello di regressione lineare assume che:

Y = a + bx + ε

in cui ε è una variabile casuale continua che esprime l’effetto di fattori

non osservati che concorrono alla formazione del valore di Y in maniera

additiva. Si suppone inoltre E(ε) = 0 e V ar(ε) = σ 2 . La prima ipotesi

implica che il valore atteso della distribuzione di Y condizionato a X =

x è dato da:

E(Y | X = x) = a + bx.

(2.1)

La seconda ipotesi implica che la varianza di ogni distribuzione condizionata è costante. I coefficienti a e b sono detti coefficienti di regressione. In particolare, il coefficiente b esprime la variazione sul valore

atteso dovuta ad un incremento unitario di x. Il modello di regressione

lineare si estende al caso generico di variabili esplicative. Sia adesso x

il vettore di variabili esplicative continue con valori x = (x1 , x2 , . . . , xp ).

Il modello di regressione lineare può estendersi al caso multiplo come:

E(Y | X = x) = a + b1 x1 + . . . + br xr .

26

E.Stanghellini – Dispense di Statistica IV

Sia y il vettore N ×1 delle osservazioni della variabile casuale risposta

Y e X la matrice N ×p delle variabili esplicative comprensiva dell’intercetta, come descritta in precedenza. Indicando con b = (a, b1 , b2 , . . . , bp )T

il vettore dei parametri, le stime mediante metodo dei minimi quadrati

di b possono derivarsi come quel vettore b̂ che minimizza la somma dei

quadrati:

(y − Xb)T (y − Xb).

Ponendo ŷ = Xb̂, si verifica agevolmente che la stima b̂ soddisfa

simultaneamente le equazioni:

XT y = XT ŷ

(2.2)

da cui

b̂ = (XT X)−1 XT y.

Sotto le ipotesi del modello di regressione, le stime mediante metodo dei

minimi quadrati hanno proprietà ottimali. Inoltre, se la distribuzione

della variabile casuale Y condizionata alle esplicative è normale, lo stimatore b̂ coincide con quello ottenuto con il metodo della massima

verosimiglianza.

Nel contesto in studio, la v.c. di risposta è binaria. Se codifichiamo i

valori che essa assume in 0 e 1, la Y ha una distribuzioni di Bernoulli. In

tal caso, volendo mantenere il parallelismo con il modello di regressione

semplice (2.1, sorgono alcuni problemi:

⇒ Il valore atteso condizionato E(Y | X = x) = π(x) = P (Y = 1 |

X = x) è una probabilità, pertanto compresa fra 0 e 1. Se non introduciamo vincoli sui parametri a e b, il modello di regressione lineare non

assicura che il valore atteso sia compreso in questo intervallo, anzi per

valori x sufficientemente grandi, o sufficientemente piccoli, può verificarsi che π(x) < 0 oppure π(x) > 1. Di conseguenza, il modello può

essere valido in un intervallo ristretto di valori della esplicativa x in cui

π(x) è compreso fra 0 e 1. Anche in questo caso, tuttavia, l’ipotesi di

linearità nell’andamento di π(x) può non essere rispettata per valori di

π(x) vicini a 0 e 1. In molti fenomeni, in particolare quelli economici,

infatti, l’incremento di π(x) varia con x e tende a diminuire nei dintorni

dei valori limite.

E.Stanghellini – Dispense di Statistica IV

27

⇒ La varianza condizionata dipende da x, essendo V ar(Y | X =

x) = π(x)[1 − π(x)]. Essa tende a zero nei valori di X in cui π(x) tende

a zero e ad uno. Inoltre è massima nei valori di x in cui π(x) = 0.5.

Questo fatto comporta che le stime del modello di regressione lineare

ottenute mediante il metodo dei minimi quadrati ordinari non hanno

proprietà ottimali. Per tutti questi motivi nell’ambito del credit scoring

il modello di regressione lineare non può essere utilizzato, ed occorre

considerare una classe di modelli diversa.

2.4

Il modello logistico semplice

Sia Y una variabile risposta con distribuzione Bernoulli e X una variabile esplicativa. Si indichi con π(x) = P (Y = 1 | X = x) = 1 − P (Y =

0 | X = x). Pertanto: π(0) = P (Y = 1 | X = 0) e π(1) = P (Y = 1 |

X = 1). Si indichi con logit[π(x)] la grandezza:

P (Y = 1 | X = x)

.

P (Y = 0 | X = x)

Essa è il logaritmo dell’odds di Y condizionato a X e varia fra −∞

e +∞; vale 0 quanto la probabilità condizionata di successo è 0.5. Il

modello logistico semplice è il seguente:

logit[π(x)] = log

logit[π(x)] = log

π(x)

= α + βx.

1 − π(x)

Come si può agevolmente verificare, se β > 0 allora π(x) tende ad 1

al crescere di x. Altrimenti, se β < 0 allora π(x) tende ad 0 al crescere

di x. Se β = 0 allora π(x) è costante rispetto a x, ovvero Y e X sono

indipendenti. Risolvendo rispetto a π(x):

π(x) =

exp(α + βx)

.

1 + exp(α + βx)

Questo modello è detto di regressione logistica, o anche modello logistico. L’interpretazione di α e β varia a seconda della natura di

X.

⇒ (a) Se X è continua possiamo calcolare dπ(x)/dx = βπ(x)(1 −

π(x)) che esprime la velocità con cui la π(x) tende a 0 o ad 1. Si può

28

E.Stanghellini – Dispense di Statistica IV

1

0.9

0.8

0.7

π (x)

0.6

0.5

0.4

0.3

0.2

0.1

0

−20

−15

−10

−5

0

x

5

10

15

20

Figura 2.1: Un esempio di funzione logistica con α = 0.7 e β = 0.5.

osservare che la velocità con cui tende a 0 è la stessa con cui tende a 1.

Inoltre, il punto più ripido della curva è in corrispondenza della x t.c.

π(x) = 0.5. Questo punto è dato da −α/β.

In Figura 2.1 è riportato il grafico di una funzione logistica con α = 0.7

e β = 0.5.

⇒ (b) Supponiamo adesso che X sia binaria. Si codifichino i livello

della X con 0 e 1. Avremo:

π(x)

= α + βx.

1 − π(x)

Questo è in realtà un modo sintetico di scrivere le due equazioni:

logit[π(x)] = log

logit[π(0)] = log

logit[π(1)] = log

π(0)

=α

1 − π(0)

π(1)

= α + β.

1 − π(1)

E.Stanghellini – Dispense di Statistica IV

29

Il parametro α è il logaritmo dell’odds di Y nel livello 0 di X, inoltre β

è il log dell’cpr della tabella 2 × 2 di Y contro X, ovvero cpr(Y, X) = eβ .

Infatti sottraendo la prima equazione dalla seconda, si ottiene:

logit[π(1)] − logit[π(0)] = β.

Infatti, ricordando che

logit[π(1)] = log

P (Y = 1 | X = 1)

P (Y = 1, X = 1)

= log

P (Y = 0 | X = 1)

P (Y = 0, X = 0)

logit[π(0)] = log

P (Y = 1 | X = 0)

P (Y = 1, X = 0)

= log

P (Y = 0 | X = 0)

P (Y = 0, X = 0)

e che

il risultato segue. Se β è positivo (negativo), la probabilità P (Y = 1 |

X) nel passare dal valore X = 0 al valore X = 1 aumenta (diminuisce).

Si noti che il modello precedente ricostruisce perfettamente le probabilità della distribuzione congiunta di Y e X. Questo pertanto è un

modello saturo, ovvero non impone nessuna semplificazione. Se β = 0,

allora cpr(Y, X) = 0 e, come visto nel capitolo precedente, Y e X sono

indipendenti, ovvero non vi è in X nessuna informazione sulla v.c. Y .

⇒ (c) Il modello di regressione logistico si estende al caso in cui

la variabile esplicativa è categorica con I livelli, che codifichiamo con

{0, 1, . . . , r, . . . I − 1}. Si indichi, per semplicità, con π(r) = P (Y = 1 |

X = r). Il modello può pertanto scriversi nel modo seguente:

π(0)

logit[π(0)] = log 1−π(0)

=α

π(r)

= α + βr r ∈ {1, . . . , I − 1}

logit[π(r)] = log 1−π(r)

con βr il log del cpr della sottotabella:

X

Y

0

1

0

pY X (0, 0)

pY X (1, 0)

r

pY X (0, r)

pY X (1, r)

(2.3)

30

E.Stanghellini – Dispense di Statistica IV

Una espressione equivalente del modello (2.3) usa le variabili dummy. Sia Xr una variabile casuale binaria che assume valore 1 se la v.c.

categorica assume valore r e 0 altrimenti, r ∈ {1, . . . , I − 1}. Il modello

è

logit[π(x1 , x2 , . . . , xI−1 )] = α + β1 x1 + β2 x2 + . . . + βI−1 xI−1 .

La scelta della parametrizzazione del modello logistico non è unica.

Quella qui presentata, detta d’angolo, è quella maggiormente utilizzata

dai software statistici che stimano il modello logistico. Il nome deriva

dal fatto che una modalità viene presa come riferimento, e i parametri

relativi alle altre modalità rappresentano la distanza da questa.

Si osservi che esiste sempre un modello che ricostruisce perfettamente

le probabilità della distribuzione congiunta di (Y, X). Questo modello è

detto saturo ed ha tutti i parametri diversi da zero. Tuttavia l’obiettivo

dell’analisi statistica è trovare delle regolarità nella descrizione delle

associazioni verificando se alcuni parametri possono essere posti uguale

a zero senza perdita di informazione. Ad esempio, se tutti i βr sono

uguali a zero, allora logit[π(r)] = α per ogni r ∈ {1, . . . , I−1} e pertanto

Y e X sono indipendenti. Di conseguenza, la classificazione delle unità

secondo la variabile X è ridondante e non aggiunge informazioni sulla

variabile Y .

2.4.1

La forma matriciale

Il modello logistico semplice può essere scritto in forma matriciale, attraverso la costruzione della matrice del disegno X. Nel caso in cui la la

variabile esplicativa sia continua, questa coincide con quella del modello

di regressione classico. Illustriamo con un esempio il caso in cui questa

è categorica.

Esempio 2.1 Si abbia la seguente tabella di contingenza doppia:

E.Stanghellini – Dispense di Statistica IV

31

X

Totale

Y

0

1

2

0

pY X (0, 0) pY X (0, 1) pY X (0, 2) pY (0)

1

pY X (1, 0) pY X (1, 1) pY X (1, 2) pY (1)

Totale

pX (0)

pX (1)

pX (2)

1

Si indichino i livelli della X attraverso due variabili dummy e si crei il

vettore dei logit in ogni livello della X, come la seguente tabella mette

in evidenza.

logit[π(i)] logit[π(x2 , x3 )]

logit[π(1)] logit[π(0, 0)]

logit[π(2)] logit[π(1, 0)]

logit[π(3)] logit[π(0, 1)]

Parametri

α

α + β1

α + β2

La configurazione precedente suggerisce una forma matriciale. Si

ponga:

logit[π(0, 0)]

η = logit[π(1, 0)] .

logit[π(0, 1)]

Vi si associ la matrice X del disegno cosı̀ costruita:

1 0 0

X = 1 1 0 .

1 0 1

Sia β T = {α, β1 , β2 }. Il modello si può riscrivere come:

η = X β.

2.5

Il modello logistico con due variabili esplicative

Si distinguono i casi a seconda della natura delle variabili esplicative.

Si hanno due casi di interesse.

32

E.Stanghellini – Dispense di Statistica IV

⇒ (a) Le Xj sono una v.c. continua e una v.c. binaria.

Sia X1 la variabile binaria. Un primo modello è il seguente:

logit[π(x1 , x2 )] = α + β1 x1 + β2 x2

che implica, nel caso in cui X1 = 0,

logit[π(0, x2 )] = α + β2 x2

e, nel caso in cui X1 = 1:

logit[π(1, x2 )] = α + β1 + β2 x2 .

L’interpretazione del modello è la seguente: vi è un effetto della v.c. X1

e un effetto della v.c. X2 . L’effetto della prima ha come conseguenza

quella di innalzare (se β1 è positivo, abbassare altrimenti) la retta che

spiega l’andamento del logit. Infatti:

logit[π(1, x2 )] − logit[π(0, x2 )] = β1 .

La pendenza della retta, tuttavia, che descrive la dipendenza del

logit rispetto a X2 è costante e pari a β2 nei due valori X1 . Questo

modello contiene solo gli effetti principali delle variabili esplicative. In

Figura 2.2 è presentato il grafico delle due rette per α = 0.2, β1 = 0.4

e β2 = 0.02.

Un modello più complesso del precedente contiene anche le interazioni ed è costruito nel seguente modo. Si crei una variabile x3 data

dal prodotto della x1 ∗ x2 . Cosı̀ costruita, x3 vale 0 se X1 = 0 e x2 se

X1 = 1. Il modello sarà allora:

logit[π(x1 , x2 )] = α + β1 x1 + β2 x2 + β3 x3 .

Esso è un modo sintetico di scrivere le due equazioni:

logit[π(0, x2 )] = α + β2 x2

nel caso in cui X1 = 0, e:

E.Stanghellini – Dispense di Statistica IV

33

2

1.8

1.6

logit π(1,x )=α+β +β x

logit π(x1,x2)

1.4

2

1

2 2

1.2

1

logit π(0,x )=α+β x

2

2 2

0.5

x2

0.6

0.8

0.6

0.4

0.2

0

0

0.1

0.2

0.3

0.4

0.7

0.8

0.9

1

Figura 2.2: Un esempio di modello logistico con α = 0.2, β1 = 0.4 e β2 = 0.02.

logit[π(1, x2 )] = α + β1 + β2 x2 + β3 x2

altrimenti. La pendenza della retta che descrive l’andamento del logit

rispetto a X2 nella popolazione con X1 = 1 è pertanto β2 + β3 . L’interpretazione del modello è la seguente: vi è un effetto di X1 e un effetto

di X2 . L’effetto di X1 ha come conseguenza sia quella di innalzare (se

β1 è positivo, abbassare altrimenti) la retta che spiega l’andamento del

logit, sia quella di aumentarne la pendenza (se β3 è positivo, diminuirne

altrimenti). Infatti:

logit[π(1, x2 )] − logit[π(0, x2 )] = β1 + β3 x2 .

Nel grafico del modello, a differenza di quello in Figura 2.2, le due rette

che descrivono l’andamento del logit rispetto alla x2 non sono parallele.

Quando l’effetto di una variabile sulla variabili risposta si modifica in

conseguenza del variare di una seconda variabile si dice che vi è una

34

E.Stanghellini – Dispense di Statistica IV

interazione di primo ordine. Il coefficiente β3 è detto coefficiente di

interazione.

⇒ (b) Le Xj sono due v.c. binarie.

Nel caso di due variabili esplicative binarie X1 e X2 , i dati possono

essere sintetizzati da una tabella 2 × 2 × 2. Il modello logistico con solo

gli effetti principali può scriversi anche nel modo seguente:

logit[π(x1 , x2 )] = α + β X1 x1 + β X2 x2 .

(2.4)

Per l’interpretazione dei coefficienti si seguono le linee già delineate.

Avremo:

logit[π(1, m)] − logit[π(0, m)] = β X1 per ogni m = {0, 1}

ovvero, β X1 è il logaritmo del rapporto dei prodotti incrociati nelle due

tabelle individuate dai valori di X2 . Infatti, supponiamo m = 0:

β X1 = logit[π(1, 0)] − logit[π(0, 0)]

e pertanto

β X1 = log

P (Y = 1 | X1 = 0, X2 = 0)

P (Y = 1 | X1 = 1, X2 = 0)

− log

.

P (Y = 0 | X1 = 1, X2 = 0)

P (Y = 0 | X1 = 0, X2 = 0)

Moltiplicando per P (X1 = 1 | X2 = 0) il numeratore e il denominatore della prima frazione e per P (X1 = 0 | X2 = 0) il numeratore e il

denominatore della seconda, si ottiene:

β X1 = log

P (Y = 1, X1 = 1 | X2 = 0)P (Y = 0, X1 = 0 | X2 = 0)

P (Y = 0, X1 = 1 | X2 = 0)P (Y = 1, X1 = 0 | X2 = 0)

da cui

β X1 = log cpr(Y, X1 | X2 = 0).

Come la precedente equazione mette in evidenza, β X1 è il logaritmo

del cpr nella sottotabella in cui X2 = 0. Ponendo m = 1 si arriva,

E.Stanghellini – Dispense di Statistica IV

35

attraverso analoghi passaggi, a verificare che β X1 è il logaritmo del cpr

nella sottotabella in cui X2 = 1. Per simmetria, il coefficiente β X2 si

presta alll interpretazione analoga, di logaritmo del cpr nella sottotabella in cui X1 = 0 e, anche, di logaritmo del cpr nella sottotabella in

cui X1 = 1.

Da quanto detto, il modello precedente implica che l’effetto di X1

su Y non varia al variare della X2 e, analogamente, l’effetto di X2 su

Y non varia al variare di X1 . Questa ipotesi è spesso irrealistica. Per

fare questo occorre inserire un ulteriore coefficiente nel modello, come

spiega il prossimo esempio.

Esempio 2.2 Si consideri il seguente modello logistico con due variabili

esplicative binarie X1 e X2 :

logit[π(x1 , x2 )] = α + β X1 x1 + β X2 x2 + β X1 X2 x1 × x2 .

(2.5)

Come la seguente tabella mette in evidenza, il modello è saturo.

logit[π(x1 , x2 )]

logit[π(0, 0)]

logit[π(1, 0)]

logit[π(0, 1)]

logit[π(1, 1)]

Parametri

α

α + β X1

α + 0 + β X2

α + β X1 + β X2 + β X1 X2

In questo modello:

logit[π(1, 0)] − logit[π(0, 0)] = β X1

da cui deriva che β X1 è il logaritmo del cpr(Y, X1 | X2 = 0). Inoltre,

logit[π(1, 1)] − logit[π(0, 1)] = β X1 + β X1 X2 = log cpr(Y, X1 | X2 = 1)

Di conseguenza:

log

cpr(Y, X1 | X2 = 1)

= β X1 X2 .

cpr(Y, X1 | X2 = 0)

36

E.Stanghellini – Dispense di Statistica IV

Ma, per simmetria,

log

cpr(Y, X2 | X1 = 0)

= β X1 X2 .

cpr(Y, X2 | X1 = 1)

Pertanto, β X1 X2 è il parametro che esprime l’effetto su Y dovuto all’interazione di X1 e X2 .

2.6

In generale: il modello logistico multiplo

Analogamente al modello di regressione lineare, il modello di regressione

logistico si estende al caso multiplo.

Sia X un vettore di v.c. p-dimensionale che assume valori x =

(x1 , x2 , . . . , xp )T . Sia π(x) = P (Y = 1 | x). Il modello logistico multiplo

ha la seguente espressione:

logit[π(x)] = log

π(x)

= α + β 1 x1 + . . . + β p xp

1 − π(x)

da cui:

P (Y = 1 | x) = π | x) =

exp(α + β1 x1 + . . . + βp xp )

1 + exp(α + β1 x1 + . . . + βp xp )

e anche:

P (Y = 0 | x) =

1

.

1 + exp(α + β1 x1 + . . . + βp xp )

Anche in questo caso, l’interpretazione dei coefficienti varia a seconda della natura delle variabili in X. Nel caso in cui le variabili in

X siano continue, il coefficiente βj esprime come varia il logit di Y ad

una variazione unitaria di Xj , mantenendo costanti le altre variabili.

Più difficile invece è l’interpretazione dei coefficienti nel caso in cui le

variabile esplicative sono categoriche. Allo scopo di introdurre gradualmente il lettore, si inizia dalla situazione più semplice, in cui si hanno

variabili esplicative binarie.

⇒ (c) Le Xj sono p variabili casuali binarie con p > 2.

E.Stanghellini – Dispense di Statistica IV

37

Supponiamo di avere tre v.c. variabili binarie X1 , X2 , X3 . Un possibile modello è il seguente:

logit[π(x1 , x2 , x3 )] = α + β X1 x1 + β X2 x2 + β X3 x3 + β X1 X2 x1 x2 . (2.6)

Questo modello implica che:

logit[π(x1 , x2 , 1)] − logit[π(x1 , x2 , 0)] = β X3

ovvero, il rapporto dei prodotti incrociati fra Y e X3 è costante in tutte

le 2 × 2 tabelle condizionate congiuntamente a X1 e X2 . Inoltre:

log

cpr(Y, X1 | X2 = 1, X3 = 0)

cpr(Y, X1 | X2 = 1, X3 = 1)

= β X1 X2 =

cpr(Y, X1 | X2 = 0, X3 = 0)

cpr(Y, X1 | X2 = 0, X3 = 1)

ovvero, il rapporto dei prodotti incrociati fra Y e X1 varia al variare

di X2 ma è costante rispetto a X3 . Pertanto, β X1 X2 è il parametro

che esprime l’effetto su Y dovuto alla interazione fra X1 e X2 . Tale

parametro non dipende dai livelli di X3 , ovvero non varia se X3 assume

valore 0 o 1.

Il modello saturo con tre variabili esplicative binarie avrà

¡3un

¢ parametro

Xj

α; 3 parametri β che esprimono gli effetti principali; 2 parametri

di interazione doppia e un parametro di interazione tripla. In tal caso, ogni combinazione (x1 , x2 , x3 ) delle variabili esplicative esprime un

diverso valore atteso della variabile casuale Y .

Con un generico numero p di v.c. binarie la determinazione dei

parametri di un modello saturo può farsi di conseguenza.

⇒ (d) Caso in cui le Xj sono p variabili sono categoriche.

La teoria precedente permette di estendere abbastanza agevolmente

l’interpretazione del modello logistico multiplo al caso generico di p

variabili esplicative categoriche. Il modello 2.6 può scriversi alternativamente:

X1 X2

X2

logitπ(k, m, r) = α + βkX1 + βm

+ βrX3 + βkm

in cui, per evitare la ridondanza fra parametri, si impone che β0X1 =

X1 X2

β0X2 + β0X3 = 0 e anche βkm

= 0 in ogni configurazione (k, m) in cui

38

E.Stanghellini – Dispense di Statistica IV

k = 0 oppure m = 0. Questo permette di scrivere l’equazione di un

modello con un numero generico di variabili esplicative categoriche.

Ad esempio, si consideri il seguente modello con quattro variabili

esplicative:

X1 X2

X1 X4

X2

+ βkl

.

logit[π(k, m, r, l)] = α + βkX1 + βm

+ βrX3 + βlX4 + βkm

Esso implica che tutte le variabili hanno un effetto sulla Y ; l’effetto della

variabile X1 varia con X2 ; l’effetto della variabile X1 varia con X4 ; infine

l’effetto di X3 non varia al variare delle altre variabili. Per convenzione

si assegna valore zero a tutti i parametri relativi a configurazioni delle

X che coinvolgono le modalità 0 di riferimento.

2.6.1

La forma matriciale

Anche il modello logistico multiplo può essere scritto in forma matriciale, attraverso la costruzione della matrice del disegno X. Sia η

il vettore dei logit nella tabella ottenuta attraverso la classificazione

congiunta delle variabili esplicative. Avremo:

η = Xβ

in cui X è la matrice del disegno. Si comprende quindi che il numero di

parametri del modello coincide con il rango della matrice X, ovvero con

il numero di colonne linearmente indipendenti nella matrice del disegno.

Si veda l’Esercizio 2.5 per la forma matriciale del modello (2.5).

2.7

La stima mediante massima verosimiglianza

Si indichi con xi il vettore riga delle variabili esplicative associato alla

i-esima cella della tabella di contingenza ottenuta dalla classificazione

congiunta delle unità secondo le variabili esplicative. Le variabili in xi ,

xij , sono continue o variabili dummy di variabili categoriche e delle loro

interazioni. Siano N le celle della tabella cosı̀ ottenuta. Per ogni cella i

si hanno ni osservazioni di cui wi sono successi. Si scriva il modello di

regressione logistico nella seguente forma:

logitπ(xi ) =

p

X

j=1

βj xij

(2.7)

E.Stanghellini – Dispense di Statistica IV

39

in cui si è posto α = β1 e xi1 = 1. Si assume che ogni cella sia una

estrazione di una v.c. binomiale relativa Wi di dimensione ni e valore

atteso π(xi ). La funzione di probabilità nella cella i-esima è pertanto

pari a

µ ¶

ni

π(xi )wi [1 − π(xi )]ni −wi

wi

con

P

exp( pj=1 βj xij )

P

π(xi ) =

.

(2.8)

1 + exp( pj=1 βj xij )

e

1

Pp

1 − π(xi ) =

.

1 + exp( j=1 βj xij )

Si indichi con li (β) la log-verosimiglianza della i-esima estrazione.

Questa è proporzionale alla seguente espressione:

li (β) = wi log π(xi ) + (ni − wi ) log[1 − π(xi )]

(2.9)

in cui wi è la somma dei successi in ogni cella i. Per N

P estrazioni

indipendenti, la log-verosimiglianza del campione L =

i li è proporzionale alla seguente:

X

{wi log π(xi ) + (ni − wi ) log[1 − π(xi )]}

L(β) =

i

da cui:

L(β) =

X

i

X

π(xi )

wi log

ni log [1 − π(xi )] .

+

1 − π(xi )

i

(2.10)

Notando che

X

X

X

X X

π(xi )

wi log

=

wi (

βj xij ) =

βj (

wi xij )

1

−

π(x

)

i

i

i

j

j

i

avremo

L(β) =

X

j

βj

Ã

X

i

!

wi xij

−

X

i

"

ni log 1 + exp

Ã

X

j

!#

βj xij

.

40

E.Stanghellini – Dispense di Statistica IV

La stima di massima verosimiglianza si ottiene uguagliando a zero le

derivate parziali ∂L(β)/∂βj . Essendo

P

X

∂L(β) X

exp( k βk xik )

P

wi xij −

ni xij

=

∂βj

1

+

exp(

k βk xik )

i

i

il sistema di equazioni di verosimiglianza è pertanto

X

X

wi xij −

xij ni π̂(xi ) = 0 , j = {1, . . . , p}

i

(2.11)

i

in cui π̂(xi ) è la probabilità di successo stimata, ottenuta sostituendo in

(2.8) le stime β̂j e ni π̂(xi ) sono le frequenze teoriche, ovvero stimate dal

modello. Se con X indichiamo adesso la matrice di dimensioni N × p

con righe xi e con w indichiamo il vettore N × 1 di elementi wi e con

ŵ il vettore N × 1 di elementi ni π̂(xi ), possiamo riscrivere le equazioni

di verosimiglianza in forma matriciale:

XT w = XT ŵ.

Si noti l’analogia con la (2.2). Tuttavia, a differenza del modello

di regressione lineare, in questo caso il sistema non ha soluzione esplicita, tranne nel caso non interessante in cui il modello è un modello saturo. In tutti gli altri casi, la massimizzazione della funzione

di verosimiglianza si ottiene attraverso algoritmi iterativi. Gli algoritmi di massimizzazione della funzione di verosimiglianza maggiormente

utilizzati nei software statistici sono il Newton-Raphson o il Fisher scoring (si veda, ad esempio, Tanner, 1996, cap. 2). Le stime di massima

verosimiglianza esistono e sono uniche, ad eccezione di alcuni casi in cui

vi è una relazione deterministica fra Y e le esplicative. Si osservi che,

al crescere del numero N di righe della matrice, diminuisce il numero

dei successi osservati wi per ogni cella i sui quali si basano le equazioni

di verosimiglianza. Di conseguenza, le stime diventano meno accurate.

Si noti infine che un modo alternativo di scrivere il modello è quello di vedere il campione nel seguente modo. Per ogni cella i si hanno

ni estrazioni di una v.c. Yi con distribuzione di Bernoulli. Si verifica agevolmente che la funzione di verosimiglianza in questo secondo

modello è proporzionale a quella scritta precedentemente a meno di un

E.Stanghellini – Dispense di Statistica IV

41

fattore costante e, pertanto, le stime di massima verosimiglianza dei

due modelli coincidono.

La massima verosimiglianza non è l’unica tecnica di stima dei parametri

del modello logistico. Tecniche alternative sono il metodo dei minimi

quadrati ponderati o le stime attraverso metodi bayesiani.

2.7.1

Matrice di varianze e covarianza asintotica

Gli stimatori β̂ ottenuti attraverso il metodo di stima della massima

verosimiglianza hanno una distribuzione asintotica normale con matrice di varianza e covarianza data dalla inversa della matrice di informazione. La stima della matrice delle varianze e covarianze degli

stimatori di massima verosimiglianza si ottiene invertendo la matrice di

informazione osservata, il cui generico elemento è, pertanto:

∂ 2 L(β)

−

=

∂βa ∂βb

P

P

X

x

x

n

exp(

ia

ib

i

i

j βj xij )

P

=−

xia xib ni π(xi )[1 − π(xi )].

[1 + exp( j βj xij )]2

i

Di conseguenza:

ˆ

cov(β)

= {XT diag[ni π̂(xi )(1 − π̂(xi )]X}−1

in cui diag[ni π̂(xi )(1 − π̂(xi )] è una matrice diagonale di dimensioni

ˆ

N × N . La radice quadrata degli elementi sulla diagonale di cov(β)

fornisce gli errori standard degli stimatori β̂. Come vedremo, queste

informazioni, ed altre che adesso andiamo ad introdurre, sono fornite

nell’ output di ogni software statistico per la stima del modello di regressione. Questi risultati permettono, oltre che di verificare ipotesi

sui coefficienti del modello di cui parleremo un seguito, la costruzione

di intervalli di confidenza per i parametri β del modello. Dal punto

di vista teorico, la costruzione segue da vicino quella degli intervalli di

confidenza dei parametri di un modello di regressione.

2.8

Verifica d’ipotesi

Come abbiamo detto, ogni analisi statistica mira a evidenziare il modello o i modelli più parsimoniosi nella classe dei modelli che spiegano

42

E.Stanghellini – Dispense di Statistica IV

bene i dati osservati. Il modello che meglio spiega i dati osservati è il

modello saturo che ha tanti parametri quante le celle i della tabella di

contingenza e ricostruisce perfettamente le osservazioni. La funzione di

verosimiglianza del modello saturo è la massima possibile. Tuttavia,

il modello saturo non distingue gli effetti dovuti al campionamento da

quelli presenti nella popolazione e come tale non può essere considerato

un modello soddisfacente. La teoria che andiamo ad esporre permette di valutare mediante un test statistico se un modello ridotto possa

essere considerato adeguato.

2.8.1

Verifica di ipotesi sul modello

I test G2 che qui presentiamo consente di effettuare un confronto fra un

modello ridotto e il modello saturo. Sia M1 il modello saturo e M0 un

secondo modello con M0 contenuto in M1 , ovvero ottenuto ponendo a

zero alcuni parametri di M1 . Si vuole verificare l’ipotesi che il campione

osservato è stato estratto dal modello M0 , contro l’ipotesi alternativa

che il campione osservato è stato estratto dal modello M1 . In simboli,

sia H0 : il modello vero è M0 e H1 : il modello vero è M1 .

Un primo test è basato sulla distanza dei logaritmi della funzione

di verosimiglianza dei due modelli ed è noto come test del rapporto di

verosimiglianze. Sia L0 il logaritmo della verosimiglianza sotto H0 e L1

il logaritmo della verosimiglianza sotto H1 . La seguente statistica, nota

come devianza,:

X·

¸

w

(n

−

w

)

i

i

i

G2 = −2(L0 − L1 ) = 2

wi log

+ (ni − wi )log

n

π̂(x

)

ni − ni π̂(xi )

i

i

i

(2.12)

è piccola se le due verosimiglianze sono vicine e grande altrimenti. L’espressione deriva dalla (2.9) e dal fatto che nel modello saturo, in ogni riga i, le frequenze teoriche di successo, ni π̂(xi ), e di insuccesso,

ni − ni π̂(xi ) coincidono con quelle osservate. Indicando con

¸

·

(ni − wi )

wi

+ (ni − wi )log

di = 2 wi log

ni π̂(xi )

ni − ni π̂(xi )

E.Stanghellini – Dispense di Statistica IV

43

la devianza può anche riscriversi come

X

2

G =

di .

i

√

I termini di sign[wi −ni π̂(xi )] sono detti residui della devianza. Essi

saranno tanto più piccoli tanto più le frequenze teoriche si avvicinano

a quelle osservate.

Se le variabili in X sono tutte categoriche, al tendere di ni all’infinito in ogni cella i della tabella di contingenza, la grandezza tende a

distribuirsi, sotto H0 , come una χ2 con gradi di libertà pari alla differenza fra il numero dei parametri in M1 e il numero dei parametri

in M0 . Molti software statistici stampano il valore della devianza del

modello e il p-value associato a questo test, ovvero la probabilità di

ottenere, sotto l’ipotesi H0 , un valore maggiore o uguale della statistica

test osservata. Se questo è elevato (ad esempio ≥ 0.05) la statistica

test cade nella zona di accettazione di H0 e pertanto si può accettare il

modello ridotto M0 .

Nel caso in cui, invece, alcune delle variabili in X siano continue, il

numero delle celle della tabella di contingenza ottenuta dalla classificazione congiunta delle variabili esplicative cresce con la numerosità del

campione e la distribuzione distribuzione asintotica della statistica non

è più una χ2 . In tale caso, è preferibile utilizzare altri test (quale ad

esempio il test di Hosmer e Lemeshow che qui non trattiamo).

⇒ In molti casi, si vuole effettuare in confronto fra due modelli, M1 e

M2 entrambi diversi dal modello saturo e tali che M2 è ottenuto da M1

ponendo a zero alcuni dei parametri. Tale confronto viene effettuato

utilizzando come statistica test la differenza delle devianze fra i due

modelli. Indicando con L1 e G21 rispettivamente la log-verosimiglianza

e la devianza del modello M1 e con L2 e G22 le analoghe grandezze del

modello M2 , la statistica test è data dalla differenza:

G22 − G21 = −2(L2 − L1 ).

Anche questo test è basato sul rapporto delle verosimiglianze. La distribuzione asintotica della statistica è una χ2 con gradi di libertà pari

alla differenza dei parametri dei due modelli o, analogamente, alla differenza dei gradi di libertà delle rispettive devianze. In questo caso,

44

E.Stanghellini – Dispense di Statistica IV

l’approssimazione risulta buona anche per tabelle sparse e per dati

continui.

Una situazione di interesse è quella in cui il modello postulato nell’H0

contiene solo l’intercetta ovvero postula la indipendenza della risposta Y

dalle variabili esplicative. Si noti che, a differenza dei test precedenti, in

cui l’obiettivo è quello di accettare il modello ridotto e quindi accettare

l’ipotesi nulla, in questo caso l’obiettivo è rifiutare l’ipotesi nulla a favore

di un modello più sofisticato.

2.8.2

Verifica d’ipotesi sull’effetto di una variabile

Il test del rapporto di verosimiglianza viene utilizzato in situazioni in

cui si vuole valutare se un termine di interazione fra due o più variabili

ha un’influenza significativa sulla probabilità π(xi ) oppure può essere

trascurato. Inoltre, si utilizza anche per valutare se gli effetti principali di una variabile esplicativa sono significativi. In questa situazione

il modello postulato nell’H0 è derivato da quello dell’ H1 imponendo

uguale a zero il vettore dei parametri che rappresentano gli effetti in

studio. Si noti che un modello in cui la esplicativa Xj non ha effetti

principali, ma tuttavia ha interazioni con le altre esplicative è poco interpretabile. Pertanto, è buona prassi imporre inizialmente a zero gli

effetti di interazione di una variabile Xj con le altre. Se questi non sono

significativi, allora si procede a valutare la significatività dei parametri

X

βr j che esprimono gli effetti principali. Ad ogni passo, la statistica test

basata sulla differenza delle devianze ha distribuzione asintotica χ2 con

gradi di libertà pari al numero dei parametri posti uguali a zero.

2.8.3

Test sul singolo coefficiente

In alcuni casi, specialmente se le variabili esplicative sono continue, può

essere di interesse sottoporre a verifica l’ipotesi che un unico parametro

sia pari a zero contro l’ipotesi alternativa che esso sia diverso da zero.

In tale caso si pone H0 : βj = 0 e H1 : βj 6= 0.

La teoria illustrata in precedenza può essere utilizzata anche in questo

caso particolare. Un secondo test è invece basato sulla statistica test

βˆj /SE(β̂j )

dove SE(β̂i ) è l’errore standard ovvero la radice quadrata del j-esimo

ˆ

elemento della matrice di varianze e covarianze stimata cov(β).

Sotto

H0 , la statistica test è asintoticamente distribuita come una N (0, 1).

Molti software statistici calcolano il p-value associato. Se il p-value è

alto (ad esempio ≥ 0.05) si accetta l’ipotesi nulla.

ESERCIZIO 2.1 . Si costruisca la matrice del disegno del modello

(2.5) e si scriva il modello in forma matriciale.

SOLUZIONE ES. 2.1 Si ordinino in forma vettoriale le celle della

tabella di contingenza ottenuta dalla classificazione di X1 e X2 , in modo

che X1 ruota più rapidamente. Si crei il vettore R dei logit associati ad

ogni cella. Ovvero:

logit[π(0, 0)]

logit[π(1, 0)]

η=

logit[π(0, 1)] .

logit[π(1, 1)]

Il modello saturo può pertanto essere riscritto:

η = Xβ

cui β = (α, β1X , β2X , β X1 X2 ) e:

1

1

X=

1

1

0

1

0

1

0

0

1

1

0

0

.

0

1