Davide Bollini

Quinta Alt

Gli acceleratori di particelle

L'innovazione del metodo galileiano consiste nella matematizzazione degli aspetti significativi del fenomeno osservato,

ovvero nella formulazione della legge fisica del fenomeno. Attraverso la legge fisica lo studioso è in grado di predire il

comportamento di sistemi fisici e l'evoluzione dei fenomeni naturali. E' stata l'abilità di razionalizzare e di

matematizzare le leggi della Natura che ha permesso ai fisici di progettare e costruire macchine acceleratrici per

capire l'infinitamente piccolo e risalire indietro nel tempo, fino ad avvicinarsi alle origini del nostro Universo.

Introduzione

Da sempre l'uomo cerca, al di là della sua innata curiosità, risposte ai “perché” assoluti su se stesso e sull'Universo di

cui fa parte. Indagare le cause prime significa interrogare la materia da cui tutto ha origine.

Rispondere al perchè dell'esistenza della materia non è mai stato un compito facile per l'indagine scientifica: alcuni

aspetti sono stati così risolti solo dal punto di vista religioso o filosofico.

La scienza, come ha insegnato Galileo Galilei, deve avere come scopo non il perché ultimo delle cose, ma il come esse

si manifestano.

Tuttavia, non si può dimenticare che alcuni scienziati hanno cercato, escogitando i più diversi esperimenti, di

raccogliere informazioni su ciò che esisteva prima del Big Bang, e di scoprire, quindi, l'origine dell'origine. Anch'essi

sono, dunque, caduti nella trappola delle disquisizioni filosofiche.

Nel momento in cui la Scienza, e la Fisica in particolare, si è staccata definitivamente dalla sua “Madre Filosofia” e ha

iniziato a trattare i fenomeni della Natura secondo i canoni del metodo galileiano (ipotizzare, costruire Teorie e

verificare), ha incominciato a dare delle risposte concrete sulle leggi della Natura, in particolare sulla struttura intima

della Materia fino a riprodurre in laboratorio le condizioni dell'Universo un istante dopo (circa 10 microsecondi) il Big

Bang.

La storia dell'evoluzione sulla conoscenza della Materia, in particolare sulla struttura intima dell'atomo, è una delle più

affascinanti e più complesse ricerche della Scienza. Ma è anche la più intricata e problematica, al punto da rendere

difficile l'individuazione anche delle tappe più significative che ne hanno permesso la comprensione.

Sicuramente, volendo ripercorrere i momenti che, di recente, hanno notevolmente contribuito a capire la struttura

dell'atomo non si può che partire dal 1911, quando il neozelandese Ernest Rutherford (1871-1937) cominciò a studiare

il microcosmo atomico ricorrendo all'urto di particelle-proiettili contro particelle-bersaglio. Dall'analisi della

distribuzione angolare delle particelle deflesse dagli atomi-bersaglio, Rutherford riuscì a decifrare la struttura

dell'atomo, impossibile all'osservazione diretta, e migliorare il Modello atomico a "panettone" dell'inglese Joseph John

Thomson (1856-1900), proponendo il nuovo modello "Planetario" più rispondente alla realtà del momento.

Durante gli ultimi cinquanta anni gli studi per comprendere la struttura più intima della materia si sono sviluppati

usando quasi esclusivamente la tecnica degli urti tra particelle ("urti per vedere"): una particella-proiettile viene

accelerata fino a velocità molto alte e portata a collidere con un'altra particella-bersaglio; dall'esame dei frammenti

emessi nell'urto si ricavano poi informazioni sulla natura delle particelle e sulle forze che agiscono tra esse.

Per portare avanti un programma di esperimenti di questo tipo è necessario avere a disposizione una sorgente di

particelle di elevata energia cinetica. Infatti, non è più pensabile servirsi di una sorgente naturale di tali particelle, come

ha fatto Rutherford, per potere esplorare il nucleo in quanto si richiedono particelle-proiettili molto energetiche e

unidirezionali. Un dispositivo capace di produrre particelle-proiettili, con queste caratteristiche, costituisce una

macchina acceleratrice.

Lo sviluppo degli acceleratori di particelle fece cambiare abbastanza radicalmente l'organizzazione della ricerca in

Fisica Subnucleare. Si sono dovuti creare grossi laboratori nazionali ed internazionali, presso i quali vengono costruiti

gli acceleratori e si fanno gli esperimenti.

Data la complessità tecnica e le dimensioni di tale macchine acceleratrici risulta evidente la costruzione di un

laboratorio attorno alla macchina acceleratrice.

La costruzione di queste macchine richiede principalmente come conseguenza delle sue dimensioni e del suo costo la

soluzione di problemi che non sono soltanto tecnologici, ma anche politici, economici e amministrativi. Sappiamo che

le risorse finanziarie a disposizione della ricerca scientifica sono scarse.

Per tentare di risolvere questo aspetto negli anni cinquanta si è rafforzata l'idea della cooperazione internazionale, per

evitare la inutile duplicazione di impianti simili e progetti troppo grossi per una singola nazione.

Secondo questo modo di procedere sono sorti laboratori come l'INFN, il CERN, il Fermilab, ecc.

Perché gli acceleratori di particelle?

Se è vero che i nostri sensi non riescono a percepire direttamente i componenti ultimi della materia, è comunque

altrettanto vero che ne conosciamo tutte le proprietà, anche se attraverso misurazioni indirette.

Innanzitutto dobbiamo ricordarci che per vedere un qualsiasi oggetto è necessario che questo sia "illuminato" cioè

investito da un'onda elettromagnetica la cui lunghezza d'onda (l) sia minore delle dimensioni dell'oggetto che si vuol

vedere. Il Radar usa onde elettromagnetiche di l = 10-1 m per vedere aerei, navi. Con questa lunghezza d'onda il Radar,

però, non può vedere aghi, chiodi o cose di questo genere. Analogamente il microscopio ottico che opera con onde

elettromagnetiche di l = 10-7 m può vedere un batterio (le cui dimensioni sono dell'ordine di 10 -6 m), ma non può

vedere un virus (dimensioni dell'ordine di 10 -8 m) e tanto meno un nucleo di un atomo le cui dimensioni sono

dell'ordine 10-15 m

In definitiva, per vedere entità sempre più piccole è necessario avere a disposizione onde elettromagnetiche sempre più

corte cioè con lunghezza d’onda sempre più piccola e quindi, secondo la teoria del fisico francese De Broglie, fasci di

particelle (elettroni) di energia sempre maggiore.

Per poter usare le particelle come sonde i fisici devono diminuirne la lunghezza d’onda aumentandone la velocità

[Ec=(1/2)mv2] per mezzo di dispositivi che si chiamano acceleratori di particelle.

In questo modo l'acceleratore di particelle è paragonato a un microscopio.

Il fondamento logico dell'impiego di un acceleratore di particelle, per esplorare la struttura intima della materia, può

essere visto in modo differente.

Fare urtare violentemente due particelle una contro l'altra per "frantumarle" nei loro componenti elementari.

Come fanno i fisici a fare urtare violentemente due particelle?

Ne aumentano la velocità della particella-proiettile fino a quella della luce con dispositivi che si chiamano acceleratori

di particelle.

E' bene ricordare che l'interazione fra due particelle di alta energia non è esattamente simile a uno scontro fra due

automobili. I frammenti non sono soltanto espulsi dalla particella-bersaglio e da quella proiettile, ma possono anche

essere creati ex novo con l'energia apportata all'urto dalla particella-proiettile come previsto dalla famosa relazione di

Einstein: E = m c2

Prestazioni degli acceleratori di particelle

ENERGIA MASSIMA

Il fondamento logico dell'impiego di acceleratori di particelle per esplorare la struttura della materia è quello di far

cozzare violentemente particelle-proiettili contro particelle-bersaglio per frantumare quest'ultime nei loro componenti

elementari. La realizzazione di simile idea, abbastanza semplice, non è tecnicamente di facile attuazione, sia per la

difficoltà di giungere al bersaglio, date le piccolissime dimensioni dei nuclei (10-14 m), sia perché è estremamente

complicato superare la barriera di potenziale elettrico che si oppone all'ingresso di particelle elettricamente cariche al

suo interno. Tale difficoltà può essere superata dotando le particelle-proiettili di energia cinetica (E = ½ m v2) piuttosto

elevata. Quindi, tanto più energetiche sono le particelle-proiettili tanto più queste riescono a penetrare nel cuore del

nucleo delle particelle-bersaglio.

L'energia massima degli acceleratori risulta, dunque, essere la grandezza fondamentale fisica che caratterizza una

macchina acceleratrice.

L'unità di misura dell'energia nel sistema internazionale è il Juole (J). Questa unità di misura nell'ambito della fisica

nucleare è un'unità di misura troppo grande, allora si preferisce introdurre una nuova unità di misura: elettronvolt (eV)

definita come l'energia acquistata da un elettrone che viene accelerato attraverso la differenza di potenziale di 1 volt.

Sapendo che la carica elementare dell'elettrone è di 1,6 10-19 C (Coulomb) e la d.d.p (differenza di potenziale) di 1Volt

dalla definizione di lavoro (L= q V) risulta: 1eV = 1,6 10-19 J

Solitamente si usano i multipli:

1 KeV = 103 eV (Kiloelettronvolt)

1 MeV = 106 eV (Megaelettronvolt)

1 GeV = 109 eV (Gigaelettronvolt)

1 TeV = 106 eV (Teraelettronvolt)

LUMINOSITÁ

L'energia massima non è il solo parametro adatto a misurare le prestazioni di un acceleratore. Un altro fattore

importante è la frequenza delle interazioni (urti) osservabili. Le probabilità di interazione è proporzionale ad un

parametro chiamato luminosità, che essenzialmente è una misura della frequenza con la quale possono essere osservate

le interazioni delle particelle (splendore del fascio).

INTENSITÁ DEL FASCIO

Un'altra caratteristica importante del fascio delle particelle accelerate è l'intensità. In base ai valori dell'intensità i fasci

vengono classificati in:

Fasci di bassa intensità fino a: 10-9 A (1nA)

Fasci di media intensità fino a: 10-6 A (1µA)

Fasci di alta intensità fino a:

10-3 A (1mA)

Il Modello Standard

Tutti i fenomeni noti in fisica delle particelle fondamentali sono in accordo con una teoria completamente formulata,

finita e, nei limiti delle capacita' tecniche attuali, calcolabile, che prende il nome di Modello Standard (MS). Il MS

descrive le interazioni forti, elettromagnetiche e deboli, alle quali tutti i fenomeni microscopici possono essere

ricondotti. Per esempio, le forze che tengono insieme i nuclei atomici sono dovute alle interazioni forti, il legame al

nucleo degli elettroni atomici o degli atomi nelle molecole e' dovuto alle interazioni elettromagnetiche, mentre l'energia

del sole e delle altre stelle e' prodotta da reazioni nucleari dovute alle interazioni deboli. Le forze gravitazionali

andrebbero in linea di principio anche aggiunte, ma il loro impatto nei processi tra particelle fondamentali alle energie

accessibili e' assolutamente trascurabile.

In questa teoria i campi materiali sono i quark (i costituenti dei protoni e dei neutroni) e i leptoni (che compredono oltre

all'elettrone, anche il muone e il tau piu' i tre corrispondenti neutrini).

Il MS ha avuto un lungo periodo di formazione. I primi lavori volti alla costruzione di una realistica teoria unificata

delle interazioni elettrodeboli risalgono alla fine degli anni cinquanta. Nei primi anni sessanta lo studio dell'algebra

delle correnti elettrodeboli e delle relative conseguenze fenomenologiche dimostro' l'intima connessione delle correnti

deboli con la corrente elettromagnetica.

Anche nel settore delle interazioni forti l'evoluzione verso il MS fu lenta e difficile. In assenza di una teoria di campo

resa impossibile dalla complessita' dello spettro degli adroni, i teorici si ridussero per molti anni all'approccio della

cosiddetta matrice S in cui si tratta direttamente con le grandezze osservabili, senza introdurre la nozione di campo. In

seguito, dopo una serie di teorie e sperimentazioni (principalmente affrontate da ricercatori italiani), si ebbero le basi

per un modello teorico delle interazioni forti, che dette poi origine alla teoria delle corde o stringhe. Tale schema e'

considerato attualmente come una possibile teoria della gravita' quantistica unificata alle altre interazioni.

Con l'affermarsi del concetto di quark la teoria delle corde venne abbandonata come teoria delle interazioni forti con un

ritorno alla teoria dei campi. Infatti lo studio sistematico delle particelle adroniche osservate (cioe' quelle con

interazioni forti) porto' lentamente negli anni sessanta alla nozione che gli adroni sono composti da quarks. La decisiva

conferma della effettiva esistenza dei quark entro gli adroni venne dai dati sperimentali sullo scattering profondamente

inelastico ottenuti a SLAC in California. Si giunse cosi' (1972), con il contributo di molti fisici, alla formulazione della

Cromodinamica Quantistica, la teoria di gauge delle interazioni forti.

Per quanto al principio degli anni settanta, come abbiamo visto, la formulazione teorica del MS fosse praticamente

completa, tuttavia, a quell'epoca, la maggior parte dei fisici era scettica sulla rilevanza di tale modello come descrizione

della realta' fisica, in quanto alcuni ingredienti fondamentali della teoria non avevano ancora trovato conferma

sperimentale. In particolare non si aveva evidenza sperimentale dell'esistenza dei processi deboli da corrente neutra e

nemmeno del quark con charm. Ma la scoperta al CERN dei processi deboli da corrente neutra nel 1973 e poi del charm

a Brookhaven e SLAC nel 1974 imposero il MS come teoria di riferimento delle interazioni fondamentali.

Ciclotroni

Il 1932, nella storia della fisica, costituisce una data importante, nell'ambito della fisica delle particelle, non solo per la

scoperta del neutrone e dell'antielettrone (poi detto positrone), ma anche per la nascita della prima macchina

acceleratrice.

Infatti, in questo stesso anno il fisico statunitense Ernest Orlando Lawrence (1901-1958) fece funzionare a Berkeley il

primo ciclotrone che permetteva di accelerare deutoni mantenuti su un'orbita a spirale da un campo magnetico. Per

l'invenzione del ciclotrone E.O. Lawrence ricevette il premio Nobel per la fisica nel 1939.

E.O. Lawrence aveva costruito il ciclotrone per scopi umanitari in quanto aveva in mente le applicazioni mediche.

Il ciclotrone sicuramente può considerarsi il capostipite di una lunga serie di acceleratori sempre più "energetici" che

hanno permesso ai fisici di tutto il mondo di esplorare l'interno del nucleo in modo sempre più dettagliato fino alla

scoperta dei quark e dell'antimateria.

Prima dell'avvento degli acceleratori la struttura del nucleo veniva esplorata facendo ricorso a fasci di particelle a

emesse da sostanze radioattive. Questa fonte naturale di "energia esploratrice" si mostrò ben presto poco efficace in

quanto il suo "contenuto energetico", di poche decina di MeV, non permetteva di penetrare nel cuore del nucleo. Inoltre,

poiché la radiazione veniva emessa in tutte le direzioni, sul bersaglio il contenuto energetico del fascio di particelle

veniva ulteriormente ridotto.

Per questo motivo furono progettati gli acceleratori di particelle, ossia macchine che consentivano di ottenere intensi

fasci unidirezionali di particelle cariche (deutoni, elettroni, positroni, protoni, antiprotoni, ecc.)

Noi descriveremo la fisica del ciclotrone di Lawrence perché questi è da considerarsi il capostipite di tutte le macchine

acceleratrici cicliche. E' un dispositivo che utilizza l'accoppiata dell'intensità del campo elettrico (E) e l'intensità del

campo magnetico (B) per accelerare particelle cariche.

Il principio di funzionamento è quello di produrre un'accelerazione progressiva di particelle che si muovono su un'orbita

chiusa (circolare) guidati da un intenso campo magnetico.

LA FISICA DI BASE DEL CICLOTRONE DI LAWRENCE

Come particelle-proiettili vengono usati i deutoni, prodotti bombardando molecole di DEUTERIO con elettroni

abbastanza energetici. Gli ioni positivi così formati entrano nel ciclotrone attraverso un piccolo foro e sono pronti per

essere accelerati.

CAMPO ELETTRICO

Il campo elettrico o potenziale elettrico acceleratore è generata da due mezze scatole cilindriche metalliche (rame)

chiamate "D" per la loro forma, fungenti da elettrodi, separate tra di loro da una fessura diametrale di qualche

centimetro nel centro di questa fessura è posizionata la sorgente delle particelle acceleratrici.

Le due mezze scatole sono collegate ad un generatore elettrico alternato di potenziale (radiofrequenza) ad alta

frequenza.

I due elettrodi rappresentano la parte più delicata dal punto di vista descrittivo. Essi sono realizzati con rame

elettrolitico nei quali non vi devono essere tracce di metalli ferromagnetici, così come richiesto nelle saldature e nei

tubi, pure di rame, per il raffreddamento.

MOTO DI UNA CARICA ELETTRICA IN UN CAMPO MAGNETICO

Quando un deutone (ione con carica positiva) entra in un campo magnetico di intensità B (B = 1,6 Wb/m2 circa, creato

da un grande elettromagnete) subisce una forza trasversale. Se la particella carica entra perpendicolarmente nel campo

magnetico la sua traiettoria, per la legge F = q v * B, (con * si intende un prodotto vettoriale) risulta circolare e non

esce più dal campo magnetico. Dalla combinazione della relazione fondamentale della dinamica e dell'espressione di F

sopra vista, possiamo calcolare le grandezze caratteristiche di una particella carica in moto in un campo magnetico: il

raggio, la frequenza, la velocità e l'energia cinetica della particella.

Dall'uguaglianza m a = q v B, sapendo che la forza è di tipo centripeta segue m v2/R = q v B, applicando le formule

inverse si ricava:

Da un'attenta osservazione della formula della frequenza risulta che essa dipende solamente dalle caratteristiche della

particella-proiettile e dal campo magnetico, ossia da quantità rigorosamente costanti (ovviamente particelle veloci si

muovono su circonferenze di grande raggio e quelle lente su circonferenze di piccolo raggio). Si può dire, allora, che se

il campo elettrico alternativo è in sincronismo all'inizio del moto della particella carica, esso vi si mantiene per tutto il

tempo di accelerazione indipendentemente dal raggio della traiettoria.

EFFETTO RELATIVISTICO

Le formule appena viste valgono solo nel caso in cui v è molto minore della velocità della luce. Quando v = 0,1 c (v =

3 107 m/s) le leggi della fisica classica devono essere riviste in quanto si entra nel campo relativistico e la variazione

della velocità è associata a quella della massa.

Nel caso relativistico l'energia totale della particella accelerata risulta:

Se poi v = 0,98 c, (v =2,94 108 m/s) si passa nel campo ultrarelativistico, dove non si ha più praticamente variazione di

velocità, ma solamente della massa all'aumentare dell'energia

A causa degli effetti relativistici il ciclotrone non può arrivare ad alte energie perché il principio su cui è basato, cioè

che la frequenza di uno ione in un campo magnetico è indipendente dalla velocità, è esatto solo per velocità molto

minore di quella della luce.

Infatti se si raggiungono valori di velocità prossimi a quella della luce, la massa non può più ritenersi costante in quanto

cresce relativisticamente secondo la relazione:

Così gli ioni si sfasano rispetto all'oscillatore elettrico e la loro energia smette di aumentare.

Questo grosso limite del ciclotrone, per valori elevati dell'energia, ha indotto gli studiosi a progettare altri tipi di

acceleratori: il SINCROCICLOTRONE e il SINCROTRONE.

Nel sincrociclotrone viene fatta variare la frequenza dell'oscillatore così da seguire la variazione di periodo del moto

della particella, in modo che all'aumentare del periodo T corrisponda in eguale misura una diminuzione della frequenza

dell'oscillatore. Con tale macchina si possono raggiungere energie massime di 800 MeV.

Nel sincrotrone, viceversa, si varia l'induzione del campo magnetico, aumentandola in misura tale da far rimanere

sempre costante il tempo t. Questo tipo di acceleratore circolare è stato inventato nel 1945.

Un sincrotrone, a seconda che acceleri elettroni o protoni, è detto elettrosincrotrone o protosincrotrone. A Ginevra nel

1981 con il superprotosincrotrone ( SPS ) si sono raggiunti valori di energia intorno ai 400 GeV (accelerando protoni

con antiprotoni).

Sincrotroni

Il sincrotrone, che funziona con oscillatore a frequenza costante e campo magnetico variabile per soddisfare alle leggi

relativistiche, è stato inventato nel 1945 da Edwin Mattison Mc Millan (nato nel 1907) e Vldimir Iosifovic Veksler

(1907-1966). Esso consente di raggiungere energie elevatissime, dell'ordine delle decine di GeV.

Il principio di base di funzionamento del sincrotrone è, come per qualsiasi altro acceleratore circolare, quello di sfruttare

l'idea di accelerare le particelle lungo un percorso circolare, in modo da attraversare le stesse postazioni di accelerazione

più volte per aumentare sempre di più l'energia.

La novità di queste macchine acceleratrici è che invece di operare con un campo magnetico costante, esse utilizzano un

campo magnetico gradualmente crescente, in modo da mantenere le particelle cariche sempre lungo la stessa orbita

circolare, qualunque sia la loro velocità.

Le parti essenziali di un sincrotrone sono:

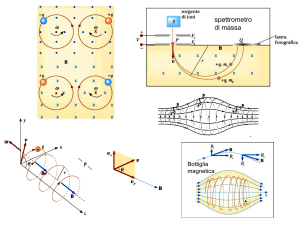

· I magneti disposti ad anello. Questi sono di due tipi: DIPOLARI, costituiti da due poli (nord e sud), generano un

campo magnetico uniforme e determinano l'incurvamento della traiettoria delle particelle cariche. QUADRUPOLARI

che generano un campo magnetico con due poli nord e due poli sud, non deviano le particelle, ma le focalizzano in un

fascio ristretto, agendo come lenti convergenti.

· Le cavità a radiofrequenza. Disseminate fra i magneti quadrupolari ci sono le cavità a radiofrequenze, dove ha luogo il

processo di accelerazione vero e proprio.

· Il tubo circolare. Le particelle cariche vengono immesse in un tubo circolare sotto vuoto spinto, per evitare urti tra le

particelle-proiettile e le molecole dell'aria.

· Preacceleratore. Alle energie più elevate non si arriva con una macchina singola, ma piuttosto con diverse macchine

disposte in serie. Ad esempio in un acceleratore per protoni il primo stadio è costituito da un acceleratore elettrostatico.

Lo stadio successivo spesso un linac. Dal linac i protoni vengono iniettati in un sincrotrone, che può costituire lo stadio

finale della catena oppure servire a sua volta per elevare l'energia dei protoni e iniettarli in un sincrotrone più grande.

· Iniettore. E' costituito da un magnete.

· Magnete di estrazione. Quando le particelle sono state portate al livello di energia desiderato, vengono fatte uscire

dall'anello, modificando la loro traiettoria mediante elettromagneti, e inviate in un bersaglio fisso.

Teoricamente non vi è limite all'energia ottenibile con questo sistema ed è per questo che i più potenti acceleratori

esistenti sono dei sincrotroni.

L'impiego di magneti superconduttori può far raggiungere alle particelle-proiettili energie dell'ordine di TeV

Per avere magneti superconduttori occorre portare tutti i magneti dell'anello ad una temperatura di circa 4,5 Kelvin

ossia - 268,5 oC (Si ricorda che T = 273 + tc dove T temperatura assoluta e tc temperatura in gradi centigradi), la

temperatura al di sotto della quale i materiali conduttori degli avvolgimenti dei magneti perdono tutta la loro resistenza

elettrica.

La difficoltà tecnica più ovvia è raggiungere tale temperatura, infatti per mantenere questa temperatura è necessario

tanto elio liquido, che deve essere pompato lungo tutto l'anello

I magneti

I magneti sono il mezzo principale utilizzato per deflettere e focalizzare particelle cariche in movimento e sono quindi

universalmente usati negli acceleratori di particelle e in molti esperimenti.

CAMPO MAGNETICO E PARTICELLE

Un corpo (o una particella) dotato di carica elettrica e in movimento è soggetto a una forza data da:

F = q v /\ B

F = forza elettromagnetica (misurata in newton [N])

q = carica elettrica (misurata in coulomb [C])

B = vettore induzione magnetica (misurato in tesla [T])

La forza F ha direzione perpendicolare al piano formato dai vettori v e B. Nel caso particolare di campo magnetico

uniforme la particella subisce una forza di deflessione costante che la costringe a percorrere una traiettoria definita

dall'equilibrio fra forza d'inerzia (centrifuga) e forza elettromagnetica (centripeta). (Si assume che la forza di gravità sia

trascurabile in questo caso.)

(f. centrifuga) mv2/r = q v B (f. elettromagnetica)

r = raggio della traiettoria (misurato in metri [m])

m = massa della particella (misurata in chilogrammi [kg])

Il campo B uniforme è diretto in modo da uscire perpendicolarmente dal foglio.

La traiettoria risulta quindi in questo case un cerchio di raggio Mu/qB proporzionale quindi al prodotto m x n, quantità

di moto, e inversamente proporzionale alla carica elettrica e al campo.

Ad esempio, per un elettrone viaggiante alla velocità di 10'000 km/s perpendicolarmente al campo magnetico terrestre

risulta:

q = 1.6 x 10-19 C, m = 9.1 x 10-31 kg, B = 0.5 x 10-4 T r = 1.14 m

Un protone nelle stesse condizioni risulterebbe molto meno deflesso grazie alla sua massa di circa duemila volte più

grande:

q = 1.6 x 10-19 C, m = 1.67 x 10-27 kg, B = 0.5 x 10-4 T r = 2088 m

Lo stesso protone in un campo tipico di un magnete analizzatore (1 tesla) percorrerebbe una traiettoria con raggio di

curvatura di circa 1 decimetro e quindi facilmente misurabile.

I magneti hanno quindi un ruolo primordiale:

- negli acceleratori e accumulatori di particelle per guidarle e focalizzarle,

- negli impianti rivelatori come analizzatori per misurare la quantità di moto delle particelle cariche secondarie

provenienti dalle collisioni di particelle primarie contro bersagli fissi o contro altre particelle circolanti in senso inverso.

Il CERN

L’ORGANIZZAZIONE ISTITUZIONALE

Il CERN (l'acrostico proviene dal nome orginariamente dato all'Organizzazione: Conseil Européen pour la Recherche

Nucléaire) è il Laboratorio Europeo per la Fisica delle Particelle.

Il CERN è stato fondato con una Convenzione Internazionale siglata a Parigi il 1.7.1953 ed entrata in vigore nel 1954.

Alla Convenzione aderirono inizialmente dodici Paesi Europei: Belgio, Danimarca, Francia, Germania federale, Grecia,

Italia, Norvegia, Olanda, Regno Unito, Svezia, Svizzera, Yugoslavia. Successivamente altri Paesi aderirono.

Attualmente essi sono diciannove Paesi, essendo entrati a far parte del CERN:

Austria, Finlandia, Polonia, Portogallo, Repubblica Ceca, Slovacchia, Spagna, Ungheria, mentre la Jugoslavia non ne fa

più parte.

Il laboratorio fu installato inizialmente in una località, Meyrin, a pochi chilometri dal centro di Ginevra in territorio

svizzero ma adiacente al confine con la Francia. Ma già alla fine degli anni 60 il laboratorio cominciò ad espandersi

oltre il confine in Francia per poter realizzare macchine acceleratrici sempre più grandi. Si è infatti passati dai 5m di

diametro della prima macchina, il Sincro-Ciclotrone SC, ai 28 km di circonferenza del LEP e LHC.

L'evoluzione delle principali macchine del CERN è schematicamente indicata nella tabellina seguente:

Sigla

SC

PS

ISR

SPS

Sp-pS

LEP

LEP-2

LHC

LHC

LHC-2

LHC-2

Anno

1957

1959

1971

1976

1981

1989

1996

2004

2004

2008

2008

circonferenza

15 M

600 m

900 m

7 km

7 km

28 km

28 km

28 km

28 km

28 km

28 km

particelle

p

p

p,p

p

p, pe+.ee+.ep, p

p, p

p, p

p, p

Energia

0.6 GeV

28 GeV

28+28 GeV

0.4 TeV

0.4+0.4 TeV

50+50 GeV

90+90 GeV

5+5 TeV

800 TeV

7+7 TeV

1200 TeV

Tipo

bersaglio fisso

bersaglio fisso

collisioni p/p

bersaglio fisso

collisioni ppcollisioni e+/e

collisioni e+/e

collisioni p/p,collisioni i,i,

collisioni p/p,

collisioni i,i,

legenda: p = protoni, p- = antiprotoni, e- = elettroni, e+ =positroni, i = ioni

Si può osservare che il LEP come pure l’LHC, con i suoi 28 km di circonferenza, è non solo la più grande macchina

acceleratrice mai realizzata, ma è anche in assoluto la più grande macchina che l'uomo abbia mai costruito da quando ha

fatto la sua comparsa sulla Terra.

I Paesi membri partecipano alle spese per il funzionamento del CERN in misura proporzionale alle dimensioni delle

proprie economie. Quindi le percentuali di contribuzioni sono andate variando nel tempo per effetto della diversa

dinamica delle economie nazionali, dei rapporti di cambio valutario, e del numero di Paesi membri. Tuttavia ad alcuni

Paesi, a causa di motivi economici contingenti, sono concesse per periodi limitati pagamenti inferiori alla quota

spettante.

LA STRUTTURA DEL LABORATORIO

Il laboratorio del CERN si estende su un vasto territorio a cavallo della frontiera svizzero-francese. E’ articolato in due

siti principali: il sito di Meyrin che comprende il nucleo originale del laboratorio e in cui si svolge la maggior parte

delle attivita’ e il sito di Prevessin, interamente in territorio francese. Inoltre i tunnel dove sono installati I due

acceleratori SPS e LEP (dove sarà installato LHC al posto di LEP a partire dal 2001) costituiscono due grandi

circonferenze a qualche decina di metri sotto il piano di campagna e vari edifici sono localizzati lungo queste

circonferenze in corrispondenza delle aree sperimentali.

PS (Protosincrotrone)

Il PS (Proto-Sincrotrone) è stato il primo grande acceleratore del CERN e la sua orginaria motivazione. E’stato usato

dal ‘59 al ‘75 come acceleratore per la fisica con i protoni; oggi è usato principalmente come pre -acceleratore per

protoni, antiprotoni e ioni pesanti da inviare a SPS e di elettroni e positroni da inviare al LEP. I protoni e gli ioni pesanti

vi arrivano da due iniettori lineari poi accelerati a 1 Gev nel Booster, che è un acceleratore di 50 m di diametro sul quale

è installato l’esperimento ISOLDE per ioni pesanti., mentre gli antiprotoni prima di essere immessi nel PS vengono

accumulati a 3,5 GeV in un piccolo anello di accumulazione, l’AAC (Antiproton Accumulator Collector). Elettroni e

positroni provengono da un acceleratore lineare LIL (Linear Injector for LEP) che ne porta l’energia a 0.6 GeV, e li

inietta in un piccolo anello di accumulazione, l’EPA (Electron Positron Accumulator), prima di passare nel PS che ne

porta l’energia a 3.5 GeV prima di iniettarli nell’SPS .

LEAR (Low Energy Antiproton Ring)

Gli antiprotoni provenienti da PS vengono inviati in LEAR, un piccolo anello di 25 m di diametro dove vengono

decelerati a energie comprese tra 2 e 0,1 GeV e impiegati per gli studi sull’antimateria a basse energie.

SPS (Super Proton Synchrotron)

E’ stato in ordine di tempo il terzo grande acceleratore del CERN (il secondo è stato l’ISR, Intersecting Storage Ring in

funzione tra il 1971 e il 1984, che costituì il primo collisionatore di protoni).

L’SPS è attualmente impiegato principalmente come iniettore di LEP nel qual caso pre-accelera elettroni e positroni ,

provenienti dal PS.

E’ ancora usato per fasci di protoni impiegati per produrre fasci di neutrini nell’interazione dei protoni accelerati a 450

GeV su un bersaglio di Berillio. In particolare vi sono installati gli esperimenti per lo studio delle oscillazioni dei

neutrini.

LEP (Large Electron Positron collider)

E’ il principale acceleratore del CERN. E’ impiegato per esperimenti in cui i fasci di elettroni e positroni vengono fatti

collidere dopo essere stati portati ad un’energia di 50 GeV ciascuno lungo un anello di 28 km di circonferenza.

Il LEP di Ginevra

Il Lep è un grande anello di collisione elettrone positrone di circa 27 km di circonferenza, che consente ai fisici delle

particelle elementari di studiare le leggi che governano le interazioni elettrodeboli. E' difficile giustificare a priori la

costruzione di un acceleratore di particelle specialmente quando ha le dimensioni del LEP. Solo a posteriori, e dopo una

decina d'anni di operazione del LEP stesso, si può apprezzare se la decisione di costruire un acceleratore così costoso è

stata una buona decisione. La storia delle scoperte scientifiche ha insegnato che gli argomenti presentati a priori per

giustificare la costruzione di un acceleratore sono in generale validi anche dopo molti anni di funzionamento, ma in

molti casi sono state fatte nuove scoperte non previste dalle teorie esistenti, che hanno aperto nuovi orizzonti nello

studio dei fenomeni fisici ad alte energie.

Nell'ultimo ventennio la forza elettromagnetica e la forza debole sono state unificate in una descrizione matematica

comune: esse sono due manifestazioni differenti di un'unica forza, la forza elettrodebole. L'unificazione di fenomeni

fisici, a prima vista differenti fra loro, in una teoria unica è un tema centrale della conoscenza scientifica. In generale

permette non solo di descrivere fenomeni diversi ma anche di predire nuovi fenomeni fisici e dà comunque una

descrizione più soddisfacente dei fenomeni conosciuti.

Il Lep, considerato nella sua globalità sia come acceleratore sia come insieme di rilevatori di particelle, costituisce uno

strumento molto potente che permette di fare esperimenti molto precisi i quali consentono di approfondire lo stato delle

conoscenze attuali.

Il LEP rimarrà per molti anni il più grande anello di collisione di elettroni e positroni del mondo. In questo gigantesco

anello si scontrano frontalmente fasci di materia (e-) e antimateria (e+) e nell'annichilazione del sistema particelleantiparticelle tutta l'energia è disponibile per produrre altre particelle. Il processo in cui l'energia può trasformarsi in

materia è ben noto poiché si basa sul fatto che la materia e l'energia sono due aspetti differenti della stessa grandezza

fisica: c'è equivalenza tra massa inerziale e energia grazie alla equazione E = mc 2, dove E è l'energia della particella, m

la sua massa e c la velocità della luce. Mentre è facile trasformare la materia in energia, la trasformazione inversa

richiede speciali strumenti come il LEP. Negli anelli di collisione tutta l'energia dei due fasci di particelle è utilizzata

per produrre nuova materia, mentre nel caso di un fascio di particelle che interagisce contro un bersaglio fisso solo una

frazione dell'energia della particelle incidente viene utilizzata per produrre materia.

CARATTERISTICHE DEL LEP

Il LEP è un grande anello circolare, o più correttamente è un poligono ottagonale con otto sezioni dritte di circa 500

metri ciascuna e otto archi circolari il cui raggio di curvatura è di 3.3 km.

La circonferenza del LEP è di 26,658 km. Esso è situato sottoterra, in media a circa 100 metri; otto zone di accesso

mettono in comunicazione la galleria sotterranea con gli edifici in superficie attraverso diciotto pozzi la cui profondità

varia da un minimo di 50 metri a un massimo di 150 metri. Il diametro dei pozzi di accesso varia tra i 5 e i 23 metri. La

sezione del tunnel ha un diametro di 3,80 metri.

Il LEP attraversa la frontiera franco-svizzera in sei punti, ma circa tre quarti del tracciato del LEP è in Francia. Tutti gli

accessi, meno uno, sono situati in Francia.

GLI ASPETTI PIU’ SIGNIFICATIVI DEL LEP

Nel progettare l'anello di collisione in modo da poter raggiungere gli obbiettivi scientifici, gli ideatori del progetto,

hanno dovuto tener presente numerosi fattori. Il più critico è il fenomeno della radiazione di sincrotrone che determina

le dimensioni dell'anello di accumulazione.

Una particella carica che segua una traiettoria curva emette fotoni e perde una frazione della propria energia. Se la

stessa quantità di energia non viene rifornita dall'esterno, le particelle decelerano rapidamente e seguono una traiettoria

a spirale fino a scontrarsi con le pareti dell'acceleratore. Quando l'energia del fascio è di circa 55 GeV (1 GeV è uguale

a un miliardo di elettronvolt) gli elettroni irradiano circa 200 milioni di elettronvolt per ogni giro percorso nell'anello.

Al fine di fornire l'energia persa occorre fare uso di una successione di cavità di radiofrequenza, che operano a 350

milioni di hertz e che forniscono una potenza di 16 milioni di watt. All'energia di 100 GeV, i fasci del LEP irradieranno

più di 2300 milioni di elettronvolt per ogni giro percorso dalle particelle.

Il costo di funzionamento di un anello di accumulazione elettroni-positroni è determinato principalmente dal costo del

sistema che fornisce l'energia persa come radiazione di sincrotrone. Per una particella che segua una traiettoria

circolare, questa perdita di energia è, in media, proporzionale al rapporto tra la quarta potenza dell'energia e il raggio

della circonferenza dell'anello. Per una data energia del fascio si può ridurre la perdita di energia aumentando il raggio

della circonferenza, ma è evidente che un anello più grande è più costoso da costruire. In termini economici si deve

raggiungere un compromesso tra i costo di costruzione di un anello più grande, che richiede più elementi costitutivi

dell'acceleratore, e il costo di funzionamento dello stesso.

La radiazione di sincrotrone benché abbia effetti negativi per quanto riguarda il costo di funzionamento, offre anche

alcuni vantaggi. La radiazione "smorza" le oscillazioni delle singole particelle del fascio permettendo di accumulare

molte particelle iniettando ripetutamente nuove particelle nell'anello. Alla forza di smorzamento che tende a ridurre a

zero le oscillazioni delle particelle, si oppone una forza di diffusione che fa aumentare le ampiezze delle oscillazioni. Il

fascio raggiunge quindi uno stato di equilibrio nel quale le due forze contrapposte si bilanciano. La situazione è simile a

quella che si verifica in un pallone: la pressione dell'aria nel pallone corrisponde alla forza di diffusione, mentre

l'elasticità della gomma corrisponde allo smorzamento provocato dalla radiazione di sincrotrone. Se la pressione

aumenta, il pallone diventa più grande, mentre se il materiale da cui esso è costituito è meno elastico le sue dimensioni,

a una data pressione, saranno minori. L'aspetto più notevole di questo stato di equilibrio è che esso dà origine a fasci di

particelle quasi insensibili a piccole perturbazioni. Alle energie del LEP questa insensibilità vale solo per gli elettroni e i

positroni, non per i protoni. Questi "ricordano" pressoché all'infinito ogni perturbazione mentre gli elettroni le

"dimenticano" di solito in qualche centesimo di secondo.

I fasci di elettroni e positroni sono costituiti da quattro pacchetti equidistanti che circolano contemporaneamente nel

LEP in versi opposti.

Il LEP consiste in due acceleratori lineari che portano la particella prima a 200 MeV e poi a 600 MeV; quindi in un

anello da 600 MeV si accumulano pacchetti di particelle fino a raggiungere l'intensità voluta e si trasferiscono poi nel

protosincrotrone (PS) del CERN. Il PS ha il compito di accelerare i pacchetti a 3,5 GeV; essi vengono poi iniettati nel

superprotosincrotrone (SPS) dove vengono accelerati fino a 20 GeV prima di essere trasferiti nel LEP. Una volta che le

particelle si trovano nell'anello del LEP devono essere guidate lungo la traiettoria e focalizzate nei punti di collisione.

Questa funzione viene svolta da elettromagneti e da separatori elettrostatici. Ciascuno degli otto archi, che coprono più

di tre quarti della circonferenza del LEP, comprende 31 moduli standardizzati, ognuno dei quali è lungo 79,11 metri e

contiene magneti nel seguente ordine: un quadrupolo di focalizzazione verticale, cioè un magnete a quattro poli che

comprime il fascio nella direzione verticale, un correttore dell'orbita nella dimensione verticale, un gruppo di sei dipoli

di curvatura, un sestupolo di focalizzazione orizzontale, un quadrupolo di focalizzazione orizzontale, un correttore

dell'orbita nella dimensione orizzontale , un secondo gruppo di sei dipoli di curvatura e infine un sestupolo di

focalizzazione verticale.

Il campo magnetico dei dipoli è di circa 0,1 tesla; la bassa intensità del campo ha consentito di realizzare il nucleo del

dipolo secondo un progetto di nuovo tipo, nel quale i traferri fra le lastre di acciaio magnetizzato sono riempiti di una

speciale malta. Questo sistema di costruzione si è rivelato del 40% più economico rispetto ai nuclei di acciaio

convenzionale.

Nei punti di collisione i fasci di particelle vengono compressi per poter aumentare la luminosità del fascio. La

compressione è ottenuta da un gruppo di quadrupoli superconduttori, i quali restringono il fascio fino a 10 micrometri

nel piano verticale a 250 micrometri nel piano orizzontale e a circa 2 cm nella direzione longitudinale.

La corrente dei magneti del LEP è controllata accuratamente da 750 alimentatori in corrente continua con potenze che

vanno da un chilowatt a parecchi megawatt. Gli alimentatori hanno una stabilità che raggiunge due parti su 100.000 e

vengono sincronizzati con la massima esattezza.

Un ultimo sistema del LEP da menzionare è il sistema di vuoto. In sei ore di funzionamento dell'anello di

accumulazione le 1012 particelle dei fasci percorrono più di 240 milioni di volte la circonferenza del LEP, coprendo

una distanza pari a 6500 milioni di chilometri, ossia più della distanza che ci separa da Nettuno. La camera a vuoto dove

vengono accelerati i fasci deve, quindi, essere a pressione bassissima per evitare che le particelle urtino con le molecole

di gas che si trovano sul percorso descritto dal fascio. La pressione statica all'interno della camera a vuoto è inferiore a

10-11 millimetri di mercurio.

Negli anelli di accumulazione per elettroni costruiti in precedenza si otteneva un vuoto ultraspinto mediante l'impiego di

pompe lineari ad assorbimento di ioni che dovevano necessariamente funzionare nel campo dei magneti di curvatura.

Poiché i campi magnetici dei dipoli del LEP sono poco intensi, per permettere l'uso delle pompe lineari, si è dovuto

ricorrere ad un nuovo sistema adottato per la prima volta in un acceleratore. Esso si basa su un sistema di pompaggio

costituito di un nastro assorbente distribuito lungo la circonferenza del LEP. Questo nastro largo tre centimetri ed esteso

per più di 20 km., è fatto di costantana (una lega rame-nichel) rivestito da una lega di zirconio-alluminio. Il materiale

che costituisce il nastro si comporta come una "carta moschicida" molecolare e forma composti chimici stabili con la

maggior parte dei gas attivi. Le molecole residue di gas aderiscono al nastro di costantana e diffondono verso l'interno

dello stesso. Questo nuovo sistema di pompaggio ha ridotto considerevolmente i costi di costruzione del sistema di

vuoto.

Il progetto LHC

Il maggior impulso alla ricerca proviene oggi dal Large Electron-Positron Collider (LEP), le cui misure insuperate per

quantità e qualità stanno confermando a un livello di precisione dell'uno per cento, che presto potrà essere spinto fino

all'uno per mille, l'attuale miglior descrizione del mondo subatomico, il Modello Standard. Quando i programmi LEP

saranno completati, si aprirà la via al futuro con il Large Hadron Collider.

I dati del LEP sono precisi a tal punto da essere sensibili a fenomeni che si manifestano ad energie più alte di quelle

della macchina stessa, proprio come le sofisticate misure delle scosse di un terremoto effettuate lontano dal suo

epicentro. Ciò costituisce l'anteprima delle esaltanti scoperte che si prevedono ad energie dell'ordine del TeV (1 TeV

=1000 GeV=1.000.000.000.000 eV) dei costituenti fondamentali. Infatti l'evidenza sperimentale indica chiaramente che

a tali energie si dovrebbero aprire nuovi orizzonti per la fisica, con la possibilità di dare una risposta agli interrogativi

più profondi della nostra epoca, quale ad esempio l'origine delle masse.

A priori un collisionatore elettrone-positone, quale il LEP, con un'energia di almeno 1 TeV sarebbe lo strumento ideale

per tali studi. In effetti le interazioni elettrone-positone, che sono particelle puntiformi senza una struttura interna,

producono eventi facilmente distinguibili dal "fondo" e l'energia dei fasci è concentrata nei proiettili elementari e non

deve quindi essere suddivisa fra i quarks e i gluoni come nel caso dei protoni. Ciò ha come conseguenza che un

ipotetico collisionatore e+e- di 1 TeV disporrebbe della stessa energia effettiva di una macchina adronica di circa 10

TeV. Ma non é possibile oggi, e non lo sarà ancora per molto tempo, realizzare un tale collisionatore. Infatti un

SUPERLEP, cioè una macchina circolare, è resa impossibile dalla grande perdita d'energia sotto forma di radiazione di

sincrotrone subita dalle particelle costrette ad un moto curvilineo (l'energia emessa é proporzionale alla quarta potenza

dell'energia delle particelle), mentre la tecnologia degli acceleratori lineari è ancora lungi dal rappresentare

un'alternativa realizzabile.

L'unica soluzione accessibile è quindi quella di un collisionatore circolare protone-protone, con un'energia dei fasci

superiore ai 10 TeV. Ciò è vero in particolare per il CERN che dispone del tunnel del LEP, nel quale installare una

seconda macchina, e di tutta la relativa infrastruttura. E' disponibile anche un formidabile complesso di iniettori (linac,

booster, PS e SPS), che ha già realizzato fasci dell'intensità e della brillanza richiesti, e che richiede solo un modesto

programma d'adattamento per essere in grado di fornire i protoni necessari al funzionamento dell' LHC alla più alta

luminosità.

L'LHC sarà un acceleratore estremamente versatile. Potrà far collidere fasci di protoni di energia fino a 7 TeV (14 TeV

nel centro di massa) in punti d'interazione d'eccezionale luminosità, consentendo di ottenere interazioni quark-quark

d'energia ben superiore al TeV. Può far collidere anche fasci di ioni pesanti come il piombo con un'energia totale di

collisione di 1250 TeV, circa 30 volte maggiore di quella del RHIC (Relativistic Heavy Ion Collider) in costruzione nel

Laboratorio di Brookhaven negli USA. Infine nel futuro il funzionamento congiunto di LHC e di LEP potrà produrre

collisioni protone-elettrone di un'energia di circa 1.5 TeV, cinque volte superiore di quella disponibile in HERA a

DESY (Amburgo).

Le tre caratteristiche principali di questa macchina:

- collisioni protone-protone, dato che sarebbe risultato impossibile ottenere una grande luminosità con quelle fra protoni

e antiprotoni, a causa della scarsità di questi ultimi.

- energia dei fasci la più elevata possibile e quindi il campo magnetico deflettore più grande possibile (energia

proporzionale al prodotto raggio di curvatura del tunnel per il campo) nei due canali magnetici richiesti dalle collisioni

fra particelle della stessa carica viaggianti in direzioni opposte.

- luminosità la più alta possibile, per sfruttare al meglio le caratteristiche dei fasci di protoni, coi quali la probabilità

statistica di ottenere scontri quark-quark di energia ben più elevata della media è tanto più grande quanto più grande è la

luminosità.

Queste caratteristiche hanno condotto ad elaborare soluzioni tecniche per il sistema magnetico molto innovative sia

rispetto ad acceleratori già realizzati. In primo luogo il campo magnetico più grande si ottiene con cavi superconduttori

raffreddandoli ad una temperatura di 1.8 K a mezzo di elio superfluido, invece del classico elio a 4.2 K. In effetti, ad

una temperatura data, la densità di corrente ottenibile in un cavo, fattore determinante per il disegno del magnete,

decresce rapidamente col campo. Raffreddando a 1.8 K invece che a 4.2 K la densità di corrente voluta si ottiene ad un

campo più elevato di circa il 30%.

La seconda novità importante adottata per il circuito magnetico è costituita dalla struttura cosiddetta "due-in-uno". I due

canali magnetici nei quali circoleranno le particelle sono infatti sistemati nello stesso giogo e contenuti nello stesso

criostato, con notevole economia sia di spazio trasversale nel ristretto tunnel del LEP, che di costi (circa il 20% in meno

rispetto alla soluzione classica di due magneti completamente separati).

Le bobine dei magneti, che hanno una lunghezza di più di 14 m su un diametro interno di soli 56 mm, richiedono molta

cura in fase di avvolgimento sia per ottenere la grande precisione richiesta nella posizione dei conduttori (errore

ammesso inferiore a 0.1 mm) che per impedire movimenti durante il funzionamento. L'attrito potrebbe infatti generare

uno sviluppo di calore sufficiente a produrre una transizione allo stato normale (chiamata "quench") anche di una

piccola porzione di conduttore e conseguente arresto della macchina. La sfida tecnologica rappresentata dai magneti

dell' LHC si può valutare meglio quando si pensi che le forze elettromagnetiche che si sviluppano nelle bobine crescono

col quadrato del campo e che la capacità termica dei conduttori metallici alla temperatura di 1.8 K è solo un decimo di

quella a 4.2 K. Ciò significa che una stessa quantità d'energia liberata da un piccolo spostamento di un conduttore

provoca un aumento di temperatura della massa metallica dieci volte più rapido a 1.8 K che a 4.2 K.

Anche l'energia elettromagnetica immagazzinata nel circuito è proporzionale al quadrato del campo e raggiunge in un

magnete dipolare più di 7 MJ. In caso di "quench", l'energia tenderebbe a concentrarsi nella zona divenuta resistiva e

porterebbe inevitabilmente alla distruzione del magnete se una rivelazione rapida di un quench incipiente non

permettesse di far transitare tutto il magnete per mezzo di bande riscaldanti. Questa necessità di aumentare

artificialmente e rapidamente la zona resistiva al fine di distribuire l'energia nel volume più grande possibile si presenta

per la prima volta per magneti di acceleratori.

Due grandi rivelatori per collisioni protone-protone ad alta luminosità ATLAS (A Toroidal Lhc Apparatus) e CMS

(Compact Muon Solenoid) saranno inseriti nella macchina. Le dimensioni totali di quest due "titani" sono

impressionanti: ATLAS avrà un'altezza di 20 m, una lunghezza di 44 m e peserà circa 6000 tonnellate, mentre CMS

sarà più piccolo (altezza 14 m, lunghezza 20 m) ma più pesante (12000 tonnellate).

Anche questi rivelatori, come la macchina, devono affrontare e superare sfide tecnologiche importanti. Basti pensare al

susseguirsi degli scontri fra i pacchetti ogni 25 nanosecondi (11 microsecondi nel caso del LEP), che impone

all'elettronica di decidere in pochi nanosecondi se conservare o scartare i dati raccolti nello scontro appena avvenuto

sulla base delle topologie registrate; o ancora al grande numero di eventi, circa venti in media, ad ogni scontro di

pacchetti. Quindi è stato necessario anche per i rivelatori intraprendere un programma di ricerca e sviluppo, che, in

pochi anni, ha prodotto risultati notevoli fornendo soluzioni adeguate ai problemi più scottanti.

E` stato concepito anche un rivelatore di collisioni di ioni di piombo (ALICE), il cui scopo è di studiare lo stato della

materia, chiamato plasma di quark e gluoni, quale avrebbe dovuto esistere fino a circa venti microsecondi dopo il Big

Bang e potrebbe essere presente oggi nel cuore delle stelle di neutroni.

L'Informatica e gli acceleratori di particelle

INTRODUZIONE

Le tecniche di acquisizione e trattamento dei dati nelle esperienze di fisica delle alte energie subiscono un'evoluzione

continua, approfittando degli sviluppi dei rivelatori di particelle e di fattori esterni quali l'evoluzione tecnologica in

elettronica e informatica.

Una discontinuità determinante in questa evoluzione si è verificata verso la metà degli anni sessanta quando sono

accaduti due fatti notevoli concomitanti. In primo luogo l'invenzione dei rivelatori "elettronici" ha permesso di misurare

con buona precisione e in tempo reale le coordinate spaziali dei prodotti di interazione. La realizzazione di questi

rivelatori su larga scala è stata resa possibile dalla miniaturizzazione e riduzione dei costi dell'elettronica, grazie all'uso

prima dei transistors e poi dei circuiti integrati e, in secondo luogo, dalla disponibilità di calcolatori elettronici per

acquisire ed elaborare grandi quantità di dati.

I rivelatori elettronici attuali permettono di ottenere risoluzioni spaziali comparabili a quelle raggiungibili con metodi

fotografici, dell'ordine di 10µm, in apparecchiature le cui dimensioni lineari raggiungono decine di metri, fornendo

ampi dettagli sulla topologia degli eventi osservati. Inoltre sono sensibili ad eventi successivi separati da intervalli

dell'ordine del nanosecondo, potendo fornire un flusso praticamente continuo di dati.

SELEZIONE E ACQUISIZIONE DATI

L'aumento dell'intensità degli acceleratori di particelle, insieme alle possibilità offerte dai rivelatori, permette di

produrre ed osservare fenomeni sempre più rari, a condizione di poterli identificare e selezionare nella moltitudine di

eventi più comuni. Questa selezione avviene in due fasi, distinguibili per le tecniche usate: una selezione rapida

(trigger) della topologia viene effettuata mentre l'informazione è conservata in memorie precarie o volatili, mentre

un'analisi sistematica dei pochi eventi selezionati e registrati in memorie permanenti procede usando tecniche raffinate

di calcolo. Questo modello semplificato (trigger + analisi) si realizza in pratica in modo quasi continuo, attraverso una

serie di operazioni via via più complesse e precise (quindi via via più lente) effettuate sugli eventi che hanno

sopravvissuto alla selezione imposta dalle operazioni precedenti.

Per dare un'idea intuitiva e solo lontanamente quantitativa del flusso di dati in gioco in un grande esperimento e della

selettività dei processi di trigger, il flusso potrebbe essere assimilato alla somma di informazione digitale che si avrebbe

se tutti gli abitanti della terra parlassero simultaneamente al telefono, saturando ciascuno una linea da 64 kbit/s. Da

questo flusso primordiale sarebbero selezionati soltanto un migliaio di individui sensati e interessanti, dei quali si

registrerebbero le conversazioni.

TECNOLOGIE INFORMATICHE

Trigger e acquisizione dati hanno una forte componente informatica multiforme. In primo luogo la logica di trigger si

realizza attraverso operazioni booleane eseguite in circuiti ad hoc e attraverso calcoli in processori di vario tipo. Il

trasferimento dei dati in modo rapido ed affidabile richiede l'uso di protocolli efficienti e sofisticati. Infine, il controllo

del flusso e della qualità dei dati e dello stato di funzionamento dei rivelatori richiede un'infrastruttura capace di

osservare ogni dettaglio e rilevare le anomalie eventuali. Le tecnologie informatiche disponibili permettono in generale

di soddisfare a tutte queste richieste considerate separatamente. Tuttavia rimane un vasto problema di integrazione delle

varie tecnologie in un unico sistema coerente: questo aspetto multidisciplinare rappresenta l'origininalità dei progetti

informatici in fisica delle alte energie.

RETI TELEMATICHE

Un elemento molto importante nel funzionamento di un laboratorio dedicato a grossi acceleratori di particelle è

l'infrastruttura di telecomunicazioni digitali.

Un primo aspetto dell'utilizzazione di informatica e comunicazioni digitali è quello comune ad ogni grande

organizzazione in cui tutte le persone che vi lavorano usano quotidianamente computers per attività convenzionali.

Un secondo aspetto è l'uso di calcolatori per il controllo degli acceleratori. Il problema da risolvere in questo caso è di

programmare, seguire e correggere azioni su diverse apparecchiature lontane anche decine di chilometri (diametri degli

anelli di accelerazione che arrivano sino a 27 Km) in tempi corrispondenti a pochi multipli del periodo di rivoluzione

delle particelle (89µs), con piccole fluttuazioni della simultaneità e con risposta deterministica. Ciò è possibile

associando una rete di calcolatori operanti in tempo reale ad un sistema di sincronizzazione che permette a tutte le

apparecchiature e calcolatori, ovunque essi siano, di riconoscere eventi che devono essere trattati come simultanei in

tutto il sistema distribuito. Tale rete a doppia funzionalità è realizzata integrando componenti propri alle trasmissioni

digitali di tradizione telefonica con componenti e protocolli usati nelle reti informatiche.

Un terzo elemento di telecomunicazione e trasferimento dati è dato dalle richieste del ricercatore singolo di accedere ai

dati dell'esperimento sul quale lavora. Dopo diverse forme di elaborazione i dati di un esperimento (e i dati simulati

associati) sono a disposizione dei membri della collaborazione, in memorie magnetiche, dischi o nastri. È quindi poi

necessario trasferire su rete sottoinsiemi coerenti di dati per permettere ai ricercatori, nei loro laboratori sparsi su tutto il

globo, di analizzare i fenomeni che li interessano. Questo stile di lavoro si è rivelato molto efficiente e produttivo ed ha

portato la comunità dei fisici attivi in ricerca in alte energie ad un ruolo pionieristico nell'uso di reti di calcacolatori con

alta banda passante a livello internazionale.

Applicazioni Industriali degli Acceleratori di Particelle

ASPETTI GENERALI

Fino al secondo dopoguerra la diffusione delle tecniche radiologiche industriali (in particolare quelle legate alla

diagnostica non distruttiva) ha avuto un aumento moderatamente crescente fino a quando un impulso nuovo e

determinante è venuto dall'uso, nello stesso settore, degli acceleratori di particelle atomiche che fino ad allora erano

stati sviluppati ed utilizzati quasi esclusivamente per la fisica fondamentale.

Oggigiorno si ha addirittura tendenza ad eliminare le sorgenti radioattive per tutta una serie di complicazioni legate al

loro uso in contrapposizione al fatto che gli acceleratori presentano diversi vantaggi ed in particolare quello di produrre

fasci più intensi e soprattutto piùcontrollabili, permettendo quindi di adattarsi meglio ai procedimenti industriali dando

le massime garanzie dal punto di vista della sicurezza operativa.

Va sottolineato che taluni risultati possono essere ottenuti esclusivamente con l'impiego di fasci di particelle mentre altri

processi si pongono in concorrenza diretta con metodi diversi e più tradizionali. Il punto di forza nell'impiego

tecnologico di acceleratori di particelle spesso risiede in un incremento di economia, rapidità e salvaguardia

dell'ambiente.

Il rapido sviluppo tecnologico degli acceleratori nelle loro diverse forme (elettrostatici, lineari, circolari etc.) e la loro

accresciuta affidabilità ha fatto si che la convenienza economica dei processi in cui possono essere impiegati sia

divenuta nel tempo sempre maggiore.

L'acceleratore utilizzato in ciascun processo influenza grandemente le valutazioni economiche, per cui, anche se molto

è stato già fatto (siamo ormai nella settima decade di sviluppo degli acceleratori), molto è ancora possibile fare

sfruttando l'apice tecnologico di questo settore che ancora oggi vede la sue fondamentali evoluzioni legate alle

apparecchiature messe a punto per la fisica fondamenale, dove le energie e le problematiche sono di parecchi ordini di

grandezza più grandi che nei processi industriali.

PRINCIPI

Alla base di tutti i processi di irradiamento vi è la capacità da parte della radiazione, sia essa elettromagnetica o

corpuscolare, incidente su un bersaglio, di generare ionizzazione e attraverso la modifica dei legami atomici o

molecolari provocare effetti di tipo chimico e/o fisico.

Fra di essi è di particolare interesse la capacità delle radiazioni di incidere sul comportamento biologico delle cellule

influendo sul DNA e provocando effetti che vanno fino alla inibizione totale di cellula o di microrganismi che, in via

generale sono tanto più radiosensibili quanto maggiore è la loro complessità strutturale.

Dosi letali per vari organismi:

Organismi

Dose in Gy

Mammiferi

5 – 10

Insetti

10 – 1.000

Batteri

500 – 10.000

Spore

10.000 – 50.000

Virus

10.000 – 200.000

[La dose assorbita è l'energia deposta dalla radiazione per unità di massa e si misura in Gray : 1 Gy = 1 Joule/1 kg]

Un altro effetto delle radiazioni è la possibilità di favorire l'insorgere di legami incrociati fra alcuni tipi di molecole

provocando cambiamenti comportamentali degli oggetti trattati.

Con qualunque acceleratore si fa si che il fascio prima di uscire dalla cosiddetta "finestra" della macchina venga fatto

oscillare con un sistema di scansione magnetica per poter coprire l'intera superficie del prodotto da trattare e di

conseguenza sterilizzarlo, decontaminarlo, disinfestarlo, o fargli ottenere le caratteristiche superficiali desiderate.

PROCESSI INDUSTRIALI

Per dare un quadro globale, anche se molto sintetico delle possibiltà tecnologiche dei fasci ionizzanti, sono possibili

diversi tipi di classificazione, facendo riferimento al tipo di macchina, al tipo di particelle, o ad altri criteri ancora. Si dà

comunque per scontato che i processi descritti traggono vantaggio dall'esclusivo impiego di acceleratori di particelle a

discapito sia delle sorgenti naturali, per le ragioni precedentemente descritte, sia dei processi tradizionali alternativi.

In particolare si presenteranno tecniche correlate con l'industria chimica, con quella della sterilizzazione nel senso più

ampio del termine, con quella della protezione ambientale con quella alimentare.

Industria chimica

Il bombardamento dei polimeri con elettroni (EB) permette, come già accennato, di generare radicali liberi che a loro

volta generano legami incrociati (cross-links) fra le molecole dei polimeri.

Questo fenomeno provoca nel materiale trattato effetti quali il miglioramento delle caratteristiche meccaniche con la

temperatura, una migliore capacità dielettrica in funzione dell'invecchiamento, l'ottenimento di pezzi fortemente

termoretraibili, la produzione di bande adesive particolari etc.

La reticolazione può ottenersi con effetto di massa, se si tratta la materia prima dello stampaggio o dell'estrusione,

oppure con trattamento superficiale se viene effettuata su prodotti finiti o in fase di lavorazione come si fa per esempio

per i cavi elettrici.

La reticolazione dei polimeri si può generare anche per via chimica, ma in questo caso i reagenti ed i catalizzatori sono

costosi , tossici, ed inoltre il processo è più lento con la conseguente incidenza sulla reddittività dell'investimento.

Le realizzazioni industriali già esistenti e di cui si riporta nel seguito una lista trattano:

Isolanti elettrici : in quanto per usi fino a 30 kV migliorano la costante dielettrica ed il comportamento con la

temperatura, la quale influisce con andamento alla quarta potenza insieme alla tensione di esercizio sull'invecchiamento

dell'isolante stesso.

Termorestringenti : l'utilizzo di queste tecniche per produrre questi prodotti ha vantaggi rispetto ai processi chimici

tradizionali sia per il costo sia per il rapporto di restringibilità che può arrivare fino a tre volte rispetto alla dimensione

iniziale. Si fa largo uso di componenti termoretraibili ottenuti da processi di irraggiamento specialmente nell'industria

automobilistica ed elettronica per i cosidetti "jackets" che assicurano protezione, isolamento e sigillamento.

Plastiche e gomme : oltre al migliore comportamento meccanico con la temperatura è possibile ottenere, con

irraggiamento di elettroni, processi di vulcanizzazione a freddo e simultanea sterilizzazione che può avere largo

impiego nell'industria dei prodotti medicali (guanti, siringhe, cateteri etc.). Le dosi necessarie sono dell'ordine 50-60

kGy ed il costo dei trattamenti per ora è competitivo solo se si considera la simultanea sterilizzazione dei prodotti in

lavorazione.

Trattamenti superficiali : quando il processo di massa risulta troppo impegnativo, tenendo conto della dose, o non è

possibile intervenire altrimenti che sul prodotto finito, risulta conveniente variare le caratteristiche solo in superficie.

Questi trattamenti stanno avendo grandissima diffusione perchè è possibile ottenere indurimento di vernici o di stampe

o di essiccamento degli inchiostri evitando l'uso di solventi. Il trattamento superficiale con EB (bombardamento con

elettroni) permette profondità di penetrazione maggiori rispetto agli equivalenti trattamenti con raggi ultravioletti

Sterilizzazione

Sotto questo termine generico possono essere compresi tutti i processi hanno influenza sul comportamento biologico

delle cellule e permettono quindi un trattamento di eliminazione selettiva di microrganismi che vanno dalle spore agli

insetti . L'impiego di questi trattamenti trova spazio in campo ospedaliero, nell'industria farmaceutica, nello stoccaggio

merci (in particolare granaglie) e nell'industria alimentare .

Presidi medici: la sterilizzazione in ambito industriale ed ospedaliero si ottiene attuamente con processi a vapore o con

l'uso di Ossido di Etilene. In questi ultimi cinque anni l'incremento della sterilizzazione con EB è stato rapidissimo

giungendo ad una diffusione del 33% del mercato totale ma è destinato ad aumentare tenuto conto che il processo

termico è costoso per l'energia in gioco ed inadatto per materie plastiche a basso punto di rammollimento, mentre

l'Ossido di Etilene, essendo tossico, dovrà essere progressivamente eliminato. La omogeneità della dose è inoltre

sicuramente migliore che con gli altri metodi. Attualmente la convenienza del trattamento è legata al costo

dell'acceleratore, che dovendo essere di alta potenza (da 10 a 50 e più kW) per far fronte rapidamente a grandi lotti di

merce da sterilizzare, ha ancora costi relativamente alti e pertanto si giustifica solo per centri con grandi capacità di

materiale da trattare per far fronte ad un ragionevole ammortamento dei costi d'impianto. La rapidità dell'ulteriore

diffusione è legata all'abbattimento dei costi per macchine acceleratrici fra 5 e 10 MeV a elettroni e con dimensioni

compatte.

Cosmetici e prodotti farmaceutici: si trattano per ottenere asetticità specialmente i prodotti in polvere e dato il loro alto

valore aggiunto risulta opportuno un trattamento a EB che privilegia l'aspetto qualitativo anche a discapito della

convenienza. In questo campo risulta estremamente vantaggioso eliminare prodotti chimici ma per adesso non è stato

ancora analizzato come l'opinione pubblica percepisce commercialmente l'irradiamento dei cosmetici.

Protezione ambientale

Trattamento di rifiuti tossici : sono state fatte esperienze per eliminare gli effetti nocivi di inquinanti contenuti in acque

di scarico contenenti per esempio pesticidi , atrazina ed altro ed i risultati sono molto positivi a parte per adesso il costo,

che dipende molto dalle capacità di trattamento delle macchine e dalla velocità del trattamento che è legata alla

profondità di laminazione del liquido per garantire la dose necessaria in funzione della portata. Ovviamente non si può

garantire l'abbattimento di tutti gli inquinanti (per esempio i metalli in sospensione), ma questo processo risulta molto

interessante per il trattamento dei rifiuti ospedalieri, che, dopo l'irradiamento, addivengono ad uno stato di normali

rifiuti da smaltire. Di grande interesse è inoltre la distruzione del PCB che come noto è molto stabile e quindi

chimicamente inattaccabile e, per ora, il solo modo di distruggere le grandi quantità di PCB che dovranno essere

eliminate nei prossimi anni, è solo attraverso l'antieconomico impiego di forni ad altissima temperatura.

Trattamento fanghi : l'aspetto interessante rispetto ai precedenti processi di sterilizzazione è quello di poter riutilizzare,

una volta abbattuta la carica virale, gli stessi fanghi come fertilizzanti naturali semplicemente reimmettendoli in

agricoltura.

Derrate alimentari : fra le tante possibilità di sterilizzazione o rallentamento della maturazione, i trattamenti che stanno

trovando più vasto ed accettato impiego sono quelli che tramite EB permettono di decontaminare da batteri come

Salmonella e la Yersinia, le carni di pesce e pollame, anche surgelate. Si riesce inoltre ad eliminare parassiti come la

Taenia e la Trichinella per esempio dalle carni di maiale. Di altrettanto vasta portata può diventare il trattamento delle

granaglie all'ammasso per disinfestarle da insetti e parassiti. In questo campo il potenziale è legato più che al costo del

trattamento in sé, alla trasportabilità della macchina per evitare di avere costi di movimentazione e facchinaggio

incidenti troppo pesantemente sul prezzo finale delle granaglie che normalmente sono a basso valore. Molto più diffuso

è il trattamento delle spezie. È possilbile anche la pastorizzazione di alcuni cibi, oltre che del latte, ma l'argomento resta

per ora relativamente controverso per via del contenuto vitaminico che talune fonti sostengono possa essere diminuito.

Gli acceleratori di particelle in medicina

Esattamente cento anni fa Wilhelm Konrad Roengten, professore di fisica all'Università di Würzburg, scopriva i raggi X

utilizzando l'acceleratore di particelle che allora era all'avanguardia : un tubo di Crookes, un po' di cartone e delle lastre

fotografiche furono sufficienti ad aprire la strada alle applicazioni diagnostiche della fisica. Dopo pochi anni i raggi X

cominciarono a essere utilizzati per la terapia dei tumori. Qui il cammino fu molto più lungo perché i raggi X, prodotti

con i primi tubi a relativamente bassa energia, sono troppo assorbiti quando attraversano la materia. L'aumento della

tensione applicata ai tubi a raggi X è proseguito fino agli anni quaranta : qualche centinaio di chilovolt divennero usuali,

così da produrre fotoni aventi energia massima pari a qualche centinaia di migliaia di elettronvolt (circa 100 keV).

Dopo la seconda guerra mondiale e per qualche decina d'anni presero il sopravvento le "bombe al Cobalto", le quali

contengono barre di metallo attivato nei reattori nucleari che emettono fotoni di circa un milione di elettronvolt (1

MeV). Presto venne la rivincita degli acceleratori di elettroni; prima quelli circolari (soprattutto betatroni) e poi gli

acceleratori lineari. All'inizio questi ultimi venivano considerati troppo costosi e poco affidabili : una sorgente

radioattiva funziona sempre. Ma oggi le bombe al Cobalto vengono rimandate (costosamente) al venditore e i

radioterapisti chiedono acceleratori lineari di elettroni di energia sempre più elevata : all'inizio 8 MeV erano sufficienti,

poi 18 MeV e oggi, sempre più spesso, 25 MeV e, con altri acceleratori, anche 50 MeV. Inoltre acceleratori di protoni e

ioni sono già oggi utilizzati nella terapia oncologica.

ACCELERATORI LINEARI DI ELETTRONI

Gli acceleratori lineari sono affidabili, leggeri e i prezzi sono molto diminuiti per la competizione industriale. I

principali produttori occidentali sono Varian, General Electric, Philips, Siemens. In Giappone domina la Mitsubishi.

L'Italia è stata assente da questa competizione fino a quest'anno, allorché la Hitesys di Pomezia ha messo sul mercato un

piccolissimo acceleratore lineare per elettroni posizionabile con un robot. In questo caso si usano direttamente gli

elettroni (e non i fotoni, o raggi X, prodotti quando gli elettroni colpiscono un bersaglio metallico) e lo scopo è quello di

irraggiare nel corso di un'operazione gli organi del paziente dopo che il tumore è stato asportato chirurgicamente.

Il mercato degli acceleratori lineari è molto vasto. Oggi sono in funzione nel mondo circa 500 linac per elettroni, la

metà dei quali nei soli Stati Uniti. In media un acceleratore di alta energia, completo di tutto, costa circa un milione di

euro. Poiché si ritiene che vi dovrebbe essere un acceleratore ogni 100'000 abitanti, il numero di acceleratori dovrebbe

moltiplicarsi per cento per coprire le necessità di tutta la popolazione mondiale. In Italia sono in funzione oggi circa un

centinaio di acceleratori lineari distribuiti su 70-80 centri di radioterapia. Con essi vengono irraggiati circa 90'000

pazienti all'anno ma in alcune regioni i centri di radioterapia mancano del tutto e in molte regioni le code di attesa sono

molto lunghe: si valuta che circa 130'000 pazienti italiani dovrebbero essere irradiati ogni anno. Bisogna sottolineare

che non sono tanto i fondi per gli acceleratori che mancano, quanto il personale addestrato capaci di utilizzarli.

TERAPIA CON NEUTRONI VELOCI

Un dieci per cento circa dei tumori sono "radioresistenti" perché le cellule ipossiche non sono sensibili alle radiazioni

convenzionali (fotoni ed elettroni); è stato dimostrato che alcuni di essi sono però distrutti da fasci di neutroni veloci

prodotti colpendo bersagli di berillio con protoni o deutoni di più di 50 MeV di energia. La maggiore efficacia biologica

dei neutroni veloci (cioè neutroni che hanno qualche decina di MeV di energia) è dovuta al fatto che essi, urtandoli,

mettono in moto i protoni dell'idrogeno che è contenuto nei tessuti attraversati. Questi protoni hanno energie circa

eguali a quelle dei neutroni che li mettono in moto e, essendo carichi, si fermano in un millimetro (o meno) e lasciano

dietro di sé una densa colonna di ioni . È questa alta densità di ionizzazione (espressa dal grande trasferimento di

energia LET = Linear Energy Transfer, che arriva fino a 100 keV/µm) che produce danni irreparabili alle cellule dei

tumori radioresistenti. Fotoni ed elettroni hanno invece una bassa densità di ionizzazione (LET @ 0.2-2 keV/µm) e le

cellule tumorali ipossiche riescono a riparare i danni da loro prodotti.