16

I percorsi della fisica

In questo capitolo si pone in prospettiva storica lo sviluppo delle varie parti della fisica utilizzando l’antinomia tra scienza e tecnologia come strumento per fare

luce sulle relazioni tra conquiste concettuali e impieghi

concreti. Si coglie l’occasione per riassumere in modo

discorsivo le principali conquiste della ricerca recente

sul tessuto della materia e dell’universo.

Un’altra antinomia parallelamente sviluppata in questo capitolo è quella tra scienza e filosofia. Non si intravede oggi la possibilità di affrontare, con i soli metodi

tradizionali della scienza, fondamentali questioni riguardanti origine e futuro dell’Universo, significato e

ruolo della civiltà umana. Si chiede aiuto a principi di

natura filosofica e si danno nuove interpretazioni alla visione dei pensatori che ponevano l’uomo al centro del

creato.

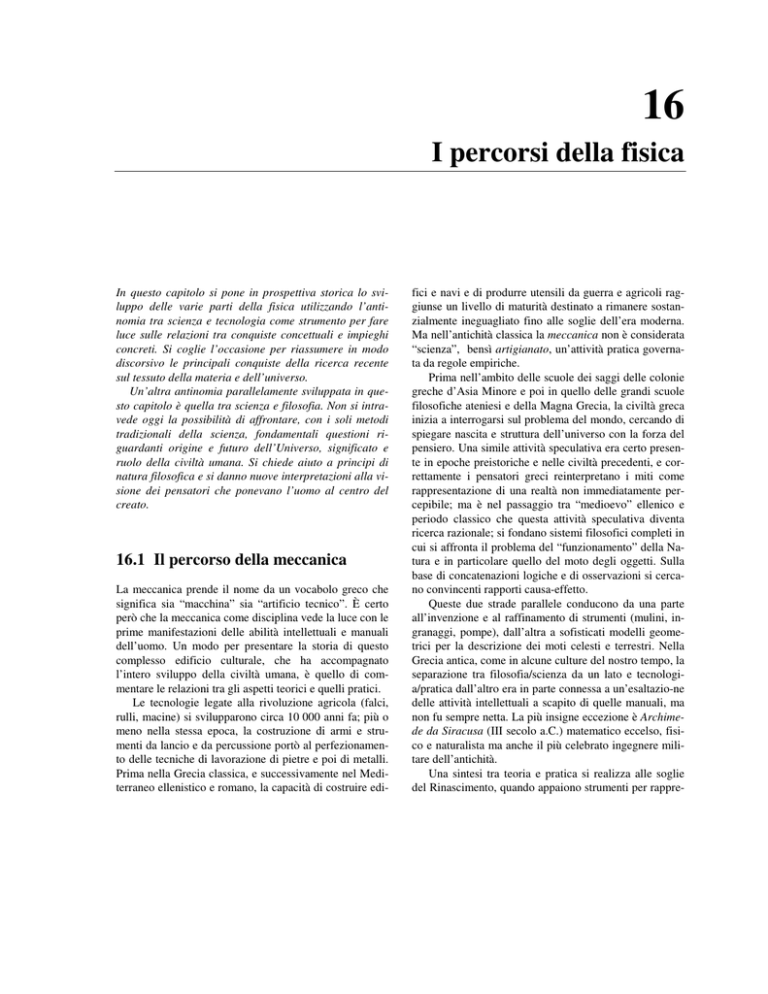

16.1 Il percorso della meccanica

La meccanica prende il nome da un vocabolo greco che

significa sia “macchina” sia “artificio tecnico”. È certo

però che la meccanica come disciplina vede la luce con le

prime manifestazioni delle abilità intellettuali e manuali

dell’uomo. Un modo per presentare la storia di questo

complesso edificio culturale, che ha accompagnato

l’intero sviluppo della civiltà umana, è quello di commentare le relazioni tra gli aspetti teorici e quelli pratici.

Le tecnologie legate alla rivoluzione agricola (falci,

rulli, macine) si svilupparono circa 10 000 anni fa; più o

meno nella stessa epoca, la costruzione di armi e strumenti da lancio e da percussione portò al perfezionamento delle tecniche di lavorazione di pietre e poi di metalli.

Prima nella Grecia classica, e successivamente nel Mediterraneo ellenistico e romano, la capacità di costruire edi-

fici e navi e di produrre utensili da guerra e agricoli raggiunse un livello di maturità destinato a rimanere sostanzialmente ineguagliato fino alle soglie dell’era moderna.

Ma nell’antichità classica la meccanica non è considerata

“scienza”, bensì artigianato, un’attività pratica governata da regole empiriche.

Prima nell’ambito delle scuole dei saggi delle colonie

greche d’Asia Minore e poi in quello delle grandi scuole

filosofiche ateniesi e della Magna Grecia, la civiltà greca

inizia a interrogarsi sul problema del mondo, cercando di

spiegare nascita e struttura dell’universo con la forza del

pensiero. Una simile attività speculativa era certo presente in epoche preistoriche e nelle civiltà precedenti, e correttamente i pensatori greci reinterpretano i miti come

rappresentazione di una realtà non immediatamente percepibile; ma è nel passaggio tra “medioevo” ellenico e

periodo classico che questa attività speculativa diventa

ricerca razionale; si fondano sistemi filosofici completi in

cui si affronta il problema del “funzionamento” della Natura e in particolare quello del moto degli oggetti. Sulla

base di concatenazioni logiche e di osservazioni si cercano convincenti rapporti causa-effetto.

Queste due strade parallele conducono da una parte

all’invenzione e al raffinamento di strumenti (mulini, ingranaggi, pompe), dall’altra a sofisticati modelli geometrici per la descrizione dei moti celesti e terrestri. Nella

Grecia antica, come in alcune culture del nostro tempo, la

separazione tra filosofia/scienza da un lato e tecnologia/pratica dall’altro era in parte connessa a un’esaltazio-ne

delle attività intellettuali a scapito di quelle manuali, ma

non fu sempre netta. La più insigne eccezione è Archimede da Siracusa (III secolo a.C.) matematico eccelso, fisico e naturalista ma anche il più celebrato ingegnere militare dell’antichità.

Una sintesi tra teoria e pratica si realizza alle soglie

del Rinascimento, quando appaiono strumenti per rappre-

352 Capitolo 16

sentare la realtà e per calcolare. Nascono apparecchi che

Epoca Storica

meccanica

(pratica)

filosofia naturale

(teoretica)

Grecia Classica

utensileria

(agricola e da

guerra)

statica

(architettura

militare e civile)

terrestre

celeste

Periodo

Ellenistico

geometria

del moto

strumenti

strumenti per

rappresentare

Medio Evo

strumenti per

calcolare

Rinascimento

esperimento

Seicento

Settecento

meccanica

applicata

teorie fisiche

(meccanicistiche)

Ottocento

M E C C A N I C A

consentono di effettuare rapidamente calcoli per il rilevamento di posizioni sulla superficie terrestre, o sulla

volta celeste, e di risolvere problemi di orientamento e di

costruzioni. Si stabilisce un nuovo clima filosofico in cui,

a differenza del Medioevo, una persona non vale solo per

l’anima o la mente, ma anche per la destrezza fisica. Il

Cortegiano del Castiglione è assetato di ogni forma di

sapere, ma sa affrontare guerre e duelli cavallereschi. Tra

Rinascimento e Seicento prendono poi forma le “sensate

esperienze”, non più come osservazioni della Natura, ma

I percorsi della fisica 353

come interventi che provocano il fenomeno e lo leggono

tramite strumenti “amplificatori dei sensi”. È in questo

periodo che nasce la metodologia della scienza moderna.

La tecnologia, nella forma di meccanica applicata, si arricchisce di paradigmi matematici e di procedure sperimentali mirate. Per la soluzione teorica di problemi di fisica vengono fondate nuove discipline matematiche: teoria delle equazioni in campo complesso, geometria analitica, calcolo integro-differenziale e calcolo matriciale.

Newton non solo dà alla meccanica una struttura coerente, ma è tra i più illustri matematici dei secoli XVII e

XVIII; fondatore, con Leibniz, del calcolo infinitesimale,

Newton ha anche dato contributi alla geometria (curve

piane del terzo ordine) e all’algebra.

L’operazione di sintesi tra teoria e pratica e la sistemazione di questioni controverse continua nell’Illuminismo settecentesco e porta, agli albori dell’Ottocento, al

trionfo della meccanica. Lo sviluppo tecnico si basa sempre più spesso sulla capacità di impostare e risolvere modelli teorici. Si ha l’impressione di avere a disposizione

tutto ciò che è necessario per descrivere in modo logicamente coerente il mondo e fare predizioni rigorose. Si

consuma in questo tempo un divorzio con la filosofia: i

primi successi della meccanica avevano creato ottimismo

sulle “magnifiche sorti e progressive”, ossia su un futuro

rischiarato da conoscenze sempre più approfondite e da

scoperte utili. Si intuisce però che la capacità di predizione della scienza meccanica, in apparenza inesauribile,

implica un mondo dove tutto è fissato da leggi che non

lasciano margini di incertezza. Ne nasce una visione pessimistica di un uomo non più libero e si gettano le basi di

una perdurante incomunicabilità tra scienza e pensiero filosofico. Ancora oggi è viva la tendenza della filosofia e

di talune discipline che si occupano di fenomeni sociali e

biologici ad appropriarsi indebitamente dei principali paradigmi delle meccaniche (classica e quantistica). Tali

paradigmi, usati al di fuori dal loro contesto d’origine, finiscono per assumere significati spesso completamente

differenti, che lo scienziato non può giustificare o, addirittura, arrivare a comprendere.

L’evoluzione della scienza all’inizio del Novecento

porta rapidamente a incrinare le fondamenta della meccanica, precedentemente considerate inattaccabili. Si comprende che la meccanica classica descrive solo una parte

della realtà: come la geometria, è uno schema concettuale

utilissimo per descrivere fenomeni macroscopici, ma che

é incapace di afferrarne la natura più profonda. È infatti a

un livello diverso da quello formale della meccanica di

Newton che va collocata la ricerca sulle interazioni fondamentali (gravitazionale, debole, elettromagnetica, nu-

cleare) che costituiscono il tessuto su cui l’intero universo è costruito.

16.2 Il percorso della termodinamica

La termodinamica, come oggi la intendiamo, si è andata

formando nell’Ottocento. Tuttavia, le sue radici empiriche e concettuali sono antichissime, essendo connesse

con lo sviluppo della capacità di produrre e usare il fuoco(☯). Nelle più antiche civilizzazioni a noi note ebbero

un ruolo importante composti “eutettici” quali bronzi, ceramiche e vetri, che hanno in comune il poter essere fusi

o rammolliti anche su di un fuoco a legna o in semplici

fornaci. Nell’ambito di credenze magiche, nei miti e nel

pensiero filosofico il fuoco ha spesso avuto un ruolo speciale, quale “elemento” degno di studio e meditazione.

Nei secoli attorno all’era volgare, una migliore padronanza della combustione, evoluta sino alla produzione

della polvere da sparo, diede un lento avvio all’uso del

calore per generare movimento, uso che porterà poi alle

macchine termiche. Durante tutto il Medioevo, la “scienza del calore” evolve lentamente: da una parte si ha la filosofia naturale, con osservazione di fenomeni atmosferici, dall’altra si ha l’alchimia, con il suo empirismo magico. Ambedue contribuiscono allo sviluppo della termometria. Dalla fine del Medioevo e per tutto il Rinascimento si costruiranno termometri per misurare il “contenuto di calore” dei corpi, non essendo ancora chiara la

distinzione tra temperatura e calore.

Gli usi pratici della combustione e gli studi di alchimisti e naturalisti sembrano avere in comune solo i concetti empirici di “caldo” e “freddo”. È con le ricerche sui

gas, sviluppatesi dall’inizio del Seicento, che si comincia

a collegare, mediante un modello meccanico che già adombra la teoria atomica della materia, la nascente chimica, la tecnica delle macchine, la termometria. Tuttavia

il legame tra applicazioni tecniche e approcci scientifici è

quanto mai esile perché non si possiede ancora una teoria

coerente del calore.

Nel Settecento si comincia a definire cosa si debba intendere, concettualmente e sperimentalmente, per quantità di calore; partendo dai concetti di calore e temperatura,

(☯) La leggenda greca di Prometeo vuole che il fuoco sia un

dono divino all’umanità. Tuttavia, questo mito nel Prometeo

Incatenato di Eschilo diventa una affascinante sintesi della storia della civilizzazione. Il Titano, incatenato da trenta millenni,

un tempo che non sembra oggi citato a caso, ricorda di avere

introdotto ciò che ha consentito all’umanità di abbandonare la

vita selvaggia delle caverne: religione, leggi, tecniche (navigazione, medicina, etc.) e arte della profezia.

354 Capitolo 16

Lavoisier fonda la chimica; è il secolo della Rivoluzione

Industriale, avviata proprio da una applicazio-

355 Capitolo 16

Epoca Storica

fuoco

4000 a.C.

500 d.C.

metallurgia

polvere da sparo

(combustioni per

generare movimento)

filosofia naturale

Medio Evo

fenomeni atmosferici

alchimia

chimica

Rinascimento

leggi dei gas

Seicento

macchine a vapore

termometria

teorie cinetiche

elementari

calorimetria

Ottocento

macchine termiche

teoria del calore

primo principio

teorie cinetiche

secondo principio

meccanica statistica

Novecento

termodinamica

tecnica

formalizzazione della

termodinamica degli

stati di equilibrio

termodinamica

di non-equilibrio

(processi irreversibili)

T E R M O D I N A M I C A

ne tecnica del calore (la macchina a vapore). Dalla pratica vengono gli stimoli per un’analisi del bilancio energetico dei metodi noti per ricavare lavoro mediante macchine termiche. Si rimane però lontani da uno schema concettuale universalmente accettato: le interpretazioni oscillano tra una teoria cinetica elementare e una teoria del ca-

lore come fluido continuo, ponderabile o no. Questo travaglio fa maturare l’esigenza di una teoria generale delle

macchine: di quanto fosse forte il bisogno di un principio

unificante e intensa la ricerca dello stesso fa fede il fatto

che nella sua opera sulla natura della scoperta scientifica

Thomas Kuhn (The structure of the scientific revolutions,

356 Capitolo 16

1962) elenca in quest’epoca ben dodici “scopritori” del

principio di conservazione dell’energia. Il dibattito sulla

possibilità del moto perpetuo svolge un ruolo fondamentale come punto di incontro tra un problema filosofico

(conservazione assoluta di una entità che verrà chiamata

energia) e tecnico (massimo rendimento nella produzione

di lavoro mediante calore).

La sistemazione teorica del problema delle macchine

termiche viene finalmente avviata nei primi decenni

dell’Ottocento quando si enunciano il primo e il secondo

principio della termodinamica. È subito chiaro che con

questi strumenti non si spiegano solo le macchine termiche, ma anche le reazioni chimiche, i cambiamenti di stato e persino la propagazione del suono nell’aria.

Nella seconda metà del XIX secolo la neonata termodinamica si sviluppa rapidamente. Viene approfondito il

concetto di energia termica e di calore come energia in

transito. Le teorie cinetiche della materia, mediante l’introduzione della meccanica statistica, portano a una interpretazione probabilistica del secondo principio in cui

l’irreversibilità del trasferimento spontaneo di calore è

legata al “gran numero” di particelle del sistema. La termodinamica viene vista come il risultato di una media su

un numero enorme di eventi microscopici, non rilevabili

né rilevanti, se considerati singolarmente, che porta a una

drastica riduzione del numero di grandezze necessarie per

definire lo “stato” di un sistema. Con questo approccio

concettuale, se da una parte la tecnologia del calore si inserisce finalmente nel paradigma energetico, dall’altra si

aprono nuove interpretazioni legate alla duplice natura

del sistema termodinamico: vi è l’aspetto microscopico,

governato da leggi “meccaniche” (reversibili e deterministiche) e l’aspetto macroscopico, probabilistico e irreversibile, dove le grandezze sono sottoposte a leggi che non

hanno parallelo in meccanica.

La formalizzazione della termodinamica a cui si giunge a cavallo tra XIX e XX secolo è solo in apparenza logica e “completa”, tanto da assumere una struttura matematica assiomatica: i primi due principi vengono riformulati in un modo molto generale, applicabile a situazioni

diversissime, e la stessa termometria è posta su basi non

più empiriche. Un ruolo importante è svolto dal concetto

di funzione di stato, grandezza fisica che ha un valore

indipendente dalla storia passata del sistema e dipendente solo dalla sua condizione del momento. Il concetto

presenta analogie formali con quello dell’energia potenziale meccanica, che è funzione solo delle coordinate del

sistema.

I successivi sviluppi mettono però in evidenza due

punti fondamentalmente irrisolti:

1.

2.

il formalismo della termodinamica classica vale solo

per “stati di equilibrio”: durante una qualunque trasformazione che non sia infinitesima si è lontani da

tali stati e le grandezze termodinamiche non sono più

definibili a rigore, poiché non si conoscono i microstati del sistema sui quali applicare il procedimento

di media;

non vi è una comprensione chiara della irreversibilità, peraltro evidente a livello macroscopico, non essendo l’interpretazione probabilistica del tutto soddisfacente.

Il primo punto porta alla termodinamica di non-equilibrio, in cui si sviluppano metodi per studiare sistemi assoggettati a trasformazioni non reversibili e in condizioni

di non-equilibrio. Si sono avuti risultati notevoli, di particolare interesse anche per le scienze biologiche e le

scienze chimiche, ma una sistemazione definitiva sembra

ancora lontana.

Il secondo punto è uno dei grandi temi concettuali del

dibattito scientifico contemporaneo. Sebbene si accetti

che l’evoluzione spontanea di un qualunque sistema avvenga nella direzione degli stati più probabili, non è chiaro quale sia il significato logico e fisico di questa affermazione; potrebbe essere di fatto una tautologia mascherata dalla sottigliezza di ipotesi fisiche e procedure matematiche che la traducono in relazioni formali. Perciò,

anche se la termodinamica è strumento applicabile con

enorme successo ai campi più disparati, dalle macchine ai

sistemi biologici, dalla radiazione ai buchi neri, dalla meteorologia all’evoluzione, dall’economia alla teoria dei

giochi, ci sembra ancora celare la sua natura più recondita, ma anche più inquietante, legata alla “freccia del tempo” e alla irripetibilità di ogni attimo che stiamo vivendo.

16.3 Il percorso

dell’elettromagnetismo

L’elettromagnetismo, così come è inteso oggi, rappresenta una sintesi, in forma di teoria completa, di osservazioni, fatte in epoche diverse e con metodi diversi, che mai

avrebbero lasciato presagire un destino unitario.

L’aspetto comune a tali osservazioni è che, fino a epoche

relativamente recenti (XVI-XVIII secolo), esse venivano

considerate non molto significative nella comprensione e

nella descrizione fisica del mondo. Nello sviluppo storico di questa branca della scienza possiamo distinguere tre

357 Capitolo 16

Epoca Storica

specchi

ambra

1000 a.C.

visione, ombre,

raggi

500 d.C.

teorie

geometriche

della visione

Medio Evo

Rinascimento

magnetite

lenti

occhiali

bussola

elettricità

per strofinio

prospettiva

sistemi ottici

fenomeni ottici

Seicento

(diffrazione,

interferenza,

dispersione)

teorie

corpuscolari

dei raggi

Settecento

(microscopi,

cannocchiali)

magnetismo

geomagnetismo

teorie

corpuscolari

dei raggi

teorie complesse

della luce

teoria del fluido

magnetico

obiettivo

acromatico

(microscopi

composti)

cannocchiali)

Ottocento

bottiglia di Leyda

conduzione

legge di Coulomb

pila voltaica

teorie dinamiche

dell’etere

legge di Ohm

effetti magnetici

delle correnti

elettrodinamica

correnti indotte

teoria delle

masse

magnetiche

teoria delle

correnti atomiche

elettromagneti

corrente di

spostamento

onde

elettromagnetiche

(elettrotecnica)

teoria del campo

elettromagnetico

E L E T T R O M A G N E T I S M O

358 Capitolo 16

classi di fenomeni (ottici, elettrici e magnetici) che la teoria di Maxwell riesce, nell’Ottocento, a descrivere in modo unitario. Nel Capitolo 11 si è cercato di dare l’idea di

come la strada di questa sintesi, pur breve nel tempo, sia

stata aspra e complicata.

L’ottica nasce in un’epoca indefinita, molto tempo

prima dell’era volgare, mostrando un duplice aspetto:

quello che potremmo definire strumentale e tecnologico

(specchi, lenti) e quello teorico e filosofico, legato al senso della vista e al suo significato nei confronti della percezione del mondo. Per molti secoli ci sono artigiani, che

producono lenti e specchi, da un lato, e filosofi o matematici, dall’altro, che disquisiscono di ombre, di cammini

dei raggi luminosi (facendo nascere l’ottica geometrica),

e di teorie della visione. Ci si chiede se gli occhi emettano “bastoncelli” che colpiscono gli oggetti e tornano poi

indietro attraverso la pupilla (funzionando cioè come gli

attuali radar e sonar) oppure se siano gli oggetti stessi

che producono i corpuscoli che raggiungono gli occhi.

Qualunque sia il meccanismo, si conclude però che comprenderlo non aiuta la “vera” conoscenza del mondo,

poiché la fallacia del senso della vista è universalmente

riconosciuta e le illusioni ottiche dimostrano l’inaffidabilità delle conoscenze desunte dalla sola vista. Così, mentre si producono lenti rudimentali (Alto Medioevo) e occhiali (Basso Medioevo), chi studia il “sistema del mondo” non presta attenzione ai risultati che gli artigiani ottengono usando i principi della geometria euclidea.

Simile a quello dell’ottica è lo sviluppo iniziale del

magnetismo. Nell’antica Grecia è conosciuta la proprietà

della magnetite (un ossido di ferro bivalente e trivalente)

di attirare limatura e pezzetti di ferro. Tuttavia per lungo

tempo questa osservazione stimola solo fantasie magiche

e teorie animistiche del mondo, che prendono vigore a

seguito dell’introduzione, durante il Medioevo, delle

prime bussole provenienti dall’oriente. Analoga è la storia dell’elettricità, vocabolo che deriva dal nome greco

dell’ambra (una resina fossile). Tutto appartiene al regno

delle curiosità, e non serve per la descrizione del mondo.

Solo l’ottica “tecnica” ha, fino a tutto il Medioevo, un

qualche impatto sulla vita quotidiana.

La situazione cambia nel Rinascimento: l’ottica geometrica svolge un ruolo cruciale nelle arti figurative (prospettiva), la qualità degli strumenti ottici migliora, si

compiono importanti osservazioni sperimentali: oltre alla

riflessione e alla rifrazione, già sostanzialmente note, si

cominciano a studiare fenomeni che più avanti verranno

indicati come dispersione e diffrazione. Queste scoperte

portano a controversie (per esempio, teoria corpuscolare

della luce contro teoria ondulatoria) che movimentano fi-

nalmente il campo della “scienza dell’ottica”.

Più o meno contemporaneamente si incominciano a

definire, grazie allo sviluppo delle bussole, i concetti di

inclinazione e declinazione magnetica. All’inizio del

1600 viene pubblicato il De magnete di William Gilbert,

il quale riassume moltissime osservazioni e avanza ipotesi sul magnetismo, che oggi possono apparire fantasiose,

ma che hanno il merito di avviare un dibattito. Si conducono i primi esperimenti di elettrostatica e si introduce, in

forma confusa, il concetto di conduzione elettrica tramite

un “fluido” non identificato. Ma la descrizione fisica (o

filosofica) del mondo non sembra aver bisogno di questi

nuovi esperimenti. Le macchine elettrostatiche con le loro scintille, l’ago della bussola, i cannocchiali interessano

pochissimi specialisti mentre per il pubblico delle persone colte o curiose sono poco più che “divertissements”.

Anche in questo caso è l’incontro tra teoria ed esperimento che avvia lo sviluppo della scienza. La capacità

di Galileo di perfezionare il cannocchiale e di mescolare

teorie matematiche con “sensate esperienze” porta l’ottica nell’ambito della scienza. Si studiano teorie e si progettano strumenti conformi a tali teorie sia per vedere il

mondo sia per capirlo meglio. La vista non è più un senso

fallace (o, per lo meno, non più degli altri sensi), ma è

anzi talmente affidabile che Galileo, scoprendo i satelliti

di Giove grazie al suo cannocchiale, li battezzerà pianeti

“medicei”: nessuno avrebbe osato dedicare ai potentissimi signori di Firenze una scoperta che potesse avere anche la minima ombra di illusorietà!

L’ottica nel Seicento diviene una scienza, e le controversie sulla natura della luce non sono più dispute oziose,

ma tentativi di spiegare fenomeni finalmente ritenuti degni di essere interpretati. Tra il Seicento e il Settecento,

mentre Newton e Huygens spiegano la luce come corpuscoli luminiferi o come onda, gli strumenti ottici raggiungono prestazioni di ottimo livello nonostante le difficoltà

associate alla dispersione della luce. Sulla fine del Settecento si inventano gli obiettivi acromatici e i microscopi

composti, destinati a svolgere fino ai nostri giorni un ruolo importantissimo in molte branche della scienza.

Anche per l’elettricità e il magnetismo le innovazioni

cruciali dal punto di vista sperimentale avvengono a cavallo tra Seicento e Settecento. L’uso della bilancia di

torsione consente di ricavare espressioni quantitative per

le forze elettriche e magnetiche. Nasce la teoria delle

“masse magnetiche” e delle “cariche elettriche” newtoniane; infatti in entrambi i casi si osservano forze che variano in maniera inversamente proporzionale al quadrato

della distanza tra gli oggetti interagenti, confermando in

qualche modo un’interpretazione meccanica del mondo.

I percorsi della fisica 359

Nel Settecento gli apparati elettrici compaiono nel laboratorio di quasi ogni “fisico” e di molti “biologi”. Molte

osservazioni vengono organicamente inquadrate dalla

teoria del “fluido elettrico” di Benjamin Franklin, che

introduce la convenzione sui nomi delle cariche elettriche, distinte in positive (+) e negative (−).

Alla fine del Settecento gli studi di Galvani, sulla elettricità animale, e di Volta, sulla pila, utilizzano apparati sperimentali a volte sorprendentemente precisi e sensibili. La scuola italiana fornisce importantissimi contributi sperimentali e strumentali, ma il quadro interpretativo

generale rimane sempre quello di Newton, che nella sua

Ottica aveva offerto un esempio di come modelli meccanici potessero interpretare anche osservazioni di tipo fisiologico. Le esperienze decisive di Oersted sull’influenza delle correnti elettriche sull’ago di una bussola e

quelle successive di Faraday (correnti indotte dalle variazioni del campo magnetico) nel terzo decennio dell’Ottocento sono l’atto di nascita dell’elettromagnetismo, sul

quale gli sviluppi matematici di Ampère, fondatore

dell’elettrodinamica, e di Gauss stimolano un ampio dibattito entro una ormai fiorente comunità scientifica.

Spetta a Maxwell, qualche decennio più tardi, scrivere le

equazioni che codificano l’elettromagnetismo come branca della scienza che unifica i fenomeni elettrici e magnetici e mostrano come la luce altro non sia che un’onda elettromagnetica. Maxwell seguendo la teoria della luce di

Newton, pensa però ancora che un etere elastico sia

l’indispensabile supporto del fenomeno luminoso.

Nonostante questa successione di tappe concettualmente ben correlate, lo sviluppo ottocentesco dell’elettromagnetismo non è privo di contrasti. Si assiste, da una

parte, alla meccanizzazione dei fenomeni elettrici e magnetici: l’introduzione del concetto di potenziale (analogo al potenziale gravitazionale newtoniano) da parte di

Poisson e l’elettrodinamica di Ampère costituiscono tutto

sommato un’interpretazione newtoniana dei fenomeni elettrici e magnetici. Dall’altra, gli approcci di Oersted e

Faraday preludono alle teorie dei campi e sono da collegarsi a quel movimento di “elettrizzazione della meccanica” già presente in opere più antiche (già Gilbert nel suo

De Magnete pensa al magnetismo come a un fluido primario che permea tutto l’universo). Una conseguenza del

lavoro di Maxwell è però la fine delle teorie meccaniche

dell’etere, fluido impalpabile e imponderabile che, permeando l’universo, è il supporto meccanico per la propagazione degli effetti ottici, elettrici e magnetici. Con la

pubblicazione nel 1873 del Treatise on Electricity and

Magnetism (Trattato su elettricità e magnetismo) di Maxwell l’elettromagnetismo diventa una teoria scientifica

che interpreta disparati fenomeni e offre nuovi e fondamentali strumenti per lo studio della Natura.

Può sembrare strano che in questa storia dell’elettromagnetismo non si sia ancora parlato di macchine elettriche, soprattutto per noi che usiamo l’energia elettrica nella maggior parte delle nostre “macchine”. Siamo in presenza di un caso, anomalo rispetto a quello di meccanica

e termodinamica, in cui le scoperte teoriche sembrano

avvenire senza lo stimolo di applicazioni pratiche, che

seguono con rispettabile ritardo temporale. Non ci si rende conto subito delle potenzialità di sfruttamento tecnologico dell’elettromagnetismo, e soprattutto della facilità

di produzione, trasmissione e conversione dell’energia

elettrica. A Michael Faraday che annuncia, nel 1831, la

scoperta della legge d’induzione magnetica, un giornalista domanda che uso abbia la sua invenzione, sentendosi

rispondere “Non si chiede che uso abbia un bambino appena nato”.

Eppure proprio la scoperta dell’induzione elettromagnetica è l’elemento capace di spalancare la strada alla

produzione di elettricità su larga scala. Ma società e mercati occidentali, impegnati nella Rivoluzione Industriale,

non sembrano richiedere tali innovazioni. Si deve attendere circa mezzo secolo per assistere all’avvio della diffusione dell’energia elettrica, diffusione completata nel

Novecento da un ingresso delle applicazioni elettrotecniche nella vita quotidiana così massiccio da rendere le

tecnologie elettriche essenziali per il modo di vivere contemporaneo.

Per buona parte dell’Ottocento l’applicazione elettrica

principale è il telegrafo via filo, introdotto fin dal 1837

da Samuel F. B. Morse, che aveva tratto ispirazione dalle scoperte di Ampère. Antonio Pacinotti descrive la sua

dinamo (l’anello di Pacinotti) nel 1859, ma motori e generatori cominciano a diffondersi industrialmente solo

vent’anni più tardi: la prima centrale elettrica lombarda

(S. Radegonda in Milano) è del 1883. Un efficiente motore asincrono (motore a campo rotante funzionante in

corrente alternata) è costruito nel 1888 da Galileo Ferraris e, indipendentemente, da Nikola Tesla. Thomas

Alva Edison nel 1879 mostra con il bulbo elettrico

(lampada a filamento di bambù sotto vuoto) un modo efficiente per ottenere l’illuminazione elettrica. I primi esperimenti di radiotrasmissione (“telegrafia senza fili”)

sono compiuti da Guglielmo Marconi del 1895.

Si deve osservare, in questa breve storia, come l’Italia

del secondo Ottocento, marginale dal punto di vita economico e politico sugli scenari europei e coloniali, non

sia affatto provinciale nel settore dell’innovazione tecnologica.

360 Capitolo 16

16.4 I percorsi della fisica moderna

La fondazione, concentrata in pochi decenni, dell’intera

teoria dell’elettromagnetismo è il segno più evidente di

una brusca accelerazione dello sviluppo della fisica

nell’Ottocento. All’inizio del Novecento, con un ritmo

ancora più incalzante di scoperte sperimentali e teorie,

vengono posti in discussione e ridefiniti i principi generali della fisica. Ci si rende conto di entrare in una nuova

era e si comincia a parlare di fisica classica in opposizione a fisica moderna: Albert Einstein (1879-1955) fa da

elemento separatore, sia idealmente sia temporalmente,

tra queste due fisiche: può essere ugualmente considerato

l’erede di Newton e Maxwell e uno dei fondatori della fisica moderna. È però sbagliato affermare che all’inizio

del Novecento la fisica classica perda dignità e valore: si

diventa solo consapevoli dei limiti di alcuni suoi principi,

ritenuti per lungo tempo assoluti. Uno scopo di questa sezione è spiegare come questo cambio di prospettiva sia

avvenuto, come abbia assorbito i risultati della fisica

classica e come ci abbia trasmesso, assieme ad alcuni

problemi irrisolti, una certa fiducia nelle nostre capacità

di studiare i misteri della Natura.

16.4.1 Einstein e lo spazio-tempo

Fondamento concettuale della legge F = ma è il principio

di relatività classica, o galileiana, che nelle parole di

Newton suona così : “I moti di corpi compresi in un dato

spazio rimangono tra di loro gli stessi sia che lo spazio

sia fermo, sia che si muova uniformemente in linea retta”. In pratica, la velocità di un oggetto appare a un osservatore in moto come somma algebrica della velocità

propria e della velocità dell’oggetto in un comune sistema di riferimento. Se l’osservatore è in moto uniforme

nel sistema di riferimento, nel sistema “fisso” e in quello

mobile le accelerazioni, e quindi le forze, saranno sempre

le stesse.

La situazione è diversa per una carica elettrica in un

campo magnetico, perché in questo caso la forza sulla carica dipende dalla velocità. A differenza dell’equazione

di Newton, le equazioni di Maxwell non mantengono la

stessa forma quando si passa da un sistema di riferimento

a un altro in moto rettilineo uniforme rispetto al primo. Si

potrebbe allora intravedere la possibilità di individuare

un qualche sistema di riferimento in cui la forza sulla carica assume uno speciale valore. Ma nel 1887 l’esperimento di Michelson e Morley dimostra che la velocità

della luce è la stessa quando si propaga nella direzione

del moto attorno al Sole e in direzione opposta; come se

ciascun raggio portasse con sé il proprio “etere” personale in cui, si pensava, la luce si propaga. La storia di come

Lorentz ed Einstein lavorarono per risolvere il dissidio

tra impostazione di Newton e impostazione di Maxwell,

sempre più evidente sul finire dello scorso secolo, è stata

già raccontata nel Capitolo 11. Va qui sottolineato che la

soluzione oggi accettata, proposta da Einstein, ha avuto

una grande fortuna perché la sua relatività introduce postulati di natura fondamentale che consentono, con argomenti eleganti e in apparenza semplici, di dedurre le equazioni volute. Einstein ipotizza che la velocità della luce sia la stessa per ogni osservatore, che valga il principio

di equivalenza tra i riferimenti galileiani (o principio di

relatività) e valgano principi di conservazione, come

quello della quantità di moto e del momento della quantità di moto, che si possono collegare a proprietà intuitive

di uniformità e isotropia dello spazio. Ma per ottenere

questo bisogna rinunciare alla richiesta che tempi, distanze e masse abbiano un significato “assoluto” cioè indipendente dalla scelta del sistema di riferimento. Va reso

atto a Newton di aver capito che la sua meccanica richiedeva che tempo e spazio fossero assoluti e che su questo

punto non si dovevano fare questioni. Infatti così Newton

proclama nei suoi Philosophiae naturalis principia mathematica (1686): “Lo spazio assoluto, nella sua propria

natura, senza relazione ad alcunché di esterno, resta

sempre uguale e immoto. Il tempo assoluto, vero e matematico, di per se stesso e per la sua stessa natura,

scorre uniformemente senza relazione ad alcunché di esterno”. Nel 1905 sembra a Einstein che sia arrivato il

momento di enunciare nuovi postulati: lo fa con meno enfasi di Newton, ma con altrettanta decisione.

16.4.2 Le regole della meccanica quantistica

La teoria della relatività di Einstein potrebbe essere vista

come una precisazione di concetti di fisica classica, capaci di porre su basi non più contrastanti meccanica ed elettromagnetismo. A cavallo tra Ottocento e Novecento una

serie di esperimenti rivelano però fenomeni che fisica

classica e relatività non possono interpretare. Tutti questi

esperimenti indicano che alcune grandezze fisiche possono assumere solo una serie discreta di valori. L’unità minima di cui può variare una grandezza viene chiamata

quanto e da qui si sviluppa la teoria della meccanica

quantistica.

I percorsi della fisica 361

Lo spettro di emissione del corpo nero e

l’effetto fotoelettrico

Ogni oggetto emette continuamente radiazione elettromagnetica e assorbe la radiazione emessa dall’ambiente

circostante. La termodinamica descrive il bilancio energetico tra radiazione emessa e assorbita quando il corpo è

in equilibrio con l’ambiente. Una conseguenza è che se

l’ambiente è una cavità chiusa a temperatura T la radiazione in questa cavità, detta corpo nero, deve dipendere

solo da T e non dalla materia di cui è costituita. Applicando i principi della termodinamica e dell’elettromagnetismo alla radiazione in equilibrio con i dipoli elettrici

oscillanti, di cui si immagina siano costituite le pareti della cavità, è possibile calcolare lo spettro di emissione del

corpo nero, cioè la distribuzione della energia nella cavità in funzione della frequenza ν della radiazione. La densità di energia E(ν) rilevata sperimentalmente non si trova però in accordo con quella così calcolata.

Nel 1899 Max Planck avanzò l’ipotesi che per ogni

possibile frequenza di radiazione ν, l’energia presente

potesse assumere solo valori che sono multipli interi della

frequenza moltiplicata una costante, h, che fu chiamata

costante di Planck. Con questa ipotesi ad hoc Planck ottenne la distribuzione sperimentale della radiazione del

corpo nero.

Se per Planck i quanti di luce sono un’ipotesi di lavoro, per Einstein sono una realtà direttamente misurabile

mediante l’effetto fotoelettrico (vedi Capitolo 15): l’energia hν e la quantità di moto h/λ di un fotone intervengono nelle formule che descrivono gli urti proprio come intervengono energia e quantità di moto delle particelle materiali. I fotoni non sono un artificio, ma una proprietà

fondamentale del campo elettromagnetico.

Nuclei ed elettroni

Nel 1910 Ernst Rutherford trovò che la carica positiva

degli atomi è concentrata in un nucleo atomico con diametro di ~10−15 m, cioè centomila volte inferiore ai tipici

diametri atomici. L’esistenza di un centro di attrazione

“puntiforme” suggerisce di usare le stesse equazioni che

regolano il moto dei pianeti attorno al Sole per descrivere

il moto dell’elettrone attorno al nucleo (modello planetario dell’atomo). Un successo di questo modello è quello

di predire correttamente l’ordine di grandezza del potenziale di ionizzazione dell’idrogeno (13.6 V). Tuttavia,

mentre non vi è una legge della meccanica che impedisca

al pianeta di stare indefinitamente sulla sua orbita,

l’elettrone è una carica che dovrebbe emettere energia elettromagnetica quando accelerata e dovrebbe perciò precipitare sul nucleo in un tempo brevissimo (≈10−8 s). Altrettanto strano è il fatto che gli atomi assorbono ed emettono radiazione elettromagnetica solo ad alcune frequenze mentre classicamente ci si aspetterebbe che l’energia

scambiata possa variare in modo continuo.

Negli anni Venti si avanzano ipotesi per superare

queste difficoltà: Niels Bohr richiede che il momento angolare dell’elettrone assuma solo valori multipli interi di

h/2π (regola di quantizzazione) mentre Louis de Broglie

associa una lunghezza d’onda

λ=

h

mv

a una particella con quantità di moto mv. Come indicato

nel Capitolo 15, in ambedue i casi si riesce a rendere conto quantitativamente della natura discreta dello spettro di

emissione dell’idrogeno.

Il dualismo onda-corpuscolo

e il principio di indeterminazione

L’idea di Einstein di trattare la luce come costituita da

corpuscoli (i fotoni), quella di Louis de Broglie di pensare all’elettrone come un’onda e altre regole empiriche di

quantizzazione sono organizzate, sul finire degli anni

Venti, nella teoria della meccanica quantistica, che combina due entità, particelle e campi, che la fisica classica

teneva ben separate. Per la fisica classica la particella si

trova in un punto mentre il campo è una regione dello

spazio; per la meccanica quantistica tutto è costituito da

entità indivisibili, come le particelle, ma che vengono descritte da equazioni di campo le quali assomigliano alle

equazioni per le onde. Per la meccanica quantistica non è

corretto dire che l’elettrone si trova in un certo punto

dell’asse x con una certa velocità vx; tutto quello che possiamo dire è che l’elettrone è descritto da una funzione

d’onda che è la somma (al limite infinita) di onde semplici, a ciascuna delle quali corrisponde una “velocità”

v=

h

me λ

dove λ è la lunghezza d’onda di de Broglie. Perché l’elettrone sia in un intorno di un punto (per esempio x = 0 a

t = 0) occorre che la sua funzione d’onda si annulli quan-

362 Capitolo 16

do la coordinata x è al di fuori di questo intorno. Un’onda

semplice oscilla fino all’infinito e non gode di questa

proprietà. La somma di tante funzioni “coseno” con lunghezze d’onda differenti ha un valore elevato per x = 0 e

quasi nullo lontano da x = 0 in quanto i segni di tali funzioni sono sia positivi sia negativi e la loro somma è, in

genere, molto piccola. Ma questo vuole dire che

l’elettrone che si trova nell’intorno di un punto deve avere lunghezze d’onda diverse, cioè molte velocità. Per conoscere precisamente la posizione di un elettrone bisogna

perciò rinunciare a conoscere precisamente la sua velocità; viceversa, se l’elettrone è descritto da un’onda semplice (ossia da una sinusoide), esso ha una velocità perfettamente definita, ma è distribuito su tutto lo spazio.

Di solito si riesce a conoscere con una certa incertezza ∆x la posizione di una particella di massa m e con una

incertezza m∆vx la sua quantità di moto. Il principio di

indeterminazione di Heisenberg discende proprio dalla

natura “di onda” di ogni particella e stabilisce il seguente

legame tra queste due incertezze:

∆x m∆vx ≥

h

4π

Il ragionamento può essere ripetuto per la coordinata

tempo e l’energia della particella vista come un’onda,

E = hν. Se la particella si trova in una certa posizione al

tempo t = 0 la sua energia è completamente indeterminata, le incertezze sul tempo e sull’energia sono tra loro

collegate da una relazione analoga a quella “posizionequantità di moto”:

∆t∆E ≥

h

4π

16.2

La grandezza fondamentale è anche qui la costante di

Planck h che ha le dimensioni di [energia] × [tempo]. Il

suo “piccolo” valore (≈10−34 J⋅s) rende poco evidenti gli

effetti quantistici sulle scale “macroscopiche” dell’esperienza ordinaria. Per esempio, secondo la meccanica

quantistica, l’incertezza sulla posizione del centro di

massa di un insetto con m = 10−6 kg e v = (1 ± 0.01) m/s

è di solo ~5(10−27) m . Quando gli effetti del principio di

indeterminazione sono trascurabili, come in questo caso,

le predizioni della meccanica quantistica sono praticamente coincidenti con quelle della meccanica classica.

Come in maniera forse un po’ troppo semplicistica si

può dire che la relatività di Einstein permette di studiare

“oggetti molto veloci”, così si può dire che la meccanica

quantistica è una specie di ricetta che consente di applica-

re concetti della fisica classica, come energia e quantità

di moto, anche al mondo del “molto piccolo”. È in questo

senso che la fisica moderna può essere considerata una

generalizzazione della fisica classica.

16.5 La fisica finirà?

Si racconta che Alessandro Magno giunto all’Indo pianse

perché si rese conto che il grande fiume segnava la fine

della sua stupefacente campagna di conquista dell’Oriente. Per analogia, lo sviluppo della fisica può essere pensato come la conquista di un territorio compreso tra scale di

tempo e di spazio sempre più estese. Si è iniziato scoprendo le leggi di quella parte dell’universo che cade sotto l’osservazione visiva diretta, da stelle distanti migliaia

di anni luce a corpuscoli submillimetrici. Con stru-menti

che estendono i nostri sensi si sono poi scoperte galassie

lontane miliardi d’anni luce, gli atomi, e le particelle che

lo costituiscono. Ora, però, si trova che le scale delle osservazioni, tanto nel tempo quanto nello spazio, hanno

limiti naturali, inavvicinabili nel prevedibile futuro, ma al

di là dei quali non è logico estendere le leggi valide per le

scale di spazio e tempo oggi accessibili. Attraverso questo metaforico “Indo” si riesce per ora solo a spingere la

navicella della fantasia.

Democrito di Abdera, filosofo greco del V secolo

a.C., fece in un certo senso ciò che molti fisici hanno poi

ripetuto innumerevoli volte: modificare una teoria per tenere conto di osservazioni sperimentali. La teoria è quella

di Parmenide ed esprime l’esigenza logica che esista una

sola entità, immutabile, mai creata e senza fine, conoscibile solo mediante il pensiero. Noi però vediamo che tutto è in mutamento: perciò Democrito ipotizza che il mondo percepito dai sensi sia costituito da “atomi”, letteralmente “particelle indivisibili”, immutabili ed eterne per

definizione, che costituiscono l’essenza dell’universo. I

cambiamenti sono dovuti al combinarsi in modi differenti

dei diversi tipi di atomi.

La storia della fisica può essere anche vista come la

ricerca di questo oggetto primordiale indivisibile da cui

tutto scaturisce. Si è cercato questo oggetto, ma si sono

finora trovate interazioni, cioè forze.

1.

La forza di gravità è debole ma onnipresente; i suoi

effetti si manifestano quando si ha l’azione combinata di un gran numero di atomi. La gravità lega le stelle in galassie, mantiene il Sole intero, la sua famiglia

di pianeti nelle loro orbite, gli oceani al loro posto. È

I percorsi della fisica 363

2.

3.

4.

l’interazione di gran lunga predominante su distanze

cosmiche, fino alla dimensione dell’Uni-verso

(~1026 m).

Quando si arriva a corpi con dimensioni dell’ordine

del chilometro, la forza principale diventa la forza

elettromagnetica: è ciò che fa crescere un albero,

esplodere un vulcano e che detta le leggi con cui avvengono le reazioni chimiche. La teoria di Maxwell

rispetta, fin dalla nascita, i principi della relatività di

Einstein. Il campo di Maxwell ha dovuto essere poi

quantizzato, ma questa operazione, in genere, non fa

male neppure agli studenti che la devono spiegare

durante un esame. La chimica è una disciplina “chiusa” nel senso che non vi è più niente di fondamentale

da scoprire nel legame chimico, anche se può essere

molto complesso affrontare dai principi primi persino la descrizione di molecole semplici.

A distanze dell’ordine di 10−15 m la forza elettromagnetica cede all’interazione forte. È la forza che

mantiene i protoni e neutroni dentro il nucleo atomico e tiene assieme i quark che formano neutroni e

protoni.

Su distanze ancora più piccole, dell’ordine di

10−19 m, dominano le interazioni deboli che provocano la disintegrazione spontanea di talune particelle

e nuclei. Queste distanze segnano all’incirca il limite

che i più potenti acceleratori d’oggi riescono a studiare: alle energie di 2(1012) eV (elettronvolt) si

hanno le particelle W e Z che sono cento milioni di

volte più piccole dell’atomo.

Sulle scale di distanze a cui dominano le interazioni deboli, forti ed elettromagnetiche la meccanica quantistica

regna incontrastata. Negli ultimi vent’anni si è affermato

un punto di vista che coglie un aspetto unitario di queste

tre interazioni: tutte si realizzano mediante lo scambio di

quanti di energia chiamati fotoni per l’elettromagnetismo,

gluoni per l’interazione forte e bosoni vettoriali intermedi

per l’interazione debole. Si pensa oggi che queste tre forze siano una manifestazione di un’unica interazione che

dovrebbe manifestarsi a distanze dell’ordine di 10−31 m,

cioè mille miliardi di volte minori della più piccola particella conosciuta. Queste distanze non sono accessibili

all’osservazione diretta, ma vi è fiducia di arrivare a provare indirettamente le ipotesi sulla forza unica.

I problemi nascono alle distanze ancora minori, dove

la stessa scala delle distanze sembra finire. Dal punto di

vista intuitivo, più riduciamo le dimensioni di una “scatola” in cui confiniamo una particella, più la sua frequenza

e quindi la sua energia e massa aumentano, fino a creare

un minuscolo buco nero. Infatti alla distanza di

Planck(☯) di circa 10−35 m torna a dominare la gravità.

Ai fisici piacerebbe applicare anche in questo caso la regola di quantizzazione che sembra funzionare così bene

con le altre interazioni. Ma la ricetta per quantizzare il

campo gravitazionale non è stata ancora trovata. La difficoltà nasce dal fatto che la gravità è indissolubilmente legata alla geometria dello spazio, il che comporta problemi formali che sembrano al momento insormontabili. Alcuni fisici cercano di ridefinire il problema ispirandosi a

risultati delle geometrie moderne. Altri capovolgono la

questione e ipotizzano che il costituente fondamentale

dell’universo sia una superstringa, un oggetto “grande”

come la distanza di Planck, così chiamato perché in esso

è “raggomitolato” uno spazio a sei dimensioni, che si aggiungono alle tre dimensioni dello spazio ordinario. Infatti, solo con nove dimensioni sembra sia possibile sviluppare un modello che abbia senso fisico. Dalla superstringa dovrebbero discendere in modo naturale tutte le proprietà delle interazioni note, gravità compresa.

La conclusione è che la fisica si trova a un punto cruciale della sua evoluzione; se riesce a unificare tutte le

forze note, “scopre” un’entità primordiale che sta alla base di tutto quanto vi è nell’universo e oltre la quale sembra difficile spingersi. Molti credono che l’unificazione

avverrà presto e che questo risultato rappresenterà il successo più grande della meccanica quantistica, cioè di una

“ricetta” che finora non ci ha ancora deluso. In tal caso la

fisica diventerebbe una disciplina chiusa, come la chimica. Altri credono che il procedimento sarà lungo e che

forse non potremo mai scoprire “l’atomo di Parmenide”.

Ma forse la questione sulla fine della fisica va proposta in

(☯) L’energia potenziale di un punto materiale di massa dm

a una distanza r da un punto materiale di massa M è −GMdm/r.

Imponendo che dmc2 sia al più la metà di questa energia cambiata di segno, si trova il cosiddetto raggio di Schwarzschild,

RS, ossia il raggio di un buco nero di massa M:

RS = 2GM / c2

In una regione di dimensioni dell'ordine di RS, per la 16.2 le

fluttuazioni di energia ∆E sono dell'ordine di

∆E ≈ hc / 2 RS

Imponendo Mc2 =∆E, RS diventa uguale alla distanza di

Planck, dove le oscillazioni di energia del vuoto quantico sono

così intense da creare buchi neri virtuali:

RS ≈

Gh

c3

≈ 10 −35 m = distanza di Planck

364 Capitolo 16

termini ancora differenti, che tengano conto del ruolo

dell’uomo.

16.5.1 Un volo di fantasia

Dal “Big Bang” in poi, la storia del nostro Universo è

stata determinata dai valori di poche costanti fisiche quali

carica e massa dell’elettrone, velocità della luce. Se, per

esempio, la costante della legge di gravitazione G fosse

stata anche di poco superiore al valore oggi noto, si sarebbero formate stelle più calde delle attuali, che si sarebbero consumate prima che su un pianeta come il nostro potessero realizzarsi le condizioni necessarie alla vita. Se G fosse stata inferiore, l’idrogeno primordiale non

si sarebbe mai compresso al punto da avviare le reazioni

di formazione dei nuclei pesanti, e vi sarebbero scuri

ammassi di gas al posto di stelle luminose. In pratica,

l’Universo è quello che è proprio perché noi esistiamo. È

questo un enunciato del principio antropico (per taluni

punto di partenza irrinunciabile, per altri affermazione totalmente priva di significato scientifico) che ricolloca

l’uomo al centro di un universo la cui finalità sembrerebbe proprio essere quella di consentire la vita biologica.

Quando notiamo ammirati che nella realizzazione di

un organismo, o una sua parte, la Natura sembra aver

compiuto una catena di scelte geniali e lungimiranti, invochiamo di solito l’evoluzione, ossia un processo di selezione tra individui differenti che conduce via via a migliori funzionalità (Charles Robert Darwin). Qualcuno,

come Edward R. Harrison (un cosmologo della Università del Massachusetts) combina evoluzione e principio antropico immaginando che sia possibile controllare le fluttuazioni di vuoto alla distanza di Planck in modo da generare un universo con le costanti fisiche volute. Ogni universo nasce e muore, ma potrebbe riprodursi qualora

realizzasse una vita intelligente capace di intervenire sulle “fluttuazioni di vuoto” che avvengono alle distanze di

Planck. L’universo figlio vivrebbe in un spazio diverso

da quello del genitore, e incomunicabile con questo; tale

universo sarebbe un ramo morto se la scelta delle costanti

fosse sbagliata; sarebbe un ramo fecondo se la scelta delle costanti fisiche fosse a sua volta compatibile con lo

sviluppo di forme di vita intelligenti. Si immagina che

l’insieme degli universi occupi un “iperspazio” in cui ogni universo sia come un foglio di una grande risma di

carta.

Se in tutto questo c’è qualcosa di profetico, la “fine”

della fisica significa solamente l’esaurimento della rivoluzione copernicana, una corrente di pensiero che ha tolto

all’uomo il suo posto privilegiato al centro del creato per

relegarlo in un punto, neppure molto centrale, di una galassia con miliardi di stelle posta in un universo con miliardi di galassie. Ma con la forza del pensiero ormai abbracciamo quasi del tutto questo universo. Arriviamo ora

a chiederci se l’Universo sia una gabbia invalicabile o se

uscire da questa gabbia sia il nostro destino e la nostra

missione o il risultato di un fantastico intreccio di caso e

necessità.

16.5.2 Civiltà ed evoluzione

La specie umana ha un’età di circa duecentomila anni e la

sua affermazione è stata preceduta, o accompagnata, da

vari tentativi (per esempio, l’uomo di Neandertal) che

non sembrano aver lasciato traccia sul nostro patrimonio

genetico. Nonostante questo, noi sembriamo ben inseriti

nel percorso evoluzionistico della biologia terrestre. Tuttavia, da almeno diecimila anni, da quando si crede abbiano avuto inizio le civiltà, lo sviluppo evoluzionistico

della specie umana si è praticamente arrestato. Si potrebbe dire che abbiamo iniziato a modificare l’ambiente per

evitare di modificare noi stessi.

La nascita della civiltà, ossia del “vivere in città”,

sembra legata all’affermarsi di una agricoltura e una pastorizia in grado di produrre più del necessario per sopravvivere. Nella breve storia delle civiltà umane oggi

note vi sono stati frequenti e dolorosi cambi delle strutture sociali e produttive, accompagnati da guerre e cataclismi naturali, che hanno avuto l’effetto di mantenere sempre elevatissimo il ritmo evolutivo delle civilizzazioni.

Sembra si stia oggi consolidando sull’intero pianeta

un modello di civiltà che non sembra aver l’equivalente

nel passato, né in termini di estensione geografica, né nella capacità di modificare l’ambiente. Le domande sul futuro di questa civiltà e del nostro ecosistema sembrano

molto più impellenti, per la nostra sorte di individui, di

quelle su origine e destino degli universi.

16.6 L’organizzazione della ricerca

La professione del fisico e i suoi legami con tecnica e società hanno subìto in questo secolo importanti cambiamenti. Innanzitutto, il formalismo della fisica diventa così

complesso che dilettanti geniali hanno oggi poche probabilità di dare contributi paragonabili a quelli di Thomas

Young (1773-1829, ottica e meccanica) e di Julius R. von

I percorsi della fisica 365

Mayer (1814-1878, termodinamica), entrambi medici

professionisti e fisici dilettanti. Anche l’attività sperimentale non è più un hobby dell’aristocrazia, come nel Settecento e, in parte, nell’Ottocento. Dopo la Seconda Guerra

Mondiale quasi tutti gli stati formano o ampliano agenzie

di ricerca senza fini bellici (in Italia: INFN, CNR,

ENEA) che contribuiscono a creare rapidamente una ampia classe di ricercatori pubblici e docenti universitari perennemente assetati di finanziamenti. La funzione di

promozione e divulgazione dei club elitari, spesso raccolti attorno alle storiche Accademie e Società Scientifiche,

si esaurisce. Le riviste scientifiche a diffusione internazionale si moltiplicano in modo impressionante e il costo

del mantenimento della biblioteca diventa un problema

anche per gli istituti più ricchi e dedicati a tematiche specialistiche.

La grande espansione e democratizzazione della ricerca degli ultimi decenni è stata resa possibile dai costanti guadagni di produttività del mondo occidentale e

dagli elevati tassi di sviluppo delle nazioni emergenti.

Mentre i fattori sociali e politici di questi fenomeni sono

variegati, l’elemento tecnologico è comune a tutto il

mondo: nella prima metà del Novecento fisica, chimica e

ingegneria si alleano per tradurre in beni e servizi le

grandi scoperte scientifiche. Poi, nel clima di ottimismo

generato dalla fine della Seconda Guerra Mondiale e dai

successi dei maggiori settori industriali (aerei, dispositivi

elettronici, materie plastiche, antibiotici), si instaura una

bonaria competizione tra Stati, competizione che conta

tra le sue motivazioni anche l’orgoglio e il prestigio nazionale. Paradossalmente, questo massiccio intervento

pubblico ha come effetto quello di indebolire il legame

tra ricerca e società: si tendono a creare iperspecializzazioni e si hanno difficoltà di comunicazione persino tra

settori affini, occupati spesso in un controllo geloso del

proprio “territorio”.

La ricaduta tecnologica diretta (introiti per brevetti)

della ricerca pubblica è modestissima, soprattutto in Europa, nonostante il denaro pubblico non trascuri affatto i

settori con le più grandi potenzialità applicative. Ma la

resa scientifica è nel complesso proporzionata allo sforzo

economico. Il resoconto dei lavori viene pubblicato dai

giornali scientifici, quasi esclusivamente in lingua inglese, diventando un patrimonio a cui tutti possono accedere. Il controllo sulla qualità dei lavori è svolto da “arbitri”

(referees) scelti dagli editori tra i migliori esperti del settore. Il sistema di comunicazione è aperto, libero ed efficiente; il lavoro dei referees è per lo più onesto e, quel

che più conta, il sistema funziona. Il maggiore stimolo

del ricercatore è proprio la competizione con i colleghi

dello stesso campo per trovare spazio sui giornali più

prestigiosi. Non solo vi è una “hit-parade” ufficiale delle

riviste e degli autori di maggior successo, ma le classifiche di questa “hit-parade” giocano un ruolo sempre più

importante nella assegnazione di finanziamenti, nuovi

posti e promozioni.

Si assiste a una esplosione delle conoscenze scientifiche umane che, secondo uno studio, oggi raddoppiano in

media ogni sette anni. L’offerta di conoscenza supera di

gran lunga la capacità di sfruttamento da parte della tecnologia e di utilizzo da parte del sistema produttivo. Per

quello che riguarda la fisica, tra gli anni Quaranta e Ottanta viene svolto un lavoro enorme, e spesso poco glorioso, per sistemare molti campi (per esempio, la scienza

dei materiali). Vengono inoltre risolti grandi problemi riguardanti l’astrofisica e le interazioni fondamentali.

Sembra però che la maggior parte dei fisici sia intenta a

digerire e articolare meccanica quantistica e relatività;

molti fisici avvertono un’atmosfera di relativa stasi e si

dedicano ad altro, alle scienze biologiche in particolare.

La situazione sociale e scientifica cambia a metà degli

anni Novanta. L’ottimismo postbellico lascia il posto a

inquietudini per il futuro e alla sensazione che le società

postindustriali non siano più in grado di mantenere certe

aree di privilegio. In particolare, sembra in via di lenta

estinzione la classe “sacerdotale” della ricerca pubblica,

quella almeno senza doveri e con privilegi garantiti. Nella ricerca pubblica i posti di lavoro permanenti sono offerti sempre più di rado e le fonti tradizionali di finanziamento (Governo e sue agenzie) tendono a ridursi, tanto in Europa quanto negli Stati Uniti.

Le risorse complessivamente dedicate alla ricerca però sono in crescita perché in parte vengono amministrate

da organismi transnazionali (come l’Unione Europea), o

vanno a grossi laboratori internazionali (come il CERN) e

a “centri di eccellenza”. Si cerca così di razionalizzare

gradualmente il finanziamento del progresso scientifico,

riconoscendo che questa impresa riguarda l’intera umanità, e non il prestigio di un singolo paese.

Benché nominalmente in clima di libero mercato, Stati singoli e comunità di Stati attuano politiche protezionistiche verso settori strategici mediante contributi a fondo

perduto alla ricerca industriale e allo sviluppo tecnologico. Inoltre, in settori con elevati livelli di competitività,

quale quello elettronico, è tipico investire una grossa parte dei ricavi, dell’ordine del 10%, in ricerca e sviluppo.

Queste sfide competitive impiegano una popolazione crescente di ricercatori che, a differenza del passato, hanno

ridottissima libertà di iniziativa e poche motivazioni, e

ancor meno possibilità, di dedicarsi a progetti difficili ma

366 Capitolo 16

gloriosi.

In questo clima in apparenza poco propizio, la fisica

sta dando segni di rinnovata vitalità: nuovi esperimenti

mettono in dubbio il senso del valore limite invalicabile

della velocità della luce e indagano i significati reconditi

delle regole della meccanica quantistica. Ci si pongono in

termini matematici e operativi questioni dal sapore filosofico. Cosa è il vuoto, il tempo, lo spazio, la materia? Cosa

è l’equilibrio? Il tempo ha un inizio e una fine o è circolare? Che mondo c’è in un punto piccolo ai limiti di ciò

che è immaginabile? Come può l’estremamente piccolo

determinare la struttura dell’Universo? Come è nato

l’Universo e come evolverà? Come si possono descrivere

in un solo modo tutte le forze oggi conosciute? Come si

può scegliere tra teorie contrastanti quando la via sperimentale sembra impraticabile?