Reti di funzioni di base radiali

(Reti RBF)

² Problema di interpolazione

² Reti RBF di regolarizzazione

² Reti RBF generalizzate

² Addestramento di reti RBF

² Tecniche di decomposizione

² Metodi di decomposizione per reti RBF

1

Problema di interpolazione

Le \Radial Basis Functions" (RBF) sono

state introdotte per risolvere problemi di interpolazione multidimensionali (Davis, 1963).

Dato un insieme di P punti

fxp 2 RM ; p = 1; : : : ; P g

e P numeri reali fdp 2 R; p = 1; : : : ; P g, determinare una funzione y : RM ! R che soddis¯

la condizione di interpolazione

y(xp) = dp

p = 1; : : : ; P:

La tecnica di interpolazione RBF consiste

nel rappresentare y come combinazione lineare

di P funzioni di base che dipendono dalla distanza kx ¡ xpk, ossia

y(x) =

P

X

p=1

wpÁ(kx ¡ xpk):

2

I coe±cienti wp 2 R si dicono pesi e i punti

xp 2 RM (dati) si dicono centri

Esempi di funzioni di base Á

- gaussiana

Ã

Á(r) = exp ¡

r2

2¾2

!

con

¾ > 0;

con

¾ > 0;

- multiquadrica inversa

µ

¶1=2

1

Á(r) = 2

r + ¾2

- multiquadrica

Á(r) = (r2 + ¾ 2)1=2

con

¾ > 0;

dove r ¸ 0.

La gaussiana e la multiquadrica inversa sono

funzioni localizzate (Á(r) ! 0 per r ! 1),

mentre la funzione multiquadrica µ

e non locale

(Á(r) ! 1 per r ! 1).

3

Utilizzando la condizione di interpolazione

y(xp) = dp

p = 1; : : : ; P

si ottiene il sistema lineare in w

©w = d;

dove © µ

e la matrice P £ P con elementi

Áji = Á(kxj ¡ xik):

La matrice © µ

e la matrice di interpolazione.

Teorema 1 (Micchelli, 86) Esiste una classe

C di funzioni di base tale che, se i punti di

interpolazione x1; : : : ; xP 2 RM sono distinti,

per ogni Á 2 C la corrispondente matrice di

interpolazione © µ

e non singolare.

La classe di funzioni C include la gaussiana e

le multiquadriche.

La matrice © µ

e anche de¯nita positiva per la

gaussiana e la multiquadrica inversa

(Powell, '88)

4

Reti RBF di regolarizzazione

Sia f : RM ! R una funzione incognita da

approssimare, utilizzando dei dati consistenti

in un insieme di coppie (training set)

T S = f(xp; dp) 2 RM £ R; p = 1; : : : P g;

in cui dp = f (xp):

Il problema µ

e in genere, mal posto. La Teoria della regolarizzazione (Tikhonov, 1963)

si basa sulla de¯nizione di un'approssimazione

di f , attraverso la minimizzazione in uno spazio

di funzioni (L2) di un funzionale del tipo:

E(y) = E1(y) + E2(y);

in cui

P

1 X

[dp ¡ y(xp)]2;

E1 (y) =

2 p=1

1

E2 (y) = ¸kDyk2;

2

dove ¸ > 0 µ

e il parametro di regolarizzazione

e D µ

e un operatore di®erenziale.

5

Il primo termine

P

1 X

E1 (y) =

[dp ¡ y(xp)]2;

2 p=1

misura la distanza della funzione approssimante

dai dati del training set; il secondo termine

1

¸kDyk2;

2

penalizza la violazione di condizioni di regolaritµ

a su f (si puµ

o assumere, ad esempio, che

f sia su±cientemente \smooth").

E2 (y) =

Il parametro ¸ pesa l'importanza relativa che

viene attribuita ai dati o alle ipotesi a priori

sulla regolaritµ

a della funzione.

Si dimostra (Poggio e Girosi, 1990) che,

sotto opportune ipotesi su D, la funzione che

minimizza il funzionale E(y) µ

e del tipo:

y¸(x) =

P

X

wiÁ(kx ¡ xik);

i=1

R+ µ

e

una funzione radiale e

in cui: Á : R+ !

w 2 RP µ

e soluzione del sistema lineare

(© + ¸I)w = d:

6

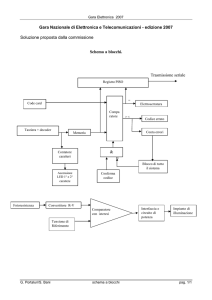

I risultati precedenti possono essere interpretati de¯nendo delle reti, dette reti RBF di

regolarizzazione, che sono reti feedforward

con le seguenti caratteristiche:

- presentano un solo strato nascosto;

- i neuroni dello strato nascosto sono unitµ

a

di calcolo che hanno come funzione di attivazione una funzione di base

- il numero di neuroni dello strato nascosto µ

e

pari al numero P degli elementi del Training

Set;

- il neurone dello strato d'uscita e®ettua una

combinazione lineare delle uscite dei neuroni dello strato nascosto.

7

Le reti RBF di regolarizzazione sono approssimatori universali e vale il teorema seguente,

che segue da un risultato piµ

u generale (Poggio

e Girosi, 1990)

Teorema 2 Comunque si ¯ssi un ² > 0 e si

scelga una funzione continua f de¯nita su un

sottoinsieme compatto − di RM , esiste una

funzione

y(x) =

P

X

i=1

wiÁ(kx ¡ xik);

dove Á µ

e una RBF, tale che per ogni x 2 −

risulta

jf (x) ¡ y(x)j < ²:

Le reti RBF di regolarizzazione presentano anche la proprietµ

a di approssimazione ottima,

nel senso che, per un valore ¯ssato di P ,

esistono parametri w che minimizzano l'errore

di approssimazione (segue dalla linearitµ

a).

8

Reti RBF generalizzate

Le reti RBF generalizzate (GRBF) si basano

su un'approssimazione del tipo:

y(x) =

N

X

i=1

wiÁ(kx ¡ cik);

in cui:

- il numero N di neuroni µ

e minore o eguale al

numero P degli elementi del Training Set;

- i centri ci 2 RM non coincidono necessariamente con i vettori xi del Training Set

Anche tali reti, che includono come caso particolare le reti regolarizzate, sono approssimatori

universali.

In pratica il numero di neuroni N µ

e molto inferiore al numero di elementi del training set P

e devono essere determinati sia i centri che i

pesi.

9

Addestramento di reti RBF

Dato il training set

T S = f(xp; dp) 2 RM £ R; p = 1; : : : P g;

si consideri una rete GRBF con N centri

y(x; w; C) =

N

X

i=1

wiÁ(kx ¡ Cik);

dove C µ

e il vettore dei centri.

La funzione d'errore (da minimizzare) si puµ

o

assumere della forma

P

1 X

E(w; C) =

[dp ¡ y(xp; w; C)]2

2 p=1

+½1kwk2 + ½2kCk2;

dove compaiono eventuali ulteriori termini di

regolarizzazione.

La rete deve essere addestrata con tecniche

supervisionate rispetto ai pesi . Per quanto

riguarda i centri, esistono due strategie:

² scelta non supervisionata dei centri

² addestramento supervisionato rispetto ai

centri

10

Nell'addestramento non supervisionato rispetto

ai centri, i vettori ci posono essere scelti

{ casualmente tra i vettori di ingresso del

training set

{ con tecniche di clustering.

I pesi w sono determinati con metodi (diretti o

iterativi) per problemi di minimi quadrati lineari. I metodi diretti sono utilizzabili, in pratica, ¯no a valori di N dell'ordine del migliaio. I

metodi iterativi possono essere basati su tecniche tipo gradiente coniugato.

(La matrice Hessiana µ

e de¯nita positiva in presenza di termini di regolarizzazione).

Nell'addestramento supervisionato rispetto a

centri e pesi occore utilizzare metodi di

ottimizzazione non lineare.

Alcuni esperimenti e confronti hanno mostrato

che i risultati migliori, in termini di capacitµ

a di

generalizzazione, si ottengono con addestramento supervisionato dei centri.

Il problema di calcolo puµ

o essere tuttavia dif¯cile. Risulta utile l'impiego di tecniche di

decomposizione.

11

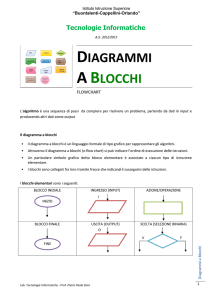

Tecniche di decomposizione

Consideriamo un problema del tipo:

min

©(y):

y 2 RN

Le tecniche di decomposizione rispetto alle variabili possono essere descritte partizionando il

vettore y in m · N vettori componenti yi 2

RNi , ossia

y = (y1; : : : ; yi; : : : ; ym )

e quindi e®ettuando, per ogni i, un' operazione

elementare Ti che associa a y la componente

i-ma aggiornata Ti(yk ).

Per poter stabilire risultati di convergenza

occorre imporre opportune condizioni su Ti e

garantire che tutte le componenti siano considerate, attraverso regole appropriate sulla

composizione delle operazioni elementari .

12

Condizioni su Ti ¤

Sia fy k g una successione assegnata. Allora:

A) per ogni k si ha:

k

©(y1k ; : : : ; Ti(y k ); : : : ; ym

) · ©(y k )

e tale che

B) se fy k g converge a y¹ ed µ

k ) ! 0;

©(y k ) ¡ ©(y1k ; : : : ; Ti(yk ); : : : ; ym

si ha:

y) = 0

(b1) ri©(¹

(b2) Se m > 2 allora kTi(yk ) ¡ yik k ! 0

(ri© µ

e il gradiente parziale rispetto a yi).

La condizione (b2) puµ

o essere sostituita da

opportune ipotesi di convessitµ

a su ©.

¤ (Grippo

e Sciandrone, OMS 1999)

13

In uno schema di composizione sequenziale ,

o essere realizzata,

la trasformazione Ti(yk ) puµ

per ogni i:

² attraverso la minimizzazione globale rispetto

a yi ( metodo Gauss-Seidel a blocchi )

k ):

yik+1 = Argmin» ©(y1k+1; ::; »; ::ym

² attraverso un algoritmo di discesa a blocchi

(line-search lungo una direzione gradientrelated rispetto al gradiente parziale ri©k ):

yik+1 = yik + ®ki dki :

Nel caso del metodo GS a blocchi la

convergenza puµ

o essere dimostrata:¤

(i) m = 2 (decomposizione in 2 blocchi)

(ii) m > 2 e © pseudoconvessa

(iii) m > 2 e © strettamente quasi-convessa

rispetto a yi per i = 1; : : : ; m ¡ 2

(quando le altre componenti sono ¯ssate).

¤ (Grippo

e Sciandrone, Op.Res.Letters,2000)

14

Controesempio di Powell :

Il metodo Gauss-Seidel puµ

o non convergere in

problemi in cui:

² m¸3

² ©µ

e una funzione non convessa

² © non µ

e strettamente convessa per

componenti.

(la sola convessitµ

a per componenti non µ

e suf¯ciente a garantire la convergenza)

Il controesempio si applica, in particolare, al

\metodo delle coordinate".

Un algoritmo \a blocchi" puµ

o ciclare, generando

punti limite che non sono punti stazionari.

15

Nel caso di metodi di discesa a blocchi le

limitazioni del metodo GS possono essere superate, anche in assenza di convessitµ

a, e la

convergenza puµ

o essere assicurata utilizzando,

sequenzialmente per ogni componente

² direzioni gradient-related rispetto ai

gradienti parziali, ad esempio

k

dki = ¡ri©(y1k+1; ::; yik ; ::ym

);

² una line search opportuna :

- se m = 2 µ

e utilizzabile un metodo standard tipo-Armijo

- se m > 2 deve essere anche soddisfatta

la condizione

kTi(y k ) ¡ yik k ! 0

Si possono usare condizioni di accettabilitµ

a

del tipo:

©(: : : ; yi + ®idi; : : :) · ©(y) ¡ °i®i2 kdik2:

16

(Proximal GS method)

Una modi¯ca del metodo GS a blocchi puµ

o

essere basata sull'iterazione:

k

yik+1 = arg min ©(y1k+1; ::; »; ::; ym

)+¿i=2k»¡yik k2

»

per ¿i > 0.

Se la minimizzazione µ

e ben de¯nita e la successione ha punti limite,

allora

ogni punto limite µ

e un punto stazionario di ©,

anche se © µ

e non convessa e m > 2

17

Metodi di decomposizione per reti RBF ¤

Sui risultati di convergenza dei metodi di decomposizione si possono basare tecniche di addestramento per reti RBF generalizzate, per

minimizzare la funzione d'errore

P

N

X

1 X

E(w; C) =

[dp ¡

wiÁ(kx ¡ Cik)]2

2 p=1

i=1

+½1kwk2 + ½2kCk2;

che:

{ µ

e strettamente convessa (e quadratica) rispetto

a w 2 RM per C 2 RN M ¯ssato

{ ha insiemi di livello compatti.

Due schemi di decomposizione sono particolarmente signi¯cativi:

² decomposizione nei 2 blocchi pesi/centri

² decomposizione negli N + 1 blocchi:

w e Ci, per i = 1; : : : ; N.

¤ Buzzi,

Grippo e Sciandrone,Neural Computation

2001

18

Algoritmo di decomposizione in 2 blocchi

Dati Scegli i centri iniziali C 0

Passo 0 Poni k = 0

Passo 1 Calcola

wk+1 = Argminw E(w; C k );

risolvendo il problema di minimi quadrati

(lineare) in w (con centri ¯ssati),

Passo 2. Se rC E(wk+1; C k ) = 0 stop;

altrimenti

1) assumi dk = ¡rC E(wk+1 ; C k );

2) calcola ®k con una linesearch tipo-Armijo

3) scegli qualsiasi C k+1 tale che

E(wk+1; C k+1) · E(wk+1; C k + ®k dk ):

Passo 3 . Poni k = k + 1 e ritorna al Passo 1

19

Vale il risultato seguente

Teorema 3 Se la linesearch soddisfa

condizioni di convergenza (A) (B), allora

le

f(wk ; C k )g ha punti di accumulazione

fE(wk ; C k )g converge

e

Ogni punto di accumulazione di f(wk ; C k )g µ

un punto stazionario di E

Se il numero di centri µ

e elevato la minimizzazione rispetto a C puµ

o essere di±cile.

Si puµ

o e®ettuare una decomposizione anche

rispetto ai singoli centri. In tal caso, per la convergenza, deve essere assicurata la condizione

kCik+1 ¡ Cik k ! 0:

20

Algoritmo in N + 1 blocchi

Dati C 0, ¿i > 0, »ik ! 0

Passo 0 Poni k = 0

Passo 1 Calcola

wk+1 = Argminw E(w; C k );

Passo 2. Per i = 1; : : : ; N :

Se krCi E(wk+1; C k )k · »ik poni Cik+1 = Cik ;

altrimenti

a) assumi dki = ¡rCi E k ;

b) calcola ®ki con una linesearch che soddis¯

le condizioni di convergenza (A)(B)

c) scegli Cik+1 tale che

E(wk+1; ::; Cik+1; ::) ·

E(wk+1; ::; Cik + ®ki dki ; ::) ¡ ¿ikCik+1 ¡ Cik k2;

oppure assumi

Cik+1 = Cik + ®ki dki

Passo 3 . Poni k = k + 1 e ritorna al Passo 1

21

Vale il risultato seguente

Teorema 4 Se la linesearch soddisfa

condizioni di convergenza (A) (B), allora

le

i)f(wk ; C k )g ha punti di accumulazione

ii)kwk+1 ¡ wk k ! 0

iii) Per i = 1; : : : N si ha kCik+1 ¡ Cik k ! 0

iv) fE(wk ; C k )g converge

v) Ogni punto di accumulazione di f(wk ; C k )g

µ

e un punto stazionario di E

L'algoritmo ha dato buoni risultati su problemi

test di addestramento e risulta piµ

u e±ciente

di un algoritmo Quasi-Newton per la minimizzazione rispetto a w; C anche per dimensioni

non elevate

22

Ricerca in corso

² Uso di metodi iterativi per risolvere il

problema di minimi quadrati nell'ambito

degli schemi di decomposizione

² Utilizzazione di metodi non monotoni

nella fase di minimizzazione rispetto ai

centri

² Estensione delle tecniche di decomposizione all'addestramento di reti multistrato con 1 o 2 strati nascosti

² Studio degli aspetti \globali" dei metodi

di decomposizione

23