ISTITUTO SUPERIORE “Giulio Natta” – Bergamo

Esami Di Stato 2014

Alunno: Brambillasca Filippo

Classe 5°D L.S.T.

Anno Scolastico 2013/2014

Il Cervello

Materie Trattate:

Biologia – Il Cervello

Fisica – Campo Magnetico e MEG

Informatica – Intelligenza Artificiale e Watson (IBM)

Filosofia – Intelligenza Artificiale

1

Il cervello è l'organo principale del sistema nervoso centrale, presente nei vertebrati e in tutti gli

animali a simmetria bilaterale, compreso l'uomo. Nei vertebrati il cervello è situato all'apice del

nevrasse, all'interno del cranio. Il termine corretto per indicare l'insieme delle strutture contenute

all'interno della scatola cranica è encefalo, di cui il cervello è una parte. Il cervello si occupa,

insieme al sistema endocrino, di parte della regolazione delle funzioni vitali ed è sede delle

regolazioni omeostatiche e delle funzioni

cerebrali superiori. Nell'uomo l'attività del

cervello, studiato a livello empirico dalle

neuroscienze, dà vita alla mente con le sue

funzioni cognitive superiori e più in generale

alla psiche con le sue funzioni psichiche,

studiate nell'ambito della psicologia.

Il Cervello Umano

L'encefalo è quella parte del sistema

nervoso centrale completamente contenuta

nella scatola cranica e divisa dal midollo spinale. Dal punto di vista embriologico, l'encefalo si

sviluppa da tre vescicole del primitivo tubo neurale: il prosencefalo, che evolve in telencefalo e

diencefalo, il mesencefalo e il romboencefalo, da cui originano bulbo, ponte e cervelletto.

Anatomicamente, quindi, l'encefalo è costituito dal cervello (diviso in telencefalo e diencefalo), dal

tronco encefalico (le cui parti sono mesencefalo, ponte e bulbo) e dal cervelletto.

Struttura

L'encefalo è costituito dalle seguenti porzioni:

Telencefalo:

Il Telencefalo è la parte più sviluppata del cervello umano ed è quella che assolve alle funzioni più

complesse come il linguaggio, i movimenti volontari, l'apprendimento e la soluzione di problemi. È

diviso da una profonda fessura in due emisferi cerebrali. I due emisferi comunicano attraverso un

grosso fascio di fibre nervose: il corpo calloso, e, attraverso fasci più piccoli di fibre: la commissura

anteriore e l'ippocampo. Gli emisferi sono costituiti all'interno da una sostanza bianca, da una

massa grigia alla base (corpo striato) e da una sostanza grigia che li riveste: la corteccia cerebrale.

L'emisfero destro controlla la parte sinistra del corpo, mentre l'emisfero sinistro controlla la parte

destra.

2

Diencefalo

Il Diencefalo è posto internamente alla sostanza bianca telencefalica, è costituito da cinque

porzioni (talamo, epitalamo, metatalamo, ipotalamo, subtalamo) ed è in continuazione

inferiormente con il mesencefalo tramite i due peduncoli cerebrali. Come già detto, i diencefalo

contiene al suo interno la cavità del terzo ventricolo, che permette di suddividere con un piano

sagittale l'intera struttura in due metà pari e simmetriche. Ciascuna di queste due metà può essere

ulteriormente suddivisa in una porzione ventrale ed in una dorsale, grazie all'esistenza di un solco

che attraversa in senso trasversale tutta la cavità del terzo ventricolo, e che viene denominato

solco ipotalamico.

La porzione ventrale, ossia quella parte di diencefalo che rimane al di sotto di tale solco,

comprende:

l'ipotalamo, comprende numerosi nuclei che attivano, controllano e integrano i

meccanismi autonomici periferici, l'attività endocrina e molte funzioni somatiche quali la

termoregolazione, il sonno, il bilancio idro-salino e l'assunzione del cibo;

il subtalamo pari e simmetrico, localizzato lateralmente all'ipotalamo da ciascun lato, che

contiene una serie di formazioni grigie e bianche in diretta continuazione con il

mesencefalo sottostante.

La porzione dorsale, ossia quella che rimane al di sopra del solco ipotalamico, comprende invece:

il talamo, la porzione più voluminosa del diencefalo, a cui sono assegnate importantissime

funzioni di ricezione e ritrasmissione delle informazioni a provenienza sia periferica che

centrale;

l'epitalamo, in posizione arretrata rispetto al talamo. Ha una funzione strettamente

olfattiva. Ha un ruolo anche nella produzione di liquido cerebrospinale, assunzione di

acqua e cibo e nel controllo dei comportamenti ritmici e stagionali.;

il metatalamo, situato posterolateralmente rispetto al talamo e comprendente solo i corpi

genicolati mediali e laterali.

Cervelletto

La porzione situata nella fossa cranica posteriore; è coinvolta nell'apprendimento e nel controllo

motorio, nel linguaggio, nell'attenzione e forse in alcune funzioni emotive come risposte alla paura

o al piacere. Le connessioni con il sistema limbico gli permettono di intervenire anche nei processi

di memorizzazione e apprendimento, potendo così parlare di cervelletto cognitivo

3

Tronco Encefalico

Il Tronco Encefalico è funzionalmente connesso con il cervelletto ed è costituito a sua volta da tre

porzioni (mesencefalo, ponte e bulbo). È sede:

dei riflessi e del controllo di molti visceri;

dei centri che regolano il respiro partono i segnali che garantiscono gli automatismi

respiratori;dei centri che regolano la temperatura corporea partono i segnali che

mantengono costante la temperatura in modo da permettere tutti i processi biologici e

chimici indispensabili per la vita;

Circolazione sanguigna.

Il cervello è costituito da due emisferi caratterizzati da solchi e circonvoluzioni, a determinate aree

si possono assegnare il controllo di funzioni quali la vista, nel lobo occipitale, l'udito, nel lobo

temporale, le attività del pensiero, associazione, memoria, anteriormente, nel lobo frontale, e la

motricità e la sensibilità, superiormente al centro, nel lobo parietale.

Esistono dunque un'area motoria e un'area sensitiva

per ciascun emisfero che controllano il lato opposto

del corpo; il comando, infatti, parte dalle cellule

motorie piramidali, percorre, sotto forma di impulso

elettrico, le fibre corrispondenti che a un certo punto

del tronco encefalico (nel bulbo, detto anche midollo

allungato perché costituisce il primo prolungamento

del midollo all'interno del cranio) si incrociano per

passare nel midollo spinale dal lato opposto,

In rosso il tronco encefalico, in giallo il diencefalo, in beige il

telencefalo; annesso si vede il cervelletto

raggiunto quindi il neurone che si trova all'incirca

all'altezza del muscolo che si deve contrarre,

fuoriesce dal midollo attraverso i nervi spinali, i quali si assottigliano e ramificano sempre più fino

a diventare fibra che si collega ad una fibra muscolare, mediante una giunzione detta appunto

sinapsi neuro-muscolare, qui l'arrivo dell'impulso determina la contrazione.

Sicché l'emisfero destro controlla la parte sinistra del corpo e viceversa.

L'impulso nervoso è una variazione di potenziale elettrico a cui si associano anche fenomeni

chimici: infatti l'arrivo dell'impulso alla giunzione neuro-muscolare (detta anche placca motrice)

determina la liberazione dell'acetilcolina, nello spazio intermedio tra le fibre e quindi degli ioni

calcio, responsabili dell'aggancio tra i filamenti delle fibre muscolari, e così il muscolo si contrae.

All'interno del muscolo, dei tendini e delle articolazioni vi sono dei recettori collegati con delle

fibre, mediante cui vengono registrati il grado di tensione delle fibre, il grado di apertura delle

articolazioni e quindi la posizione dei nostri segmenti corporei nello spazio, sempre sotto forma di

4

impulsi che vengono trasmessi al cervello seguendo esattamente il percorso inverso a quello della

via motoria. Allora abbiamo una via motoria, discendente, dal cervello ai muscoli, e una via

sensitiva, ascendente, dai muscoli al cervello.

Sitografia

http://it.wikipedia.org/wiki/Encefalo

http://digilander.libero.it/paxiol/SNCeAPPRENDIMENTO.htm

5

CAMPO MAGNETICO

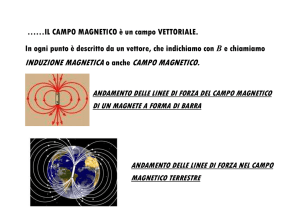

In fisica, in particolare nel magnetismo, il campo magnetico è un campo vettoriale solenoidale generato

nello spazio dal moto di una carica elettrica o da un campo elettrico variabile nel tempo.

Per riuscire a visualizzare il campo magnetico, rappresentato con il simbolo , si sparge della limatura B

ferro molto fine su una superficie liscia. Mettendo una sottile lastra di vetro

o di plastica sopra una barra magnetica e cospargendola di limatura di ferro,

possiamo osservare che la limatura si allinea al campo magnetico,

visualizzando chiaramente il campo prodotto dal magnete. La limatura di

ferro si va ad accumulare ai poli del magnete, dove il campo magnetico è più

intenso così da poter visualizzare le linee del campo magnetico.

Allontanandosi dal magnete in una direzione qualsiasi il campo si indebolisce,

come è indicato dalla minore densità delle linee. Perciò associamo l’intensita

del vettore

alla separazione delle linee del campo.

Al campo magnetico si può associare anche un verso. Il verso del campo

magnetico

in un dato punto è dato dal verso nel quale punta il polo nord

dell’ago di una bussola posta in quel punto. Le linee del campo magnetico

escono dal polo nord di un magnete ed entrano nel polo sud.

Figura 1: Il campo magnetico di una

barretta di metallo può essere

visualizzato. La limatura si orienta

seguendo le linee del campo magnetico

Intensita Della Forza Magnetica

1.

2.

3.

4.

Una particella di carica q si muove in questa regione con una velocita v,

formando un’angolo θ tra v e . Sperimentalmente possiamo

osservare che la forza F cui è soggetta la particella ha un’intensità pari

a:

| |

Nel SI la forza viene calcolata in N (Newton 1 Kg = 9,81 N).

Figura 2: Linee del campo magnetico

Come osservato dalla formula usata per ricavare l’intensità di una

forza magnetica possiamo dedurre che essa dipenda da diversi fattori:

La carica q della particella;

L’intensità del campo data dal campo magnetico ;

La velocità della particella;

L’ampiezza dell’angolo θ tra il vettore velocità ed il vettore campo magnetico.

Se si vuole che il campo magnetico eserciti una forza su una particella questa deve avere una carica e deve

essere in movimento. Nonostante vengano rispettate questa due condizioni non è detta che il campo

6

magnetico eserciti una forza. Se l’angolo θ tra i vettori velocità e campo magnetico corrisponde a 0° (la

particella si muove nella stessa direzione del campo) o a 180° (la particella si muove nella direzione opposta

del campo) la forza si annulla. La massima forza si otterrà quando l’angolo θ sarà di 90°.

Intensita Del Campo Magnetico

| |

L’unità di misura di B sono quelle di una forza divisa per il prodotto di una carica per una velocità,

cioè

⁄

. Possiamo scrivere quest’unità di misura anche come

⁄ , troviamo che

⁄

e infine sapendo che

. L’ultima combinazione di unità di misura è chiamata Tesla, in

onore dell’ingegnere serbo Nikola Tesla (1856-1943).

1 Tesla = 1 T =

⁄

Siccome il Tesla è un’unità di misura molto grande per esprimere l’intensità di un campo

magnetico si utilizza come unità di misura il Gauss nonostante questo non faccia parte delle unità

di misura del Sistema Internazionale.

1 Gauss = 1 G = 10-4 T

Forza Magnetica E Regola Della Mano Destra

Consideriamo la direzione della forza magnetica, le cui proprietà sono alquanto interessanti e

inaspettate. Invece di puntare nella direzione del campo magnetico o della velocità v, come ci si

potrebbe aspettare, si osserva che la forza magnetica F punta in una direzione perpendicolare sia

a che a v.

Per determinare il verso della forza magnetica su una carica

positiva si inizia puntando le dita della mano destra nella direzione

della velocità v. Successivamente si ruotano le sita nella direzione

di . Il pollice punterà nella direzione della forza magnetica F. Se

la carica è negativa la forza punta nel verso opposto a quello del

pollice.

Figura 3a: Regola Della Mano Destra (carica

positiva)

Figura 3b: Regola Della Mano Destra

(carica negativa)

7

Moto Di Particelle Cariche In Un Campo Magnetico

Analizziamo il moto di una particella carica che entra in una regione in cui è presente un campo

magnetico. Prendendo come esempio un campo magnetico uniforme e diretto verso il basso. La

regola della mano destra indica che F punta verso l’interno: la nostra particella inizia a seguire una

traiettoria orizzontale diretta verso l’interno. Se la particella si muove in un campo magnetico, su

di essa non viene compiuto alcun lavoro, dal momento che la forza magnetica è sempre

perpendicolare alla direzione del moro; perciò il modulo della velocità della particella nel campo

magnetico rimane costante.

La Forza Magnetica Esercitata Su Un Filo Percorso Da Corrente

Una particella carica che si muove in un campo magnetico è soggetta a una forza. Un filo percorso

da una corrente sarà soggetto alla risultante delle forze agenti

sulle singole cariche in movimento che costituiscono la corrente.

Consideriamo un segmento di filo rettilineo di lunghezza L, con

una corrente I che scorre da sinistra a destra. Nella stessa regione

di spazio è presente anche un campo magnetico B che forma un

angolo θ con il filo. Se le cariche si muovono nel filo con una

velocità media v, il tempo necessario perché esse si spostino da

un estremo all’altro del filo è

. La quantità di carica che

passa nel filo in questo tempo è

esercitata sul filo è quindi:

. La forza

( )

Figura 4: Forza Magnetica In Un Filo

.

Semplificando v, otteniamo che l’intensità della forza ce si esercita su un segmento di filo di

lunghezza L percorso da una corrente I che orma un angolo θ con un campo magnetico B è:

Spire Di Corrente E Momento Torcente Magnetico

Il fatto che un filo percorso da una corrente sia soggetto a una forza quando è immerso in un

campo magnetico è una delle coperte fondamentali che ha reso possibile lo sfruttamento

dell’energia elettrica. Nella maggior parte delle applicazioni moderne il filo va a formare una spira.

8

Spira Rettangolare

Consideriamo una spira rettangolare di altezza a e larghezza b, percorsa da una corrente I. La spira

è immersa in un campo magnetico uniforme B parallelo al piano

della spira. I segmenti verticali sono perpendicolari a B e sono

soggetti a una forza di intensità

. La forza sul lato sinistro

punta verso l’interno e quella sul lato destro verso l’esterno. Se

immaginiamo un asse di rotazione passente per il centro della

spira, nel punto O, le forze esercitano un momento torcente che

tende a far ruotare la spira in senso orario. L’intensità del

momento torcente per ciascun segmento verticale è data dal

Figura 5: Spira Rettangolare

prodotto della forza

per il braccio d/2. Il momento

torcente totale è semplicemente la somma dei momenti prodotti da

ciascun segmento:

(

)( )

(

)( )

(

). Se

osserviamo che l’area della spira è data da

, possiamo

esprimere il momento torcente con:

.

Quando la spira inizia a ruotare le forze hanno la stessa intensità ma il

braccio è ( ⁄ )

Figura 6: Momento Torcente Della

Spira Rettangolare

quindi il momento torcente è:

Viene rappresentato nel SI con l’unità Newton per Metri (N m)

Spira Generica

La stessa relazione rappresentate precedentemente con la spira rettangolare può essere estesa a

tutte le spire piane. In molte applicazioni si desidera produrre il massimo momento possibile. Un

modo semplice per aumentare il momento è quello di arrotolare lungo un filo intorno a una spira

N volte, creando una spira di N avvolgimenti. Ogni avvolgimento produce il momento di una spira

singola.

Correnti Elettriche, Campi Magnetici E Legge Di Ampere

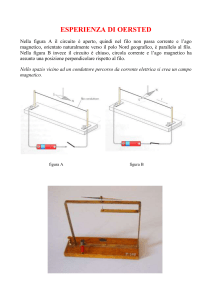

Nel 1820 Hans Christian Oersted scoprì accidentalmente una relazione tra l’elettricità ed il

magnetismo. Oersted stava tenendo una conferenza sui vari aspetti della scienza quando, ad un

certo punto, chiuse un interruttore e fece scorrere la corrente in un filo. Noto così che in

9

corrispondenza della chiusura dell’interruttore, l’ago di una bussola che si trovava nelle vicinanze

del filo deviava dalla sua orientazione abituale. Oersted aveva appena scoperto che le correnti

elettriche possono creare campi magnetici.

Corrente In Un Lungo Filo Rettilineo

Consideriamo un filo infinitamente lungo nel quale scorre una

corrente I. Per visualizzare il campo magnetico prodotto da un filo

del genere spargiamo della limatura di ferro su un foglio di carta

attraversata dal filo. La limatura di ferro forma dei cerchi

concentrici centrati nel filo. Dall’esperienza si può dedurre che il

campo magnetico “circola” intorno al filo. Per determinare la

direzione del campo dobbiamo ricorrere alla regola della mano

destra in riferimento al campo magnetico.

Figura 7: La limatura di ferro si orienta andando

a formare dei cerchi concentrici

Per determinare la direzione e il verso del campo magnetico generato da un filo percorso da

corrente puntiamo il pollice della mano destra lungo il filo nel verso della corrente I. Le dita

ruotano intorno al filo nel verso del campo magnetico.

Figura 8: Regola della mano destra in

riferimento al campo magnetico

Legge Di Ampere

La legge di Ampere lega il campo magnetico lungo un percorso chiuso alla corrente elettrica

concatenata con tale percorso. Questi fili sono concatenati dal percorso chiuso P, che può essere

suddiviso in tanti piccoli segmenti rettilinei di lunghezza ΔL. Per ciascuno di questi segmenti, si può

scomporre il campo magnetico in una componente parallela al segmento, B//, e in una

perpendicolare, B . Secondo la legge di Ampere, la somma dei B//ΔL estesa a tutti i segmenti che

formano il percorso chiuso è uguale al prodotto di una costante per la corrente concatenata con il

percorso stesso

∑

In questa espressione,

0

0 è una costante chiamata permeabilità

magnetica del vuoto. Il suo valore è:

(T x m)/A

10

Applichiamo la legge di Ampere caso di un lungo filo rettilineo percorso dalla corrente I. Dato che il

campo magnetico è parallelo all cammino circolare in ogni punto e tutti i punti sono alla stessa

distanza dal filo, sia ha che

B costante. Perciò sommando

lungo tutto il percorso chiuso

si ottiene

∑

∑

(

)

Per la legge di Ampere tale somma deve essere uguale a

(

. Perciò abbiamo:

)

Esplicitando B:

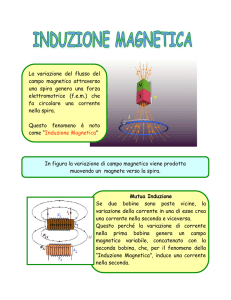

MAGNETOENCEFALOGRAFIA (MEG)

La magnetoencefalografia è una tecnica di imaging biomedico

funzionale utilizzata nella neurologia, che si basa sulla

misurazione dei campi magnetici prodotti dall'attività

elettromagnetica dell'encefalo. Viene usata per valutare le

fluttuazioni del campo magnetico che l'organismo produce,

studia dunque la funzionalità cerebrale tramite la misura di

tale campo magnetico generato dall'attività elettrica cerebrale,

fornendo ottimi risultati. Viene utilizzata da tempo come

strumento diagnostico per l'epilessia. Riesce ad essere

utilizzato anche nei disturbi uditivi, stimolando la corteccia

uditiva ed a far percepire dei toni.

La magnetoencefalografia (MEG) è una tecnica a immagini

elaborate dalla misura dei campi magnetici prodotti

dall'attività elettrica del cervello per mezzo di dispositivi

altamente sensibili come i superconducting quantum

interference devices (SQUIDs). . Uno SQUID (Superconduttore ad interferenza quantica) consiste in

una spirale superconduttiva immersa nell’elio liquido. L’elio liquido è a circa -269°C così da creare

una ridottissima resistenza elettrica nella spirale. Lo SQUID rileva il campo magnetico indotto dalle

correnti elettriche celebrali e lo trasforma in un segnale elettrico. Queste immagini vengono usate

11

comunemente sia in ambito clinico che di ricerca per molteplici scopi. In chirurgia, ad esempio, per

la localizzazione di una patologia, nella ricerca, per determinare la funzione della varie parti del

cervello, neurofeedback, ed altro.

Il MEG (acronimo di Magneto-Encefalo-Grafia) è stato utilizzato

per la prima volta da David Cohen nel 1968, prima che venisse

utilizzato lo SQUID, utilizzando unicamente una bobina ad

induzione di rame come rivelatore. Per ridurre il disturbo

magnetico di fondo, le misure vennero effettuate in una camera

magneticamente schermata. Tuttavia, la scarsa sensibilità di

questo rivelatore ebbe come risultato segnali MEG scadenti e

disturbati, che erano di difficile utilizzo. In seguito, all'MIT

(Massachussetts Institute of Technology), costruì una camera schermata migliore, e utilizzò uno

dei primi rivelatori SQUID (appena sviluppato da James E. Zimmerman, un ricercatore per la Ford

Motor Company) per misurare di nuovo la MEG. Questa volta i segnali erano chiari quanto quelli di

un'EEG (Elettroencefalografia), e stimolò l'interesse dei fisici che avevano iniziato a cercare i

possibili utilizzi degli SQUID. Perciò, la MEG iniziò ad essere utilizzata, così che diverse tipologie di

MEG spontanee ed evocate incominciarono ad essere misurate.

All'inizio solamente un unico rivelatore SQUID era utilizzato, per misurare successivamente il

campo magnetico in un numero di punti attorno alla testa del soggetto. Ciò era lento e scomodo e

negli anni ottanta, i costruttori di MEG incominciarono ad aumentare il numero di sensori nel vaso

di Dewar[1], per coprire un'area più vasta della testa, utilizzando parallelamente un vaso di Dewar

più grande. Le MEG attuali hanno forma di casco e contengono fino a 300 sensori, coprendo la

maggior parte della testa. In questo

modo, le MEG di un soggetto o di un

paziente ora possono essere

accumulate in maniera rapida ed

efficiente.

La letteratura del campo, anche

italiana, ha esposto i limiti di tale

esame, osservando come vi siano dei

disturbi che possono influenzare il

risultato alterandolo, come i

movimenti dell'occhio, i segnali

cardiaci e le contrazioni muscolari.

Poiché i segnali magnetici emessi dal

cervello sono dell'ordine di pochi femtotesla (1 fT =

T), risulta necessaria la schermatura dai

segnali magnetici esterni, incluso il campo magnetico terrestre. Una schermatura magnetica

appropriata può essere ottenuta costruendo camere in alluminio e mu-metal per ridurre

rispettivamente i disturbi ad alta frequenza e a bassa frequenza.

12

Da Maggio 2009 un sistema MEG a 306 canali è installato presso il Centro Interdipartimentale

Mente e Cervello dell’Università di Trento. Il sistema permette la registrazione simultanea MEG e

EEG. L’EEG può essere misurato anche con 128 elettrodi. Il laboratorio dispone di strumentazione

per la stimolazione visiva, uditiva, tattile e elettrica che permette un ampia gamma di esperimenti

neuroscientifici. E’ disponibile anche un sistema di Eye-tracking per misurare le posizioni delle

fissazioni oculari, contemporaneamente alla registrazione dell’attività cerebrale. Il sistema MEG

può essere usato sia in posizione seduta che supina.

E’ inoltre possibile la coregistrazione con i risultati di “imaging” anatomici e funzionali di MRI e

TMS.

Dall’inaugurazione del laboratorio sono stati condotti vari esperimenti. Le aree di ricerca

includono la formazione di concetti mentali, processamento linguistico, integrazione

sensomotoria, interazione interemisferica e meccanismi neuronali di percezione.

[1] Un vaso di Dewar o semplicemente dewar è un contenitore che mantiene il suo contenuto isolato

dell'ambiente esterno frapponendo con l'esterno delle aree di vuoto che consentono un isolamento

termico tra il contenuto e l'ambiente. Il vuoto è usato solo per l'isolamento termico, il contenuto non è

sotto vuoto.

Bibliografia:

Walker J., Corso di FISICA, Milano-Torino, Pearson Italia, 2010

Sitografia:

http://servizi.psice.unibo.it/uploads/luci_zwrbwszevvpivgnultmobvurazkvhk.pdf

http://web.unitn.it/cimec/10907/laboratorio-magnetoencefalografia

http://it.wikipedia.org/wiki/Magnetoencefalografia

http://it.wikipedia.org/wiki/Vaso_di_Dewar

13

Intelligenza Artificiale

Con il termine intelligenza artificiale (o IA, dalle iniziali delle due parole, in italiano) si intende

generalmente l'abilità di un computer di svolgere funzioni e ragionamenti tipici della mente

umana. L'intelligenza artificiale è una disciplina dibattuta tra scienziati e filosofi, la quale manifesta

aspetti sia teorici che pratici. Nel suo aspetto puramente informatico, essa comprende la teoria e

le tecniche per lo sviluppo di algoritmi che consentano alle macchine (tipicamente ai calcolatori) di

mostrare un'abilità e/o attività intelligente, almeno in domini specifici. Uno dei problemi principali

dell'intelligenza artificiale è quello di dare una definizione formale delle funzioni

sintetiche/astratte di ragionamento, metaragionamento e apprendimento dell'uomo.

I Primi Passi

In tal senso la storia ha inizio nel XVII secolo

quando Blaise Pascal (scienziato, scrittore e

filosofo francese) inventa la cosiddetta

"Pascalina" per aiutare il padre, incaricato

dall'amministrazione fiscale della Normandia di

eseguire un difficile lavoro di calcolo. La

macchina era capace di eseguire

automaticamente addizione e sottrazione; questa "macchina aritmetica" fu la capostipite dei

calcolatori ad ingranaggi.

La Rivoluzione Informatica

Se la teoria dell'IA evolve indipendentemente dai progressi scientifici, le sue applicazioni sono

fortemente legate agli avanzamenti della tecnologia informatica. Infatti, solo nella seconda metà

del XX secolo è possibile disporre di dispositivi di calcolo e linguaggi di programmazione

abbastanza potenti da permettere sperimentazioni sull'intelligenza.

La struttura dei calcolatori viene stravolta con la sostituzione dei "relè", usati per i primi calcolatori

elettromeccanici, con le "valvole" o tubi elettronici. Nel 1946 nasce ENIAC (Electronic Numerical

Integrator And Calculator), concepito come calcolatore moderno nel '45 da John von Neumann;

faceva l'elaborazione a lotti (batch) nell'ordine di migliaia di informazioni al minuto. La

programmazione avveniva comunque tramite schede.

14

La seconda generazione di computer si ha nei '60, "The time sharing", sistemi basati sulla divisione

di tempo e quindi più veloci; più terminali, soprattutto telescriventi, sono collegati ad un

calcolatore centrale". L'innovazione in questo periodo sta nel passaggio dalle valvole ai transistor.

A quell'epoca i programmi erano fortemente condizionati dai limiti dei linguaggi di

programmazione, oltre che dai limiti di velocità e memoria degli elaboratori. La svolta si ha proprio

tra gli anni '50 e '60, con linguaggi di manipolazione simbolica come l'ILP, il Lisp e il POP.

Il Punto Di Svolta

Un punto di svolta della materia si ha con un famoso articolo di Alan Turing sulla rivista Mind nel

1950. Nell'articolo viene indicata la possibilità di creare un programma al fine di far comportare un

computer in maniera intelligente. Quindi la progettazione di

macchine intelligenti dipende fortemente dalle possibilità di

rappresentazione simbolica del problema.

Il test di Turing - così viene chiamata la condizione che la

macchina dovrebbe superare per essere considerata intelligente

- è stato più volte superato da programmi e più volte

riformulato, tanto che queste teorie hanno ricevuto diverse

confutazioni. Il filosofo Searle ne espose una famosa, chiamata

"la stanza cinese".

Nello stesso anno dell'articolo di Turing sull'omonimo test per le

macchine pensanti, Arthur Samuel presenta il primo programma

capace di giocare a Dama, un risultato molto importante perché

dimostra la possibilità di superare i limiti tecnici (il programma

era scritto in Assembly e girava su un IBM 704) per realizzare sistemi capaci di risolvere problemi

tradizionalmente legati all'intelligenza umana. Per di più, l'abilità di gioco viene appresa dal

programma scontrandosi con avversari umani.

Nel 1956, alla conferenza di Dartmouth (la stessa conferenza a cui l'IA deve il suo nome), viene

mostrato un programma che segna un'altra importante tappa dello sviluppo dell'IA. Il programma

LT di Allen Newell, J. Clifford Shaw e Herb Simon rappresenta il primo dimostratore automatico di

teoremi

Verso L'IA Moderna

I primi anni settanta vedono lo sviluppo dei sistemi di produzione, ossia dei programmi che

sfruttano un insieme di conoscenze organizzate in base di dati, attraverso l'applicazione di regole

di produzione, per ottenere risposte a domande precise. I sistemi esperti hanno sostituito i sistemi

di produzione per via delle difficoltà incontrate da questi ultimi, con particolare riferimento alla

necessità di fornire inizialmente la conoscenza in forma esplicita e la poca flessibilità delle regole

di produzione. Questi sistemi, di cui Dendral è il più rappresentativo, mostrano le enormi

possibilità offerte da un efficace sfruttamento di (relativamente) poche basi di conoscenza per

15

programmi capaci di prendere decisioni o fornire avvisi in molte aree diverse. In pratica l'analisi dei

dati è stata razionalizzata e generalizzata.

IBM : Watson

Watson può pensare: parola di IBM. Il cognitive computing è il prossimo obiettivo che il settore si

è posto e Watson è un passo importante nella direzione di una migliore “intelligenza artificiale”. Il

progetto prende il nome da Thomas Watson, fondatore del gruppo, la cui impronta sull’azienda

era quella di anticipare i tempi, invece di subirli:

È politica di questa compagnia non essere mai soddisfatta di quel che abbiamo, ma sempre

anticipare le esigenze del futuro.

Cosa è Watson?

Watson è un progetto nato in seno al

gruppo IBM e focalizzato sulla creazione di

una intelligenza artificiale in grado di

gestire grandi quantità di dati non

strutturati per sublimare tale ricchezza in

valore vero: informazioni strutturate prima

e decisioni poi.

Watson nasce come ecosistema, ossia

sotto le sembianze di una piattaforma alla

quale in molti potranno accedere per dar vita alle proprie idee. Quel che IBM vuol mettere a punto

è una capacità che si fa sistema, e tale capacità si avvicina molto all’idea che si ha di “pensiero”. La

concentrazione di tante funzioni e tante capacità all’interno di una stessa entità, però, costringe

giocoforza anche a una rimodulazione degli equilibri fin qui esistiti tra uomo e macchina: la

relazione viene ad assumere forme nuove, poiché un maggior potere vien messo nelle mani del

computing, ma al tempo stesso l’uomo viene ad avere un ruolo fondamentale nella definizione dei

problemi prima e nella fase decisionale poi. Vada sé, infatti, che soltanto a fronte di un input ben

formato si possa pensare di restituire un output soddisfacente: la «santa alleanza» tra uomo e

macchina prende forma sotto il vessillo di Watson nella convinzione per cui il cognitive computing

possa fare molto per estrapolare informazioni “pure” all’interno di un bacino non-strutturato di

informazioni.

Come funziona Watson?

Il funzionamento di Watson è stato annunciato ai media e ai Chief Information Officer italiani nel

contesto di un workshop organizzato da Eni in collaborazione con IBM. L’interesse di Eni su

Watson è legato alla possibilità di gestire in modo più efficiente tanto la moltitudine dei dati

raccolti durante le analisi antecedenti gli scavi per le estrazioni, quanto per gestire in modo

16

migliore l’enorme mole di comunicazioni e dati interne all’azienda. I processi attraverso i quali

prende forma il “pensiero” di Watson sono 4:

Analisi della domanda, affinché sia ben formata e interpretabile;

Il testo viene ricollegato alla conoscenza esistente, disambinguandone il significato a

partire dal contesto individuato;

Vengono estratte relazioni dal testo (ad oggi Watson ne contempla circa 7000) per

approfondire la comprensione dello stesso;

Acquisizione di informazioni dal testo, aumentando così la base di conoscenza sulla quale

verrà formato il processo di comprensione successivo: di fatto la macchina è in grado di

imparare.

IBM precisa come, sebbene in apparenza tutto ciò sia quanto posto normalmente in essere dai

motori di ricerca, in realtà Watson sia in grado di andare oltre. Primo, perché sa cercare in

database come all’interno di panieri non strutturati di informazioni; secondo, perché sa

interpretare (oltre che individuare) entità, ontologie e conoscenza. Il processo passa prima per

l’analisi del testo, quindi per l’interpretazione dello stesso, fino ad arrivare ad un alto numero di

ipotesi. Il peso statistico delle risposte stesse determina la formazione delle evidenze tra le quali si

sceglierà la risposta. Tanto in entrata quanto in uscita, la comunicazione tra uomo e macchina

avviene con le regole del linguaggio naturale: Watson nasce in lingua inglese, ma gli adattamenti

ad altre lingue andranno di pari passo con le applicazioni che sorgeranno nei vari territori attorno

al sistema IBM.

IBM e Watson

IBM non ha fretta. Così come il codice a barre ci ha impiegato 15 anni ad essere capito e adottato,

arrivando poi a penetrare il mercato con capillarità, anche Watson necessita del tempo necessario

affinché il suo ruolo possa essere interiorizzato dai CIO e dagli sviluppatori, ma poi diventerà un

valore irrinunciabile. IBM ci crede a fondo, ipotizzando per Watson un ruolo da “browser” della

rete del futuro, un passaggio fondamentale per

l’organizzazione e il reperimento delle informazioni.

Watson nasce all’interno di IBM, ma il gruppo ha

l’intenzione di creare attorno al progetto le migliori

condizioni per poter crescere senza dannose pressioni

di mercato. Il team è stato organizzato quindi come in

una vera e propria startup, con l’obiettivo di creare

dapprima un ecosistema funzionante per poi valutare

come il tutto possa essere proposto sotto forma di

modello di business. Non una startup qualunque, però: 2000 specialisti assoldati, 1 miliardo di

17

dollari di investimento, 100 milioni versati al fine di sostenere lo sviluppo dell’ecosistema di

imprenditori e partner sui quali maturare il futuro del progetto.

L’idea è quella di arrivare a rendere Watson una sorta di piattaforma cloud per lo sviluppo di

applicazioni. 700 entità (tra grandi aziende e startup) sono già in collaborazione con Watson per

capire come dar vita a nuovi progetti: da questo numero usciranno i primi esperimenti pilota, con

una roadmap che fissa al 2017 l’anno in cui Watson dovrà iniziare a dimostrare davvero di potersi

proporre sul mercato come realtà valida, efficiente ed economicamente sostenibile.

Se solo 10 anni fa il 70% degli introiti IBM provenivano dalla vendita hardware, oggi tale quota è

scesa ad appena il 20%: l’azienda ha ripensato completamente il proprio core business e in futuro

lo sviluppo di software e servizi passerà anche per il cognitive computing. Watson è dunque il

futuro di IBM, o almeno uno dei futuri possibili e sui quali l’azienda sta scommettendo con forza.

Dove Può Essere Applicato Watson

Watson ha già trovato applicazione pratica al servizio della ricerca clinica in ambito oncologico ma,

in breve tempo, è destinata a rivoluzionare un più ampio numero di settori – energia, salute, retail,

editorial, finanza, biotech, farmaceutico – e molteplici aspetti della nostra stessa quotidianità.

Sembra difficile capire oggi dove possa arrivare Watson perché, in qualità di sistema basato sul

deep learning, l’idea di fondo è quella di non porre limiti né alla provvidenza, né alla capacità

tecnologica. Si sa però da dove è partito: nel 2006 l’idea è stata messa a punto e il team

(comprensivo peraltro di varie personalità italiane) è riuscito a raccogliere i primi importanti

risultati nel 2011. È infatti questo l’anno di Jeopardy, il gioco televisivo USA al quale Watson ha

partecipato in qualità di concorrente. Il gioco prevede domande aperte in forma testuale, nelle

quali il tempo utile per la risposta è minimo: in quei pochi secondi bisogna recepire la domanda,

comprenderla, interpretarla e rispondere. Watson ha dimostrato in poche prove di poter vincere

contro l’essere umano, dimostrandosi così capace di “ragionare” al pari di una persona. Anni dopo

le performance sono ulteriormente migliorate, la base di conoscenza è aumentata e Watson è ora

pronto a spingersi oltre.

Il primo campo di applicazione pensato è l’ambito sanitario. In questo campo, infatti, i dati

disponibili sono moltissimi, molti di più di quanti un comune medico non possa gestire. Watson

può pertanto configurarsi come un assistente di grande prestigio in fase di diagnosi, potendo

analizzare molti dati per portare poche ipotesi importanti all’attenzione del professionista.

Migliora la diagnosi, migliorano le possibilità di cura, diminuiscono i falsi positivi e il tutto va a

vantaggio dell’intero sistema sanitario.

Altro ambito di interesse potenziale è quello dell’assistenza clienti. I problemi gestiti in questo

settore dalle grandi aziende consentono infatti di arrivare a modelli predefiniti per risposte di più

18

comune ricaduta: Watson potrebbe facilitare l’identificazione di tali modelli, l’emergenza di

problematiche specifiche e facilitare (e velocizzare) i tempi di intervento.

Sulla base di quanto emerso, è da ipotizzare un ruolo di Watson in occasione dell’Expo 2015: IBM

avrà tra le mani una occasione unica per dimostrare la bontà del proprio sistema, applicando il

tutto a un grande evento nel quale il flusso di utenti di lingua anglofona potrà mettere alla prova

le applicazioni pensate per l’appuntamento.

Watson vs Turing

IBM lo dice a chiare lettere: il problema del Test di Turing non si pone, almeno non in questa fase.

Inutile infatti pensare a una macchina che si relazioni alla persona senza frizioni e senza tutta la

ricchezza semantica che una relazione diretta richiede. L’Intelligenza

artificiale non è dunque ancora arrivata al punto da rendere la macchina

intelligente quanto l’uomo. Tuttavia se ci si chiede se Watson sarebbe in

grado di superare il Test di Turing, ci si sta ponendo di fatto la domanda

sbagliata.

L’obiettivo di IBM, infatti, non è quello di sostituire l’uomo. Watson, anzi,

intende presentarsi come il miglior complemento all’uomo stesso,

potenziandone le capacità grazie a un ruolo simbiotico in perfetta

complementarità con quella che è la natura umana.

Alan Turing

L’input e l’output rimangono nelle mani dell’utente, il quale ha inoltre il dovere di validare la bontà

del processo effettuato dalla macchina. L’Intelligenza Artificiale di Watson non intende prevaricare

l’uomo, insomma, ma esaltarne invece l’intelligenza.

Sitografia:

http://www.webnews.it/speciale/watson

http://it.wikipedia.org/wiki/Intelligenza_artificiale

19

Intelligenza Artificiale

Il termine Intelligenza Artificiale è stato coniato da John McCarthy della Stanford University

durante uno storico simposio.

L'Intelligenza Artificiale è una disciplina scientifica il cui scopo è studiare i meccanismi che sono

alla base delle attività cognitive degli esseri umani come il ragionamento, la capacità di risolvere

problemi, il linguaggio, etc. e l'eventuale loro riproduzione tramite programmi per computer.

Tutto questo è nato dal fatto che molti scienziati considerano il pensiero umano come una forma

di "calcolo" e che, quindi, è possibile riprodurlo con dei programmi per calcolatore. Anzi, alcuni di

essi, credono che, in futuro, sarà possibile dotare un computer di un'intelligenza equivalente a

quella umana.

L'Intelligenza Artificiale classica

è

costituita da due discipline: la

prima è l'intelligenza artificiale

forte che ritiene che un

calcolatore, dotato di

programmi opportuni, possa

essere dotato di un'intelligenza

vera indistinguibile da quella

umana. Alla base di questa

convinzione vi è la teoria che il

pensiero umano sia una forma di calcolo non troppo diversa da quella usata per risolvere un

problema e quindi perfettamente riproducibile attraverso uno o più algoritmi; la seconda è

l'intelligenza artificiale debole che sostiene che un elaboratore opportunamente programmato sia

solo in grado di simulare alcuni dei processi mentali e non di riprodurli effettivamente. In tal caso

un computer sembrerà possedere capacità intellettive ma in realtà eseguirà solamente una serie

di operazioni pre-impostate che hanno lo scopo di fornire un risultato identico a quello che

produrrebbe il cervello umano. Entrambe le discipline condividono alcuni concetti come il fatto

che per riprodurre o simulare il comportamento intelligente sia necessario realizzare dei

programmi in grado di elaborare delle informazioni.

Recentemente è nata una nuova disciplina, chiamata connessionismo la quale sostiene che per

20

riprodurre o simulare il comportamento intelligente sia necessario replicare, tramite un

elaboratore, il funzionamento del cervello umano a livello cellulare. In tal modo si replica il

funzionamento dei singoli neuroni e si simulano le connessioni che trasmettono le informazioni fra

un neurone e l'altro. Le applicazioni reali di questa tecnologia hanno dato origine alle reti neurali:

sistemi in grado di evolversi e di apprendere in base agli stimoli a cui vengono sottoposti.

Un'applicazione di Intelligenza Artificiale deve essere in grado di acquisire e rappresentare le

informazioni (la conoscenza) relative al compito da eseguire e di elaborarle utilizzando meccanismi

che possono sembrare intelligenti. L'immagazzinamento delle informazioni e la loro elaborazione

avviene utilizzando i meccanismi tipici dell'intelligenza umana come la deduzione, l'inferenza, il

ragionamento logico, la generazione e la valutazione di ipotesi e l'apprendimento.

Nell'ambito dell'intelligenza artificiale si possono distinguere le seguenti sottoaree principali che

prendono il nome di applicazioni di primo livello dell'IA:

x comprensione del linguaggio naturale parlato e scritto;

x manipolazione di oggetti;

x visione e riconoscimento delle forme;

x giochi (scacchi, dama,...);

x dimostrazione di teoremi matematici non banali;

x scrittura automatica di programmi per l'elaborazione delle informazioni.

Esistono poi i temi centrali dell'Intelligenza Artificiale. Essi sono:

x ragionamento comune; risoluzione di problemi; deduzione;

x modelli e rappresentazione della conoscenza;

x sistemi di programmazione e linguaggi per la realizzazione di sistemi intelligenti;

x ricerca euristica.

Quanto è naturale l’Intelligenza Artificiale?

Lo scontro dialettico tra “naturale” e “artificiale” deve certamente le sue origini, anche se in modo

indiretto, alla distinzione cartesiana tra res cogitans e res extensa: il filosofo francese partiva

infatti dal presupposto che esistesse una differenza netta tra chi è in grado di pensare e tutto il

resto dell’universo. Un simile approccio al problema porta certamente verso una concezione

dell’attività mentale che è del tutto svincolata dai limiti della materia inerte: l’uomo, pur essendo

fatto di atomi esattamente come una roccia, è “costretto” a possedere una sorta di vis viva che

trasmuta la sua natura oggettivamente materiale in una omologa definibile solo in termini

metafisici. Tutto ciò ha portato negli ultimi vent’anni ad un acceso dibattito tra coloro che sono del

parere che è ontologicamente necessaria una distinzione tra mente e cervello e chi sostiene che

ciò che noi ci ostiniamo a chiamare mente non è altro che il risultato dell’attività, reale e

fisicamente analizzabile, del sistema nervoso centrale. Grazie alle moderne tecniche di brain

imaging come la PET o la risonanza magnetica funzionale è stato possibile provare

21

sperimentalmente che determinate aree del cervello si attivano solo quando il soggetto in esame

è sottoposto a particolari test; ad esempio, se si chiede di eseguire un calcolo numerico non

troppo banale si evidenzia una spiccata attività bioelettrica nell’emisfero sinistro del cervello,

mentre se la prova comporta la lettura mentale di un testo si vede come l’area di Wernicke,

responsabile della decodificazione semantica, entri in azione, permettendo all’individuo di

comprendere ciò che sta leggendo. Naturalmente è assurdo pensare che si possa effettuare una

localizzazione esatta di ogni funzione cerebrale poiché, come avremo modo di vedere, la struttura

stessa del cervello è tale da consentire una fusione di flussi informativi provenienti da sorgenti

diverse. E’ proprio grazie a tale peculiarità che noi, ogni giorno, possiamo affrontare attività che

scomposte in sotto-problemi risulterebbero proibitive anche per il più potente supercomputer.

Un cervello “statico”, cioè fortemente localizzante, si troverebbe in estrema difficoltà

ogniqualvolta si dovessero

presentare alternative –

funzionalmente e strutturalmente

compatibili – alle strutture preimmagazzinate; per tentare di

comprendere come ciò possa

avvenire dobbiamo necessariamente

andare indietro nel tempo e

interpellare Immanuel Kant: fu

proprio lui, infatti, il primo

ricercatore a domandarsi come mai

la rielaborazione mentale di un

concetto fosse quasi del tutto

indipendente dalla particolare

esperienza che ci ha

precedentemente condotti ad esso.

Nella Critica della Ragion Pura Kant

spiegava, senza fare riferimento alla

posteriore psicologia cognitiva, il

perché, ad esempio, l’idea di “casa” fosse svincolata dall’edificio in cui abito o da quello che

osservo guardando fuori dalla finestra. La sua indagine partì dal presupposto che il pensiero di un

oggetto non si forma a partire da una “catalogazione” di percezioni, ma piuttosto da una sintesi di

un molteplice che scaturisce da una serie di informazioni in ingresso: la “casa” – intesa come

concetto/oggetto – viene scomposta nelle sue parti peculiari e, una volta che l’idea ad essa

collegata è divenuta sufficientemente stabile , il cervello ri-utilizza questi dati per poter “costruire”

una casa basandosi sulle esperienze correnti o, anche solo sulla fantasia. Naturalmente Kant non

22

possedeva i mezzi di indagine necessari per potere, seguendo gli insegnamenti di Galileo,

confermare sperimentalmente le sue ipotesi e di conseguenza si lasciò guidare solo dall’intelletto;

oggi invece la situazione è stata chiarita e ad essa è stato dato il nome di “capacità di

generalizzazione”.

Se si chiedesse ad una persona se la sua intelligenza è naturale è ovvio che la risposta sarebbe

certamente affermativa, ma se si chiedesse che cosa essa intenda per “naturale” si potrebbero

collezionare così tante spiegazioni da poter compilare una nuova enciclopedia britannica...

Ognuno di noi è convinto di essere un membro della natura, intendendo con ciò che il corpo e la

mente si sono formati a partire da processi che non possono in alcun modo essere definiti

artificiali. Questo è vero, tuttavia a noi interessa capire se

può esistere una qualche distinzione tra un uomo e

un’ipotetica macchina pensante: quali parametri bisogna

prendere in considerazione ? E, soprattutto, a quali test è

necessario sottoporre entrambe le parti ?

Un primo approccio potrebbe essere quello di chiedere alla

macchina se essa è naturale (ciò si rifà al famoso test di

Turing), ma che valore potrebbe avere questa risposta ? Un

eventuale “sì” o il suo contrario non ci illuminerebbero più

di tanto; è ovvio che un computer è costruito dall’uomo, ma

è altrettanto scontato che gli elettroni, i protoni e i neutroni

che lo compongono sono uguali sia all’interno del suo

microprocessore, sia nel cervello, nel cuore e nel fegato del

soggetto umano: entrambi sono “costruiti” a partire dai

medesimi elementi, ma, mentre la macchina è fredda e inespressiva, la persona manifesta

caratteristiche che noi definiremmo “emozionali”. Ci si potrebbe allora chiedere se siano proprio

le emozioni a fare la differenza, ma, pur rispettando coloro che pensano che esse siano una sorta

di “ispirazione divina”, è giusto precisare che ciò che noi chiamiamo paura, ansia o felicità è

traducibile in tutta una serie di percezioni-elaborazioni cerebrali-auto condizionamenti dovuti ai

neurotrasmettitori prodotti dai neuroni e da alcuni ormoni secreti dalle ghiandole surrenali. In

altre parole, l’emozione è uno stato interno che scaturisce a partire da una causa qualunque, ma

che si sviluppa seguendo una sorta di copione che il nostro organismo conosce estremamente

bene.

Scartando, quindi, anche l’ipotesi dell’emozione non resta che rifarsi alle capacità intellettive pure,

vale a dire alla logica, al pensiero astratto e, in ultima analisi, anche alle capacità artistiche. Agli

albori dell’intelligenza artificiale, grandi pionieri come Marvin Minsky proposero quella che per

molti anni a seguire fu la “metodologia” da adottare per affrontare problemi di particolare

complessità; in particolare la loro idea si basava sul presupposto che l’aggettivo “artificiale” fosse

riferito non tanto all’intelligenza della macchina, ma piuttosto al fatto che un bravo

programmatore riuscisse a scrivere algoritmi innovativi e capaci di far fronte a situazioni

computazionalmente molto pesanti. In pratica, seguendo questo filone, la risposta alla nostra

domanda iniziale non può che essere: “L’intelligenza artificiale è naturale tanto quanto lo è un

computer”, con la differenza che, mentre l’uomo è capace di astrarre ma non di calcolare

23

velocemente, il calcolatore, opportunamente predisposto dall’operatore, è virtualmente in grado

di assolvere ad entrambi i compiti. Il problema principale, tuttavia, nasce proprio dal fatto che

senza l’ausilio dell’esperto umano non è praticamente possibile effettuare quella transizione di

intelligenza che può migliorare il comportamento delle macchine automatiche.

Fortunatamente la ricerca si è spinta oltre il vicinissimo confine tracciato dai padri dell’intelligenza

artificiale detta ormai “classica” e la cosa più stupefacente è stata non tanto la variazione di

strategia, ma piuttosto l’idea che un calcolatore può divenire più intelligente solo se imita

operazionalmente e strutturalmente gli organi animali preposti a svolgere tutte le svariate funzioni

di controllo ed elaborazione. In parole povere, a partire dai risultati della neurofisiologia, si è

pensato di implementare particolari strutture (le reti neurali) che avessero un funzionamento

analogo a quello delle omologhe naturali; in

questo modo – che noi non descriveremo per

mancanza di spazio – fu immediato constatare

che il ruolo del programmatore non era più

centrale, ma andava assumendo una posizione

sempre più marginale per lasciare spazio ad

un’evoluzione interna semi-autonoma guidata

solo dagli obiettivi che si desiderava

raggiungere. Ad esempio, con una rete di 20 neuroni, è possibile far sì che essa apprenda

(apprendimento inteso come modificazione di alcuni parametri caratteristici) a riconoscere le

lettere dell’alfabeto e sia in grado di riconoscere con estrema facilità un carattere distorto. Ormai

molti software per personal computer si basano su questo approccio, basti pensare ai cosiddetti

OCR, ovvero a quei programmi che sono in grado di convertire un’immagine contenente del testo

in un documento elettronico, oppure ai sofisticati strumenti utilizzati dalla polizia per confrontare

un volto sospetto con quelli contenuti nella loro banca dati; questi naturalmente sono solo banali

esempi, ma in realtà l’intelligenza artificiale basata sul connessionismo è ormai così diffusa da

essere un requisito essenziale per ogni programmatore di sistemi intelligenti che si rispetti.

E’ chiaro che adesso la risposta alla domanda inizia lentamente a volgere verso un’affermazione

positiva, ma ancora non è chiaro perché un semplice cambiamento di rotta abbia determinato una

rivoluzione la cui portata è comprensibile solo agli scrittori di fantascienza

Sitografia

http://www.portalefilosofia.com/intelligenzaartificiale.php

24