L’AUDIO

1. Cos’e’ il suono

2. frequenza

3. Ampitude

4. Percezione del suono e Psicoacustica

5. rappresentazione digitale delle informazioni audio

6. Campionamento e quantizzazione

7. Teorema di Nisquit

8. Rapporto segnale rumore

9. Dimensione dei dati e banda di trasmisisione

10. formati standard per la codifica dei dati audio

a. wav

b. u-law

c. aiff

d. mpeg (la compressione audio)

11. I sistemi midi

Cos’e’ il suono

Il suono e’ un fenomeno fisico causato dalla vibrazione di un materiale. Questa vibrazione provoca

variazioni di pressione nell’ aria attorno al materiale, e si propagano nell’aria. Il cammino di questa

oscillazione e’ detto forma d’onda. Noi sentiamo il suono quando un onda arriva alle nostre

orecchie.

Questa forma d’onda ha una forma regolare attraverso intervalli di tempo

Frequenza

La frequenza di un suono e il valore reciproco del suo periodo, e rappresenta il numero di periodi in

un secondo ed e’ misurata in Hertz (Hz)

I suoni sono classificati in base alla frequenza

• Infrasuoni: 0 – 20 Hz

• AudioSuoni: 20 Hz – 20 kHz

• Ultrasuoni: 20kHz – 1 GHz

• Ipersuoni: 1 GHz – 10 THz

Gli audio suoni sono deti anche segnali acustici e sono quelli udibili dall’orecchio umano

Ampiezza

E’ una proprietà del suono che l’uomo percepisce come sonorita’ o volume del suono. L’ampiezza

di un suono e’ l’unita’ di misura usata per deviare l’onda di pressione dal suo valore principale.

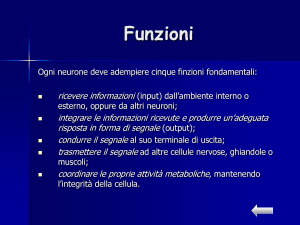

Percezione del suono e psicoacustica

The Physical Acoustic Perspective

I suoni da una sorgente Sonora si espandono come onde concentriche di pressione. La posizione

della sorgente puo’ essere descritta caon la distanza dal centro della testa dell’ascolatatore e da due

angoli, uno in un livello orizzontale ed uno in un livello verticale

ITD (Interaural time difference): e’ la differenza di tempo con cui le onde sonoro raggiungono le

due orecchie.

IID (interaural intensity difference)

Queste due caratteristiche delle onde sonore arrivano alle orecchie e possono essere misurate e

descritter e rappresentano le basi per la ricognizione spaziale

L’apparato uditivo inoltre ha alcune caratteristiche che falsano la percezione, per esempio per

frequenze di 3 kHz , l’onda originale viene percepita in modo diverso a causa della risonanza nel

canale uditivo.

L’iterazione fra il corpo dell’ascoltatore e l’onda e’ complessa e genera una forte dipendenza su

angoli verticali e orizzontali, in cui la sorgente sonora e’ disposta

Inoltre il suono come un onda e’ soggetto a tutte le leggi di rifrazione,riflessione e dispersione che

falsano la reale percezione del suono ma danno informazioni sullo spazio intorno al suono.

Prospettiva Psicoacustica

Human Hearing and voice

• il campo di frequenze udibili va da 20 Hz fino a 20kHz, I piu’ sensibili da 2 a 4 kHz

• Il range dinamico e sui 96 dB

• La voce copre un range di frequenze da 500 Hz a 2 kHz

o Le frequenze piu basse sono bassi e vocali

o Le frequenze alte sono le consonanti

• La sensibilita’ dell’orecchio umano e’ variabile lungo lo spettro audio, e la sensibilita’

massima si ha intorno ai 2-3 kHz, e decresce all’estremita’ dello spettro

•

Bande Critiche:

L’apparato uditivo umano ha dei limiti , dipendenti dalla frequenza delle onde sonore. La misura

uniforme della percezione delle frequenza uniforme puo’ essere espressa in termini di larghezza di

Bande Critiche.

• ogni banda ha un ampiezza da 100 Hz a 4kHz

• l’intero spettro delle frequenze udibili e’ suddiviso in 25 bande critiche

Mascheramento delle frequenze

Un suoo puro puo’ mascherare un altro con frequenza vicina e livello piu’ basso, per esempio se

eseguiamo un suono a 1kHz, altri suoni nell’intervallo di mascheramento non sono percepiti.

Il mascheramento e’ differente per ogni frequenza e puo’ essere definito per ogni banda critica

Mascheramento temporale

Se si ascolta un suono alto, quando ci si ferma, ci vuole un po di tempo prima che si possa sentire

un tono piu’ basso

Combinando tutti gli effetti di mascheramento (di frequenza e temporale) otteniamo un grafico 3d

in cui si possono individuare delle zone, in cui i suoni sono inudibili e sono quelli sfruttati nella

compressione audio

Rappresentazione audio sui computer

La curva continua di un onda sonora per essere messa in un computer, il computer deve misurare

l’ampiezza dell’onda ad intervalli regolari. Il risultato e’ una sequenza di valori campionati.

ADC analog to digital converter: e’ il meccanismo che converte un segnale audio in una sequenza

di campionamenti digitali

DAC digital to analog converter: usato per fare la conversione opposta

Sampling Rate (velocita’ di campionamento): la velocita’ con cui un onda continua e’ campionata.

E’ misurata in Hz

Quantizzazione

Il processo di digitalizzazione richiede due passi

• prima il segnale analogico deve essere campionato. Cio’ significa che solo un insieme finito

di valori e’ mantenuto durante intervalli di tempo.

• Il secondo passo include la quantizzazione che consiste nel con vertire un segnale

campionato in un segnale che puo’ avere solo un numero limitato di valori. Per esempio

o 8 bit quantization- 256 valori possibili

o 16 bit quantization 65536 valori possibili

Questo significa che piu’ bassa e’ la quantizzazione (in bits), piu’ il suono risultante e’ di qualita’

inferiore.

TEOREMA DI NYQUIST: Il teorema di nisquit pone un limite alla frequenza di campionamento di

un segnale (in pratica una frequenza di campionamento piu’ alta sarebbe inutile alla fine della

riproduzione del segnale) e testualmente dice:

“ un segnale il cui spettro di frequenza e’ limitato superiormente puo’ essere completamente

ricostruito da un insieme di campioni se la frequenza di campionamento e’ almeno doppia della

piu’alta frequenza presente nel segnale”

RAPPORTO SEGNALE/RUMORE

Nei sistemi analogici il segnale e’ alterato dal rumore, una fluttuazione casuale del livello del

segnale dovuto a fenomeni elettronici.

Il rapporto segnale rumore e’ una misura della qualita’ del segnale

SNR(signal noise ratio)= 10log(V2signal/V2noise)=20log (Vsignal/Vnoise)

Nei sistemi digitali il rumore compare come differenza tra il livello del segnale reale e il livello del

segnale quantizzato.

SQNR=20log (Vsignal/Vquant-noise)= 20log(VN-1/(1/2))=6.02 N (dB)

DIMENSIONE DEI DATI E BANDA DI TRASMISSIONE

Qualita’ dell’ audio VS dimensione

Piu’ alta e’ la qualita’ dell’audio piu questo occupa in termini di spazio

Problemi della codifica audio

La codifica e decodifica digitale di segnali audio presenta maggiori problemi rispetto alle immagini

e al video

• l’audio ha una struttura temporale che non puo’ essere modificata (frequenza)

• l’informazione audio e’ variabile nel tempo

• la qualita’ di riproduzione richiesta di solito supera di molto la soglia della semplice

comprensibilita’

Audio:dimensione e tempo di trasferimento

L’audio non compresso di buona qualita’ supera la capacita’ di trasmissione delle reti convenzionali

( un segnare radio fm> 640 kbit/sec,CD audio > 1.2 Mbit/sec)

I dati sono di grandi dimensioni

• il segnale codificato occupa molto spazio

• la lunghezza e’ in linea di principio non limitata

Per questo non e’ possibile trasferire tutto il file prima di iniziare la riproduzione (si ha straming)

riproduzione durante la ricezione.

I FORMATI AUDIO:

WAV: Waveform Audio File

• sviluppato da MicroSoft e IBM

• diventa lo standard de facto per la codifica del suono su pc

• non e’ compresso (ed e’ di grandi dimensioni)

AIFF: Audio Interchange File Format

• sviluppato dalla Apple

• e’ il formato standard del Macintosh

• non compresso ( ma comunque esiste una versione compressa)

U-law

• formato audio standar unix

• standard telefonico in USA (8KHz,8bit)

A-LAW

• versione europea di u law

MPEG 1

• codifica le traccie audio nei video MPEG

• e’ un formato compresso per la codifica a qualita’ variabile

• usa un algoritmo a piu’ stadi basato sui principi di psicoacustica

• sono definiti tre livelli di codifica per tre diversi bit-rate

• e’ uno standard cross plattform

COMPRESSIONE DELL”AUDIO

I metodi di compressione senza perdita non forniscono buoni risultati per quanto riguarda la

compressione in aunto i dati audio sono molto variabili e le configurazioni ricorsive sono rare (

vediu Huffman, LZW ecc…).Per questo si devono usare per forza metodi di compressione con

perdita in quanto

• l’informazione audio e ridondante

• la qualita’ di compressione puo’essere controllata

• l’orecchio unano ha un comportamento non lineare

I metodi con perdita sfruttano le nozioni di psicoacustica visti sopra

• Compressione del silenzio

o Il silenzio e’ un insime di campioni sotto una certa soglia

o E’ simile alla compressione RLE

• Adaptive Differenziali Pulse Code Modulation (ADPCM)

o Codifica le differenze fra due o piu’segnali consecutivi

o La differenza e’ quantizzata quindi si ha perdita di informazione

o E’ necessario prevedere dove la forma d’onda e’ diretta (difficile)

o Apple ha un formato proprietario detto ACE/MACE. Quesrto schema con perdita

tenta di prevederte dove andra’ l’onda nel prossimo campionamento

• Linear Predictive Coding (LPC)

o Adatta il segnale ad un modello del parlato umano

•

o Trasmette i parametri del modello e le differenze del segnale reale rispetto al

modello

o Suoni come parlato umano a 2.4 kbit/sec

Code Excited Linear Predictor (CELP)

o Come LPC ma trasmette anche errori (audio conference quality ad 4.8 kbits/sec.)

MPEG AUDIO COMPRESSION

•

•

•

•

•

•

MPEG 1: 1.5 Mbits/sec per l’audio e video (1.2 Mbits/sec per video, 0.3 Mbits/sec for

audio) (un cd non compresso a 44100 campioni al secondo codificato con 16 bit per

campione in due canali occupa uno spazio maggiore di 1.4 Mbits/sec)

Ha un fattore di compressione che varia in uno spazio da 2.7 a 24

Con un livello di compressione si 6:1 ( 16 bit stereo campionato a 48 KHz e ridotto a 256

kbits/sec) il segnale compresso e’ praticamente indistinguibile dal segnale originale

Da 96 a 128kbit/s la qualita’ e’ ottimale per applicazioni domestiche

MPEG supporta frequenze di campionamento che vanno da (32/44.1 a 48 kHz) usando 16

bit per campione

Supporta uno o due canali audio in uno dei seguenti 4 formati

o Mono- canale audio singolo

o Dual monophonic:due canali indipendenti

o Stereo

o Joint stereo

L’ALGORITMO DI COMPRESSIONE AUDIO MPEG

L’algoritmo di codifica e’ diviso in quattro stadi che utilizzano le proprieta’ del modello

psicoacustico

• divisione del segnale audio in 32 sottobande di frequenza

• per ogni sottobanda cal;cola la quantita’ di mascheramento

• se la potenza del segnale nella sottobanda e’ inferiore alla soglia di mascheramento, il

segnale non viene codificato

• altrimenti calcola il numero di bit necessari per rappresentare il segnale in modo che i l

rumore di quantizzazione sia inferiore all soglia di mascheramento (1bit ~ 6dB di rumore)

• compone il flusso di bit secondo un formato standard per la trasmissione

Segnale audio non

compresso

Divisione in 32

bande di frequenza

Modello

Psicoacustico

Quantizzazione

Se applicabile

Codifica entropica

Compressed Audio

Data

MPEG LAYERS

•

•

•

•

•

MPEG definisce 3 layers per l’audio. Il modello base e’ lo stesso ma la complessita’ di

codifica aumenta con ogni layer

Divide i dati in frames, ognuno dei quali contiene 384 campioni, 12 campioni per ognuna

delle 32 sottobande filtrate come visto di seguito

Layer 1: filtro tipo DCT, con un solo frame ed una ripartizione costante dell frequenze e

delle sottbande( il modello psicoacustico usa solo il mascheramento di frequenza

Layer2: usa tre frame durante il filtraggio ( precedente, corrente e prossimo, per un totale di

1152 campioni) utilizzando in parte il mascheramento temporale

Layer 3: ripartisce lo spettro di frequenza in sottobande di ampiezza diversa

o Il modello psicoacustico comprende il mascheramento temporale

o Considera anche la ridondanza stereo

o Utilizza un compressore do Huffman

ESEMPIO CODIFICA MP3 vedi slides e esempi di codifica vedi slides

Music and the MIDI Standards

Un suono puo’ essere rappresentato come un suono digitalizzato che e’ una sequenza di

campionamenti, ognuno codificato con una cifre binarie.

Questa sequenza puo’essere compressas o non. Inoltre sappiamo che qualsiasi suono puo’essere

rappresentato in questo modo, inclusa la musica, ma questa rappresentazione non conserva la

descrizione semantica del suono, ovvero il computer non riconosce se una sequenza di bit

rappresenta parlato oppure musica, e se e’ musica, che note sono suonate e da quale strumento

La musica puo’essere descritta in una forma simbolica (note). Per gli strumenti computerizzati e

strumenti musicali elettronici usano una tecnica simile e molti di essi usano MIDI uno standard che

definisce come codificare tutti gli elementi della musica come una sequenza di note, condizioni

temporali, strumenti che suonano queste note .

INTRODUZIONE AI MIDI

MIDI rappresenta un insieme di specifiche usate nello sviluppo di strumenticosicche strumenti

diversi possono facilemte scambiarsi informazioni

Il protocollo MIDI e’ una descrizione intera della musica in forma binaria, ad ogni parola che

descrive un azione di una performance musicale e’ assegnato un codice binaria specifica.

Un interfaccia MIDI e’ composta di due componenti:

• Hardwere per connettere lo strumento

• Una forma di dati per codificare l’informazione che deve essere processata dall’hardware. Il

formato di dato midi non include la codifica di valori di campioni individuali , midi usa uno

formato specifico per ogni strumento, descrivendo cose tipo l’inizio e la fine di un pezzo, la

frequenza base , lodness in aggiunta allo strumento stesso

• Il formato di dati midi digitale e dati e sono raggruppate dentro messaggi midi

• L’interfaccia midi genera messaggi midi che definisce l’inizio di ogni pezzo e la sua

intensita’. Qesto messaggio e’ trasmesso ad una macchina connessa al sistema.. Appena il

musicista rilascia il tasto, un altro segnale midi e’ creato e trasmesso.

PERIFERICHE MIDI

Uno strumento che e’ in accordo con tutti gli standard midi e una periferica midi (un sintetizzatore)

capace di comunicare con altre periferiche midi attraverso canali. Lo standard midi definisce 16

canali. Una periferica midi e mappata sui canali. Lo standard midi definisce 128 strumenti, e effetti

rumorosi. Ci possono essere piu’ pezzi suonati contemporaneamente da un minimo di 3 a un max di

16 il tutto dipendente dalle proprieta’ del sintetizzatore.

Un computer usa un interfaccia midi per controllare strumenti per il playout. Il computer puo’ usare

la stessa interfaccia per ricevere, immagazzinare e processare dati musicali codificati.. Nello

sviluppo midi questi dati sono generati su una tastiera e suonati su un sintetizzatore

Un sequencer serve per modificare i dati (risiede di solito in un computer)