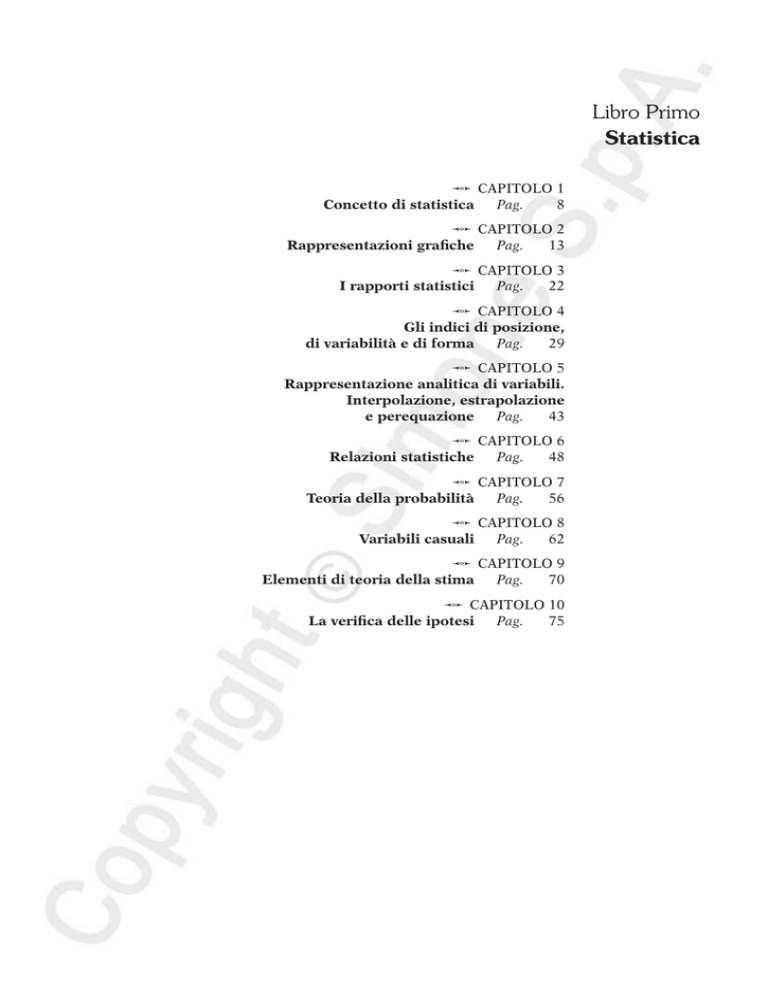

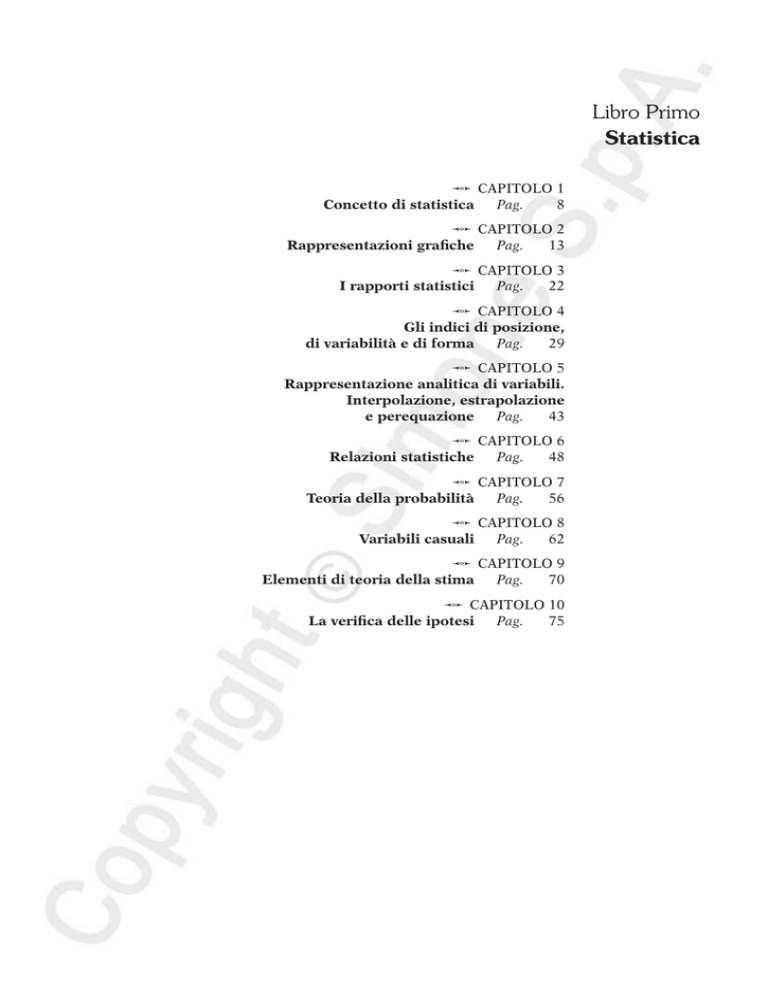

Libro Primo

Statistica

Capitolo 1

Concetto di statistica Pag.

8

Capitolo 2

Rappresentazioni grafiche Pag. 13

Capitolo 3

I rapporti statistici Pag. 22

Capitolo 4

Gli indici di posizione,

di variabilità e di forma Pag. 29

Capitolo 5

Rappresentazione analitica di variabili.

Interpolazione, estrapolazione

e perequazione Pag. 43

Capitolo 6

Relazioni statistiche

Pag.

48

Capitolo 7

Teoria della probabilità

Pag.

56

Capitolo 8

Variabili casuali

Pag.

62

Capitolo 9

Elementi di teoria della stima

Pag.

70

Capitolo 10

La verifica delle ipotesi

Pag.

75

Capitolo 1

Concetto di statistica

1. Generalità

La statistica è una scienza, strumentale ad altre, concernente la determinazione dei metodi

scientifici da seguire per raccogliere, elaborare e valutare i dati riguardanti l’essenza di particolari

fenomeni di massa.

Nell’ambito della metodologia statistica si distinguono, a fini puramente didattici, due filoni

fondamentali: la statistica descrittiva e la statistica inferenziale.

La statistica descrittiva è volta alla rappresentazione, attraverso mezzi matematici, di uno o

più fenomeni reali conducendo lo studio sull’intera popolazione in cui si palesa il fenomeno o i

fenomeni oggetto di studio.

La statistica inferenziale è volta all’induzione probabilistica circa la struttura incognita di una

popolazione. Questo filone della statistica si occupa di risolvere il cosiddetto problema inverso, ossia,

sulla base di osservazioni su un campione di unità selezionate con date procedure dalla popolazione, perviene a soluzioni valide, entro dati livelli di probabilità, anche per la popolazione stessa.

Le partizioni della statistica sopra enunciate sono comunque riconducibili ad una specifica

branca: quella della statistica pura o teorica. Esse prevedono, in altre parole, regole e principi generali propri della scienza statistica astratta, qualunque sia il tipo di fenomeni cui essa si riferisce.

Il campo di applicazione della statistica si è notevolmente esteso negli ultimi anni, comprendendo tutte le situazioni in cui sono implicati fenomeni collettivi. A seconda della materia cui la

scienza statistica si applica, si possono distinguere varie specializzazioni della stessa: statistica

economica, statistica demografica, statistica medica etc. In generale, per tutti questi rami della

statistica si parla, appunto, di statistica applicata.

2. Fasi dell’analisi statistica

Non esiste una sequenza di fasi da seguire pedissequamente nello svolgere un’analisi statistica,

in quanto alterne necessità possono richiedere di essere meno canonici in alcune.

Si conviene, generalmente, di dividere un’analisi statistica in cinque fasi:

1. La definizione degli obiettivi. Si tratta di una fase alquanto delicata in cui gli obiettivi

prefissati devono essere esattamente individuati delimitando la ricerca in termini spaziali e

temporali.

2. La rilevazione. È la fase dell’analisi statistica concernente l’osservazione dei caratteri relativi

alle unità statistiche mediante opportune tecniche e strumenti. Essa può essere completa

(censimento) se è condotta su tutte le unità costituenti la popolazione cui si riferisce il fenomeno in esame, o parziale se è condotta su un campione estratto dalla popolazione, il cui

impiego si basa sull’approccio induttivo (dalla parte al tutto) tipico dell’inferenza statistica.

Data la multiforme varietà in cui si manifestano i fenomeni collettivi oggetto dell’analisi statistica, le rilevazioni non sono quasi mai effettuate sull’intera popolazione, ma su un campione

rappresentativo della stessa.

La rilevazione dei dati può essere effettuata da enti privati (aziende, società commerciali, studi

professionali etc.). In Italia l’organo statistico ufficiale dello Stato è l’ISTAT (Istituto Nazionale

di Statistica), persona giuridica di diritto pubblico con ordinamento autonomo, sottoposta alla

vigilanza della Presidenza del Consiglio dei Ministri e al controllo della Corte dei Conti.

La rilevazione si esegue sulla base di modelli che consistono in formulari completi di domande e

risposte, predisposti in modo da ottenere esattamente quei dati che interessano ai fini dell’analisi.

Capitolo 1: Concetto di statistica

9

3. La elaborazione dei dati. In questa fase i dati rilevati sono sintetizzati allo scopo di ottenere

dati più significativi.

4. La presentazione ed interpretazione dei dati. Questa fase dell’analisi statistica è particolarmente delicata in quanto consiste nella rappresentazione dei dati attraverso tabelle, grafici

e indici, e nella spiegazione dei risultati ottenuti dall’intera analisi statistica.

5. L’applicazione degli esiti dell’analisi. La statistica, come già è stato detto, non è una scienza

fine a se stessa, essa trova applicazione in diversi campi; è compito dello statistico definire i

criteri e i limiti all’impiego degli esiti di un’analisi.

3. Le unità statistiche

La statistica acquisisce le informazioni su una data popolazione, non necessariamente riferita

ad esseri umani. Le componenti elementari della popolazione su cui materialmente è effettuata

un’indagine sono denominate unità statistiche e si distinguono in:

— unità semplici come una singola persona, una singola abitazione etc.;

— unità composte se sono insiemi di unità semplici simili considerate anche a prescindere

dall’unità composta; in questa tipologia rientra una famiglia intesa come insieme dei suoi

componenti, un edificio inteso come insieme di abitazioni etc.;

— unità complesse se sono insiemi di unità semplici diverse considerate, però, nella loro globalità; in questa tipologia rientra il rapporto coniugale di cui sono unità semplici il marito e

la moglie, oppure un determinato rapporto di lavoro di cui sono unità semplici il datore di

lavoro e i dipendenti etc.

4. Il carattere statistico

Il fenomeno oggetto dell’analisi statistica è il carattere (o caratteristica), e rappresenta l’elemento che consente di descrivere una popolazione (o un campione). I valori che può assumere

un carattere su un’unità statistica sono denominati modalità.

Un carattere può essere qualitativo o quantitativo.

Un carattere qualitativo, o mutabile, si manifesta nell’unità statistica mediante modalità,

dette attributi, e può essere indicato solo con espressioni verbali (aggettivi, sostantivi etc.). Ad

esempio, il sesso di una persona si presenta nell’attributo: maschio o femmina; il tipo di lavoro

svolto da un certo numero di persone può essere indicato solo con la qualifica verbale di esso:

operaio, impiegato etc. A volte è possibile indicare caratteri qualitativi con simboli numerici,

ad esempio, gli impiegati dello Stato sono classificati secondo categorie A, B etc. previste dalla

legge sul pubblico impiego. Questi simboli numerici, tuttavia, non sono altro che delle qualifiche

e restano caratteri qualitativi.

Un carattere quantitativo, o variabile, è indicato mediante espressioni numeriche, in altre

parole, per esso è realizzabile una misurazione espressa in cifre, come il reddito delle persone,

il loro peso, la loro età etc.

A sua volta, una variabile può essere:

— continua quando può assumere come modalità un numero reale qualsiasi, come la temperatura di una stanza, la statura, l’età, il peso di un individuo etc.;

— discreta quando può assumere come modalità solo numeri interi, come il numero dei componenti di una famiglia, il numero di addetti di un’azienda etc.

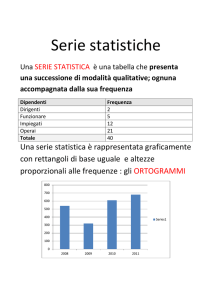

5. Frequenze e intensità

Il numero di volte in cui una data modalità del carattere si presenta nel collettivo è denominato

frequenza assoluta. Essa è il risultato di una enumerazione.

Il rapporto tra la frequenza assoluta e il numero totale di unità statistiche del collettivo esprime la frequenza relativa.

10

Parte Prima: Manuale - Libro Primo: Statistica

La frequenza cumulata rappresenta l’ammontare del carattere posseduto dalle prime i

modalità, ordinate in senso non decrescente. Essa è anche detta frequenza cumulata assoluta

per distinguerla dalla frequenza cumulata relativa e che rappresenta la frazione del carattere

posseduta complessivamente dalle prime i modalità, ordinate in senso non decrescente.

L’intensità è, invece, l’ammontare o la misura di un carattere additivo posseduto dalle unità

statistiche. Sono esempi di intensità il reddito di un individuo, il peso di una persona etc.

6. La classe di modalità

La classe, o classe di modalità, è ciascuno degli intervalli di prefissata ampiezza in cui risulta

suddiviso l’insieme delle modalità di un carattere quantitativo X. Ad ogni classe si fa corrispondere

una frequenza assoluta o relativa, che indica il numero di unità della popolazione che possiedono

un valore del carattere compreso tra i suoi limiti, xi e xi + 1.

Una classe di modalità può essere:

— aperta sia a sinistra che a destra;

— aperta a sinistra e chiusa a destra;

— chiusa a sinistra e aperta a destra;

— chiusa sia a sinistra che a destra.

Talvolta, quando l’insieme dei valori del carattere non è strettamente specificabile, si tende

a non precisare il limite inferiore e il limite superiore, rispettivamente, della prima e dell’ultima

classe, in altre parole, la prima classe è aperta a sinistra e l’ultima è aperta a destra.

Il valore centrale di una classe è dato dalla semisomma dei limiti superiore e inferiore della

classe. In simboli:

x + xi+1

xi = i

2

I valori centrali x–i sono utilizzati ai fini della determinazione di medie e di indici di variabilità

in luogo delle modalità xi quando i dati sono raggruppati in classi.

I confini di una classe sono gli estremi della classe:

— l’estremo superiore di una classe si ottiene dalla semisomma del limite superiore della classe

data e del limite inferiore della classe successiva;

— l’estremo inferiore di una classe si ottiene dalla semisomma del limite inferiore della classe

data e del limite superiore della classe precedente.

L’ampiezza (αi), infine, di una classe è la differenza tra il confine superiore e il confine inferiore

della classe stessa. Essa è detta anche modulo e può essere uguale o diversa per tutte le classi.

7. Scale di misurazione dei caratteri

Dopo aver scelto il carattere da rilevare, lo statistico deve occuparsi della misurazione delle

modalità con cui esso si presenta nelle varie unità. A tal fine, è stata introdotta la seguente distinzione dei caratteri in funzione della scala di misurazione:

— Caratteri con scala nominale sono quelli per cui non si riscontra alcun ordine di successione tra le modalità (attributi); date due osservazioni su due unità statistiche, si può stabilire

se esse sono uguali o diverse. Rientrano in questa tipologia la professione, la nazionalità, il

sesso, la religione, il partito politico etc.

— Caratteri con scala ordinale sono quelli per cui si riscontra un ordine logico di successione

delle modalità; date due osservazioni su due unità statistiche, si può stabilire una relazione

d’ordine, ossia se esse sono uguali o l’una maggiore o minore dell’altra. Rientrano in questa

tipologia i giudizi scolastici, i gradi militari etc.

— Caratteri con scala ad intervallo sono caratteri quantitativi per cui è possibile operare un

confronto, per differenza, tra le modalità e per cui si assume una origine arbitraria e un’unità

Capitolo 1: Concetto di statistica

11

di misura. Rientrano in questa tipologia la misurazione degli anni, in cui si è convenuto di

fissare l’anno zero come l’anno di nascita di Cristo, oppure la misurazione della temperatura

in gradi Celsius la cui origine arbitraria, 0°, coincide con il punto di congelamento dell’acqua.

— Caratteri con scala proporzionale sono caratteri quantitativi per i quali si stabilisce oggettivamente un’origine, il cosiddetto zero assoluto. Per tali caratteri si effettua una vera e

propria operazione di misurazione con strumenti appropriati, o una operazione di computo,

ed è possibile effettuare rapporti tra le misure nel senso che si stabilisce se l’una è la metà,

il doppio … dell’altra. Rientrano in tale tipologia il numero dei componenti di una famiglia,

il numero di appartamenti di un edificio, l’età, il peso di un individuo etc.

8. Distribuzioni di frequenza

Dopo aver effettuato la rilevazione, lo statistico deve realizzare una sintesi efficace dei dati,

attraverso una classificazione delle modalità del carattere (o dei caratteri) investigato, non potendole presentare sempre in forma enumerativa.

A seconda dell’esigenza i dati sono rappresentati in forma tabellare e in forma grafica; ciascun

modo presenta dei vantaggi e degli svantaggi e l’uso dell’uno non esclude l’altro.

La distribuzione statistica è la più importante rappresentazione statistica, essa consiste nella

organizzazione dei dati in forma tabellare che ad ogni modalità di un dato carattere fa corrispondere

la rispettiva frequenza ed è denominata distribuzione di frequenza, oppure che ad un insieme di

eventi fa corrispondere un insieme di numeri reali ed è denominata distribuzione di probabilità.

La tabella seguente indica la distribuzione (semplice) di frequenza di un carattere X discreto:

Modalità di X

Frequenze

x1

n1

x2

n2

:

:

xi

ni

:

:

xr

nr

Totale

n

La tabella seguente indica, invece, la distribuzione (semplice) di frequenza in un carattere

continuo con modalità raggruppate in classi:

Classi di modalità di X

Frequenze

x1 x1

n1

x2 x3

n2

:

:

xi xi+1

ni

:

:

xr xr+1

nr

Totale

n

Nel caso si consideri un carattere qualitativo, nella tabella, invece della frequenza figurano

gli attributi.

12

Parte Prima: Manuale - Libro Primo: Statistica

9. Misure sintetiche di distribuzioni statistiche

L’analisi statistica fornisce misure sintetiche per valutare aspetti complessi e globali di una

distribuzione di un fenomeno X mediante un solo numero reale costruito in modo da disperdere

al minimo le informazioni sui dati originari. In rapporto alle caratteristiche che si misurano si

parla di rapporti statistici, indici di posizione, indici di variabilità, indici di forma, di essi

ci occuperemo, rispettivamente, nei capitoli successivi.

In rapporto alla natura degli indici si distinguono in:

— indici assoluti che sono introdotti per valutare in modo sintetico un aspetto di una distribuzione e sono espressi nella stessa unità di misura del fenomeno o in sua funzione;

— indici relativi che non dipendono dall’unità di misura del fenomeno, e si ottengono rapportando due misure assolute oppure un indice assoluto al suo massimo.

Infine, gli indici normalizzati sono indici relativi che assumono valori in un intervallo finito

quasi sempre [0, 1] oppure [–1, +1].

10. Le serie

La serie è la successione di dati ordinati secondo modalità di caratteri qualitativi:

a) Serie storiche: sono quelle serie in cui il fenomeno è studiato in funzione del tempo. Sono

anche dette serie temporali.

Le serie storiche possono essere:

— statiche se presuppongono la costanza (o quasi) dei loro termini nel tempo;

— dinamiche se descrivono un fenomeno in continuo mutamento. Esse si dicono evolutive,

quando il fenomeno si modifica in senso costante, periodiche, quando i termini del fenomeno oscillano in modo irregolare.

b) Serie territoriali: sono quelle serie in cui il fenomeno collettivo è studiato in relazione al

territorio.

c) Serie rettilinee: sono così chiamate quelle serie di termini in cui è possibile riscontrare un

ordine logico naturale di successione dei termini. Esiste cioè un termine che rappresenta una

modalità iniziale del fenomeno, ed un altro che rappresenta una modalità finale di esso.

d) Serie cicliche: sono così chiamate quelle serie di termini in cui non è dato stabilire quale sia

il termine iniziale assoluto e quello finale assoluto della serie, pur senza un inizio ed una fine

certi dell’andamento del fenomeno.

e) Serie sconnesse: sono così chiamate quelle serie in cui non è possibile riscontrare alcun

ordine di successione tra le modalità. Sono delle serie sconnesse quelle che rappresentano la

professione, la nazionalità, la religione e il partito politico degli intervistati etc.

11. Gli errori

Nell’analisi statistica il concetto di errore è più ampio di quello comune. Infatti, considerato

che per errore si intende la differenza tra il valore stimato e il valore vero o teorico, una prima

distinzione si opera tra gli errori campionari costituiti dalla differenza tra il valore stimato su

un campione e il valore calcolato sulle unità statistiche della popolazione, e gli errori extra‑

campionari non dovuti, appunto, al campionamento e che si possono commettere nel corso di

un’indagine statistica.

Una ulteriore distinzione si opera tra errore sistematico ed errore casuale. Il primo è provocato dall’utilizzo di strumenti difettosi o modalità erronee di rilevazione e può essere ridotto

o eliminato; il secondo è provocato da fattori esterni o intrinseci ed è controllabile con metodi

statistici, ma non eliminabile.

Accade spesso che, dopo la raccolta dei dati, si presenti la necessità di correggere le cifre

ottenute.

Libro Quinto

Elementi di Politica economica

Capitolo 1

Introduzione alla teoria generale

della politica economica Pag. 404

Capitolo 2

Gli elementi di instabilità del sistema economico:

disoccupazione, inflazione e crescita Pag. 411

Capitolo 3

La politica economica:

teoria normativa e positiva Pag. 426

Capitolo 4

L’analisi benefici-costi: come effettuare un calcolo

di convenienza sociale Pag. 435

Capitolo 5

La politica monetaria Pag. 443

Capitolo 6

La politica fiscale Pag. 449

Capitolo 7

La politica dei redditi e dei prezzi Pag. 459

Capitolo 8

Le politiche per la bilancia dei pagamenti Pag. 464

Capitolo 9

La politica economica dell’Unione Europea Pag. 477

Capitolo 1

Introduzione alla teoria generale

della politica economica

1. Il Teorema di Tinbergen

Lo studioso olandese Tinbergen, vincitore del primo premio Nobel per l’economia nel 1969,

analizza un caso estremamente semplificato di Politica economica. I policy makers affrontano

due obiettivi, indicati con T1 e T2 (dal termine anglosassone target) e dispongono di due strumenti

di intervento I1 e I2 (dal termine anglosassone instrument).

È dato che quando i due obiettivi raggiungono il livello T *1 e T *2 , il sistema raggiunge lo stato

massimo di benessere, definito bliss point (punto di felicità).

Nel modello gli obiettivi costituiscono funzione lineare degli strumenti, pertanto avremo che:

T1 = a1I1 + a2I2

(1)

T2 = b1I1 + b2 I2

(2)

Ciascuno obiettivo è funzione di entrambi gli strumenti.

Imponendo il valore ottimale degli obiettivi:

*

T*1 = a 1 I 1 + a 2 I 2

T*2 = b 1 I 1 + b 2 I 2

(3)

e risolvendo rispetto agli strumenti, avremo:

I 1 = ` b 2 T*1 - a 2 T*2j ` a 1 b 2 - b 1 a 2 j

(4)

I 2 = ` a 1 T*2 - b 1 T*1j ` a 1 b 2 - b 1 a 2 j

(5)

(a1b2 – b1a2) = 0

(6)

Le soluzioni esistono soltanto se il denominatore delle equazioni non sia pari a 0, ossia

non deve risultare:

Il che equivale ad escludere che a1/b1 = a2/b2.

Il teorema dimostra che sarà possibile raggiungere il bliss point soltanto se due condizioni risultano verificate:

1) i policy makers sono in grado di agire su entrambi gli strumenti;

2) gli effetti associati agli strumenti sono linearmente indipendenti.

Mentre la prima condizione dipende esclusivamente dal quadro istituzionale del sistema, che

assegna in maniera più o meno ampia il potere discrezionale su quegli strumenti ai policy makers

chiamati a raggiungere gli obiettivi; la seconda condizione è analiticamente verificata dal fatto che

a1/b1 sia diverso da a2/b2. In caso contrario sarà possibile raggiungere uno soltanto degli obiettivi.

Nel caso in cui a1/b1 = a2/b2 gli effetti degli strumenti degli obiettivi sono esattamente proporzionali, pertanto è come se i policy makers disponessero di un solo strumento.

Allargando e complicando il discorso, si dimostra che in presenza di N obiettivi (target) le

autorità pubbliche, per raggiungerli tutti, dovranno essere in grado di utilizzare N strumenti tra

loro linearmente indipendenti.

Capitolo 1: Introduzione alla teoria generale della politica economica

405

Fin qui abbiamo ricavato l’indipendenza lineare analiticamente. Questa, nella pratica, dipende dalla natura stessa degli strumenti e dalla loro caratteristica di non esercitare un’influenza

reciproca. Un esempio tratto dalla politica monetaria può chiarire meglio le idee.

Sappiamo che i maggiori strumenti dell’autorità monetaria consistono nella determinazione

dell’offerta di moneta e nella fissazione del tasso di interesse. Orbene è stato dimostrato che

l’autorità monetaria possa agire su uno o sull’altro degli strumenti ma non su entrambi contemporaneamente. Questi strumenti, in altre parole, non sono linearmente indipendenti.

Del resto risulta piuttosto difficile che esistano strumenti di politica economica linearmente

indipendenti, a causa delle complesse interazioni esistenti tra i diversi parametri macroeconomici,

tuttavia si può sempre ipotizzare che, indipendentemente da una relazione tra gli effetti associati

agli strumenti, non risulti verificata, tra i parametri a e b l’uguaglianza:

a1/b1 = a2/b2

(7)

Questo capita, ad esempio, quando uno strumento esercita un peso preponderante su un certo

target piuttosto che sull’altro. Stiamo, naturalmente, ancora ragionando nei termini dualistici

dei target e degli strumenti.

Per esempio, prendendo come obiettivi il tasso di inflazione e quello di produzione a livello di

bliss point e come strumenti la politica monetaria (offerta di moneta) e quella fiscale (tassazione) accadrà che, in un regime di cambi flessibili, mentre sul livello di produzione gli effetti della

politica fiscale e di quella monetaria saranno identici (ossia per i policy makers sarà indifferente

agire con una manovra di politica fiscale o monetaria), il livello di inflazione risulta più sensibile

a manovre di politica monetaria, ne consegue una indipendenza lineare tra gli strumenti.

Ma anche dopo essere giunti a questa conclusione non possiamo ritenere sempre attuabile

l’applicazione ortodossa del modello di Tinbergen, in quanto il conseguimento del bliss point

potrebbe richiedere un utilizzo talmente spropositato di taluni strumenti, ad esempio l’offerta di

moneta, da portare questo parametro a livelli così inconsueti (con strette creditizie o manovre

espansive) da risultare destabilizzanti per i mercati.

Traendo spunto dal diverso peso specifico che ciascuno strumento è in grado di esercitare su

un particolare obiettivo, Mundell ha ampliato le conclusioni del teorema.

Secondo Mundell, poiché, solitamente, la Politica economica di un Paese non viene attuata

da un’unica autorità, bensì da diversi centri di potere sottostanti a policy makers differenti, sarà

possibile portare il sistema al livello di bliss point decentrando al massimo il potere decisionale.

Questa prospettiva era stata trascurata da Tinbergen che riteneva l’operatore pubblico un’entità

univoca che agiva in maniera contestuale.

Mundell, invece, ritiene che sia possibile assegnare ad ogni centro di potere, che controlla uno

specifico strumento, il target che risulti più sensibile a quello stesso strumento.

Un siffatto decentramento decisionale viene definito principio della classificazione effettiva dei

mercati e attraverso tale principio, Mundell dimostra che sia possibile raggiungere gli obiettivi.

Concretamente, riprendendo l’esempio precedente che utilizza come target il livello di produzione e quello di inflazione, il principio di Mundell assegnerebbe all’autorità monetaria l’obiettivo

di raggiungere il livello ottimale di inflazione, mentre il controllo del livello di produzione sarebbe

assegnato all’autorità fiscale.

Analiticamente Mundell dimostra che tale soluzione porta con una graduale approssimazione

verso i livelli ottimi di produzione ed inflazione, mentre una opposta distribuzione del potere

decisionale, cioè l’assegnazione all’autorità monetaria del controllo sul livello di produzione, e

viceversa, rende impossibile il raggiungimento del bliss point.

Ulteriori sviluppi e critiche del teorema di Tinbergen

Un aspetto cruciale in grado di assicurare la soluzione del teorema di Tinbergen è l’esistenza

di un numero di strumenti perlomeno pari a quello degli obiettivi.

Cosa accade quando questa parità non risulti verificata?

406

Parte Prima: Manuale - Libro Quinto: Elementi di Politica economica

Consideriamo il caso di un sistema economico in cui si voglia ridurre l’inflazione attraverso

una manovra di stretta creditizia, senza che ciò comporti costi in termini di una riduzione del

reddito nazionale. Supponiamo anche che non sia possibile effettuare manovre di politica fiscale,

che potrebbero, ad esempio, attraverso un allargamento della spesa pubblica, contenere il contraccolpo sul reddito nazionale della stretta creditizia.

Ci troveremo in una situazione in cui a fronte di due obiettivi, avremmo un unico strumento:

la politica monetaria.

La situazione è analoga a quella rappresentata dalla curva di Phillips, e qui come in quel caso,

i policy makers sono posti di fronte ad un trade off, la scelta che si pone è quella tra inflazione e

riduzione del reddito nazionale. In altri termini, quando gli strumenti sono numericamente

inferiori agli obiettivi è necessario una scelta orientata al «male minore».

Scegliere il male minore significa, tradotto in termini economici, determinare il punto di

minimo della funzione di perdita sociale.

La funzione di perdita sociale esplicita i costi sostenuti dalla società quando le variabili

obiettivo si discostano dai livelli di bliss point.

Ovviamente quanto più i valori attuali delle variabili obiettivo si discostano da quelli ideali,

tanto maggiore sarà la perdita, gli economisti stimano tale perdita uguale alla somma degli scostamenti al quadrato.

È possibile disegnare una mappa di curve di indifferenza rispetto alla perdita sociale, le curve

saranno circonferenze concentriche rispetto al bliss point che si allargano a mano a mano che

aumenta lo scarto tra i valori attuali delle variabili obiettivo e quelli ottimali, secondo una progressione geometrica. In figura Pt è l’inflazione e Q la produzione.

ΔP̂

L0 L1

L2

L3

ΔQ

Figura 1

2. Il ruolo delle incertezze e le aspettative

Il teorema di Tinbergen, anche se espresso nella sua formulazione più semplice dimostra le

oggettive difficoltà nel raggiungimento del bliss point, ma quando andiamo ad applicare certi

risultati alla pratica, le complicazioni diventano ancora più sconcertanti.

Finora abbiamo presentato equazioni esplicative del rapporto tra obiettivi e strumenti basandoci su parametri, a e b, dati come certi. Nella realtà i policy makers pur avendo consapevolezza

della tipologia di effetti che l’utilizzo di taluni strumenti sortisce sulle variabili obiettivo, non

sono in grado di quantificare questo impatto.

Un problema fondamentale è quello di non conoscere la durata entro cui tale impatto esplicherà le sue conseguenze. Milton Friedman espone la questione servendosi del concetto di timing,

Capitolo 1: Introduzione alla teoria generale della politica economica

407

un’espressione di difficile traduzione, che sta appunto ad indicare il perdurare, di lunghezza

sconosciuta, di un certo effetto.

L’economista riguardo a questo problema consiglia di non modificare troppo spesso gli strumenti di politica economica, proprio perché essi agiscono sugli obiettivi con «ritardi lunghi e

variabili» (M. Friedman, The Lag in the Effect of Monetary Policy, in «Journal of Political Economy »1961, ottobre).

Un secondo livello di difficoltà è rappresentato dalla eventualità del verificarsi di eventi esogeni

al di fuori del controllo dei policy makers.

Vi è poi il problema della scelta tra gli strumenti utilizzabili, essa andrà operata sulla base di

particolari caratteristiche attinenti al sistema economico e riguardanti la sua maggiore propensione a subire gli effetti di una particolare tipologia di shock.

Sempre riferendoci al caso della politica monetaria e all’assunto che costringe l’autorità emittente a dover scegliere, alternativamente, se agire sull’offerta di moneta o sul livello del tasso di

interesse, essendo preclusa la possibilità di operare contemporaneamente su entrambi, l’economista William Poole ha dimostrato che sarà preferibile attuare manovre sul primo strumento se

l’instabilità del sistema colpisce, in particolare la funzione degli investimenti, ovvero sul secondo

se tale instabilità è più acuta nella funzione di domanda di moneta.

Nella prima metà degli anni Settanta, irrompe sullo scenario della ricerca l’innovativa critica

di Lucas, destinata a ribaltare, o comunque a far riflettere seriamente sui concetti alla base dei

modelli macroeconomici.

Questi modelli, cui fino ad allora si era fatto un ampio ricorso, sono, secondo Lucas, altamente

inaffidabili e ciò, in quanto, si fondano sulla idea di comportamenti stabili e matematicamente

determinati degli operatori economici. I parametri vengono estrapolati da serie storiche e, pertanto, adottare un modello economico equivale a postulare un comportamento stabile e preordinato di tutti i soggetti interessati. Orbene, secondo Lucas, seppure fosse possibile individuare

parametri matematici in grado di esplicare gli effetti dei diversi strumenti di politica economica,

questi parametri sarebbero destinati a crollare miseramente qualora le linee guida della politica

economica stessa fossero in evoluzione.

In pratica, ogni qual volta i policy makers modificano la politica economica, anche gli operatori

modificano i comportamenti, con effetti imprevedibili sul sistema.

La critica di Lucas, che emerse in un periodo di grandi sconvolgimenti economici che avevano gettato gambe all’aria le posizioni fino ad allora giudicate incontrovertibili, prima tra tutte

la curva di Phillips, riscontrò un immediato successo e soltanto in seguito, smentita da alcuni

risultati empirici, è diventata essa stessa argomento di discussione e sprone alla ricerca.

In modo coerente al pensiero di Lucas, il monetarista Friedman espone la regola del K per

cento, secondo la quale, onde evitare gli effetti, comunque imprevedibili delle politiche monetarie,

quando queste vengono modificate di continuo, sarebbe preferibile fissare l’espansione dell’offerta

di moneta ad una percentuale nota ed annunciata, che permane costante nel tempo, alla stessa

velocità aumenterà anche l’inflazione.

Il comportamento effettivo dei policy makers è stato anch’esso oggetto di studio ed analisi. In

particolare si discute se sia lecita un’assoluta discrezionalità nell’adozione di politiche economiche o se sia più giusto dare una serie di regole fisse a cui le autorità devono comunque attenersi

durante il loro mandato.

È questa l’analisi della incoerenza dinamica. Il quesito alla base di tale prospettiva di ricerca

del problema può essere sintetizzato nel seguente modo: una volta stabilite le linee guida della

politica economica, è preferibile lasciare che i governi possano discrezionalmente modificare

le stesse, di volta in volta, a seconda delle necessità del momento, o sarebbe opportuno che, una

volta stabilite, le linee guida venissero rispettate?

La questione è abbastanza complessa. Si consideri, per esempio il caso dell’inflazione.

Se il governo annuncia un programma di stretta creditizia e di rigidi controlli e mantiene la

promessa, i sindacati potrebbero fidarsi e non avanzare richieste eccessive di rialzi degli stipendi

in sede di rinnovo dei contratti. Ovviamente il presupposto è che i sindacati mirino a mantenere

408

Parte Prima: Manuale - Libro Quinto: Elementi di Politica economica

costante il livello del salario reale e, quindi, ad ottenere che il rialzo del salario nominale sia della

stessa entità e degli stessi punti percentuali dell’inflazione prevista.

Questo scenario potrebbe condurre ad un’incoerenza dinamica del sistema, in quanto se i

salari aumentano in modo ridotto e persiste disoccupazione ad un livello maggiore rispetto a

quello naturale, il governo, adottando un comportamento incoerente, sarebbe tentato di attuare

una espansione creditizia con effetti inflattivi per ridurre di fatto il salario reale ed aumentare

la domanda di lavoro.

Anticipando questa sorta di «tradimento», il sindacato potrà, in sede contrattuale, indipendentemente dalle affermazioni preventive del governo circa il livello di inflazione, «non crederci»

e avanzare richieste esose che darebbero il via a forti pressioni inflazionistiche, o ad altre forme

di instabilità come scioperi e manifestazioni di piazza, che, come sappiamo, non fanno bene

all’economia.

Un altro esempio che illumina il meccanismo perverso dell’incoerenza temporale è legato al

gettito fiscale. Solitamente il governo desidera sostenere la spesa pubblica con il gettito fiscale

perché questo metodo non produce inflazione rispetto ad altri meccanismi di finanziamento.

Per ottenere un ammontare cospicuo di entrate si attiverà nella lotta all’evasione. Se, però, nel

breve periodo, magari incalzato da un crescente debito pubblico, cerca di rastrellare denaro

dagli evasori, promettendo il condono, si genera un effetto perverso di questo tipo: nel breve

periodo ci saranno maggiori entrate, ma in generale, il governo perde credibilità rispetto alla

lotta all’evasione ed i contribuenti sarebbero nel lungo periodo incoraggiati ad evadere, perché

tanto, prima o poi arriva il condono.

D’altro canto, stabilire linee guida fisse, limitando la flessibilità e la discrezionalità in politica

economica potrebbe rivelarsi controproducente, soprattutto se a questa rigidità si accompagna

l’uso di modelli macroeconomici non troppo affidabili.

Sarebbe opportuno distinguere tra regole fisse, sottratte alla discrezionalità dei policy makers,

e regole così dette di feed back contenenti informazioni di ritorno, in grado di correggere le sviste

della programmazione economica. La regola di Friedman sul K costante dovrebbe essere fissa, e si

potrebbe ricorrere a manovre sul tasso di interesse, ad esempio, per il rilancio dell’occupazione.

Altri filoni di ricerca, puntano il dito, sui meccanismi alla base del consenso sociale, che nei

Paesi democratici, legittima i governi e quindi le politiche da questi attuate.

In particolare, la teoria del ciclo elettorale sostiene che i governi operino manovre espansive

dell’economia all’approssimarsi delle consultazioni elettorali ed allo scopo di essere rieletti.

Queste manovre, quali ad esempio l’aumento della spesa pubblica, gli incentivi all’occupazione,

l’ampliamento dei servizi, etc., generalmente riservano un contraccolpo inflazionistico che però

si rende evidente soltanto dopo le elezioni e dopo la conferma elettorale.

A questo punto, gioco forza il governo rieletto sarà «costretto» a manovre antinflattive di

solito largamente impopolari, quali, ad esempio, il blocco delle assunzioni pubbliche, il taglio

delle spese per i servizi sociali, etc.

Questa interessante interpretazione dell’azione politica, non sempre è stata verificata nella realtà.

Ma i meccanismi del consenso non si limitano a costruire l’accordo tra governo ed elettori,

ma anche tra le diverse ripartizioni di governo.

In molti Paesi, tra cui il nostro, esiste un decentramento accentuato che genera separazioni

dei poteri basate tanto sulla competenza quanto sul territorio.

In simili circostanze, sarà difficile seguire linee di politica economica armoniche fra loro e ciò

che si decide a livello centrale, per esempio a livello di Ministero, può risultare completamente

travisato a livello locale e periferico. Il che, si badi, potrebbe anche essere un bene per il cittadino,

il quale, in un sistema che consente di spostarsi da una regione all’altra a costi relativamente sostenuti, potrebbe scegliere il distretto più confacente ai suoi desideri, secondo il sistema definito

vote by feet (voto con i piedi, cioè spostandosi).

Altro meccanismo cruciale di consenso è quello legato alla consistenza della maggioranza.

Risulta empiricamente rilevato (Cfr. N. Roubini e J. Sachs, Political and Economic Determinants

of Budget Deficits in the Industrial Democracies, in «European Economic Review», 1989) che,

Capitolo 1: Introduzione alla teoria generale della politica economica

409

in presenza di una maggioranza multipartitica, i governi incontrano molte più difficoltà a far

passare manovre impopolari, come lo sono solitamente quelle attuate per contrastare l’inflazione;

in questi casi vi saranno pesanti ripercussioni sui deficit di bilancio.

Risulta altresì dimostrato (Cfr. A. Alesina, G.Tabellini, A positive Theory of Fiscal Deficits

and Government Debt in a Democracy, National Bureau of Economic Research Working Paper

n. 2308, 1987) che nei Paesi in cui avvenga una frequente alternanza tra coalizioni politiche, le

politiche fiscali sono spesso espansive, ciò per due motivi: in primo luogo per comportamenti

simili a quelli descritti nella teoria dei cicli elettorali ed, inoltre, perché il governo uscente, non

si fa remora di far ereditare all’avversario politico altissimi deficit di bilancio.

3. L’economia del benessere

L’economia del benessere rappresenta quella parte della Politica economica che, facendo

riferimento a concetti filosofici, mira alla definizione di interesse pubblico. Essa si serve di

termini quali: «obiettivo sociale», «ordinamento sociale» e «funzione di benessere sociale».

Diciamo, innanzitutto, che l’intero discorso sull’economia del benessere sottostà alla interpretazione normativa della politica economica, cui si è accennato nell’introduzione di questo capitolo.

In economia del benessere si definisce ordinamento sociale una graduatoria dei possibili stati

del mondo o stati sociali: per stato del mondo è da intendersi una possibile condizione, riferita

ad una comunità, in cui siano determinate le caratteristiche di esistenza e funzionamento sotto

ogni aspetto (economico, sociale, giuridico, ideologico, filosofico, etc.). Una volta compiutamente

definiti più stati del mondo, è possibile che questi vengano ordinati secondo un criterio di preferenza, che individui, alla fine, in quale di essi viene massimizzata la soddisfazione collettiva.

Il principio della preferenza gode della proprietà transitiva, cioè se lo stato a è preferito allo

stato b e lo stato b è preferito allo stato c, lo stato a risulta preferito allo stato c.

L’ordinamento può non essere completo in quanto taluni stati del mondo potrebbero risultare

non identificati rispetto al principio di preferenza secondo il quale è ordinata la graduatoria.

Poiché ogni stato del mondo risulta connotato da elementi non esclusivamente economici,

ma anche sociali, giuridici ed ideologici, l’ordinamento sociale (social ordering) si basa su giudizi

di valore.

Gli ordinamenti sociali possono essere costruiti con metodi indiretti o diretti.

Il metodo diretto, in riferimento ad un principio postulato dall’esterno, ad esempio il principio egalitario, consente di ordinare i diversi stati del mondo a seconda se essi siano più o meno

aderenti a tale principio.

Il limite di questo metodo è che esso non tiene conto delle effettive preferenze degli

individui appartenenti alla collettività, tali preferenze potrebbero, al limite, risultare del tutto

estranee rispetto al postulato prescelto come elemento ordinatore.

Con l’utilizzo di metodi diretti, la graduatoria tra gli stati del mondo potrebbe, teoricamente,

essere compilata da un soggetto esterno alla collettività, un riformatore o un filosofo, ad esempio.

I metodi indiretti sono usati molto più frequentemente nell’economia del benessere, essi

si propongono di valutare, in prima istanza, le preferenze individuali degli appartenenti alla

collettività, in tal modo le preferenze collettive vengono ricavate indirettamente e per mero

riflesso. Anche in questi metodi si parte da un postulato rispetto al quale operare confronti tra

diverse situazioni.

Questi metodi seguono l’impostazione dell’individualismo etico, definito anche welfarismo

o benesserismo, secondo tale orientamento di ispirazione liberale, soltanto al singolo individuo

spetta la valutazione del proprio livello di soddisfazione e pertanto la preferenza per un dato stato

del mondo va rilevata a livello di singolo e non a livello collettivo.

I metodi indiretti traggono da questa impostazione alcuni dei loro limiti più rilevanti: in primo

luogo possono trascurare completamente alcune caratteristiche degli stati del mondo preferendone altre: ad esempio la considerazione del livello dei redditi, potrebbe oscurare principi quali

il grado di libertà concesso agli individui, cioè, se si utilizza come principio di preferenza, il più

410

Parte Prima: Manuale - Libro Quinto: Elementi di Politica economica

alto tenore di vita, uno stato del mondo caratterizzato da maggiore ricchezza sarà preferito ad

un altro in cui gli individui, complessivamente meno ricchi, godono, di maggiore democraticità.

A ben vedere tale limite si incontra anche quando si utilizzino metodi diretti.

Un secondo limite, altrettanto gravoso dei metodi indiretti, consiste nel fatto che essi valutino le preferenze individuali come «spontanee», non tenendo conto del fatto che queste siano,

almeno in una certa misura, socialmente determinate, ossia scaturiscano da condizionamenti

ambientali e da manipolazioni dell’opinione pubblica (preferenze esogene).

I metodi di ordinamento sociale indiretto pongono sul tavolo il problema della aggregazione delle preferenze individuali.

Una volta raccolte informazioni circa le preferenze dei diversi membri della collettività rispetto ai differenti stati del mondo, per costruire l’ordinamento occorre passare a determinare

la graduatoria delle preferenze collettivamente espresse.

Rispetto alla questione dell’aggregazione delle preferenze individuali si individuano due

diverse scuole di pensiero.

L’orientamento, che fa capo a Pareto, afferma che la valutazione individuale del livello di

soddisfazione può essere soltanto ordinale, ossia il soggetto può individuare la propria personale graduatoria degli stati del mondo ma è ben lungi dal poter esprimere cardinalmente la sua

soddisfazione.

Nel passaggio da uno stato del mondo all’altro l’individuo potrà semplicemente informarci se

sia più o meno felice, ma non potrà dirci in che misura.

Questa impostazione nega la possibilità di un raffronto tra le soddisfazioni di più individui, ciascuno caratterizzato da un proprio modo di sentire, e pertanto la preferenza sociale

non può essere ricavata per sommatoria.

Tecnicamente, per determinare l’ordinamento sociale occorrerà ricorrere ad altri sistemi

come quello delle votazioni.

Il principio paretiano della inconfrontabilità del livello di soddisfazione è stato ripreso da

Robbins a partire dagli anni Trenta che ha fondato la corrente denominata «Nuova economia

del benessere».

Una seconda scuola di pensiero fa, invece, riferimento a Pigou, autore inglese che nel 1920

pubblicò «L’economia del benessere», libro che pose alla ribalta le problematiche affrontate da

questa branca della politica economica.

Il principio su cui si basa Pigou è quello di uguale capacità di soddisfazione tra gli individui,

successivamente negato da Robbins, le situazioni degli individui sarebbero, perciò, confrontabili.

Sul piano pratico le differenze tra le due scuole appaiono ricche di conseguenze.

Se le soddisfazioni degli individui non sono confrontabili, nessun legislatore, potrà mai, ad

esempio, operare alla Robin Hood, cioè sottrarre anche un solo centesimo al più ricco per aumentare le entrate del più povero, in quanto non saprà se il nuovo stato del mondo è preferibile

a quello precedente, il che risulterebbe verificato soltanto se la perdita di soddisfazione del ricco

fosse compensata da un incremento della soddisfazione del povero di maggiore entità.

D’altro canto, pur ammettendo, con Pigou, la possibilità di misurare cardinalmente il livello di

soddisfazione, si potrebbe non essere d’accordo sulla possibilità di operare confronti tra i livelli

di soddisfazione dei diversi individui.