11 Statistica - 3o canale (P-Z) - Prof.ssa M. Barbieri - a.a. 2005-2006

1

12

10

8

y

Consideriamo un riferimento cartesiano in cui

i valori di una variabile compaiono sull’asse

orizzontale e quelli dell’altra variabile sull’asse

verticale. I dati riferiti a ciascuna unità vengono

rappresentati sul grafico come un punto di

coordinate pari alle modalità delle due variabili

rilevate su quella unità.

Il diagramma di dispersione è

6

Un diagramma di dispersione aiuta a studiare la

relazione tra due variabili quantitative rilevate

sulle stesse unità.

X 2 2 11 8 6 5 2 11 4 5 3 3

Y 10 5.8 1.8 2.2 2.8 3.5 9.4 1.1 4.5 7 8.5 13

4

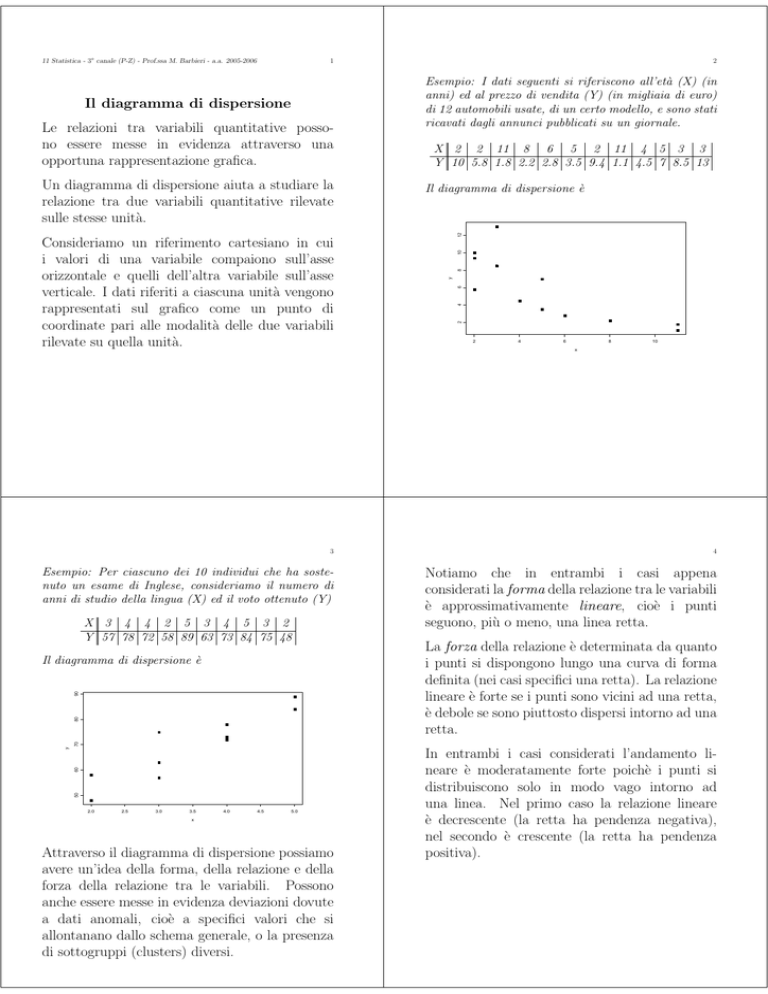

Le relazioni tra variabili quantitative possono essere messe in evidenza attraverso una

opportuna rappresentazione grafica.

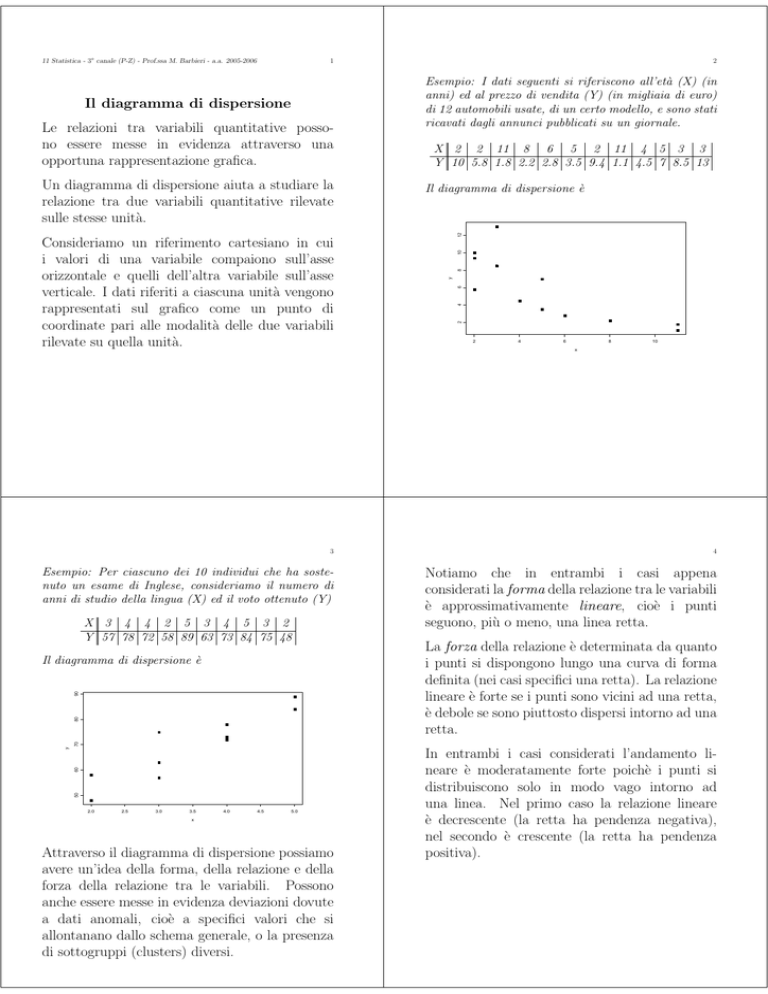

Esempio: I dati seguenti si riferiscono all’età (X) (in

anni) ed al prezzo di vendita (Y) (in migliaia di euro)

di 12 automobili usate, di un certo modello, e sono stati

ricavati dagli annunci pubblicati su un giornale.

2

Il diagramma di dispersione

2

2

4

6

8

10

x

3

4

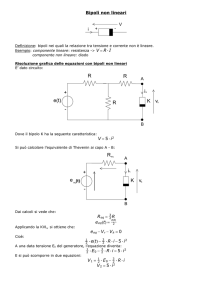

Esempio: Per ciascuno dei 10 individui che ha sostenuto un esame di Inglese, consideriamo il numero di

anni di studio della lingua (X) ed il voto ottenuto (Y)

Notiamo che in entrambi i casi appena

considerati la forma della relazione tra le variabili

è approssimativamente lineare, cioè i punti

seguono, più o meno, una linea retta.

X 3 4 4 2 5 3 4 5 3 2

Y 57 78 72 58 89 63 73 84 75 48

La forza della relazione è determinata da quanto

i punti si dispongono lungo una curva di forma

definita (nei casi specifici una retta). La relazione

lineare è forte se i punti sono vicini ad una retta,

è debole se sono piuttosto dispersi intorno ad una

retta.

50

60

y

70

80

90

Il diagramma di dispersione è

2.0

2.5

3.0

3.5

4.0

4.5

5.0

x

Attraverso il diagramma di dispersione possiamo

avere un’idea della forma, della relazione e della

forza della relazione tra le variabili. Possono

anche essere messe in evidenza deviazioni dovute

a dati anomali, cioè a specifici valori che si

allontanano dallo schema generale, o la presenza

di sottogruppi (clusters) diversi.

In entrambi i casi considerati l’andamento lineare è moderatamente forte poichè i punti si

distribuiscono solo in modo vago intorno ad

una linea. Nel primo caso la relazione lineare

è decrescente (la retta ha pendenza negativa),

nel secondo è crescente (la retta ha pendenza

positiva).

5

Ad occhio è difficile giudicare quanto una

relazione lineare sia forte. I due grafici seguenti

si riferiscono agli stessi dati, ma hanno scale

differenti.

6

La correlazione lineare

Supponiamo di voler studiare il legame tra

due variabili statistiche X ed Y entrambe

quantitative, rilevate sulle n unità di un collettivo

45

50

(xi, yi)

i = 1, 2, . . . , n

σx2 e µy ,

σy2,

30

y

35

40

di media e varianza µx,

rispettivamente.

15

20

25

Si dice che tra le variabili X ed Y vi è

concordanza o che sono associate positivamente

se a valori di X inferiori alla media corrispondono

valori di Y inferiori alla media ed a valori

di X superiori alla media corrispondono valori

di Y superiori alla media. Cioè i prodotti

(xi − µx)(yi − µy ) sono in maggioranza positivi.

Mentre vi è discordanza o sono associati

negativamente se a valori di X inferiori alla media

corrispondono valori di Y superiori alla media ed

a valori di X superiori alla media corrispondono

valori di Y inferiori alla media. Cioè i prodotti

(xi − µx)(yi − µy ) sono in maggioranza negativi.

0.5

1.0

1.5

2.0

2.5

20

25

y

30

35

x

1.2

1.4

1.6

1.8

x

Il primo sembra indicare una relazione lineare più

forte. E’ necessario un indicatore numerico.

7

8

Una misura sintetica delle relazioni quantitative

tra X ed Y , ottenuta come media aritmetica di

tali prodotti, è la covarianza

1 n

σxy = Cov(X, Y ) =

(x − µx)(yi − µy ).

n i=1 i

Le medie valgono

Esempio: Supponiamo di aver osservato i seguenti dati

x

6

2

2

-2

X 6 2 2 -2

Y 5 5 -3 -3

Il diagramma di dispersione mostra un’associazione

positiva

µx =

6+2+2−2

=2

4

µy =

5+5−3−3

= 1.

4

e

Allora

y x − µx y − µy (x − µx)(y − µy )

5

4

4

16

5

0

4

0

-3

0

-4

0

-3

-4

-4

16

0

0

32

6

Si noti che la somma degli scarti dalla media in

entrambi i casi è 0, come ci aspettavamo.

-4

-2

0

y

2

4

Per calcolare la covarianza basta dividere il totale

dell’ultima colonna per il numero delle unità sulle quali

sono state effettuate le osservazioni (bivariate), cioè

n = 4. Quindi

32

σxy =

= 8.

4

-4

-2

0

2

x

4

6

8

9

10

Un’utile formula alternativa per il calcolo della

covarianza è

Se si dispone direttamente della distribuzione

doppia di frequenze, la covarianza si calcola come

1 k

h (x − µx)(yj − µy )nij =

σxy =

n i=1 j=1 i

σxy = µxy − µxµy

in cui

1 n

xy

µxy =

n i=1 i i

è la media del prodotto delle due variabili.

=

µxy =

e

(xi − µx)(yj − µy )fij

i=1 j=1

σxy = µxy − µxµy

in cui la media del prodotto è definita come

1 k

k

h h xiyj nij =

xiyj fij .

µxy =

i=1 j=1

n i=1 j=1

Esempio: Data la distribuzione doppia

Se riprendiamo l’esempio, si ha

da cui

k

o attraverso la

Infatti: σxy = n1 ni=1(xi − µx)(yi − µy ) = n1 ni=1 xiyi −

− µx n1 ni=1 yi − µy n1 ni=1 xi + µxµy = µxy − µxµy .

x

6

2

2

-2

h

x/y

0 1 2 totale

-1 0.2 0.3 0.1 0.6

0

0.1 0.1 0.2 0.4

totale 0.3 0.4 0.3

1

y x·y

5 30

5 10

-3 -6

-3 6

40

si ha µx = −1 · 0.6 + 0 · 0.4 = −0.6,

µy = 0 · 0.3 + 1 · 0.4 + 2 · 0.3 = 1,

µxy = 0 · (−1) · 0.2 + 0 · 0 · 0.1 + 1 · (−1) · 0.3 + 1 · 0 · 0.1 +

+ 2 · (−1) · 0.1 + 2 · 0 · 0.2 = −0.5

e

σxy = −0.5 − (−0.6) · 1 = 0.1

n

1 40

= 10

x i yi =

n i=1

4

σxy = µxy − µxµy = 10 − 2 · 1 = 8.

11

12

Che tipo di dipendenza tra X e Y viene misurata

dalla covarianza?

Il legame tra X ed Y in questo caso risulta

perfettamente lineare: per ogni osservazione si ha yi =

5 + xi. Se rappresentiamo graficamente le osservazioni

su un diagramma cartesiano, si nota che il legame tra

X e Y è perfettamente rappresentato attraverso una

retta con pendenza positiva.

Esempio: Supponiamo di aver osservato i seguenti dati

9

X 1 2 3

Y 6 7 8

Si nota una precisa tendenza delle due variabili a

muoversi insieme: a valori grandi della X (cioè > µx)

corrispondono valori grandi di Y (cioè > µy ), mentre

a piccoli valori della X (< µx) corrispondono valori

piccoli di Y (< µy ). Il prodotto degli scarti tra i

valori delle variabili e la corrispondente media è sempre

positivo e la covarianza risulta positiva, infatti:

1 · 6 + 2 · 7 + 3 · 8 44

µxy =

=

3

3

2

44

σxy = µxy − µxµy =

−2·7=

3

3

La ditribuzione doppia di frequenze relative è

x\y 6 7 8 Totale

1

1

1

3 0 0

3

1

1

2

0 3 0

3

1

1

3

0 0 3

3

1 1 1

Totale 3 3 3

1

8

= 7.

y

6+7+8

3

7

= 2 e µy =

6

1+2+3

3

5

con µx =

0

1

2

x

3

4

Se invece abbiamo osservato i dati

X 1 2 3

Y 8 7 6

con µx = 2 e µy = 7.

In questo caso si nota una precisa tendenza delle due

variabili a muoversi in direzioni opposte: a valori

piccoli della X (cioè < µx) corrispondono valori grandi

di Y (cioè > µy ), mentre a grandi valori della X

(> µx) corrispondono valori piccoli di Y (< µy ). Il

prodotto degli scarti tra i valori delle variabili e la

corrispondente media è sempre negativo e la covarianza

13

risulta negativa:

14

Se i dati osservati sono

1 · 8 + 2 · 7 + 3 · 6 40

=

3

3

2

40

σxy = µxy − µxµy =

−2·7=−

3

3

La distribuzione di frequenze relative congiunta di X e

Y è

µxy =

X 1 1 1 2 2 2 3 3 3

Y 6 7 8 6 7 8 6 7 8

con µx = 2 e µy = 7, la distribuzione di frequenze

relative congiunta di X e Y è

x\y 6 7 8 Totale

1 1 1

1

1

9 9 9

3

1 1 1

1

2

9 9 9

3

1 1 1

1

3

9 9 9

3

1 1 1

Totale 3 3 3

1

x\y 6 7 8 Totale

1

1

0 0 13

3

1

1

2

0 3 0

3

1

1

3

3 0 0

3

1 1 1

Totale 3 3 3

1

z

5

6

7

8

9

Anche in questo caso il legame tra X ed Y è

perfettamente lineare: per ogni osservazione si ha yi =

9 − xi. Se rappresentiamo graficamente la distribuzione

su un diagramma cartesiano, si nota che il legame tra

X e Y è perfettamente rappresentato da una retta con

pendenza negativa.

0

1

2

x

3

4

Non si nota alcuna tendenza delle due variabili a

muoversi congiuntamente: a valori piccoli della X

corrispondono valori sia grandi che piccoli di Y ed a

grandi valori della X corrispondono sia valori piccoli

che valori grandi di Y . Alcuni prodotti degli scarti

tra i valori delle variabili e la corrispondente media

sono positivi, altri negativi. Nel calcolo della media si

compensano dando luogo ad una covarianza nulla:

1

1

1

µxy = 1 · 6 + 1 · 7 + 1 · 8 +

9

9

9

1

1

1

+ 2·6 +2·7 +2·8 +

9

9

9

1

1

1 126

+ 3·6 +3·7 +3·8 =

= 14

9

9

9

9

σxy = µxy − µxµy = 14 − 2 · 7 = 0

15

Nell’esempio sulle auto usate in vendita

x

2

2

11

8

6

5

y 10 5.8 1.8 2.2 2.8 3.5

xy 20.0 11.6 19.8 17.6 16.8 17.5

7

totale

x

2

11

4

5

3

3

62

y 9.4 1.1 4.5

7

8.5 13 69.6

xy 18.8 12.1 18.0 35.0 25.5 39.0 251.7

5

6

y

8

9

Tra X ed Y non vi è un legame lineare, come si

può notare anche dalla rappresentiamo grafica della

distribuzione.

16

0

1

2

x

3

4

e

In effetti in questo caso tra le due variabili non vi

è alcun tipo di legame, poichè X ed Y risultano

indipendenti.

Gli ultimi esempi considerati sono riferiti a

situazioni estreme.

Di solito in casi reali

abbiamo a che fare con situazioni intermedie, in

cui comunque le motivazioni della formula che

definisce la covarianza restano invariate.

σxy = µxy − µxµy =

251.7 62 69.6

−

= 20.98 − 5.17 · 5.8 = −9.006

12

12 12

Mentre nell’esempio sull’esito dell’esame di Inglese

totale

x

3

4

4

2

5

3

4

5

3 2

35

y 57 78 72 58 89 63 73 84 75 48 697

xy 171 312 288 116 445 189 292 420 225 96 2554

e

σxy = µxy − µxµy =

2554 35 697

−

= 255.4 − 3.5 · 69.7 = 11.45

10

10 10

La covarianza misura il grado con cui due variabili

sono legate linearmente. Tuttavia ha il difetto di

dipendere dall’unità di misura di X ed Y e di non

avere un valore minimo e massimo ben definiti.

17

che, in modo equivalente, può essere espresso

come

1 n (x − µ )(y − µ )

x i

y

rxy = n i=1 i

=

σxσy

σxy

Cov(X, Y )

=

.

=

σxσy

V ar(X)V ar(Y )

X 6 2 2 -2

Y 5 5 -3 -3

0

y

2

4

6

con diagramma di dispersione

-2

Se calcoliamo la loro covarianza otteniamo il

coefficiente di correlazione lineare di

Bravais-Pearson

1 n xi − µx yi − µy

rxy = Corr(X, Y ) =

n i=1

σx

σy

Esempio: Nel caso, già considerato, in cui si abbiano i

seguenti dati

-4

In generale le due distribuzioni marginali di X e

Y avranno presumibilmente posizione e variabilità differenti (potrebbero anche essere espresse

in unità di misura diverse). E’ conveniente

considerare i dati standardizzati, cioè

x i − µx

y i − µy

e

.

σx

σy

18

-4

-2

0

2

4

6

8

x

µx = 2, µy = 1, σxy = 8 e per le varianze si ha

36 + 4 + 4 + 4

− 22 = 8

4

25 + 25 + 9 + 9

− 12 = 16

σy2 =

4

σx2 =

da cui

σx =

√

8 = 2.8

σy =

√

16 = 4

ed il coefficiente di correlazione vale

8

rxy =

= 0.71

2.8 · 4

19

Il coefficiente di correlazione lineare rxy è una

misura del grado di dipendenza lineare tra le due

variabili X e Y che gode delle seguenti proprietà:

20

Nell’esempio sulle auto usate in vendita

x

2

2

y

10

5.8

x2

4

4

y2 100.00 33.64

• −1 ≤ rxy ≤ 1 ed il suo valore non dipende

dall’unità di misura dei due caratteri (è un

numero puro), quindi non cambia quando si

cambiano le unità di misura di X, di Y o di

entrambi.

• il segno di rxy dipende dal segno della

covarianza σxy . Se i due caratteri variano

nello stesso senso, sia rxy che σxy saranno

positivi e si dice che i due caratteri sono

correlati positivamente. Se i due caratteri

variano in senso inverso, sia rxy che σxy saranno

negativi e si dice che i due caratteri sono

correlati negativamente. Se rappresentiamo i

due caratteri su un diagramma cartesiano, ogni

unità sarà individuata da un punto. Il segno di

rxy è legato alla direzione media complessiva del

legame lineare, che è quella di una retta che passa

per la nuvola dei punti.

x

2

y 9.4

x2

4

y2 88.36

Allora

11

8

6

5

1.8 2.2 2.8 3.5

121 64 36

25

3.24 4.84 7.84 12.25

totale

11

4

5

3

3

62

1.1 4.5

7

8.5

13

69.6

121 16

25

9

9

438

1.21 20.25 49.00 72.25 169.00 561.9

438

− 5.172 = 9.8

12

561.9

σy2 =

− 5.82 = 13.2

12 √

σx = 9.8 = 3.1

√

σy = 13.2 = 3.6

σx2 =

e

σxy

−9.006

= −0.81

=

σxσy 3.1 · 3.6

che indica un legame lineare negativo piuttosto forte tra

le due variabili.

rxy =

21

• rxy = 0 quando σxy = 0. Questo avviene

quando X ed Y sono indipendenti, ma anche

quando la somma dei prodotti degli scostamenti

discordi si compensa con quella degli scostamenti

concordi. In questo caso i caratteri si dicono

incorrelati.

Mentre nell’esempio sull’esito dell’esame di Inglese

x

3

4

4

2

5

3

y 57

78

72

58

89

63

x2 9

16

16

4

25

9

y2 3249 6084 5184 3364 7921 3969

totale

x

4

5

3

2

35

y 73

84

75

48

697

x2 16

25

9

4

133

y2 5329 7056 5625 2304 50085

Allora

22

Attenzione:

se X ed Y sono indipendenti sono

anche incorrelate, cioè tra loro non vi è

una dipendenza di tipo lineare, non essendoci

in realtà dipendenza di qualsiasi natura.

Infatti se sono indipendenti si ha

133

− 3.52 = 1.05

10

50085

σy2 =

− 69.72 = 150.41

10 √

σx = 1.05 = 1.0

√

σy = 150.41 = 12.3

σx2 =

µxy = µxµy

Poiché µxy = n1 hi=1 kj=1 xiyj nij =

n n

= n1 hi=1 kj=1 xiyj i·n ·j = n1 hi=1 xini· n1 kj=1 yj n·j

e

σxy

11.45

= 0.93

=

σxσy 1 · 12.3

che indica un forte legame lineare positivo tra le due

variabili.

rxy =

Dal momento che σxy = µxy − µxµy , segue

che

σxy = rxy = 0.

se X ed Y sono incorrelate non

è detto che siano indipendenti.

L’assenza di dipendenza lineare non esclude la

23

presenza di dipendenza di natura diversa tra

le due variabili. D’altra parte il fatto che

σxy = rxy = 0

cioè che

µxy = µxµy

non implica che per ogni possibile coppia di

valori xi ed yj si abbia

n n

nij = i· ·j .

n

Esempio: Consideriamo la distribuzione di frequenze

relative doppia

y\x −1 0 1 Totale

1

−1

0 14 0

4

1

1

1

0

4 0 4

2

1

1

1

0 4 0

4

1

1 1

Totale 4 2 4

1

Dal momento che, ad esempio,

11

= f1·f·1

f11 = 0 =

44

le due variabili non sono indipendenti. Tuttavia µx =

= µy = 0 e µxy = 0, da cui σxy = rxy = 0, cioè X ed Y

sono incorrelate linearmente.

24

• rxy vale +1 o −1 solo quando i due caratteri

sono legati da un perfetto legame lineare del tipo

yi = α + βxi. In particolare rxy = +1 se β > 0

e rxy = −1 se β < 0.

Infatti se yi = α + βxi, allora µy = α + βµx, σy2 = β 2σx2

e σy = |β|σx. Ma σxy = n1 ni=1(xi − µx)(yi − µy ) =

β n

1 n

2

2

n i=1 (xi −µx )(α+βxi −α−βµx ) = n i=1 (xi −µx ) = βσx .

2

σxy

βσx

β

Quindi rxy = σxσy = σx|β|σx = |β| , cioè rxy = 1 se β > 0 e

rxy = −1 se β < 0.

Esempio: Se riprendiamo i dati

X 1 2 3

Y 6 7 8

sappiamo che µx = 2, µy = 7 e σxy = 23 . Inoltre

σx2 = 1+4+9

− 4 = 23 , σx = 23 , σy2 = 36+49+64

− 49 = 23 ,

3

3

σx =

2

3

e

rxy =

σxy

2/3

=

= 1.

σxσy

(2/3)(2/3)

25

26

sappiamo che µx = 2, µy = 7 e σxy = − 23 . Inoltre

σx2 = σy2 = 23 , σx = σy = 23 e

• rxy esprime il grado di prevedibilità lineare di

una variabile rispetto ad un’altra. Se il valore

(assoluto) di rxy è elevato, la conoscenza ad

esempio di X aiuta nella previsione di Y : il valore

di Y si posizionerà, con bassa variabilità, intorno

al valore determinato da quello di X e dalla retta

che passa per la nuvola dei punti. Se rxy è molto

vicino a zero, tutti i punti saranno “intorno”

ad una retta parallela all’asse delle ascisse: la

conoscenza di X non aiuta a prevedere Y .

Mentre se riprendiamo i dati

X 1 2 3

Y 8 7 6

rxy =

−2/3

= −1.

(2/3)(2/3)

• il valore numerico di rxy esprime la forza del

legame lineare, cioè la misura dell’intensità della

relazione lineare tra X ed Y .

• rxy non distingue il ruolo delle due variabili.

Nel misurare la correlazione non fa differenza

quale variabile chiamiamo con X e quale con Y .

2 (0 ≤ r 2 ≤ 1) è una misura della vicinanza

• rxy

xy

della nuvola dei punti alla retta che la attraversa

perché, a prescindere dal segno, il suo valore

cresce con l’addensarsi dei valori osservati attorno

a tale retta.

Esempio: In un collettivo di n = 5 famiglie è

stato misurato il reddito X ed il consumo mensile per

spese alimentari Z (entrambi in Euro). Definiamo la

variabile Y = 100 Z/X, la quota percentuale di spese

per consumi alimentari

xi

1215

2510

1745

1875

3100

zi

842

1120

910

900

800

La rappresentazione della

diagramma cartesiano è

yi

69.3

44.6

52.1

48.0

25.8

distribuzione

su

un

27

28

20

30

40

y

50

60

70

• come media e varianza, rxy non è un indicatore

robusto: può essere influenzato dalla presenza di

“outliers”. Se il diagramma di dispersione mette

in evidenza la presenza di dati anomali, bisogna

far attenzione all’interpretazione di rxy .

che indica la presenza di un forte legame lineare tra i

due caratteri: quando X cresce, Y tende a diminuire e

viceversa.

xi 1 2 3 4

yi 2 2 2 4

per i quali si ha

5

Calcoliamo il coefficiente di correlazione lineare

n

1 µx =

xi = 2089

n i=1

n

1 µy =

yi = 48

n i=1

n

1 σx2 =

x2 − µ2x = 425474

n i=1 i

σx = 652.2837

n 2

1 y − µ2y = 194.98

σy2 =

n i=1 i

σy = 13.96352

n

1 σxy =

xiyi − µxµy = −8780.76

n i=1

Allora

σxy

−8780.76

= −0.964

rxy =

=

σxσy 652.2837 · 13.96352

Esempio: Supponiamo di aver osservato i

seguenti dati

4

3000

3

2500

x

2

2000

1

1500

y

1000

0

1

2

3

4

5

x

e µx = 2.5, µy = 2.5, σx2 = 1.25, σy2 = 0.75,

2 = 0.75, r = √ 0.75

= 0.77.

σxy

xy

1.25·0.75

Notiamo che, se togliamo i dati rilevati

sull’ultima unità rxy = 0.

29

Media e varianza di combinazioni lineari

di variabili

Date due variabili X e Y e due costanti reali α e

β, se consideriamo αX + βY , per la proprietà di

linearità della media

µαX+βY = αµX + βµY .

30

In particolare

var(X + Y ) = var(X) + var(Y ) + 2 cov(X, Y )

e

var(X − Y ) = var(X) + var(Y ) − 2 cov(X, Y ).

Infatti, ad esempio,

In particolare

var(X − Y ) =

µX+Y = µX + µY

µX−Y = µX − µY .

=

=

Questa proprietà è di particolare importanza

poiché ci consente di calcolare il valor medio

di una variabile, definita come combinazione

lineare di altre variabili, senza che sia necessario

determinarne la distribuzione.

La proprietà precedente, valida per la media, non

è vera per la varianza:

Esempio: Riprendiamo i dati

X 6 2 2 -2

Y 5 5 -3 -3

con µx = 2, µy = 1, σx2 = 8 σy2 = 16 e σxy = 8.

Supponiamo che Z = X + Y , allora

Z 11 7 -1 -5

11 + 7 − 1 − 5

=3

4

2

2

11 + 7 + (−1)2 + (−5)2

σz2 =

− 32 = 40

4

che avremmo anche potuto ottenere, senza ricavare

esplicitamente i valori di Z, come

µX+Y = µX + µY = 2 + 1 = 3

var(X + Y ) = var(X) + var(Y ) + 2 cov(X, Y ) =

= 8 + 16 + 2 · 8 = 40.

Se invece consideriamo V = 2 · X − 3 · Y , allora

µV = 2µX − 3µY = 2 · 2 − 3 · 1 = 1

var(V ) = 22 · var(X) + (−3)2 · var(Y ) +

+ 2 · 2 · (−3)cov(X, Y ) =

= 4 · 8 + 9 · 16 + 2 · 2 · (−3) · 8 = 80.

=

Se X ed Y sono incorrelate cov(X, Y ) = 0 e

var(X + Y ) = var(X) + var(Y )

var(X − Y ) = var(X) + var(Y ).

31

µz =

−

e

var(αX + βY ) = α2var(X) + β 2var(Y ) +

+ 2αβcov(X, Y ).

da cui

=

n

1 [(xi − yi) − µX−Y ]2 =

n i=1

n

1 [xi − yi − µX + µY ]2 =

n i=1

n

1 [(xi − µX ) − (yi − µY )]2 =

n i=1

n

n

1 1 (xi − µX )2 +

(yi − µY )2 +

n i=1

n i=1

n

1 2·

(xi − µX )(yi − µY ) =

n i=1

var(X) + var(Y ) − 2 cov(X, Y )