Regressione Semplice

Analisi

Per avere una prima idea della struttura di dipendenza fra le variabili in esame, possiamo

cominciare col costruire la matrice di correlazione delle variabili presenti nel data set.

Dal menù Analyze => Correlate => Bivariate =>come Variables scegliamo SCONTO e

LEVERAGE => OK

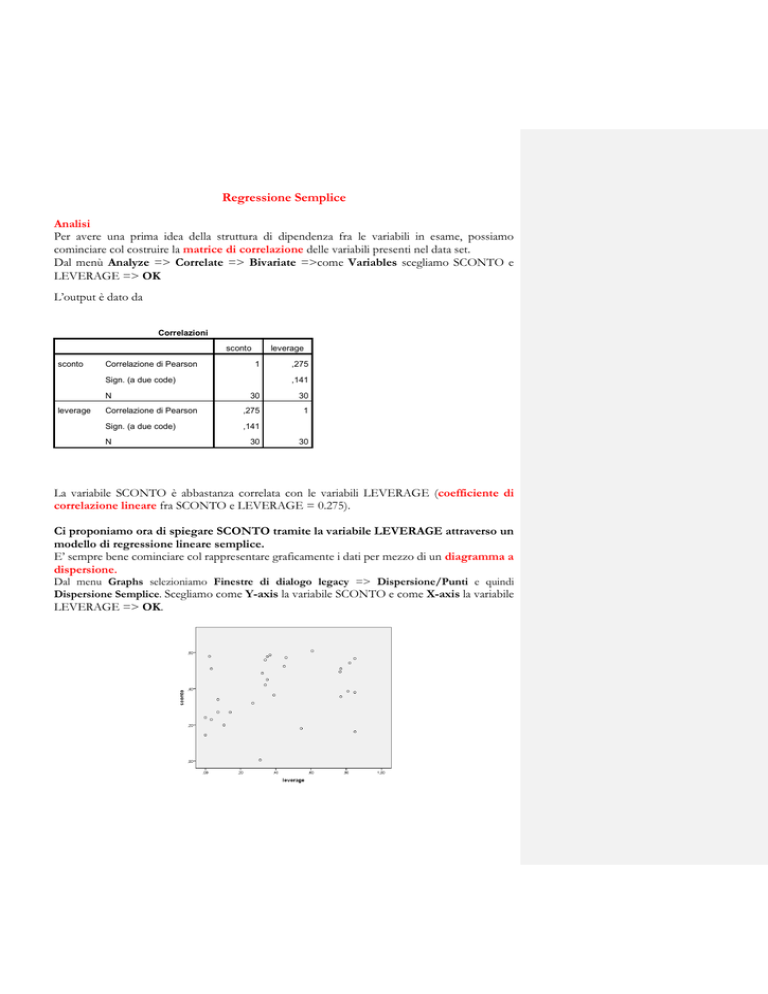

L’output è dato da

Correlazioni

sconto

sconto

Correlazione di Pearson

leverage

1

Sign. (a due code)

N

leverage

,275

,141

30

30

Correlazione di Pearson

,275

1

Sign. (a due code)

,141

N

30

30

La variabile SCONTO è abbastanza correlata con le variabili LEVERAGE (coefficiente di

correlazione lineare fra SCONTO e LEVERAGE = 0.275).

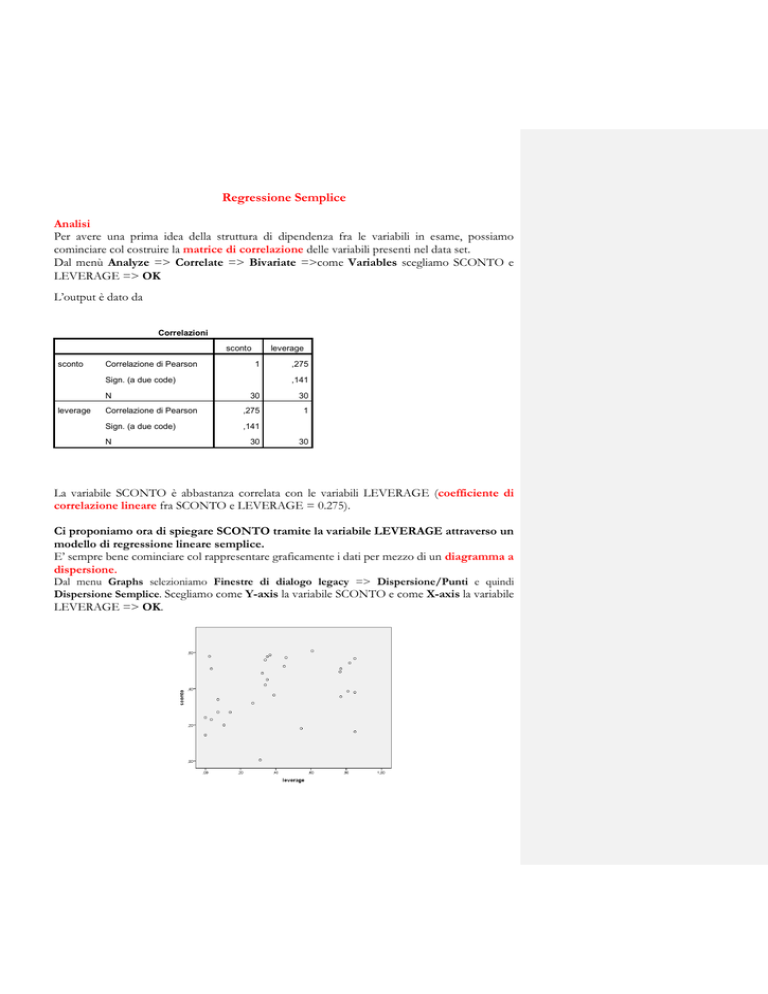

Ci proponiamo ora di spiegare SCONTO tramite la variabile LEVERAGE attraverso un

modello di regressione lineare semplice.

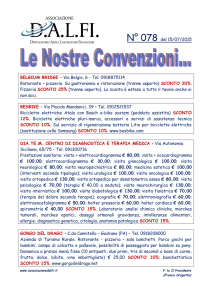

E’ sempre bene cominciare col rappresentare graficamente i dati per mezzo di un diagramma a

dispersione.

Dal menu Graphs selezioniamo Finestre di dialogo legacy => Dispersione/Punti e quindi

Dispersione Semplice. Scegliamo come Y-axis la variabile SCONTO e come X-axis la variabile

LEVERAGE => OK.

Dal diagramma di dispersione appare evidente che un modello di regressione lineare è abbastanza

adeguato a rappresentare la relazione tra SCONTO e LEVERAGE.

Il grafico mostra anche la presenza di alcuni punti anomali. DEVe quindi partire una discussione

all’interno del gruppo di ricerca per capire cosa fare al fine di non violare la 3° assunzione per la

bontà delle stime fornite dagli stimatori OLS in una regressione semplice (perché sono outliers?

toglierli/non toglierli… non è univoca la soluzione e tutto va commentato…)

Ipotizziamo che valga il seguente modello:

𝑌 = 𝛽0 + 𝛽1 𝑋 + 𝜀

𝑆𝐶𝑂𝑁𝑇𝑂 = 𝛽0 + 𝛽1 𝐿𝐸𝑉𝐸𝑅𝐴𝐺𝐸 + 𝜀

e supponiamo che siano soddisfatte le ipotesi forti degli OLS (ossia la 1°, 2° e 3°).

Dal menu Analyse, selezioniamo Regression e quindi Linear. Selezioniamo come Dependent

variable SCONTO e come Independent(s) variable LEVERAGE.

Dalla finestra Linear Regression selezioniamo

Statistics => Stime

Intervallo di confidenza

Adattamento del modello

Descriptive

e dalla finestra Residuals => Durbin Watson

Casewise Diagnostics, con Outliers outside: 2 standard

deviations

Poi Continua e si trona nella precedente finestra dove si seleziona

Save => dalla finestra Predicted values => Unstandardized

dalla finestra Residuals => Standardized (in questo modo vengono salvate

nella Window SPSS data editor, contenente la matrice di dati le

variabili PRE_1 e ZRE_1 e Studentized deleted (cioè Per cancellazione

studentizzati viene salvata nella Window SPSS data editor la variabile SDR_1)

dalla finestra Distances => Cook’s and Leverage values (vengono salvate

nella Window SPSS data editor le variabili COO_1 e LEV_1)

dalla finestra Influence Statistics => Standardized DfBeta(s) e DfFit(vengono

salvate nella Window SPSS data editor le variabili DIFF_1, SDB0_0, SDB1_1)

Poi Continua e si trona nella precedente finestra dove si seleziona

Plots => Histogram e Normal probability plot

Poi Continua e si trona nella precedente finestra dove si seleziona OK

Analisi dell’output

La tabella Descriptive Statistics (Statistica Descrittiva) contiene media e deviazione

standard delle variabili prese in esame. Lo sconto medio è 0,3943 mentre il leverage medio è

0,4020

Statistica descrittiva

Media

Deviazione std.

N

sconto

,3943

,16301

30

leverage

,4020

,29764

30

Commentato [AGQ1]:

IN REALTA’ DOBBIAMO VERIFICARLE!!!

Nella Tabella Correlazioni si trova l’r di Bravais-Pearson

Correlazioni

sconto

Correlazione di Pearson

sconto

,275

,275

1,000

.

,071

leverage

Sign. (a una coda)

sconto

leverage

N

leverage

1,000

,071

.

sconto

30

30

leverage

30

30

Variabili immesse/rimossea

Variabili

Modello

immesse

1

leverage

Variabili rimosse

b

Metodo

. Inserisci

a. Variabile dipendente: sconto

b. Sono state immesse tutte le variabili richieste.

Riepilogo del modellob

Modello

R

R-quadrato

,275a

1

R-quadrato

Errore std. della

adattato

stima

,076

,043

Durbin-Watson

,15950

1,594

a. Predittori: (costante), leverage

b. Variabile dipendente: sconto

La Tabella ANOVA in una regressione semplice non si guarda….

ANOVAa

Somma dei

Modello

1

quadrati

Media

gl

quadratica

Regressione

,058

1

,058

Residuo

,712

28

,025

Totale

,771

29

a. Variabile dipendente: sconto

b. Predittori: (costante), leverage

F

2,289

Sign.

,141b

La tabella Coefficients (Coefficienti) contiene

Coefficientia

Coefficie

nti

Coefficienti non standard

standardizzati

izzati

Errore

Modello

B

std.

Beta

t

Sign.

1

(Costa

,334

,049

6,746 ,000

nte)

levera

,151

,100

,275 1,513 ,141

ge

a. Variabile dipendente: sconto

-

95,0% Intervallo di

Statistiche di

confidenza per B

collinearità

Limite

Limite

superior

Toller

inferiore

e

anza

VIF

1,000

1,000

,232

,435

-,053

,354

le stime dei parametri del modello (intercetta e coefficiente angolare)

gli errori standard degli stimatori ottenuti con il metodo dei minimi quadrati (Errore Std.) e

le statistiche (t), i p-values (Sig.) dei test di Students e gli intervalli di confidenza dei

parametri che verificano se i parametri siano significativamente diversi da zero.

Nella tabella ottenuta, il p-value del test che verifica H0 (parametro =0) contro H1 (parametro

diverso da zero) è zero per l’intercetta, quindi a tutti i livelli di significatività si rifiuta l’ipotesi che

𝛽0 sia zero, e pari a 0,141 per il coefficiente angolare, quindi si rifiuta l’ipotesi che 𝛽1 sia uguale a

zero con l’86% di probabilità circa.

Il modello lineare stimato è dunque

𝑆𝐶𝑂𝑁𝑇𝑂 = 0,334 + 0,151𝐿𝐸𝑉𝐸𝑅𝐴𝐺𝐸 + 𝜀

All’aumentare del LEVERAGE di 1 lo SCONTO aumenta di 0,151.

Rappresentiamo ora sullo stesso grafico i valori osservati di LEVERAGE e SCONTO e la retta

interpolante (o retta di regressione). Dal menu Graphs selezioniamo Finestra di dialogo legacy

e dopo Scatter (Dispersione/Punti) e quindi Overlay (A dispersione sovrapposta) e dopo

Definisci. Come Y-X Pairs (Coppia Y-X) scegliamo dapprima la coppia di variabili SCONTO-

LEVERAGE e successivamente la coppia di variabili PRE_1-LEVERAGE. Poi OK e compare

La capacità esplicativa della variabile esplicativa LEVERAGE di rappresentare la variabile

dipendente SCONTO per mezzo di una retta può essere misurata utilizzando il coefficiente di

determinazione R ( 0 R 1 ), che è dato dal rapporto tra la devianza spiegata (o devianza del

modello) e devianza totale e rappresenta la proporzione di variabilità totale spiegata dal modello.

Nella tabella Model Summary (Riepilogo del Modello) che sta sopra leggiamo il valore di R

che rappresenta il coefficiente di correlazione lineare tra le due variabili e il valore del coefficiente

di determinazione R che è pari a 0,275. Il modello spiega il 27,5% della variabilità della variabile

SCONTO (come era facile attendersi, una variabile sola non basta…..).

2

2

2

LE 2 TABELLEQUI SOTTO POSSONO ESSERE TRALASCIATE dato che la variabile

indipendente è una solo e non si può parlare di collinearità….

Diagnostiche di collinearitàa

Proporzioni varianza

Modello

Dimensione

1

1

Autovalore

1,808

Indice contenuti

1,000

(Costante)

,10

leverage

,10

2

,192

3,073

,90

,90

a. Variabile dipendente: sconto

Diagnostiche casewisea

Numero di caso

4

Residuo std.

-2,353

a. Variabile dipendente: sconto

sconto

,01

Valore previsto

,3806

Residuo

-,37524

IN REALTA’ QUESTO CHE DICIAMO ADESSO VA FATTO PRIMA DI TUTTO!!!! E’

CON QUESTO CHE SI VERIFICANO LE ASSUNZIONI SUI RESIDUI PER LA

VALIDITA’ DELLE STIME OLS!!!!

Un ulteriore strumento per controllare la bontà di un modello di regressione è dato dall’analisi

dei residui.

Statistiche dei residuia

Minimo

Valore previsto

Valore previsto std.

Errore standard del valore

previsto

Valore previsto adattato

Massimo

Media

Deviazione std.

N

,3338

,4618

,3943

,04481

30

-1,351

1,505

,000

1,000

30

,029

,053

,040

,009

30

,3136

,4994

,3955

,04697

30

-,37524

,24124

,00000

,15673

30

Residuo std.

-2,353

1,512

,000

,983

30

Residuo stud.

-2,397

1,585

-,004

1,016

30

-,38948

,26488

-,00119

,16751

30

-2,640

1,631

-,014

1,049

30

Distanza di Mahal.

,002

2,266

,967

,840

30

Distanza di Cook

,000

,249

,035

,051

30

Valore di leva centrato

,000

,078

,033

,029

30

Residuo

Residuo eliminato

Residuo eliminato stud.

a. Variabile dipendente: sconto

Se sono verificate le ipotesi forti del modello lineare semplice, allora

i residui hanno distribuzione normale, con media zero e varianza costante;

i residui sono indipendenti

i residui e i valori stimati sono indipendenti

I due grafici successivi, un istogramma e un normal probability plot (NPP) dei residui

standardizzati, sono utilizzati per verificare se sia plausibile l’assunzione di normalità dei residui.

Come possiamo osservare dal grafico ottenuto, i residui non seguono bene approssimativamente

una distribuzione normale. Pur tenendo conto del numero basso di osservazioni, si può

concludere che c’è sufficiente evidenza di una forte violazione dell’ipotesi di normalità.

Commentato [AGQ2]:

Sono le 3 + 2 !!!!

Commentato [AGQ3]:

ASSUNZIONE 1°

Commentato [AGQ4]:

Si chiama OMOSCHEDASTICITA’!!! ASSUNZIONE 4°

Il plot dei residui standardizzati rispetto alla variabile esplicativa LEVERAGE può

evidenziare un andamento nei residui che indica non linearità e può rivelare la presenza di punti

outliers per la variabile esplicativa.

Dal menu Graphs selezioniamo Finestra di dialogo legacy e dopo Scatter (Dispersione/Punti) e

quindi Simple. Come Y-axis la variabile ZRE_1 e come X-axis la variabile LEVERAGE. Poi

OK. Si ottiene

Il plot dei residui standardizzati rispetto ai valori stimati.

Dal menu Graphs selezioniamo Finestra di dialogo legacy e dopo Scatter (Dispersione/Punti)

Scatter e quindi Simple (A dispersione Semplice) e poi Definisci. Come Y-axis selezionare la

variabile ZRE_1 e come X-axis la variabile PRE_1. Poi OK. Si ottiene

Dal momento che, se sono soddisfatte le ipotesi del modello, i residui e i valori stimati sono

indipendenti, nel grafico di punti (PRE_1 e ZRE_1) dovrebbe apparire che i valori di una delle due

coordinate non influenzano i valori dell’altra. Questo grafico può anche mostrare se è presente

eteroschedasticità, cioè se la varianza dei residui non è costante nel tempo.

Regressione Multipla

Ipotizziamo che valga il modello

𝑌 = 𝛽0 + 𝛽1 𝑋1 + 𝛽2 𝑋2 + 𝜀

𝑆𝐶𝑂𝑁𝑇𝑂 = 𝛽0 + 𝛽1 𝐿𝐸𝑉𝐸𝑅𝐴𝐺𝐸 + 𝛽2 𝑆𝐼𝑍𝐸 + 𝜀

Dal menu Analyse, selezioniamo Regression e quindi Linear. Selezioniamo come Dependent

variable SCONTO e come Independent(s) variable LEVERAGE e anche SIZE.

Dalla finestra Linear Regression selezioniamo

Statistics => Stime

Intervallo di confidenza

Adattamento del modello

Descriptive

e dalla finestra Residuals => Durbin Watson

Casewise Diagnostics, con Outliers outside: 2 standard

deviations

Poi Continua e si trona nella precedente finestra dove si seleziona

Save => dalla finestra Predicted values => Unstandardized

dalla finestra Residuals => Standardized (in questo modo vengono salvate

nella Window SPSS data editor, contenente la matrice di dati le

variabili PRE_1 e ZRE_1 e Studentized deleted (cioè Per cancellazione

studentizzati viene salvata nella Window SPSS data editor la variabile SDR_1)

dalla finestra Distances => Cook’s and Leverage values (vengono salvate

nella Window SPSS data editor le variabili COO_1 e LEV_1)

dalla finestra Influence Statistics => Standardized DfBeta(s) e DfFit(vengono

salvate nella Window SPSS data editor le variabili DIFF_1, SDB0_0, SDB1_1)

Poi Continua e si trona nella precedente finestra dove si seleziona

Plots => Histogram e Normal probability plot

Poi Continua e si trona nella precedente finestra dove si seleziona OK

Analisi dell’output

Statistica descrittiva

Media

Deviazione std.

N

sconto

,3943

,16301

30

leverage

,4020

,29764

30

size

,0449

,02698

30

Correlazioni

sconto

Correlazione di Pearson

sconto

Sign. (a una coda)

size

,275

leverage

,275

1,000

,588

size

,313

,588

1,000

sconto

N

leverage

1,000

,313

.

,071

,046

leverage

,071

.

,000

size

,046

,000

.

sconto

30

30

30

leverage

30

30

30

size

30

30

30

Variabili immesse/rimossea

Variabili

Modello

immesse

Variabili rimosse

size, leverageb

1

Metodo

. Inserisci

a. Variabile dipendente: sconto

b. Sono state immesse tutte le variabili richieste.

Riepilogo del modellob

Modello

R

R-quadrato

,333a

1

R-quadrato

Errore std. della

adattato

stima

,111

,045

Durbin-Watson

,15933

1,488

a. Predittori: (costante), size, leverage

b. Variabile dipendente: sconto

ANOVAa

Somma dei

Modello

1

quadrati

Media

gl

quadratica

Regressione

,085

2

,043

Residuo

,685

27

,025

Totale

,771

29

F

1,678

Sign.

,206b

a. Variabile dipendente: sconto

b. Predittori: (costante), size, leverage

La tabella ANOVA contiene la somma dei quadrati del modello di regressione (Regression), la

somma dei quadrati dei residui (Residuals) e la somma dei quadrati totali (Total).

Se la statistica F è altamente significativa (con un p -value prossimo a zero) si rifiuta l’ipotesi

nulla del test H0 (parametro = zero) contro H1 (parametro 0 per almeno un parametro).

Coefficientia

Coefficien

ti

Coefficienti non

standardi

95,0% Intervallo di

standardizzati

zzati

confidenza per B

Errore

Modello

1

(Costa

nte)

leverag

e

size

B

std.

,301

,059

,076

,123

1,397

1,356

Beta

t

Sign.

Statistiche di

collinearità

Limite

Limite

Tollera

inferiore

superiore

nza

VIF

5,121

,000

,180

,422

,139

,619

,541

-,176

,328

,654

1,528

,231

1,031

,312

-1,384

4,178

,654

1,528

a. Variabile dipendente: sconto

La tabella Coefficients (Coefficienti) - come al solito - contiene le stime dei parametri del

modello, gli errori standard degli stimatori ottenuti con il metodo dei minimi quadrati (Std.Error)

e le statistiche (t), i p-values (Sig.) dei test di Students e gli intervalli di confidenza che verificano

se i parametri siano significativamente diversi da zero.

Si può respingere l’ipotesi nulla per l’intercetta del modello. Entrambi gli altri parametri non

risultano significativamente differenti da zero.

Dal momento che la matrice di correlazione mette in evidenza che le variabili LEVERAGE e SIZE

sono molto correlate (0.588), ci aspettiamo che vi siano problemi di multicollinearità.

Nella tabella Coefficients leggiamo i valori delle statistiche Collinearity Statistics: Tolerance e VIF.

Per la variabile esplicativa i -esima la statistica Tolerance è data da Tolerance = 1-R2i dove R2i è il

coefficiente di correlazione multipla tra la variabile i -esima e le altre variabili indipendenti.

I valori di questa statistica sono compresi tra 0 e 1. Quando questa statistica assume valori piccoli,

allora la variabile è una combinazione lineare delle altre variabili indipendenti.

La statistica VIF (Variance Inflation Factor) è il reciproco della statistica Tolerance. Un valore

soglia per la statistica VIF è rappresentato da 10, che corrisponde a una Tolerance di 0.10)

In questo caso i valori di Tolerance associati a LEVERAGE e SIZE non sembrerebbero

evidenziare eccessivi problemi di multicollinearità.

Vi sono diversi “rimedi” al problema della multicollinerità, che tuttavia qui non approfondiremo.

Un primo passo è chiedersi se sia migliore il modello con due regressori (collineari), o un modello

più semplice con un solo regressore.

Sappiamo che una misura della bontà del modello è data dal coefficiente di determinazione

multipla R Tuttavia, R cresce all’aumentare del numero di regressori; perciò, è preferibile

considerare l’indice “R aggiustato” (adjusted R ) che tiene conto del numero k di regressori. Non

è sorprendente che il valore di R aggiustato rimanga elevato, nonostante la presenza di

2

2

2

2

2

Commentato [AGQ5]:

Assunzione 4° del modello di regressione multipla

multicollinearità. La multicollinearità tuttavia rende molto instabili le stime dei coefficienti di

correlazione e rende del tutto ambigua l’interpretazione del coefficiente di regressione come

variazione della variabile dipendente in corrispondenza ad un incremento unitario della variabile

esplicativa, quando le rimanenti variabili esplicative sono mantenute costanti.

In questo caso, per tutta una serie di considerazioni, si concluderebbe dicendo che è preferibile

il modello con il solo regressore LEVERAGE.

Diagnostiche di collinearitàa

Proporzioni varianza

Modello

Dimensione

Autovalore

Indice contenuti

(Costante)

1

1

2,695

1,000

,03

leverage

,03

,02

2

,192

3,746

,70

,53

,00

3

,113

4,876

,27

,44

,97

a. Variabile dipendente: sconto

Diagnostiche casewisea

Numero di caso

4

Residuo std.

-2,319

a. Variabile dipendente: sconto

sconto

,01

Valore previsto

,3749

Residuo

-,36953

size