Lorenzo Mambretti – www.mambrettinet.altervista.org

La seconda rivoluzione scientifica

Introduzione

La crisi dei fondamenti, che interessa fisica, matematica e logica si innesta in una crisi più

generale della crisi della cultura europea che si sviluppa a cavallo tra i due secoli. Tale crisi,

che getta la sua ombra ben oltre gli anni della prima guerra mondiale, ha un carattere

generale. Incide sul modo di pensare del mondo occidentale, sull'immagine che l'uomo si è

costruito di sé stesso, sulla prospettiva che l'uomo europeo ha elaborato circa il suo futuro.

Nietzsche funziona da spia, da vedetta, perché evidenzia questo stato di cose. I capisaldi

della cultura occidentale, come il razionalismo, la fiducia nel successo economico e sociale,

nelle conquiste della scienza e dalla tecnica vengono scosse da un terremoto costituito

dall'esplodere di drammatiche contraddizioni. Le profonde ingiustizie sociali, le conquiste

della tecnologia spesso trasformate in strumenti di morte e di dominio, il contrasto tra la

crescita del benessere materiale e la caduta verticale della spiritualità, della mortale,

l'emergere di comportamenti irrazionalistici nelle masse e negli individui sono elementi che

stimolano la riflessione degli intellettuali sullo stato di crisi della cultura europea. Se alcuni

intellettuali ricavano dalla coscienza motivi addirittura per dubitare sulla sopravvivenza

della civiltà occidentale, molti invece colgono la denuncia del disagio con la ricerca di

alternative. In molti casi la crisi coinciderà con vere e proprie rivoluzioni culturali di grande

profondità, come nell'arte (espressionismo).

Vengono messi in discussione i risultati della scienza di derivazione galileiana-newtoniana.

Galileo aveva espresso il modello meccanicistico nel 1638 nell’opera “Discorsi e

dimostrazioni sopra due nuove scienze”. Newton lo delinea maggiormente all'interno dei

“Principia matematica”, dove però dichiara di essere stato un nano salito sulle spalle dei

giganti, indicando tutti gli autori che hanno contribuito alla prima rivoluzione scientifica. Il

modello meccanicistico era basato sul postulato per cui la realtà fosse costituita da

movimento. Siccome il movimento è riconducibile a precise leggi, non c'è fenomeno della

realtà che non sia conoscibile alla luce delle equazioni della meccanica. Viceversa, questo

quadro così rassicurante, che aveva funzionato per il Settecento e per una parte

dell'Ottocento, entra in crisi, sia alla luce di riscontri sperimentali, sia per alcune scoperte

teoriche. É una crisi che coinvolge sia scienze esatte sia le altre scienze.

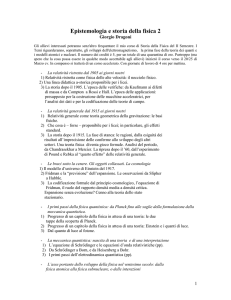

La crisi dei fondamenti

La geometria

Tra la metà del XIX secolo e i primi decenni del XX gli sviluppi delle matematiche mettono in

crisi i principi fondamentali della scienza moderna. Questa crisi investe per prima la

geometria, la scienza dello spazio. Fino a Kant la geometria euclidea continua a presentarsi

come il modello di rigore scientifico. La sua struttura sembra rispecchiare a pieno

l'architettura stessa della realtà. A causa di cambiamenti rivoluzionari si inizia a parlare di

nascita di geometrie alternative, non-euclidee. Bisogna riconoscere il fallimento della

1

Lorenzo Mambretti – www.mambrettinet.altervista.org

ragione scientifica, incapace di individuare la vera struttura della realtà? O bisogna pensare

che la geometria precedente è solo una rappresentazione particolare della realtà valida in

un determinato ambito ma non in tutti?

La matematica e la logica

Al dibattito della geometria si collega il dibattito sul fondamento della matematica. Ci sono

elementi difficilmente inquadrabili sul modello classico, fondato sull'intuizione e su una

forma logica imprecisa in quanto fondata sul linguaggio comune. La crisi prende il nome di

“crisi dei fondamenti”. Ci si chiede se riconoscere i limiti del modello classico per

approfondirne i concetti e i metodi. Questa strada sarà intrapresa da matematici e logici di

questo periodo.

La logica si emancipa del linguaggio comune e raggiunge un rigore formale che prima non

aveva, fornendo alla matematica nuovi e stimolanti problemi. La logica apre la discussione

sugli stessi fondamenti della matematica con l'obbiettivo di darle una dimensione

formalmente rigorosa. Fino ad allora la matematica, a cui appartengono immense

applicazioni pratiche, era basata su criteri puramente intuitivi. La prima regola del metodo

cartesiano era l'evidenza. Quando affermiamo l'evidenza di una cosa non superiamo però il

soggettivismo dell'affermazione, per cui il criterio di evidenza non garantisce il massimo

della certezza.

1.Boole

La storia della moderna logica matematica prende avvio con il contribuito di Boole, il quale,

applicando l'analisi matematica allo studio delle operazioni del pensiero, è il primo ad avere

piena consapevolezza dell'applicabilità dell'algebra negli oggetti descritti nel linguaggio

comune. Il linguaggio simbolico dell'algebra viene esteso alle preposizioni del linguaggio

comune.

2. Cantor

Nella seconda metà dello stesso Ottocento ci sarà un matematico tedesco, Cantor, che si

dedica all'elaborazione di una teoria rivoluzionaria: la teoria degli insiemi. Essa prevede che

gli elementi numerici sono racchiusi in insiemi che possono essere finiti o infiniti, una volta

stabilite le relazioni tra gli insiemi attraverso assiomi.

3.Frege

Frege tenta di pervenire alla fondazione della matematica sulla logica. Il suo logicismo si

propone di fondare la matematica sulle verità apodittiche della logica, quindi di tipo

dimostrativo. Per realizzare il programma logicista, è necessario condurre dimostrazioni

rigorose, che siano esplicite in ogni passo. A questo scopo non ci si può servire del

linguaggio ordinario, gravato da troppe ambiguità. Per questo egli costruisce un linguaggio

simbolico, con cui riscrivere al netto di ogni ambiguità tutta la logica e matematica. Esso ha

importanti continuatori nel Novecento come Russell. Anche il programma logicista è però

vittima di aspetti critici: esso viene messo in crisi dalla scoperta di paradossi (contro

l'opinione = dal greco) e anche antinomie (contraddizioni). Paradossi e antinomie sono

ricavabili direttamente dai principi su cui Cantor e Freghe si erano basati.

2

Lorenzo Mambretti – www.mambrettinet.altervista.org

4.Russell

I principi del programma logicista erano sembrati loro assolutamente semplici e naturali a

Cantor e Frege, ma ai primi del novecento arriva un matematico e filosofo inglese, Bertrand

Russell, che individua una fila consistente di paradossi. Si è soliti associare la crisi dei

fondamenti proprio al 1902 e agli interventi di Russell, grazie all'evidenziazione dei

paradossi. Russell riesce, attraverso la scoperta del principio di astrazione, a scoprire

un'antinomia. Individua la causa nell'autoriferimento, ovvero nella possibilità di definire le

classi che includano sé stesse come propri elementi (esempio = una classe è un insieme

ma è anche un elemento).

Intuizionismo e formalismo

La matematica utilizzava troppe approssimazioni e non usava formalismi precisi. Si parla di

logicizzazione matematica, di un linguaggio simbolico soggetto a precise regole logiche. I

risultati estremi di questa impostazione si tradurranno nel cosiddetto intuizionismo e nel

formalismo.

1.Intuizionismo

L'intuizionismo in qualche modo precisa i diversi ambiti di matematica e logica, intendendo

la matematica come una abilità costruttiva, mentre la logica è più legata alle esigenze di

comunicazione. É l'intuizione a garantire lo scorrere continuo del tempo, rendendo possibile

l'elaborazione degli enti matematici. Gli enti matematici non hanno realtà esterna ma sono

solo costruzioni mentali.

2.Formalismo

Nella sponda opposta dell'intuizionismo vi è il formalismo di Hilbert. Le diverse teorie

matematiche e insiemistiche sono considerate strutture assiomatico-deduttive, ciascuna

fondata fintanto che non emergano aspetti contraddittori. Quello che garantisce

l'autenticità è la coerenza formale. Hilbert sarà il caposcuola del formalismo che porta in

primo piano la cosiddetta meta-logica, ovvero la logica di un sistema formale. Il formalismo

a un certo punto si macchia di eccessi ed entra in crisi quando, all'inizio degli anni 30 del

Novecento, Gӧdel dimostra i due teoremi di incompletezza. “Un enunciato è indicibile

quando appartiene ad un sistema formale, e non si può decidere né la verità né la falsità”.

Gӧdel dimostra che non è possibile fondare sul più semplice il più complesso, anche se

questo non esclude la possibilità di altre forme di giustificazione, che saranno messe a

punto dopo Gӧdel, e quindi dopo la seconda guerra mondiale.

La fisica

Se la crisi dei fondamenti sui quali si era basata la scienza moderna investe in primis la

matematica, fondamento della scienza moderna, che è quantitativa, anche la fisica entra in

crisi. La fisica fino a Newton era qualitativa, mentre dopo diventa quantitativa. Aristotele

aveva elaborato la dottrina della potenza e dell'atto, per cui ciascuna cosa ha in sé la

possibilità del proprio movimento e della propria evoluzione, delle proprie trasformazioni. La

fisica aristotelica giustificava il motore immobile, qualcosa che muoveva senza essere

3

Lorenzo Mambretti – www.mambrettinet.altervista.org

mosso. La risoluzione alle troppe perplessità imputabili alla fisica aristotelica era venuta

nella prima rivoluzione scientifica. Non si può più avere scienza di ciò che è all'interno delle

cose, ma si possono solo misurare gli effetti. Quindi si hanno relazioni di tipo quantitativo.

Fisica galileiana-newtoniana

Si arriva poi alla fisica in termine di meccanica razionale. Il successo della fisica di

derivazione Galileiana-newtoniana era strepitoso, e i fisici erano convinti che non ci fossero

aspetti della realtà che non trovassero la loro spiegazione. Il modello meccanicistico era

stato poi esteso a qualsiasi ambito, e agli inizi dell'Ottocento il meccanicismo dominava le

scienze fisiche. I vari ambiti della fisica, dal movimento al calore, dall'acustica al

magnetismo e all'elettricità dovevano essere ricondotti ad un unico modello newtoniano. Il

modello di Newton era fondato su particelle di materia capaci di esercitare reciprocamente

forze attrattive e repulsive a distanza. Venivano poi pensati dei fluidi imponderabili (privi di

peso) costituiti di particelle che interagiscono a distanza le une con le altre e anche con

particelle ponderabili. La teoria che regolava il comportamento di questo modello è appunto

la meccanica. La spiegazione di qualsiasi fenomeno consisteva nel modello meccanico che

dà una visione razionale della realtà esterna. Il fenomeno del suono veniva spiegato con i

moti ondulatori delle particelle del mezzo in cui si propaga, per esempio l'aria o il calore di

un corpo veniva spiegato con l'agitazione delle sue particelle.

Scetticismo sul modello

Da parte di tanti studiosi c'è molta prudenza nell'andare a valutare il significato da attribuire

a tali modelli meccanici: piuttosto che intenderli come rappresentazione di realtà

effettivamente esistenti, alcuni affermavano che la funzione di questi modelli meccanici era

quella di unificare, di dare unitarietà dei fenomeni fisici, riconducendoli ad un unico modello.

Tuttavia i modelli convincono tanti scienziati, superando le perplessità. I modelli meccanici

secondo alcuni avevano una portata ontologica, in grado di fotografare l'essere della realtà.

Inoltre una spiegazione che utilizzava i modelli meccanici poteva essere una spiegazione

ultima, non passibile di ulteriori perfezionamenti. Anche se negli anni 20-30 dell'Ottocento i

modelli della fisica iniziano ad incontrare alcuni ostacoli, il meccanicismo continua ad

essere il paradigma dominante delle scienze fisiche fino alla fine del secolo. Solo con il

nuovo secolo, il Novecento, si assiste ad un vero e proprio crollo dell'immagine

meccanicista del mondo.

I primi problemi

I primi problemi si apprezzano in relazione ai fenomeni termici. Negli anni 20 dell'Ottocento

un fisico francese Fourier presenta una teoria del calore di grande rilevanza, che lascia

cadere ogni tentativo di dare l'interpretazione meccanicista dei fenomeni termici, rifiutando

ogni ipotesi sulla struttura ultima del reale, rifiutando il metodo meccanicistico. Parte dalla

convinzione che esista una incompatibilità tra la meccanica e le caratteristiche del calore.

Quindi la termodinamica doveva, secondo Fourier, fondarsi su principi indipendenti da quelli

della meccanica. Questo è quello che succede in giro di un ventennio, diventando una

disciplina autonoma dotata di principi che sembrano aprire una profonda frattura rispetto al

modello meccanico.

4

Lorenzo Mambretti – www.mambrettinet.altervista.org

Fino a questo momento c'erano stati vari tentativi, sia in ambito scientifico sia in ambito

filosofico di ricondurre la molteplicità dei fenomeni ad un nucleo unitario per mezzo

dell'individuazione di qualcosa che rimanga costante pur nel continuo cambiamento. Nel

meccanicismo questa questione si era manifestata nella conservazione di una quantità

meccanica nel corso del movimento del cosmo. C'era stata una disputa, nel settecento, tra i

cartesiani – secondo cui si conserva la quantità di moto - e i leibniziani – secondo i quali

quello che si conserva è la forza viva: il prodotto della massa per la velocità elevata al

quadrato. In questo testa a testa hanno vinto i secondi, con una fisica più moderna e con

meno contraddizioni. Il principio di conservazione della forza viva si attesta come principio

fondamentale della meccanica.

Principio di conservazione dell’energia

Il problema della fisica diventa più urgente negli anni 30 con la scoperta di connessioni, di

trasformazioni reciproche tra settori apparentemente lontani, distanti e distinti,

dell'esperienza. Si rilevano nuovi fenomeni di conversione, come la produzione di calore da

parte della luce e di movimento, come la produzione di luce da parte dell'elettricità, come

quella del movimento indotto da campi magnetici. Se all'inizio dell'Ottocento Alessandro

Volta aveva rivelato come si potevano ottenere effetti elettrici da azioni chimiche, dopo gli

anni 20 le scoperte di Oersted e Faraday e le loro scoperte sui campi elettrici e magnetici

rivelano collegamenti inaspettati tra elettricità, magnetismo e movimento. Lo stesso

Faraday con le ricerche sull'elettrolisi mette in rilievo gli effetti chimici della corrente

elettrica. Si creano connessioni tra parti apparentemente distinte della scienza. Si pensa di

poter trovare un unico principio unificatore. Molti studiosi, in modo indipendente, arrivano al

principio di conservazione dell'energia. Prima viene enunciato solo riferito al nesso calorelavoro nel 1841 e poi da Joule in forma completa nel 1943. Il principio affermava che:

il rapporto tra calore e lavoro rimane costante nel tempo

una data quantità di lavoro si trasforma sempre in una uguale quantità di calore, e

quindi si parla di reversibilità

nella trasformazione non si perde mai nulla.

Calore e lavoro sono quindi due aspetti di un’unica entità, l'energia, che si conserva sempre

nel tempo. Il principio convince talmente che viene generalizzato a tutti i tipi di energia. Sarà

Helmholtz che produce la generalizzazione alla fine degli anni 40. Egli inquadra questa sua

conclusione entro una concezione essenzialmente meccanicistica secondo la quale il

principio si può esprimere sotto forma del principio meccanico di conservazione, che

scaturisce dalla somma dell'energia cinetica, dovuta al movimento dei corpi, e l'energia

potenziale dovuta alla posizione dei corpi.

I principi della termodinamica

Il rapporto tra calore e lavoro meccanico viene ripreso alla luce di un impiego sempre più

ampio del motore a vapore. Mentre le macchine utilizzanti il vapore come forza motrice

erano impiegate già da tempo e avevano svolto un impiego importante nella rivoluzione

industriale, la loro comprensione teorica era rimasta a livello rudimentale. Lo stesso Watt

non aveva creato questo strumento ex-novo, ma lo aveva semplicemente elaborato da uno

strumento messo a punto in modo ascientifico nel 1712. Non vi era un sostegno teorico al

5

Lorenzo Mambretti – www.mambrettinet.altervista.org

suo lavoro. Il primo lavoro teorico di importanza nel funzionamento delle macchine

termiche sarà di quello di Sadi Carnot. Nel 24 scrive un libro intitolato “riflessioni sulla

potenza motrice del fuoco”. Basandosi sull'impossibilità del moto perpetuo dimostra che la

produzione del lavoro meccanico può avvenire attraverso il passaggio da un corpo più caldo

ad un corpo più freddo. Se non ci fossero corpi a diverse temperature non sarebbe possibile

ottenere lavoro dal calore. Il saggio di Carnot non lascia traccia, e nessuno lo nota per circa

un decennio, fino a quando Clapeyron non lo riprende e ne comprende la portata

rivoluzionaria. Viene poi ancora ripreso dal tedesco Clausius e Thomson (lord Kelvin). Alla

fine degli anni 40, primi anni 50, giungono alla formulazione dei due principi base della

termodinamica, riprendendo i principi basi di Carnot e della conservazione dell'energia

meccanica. Dicono:

1. «L’Energia di un sistema termodinamico isolato non si crea né si distrugge, ma si

trasforma, passando da una forma a un'altra.»

2. «È impossibile realizzare una trasformazione ciclica il cui unico risultato sia la

trasformazione in lavoro di tutto il calore assorbito da una sorgente omogenea»

(formulazione di Kelvin)

Il secondo principio pone in evidenza che il passaggio di calore da un corpo all'altro non può

avvenire indifferentemente in entrambi i sensi, ma solo dal più caldo al più freddo. Viene

quindi scosso il principio di reversibilità della meccanica classica. Esistono fenomeni

irreversibili, che non possono più procedere a ritroso. L'irreversibilità non era contemplata

da Newton, per cui non esiste alcun principio che consenta di invertire la variabile tempo. Il

mondo, non può svilupparsi tanto verso il futuro quanto tornare al passato, come diceva

Newton. La realtà è differente.

Irreversibilità

I dati sperimentali confermano la presenza di fenomeni irreversibili. L'irreversibilità non è

contemplata da Newton. Qualsiasi situazione deve consentire il ritorno alla posizione di

partenza. I fenomeni termici, come nelle esperienze di Carnot poi spiegati nei principi della

termodinamica, viceversa dicono il contrario. I fenomeni del calore sembrano negare e

contraddire il postulato newtoniano della reversibilità. Ovvio che si apra un dibattito

accesissimo che diventerà ancora più violento quando la termodinamica verrà utilizzata

nella trattazione dei fenomeni chimici, risolvendo un problema chiave che era sempre stato

una barriera rispetto a tutti i tentativi meccanicistici, ovvero quello della dinamica chimica,

che regola le direzione delle reazioni chimiche. La termodinamica, nel fervore di studi tipico

dell'età del positivismo, verrà estesa anche all'elettricità, al magnetismo, a particolari

fenomeni meccanici come la viscosità, diventando la scienza regina in quanto sembrava

dotata della capacità di unificare una pluralità di settori della fisica, che la meccanica – che

prima assolveva questo compito – sembrava perdere progressivamente. La termodinamica

fruiva di un metodo diverso rispetto a quello del meccanicismo, siccome, anziché cercare

l'elaborazione di fenomeni attraverso modelli raffiguranti la realtà come faceva la

meccanica, la termodinamica si accontenta di descrivere matematicamente la realtà

attraverso formalismi e equazioni matematiche. Si stabiliscono connessioni tra concetti. Si

arriva così ad una contrapposizione tra una scienza del perchè, che vedeva nella meccanica

una disciplina che ha un potere unificante, e una scienza del come fondata sulla

termodinamica. Per i sostenitori del meccanicismo la questione più ardua da risolvere era

6

Lorenzo Mambretti – www.mambrettinet.altervista.org

rappresentata dall'apparente contraddizione tra la reversibilità e l'irreversibilità evidenziata

dalla termodinamica. Una prima soluzione viene prodotta da Maxwell e Bolzman, i quali

individuano la soluzione all'interno della Teoria cinetica dei Gas, la quale interpreta i

fenomeni nei fluidi come interazione tra molecole. Il gas è rappresentato da un grandissimo

numero di molecole non osservabile ad occhio nudo, che non si possono osservare ad

occhio nudo. Spiega il comportamento delle grandezze macroscopiche per mezzo delle

grandezze che caratterizzano lo stato delle ipotetiche particelle microscopiche, come

l'Energia cinetica e la velocità delle stesse. Siccome è impossibile osservare o compiere

rilevazioni sulla singola molecola, la teoria cinetica dei gas si configura come teoria di tipo

statistico. Non determina se a è b, ma solo la probabilità che a possa essere b. Teoria

statistica svolge cioè solo considerazioni probabilistiche su un grandissimo numero di

oggetti. La conciliazione tra la meccanica e il secondo principio della termodinamica viene

cercata in una interpretazione probabilistica dell'irreversibilità. Per la teoria cinetica non è

vero che i fenomeni debbano avere un unico senso di marcia ma possono ricostituire uno

stato già scomparso come vuole la meccanica. Tuttavia la probabilità di tale ritorno nei

fenomeni naturali sono molto più scarse che andare in direzione opposta.

Non esistono, ci dicono Maxwell e Boltzman, fenomeni assolutamente irreversibili ma solo

processi che hanno poche probabilità di ritornare alla situazione di partenza. Si può dire che

la reversibilità non è impossibile ma solo improbabile. L'universo evolve verso stati più

probabili ma non è esclusa una possibilità di un evoluzione diversa anche se è altamente

improbabile. La soluzione proposta dalla teoria genetica è un primo passo nella

conciliazione tra termodinamica e meccanica. Alla fine del secolo Boltzman rimane quasi

isolato nel suo tentativo di proseguire su questa via. Solo con il Novecento, con la

formulazione della meccanica statistica di Gibbs e le sue applicazioni a opera di Albert

Einstein. Einstein applica la meccanica statistica al metodo browniano.

Il moto browniano è il movimento caotico, incessante manifestato dalle piccole particelle

sospese in un fluido.

Quando Einstein applica la meccanica statistica a questo movimento il programma cinetico

riacquista forza.

Elettromagnetismo

Nel frattempo il meccanicismo aveva dovuto affrontare una nuova sfida, ovvero la teoria

elettromagnetica di Maxwell del 1873 che trova il suo sofisticato formalismo nel 79. I

fenomeni elettrici dunque erano diventati nell'Ottocento un campo di indagine privilegiato

per la fisica grazie alle scoperte del primo Ottocento. Per esempio la scoperta della pila da

parte dell'italiano volta che permette di ottenere un flusso costante di elettricità, avviando

quindi una sperimentazione completamente nuova rispetto ai lavori portati avanti nel

Settecento. Nell'arco di pochi decenni si mettono insieme tante conoscenze sperimentali

innovative come Oersted, Faraday. Gli esperimenti di Oersted e di Faraday mettono in

evidenza i molteplici legami che collegano i fenomeni elettrici con quelli magnetici, che

prima si consideravano ambiti assolutamente differenziati. In particolare Faraday introduce

un concetto che comporta una rottura decisa e decisiva rispetto al meccanicismo, ovvero il

concetto di Campo. Mentre il meccanicismo si basa su particelle che agiscono a distanza

7

Lorenzo Mambretti – www.mambrettinet.altervista.org

su uno spazio vuoto il mondo immaginato da Faraday è uno spazio continuo, pieno di entità

fisiche che si traducono in forze elettriche e magnetiche, le quali formano dei campi di

forze. Questa impostazione basata sulla continuità della natura viene tradotta

matematicamente da Maxwell, il quale dimostra come fosse plausibile identificare la luce

con l'insieme delle azioni elettromagnetiche. Maxwell era nato nel 1831 e aveva una

formazione meccanicista critica,

che superava la classica posizione newtoniana

dell'assolutezza dello spazio e del tempo, che servivano per garantire la misurabilità degli

spazi e dei tempi relativi.

Maxwell ha ovviamente un atteggiamento molto ma molto più critico, ritenendo che la

migliore spiegazione possibile di qualunque fenomeno fosse quella meccanica, tentando di

fornire una modellizzazione di tipo meccanico anche in campo elettromagnetico,

allontanandosi così però dal meccanicismo. Per il meccanicismo i modelli dovevano

assolvere ad una funzione unificante dei vari aspetti della fisica siccome la natura è

semplice. Non tutto si può però unificare. Nell'opera di Maxwell sono presenti molti modelli

meccanici del campo elettromagnetico molto differenti tra loro a seconda della specificità

del modello indagato. Questo non piace ai sostenitori del meccanicismo ortodosse.

Maxwell è cosciente di operare al di fuori del binario meccanicistico, ritenendo che il

modello meccanico non dovesse avere una funzione unificante. I modelli servono solo per

la ricerca teorica, aiutando l'immaginazione scientifica a prefigurare le situazioni.

L'importanza del modello meccanicista risultava alterata. Le equazioni di Maxwell hanno

portato ad un pericolo ancora maggiore per il meccanicismo aprendo così la strada per la

teoria einsteiniana della relatività.

Relatività

Relatività Galileiana

La fisica è poi investita da due cambiamenti enormi: la relatività e la fisica quantistica.

La relatività galileiana affermava che il comportamento dei corpi era identico nei sistemi

inerziali, e nessuno degli osservatori può stabilire con esperienze meccaniche se il sistema

è in moto o in quiete rispetto allo spazio assoluto. Applicando il principio di relatività al

sistema copernicano, Galileo affermò che non si poteva stabilire che la terra sia ferma. Dal

punto di vista matematico, il fatto che due osservatori vedano gli stessi fenomeni

meccanici si esprime attraverso una particolare proprietà di cui godono le equazioni, ovvero

il fatto che sono invarianti: attraverso le trasformazioni galileiane si può descrivere un

qualsiasi sistema di riferimento inerziale. Le equazioni utilizzate dal secondo osservatore

sono assolutamente identiche rispetto a quelle utilizzate dal primo osservatore. I fenomeni

sono assolutamente identici.

Il problema dell’etere

L'assolutezza dello spazio e del tempo per Newton risponde ad un’esigenza interna rispetto

al sistema newtoniano, ma non era stata dimostrata. A molti era parso, già nel seicento, che

fosse inutile parlare di movimento rispetto ad uno spazio assoluto se poi era assente la

possibilità di riscontrarlo attraverso l’esperienza. Lo spazio come assoluto viene dato per

scontato, fino ad essere considerato con l'etere. L'etere era stato posto alla base delle teorie

8

Lorenzo Mambretti – www.mambrettinet.altervista.org

elettromagnetiche alla fine dell'ottocento per cercare di spiegare i fenomeni e i problemi

relativi. Il campo elettromagnetico di Maxwell è pensato come una serie di perturbazioni

nell'etere, che si estende occupando tutto lo spazio. Per i fisici dell'epoca è impensabile che

un onda elettromagnetica potesse propagarsi senza un mezzo che avesse la funzione di

trasmettere le vibrazioni. Lo spazio identificato nell'etere era uno spazio assoluto. Tuttavia

c'era un problema, ovvero che le equazioni di Maxwell non sono invarianti rispetto al

sistema galileiano. Cambiano se si passa da un osservatore in stato di quiete rispetto ad un

sistema in moto rettilineo uniforme. Questo significa che gli osservatori non vedono i

fenomeni in modo identico. Un osservatore assiste a fenomeni diversi rispetto a quelli

dell'altro osservatore. Il principio di relatività galileiana dunque vale, ma non universalmente,

non potendo essere utilizzato nei fenomeni elettromagnetici. Questa conclusione consente

di mettere in piedi un'altra ipotesi. Doveva essere possibile rilevare, con esperienze di tipo

elettromagnetico, il movimento della terra rispetto all'etere, rispetto allo spazio assoluto.

Tentativi di compiere tale misurazione e quindi di misurare il vento d'etere sono molti, ma

tutti falliscono in quanto constatano che la velocità della luce, che doveva diffondersi

nell'etere, è costante e quindi non c'è il vento d'etere. Gli esperimenti più famosi sono quelli

di Michelson e Mosley.

Lorentz e Relatività Speciale

Dal punto di vista matematico le equazioni di Maxwell avrebbero dovuto essere invarianti

passando da un osservatore all'altro. Poiché non sono invarianti per le trasformazioni

galileiane, occorreva trovare nuove trasformazioni, che applicate all'elettromagnetismo le

rendessero invarianti. Queste formule alternative vengono trovate da Lorentz. Le propone

come uno strumento matematico che giustifica il perché del fallimento del tentativo di

Michelson e Mosley. Dal punto di vista matematico e formale le cose vanno bene.

L'aggiustamento prodotto da Lorentz è perfetto sul piano formale, ma sul piano fisico le

cose rappresentano un vero e proprio scandalo, visto che essere indicano che un

osservatore, collocato in un sistema di riferimento in movimento, quindi con una velocità v,

compiendo delle misure, vedrà le lunghezze dei corpi contrarsi lungo la direzione del moto e

intervalli temporali allargarsi e dilatarsi. Lunghezze e tempi non sembrano più proprietà

assolute del mondo materiale, ma relative alla velocità del sistema di riferimento

dell'osservatore. Questa situazione imbarazzante generata, lesiva del rigore scientifico viene

risolta da Einstein, attraverso tre fondamentali articoli comparsi nel 1905 nella rivista "Der

Physik". Attraverso questi tre articoli comparsi nel Novecento nella rivista "La fisica" Einstein

fonda la relatività speciale o ristretta. Einstein fornisce una spiegazione teorica efficace

delle formule di Lorentz. Partendo dai dati sperimentali si afferma che la velocità della luce

è una costante, e non dipende dalla velocità dell’osservatore come in Galileo. Einstein

sostiene che proprio questa tesi apparentemente paradossale serviva come punto di

partenza per una teoria rivoluzionaria. Einstein dimostra che, se si ammette come postulato

la costanza della velocità della luce e si esaminano le procedure con le quali due osservatori

in moto relativo, ciò che appare simultaneo all'osservatore a può non apparire simultaneo

all'osservatore b. La simultaneità di due eventi non è un carattere assoluto della natura ma

è relativo al moto dell'osservatore. Non si ferma qua Einstein, mostrando anche che la

relatività del concetto di simultaneità implica la relatività dei concetto di lunghezza e di

intervallo temporale. In questo modo, le strane proprietà matematiche di Lorentz non sono

9

Lorenzo Mambretti – www.mambrettinet.altervista.org

che conseguenze di procedure e misure date dalla costanza della velocità della luce.

Siccome le nozioni di tempo e spazio sono fondamentali per qualsiasi fenomeno naturale la

teoria einsteiniana comporta una radicale modificazione dell'intera fisica dando avvio ad

una fisica post newtoniana, relativistica. Accantonati finalmente i concetti assoluti di spazio

e di tempo considera gli eventi fisici rispetto ai tempi e agli spazi relativi all'osservatore. Con

l'abbandono del tempo e dello spazio newtoniano assoluti, imprescindibili, veniva a crollare

anche il quadro concettuale in cui era inscritto il grande universo macchina pensato da

Newton.

Relatività generale

La teoria della relatività formulata nel 1905 è detta speciale perché è solo limitata ai sistemi

inerziali. Einstein successivamente estende la propria teoria ai sistemi non inerziali. Nel

1916 si arriva alla pubblicazione della relatività generale. Questa porta ad una applicazione

di geometrie non euclidee nella descrizione dello spaziotempo, implicando la possibilità che

lo spazio sia curvo. La formulazione delle geometrie non euclidee degli anni 30-40 si erano

fermate solo allo stadio teorico, valide solo a livello matematico. Proprio l'impiego in Fisica

di parti della matematica prima ritenute difficilmente suscettibili di interpretazioni fisiche,

che sembravano descrivere irreali mondi curvi, suscita l'opposizione di molti scienziati,

portando ad una reazione di stupore da parte di Einstein. Quando era passata la relatività

speciale tutti erano d'accordo, ma quando si presenta la relatività generale la situazione è

diversa. Se la prima superava problemi della fisica in quel momento, la seconda, che per

Einstein era una banale estensione della prima, non viene compresa e accettata da tutti.

La teoria della relatività è assolutamente innovativa ma rimane comunque all'interno della

concezione meccanicista, conservando quel carattere che da Galileo era l'essenza stessa

della scienza, ovvero si fondava sul fatto che la natura fosse regolamentata da leggi di

portata universale. La scienza doveva tradursi nella ricerca, nella individuazione di un

determinismo negli eventi naturali. Fino ad Einstein, pur con tutta la valanga di innovazioni

ci muoviamo in questa direttiva. "Dio non gioca a dadi" dice Einstein. E se niente è casuale,

tutto è spiegabile in modo deterministico. Adesso anche questa visione deterministica che,

pur portando con sé innovazioni macroscopiche, preservava la sostanziale identità della

scienza subisce una rivoluzione.

La meccanica quantistica

All'inizio del Novecento una nuova proposta metterà in discussione anche quel pilastro

rimasto saldamente in piedi per millenni, proponendo una scienza che si occupa di corpi

che non sembrano essere soggetti al determinismo, e quindi non sembrano obbedire a

leggi rigorose e sempre uguali a sé stesse. Nasce la meccanica quantistica. L'elaborazione

di questa nuova teoria appare ai più una inaccettabile rottura con la fisica tradizionale,

molto più grave che quella prodotta dalla relatività einsteiniana. Anche Einstein sarà un

nemico e critico della meccanica quantistica, che nasce in stretta connessione con una

sorprendente serie di scoperte fondamentali, dischiudendo alla ricerca fisica il mondo degli

oggetti atomici e subatomici.

Il determinismo era diventato un assioma nel tempo, e la meccanica quantistica lo mette in

10

Lorenzo Mambretti – www.mambrettinet.altervista.org

discussione. Sembra rovesciare l'immagine stessa della scienza. Si occupa di corpi che

sfuggono al determinismo, non obbedendo a leggi rigorose. Fondata da Max Planck,

sembra a molti una frantumazione di tutto quanto la scienza aveva proposto. La relatività

speciale aveva assestato una sberla ma preservando il determinismo era stata accettata

anche in virtù degli effetti che aveva prodotto. La relatività generale, con l'applicazione del

mondo fisico delle geometrie non euclidee, aveva in qualche modo suscitato maggiori

perplessità, ma anche con questa Einstein non si era discostato dall'idea che l'universo

rispondesse a leggi deterministiche. La fisica quantistica, che afferma che le particelle si

comportano a volte come onda e a volte come corpuscolo, fa saltare le convinzioni. Il

terreno sul quale nasce la meccanica quantistica è composto di eccezionali scoperte

sperimentali che superano in via definitiva la concezione newtoniana di una fisica del

macroscopico, la cui osservazione dei fenomeni è possibile a occhio nudo. La fisica

quantistica racchiude la prospettiva di una fisica nuova, del microscopico, degli oggetti

atomici e subatomici.

Fisica Quantistica

Atomismo e le sue origini

La concezione atomistica del mondo risale ai primordi della riflessione filosofico-scientifica.

Il primo a parlare di atomi è Democrito di Abdera, e sembra che anche qualcuno prima di lui,

come Leucippo sia estensore della teoria , anche se non abbiamo testi a confermarlo. Dai

frammenti di Democrito, dell'opera "Piccolo sistema dell'universo", veniamo a sapere che la

realtà è costituita da atomi, particelle infinitesimali, che dotate di caratteristiche quantitative

– un peso – e dotate di movimento, si aggregano e disgregano in uno spazio vuoto

necessario per tale fenomeno. Si giustificano la nascita e la morte delle cose. Democrito

afferma però che gli atomi si vedono con gli occhi della mente, sono un ipotesi mentale

costruita per giustificare la realtà fisica. Quindi tutti sanno cosa è stato l'atomismo. Sono

stati perfino trovati recentemente – negli anni 80 del Novecento – i verbali delle sedute del

processo a Galileo in cui risulta che il papa Bonifacio VIII non fosse scandalizzato

dall'eliocentrismo, ma fosse preoccupato dell'atomismo di Galileo. La scienza per Galileo si

fa con gli aspetti quantitativi, come Democrito. Però tutta la tradizione atomistica arriva fino

all'Ottocento riciclando l'assunto democriteo per cui gli atomi sono delle ipotesi mentali e

nessuno, tra gli scienziati dell'Ottocento, pur preparatissimi, era disposto ad ammettere che

al concetto di atomo corrispondesse una realtà oggettiva, ed esistessero particelle

piccolissime oltre le quali non è possibile procedere con ulteriori divisioni.

Verifiche sperimentali

Le eccezionali scoperte sperimentali dell'ultimissima parte dell'Ottocento, nella seconda

metà degli anni 90 viceversa mettono di fronte ad un dato sbalorditivo: la materia ha

effettivamente una struttura discreta, una struttura atomica. E queste particelle costitutive

della materia non sono per niente le ultime e indivisibili, ma sono sicuramente divisibili al

loro interno. Le ricerche sugli spettri degli elementi evidenziano che ad alta temperatura vi

sono particolari emissioni per ogni elemento. Le ricerche sui raggi catodici vengono fatte

nei primi anni del Novecento e permettono di individuare elettroni e protoni. Nel 1895

11

Lorenzo Mambretti – www.mambrettinet.altervista.org

vengono scoperti i raggi X, radiazioni capaci di attraversare la materia. Viene scoperta la

radioattività naturale, la capacità di certe sostanze come il Radio di emettere radiazioni

simili a quelle create artificialmente. Viene inoltre spiegato l'effetto fotoelettrico, studiato da

Einstein. Tutte queste scoperte sperimentali e teoriche costringono a modificare il concetto

di materia. L'atomo deve essere pensato come una struttura complessa, composta di

particelle, di componenti ancora più piccole. Si parla non a caso di elettroni e protoni e poi

neutroni, procedendo successivamente (molto dopo) con ulteriori divisioni.

Modelli atomici e “quanti”

Attraverso questa divisione della materia bisogna approntare un modello di atomo,

andandone a ricercare le regole di comportamento. I primi 20 anni del Novecento ci fanno

assistere ad una vera e propria proliferazione di modelli atomici, nel tentativo di applicare al

microcosmo le leggi della fisica che si erano dimostrate valide nel macrocosmo.

Certamente la pluralità di modelli presenta al suo interno incongruenze più o meno rilevanti.

Nel 1913 viene prodotto il modello di Bohr, il quale supera un certo numero di incongruenze,

andando oltre una serie di ostacoli, pagando pegno del fatto che è necessario ipotizzare che

gli elettroni avessero comportamenti anomali, cioè non obbedissero alle leggi tipiche della

fisica classica. Secondo il modello di Bohr gli elettroni non possono muoversi attorno il

nucleo dell'atomo seguendo tutte le orbite possibili, ma alcune di queste orbite sono

interdette mentre altre sono consentite. In più, quando un elettrone si muove su un’orbita

consentita non emette radiazione elettromagnetica. L'elettrone può emettere o assorbire

radiazione elettromagnetica solo quando passa da un’orbita stazionaria ad un’altra. Il

passaggio è caratterizzato da salti, da una sostanziale discontinuità. Scompare da un'orbita

per apparire in un'altra essendo proibita l'esistenza negli stati intermedi. Nel modello di

Bohr, l'energia degli elettroni non varia con continuità, ma solo per salti, per "pacchetti"

indivisibili di energia che Planck chiama "quanti". L'idea della quantizzazione dell'energia

degli elettroni è introdotta nel 1916 dal fisico e filosofo Planck. Einstein, nello studio

dell'effetto fotoelettrico aveva presentato già nel 1905 un’idea di una fisica discreta, ma solo

con Planck prende forma una visione della fisica quantistica. Il modello di Bohr diviene

contemporaneamente il perno della fisica atomistica.

Si tratta di una rottura con la millenaria convinzione circa la sostanziale continuità dei

processi naturali. L'antica massima ribadita a spada tratta da Newton, " natura non fecit

saltus", risulta assolutamente negata dal comportamento dell'elettrone, che secondo il

modello di Bohr cambia il proprio stato proprio per salti, con repentine discontinuità. Pur

problematico dal punto di vista della rappresentazione concettuale, il modello di Bohr

rimane una pietra miliare, il punto di riferimento fondamentale per lo studio dei modelli

atomici fino alla metà circa degli anni 20, dando origine a quella che gli storici della scienza

del Novecento chiamano la vecchia meccanica quantistica.

La nuova fisica quantistica

Tra il 1924 e 1927 ha inizio invece la nuova fisica quantistica, sfruttando le ricerche e le

eccezionali intuizioni teoriche dei più grandi scienziati del tempo. Sono scienziati che

partono da prospettive lontanissime tra di loro. I fondamenti teorici elaborati in questi anni

rappresentano sicuramente la base sulla quale è costruita la fisica Novecento, suscitando

12

Lorenzo Mambretti – www.mambrettinet.altervista.org

anche un dibattito fisico e filosofico e sradicando concezioni scientifiche e convincimenti

del senso comune consolidati da secoli. Due in particolare sono gli aspetti su cui si

focalizza la discussione:

1. La natura statistica e probabilistica della nuova scienza fisica.

2. Il fondamentale dualismo tra onda e corpuscoli che scaturisce dalla concezione della

meccanica quantistica.

La fisica quantistica fa saltare la determinazione dei fenomeni fisici, solo che risulta

evidente che la determinazione possa avvenire però su base probabilistica. Per cui, non si è

più in grado come nell'orizzonte meccanicistico-deterministico di Newton dire che A è B, ma

solo stabilire che probabilità ci sia in cui A sia B. Questa conclusione, ricavabile dalle

scoperte della fisica quantistica, con la sostanziale distinzione tra fenomeni macroscopici e

microscopici porta Heisenberg, fisico tedesco, nobel per la fisica nel 32, all'enunciato del

principio di indeterminazione, da cui risulta evidente la natura probabilistica, la natura

statistica della nuova teoria. Se non si è in grado di avere informazioni precise sulla

condizione dell'oggetto del fenomeno considerato non sarebbe possibile nemmeno fare

previsione sul suo comportamento futuro. La meccanica classica newtoniana compiva

previsioni deterministiche avendo a disposizione informazioni sui valori delle coordinate

canoniche dell'oggetto in esame in un dato istante. Il principio di indeterminazione assesta

un colpo basso a questa felice illusione. Il principio di indeterminazione esclude che si

possa prevedere con assoluta precisione il futuro di un oggetto.

Questo significa che ci è negata in assoluto la possibilità di prevedere il comportamento

futuro di un fenomeno? No, la prospettiva probabilistica si traduce non in una negazione

della possibilità della scienza, ma semplicemente quello che si può prevedere coincide con

il calcolo delle probabilità per cui un oggetto si comporterà in un modo o in un altro. Dove

troviamo mirabilmente applicata la prospettiva del principio di indeterminazione è nel

dualismo onda corpuscolo. Onde e corpuscoli sono differenti, radicalmente differenti e

quindi è bene che i concetti fondati sulla nozione di corpuscoli siano assolutamente

separati dai concetti fondati sulle onde. Il primo a mettere in discussione questa

contrapposizione assoluta è Einstein quando espone la sua teoria della luce per spiegare

l'effetto fotoelettrico. Tale teoria afferma che un raggio luminoso è un "treno di particelle di

luce chiamate fotoni", proponendo che per il caso dell'effetto fotoelettrico la luce non

venisse considerata come un fenomeno ondulatorio, come aveva affermato Maxwell, bensì

come corpuscoli. Tale anomalia non è destinata a risolversi bensì ad ingigantirsi quando,

nel 1924, il fisico francese Broglie cerca di estendere alla traiettoria dell’elettrone un

andamento ondulatorio. Attraverso l'uso di sofisticati formalismi matematici Schrödinger

svilupperà meglio l'ipotesi di Broglie, e dopo alcuni tentativi di intendere l'elettrone come un

fenomeno puramente ondulatorio diventa scontato che il concetto di onda non può

sostituire in tutto quello di corpuscolo che, viceversa, l'elettrone come la luce richiede per la

comprensione non una ma due concezioni. Per cui, in determinate circostanze si comporta

come corpuscolo, in altre come onda. Questo duplice comportamento diventerà evidente

sul piano sperimentale. Se la collochiamo in un particolare apparato una fonte di elettroni fa

registrare fenomeni, immagini corpuscolari, se in un altro non possiamo che constatare

fenomeni di tipo ondulatorio.

13

Lorenzo Mambretti – www.mambrettinet.altervista.org

Bohr nel 27, proprio per giustificare sul piano teorico, elabora il principio di

complementarietà, il quale indica che il duplice aspetto di alcune rappresentazioni fisiche di

fenomeni non può essere osservato contemporaneamente nello stesso esperimento.

Successivamente fa un ulteriore passo teorico, sostenendo che in ogni esperienza sugli

oggetti atomici è rilevabile un’interazione tra oggetto e strumento di misura. Lo strumento

di misura altera lo stato di quanto si va ad osservare. Per questo si trova una diversità di

comportamento riconducibile alle diverse sperimentazioni. La meccanica quantistica

convincerà una parte piccola degli addetti ai lavori, mentre lascerà vere e proprie voragini di

dubbio in quanti temevano che una prospettiva probabilistica si traducesse in una

sostanziale indeterminazione, quindi nel fallimento della scienza fisica. D'altra parte, va da

sé che questa di rivoluzioni che interessano sia aspetti sperimentali ma anche aspetti

teorici comportano una vera e propria rivoluzione all'interno del modo di considerare la

scienza. Questa rivoluzione nel modo di considerare la scienza si traduce in un

accantonamento, non in un rifiuto, della scienza Newtoniana. Viene così a cadere l'aggettivo

"universale" della teoria gravitazionale newtoniana.

La serie di rivolgimenti prodotti sia in ambito sperimentale e in ambito teorico comportano

la messa in discussione della fisica newtoniana fino a relativizzarne gli assunti, che quindi

non sono più universali. Si realizza però anche un attacco mortale nei confronti della fisica

ottocentesca e del positivismo, della pia illusione in virtù della quale la fisica era una

scienza che poteva spiegare i fatti con i fatti. Allora, con la seconda rivoluzione scientifica,

cambia l'idea della scienza

L'idea della scienza

L'idea della scienza cambia avendo come polo polemico il positivismo. I contributi alla

nuova immagine della scienza e della riflessione sulla scienza sono dati dalla

epistemologia. I contributi alle trasformazioni epistemologiche che si realizzano tra la fine

dell'Ottocento e i primi del Novecento, di pari passo alla rivoluzione scientifica sono molti. I

tre filosofi della scienza più importanti sono Mach, Poincaré, Diurem(?).

Ernst Mach

Mach è il primo a portare una critica radicale al positivismo, tentando di dimostrare

l'infondatezza della posizione positivista di ammettere, ai fini delle costruzioni scientifiche,

solo quelle conoscenze saldamente fondate sull'esperienza, sui "fatti". A parere di Mach,

l'elemento qualificante della conoscenza non è la realtà colta dall'esperienza, ma bensì

l'elemento qualificante della conoscenza è il pensiero. Se il positivismo concentrava la sua

attenzione sull'oggetto, la critica lo faceva sul soggetto. Cambia radicalmente il significato

di scienza. La scienza non è più, come si illudeva il positivismo, registrazione o fotografia

della realtà ma convenzione attraverso la quale il soggetto opera alla luce di rendere la

realtà funzionale ai suoi bisogni. La scienza non è una fotografia, registrazione pedissequa

della realtà: è ordinamento della realtà ai fini utilitaristici dei dati dell'esperienza. Di per sé

nulla impongono al soggetto conoscente. Io sono catapultata nella realtà, sono costretta a

14

Lorenzo Mambretti – www.mambrettinet.altervista.org

viverci, di dare un senso, di calcolare cause ed effetti di quello che mi circonda in funzione

della mia esistenza come soggetto. Per cui, se io per spiegare questo elaboro una legge non

è scritto da nessuna parte che tale legge risponda a quello che l'oggetto è, ma la legge

consente di rapportarmi a tale oggetto come ad un termine noto che posso manovrare e

utilizzare a mio vantaggio, evitando quello ciò mi può essere dannoso, che mi può

complicare l'esistenza. Alla luce della rivoluzione, del modo diverso di considerare la scienza

che cronologicamente si colloca in contemporanea con la seconda rivoluzione scientifica,

la scienza non fotografa la realtà ma ne costituisce un ordinamento convenzionale dei dati

empirici che in sé per sé non dicono niente, ma ordinati rispondono alle esigenze del

soggetto. Mach rifiuterà di elaborare un sistema filosofico, rifiuta per sé la definizione di

filosofo. Le sue concezioni avranno un influenza vastissima sull'intero pensiero del

novecento. Mach pretende di essere un critico, di far scaturire le proprie considerazioni

dall'analisi puntualissima delle discipline scientifiche.

Considerazioni sulla fisica

Mach studia la fisica, scienza regina dell'Ottocento e novecento. Alla luce di quello che va

succedendo nel suo tempo, quindi gli sviluppi dell'elettromagnetismo e della

termodinamica, tutti i risultati che convincono Mach della sostanziale inadeguatezza per

dare effettiva spiegazione dei fenomeni fisici. Mach ritiene che la termodinamica sia capace

di fornire un modello alternativo rispetto alla meccanica. Questo perché Mach rivede,

pesantemente, il significato di sensazione e conseguentemente i pilastri della tradizione

empiristica. In accordo con la tradizione empirista (Locke- Hume – Newton), visti i successi

della meccanica, per buona parte dell'Ottocento la tradizione empirista viene mantenuta

sostenendo che la conoscenza scaturisse esclusivamente dalla sensazione. Mach si

impegna in un indagine a tappeto dell'attività sensoriale, condotta sia dal punto di vista

fisico che dal punto di vista psicologico. Per cui, questa serie di ricerche convincono Mach

dell'impossibilità di dar vita ad una scienza unificata sulla base della meccanica come

aveva preteso il positivismo.

Attività conoscitiva

Mach non è che metta in discussione lo scientismo che contraddistingue l'ottocento. È

infatti d'accordo con l'evoluzionismo darwiniano e altre attività scientifiche. L'attività

conoscitiva deve essere vista come una forma di adattamento, una serie di risposte a quelle

che sono le sollecitazioni dell'ambiente esterno. La realtà quindi non è qualche cosa da

contemplare passivamente, ma è qualcosa da conoscere, con l'obbiettivo di modificarla,

ricostruirla, di viverla. La conoscenza, per carità, può partire dalle sensazioni, ma non è

come volevano gli empiristi come Locke e Hume, manifestazione della sostanziale passività

umana.

La sensazione

La sensazione è il primo atto di un meccanismo di difesa. In questo c'è una continuità tra

uomo e animali. L'uomo, attraverso le sensazioni prende le misure a ciò che c'è fuori di lui in

modo di sapersi rapportare a ciò che lo circonda. A questa concezione non può sottrarsi

neppure la scienza, come forma più alta di conoscenza. La scienza ha un fine pratico, un

fine utilitaristico, un fine (darwinianamente) indirizzato alla conservazione della specie. Ciò è

15

Lorenzo Mambretti – www.mambrettinet.altervista.org

possibile quando la scienza ci mette a disposizione una ricostruzione dei fenomeni facile

,semplice, accessibile. Per questo la filosofia di Mach può essere definita empirista con però

delle modificazioni rispetto all'empirismo ingenuo di Locke e Hume. Oltre che empirista può

essere definita convenzionalista, perché a costruire la scienza non è l'esperienza ma il

modo in cui noi interpretiamo i dati empirici. E poi, la filosofia di Mach può essere definita

monistica, quindi una filosofia che riunifica, che raccoglie e che richiede l'eliminazione di

tutti i tipici dualismi e contrapposizioni che scaturiscono dalla distinzione tra soggetto e

oggetto. Mah ritiene che il mondo sia costituito da un unico tipo di elementi: non esiste un

soggetto che percepisce e degli oggetti che viceversa vengono percepiti. Esistono solo

entità che abitualmente chiamiamo sensazioni e che lui decide di chiamare con un termine

più neutro "elementi". Il concetto di soggetto, oggetto, di "io" proprie delle teorie dualistiche

sono elementi che rappresentano né più e né meno i mezzi che ci costruiamo per dare un

ordine ad un mondo disordinato. Perché dobbiamo dare un ordine a tutto? Solo per poter

vivere in questo mondo. Ordinare il mondo significa operare attraverso l'intelletto il

passaggio dal caos al cosmos, far diventare quelle incognite, quelle colossali "x"

rappresentate dalle cose prima di definirle dei termini noti. Il soggetto umano si sottopone a

questa fatica per vivere nel mondo. Quindi gli elementi sono solo gli strumenti di cui

faticosamente ci dotiamo per trasformare una realtà costituita di incognite in una realtà

costituita da termini noti in cui sappiamo muoverci. LA distinzione tra soggetto e oggetto

ha solo finalità pratiche ma nulla di metafisico. La scienza è tale se studia le connessioni

esistenti tra elementi. Ogni distinzione all'interno di essa, la distinzione per esempio tra

fisica e psicologia ha carattere puramente convenzionale. La fisica si occupa delle

connessioni tra quegli elementi chiamati corpi e non presta conseguentemente attenzione

a quel complesso di elementi che solitamente chiamiamo "io", "psiche" o "mente".

1. astrazione

Il riconoscimento di legami tra elementi che costituisce la scienza prende il via con un

processo di astrazione. Del complesso di elementi apparentemente presentato come un

tutt'uno, noi tendiamo ad evidenziare alcuni di questi elementi emarginandone degli altri. Da

prima questa, scelta che si traduce nell'astrazione, si può presentare come inconsapevole,

quasi senza l'intervento della nostra volontà, cogliendo quelle relazioni tra elementi

particolarmente utili a farci un idea delle cose e quindi a costruirci la nozione delle cose che

sarà utili alla nostra conoscenza. Le conoscenze così acquisite saranno il piano su cui

poggiano tutte le dimostrazioni della scienza, da quelle più semplici a quelle più sofisticate.

I fondamenti di tutti i principi scientifici, anche quelli che possono sembrare ad alto livello

teorico consistono in esperienze elementari. I principi della meccanica, ad esempio,

possono essere viste come traduzioni più eleganti e raffinate del dato primitivo. Il processo

di astrazione diviene poi assunto coscientemente come metodo di indagine della realtà, fino

a produrre astrazioni sempre più complesse che trovano il loro culmine nei concetto. Quelle

che ci siamo abituati a considerare leggi naturali non sono altro che concetti scientifici

particolarmente rilevanti. Le leggi naturali per Mach non hanno alcun valore oggettivo,

perché in natura non esistono. Va detto che l'esperienza non ci pone mai di fronte alla legge

della caduta dei gravi, ma sempre e soltanto a degli esempi, a determinati corpi (un sasso,

una penna) che cadono in determinate e continuamente diverse situazioni. Le leggi per

tanto non sono registrazioni né fotografie di quanto avviene nel mondo, ma sono regole per

16

Lorenzo Mambretti – www.mambrettinet.altervista.org

descrivere singoli fenomeni. Grazie alle leggi noi possiamo prevedere quello che accadrà in

una x circostanza anche senza sperimentarla direttamente. Le leggi, dunque, hanno proprio

una funzione, la funzione di consentire l'individuazione di una categoria, di un complesso di

fenomeni che allora si possono presentare a noi come noti e quindi ci consentono di

prevedere il darsi di fenomeni analoghi. È implicita la critica Macchiana al meccanicismo

newtoniano. Il meccanicismo infatti aveva elevato alcune leggi a livello di principi primi,

giudicandole capaci di illustrare la sostanza della realtà. Ogni legge è allo stesso livello di

tutte le altre. Quelli che vengono chiamati principi non sono altro che leggi che hanno

assunto un ruolo particolare nella costruzione di una teoria. Le teorie scientifiche non sono

che insiemi di leggi. Rispecchiano quello che la realtà effettivamente é? Rispecchiano un

ordinamento oggettivo? No, solo un ordinamento convenzionale, quello che noi diamo alle

cosi. La teoria ha il compito di ordinare le leggi in modo di consentire di ordinare i dati nel

modo più semplice e rapido. Una teoria serve ad economizzare il pensiero, far leva su

quattro punti per consentire la massima efficacia pratica. Per questo suo carattere la teoria

ha una grande libertà. Può liberamente porre a proprio fondamento, chiamandole principi,

quelle leggi che risultino più utili ai fini della ricostruzione della totalità dei fatti. Solo per

questa loro funzione convenzionale, di punto di partenza per l'organizzazione del numero

più alto possibile di leggi i principi acquistano un rilievo particolare. Niente, se non questioni

di utilità, vieta di modificare l'ordine di una teoria facendone saltare anche i principi,

cambiando i principi che ne costituiscono il fondamento. Di fronte all'esperienza l'uomo

sceglie l'ordine del mondo più adeguato ai suoi obbiettivi, i quali obbiettivi coincidono con il

vivere nell'ambiente in cui ci si trova evitando di soccombere e realizzando al massimo sé

stessi.

Rispetto alla legge darwiniana vince chi si riesce ad adattare meglio, eliminando l'attrito con

l'ambiente. Alla luce di questo fortissimo pragmatismo Mach ritiene vana la pretesa di fare

della scienza un'impresa che colga qualche verità metafisica. Il valore della scienza è, se

vogliamo, circoscritto all'ambito dell'utile. L'ordine scientifico è un ordine convenzionale

costruito dall'uomo per rapportarci in modo vincente alla realtà.

Poincaré

La strada aperta da Mach trova altri fautori, altri sostenitori, che magari provengono da

formazioni diverse. Poincaré è un ingegnere, studia nel Politecnico. Quando arriviamo nel

secondo ottocento il politecnico si specializza in modo tecnico. Egli si dedica alla ricerca

matematica, ottenendo risultati importati quando è poco più che ventenne, e dalla metà

degli anni ottanta insegna meccanica, fisica e matematica e il calcolo della probabilità

presso l'università di Parigi. Dalla fine degli anni novanta avrà anche la cattedra di

astronomia matematica e di meccanica celeste. In qualsiasi ambito si applichi produce dei

lavori di grande valore che contribuiscono a farne uno dei maggiori scienziati dell'epoca.

Prova a cimentarsi anche con dei problemi filosofici scaturiti dalla ricerca scientifica

pubblicando alcuni saggi che costituiscono tra i contributi più significativi sul dibattito dei

fondamenti della scienza tra ottocento e novecento. Scrisse un saggio di carattere generale

molto attuale che si intitola "il valore della scienza". Scrisse anche "la scienza e le ipotesi" o

"scienza e metodo". Nel 1911 muore.

Da contributi importantissimi contrassegnati da un rigore notevole senza arrivare mai ad

17

Lorenzo Mambretti – www.mambrettinet.altervista.org

elaborare una sia filosofia definita. Preferisce dedicarsi a studi specifici, sia pure di altissimo

spessore teorico. Preferisce trattare questioni poste dagli sviluppi della scienza senza

utilizzare i risultati, pur importanti, ricavati, per costruire una concezione generale della

scienza o del metodo scientifico. In virtù delle sue indagini la filosofia sarà meglio in grado

di rapportarsi alla scienza, di individuare quelle che sono le procedure sotterranee, non

sempre esplicite che stanno sotto la ricerca scientifica. Questa compenetrazione è alla

base della modernità degli scritti di Poincaré. In tempi nei quali vengono continuamente

bruciate le tappe e quello che sembrava una scoperta ieri già oggi inizia ad essere

considerata obsoleta, ancora oggi ha grande rilevanza.

18