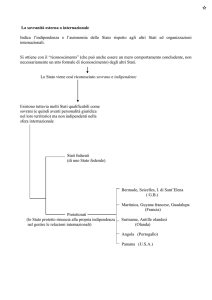

Analisi Bivariata

e Test Statistici

Metodi Quantitativi per Economia,

Finanza e Management

Esercitazione n°5

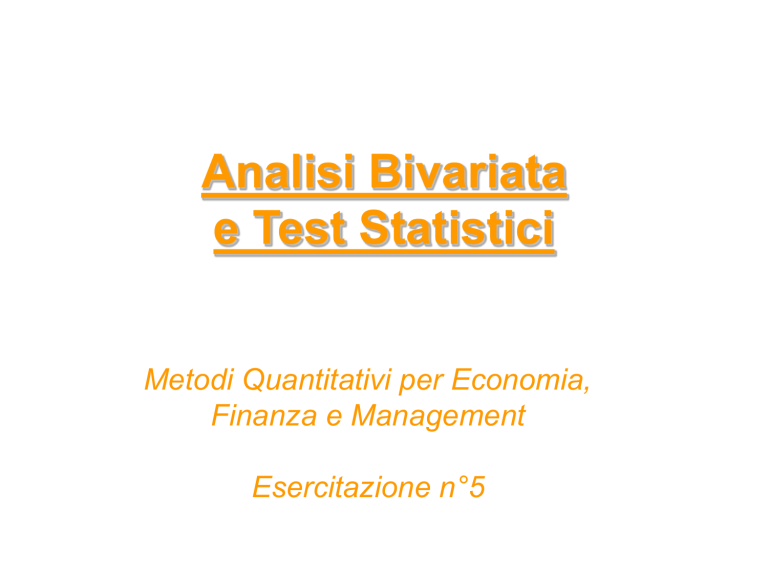

Statistica descrittiva bivariata

Indaga la relazione tra due variabili misurate.

Si distingue rispetto alla tipologia delle variabili indagate:

• var. qualitative/quantitative discrete: tavole di contingenza (o a

doppia entrata)

• var. quantitative: analisi di correlazione lineare

• una var. qualitativa e una quantitativa: confronto tra le medie

Test per lo studio dell’associazione

tra variabili

• Nella teoria dei test, il ricercatore fornisce ipotesi riguardo la

distribuzione

della

popolazione;

tali

ipotesi

sono

parametriche se riguardano il valore di uno ò più parametri

della popolazione conoscendone la distribuzione a meno dei

parametri stessi; non parametriche se prescindono dalla

conoscenza della distribuzione della popolazione.

• Obiettivo dei test: come decidere se accettare o rifiutare

un’ipotesi statistica alla luce di un risultato campionario.

Esistono due ipotesi:

– H0 l’ipotesi nulla, cioè l’ipotesi che deve essere verificata

– H1 l’ipotesi alternativa la quale rappresenta, di fatto, l’ipotesi che

il ricercatore sta cercando di dimostrare.

Test per lo studio dell’associazione

tra variabili

• Si può incorrere in due tipologie di errore:

Possibili Risultati Verifica di Ipotesi

Stato di Natura

Decisione

Non

Rifiutare

H0

Rifiutare

H0

H0 Vera

No errore

Errore

Primo Tipo

H0 Falsa

Errore

Secondo Tipo

No Errore

Test per lo studio dell’associazione

tra variabili

• Errore di Primo Tipo

– Rifiutare un’ipotesi nulla vera

– Considerato un tipo di errore molto serio

La probabilità dell’errore di primo tipo è

• Chiamato livello si significatività del test

• Fissato a priori dal ricercatore (i valori comuni sono

0.01, 0.05, 0.10)

Test per lo studio dell’associazione

tra variabili

• Errore di Secondo Tipo

– Non rifiutare un’ipotesi nulla falsa

La probabilità dell’errore di secondo tipo è β

Test per lo studio dell’associazione

tra variabili

Possibili Risultati Verifica di Ipotesi

Stato di Natura

Legenda:

Risultato

(Probabilità)

Decisione

H0 Vera

Non

Rifiutare

H0

No errore

(1 - )

Rifiutare

H0

Errore

Primo Tipo

()

H0 Falsa

Errore

Secondo Tipo

(β)

No Errore

(1-β)

Test per lo studio dell’associazione

tra variabili

Errore di primo tipo ed errore di secondo tipo non si

posso verificare contemporanemente

Errore di primo tipo può occorrere solo se H0 è vera

Errore di secondo tipo può occorrere solo se H0 è falsa

Se la probabilità dell’errore di primo tipo ( )

,

allora la probabilità dell’errore di secondo tipo ( β )

Lettura di un test statistico (1)

Esempio:

H0: b1= b2 = ....=bk = 0

1) Ipotesi

H1: almeno un bi≠0

2) Statistica test

3) p-value

Statistica F

Rappresenta la probabilità di

commettere l’errore di prima specie.

Può essere interpretato come la

probabilità che H0 sia “vera” in base al

valore osservato della statistica test

Lettura di un test statistico (2)

Fissato un livello di significatività :

Se p-value piccolo (< )

RIFIUTO H0

Altrimenti (>= )

ACCETTO H0

Il p-value è il più piccolo valore di per il quale H0 può essere rifiutata

Test χ² per l’indipendenza statistica

Si considera la distribuzione χ², con un numero di gradi di libertà

pari a (k-1)(h-1), dove k è il numero di righe e h il numero di

colonne della tabella di contingenza. Qui:

• H0 :indipendenza statistica tra X e Y

• H1 : dipendenza statistica tra X e Y

La regione di rifiuto cade nella coda di destra della distribuzione

0.2

0.15

0.1

0.05

La regione di rifiuto è

caratterizzata da valori

relativamente elevati di

χ²; se il livello di

significatività è al 5%,

si rifiuta per χ²> χ²0.95

0

Regione di rifiuto

0 1.1 2.2 3.3 4.4 5.5 6.6 7.7 8.8 9.9 11

Test χ² per l’indipendenza statistica

Chi-Square Tests

Pears on Chi-Square

Likelihood Ratio

N of Valid Cases

Value

5.471 a

5.402

221

df

3

3

Asymp. Sig.

(2-s ided)

.140

.145

a. 0 cells (.0%) have expected count les s than 5. The

minimum expected count is 15.95.

p-value=0.140 > =0.05 accetto l’ipotesi di indipendenza statistica

Chi-Square Tests

Pears on Chi-Square

Likelihood Ratio

N of Valid Cases

Value

26.304a

28.928

221

df

8

8

Asymp. Sig.

(2-s ided)

.001

.000

a. 0 cells (.0%) have expected count les s than 5. The

minimum expected count is 5.47.

p-value=0.001 < =0.05 rifiuto l’ipotesi di indipendenza statistica

Test t per l’indipendenza lineare

Questo test verifica l’ipotesi di indipendenza lineare tra due

variabili, partendo dall’indice di correlazione lineare ρ. Si

ha:

• H0: indipendenza lineare tra X e Y (ρpopolaz=0)

• H1: dipendenza lineare tra X e Y (ρpopolaz ≠ 0)

La statistica test è distribuita come una t di Student con n-2

gradi di libertà, e tende a crescere all’aumentare

dell’ampiezza campionaria

t= ρ √(n-2)/ (1- ρ²)

Test t per l’indipendenza lineare

La regione di rifiuto è caratterizzata da valori relativamente

elevati di t in modulo; se il livello di significatività è al

5%, si rifiuta per |t| >t0,975

0,35

0,3

0,25

0,2

0,15

0,1

0,05

0

Regione di rifiuto

Regione di rifiuto

Test t per l’indipendenza lineare

Correlations

Qualità degli ingredienti

Genuinità

Leggerezza

Sapore/gusto

Pears on Correlation

Sig. (2-tailed)

N

Pears on Correlation

Sig. (2-tailed)

N

Pears on Correlation

Sig. (2-tailed)

N

Pears on Correlation

Sig. (2-tailed)

N

Qualità degli

ingredienti

1

Genuinità Leggerezza Sapore/gusto

.629**

.299**

.232**

.000

.000

.001

220

220

218

220

.629**

1

.468**

.090

.000

.000

.181

220

220

218

220

.299**

.468**

1

.030

.000

.000

.657

218

218

219

219

.232**

.090

.030

1

.001

.181

.657

220

220

219

221

**. Correlation is s ignificant at the 0.01 level (2-tailed).

p-value=0.657 > =0.05 accetto l’ipotesi di indipendenza lineare tra le

variabili leggerezza e sapore/gusto

Test F per la verifica di ipotesi

sulla differenza tra medie

Si considerino le medie di una variabile quantitativa calcolate per

ognuna delle modalità di una variabile categorica (ad esempio

reddito medio per area geografica=nord, per area

geografica=centro e per area geografica=sud).

• H0: le medie sono tutte uguali tra loro

• H1: esistono almeno due medie diverse tra loro

La statistica test da utilizzare, sotto l’ipotesi H0, si distribuisce

come una F di Fisher con (c-1,n-1) gradi di libertà. Tende a

crescere all’aumentare della varianza tra medie e al diminuire

della variabilità interna alle categorie. Cresce inoltre

all’aumentare dell’ampiezza campionaria.

Test F per la verifica di ipotesi

sulla differenza tra medie

La regione di rifiuto cade nella coda di destra della distribuzione,

cioè è caratterizzata da valori relativamente elevati di F; se il

livello di significatività è 5%, si rifiuta per F> F0,95

0.8

0.7

0.6

0.5

0.4

0.3

0.2

Regione di rifiuto

0.1

0

0

0.7

1.4

2.1

2.8

3.5

4.2

4.9

Test F per la verifica di ipotesi

sulla differenza tra medie

Report

Measures of Association

Produzione artigianale

Età

18-25

26-35

36-50

Over 50

Total

Mean

5.01

5.53

6.00

6.09

5.55

Eta

N

78

55

41

47

221

Std. Deviation

2.224

2.609

2.098

2.320

2.352

Produzione

artigianale * Età

Eta Squared

.191

.036

ANOVA Table

Produzione

artigianale * Età

Between Groups

Within Groups

Total

(Combined)

Sum of

Squares

44.296

1172.356

1216.652

df

3

217

220

Mean Square

14.765

5.403

F

2.733

Sig.

.045

p-value=0.045 < =0.05 rifiuto l’ipotesi di uguaglianza tra medie

Report

Attenzione a bis ogni s pecifici

Età

18-25

26-35

36-50

Over 50

Total

Mean

4.05

4.53

5.00

5.83

4.73

N

Std. Deviation

2.772

2.791

2.837

8.168

4.536

78

53

41

47

219

ANOVA Table

Attenzione a bisogni

s pecifici * Età

Between Groups

Within Groups

Total

(Combined)

Sum of

Squares

97.921

4387.641

4485.562

df

3

215

218

Mean Square

32.640

20.408

F

1.599

p-value=0.191 > =0.05 accetto l’ipotesi di uguaglianza tra medie

Sig.

.191

PROC FREQ - Descrizione

La PROC FREQ permette di

• calcolare le distribuzioni di frequenza univariate

per variabili qualitative e quantitative discrete

• creare tabelle di contingenza a due o più

dimensioni per variabili qualitative e quantitative

discrete

• calcolare indici di dipendenza relativi a tabelle di

contingenza

PROC FREQ – Sintassi generale

Distribuzione di frequenza bivariata

proc freq data= dataset option(s);

tables variabile1 * variabile2 /option(s);

run;

OPTIONS:

• noprint non mostra i risultati nella finestra di output

• /missing considera anche i missing nel calcolo delle frequenze

PROC FREQ - Esempio

Variabili qualitative: sesso e operatore

telefonico

proc freq data=corso.telefonia;

table sesso * operatore;

run;

Output PROC FREQ - Esempio

Distribuzioni marginali:

frequenze marginali assolute

e relative

Frequenze congiunte

assolute e relative

Frequency

Percent

Row Pct

Col Pct

Table of sesso by operatore

sesso

operatore

3

Tim

F

7

2.97

7.00

58.33

27

11.44

27.00

49.09

63

26.69

63.00

40.91

3

1.27

3.00

20.00

100

42.37

M

5

2.12

3.68

41.67

28

11.86

20.59

50.91

91

38.56

66.91

59.09

12

5.08

8.82

80.00

136

57.63

Total

12

5.08

55

23.31

154

65.25

15

6.36

236

100.00

Frequenze

subordinate

Vodafone

Total

Wind

Output PROC FREQ - Esempio

freq. congiunta relativa =(7/236)*100

Frequency

Percent

Row Pct

Col Pct

freq. subordinate:

freq. marginale assoluta=7+27+63+3

Table of sesso by operatore

sesso

operatore

3

Tim

Vodafone

Total

Wind

F

7

27

63

3

100

2.97

11.44 26.69

1.27

42.37

7.00

27.00 63.00

3.00

58.33 freq.

49.09marginale

40.91 relativa=(7+27+63+3)/236*100

20.00

M

5

2.12

3.68

41.67

28

11.86

20.59

50.91

91

38.56

66.91

59.09

12

5.08

8.82

80.00

136

57.63

Total

12

5.08

55

23.31

154

65.25

15

6.36

236

100.00

% di riga=5/136*100

% di col=5/12*100

PROC FREQ - Descrizione

La PROC FREQ permette di

• calcolare le distribuzioni di frequenza univariate

per variabili qualitative e quantitative discrete

• creare tabelle di contingenza a due o più

dimensioni per variabili qualitative e quantitative

discrete

• calcolare indici di dipendenza relativi a tabelle di

contingenza

Test chi-quadro – Indipendenza

statistica

• Si applica alle tabelle di contingenza a due

dimensioni

• Per testare l’hp di indipendenza statistica tra le

due variabili della tabella (ossia, la distribuzione di

X non è influenzata da Y e viceversa)

• Si calcola con la PROC FREQ (opzione CHISQ)

PROC FREQ – Sintassi generale

Calcolo dell’indice chi-quadro

proc freq data= dataset option(s);

tables variabile1 * variabile2 /option(s);

run;

OPTIONS:

• noprint non mostra i risultati nella finestra di output

• /missing considera anche i missing nel calcolo delle frequenze

• /chisq calcola l’indice chi-quadro e altre misure di

associazione basate sul chi-quadro

Esempio n°1- Test chi-quadro –

Indipendenza statistica

C’è indipendenza statistica tra le variabili sesso del

rispondente (SESSO) e possesso del computer

(COMPUTER)?

proc freq data=corso.telefonia;

table sesso * computer /chisq;

run;

Esempio n°1- Test chi-quadro –

Indipendenza statistica

Le frequenze della variabile COMPUTER subordinata a SESSO:

sesso=F

Cosa sono le frequenze

subordinate?

Frequency

Table of sesso by computer

Percent sesso(sesso) computer(computer)

Row Pct

0

1

16

84

Col Pct

F

6.78

35.59

16

84

28.57

46.67

40

96

M

16.95

40.68

29.41

70.59

71.43

53.33

56

180

Total

23.73

76.27

computer

computer

Percent

Frequency

136

57.63

236

100

Cumulative

Percent

16

100

29.41

70.59

Cumulative

Frequency

40

136

Cumulative

Percent

29.41

100

16

84

0

1

sesso=M

Total

100

42.37

16

84

Cumulative

Frequency

16

100

computer

0

1

computer

Percent

Frequency

40

96

Le frequenze della variabile di SESSO subordinata a COMPUTER:

computer = 0

sesso

sesso

Frequency

Percent

16

40

F

M

28.57

71.43

Cumulative

Frequency

16

56

Cumulative

Percent

28.57

100

Cumulative

Frequency

84

180

Cumulative

Percent

46.67

100

computer = 1

sesso

sesso

F

M

Frequency

Percent

84

96

46.67

53.33

Esempio n°1- Test chi-quadro –

Indipendenza statistica

Le frequenze subordinate (di SESSO subordinata a

COMPUTER e viceversa) sono diversedenota influenza di

ognuna delle due variabili sulla distribuzione dell’altra

(=dipendenza statistica)

Frequency

Table of sesso by computer

Percent sesso(sesso) computer(computer)

Row Pct

0

1

16

84

Col Pct

F

6.78

35.59

16

84

28.57

46.67

40

96

M

16.95

40.68

29.41

70.59

71.43

53.33

56

180

Total

23.73

76.27

Total

100

42.37

136

57.63

236

100

Esempio n°1- Test chi-quadro –

Indipendenza statistica

Possiamo concludere che le due variabili sono

statisticamente dipendenti?

Il p-value del test chi-quadro è basso (<0.05) rifiuto

l’hp di indipendenza statistica le due variabili sono

statisticamente dipendenti

Statistic

Chi-Square

Likelihood Ratio Chi-Square

Continuity Adj. Chi-Square

Mantel-Haenszel Chi-Square

Phi Coefficient

Contingency Coefficient

Cramer's V

DF

1

1

1

1

Value

5.7275

5.9139

5.0104

5.7032

-0.1558

0.1539

-0.1558

Prob

0.0167

0.015

0.0252

0.0169

Esempio n°2 - Test chi-quadro –

Indipendenza statistica

C’è indipendenza statistica tra le variabili SESSO e

MARCA?

proc freq data=corso.telefonia;

table sesso * marca /chisq;

run;

Esempio n°2 - Test chi-quadro –

Indipendenza statistica

Attenzione: molte celle con frequenze congiunte

assolute molto bassetest non molto affidabile

Frequency

Percent

Row Pct

sesso

Col Pct

F

Altro

M

Total

2

0.85

2

33.33

4

1.69

2.94

66.67

6

2.54

Lg

8

3.39

8

61.54

5

2.12

3.68

38.46

13

5.51

Motorola

19

8.05

19

36.54

33

13.98

24.26

63.46

52

22.03

Table of sesso by marca

marca

Nek

Nokia PalmOne Samsung Siemens

2

0.85

2

50

2

0.85

1.47

50

4

1.69

45

19.07

45

43.69

58

24.58

42.65

56.31

103

43.64

1

0.42

1

100

0

0

0

0

1

0.42

15

6.36

15

37.5

25

10.59

18.38

62.5

40

16.95

1

0.42

1

20

4

1.69

2.94

80

5

2.12

Total

Sony

Ericsson

7

2.97

7

58.33

5

2.12

3.68

41.67

12

5.08

100

42.37

136

57.63

236

100

Esempio n°2 - Test chi-quadro –

Indipendenza statistica

Il p-value del test chi-quadro è alto accetto l’hp di

indipendenza statistica le due variabili sono

statisticamente indipendenti

Statistic

Chi-Square

Likelihood Ratio ChiSquare

Mantel-Haenszel ChiSquare

Phi Coefficient

Contingency Coefficient

DF

Value

8 7.0754

8 7.5018

Prob

0.5285

0.4836

1

0.9191

0.0103

0.1731

0.1706

0.1731

Cramer's V

WARNING: 44% of the cells have expected counts

less

than 5. Chi-Square may not be a valid test.

Test t – Indipendenza lineare

• Si applica a variabili quantitative

• Per testare l’hp di indipendenza lineare tra due

variabili (ossia, il coefficiente di correlazione lineare

tra X e Y è nullo)

• Si calcola con la PROC CORR

PROC CORR - Descrizione

La PROC CORR permette di

• calcolare la correlazione tra due o più variabili

quantitative

PROC CORR – Sintassi generale

Correlazione tra due variabili

proc corr data= dataset;

var variabile1;

with variabile2;

run;

PROC CORR - Esempio

Correlazione tra il numero medio di ore di

utilizzo del telefono cellulare e del fisso al

giorno.

proc corr data=corso.telefonia;

var cell_h;

with fisso_h;

run;

Output PROC CORR - Esempio

1 With

Variables:

1 Variables:

fisso_h

20

c

cell_h

e

15

l

l

Variable

fisso_h

cell_h

N

10

Simple Statistics

_

h

Mean Std Dev

Sum

5

208 0.67933 0.72715 141.3

236 2.43644 3.90018

575

Minimum

Maximum Label

0.05

5 fisso_h

0.25

24 cell_h

1

Pearson Correlation Coefficients

Prob > |r| under H0: Rho=0

Number of Observations

cell_h

0.24403

fisso_h

fisso_h

0.0004

208

2

3

4

f i sso_h

Coefficiente di correlazione

lineare ρ(X,Y): è un indice

relativo, assume valori

compresi tra -1 e 1. Se ρ >0

(ρ <0) la relazione tra X e Y

è lineare positiva (negativa),

se ρ =0 non c’è relazione

lineare.

5

PROC CORR – Sintassi generale

Correlazione tra più variabili

proc corr data= dataset;

var variabile1;

with variabile2 variabile3 variabile4;

run;

proc corr data= dataset;

var variabile1 variabile2 variabile3 variabile4;

run;

PROC CORR - Esempio

Correlazione tra la durata media delle chiamate effettuate e:

• durata media delle chiamate ricevute,

• numero medio di ore di utilizzo del telefono cellulare al giorno,

• numero medio di ore di utilizzo del telefono fisso al giorno.

proc corr data=corso.telefonia;

var durata_chiamate_e;

with durata_chiamate_r cell_h fisso_h;

run;

Output PROC CORR - Esempio

3 With Variables:

1 Variables:

Variable

durata_chiamate_r

cell_h

fisso_h

durata_chiamate_e

durata_chiamate_r

cell_h fisso_h

durata_chiamate_e

N

Simple Statistics

Mean

Std Dev Sum Minimum Maximum

Label

236 12.02119 12.57706 2837

0

90 durata_chiamate_r

236 2.43644 3.90018 575

208 0.67933 0.72715 141.3

236 11.16314 12.40367 2635

Pearson Correlation Coefficients

Prob > |r| under H0: Rho=0

Number of Observations

durata_chiamate_e

0.78645

durata_chiamate_r

durata_chiamate_r

cell_h

<.0001

236

0.23099

fisso_h

0.0003

236

0.24568

cell_h

fisso_h

0.0003

208

d

0.25

0.05

0

24 cell_h

5 fisso_h

90 durata_chiamate_e

80

u

r

a

60

t

a

_

40

c

h

i

20

a

m

0

0

20

40

60

d u r a t a _ c h i a ma t e _ e

80

Esempio n°1 - Test t –

Indipendenza lineare

C’è indipendenza lineare tra il numero medio ore

utilizzo cellulare al giorno(CELL_H ) e il numero

medio ore utilizzo telefono fisso al giorno

(FISSO_H)?

proc corr data=corso.telefonia;

var cell_h;

with fisso_h;

run;

Esempio n°1 - Test t –

Indipendenza lineare

Il p-value del test t è basso rifiuto l’hp di

indipendenza lineare esiste una relazione lineare tra

le due variabili, anche se non molto forte (il coefficiente

di correlazione lineare è non nullo ma ha valore non

molto elevato)

Pearson Correlation

Prob > |r| under H0: Rho=0

Number of Observations

cell_h

fisso_h

fisso_h

0.24403

0.0004

208

Esempio n°2 - Test t –

Indipendenza lineare

C’è indipendenza lineare tra il numero medio ore

utilizzo telefono fisso (FISSO_H ) e il numero

medio di email inviate al giorno (EMAIL_H)?

proc corr data=corso.telefonia;

var fisso_h;

with email_h;

run;

Esempio n°2 - Test t –

Indipendenza lineare

Il p-value del test t è alto accetto l’hp di indipendenza

lineare non esiste una relazione lineare tra le due

variabili

Pearson Correlation

Prob > |r| under H0: Rho=0

Number of Observations

fisso_h

email_h

email_h

0.06069

0.3838

208

Test F – Indipendenza in media

• Si applica a variabili quantitative

• Per testare l’hp di indipendenza in media tra due

variabili, di cui una categorica (ossia, se X è

categorica, le medie di Y calcolate per ogni

categoria di X sono uguali tra di loro e uguali alla

media globale di Y)

• Si calcola con la PROC REG (la vedremo quando

parleremo di modelli di regressione lineare)

Esercizi

1. Testare se le variabili area geografica e sesso

del data set DENTI sono statisticamente

indipendenti

2. Testare l’ipotesi di indipendenza lineare tra le

variabili consumo di dentifrici della marca A e

numero di contatti pubblicitari totali del data

set DENTI