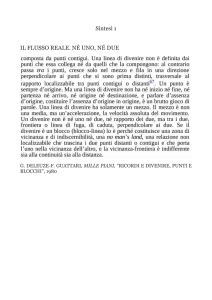

L’Analisi

Multidimensionale

dei Dati

Una Statistica da vedere

I metodi

di Classificazione automatica

Matrici e metodi

Strategia

di AMD

Anal. Discrimin.

Segmentazione

SI

Per riga

NO

Correl. Canon.

Corrisp. Multi.

SI

Analisi

simmetrica

SI

Matrice

strutturata

NO

Analisi nello

spazio delle

variabili

NO

SI

Comp.Princ.

An. Corrisp.

An. Matrici 3D

NO

Analisi

confermative

Cluster Anal.

Scaling Multid

Regress.Mult,

Conjoint Anal.

An. Non Simm

Corrisp.

• Variabili qualitative

• Variabili ordinali

• Variabili quantitative

Analisi

esplorative

Classificazione automatica

Insieme di procedure (algoritmi) che si prefiggono

di classificare o raggruppare individui in classi tali che:

- gli individui all'interno di una classe siano molto simili

- ogni classe sia relativamente distinta dalle altre

• Tabelle individui-variabili numeriche

I dati • Tabelle di contingenza

• Tabelle di presenza-assenza

Si ipotizza la presenza di raggruppamenti tra le unità

oppure

Se ne richiede la determinazione

La definizione delle classi si ottiene mediante algoritmi

iterativi basati su una serie di operazioni elementari

ripetute in maniera ricorsiva.

I metodi di Classificazione automatica

Definire una o più partizioni a partire dall’insieme dei punti considerati

Obiettivo

Numero delle partizioni possibili

Problema

Es.: 4 elementi (A,B,C,D) e 2 gruppi

(A) (B,C,D)

(B) (A,C,D)

(C) (A,B,D)

Numero delle partizioni (P)

(D) (A,B,C)

(A,B) (C,D)

(A,C) (B,D)

(A,D) (B,C)

2n-1- 1

n=4

P=7

n=10

P = 511

n=100

P = 1,000,000,000,000,000,000,000,000,000,00 - 1

= 1029-1

I metodi di Classificazione automatica

1 milione di partizioni

al secondo

Partizione ottimale di...

… 20 unità in 5 classi

8 giorni

… 30 unità in 5 classi

2444 secoli!

I metodi di Classificazione automatica

• Gli algoritmi per la classificazione automatica possono portare:

Alla costruzione di classi per

dicotomizzazioni successive

dell’insieme degli oggetti

Alla costruzione di classi per

aggregazioni successive di

coppie di oggetti

Direttamente a

delle partizioni

Classificazione

gerarchica discendente

Classificazione

gerarchica ascendente

Classificazione non

gerarchica

Criteri di classificazione

E = {e1, e2, ..., ei, ..., en} è l'insieme degli n individui da raggruppare

Una PARTIZIONE di E : P(E) = {c1, c2, ..., cj, ..., ck} (k n) verifica le

seguenti proprietà

per cj e cj P(E) cj cj = j j

c1 c2 ... cj ... ck = E

P(E) P(E) se ogni elemento di P(E) è incluso in un solo elemento di

P(E)

Una GERARCHIA di E : H(E) = {c1, c2, ..., cj, ..., ck} verifica le seguenti

proprietà

ei E ei H(E)

E = {e1, e2, ..., ei, ..., en} H(E)

per cj e cj H(E) cj cj = o cj cj o cj cj

taglio del dendrogramma per

ottenere i gruppi

H(E)

e3

e1

P4={(e1 e2 e3 e4) e5}

nodi

e2

e4

P5={(e1 e2 e3 e4 e5)}

H(E)

rami

P2={(e1 e2) e3 e4 e5}

e5

E

Gerarchia

una gerarchia è una

sequenza di

partizioni nidificate

P3={(e1 e2) (e3 e4) e5}

P1={e1 e2 e3 e4 e5}

e1

e2

e3

e4

e5

Albero Gerarchico

o

Dendrogramma

La misura del grado di somiglianza

Si può definire una applicazione d che faccia corrispondere un

numero reale positivo o nullo a ciascuna coppia (i,h)

Condizioni:

1) Separabilità: d i, h 0 ei eh

2) Simmetria: di, h dh, i

3) Disuguaglianza triangolare: di, h di, e de, h

i, h, e

4) Condizione di Krassner: di, h SUPdi, e ; de, h

i, h, e

Parleremo di:

.) indice di dissimilarità se si verificano le condizioni 1 e 2

.) metrica o distanza se si verificano le condizioni 1, 2 e 3

.) ultrametrica

se si verificano le condizioni 1, 2 e 4

• indici di similarità: dati booleani

• indici di distanza: dati numerici e frequenze

Indici di similarità per variabili dicotomiche

Dati binari

•

Sii 0

Indici di similarità: ei , ei E Sii Sii (simmetria )

S max solo se x x j 1, ..., p

ij

ij

ii

ei

ei

1 2 3 4 5 .. .. .. .. 10 .. .. .. .. 15 .. .. .. .. 20

0 1 1 0 0 1 0 0 1 0 0 1 1 1 0 0 1 0 1 0

0 1 1 1 0 0 0 0 1 1 1 1 1 1 0 1 1 0 1 0

ei

ei

ei

1

0

1

a

c

0

b

d

ei

1

0

• Indice di Sokal-Michener:

1

8

4

12

0

1

7

8

Sii

• Coefficente di Jaccard: Sii

9

11

20

a+ d = concordanza

a+d

a+b+c+d

a

a b c

0,1

0,1

15

0.75

20

8

0.6

13

La matrice di similarità/dissimilarità

Dati binari

e1. . ei ei . . en

e1

1

.

.

1

ei

Sii

ei

Si i

.

.

1

en

Indice di dissimilarità

Matrice di Similarità

quadrata n n

simmetrica

diagonale = 1

d ii 1 S ii

Distanze per variabili quantitative

METRICA DI MINKOWSKY d

h

ii

xij - xij

j

h

1

h

Caso particolare

h=2

h=1

2

d

x

x

2

Distanza Euclidea

ij ij

j

Distanza di Manhattan (city block) d 1 x ij - x ij

1

2

j

d Max x ij - x i j

h Distanza di Lebisev

j

e1

x12

d 22 4 2 2 2

d1 4 2 6

2

x11

2

4.472

d Max 4,2 4

4

x22

1

e2

x21

2

DISTANZA EUCLIDEA NORMALIZZATA d ii

DISTANZA DI MAHALANOBIS

xi

1

2

2 x ij - x ij

j

j

1

2

- x i W -1 x i - x i

(W è la matrice di varianza)

INDICE DI DISTANZA DEDOTTO DAL COEFFICIENTE DI CORRELAZIONE

d ii 1 - rii

Distanze per tabelle di frequenze

Distanza del

c2 (Benzecri)

• Distanza tra due righe i e i’:

d ii

j

• Distanza tra due colonne j e j’:

d jj

1 f ij f ij

f . j f i. f i.

i

1

f i.

2

f ij

f ij

f .j

f .j

2

PCI

DC

Una Metrica Particolare: la Distanza del

V.D'Aosta

Piemonte

PCI DC

VDA

PIE

c2

2

2

PCI2

DC2

1 PCI1

1 DC1

...

PCI VDA PIE DC VDA PIE

f i j

1 f ij

c2

f i .

j f. j fi .

2

Classificazione gerarchica

• Il principio dell’algoritmo consiste nel creare, a ciascun passo, una

partizione ottenuta aggregando a due a due gli elementi più vicini;

• L’algoritmo non fornisce una partizione in q classi di un insieme di n

oggetti ma una gerarchia di partizioni che si presentano sotto forma di

albero detto anche dendrogramma e che contiene n-1 partizioni;

• L’importanza della lettura del dendrogramma è nella possibilità di

suggerire il numero di classi effettivamente presenti nell’insieme

osservato.

I passi di una procedura di classificazione

•

PASSO 0: n individui da classificare

•

PASSO 1: analisi della matrice di dissimilarità

(distanza) e aggregazione dei due elementi più vicini

•

PASSO 2: calcolo delle distanze tra il nuovo punto ed

i punti restanti. Ritorno al passo 0 con n-1 punti da

classificare

•

PASSO 3: nuova ricerca dei due punti più vicini e loro

aggregazione. Calcolo delle nuove distanze e

ripetizione del processo fino a comprendere tutti gli

elementi in un'unica classe

Dendrogramma

14

15

16

gruppi

19

18

17

48

9

7

6

5

3

gruppi

1

gruppo

2 gruppi

gruppi

Scelta del livello

di “taglio”

x

Definizione delle

classi della partizione

x

x

I diversi criteri di raggruppamento

Gruppo A

Gruppo B

x

x

• Criteri per la determinazione della distanza tra due gruppi

a. Distanza minima

;

b. Distanza massima

c.

;

d. Distanza media

Distanza centroidi

• Criteri basati sull’inerzia dei gruppi

Metodo di Ward

I diversi criteri di raggruppamento

• Criteri basati sull’inerzia dei gruppi

Metodo di Ward

Il metodo di Ward è basato sulla minimizzazione della

varianza all’interno dei gruppi

Inerzia totale

=

Inerzia entro le classi + Inerzia tra le classi

gj

Teorema di Huyghens:

g

gk

g

gi

xi

• Obiettivo della partizione è minimizzare la quota di variabilità interna ai gruppi,

massimizzando al contempo la variabilità tra i gruppi, così da ottenere classi

omogenee al loro interno e ben separate l’una dall’altra

• Varianza tra i gruppi in caso di n classi: massima

• Varianza tra i gruppi in caso di una classe: nulla

• L’algoritmo di Ward aggrega, ad ogni passo intermedio, gli oggetti (gruppi o unità)

che determinano la perdita di inerzia tra le classi minima.

DISTANZA DI WARD O CRITERIO DELLA VARIANZA MINIMA

d c j , c j n j d e j , e jj n j d e j , e jj e jj centroide di c j c j

e j j

cj

(nj )

ej

cj

e j

e j j

(nj )

e j j

e j

cj

(nj )

Un esempio

(Criterio della distanza minima)

6

a b

a

b

c

d

e

f

g

ab

c

de

f

g

abcde

f

g

c

d e

a

0

ab

0

f

b

1

0

c

2

0

abcde

0

g

c

3

2

0

de

5

3

0

f

4

0

d

6

5

3

0

f

10

8

4

0

g

9

5

0

e

7

6

4

1

0

g

15

13

9

5

0

5

f

11

10

8

5

4

0

abc

de

f

g

4

g

16

15

13

10

9

5

0

abc

0

abcdef

abcdef

0

g

3

2

1

a b c d e

de

3

0

g

5

0

f

8

4

0

g

13

9

5

0

f

g

I diversi criteri di raggruppamento

a b

c

d e

a b c d e f g

Distanza

minima

f

g

a b c d e f g

a b c d e f g

Distanza

massima

Distanza

media

I passi di una classificazione gerarchica

1

…

p

1

1

:

Matrice

dei dati

:

…

n

1

…

n-1

1

Matrice

delle

distanze

:

n-1

n

Matrice delle

ultrametriche

n

1

:

n

1

n

1

…

Matrice

delle

distanze

1 … 2

...

1

2

Matrice

delle

distanze

Esempio: I consumi alimentari

2.92

Livello

di taglio

1.40

0.93

0.77

0.71

0.54

0.38

0.36

0.13

0.08

BE

FR

GE

DA

0.15

IR

AU

0.22

0.11

OL

SV

FI

0.18

0.13

GB

NO

Classi della partizione

IS

SP

PO

GR

IT

La descrizione delle classi: I valori-test

Media

generale

Media

classe k

a) variabili continue:

t k X j

x jk x j

j2 N n k

nk

~

N 1

N(0,1)

Numerosità

classe k

Variabile j

Varianza

variabile j

Numerosità

totale

b) variabili nominali

tk X j

p jk Pj

Pj 1 Pj N nk

nk

N 1

95%

~

N(0,1)

2.5%

-1,96

0

2.5%e

1,96

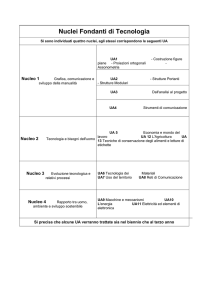

La definizione delle classi

Classe 1

BE, FR, GE, DA, IR

V. test

Media

Classe Generale

Classe 2

AU, OL, SV, FI, GB, NO, IS

Variab.

V. test

Media

Classe Generale

Classe 1

SP, PO, GR, IT

Variab.

V. test

Media

Classe Generale

Variab.

2,81

104,10

85,78

Carne

2,46

161,63

128,41

Latte

3,26

175,78

95,61

Verdure

2,20

6,20

4,22

Burro

2,09

40,29

36,38

Zucchero

2,50

94,35

78,21

Cereali

2,16

13,94

12,27

Uova

0,33

4,44

4,22

Burro

2,33

5,43

4,17

Riso

1,05

91,92

81,31

Patate

0,37

85,75

81,31

Patate

0,33

37,18

36,38

Zucchero

-0,15

4,11

4,17

Riso

-1,12

11,61

12,27

Uova

-0,01

85,68

85,78

Carne

-0,39

76,08

78,21

Cereali

-1,30

71,20

81,31

Patate

-1,03

11,35

12,27

Uova

-0,47

120,14

128,41

Latte

-1,82

70,51

78,21

Cereali

-2,32

80,62

128,41

Latte

-0,87

77,26

95,61

Verdure

-2,03

62,90

95,61

Verdure

-2,73

1,35

4,22

Burro

-2,02

3,24

4,17

Riso

-2,61

72,76

85,78

Carne

-2,74

28,52

36,38

Zucchero

es.:

t Carne,Cl.1

104.10 85.78

18.32

6.53

290.70 16 5

5

16 1

2.81

Le “tipologie”

La dieta

mediterranea

La dieta

iperproteica

La dieta grassa

Classificazione non gerarchica

• E’ utilizzata quando si hanno molti punti da classificare

• Richiede la determinazione a priori del numero di classi che definiscono la

partizione

Metodo dei centri mobili

• L’algoritmo è convergente ed il numero di iterazioni richieste è

generalmente limitato, cosa che rende questo metodo applicabili anche a

grosse quantità di dati;

• D’altra parte, la soluzione ottenuta non rappresenta la soluzione ottimale

ma solo una delle tante possibili, ottenuta avendo determinato a priori quel

numero di classi e avendo scelto quelle unità iniziali;

Soluzione proposta

Metodo delle nubi dinamiche

Metodo dei centri mobili

1° passo: Scelta casuale dei k nuclei iniziali

2° passo: Calcolo delle distanze e definizione della prima partizione

Passi successivi: Definizione dei nuovi nuclei, calcolo delle nuove

distanze, definizione della nuova partizione, e così via...

Convergenza: Stabilità della partizione

Un algoritmo generale di tipo nubi dinamiche

PASSO 0: definizione del numero delle classi (k) e dei nuclei costituiti

da uno o più elementi rappresentativi di ciascuna classe. La

scelta dei nuclei può essere inizialmente arbitraria (per es.

elementi casuali) o basata su informazione a priori (per es.

un'analisi fattoriale preliminare

L 0 l'insieme

n j ( j 1, ..., k ) ,

PASSO 1: sia

0

dei k nuclei iniziali E j

di numerosità

L E ... E ... E

0

0

0

1

0

j

0

k

Al primo passo si passa da questi nuclei ad una prima

partizione P0 E C10 ... C0j ... C0k

per mezzo di una funzione di distanza D tale che:

C 0j ei E

D ei , E 0j D ei , E 0h h j

Un algoritmo generale di tipo nubi dinamiche

PASSO 1

D può essere il legame singolo, il legame medio, ecc., tra i gruppi

E 10

.......

E 0j

.......

E 0k

D i1

.......

D ij

.......

D ik

e1

.

.

.

ei

.

.

.

en

Un algoritmo generale di tipo nubi dinamiche

PASSO 2: ridefinizione dei k nuclei L11 E11 ... E1j ... E1k di numerosità

n j ancora considerando gli elementi più vicini alla classe

C 0j per mezzo di una funzione di distanza R tale che:

E 1j ei E i 1, ..., n j

C

0

1

.......

C 0j

e1

R1j

.

.

.

.

.

.

ei

.......

R ij

.

.

.

.

.

.

en

R nj

R ei , C 0j Min

.......

.......

C 0k

Un algoritmo generale di tipo nubi dinamiche

1

PASSI SUCCESSIVI: si passa dai nuovi nuclei E j ad una nuova

partizione P1 E , poi ai nuclei E 2j e da questi ad una nuova

partizione e così via fino alla convergenza ad una soluzione

stabile e quindi ottimale

Ricerca delle forme forti:

la soluzione dipende dalle scelte iniziali.

Ripetendo la procedura s volte P , P , ..., P si

definiscono forme forti le k classi della partizione

prodotto P costituita da elementi classificati

insieme in ciascuna delle s partizioni

1

j

2

s

Metodo delle nubi dinamiche

x1

x2

x3

x4

x5

1

2

2

0

3

4

2

5

1

5

2

1

x1

x2

x3

x4

x5

Matrice

dei Dati

x3

x1 x2 x3 x4 x5

0

4

2 3.16 4.45

4

0 4.45 1.41 2

2 4.45 0 4.25 5.65

3.16 1.41 4.25 0 1.41

4.45 2 5.65 1.41 0

Matrice delle

Distanze Euclidee

E 10 x3 , x5

x1

E 02 x1

x4

x2

x5

Scelta dei Nuclei

Iniziali

Metodo delle nubi dinamiche

x1

x2

x3

x4

x5

E 10 E 02

3.23 0

3.23 4

2.83 2

2.83 3.16

2.83 4.45

0

P1 x 2 , x 4 , x 5

0

P2 x1 , x 3

PPAAASSSS

11:: passaggio

S

O

Passo

1:

dai dai nuclei

SO

Opassaggio

nuclei

alla partizione

prima secondo il

alla prima

partizione

il

criterio secondo

della distanza

media

criterio della distanza

media

x1

x2

x3

x4

x5

P10 P20

PPasso

O

PAAASSSSSSO

O 2:2

2::calcolo

calcolodei d

3.87 1

nuclei nuclei

in baseinagli

ele

nuovi

base

1.14 4.23

agli

elementi

più

prossimi

alla partizion

4.78 1

prossimi alla partizione

0.94 3.71

1.14 5.05

E 11 x 4 , x 5

Passo 3: passaggio dai

nuovi nuclei ad una

nuova partizione

x1

x2

x3

x4

x5

E 12 x1

E 11 E 12

3.58 0

0.71 4

4.35 2

0.71 3.16

1.71 4.45

1

P1 x 2 , x 4 , x 5

1

P2 x1 , x 3

PPAAASSSSSSO

O

O 3

3:: passaggio

Metodo delle nubi dinamiche

Partizione

Finale

x

3

P x2 , x4 , x5

1

1

P21 x1 , x3

x

1

x

4

x

2

x

5

Metodo delle nubi dinamiche

(distanza minima dai nuclei)

x1

x2

x3

x4

x1

x2

x3

0

4

2

0

x4

3.16 4.45

4.45 1.41

0

x5

x5

Matrice delle

Distanze

{x1 x2 x3}

{x4 x5}

{x1 x3}

{x2 x4 x5}

4

4.45

2

3.4

1

3.37

0

2

4.05

1.7

4.2

1.41

4.45

5.65

2.2

4.45

1

4.78

1.41

1.41

1.41

2.3

0.7

3.47

1.41

0

2

0

4.3

0.7

3.35

1.7

2

4.25 5.65

0

A) {x2} {x5}

Metodo delle nubi dinamiche

(distanza media dai nuclei)

B) {x1} {x3}

x3

x1

{x3}

0

2

3.4

2

4

4.25

1.84

4.45

2

0

4.18

0

3.16

4.25

1.49

4.25

4.45

5.65

1.96

5.65

x4

x2

{x1 x2 x4}

Partizione Finale

x5

A

{x1 x3}{x2 x4 x5}

B

{x1 x3}{x2 x4 x5}

Metodi fattoriali e Classificazione

Metodi fattoriali

+ Sono particolarmente adatti all’esplorazione di grandi tabelle di dati individuali

+ Consentono di evidenziare le relazioni strutturali tra le variabili e/o le unità osservate

-

I piani rappresentano solo una parte della variabilità totale

La lettura può risultare complessa

Metodi di classificazione

delle classi è più facile di quella di uno spazio continuo, anche

+ Lase adescrizione

due dimensioni

Le classi si formano sulla base delle dimensioni reali del fenomeno e non

+ considerano, quindi, eventuali deformazioni dovute ad operazioni di proiezione

algoritmi di classificazione sono generalmente “robusti”, nel senso che

+ Gli

risultano non influenzati da eventuali punti anomali isolati

Lo spazio a p dimensioni è probabilmente ridondante e contiene, quindi, una

- parte di “rumore”, inutile ai fini dell’analisi

Approccio integrato

Classificazione sui risultati di un

metodo fattoriale