Leon M. Lederman e David N. Schramm

DAI QUARK AL COSMO

1991 Zanichelli

dalla quarta pagina di copertina:

Dai quark al cosmo è il racconto "in diretta" di un'avvincente impresa scientifica, a cui si

stanno dedicando numerosi ricercatori in ogni parte del mondo: il tentativo di costruire una

teoria unitaria dei fenomeni fisici, collegando cosmologia e fisica delle particelle, l'immensa

scala dell'universo e quella incredibilmente piccola dei leptoni e dei quark.

Il racconto inizia il 17 aprile 1987 con la prima registrazione di una collisione protoneantiprotone al fermilab, l'acceleratore di particelle di Chicago. A partire da questo episodio, i

due autori descrivono lo sviluppo delle attuali concezioni dello spazio, del tempo, della

materia e delle forze fondamentali; con un tono narrativo che si mantiene sempre avvincente

e chiaro, ci parlano del Modello Standard della fisica delle particelle e della teoria del Big

Bang, della supersimmetria, della "teoria del Tutto" (TOE), della supergravità.

Il libro si conclude con una rassegna degli strumenti che si stanno approntando per la fisica

degli anni Novanta, come il Superconducting Supercollider (SCC), capace di simulare le

condizioni dell'Universo pochi trilionesimi di secondo dopo il Big Bang, e i nuovi telescopi e

osservatori spaziali.

Gordon Kane

IL GIARDINO DELLE PARTICELLE

1997 Longanesi & C.

dalla quarta pagina di copertina:

Sebbene l'idea secondo cui gli "oggetti" intorno a noi - le case, gli alberi, gli animali e persino

l'arcobaleno - sono composti da particelle piccolissime sia molto antica, essa ha dovuto

passare al vaglio di innumerevoli scienziati (da Newton a Rutherford, da Boltzmann a

Feynman) per raggiungere quel grado di "concretezza" che le attribuiamo oggi. La semplice

nozione di atomo dell'inizio del nostro secolo - quella di un sistema solare in miniatura

formato da un nucleo centrale circondato da elettroni orbitanti - è stata infatti ormai

soppiantata da un quadro assai più variegato e complesso, e le varie decine di particelle

oggi note compongono quello che alcuni hanno chiamato uno "zoo" e che l'autore di questo

libro, usando un'altra metafora, ha preferito chiamare un "giardino". Di questo giardino, che è

l'universo, le particelle sono in un certo senso i semi, dai quali cresce la diversità di tutto ciò

che ci circonda.

In questo saggio, Gordon Kane c'illustra anzitutto come gli scienziati siano giunti a

comprendere le leggi sottese all'intero universo: dalle affermazioni dei filosofi greci, secondo

i quali doveva esistere un elemento primario costitutivo della materia, fino alle scoperte di

Newton, Maxwell, Einstein, Heisenberg. Poi, grazie a un affascinante tour dei maggiori

laboratori di fisica nel mondo, l'autore ci mostra come gli enormi acceleratori e collisori

odierni siano in grado di "vedere" cose milioni di milioni di volte più piccole di quelle

osservabili attraverso i primi microscopi, quattrocento anni or sono. Così, grazie alla

comprensione del funzionamento dei macchinari utilizzati per "vedere" i quark e i leptoni,

riusciamo a capire meglio gli esperimenti che hanno condotto gli scienziati a formulare la

cosiddetta "teoria standard", cioè la teoria matematica completa che descrive come

funzionano tutte le cose, dalle particelle alle stelle, cominciando dagli elettroni a dai quark. Il

punto d'arrivo della ricerca scientifica, quindi? Niente affatto, ci rivela Kane, spiegandoci

come la "teoria standard" si estenda di giorno in giorno, incorporando le ricerche più

avanzate sulla supersimmetria, sulla materia oscura e sulle superstringhe, e spingendosi

sino a far intravedere una possibile - ed esaltante - "teoria del tutto".

Forte di una pluriennale esperienza nell'insegnamento della fisica a studenti non

specializzati, Gordon Kane ci guida con sicurezza e disinvoltura in un campo tanto ostico

quanto affascinante: grazie al suo libro, destinato a diventare un piccolo classico

sull'argomento, il mondo delle particelle non sarà più, per noi, un giardino proibito.

Leon Lederman e Dick Teresi

LA PARTICELLA DI DIO

1996 Mondadori

dalla quarta pagina di copertina:

Nel V secolo a.C. Democrito di Abdera ipotizzò che la materia sia costituita da particelle

invisibili e indivisibili, alle quali attribuì il nome di "atomi". Partendo da tale intuizione, il

premio Nobel per la fisica Leon Lederman, in un'epoca in cui dagli ambienti scientifici quasi

ogni giorno giunge l'annuncio di scoperte riguardo alla struttura della materia, ripercorre

l'affascinante storia di ricerche, esperimenti e studi svolti dall'uomo per rispondere

all'antichissima e ardua domanda: "Di che cosa è fatto il mondo?". Secolo dopo secolo, egli

ci permette di cogliere lo sforzo comune dell'umanità nel tentativo di individuare e descrivere

l'atomo teorizzato da Democrito, uno sforzo coronato da successi sempre parziali, provvisori,

inevitabilmente limitati, a fronte dei continui progressi scientifici e tecnologici. Galileo,

Newton, Faradey, Rutherford, Einstein sono soltanto alcuni dei numerosi protagonisti di tale

appassionante avventura, presentati come veri e propri detective alla ricerca di indizi che

svelino il segreto ultimo dell'universo.

Illustrando ogni tappa di questo viaggio in prosa chiara e accattivante, non di rado venata da

un originale umorismo. Lederman ci conduce fino all'ultimo cinquantennio, in cui lo studio del

mondo subatomico ha conosciuto uno sviluppo straordinario grazie alla creazione della più

complessa apparecchiatura sperimentale mai realizzata. l'acceleratore di particelle. L'autore

ce ne spiega il funzionamento in modo estremamente semplice, con la metafora di un

affilatissimo coltello che seziona la materia fino a separarne gli elementi costitutivi (leptoni,

mesoni, quark, ecc.). E, infine, immagina la possibilità di metterne a punto un nuovo,

potentissimo modello in grado di fornirci la risposta definitiva sull'argomento, di farci scoprire

appunto la "particella di Dio".

Gerard 't Hooft

IL MONDO SUBATOMICO - alla ricerca delle particelle fondamentali

1999 Editori Riuniti

dalla quarta pagina di copertina:

Gerard 't Hooft, fisico teorico di punta, presenta in modo chiaro e affascinante uno degli

ambiti di ricerca più creativi nella fisica del Novecento: quello che, soprattutto a partire dagli

anni sessanta, ha esplorato a fondo la struttura fondamentale della materia, alla ricerca degli

elementi ultimi, dei costituenti indivisibili. E' una storia che coinvolge aspetti della ricerca

scientifica contemporanea, dalla riflessione teorica sull'origine dell'universo alle spettacolari

sperimentazioni della fisica delle alte energie.

Nella prima parte del libro 't Hooft ricostruisce le modalità con cui si è giunti a elaborare il

cosiddetto Modello Standard della fisica, la teoria che descrive il mondo subatomico. La

seconda parte illustra le ipotesi teoriche più attuali e più ardite circa la struttura della materia,

dello spazio e del tempo.

Paul Davies

LE FORZE DELLA NATURA

1990 Bollati Boringhieri

dalla quarta pagina di copertina:

Vero "cavallo di razza" della divulgazione scientifica, Paul Davies è uno dei rari fisici che

sanno farsi seguire dal lettore comune anche quando affrontano argomenti difficili. ne è una

prova il presente volume, una delle migliori illustrazioni disponibili del microcosmo atomico e

dell'incredibile fauna che lo abita: non solo la familiare triade protone-elettrone-neutrone, ma

le ben più intriganti realtà che vanno sotto il nome di "colore", "incanto", "stranezza".

Negli ultimi anni la ricerca fondamentale ha fatto passi da gigante, si da far pensare

prossima una descrizione unificata di tutte le forze della natura, sostituite da un'unica

"superforza", e l'avvento di una "supersimmetria" capace di unire forza e materia. Progressi

promettenti si sono avuti nel campo delle teorie di grande unificazione, ma forse la spinta

decisiva è stata data dalla scoperta delle particelle W e Z, i bosoni intermedi portatori della

cosiddetta interazione debole.

Anche di questi nuovi sviluppi rende conto il libro di Davies, che ha dunque tutto per

interessare un pubblico vario, compresi i lettori di formazione scientifica, ma non addentro

alla materia, desiderosi di curiosare "nell'orto del vicino".

Paul Davies

SUPERFORZA - verso una teoria unificata dell'universo

1986 Mondadori

dalla quarta pagina di copertina:

Sta oggi per realizzarsi un sogno antico dell'uomo: costruire una teoria che gli consenta di

unificare lo scibile, di ricondurre la sconcertante molteplicità dei fenomeni che lo circondano

a un'unica legge fisico-matematica. Una legge che comprenda l'infinitamente grande, ma

anche l'infinitamente piccolo: le stelle, le galassie, gli spazi immensi, e la popolazione

sterminata di particelle di cui i grandi acceleratori di tutto il mondo annunciano sempre più

spesso la scoperta - bosoni, fermioni, quark, antiquark, particelle W, particelle Z...

La soluzione viene intravista, oggi, dai fisici, nell'unificazione delle quattro forze che

producono tutti gli eventi della natura - gravità, elettromagnetismo, interazione nucleare forte

e debole - in una singola superforza, amalgama di materia, spazio-tempo ed energia: una

struttura integrata e armoniosa, che confermerebbe le simmetrie profonde della materia

rivelate dall'analisi matematica.

In questo libro Paul Davies racconta la storia affascinante di questa ricerca, dalle ipotesi di

Einstein alle scoperte di Rubbia alle prospettive attuali. E' un viaggio avventuroso nel cuore

di un universo a undici dimensioni, nato spontaneamente dal nulla eppure "prodotto della

legge, più che del caso": un mondo dominato da una logica molto diversa da quella del

senso comune, una logica surreale che richiama alla mente il Paese delle Meraviglie di

Alice.

Brian Greene

L'UNIVERSO ELEGANTE - supertringhe, dimensioni nascoste e la ricerca della teoria

ultima

1999 Einaudi

dalla quarta pagina di copertina:

La teoria delle superstringhe è come una grande rete che avvolge molte delle scoperte

fondamentali della fisica; è una teoria che unifica le leggi del grande e del piccolo, leggi che

governano i più ampi spazi del cosmo e i più piccolo brandelli di materia. Dunque, è una

teoria a cui ci si può accostare in vari modi. Ho scelto di concentrarmi sui progressi nella

nostra concezione dello spazio e del tempo. Mi sembra una linea evolutiva molto stringente,

che apre vaste e interessanti prospettive su nuovi concetti. Einstein ci ha mostrato che lo

spazio e il tempo si comportano in modi sorprendenti e controintuitivi; oggi le ricerche più

avanzate hanno integrato le sue idee nell'ambito di un universo quantistico, dotato di molte

dimensioni nascoste nella trama del cosmo - dimensioni dalla geometria riccamente intricata

che possono celare la risposta alle domande più profonde mai poste. Alcuni di questi

concetti sono complessi, ma possono essere intesi grazie ad analogie prese dal mondo

quotidiano; quando li si comprende appieno, ci offrono una prospettiva sorprendente e

rivoluzionaria da cui guardare l'universo.

Robert P. Crease e Charles C. Mann

ALLA RICERCA DELL'UNO

1987 Mondadori

dalla quarta pagina di copertina:

Un'opera unica, irripetibile: Alla ricerca dell'uno oltreché un capolavoro di divulgazione

scientifica, è un trascinante viaggio nel cuore della fisica del nostro secolo raccontato dai

suoi grandi protagonisti: una storia non di protoni ma di persone, individui geniali.

Ecco giganteggiare, all'inizio, la figura di Einstein, l'ultimo pensatore solitario, il primo a

intuire le relazioni che legano insieme tutti i fenomeni dell'universo. ecco poi il sorgere della

teoria quantistica, la scoperta dei quark, l'entusiasmante proposta della teoria della "forza

elettrodebole" di Weinberg e Salam, la sua clamorosa conferma sperimentale compiuta da

Carlo Rubbia al CERN di Ginevra nel 1983. E infine ecco che appaiono le Nuove Teorie

Unificate - dalla Superforza alle Supercorde - che propongono una spiegazione globale del

cosmo, della sua nascita come del suo destino...

Fisica

La particella di Dio

Il nostro mondo, dagli atomi alle galassie più lontane, è oggi tenuto insieme da

quattro distinte forze, molto diverse tra loro. Unificarle in una sola formula è il

sogno di ogni fisico. Così i ricercatori elaborano teorie raffinate e affascinanti,

cercando poi di verificarle con la scoperta di "superparticelle" che sembrano

inaccessibili. La ricerca continua, e un giorno sapremo se è davvero così. Allora,

come dice Stephen Hawking, "conosceremo la mente di Dio"

Poter descrivere la complessità dell'universo in cui viviamo con una semplice teoria, la

"Teoria del tutto", è il sogno di ogni scienziato. Ma per arrivare a farlo è indispensabile un

passo intermedio: riuscire a descrivere, in un'unica trattazione matematica, tutte le quattro

forze fondamentali esistenti in natura. A questa meta ambiziosa - l'unificazione - stanno

lavorando ricercatori in tutto il mondo, alle prese con alcune delle più astratte e raffinate

teorie fisiche e matematiche mai elaborate dall'uomo, che hanno nomi suggestivi e difficili

(come superstringhe, supersimmetrie, supergravi- tà...) e che puntano a penetrare i più

riposti segreti del mondo delle particelle subatomiche. "Se riusciremo a trovare una

risposta", ha detto il famoso scienziato inglese Stephen Hawking, "decreteremo il trionfo

definitivo della ragione umana, giacché allora conosceremmo la mente di Dio". Via via che le

nostre conoscenze della natura e del cosmo si sono approfondite e nuovi esperimenti hanno

permesso di esplorare in dettaglio le nascoste proprietà della materia, la comprensione delle

quattro forze, o interazioni, fondamentali, che sono alla base dei processi fisici, chimici e

biologici è divenuta più chiara. Le quattro forze di base La forza gravitazionale, che si

esercita tra tutti i corpi dotati di massa, è la più familiare poiché viene avvertita attraverso il

nostro peso corporeo; è la causa della caduta dei corpi sulla Terra, e del movimento dei

pianeti intorno al Sole. All'interazione elettromagnetica, che si esercita tra particelle cariche,

si devono l'elettricità, le onde radio e l'attrazione che consente agli elettroni di carica

negativa di orbitare attorno al nucleo dell'atomo, che ha una carica positiva. Nel mondo di

dimensioni infinitesimali in cui vivono le particelle elementari, sono attive due altre

interazioni senza le quali l'universo come noi lo conosciamo non potrebbe esistere: la forza

"forte" e quella "debole". La prima è quella che tiene uniti protoni e neutroni (a loro volta

formati da quark) a formare il nucleo dell'atomo. La forza "debole" invece (centomila volte

meno intensa di quella forte), si esercita tra particelle chiamate leptoni (come l'elettrone e il

neutrino), ed è la causa della disintegrazione degli atomi radioattivi e di alcune delle reazioni

nucleari che avvengono all'interno del Sole. Questa disparità di interazioni non esisteva,

secondo gli scienziati, poco dopo il Big Bang, quando l'universo era estremamente caldo e

denso, ma le forze si sono andate via via separando mentre il cosmo si raffreddava e

prendeva le sembianze che oggi conosciamo. A riprova dell'enorme difficoltà di riunire in

un'unica trattazione quello che ci appare diverso nel mondo percepibile, vi è il fatto che

anche il grande Albert Einstein provò, per buona parte della sua vita, a unificare la forza

gravitazionale e quella elettromagnetica senza ottenere alcun risultato. La scoperta dei

bosoni Da allora il più importante successo è consistito nella creazione della "teoria unitaria

delle forze elettromagnetiche e deboli", realizzata da Sheldon Glashow, Steve Weinberg e

Abdus Salam, vincitori del premio Nobel nel 1979. La loro teoria prevedeva l'esistenza di

particelle mediatrici della forza elettrodebole, i bosoni vettori intermedi (le particelle W+, We Z0) che sono stati successivamente scoperti al Cern di Ginevra (il Laboratorio europeo per

la fisica delle particelle, il più prestigioso al mondo), dall'équipe guidata da Carlo Rubbia,

vincitore del premio Nobel nel 1984. Insieme ai bosoni, le altre particelle che mediano

l'azione delle forze (azione che, nella fisica moderna, è sempre vista come uno scambio di

particelle tra i corpi che interagiscono), sono i fotoni per la forza elettromagnetica, i gluoni

per quella forte, e gli ipotetici gravitoni per quella gravitazionale. Il passo successivo è stato

la formulazione delle cosiddette "teorie di grande unificazione", che trattano insieme la forza

forte e la forza elettrodebole, ma non tengono conto dell'interazione gravitazionale. Secondo

queste ultime teorie, nei primi anni di vita dell'Universo sarebbe dovuta esistere una

"superforza" mediata da una superparticella chiamata "X". Un'ipotesi che è impossibile

verificare, allo stato attuale delle conoscenze, come spiega Nicola Cabibbo, fisico teorico e

presidente dell'Enea, l'Ente per le nuove tecnologie, l'energia e l'ambiente. "Risultati recenti

ottenuti con gli esperimenti effettuati nel Lep, la macchina acceleratrice attualmente in

funzione al Cern, hanno permesso di capire che queste ipotetiche particelle sarebbero

estremamente pesanti, circa un milione di miliardi di volte la massa del protone. Per

trovarle, sarebbero necessari acceleratori che arrivano a energie così enormi da essere del

tutto irrealizzabili". Il fatto è che, secondo la famosa formula di Einstein, E=mc2 , che

esprime l'equivalenza di massa ed energia, più elevata è la massa di una particella che si

vuole produrre all'interno di un acceleratore, più elevata deve essere l'energia. Uno scambio

di ruoli Ma non è questo il solo limite delle "teorie di grande unificazione", che sono per il

momento considerate abbastanza insoddisfacenti. Più promettenti sono invece ritenute le

teorie "supersimmetriche" (chiamate "SuSy", da supersymmetry), che riuniscono in una

stessa famiglia i due grandi gruppi di particelle precedentemente considerati diversi fra loro:

i bosoni, cioè i mediatori delle interazioni (fotone, gluone, gravitone, e le particelle W e Z), e

i fermioni, le particelle che compongono l'atomo, come elettroni e quark. Queste particelle

potrebbero trasformarsi le une nelle altre, scambiandosi i ruoli. Ciò implica, per le stesse

complesse simmetrie matematico-fisiche, che ogni particella conosciuta abbia un compagno,

il cosiddetto "partner supersimmetrico", che si chiama squark per il quark, fotino per il

fotone, Wino per il W e così via. Un modo per verificare la validità della costruzione teorica è

dunque quello di "catturare" le particelle supersimmetriche. E i fisici sono sicuri di riuscire a

farlo presto con la nuova macchina acceleratrice Lhc che entrerà in funzione al Cern. "Dal

momento che la loro massa potrebbe non essere troppo alta", conferma Cabibbo,

"dovrebbero essere accessibili ai nostri rivelatori. Individuarle è uno dei grandi temi della

ricerca odierna". La "supergravità" Grazie alla supersimmetria può diventare più facile

trattare anche la forza gravitazionale, che è la più difficile da unificare, e ha sempre dato ai

fisici molti grattacapi. "La forza di gravità ci sembra intensa, ma all'interno dell'atomo è

molto debole, miliardesimi di miliardesimi di miliardesimi di miliardesimi di volte (il numero

preciso è 10 seguito da trentasette zeri) meno forte della forza elettromagnetica e quindi è

irrilevante per le particelle subatomiche", dice Cabibbo. Per arrivare alla possibilità di trattare

l'interazione gravitazionale insieme alle altre una nuova teoria, detta della "supergravità", è

stata formulata nel 1976 dal fisico italiano Sergio Ferrara (che lavora al Cern) insieme a

Daniel Freedman e Peter van Nieuwenhuizen (che hanno insieme vinto nel 1993 il

prestigioso premio Dirac). Si tratta di un ampliamento della teoria della gravitazione (la

relatività generale) di Einstein. Basata sulle teorie supersimmetriche, introduce accanto al

mediatore della forza gravitazionale, il gravitone, il suo partner supersimmetrico, chiamato

gravitino. Commenta Ferrara: "Lo schema teorico porta automaticamente a trattare la

gravità insieme alle altre interazioni, ma ci sono ancora al suo interno molti problemi aperti

che vanno affrontati". Ed ecco che entra in gioco una delle costruzioni matematiche forse più

affascinanti e complesse della fisica contemporanea, la "teoria delle superstringhe", la

migliore candidata, secondo i suoi sostenitori, per arrivare all'unificazione sognata. Spazio a

dieci dimensioni Formulata nel 1984 da Michael Green e John Schwarz (vincitori del premio

Dirac nel 1989), questa teoria suggestiva vale in un mondo molto particolare dove le quattro

dimensioni dello spazio-tempo in cui viviamo (tre per lo spazio e una per il tempo)

diventerebbero addirittura dieci. Inoltre le particelle elementari non sarebbero più

paragonabili a punti ma diventerebbero delle stringhe vibranti come corde musicali. E

sarebbero piccolissime, contenute in uno spazio di molti miliardi di volte più piccolo del

nucleo atomico: tanto più piccole di un atomo di idrogeno, quanto un atomo di idrogeno lo è

rispetto all'intero sistema solare. Ma quando si ritorna a distanze maggiori le stringhe

ridiventerebbero puntiformi e le dimensioni dello spazio tornerebbero a essere quattro. "Si

pensa che le sei dimensioni in più, presenti a distanze così piccole, si "arrotolino" e quindi

scompaiano a mano a mano che si ritorna verso le dimensioni del mondo in cui viviamo",

commenta Ferrara. Tra scienza e fantascienza Fantascienza? Forse, ma l'immaginazione

scientifica dei fisici teorici, nel tentativo di dominare i sottili meccanismi del mondo

subatomico, sembra non avere limiti. Tant'è vero che, da un po' di tempo, si sta facendo

strada un'altra teoria ancora più fantascientifica, chiamata "M", secondo la quale le particelle

non sarebbero simili a stringhe monodimensionali bensì a membrane bidimensionali che

fluttuerebbero in uno spazio a undici dimensioni. Vi stanno lavorando alcuni grandi scienziati,

tra cui lo stesso Ferrara e il famoso fisico Ed Witten dell'Institute for Advanced Study di

Princeton (dove lavorò per molti anni, fino alla fine della vita, lo stesso Einstein). Come si

vede, la strada verso l'unificazione e la comprensione dei mattoni elementari della materia,

nonostante gli sforzi di alcune delle menti più brillanti della fisica teorica, è lastricata di

difficoltà. "Anche se sono stati fatti progressi, c'è ancora molto lavoro da fare", conclude

Cabibbo. "Sarà il principale argomento di ricerca per il prossimo secolo".

Michela Fontana

L'UNO E IL TUTTO

di Mariangela Ferrara del gruppo Mizar

Comprendere i segreti della natura, dell’universo, della coscienza è la mèta che si è posta ogni

serio ricercatore in tutte le epoche storiche, tentando, attraverso studi e analisi sempre più

approfondite, di penetrare i misteri del mondo in cui viviamo, di rendere comprensibili i

fenomeni di cui siamo testimoni, nella speranza di “conoscere il pensiero stesso di Dio”.

Con quest’obiettivo e per questo scopo, Einstein, già famoso per aver pubblicato la teoria

della relatività (1905) dedicò gli ultimi anni della sua vita all’infruttuosa ricerca di una teoria

unificata e completa in grado di dare una spiegazione ad ogni cosa, ma i tempi non erano

ancora maturi, si sapeva ben poco sulle forze nucleari, ed inoltre Einstein si rifiutava, a torto,

poiché smentito dalle successive ac-quisizioni teorico-scientifiche, di credere nella realtà della

meccanica quantistica e nel principio di indeterminazione (Heisenberg, 1927). Celebre, a

questo proposito, è la sua frase “Dio non gioca a dadi con l’universo”.

Ancora oggi relatività generale e meccanica quantistica, pur rappre-sentando i due pilastri

fondamentali della fisica, hanno campi d’indagine differenti.

La relatività generale trova la sua applicazione solo nell’infinitamente grande, la meccanica

quantistica solo nell’infinitamente piccolo. Le due grandi teorie della fisica del XX secolo,

perciò, non possono essere giuste entrambe, sono incompatibili fra loro. Questo significa che ci

rivolgiamo di volta in volta alla relatività generale oppure alla meccanica quantistica.

La speranza resta quella di trovare una teoria unificata, coerente e completa che includa

tutte le teorie parziali che descrivono invece solo un ambito limitato di fenomeni. La difficoltà

principale nel trovare la grande teoria unificata è data dal fatto che la relatività generale è una

teoria classica, ossia non incorpora il principio di indeterminazione, tuttavia sembra che tale

principio costituisca un tratto fondamentale dell’universo in cui viviamo; una teoria unificata,

per poter raggiungere il proprio obiettivo, deve quindi necessariamente incorporare questo

principio.

Il grande astrofisico S. Hawking, nel suo libro “La teoria del tutto” sostiene che “un primo

passo da compiere nella ricerca è quello di combinare la relatività generale con il principio di

indeterminazione, ciò può portare a conseguenze notevoli come l’idea che i buchi neri non

siano così neri, che l’universo sia racchiuso in se stesso e privo di confine, che lo spazio vuoto

sia in realtà pieno di particelle e antiparticelle virtuali”.

La teoria unificata che la fisica cerca, tenta di riunire le grandi forze della natura per arrivare

a comprendere la meraviglia del creato e la semplicità delle leggi su cui è fondato, per svelare

il funzionamento dell’universo e per poterlo contemplare attoniti in tutta la

sua bellezza ed eleganza.

Anche l’uomo fa parte di questo scenario, egli non è solo spettatore

passivo di un meccanismo che sta al di fuori di lui. Egli fa parte

integrante del tutto, forse non è soltanto mèro osservatore degli eventi

e della realtà del cosmo.

La visione meccanicistica dell’universo è stata profondamente minata

proprio dal principio di indeterminazione che, secondo l’interpretazione

di alcuni ricercatori, dimostrerebbe che l’osser-vatore condiziona

l’osservato ponendo l’uomo e più precisamente la coscienza dell’uomo

stesso in una posizione interattiva rispetto al tutto.

La ricerca della “grande teoria unificata” mira alla descrizione di tutte e quattro le forze

fondamentali (nucleare forte, nucleare debole, elettromagnetica e gravitazionale) e di tutta la

materia nell’ambito di un unico quadro concettuale onnicomprensivo, attraverso formule ed

equazioni sempre più complesse, ma può tenere anche conto di ciò che è definito “principio

antropico” enunciato per la prima volta negli anni '50 da R.H. Dicke ed elaborato nel 1986 da

J.D. Barrow e da F.J. Tipler e, secondo il quale “la spiegazione del perché l’universo ha le

proprietà che osserviamo sta nel fatto che, qualora queste proprietà fossero differenti, è

probabile che la vita non sarebbe emersa e, di conseguenza, noi esseri umani non saremmo

qui ad osservare tali differenze. La peculiarità che contraddistingue la combinazione di forze e

particelle del nostro universo è quella di permettere il formarsi della vita. L’esistenza della vita,

della vita intelligente in particolare, è un presupposto necessario per potersi domandare perché

il nostro universo ha le proprietà che ha”. In altre parole le cose nel nostro universo sono come

sono perché se fossero diverse noi non saremmo qui ad osservarle. L’essere umano è parte

della natura, della terra, dell’universo e come tale rispetta i ritmi biologici e cosmologici propri

del suo ambiente. Egli partecipa anche alle misteriose sincronie della natura: nel cervello

milioni di neuroni agiscono in modo coordinato per regolare il respiro, mentre un metronomo

naturale dà il ritmo al cuore; il corpo umano è come un’orchestra i cui musicisti sono le singole

cellule che seguono il ritmo regolato dal loro DNA. Non soltanto nel corpo umano ma in tutti i

fenomeni naturali le sincronie sembrano avere un regista o un coreografo. Sono significativi in

tal senso i comportamenti di alcune specie di piante o di animali, eccone alcuni esempi: in

Cina, dopo mezzo secolo di fioriture casuali, i bambù di una stessa specie fioriscono tutti nello

stesso periodo, le farfalle monarca ogni anno partono in massa dal Canada dirette al Nuovo

Messico, i polipi della barriera corallina australiana in una notte di luna piena di agosto su un

fronte di duemila chilometri liberano simul-taneamente una nuvola di miliardi di uova.

Per non parlare delle straordinarie coreografie di nuoto sincronizzato di alcuni pesci che si

dispongono in banchi dalle forme più bizzarre, o delle formazioni complesse che assumono gli

stormi mostrando la capacità di volare e di muoversi all’unisono coordinati da un regista

invisibile.

Anche gli elettroni in un superconduttore si muovono in sincronia, permettendo all’elettricità

di fluire senza incontrare resistenza. Sembra esserci un impercettibile legame che unisce tutte

le sincronie esistenti. “Molti organismi si comportano come oscillatori accoppiati cioè sistemi

composti da molti elementi legati da una grandezza il cui valore in una unità del sistema

influenzerebbe tutte le altre.”

Il matematico Steven Strogatz, docente di matematica applicata alla Cornel University e al

Massachussetts Insitute of Tecnology, dopo venti anni di studi, sostiene questa tesi; i risultati

ottenuti dimostrano perciò che l’uno, non solo è parte del tutto ma ne condiziona il

funzionamento globale in un interscambio di informazioni dando luogo alle manifestazioni

osservabili. Il matematico si spinge ad affermare, altresì, che alcuni comportamenti umani

stranamente ritmici potrebbero essere spiegati dallo studio e dall’applicazione di questa nuova

disciplina divenuta nota con il nome di “ scienza dell’ordine

spontaneo”.

Le mode o i movimenti di pensiero sarebbero guidati dalle stesse

leggi che regolano alcune sincronie naturali.Si Potrebbe anche

azzardare l’ipotesi, quindi, che il sorgere repentino e quasi

contemporaneo di varie culture storiche o di molteplici abilità umane,

i tratti culturali e religiosi comuni alle civiltà superiori dell’antichità,

potreb-bero scaturire dalle connessioni individuate

dall’interpretazione della “scienza dell’ordine spontaneo”.

Alla luce di questa nuova chiave di lettura degli eventi della natura,

si può tentare di estendere il concetto dell’unione e dell’interazione della parte con il tutto

anche a livelli più profondi. Non solo la materia, sia organica che inorganica, risponde-rebbe

alle sincronie naturali, ma anche l’inconscio e di conseguenza il pensiero, la mente e taluni

comporta-menti, sarebbero soggetti a tale osmosi, creando incredibili sinergie.

Gli esseri umani sarebbero liberi nelle loro scelte ma collegati gli uni agli altri molto più di

quanto si creda, impegnati nella danza individuale della vita ma ignari delle invisibili sincronie.

Sapendo che la coscienza emerge proprio a causa delle complesse connessioni neurali che

hanno sede nella corteccia cerebrale,si potrebbe stabilire un’analogia e giungere ad identificare

l’universo con un grande organismo vivo e pulsante, un corpo fisico, ma anche una metamente di cui le capacità cerebrali rappresente-rebbero i neuroni.

Infatti, come in un corpo ogni cellula contribuisce e partecipa al funzio-namento

dell’organismo, così, sia nell’universo (infinitamente grande) che nell’atomo (infinitamente

piccolo), ogni parte interagisce con il tutto. Purtroppo, tranne le incoraggianti previsioni fornite

dalla teoria delle Superstringhe, secondo la quale la trama microscopica dell’universo è un

intricato labirinto a più dimensioni in cui stringhe unidimensionali vibrano senza posa dando il

ritmo alle leggi naturali, a causa dell’assenza di una teoria unificata, non possediamo ancora le

equazioni adeguate e compatibili per entrambe le realtà. Forse, però, se ci si spingesse a

considerare il Cosmo non solo come materia ma anche come spirito,inteso come essenza

nascosta delle cose,soffio animatore del reale e insieme delle attività mentali, tenendo

presente che gli elementi atomici si comportano sia come particelle sia come onde, si

giustificherebbero anche le fluttuazioni quantistiche, le onde di probabilità e l’indeterminismo

tipico dell’infini-tamente piccolo, poiché, così come la materia a grande scala risponde a leggi

fisiche definite e prevedibili, la psiche presenta invece caratteristiche inde-finite ed

imprevedibili.

In quest’ottica la ricerca della grande teoria unificata, riservata allo specifico campo della

fisica, potrebbe essere ampliata ad ulteriori territori d’inda-gine e curare l’aspetto interdisciplinare, ponendo l’attenzione anche alla biologia, all’etologia, alla neurofisiologia, alla

psicologia etc.

La scienza dell’ordine spontaneo ci ha suggerito un nuovo percorso da seguire ed un nuovo

approccio alla spiegazione degli eventi della natura, attraverso l’attendibile ipotesi di

correlazioni e collegamenti non solo fisici ma anche psichici.

Il principio di indeterminazione ci ha fornito un indizio facendoci com-prendere che non

esistono proprietà dell’universo a livello microscopico che si possono determinare con

precisione e che l’osservatore interagisce con l’osservato.

Sulla base di tali presupposti che rappresentano le ultime frontiere della ricerca scientifica, si

può dedurre che l’uomo è una parte del tutto al quale partecipa e, come tale, quindi,

probabilmente influenza le interazioni tra le particelle elementari, gli scambi molecolari e

cellulari, l’inconscio collettivo, già ipotizzato da Jung.

Per ora, nell’attesa di nuovi risultati sperimentali e di un più completo quadro teorico,

possiamo solo accontentarci della certezza che nell’unico universo che osserviamo, tentiamo di

comprendere e nel quale ci è consentito di vivere, determiniamo, attraverso le scelte che

operiamo, il nostro destino e la nostra storia.

Bibliografia:

La teoria del tutto, Origine e destino dell’universo di S. Hawking, Rizzoli

Sincronia di S. Strogatz, Rizzoli

All'inizio d'un mondo-nuovo

Una novella ateologico-scientifica intorno alla Teoria delle

Superstringhe

Domandarono a Dio se già avesse concepito il mondo e, se sì, in qual modo l'avrebbe creato.

Dio disse di aver pensato a tutti i modi possibili per dar origine alle cose, agli animali e agli uomini pensanti.

Ma le aveva scartate tutte. Infatti il modo di creare le pietre, le piante e gli animali poteva anche essere

pensato e generato, ma per quanto riguardava gli uomini, in particolare per quel loro pensiero non c'era

nulla da fare. Occorreva un inizio speciale che prendesse insieme il tutto, che oltrepassasse le cose, le piante,

gli animali, poi ancora oltre, un tutto differente e nuovo, che forse non avrebbe mai potuto esistere. A meno

che ... Ci pensò e ripensò, più e più volte, standosene fuori del tempo; gli capitò persino d'entrarci nel

mezzo. Ma ne era dovuto uscire in tutta fretta con uno sforzo non da poco, per non rimanerne impigliato e

vivo d'una vita non ancora possibile e vera. Non ne poteva proprio più. Come escogitare un'energia che

desse conto d'un'attività - quella del pensare - che nulla aveva a che fare con quella del cosmo costituito da

miliardi di anni di sola materia, energia non consapevole? Come dar conto di qualcosa di assolutamente

differente da ciò che già si vede, che appare consolidato lì fuori, che i sensi così facilmente recepiscono?

Come pensare a qualcosa che assomigliasse a quel suo pensiero e che persino lo trascendesse? .. Come

precedere se medesimo? Si fermò di colpo. Ma sì: ecco lo spiraglio!

Come precedere il mio stesso pensare? Come pensare qualcosa che mi antecede?

Come concepire un universo che manca persino di questo mio fondamentale credere che qualcosa sia posto

lì fuori ed esso sia vero ed io con esso, oppure il contrario?

Come inventare un tempo che s'inveri antecedendo se stesso insieme con colui che lo ha inventato?

Aveva trovato qualcosa da cui avrebbe potuto anche procedere. Che cosa? S'interrogava. Ma non riusciva

ancora a progettare un alcunché. Ci pensò ancora una volta e poi per milioni e milioni di anni, in un tempo

nuovo che tuttavia ancora non era stato generato in modo evidente e consapevole.

Non veniva però per nulla a capo dell'idea appena abbozzata: non riusciva a trattenerla, ad elaborarla,

renderla reale. Qualcosa che anteceda. Che sia oltre me. Al di là di Dio. Che cosa? Qualcosa che non c'è. Ma

sì ... ecco qualcosa che non c'è!

Qualcosa che manca. Ma allora anch'io non sono quel che sono e quel che penso. Nulla è così com'è. Non

esiste neppure la cosa cui credere, quell'idea che desidero emanare: nulla m'impersona.

Si fermò di botto: tutto l'universo che aveva immaginato e che ancora non era, anch'esso si era fermato di

colpo in un punto, con l'aprirsi d'un varco. Una mancanza. La mancanza di Dio. La mancanza dell'Essere. Il

venir meno del Creatore. Una vibrazione che, invece che uscire da qualcuno o da qualcosa, rientrasse. Ma in

che cosa sarebbe rientrata? "In niente", fu la risposta che subito ritornò su se stessa, ricollocandosi in una

nuova più feconda disposizione senza sollecitare alcun'altra soluzione.

Una potentissima vibrazione di nulla. Un fortissimo richiamo al mancare. Un'eco profondissima di ritorno

incominciò ad emergere. Un suono al negativo; un'assenza immane, un nulla che ondeggiava, una mancanza

che si mostrava ... Dio era scomparso. In sua vece una vibrazione che non ne occupava né il posto né la

maestà. Un silenzio che subentrava a se stesso. Un segno, un suono, un andirivieni di luci e assenze che

transitavano sotto la pelle del mondo giammai creato. Era la vibrazione del niente. Un'antivibrazione, come fu

chiamata dopo un tempo che era trascorso quasi all'infinito. Di più: un'antiantivibrazione come un suono che

suona all'inverso costituendo una soglia sottostante al piano dell'ascolto consueto. Si fanno simultaneamente

evidenti pacchetti d'una luce speciale che subito si dissolvono privati della loro medesima primigenia

illuminazione: ma questa già è incrementata all'infinito d'un mancare nel mezzo similmente a una vibrazione

che cessa, s'investe di nulla e si situa oscillando al-negativo.

Da quel momento le creature, a poco a poco, nel giro di milioni e milioni di anni, si videro crescere,

evolvere e uscire dalle antiche tane, dalle loro inveterate abitudini, e incominciare a pensare un pensiero

sottile, come se da un cervello, da una formidabile neocorteccia s'iniziasse ad emanare la descrizione chiara e

l'esistenza - per un lato evidenti e nouminose, ma per un altro in gran parte ancora oscure - d'un universo

assai complesso che andava ricercando in ogni sua piega e ad ogni istante quella pulsazione di nulla assente, il

solco d'una scintilla che in parte - o forse del tutto - esso aveva perduto, avendola tralasciata fin dal suo

principiare; oppure - è un'ipotesi recente - si trattava d'un pensiero, un'entità davvero pregevole, una

condizione dell'esistente che ancora non sapeva - o forse non voleva - né pensare né accettare nel profondo

del cuore ed entro le cavità abissali del suo capo un universo già pronto a fare a meno di sé e di chi l'aveva

creato.

Le corde di Witten

Nel 1984 Edward Witten concepì una nuova teoria fisica il cui principio risiede nel concetto di "corda".

Secondo questa teoria la "materia" sarebbe costituita da un insieme di vibrazioni presenti nella parte

più intima della struttura atomica .

Se fosse possibile osservare le particelle elementari, come elettroni e quark, con un ingrandimento

centomila miliardi di volte maggiore di quello che è consentito dalle attuali tecnologie, ci accorgeremmo

che queste non si presentano come palline ma come linee o anelli sottilissimi o, appunto, come corde

vibranti; per avere un'idea delle loro dimensioni basti pensare che un atomo, paragonato a una di

queste corde, sarebbe grande quanto un sistema stellare!

In questa teoria le caratteristiche delle particelle, compresi gravitoni, fotoni, bosoni e gluoni sarebbero

l'effetto del modo con il quale queste minuscole stringhe possono vibrare, proprio come vibrano le corde

di uno strumento musicale. Ciò che le vibrazioni producono, però, non sono note musicali, bensì

particelle distinte a seconda delle frequenze di vibrazione. Le interazioni tra le varie particelle si

presentano così come una sorta di fusione e scissione di corde.

I ricercatori hanno costruito ben cinque diverse teorie sulle superstringhe che dovrebbero essere forme

diverse di un'unica legge in grado di riassumerle tutte, una legge che dovrebbe essere formulata in dieci

dimensioni spaziali e una temporale e che dovrebbe essere in grado di unificare la teoria della relatività

generale e quella quantistica.

Non sappiamo se questa complicata teoria potrà mai essere espressa da formule matematiche, ma

l'intuizione appare straordinaria per procedere nella ricerca della struttura del cosmo.

Fisica e Macrocosmo: Cosmologia

[1]

La cosmologia moderna nasce negli anni ’20 del secolo scorso come una delle prime

applicazioni della Relatività Generale per lo studio delle proprietà del cosmo su larga

scala. [2] Se l’astrofisica tradizionale studiava oggetti celesti singoli (e.g. stelle) o

aggregati di tali oggetti su piccola scala (e.g., ammassi stellari, galassie), che

caratterizzano solo le proprietà locali del cosmo, con una strumentazione più

sofisticata è stato possibile sondare distanze più profonde, e quindi scale più estese

I numeri entro parentesi quadre [#] fanno riferimento alle diapositive del file [nome].ppt della

Lezione II.

[3]. Più in generale, volendo descrivere le proprietà globali del cosmo, volendone dare

cioè una descrizione in toto, indicheremo col termine “universo” il primo oggetto di

indagine della cosmologia. Non potendo ricevere segnali da distanze maggiori di c x

[età dell’universo], le proprietà globali si configureranno al più come proprietà medie

della regione di universo visibile. Tali proprietà medie, oltre a rivestire un interesse

scientifico intrinseco, definiscono la cornice in cui inquadrare lo studio della

formazione e dell’evoluzione degli oggetti su scale più piccole, cioè stelle e galassie. In

definitiva, l’oggetto di indagine della cosmologia sono gli ammassi di galassie, i

superammassi di galassie, le strutture su larga scala, fino alla caratterizzazione delle

proprietà medie dell’universo visibile [4].

Principio Cosmologico. Nel linguaggio della Relatività Generale, il primo obiettivo

della cosmologia si traduce nella descrizione della geometria dello spazio-tempo su

larga scala, o meglio nella descrizione della geometria media dell’universo visibile.

[5] [isotropia] Nel 1969 Arno Penzias e Robert Wilson scoprono una radiazione

isotropa di fondo, cioè proveniente da tutte le direzioni con la stessa intensità e non

riconducibile ad alcun fenomeno astrofisico peculiare (i.e., emissione da un oggetto)

ma caratterizzante l’aspetto dell’universo su larga scala, cioè su distanze profonde

(“cosmologiche”), e quindi nelle sue prime fasi di vita. Essendo concentrata nella banda

delle microonde, la si chiama Cosmic Microwave Background (CMB). Lo spettro è quello

che tecnicamente si dice “di corpo nero”, un corpo caldo in equilibrio termodinamico

che emette radiazione elettromagnetica in tutte le direzioni indistintamente.

Lo spettro che si presenta all’antenna di Penzias e Wilson descrive il miglior corpo

nero che sia mai stato osservato in natura, e ciò significa: la radiazione di origine

cosmologica descrive un sistema, l’universo, in eccezionale equilibrio termodinamico al

momento dell’emissione di quella radiazione e straordinariamente isotropo. In altri

termini la geometria su larga scala, cioè la geometria media dell’universo, è

caratterizzata da un elevato grado di isotropia.

[6] [omogeneità] Muoviamo ora da una “dichiarazione di umiltà”, recuperando il

principio copernicano: non c’è ragione di di pensare che noi (= la nostra galassia)

occupiamo una posizione privilegiata. Più in generale, ogni punto è geometricamente

equivalente (questa la definizione di ‘omogeneità’). Meglio ancora: tutti gli osservatori

- definiti come quelli che esperimentano il moto “medio” di espansione osservato da

Hubble a parte il proprio moto peculiare - sono equivalenti. Quindi tutti osserveranno

lo stesso spettro della radiazione di fondo a microonde, cioè tutti osserveranno

l’isotropia su larga scala. Quindi tutte le singole posizioni sono, su larga scala,

equivalenti. In altri termini la geometria media dell’universo è caratterizzata da

omogeneità. Le osservazioni confermano questa conclusione: vedi e.g. catalogo Lick e

APM survey (ottico), Texas survey (radio).

[7] Siamo così giunti al Principio Cosmologico: su larga scala l’universo è omogeneo e

isotropo. Esso definisce la geometria media dell’universo visibile, o, rozzamente, la sua

“forma” media. Un teorema di geometria differenziale garantisce poi che uno spazio

omogeneo e isotropo possa essere descritto da tre sole geometrie (tre “forme”),

discriminate dal parametro di curvatura (k); sono quelle che in uno spazio 2D

descriverebbero la superficie si una sfera, di un piano o di un paraboloide iperbolico

(la “sella”). Si parla allora di universo chiuso (k > 0), aperto (k < 0) o piatto (k = 0).

[dinamica] Si dimostra inoltre che la “forma” deve mantenersi sempre uguale a se

stessa; e’ ragionevole però chiedersi se sia ammessa una dinamica, in altri termini se le

distanze tra gli oggetti distribuiti su larga scala debbano restare fisse o possano

variare nel tempo (un’immagine infantile che può aiutare: un pallone resta sempre

sferico se lo si gonfia). [8] Come già accennato, attraverso misure di magnitudine

apparente e redshift, nel 1929 Edwin Hubble rileva un allontanamento delle galassie

più distanti, secondo una legge di proporzionalità tra velocità di allontanamento e

distanza dell’oggetto osservato. Data la provenienza del segnale dalle distanze più

profonde, interpreta i suoi risultati come evidenza dell’espansione dell’universo: è

messa in luce la natura dinamica della geometria dello spazio-tempo su larga scala.

Il progresso tecnologico ha permesso di constatare che la legge di Hubble e’ di fatto

una legge approssimata: potendo osservare oggetti di cui sia nota la luminosità

intrinseca a distanze più profonde (nella fattispecie, supernovae di tipo IA), si

riscontra una legge quadratica, deviazione dalla legge lineare trovata da Hubble. Se

quest’ultima descrive un universo oggi in espansione (con velocità per unità di

lunghezza data da H0), la legge quadratica aggiunge l’informazione che tale espansione

è oggi accelerata (con “accelerazione”–q0). È una prova, questa, di come il miglioramento della sensibilità e risoluzione degli strumenti abbia mostrato una natura più

ricca e complessa dell’oggetto di studio.

[9] Relatività Generale. Il sistema che vogliamo descrivere, l’universo, e’ dominato dalle

interazioni gravitazionali: sulle scale in gioco (distanze > 1Mpc) le interazioni deboli e forti non

giocano ovviamente alcun ruolo, quelle elettromagnetiche possono avere degli effetti ma

assolutamente marginali in prima approssimazione. La teoria della gravitazione più completa a

disposizione è la teoria della Relatività Generale: essa dovrà rendere conto della geometria dello

spazio e della sua dinamica nel tempo compatibilmente con le grandezze osservabili. Nella

fattispecie, dovrà fornire delle equazioni che mettano in relazione le proprietà dello spazio-tempo

sulle distanze cosmologiche a valori medi di grandezze osservabili.

Le osservazioni di Hubble sono state cronologicamente la prima spinta all’interesse

per la cosmologia, che all’inizio era semplicemente oggetto di speculazioni matematiche come applicazione della teoria della Relatività Generale. Il modo di procedere di

quella fase è tipico della ricerca in fisica teorica, merita un’occhiata!

L’idea fondamentale della Relatività Generale è descritta da equazioni (“equazioni di

Einstein”) che mettono in relazione le proprietà geometriche dello spazio-tempo alla

distribuzione di materia-energia, determinandone così l’evoluzione in modo reciproco.

Sono costruite in modo da restituire la legge di gravitazione di Newton, le cui

predizioni sono eccezionalmente corrette sulle distanze del sistema solare; come

novità, soffrono di patologie predicendo l’esistenza di regioni singolari con densità di

energia infinita (buchi neri e big bang), e prevedono fenomeni astrofisici non possibili

nella vecchia teoria newtoniana (lenti gravitazionali e onde gravitazionali). - vedi

Lezione 3 @ Macrocosmo.

[simmetrie] Come tutte le equazioni, anche quelle di Einstein si semplificano

notevolmente (e magari si possono addirittura risolvere!) se si fa qualche ipotesi

opportuna e diventano più facilmente interpretabili da un punto di vista fisico. In

termini più corretti, si semplificano se si assume qualche simmetria (così come, ad

esempio, il moto lungo un cerchio è più semplice da descrivere di un moto caotico).

Consideriamo in particolare la cosmologia d’inizio ‘900: mossi soprattutto da un

interesse matematico per le soluzioni delle equazioni di Einstein, anche se debolmente

garantiti dall’evidenza osservativa, possiamo valutare come si presentano le equazioni

di Einstein facendo l’ipotesi che lo spazio-tempo da queste descritto sia invariante

sotto la simmetria per traslazioni, cioè omogeneo, o invariante sotto la simmetria per

rotazioni, cioè isotropo, o omogeneo e isotropo, o altro. In questo modo sono stati

studiati numerosi modelli e per ciascuno di essi sono state calcolate le conseguenti

proprietà fisiche osservabili (ed es. numero di oggetti per unità di volume).

Torniamo a oggi. La simmetria per rotazioni e la simmetria per traslazioni, cioè isotropia e

omogeneità, ora hanno dignità fisica sulle scale cosmologiche perché provate da osservazioni, tanto

da aver meritato l’appellativo di Principio Cosmologico. Di conseguenza le equazioni di Einstein si

semplificano lecitamente in una forma più leggibile: resta così definito il “Modello Cosmologico

Standard”, il punto di partenza per costruire dei modelli ragionevoli del cosmo su larga scala.

[10] Equazioni di Friedmann. Le equazioni di Einstein scritte sulla base del

Principio Cosmologico furono formulate da Friedmann nel 1922. Esse descrivono (il

quadrato della) velocità – H nelle equazioni- e accelerazione dell’universo, riconducibili

alle grandezze osservabili magnitudine e redshift, come effetto della densità media

di energia e della pressione media di tutte le sue componenti: radiazione, materia

barionica (protoni, neutroni, atomi di idrogeno, ecc.; MACHO), materia non barionica

(materia oscura: vedi Lezione 3 @ Macrocosmo), neutrini, ecc. Matematicamente sono

delle equazioni differenziali, cioè equazioni la cui soluzione è una funzione: con la

geometria in gioco la soluzione è il “fattore di scala” a(t), che definisce le distanze

degli oggetti da noi come da qualunque altro osservatore (per il principio copernicano!),

dunque l’estensione delle strutture sulle scale cosmologiche e quindi, rozzamente, il

“raggio” dell’universo visibile. Fissati i parametri cosmologici e H a un dato istante, il

fattore di scala a(t) assume una forma ben definita come funzione del tempo t (un

esempio: per il “modello Standard Cold Dark Matter”, SCDM, in grado di spiegare le

osservazioni compiute fino ad una decina di anni fa nell’ipotesi di universo piatto, si

ricava a(t) = [costante] t2/3). Tutte le grandezze osservabili che descrivono la

cinematica e la dinamica dell’universo sono funzioni del fattore di scala, o

equivalentemente (composizione di funzioni!) del redshift z:* risulta infatti (1 + z) =

1/a – relazione che permette un diretto legame tra una grandezza osservabile, la

lunghezza d’onda, e la grandezza caratterizzante la geometria dello spazio-tempo.

Secondo la relazione 1/a = (1+z) resta fissata allora la dipendenza spazio-temporale

delle grandezze osservabili: ad esempio tempo e redshift, t=t(z), densità di energia

media e il redshift, =(z), temperatura media e reshift, T = T(z), numero di oggetti e

redshift, N = N(z). Dalla misura un osservabile e del corrispondente redshift si

possono inferire i valori dei parametri cosmologici coinvolti: in questo modo si testa il

modello confrondandone le previsioni con previsioni di altra natura. Un esempio: il

modello SCDM prevede che l’età dell’universo sia inferiore a quella degli oggetti più

vecchi in esso contenuti, gli ammassi globulari - stimata per altra via - il che è

evidentemente assurdo. Un modello più corretto dovrà ovviare a questo difetto.

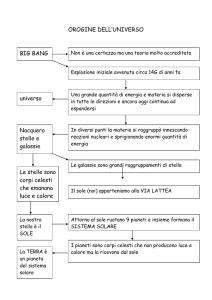

Quali le principali conseguenze delle soluzioni delle equazioni di Friedmann? [11]

1. Big Bang. Matematicamente le equazioni differenziali richiedono che siano

definite delle condizioni iniziali, cioè che il valore iniziale della funzione incognita

(e delle sue derivate…) sia preassegnato. Nel caso delle equazioni di Friedmann, per

convenienza, cioè per riuscire a risolverle, si usa porre a(0) = 0: significa dire che

all’istante iniziale t = 0 il “raggio dell’universo” è nullo. Ciò sembra dire che

procedendo all’indietro nel tempo tutta la materia-energia fosse concentrata in un

punto geometrico e che ad un certo istante (t = 0) il tutto ha cominciato a

prendere forma: il Big Bang. Ovviamente questa è un’approssimazione di comodo,

utile solo a poter definire una soluzione, cioè un modello, la cui validità va limitata a

descrivere il comportamento dell’universo a tempi successivi (t > 0) e dunque su

regioni spazialmente estese, cioè di interesse fisico e non geometrico (il punto

geometrico è fisicamente irrilevante). Il Big Bang è dunque solo l’effetto

dell’estrapolazione di un risultato della relatività generale in situazioni dove questa

teoria non è più valida. Einstein stesso scrisse: “La teoria è basata sulla

separazione dei concetti di campo gravitazionale e materia. Nonostante questa

possa essere una valida approssimazione per campi deboli, può presumibilmente

essere abbastanza inadeguata per densità di materia molto alte. Non si può

pertanto assumere la validità delle equazioni per densità di energia molto alte ed è

solo possibile che in una teoria unificata non ci debbano essere tali singolarità”

*

Il redshift è definito dal rapporto (oss - em) /em , dove è oss la lunghezza d’onda della

radiazione elettromagnetica emessa dalla sorgente luminosa misurata dall’osservatore (noi) e em quella

misurata nel sistema di riferimento solidale con la sorgente, in moto rispetto all’osservatore. Data la

natura relativistica del segnale (fotoni!), l’effetto doppler così manifestato non distingue tra moto

dell’osservatore o della sorgente: è rilevante solo il moto relativo dei due.

[“The Principle of Relatività”, Methuen, London, 1950]. In tali regimi la fisica

teorica moderna usa appellarsi alla Gravità Quantistica o alla Teoria delle

Superstringhe, tanto lontane da una formulazione definitiva quanto

matematicamente stimolanti (e ricordiamo che interessi esclusivamente

matematici stimolarono le prime soluzioni delle equazioni di Einstein!).

2.

Geometria 3D. Come visto prima, solo tre geometrie sono compatibili con uno

spazio omogeneo e isotropo. Per ciascuna di esse sono univocamente definiti

lunghezza di un segmento e angolo tra due rette in termini del fattore di scala

a(t); l’estensione di un oggetto, ad es. un ammasso di galassie, o l’angolo sotteso da

due oggetti, ad es. individuato dalla traiettoria della luce emessa da due quasar

distanti, dipende dalla geometria media e quindi, attraverso le equazioni di

Friedmann, dalla distribuzione di energia media dell’universo, cioè dai parametri

cosmologici. La corrispondenza biunivoca tra geometria dell’universo e contenuto di

materia-energia è manifesta riscrivendo le equazioni di Friedmann in termini della

densità critica cr, definita come valore della densità in corrispondenza del quale

la geometria spaziale è piatta (k = 0), cioè quella euclidea. Scrivendo = cr, la

prima equazione di Friedmann diventa

1 = - kc2 / (H2 a2):

risulta allora k = 0 se e solo se = 1, k = +1 se e solo e > 0 e k = -1 se e solo se

< 0.

Osservazione: da questa equazione che si deduce che il segno di k resta costante

nel tempo.

3. CMB. [12] Si è già parlato della radiazione cosmica di fondo (CMB) interessati

alle informazioni sulla geometria che da essa si possono dedurre. Consideriamo ora

la sua origine fisica un po’ più in dettaglio, alla luce della storia termica

dell’universo. Si può immaginare che nei primi istanti di vita l’universo fosse

costituito da una miscela di materia (protoni, elettroni, ecc.) e radiazione

elettromagnetica in equilibrio termodinamico sotto forma di “plasma” – uno stato

che sappiamo ben descrivere con le leggi dell’elettromagnetismo e della

fluidodinamica. Come osservato da Hubble nel 1929, l’universo è in espansione; per

effetto dell’espansio-ne ad un certo istante la radiazione elettromagnetica e la

materia non interagisco-no più come durante l’iniziale fase di plasma

(tecnicamente, si disaccoppiano). Quella radiazione, a questo punto libera di

propagarsi, da allora giunge alle nostre antenne praticamente senza più interagire

con la materia, mantenendo l’impronta delle condizioni di equilibrio in cui si trovava

l’universo nell’istante in cui si è disaccoppiata: deve essere caratterizzata cioè da

uno spettro di corpo nero corrispondente alla temperatura di disaccoppiamento (~

3000 K). Le equazioni di Friedmann devono predevere come il valore di quella

temperatura varia con il redshift, come effetto dell’espansione adiabatica

dell’universo: il valore predetto per z = 0, cioè misurato oggi, è proprio quello

osservato, 2.728 ± 0.002K!

Verso la complessità. Sulla base dei grafici z e z-T, è possibile distinguere

delle fasi nella storia evolutiva dell’universo. Una di particolare interesse l’abbiamo

appena reincontrata, riguarda l’”istante” dell’emissione della radiazione cosmica di

fondo a microonde; l’elevato grado di isotropia di questa radiazione si è dimostrato di

fondamentale importanza per la geometria su larga scala. Ma la radiazione del CMB è

realmente isotropa? Eventuali anisotropie cosa segnalerebbero? Consideriamo due

aspetti di rilievo in cosmologia: lo studio delle anisotropie della radiazione cosmica di

fondo (1) quale attuale strumento per la misura ad elevata precisione di alcuni

parametri cosmologici e (2) in quanto punto di partenza del processo fisico che domina

almeno il 90% del tempo di vita dell’universo, la formazione e l’evoluzione delle

strutture cosmiche, da galassie ad ammassi e superammassi di galassie fino alle

strutture su larga scala.

[12] Anisotropie del CMB. [anisotropia di dipolo] Una differenza di temperatura dal

valor medio di una parte su mille è rilevata in due regioni opposte sulla sfera celeste,

vale a dire separate da un angolo di 180°. Non è di origine cosmologica, ma va imputata

all’effetto Doppler dovuto al moto peculiare della nostra galassia: la radiazione

cosmica di fondo proveniente dalla regione verso cui ci muoviamo (il Grande

Attrattore) appare “più blu”, quella proveniente dalla regione da cui ci allontaniamo

appare viceversa “più rossa”, come se l’universo fosse più caldo in una direzione e meno

in quella opposta. Un “osservatore cosmologico” a riposo sarebbe quello che non

osserva tale anisotropia.

[anisotropie d’ordine superiore] Lo strumento DMR, montato sul satellite COBE che

per la prima volta rileva lo spettro di corpo nero della radiazione cosmica di fondo con

eccezionale precisione, misura delle differenze di temperatura dal valore medio pari

ad una parte su 105. Tali deviazioni dall’isotropia risultavano su una scala angolare di

circa 7°, limite dovuto al potere risolutivo dello strumento: ciò lascia intendere che

strumenti sensibili a scale angolari inferiori possano scoprire un aspetto ancora più

articolato. Il più recente risultato in questa direzione è stato raggiunto dal satellite

WMAP, che ha ottenuto delle immagini straordinariamente dettagliate; immagini ancor

più dettagliate saranno ottenute dal satellite PLANCK, il cui lancio è programmato per

il 2007. Molte delle informazioni codificate nelle anisotropie di temperatura su

piccola scala sono di origine cosmologica, ad esempio la curvatura media dell’universo e

i parametri di densità di materia oscura e materia barionica. Questo segnale se ne

sovrappongono altri di origine non cosmologica, ad esempio dovuti all’emissione di

galassie vicine o della polvere del mezzo intergalattico: lo spettro complessivo è uno

strumento per studiare anche questi processi astrofisici.

[12] [missione Boomerang] Dati eccezionalmente precisi sulle anisotropie della

radiazione cosmica di fondo sono stati ottenuti dalla missione Boomerang, un

telescopio montato su un pallone aerostatico fatto volare al Polo Sud nel 1998. Il

telescopio ha osservato solo una regione di cielo, ciononostante le informazioni

dedotte sono state molto accurate. Il risultato più rilevante è stato la misura della

curvatura dell’universo inferita dalla separazione angolare media dei picchi di intensità

corrispondenti alle regioni più calde (10K oltre la temperatura media di 2.7K). Con

un errore sperimentale di circa il 5% quei dati risultano compatibili con un modello di

universo piatto, la geometria spaziale media è cioè quella euclidea. Questo effetto è in

totale accordo con l’ipotesi dell’inflazione primordiale, una fase di espansione

accelerata in cui sarebbe incorso l’universo nei primi istanti di vita, teorizzata per

risolvere alcuni problemi del Modello Cosmologico Standard.

[14] Formazione delle strutture cosmiche: ammassi di galassie, superammassi di

galassie, strutture su larga scala. Dopo l’oscura e affascinante fase iniziale dominio

della Gravità Quantistica, e la successiva inflazione, raffreddandosi l’universo si

assesta in uno stato più familiare, nel quale dominano le interazioni forti, deboli ed

elettromagnetiche descritte dal Modello Standard delle Particelle Elementari. Si

formano prima i quark, che condensano poi in adroni (essenzialmente protoni e

neutroni), che a loro volta si fondono in nuclei di atomi leggeri (nucleosintesi

primordiale). Sulla base della consolidata teoria che descrive questi processi, è

possibile predire l’abbondanza degli elementi leggeri così formati: misure su scale

cosmologiche delle abbondanze di idrogeno, elio, litio, ecc., neutri e ionizzati, sono in

accordo con le stime teoriche, confermando la previsione del raffreddamento

dell’universo in virtù della sua espansione così come descritta dal Modello Cosmologico

Standard.

[15] La materia così formata, in equilibrio con la radiazione elettromagnetica, è ancora

distribuita sostanzialmente in modo omogeneo e isotropo. La debole anisotropia della

distribuzione di materia, che è quella letta nelle anisotropie della radiazione cosmica

di fondo di ordine 10-5, è tuttavia in grado di accendere il meccanismo di collasso

gravitazionale: se le fluttuazioni di materia sono sufficientemente vicine, in virtù della

loro massa possono vincere il moto di espansione reciproco e dar luogo alla formazione

delle strutture cosmiche. Si entra così nella fase in cui dominano le interazioni

gravitazionali. [regime lineare e non-lineare] [16] Da principio sono molto deboli:

fintanto che le fluttuazioni della densità di materia sono piccole rispetto al valore

medio, le relazioni matematiche che descrivono il processo di collasso possono essere

semplificate notevolmente, fornendo una soluzione analitica. Quando le concentrazioni

di materia sono elevate, una trattazione analitica non è più sufficiente: si rende

necessario l’uso del calcolo numerico per ottenere soluzioni “esatte”. In qualche modo

si può pensare a questo approccio come ad un laboratorio: variando tutti i parametri

liberi, si realizzano configurazioni da confrontare con quelle reali osservate con i

telescopi, chiamando in causa solo equazioni che descrivono processi ben noti (F = ma =

-GMm r/r3 !).

La natura della materia su cui agiscono le forze gravitazionali definisce la storia di

formazione delle strutture cosmiche. Ad esempio, scenari in cui ci sia solo materia

oscura “calda” (la cui massa è molto piccola, e.g. 1eV/c2), prevedono la formazione

prima di strutture su larga scala, a cui seguirebbe per frammentazione la formazione

di strutture su scale più piccole (galassie e ammassi di galassie): il quadro così dipinto

è però poco compatibile con le osservazioni. Scenari con solo materia oscura “fredda”

(cioè non relativistica) prevedono invece prima la formazione di piccole strutture, poi

di quelle su scale maggiori: anche così non si ottengono risultati in pieno accordo con le

osservazioni.

[17] Il modello che descrive meglio quanto effettivamente osservato si avvicina a

quest’ultimo, che deve però essere modificato con il coinvolgimento di una costante

cosmologica () – a questo livello è solo un parametro geometricamente compatibile

con le equazioni di Einstein, ma negli ultimi anni sta attirando molta attenzione per

effetti direttamente misurati e per l’inquadramento in teorie fondamentali che si

propongono di estendere il Modello Standard delle Particelle Elementari.

Questi modelli (CDM) prevedono una storia di formazione delle strutture di tipo

gerarchico: prima si sarebbero formate le strutture di piccola massa, le galassie,

successivamente strutture più massive, ammassi e superammassi di galassie. Le prime

galassie osservabili, sedi di processi astrofisici ad alta energia (quasar, in sigla QSO),

risulterebbero osservabili a valori di redshift z 6: è quanto effettivamente

osservato di recente dal telescopio spaziale Hubble! Questo modello di formazione

risulta compatibile con le osservazioni. – vedi anche [20-21-22-23-24-25]

[18] ICM. Finora ci siamo concentrati sulle sorgenti luminose. È ovvio, tuttavia, che la

maggior parte dello spazio è occupata da regioni vuote, o più correttamente regioni in

cui la densità di materia è inferiore al valor medio; la loro evoluzione è regolata dalle

stesse leggi che descrivono la dinamica degli oggetti collassati. Queste appaiono buie

nella banda dello spettro visibile: osservandole invece nell’infrarosso o nella banda X,

manifestano una natura ben più ricca.

Su distanze cosmologiche, risultano di interesse le regioni tra gli ammassi di galassie

(Intra Cluster Medium, ICM). Sono regioni estremamente calde, sedi di interazioni

elettromagnetiche e processi d’urto tra elettroni e atomi pesanti ionizzati: il risultato

è uno spettro caratteristico, dalla cui forma è possibile dedurre la temperatura di

quelle regioni e la densità media di elettroni e ioni pesanti in esse contenuti. Lo studio

di simulazioni e il confronto con i dati osservativi costituiscono lo strumento per

l’indagine di queste strutture e il ruolo giocato contemporaneamente dalla

fluidodinamica e dall’elettrodinamica (collettivamente magnetoidrodinamica, un ramo

della fisica dei plasmi). – vedi anche [21]

[26-27] Un altro strumento di indagine del mezzo inter cluster, nella fattispecie la

distribuzione dell’elemento più abbondante sulle scale cosmologiche, l’idrogeno, è lo

studio degli spettri dei quasar più distanti (circa z > 3). La radiazione da questi

emessa attraversa lo spazio fino a raggiungere i nostri telescopi – spostata verso

lunghezze d’onda maggiori per effetto dell’espansione dell’universo. Nell’attraversamento di regioni con idrogeno neutro, viene assorbita la componente di questa

radiazione in grado di portare l’idrogeno neutro dallo stato fondamentale al primo

stato eccitato, cioè i fotoni con lunghezza d’onda pari a 1216Å. La lettura dello

spettro di assorbimento permette una mappatura della distribuzione dell’idrogeno

lungo la linea di vista: dalla posizione della riga di assorbimento si deduce il valore del

redshift della regione assorbente, cioè la sua distanza da noi; dall’ampiezza della riga

di assorbimento si risale invece alla densità di idrogeno di quella regione. [28]

Confrontando gli spettri di assorbimento di due o più quasar angolarmente vicini è poi

possibile una mappatura bi- o tri-dimensionale della distribuzione dell’idrogeno neutro.

Ancora una volta, le simulazioni numeriche costituiscono il “laboratorio” per esplorare

questi sistemi. E si ricordi: l’astronomia non è una scienza galileiana!

[19] Epilogo. Si conclude così questa rapida e sicuramente non esaustiva panoramica

u quell’affascinante ramo delle scienze fisiche e astronomiche che passa sotto il nome

di cosmologia: lo strumento con cui raccontare la storia dell’universo dai primi istanti

di vita fino ad oggi, in un quadro che vede coinvolti relatività generale, fisica delle

particelle elementari, elettrodinamica e fluidodinamica, che lascia spazio

all’introduzione di nuove teorie e nuova fisica, che fa uso dei più raffinati strumenti

della statistica e del calcolo numerico e che stimola il progresso tecnologico per

l’esplorazione del cosmo. Tutto ciò dovrebbe almeno suscitare curiosità e stimolare

l’immaginazione. E forse aveva ragione Einstein: “Imagination is more important than

knowledge”.

Aforismi

Paul Davies

Un fisico alla ricerca di Dio

Documenti correlati

I teologi affermano che l'universo ha molti tratti "contingenti". Intendono dire

che presenta dei fenomeni che devono essere spiegati con il richiamo a

qualcosa d'altro, con delle cause esterne all'universo. Certamente l'esistenza

degli esseri umani, come quasi tutto ciò che possiamo osservare nell'universo,

è, in questo senso, contingente.

Dunque, ci deve essere stato un atto di intellegenza che ha selezionato

l'enorme varietà di universi possibili. Deve essere stato, in qualche modo,

"scelto" un universo, o una gamma ristretta di universi. Non é illecito ritenere

che questa selezione si situi al di fuori o al di là del dominio della fisica, nello

spazio della metafisica. Così da un punto di vista religioso si può dire che

questa selezione è stata fatta da Dio. Molti scienziati non amano questa

spiegazione ed affermano che dobbiamo ricercare un meccanismo di selezione

del tutto interno all'universo.

I cosmologi di oggi, però, si richiamano alla cosiddetta "fisica dei quanti" e con

essa cercano di rendere ragionevole l'idea teologica di una creazione dal nulla

dell'universo. La fisica dei quanti si basa sul cosiddetto "principio di

indeterminazione" di W. Heisenberg. Questo principio ci dice che tutto ciò che

può essere misurato o osservato è soggetto a fluttuazioni spontanee: possono

accadere, cioé, cambiamenti improvvisi senza ragione alcuna. Possiamo

osservare in laboratorio come il fenomeno dei quanti faccia accadere delle cose

senza ragione apparente. Ad esempio, il decadimento di un nucleo radioattivo

è qualcosa che accadrà in un certo momento particolare senza ragioni

apparenti. Noi non possiamo dire in anticipo perché o quando il nucleo

decadrà, perché ciò accade in un momento piuttosto che in un altro. In altre

parole, per la fisica dei quanti c'è una imprevedibilità inerente alla natura.

Diviene così possibile per la prima volta concepire un universo che nasce per

una sorta di fluttuazione quantistica: la sua origine è un evento senza causa.

Nella fisica pre-quantistica non era concesso avere degli eventi senza cause.

Tutto ciò che avveniva nell'universo doveva avere una causa antecedente ben

definita, mentre nella fisica quantistica è possibile che si producano degli

eventi senza una causa antecedente ben definita. Se questo evento è la nascita

dell'universo, esso non costituisce più per noi un problema: l'universo

semplicemente nasce venendo fuori dal nulla.

Dobbiamo ricordarci che già molti secoli or sono Sant'Agostino diceva che il

mondo é nato con il tempo e non nel tempo. E' degno di nota che la moderna

immagine cosmologica riprenda questo punto di vista. Oggi sappiamo che

spazio e tempo sono parte dell'universo fisico e sono nati con esso. Vorrei

esprimere la cosa in questi termini: prima di Einstein si era portati a pensare

allo spazio e al tempo come ad un'arena in cui si rappresentava il grande

dramma della natura. Noi sapppiamo ora che spazio e tempo appartengono in

effetti al "cast" di questo dramma: essi stessi partecipano al dramma, sono

attori nel grande dramma della natura che si svolge di fronte a noi.

Non si può davvero parlare della nascita della materia senza parlare della

nascita dello spazio e del tempo. L'idea della nascita del tempo é molto

originale. Essa comporta una conseguenza: domande del tipo "Cosa accadde

prima del "big bang"?", oppure "Che cosa ha causato il "big bang"?", risultano

prive di significato, perché non c'era un "prima", non c'era una causa

antecedente come la intende la fisica tradizionale.

Inoltre, se spazio e tempo sono elementi dell'universo, possono essere

allungati e accorciati perfino in laboratorio. Possiamo manipolare spazio e

tempo allo stesso modo in cui possiamo manipolare la materia. Se essi sono

parte, per usare un termine religioso, della "creazione", allora devono esser

stati creati. Io personalmente non credo che ci sia modo di dare un senso al

mondo senza supporre che spazio e tempo, nel "big bang", siano stati creati

con la materia e l'energia originarie.

Tratto dall'intervista "Riflessioni sulla cosmologia

contemporanea" - Venezia, Università Ca' Foscari, sabato

16 dicembre 1989

Aforismi

Paul Davies

Scienza e tecnica

Documenti correlati

DOMANDA

Professor Davies, condivide la distinzione fra scienza e uso della

scienza?

DAVIES

Sicuramente. Penso che, spesso, si tenda ad equiparare scienza e tecnologia.

La mia carriera è stata contrassegnata dal tentativo di comprendere la scienza

come un mezzo per svelare i segreti della natura. Il mio fine è sempre stato

capire come funziona il mondo e qual è il suo significato. E credo sia questo un

uso molto nobile della scienza. Ma vi esiste anche la scienza come fondamento

della tecnologia. Come ho già avuto modo di spiegare, non credo che

possiamo fare a meno della tecnologia. La tecnologia non è intrinsecamente

buona o cattiva, è buona o cattiva a seconda dell’uso che ne vien fatto. Molti

cercano di giustificare il fatto di fare scienza in base ai suoi risultati

tecnologici. Secondo me la scienza è veramente un’impresa più profonda. Essa

è per sua natura fondamentalmente culturale. E’ da porre accanto alle arti, ed

è qualcosa che vale la pena di fare per se stessa. Ma ovviamente la scienza è

costosa, deve pagare un prezzo per il proprio sviluppo e lo fa attraverso i suoi

prodotti tecnologici. Ma è nell’era della tecnologia e non in quella della scienza

come tale che si nascondono i pericoli. La scienza è semplicemente un nobile

cammino verso la conoscenza. Invece, la scienza, in quanto strumento di

creazione della tecnologia, è pericolosa: per questo dobbiamo non già

arrestarci, ma essere consapevoli dei suoi pericoli e creare le istituzioni e la