Corso di Laurea in Fisica

Corso di Struttura della Materia - G. Rinaudo

Nota 4 – Transizioni radiative e spettroscopia

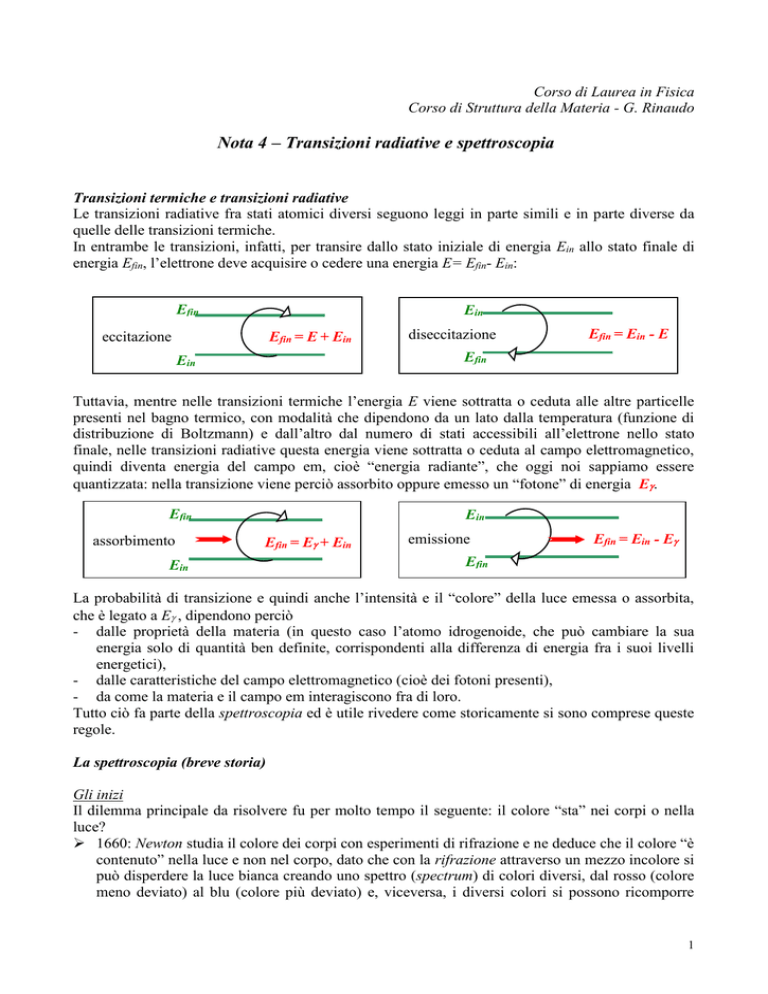

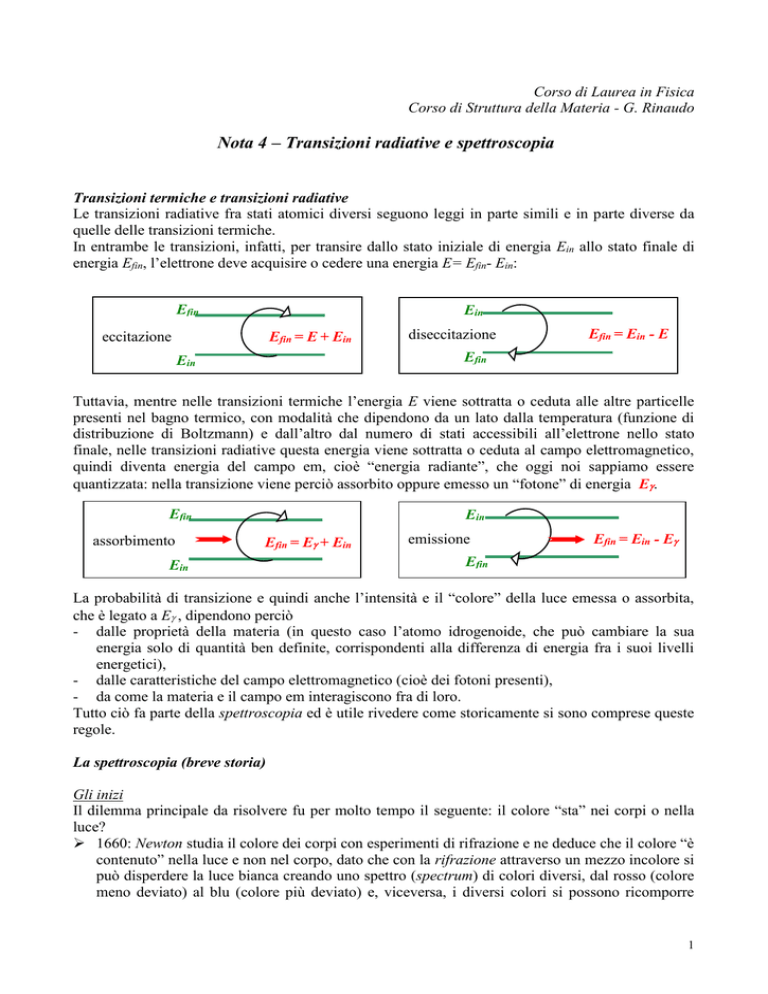

Transizioni termiche e transizioni radiative

Le transizioni radiative fra stati atomici diversi seguono leggi in parte simili e in parte diverse da

quelle delle transizioni termiche.

In entrambe le transizioni, infatti, per transire dallo stato iniziale di energia Ein allo stato finale di

energia Efin, l’elettrone deve acquisire o cedere una energia E= Efin- Ein:

Efin

Ein

eccitazione

Efin = E + Ein

diseccitazione

Efin = Ein - E

Efin

Ein

Tuttavia, mentre nelle transizioni termiche l’energia E viene sottratta o ceduta alle altre particelle

presenti nel bagno termico, con modalità che dipendono da un lato dalla temperatura (funzione di

distribuzione di Boltzmann) e dall’altro dal numero di stati accessibili all’elettrone nello stato

finale, nelle transizioni radiative questa energia viene sottratta o ceduta al campo elettromagnetico,

quindi diventa energia del campo em, cioè “energia radiante”, che oggi noi sappiamo essere

quantizzata: nella transizione viene perciò assorbito oppure emesso un “fotone” di energia E.

Efin

assorbimento

Ein

Efin = E + Ein

Ein

emissione

Efin = Ein - E

Efin

La probabilità di transizione e quindi anche l’intensità e il “colore” della luce emessa o assorbita,

che è legato a E , dipendono perciò

- dalle proprietà della materia (in questo caso l’atomo idrogenoide, che può cambiare la sua

energia solo di quantità ben definite, corrispondenti alla differenza di energia fra i suoi livelli

energetici),

- dalle caratteristiche del campo elettromagnetico (cioè dei fotoni presenti),

- da come la materia e il campo em interagiscono fra di loro.

Tutto ciò fa parte della spettroscopia ed è utile rivedere come storicamente si sono comprese queste

regole.

La spettroscopia (breve storia)

Gli inizi

Il dilemma principale da risolvere fu per molto tempo il seguente: il colore “sta” nei corpi o nella

luce?

1660: Newton studia il colore dei corpi con esperimenti di rifrazione e ne deduce che il colore “è

contenuto” nella luce e non nel corpo, dato che con la rifrazione attraverso un mezzo incolore si

può disperdere la luce bianca creando uno spettro (spectrum) di colori diversi, dal rosso (colore

meno deviato) al blu (colore più deviato) e, viceversa, i diversi colori si possono ricomporre

1

(disco di Newton) per ricreare la luce bianca; Newton studia perciò gli spettri continui ma non

riesce a spiegare perché le fiamme hanno colori ben definiti che non si possono “scomporre”.

angolo di deviazione

rosso

violetto

1750: Melville scopre gli spettri a righe osservando sistematicamente le fiamme con lo

spettroscopio a prisma e descrive per primo la riga gialla del sodio.

1800 in poi: Herschel scopre l’infrarosso studiando la distribuzione spettrale dell’energia

termica associata alla radiazione solare, si accorge cioè che c’è ancora dell’energia che viaggia

anche ad angoli di deviazione al di sotto del visibile. In modo analogo Ritter scopre

l’ultravioletto dalle proprietà fotochimiche del cloruro di argento.

angolo di deviazione

infrarosso

rosso

violetto

Dall’osservazione qualitativa alle misure e classificazioni su base quantitativa

1801: Young calcola per la prima volta una lunghezza caratteristica associabile a ogni colore,

utilizzando vecchi dati di Newton che descrivevano l’associazione fra il colore di pattern

colorati che si osservano su lamine sottili a cuneo e lo spessore locale d della lamina.

2d = differenza di cammino fra il raggio (2) e il raggio (1)

si assegna al colore la “lunghezza” = 2d

(1)

raggio incidente

(2)

d

1810 in poi: Fraunhofer sviluppa nuovi tipi di spettroscopio, basati sul principio del reticolo

a diffrazione; studia così e descrive ben 700 righe identificate nello spettro solare, separandole

in righe chiare (di emissione) e righe scure (di assorbimento); inoltre classifica con lettere

maiuscole le 8 righe più intense (di qui la lettera D assegnata alla riga gialla del sodio, che

venne però riconosciuta come proveniente da transizioni del sodio solo molto più tardi). Altri

contributi a questa classificazione sistematica vengono dati in questo periodo da Brewster e da

Herschel e varie righe vengono via via associate alle diverse sostanze: si delinea così

l’associazione fra lunghezza d’onda della riga e sostanza che la emette e nasce quindi la

spettroscopia come tecnica di riconoscimento delle sostanze chimiche. Restano però dei casi

irrisolti, come quello della riga D che compare negli spettri di assorbimento di moltissime

2

sostanze a causa della difficoltà di eliminare completamente la presenza di contaminazioni di

sodio nelle sostanze analizzate.

1848: Foucault risolve il rompicapo della riga D studiando l’assorbimento della luce solare da

parte di vapori di sodio; associa quindi definitivamente la riga D al sodio e dà sicurezza alla

analisi spettroscopica come tecnica di analisi chimica.

1859: Kirchhoff enuncia le leggi della spettroscopia:

- la lunghezza d’onda a cui una sostanza emette dipende unicamente dalla sostanza,

- le lunghezze d’onda a cui si verificano i picchi di emissione di una sostanza coincidono con

quelle a cui si verificano i picchi di assorbimento della stessa sostanza,

- una sostanza trasparente non emette nel visibile.

Kirchhoff inoltre:

- spiega le righe scure osservate da Franhofer negli spettri della corona solare come righe di

assorbimento dovute alle stesse sostanze che producono le righe chiare di emissione,

- spiega perché la riga D del sodio si osserva in molti spettri anche di altre sostanze

giustificandola con la presenza diffusa di impurità di sodio,

- inizia a usare la spettroscopia non solo per riconoscere le sostanze in base ai loro spettri ma

anche per scoprire sostanze nuove o proprietà nuove dagli spettri: ad esempio predice

l’esistenza del rubidio estrapolando le caratteristiche ricorrenti in modo regolare degli spettri

del sodio e del potassio (nella tabella periodica di Mendeleiev, il rubidio, Z=37, è infatti il

quarto “metallo alcalino” dopo il litio, Z=3, il sodio, Z=11, e il potassio, Z=19).

Verso la fisica dei quanti

1885: Balmer scopre quasi casualmente la “serie” che porta il suo nome, cioè una relazione

“numerologica” tra le frequenze f delle righe spettrali dell’idrogeno che può essere espressa in

modo proporzionale alla differenza fra gli inversi al quadrato di due numeri interi,

1

1

f R

n2 n2

2

1

-15 -1

dove R 3 10 s . È la prima volta che numeri interi vengono associati agli spettri di

radiazione.

1901: Planck1 spiega la distribuzione spettrale dell’emissione di corpo nero ipotizzando che

materia e radiazione scambino energia in modo quantizzato, cioè che l’energia scambiata E sia

proporzionale alla frequenza con costante di proporzionalità data dal quanto di azione h, E=hf.

1905: Einstein interpreta i dati sull’effetto fotoelettrico associando a una radiazione di frequenza

f una energia E data dalla relazione di Planck, E=hf. La radiazione consiste quindi di fotoni

(anche se il termine “fotone” venne coniato molto più tardi), cioè di quanti di energia. I fotoni

trasportano anche quantità di moto, p=E/c, con c = velocità della luce, come atteso dalla

relazione relativistica E2=p2c2+m2c4 per particelle di massa nulla (la verifica sperimentale venne

più tardi con gli esperimenti sull’effetto Compton).

1908: Ritz enuncia il principio di ricombinazione, secondo il quale a ogni atomo possono essere

associati dei termini spettrali, cioè delle frequenze caratteristiche discrete, tali che tutte le righe

spettrali emesse o assorbite dall’atomo si possono esprimere combinando in tutti i modi tali

1

Planck iniziò la sua carriera scientifica come assistente di Kirchhoff ed è probabile che il suo interesse per gli spettri

nacque proprio da questi interessi giovanili.

3

frequenze, cioè calcolando le differenze fra i termini spettrali, come appunto avviene nella

relazione di Balmer.

1913: Bohr ipotizza che l’emissione e l’assorbimento da parte di un atomo sono dovuti a

transizioni fra stati stazionari dell’elettrone, in cui la frequenza della radiazione emessa o

assorbita, e quindi l’energia del fotone associato, è legata alla differenza di energia fra i due stati

dalla legge di conservazione dell’energia.

E2

assorbimento

E2

E + E1 = E2

emissione spontanea

E2 = E + E1

E1

E1

1917: Einstein ipotizza, sulla base dell’analisi statistica dello spettro di corpo nero, l’esistenza

di un secondo processo di emissione, l’emissione stimolata, cioè l’emissione indotta da un

fotone di energia risonante con la differenza fra le energie dei due livelli: i fotoni “uscenti” dalla

transizione sono perciò due e sono “identici” al fotone incidente

E2

E + E2 = 2 E + E1

emissione stimolata

E1

1954: Gordon, Zeiger e Townes realizzano per la prima volta un dispositivo che funziona sul

principio dell’emissione stimolata, il “MASER all’ammoniaca”.

Come descrivere la transizione fra due stati stazionari

Per indurre la transizione fra due stati stazionari, ciascuno dei quali è un “autostato”, cioè è una

soluzione dell’equazione stazionaria di Schrodinger, occorre che la perturbazione abbia due

caratteristiche:

-

sia sintonizzata con il sistema,

abbia il corretto accoppiamento fra radiazione e materia, cioè fra il campo elettromagnetico e

gli operatori in grado di indurre la transizione della funzione d’onda dell’elettrone dallo stato

iniziale a quello finale.

Nella derivazione che segue descriveremo quantisticamente gli stati iniziale e finale dell’elettrone,

mentre descriveremo lo stato del fotone in modo classico, cioè attraverso un campo

elettromagnetico non quantizzato. Scopo della derivazione è calcolare la probabilità di transizione

per unità di tempo fra stato iniziale e finale.

Deriveremo l’espressione della probabilità di transizione solo per l’assorbimento e per l’emissione

stimolata, cioè per processi in cui è già presente inizialmente un campo elettromagnetico che può

produrre la “perturbazione” sullo stato iniziale dell’elettrone tale da indurre la transizione allo stato

finale. Inoltre terremo conto solo della perturbazione indotta dal campo elettrico E , perché è il tipo

di interazione più forte. Il campo viene scritto come un’onda caratterizzata da una pulsazione

=2f e da un numero d’onda k=2/ =2f/c=/c:

4

E ( r , t ) 2Eo cos(k r t ) E o(ei (k r t ) ei (k r t ) )

z

La perturbazione introdotta dalla presenza del campo

elettrico dell’onda elettromagnetica nella zona dello spazio

in cui “si trova” l’elettrone, cioè nei punti di coordinate

r tali che la funzione d’onda (r ) dell’elettrone sia

sensibilmente diversa da zero, viene descritta come una

hamiltoniana di interazione Hint dipendente dal tempo,

proporzionale al campo elettrico, piccola rispetto agli altri

termini che compaiono nella hamiltoniana imperturbata Ho:

i (k r t )

i ( k r t )

H int er E er Eo (e

e

)

(1)

E

d3r

r

B

y

x

Dimostriamo ora che Hint soddisfa alle due condizioni di sintonizzazione e di accoppiamento sopra

citate.

Sintonizzazione

Per la sintonizzazione, occorre che la pulsazione del campo elettromagnetico sia prossima alla

differenza di frequenza fra il livello alto e quello basso. Se chiamiamo E2= 2 l’energia del livello

alto e E1= 1 quella del livello basso, occorre che sia

2 - 1

Infatti, se, ad esempio, il sistema è inizialmente, prima dell’applicazione della perturbazione, sul

livello E1, la sua funzione d’onda ha una evoluzione temporale della fase del tipo e i1t . Per

vederlo, scriviamo l’equazione temporale di Schrodinger con l’hamiltoniana imperturbata Ho:

Ψ ( r , t )

H oΨ ( r , t ) i

t

la cui soluzione, per l’autostato di energia iniziale E1, è la funzione d’onda temporale

Ψ1(r , t ) 1(r )eiE1t / 1(r )ei1t

mentre, per l’autostato di energia finale E2 è:

Ψ 2 (r , t ) 2 (r )eiE2t / 2 (r )ei2t

Applicando una hamiltoniana di interazione che contiene un termine che varia nel tempo come

e i t , quale è il primo dei due termini della (1), se 2 - 1, si ottiene una variazione del tipo

e i (1 )t e i 2 t . Tale evoluzione è appunto quella aspettata per uno stato sul livello E2 ed è

conseguenza della conservazione dell’energia nel processo di assorbimento di un quanto del campo

elettromagnetico, cioè di un “fotone” di energia E= , che somma la sua energia all’energia E1

dell’elettrone: E2= E+ E1.

Il secondo termine della (1) permette invece la “sintonizzazione” in un processo di emissione

stimolata da parte di un campo elettromagnetico di pulsazione che agisce sullo stato di energia

più elevata E2>E1, la cui funzione d’onda ha una evoluzione temporale della fase del tipo e i 2 t ;

applicando una hamiltoniana di interazione che contiene un termine che varia nel tempo come

5

e i t , quale è appunto il secondo dei due termini della (1), se 2 - 1, si ottiene una variazione

del tipo e i ( 2 )t e i1t , che è appunto l’evoluzione aspettata per uno stato sul livello E1. In

termini di conservazione di energia, ciò è proprio quanto accade nel processo di emissione stimolata

causata da un quanto del campo elettromagnetico, cioè da un “fotone” di energia E= , che

somma la sua energia all’energia E2 dell’elettrone dando luogo a due fotoni nello stato finale aventi

la stessa energia, E2+E = 2E+ E1 (che, semplificando, si riduce a E2 = E+ E1).

Accoppiamento

Costruiamo l’accoppiamento per analogia con quanto avviene nell’accoppiamento di un circuito

oscillante LC a un campo elettromagnetico. Anche in questo caso è essenziale la sintonizzazione tra

la frequenza del campo elettromagnetico esterno e la frequenza caratteristica della “materia” che qui

è rappresentata dai parametri caratteristici del circuito elettrico, cioè deve essere LC ' .

Tuttavia la sintonizzazione non basta, perché tutti sappiamo che non ogni circuito LC è un buon

“ricevitore”, cioè si accoppia bene con il campo esterno. Per creare un buon accoppiamento, occorre

che ci sia una “antenna”, che si ottiene deformando la geometria del condensatore in modo che si

adatti al campo elettrico esterno attraverso un dipolo elettrico esteso. L’ampiezza d del dipolo

oscilla nel tempo con una pulsazione ’=LC e vale d=qrmax cos(’t). È questo dipolo oscillante

che si accoppia con il campo elettrico dell’onda, con una energia di accoppiamento

Eacc qr cos( ' t ) E qr cos( ' t ) Eo cos(k r t )

(1’)

E

C

k

rmax

L

B

Nella (1’) l’accoppiamento si ottiene se r Eo è diverso da zero (mentre si dimostra, con argomenti

simili a quelli descritti sopra, che la sintonizzazione si ottiene con prossimo a ’).

Calcolo della probabilità di transizione

Per analogia con il dipolo classico, possiamo scrivere l’hamiltoniana di interazione come termine di

accoppiamento di dipolo elettrico, dove r diventa ora l’operatore che opera sulla funzione d’onda

dell’elettrone:

H int er E er Eo (ei (k r t ) e i (k r t ) )

(2)

Inseriamo l’hamiltoniana di interazione nell’equazione temporale di Schroedinger:

Ψ ( r , t )

( H o H int )Ψ ( r , t ) i

t

(3)

p 2 Ze2

è l’hamiltoniana imperturbata e Ψ ( r , t ) è l’intera funzione d’onda

2m

r

dell’elettrone, che include anche la dipendenza dal tempo: non si può infatti usare la funzione

d’onda stazionaria perché l’elettrone non è in uno stato di energia definita dato che sta facendo la

transizione fra lo stato 1 e lo stato 2. Mentre infatti l’antenna descritta prima è un sistema classico,

in cui si poteva, almeno in linea di principio, pensare di misurare, istante per istante, la posizione

del baricentro delle cariche positive e delle cariche negative che oscillano nell’antenna, nulla di

dove H o

6

questo può essere fatto per l’elettrone atomico, del quale si conoscono solo le autofunzioni che

descrivono gli stati stazionari su cui l’elettrone può trovarsi.

Scriviamo pertanto Ψ ( r , t ) come sovrapposizione delle due funzioni d’onda temporali

Ψ1( r , t ) 1( r )eiE1t / e Ψ 2 ( r , t ) 2 ( r )eiE2t / associate alle energie E1 1 ed E2 2 :

2

2

Ψ ( r , t ) c11( r )ei1t c2 2 ( r )ei2t con c1 c2 1

(4)

dove 1 e 2 sono autofunzioni di Ho con autovalori rispettivamente E1 ed E2:

H o1 (r ) E11 (r ) 11 (r ) ; H o 2 (r ) E2 2 (r ) 2 2 (r )

(5)

Da notare che la funzione d’onda (4) non è uno stato stazionario, con energia definita, ma è una

sovrapposizione di stati stazionari, ognuno dei quali ha una fase che evolve nel tempo con una

propria frequenza: la sovrapposizione dei due ha non solo la fase ma anche il modulo che evolve nel

tempo, come si può calcolare facilmente, e proprio per questo non è uno stato stazionario.

A questo punto si assume che, in presenza di una hamiltoniana di interazione dipendente dal tempo,

i coefficienti di sovrapposizione c1 e c2 dipendano dal tempo, dato che l’interazione causa una

variazione dell’ampiezza di probabilità di ciascuno dei due stati.

I dettagli del calcolo sono dati in appendice. Il risultato è che la probabilità di transizione nell’unità

di tempo fra lo stato 1 e lo stato 2, 21, vale:

21

4π 2

2

M 21 ( 21 ) B21 ( 21 )

(6)

3

dove M21 è il cosiddetto “elemento di matrice di dipolo elettrico”, che è il valore medio

dell’operatore cruciale che produce la transizione, l’operatore e r :

2

M 21 2 (r ) | er | 1 (r )

(7)

Questo è appunto l’operatore che, applicato all’autostato stazionario 1 ( r ) lo trasforma in un altro

stato stazionario 2( r ) .

Il coefficiente B21 è detto “coefficiente di assorbimento di Einstein”.

Il termine (21) è la densità di energia elettromagnetica alla frequenza = 2 - 1, che è legata

all’intensità Eo2 del campo elettrico; Eo2 è infatti l’integrale su tutte le frequenze del valore di ()

nell’intervallo di pulsazione d:

Eo2 2 ( ) d

0

L’equazione (6) è un esempio di regola d’oro di Fermi, secondo la quale la probabilità di

transizione è proporzionale all’elemento di matrice al quadrato del termine di hamiltoniana di

interazione che collega stato iniziale e stato finale, moltiplicata per la densità degli stati disponibili

per la transizione (in questo caso gli stati sono quelli del campo elettromagnetico che hanno la

frequenza opportuna).

La stessa equazione descriverebbe l’emissione indotta, cioè la probabilità di transizione per il

processo inverso, il passaggio dallo stato 2 allo stato 1 (basta scambiare, in tutte le equazioni a

partire dall’equazione A1 dell’appendice lo stato 2 con lo stato 1). Il risultato che si ottiene è lo

stesso, dato che nella (9) |M21|2=|M12|2 (e anche B21 = B12): infatti lo stesso elemento di matrice di

dipolo elettrico induce la transizione dallo stato 2 allo stato 1 oppure la transizione opposta.

Questo è il cosiddetto principio del bilancio dettagliato.

7

Emissione spontanea

Si calcola per analogia al calcolo classico di emissione di onde elettromagnetiche da una antenna, in

cui la potenza irradiata è proporzionale al quadrato del momento di dipolo elettrico e alla frequenza

alla quarta (vedi, ad esempio, Costa e Predazzi, XV.20, W ( )

1 4 ( qz )2

). Interpretando

4o 3c3

l’emissione in modo quantizzato, cioè calcolando il numero di fotoni emessi nell’unità di tempo alla

frequenza 21 corrispondente alla differenza di energia fra i due livelli, e tenendo conto che ogni

fotone ha una energia 21 , si ottiene la probabilità di emissione spontanea nell’unità di tempo:

spont

21

3

4 21

2

M 21 A21

(9’)

3c

dove A21 è chiamato il “coefficiente di Einstein dell’emissione spontanea”. Anche la probabilità di

transizione spontanea è quindi proporzionale al quadrato dello stesso elemento di matrice di dipolo

elettrico come le transizioni indotte.

3

Le regole di selezione

Come si vede dalla (7) la probabilità di transizione, a parità di

intensità dell’onda elettromagnetica, è proporzionale |M21|2. Per

calcolare M21 scriviamo esplicitamente i tre operatori contenuti

nell’espressione data nell’equazione, proporzionali alle componenti

rx, ry, rz dell’operatore r , che, scritti in coordinate polari, sono:

rx = r sin cos = r sin (e i + e -i)/2

ry = r sin sin = r sin (e i - e -i)/2

rz = r cos

z

d3r

r

y

x

Esaminiamo per primo l’effetto di rz; supponiamo ad esempio che lo stato 1 sia lo stato 1s

dell’idrogeno, per cui 1 (r ) R10Y00 . La funzione d’onda, che rappresenta l’ampiezza di

probabilità di trovare l’elettrone nel volumetto d3r intorno al punto di coordinate r, e , dipende

solo dalla distanza radiale e non dagli angoli e . Applicando allo stato l’operatore rz si ottiene:

rz 1 (r ) rR10 (r )Y00 cos

che, chiaramente, non è più uno stato indipendente dai valori di e di , ma ha una dipendenza da

e uguale a quella della funzione sferica Y10 ; si può quindi dire che rz “opera” la trasformazione di

uno stato s in uno stato p avente ml=0. In modo analogo si può calcolare come opererebbe su uno

stato con un l qualunque, ad esempio l=1:

3

1 1

rz n,1,0 (r ) rRn1 (r ) Y10 cos CrRn1 (r ) cos 2 C ' rRn1 (r ) cos 2

2 2

2

C ' ' rRn1 (r ) C2Y20 C0Y00

Come si vede, rz trasforma lo stato con l=1 in una sovrapposizione di stati con l=2 oppure l=0, ma

sempre con ml=0. In generale, l’operatore rz opera quindi una trasformazione che cambia di una

unità il numero quantico l di momento angolare orbitale mentre lascia invariato il numero quantico

ml, quindi il corrispondente elemento di matrice sarà diverso da zero solo se valgono le regole:

l = 1 ; ml = 0

(10)

8

Per calcolare l’elemento di matrice corrispondente, scriviamo esplicitamente la (7) per la

componente z, chiamando n, l, ml i numeri quantici dello stato 2 ed n’, l’, ml’ i numeri quantici dello

stato 1:

1 2

0

1 0

m*

m

M 21, z 2 (r ) | erz | 1 (r ) e Rnl (r ) Rn'l ' (r )r 3dr Yl l cos Yl ' l ' d cos d

L’integrale sugli angoli e è diverso da zero solo se valgono le regole date nella (10), che sono

quindi “regole di selezione” della transizione indotta da rz. Non c’è invece nessuna regola di

selezione particolare che riguardi il numero quantico n, tuttavia il valore dell’integrale sulla

variabile r può essere più o meno grande a seconda delle funzioni Rnl coinvolte e, di conseguenza, la

transizione può essere più o meno probabile e la relativa riga spettrale più o meno intensa.

In una rappresentazione in termini di diagrammi di Grotrian, le transizioni sono quindi sempre

rappresentate da “frecce” che si spostano lateralmente verso destra o verso sinistra di una unità di

momento angolare l:

E (eV)

4

-0.85

3

-1.5

2

-3.4

rz

rz

rz

1 -13.6

0

n

-1

0

+1

-2

-1

0

0

1

2

s

p

d

+1

ml

+2

l

In modo analogo si calcola come operano gli operatori rx o ry. Applicando, ad esempio, rx allo stato

1s, si ottengono gli stati p con ml = 1:

rx 1 (r ) rR10 (r )Y00 sen (ei e i ) CrR10 (r )(Y11 Y11 )

9

Applicando rx allo stato con l e ml qualunque, si ottiene una sovrapposizione di stati con l e ml

variati di una unità in più o in meno. Conviene definire gli operatori

r+ = (rx+ iry)/2 = r ei

r- = (rx- iry)/2 = r e-i

che variano rispettivamente di +1 e di –1 il valore di ml e di 1 il valore di l, dando quindi origine a

ben precise transizioni. Come per rz, non ci sono regole che impongano una variazione precisa del

numero quantico radiale n, tuttavia la variazione di n va a influire il valore dell’integrale su r e

quindi il valore di M12.

Alcune transizioni indotte da questi operatori sono mostrate nel seguente diagramma di Grotrian.

E (eV)

4

-0.85

3

-1.5

2

-3.4

rz

r-

rz

r-

rz

r-

r+

r+

r+

1 -13.6

0

n

-1

0

+1

-2

-1

0

0

1

2

s

p

d

+1

ml

+2

l

Nessuno dei tre operatori r+, r-, rz può invece indurre variazioni nel valore di ms, perché nessuno

contiene operatori che possano operare sugli spinori, quindi ms si conserva nella transizione.

Riassumendo, le regole di selezione sono:

l = 1

ml = 0, 1

ms = 0

10

Appendice: dettagli del calcolo della probabilità di transizione

Sostituendo l’espressione (4) della funzione d’onda nell’equazione di Schrodinger (3) contenente

l’hamiltoniana di perturbazione Hint si ottiene:

(c11 (r )e i1t c2 2 (r )e i 2t )

i

( H o H int )(c11 (r )e i1t c2 2 (r )e i 2t )

t

dove abbiamo trascurato la dipendenza spaziale del campo elettrico, contenuta nel termine k r che

è molto piccolo: infatti è dell’ordine di 2<r>/, cioè del rapporto fra le dimensioni medie

dell’atomo date da <r> (regione in cui le funzioni d’onda 1 e 2 sono sensibilmente diverse da

zero, dell’ordine di 10-10m) e la lunghezza d’onda del campo elettromagnetico (che è dell’ordine di

10-6m). Sviluppando i calcoli e tenendo conto delle relazioni (5) si ottiene:

c

c

i 1 1 (r )e i1t 2 2 (r )e i 2t i1c1 1 (r )e i1t i 2c2 2 (r )e i 2t

t

t

i1t

i 2t

i1t

i 2t

1c1 1 (r )e

2c2 2 (r )e

H int (c1 1 (r )e

c2 2 (r )e

)

e, semplificando i termini eguali nei due membri, si ottiene:

c

c

i 1 1( r )e i1t 2 2 ( r )e i 2t H int c1 1( r )e i1t c2 2 ( r )e i 2t

t

t

(A1)

Se ad esempio interessa conoscere l’evoluzione temporale di c2 a partire da un istante iniziale in cui

il sistema è nello stato (1), moltiplichiamo per il “bra” <2(r)| e integriamo su tutto lo spazio,

tenendo conto delle le condizioni di autonormalizzazione:

*

3

2 ( r , t ) 2 (r , t )d r 1

; 2*(r , t )1(r , t )d 3r 0

Si ottiene così:

c

i 2 e i 2 t 2 (r ) | H int | 1 (r ) e i1t e 2 (r ) | r Eo (eit e it ) | 1 (r ) e i1t

t

dove, a secondo membro, si è posto c11 e trascurato il termine proporzionale a c2, supponendo che

per tutto l’intervallo di tempo to in cui si considererà la transizione l’ampiezza dello stato 2 resti

comunque piccola. Esaminiamo prima la dipendenza dal tempo:

c2 e

2 (r ) | r Eo | 1 (r ) ei ( 2 1 )t (eit e it )

t

i

Conviene introdurre l’elemento di matrice di dipolo elettrico M21 fra gli stati 1 e 2:

M 21 2 (r ) | er | 1 (r )

sostituendo si ottiene:

M 21 Eo i ( 2 1 )t

c2

e

e i ( 2 1 )t

t

i

(A2)

(A3)

11

Per calcolare la probabilità di transizione per unità di tempo, occorre:

calcolare l’ampiezza c2 all’istante to integrando la (8) fra l’istante t=0 in cui viene “accesa” la

perturbazione e l’istante to,

calcolare il modulo quadro di c2 e dividerlo per to,

integrare su tutte le pulsazioni del campo elettrico fra 0 e infinito, anche se il maggior

contributo verrà dalle pulsazioni intorno al valore 21 = |2 - 1|.

Partendo dall’equazione (A3):

M 21 Eo i ( 2 1 )t

c2

e

e i ( 2 1 )t

t

i

(A4)

per calcolare l’ampiezza c2 all’istante to occorre integrare fra l’istante t=0 in cui viene “accesa” la

perturbazione e l’istante to,

t

i ( 2 1 )to 1 ei ( 2 1 )to 1

M 21 E o i ( )t

M

E

i

(

)

t

21

o e

c2 (to )

(e 2 1

e 2 1

)dt

( 2 1 )

i

i

(

)

2

1

0

i ( 21 ) to

i ( 21 ) to / 2

/ 2 i ( 21 )to / 2

M 21 Eo e

(e

e i ( 21 )to / 2 ) e

(e i ( 21 )to / 2 e i ( 21 )to / 2

i

( 2 1 )

( 2 1 )

dove si è utilizzata la notazione semplificata 21=2 - 1. Dei due termini, solo il secondo è

sensibilmente diverso da zero, dato che 21 è positivo e consente di realizzare la situazione di

“sintonizzazione” sopra discussa, che si verifica quando 21. Teniamo solo il secondo termine e

calcoliamo il modulo:

iM 21 Eo ei ( 2 1 )to / 2 (sen 2 1 )to / 2

c2 (to )

i

( 2 1 )

M 21 Eo sen( 2 1 )to / 2 to

[( 2 1 ) ]to / 2 2

da cui ottieniamo la probabilità di transizione per unità di tempo 21 fra i due stati:

2 2

2

M 21 Eo

c2 (to )

21

to

32

2

sen( 2 1 )to / 2

to

[(2 1 ) ]to / 2

(A5)

dove il fattore 1/3 deriva dalla media fra i valori di cos2(ME), ME essendo l’angolo fra la direzione

del momento di dipolo elettrico atomico e il campo Eo .

Quale è il significato del tempo to che compare nella (A5)? È legato alla larghezza di banda del

campo Eo: il campo infatti non è mai rigorosamente monocromatico, ma ha una certa distribuzione

in frequenza e la banda di frequenze di cui tenere conto è, per il principio di indeterminazione,

inversamente proporzionale a to. Per fare il calcolo, si tiene conto che l’energia immagazzinata nel

campo è, per unità di volume, pari a Eo2 / 2 π (nel sistema di unità di Gauss) e quindi, esprimendo

Eo2 come l’integrale su tutte le frequenze della densità di energia elettromagnetica ()

nell’intervallo di pulsazione d, si ottiene:

12

Eo2 2 ( ) d

(A6)

0

Sostituendo nella (A5), si dovrà includere nell’integrazione anche tutta la dipendenza dalla

frequenza contenuta nel termine in parentesi, che anzi è molto più forte della dipendenza di ():

2

2

2

2

M 21 2 sen( 2 1 )to / 2

M 21 4

sen u

21

t

(

)

d

(

)

du

21

( 2 1 )to / 2 o

2

u

3 2

3

0

0

Nell’ultimo passaggio si è introdotta la variabile adimensionale u=(2 - 1 - )to/2 e si è estratto il

valore di () per =2 -1, dato che l’integrando tende alla funzione di Dirac per u tendente a 0.

Poiché l’integrale vale , si ottiene la relazione finale:

21

4π 2

3

2

2

M 21 ( 21 ) B21 ( 21 )

(A7)

13