Situazione dei Laboratori Virgo-Italia (autunno 2002)

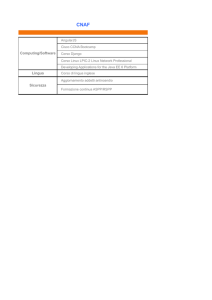

Laboratori

Person.

Person.

Esterno

INFN

dedicato

[FTE]

(*)

Firenze(**)

Urbino(**)

2

[0.75]

3

[1.5]

9

Napoli

[7.0]

Perugia

5

[3.2]

6

Pisa

[4.1]

6

Roma1

[4.0]

(*)

1

Spazi

strutturati

a

disposizione

Risorse

Centro di

Calcolo di

Sezione

(condiviso)

Cluster di

2PIII biprocessore (slave)

+ 1 PIII biprocessore (master)

SO Linux

Centro di

Calcolo di

Istituto

(condiviso)

HW

SW

e sperimentazioni

in corso

Matched filtering con double

whitening per binarie coalescenti;

generazione e gestione di templates

per bin.coal. Calcolo distribuito con

altre sedi Virgo

Sviluppo codice per bursts;

Generazione griglie di templates per

bin.coalesc. e calcolo distribuito con

altre sedi Virgo. Generazione di

forme d’onda

Cluster di

3PIII monoprocessore (slave)

+ 1 PIII biprocessore (master)

SO Linux

12 server SMicro 6010H, 8

server APPRO1224X, 4PIII

dedicati a GRID

Librerie GRASP 1.9.8, LAL, Virgo

Spazio total=

1°

Farm:

2PIII

1GHz,

2

Lib, Num.Recipes, FFTW, MPICH

mente dedi=

conn. FastEth,D18GB SCSI,

1.2.1; kit di Globus 1.1.4.

cato,

completo

Collabo=

S.O.

Lynux

R.H.7.2,

Sviluppo

di algoritmi ottimali

di infrastrut=

razione

Mosix1.04.

(matched filter) e subottimali (filtri

ture

all’interno

col

2°Farm: 2PIV XEON

adattivi; reti neurali) per bin.coalesc.;

personale del laboratorio

2.4Ghz,2conn.FastEth,

test di riferimento per l’on-line

VIRGO, già

del Centro

D72GBSCSI, S.O.Linux

processing per segnali da bin.

dimensionato

di Calcolo

R.H.

7.2,

Mosix1.04

coalescenti.

Test di calcolo distribuito

per Tier2

di Sezione

Entrambe possono essere

(diversi protocolli), anche in

utilizzate stand alone o

ambiente GRID

integrate per calcolo distr.in

ambiente GRID. S.O. Lynux

Red Hat 6.2

Cluster Beowulf da 14 nodi

Sviluppo del sistema di calcolo

Spazio dedi=

PIII biprocessore;

parallelo per la “in time” analysis di

cato all’inter= 1FileServerUW SCSI- 160; 1

bin.coalesc: ottimizzazione e

no del labora=

FileServer UATA100;

sviluppo del codice in MPI. Test di

torio VIRGO + 1master AMD biproc;back =

calcolo distribuito con altre sedi.

Spazi Com=

bone Gb; Fast Eth; SO Linux

Analisi dei dati per il commis=

puting room di Debian 3.0 ed MPI. 1XEONsioning di Virgo.

Sezione

PIV in fase di installazione.

Librerie Fr,FrV,Vega, FFTW,SigLib

Spazi dedicati

Noise analysis; simulazione del ri=

con

servizi

Cluster

di

4

PC

Appro1142

velatore; algoritmi per correlazioni

2

nella sala

biproc. 42GB + file server

tra interferometri; Sviluppo di pro=

(Dpt Fis

calcolo della

400GB RAID

grammi per il monitoring; sviluppo di

Univ.Pisa)

nuova sede

SO Linux-Mosix

pacchetti in C++ per analisi

della Sezione

statistiche. Debugging del SW VEGA

pisana

Cluster di 15 Server: 8 Server

2PIII 1GHz, 7 Server 2Xeon

Sviluppo dell’algoritmo gerarchico

Spazi dedicati

P4 2.4 GHz, ciascuno con 2

(Hough Transform) per sorgenti

con servizi

conn. FastEthernet,

continue: moduli di benchmark, di

2

presso la sala

D 18GByte. SO: Linux RH

gestione, di creazione del Short FFT

(CASPUR)

calcolo della

7.2, MOSIX 1.5.2.

DB, modulo con i codici per la

Sezione di

1 server funge da master;

Hough Transf., modulo di analisi

Roma1 + spazi

network interno per boot

incoerente in ambiente SNAG

che saranno

remoto e data transfer

(appositamente creato dal gruppo).

2

resi disponibili

Storage (incl. server) 0.5

Sperimentazione Grid con codici per

ex CASPUR

TByte. La farm configurata,

la ricerca dei segnali continui.

(ROG)

con il software INFN –GRID, Nuovi algoritmi per la ricerca di burst

ha tre unità non

Sperimentazione su architettura a

completamente dedicate al

64 bit

calcolo, CI, CE, SE

EGO dispone in Càscina di 4 persone utilmente inserite in attività HW e SW parzialmente disponibili per Virgo

Le Università di Firenze ed Urbino appartengono alla stessa Sezione INFN (Firenze) e usufruiscono di un unico finanziamento dall’INFN.

(**)

Comp.

Power

GFLOPS

[kSI2000]

4.2

[1.0]

4.2

[1.0]

54

[12.3]

30

[7.2]

6

[1.5]

45

[10.9]