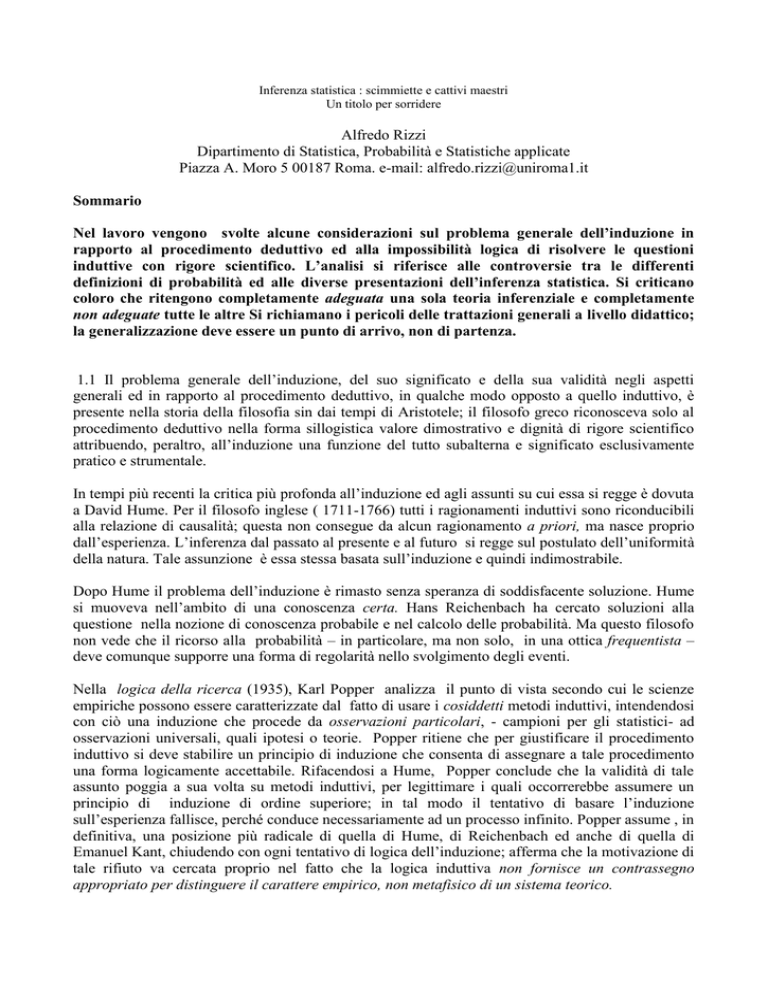

Inferenza statistica : scimmiette e cattivi maestri

Un titolo per sorridere

Alfredo Rizzi

Dipartimento di Statistica, Probabilità e Statistiche applicate

Piazza A. Moro 5 00187 Roma. e-mail: [email protected]

Sommario

Nel lavoro vengono svolte alcune considerazioni sul problema generale dell’induzione in

rapporto al procedimento deduttivo ed alla impossibilità logica di risolvere le questioni

induttive con rigore scientifico. L’analisi si riferisce alle controversie tra le differenti

definizioni di probabilità ed alle diverse presentazioni dell’inferenza statistica. Si criticano

coloro che ritengono completamente adeguata una sola teoria inferenziale e completamente

non adeguate tutte le altre Si richiamano i pericoli delle trattazioni generali a livello didattico;

la generalizzazione deve essere un punto di arrivo, non di partenza.

1.1 Il problema generale dell’induzione, del suo significato e della sua validità negli aspetti

generali ed in rapporto al procedimento deduttivo, in qualche modo opposto a quello induttivo, è

presente nella storia della filosofia sin dai tempi di Aristotele; il filosofo greco riconosceva solo al

procedimento deduttivo nella forma sillogistica valore dimostrativo e dignità di rigore scientifico

attribuendo, peraltro, all’induzione una funzione del tutto subalterna e significato esclusivamente

pratico e strumentale.

In tempi più recenti la critica più profonda all’induzione ed agli assunti su cui essa si regge è dovuta

a David Hume. Per il filosofo inglese ( 1711-1766) tutti i ragionamenti induttivi sono riconducibili

alla relazione di causalità; questa non consegue da alcun ragionamento a priori, ma nasce proprio

dall’esperienza. L’inferenza dal passato al presente e al futuro si regge sul postulato dell’uniformità

della natura. Tale assunzione è essa stessa basata sull’induzione e quindi indimostrabile.

Dopo Hume il problema dell’induzione è rimasto senza speranza di soddisfacente soluzione. Hume

si muoveva nell’ambito di una conoscenza certa. Hans Reichenbach ha cercato soluzioni alla

questione nella nozione di conoscenza probabile e nel calcolo delle probabilità. Ma questo filosofo

non vede che il ricorso alla probabilità – in particolare, ma non solo, in una ottica frequentista –

deve comunque supporre una forma di regolarità nello svolgimento degli eventi.

Nella logica della ricerca (1935), Karl Popper analizza il punto di vista secondo cui le scienze

empiriche possono essere caratterizzate dal fatto di usare i cosiddetti metodi induttivi, intendendosi

con ciò una induzione che procede da osservazioni particolari, - campioni per gli statistici- ad

osservazioni universali, quali ipotesi o teorie. Popper ritiene che per giustificare il procedimento

induttivo si deve stabilire un principio di induzione che consenta di assegnare a tale procedimento

una forma logicamente accettabile. Rifacendosi a Hume, Popper conclude che la validità di tale

assunto poggia a sua volta su metodi induttivi, per legittimare i quali occorrerebbe assumere un

principio di induzione di ordine superiore; in tal modo il tentativo di basare l’induzione

sull’esperienza fallisce, perché conduce necessariamente ad un processo infinito. Popper assume , in

definitiva, una posizione più radicale di quella di Hume, di Reichenbach ed anche di quella di

Emanuel Kant, chiudendo con ogni tentativo di logica dell’induzione; afferma che la motivazione di

tale rifiuto va cercata proprio nel fatto che la logica induttiva non fornisce un contrassegno

appropriato per distinguere il carattere empirico, non metafisico di un sistema teorico.

Nelle nostre discipline in sostanza il problema che si pone è il seguente: come ottenere attraverso

esperienze limitate risultati e conclusioni che abbiano significato generale? L’inferenza statistica

studia per l’appunto i procedimenti induttivi, di natura logica e matematica, con i quali si perviene

a risultati e conclusioni di validità generale attraverso indagini condotte su un conveniente

sottoinsieme ( campione ) delle manifestazioni del fenomeno di studio ( Badaloni, 2002).

Nell’affrontare aspetti previsivi si ripresenta il problema logico di Hume: siamo autorizzati nel

ragionamento a passare da aspetti di cui abbiamo esperienza ad altri dei quali pure abbiamo

esperienza e da questi ad altri ancora di cui non abbiamo alcuna esperienza ? ( Popper, 1979).

Marbach (1991), nel trattare il problema della previsione, ritiene che la realtà sia costituita da un

sistema di stimoli e di accadimenti rivissuti ed ordinati nel pensiero. In tal modo si realizza il ponte

tra fatto e sua valutazione interna , ovvero “ metabolizzando “ un accadimento che quindi si

compone congiuntamente di avvenimenti, stimoli, ed aspettative. La macchina –Uomo agisce nella

prospettiva unificatrice passato - futuro, finalizzando il già accaduto agli eventi attesi ( sperati o

temuti. Nella elaborazione cosciente l’antinomia presunta tra accaduto e futuro si smorza.

Rimane, come scrive Frosini ( 2000), una grande distanza fra i processi ( conoscitivi ) induttivi

rispetto a quelli deduttivi.Nella deduzione non sono possibili errori- salvo che non si tratti di errori

materiali; se le regole di deduzione sono state correttamente applicate, la validità delle premesse

implica ( deduttivamente ) la validità della conclusione. Non così nell’induzione: il modello che

conduce a descrivere la verosimiglianza può descrivere in modo molto accurato la casualità

dell’esperimento in questione, ma possiamo essere stati sfortunati con l’estrazione di un campione

scarsamente rappresentativo della popolazione- per l’aspetto che ci interessa; in tal caso

l’inferenza, dal campione alla popolazione, non potrà evitare errori anche di grande rilievo. … è

comprensibile come l’induzione cerchi di rivestire i panni – per la verità un po’ stretti – forniti

dalla deduzione, nel tentativo di apparire più accettabile nella buona società e di nascondere i

propri difetti.

Sono cattivi maestri - secondo la mia opinione , ma ometterò in seguito questa precisazione – coloro

che insegnano l’inferenza statistica senza mettere chiaramente in evidenza che gli aspetti induttivi si

devono comunque confrontare con questioni logiche fondamentali, indipendentemente dal

linguaggio della presentazione o dall’eleganza della teoria e da eventuali errori ed incongruenze di

altre teorie.

Occorre distinguere, poi, le opinioni personali del docente e i contenuti del suo insegnamento; in

particolare qualora si tratti di corsi di formazione generale. Il docente deve mettere a disposizione

tutti gli strumenti di formazione critica per far sì che i discenti possano valutare comparativamente

le differenti alternative indipendentemente dalle sue preferenze ideologiche.

Quello che è in discussione è il comportamento del maestro, non il suo livello di certezza o di

appartenenza ad una scuola di pensiero.

Sono scimmiette – mi si perdoni questa espressione e la dizione cattivo maestro introdotte solo per

far sorridere un po’ e rendere più vivace, forse, l’esposizione – gli studiosi che dedicano tutta o

parte della loro ricerca al tentativo di mostrare la superiorità di alcune teorie di altri su

contrapponibili teorie sempre di altri.

1.2 Nella scienza, dopo adeguati periodi di studi ed approfondimenti, si giunge alla conclusione che

certi assunzioni non sono dimostrabili, alcune teorie non sono decidibili, certe impostazioni logiche

non hanno conferma dimostrazionale.

Alcuni esempi:

Per circa 2100 anni si è tentato di dimostrare il quinto postulato di Euclide partendo dagli altri

quattro. Nikolaj Ivanovi Lobaeskij , nella prima metà dell’ottocento, ha indagato sulle proprietà

di una geometria che non si basa sul quinto postulato.Con un articolo del 1829 egli fu il primo

matematico – ma sembra che Gauss e F.Bòlyai fossero arrivati quasi contemporaneamente agli

stessi risultati senza pubblicarli - a fare il passo rivoluzionario consistente nell’elaborare una nuova

geometria, oggi nota come geometria iperbolica, costruita su una ipotesi in contraddizione con il

postulato delle parallele. La geometria non euclidea è di interesse in molti rami della scienza , ed in

particolare in fisica. Le geometrie di Riemann, di grande interesse in matematica, sono non

euclidee.

Nelle nostre discipline la metrica dello spazio determinerà il tipo di geometria. Ad esempio la

metrica della città a blocchi implica la cosiddetta geometria del taxi (Rizzi,1985).

Sarebbe cattivo didatta colui che iniziasse ad insegnare le geometrie non euclidee e ne facesse

discendere quella euclidea come caso particolare. I giovani discepoli non lo seguirebbero!

Nell’insegnare la geometria euclidea, peraltro, va dato adeguato spazio all’apertura verso concetti

generali propri delle geometrie non euclidee.

Anche nella nostra disciplina, in qualsiasi tipo di insegnamento, si deve andare oltre qualche

formuletta stereotipata che fornisce inesistenti certezze al di fuori delle precise assunzioni di base

non sempre completamente dichiarate!

I fisici, dopo l’esperienza di Roemer che aveva effettuato nel 1675 una determinazione astronomica

della velocità della luce, hanno confutato l’opinione corrente, già messa in discussione da Galileo

Galilei, che tale velocità fosse infinita. I numerosi tentativi che cercavano di inquadrare i fenomeni

luminosi in uno schema unitario portarono alle formulazioni delle teorie corpuscolare da parte di

Newton e ondulatoria di Huygens. Più di duecento anni di ricerche e di polemiche tra giganti della

fisica tra i quali Maxwell, Plank, Hertz, Einstein, Compton, Bohr hanno mostrato la non

incompatibilità tra le due teorie.

Werner Heisenberg, nel 1925, elaborò la meccanica delle matrici, sviluppata successivamente da

M. Born e da P. Jordan, per descrivere un atomo senza fare intervenire concetti e quantità su cui a

priori non è possibile avere informazioni sperimentali. Una delle conseguenze che il grande fisico

ricavò fu, nel 1927, la deduzione del principio di indeterminazione secondo cui coppie di grandezze

( quali la posizione e la quantità di moto di una particella ) sono misurabili con un livello di

precisione che riguarda essenzialmente soltanto un elemento della coppia di variabili.

Ricordiamo, inoltre, l’affermazione di Heisenberg – apparsa in un articolo pubblicato su

Dialectica nel 1948 nelle pagine 333 e seguenti- Ne segue che noi non diciamo più “ la meccanica

di Newton è falsa “….Piuttosto ora usiamo la seguente formulazione: la meccanica classica …è

rigorosamente “ giusta “ dovunque i suoi concetti possono essere applicati.

Il principio di indeterminazione è di importanza fondamentale nella fisica; ma nell’insegnamento di

questa disciplina va introdotto solo a livello avanzato e, ad esempio, non nella presentazione della

cinematica.

Kurt Gdel nel 1931, matematico venticinquenne, pubblicò il breve lavoro ber formal

unentscheidbare Stze der “ Principia matematica” und Verwandter Systeme ( Sulle proposizioni

formalmente indecidibili e di sistemi affini ). Questo contributo costituisce una pietra miliare nella

storia della logica matematica. Nei due secoli precedenti il metodo assiomatico era utilizzato con

una potenza sempre crescente. Rami vecchi e nuovi della matematica, come la ben nota aritmetica

dei numeri interi ( o cardinali ), erano stati corredati con insiemi, apparentemente adeguati, di

assiomi. Si era creato un diffuso convincimento per il quale ogni settore della matematica potesse

essere fornito di un insieme di assiomi sufficienti per sviluppare correttamente l’infinita totalità

delle proposizioni vere nell’ambito di una data area di ricerca. Il lavoro di Gdel ha dimostrato

che questa ipotesi è insostenibile in quanto la coerenza di ogni sistema assiomatico è indecidibile.

Ma per insegnare l’aritmetica alle scuole secondarie si deve partire dalle ricerche di Gdel o

queste possono costituire solo un necessario completamento di un corso avanzato?

Il premio Nobel Kenneth Arrow, all’inizio degli anni ’50, dimostrò che non è possibile costruire un

dispositivo di aggregazione razionale, ad esempio nell’ambito dei sistemi elettorali che soddisfano

ad alcuni assiomi che sembrano logici. In altre parole, fissate alcune condizioni che, secondo il

buon senso comune, sembrano ragionevoli ed inoffensive, non esiste alcuna regola di decisione che,

nei casi non banali, le soddisfi. Le condizioni riguardano la possibilità di ordinare ogni insieme

coerente di preferenze individuali (unrestricted scope ), il principio di Pareto per il quale se un

individuo preferisce l’alternativa X ad Y , X deve precedere Y in un ordinamento crescente, un

principio che esclude l’esistenza di un dittatore che impone la sua preferenza e l’indipendenza delle

alternative. Naturalmente tra le condizioni poste da Arrow, non tutte sono ugualmente convincenti.

Il paradosso di Arrow, ha notevoli conseguenze di carattere logico - filosofico; da esso derivano

altri paradossi che mostrano, in casi particolari, forte incoerenza dei sistemi elettorali.

Esso non può impedire l’insegnamento dei sistemi elettorali dei diversi Paesi e la ricerca delle

affinità e differenze tra di essi. Non si deve considerare la base delle importanti analisi in tale

campo. Ci insegna, solo, che non esistono sistemi elettorali perfettamente coerenti.

Karl Popper (1984) nel Poscritto alla logica della scoperta scientifica, scritto nel periodo 1951-56

ma rimasto inedito per circa 25 anni, afferma che :

non c’è alcun metodo per scoprire una teoria scientifica;

non c’è alcun metodo per accertare la verità di una ipotesi scientifica, quindi non c’è modo

di verificarla;

non c’è alcun metodo per accertare se una ipotesi è probabile o probabilmente vera.

Egli aggiunge: Le teorie scientifiche si distinguono dai miti solo in quanto criticabili e suscettibili

di modifiche alla luce della critica. Non possono essere né verificate né rese più probabili.

Mentre Bacone riteneva che un esperimento cruciale possa rafforzare o verificare una teoria,

Popper affermava che esso può al massimo confutarla o falsificarla.

Popper insegnava queste teorie ai suoi studenti di un corso di filosofia della scienza.

Possono rientrare nei corsi di base delle facoltà scientifiche delle nostre università? Trattazioni

sommarie non rischiano di banalizzarle?

1.2.1 E’ di questi giorni l’uscita di una raccolta bilingue di scritti giniani, curata in tutti gli aspetti,

nel Supplemento al numero 1 del 2001 della rivista Statistica, con impulso di Italo Scardovi e di

altri studiosi della Scuola dell’università di Bologna.

La lettura degli scritti di Corrado Gini che appaiono nel volume non può non indurre riflessioni

profonde sulla genialità ed attualità di questo studioso che ha affrontato, tra l’altro, anche i

problemi dell’induzione negli aspetti generali e particolari, rifacendosi ai padri del calcolo delle

probabilità e dell’inferenza statistica. E’ con profonda partecipazione e commozione che si

leggono memorie fondamentali quali Intorno alle basi logiche e alla portata gnoseologica del

metodo statistico (1945), Rileggendo Bernoulli (1946 ), I test di significatività ( 1943), Postilla

metodologica (1961) , oltre al ben noto lavoro I pericoli della Statistica (1939).

2.1 Teorie probabilistiche

Le differenti definizioni di probabilità sono soggette a critiche da parte degli studiosi di questa

disciplina e di coloro che se ne avvalgono nelle ricerche nei più diversi campi.

La definizione classica ha il venenum nella specificazione della differenza tra casi ugualmente

possibili e ugualmente probabili. Il suo campo di applicabilità è limitato alle situazioni assimilabili

ai giochi dei dadi, delle carte,ecc. e quindi, ad esempio, in molti settori della tecnologia.

Spesso nella letteratura corrente si afferma che Laplace, tra le diverse concezioni di probabilità in

uso anche all’inizio del XIX secolo, aveva scelto quella classica con la implicita supposizione

dell’equiprobabilità dei casi possibili. Ma la attenta lettura del Saggio filosofico sulle probabilità

(1951) mostra che a Laplace, anche se non era stato del tutto esplicito, non era estranea la

definizione di probabilità come rappresentazione della informazione, e non di aspetti oggettivi pur

se incogniti.

La definizione frequentista ha il venenum nel concetto di limite su cui si basa, non rigorosamente

definibile. Si deve ricorrere ad essa in alcune situazioni del campo finanziario, nell’esame di aspetti

aziendali, nella teoria dell’ affidabilità e nel controllo statistico della qualità, ecc. Ma il suo ambito

di validità è più ridotto di quello di altre concezioni.

Tra i sostenitori della concezione frequentista si riconoscono diverse posizioni scientifiche. Il

denominatore comune è nella probabilità intesa come qualche cosa di oggettivo. Von Mises ha

proposto una definizione frequentista di probabilità che, di fatto, ha portato all’abbandono di quella

formulata da Laplace.

Sia la definizione classica sia quella frequentista sono operative, nel senso che individuano un

valore numerico della probabilità di un evento.

La definizione soggettiva della probabilità come grado di fiducia che una persona ha nel

verificarsi di un evento fa perdere la caratteristica assoluta di numero legato all’evento. La

definizione non è operativa e necessita di meccanismi che consentano di trasformare una opinione

in numero.Ciò si ottiene, ad esempio, con riferimento allo schema delle scommesse, imponendo

una condizione di coerenza. Il venenum è’ proprio in questo tipo di trasformazione.

Ritenere equa una scommessa non implica essere poi disposti a scommettere. Provino gli scettici a

far scommettere un gestore finanziario o qualsiasi altro professionista delle decisioni! Ma questa

critica non è accettata dai soggettivisti. Ad esempio, Di Bacco (2001) afferma che per esprimere la

propria opinione con questa impostazione non occorre che la scommessa sia fatta per davvero,

come non è necessario disporre di una pentola d’acqua per esprimere in calorie ciò che è noto circa

il valore energetico di un quarto di pollo arrosto.

L’impostazione assiomatica di Kolmogorov ( 1933), al di là della sua eleganza matematica, non

risolve tutti i problemi delle applicazioni del calcolo delle probabilità. Deve osservarsi (Landenna –

Marasini, 1986 ) che, diversamente da Kolmogorov, né classici né frequentisti chiamano in causa la

-algebra anche se poi, in pratica, ricorrono ad essa o ritenendola del tutto naturale o giustificandola

con motivazioni di vario tipo. Le critiche all’impostazione di Kolmogorov si estendono anche alla

definizione di eventi condizionati, dedicando ad essa una attenzione marginale.

Abbiamo riletto alcuni importanti volumi pubblicati recentemente in Italia da noti studiosi di

Calcolo delle probabilità, citati in bibliografia. Non abbiamo riscontrato sostanziali differenze

tecniche nello sviluppo dell’esposizione della disciplina, pur nella diversità degli argomenti trattati

e degli approfondimenti teorici che caratterizzano questi volumi. Ad esempio, nel bel libro di

Dall’Aglio (2000) l’impostazione soggettiva e il teorema di Bayes costituiscono una parte assai

ridotta dell’opera.

Le differenze tra l’ impostazione cosiddetta classica o oggettiva e quella soggettiva, scrive

Dall’Aglio, portano a conclusioni del tutto diverse in particolare nell’induzione o inferenza

statistica . L’impostazione oggettiva, detta ora anche “classica”, si basa sulle sole verosimiglianze,

e per giungere a delle conclusioni introduce criteri di scelta che hanno giustificazioni intuitive ma

non logiche. L’impostazione soggettiva, detta anche “bayesiana” o “neo-bayesiana“, si basa, come

dice il nome sul teorema di Bayes.

Anche il libro di Scozzafava (2001) , indipendentemente dalla dichiarata intenzione di recuperare in

una impostazione soggettiva la visione classica e quella frequentista, ovviamente per quei

particolari tipi di eventi ai quali esse sono applicabili, propone una visione concreta del calcolo

delle probabilità, propedeutica o integrativa per corsi universitari di probabilità e statistica non

basati sulla concezione soggettiva.

Nella presentazione della disciplina i libri di probabilità rimangono sostanzialmente indipendenti

dalla posizione assunta riguardo alla definizione di probabilità.

In molti di questi libri, ad esempio, non si parla di scambiabilità e del teorema di rappresentazione

di de Finetti ( 1937 ). Questo importante teorema mostra che, in condizioni molto generali di

scambiabilità, ogni successione di variabili che possono assumere solo le determinazioni 0 e 1 può

essere rappresentata come miscuglio di variabili aleatorie di Bernoulli.

Tale presentazione del teorema può considerarsi caso particolare della formulazione più ampia in

base alla quale se le variabili aleatorie Xi sono scambiabili, ossia se la distribuzione di un qualsiasi

sottoinsieme Xi1, Xi2, … ,Xin non dipende dagli indici i1,i2,…,in -ossia dall’ordine delle variabili

scelte - ma dal loro numero n, allora esiste una quantità aleatoria θ tale che, condizionatamente a

questa , ogni n-pla X1, X2, …,Xn é costituita da variabili indipendenti e somiglianti.

Tale teorema riveste grande importanza in una ottica bayesiana, in quanto riesce a spiegare il

significato del parametro sulla base delle caratteristiche assunte circa le variabili osservabili,

proprio perché la sua distribuzione viene definita per mezzo delle variabili aleatorie osservabili (

Piccinato, 1996).

E’ indubbio che assume un ruolo fondamentale in Statistica se ci si pone il problema di come si

possono interpretare le probabilità oggettive incognite in ambito soggettivista e, più in generale, di

come si possono giustificare i modelli che sono alla base delle elaborazioni inferenziali standard.

E’ forse inutile sottolineare che il teorema di rappresentazione di de Finetti ha validità generale,

non legata alla sola impostazione bayesiana. Si tratta di un importante risultato della teoria della

probabilità, il quale mostra che una funzione di probabilità è simmetrica se e solo se è una mistura

di probabilità bernoulliane.

Forse è bene che non si consideri il teorema di rappresentazione l’asse portante di una sola

impostazione probabilistica. Oggi esso ha maggiore spazio nelle trattazioni bayesiane ( BernardoSmith, 1994).

2.2 L’inferenza statistica

Nella storia dello sviluppo dell’inferenza statistica si possono individuare tre fasi ( de Finetti, 1959).

Nella prima si affermò rapidamente la teoria bayesiana; vi furono alcune ingenuità nell’applicazione

che comportarono qualche discredito e persino l’abbandono della Teoria. Le critiche principali

hanno riguardato il principio di indifferenza o postulato di Bayes, che assegna come distribuzione

a priori quella uniforme. Non si era compreso che l’utilizzo della distribuzione uniforme riguardava

solo un caso del tutto particolare.

L’impostazione bayesiana, quindi, non è la più recente. Fu il grande Pietro Simone Laplace (17491827) che diede molta importanza al lavoro di Thomas Bayes ( 1702 –1761 ). Questo ministro del

culto presbiteriano, che era solo un dilettante della matematica, non si era reso conto,

probabilmente, della rivoluzione da lui innescata. Laplace, nella seconda edizione de la Teorie

analytique des Probabilitès del 1814, introdusse le probabilità a priori diverse.

Nella prima metà del XX secolo de Finetti, Savage, Lindley e molti altri studiosi hanno proseguito

l’opera di Laplace dando origine alla Statistica bayesiana.

Nella seconda fase si è sviluppata la Scuola classica, con i fondamentali contributi di Ronald

Aylmer Fisher, di Karl Pearson,di suo figlio Egon Sharpe Pearson, di Jerzy Neyman. Questa scuola

si avvale del principio della massima verosimiglianza e della ripetizione degli esperimenti.

La Teoria della stima si può far risalire alla prima pubblicazione di Ronald Fisher dell’aprile 1912,

in cui l’autore utilizza il principio della massima verosimiglianza senza ancora menzionarlo; il

metodo è stato sviluppato e divulgato in due importanti articoli del 1922 e 1925 ( On the

Mathematical Foundations of Theoretical Statistics – Phil.Trans. Royal Society, A.222 – Theory of

Statistical Estimation - Proc.Comb.Phil.Soc. 22- ). Al di là dell’importanza delle metodologie

introdotte, per la prima volta è proposto un modello di inferenza statistica che contiene i tre principi

fondamentali della verosimiglianza, dell’esaustività e dell’informazione.

Nel primo dei due lavori di Fisher è scritto - nella nostra traduzione in italiano -: L’oggetto del

metodo statistico è la riduzione dei dati. Una massa di dati deve essere sostituita da un piccolo

numero di quantità che rappresentano correttamente questa massa e che devono fornire il massimo

di informazione pertinente contenuta nei dati originari. Questo obiettivo si raggiunge con la

costruzione di una popolazione ipotetica infinita. La statistica comporta dei problemi di

specificazione che sorgono nella scelta della forma matematica della popolazione, problemi di

stima,che implicano la scelta del metodo di calcolo delle quantità derivate dal campione, che noi

chiameremo “ statistiche “, costruite per stimare i valori dei parametri della popolazione ipotetica

ed infine i problemi di distribuzione.

La forza del ragionamento fisheriano che è il fondamento della teoria dei test è costituito dalla nota

affermazione o si è verificato un evento molto raro oppure la ipotesi della casualità è falsa. Tale

struttura è costante in questa teoria dei test di significatività.

Il concetto di test di ipotesi e la sottostante metodologia appaiono dopo la teoria della stima, nel

periodo 1926 –1930.

Karl Pearson, nel 1900, aveva già introdotto il test 2 di adattamento ad una legge di probabilità

nota ; George Yule, assistente di Karl Pearson, e Ronald Fisher avevano individuato i gradi di

libertà di questo test. Neyman e Pearson ( figlio di Karl ) sviluppano le loro argomentazioni nella

convinzione che nessun test statistico possa dimostrare la verità di una data ipotesi.

Non ci soffermiamo sui diversi aspetti di queste teorie, peraltro ben note agli studiosi. Vogliamo

solo ricordare che Neyman contrappone polemicamente il comportamento induttivo da lui seguito

al ragionamento induttivo di Fisher. Neyman, ricollegandosi al classico metodo ipotetico deduttivo,

distingue tre momenti nel procedimento induttivo:

l’individuazione delle ipotesi rilevanti per i fenomeni in analisi;

la deduzione delle conseguenze osservative delle ipotesi;

la decisione, sulla base dei risultati sperimentali, di accettare o rifiutare l’ipotesi formulata.

E’ in relazione a questo ultimo momento che Neyman ritiene il metodo fisheriano carente, poiché

verrebbe ammesso un nesso di implicazione logica tra i risultati sperimentali e le conclusioni

riguardanti le ipotesi. Per Neyman il terzo momento del procedimento induttivo rinvia ad un atto di

volontà che si concretizza in una decisione relativa ad un comportamento da adottare. E’ questa

linea operativa che caratterizza il processo induttivo come comportamento e non come

ragionamento. Chi decide, però, deve tener presente la possibilità di compiere due tipi di errore, i

ben noti errori di prima e seconda specie, che implicano di respingere una ipotesi vera o accettare

una ipotesi falsa.

E’ cattivo maestro chi critica la teoria classica o quella bayesiana nelle diverse impostazioni e

ritiene, in tal modo, di risolvere i problemi logici della verifica delle ipotesi con formalizzazioni ed

impostazioni anch’esse criticabili.

Nella terza fase delle ricerche sull’inferenza statistica affiorano le insufficienze dell’impostazione

classica, si rivedono i giudizi sulle teorie bayesiane, si afferma il neo-bayesianesimo. Sono

fondamentali i contributi di de Finetti, che con i Suoi lavori ha influenzato ed influenza la ricerca

statistica che va sotto il nome di bayesiana.

La funzione di verosimiglianza costituisce il criterio inferenziale intorno a cui è costruita la

cosiddetta Teoria del supporto ( Frosini, 2000). Secondo il principio di verosimiglianza, all’interno

di un modello statistico valido per un esperimento casuale tutta l’informazione ottenibile da un

campione per decidere la preferenza da accordare ad una fra due ipotesi è contenuta nel rapporto di

verosimiglianza calcolato sulle due ipotesi, dato il campione.

Poiché una verosimiglianza non interessa in sé e per sé, ma solo in quanto rapportata o rapportabile

a un’altra verosimiglianza, in genere si definisce la funzione di verosimiglianza a meno di una

costante moltiplicativa che non ne altera le caratteristiche operative. Tale artificio matematico può

essere sfruttato sia ignorando, nella espressione della verosimiglianza, tutti i fattori che non

dipendono dal parametro di interesse in modo tale da semplificare la formula stessa, sia rapportando

tutte le verosimiglianze al massimo o all’estremo superiore della stessa verosimiglianza, in modo da

ottenere un valore normalizzato variabile tra zero ed uno.

L’importanza della funzione di verosimiglianza nel ragionamento statistico, scrive Piccinato (1996

pag.147) , è stata riconfermata in tempi più recenti anche in una prospettiva bayesiana, pur non

avendo conseguito un riconoscimento unanime nella letteratura scientifica. Il ruolo

dell’esperimento è proprio quello di attribuire alle diverse ipotesi possibili un peso determinato

completamente ed esclusivamente dal risultato; in definitiva il risultato dell’esperimento è la

funzione di verosimiglianza stessa. Allo scopo di rendere precise le discussioni e i confronti sui

fondamenti logici delle diverse procedure inferenziali, è stato anche formalmente definito ( da A.

Birnbaum,1962 ) un Principio di verosimiglianza che esprime in modo particolarmente chiaro ed

operativo il concetto della centralità della funzione di verosimiglianza nel senso delineato.

Piccinato aggiunge: la funzione di verosimiglianza, nel quadro del modello adottato, incorpora

tutta l’informazione prodotta dall’esperimento relativamente al parametro . Il principio non dice

invece – e resta in certo senso un problema aperto- come vada elaborata tale informazione per

risolvere i problemi inferenziali. Ed ancora…La più importante impostazione alternativa rispetto

allo schema verosimiglianza-Bayes fin qui descritto, e probabilmente ancora la più diffusa

(almeno mettendo insieme le diverse varianti ), è quella che si può ricondurre dal punto di vista

logico al Principio del campionamento ripetuto…Le procedure statistiche debbono essere valutate

per il loro comportamento in ripetizioni ipotetiche dell’esperimento che si suppongono eseguite

sempre nelle stesse condizioni.

Nel condividere, nella sostanza, le indicazioni di Piccinato, non si possono dimenticare le possibili

critiche a tale impostazione. Inoltre il ruolo della funzione di verosimiglianza è diverso a seconda

dell’impostazione logica adottata.

Tommaso Salvemini (1974), con la consueta chiarezza, afferma: Rinunciando quindi a chiedere

con quale probabilità un certo evento che si sia già verificato possa essere frutto, ad esempio, del

caso, per risolvere i problemi di inferenza statistica ripiegheremo, come propone il Pompilj, sul

concetto di conformità delle osservazioni o degli esperimenti alle ipotesi stabilite, nel senso che tra

più ipotesi possibili si sceglierà quella verso cui i risultati dimostrano maggiore conformità.

2.2.1. La Società Italiana di Statistica ha sempre avuto parte attiva, sin dalla sua fondazione nel

1939, nel promuovere o incoraggiare il dibattito sui diversi approcci all’inferenza statistica, come

dimostrano i molti incontri scientifici, a partire dalla Tavola rotonda di Poppi del 1966.

Nell’ambito del Comitato per lo studio dei recenti sviluppi dei metodi statistici nell’approccio

all’inferenza statistica istituito dalla SIS nel 1979, un gruppo di studiosi costituito dai compianti

professori Alighiero Naddeo ed Amato Herzel e da Giampiero Landenna, Pieralda Ferrari, Donata

Marasini condusse una analisi critica del lavoro di Ian Hacking, che partecipò alla discussione

finale.

Nella Logic of Statistical Inference, Hacking esamina in maniera critica, da un punto di vista logico

filosofico, i differenti approcci che hanno caratterizzato il secolo scorso. Il lavoro prende origine

dalle ricerche di Sir R.A. Fisher e di molti altri autori.

I principali strumenti che vengono utilizzati sono:

long run frequency or change;

change set- up;

supporto;

verosimiglianza ;

la legge di verosimiglianza.

Con tali strumenti Hacking imposta la sua ingegnosa teoria dell’inferenza statistica. Ma gli statistici

non accettano l’unicità di tale impostazione. Comunque non si evitano le questioni fondamentali

della induzione.

Nella suddivisione – forse troppo scolastica - dell’inferenza statistica in stima puntuale, stima per

intervalli e verifica delle ipotesi, i problemi logici maggiori sorgono proprio per il significato da

dare agli intervalli di confidenza e alla verifica delle ipotesi. Per quanto riguarda la stima dei

parametri le proprietà che usualmente ad essi si richiedono – sufficienza, efficienza, consistenza,

non distorsione – non esauriscono l’insieme delle proprietà auspicabili per uno stimatore.

2.2.2 In molte situazioni di ricerca - ed in particolare per le applicazioni in campo socio economicoi dati sono rilevati in modo non esattamente definito, presentano margini di errore anche di tipo

materiale dovuti a molteplici cause, - tra le quali ad esempio quelle relative alla trascrizione sui

supporti di rilevazione sia di tipo cartaceo sia magnetico, ad errate risposte, a dati mancanti ecc. - .

Le ricerche sulla robustezza sono di importanza fondamentale per le applicazioni. Per molti

parametri sappiamo costruire la curva di influenza, ossia la curva che, in qualche modo, misura

l’effetto di contaminazioni sul campione, descrivendo, quindi, il comportamento locale di uno

stimatore.

E’ cattivo maestro colui che mostra l’eleganza matematica della teoria della stima e si dimentica di

porre l’accento anche sugli aspetti della robustezza e sulla validità operativa dei risultati. L’errore

non campionario ha, in molte situazioni di ricerca, peso di gran lunga superiore a quello

campionario. Occorre renderne completamente edotti i discenti con esemplificazioni ed applicazioni

che si riferiscono a situazioni operative e non di laboratorio.

2.3 Cattivi maestri sono coloro che ritengono di insegnare una sola teoria mettendo in cattiva luce le

ricerche degli altri, con considerazioni affrettate, spesso non adeguatamente documentate, a volte in

maniera faziosa, utilizzando argomentazioni discutibili. Spesso sono aiutati da scimmiette, studiosi

talora alle prime armi che scelgono di dedicarsi ad una teoria, in base a scelte politiche di

convenienza di varia natura (accademica, di appartenenza a gruppi consolidati, ecc).

Noi riteniamo che il dibattito sull’inferenza statistica sia oggi sufficientemente maturo per poter

accettare l’idea che non vi sia una presentazione superiore alle altre in assoluto e per tutti gli

aspetti. Non vi è una teoria vera da contrapporre a tutte le altre che sarebbero quindi false.

Nessuna può risolvere il problema generale dell’induzione. .

Sarebbe cattivo maestro colui che dedicasse tutte le sue energie a dimostrare la verità della

impostazione scientifica prescelta in contrapposizione alle altre, non impegnandosi, invece, a

mostrare i limiti e la validità della teoria anche con riferimento alle applicazioni ed alle sue

personali convinzioni.

2.3.1 Caratteristica fondamentale del modo di ragionare della logica del probabile è quello di

valutare la probabilità delle diverse conclusioni possibili quando si fa inferenza, indipendentemente

dai dati osservati; tra questi e le possibili conclusioni intercorre una relazione che non è di tipo

logico-deduttivo. Sulla base dei dati non è possibile accettare o respingere una ipotesi. L’analisi

dei dati provenienti da osservazioni o esperimenti ha l’obiettivo di acquisire conoscenze su

fenomeni che si ritengono, in qualche modo, parzialmente o totalmente descritti dai dati stessi.

In questo contesto non c’è posto per visioni meccanicistiche che demandano a strumenti neutri

decisioni proprie del ricercatore, del manager o quant’altro. La risposta di uno o più test statistici,

qualsiasi sia la teoria che giustifica lo strumento di cui ci si avvale, non potrà, da sola, indurre un

ricercatore medico a cambiare tipo di terapia o un gestore finanziario ad effettuare un tipo di

investimento in contrapposizione ad un altro. Peraltro a me sembra che questi aspetti siano ormai

conoscenza comune di chi si avvale del metodo statistico in maniera appropriata.

Pericoli derivano proprio dalla larga diffusione del software statistico che, se utilizzato da persone

aventi scarsa conoscenza dei problemi di cui qui discutiamo, possono portare a conclusioni

meccanicistiche avulse da ogni riflessione critica.

Gli schemi basati sugli esperimenti non esauriscono, poi, il processo di acquisizione ed

elaborazione delle informazioni. Nelle scienze socio-economiche i dati non derivano da esperimenti

programmati e condotti con rigore scientifico. In questi casi la validità dei risultati derivanti

dall’applicazione della teoria dei test è veramente problematica.

2.3.2 Suppes (1984, pag. 74-76) scrive:… la logica non rende assolutamente conto dei

ragionamenti inferenziali che si trovano nei migliori e più accurati trattati. Se alla inferenza logica

aggiungiamo ora l’inferenza bayesiana, giungiamo alle medesime conclusioni: non appare

possibile costruire un processo inferenziale in termini logici o bayesiani. Se identifichiamo

l’inferenza bayesiana con una estensione della logica, allora tendiamo ad isolare l’approccio

bayesiano dalla effettiva pratica scientifica più di quanto vorrebbero i bayesiani come de Finetti e

Savage.…. Per prendere in seria considerazione la pretesa bayesiana di rendere conto in maniera

completa o quasi completa di ogni tipo di apprendimento dall’esperienza, occorrerebbe un tipo di

argomento decisivo che non è sinora disponibile. Dobbiamo dunque lasciare ampio spazio ad altri

metodi, anche di natura normativa….. In conclusione, penso che l’approccio bayesiano abbia un

ruolo importante ma limitato, nel panorama delle attività umane…..ma dovrebbe essere evidente

che nessun altro approccio ai fondamenti della statistica offre prospettive altrettanto ricche.

Il teorema di Bayes può essere assunto come la regola fondamentale per imparare, in molte

situazioni, dall’esperienza: fornisce una base quantitativa che consente di modificare una opinione

iniziale sul verificarsi di un evento, espressa nella forma delle probabilità iniziali, alla luce

dell’informazione descritta dalle verosimiglianze, per formarsi una nuova opinione sullo stesso

evento, quantificabile nella forma di probabilità finali.

Non tutti i fenomeni di apprendimento sono riportabili al teorema di Bayes; si pensi, ad esempio,

alla capacità di distinguere oggetti, alle abilità manuali, ad alcune regole di comportamento sociale.

A nostra opinione il difetto maggiore del bayesianesimo – che costituisce una indubbiamente una

importante teoria scientifica- è nella pretesa di voler riportare ogni ragionamento inferenziale, ogni

definizione di probabilità, nel proprio ambito.

3. Il progresso della scienza si basa su scoperte, risultati, intuizioni molto particolari, almeno in un

primo momento. Gli esempi quasi esauriscono la storia della scienza. Occorre stimolare nei giovani

anche il gusto dei piccoli risultati, delle teorie applicabili a situazioni specifiche, farli riflettere

sull’impossibilità che ogni ricerca trovi risultati aventi carattere universale. Anche i grandi della

scienza si sono cimentati su casi particolari, hanno contributo a chiarire situazioni specifiche, hanno

portato, in alcune ricerche, contributi non eccezionali, si sono dedicati a quella che Khun chiama

scienza normale.

Ricordo quanto ha scritto Dario Fürst nel suo scritto : de Finetti e l’insegnamento della

matematica ( de Finetti, 1993, pag.28):

Forse tutto il pensiero di de Finetti in tema di insegnamento della matematica – e noi aggiungiamo

della Statistica e del Calcolo delle probabilità– si potrebbe condensare in queste poche parole: fare

in modo che lo studente senta che l’astrazione, l’assiomatizzazione, la formalizzazione siano il

coronamento delle sue esperienze, un modo di inquadrare e semplificare ciò che ha già

appreso,non di complicarli, un modo di scoprire l’unità sotto l’apparente diversità; fare di tutto ciò

un punto di arrivo e non di partenza, come sempre è avvenuto nella storia del pensiero matematico.

Come autorevolmente affermano Italo Scardovi e Paola Monari (1984) : la storia delle metodologie

induttive è la storia di un lungo dibattere il ruolo delle conoscenze a priori, dei paradigmi esistenti;

un continuo ripensare il nesso dialettico tra dato e ipotesi, tra realtà sperimentale e schema

formale, e un ricorrente illudersi sulla possibilità di una codificazione in astratto del rapporto

euristico tra modello teorico ed evidenza empirica. Se la storia della scienza è considerata come

una successione o sostituzione di vecchi paradigmi con nuovi, il ruolo dell’a-priori può solamente

cambiare in accordo con lo stato delle teorie dominanti del pensiero scientifico.

E’ cattivo maestro colui che insegna la Statistica, sia essa l’analisi dei dati o l’inferenza o le

statistiche cosiddette applicate, o il Calcolo delle probabilità, seguendo schemi astratti ed

apparentemente generali come punto di partenza e non di arrivo. Ma in tal caso, come suggerisce

Piccinato, si deve parlare piuttosto di cattivo didatta!

E’ scimmietta lo studioso – giovane o meno giovane – il quale si affanni a mostrare, con

considerazioni ed esempi, che alcune posizioni scientifiche sono superiori ad altre, con spirito di

appartenenza a gruppi o scuole di pensiero, sopraffatto dall’ansia di omologarsi alle stesse.

Riferimenti bibliografici

AAVV (1966), Atti della Tavola rotonda su: I fondamenti del Calcolo delle probabilità, tenuta a

Poppi. Scuola di Statistica dell’Università, Firenze

AAVV (1978), Atti del convegno su: Induzione, Probabilità, Statistica..Università degli studi di

Venezia

AAVV (1978), Atti del convegno:I fondamenti dell’inferenza statistica. Dipartimento statistico.

Università degli studi di Firenze

AAVV (1983), Atti della Tavola rotonda su: I fondamenti dell’analisi dei dati, Istituto di Statistica e

Ricerca sociale “ C. Gini”, Cisu

AAVV (1982 ? ), Critical Analysis of Ian Hacking’s Book “Logic of Statistical Inference”, Società

Italiana di Statistica, Committee for the study on recent developments of statistical

methods in the approach to inference

Badaloni M. (2002 ), Teoria dell’inferenza statistica, Dipartimento di Statistica, Probabilità e

Statistiche applicate, Università di Roma “ La Sapienza “

Berardo J.M.-Smith,A.F.M. (1994), Bayesian Theory, Wiley

Brizzi M. (2000), Calcolo delle probabilità con note introduttive di inferenza statistica, editrice Lo

Scarabeo, Bologna

Cifarelli D.M.-Muliere P. (1989), Statistica Bayesiana, Iuculano

Costantini D.- Geymonat L. ( 1982 ), Filosofia della probabilità, Feltrinelli

Costantini D.-Scardovi I. ( a cura di ) (1999), Quanti e statistica, Rivista Statistica,anno LIX,

Daboni L-Wedlin A. (1981), Statistica. Un’introduzione alla impostazione neo-bayesiana, Utet.

Dall’Aglio G. (2000), Calcolo delle probabilità, Zanichelli

de Finetti B. (1937), La prevision :ses lois logiques, ses sources subjectives, Ann. Inst. H.Poincar,

7,1-68

de Finetti B. (1970) , Teoria della probabilità, Giulio Einaudi editore Einaudi

de Finetti B. (1959), La probabilità e la statistica nei rapporti con l’induzione, secondo i diversi

punti di vista, Atti del corso CIME su : Induzione e statistica, Varenna

de Finetti B. (1993) a cura di P.Monari e Cocchi D., Probabilità e induzione, Biblioteca di

Statistica, Cleub, Bologna

Di Bacco M.-Frederic P. (2001), Introduzione al calcolo delle probabilità, Pitagora editrice,

Bologna

Feyerabend P.K. (1979), Contro il metodo, Feltrinell

Frosini B.V. (2000), Introduzione alla Statistica, Carocci

Geymonat L. (1977), Scienza e realismo, Feltrinelli, Milano

Ghirardi G..C. (1997), Uno sguardo alle carte di Dio, Il saggiatore, Milano.

Gini C. (2001), Statistica e induzione, Biblioteca di Statistica, CLEUB, Bologna

Landenna G.-Marasini D.(1986), Uno sguardo alle principali concezioni probabilistiche, Giuffrè,

Laplace P.S. (1951), Saggio sulle probabilità, Laterza, Bari

Lessi O.(1993), Corso di probabilità, Metria

Lindley D.(1990), La logica della decisione, Il Saggiatore

Mackay A.F. (1980), Arrow’s Theorem :The paradox of social choice, Yale Universty Press

Marbach G.(1991). La problematica delle previsioni, in G. Marbach, G. Mazziotta, A.Rizzi, Le

previsioni: fondamenti logici e basi sintetiche, EtasLibri

Nagel E.-Newman J.R. (1961), La prova di Gdel, Paolo Boringhieri,1961

Piccinato L.(1996), Metodi per le decisioni statistiche, Springer

Pompilj G. (1952), Teoria dei campioni, Veschi, Roma

Popper K. (1969), Scienza e filosofia, Einaudi.

Popper K. (1979 , Objective knowledge, Clarendon,Oxford

Popper K. (1984), Poscritto alla logica della scoperta scientifica, vol. 1 e 2, Il Saggiatore

Rizzi A. (1985), Analisi dei dati. La Nuova Italia scientifica

Rizzi A.(1991), Inferenza statistica, Utet.

Salvemini T. (1974), Lezioni di Statistica, Cacucci, Bari

Sandrini M.G.,(1998), Logica della ricerca:Introduzione critica ai metodi di inferenza statistica,

Carocci.

Scardovi I.-Monari P. (1984), Statistical Induction:Probabile Knoledge or Optimal Strategy? In

Epistemologia,VII,1984,pp.102-120

Scozzafava R.(2001), Incertezza e probabilità, Zanichelli

Suppes P.(1984), La logica del probabile, Cleub, Bologna