UNIVERSITÀ DEGLI STUDI DI PARMA

Facoltà di Scienze Matematiche, Fisiche e

Naturali

Corso di laurea triennale in Informatica

Tesi di Laurea

Accesso a basi di dati con una piattaforma

ORM

Candidato:

Simone Bianchi

Relatore:

Chiar.mo Prof. Giulio Destri

Co-relatore:

Ing. Alberto Picca

Anno accademico 2008—2009

Ringraziamenti

Desidero innanzitutto ringraziare il Prof. Giulio Destri e l’Ing. Alberto Picca per la disponibilità in modo più assoluto avuta e per avermi permesso lo

svolgimento del mio stage formativo presso la ditta Area Solutions Provider

ubicata a Casalmaggiore—Parma. Ho appresso le basi per lo sviluppo di software a livello professionale e impostando la stesura della mia tesi. Ringrazio

Carlo e Donatella in modo speciale per essermi stato molto vicini e per avermi

supportato materialmente e moralmente. Un altro grosso ringraziamento va

ad Adamo, Stina e Paolo per essermi stati vicini. Ringrazio i miei compagni di

Università Maria Chiara, Davide, Fede, Marina, Cecilia, Paolo, Fabio, Sparty,

Alessandro U., Alessandro T., Lucia, con cui ho passato questi anni di studio

insieme. Desidero ringraziare anche altri miei amici, in modo speciale Stefano

e Marcello, per tutta la disponibilità e l’amicizia avuta nei miei confronti.

Desidero concludere con un sentimento che offro a tutti quelli che come me,

cercano di raggiungere obiettivi che sono importantissimi nella vita. Lo studio

è uno strumento e la cultura ne fa padrona. I CARE, concludo con questa

semplice frase che significa Me ne importa. Ho voluto scrivere questa frase

perchè credo che per fare una cosa bisogna che te ne importi, se no diventa

una cosa fatta male e non ti servirà a niente nella crescita personale di ognuno

di noi.

i

Indice

Ringraziamenti

i

Indice

iii

Introduzione

Il contesto del problema . . . . . . . . . . . . . . . . . . . . . . . . .

1 Il problema della persistenza

dei dati

1.1 Programmazione orientata agli oggetti . . . . . .

1.2 Persistenza dei dati . . . . . . . . . . . . . . . . .

1.3 Survey sulle soluzioni esistenti per la persistenza

1.4 L’importanza dei RDBMS . . . . . . . . . . . . .

1.5 Modello a oggetti vs modello relazionale . . . . .

1.6 Il disaccoppiamento di impedenza . . . . . . . . .

1.7 Le soluzioni possibili . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Architetture software a oggetti

2.1 I Design Pattern . . . . . . . . . . . . . . . . . . . . .

2.2 Il pattern MVC nella progettazione software . . . . . .

2.3 Le architetture stratificate ed i loro vantaggi . . . . . .

2.4 Classi ed oggetti entità . . . . . . . . . . . . . . . . . .

2.5 Algoritmi e strutture dati . . . . . . . . . . . . . . . .

2.6 Classi ed oggetti contenitori . . . . . . . . . . . . . . .

2.7 Le soluzioni informatiche dato-centriche . . . . . . . .

2.8 Gli ORM ed il loro ruolo . . . . . . . . . . . . . . . . .

2.9 Implementazione di un ORM : Il pattern Data Mapper

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

v

v

.

.

.

.

.

.

.

1

1

4

6

8

12

13

14

.

.

.

.

.

.

.

.

.

18

18

22

23

26

29

39

44

49

50

3 Soluzioni nel mondo .NET: Nhibernate

51

3.1 Il mondo .NET . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

3.2 Le DataTable e le loro caratteristiche . . . . . . . . . . . . . . . 54

3.3 Rappresentazioni in memoria: DataTable vs ArrayList di oggetti entità . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

3.4 Introduzione a Nhibernate . . . . . . . . . . . . . . . . . . . . . 59

3.5 Scenari di applicazione . . . . . . . . . . . . . . . . . . . . . . . 70

iii

iv

4 Realizzazione del mapper automatico per Nhibernate

4.1 UML e metodologie per la progettazione del software . .

4.2 Obiettivi del progetto . . . . . . . . . . . . . . . . . . .

4.3 Analisi, progettazione ed implementazione . . . . . . . .

4.4 Il progetto compiuto . . . . . . . . . . . . . . . . . . . .

Indice

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

82

82

87

88

92

5 Realizzazione del prototipo operativo

109

5.1 Le entità e la base di dati utilizzata . . . . . . . . . . . . . . . 109

5.2 Versione con Query automatiche . . . . . . . . . . . . . . . . . 111

5.3 Versione con Nhibernate . . . . . . . . . . . . . . . . . . . . . . 123

6 Confronto di prestazioni

129

7 Conclusioni

150

7.1 Bilancio del lavoro svolto . . . . . . . . . . . . . . . . . . . . . 150

7.2 Esperienze e conoscenze acquisite . . . . . . . . . . . . . . . . . 150

7.3 Espansioni future . . . . . . . . . . . . . . . . . . . . . . . . . . 150

Bibliografia

152

Introduzione

La presente tesi di Laurea Triennale è stata sviluppata dal candidato dopo

un periodo di tirocinio svolto presso l’azienda informatica Area Solutions

Providers S.r.l., nella sede operativa Lombardia Est ed Emilia, sotto il coordinamento dell’Ing. Alberto Picca, e con la supervisione del Prof. Giulio

Destri.

Il contesto del problema

Nello sviluppo di sistemi informatici si sono affermate numerose tecnologie,

che vanno utilizzate in modo combinato e, possibilmente sinergico.

Da una parte, i sistemi di gestione di basi di dati relazionali consentono

una gestione efficiente ed efficace di dati persistenti, condivisi e transazionali [1]. Dall’altra, gli strumenti e i metodi orientati agli oggetti (linguaggi di

programmazione, ma anche metodologie di analisi e progettazione) consentono

una sviluppo efficace della logica applicativa delle applicazioni [2].

È utile in questo contesto spiegare che cosa s’intende per sistema informativo e sistema informatico.

• Sistema informativo: L’insieme di persone, risorse tecnologiche, procedure aziendali il cui compito è quello di produrre e conservare le informazioni che servono per operare nell’impresa e gestirla. (M. De Marco

in [3])

• Sistema informatico: L’insieme degli strumenti informatici utilizzati

per il trattamento automatico delle informazioni, al fine di agevolare le

funzioni del sistema informativo. Ovvero, il sistema informatico raccoglie, elabora, archivia, scambia informazione mediante l’uso delle tecnologie proprie dell’Informazione e della Comunicazione (ICT ): calcolatori, periferiche, mezzi di comunicazione, programmi. Il sistema

informatico è quindi un componente del sistema informativo.

La costruzione dell’informazione ed il suo uso entro l’azienda può avvenire

seguendo questi passi, in base alla classificazione di G. Bellinger, N. Shedroff

ed altri, definita in [4] e [5]:

• Dati: I dati sono materiale informativo grezzo, non (ancora) elaborato

da chi lo riceve, e possono essere scoperti, ricercati, raccolti e prodotti.

v

vi

INTRODUZIONE

Sono la materia prima che abbiamo a disposizione o produciamo per

costruire i nostri processi comunicativi. L’insieme dei dati è il tesoro di

un ’zazienda e ne rappresenta la storia evolutiva [6].

• Informazione: L’informazione viene costruita dai dati elaborati cognitivamente, cioè trasformati in un qualche schema concettuale successivamente manipolabile e usabile per altri usi cognitivi. L’informazione

conferisce un significato ai dati, grazie al fatto che li pone in una relazione

reciproca e li organizza secondo dei modelli. Trasformare dati in informazioni significa organizzarli in una forma comprensibile, presentarli in

modo appropriato e comunicare il contesto attorno ad essi.

• Conoscenza: La conoscenza è informazione applicata, come un senso

comune, o non comune, che sa quando e come usarla. È attraverso l’esperienza che gli esseri umani acquisiscono conoscenza. È grazie alle esperienze fatte, siano esse positive o negative, che gli esseri umani arrivano

a comprendere le cose. La conoscenza viene comunicata sviluppando

interazioni stimolanti, con gli altri o con le cose, che rivelano i percorsi nascosti e i significati dell’informazione in modo che possano essere

appresi dagli altri. La conoscenza è fondamentalmente un livello di comunicazione partecipatorio. Dovrebbe rappresentare sempre l’obiettivo

a cui tendere, poichè consente di veicolare i messaggi più significativi.

Le informazioni ottenute dall’elaborazione dei dati devono essere salvate

da qualche parte, in modo tale da durare nel tempo dopo l’elaborazione. Per

realizzare questo scopo viene in aiuto l’informatica.

Per informatica si intende il trattamento automatico dell’informazione

mediante calcolatore (naturale o artificiale). Philippe Dreyfus

All’inizio di questo capitolo è stato accennato che nello sviluppo dei sistemi

informatici si sono affermate diverse tecnologie e che, in particolare, l’uso di

sistemi di gestione di basi di dati relazionali comporta una gestione efficace

ed efficiente di dati persistenti.

Per persistenza di dati in informatica si intende la caratteristica dei dati

di sopravvivere all’esecuzione del programma che li ha creati. Se non fosse

cosi, i dati verrebbero salvati solo in memoria RAM e sarebbero persi allo

spegnimento del computer.

Nella programmazione informatica, per persistenza si intende la possibilità

di far sopravvivere strutture dati all’esecuzione di un programma singolo. Occorre il salvataggio in un dispositivo di memorizzazione non volatile, come per

esempio su un file system o su un database. Nel capitolo 1 si vedranno le problematiche e le possibili soluzioni che si hanno per persistere i dati, mostrando

l’importanza di database relazionali. Dal capitolo 2 in avanti si vedranno

IL CONTESTO DEL PROBLEMA

vii

delle caratteristiche di una tecnica di programmazione per convertire dati fra

RDBMS e linguaggi di programmazione orientati agli oggetti. Quindi per persistere i dati entro un database relazionale. Questa tecnica di programmazione

prende il nome di ORM, ovvero di Object-Relation mapping.

Capitolo 1

Il problema della persistenza

dei dati

In questo capitolo viene introdotto il problema della persistenza dei dati. Si

vedrà anche come lo sviluppo di applicazioni orientate agli oggetti richiede

quasi sempre di memorizzare lo stato degli oggetti in una base di dati. Sarà

dimostrata l’importanza dei RDBMS per la gestione della persistenza dei dati

e si vedrà qualche soluzione possibile.

1.1

Programmazione orientata agli oggetti

Il computer è una macchina capace di eseguire algoritmi generici descritti

attraverso un linguaggio noto come codice macchina. Purtroppo il linguaggio macchina è poco espressivo in quanto descrive, attraverso codici binari,

semplicemente istruzioni elementari aritmetiche e logiche o di input/output

direttamente comprensibili dalla CPU.

È nata l’esigenza di esprimere gli algoritmi attraverso concetti e simboli più

vicini alla mente umana. I linguaggi di programmazione servono a questo. Un

linguaggio di programmazione è un testo più facilmente leggibile da un essere

umano che sarà convertito cda un programma apposito (compilatore) in un

codice macchina dal medesimo significato. La programmazione procedurale

è stato il primo paradigma di programmazione: infatti descrive gli algoritmi

come una sequenza di operazioni da fare; a seconda del linguaggio le operazioni

erano le stesse del hardware (Assembly) oppure a più alto livello (Linguaggio

C).

Es. Apri il frigorifero, prendi l’uovo, rompi l’uovo nella padella, accendi il

fuoco, cuoci l’uovo e servi nel piatto.

La programmazione procedurale presenta dei limiti: i programmi nel tempo sono diventati sempre più complessi e programmando con questo stile non

si riusciva più a riutilizzare il codice e c’è stata la difficoltà di adattarlo ad

esigenze che possono mutare in corso d’opera.

Per ridurre questi problemi, è nato il paradigma di programmazione orientata agli oggetti: invece di semplicemente descrivere i passi per risolvere i

problemi, si cerca di spezzare la realtà in oggetti e programmare le operazioni

possibili di ogni oggetto indipendentemente. Gli oggetti sono poi messi in

1

2

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

Figura 1.1: Un uovo nella realtà un’istanza della classe uova

relazione per la risoluzione del problema, ma gli algoritmi relativi ai singoli

oggetti ed implementati entro i metodi interni di ogni oggetto sono facilmente

riutilizzabili.

Tornando all’esempio dell’uovo, usando il paradigma OOP si potrebbe programmare le varie operazioni relative all’uovo in modo separato del resto del

programma. In questo modo l’attenzioe si focalizza sull’uovo come entità del

mondo reale e tutto il resto divemta solo l’insieme delle condizioni al contorno

(vedi fig. 1.1).

Negli ultimi anni sempre piùOB lo sviluppo del software si basa sul paradigma di programmazione orientata agli oggetti OOP. Esso introduce un modo

diverso e, se si vuole, più efficiente per strutturare cil codice e la logica applicativa in esso contenuta. I primi linguaggi di programmazione che supportano

questo paradigma sono stati progettati negli anni ’70 e ’80, come per esempio Simula1, Simula67 e SmallTalk. Ma è nella seconda metà degli anni’80

che si diffondono anche nuove metodologie di programmazione più adatte per

gestiree problemi reali più complessi. A fine anni’80 vede la luce un altro

linguaggio usatissimo, il C++, creato da Bjarne Stroustrup, in cui vengono

introdotti concetti Object-Oriented nel linguaggio di programmazione C.

Il grosso vantaggio dell’approccio Object-Oriented rispetto agli altri paradigmi di programmazione consiste nel fatto che, per strutturare le applicazioni,

lo sviluppatore si trova ad utilizzare una logica che è molto vicina a quella che

è la percezione comune del mondo reale.

Pensare ad oggetti significa infatti saper riconoscere gli aspetti che caratterizzano una particolare realtà e saper fornire di conseguenza una rappresentazione astratta in un’ottica OOP.

Semplicemente, definiamo i concetti di oggetto e classe. Una classe è un’astrazione di uno degli aspetti della realtà che ci interessa. Questa astrazione

avviene tramite la definizione di attributi, che rappresentano i possibili stati

dell’aspetto in questione, e funzioni, che rappresentano le azioni possibili da

parte di quell’aspetto e che, quindi, si possono fare con le istanze della classe

rappresentante tale aspetto. Un oggetto è una istanza di una classe, ovvero è

una n-upla di valori memorizzati negli attributi, che occupa uno spazio entro

1.1. PROGRAMMAZIONE ORIENTATA AGLI OGGETTI

3

la memoria di lavoro del programma, tipicamente la memoria RAM. La sua

classe definisce come sono organizzati i dati di questa memoria, possiede tutti gli attributi definiti nella classe, ed essi hanno un valore, che può mutare

durante l’esecuzione del programma, cosı̀ come avviene per le variabili di un

programma procedurale.

Gli oggetti e le classi di un sistema orientato agli oggetti si basano sui

principi di [7]:

• Information Hiding: La descrizione interna dei dati di un oggetto e

del suo funzionamento, non deve essere visibile all’esterno, ovvero all’utente, ma è resa accessibile soltanto definendone opportune interfacce

ben definite. Nei moderni linguaggi orientati agli oggetti vi sono diversi

livelli di protezione delle informazioni (private, protette, pubbliche). Inoltre è bene notare che esiste una differenza concettuale tra Information

Hiding e Incapsulamento. L’information hiding è il principio teorico su

cui si basa la tecnica dell’incapsulamento. Con la tecnica dell’incapsulamento si può vedere l’oggetto in esame come una black-box, cioè

una scatola nera di cui, attraverso l’interfaccia si sa cosa fa e come interagisce con l’esterno ma non come lo fa, ossia l’implementazione dei

comportamenti a livello di codice risulta totalmente nascosta all’esterno

dell’oggetto. L’incapsulamento contribuisce ai vantaggi della programmazione ad oggetti: (indipendenza), (robustezza) e (riusabilità degli

oggetti creati).

• Identità dell’oggetto: Ogni oggetto dispone di un’identità univoca

valida in tutto il sistema. L’uguaglianza di due oggetti implica che tutti

gli attributi hanno il medesimo valore, ma gli oggetti non hanno necessariamente la stessa identità. Due oggetti identici sono lo stesso oggetto. L’identità è spesso espressa attraverso il concetto di identificatore

univoco di un oggetto o Object IDentifier (OID).

• Ereditarietà: Gli oggetti con comportamenti simili e/o con strutture

dati simili possono ereditare le loro proprietà e funzioni. Pensiamo per

esempio ad una classe Cane che eredita da una classe Animale. Il Cane

è un animale. Questo tipo di relazione si chiama IS A è la più usata

nella programmazione orientata agli oggetti. Ne esistono delle altre, ma

un altra comunemente usata è la relazione per contenimento chiamata

HAS A. Una classe che contiene un’istanza di un altra classe.

• Polimorfismo: I metodi con gli stessi nomi, possono avere una semantica diversa, secondo il contesto in cui vengono richiamati (concetto di

overriding).

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

4

1.2

Persistenza dei dati

Nell’introduzione abbiamo parlato di cosa significa persistere i dati. Adesso

prima di addentrarci sulle soluzioni esistenti per la persistenza, vediamo come

si rappresenta l’informazione in informatica.

Per far si che l’informazione esista nel mondo fisico, è necessario rappresentarla in modo fisico [6].

Può essere rappresentata come variazioni di grandezze fisiche entro opportuni supporti fisici. Per poterla immagazzinare e trasmetterla, sono necessari supporti fisici. L’immagazzinamento dell’informazione viene realizzato

attraverso archivi cartacei oppure attraverso archivi informatici. Anche la

trasmissione dell’informazione può aver luogo attraverso canali “tradizionali”

come la posta cartacea o il fax o attraverso canali digitali come Internet ed i

vari meccanismi di comunicazione in essa contenuti.

In informatica, l’informazione viene rappresentata e misurata come insiemi di byte. L’unità elementare di informazione è la quantità di informazione

ottenuta da un supporto che può contenere al più due configurazioni diverse.

Essa viene chiamata bit. Esistono codifiche associate agli standard che assegnano significati particolari a tali valori, per esempio il codice ASCII associa

ai valori da 0 a 255 rappresentati dai byte le lettere (maiuscole e minuscole)

dell’alfabeto latino internazionale, le lettere accentate, le cifre da 0 a 9, i segni

di interpunzione, parantesi, simboli matematici, caratteri di controllo tra quali

cito l’a capo e il fine riga.

Poiché sempre più spesso le applicazioni sono realizzate ad oggetti è necessario rendere persistenti alcune oggetti di alcune classi. Esistono diversi modi

per persistere gli oggetti:

• Base di dati a Oggetti

• Base di dati relazionale

• Insieme di file

Confrontando le metodologie, la migliore oggi è quella basata sulle basi di

dati relazionali Vedremo nella prossima sezione l’importanza di esso e che si

dimostrerà un eccelente immagazzinatore dell’informazione e un modo utile

per persistere gli oggetti nel mondo della programmazione OOP.

L’approccio convenzionale alla gestione dei dati e quindi alla loro persistenza sfrutta la presenza di archivi o file per memorizzare i dati in modo persistente sulla memoria di massa. Un file consente di memorizzare e ricercare

dati, ma fornisce solo semplici meccanismi di accesso e di condivisione.

Le procedure scritte in un linguaggio di programmazione sono completamente autonome; ciascuna di essa definisce e utilizza uno o più file privati.

Dati di interesse per più programmi sono replicati tante volte quanti sono i

1.2. PERSISTENZA DEI DATI

5

programmi che li utilizzano. Si noti che operando in questo modo inciampiamo

su ridondanza e possibilità di incoerenza.

Per superare questi problemi, sono state concepite le basi di dati, che non

sono altro una collezione organizzata di dati, di interesse per una qualche

applicazione.

Un sistema di gestione di basi di dati (DBMS) è un sistema software in

grado di gestire collezioni di dati che siano grandi, condivise, e persistenti,

assicurando la loro affidabilità e privatezza. Inoltre devono essere efficace e

efficienti.

Spieghiamo brevemente queste caratteristiche che deve avere un DBMS.

• Grandi: Le basi di dati possono avere dimensioni molto più grandi

della memoria centrale disponibile. Quindi i DBMS devono prevedere

una gestione dei dati in memoria secondaria.

• Condivise: Applicazioni e utenti diversi devono poter accedere ai dati

comuni. Cosi facendo si riduce la ridondanza dei dati e si riduce anche

possibilità di inconsistenze. I DBMS dispongono di un controllo di concorrenza che serve nel garantire l’accesso condiviso ai dati da parte di

molti utenti che operano contemporaneamente.

• Persistenti: Le basi di dati sono persistenti, ovverro hanno un tempo

di vita che non è limitato a quello delle singole esecuzioni dei programmi che le utilizzano. Ricordo che, i dati gestiti da un programma in

memoria centrale hanno una vita che inizia e termina con l’esecuzione

del programma. Tali dati non sono persistenti.

• Affidabilità: Capacità del sistema di conservare sostanzialmente intatto il contenuto della base di dati in caso di malfunzionamenti hardware o

software. I DBMS devono offrire politiche di backup e disaster recovery.

• Privatezza: Attraverso meccanismi di autorizzazione, l’utente, riconosciuto in base ad un nome utente, viene abilitato a svolgere determinate

azioni sui dati.

• Efficienza: Capacità di svolgere le operazioni utilizzando un insieme di

risorse (spazio e tempo) che sia accettabile per gli utenti.

• Efficacia: Capacità della base di dati di rendere produttive, in ogni

senso, le attività dei suoi utenti.

Alcune delle caratteristiche dei DBMS sono già garantite, per esempio,

dai file. Possiamo quindi vedere un DBMS come concepito e realizzato per

estendere le funzioni dei file systems.

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

6

1.3

Survey sulle soluzioni esistenti per la

persistenza

In questa sezione vengono illustrate alcune soluzioni esistenti per gestire la

persistenza dei dati. Esistono diversi meccanismi o, per meglio dire, implementazioni della persistenza. Il primo meccanismo è il concetto di serializzazione

e deserializzazione.

La serializzazione è un meccanismo che permette la trasformazione automatica di oggetti (di qualunque complessità) in una sequenza di byte. In altri

termini, è un meccanismo che permette di salvare un oggetto in un supporto

di memorizzazione lineare, per esempio in un’area di memoria o in un file,

o per trasmetterlo su una connessione di rete, per esempio in un socket. In

che forma può essere la serializzazione? Una forma è quella binaria, abbiamo

detton che essa trasforma automaticamente gli oggetti in sequenza di byte

oppure in un altra forma più leggibile ad un essere umano, per esempio in

formato XML.

Il processo inverso, detto di deserializzazione consiste nel riportare gli

oggetti negli stati in cui si trovavano prima di effettuare la serializzazione.

Prima di vedere un esempio, è meglio chiarire perchè si utilizza questo

approccio per persistere gli oggetti.

Esistono sostanzialmente due motivi principali: quello di rendere persistente lo stato di un oggetto su un supporto di archiviazione in modo da poter

ricreare una copia esatta in una fase successiva e di inviare l’oggetto per valore

da un dominio dell’applicazione ad un altro.

Per chiarire meglio il concetto di serializzazione ecco un esempio in codice

Java:

public class Serializza { public static void main(String[] args)

throws IOException { Film film = new Film("Fantozzi alla riscossa",

"Paolo Villaggio", "1994");

//Apriamo lo stream di output (supporto di persistenza) OutputStream

fos = new FileOutputStream("C:\\Film.ser");

//Apertura dello stream di serializzazione ObjectOutputStream oos =

new ObjectOutputStream(fos);

//Scrittura su file della sequenza di byte rappresentativa dello

//stato dell’oggetto. oos.writeObject(film); oos.close();

fos.close(); } }

Come si può notare nel main(), vien creato un oggetto film ed aperto uno

stream in output in modo tale che l’oggetto, binarizzato, vien scritto nel file

C:

1.3. SURVEY SULLE SOLUZIONI ESISTENTI PER LA PERSISTENZA7

Film.ser. Lo stream di output funge come supporto alla serializzazione dell’oggetto e una volta aperto viene scritto sul file la sequenza di byte rappresentativa dell’oggetto film.

Ed ecco l’esempio di deserilizzazione corrispondente:

public class Deserializza { public static void main(String[] args) {

//Apertura dello stream di input InputStream fis = new

FileInputStream("C:\\Film.ser");

//Apertura stream di deserializzazione ObjectInputStream ois = new

ObjectInputStream(fis);

//Lettura e assegnazione dell’oggetto Film film =

(Film)ois.readObject();

ois.close(); fis.close(); System.out.println(film.toString()); } }

In questo caso viene aperto lo stream di input dell’oggetto film, viene letto

byte per byte dal file Film.ser e viene ricostruita una copia esatta dell’oggetto

Film come era prima di effettuare la serializzazione.

Il meccanismo di serializzazione quindi, permette di salvare lo stato dell’oggetto nel suo complesso. Ciò significa due cose: se in tale oggetto è presente un riferimento ad un altro oggetto viene salvato anche lo stato di tale

oggetto, in questo caso si parla di Copia in profondità e non semplicemente il

riferimento ad esso nel qual caso si sarebbe parlato di Copia superficiale.

Questo è il motivo per cui il network di oggetti deve essere costituita

da istanze derivanti da classi serializzabili. Nel file binario, questa rete viene

riprodotta esattamente con la stessa configurazione esistente in memoria prima

della serializzazione. Gli indirizzi di memoria che sono privi di significato fuori

dal contesto dell’esecuzione del programma, sono sostituiti da numeri seriali.

Da qui prende il nome di serializzazione.

Chiaramente questo modo di procedere crea sia vantaggi sia svantaggi.

Un grosso vantaggio della serializzazione è quello di essere semplice da implementare ed è intrinsicamente Object-Oriented. Uno svantaggio è che non

dispone di supporto per transazioni e non consente il recupero selettivo dei

dati (se non dopo aver effettuato la deserializzazione). Un altro svantaggio

è quello della gestione della sicurezza e delle versioni dei singoli oggetti, che

risulta molto onerosa. Quindi, questo metodo si può impiegare per progetti

che non presentano particolare criticità in termini di sicurezza e non gestiscano

notevoli quantità di dati.

Esistono diversi altri meccanismi per persistere i dati, per esempio:

• EJB (Enterprise Java Beans)

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

8

• JDBC (Driver per la connessione alla sorgente di base di dati

per Java)

• XMI

• JDO

• HIBERNATE (ORM nel mondo Java)

• NHIBERNATE (ORM nel mondo C#)

Molti dei metodi citati usano al loro interno il metodo oggi più diffuso per

immagazzinare (persistere) i dati, il RDBMS.

1.4

L’importanza dei RDBMS

Prima di dire il perchè ancor’oggi i DBMS più diffusi e più utilizzati sono

quelli relazionali è bene spiegare i diversi modelli che esistono.

Un DBMS è un potente strumento per creare e amministrare grosse moli di

dati in modo efficiente e permettendo di persistere per un lungo periodo di

tempo questi dati. [8].

Le potenzialità che un DBMS offre agli utenti sono:

• Persistenza: Come un file system, un DBMS supporta la memorizzazione di grosse mole di dati che esistono indipendentemente dai molti

processi che li utilizzano.

• Programmazione di interfacce: Un DBMS permette agli utenti o

ad un programma applicativo di accedere o modificare dati offrendo un

potente linguaggio per creare delle Query.

• Gestione delle transazioni: Un DBMS supporta accessi ai dati in

modo concorrente. In altri termini, possiamo dire che accessi simultanei

corrispondono a molti processi distinti(transazioni).

Un modello di dati è un insieme di concetti utilizzati per organizzare i dati

di interesse e descriverne la struttura in modo che essa risulti comprensibile a

un elaboratore [1].

Questo modello si basa sullo standard ANSI/X3/SPARC (vedi Fig. 1.2).

Lo standard definisce in pratica tre livelli [9] e [10]:

• Schema esterno: Rappresenta la visione che l’utente e le applicazioni

utente devono avere del sistema; si opera per mezzo di SQL creando

delle viste.

1.4. L’IMPORTANZA DEI RDBMS

9

Figura 1.2: Architettura ANSI/SPARC delle moderne basi di dati

• Schema concettuale: Vengono definiti gli elementi costitutivi del database,

talora chiamati anche oggetti del database, come le tabelle, le viste,

gli indici; si opera anche qui per mezzo di SQL creando le tabelle e

definendone gli attributi.

• Schema interno: Rappresenta il layout fisico dei record e dei campi; si

opera per mezzo di un linguaggio di programmazione come il C definendo

a basso livello la struttura della tabella.

Questa struttura a livelli consente di avere indipendenza di dati tra un

livello e l’altro. All’interno dello schema concettuale viene definito il modello

dei dati ed è qui che esistono diversi modelli.

• Modello gerarchico

• Modello reticolare

• Modello relazionale

• Modello ad oggetti

• Modelli ibridi relazionali e orientati agli oggetti

Il modello gerarchico è stato storicamente il primo modello ad affermarsi.

Fù definito negli anni sessanta. In questo modello i dati sono organizzati

secondo strutture ad albero, che si suppone che riflettano in una gerarchia

esistente le entità che appartengono al database e le relazioni che le connettono.

Un esempio di questo modello sono i file system che usiamo oggi. Essi sono

organizzati secondo una struttura ad albero, in uso ormai da decenni.

10

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

Il modello reticolare fù definito negli anni settanta. Esso è basato sull’uso

dei grafi.

I modelli ibridi sono invece quelli che all’interno del singolo record posso

avere degli oggetti, ovvero elementi complessi come altri record o intere tabelle.

Il modello relazionale si basa su due concetti fondamentali, relazione e

tabella. Il termine relazione proviene dalla matematica, in particolare dalla teoria degli insiemi. Infatti una relazione è un sottoinsieme del prodotto

cartesiano. Invece il termine tabella è un concetto semplice e molto intuitivo.

Esso risponde al requisito dell’indipendenza dei dati, che come abbiamo

visto nell’introduzione, è uno dei requisiti per poter parlare di DBMS.

Il modello a oggetti è stato introdotto negli anni ottanta come evoluzione

del modello relazionale. Qui troviamo concetti Object-Oriented.

I Database relazionali furono proposti da Edgar F. Codd nel 1970 per semplificare la scrittura di interrogazioni SQL e per favorire l’indipendenza dei

dati. Diciamo che un database è relazionale se asserisce alle 12 regole di

Codd.

Richiamo qui di seguito le 12 regole:

• Regola 0 : Il sistema deve potersi definire come relazionale, base di dati,

e sistema di gestione. Affinché un sistema possa definirsi sistema relazionale per la gestione di basi di dati (RDBMS), tale sistema deve

usare le proprie funzionalità relazionali (e solo quelle) per la gestire la

base di dati.

• Regola 1 : L’informazione deve essere rappresentata sotto forma di tabelle;

L informazioni nel database devono essere rappresentate in maniera univoca, e precisamente attraverso valori in colonne che costituiscano, nel

loro insieme righe di tabelle.

• Regola 2 : La regola dell’accesso garantito: tutti i dati devono essere

accessibili senza ambiguità (questa regola è in sostanza una riformulazione de requisito per le chiavi primarie). Ogni singolo valore scalare

nel database deve essere logicamente indirizzabile specificando il nome

della tabella che lo contiene, il nome della colonna in cui si trova e il

valore della chiave primaria della riga in cui si trova.

• Regola 3 : Trattamento sistematico del valore NULL; il DBMS deve

consentire all’utente di lasciare un campo vuoto, o con valore NULL. In

particolare, deve gestire la rappresentazione di informazioni mancanti e

quello di informazioni inadatte in maniera predeterminata, distinta da

ogni valore consentito (per esempio, diverso da zero o qualunque altro

numero per valori numerici), e indipendente dal tipo di dato. È chiaro inoltre che queste rappresentazioni devono essere gestite dal DBMS sempre

nella stessa maniera.

1.4. L’IMPORTANZA DEI RDBMS

11

• Regola 4 : La descrizione del database deve avvenire ad alto livello logico

tramite i metadati.

• Regola 5 : Deve esistere un linguaggio che permetta la gestione dei dati

(come SQL).

• Regola 6 : Si possono creare delle viste per vedere una parte dei dati.

Queste viste devono essere aggiornabili.

• Regola 7 : Le operazioni che avvengono sul database devono avvenire

anche sulle tabelle.

• Regola 8 : I dati memorizzati nel database devono essere indipendenti

dalle strutture di memorizzazione fisiche.

• Regola 9 : I dati devono essere indipendenti dalla struttura logica del

database per garantire la crescita naturale e la manutenzione del database.

• Regola 10 : Le restrizioni sui dati devono essere memorizzate nel database.

• Regola 11 : L’accesso ai dati è indipendente dal tipo di supporto per la

lettura o memorizzazione degli stessi.

• Regola 12 : L’accesso ai dati non deve annullare le restrizioni o i vincoli

di integrità del linguaggio principale.

Vediamo adesso gli elementi principali che costituiscono un modello relazionale.

Come abbiamo detto in precedenza il tutto si basa sul concetto di relazione.

Dati n > 0 insiemi A1 , ..., An , non necessariamente distinti, il prodotto cartesiano di A1 , ..., An , indicato con A1 × A2 × ... × An , è costituito

dall’insieme delle n-uple (v1 , ..., vn ) tali che vi ∈ Ai , per1 ≤ i ≤ n.

Una relazione matematica sui domini A1 , ..., An è un sottoinsieme del

prodotto cartesiano A1 × A2 × ... × An . Se vogliamo essere meno matematici,

una relazione è un insieme di record omogenei, cioè definiti sugli stessi campi.

Ad ogni campo è associato un nome, quindi associamo a ciascuna occorrenza

di dominio (A1 , ..., An ) nella relazione un nome, detto attributo, che descrive

il ruolo giocato dal dominio stesso. Per essere più formali, esiste una corrispondenza tra attributi e domini per mezzo di una funzione dom : X −→ A,

che associa a ciascun attributo att ∈ X un dominio dom(att) ∈ A che ne

definisce valori discreti o intervalli di valori continui possibili. Prende il nome

di tupla un insieme non ordinato di valori degli attributi.

Le relazioni nei database relazionali vengono rappresentate graficamente

tramite le tabelle. Ogni colonna di tale tabella costituisce un attributo. Le

tuple sono rappresentate dalle righe delle tabelle. Nella fig. 1.3 mostra un

esempio di tabella nel mondo dei database relazionali.

12

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

Figura 1.3: Una tabella

In altri termini, un database relazionale è un insieme di tabelle, collegate

tramite determinati attributi, che hanno la caratteristica di avere diversi valori

associati per ogni tupla della tabella e detti chiave primaria. Quando questi

vengono utilizzati per relazionare (ossia collegare, ponendole in relazione fra

loro) due tabelle vengono dette chiavi esterne.

I sistemi informatici richiedono solitamente di gestire alcuni dati in modo

persistente e abbiamo visto fino adesso dei modi per persistere (serializzazione,

EJB, XML, ecc.). In un’applicazione a oggetti, è necessario rendere persistenti

alcuni oggetti di alcune classi (vedremo in seguito che queste classi sono spesso

indicate col nome di classi entità). Queste classi prendono anche il nome di

classi persistenti. Sono classi che fanno parte della logica applicativa ispirate

alle classi concettuali.

Però, esistono alcuni problemi legati al voler gestire oggetti persistenti

mediante una base di dati relazionale. Questo problema è noto in letteratura

come Impedance Mismatch o disaccopiamento di impedenza.

Vedremo in seguito di che cosa si tratta e di come poterlo risolvere. Per

arrivare a spiegare l’importanza dei RDBMS è utile soffermarci un’attimo a

confrontare il modello a oggetti vs il modello relazionale. Da qui si evincerà

l’importanza dei database relazionali.

1.5

Modello a oggetti vs modello relazionale

I modelli a oggetti costituiscono una promettente evoluzione delle basi di dati.

I sistemi a oggetti integrano la tecnologia della base di dati con il paradigma

ad oggetti sviluppato nell’ambito dei linguaggi di programmazione.

1.6. IL DISACCOPPIAMENTO DI IMPEDENZA

13

Nelle basi di dati a oggetti, ogni entità del mondo reale è rappresentata da

un oggetto. Per esempio: dati multimediali, cartine geografiche, ecc [11]. Da

notare che è difficile pensare ad una struttura relazionale per queste entità. I

programmatori che utilizzano il paradigma OOP e hanno necessità di salvare

i propri oggetti, possono scegliere di salvarli su un database relazionale; in

questo caso però bisogna convertire gli oggetti in tabelle con righe e colonne,

nel fare questo bisogna mantenere anche la descrizione e le relazioni delle varie

classi nonchè lo schema relazionale e il mapping delle classi nel db relazionale.

Se al contrario scegliamo una base di dati a oggetti, i programmatori possono salvare gli oggetti cosi come sono e dovranno solamente preoccuparsi di

modellare una base di dati a oggetti che descriva correttamente la realtà fisica

che deve immagazzinare nel database. La differenza tra questi due modelli

sta nella mancanza di interoperabilità. Ciò significa che si può accedere ad

un ODBMS solo per mezzo del DBMS che lo gestisce. Per esempio, ad un database

Goods si può accedere solo per mezzo di un programma scritto per Goods e non

qualcos’altro.

1.6

Il disaccoppiamento di impedenza

Le informazioni memorizzate in un database hanno una natura persistente: ogni

tabella sul disco conserva il suo stato (ossia il valore degli attributi nelle tuple) tra

sessioni di lavoro successive. Pertanto un programmatore che sfrutta un linguaggio di

programmazione ad oggetti e che costruisce la classe tabella dovrà fare in modo che

tale classe sia persistente. Non ci deve essere nessuna differenza tra il trattamento

fra oggetti transitori e oggetti persistenti. Cosi facendo, la persistenza è una proprietà che non dipende dal particolare tipo di oggetto, ma è una proprietà attribuile

ad ogni classe di oggetti. Bisogna quindi che la classe che deve essere persistente

deve prevedere opportuni metodi per gestire la persistenza. L’oggetto persistente

a differenza di un oggetto non persistente, deve essere in grado automaticamente

di rileggere da una memoria di massa le informazioni sul suo stato. dei problemi

nel persistere dei dati entro un database. Questo comporta la necessità di decidere

in generale come implementare politiche di persistenza e in particolare quali scelte

progettuali fare nel programma specifico che si sta realizzando.

Un programmatore che utilizza un linguaggio di programmazione orientato agli

oggetti (C++, Java, C#, J#, Vb.net, Eiffell, ecc.) gradisce nella maggior parte dei

casi utilizzare lo stesso approccio anche quando salva i dati sul database. Cioè rende

le classi persistenti. Il problema che è noto in letteratura sotto il nome di impedance

mismatch [12], sta a significare il problema dell’integrazione tra SQL (linguaggio

dichiarativo, in cui non si pensa all’algoritmo che implementa la ricerca, ma solo al

risultato della ricerca) e i normali linguaggi di programmazione OOP che non sono

dichiarativi. Esiste anche il problema legato alla conversione dei dati come tornati

dall’SQL in dati che possono essere interpretati dall’ambiente OOP, come Java o

C++. Quindi questo dissaccoppiamento di impedenza porta a differenze sui tipi di

dato primitivi (anche se molte differenze sono risolte dai driver di comunicazione tra

programma e RDBMS) e, soprattutto, differenze tra i riferimenti interni al programma

ad oggetti e gli insiemi di chiavi esterne che collegano i dati nel RDBMS.

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

14

Figura 1.4: Un esempio di interazione sql immerso nelle classi

1.7

Le soluzioni possibili

Esistono diverse soluzioni per impedire il verificarsi del problema del disaccopiamento

d’impedenza.

Una prima possibilità è quella di rendere persistente una classe scrivendo direttamente il codice SQL dentro la classe stessa (vedi fig. 1.4).

Questo approccio presenta alcuni ostacoli. Il primo problema deriva dal fatto

che SQL è un linguaggio ricco, con una propria sintassi. Sono state proposte due

soluzioni:

1. SQL Embedded

2. CLI (Call Level Interface)

SQL Embedded prevede di introdurre direttamente nel programma sorgente scritto nel linguaggio ad alto livello le istruzioni SQL, distinguendole dalle normali istruzioni

tramite opportuni separatori e/o sintassi appropriate. Di norma in questo approccio la

compilazione è preceduta dall’esecuzione di un apposito preprocessore che riconoscerà

le istruzioni SQL è sostituirà a esse un insieme opportuno di chiamate ai servizi dei

RDBMS, tramite una libreria specifica per ogni RDBMS.

Le CLI sono un insiemi di funzioni messe a disposizione per il programmatore

che permettano di interagire con il DBMS. Rispetto al SQL Embedded con questa

libreria di funzioni si dispone di uno strumento più flessibile, meglio integrato con

il linguaggio di programmazione, con l’incoveniente di dover gestire esplicitamente

aspetti che in SQL Embedded erano risolti dal preprocessore. Le CLI si usano in

questo modo:

1. Si utilizza un servizio della CLI per creare una connessione con il DBMS.

2. Si invia sulla connessione un comando SQL, in forma di stringa, che rappresenta

la richiesta.

1.7. LE SOLUZIONI POSSIBILI

15

Figura 1.5: Un esempio di utilizzo di data classes [ERRORE: 2 FIGURE

UGUALI]

3. Si riceve come risposta del comando una struttura relazionale in un opportuno

formato (col linguaggio C# usato nella parte sperimentale della corrente tesi è

una DataTable); la CLI dispone di un certo insieme di primitive che permettono

di analizzare e descrivere la struttura del risultato del comando.

4. Al termine della sessione di lavoro, si chiude la connessione e si rilasciano le

strutture dati utilizzare per la gestione del dialogo.

Una seconda soluzione è quella di scrivere il codice SQL in appossite classi di

supporto (detti data classes) alle classi persistenti (vedi fig. 1.5).

Una terza soluzione è quella di delegare la gestione della persistenza degli oggetti

ad un modulo apposito, detto PL - Persistence Layer (vedi fig. 1.6).

Un PL nasconde i dettagli della persistenza (nonché della condivisione e della

transazionalità) al programmatore. Gli Object-Relational Mapper (ORM) sono una

categoria molto diffusa di PL e nel corso di questa tesi viene usato un ORM open

source chiamato NHibernate.

Qui di seguito ecco un esempio di codice che fa uso di un PL:

PersistenceManager pm = new PersistenceManager(...); Transaction tx

= pm.currentTransaction(); PersonaID pID = new PersonaID("1");

Persona p = (Persona) pm.getObjectByID(pID); p.setStipendio(1000);

tx.commit();

Persona è una classe entità, che fornisce soltanto metodi get e set, cioè che consentono

accesso pubblico in lettura e scrittura sui suoi attributi privati. Si può dire che in

questo esempio esiste un isomorfismo tra tabella nel mondo dei database relazionale

e la classe nel mondo OOP. Questo importante concetto verrà dettagliato in seguito.

CAPITOLO 1. IL PROBLEMA DELLA PERSISTENZA

DEI DATI

16

Figura 1.6: Un esempio di utilizzo del PL

Un PL nasconde al programmatore i dettagli di come gli oggetti vengono resi

persistenti. Esistono tre approcci principali per la realizzazione di un PL:

1. O/R Mapping

2. R/O Mapping

3. Incontro al centro

Nel primo approccio, il programmatore indica in un file di configurazione quali

sono le classi che vanno rese persistenti e quindi a partire da questi file viene generata

la base di dati e le data classes per le classi persistenti.

Nel secondo approccio, il programmatore indica in un file di configurazione la

base di dati relazionale di interesse e quindi, a partire da questi file, vengono generate

le data classes per accedere e modificare le tuple delle relazioni delle base di dati.

Nell’ultimo approccio, le classi persistenti e la base di dati vengono progettate e

realizzate in modo indipendente. Il programmatore indica in un file di configurazione

le corrispondenze tra classi persistenti e base di dati e quindi a partire da questi file

vengono generate le data classes per le classi persistenti.

Esistono altre soluzioni a questo problema:

1. Cursori

2. Uso di una struttura del tipo insieme di righe

Un cursore è uno strumento che permette a un programma di accedere alle righe

di una tabella una alla volta; esso viene definito su una generica query. La sintassi

SQL per la definizione di un cursore è la seguente:

declare NomeCursore [scroll] cursor for SelectSQL

only|update [of Attributo{, Attributo}]>]

[for <read

1.7. LE SOLUZIONI POSSIBILI

17

É importante analizzare la semantica dell’istruzione:

1. declare cursor : Definisce un cursore, associato ad una particolare query sulla

base di dati.

2. scroll : Opzionale, se si vuole permettere al programma di muoversi “liberamente” sul risultato della query.

3. for update: Opzionale, specifica se il cursore deve essere utilizzato nell’ambito di

un comando di modifica, permettendo di specificare eventualmente gli attributi

che saranno oggetto del comando di update.

La seconda soluzione consiste nell’utilizzare un linguaggio di programmazione che

abbia a disposizione dei costruttori di dati più potenti e in particolare riesce a gestire

in modo naturale una struttura del tipo insieme di righe. Esempi che adottano questa

soluzione sono: ADO, ADO.net, JDBC.

Per meglio chiarire gli aspetti pratici risultanti per i programmatori è bene illustrare brevemente le caratteristiche di alcune tra le soluzioni oggi maggiormente

diffuse:

1. ODBC : Interfaccia standard che permette di accedere a basi di dati in qualunque

contesto, realizzando interoperabilità con diverse combinazioni DBMS - Sistemi

Operativi - Reti.

2. OLEDB: Soluzione proprietaria Microsoft, basata sul metodo COM, che permette ad applicazioni Windows di accedere a sorgenti dati generiche, ovvero non

solo DBMS. Vedremo che questa soluzione sarà usata largamente nel progetto

di generazione di strati software che sarà descritta nel capitolo 5.

3. ADO: Soluzione proprietaria Microsoft che permette di sfruttare i servizi OLEDB,

utilizzando un’interfaccia record-oriented.

4. ADO.NET: Soluzione proprietaria Microsoft che adatta ADO alla piattaforma

.NET; offre un’interfaccia set-oriented e introduce i DataAdapter.

5. JDBC: Soluzione per l’accesso ai dati in Java sviluppata da Sun Microsystems;

offre in quel contesto un servizio simile a ODBC.

In particolare vediamo ora ADO.NET. In ADO.NET i dati vengono gestiti tramite

DataSet i quali costituiscono dei contenitori di oggetti (in particolare entro i DataSet

si trovano le DataTable, che rappresentano in memoria le normali tabelle del RDBMS

con tutte le loro caratteristiche). Parleremo più in dettaglio di come sono rappresentate in memoria le DataTable e il loro utilizzo entro il contesto degli ORM e del

progetto creato. Un DataSet permette anche la gestione di relazioni e vincoli di integrità tra gli oggetti al suo interno. Questa flessibilità è resa possibile dal fatto che

i DataSet rappresentano strutture che risiedono pienamente nell’ambiente del programma. Per concludere questa breve descrizione, aggiungo che il coordinamento tra

i DataSet e le sorgenti dati avviene tramite dei componenti specifici, che prendono il

nome di DataAdapter.

Capitolo 2

Architetture software a oggetti

In questo capitolo vengono introdotte le architetture ad oggetti e, in particolare, i

Design Pattern e il loro utilizzo. Si vedranno come le architetture stratificate sono

vantaggiose nella progettazione e realizzazione di progetti di medie-grandi dimensioni.

Inoltre si vedranno i primi ingredienti nella realizzazione di un ORM: le classi e gli

oggetti entità. Sarà presentato infine il ruolo degli ORM come strumento dato al

programmatore per legare il mondo della programmazione a oggetti con il mondo dei

database.

2.1

I Design Pattern

Progettare sistemi secondo il paradigma Object-Oriented non è facile e creare software Object-Oriented che sia anche riutilizzabile è ancora più difficile: una soluzione

dovrebbe essere specifica al problema ma abbastanza generale da poter essere riutilizzata. Di solito è molto difficile creare del software che risponda alle esigenze

funzionali alla prima scrittura e il programmatore in generale impiega molto tempo

ad imparare a creare del buon codice Object-Oriented. I programmatori esperti solitamente non risolvono i loro problemi partendo da zero ma riusano soluzioni o parte

di esse, sulle quali hanno lavorato in passato: in questo modo riutilizzano pezzi di

design e di codice che sono consolidati e testati. Il riutilizzo di elementi della fase di

progettazione è l’obiettivo dei design pattern: il semplice riutilizzo del codice porta

a degli indiscutibili vantaggi in termini di risparmio di tempo ma il poter usare dei

pezzi di design si pone ad un livello superiore. Come è noto, la fase di design è una

delle fasi più impegnative nel ciclo di sviluppo di un’applicazione software mentre la

scrittura del codice non è cosı̀ critica: il riutilizzo di micro-architetture nella fase di

progettazione ha dei vantaggi notevoli sia nella fase stessa che nella fase di programmazione, senza contare i riflessi sulla manutenzione del sistema. Alcune soluzioni

per di risolvere dei problemi a livello di progettazione si sono rivelate una costante

di molti progetti, anche in contesti diversi. Da qui l’idea di collezionare e documentare queste soluzioni sicure a dei problemi ricorrenti per migliorare lo sviluppo

di un sistema software. Per facilitare il riutilizzo di alcuni elementi di progettazione

che sono già stati sviluppati si ricorre ai design pattern, che hanno lo scopo di dare

un nome, spiegare e valutare pezzi importanti e ricorrenti nella progettazione del

software Object-Oriented. I design pattern aiutano a costruire del software che sia

riusabile ed evitare scelte che compromettano il riutilizzo dello stesso, inoltre possono migliorare la documentazione e la manutenzione di sistemi esistenti, in poche

parole aiutano a progettare in modo giusto in minor tempo. La prima e la più famosa

collezione di design pattern è contenuta nel libro di Gamma [13], più noto come libro della “Gang of 4”. In questo libro sono contenuti e documentati 23 design pattern.

18

2.1. I DESIGN PATTERN

19

Un design pattern sistematicamente dà un nome, motiva e spiega un concetto

generale che indirizza un problema di progettazione ricorrente nei sistemi Object

Oriented. Esso descrive il problema, la soluzione, quando applicare la soluzione e

le sue conseguenze. Inoltre dà suggerimenti sull’implementazione ed esempi. La

soluzione è personalizzata e implementata per risolvere il problema in un particolare

contesto.

Il problema dell’impedance mismatch che abbiamo visto nel capitolo precedente,

può essere trattato anche per mezzo di pattern. I pattern quindi sono degli schemi

di idee [14], ossia soluzioni preconfezionate, provate in diverse situazioni e standardizzate [15]. Essi si concentrano maggiormente sui concetti e meno sull’aspetto

implementativo. I pattern nella programmazione Object-Oriented sono usatissimi.

Vedremo che il progetto Generatore Strati Software si basa su un pattern chiamato

MVC. Ma prima di addentrarci in alcuni pattern fondamentali che ricorrono nello

studio degli ORM e nel mio progetto, vediamo alcune caratteristiche dei pattern e

vediamo come si classificano.

Nel libro dei Gang of four vengono identificati 23 tipi di design pattern, suddivisi

in 3 categorie:

1. Pattern strutturali

2. Pattern creazionali

3. Pattern comportamentali

I pattern strutturali consentono di riutilizzare degli oggetti esistenti fornendo

agli utilizzatori un’interfaccia più adatta alle loro esigenze. Qui troviamo:

• Adapter: Converte l’interfaccia di una classe in un’altra permettendo a due

classi di lavorare assieme anche se hanno interfacce diverse.

• Bridge: Disaccoppia un’astrazione dalla sua implementazione in modo che

possano variare in modo indipendente.

• Composite: Compone oggetti in strutture ad albero per implementare delle

composizioni ricorsive.

• Decorator: Aggiunge nuove responsabilità ad un oggetto in modo dinamico,

è un’alternativa alle sottoclassi per estendere le funzionalità.

• Facade: Provvede un’interfaccia unificata per le interfacce di un sottosistema

in modo da rendere più facile il loro utilizzo.

• Flyweigth: Usa la condivisione per supportare in modo efficiente un gran

numero di oggetti con fine granularità.

• Proxy: Provvede un surrogato di un oggetto per controllarne gli accessi.

• Private class data

• Extensibility

I pattern creazionali nascondono i costruttori delle classi e mettono dei metodi

al loro posto creando un’interfaccia. In questo modo si possono utilizzare oggetti

senza sapere come sono implementati.

20

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

• Abstract Factory: Provvede un’interfaccia per creare famiglie di oggetti in

relazione senza specificare le loro classi concrete.

• Builder: Separa la costruzione di un oggetto complesso dalla sua rappresentazione in modo da poter usare lo stesso processo di costruzione per altre

rappresentazioni.

• Factory method: Definisce un’interfaccia per creare un oggetto ma lascia

decidere alle sottoclassi quale classe istanziare.

• Prototype: Specifica il tipo di oggetti da creare usando un’istanza prototipo

e crea nuovi oggetti copiando questo prototipo.

• Singleton: Assicura che la classe abbia una sola istanza e provvede un modo

di accesso.

• Lazy initialization: É la tattica di instanziare un oggetto solo nel momento in

cui deve essere usato per la prima volta. É utilizzato spesso insieme al pattern

factory method.

I pattern comportamentali forniscono soluzione alle più comuni tipologie di

interazione tra gli oggetti.

• Chain of responsibility: Evita l’accoppiamento di chi manda una richiesta

con chi la riceve dando a più oggetti la possibilità di maneggiare la richiesta.

• Command: Incapsula una richiesta in un oggetto in modo da poter eseguire

operazioni che non si potrebbero eseguire.

• Iterator: Provvede un modo di accesso agli elementi di un oggetto aggregato

in modo sequenziale senza esporre la sua rappresentazione sottostante.

• Mediator: Definisce un oggetto che incapsula il modo in cui un insieme di

oggetti interagisce in modo da permettere la loro indipendenza.

• Memento: Cattura e porta all’esterno lo stato interno di un oggetto senza

violare l’incapsulazione in modo da ripristinare il suo stato più tardi.

• Observer: Definisce una dipendenza 1:N tra oggetti in modo che se uno cambia

stato gli altri siano aggiornati automaticamente.

• State: Permette ad un oggetto di cambiare il proprio comportamento a seconda

del suo stato interno, come se cambiasse classe di appartenenza.

• Strategy: Definisce una famiglia di algoritmi, li incapsula ognuno e li rende

intercambiabili in modo da cambiare in modo indipendente dagli utilizzatori.

• Interpreter: Dato un linguaggio, definisce una rappresentazione per la sua

grammatica ed un interprete per le frasi del linguaggio.

• Template method: Permette di definire la struttura di un algoritmo lasciando

alle sottoclassi il compito di implementarne alcuni passi come preferiscono.

• Visitor: Permette di separare un algoritmo dalla struttura di oggetti composti

a cui è applicato, in modo da poter aggiungere nuovi comportamenti senza dover

modificare la struttura stessa.

• Single-serving Visitor

2.1. I DESIGN PATTERN

21

• Hierarchical Visitor

• Event Listener

Esistono anche altri tipi di design pattern, ma questi non operano al livello di

progettazione del sistema. Essi sono suddivisi in:

1. Pattern architetturali

2. Pattern di metodologia

3. Pattern di concorrenza

I pattern architetturali operano ad un livello diverso (e più ampio) rispetto ai

design pattern, ed esprimono schemi di base per impostare l’organizzazione strutturale

di un sistema software. In questi schemi si descrivono sottosistemi predefiniti insieme

con i ruoli che essi assumono e le relazioni reciproche.

Qui si trovano i pattern: Broker, MVC, Repository, Client-Server, Reflection, Presentation Abstraction Control, Microkernel, Layers, Pipes and

Filters e Blackboard.

Nei pattern di metodologia si trovano: Responsibility e Make it run, make

it right, make it fast, make it small.

Nel caso di processi che eseguono contemporaneamente delle attività su dati condivisi si parla di concorrenza. Alcuni design pattern sono stati sviluppati per mantenere sincronizzato lo stato dei dati in tali situazioni. Si parla in tal caso di pattern di concorrenza. Essi sono suddivisi in: Active object, Balking, Double

checked locking, Guarded suspension, Leaders/followers, Monitor object,

Read-Write lock, Scheduler, Thread pool, Thread-specific storage, Token

passing synchronization e Reactor.

Al suo interno, un pattern è formato da questi quattro elementi:

1. Il nome, che è utile per descrivere la sua funzionalità.

2. Il problema nel quale il pattern è applicabile. Esso spiega il problema e il

contesto, a volte descrive strutture di classi o a volte il design di sistema. Può

includere anche una lista di condizioni.

3. La soluzione, che descrive in maniera astratta come il pattern risolve il problema. Descrive anche la responsabilità e le collaborazioni che compongono il

progetto.

4. Le conseguenze portate dall’applicazione del pattern. Servono per valutare i

costi-benefici dell’utilizzo del pattern.

Il nome del pattern Il problema La soluzione Infine le conseguenze

Vediamo adesso il pattern architetturale MVC che è stato usato nella progettazione del prototipo Generatore Strati Software (GSS 1.0) realizzato durante la

presente tesi.

22

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

Figura 2.1: Schema funzionale MVC

2.2

Il pattern MVC nella progettazione software

Questo modello prevede una netta separazione tra i dati, la rappresentazioni dei dati

e la logica di funzionamento del sistema [16] e [17].

Questo approccio porta a diversi vantaggi:

1. Separazione dei ruoli e delle relative interfacce;

2. Indipendenza tra business data (model), logica di presentazione (view) e logica

di controllo (controller);

3. Viste diverse per il medesimo model;

4. Maggior semplicità per il supporto a nuove tipologie di client: basta scrivere la

vista ed il controller appropriati riutilizzando il model esistente;

Nella figura (fig. 2.1) viene mostrata lo schema funzionale del pattern MVC

(Model-View-Controller).

Nella figura si vedono i tre componenti funzionali del MVC: il model, view e

controller.

2.3. LE ARCHITETTURE STRATIFICATE ED I LORO VANTAGGI

23

• Model: Esso individua la rappresentazione dei dati dell’applicazione e le regole

di business con cui viene effettuato l’accesso e la modifica a tali dati. Il modello

non e a conoscenza dei suoi controller e tanto meno delle sue view; non contiene

riferimenti ad essi, ma è il sistema che si prende la responsabilità di mantenere

i link tra il modello e le sue view e di notificare quest’ultime le variazioni nei

dati del modello;

• View: È la presentazione visuale dei dati all’utente e interagisce con il modello attraverso un riferimento ad esso. Uno stesso modello può quindi essere

presentato secondo diverse viste (Form, WPF, Web, Console, ecc);

• Controller:È colui che interpreta le richieste della view in azioni che vanno ad interagire con il model (di cui possiede un riferimento), aggiornando

conseguentemente la view stessa.

La suddivisione in livelli permette di gestire la progettazione e la programmazione

dei vari componenti in maniera indipendente tra loro, collegandoli solamente a runtime.

2.3

Le architetture stratificate ed i loro vantaggi

I sistemi software stanno diventando sempre più complessi e più grandi. Nell’ambito

della progettazione cresce sempre di più la necessità della configurazione strutturale

del sistema. In tal modo nasce il concetto di Archittetura Software. Essa viene

definita come [18]:

L’Archittetura software comprende la descrizione degli elementi partendo dai

quali vengono creati i sistemi, le interazioni tra essi, i modelli che ne gestiscono

la composizione e i limiti rispetto a questi modelli. Un determinato sistema viene

descritto attraverso un insieme di componenti e le interazioni di questi.

Un altra definizione, estremamente pragmatica, di architettura software è la

seguente:

L’Architettura software è l’insieme di decisioni progettuali le quali se non sonfatte

in modo coretto, causeranno il fallimento del progetto.

Prima d’arrivare a definire il concetto di archittetura stratificata e fornirne i

vantaggi, è bene capire come si è arrivati alla necessità di ricorrere ad architetture

nella strutturazione di un progetto software.

Il problema principale per chi si occupa di software è la manutenzione [6]. Essa

è definita come la fase che segue l’entrata in servizio di un software.

Il termine manutenzione viene usato tipicamente per descrivere due attività distinte:

1. Manutenzione evolutiva

2. Manutenzione ordinaria

24

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

Figura 2.2: Il Mainframe

La prima rappresenta i cambiamenti che il software deve subire per adattarsi

alle nuove specifiche dovute a mutamenti dei requisiti funzionali cui il software deve

rispondere. Il secondo è la rimozione di errori che in realtà non avrebbero dovuto

essere presenti, ma che sono sfuggiti alle fasi di test prima della messa in produzione

del software stesso. La maggior parte del costo del software sta nella manutenzione.

Per ridurre questi costi, si sono sviluppate architetture software via via sempre più

stabili.

Inizialmente ci fù il Mainframe. Esso prevedeva che tutto debba essere centralizzato e il Mainframe ne costituiva l’unità centrale, spesso chiamato il cervellone.

Ancor’oggi questa tipo di archittetura la troviamo nel settore bancario. A questo

Mainframe sono collegati un numero abbastanza elevato di terminali, per esempio i

diffusissimi IBM 3270. Essi sono privi di sistema operativo, dotati di poca memoria

e indipendenti da ciò che accade all’interno dei Mainframe. Nella figura 2.2. viene

rappresentato un Mainframe.

La manutenzione di questi sistemi con il passare del tempo è diventata sempre

più complessa, conducendo al concetto di legacy.

Con questo termine intendiamo un oggetto di cui non si può fare a meno, ma che

nessuno riesce più a dominare [6] e [19]. Molto spesso, associata alla legacy c’è poi

una situazione di software ormai inadeguato, che, più che subire degli aggiornamenti,

è soggetto a continue correzioni, spesso non documentate, che rendono le ulteriori

manutenzioni più difficili di giorno in giorno.

Il mainframe monolitico era destinato a scomparire sia a causa del legacy sia a

causa dei problemi di costo di manutenzione e scalabilità. La soluzione di questi

problemi venne trovata ribaltando la situazione ovvero nel diminuire il carico computazionale del server e dotare invece il terminale di funzionalità diciamo più intelligenti.

Per essere più formali, possiamo dire che questa architettura è la logica estensione

2.3. LE ARCHITETTURE STRATIFICATE ED I LORO VANTAGGI

25

Figura 2.3: Possibili configurazioni di un sistema Client-Server basato sul

modello 2-Tier

alla programmazione modulare il cui pressuposto base è la separazione di grossi stralci

di codice in tanti parti detti moduli che consentono uno sviluppo più facile e una

migliore manutenzione; inoltre non è necessario che questi moduli debbano essere

eseguiti all’interno dello stesso spazio di memoria.

Questa archittetura va sotto il nome di Client-Server.

Il Client è il modulo che esegue le richieste dei servizi e il Server quello che mette

a disposizione i servizi.

In quasi tutte le applicazioni interattive, ossia destinate ad essere utilizzate da un

operatore umano, si possono riconoscere le tre differenti componenti:

1. L’interfaccia utente

2. Il Business-Logic

3. Dati

Nel momento in cui i 3 elementi logici vengono “spalmati” su 2 elementi fisici,

l’archittetura prende il nome di 2-Tier. Se consideriamo un ambiente tipicamente

orientato alle basi di dati, possiamo schematizzare i tre livelli appena indicati come

in figura 2.3.

Nelle applicazioni 2-Tier i primi due componenti (interfaccia e business-logic) sono

unificati e il terzo è separato e rappresenta i servizi a cui accedere (es. base di dati).

Il problema di questa architettura è la scalabilità.

Nella figura possiamo vedere tre casi (A, B e C) che rappresentano come una applicazione 2-Tier può essere scritta. Purtroppo gran parti dell’applicazioni rientrano

26

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

Figura 2.4: I componenti logici di una architettura 3-Tier

nel caso C, dove non c’è una netta separazione fra server e client e ogni tier fa una

parte di quello che dovrebbe fare e una parte di quello che non dovrebbe fare.

Le architetture a 2-Tier col passare degli anni hanno cominciato a dimostrare i

loro limiti e gli sviluppatori si sono accorti che non erano più adatte a supportare il

peso delle nuove funzionalità proposte dai manager.

Per questi motivi è nata l’architettura 3-Tier, in cui i 3 elementi logici vengono

distribuiti su 3 elementi fisici. Scrivere applicazioni in questa nuova architettura

presenta una complessità decisamente maggiore ma che viene ripagata nel tempo,

migliorando molto la manutenzione.

Nella figura 2.4. vengono mostrati i componenti logici di un architettura 3-Tier.

Il presentation service gestisce l’interfaccia utente verso il sistema. Il process

service agisce come sorta di buffer tra il livello superiore e quello inferiore. Il data

service rappresenta di solito il database vero e proprio, quindi sia i dati propriamente

detti sia la logica che consente di aggiornarli, cancellarli e modificarli.

Nella figura 2.5. vengono mostrati invece i componenti fisici di un architettura

3-Tier.

A questo punto è possibile descrivere l’architettura stratificata. Come dice il

nome, quest’architettura è suddivisa in livelli. Ogni livello fornisce fornisce un servizio

più astratto ai livelli superiori, rispetto a quanto ad esso fornito da quelli inferiori.

La stratificazione favorisce lo sviluppo incrementale ed evoluzione.

2.4

Classi ed oggetti entità

Uno degli ingredienti fondamentali quando si parla di ORM sono le classi entità.

Prima avevamo parlato di achitetture software, più precisamente di architettura a

3 livelli o 3-Tier. In questa architettura i tre livelli sono: presentazione, dominio e sorgente dati. Tutta la logica business si trova nel livello dominio e qui che collocheremo

gli oggetti entità.

É chiarificante esaminare le caratteristiche di uno degli standard maggiormente

2.4. CLASSI ED OGGETTI ENTITÀ

27

Figura 2.5: I componenti logici di una architettura 3-Tier

usati per questi oggetti entità, usato nel linguaggio di programmazione Java, che

viene chiamato POJO(Plain Old Java Object). I POJO sono uno standard basato

sui Bean entità, simile agli EJB.

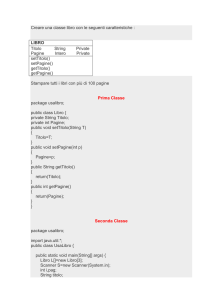

Questi file POJO devono seguire la seguente semantica:

1. Il costruttore deve essere privo di argomenti;

2. Tutti gli attributi privati che si vuole considerare devono avere dei metodi

accessori ( chiamati getter e setter essendo basati sullo standard getAttributo

per la lettura e setAttributo per la scrittura);

Gli attributi privati sono resi pubblici grazie ai metodi accessori. Risulta possibile

anche definire degli attributi virtuali allorchè i metodi accessori collegano il valore

ritornato a quello di un attributo diverso da quello corrispondente al loro nome.

Questo standard è stato esteso anche al linguaggio di programmazione C#, dove

gli oggetti entità corrispondenti vengono chiamati POCO.

Per meglio chiarire come è fatta una classe entità ecco un esempio, relativo al

modello entità-relazione della figura 2.6.

La classe entità relativa alla tabella Dipartimento può essere ottenuta con le

seguenti caratteristiche:

public class Dipartimento {

// ATTRIBUTI PRIVATI private Long

private String sede;

id; private String nome;

//COSTRUTTORE DI DEFAULT public Dipartimento() { }

public Dipartimento(String nome,String sede) { this.nome=nome;

this.sede=sede; }

28

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

Figura 2.6: Un agenzia

//METODI ACCESSORI (getAttributo E setAttributo)

public Long getId() { return id; }

private void setId(Long id) { this.id = id; }

public String getNome() { return nome; }

public void setNome(String nome) { this.nome = nome; }

public String getSede() { return sede; }

public void setSede(String sede) { this.sede = sede; }

//METODI PER LA CONVERSIONE public String toString() { ....

} }

L’equivalente nel mondo C#, il POCO, è il seguente, in cui i metodi accessori

sono sostituiti dalle proprietà che il C# eredita dal Visual Basic:

public class Dipartimento { // ATTRIBUTI PRIVATI private long

private string nome; private string sede;

//COSTRUTTORE DI DEFAULT public Dipartimento() {}

id;

2.5. ALGORITMI E STRUTTURE DATI

29

public Dipartimento(string nome, string sede) { this.nome =

nome; this.sede = sede; }

//METODI ACCESSORI (GET e SET)

public long Id { get { return id;

} set { id = value; } }

public string Nome { get { return nome;

}

} set { nome = value; }

public string Sede { get { return sede;

} }

} set { sede = value; }

Come si può notare non c’è niente di complesso, e si crea un isomorfismo tra

la tabella Dipartimento del database e la classe entità Dipartimento. Per essere

maggiormente chiari, si parla di isomorfismo fra classi entità e tabelle, quando i

nomi dei campi sono gli stessi dei nomi degli attributi della classe e i tipi dati sono

corrispondenti (ad esempio, String e Varchar, double e numeric).

Dal punto di vista esterno, la classe entità viene trattata esattamente come se

fosse una struttura (es. struct in C). Come si vedrà meglio nei capitoli seguenti, gli

elementi interni della libreria ORM NHibernate provvedono al caricamento di questa

struttura in presenza di un’operazione di lettura del database e alla lettura della stessa struttura per scrivere nel database nel caso opposto, il tutto in modo trasparente

per il programmatore. Nel caso di NHibernate, oltre alla classe entità serve anche il

file mapper, che stabilisce una corrispondenza tra campi ed attributi, per mappare

gli oggetti nel mondo Object-oriented e le tabelle nel mondo RDBMS.

Formalmente, indicando con:

• O: L’oggetto entità;

• T: Tabella o vista nel database;

• M: Il mapper in formato XML;

esiste la condizione:

∀O, ∃ < T, M, O >

2.5

Algoritmi e strutture dati

Le strutture dati sono una delle caratteristiche fondamentali per una piattaforma di

sviluppo. La necessità di mantenere in memoria un insieme di informazioni prima

della loro scrittura o dopo la loro lettura è infatti un’esigenza che si presenta in ogni

programma, dal più semplice al più complesso.

30

CAPITOLO 2. ARCHITETTURE SOFTWARE A OGGETTI

In un programma a oggetti, l’importanza delle strutture dati è ridimensionata

rispetto a un programma procedurale, in quanto sono gli oggetti stessi a mantenere le

informazioni. Nonostante questo, non potrebbe esserci cardinalità (es. più oggetti figli

per un oggetto padre) se non ci fossero strutture dati pronte a ospitare gli oggetti di

applicazione. Infatti, come si vedrà anche nel prossimo capitolo, senza una struttura

dati come la DataTable si sarebbe in grado di importare in memoria tutta una tabella

di un database, per esempio.

Diamo una definizione più precisa di struttura dati, presa da [20].

Una struttura dati è un particolar tipo di dato, caratterizzata più dall’organizzazione imposta agli elementi che la compongono, che dal tipo degli elementi

stessi.

Per essere più precisi, una struttura dati consiste di:

1. Un modo sistematico di organizzare i dati;

2. Un insieme di operatori che permettono di manipolare elementi della struttura

o di aggregare elementi per costruire altri agglomerati;

Quello che segue è una classificazione delle strutture di dati in base alle caratteristiche presentate dalla disposizione dei dati, dal loro numero e dal loro tipo.

• Lineari: Gli agglomerati sono formati da dati disposti in sequenza, tra i quali

si individua un primo elemento, un secondo, ecc.;

• Non lineari: In cui non si individua una sequenza;

• A dimensione fissa: Il numero di elementi dell’agglomerato rimane sempre

costante nel tempo;

• A dimensione variabile: Il numero di elementi può aumentare o diminuire

nel tempo;

• Omogenee: I dati sono tutti dello stesso tipo;

• Non omogenee: I dati non sono tutti dello stesso tipo;

Vedremo in seguito, che l’utilizzo di strutture di dati sono fondamentali nella buon