Il sistema

di elaborazione

Che cosa serve per eseguire delle istruzioni

e per elaborare l’informazione

in modo automatico

Un computer (in italiano anche calcolatore o elaboratore) è una macchina calcolatrice in grado di eseguire automaticamente sequenze di operazioni logico-aritmetiche

sui dati in ingresso (input) e di restituire i risultati di tali operazioni in uscita (output). Come per gran parte della terminologia informatica, l’utilizzo dell’originale

inglese prevale sulla traduzione italiana (calcolatore o elaboratore), sebbene in altre

lingue europee accada diversamente (francese: ordinateur, spagnolo: computadora

o ordenador).

Nel corso della storia, l’implementazione tecnologica di questa macchina si è

modificata profondamente sia nei meccanismi di funzionamento (meccanici, elettromeccanici ed elettronici), che nelle modalità di rappresentazione dell’informazione

(analogica e digitale) che in altre caratteristiche (architettura interna, programmabilità, ecc.). Al giorno d’oggi, ci si riferisce comunemente al computer come ad un

dispositivo elettronico e digitale, programmabile a scopo generico costruito secondo la cosiddetta architettura di von Neumann ed il modello teorico-computazionale

della cosiddetta macchina di Turing. Sebbene i computer programmabili a scopo

generico siano oggi i più diffusi esistono in specifici ambiti di applicazione modelli

di computer dedicati (automazione industriale, domotica, ecc.).

In questa forma e al pari della televisione, esso rappresenta il mezzo tecnologico

simbolo che più ha modificato le abitudini umane dal secondo dopoguerra ad oggi:

la sua invenzione ha contribuito alla nascita e allo sviluppo dell’informatica moderna,

che ha segnato l’avvento della cosiddetta terza rivoluzione industriale e della società

dell’informazione.

In sostanza un computer è in grado di eseguire operazioni logiche come ad

esempio calcoli numerici e storicamente è stato proprio il calcolo la prima forma

di applicazione del computer, ovvero il problema che ha spinto all’invenzione e alla

realizzazione del computer stesso. Dalla nascita della struttura più elementare in

seguito si sono sviluppati e succeduti molti tipi di computer, costruiti per svariati

compiti, professionali e non, che, pur affinando sempre più il calcolo numerico fino

ad arrivare al moderno calcolo scientifico ad elevate prestazioni grazie ai supercalcolatori, vanno ben oltre offrendo applicazioni diffusissime all’utente comune come

la videoscrittura in sostituzione delle vecchie macchine da scrivere e in generale applicazioni di office automation, creazione e gestione di database, la progettazione

assistita al calcolatore, la computer grafica, la simulazione, sistemi elettronici di

controllo, applicazioni di diagnostica medica, i videogiochi ecc.

Le chiavi di successo del computer sono dunque la grande potenza di elaborazione e la notevole capacità di memorizzazione che, in qualità di macchine, estendono le

rispettive capacità umane di calcolo, processamento e memorizzazione consentendo

21

applicazioni

pratiche

successo dei

computer

22

Il sistema di elaborazione

una diminuzione sensibile dei tempi richiesti per la risoluzione di un problema dato

o spesso la sua effettiva risoluzione, altrimenti non possibile. Ad essa si aggiunge la

grande usabilità grazie al suo utilizzo in molti campi dell’elaborazione dati (vedi i

sistemi embedded) e, sul fronte del consumo di massa, allo sviluppo di innumerevoli

applicazioni a favore di una vasta gamma di utenti e, nella maggior parte dei casi,

anche la semplicità di utilizzo da parte dell’utente stesso grazie all’implementazione

di sistemi di interfacciamento utente/macchina molto spesso di tipo user-friendly.

Il primo calcolatore

struttura

logica

John von

Nuemann

Alan Turing

ENIAC

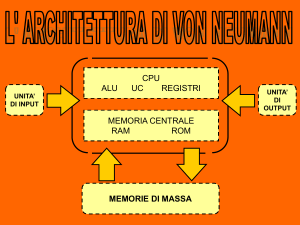

La struttura logica del computer attuale può ricondursi alla presenza di almeno

quattro elementi fondamentali o sottosistemi: un’unità centrale di elaborazione

(o CPU), un memoria, un insieme di dispositivi di input/output e un canale di

comunicazione dei dati (o Bus). Questo schema venne proposto per la prima volta

dal matematico John von Neumann all’interno di uno scritto informale del 1945 noto

come First draft of a report on the EDVAC. L’opera nasce dalla partecipazione di

von Neumann al progetto ENIAC (Electronic Numerical Integrator and Computer) e

raccoglie le idee provenienti da vari membri del team di sviluppo su come migliorare

la funzionalità del computer nascituro.

Va inoltre ricordato che von Neumann era stato profondamente influenzato da

Alan Turing, il quale aveva proposto nel 1937 un modello di calcolo - passato alla

storia come Macchina di Turing - che ben si prestava a descrivere le operazioni

eseguite da un computer, pur non essendo stato concepito per quello scopo (Turing si stava occupando in quella sede del problema della computabilità, non della

realizzazione di un calcolatore). Il funzionamento della Macchina di Turing suggerì

a von Neumann l’idea che la memoria dovesse contenere non solo i risultati delle

operazioni svolte dal computer, ma anche le istruzioni di programmazione.

Premesso il contributo degli altri progettisti dell’ENIAC e quello di Alan Turing,

a von Neumann va il merito di aver approfondito, arricchito e messo a sistema gli

spunti raccolti: motivo per il quale la struttura logica sopra indicata è oggi nota

come architettura di von Neumann.

Durante la Seconda guerra mondiale, nel 1943, il Governo degli Stati Uniti subì

una forte pressione ai fini della realizzazione di una macchina da calcolo. Questa

doveva essere capace di risolvere i problemi di calcolo balistico, l’ENIAC appunto,

per il lancio dei proiettili d’artiglieria. Il progetto, dopo ben 7.237 ore di lavoro,

fu portarono a compimento. Furono necessarie ben 18.000 valvole termoioniche

che portarono l’ambiente ad una temperatura superiore ai 50 gradi centigradi. Era

il 1946. Un anno dopo si assisterà all’invenzione del transistor, il componente

elettronico che soppianterà la valvola termoionica nella realizzazione del computer

elettronico.

L’ENIAC assorbiva tanta energia elettrica che, alla sua prima messa in funzione, causò un black-out nel quartiere ovest di Filadelfia. Durante la presentazione

ufficiale nel 1946 l’ENIAC fu in grado, in meno di un secondo, di moltiplicare il

numero 97.367 per sé stesso 5.000 volte. Alla presentazione del calcolatore seguirono, oltre ai comunicati del Dipartimento di guerra, vari articoli in giornali popolari,

Il sistema di elaborazione

23

quali ad esempio Newsweek, a dimostrazione dell’attenzione suscitata dall’ENIAC

nell’opinione pubblica.

Come tutti i primi computer era di grandi dimensioni, occupava una stanza di

m 9 × 30, per una superficie complessiva di 180m2 , e pesava 30 tonnellate. Era

costituito principalmente da 42 pannelli disposti su tre pareti della stanza. Ogni

pannello era alto circa 9 piedi, largo 2 piedi e spesso 1 piede. Sopra i pannelli erano

stati sistemati i condotti di aria per il raffreddamento. C’erano inoltre 5 pannelli

portatili che potevano venir spostati da un posto all’altro.

L’ENIAC impiegava 18.000 valvole termoioniche, collegate da 500.000 contatti

saldati manualmente, 1.500 relè e dissipava in calore una potenza termica di circa

200 kW. Ciò creava seri problemi di affidabilità perché il grande calore generato

faceva bruciare le valvole con la frequenza di una ogni 2 minuti. Lo stress termico era

maggiore soprattutto durante le fasi di accensione e di spegnimento del calcolatore,

per cui venne deciso di lasciarlo sempre in funzione. Questo provvedimento, insieme

all’adozione di valvole più affidabili a partire dal 1948, fece ridurre la frequenza di

rotture ad una media di una ogni due giorni, con un periodo massimo di 116 ore

ininterrotte nel 1954. Si calcola che, nel periodo in cui l’ENIAC è stato in funzione,

abbia richiesto la sostituzione di 19000 valvole termoioniche.

L’ENIAC, pur essendo digitale, utilizzava il sistema numerico decimale. La sua

memoria poteva contenere solo 20 numeri di 10 cifre e l’input era consentito da

schede di carta perforate. Era in grado di riconoscere il segno di un numero, confrontare numeri, e di eseguire le operazioni di addizione, sottrazione, moltiplicazione,

divisione e radice quadrata.

La programmazione avveniva tramite cavi elettrici di collegamento sui pannelli, che dovevano essere ogni volta scollegati e ricollegati, ed ogni configurazione

consentiva al computer di risolvere un diverso problema.

I maggiori limiti, oltre al calore prodotto, consistevano nei tempi piuttosto lunghi

richiesti per la programmazione, nell’affidabilità e nella quantità di memoria.

L’ENIAC rimase in funzione fino al 2 ottobre 1955; venne poi trasferito a

Washington, al museo Smithsonian Institution, dove è ancora esposto.

Alan Turing

Alan Mathison Turing (Londra, 23 giugno 1912 - Wilmslow, 7 giugno 1954) è

stato un matematico, logico e crittografo britannico, considerato uno dei padri dell’informatica e uno dei più grandi matematici del XX secolo. Il suo lavoro ebbe vasta

influenza sullo sviluppo dell’informatica, grazie alla sua formalizzazione dei concetti

di algoritmo e calcolo mediante la macchina di Turing, che a sua volta ha svolto

un ruolo significativo nella creazione del moderno computer. Per questi contributi

Turing è solitamente considerato il padre della scienza informatica e dell’intelligenza

artificiale.

Fu anche uno dei più brillanti crittoanalisti che operavano in Inghilterra, durante

la seconda guerra mondiale, per decifrare i messaggi scambiati da diplomatici e

militari delle Potenze dell’Asse. Durante la Seconda Guerra Mondiale Turing lavorò

infatti a Bletchley Park, il principale centro di crittoanalisi del Regno Unito, dove

ideò una serie di tecniche per violare i cifrari tedeschi, incluso il metodo della Bomba,

24

Il sistema di elaborazione

una macchina elettromeccanica in grado di decodificare codici creati mediante la

macchina Enigma.

Omosessuale, morì suicida a soli 41 anni, probabilmente in seguito alle persecuzioni subite da parte delle autorità britanniche a causa della sua omosessualità.

Nel 1952 era stato infatti dichiarato colpevole di grave indecenza per essere stato

sorpreso in rapporti sessuali con un altro uomo e condannato alla castrazione chimica. In suo onore la Association for Computing Machinery (ACM) ha creato nel

1966 il Turing Award, massima riconoscenza nel campo dell’informatica, dei sistemi

intelligenti e dell’intelligenza artificiale.

Tipi di computer e loro evoluzione

sistemi

embedded

accesso

condiviso

mainframe

I computer possono essere idealmente divisi in alcune categorie molto generali,

a seconda delle loro caratteristiche salienti, dell’uso che in generale se ne fa, del

software e dei sistemi operativi che fanno girare e dell’epoca in cui sono comparse.

Le definizioni nel tempo sono molto cambiate e i confini non sono mai così netti.

Una prima classificazione in base all’uso distingue tra computer general purpose ovvero riprogrammabili per svariate applicazioni dall’utente e computer special

purpose ovvero sistemi embedded dedicati ad una sola applicazione specifica come

ad esempio i microcontrollori.

Un’altra classificazione è basata sull’accesso condiviso o meno alle risorse hardware: un computer general purpose può essere monoutente oppure multiutente sfruttando il cosiddetto timesharing delle risorse e con diversi sistemi operativi. Un computer monoutente può essere monotasking oppure multitasking ovvero

può eseguire più processi in contemporanea (in pratica tutti i computer moderni).

Ovviamente un computer multiutente è anche multitasking.

Una classificazione basata sulle dimensioni, sull’evoluzione storica e sulla destinazione d’uso è invece quella che segue. In linea di massima le dimensioni dei sistemi

di elaborazione sono progressivamente diminuite nel tempo in virtù del miglioramento delle tecniche di elaborazione digitale ovvero all’alta capacità di integrazione dei

transistor all’interno dei processori ed il parallelo aumento della capacità di processamento. Computer di grandi dimensioni rimangono ora solo nei grandi centri di

calcolo.

Negli anni 40 i computer occupavano stanze intere, l’energia richiesta per il

funzionamento ed il raffreddamento era elevata e, naturalmente, erano costosissimi; per questo motivo si tendeva a sfruttarli il più possibile e, quindi, l’utilizzo

era suddiviso generalmente fra un numero di utenti piuttosto grande. Spesso la

comunicazione con la macchina sia in input che in output avveniva direttamente in

binario tramite l’uso di schede perforate.

Oggigiorno questi sistemi vengono utilizzati nelle grandi aziende, nelle banche, in

società di assicurazioni, nella pubblica amministrazione ed in tutte quelle strutture

che hanno bisogno di una potenza di elaborazione proporzionata al grande numero

di utenti che devono fruirne. Dal punto di vista estetico non sono molto più grandi

dei normali PC ma sono più potenti, però sono molto onerosi sia in termini di

investimento iniziale che di costi di gestione.

Il sistema di elaborazione

25

In un secondo tempo, negli anni sessanta, in particolare da Digital e da HP,

vennero introdotti elaboratori dal costo abbastanza ridotto da poter essere comprati anche da piccole aziende o da singoli dipartimenti di ricerca e di dimensioni

paragonabili ad un armadio. Questo permise un utilizzo più flessibile e quindi le

prime sperimentazioni in campo informatico. Per distinguerli dai mainframe venne

coniato il termine minicomputer.

minicomputer

All’inizio degli anni settanta l’introduzione del primo microprocessore, l’Intel

4004, rese disponibili computer dal prezzo abbastanza ridotto da poter essere acquistati anche da una singola persona. La prima generazione di questi dispositivi

era destinata soprattutto agli appassionati, perché di difficile utilizzo. I personal

computer possono essere considerati microcomputer.

microcomputer

La seconda generazione di microcomputer, che prende il nome popolare di home

computer, fece il suo ingresso nel mercato nella seconda metà degli anni settanta

e divenne comune nel corso degli anni ottanta, per estinguersi entro i primi anni

novanta con l’ascesa dei personal computer.

home

computer

Gli home computer, macchine a costo contenuto e di utilizzo prevalentemente

domestico, contribuirono largamente a diffondere a livello popolare l’uso del computer e all’alfabetizzazione informatica di vasti strati di popolazione (specie giovanile)

nei paesi sviluppati.

Basati su processori a 8 bit e costruttivamente molto semplici, erano dotati di

interfacce esclusivamente testuali e come memorie di massa sfruttavano, almeno

inizialmente, supporti analogici come le cassette audio (che fra l’altro, come è noto,

tendono a smagnetizzarsi con l’uso). Erano utilizzati prevalentemente come console

per videogiochi, oppure per i primi approcci con la programmazione.

Con oltre dieci milioni di macchine vendute, il più rappresentativo computer di

questa categoria fu il Commodore 64. Anche lo ZX Spectrum della Sinclair ebbe

buona diffusione.

Per Personal Computer (PC) si intende un microcomputer economico destinato, prevalentemente, a un utilizzo personale da parte di un singolo individuo. Si

distingue da un Home computer principalmente perché si prestano - grazie alle maggiori risorse hardware e software a disposizione - a utilizzi maggiormente produttivi

rispetto a questi ultimi, destinati invece a un utilizzo ludico o didattico. A differenza degli Home Computer, i PC odierni sono sempre più espandibili, sempre più

spesso hanno più processori per supportare il multitasking, inoltre si prestano alla

multimedialità, tutte cose che al tempo degli Home Computer erano considerate

quasi fantascienza; si pensi che nella maggior parte dei casi questi nemmeno erano

dotati di disco rigido e visualizzavano al massimo 16 colori standard (i mezzitoni si

ottenevano con artifici grafici).

Dato che la definizione di Personal Computer si consolidò definitivamente con

la diffusione dei computer PC IBM, oggi per Personal Computer (PC) spesso si

intende un computer da essi derivato, ma inizialmente il termine andrebbe riferito

a macchine con sistemi operativi e tipi di microprocessori del tutto diversi, quali

l’Olivetti P6060 e le prime versioni dell’Apple.

personal

computer

26

Il sistema di elaborazione

Panoramica dell’architettura di un elaboratore

struttura

generale

il case

raffreddamento

scheda

madre

periferiche

La macchina elaboratrice è adagiata all’interno di un cabinet o case e viene

alimentata elettricamente da un’unità (alimentatore), interna od esterna che fornirà

al sistema le giuste tensioni elettriche alle sue diverse componenti, nei termini della

potenza e stabilità richieste.

Dal punto di vista pratico e costruttivo tutti i computer di questa categoria,

hanno almeno una CPU, una certa quantità di memoria primaria di lavoro, generalmente volatile ma piuttosto veloce (RAM) e una certa quantità di memoria non

volatile. Quest’ultima è suddivisa in una piccola parte (ROM, PROM, EPROM,

EEPROM o Flash) in cui è scritto il primo programma da eseguire all’avvio (Boot)

del computer stesso.

Esempi di memoria ROM sono l’Open Firmware e BIOS (Basic Input Output

System), che assolvono comunque anche ad altre funzioni di base. In particolare

il BIOS ha il compito di dare i primi comandi al sistema durante la fase di avvio. In questa fase, dopo i controlli preliminari sulla funzionalità dei componenti

fondamentali (memoria RAM, tastiera, dischi, porte), per sapere come inizializzare

correttamente le periferiche presenti il BIOS legge alcuni parametri (come l’ora e

la data correnti) da una piccola memoria RAM CMOS tamponata, cioè mantenuta alimentata anche a PC spento da una batteria, del tutto separata dalla RAM

principale del computer.

Il componente forse meno essenziale, ma che caratterizza il calcolatore al primo

colpo d’occhio è l’involucro, generalmente chiamato case nei personal computer e

cabinet nei sistemi più grandi. Il telaio che meccanicamente sostiene la componentistica, l’apparato di raffreddamento generale, e l’involucro esterno caratterizzano e

in parte differenziano i molti tipi di macchine finora viste.

Elemento fondamentale è l’apparato di raffreddamento. Attualmente molti calcolatori montano sistemi di raffreddamento sui singoli chip, come CPU e GPU o

altri, i quali possono andare da una semplice alettatura per il raffreddamento ad

aria, a ventole, o a sistemi con circolazione di liquidi di raffreddamento. In aggiunta a questi, nel case del computer vengono predisposti ulteriori altri sistemi per la

circolazione e l’espulsione dell’aria calda generata. Nei cabinet dei mainframe e dei

supercomputer, il problema del raffreddamento è notevole, e l’energia in gioco spesa

nell’implementarlo è una quota rilevante del costo del sistema. Sistemi architetturalmente moderni o di piccole dimensioni riescono ad avere una generazione di calore

talmente bassa da fare a meno di ventole od altre parti in movimento, con evidenti

vantaggi, a pari dispersione termica, in termini di silenziosità o di consumi. Il telaio

e l’involucro caratterizzano visivamente la macchina, e possono situarsi in un arco

dimensionale che va dal computer palmare, alle armadiature dei grossi sistemi.

In genere i tre componenti suddetti, escludendo solitamente la parte di memoria

di massa, si trovano implementati fisicamente insieme sullo stesso circuito integrato

o sulla stessa scheda elettronica, che in questo caso viene detta scheda madre o

mainboard, o eventualmente in schede figlie o d’espansione direttamente inserite

nella stessa scheda madre.

Oltre ad eseguire programmi un computer deve anche poter comunicare con

l’esterno ovvero con l’utente o con altri dispositivi: per questo sono sempre presenti

Il sistema di elaborazione

27

un certo numero di interfacce verso vari dispositivi dette periferiche di sistema

quali ad esempio l’I/O. Quasi sempre, tranne nei casi di microcontrollori molto

semplici, è infatti prevista la possibilità di collegare una tastiera e un dispositivo

di visualizzazione (monitor, stampante, schermo). Inoltre un computer fa spesso

uso di memorie di massa per registrare dati e programmi liberando così spazio nella

memoria RAM ed è quasi sempre possibile collegare ad esso periferiche esterne e/o

schede di espansione.

Una delle schede di espansione più importanti è la scheda video che è l’elemento

hardware che si occupa dell’elaborazione delle immagini e della loro visualizzazione

sul video. Altre schede d’espansione sono la scheda audio, la scheda di rete, la

scheda Wi-Fi.

La CPU, sigla di Central Processing Unit, è uno dei componenti della macchina

di Von Neumann, il più diffuso modello teorico-implementativo di computer. Essa è

un circuito integrato programmabile dall’utente tramite programma applicativo ed è

il cervello vero e proprio del computer ovvero il dispositivo che ha il compito di elaborare (processing) le informazioni (dati) provenienti dalla memoria decodificando

ed eseguendo le istruzioni operative in codice macchina del programma e appartenenti al set di istruzioni fondamentali/specifiche della CPU. Si suddivide in Unità di

Controllo (Control Unit) ed Unità Logico Aritmetica (ALU). La sua conformazione,

detta architettura, è stata soggetta ad evoluzione nel tempo, integrando progressivamente quantità sempre maggiori di transistor, arricchendosi di memoria interna

detta cache di primo livello, aumentando la dimensione del bus dati e integrando più

di una struttura esecutiva delle istruzioni, detta pipeline, aumentando così il grado

di parallelismo. Nelle ultime versioni si hanno più CPU che coesistono insieme sullo

stesso circuito integrato, detto quindi processore multicore, ad esempio dual-core o

quad core a seconda che ospiti due o quattro processori in parallelo.

scheda video

CPU

processori

multicore

L’unità centrale di elaborazione

L’unità di elaborazione centrale (abbreviazione comunemente utilizzata: CPU) o

processore centrale è una tipologia di processore digitale general purpose la quale si

contraddistingue per sovrintendere tutte le funzionalità del computer digitale basato

sull’architettura di von Neumann.

Il compito della CPU è quello di eseguire le istruzioni di un programma presente

in memoria. Durante l’esecuzione del programma la CPU legge o scrive dati in

memoria. Il risultato dell’esecuzione dipende dal dato su cui si opera e dallo stato

interno in cui la CPU stessa si trova, e può mantenere la traccia delle operazioni

passate.

Una generica CPU contiene un’unità di controllo, un’unità aritmetico logica e

un set di registri.

L’unità di controllo (anche nota con l’acronimo CU) che legge dalla memoria

le istruzioni, se occorre legge anche i dati per l’istruzione letta, esegue l’istruzione

e memorizza il risultato se c’è, scrivendolo in memoria o in un registro della CPU.

L’unità aritmetica e logica (anche nota con l’acronimo ALU) che si occupa di

eseguire le operazioni logiche e aritmetiche.

CU

ALU

28

Il sistema di elaborazione

I registri sono speciali locazioni di memoria interne alla CPU, molto veloci, a cui

è possibile accedere molto più rapidamente che alla memoria: il valore complessivo

di tutti i registri della CPU costituisce lo stato in cui essa si trova attualmente.

FPU e MMU

Possono affiancare la CPU due unità ausiliarie: la FPU e la MMU. La FPU

(Floating Point Unit) si occupa di eseguire calcoli in virgola mobile, mentre la MMU

(Memory Management Unit) si occupa di tradurre gli indirizzi di memoria logici in

indirizzi fisici, supportando la protezione della memoria e/o uno o più meccanismi

di memoria virtuale.

istruzioni

Le istruzioni di una CPU (instruction set) sono semplicemente dei numeri, detti

macchina

opcode o codici operativi: in base al loro valore l’unità di controllo intraprende delle

azioni predefinite, come per esempio leggere la successiva locazione di memoria per

caricare un dato, oppure attivare la ALU per eseguire un calcolo, oppure scrivere il

contenuto di un registro in una certa locazione di memoria o in un altro registro,

oppure una combinazione di queste.

Per una persona, stendere programmi scrivendo direttamente gli opcode è estremamente noioso e prono all’errore. Per questo motivo si utilizza l’assembly, che

associa un simbolo mnemonico ad ogni istruzione della CPU e introduce una sintassi

che permette di esprimere i vari metodi di indirizzamento in modo più intuitivo.

GPU

Un particolare tipo di unità di elaborazione è l’unità di elaborazione grafica o

processore grafico, anche nota come GPU. Essa è una tipologia di coprocessore che

si contraddistingue per essere specializzata nel rendering di immagini grafiche.

microprocessore

Il microprocessore è attualmente l’implementazione più comune della CPU e

della GPU, utilizzato dalla quasi totalità dei moderni computer, con la caratteristica

di utilizzare, per tutte le sue elaborazioni, un insieme di istruzioni fondamentali di

base (instruction set). Il microprocessore è montato sulla scheda madre e collegato

alle altre periferiche interne (schede elettroniche) attraverso il chipset, presente

anch’esso sulla scheda madre, e relative interfacce di collegamento.

Attualmente la tendenza è di inserire anche più processori nel medesimo circuito

integrato. In particolare, da una decina d’anni, la tendenza è di inserire, nel medesimo circuito integrato, molteplici CPU tutte identiche (tale circuito integrato è

chiamato processore multicore). Da qualche anno inoltre è in atto la tendenza ad

inserire, nel medesimo circuito integrato, oltre a molteplici CPU, anche una GPU.

prestazioni

I parametri che caratterizzano un processore e permettono di valutarne le prestazioni sono la dimensione dei registri, la frequenza di clock, la quantità di memoria

cache.

dimensione

La dimensione del registro della CPU indica la quantità di dati che l’unità

dei registri

elabora e invia nell’unità di tempo. Una CPU che adotta registri di 16 bit, per ogni

accesso in lettura in memoria, legge due byte e le operazioni vengono effettuate

considerando 16 bit per volta. Tutti i registri in cui vengono conservati dati, hanno

questa dimensione. Nelle CPU attuali vengono utilizzati registri di 32 bit e 64 bit

(Architetture a 64 bit) e si sta migrando verso architetture 128 bit.

frequenza di

Un’altra caratteristica nota di un microprocessore è la sua frequenza di lavoro,

clock

detta anche frequenza di clock. Essa indica il numero di volte al secondo in cui

vengono eseguite le operazioni fondamentali della CPU. Bisogna prestare attenzione

al fatto che esistono due tipi di frequenza di clock : una interna, che gestisce

le operazioni della CPU, e una esterna, più bassa, che regola la velocità con cui

registri

Il sistema di elaborazione

29

viaggiano le informazioni sul bus di sistema. La velocità del microprocessore è

determinata dal ritmo del segnale di clock esterno, creato dalla scheda madre. Il

processore stesso poi, grazie ad un moltiplicatore interno, provvede a innalzare tale

clock alla propria frequenza lavorativa. L’unità di misura della frequenza di clock

e il megahertz, dove 1MHz è pari a 1 milione di oscillazioni al secondo, quindi un

processore da 3200MHz compie 3 miliardi e 200 mila oscillazioni, ovvero operazioni

fondamentali.

Memorie e dispositivi di memorizzazione

la memoria è la parte del computer destinata a conservare informazioni per

un certo periodo di tempo. La memorizzazione di informazioni in memoria, e il

successivo recupero delle medesime, sono funzioni fondamentali nel funzionamento

del computer.

È una parte essenziale nonché una delle chiavi di successo (assieme alla capacità

di processamento e alla riprogrammabilità) del computer grazie alla possibilità di

memorizzare, nei moderni sistemi elettronici, grandi quantità di dati ben oltre le

capacità umane. In essa sono memorizzati dati d’archivio dell’utente e le istruzioni

dei programmi sfruttabili dall’utente.

Una memoria può essere considerata astrattamente come una sequenza finita

di celle in cui ogni cella contiene una sequenza finita di bit, normalmente gestiti

a gruppi di otto detti byte. Pertanto lo spazio fisico della memoria può essere

immaginato come una sequenza di posizioni, ognuna contenente un byte. Ogni

posizione è individuata da un preciso indirizzo di memoria, normalmente espresso

tramite un numero intero positivo.

Le operazioni effettuate sulla memoria di un computer sono fondamentalmente

le operazioni di inizializzazione, scrittura e lettura.

L’ inizializzazione è il trattamento che subisce la memoria prima dell’uso normale. Alcuni tipi di memoria (per esempio la RAM elettronica) non hanno bisogno

di inizializzazione; per tali memorie, il contenuto iniziale è impredicibile. Per le memorie a sola lettura, l’inizializzazione consiste nella scrittura dei dati effettuata in

fase di produzione. Per i dischi magnetici, l’inizializzazione consiste nella scrittura

di dati che costituiscono un casellario in cui porre le informazioni utili (la cosiddetta

formattazione).

La scrittura è l’operazione di memorizzazione delle informazioni. Un esempio

di scrittura è assegnare il byte 123 alla cella di indirizzo 1000.

La lettura è l’operazione di recupero di informazioni memorizzate. Un esempio

di lettura è chiedere alla memoria il contenuto della cella di indirizzo 1000. Si accede

inoltre alla memoria e ai suoi contenuti ogni qual volta l’Unità di Controllo (Control

Unit) del Processore richiede dati utili su cui eseguire un’operazione di elaborazione.

Per parlare indifferentemente di lettura o di scrittura, si usa il termine accesso.

Per esempio, per indicare che una memoria è veloce sia in lettura che in scrittura,

si dice che ha un basso tempo di accesso.

La memoria informatica si può classificare secondo vari criteri:

operazioni

inizializzazione

scrittura

lettura

accesso

classificazione

Il sistema di elaborazione

30

• ordine di accesso (memorie ad accesso diretto o memorie ad accesso sequenziale);

• possibilità di scrittura (memorie a lettura-scrittura, memorie scrivibili una sola

volta, memorie a sola lettura);

• velocità di lettura;

• velocità di scrittura;

• costo unitario;

• volatilità;

• tecnologia (elettronica, magnetica, ottica).

volatilità

Le memorie per computer possono usare varie tecnologie che forniscono prestazioni e costi molto variabili. Spesso per le memorie veloci ma dall’alto costo unitario

si usa l’espressione memoria centrale o memoria primaria, mentre per le memorie

dal basso costo unitario ma lente si usa l’espressione memoria di massa o memoria

secondaria.

In base alla capacità di memorizzare in maniera permanente i dati si distinguono due tipologie di memoria: memorie volatili e non volatili. Le memorie volatili

perdono le informazioni se non alimentate elettricamente (lo sono la maggior parte

delle memorie elettroniche RAM), mentre le memorie non volatili mantengono le

informazioni anche se non alimentate elettricamente (lo sono tutti gli altri tipi di

memoria).

I difetti della volatilità sono il consumo di energia per conservare le informazioni, la necessità di una fonte di energia rende meno portabile e maneggevole la

memoria (i CD-ROM, per esempio, se dovessero avere un’alimentazione a batteria

per mantenere le informazioni, sarebbero molto più costosi e scomodi) e la perdita

delle informazioni in caso di malfunzionamento o manutenzione del computer.

Nonostante i loro difetti, le memorie volatili sono molto utilizzate, in quanto

hanno tempi di accesso molto inferiori a quelli di altre memorie.

La memoria primaria

memoria

virtuale

Collegata alla scheda madre tramite connettori chiamati socket ed alla CPU

tramite il BUS di sistema, la memoria primaria, chiamata anche memoria centrale

o memoria principale, contiene dati ed istruzioni in attesa che questi siano prelevati

dal microprocessore per essere elaborati, lavorando dunque in maniera strettamente

accoppiata con esso. È una parte importante del computer in quanto dalle sue

dimensioni in termini di capacità di immagazzinamento dipende dunque la quantità

massima di dati che possono essere prelevati e dunque elaborati dal processore in

condizioni di monotasking e multitasking ed è dunque considerata un parametro

prestazionale del computer stesso. Qualora la memoria primaria venga esaurita

molti sistemi di elaborazione moderni sono in grado di implementare il cosiddetto meccanismo della memoria virtuale come estensione provvisoria della memoria

primaria.

Il sistema di elaborazione

31

Per realizzare una memoria principale vengono normalmente utilizzate tecnologie

a semiconduttore (cioè vengono utilizzati circuiti integrati a base di silicio).

Tale memoria è costituita da numerosissime celle di memoria, dispositivi bistabili, capaci cioè di assumere due stati stabili alternativi attraverso i quali è possibile

memorizzare la quantità minima di informazione (1 bit). Le operazioni che possono

essere effettuate su questo componente sono due: lettura (load) e scrittura (store).

Poiché nella realtà quotidiana le scelte possibili in vari casi sono molte più di due,

un bit non è più sufficiente a rappresentarle e pertanto si è pensato di unire più

celle di memoria in registri di memoria. Se con un solo bit è possibile ottenere

solo due diversi stati, con due celle (2 bit) è possibile rappresentare 22 alternative,

con l’associazione di 3 celle (3 bit) 23 alternative, e così via... In particolare, la

dimensione del registro più diffusa è quella da 8 bit. L’unione di 8 bit forma infatti 1 byte di memoria, il primo multiplo del bit, il quale può rappresentare fino a

256 possibili combinazioni diverse (28 ). In un registro di memoria le operazioni di

lettura/scrittura avvengono contemporaneamente su tutte le celle facenti parte del

registro. In memorie con registri da 1 byte, quindi, vengono lette 8 celle alla volta.

struttura

Bisogna distinguere tra vari tipi di memorie primarie, a seconda della funzione

svolta e delle loro caratteristiche peculiari. Di seguito vengono elencate quelle più

importanti.

La memoria RAM, dall’acronimo per random access memory, ovvero memoria

ad accesso casuale, è la memoria in cui vengono caricati i dati che devono essere

utilizzati dal calcolatore per elaborare. La RAM può essere volatile (si cancella

spontaneamente ed ha bisogno di essere aggiornata), statica o tamponata (mantiene

l’alimentazione anche a macchina spenta). Il processore identifica le celle della

RAM tramite indirizzi preassegnati che ne specificano la posizione: la memoria si

presenta, quindi, come un enorme vettore (stringa ordinata di elementi detti byte,

ciascuno individuabile con un indirizzo). Il termine random evidenzia che non ci sono

differenze ad accedere alle varie celle della memoria. Le caratteristiche della RAM

vengono ereditate anche da tutte le altre memorie ad accesso casuale (individuabili

facilmente dal fatto che contengono RAM alla fine). Sostanzialmente le memorie

RAM si suddividono in DRAM (dinamiche), SRAM statiche e che vengono utilizzate

per la memoria cache.

RAM

La cache RAM è una memoria associativa integrata nel processore e ha la caratteristica di essere molto veloce; dato l’elevato costo, viene utilizzata esclusivamente

per contenere i dati e le istruzioni utilizzati più di frequente (in modo da migliorare

notevolmente le prestazioni del processore).

cache

La memoria ROM, dall’acronimo per read only memory, ovvero memoria in sola

lettura (o solamente leggibile), è una memoria permanente (cioè ha un contenuto

fisso che non può essere cancellato ed inoltre non è volatile), presente sulla scheda

madre, che contiene le istruzioni che la CPU deve caricare per consentire l’avvio del

sistema e le routine di base che prendono il nome di BIOS (Basic I/O System).

ROM

Infine la sigla EPROM, acronimo per erasable programmable read only memory,

identifica una memoria ROM cancellabile e programmabile, che è una memoria in

sola lettura, ma ha la particolarità di poter essere cancellata in particolari condizioni.

EPROM

32

Il sistema di elaborazione

Il dissco rigido

Un disco rigido o disco fisso, anche chiamato hard disk drive, è un dispositivo

di memoria di massa di tipo magnetico che utilizza uno o più dischi magnetizzati

per l’archiviazione dei dati. Esso è una periferica di input-output del computer ed

è uno dei tipi di dispositivi di memoria di massa attualmente più utilizzati essendo

presente nella maggior parte dei computer ed anche in altri dispositivi elettronici.

L’hard disk è stato inventato nel 1956 dall’IBM. Il primo prototipo era costituito

da 50 dischi del diametro di 24 pollici (circa 60 cm) e poteva immagazzinare circa

5 megabyte di dati. Era grande quanto un frigorifero, con un peso di oltre una

tonnellata. La denominazione originaria era fixed disk (disco fisso), il termine hard

disk (disco rigido) nacque intorno al 1970 per contrapposizione coi neonati floppy

disk (dischetti).

Il disco rigido è costituito fondamentalmente da uno o più piatti in rapida rotazione, realizzati in alluminio o vetro, rivestiti di materiale ferromagnetico e da due

testine per ogni disco (una per lato), le quali, durante il funzionamento volano alla

distanza di poche decine di nanometri dalla superficie del disco leggendo o scrivendo

i dati. La testina è tenuta sollevata dall’aria mossa dalla rotazione stessa dei dischi

la cui frequenza o velocità di rotazione può superare i 15.000 giri al minuto.

Tipicamente per la memorizzazione di dati digitali il disco rigido necessita dell’operazione preliminare di formattazione logica con scelta del particolare sistema

logico di archiviazione dei dati da utilizzare noto come file system, tramite il quale

il sistema operativo è in grado di scrivere e recuperare i dati.

I dati, a livello fisico, sono generalmente memorizzati su disco seguendo uno

schema di allocazione fisica ben definito in base al quale si può raggiungere la

zona dove leggere/scrivere i dati sul disco. Uno dei più diffusi è il cosiddetto CHS

acronimo per il termine inglese Cylinder/Head/Sector (Cilindro/Testina/Settore);

Un disco rigido infatti si compone di uno o più dischi paralleli, di cui ogni

superficie, detta piatto e identificata da un numero univoco, è destinata alla memorizzazione dei dati. Ogni piatto si compone di numerosi anelli concentrici numerati,

detti tracce, ciascuna identificata da un numero univoco. L’insieme di tracce alla

stessa distanza dal centro presenti su tutti i dischi è detto cilindro. Corrisponde a

tutte le tracce aventi il medesimo numero, ma diverso piatto. Ogni piatto è suddiviso in settori circolari, ovvero in spicchi radiali uguali ciascuno identificato da un

numero univoco. Su ogni piatto è presente una testina per accedere in scrittura o

in lettura ai dati memorizzati sul piatto; la posizione di tale testina è solidale con

tutte le altre sugli altri piatti. In altre parole, se una testina è posizionata sopra una

traccia, tutte le testine saranno posizionate nel cilindro a cui la traccia appartiene.

Infine l’insieme di frammenti di tracce contigui è detto cluster.

in questa struttura i dati sono memorizzati avendo come indirizzo fisico un

numero per ciascuna delle precedenti entità fisiche.

I dischi ottici

Il disco ottico è una tipologia di supporto di memoria. È costituito da un disco

piatto e sottile in genere di policarbonato trasparente. Al suo interno è inserito un

Il sistema di elaborazione

33

sottile foglio metallico, in genere di alluminio, su cui vengono registrate e lette le

informazioni tramite un raggio laser.

Il Compact disc (CD) è una tipologia standardizzata di disco ottico utilizzata

in vari ambiti per la memorizzazione di informazioni in formato digitale. Esso è

composto da un disco di policarbonato trasparente, generalmente di 12 centimetri di

diametro, accoppiato nella parte superiore ad un sottile foglio di materiale metallico

sul quale, nella parte inferiore vengono memorizzate le informazioni come successioni

di buchi e terre (in inglese pits e lands) successivamente letti per mezzo di un laser

(per questo motivo sono detti anche dischi ottici). Il primo CD per uso commerciale

venne prodotto in una fabbrica della Philips il 17 agosto 1982.

I CD hanno una struttura paragonabile a quella dei normali dischi musicali in vinile: i dati sono ordinati lungo un’unica traccia a forma di spirale, un’organizzazione

quindi molto diversa da quella dei dischi magnetici (hard disk e floppy disk). La

spirale parte al centro (contrariamente ai dischi in vinile) e procede verso l’esterno,

permettendo così di avere CD più piccoli dello standard (per esempio i mini-CD o i

CD a forma di carta di credito).

La struttura a spirale del CD-ROM è tale da massimizzare le prestazioni per

l’accesso sequenziale a scapito dell’accesso diretto. Inoltre poiché il compact disc

non offre alcuna protezione contro la manipolazione e l’usura, è frequente la formazione sulla superficie di graffi o depositi di sporco che possono comprometterne la

lettura. Per ovviare al problema sono adottate complesse tecniche di correzione di

errore e di ridondanza dei dati.

Una caratteristica dei CD audio è data dalla velocità di lettura costante. Il

principio stabilisce che il laser deve leggere i dati a velocità uniforme, sia che si

tratti della parte esterna sia quella interna del disco. Questo si ottiene variando la

velocità di rotazione del disco, che passa da 500 giri al minuto al centro a 200 giri

al minuto all’esterno. I CD dati invece possono essere letti tranquillamente anche a

velocità variabile. Per ottenere prestazioni di lettura elevate il disco viene pertanto

fatto girare a velocità costanti ed elevate, pur se questo comporta un leggero rumore.

La velocità di lettura dati è una caratteristica fondamentale di un CD-ROM: essa

viene contrassegnata da un numero standard seguito da una x, equivalente a 153,6

kB/s (ad es. 4x = 614,4 kB/s). Questa velocità di base indicata con x è quella

a cui vengono letti i CD audio registrati in PCM con 44100 campioni al secondo,

ognuno da due byte per l’altoparlante destro e altri due per quello sinistro.

I formati fisici dei CD sono i seguenti:

• CD Audio: fu il primo tipo di compact disc messo in commercio nei primi

anni ottanta, concepito per la memorizzazione di flussi audio.

• CD-ROM: acronimo di Compact Disc Read Only Memory, sono usati per la

memorizzazione di dati generici. Si ottengono per stampa, con appositi macchinari industriali. I CD-ROM di più larga distribuzione hanno una capienza

di 74 minuti/650 MB e di 80 minuti/700 MB, mentre più rari sono i formati

da 90 minuti/800 MB e da 100 minuti/870 MB.

• CD-R: è la sigla che contraddistingue i compact disc masterizzabili (dall’inglese Compact Disc-Recordable). I CD-R appartengono alla famiglia di supporti

CD

pits a lands

34

Il sistema di elaborazione

di tipo WORM (Write Once Read Many), cioè di quelli che possono essere scritti (masterizzati) una sola volta in maniera permanente ed essere letti

molte volte.

• CD-RW: è la sigla che contraddistingue il CD riscrivibile (Cd Rewritable),

un particolare tipo di CD in cui i dati possono essere modificati anche dopo la prima masterizzazione. Noto con il nome di CD-E (CD-Erasable, CD

cancellabile) durante il suo sviluppo, è stato introdotto nel 1997.

DVD

Blu Ray

HD-DVD

Il DVD, acronimo di Digital Versatile Disk (in italiano Disco Versatile Digitale,

originariamente Digital Video Disc, Disco Video Digitale) è il prodotto della cooperazione di alcune fra le maggiori aziende nel campo della ricerca e dell’elettronica

di consumo: l’associazione d’imprese che si incaricò di redigere le specifiche del

nuovo supporto, era infatti formata da Philips, Sony, Matsushita, Hitachi, Warner,

Toshiba, JVC, Thomson e Pioneer. L’intento era quello di creare un formato di

immagazzinamento di grandi quantità di video digitali che fosse accettato senza

riserve da tutti i maggiori produttori, evitando quindi tutti i problemi di incertezza

del mercato dovuti alla concorrenza fra formati che si erano presentati al tempo

dell’introduzione delle videocassette per uso domestico.

Il formato del DVD fu introdotto nel 1995. Il formato DVD-R, lo standard

ufficiale per i DVD Registrabili, è stato invece formalizzato nel corso del 1999. Nel

2000 è stato formalizzato lo standard DVD-RW, che ricalca le caratteristiche dei

DVD-R. Negli anni necessari alla formalizzazione dello standard DVD-R, sono stati

commercializzati altri 2 formati per la registrazione in formato DVD: il DVD+R

(e DVD+RW) dal consorzio Sony-Philips. Questi formati differiscono notevolmente

dal formato DVD-R in termini tecnici, anche se i più moderni lettori e masterizzatori

sono in grado di supportare DVD registrabili in qualunque formato. Più recente è

l’introduzione di standard per la masterizzazione di DVD a doppio strato e con

una capienza di circa 8,5 GB di informazioni. Il formato DVD+R Double Layer

(c.d. DVD+R DL) fu introdotto nel 2002, mentre solo nel 2004 si è formalizzato

lo standard ufficiale DVD-R DL.

Il Blu-ray Disc (acronimo ufficiale BD) è il supporto ottico proposto dalla Sony

agli inizi del 2002 come evoluzione del DVD per la televisione ad alta definizione.

Grazie all’utilizzo di un laser a luce blu (405 nm), di lunghezza d’onda più corta

rispetto al CD (720 nm) ed al DVD (650 nm), il Bluray riesce a contenere fino a

200 GB di dati, ovvero quasi 40 volte di più rispetto a un DVD Single Layer-Single

Side (4,7 GB). Tuttavia un disco da 25 GB risulta sufficiente per contenere circa 2

ore di filmato ad alta definizione utilizzando il tradizionale codec MPEG-2.

anche l’HD DVD (acronimo di High Definition Digital Versatile Disc) era un

formato ottico digitale sviluppato al fine di diventare uno standard per i DVD di

nuova generazione adatti ai contenuti ad alta definizione, promosso da Toshiba,

NEC, Sanyo, Microsoft e inizialmente supportato da Paramount Pictures, Dreamworks e da Universal Studios. Ma il 19 febbraio 2008 Blu-ray ha definitivamente

vinto la sua competizione con l’HD DVD, visto che Toshiba, titolare dei diritti sullo

standard concorrente, ha dichiarato la chiusura del progetto e la dismissione delle

attività collegate.

Il sistema di elaborazione

35

Gerarchie di memoria

La grande quantità di dati normalmente presente in un elaboratore è memorizzata su supporti che possono presentare caratteristiche molto diverse tra loro, in

termini di tempo di accesso, di capacità e di costo. Tali supporti sono organizzati

come una struttura gerarchica in cui al livello più alto troviamo i dispositivi di memoria più lenti, con capacità maggiore e meno costosi; man mano che si scende in

questa gerarchia, i supporti hanno capacità sempre più piccola, tempo di accesso

sempre più basso e costo maggiore. L’obbiettivo che si vuole raggiungere è quello

di ottimizzare il rapporto prestazioni/costo, ottenendo, così, prestazioni equiparabili

al caso in cui tutte le informazioni necessarie siano disponibili al livello più basso

della gerarchia, con un costo paragonabile al caso in cui siano concentrate al livello

più alto.

In un elaboratore comune una tipica gerarchia di memoria è quella in cui si trova,

al livello più alto, il disco fisso, dove le informazioni vengono conservate in maniera

permanente. Subito dopo si trova la memoria principale (DRAM/SDRAM), di

elevata capacità nell’ordine del GB, basso costo e basso tempo di accesso. Qui

vengono conservate le informazioni relative ai processi in esecuzione: quando un

nuovo processo viene caricato, vi verranno trasferite almeno le informazioni basilari

che ne permetteranno la messa in esecuzione. Nel caso tale livello della gerarchia

risultasse saturo, verranno adottate politiche di ottimizzazione che possono consistere dalla compattazione della memoria allo swap-out delle pagine, il quale consiste

nel trasferimento di informazioni al livello superiore, ossia al disco fisso.

Ai livelli inferiori abbiamo la memoria cache; possono esistere più livelli di questo

tipo di memoria e vengono normalmente indicati con una serie decrescente di numeri,

via via che si scende nella gerarchia. Normalmente il livello cache L1 è on-chip, ossia

è direttamente presente nella CPU in maniera tale da ridurre fisicamente la latenza

dei collegamenti. Il livello più basso della gerarchia è sicuramente rappresentato

dai registri del processore il cui tempo di accesso è valutabile in un ciclo di clock.

disco fisso

RAM

swap

cache

registri

Dispositivi di Input-Output

Con il temine periferica si intende qualunque apparecchiatura elettronica hardware che possa essere connessa ad un computer per ricevere od inviare dati. Si

distinguono in periferiche di output (es: monitor) quando ricevono dati, di input

(es: tastiera) quando li inviano. Alcune periferiche posso svolgere entrambe le

funzioni (es: chiavetta usb).

La tastiera

La tastiera è un dispositivo di input del computer atto all’inserimento manuale

di dati nella memoria del computer e al controllo del computer stesso. Per l’utilizzo

efficiente e veloce della tastiera alfanumerica esiste una tecnica, la dattilografia, nata

con la macchina per scrivere. Nella maggior parte dei casi la tastiera alfanumerica

ha mutuato infatti la disposizione dei tasti da tale dispositivo.

Sono adottati vari schemi per la disposizione dei tasti delle tastiere alfanume-

QUERTY

36

tastierino

numerico

Il sistema di elaborazione

riche. Il più comune di essi è il QWERTY. Generalmente ci sono 103 tasti nella

disposizione QWERTY (dalle lettere della prima riga di tasti), alcuni dei quali con

funzioni particolari. Ogni tasto è associato ad una lettera, ad un numero, ad un

segno grafico oppure ad una funzione. Il nome QWERTY deriva dalla sequenza

delle lettere dei primi sei tasti della riga superiore della tastiera

La tastiera alfanumerica può essere dotata della cosiddetta tastierina numerica

(anche detta tastierino numerico). La tastierina numerica è un gruppo di tasti che

replica i tasti dei numeri e degli operatori aritmetici. Tali tasti sono disposti tutti

affiancati e hanno la funzione di velocizzare le operazioni aritmetiche per chi ne fa

un utilizzo intenso (ad esempio un contabile).

Dispositivi di puntamento

joystick

trackball

emulatori

touch pad

touch screen

Il dispositivo di puntamento è un sistema di input che permette un accesso alle

zone di manipolazione dati. Il puntatore di norma è una freccia, ma può assumere

diverse forme, secondo le funzioni del programma che lo sta impiegando. Il dispositivo di puntamento più comune è il mouse che possiede almeno due tasti (tasto

destro e sinistro), configurabili. Viene detto comunemente click la pressione del

tasto sinistro del mouse, click destro la pressione del tasto destro, drag and drop

la pressione continua con trascinamento, doppio click una doppia pressione veloce

del tasto. Attraverso Accesso Facilitato, opzione che si trova nei sistemi operativi

Windows è possibile impostare delle facilitazioni per l’uso della mouse. In commercio esistono una vasta gamma di prodotti che risolvono i diversi problemi che molti

disabili incontrano nell’utilizzo del mouse.

Il Joystick è una periferica che trasforma i movimenti di una leva manovrata

dall’utente in una serie di segnali elettrici o elettronici che si traducono in degli

spostamenti del puntatore. Le direzioni nelle quali si può spostare la leva sono

prefissate solitamente a otto ed è dotato di pulsanti che riproducono tutte le funzioni

del mouse e che ne regolano la velocità del puntatore.

La Trackball è un mouse che consiste in una sfera applicata ad un contenitore.

La sfera viene spostata con le dita. La trackball funziona quindi come una specie

di mouse al contrario. Il contenitore e la sfera solitamente sono fatti di materiale

plastico. Il vantaggio della trackball è che così solo poche dita debbono muoversi e

la mano è a riposo

Gli emulatori di mouse sono dei sistemi hardware/software che per mettono di

utilizzare il mouse col capo, con gli occhi e con altri moventi se volontari e controllati

Il Touch Pad è una periferica che serve per spostare il puntatore sul monitor

utilizzando il proprio dito su una piccola superficie sensibile di forma quadrata o

rettangolare e di dimensioni variabili. Il touch pad può essere integrato oppure

esterno.

Il Touch screen è un dispositivo hardware che consente all’utente di interagire

con un computer toccando lo schermo. Lo si può dunque considerare come l’unione

di un dispositivo di output (lo schermo) e un dispositivo di input (il sistema che

rileva il contatto con lo schermo stesso, ricavandone la posizione). Quest’ultimo

meccanismo è alternativo all’uso di altri dispositivi di puntamento come il mouse o

la touch pad.

Il sistema di elaborazione

37

I sensori

Un sensore è un dispositivo che trasforma una grandezza fisica in un segnale

tipicamente elettrico. Sono dei particolari pulsanti di tipo on-off che permettono

alla persona con disabilità di interfacciarsi ad un computer, ad un piccolo elettrodomestico ecc. In relazione alle modalità di attivazione essi si distinguono in diverse

tipologie.

• Meccanici: il loro sistema di funzionamento si basa su meccanismi meccanici

attivabili attraverso semplici pressioni. Pulsanti, lamelle, leve ecc...

• Pneumatici: l’attivazione del comando avviene attraverso la rilevazione di una

variazione di pressione provocata da un soffio od un succhio.

• Acustici: il funzionamento si basa sulla rilevazione di un suono

• Ottici: si basano generalmente su delle fotocellule che rilevano i movimenti

della persona.

• Biopotenziali: sfruttano la produzione di impulsi elettrici o la variazione dei

potenziali.

• Multipli: vanno intese quelle apparecchiature che permettono l’emulazione

del mouse.

Il monitor video

Il monitor video è un apparecchio elettronico che consente la valutazione dei dati

in uscita da diverse tipologie di strumentazione sotto l’aspetto di immagini visibili.

Esso dunque assolve la funzione di trasduttore di segnali elettrici o elettromagnetici

in ingresso in segnali visivi o ottici bidimensionali in uscita. Le immagini video

possono essere statiche o in movimento. Può eventualmente essere dotato di casse

per la riproduzione dell’audio e di altri tipi di connettori (es. USB). Il monitor viene

anche chiamato videoterminale.

Il componente principale di un monitor è il display, cioè il dispositivo elettronico

per la visualizzazione. In base alla tecnologia usata si distinguono diverse tipologie

di display.

Lo schermo a tubo catodico o schermo CRT, è una tipologia di display ormai

quasi del tutto soppiantata, a partire dall’inizio del secolo, dallo schermo a cristalli

liquidi e dallo schermo al plasma. Quando è utilizzato per applicazioni video (ad

esempio per realizzare monitor e televisori) è anche chiamato cinescopio. Per creare

le immagini lo schermo a tubo catodico utilizza un tubo a raggi catodici nel quale

i raggi catodici sono convogliati ad hoc su di una superficie fotosensibile.

Attualmente per la tecnologia del tubo catodico è in corso una progressiva obsolescenza in favore dei display a matrici di pixel, quali quelli basati su tecnologie al

plasma, a o cristalli liquidi, meno ingombranti e con costi di produzione in continua

discesa. I monitor a tubo catodico presentano il vantaggio, rispetto alle tecnologie

display

CRT

38

plasma

LCD

prestazioni

risoluzione

contrasto

tempo di

risposta

Il sistema di elaborazione

concorrenti, di una migliore velocità di reazione (o minore latenza, molto apprezzata nell’uso dei videogiochi), immagini con colori più fedeli e più parsimoniosi nei

consumi e il consumo si riduce ulteriormente in caso di immagini scure.

Gli schermi al plasma, in sigla PDP (del corrispondente termine inglese plasma

display panel), sono luminosi, hanno un ampio gamut di colori e possono essere prodotti in grandissime dimensioni, fino a 262 cm (103 pollici) diagonalmente.

Recentemente al CES di Las Vegas di gennaio 2008, Panasonic ha presentato un

prototipo di pannello da ben 150 pollici, che è attualmente lo schermo piatto più

grande del mondo mai realizzato. Hanno un grandissimo livello di nero, creando

il nero perfetto desiderabile per guardare i film. Il pannello dello schermo è largo

soltanto 6 centimetri, mentre la larghezza totale, inclusa la parte elettronica che

gestisce lo schermo, è inferiore ai 10 centimetri.

Il vantaggio principale della tecnologia per schermi al plasma è che si può produrre uno schermo molto grande utilizzando materiali molto sottili. Siccome ogni

pixel viene acceso individualmente, l’immagine è molto luminosa ed ha angolo di

visione molto ampio.

Lo schermo a cristalli liquidi, in sigla LCD dalla corrispondente espressione

inglese liquid crystal display, è una tipologia di display a schermo piatto utilizzata

nei più svariati ambiti, con dimensioni dello schermo che variano da poche decine

di millimetri a oltre 100 pollici.

L’LCD è basato sulle proprietà ottiche di particolari sostanze denominate cristalli

liquidi. Tale liquido è intrappolato fra due superfici vetrose provviste di numerosissimi contatti elettrici con i quali poter applicare un campo elettrico al liquido

contenuto. Il pannello presenta una retroilluminazione e, controllando la torsione

dei cristalli liquidi in ogni pixel, si può dunque regolare quanta luce far passare.

Una delle caratteristiche principali dei pannelli a cristalli liquidi (fatta salva la

retroilluminazione) è il basso consumo di potenza elettrica, che li rende di per sé

particolarmente indicati per applicazioni in apparecchiature alimentate da batterie

elettriche. Inoltre gli schermi LCD sono oggi caratterizzati da una luminosità molto

elevata.

Le caratteristiche principali di uno schermo sono la risoluzione (solo per gli

schermi a matrice), la luminosità, il contrasto, il tempo di risposta e l’angolo di

visuale.

La risoluzione dello schermo è il numero dei pixel orizzontali e verticali presenti

o sviluppabili in uno schermo. Ad esempio, una risoluzione di 640x480 ad esempio

indica che l’immagine sul monitor è formata da 640 colonne e 480 righe.

Il contrasto è il rapporto o differenza tra il valore più alto (punto più luminoso)

e il valore più basso (punto più scuro) della luminosità nell’immagine. Se si aumenta

tale differenza i valori più luminosi tendono al valore massimo e i valori più scuri

tendono al valore minimo. I valori intermedi non cambiano.

Il tempo di risposta, espresso in millisecondi, è la somma del tempo per accendere un pixel (tempo di salita) e del tempo per spegnerlo (tempo di discesa). Se

tale tempo è troppo lungo, le immagini in movimento appaiono con uno strascico.

Attualmente, il tempo di risposta più breve tra i monitor LCD in produzione, è di

2 millisecondi (nei plasma è di 0,001 millisecondi, primato della Panasonic). I due

Il sistema di elaborazione

39

tempi possono differire uno dall’altro, alcuni produttori forniscono entrambi i dati:

tempo di accensione e tempo di spegnimento.

L’angolo di visuale è l’angolo massimo tra la linea di vista e la perpendicolare

allo schermo, oltre il quale la luminosità o la cromaticità dell’immagine risultano

alterati.

La stampante

Una stampante è un apparecchio capace di trasferire su carta i dati forniti da

un computer, siano essi dati in formato testuale o sotto forma di immagini digitali.

Ve ne sono di tre categorie principali

• ad aghi: ormai vecchie ed obsolete. Come le macchine da scrivere usano un

sistema di aghi che battono su un nastro inchiostrato. Molto lente, imprecise

e rumorose

• a getto d’inchiostro: più veloci e precise delle stampanti ad aghi. Spruzzano

un sottilissimo getto d’inchiostro sul foglio. Sono generalmente a colori. Sono

le stampanti economiche più comuni per uso domestico.

• laser: le più veloci, silenziose e precise. Usano una tecnologia simile a quella

delle fotocopiatrici. Sono generalmente in bianco e nero ma ne esistono anche

a colori (molto costose)

Esistono poi altri tipi di stampanti professionali (per es. i Plotter, usati per il disegno

tecnico su grandi formati) Generalmente la stampante si collega alla porta parallela

ma le ultime usano la porta USB.

angolo di

visuale