Davide Briani

Liceo Scientifico E. Curiel, classe 5G

Padova, 7 luglio 2012

Il pensiero artificiale: è possibile?

Una visione di insieme sul dibattito odierno

2

Indice

I

Prefazione

0.1

II

7

Preambolo e materie coinvolte . . . . . . . . . . . . . . . . . .

Pensiero e intelligenza artificiale

9

11

1 Introduzione

13

1.1 L’Intelligenza Artificiale . . . . . . . . . . . . . . . . . . . . . 13

1.2 L’I.A. nella storia . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.3 Il contributo di Turing e le reti neurali . . . . . . . . . . . . . 14

2 IA: La questione filosofica

2.1 Il test di Turing . . . . . . . . . . . . . .

2.1.1 La critica relativa all’incapacità .

2.1.2 L’obiezione matematica . . . . .

2.1.3 La critica sulla consapevolezza . .

2.2 Searle: la rappresentazione . . . . . . . .

2.3 Heidegger: il Dasein e l’essere nel mondo

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 La coscienza e il rapporto tra mente e corpo

3.1 Cos’è la coscienza? . . . . . . . . . . . . . . .

3.1.1 La visione fisicalista . . . . . . . . . .

3.1.2 La visione non-fisicalista . . . . . . . .

3.2 Conclusioni . . . . . . . . . . . . . . . . . . .

4 Le reti neurali artificiali

4.1 Struttura del neurone biologico . . . . . . . .

4.2 Il neurone artificiale . . . . . . . . . . . . . . .

4.3 Struttura di una rete . . . . . . . . . . . . . .

4.4 Principali componenti di un neurone artificiale

4.4.1 Pesi sinaptici . . . . . . . . . . . . . .

4.4.2 Funzioni di somma e di attivazione . .

3

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

17

18

18

19

19

20

23

.

.

.

.

29

31

32

35

38

.

.

.

.

.

.

41

42

43

44

47

47

47

4

INDICE

4.4.3 Funzioni di trasferimento e di limitazione . .

4.4.4 Rumore e temperatura del neurone . . . . .

4.4.5 Funzione di output: competizione . . . . . .

4.4.6 Funzione di errore . . . . . . . . . . . . . . .

4.4.7 Funzione di apprendimento . . . . . . . . .

Tipologie di apprendimento . . . . . . . . . . . . .

4.5.1 Apprendimento supervisionato . . . . . . . .

4.5.2 Apprendimento non supervisionato . . . . .

4.5.3 Apprendimento per rinforzo . . . . . . . . .

4.5.4 Velocità di apprendimento . . . . . . . . . .

4.5.5 Regole principali per l’apprendimento . . . .

Considerazioni sulle reti neurali . . . . . . . . . . .

4.6.1 Successi e insuccessi . . . . . . . . . . . . .

4.6.2 Campi di utilizzo . . . . . . . . . . . . . . .

Esempio di utilizzo . . . . . . . . . . . . . . . . . .

4.7.1 Matematica: Approssimazione della funzione

4.5

4.6

4.7

5 IA:

5.1

5.2

5.3

III

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

seno

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

49

50

51

51

52

52

52

54

55

55

56

58

58

60

61

61

il contributo di Gödel

65

I teoremi di incompletezza . . . . . . . . . . . . . . . . . . . . 66

Interpretazioni e dibattito . . . . . . . . . . . . . . . . . . . . 69

Conclusione . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

Riferimenti

73

Bibliografia

75

Sitografia

77

Filmografia

78

Elenco delle figure

1.1

Alan Turing (1912-1954) . . . . . . . . . . . . . . . . . . . . . 14

2.1

2.2

2.3

2.4

2.5

John Searle (1932) . . . . . .

Marvin Minsky (1927) . . . .

Hubert Dreyfus (1929) . . . .

Anirban Bandyopadhyay . . .

Martin Heidegger (1889-1976)

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

20

22

23

24

24

3.1

3.2

3.3

3.4

3.5

3.6

Joseph E. LeDoux (1949) . . . .

Renato Cartesio (1596-1650) . .

Hilary Putnam (1926) . . . . .

Galileo Galilei (1564-1642) . . .

Vincenzo Tagliasco (1941-2008)

Riccardo Manzotti . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

30

31

33

33

36

37

4.1

4.2

4.3

4.4

4.5

4.6

4.7

4.8

4.9

Struttura di un neurone naturale . . . . . . . . . . . . . .

Struttura di un neurone artificiale . . . . . . . . . . . . . .

Esempio di rete neurale multistrato . . . . . . . . . . . . .

Il modello del Percettrone . . . . . . . . . . . . . . . . . .

Funzioni di trasferimento più comuni . . . . . . . . . . . .

Set di punti P(input, output) per l’apprendimento di sin(x)

Output dell’approssimazione della rete neurale a sin(x) . .

Confronto tra l’approssimazione di sin(x) e sin(x) . . . . .

Diminuzione dell’errore quadratico medio della rete . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

43

44

45

46

49

62

63

63

64

5.1

5.2

5.3

5.4

5.5

5.6

Kurt Gödel (1906-1978) . . .

Bertrand Russell (1872-1970)

Douglas Hofstadter (1945) . .

Roger Penrose (1931) . . . . .

Piergiorgio Odifreddi (1950) .

Jean-Yves Girard (1947) . . .

.

.

.

.

.

.

.

.

.

.

.

.

66

67

68

68

70

71

5

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

ELENCO DELLE FIGURE

Parte I

Prefazione

7

0.1. PREAMBOLO E MATERIE COINVOLTE

0.1

9

Preambolo e materie coinvolte

Il testo sviluppato si prefigura come il frutto di un approfondimento personale su un tema di notevole interesse per l’autore; un esito di tale ricerca è

stato quello di notare come, partendo da un quesito apparentemente estraneo

all’attività didattica affrontata durante il quinto anno di studi, la strada si

ricolleghi invece ad alcuni temi ed autori del programma svolto.

Le macchine possono pensare?

Questo interrogativo conduce a questioni care ai ricercatori delle scienze

cognitive, come quella dell’intelligenza e della coscienza artificiali. Sebbene

di ampio respiro, l’argomento viene trattato sviluppando i punti principali

che lo caratterizzano, cercando di offrire una trattazione chiara e agevole.

Per quanto il tema venga esposto nei suoi caratteri più generali, alcune

materie e aree di studio vengono maggiormente toccate, come Matematica

e Filosofia. Nel tentativo di trovare una risposta alla domanda iniziale circa

la possibilità di un pensiero artificiale, il testo contiene riferimenti a idee e

concezioni di personaggi anche illustri: Heidegger, Gödel, Minsky, Galilei,

Turing, Searle, Cartesio, Odifreddi; si parte dunque dal dualismo cartesiano tra materia e spirito per giungere agli odierni orientamenti della ricerca

scientifica e filosofica. All’interno dello scenario moderno e del ventaglio

delle concezioni correnti riguardo l’intelligenza artificiale viene esplicitato il

contributo di diversi pensatori: cosı̀ per alcuni come Tagliasco o Manzotti

la quantificazione galileiana della realtà è una visione distorta e riduttiva e

occorrono nuovi strumenti di indagine per studiare il pensiero, mentre altri

come Turing o Minsky ritengono possibile giungere a vere menti artificiali; il

Teorema di incompletezza di Gödel si posiziona come un nodo fondamentale

del dibattito circa l’impossibilità delle macchine di affrontare problemi che

gli umani sono in grado di risolvere; il Dasein di Heidegger è quell’ essere nel

mondo che da alcuni viene contestato a macchine incapaci di interagire adeguatamente con l’ambiente esterno e di possedere un sufficiente background

culturale o senso comune. Obliquamente al ventaglio di riflessioni filosofiche

e, per cosı̀ dire, astratte prendono posto le reti neurali artificiali, sistemi di

elementi adattivi a somiglianza dei neuroni naturali che seguendo modelli

matematici tentano di riprodurre la capacità dell’uomo di imparare a partire

dagli input dell’ambiente esterno e di agire di conseguenza.

Per semplicità, nella stesura del testo si è cercato di operare delle suddivisioni in sezioni e paragrafi, correlati da formule, immagini, grafici e alcuni

esempi.

10

Parte II

Pensiero e intelligenza

artificiale

11

Capitolo 1

Introduzione

1.1

L’Intelligenza Artificiale

L’Intelligenza Artificiale è una disciplina sviluppata in un periodo relativamente recente che si prefigge due scopi: lo studio dei principi e dei meccanismi che sono alla base dell’intelligenza umana e la realizzazione di prodotti

artificiali in grado di riprodurre comportamenti intelligenti.

1.2

L’I.A. nella storia

L’espressione intelligenza artificiale venne coniata per la prima volta in un

seminario tenutosi nel 1956 a Dartmouth, negli Stati Uniti. In quell’occasione

Marvin Minsky, uno dei fondatori della disciplina, definı̀ l’IA come la scienza

che fa fare alle macchine cose che richiederebbero intelligenza se fossero fatte

dagli uomini. Alcuni studiosi non sono d’accordo, perché considerano l’IA

non una vera e propria scienza, ma un’area di ricerca tecnologica. La definizione di Minsky ha comunque il pregio di chiarire gli scopi dell’IA: costruire

macchine in grado di dare prestazioni intelligenti.

Ad ogni modo, l’idea di costruire artefatti o automi che si comportano

come uomini o animali risale addirittura all’antico Egitto. Ci è stato infatti

tramandato che venivano costruite statue di divinità azionate da congegni

elementari come leve e girelle. L’abilità nel costruire automi ebbe però il suo

massimo sviluppo dal Rinascimento in poi; si racconta che Leonardo da Vinci

avesse costruito un leone animato, ma il più famoso costruttore di automi fu

Vaucanson che nel Settecento fabbricò un suonatore meccanico di flauto che

era in grado di eseguire diversi pezzi musicali e un canarino meccanico che

mangiava e digeriva.

13

14

CAPITOLO 1. INTRODUZIONE

Nel Seicento si diffuse la moda dei giochi idraulici e degli automi da giardino. Fu proprio osservando gli automi idraulici nei giardini di Fontainbleau

che Cartesio concepı̀ l’idea che il corpo umano fosse una macchina. La filosofia di Cartesio, che opera la famosa distinzione fra res extensa e res cogitans,

cioè fra il meccanicismo del corpo e la spiritualità della mente, è perfettamente compatibile con la costruzione di automi: i corpi umani e animali

sono riproducibili meccanicamente, il pensiero invece appartiene alla sfera

spirituale e non è pertanto riproducibile.

Fu Thomas Hobbes a contestare questa concezione spiritualistica del pensiero contrapponendovi una concezione materialistica; egli affermava, infatti,

che ragionare equivale a calcolare, in altre parole a fare operazioni di somma

o sottrazione fra idee o nomi. L’idea che il ragionamento sia un calcolo e sia

pertanto riproducibile meccanicamente, è condivisa dai moderni studiosi di

IA. Ma per poter arrivare ai primi tentativi di realizzazione dell’IA stessa,

la scienza è dovuta giungere alla costruzione dei calcolatori elettronici e ha

dovuto interrogarsi sul significato del termine intelligenza.

1.3

Il contributo di Turing e le reti neurali

Nel cammino che conduce alla ricerca odierna sull’intelligenza e sugli automi, è necessario ricordare

il contributo dato da Alan Turing, uno dei “padri”

del calcolo automatico. Egli sviluppò le basi teoriche dell’informatica nel 1936, introducendo un

modello di “macchina calcolatrice programmabile” chiamata appunto macchina di Turing. Per

la realizzazione di questo modello egli prese spunto da analogie con il cervello e nel 1950 pubblicò

la sua teoria scrivendo un articolo ove sostenne

la possibilità di realizzare un programma che perFigura 1.1: Alan Turing mettesse a un computer di comportarsi in maniera

(1912-1954)

intelligente.

Lo sviluppo delle reti neurali artificiali, nuovo

campo di ricerca che tentava di ideare modelli artificiali del cervello umano,

fu di poco successivo alla pubblicazione della macchina di Turing. Infatti

agli inizi degli anni ’40, alcuni pionieri del campo dell’intelligenza artificiale

cominciarono a studiare le potenzialità e le capacità derivanti dalla interconnessione di numerosi elementi semplici basati sul modello fisiologico semplificato di un neurone. Cominciò allora ad avviarsi la ricerca e lo studio

delle reti neurali artificiali ed un primo esempio di rete si ebbe già nel 1943,

1.3. IL CONTRIBUTO DI TURING E LE RETI NEURALI

15

quando McCulloch e Pitts proposero un primo modello di neurone artificiale

e la connessione di un gruppo di queste unità. Le teorie di McCulloch e Pitts

mancavano però di un passo fondamentale: la possibilità di apprendimento.

Per questo nel 1949 lo psicologo Hebb propose un semplice meccanismo di

apprendimento ispirandosi al sistema nervoso.

Vari ricercatori e studiosi si ispirarono alle idee di Turing ed infatti durante la conferenza di Dartmouth si mostrò anche il primo programma che

realizzava dimostrazioni automatiche di teoremi: il programma LT. Dalla

data della conferenza il dibattito sulla intelligenza artificiale si fece sempre

più vivo, anche se le reti neurali restarono in secondo piano: lo sviluppo di

queste nuove teorie iniziò infatti a rallentare tra il 1970 e il 1980, a causa di

critiche di altri studiosi che le consideravano di “basso rigore scientifico”. Nel

1985 ci fu poi un grandissimo rilancio dato dalla pubblicazione di un nuovo

algoritmo di apprendimento detto “di retro-propagazione dell’errore” (error

back-propagation) da parte di Rumelhart.

Per quanto riguarda il dibattito sulla intelligenza artificiale esso prese vita

dividendosi in due rami, tutt’ora presenti: quello dell’intelligenza artificiale

forte e dell’intelligenza artificiale debole. La prima sostiene che un computer

opportunamente programmato e sufficientemente potente possa mostrare un

comportamento intelligente del tutto indistinguibile da quello umano. La

seconda sostiene invece che un computer possa sı̀ mostrare un comportamento

intelligente, ma in modo solo apparente, che non sarà mai paragonabile a

quello umano.

Nel capitolo successivo la trattazione verrà focalizzata sull’aspetto teorico dell’argomento e sull’odierno dibattito circa la possibilità di un pensiero

artificiale paragonabile o uguale a quello umano. Uno sguardo al campo più

concreto delle reti neurali verrà proposto solo in un secondo tempo.

16

CAPITOLO 1. INTRODUZIONE

Capitolo 2

IA: La questione filosofica

La filosofia della mente è una disciplina il cui scopo è lo studio della mente, della coscienza, delle funzioni cognitive e del loro rapporto con il cervello.

Non solo, lo studio si rivolge anche alle relazioni che intercorrono tra la mente

e il corpo o il mondo. Con la ricerca odierna gli sforzi si sono inevitabilmente diretti anche verso i tipi di intelligenza che possiamo definire artificiali,

soprattutto quelli che presentano caratteristiche tali da ipotizzare per essi la

possibilità di riprodurre il cervello umano, se non addirittura la vita.

Solitamente, riguardo a questo tema, ciò che interessa ai filosofi è il confronto tra due architetture, quella umana e quella delle macchine: tradizionalmente il problema è stato formulato come “le macchine possono pensare?”.

Da una parte, alcuni hanno cercato di dimostrare che l’IA è impossibile e

che le macchine non hanno alcuna possibilità di agire in modo intelligente,

dall’altra il pensiero artificiale è visto come possibile. Perché domande come

quella posta abbiano un senso occorre ad ogni modo determinare prima cosa

significhi pensare. Ironicamente infatti, nonostante tutti siano d’accordo che

gli esseri umani siano intelligenti, nessuno è ancora riuscito a dare una definizione soddisfacente di intelligenza. Per questo si è soliti individuare, come

già detto, due “schieramenti” principali tra gli studiosi in questo campo:

• il primo, detto “Intelligenza artificiale forte”, viene sostenuto soprattutto dai funzionalisti e ritiene che un computer correttamente programmato possa raggiungere un livello di intelligenza non distinguibile

da quello umano. L’idea alla base di questa teoria risale a quella dell’empirista inglese Thomas Hobbes, il quale sosteneva che ragionare

non è nient’altro che calcolare: la mente umana consisterebbe cioè in

un insieme di processi e calcoli eseguiti dal cervello.

• il secondo, detto “Intelligenza artificiale debole”, sostiene che un computer non sarà mai in grado di eguagliare la mente umana, ma potrà

17

18

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

arrivare a simulare solo alcuni aspetti di essa, non riuscendo a riprodurli

tutti contemporaneamente.

La vera Intelligenza Artificiale, almeno secondo alcuni, potrebbe dunque essere raggiungibile solo da sofisticati robot in grado di muoversi ed interagire

con l’ambiente che li circonda grazie a sensori. La ricerca odierna, anche

relativamente al campo delle reti neurali artificiali, è infatti indirizzata verso

questa ipotesi. Le macchine dovranno essere quindi in grado di imparare

e apprendere dalle proprie esperienze tramite mezzi propri. Alcuni studiosi

inoltre ritengono che anche nei robot intelligenti occorra creare una “infanzia” che gli consenta di mettere a punto autonomi processi di apprendimento

e adattamento all’ambiente.

Il quesito iniziale di fondo, “le macchine possono pensare”, non sembra

comunque poter ricevere una risposta chiara.

2.1

Il test di Turing

Alan Turing, nel suo celebre Computing Machinery and Intelligence (Turing, 1950), suggerı̀ che invece di chiederci se le macchine possono pensare

dovremmo chiederci se possono superare un test comportamentale di intelligenza, che da allora è stato chiamato test di Turing. Il test, detto anche gioco

dell’imitazione, consiste nel sostenere una conversazione (attraverso messaggi digitati su una tastiera) con un interlocutore per cinque minuti. Alla fine

la persona che ha posto le domande deve indovinare se la conversazione ha

avuto luogo con un programma oppure con un essere umano; il programma

passa il test se riesce a ingannare il suo interlocutore tre volte su dieci.1

Turing prese anche in esame una grande varietà di eventuali obiezioni alla

possibilità che esistano macchine pensanti, tra cui praticamente tutte quelle

sollevate nel mezzo secolo successivo alla pubblicazione del suo articolo.

2.1.1

La critica relativa all’incapacità

L’argomentazione derivante dall’incapacità si basa sull’asserzione che “una

macchina non potrà mai fare X”. Come esempi di X Turing ha elencato le

seguenti capacità: essere gentile, pieno di risorse, bello, amichevole, avere

iniziativa, senso dello humor, riconoscere ciò che è giusto e sbagliato, fare

errori, innamorarsi, godersi una coppa di fragole e gelato, far sı̀ che qualcuno

1

A. M. Turing, Macchine calcolatrici e intelligenza, in V. Somenzi - R. Cordeschi (a

cura di) La filosofia degli automi. Origini dell’intelligenza artificiale, Boringhieri, Torino,

1986, pp. 157-158

2.1. IL TEST DI TURING

19

la apprezzi, imparare dall’esperienza, usare le parole correttamente, essere

l’oggetto del proprio pensiero, esibire una diversità di comportamenti pari a

quella di un essere umano, fare qualcosa di veramente nuovo.

Turing dovette usare il proprio intuito per indovinare quello che sarebbe

stato possibile fare in futuro, ma noi ora abbiamo la comodità di poter guardare indietro a ciò che i computer hanno già fatto e dato quello che sappiamo

oggi sui computer, non ci sorprende che si comportino cosı̀ bene in problemi

combinatori come gli scacchi. Ma gli algoritmi possono eseguire attività che

apparentemente richiedono una capacità di giudizio umana o, per dirla come Turing, la capacità di “apprendere dall’esperienza” e di “riconoscere ciò

che è giusto e sbagliato”; è chiaro che i computer possono fare molte cose

altrettanto bene o meglio degli uomini, tra cui alcune che si pensa richiedano

una grande quantità di intuizione e comprensione umana. Ciò non significa,

naturalmente, che i computer ricorrano all’intuizione e alla comprensione: il

punto è che spesso ci si sbaglia quando si ipotizzano processi mentali richiesti

per produrre un determinato comportamento. Ovviamente, è anche vero che

ci sono molte attività in cui i computer non sono ancora in grado di “eccellere”, tra cui quella richiesta da Turing: sostenere una conversazione ad

argomento libero. Questo tuttavia potrebbe rivelarsi un problema destinato

a essere lentamente dimenticato in seguito ai successi della ricerca nel campo

dell’intelligenza artificiale, delle reti neurali e degli automi.

2.1.2

L’obiezione matematica

Turing prese in esame anche le considerazioni e le conseguenze insite nel

Teorema di incompletezza di Gödel (1931), il quale dimostra come certe

asserzioni matematiche risultino indecidibili in particolari sistemi formali.

Poggiandosi sulle affermazioni del teorema, alcuni critici vedono le macchine

come sistemi formali limitati e naturalmente inferiori all’intelligenza umana.

Un capitolo a parte è tuttavia stato riservato in questo testo per una

introduzione al famoso teorema e al relativo dibatto, la cui trattazione viene

dunque momentaneamente rinviata.

2.1.3

La critica sulla consapevolezza

Un’altra possibile e comune obiezione che stata sollevata sul fatto che una

macchina sia effettivamente in grado di pensare è quella relativa alla consapevolezza del proprio pensiero e della proprie azioni, una obiezione resa

famosa anche dall’esperimento mentale ideato da Searle che verrà presentato nel prossimo paragrafo. In sostanza, come Turing aveva previsto, alcuni

affermano che una macchina che passi il test da lui ideato non stia in realtà

20

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

pensando ma stia unicamente producendo una simulazione del pensiero. Già

Turing citò il Professor Geoffrey Jefferson (1949): “Finché una macchina

non sarà in grado di scrivere una poesia o comporre una melodia grazie a

pensieri ed emozioni provate, non sarà possibile convenire che le macchine

equivalgono il cervello - ossia, non solo scrivere la poesia ma sapere di averla

scritta.”. A tale obiezione Turing rispose semplicemente con un’ulteriore domanda: perché dobbiamo insistere nell’esigere dalle macchine più di quanto

chiediamo a noi umani? Nella vita di tutti i giorni, dopotutto, non abbiamo

nessuna evidenza diretta circa la sussistenza di stati mentali interni negli altri umani. Ciò nonostante siamo soliti dare per scontata la convenzione che

ciascuno pensi.

2.2

Searle: la rappresentazione

L’esperimento di Turing, in ogni caso, è un test comportamentistico, il cui fine

non è prettamente quello di identificare se e dove ci possa essere intelligenza

ma piuttosto di valutare il grado di abilità del sistema artificiale nel dare

risposte consone alle richieste presentate. Il test è difatti senza dubbio anche

in buona parte soggettivo poiché è proprio l’interrogante il giudice supremo

che deve decidere se ha di fronte un uomo o una macchina. L’interrogativo

iniziale Può una macchina pensare? non sembra quindi, almeno per alcuni,

poter trovare una adeguata risposta tramite il gioco dell’imitazione.

Al riguardo, il filosofo John Searle replicò

con un famoso esperimento mentale, denominato

esperimento della stanza cinese. Urge ora una rapida esposizione dello stesso: “Supponiamo che io

mi trovi chiuso in una stanza con un grande foglio

di carta tutto coperto di ideogrammi cinesi. Supponiamo inoltre che io non conosca il cinese (ed

è proprio cosı̀), scritto o parlato, e che io non sia

nemmeno sicuro di riuscire a distinguere la scrittura cinese dalla scrittura diciamo, giapponese o

da sgorbi privi di significato: per me gli ideogrammi cinesi sono appunto sgorbi privi di significato. Figura 2.1: John Searle

(1932)

Ora supponiamo che, dopo questo primo foglio in

cinese, mi venga fornito un secondo foglio scritto

nella stessa scrittura, e con esso un insieme di regole per correlare il secondo foglio col primo. Le regole sono scritte in inglese e io capisco queste

regole come qualsiasi altro individuo di madrelingua inglese. Esse mi permettono di correlare un insieme di simboli formale con un altro insieme di

2.2. SEARLE: LA RAPPRESENTAZIONE

21

simboli formali; qui formale significa semplicemente che io posso identificare

i simboli soltanto in base alla loro forma grafica. Supponiamo ancora che

mi venga data una terza dose di simboli cinesi insieme con alcune istruzioni, anche queste in inglese, che mi permettono di correlare certi elementi di

questo terzo foglio coi primi due, e che queste regole mi insegnino a tracciare

certi simboli cinesi aventi una certa forma in risposta a certi tipi di forme

assegnatomi nel terzo foglio. A mia insaputa le persone che mi forniscono

tutti questi simboli chiamano il contenuto del primo foglio scrittura, quello

del secondo storia e quello del terzo domande. Inoltre chiamano risposte alle

domande i simboli che io do loro in risposta al contenuto del terzo foglio e

chiamano programma l’insieme delle regole in inglese che mi hanno fornito.

[...] Nessuno, stando solo alle mie risposte, può rendersi conto che non so

neanche una parola di cinese. [...] Dal punto di vista esterno, cioè dal punto

di vista di qualcuno che legga le mie risposte, le risposte alle domande in

cinese e a quelle in inglese sono altrettanto buone. Ma nel caso del cinese,

a differenza dell’inglese, io do le risposte manipolando simboli formali non

interpretati. Per quanto riguarda il cinese, mi comporto né più né meno che

come un calcolatore: eseguo operazioni di calcolo su elementi specificati per

via formale. Per quanto riguarda il cinese, dunque, io sono semplicemente

un’istanziazione (ossia un’entità totalmente corrispondente al suo tipo astratto) del programma del calcolatore”. 2 Ciò che in sostanza il filosofo tentò di

dimostrare tramite questo esperimento mentale è che la sintassi formale non

implica di per sé la presenza di contenuti mentali; cioè poiché i programmi

sono definiti in termini puramente formali o sintattici e che la mente possiede

un contenuto mentale intrinseco, ne consegue che essa non può consistere in

un semplice programma. Una macchina quindi non sarà veramente in grado

di pensare come un umano.

Riguardo questa considerazione è tuttavia possibile fare qualche osservazione e critica. Innanzitutto bisogna dire che l’argomentazione poggia su una

semplice verità logica: sintassi e semantica non si equivalgono e la sintassi

non può costituire e generare la semantica. Il che sembra ovvio e razionale.

Ciò che va notato però è che la stanza cinese è un luogo virtuale privo di qualsiasi collegamento con i significati e quindi incapace di significare; non si può

dire, infatti, che qualora effettivamente la mente fosse un programma, esso

dovrebbe limitarsi a manipolare simboli senza effettuare alcuna associazione

con la realtà cosciente. Essa potrebbe cioè manipolare simboli e nel contempo operare con gli oggetti ad essi associati e quindi acquistare coscienza degli

stessi.

Secondo alcuni studiosi inoltre, gli esperimenti di Turing e di Searle non

2

J. R. Searle, Il mistero della coscienza, Raffaello Cortina, 1998

22

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

dimostrano con certezza alcunché. Ad esempio per Marvin Minsky, pioniere

nel campo della I.A., il test di Turing è solo una riflessione sul fatto che il

termine “intelligenza” viene solitamente adoperato per indicare realtà molto

diverse tra loro. Si possono ottenere macchine intelligenti e che siano in grado

di passare il test proposto ma che hanno poco in comune con le persone. Per

questo Minsky ritiene che non sia di grande importanza definire l’intelligenza

bensı̀ concentrarsi sul cammino della ricerca, nel tentativo di arrivare a una

più ampia conoscenza del problema. In questa ottica, l’esperimento mentale

di Searle si prefigura come un incentivo allo studio dei processi cognitivi,

umani e non. Occorre analizzare a fondo anche il linguaggio e soprattutto i

significati correlati; più che la sintassi occorrono nuove idee di semantica e

semiotica, sebbene la ricerca in questo campo comprenda una ristretta fascia

di studiosi.

Dunque il problema della rappresentazione

costituisce effettivamente un nodo fondamentale

nello sviluppo di una intelligenza artificiale. Secondo alcuni però le macchine sarebbero in grado

di raggiungere notevoli livelli di intelligenza e di

pensiero, il vero problema risiede nel processo di

rappresentazione in quanto metodo per lavorare

e prendere coscienza della realtà. Ciò che suggerisce Minsky è che se si vuole una macchina che

rifletta su determinati oggetti bisogna che abbia

modo di rappresentarli. Se a tale scopo si utilizzano soltanto dei simboli collegati tra loro in Figura 2.2: Marvin Minsky (1927)

maniera disordinata, ogni volta che si rappresenta un dato inedito sarà necessario un nuovo tipo

di programma che lo interpreti. Risulta necessario sia per il cervello che per i

computer sviluppare modi diversi di rappresentare la conoscenza ed essere in

grado di selezionare elementi della conoscenza e tramite questi estrapolarne

di nuovi. A tal fine si deve a Minksy l’introduzione del concetto di frame,

un metodo relativamente semplice di rappresentare le caratteristiche di un

oggetto. Nel processo di rappresentazione vengono creati frame differenti che

possono essere collegati tra loro in modo da permettere al sistema di mutare il

punto di osservazione, guardare a un oggetto da una determinata prospettiva

per passare poi a un’altra inquadratura. Questo è appunto uno dei settori di

studio che tengono impegnati scienziati e ingegneri nel tentativo di produrre

macchine capaci di conoscenze più complete. Uno dei problemi principali

di costoro è infatti quello di riuscire a realizzare un ragionamento impiegando diversi tipi di rappresentazione contemporaneamente. La mente umana,

invece, è capace di passare continuamente da un modo di rappresentazione

2.3. HEIDEGGER: IL DASEIN E L’ESSERE NEL MONDO

23

all’altro. L’esempio più semplice è quello di un uomo che osserva un oggetto

nel suo insieme o in ciascun suo particolare.

Riprendendo un esempio già proposto poco fa, è possibile pensare di realizzare un programma che, pur manipolando simboli, operi nel contempo con

gli oggetti associati ad essi e acquisti di conseguenza coscienza di essi: per

chiarire le idee si immagini un semplice sistema formale costituito da tre

simboli {A, B, C} e si introduca una funzione biunivoca chiamata f (x) che

associ a ciascuno di essi una immagine, ad esempio un vaso, un mucchio di

terra e un fiore. A questo punto è possibile ammettere che ∀C =⇒ ∃A, B,

ossia per ogni fiore C deve esistere un vaso A pieno di terra B. A questo

punto è possibile compiere una osservazione: la regola è espressa secondo il

linguaggio formale della logica ma in virtù delle associazioni mentali è possibile immaginare la situazione pensando direttamente alla sovrapposizione

di f (A), f (B) e f (C); oppure, in termini meno astratti, si può immaginare

un quadretto in cui compare raffigurato un vaso con un fiore. Secondo questa concezione, la conoscenza si articola in più livelli differenti e può essere

possibile e completa anche artificialmente; il significato e la semantica non

compaiono nell’esperimento della stanza cinese perché viene lasciato spazio

unicamente alla sintassi e alla manipolazione di simboli; l’interpretazione non

può essere messa in relazione con l’oggetto. Secondo alcuni, Searle, nella sostanza, sarebbe riuscito al massimo a postulare l’impossibilità di una mente

priva di semantica ma il pensiero e la rappresentazione a più livelli sono obiettivi possibili e concreti. Questo è il sogno che i sostenitori dell’intelligenza

artificiale cercano di realizzare.

2.3

Heidegger: il Dasein e l’essere nel mondo

Quando gli studi in fatto di intelligenze artificiali e

macchine arriveranno al punto di produrre sistemi

non distinguibili dall’uomo in quanto a comportamento, come aveva predetto Turing, probabilmente le critiche teoriche riguardo la possibilità della

loro concretizzazione semplicemente svaniranno.

Fino ad ora però il dibattito è stato senza dubbio vivo e numerose critiche sono state presentate.

Riguardo il problema della rappresentazione vi è

chi, come detto, tenta di dimostrare l’analogia tra

mente e calcolatore, ma vi è pure chi, come il filoFigura 2.3: Hubert Drey- sofo Dreyfus, ritiene che le macchine nonostante i

fus (1929)

passi avanti della ricerca siano inferiori all’uomo.

24

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

Questi pensa infatti che l’intelligenza umana sia

più olistica di quella artificiale. Se l’affermazione viene riferita all’attuale sviluppo del campo delle reti neurali artificiali quali emulatori delle capacità del

cervello umano, essa risulta veritiera in quanto al momento nessun modello

matematico-ingegneristico di rete neurale ispirato alla teoria connessionista

sembra in grado di riprodurre con efficacia il carattere olistico, situazionale

e corporeo dell’intelligenza umana. Questo significa che per eguagliare l’uomo, le macchine dovrebbero avere bisogni, desideri, emozioni, sensazioni, cioè

possedere un corpo simile al nostro, con tutta la sua naturale complessità.

Sebbene tentativi di riprodurre il cervello

umano anche con strutture organizzate di neuroni biologici vengano correntemente effettuate e

sembrino lasciar spazio a notevoli possibilità, la ricerca odierna è certamente ancora lontana dal riprodurre completamente l’intelligenza dell’uomo,

la quale sembra essere motivata sia dalla totalità

dell’organismo corporeo che dalla totalità dell’ambiente socio-culturale. Esperimenti come quello

del ricercatore indiano Anirban Bandyopadhyay,

che è riuscito a ideare e realizzare un cervello bioAnirban

logico costituito da una gelatina di molecole orga- Figura 2.4:

Bandyopadhyay

niche che funziona a bassa energia, riproducono

in maniera sorprendente la struttura del cervello

umano e rivelano già grosse potenzialità, tuttavia non riescono per ora ad

offrire altro se non il proprio interessante e utile aspetto applicativo, ad esempio nel campo della nano-chirurgia.3

Quale ingrediente manca a questi sistemi affinché dispongano di una intelligenza completa,

perché possano fare esperienza di un pensiero

come il nostro?

Alcuni filosofi e studiosi concordano nel dire

che una componente fondamentale perché ciò accada sia proprio la coscienza da parte della macchina di essere al mondo, di interagire con la realtà

e l’ambiente esterno. Ciò significa che, riprendendo il pensiero heideggeriano, un sistema per essere intelligente deve innanzitutto essere, ovvero

Figura 2.5: Martin Heiessere vivo, essere nel mondo. Come propone-

degger (1889-1976)

3

V. Kasam, I neuroni di Anı̀, Il Sole 24 Ore, 3 giugno 2012, p. 31

2.3. HEIDEGGER: IL DASEIN E L’ESSERE NEL MONDO

25

va Heidegger dando avvio all’indagine ontologica

della realtà, la questione fondamentale riguarda

il rapporto tra il nostro essere ciò che siamo e il nostro essere nel mondo;

come viene esplicitato in “Essere e Tempo” dal filosofo, si verifica un vero e

proprio rovesciamento del concetto cartesiano Cogito, ergo sum che diviene

Sum, ergo cogito: “...Cartesio a cui si attribuisce con la scoperta del cogito

sum, l’avvio della problematica filosofica moderna, indagò, entro certi limiti,

il cogitare dell’ego. Per contro lasciò del tutto indiscusso il sum, benché lo

presenti come non meno originario del cogito. L’analitica pone il problema

ontologico dell’essere del sum. Quando questo sarà determinato, e solo allora, risulterà comprensibile anche il modo di essere delle cogitationes”. 4

E’ il Dasein il concetto fondamentale che caratterizza la natura dell’uomo

come animale sociale; significa esistenza anche come vita, come agire ed essere nel mondo. L’essere è il livello fondamentale che si pone come base per

la comprensione del mondo; la coscienza e l’intenzionalità vanno pensate a

partire dall’essere, cosicché il problema della mente diviene sostanzialmente

un problema ontologico.

Per Heidegger la storia della filosofia è la storia della “dimenticanza dell’essere”, a partire da Platone e dall’idea che sia possibile conoscere l’universo oggettivamente fino a Cartesio e al suo “Cogito, ego sum”; occorre invece

presupporre uno sfondo di pratiche quotidiane alle quali non corrispondono

rappresentazioni mentali; l’uomo, cioè, vive autenticamente quando riesce a

“incontrare” il mondo non solo teoreticamente ma anche praticamente: l’uomo esprime le proprie capacità e abilità nell’interazione con gli strumenti, i

mezzi, gli oggetti e gli altri esseri umani. Come è stato osservato da Dreyfus,

la visione heideggeriana della natura dell’uomo come non rappresentazionale

e non formalizzabile in quanto essere-nel-mondo, in quanto Dasein, mette

in discussione le ipotesi circa la creazione di una mente artificiale tramite

sofisticata tecnologia. Proprio il Dasein è ciò che è impossibile simulare per

una macchina: la specificità dell’essere è data dal suo relazionarsi al mondo

esterno, non solo nel rapporto tra stati mentali e realtà oggettiva, ma nel

modo in cui l’essere “incontra” il mondo. Ad esempio quando giochiamo a

tennis o guidiamo un’auto non prestiamo attenzione al nostro agire o all’oggetto, sia esso una racchetta o una macchina, ma siamo concentrati sul fine

dell’azione. In altre parole non abbiamo bisogno di una chiara percezione

di stare guidando una macchina o della esistenza stessa della macchina; il

nostro agire, il nostro “incontrare” la realtà non passa attraverso la parte

cosciente del cervello. Si potrebbe affermare dunque, seguendo la visione di

Heidegger e Dreyfus, che la coscienza non è una condizione necessaria per

4

M. Heidegger, Essere e Tempo, trad. it. di P. Chiodi, Longanesi, Milano, 1976, p. 69

26

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

entrare in relazione con il mondo ma è piuttosto il Dasein e l’essere nel mondo

a costituire quello sfondo ontologico necessario perché si possano manifestare

le nostre capacità e la nostra coscienza.

Affinché sia possibile il pensiero artificiale, quindi, le macchine dovrebbero

possedere perlomeno una qualche forma di Dasein, di senso comune. Quest’ultimo sembra sempre più poter essere la chiave, o almeno un ingrediente

essenziale, per la concretizzazione delle ipotesi dei fautori dell’intelligenza

artificiale. Scienziati impegnati in questo campo, infatti, concentrano sforzi

sempre maggiori allo scopo di riuscire a fornire alle proprie macchine una forma seppur limitata di senso comune, un background culturale che permetta

di inserirle e farle “vivere” in un ambiente tramite sensori e mezzi di comunicazione che riproducono le abilità innate dell’uomo garantite dai “cinque

sensi”. Uno dei problemi maggiori incontrati lungo questa via è costituito

dal fatto che spesso si tende a ridurre i processi di conoscenza e di sviluppo

dell’intelligenza al problema della memoria: alcuni studiosi di I.A. sostengono che disponendo di tempo e capacità sarà possibile accumulare moltissime

informazioni e costruire sulla base di queste macchine molto simili agli esseri

umani. Ma una tale forma di conoscenza risulterebbe in ogni caso limitata e parziale perché, secondo alcuni come Dreyfus, i meccanismi stessi delle

macchine sono limitati. Ad esempio, per comprendere cos’è un martello, un

computer non dovrebbe fare riferimento ad un database costituito di chiodi, muri, persone, case, legno, ferro, prove di resistenza, ecc., ma accedere

solamente ai fatti di possibile rilevanza nel contesto specifico in cui esso sta

operando. Per fare questo però il computer dovrebbe riprodurre il contesto

umano, dovrebbe essere in grado di “essere in una situazione”, di “sentirsi

situato”. E questo costituisce un problema notevole.

Il fatto è che la pretesa di riprodurre ciò che fa la mente umana esattamente nello stesso modo in cui essa lo fa manca di concretezza e il livello

tecnologico odierno disponibile non sembra poter concedere speranza a tale

ipotesi. Come già accennato, una scelta possibile è quella, semplicistica, di

ridurre il problema della conoscenza a quello della memoria; tuttavia sebbene

sia possibile creare sistemi artificiali “intelligenti” sotto alcuni aspetti, come

una macchina che gioca a scacchi, il processo avviene per via meramente

computazionale e per quanto sia vero che esistono programmi capaci di calcolare milioni di mosse ad una velocità per noi impensabile, ciò non ci dice

nulla sul modo in cui gli esseri umani giocano a scacchi.

Da quanto detto, seppure sia meglio ricordare che non è possibile essere

certi di una determinata teoria, sembra allora che scienziati e ricercatori si

debbano accontentare di cercare di riprodurre in un unico sistema contemporaneamente più caratteristiche e abilità possibili del cervello umano, ma

2.3. HEIDEGGER: IL DASEIN E L’ESSERE NEL MONDO

27

senza la convinzione di poter riprodurre artificialmente il suo esatto funzionamento. Se vengono poste queste premesse, nulla vieta di compiere grandi

passi avanti e di arrivare a risultati importanti. Lo stesso campo delle reti

neurali, per quanto sia ora limitato ad un impiego pratico e utilitaristico, si

pone come una delle basi per la produzione di robot di nuova generazione, che

interagiscono col mondo e imparano dall’esperienza reale senza bisogno di un

“insegnante” umano. La ricerca riguardo tipologie di reti neurali artificiali

auto-organizzanti che imparano e si costituiscono da sole tramite unsupervised learning dà i suoi frutti. Di questo argomento verrà discusso più avanti

in un capitolo a sé stante.

Come è stato evidenziato, la visione di Heidegger circa la mente e l’esperienza umana si basa sul livello fondamentale e fondante del Dasein, concetto

antecedente alla stessa coscienza. Tuttavia è stato anche sottolineato che non

è possibile essere del tutto certi di tale teoria; per questo motivo una parte

consistente della comunità scientifica ha sentito e sente tuttora il bisogno

di indagare la questione della coscienza, delle emozioni e dell’intenzionalità:

l’interrogativo ricorrente è se queste esistano, se siano necessarie per l’intelligenza e il pensiero, e che ruolo possiedano nel rapporto tra mente e corpo,

tra soggetto e realtà esterna. Un dibattito questo di largo respiro che si fa

via via sempre più acceso e frequente; per tale motivo l’autore di questo testo

ritiene opportuno inserire un capitolo a parte atto a riprendere, per sommi

capi, ipotesi e critiche fiorite negli ultimi decenni all’interno della comunità

scientifica internazionale. La trattazione viene dunque lasciata al prossimo

capitolo.

28

CAPITOLO 2. IA: LA QUESTIONE FILOSOFICA

Capitolo 3

La coscienza e il rapporto tra

mente e corpo

Sonny: Mio padre ha provato ad insegnarmi le emozioni umane. Sono...

difficili.

Spooner: L’uomo che ti ha progettato?

Sonny: Sı̀.

Spooner: Allora perché l’hai ucciso?

Sonny: Non ho ucciso il dottor Lanning.

Spooner: E perché ti nascondevi sul luogo del delitto?

Sonny: Avevo paura.

Spooner: I robot non provano paura. Non provano niente. Non hanno fame,

non devono dormire.

Sonny: Io sı̀. Ho persino sognato, alcune volte.

Spooner: Gli esseri umani sognano quando dormono. Anche i cani sognano.

Ma tu no. Tu sei solo una macchina. Un’imitazione della vita. Un robot può

scrivere una sinfonia? Un robot può trasformare una tela bianca in un’opera,

un capolavoro?

Sonny: Lei può farlo?

tratto dal film “Io, robot” (2004), regia di Alex Proyas.

Le parole attribuite al robot Sonny nel film “I, robot” di Proyas sembrano

riprendere, con una punta di fantasia, il dibattito odierno sull’intelligenza artificiale. Sono in molti infatti a chiedersi se una macchina sarà mai in grado

di provare emozioni; ma cosa sono le emozioni? E cos’è la coscienza, entità

che il fantascientifico Sonny sembra possedere? Questi quesiti arrovellano la

mente dell’uomo da generazioni eppure far luce sul mistero che la coscienza

rappresenta sembra essere più arduo di quanto si possa pensare. Alla fine

29

30CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

del secolo scorso, Thomas Huxley affermava che:“come avvenga che qualcosa

di cosı̀ sorprendente come uno stato di coscienza sia il risultato della stimolazione del tessuto nervoso è tanto inspiegabile quanto la comparsa del genio

quando Aladino, nella favola, strofina la lampada”.1 In tempi più recenti invece, il mistero che avvolge la coscienza e il meccanismo del pensiero umano

ha ispirato ampi filoni di letteratura fantascientifica; ancora di più, robot e

strutture aritificiali coscienti e intelligenti compaiono in numerosi film come

HAL 9000 in 2001: Odissea nello spazio, Pensiero Profondo in Guida galattica per autostoppisti, Skynet nella serie cinematografica di Terminator, le

macchine in Matrix, Numero 5 in Corto Circuito, e molti altri.

Ma nella realtà, è effettivamente concretizzabile il sogno di una intelligenza artificiale che

possieda, come l’uomo, una coscienza? Nel film

A.I. Artificial Intelligence, David è addirittura un

bambino robot in grado di amare, odiare, provare sentimenti. Tuttavia l’incertezza propria della

ricerca attuale può essere in buona parte esplicitata tramite le parole di Le Doux nel suo Il sé

sinaptico:“La mente descritta dalla scienza cognitiva è in grado, per esempio, di giocare perfettamente a scacchi, e può persino essere programmata per barare. Ma non è afflitta dal senso di colpa Figura 3.1: Joseph E.

LeDoux (1949)

quando bara, o distratta dall’amore, dalla rabbia

o dalla paura. Né è automotivata da una vena

competitiva oppure dall’invidia e dalla compassione”.2

Ma se le conoscenze attuali non ci permettono di concretizzare macchine

che vadano molto al di là della semplice capacità combinatoria che consente

loro di giocare a scacchi, allora fino a che punto è possibile l’analogia tra

mente umana e calcolatore? Nell’analisi di tale rapporto bisogna tenere in

considerazione le emozioni, il contenuto mentale? Nell’ambito descritto dal

problema, si giunge facilmente a chiedersi come sia possibile fornire ad un

sistema artificiale ciò che noi chiamiamo con i nomi di coscienza, emozioni e

intenzionalità.

Sicuramente la tentazione di ricondurre il problema all’analisi fisiologica e di spiegare tali concetti tramite processi fisici e chimici che avvengono

all’interno del corpo umano, semplifica enormemente la questione. Secondo

Edelman occorre notare però che:“l’analogia tra mente e calcolatore cade in

difetto per molte ragioni. Il cervello si forma secondo principi che ne ga1

2

Thomas Henry Huxley, The elements of physiology and hygiene, 1868, p. 178

Joseph LeDoux, Il sé sinaptico, Raffaello Cortina, Milano, 2002, p. 34

3.1. COS’È LA COSCIENZA?

31

rantiscono la varietà e anche la degenerazione; a differenza di un calcolatore

non ha una memoria replicativa; ha una storia ed è guidato dai valori; forma categorie in base a criteri interni e a vincoli che agiscono su molte scale

diverse, non mediante un programma costruito secondo una sintassi ”.3

L’indagine riguardo la coscienza non si esaurisce tuttavia in queste parole

e richiede uno scenario di visioni più complesso. Per questo verranno ora

esposti alcuni orientamenti di pensiero che tentanto di trovare una risposta

al quesito principale:

3.1

Cos’è la coscienza?

Cercare una risposta alla domanda “Cos’è la coscienza ed è essa necessaria

per parlare di intelligenza e pensiero?” significa impegnarsi ad affrontare

il problema del rapporto tra cervello fisico e psiche e a studiare i meccanismi e le proprietà che li mettono in relazione. Per comprendere come una

macchina possa essere in grado di provare emozioni, di percepire sensazioni

e di compiere esperienze coscienti, bisogna prima determinare come ciò sia

possibile nell’uomo. Ciò che viene indicato come il presupposto a coscienza

e sensazioni è il concetto di mente; l’analisi di quest’ultimo da parte degli

studiosi al fine di comprendere il meccanismo di funzionamento dell’intelligenza umana presenta un problema che ha rappresentato fin dall’antichità

uno spunto per la riflessione intorno alla natura e alle proprietà del pensiero

umano. Il problema principale che ha impegnato gli scienziati soprattutto

negli ultimi secoli è quello del rapporto tra mente e corpo: cos’è la mente e

che relazione c’è fra essa ed il corpo? La mente agisce sul corpo o è il corpo

ad agire sulla mente?

Il punto di partenza principale di tutte queste

problematiche può essere rintracciato in Cartesio

che delineò una divisione tra il soggetto conoscente e la realtà conosciuta caratterizzando il pensiero come essenza del mentale. Si istituı̀ in tal modo un dualismo ontologico tra la mente e il corpo,

l’una considerata come res cogitans, sostanza immateriale e misteriosa, l’altro come res extensa,

sostanza corporea. Con res cogitans si intende

quindi la realtà psichica a cui Cartesio attribuisce

le seguenti qualità: inestensione, libertà e consapevolezza. La res extensa rappresenta invece la Figura 3.2: Renato Cartesio (1596-1650)

3

Gerald M. Edelman, Sulla materia della mente, Adelphi, Milano, 1993, p. 236

32CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

realtà fisica, che è estesa, limitata e inconsapevole. Un dualismo interazionista, quello cartesiano,

che presentava non pochi punti deboli, come il processo non chiarito secondo

il quale la mente agisce sul corpo attraverso un punto di contatto tra le due

sostanze tra loro incommensurabili: la ghiandola pineale. L’errore gnoseologico insito nella visione dualistica cartesiana è stato più volte sottolineato

nell’ultimo secolo da molti studiosi, tra cui Antonio Damasio che ha dedicato

all’argomento un intero libro.4 I filosofi moderni preferiscono al dualismo ontologico un dualismo delle proprietà o delle funzioni, in base al quale mente

e corpo sono compenetrati e coniugati funzionalmente ma non costituiscono

due sostanze separate. Si possono invece distinguere due tipi di “stati esperienziali”, i neurostati e gli psicostati ; i primi fenomeni cerebrali e i secondi

fenomeni mentali.

Il dualismo di Cartesio è stato portato dai suoi successori alle estreme conseguenze con determinate forme di anti-sostanzialismo, moderato in Locke,

il quale sosteneva la funzione essenziale della coscienza indipendentemente

dalla sostanza, radicale in Hume, che pensò il soggetto conoscente come un

fascio di percezioni, e trascendentale in Kant, con la teoria “dell’io puro”.

Una volta raggiunti tali limiti, si percepı̀ la fallacia dei tentativi compiuti

nel comprendere maggiormente il rapporto mente/corpo. Si tentò allora di

superare gli ostacoli posti in essere dal dualismo cartesiano attraverso nuove strade, ad esempio rinunciando al carattere originale di una delle due

sostanze. Si sono determinate cosı̀ due tipologie di pensiero dominanti all’interno delle scienze che studiano il cervello, l’intelligenza e i processi cognitivi:

quella del fisicalismo e quella del mentalismo o del non-fisicalismo.

3.1.1

La visione fisicalista

Secondo i fisicalisti, al problema mente-corpo è possibile trovare soluzione

riconducendo gli stati mentali agli stati cerebrali, operando una sorta di riduzionismo materialista e fisicalista. Seguendo tale concezione, l’esperienza

cosciente e le emozioni sono giustificabili come conseguenze di determinati

processi chimici e fisici del corpo umano, di determinate configurazioni neuronali all’interno del cervello, di determinati stimoli e impulsi elettro-chimici.

Il mentale è presentato come epifenomenico del cerebrale. Si assiste cosı̀ ad

una rinascita del materialismo dell’identità tra mente e cervello, la cui forma

più estrema è rappresentata dall’eliminativismo, il quale rifiuta l’idea della traducibilità del linguaggio mentale, semanticamente inconsistente e ricco

4

A. Damasio, L’errore di Cartesio, Adelphi, Milano, 1995

3.1. COS’È LA COSCIENZA?

33

di espressioni prive di riferimento, con quello fisicalistico (Paul e Patricia

Churchland).

Assieme al fisicalismo, inoltre, sono nate poi

tendenze quali il connessionismo, che mira a riprodurre l’intelligenza attraverso la simulazione

di reti neurali, e il funzionalismo, che trova il

suo massimo esponente in Hilary Putnam, il quale

considera gli eventi mentali come condizioni causali tra input e output caratterizzate da funzioni:

secondo la teoria, due sistemi qualsiasi possiedono

gli stessi stati mentali se caratterizzati da processi causali isomorfi; una macchina potrebbe perciò

avere gli stessi stati mentali di un uomo. Il conFigura 3.3: Hilary Put- nessionismo, o connettivismo, è tuttavia ancora

nam (1926)

per molti solo uno dei metodi possibili e necessari

per ricostruire la fisionomia del cervello e del pensiero umano, in quanto produce modelli neurali in cui il numero di connessioni

tra i vari elementi non può essere eccessivo e gli oggetti vengono rappresentati tramite numeri, valori e coefficienti, che però non riescono a fornire una

rappresentazione soddisfacente di molti fattori in quanto non precisamente

quantificabili.

Questa visione della realtà deve sicuramente

qualcosa a Galileo Galilei e al cammino da lui indicato, nell’affrontare lo studio della natura iniziando da ciò che appare semplice ed essenziale.

Nessuno ha vietato in passato di procedere nello

studio in senso olistico senza dividere l’universo

in parti semplici e più facilmente comprensibili,

come ad esempio sosteneva Goethe dicendo che la

natura non ha “né nocciolo né buccia ed è data

tutta insieme”. Il problema è che per questa via

in passato lo studio si è sempre rivelato arduo e

non sono stati compiuti progressi in tale direzione. Figura 3.4: Galileo Galilei (1564-1642)

La dottrina galileiana insegna invece un metodo

rivelatosi efficace e fecondo di risultati: occorre

studiare i fenomeni fisici liberandoli da tutti gli impedimenti “esterni e accidentari”, tenere in considerazione solo gli aspetti quantitativi della realtà che

ci circonda e porre in secondo piano gli aspetti qualitativi assieme a emozioni,

impressioni e coscienza.

I fisicalisti moderni, tuttavia, pur aderendo a un materialismo di stampo

galileiano nel risolvere il problema mente/corpo operando un riduzionismo

34CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

della mente a processi fisici e concentrando gli sforzi degli studi su questi

ultimi, ritengono spiegabili su tale base anche eventi mentali, pensiero intelligente ed esperienza cosciente. Il fondamento di questa concezione risiede

nel supporto fornito dalle scienze della complessità, che a partire da Poincaré, individuano la complessità e l’impredicibilità come legate e conseguenti

al determinismo delle equazioni di Newton; l’illusione illuministica di poter

prevedere con certezza il futuro di un sistema svanisce cioè grazie alla scoperta negli anni ’70 del caos deterministico, ossia il cui stato è determinato

univocamente da quello iniziale. Si giunge cosı̀ a comprendere che l’apparente

contraddizione insita nel rapporto tra mente e corpo nasce dalle barriere psicologiche dovute a secoli di tradizione che hanno considerato determinismo

e caos come concetti contrapposti; allo stesso modo il supporre che l’irrazionalità della mente e del pensiero umano sia incompatibile con i calcolatori, è

una idea basata su una confusione tra livelli: un meccanismo semplice e senza

errori ad un certo livello potrebbe costituire la base di una manipolazione di

simboli ad un livello superiore che appare complessa, caotica e senza spiegazione. Sulla base di ciò, alcuni affermano dunque che poiché anche il cervello

umano è formato da elementi semplici quali i neuroni che non commettono

errori allora potrebbe essere plausibile dire che entità considerate astratte e

inspiegabili come il pensiero e la coscienza siano in realtà il risultato di un

processo deterministico dovuto al livello neuronale sottostante. Allo stesso

modo quindi si ritiene che l’hardware di una macchina, esente da errori, abbia i requisiti necessari per costituire la base di comportamenti ad alto livello

che sembrino intelligenti e che rappresentino stati tipicamente umani come

l’indecisione, la dimenticanza, la capacità di giudizio, l’intenzionalità.

Allora le macchine possono pensare e provare emozioni? Da quanto detto, la risposta tende sicuramente verso il positivo. Se pensiamo all’essere

umano, il fisicalismo insegna che ciò che noi chiamiamo emozione in fondo è

soltanto un particolare stato mentale che si sovrappone alla configurazione

precedente alterandone alcune caratteristiche allo scopo di preparare l’organismo ad attuare una precisa procedura. Ad esempio, se un uomo ode

la parola “Attento”, all’interno del suo corpo avvengono numerose reazioni

organiche, alcune delle quali sono associate a forti emozioni - secrezione di

adrenalina, blocco della digestione, liberazione del glucosio immagazzinato,

e cosı̀ via. Tutto ciò avviene allo scopo di far fronte a una situazione di

probabile pericolo imminenente; questo non significa però che l’emozione sia

qualcosa di impalpabile e di origine ignota. Cosı̀ come per noi le emozioni

sono conseguenze di processi fisici allora, ritengono alcuni fisicalisti, anche

per le macchine possono sussistere meccanismi paragonabili. Per spiegare

il concetto è possibile addurre un semplice esempio. Si immagini che esista

una macchina molto sensibile ai colori visibili intorno ad essa e che svolga la

3.1. COS’È LA COSCIENZA?

35

funzione di regolare la temperatura di una stanza; se il colore verde risulta

visibile, quest’ultima verrà aumentata. All’inizio lo stato interno del sistema

è caratterizzato da una temperatura ambientale di 20◦ C, il che può essere

paragonato ad un uomo che cammina per strada con 60 pulsazioni cardiache

al minuto. All’improvviso un evento inatteso si presenta sulla scena: un tavolo verde per la macchina e una donna di notevole bellezza per l’uomo. A

questo punto le pulsazioni al minuto del cuore umano aumenteranno a causa

del maggior afflusso di adrenalina e l’uomo avrà l’impressione di provare una

forte emozione; allo stesso modo nella macchina l’evento improvviso provocherà una variazione del valore da attribuire alla temperatura e essa “proverà

un’emozione”, ossia si ritroverà con uno stato interno differente da quello memorizzato in precedenza. Insomma è come se ci fossero inizialmente 20◦ C, o

60 pulsazioni al minuto, ma per determinati processi e ragioni la variazione di

tale valore induce la consapevolezza di un evento particolarmente importante. Ecco dunque, a grandi linee, uno dei modi tramite cui vengono spiegati

la coscienza e il pensiero intelligente nel riduzionismo fisicalista, il quale non

vuole criticare l’importanza o l’utilità delle emozioni ma l’immaterialità che

a esse viene da molti attribuita. Le emozioni infatti appartengono alla sfera

più primordiale dell’encefalo e a una fase molto antica dell’evoluzione; Joseph LeDoux ne “Il Sé sinaptico” sottolinea a tale proposito proprio il ruolo

svolto dall’amigdala nella decodifica delle emozioni e in particolare della paura, un sistema che deve essere stato di grande aiuto ai vertebrati quando la

corteccia cerebrale non era ancora sviluppata. Alla luce di queste considerazioni l’emozione è uno stato mentale magari peculiarmente più immediato e

sconvolgente di altri, ma rimane sempre un “semplice” stato mentale.

3.1.2

La visione non-fisicalista

Dalla parte opposta rispetto ai fisicalisti, che tentano di spiegare come stati

fisici possano contemporaneamente essere anche stati mentali, gli esternalisti

cercano di superare il cosiddetto “Fossato Galileiano” rifiutando una separazione tra mondo mentale e mondo esterno. Si può e si deve analizzare

la mente e il mondo qualitativo non limitandosi a oggetti, processi e sistemi quantificabili. L’esternalismo non nega, in generale, il fatto che senza

il cervello e il sistema nervoso non si ha nessuna mente, esso mette però

in discussione che il cervello sia sufficiente a produrre la mente e che esso

sia l’unico fondamento fisico per i processi e i contenuti mentali. Oltre alla

posizione principale che rivolge all’approccio riduzionista la critica di non

spiegare efficacemente la coscienza, vi sono comunque varie sfumature all’interno dell’esternalismo. Alcuni affermano che la mente è indipendente da

fattori esterni ma avviene sostanzialmente all’interno del cervello, altri che

36CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

la mente dipende necessariamente da o è identica a processi fisici, in parte

o totalmente esterni al sistema nervoso. Atri ancora poi rifiutano l’idea che

il contenuto della mente sia fatto di rappresentazioni e ipotizzano che l’uomo percepisca direttamente il mondo esterno. Sostenitori dell’esternalismo

semantico suggeriscono una visione cauta seconda la quale i meccanismi che

corrispondo alla mente si trovano all’interno del corpo ma il contenuto semantico non sopravviene nel cervello bensı̀ nelle relazioni sociali, culturali e

linguistiche.

Ad ogni modo, in generale gli studiosi non fisicalisti tendono a far leva sulla difficoltà di descrivere la coscienza per dipingere il riduzionismo come una

scienza in difficoltà e in imbarazzo, motivo per cui essa ha sempre rinnegato

la possibilità di una effettiva esistenza della coscienza e ha lasciato intoccato

il suo dominio; la coscienza è intrinsecamente soggettiva ma la scienza studia

programmaticamente gli enti oggettivi e i fatti quantitativi, esprimibili con

grandezze numeriche, che sono stati considerati come i soli veramente importanti. Occorre dunque rivalutare il valore dell’aspetto qualitativo e della

coscienza fenomenica, poiché essa, secondo alcuni come i ricercatori Manzotti e Tagliasco, “contraddistingue il nostro stato di veglia, contraddistingue

il nostro stesso esserci di persone. Ansi, potremmo persino concordare sul

fatto che, senza l’esperienza cosciente, noi siamo assenti nel senso più pieno del termine. [...] sentiamo che [...] la vita da sola non è sufficiente a

garantire l’integrità della persona”.5 Perché sia possibile l’intelligenza e il

pensiero occorre dunque che esista anche la coscienza, vista come precedente

allo sviluppo cognitivo stesso della persona.

Secondo gli stessi Manzotti e Tagliasco, da notare, macchine intelligenti non sono tuttavia da

escludere definitivamente. I due evidenziano però

il fatto che non è possibile giungere a realizzazioni

concrete di esse se si parla di Artificial Intelligence nel senso che è stato conferito al termine fino

ad ora. La parola artificiale implica infatti un

programma di lavoro di tipo ingegneristico che ha

Figura 3.5:

Vincenzo sempre riscosso successo grazie agli aspetti appliTagliasco (1941-2008)

cativi; ma ora secondo i due studiosi la coscienza

è diventata un problema scientifico e non solo un

problema filosofico, perciò se si vuole giungere a risultati concreti e soddisfacenti servono nuovi strumenti, occorre parlare anche di intenzionalità e di

Artificial Consciousness, una branca di studio che solo nell’ultimo venten5

Riccardo Manzotti e Vincenzo Tagliasco, Essere e fare: perché l’approccio riduzionista

non spiega la coscienza in “L’arsenale”, La Spezia, Dicembre 2002, p. 3

3.1. COS’È LA COSCIENZA?

37

nio ha cominciato a produrre un certo dibattito. Argomento di discussione

è certamente la concezione che l’intelligenza abbia bisogno di una volontà

che la guidi e che la razionalità debba essere mossa da fini e motivazioni

che non possono essere il prodotto delle elaborazioni interne di un sistema

chiuso. La coscienza in quanto intenzionalità è basilare dunque affinché una

macchina possa essere in grado di pensare e avere comportamenti intelligenti;

per questo “il problema della realizzabilità della coscienza artificiale ha avuto

all’inizio la forma della costruzione di un agente intenzionale [...] tuttavia

senza una teoria della coscienza e quindi dell’intenzionalità, era impossibile

riconoscere in una struttura artificiale la presenza di genuine capacità intenzionali. E infatti la domanda sui correlati neurali della coscienza resta

aperta sia nel campo biologico sia nel campo, finora ipotetico, dell’artificialità”.6 Secondo i due esternalisti fautori della “Teoria della Mente allargata”,

la coscienza è stata la grande assente della ricerca scientifica nel Novecento e un prerequisito per lo studio della mente, al fine della sua costruzione

in strutture artificiali, è l’identificazione fra la mente e la mente cosciente:

una precisazione non superflua che nelle parole dei due ricercatori acquista

il significato di critica nei confronti dei ricercatori degli ultimi cinquant’anni

che hanno cercato di spiegare la mente senza far uso della coscienza, esito

estremo delle contraddizioni interne del dualismo seicentesco.

Un ulteriore punto sottolineato è che essere

coscienti non significa essere vivi. La distinzione

si basa sul fatto che essere in vita vuol dire essere costituiti da molecole basate sulla replicazione

del DNA mentre essere coscienti significa essere

in grado di poter fare esperienza del mondo; vi

è pertanto una sottile linea di demarcazione tra

i due concetti che lascia spazio alla possibilità di

supporre una struttura artificiale capace di produrre un soggetto dotato di esperienze coscienti.

Dunque una coscienza, e intelligenza, artificiale

è ipotizzabile e in sintesi, “è possibile che il secolare empasse in cui si è imbattuta la scienza,

Figura 3.6:

Riccardo

nello spiegare la natura della mente cosciente, sia

Manzotti

causato non tanto dalla natura del problema in

sé quanto dalle ipotesi che acriticamente si sono

accettate sulla natura della realtà. Cambiando queste, e sottoponendole al

vaglio dell’evidenza, è possibile che si guadagni una migliore comprensione

6

Riccardo Manzotti e Vincenzo Tagliasco, Si può parlare di coscienza artificiale?,

Dicembre 2001, pp. 4-5

38CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

tanto della coscienza quanto della realtà”.7

Secondo i non-fisicalisti, insomma, è necessario abbracciare una prospettiva più ampia ed è ormai riconosciuto il fatto che non esistano dati osservativi

neutri, assolutamente indipendenti da qualsiasi punto di vista e quantificabili esattamente secondo le categorie galileiane. Ogni osservazione è sempre

condizionata dall’orientamento e dalle aspettative dell’osservatore, dalla soggettività umana. Ad aumentare la complessità del problema si aggiunge

inoltre il fatto che ogni organismo raccoglie anche informazioni dall’ambiente

in modo apparentemente inconscio e automatico; ma tali informazioni non

sono esplicitabili e riconducibili ad affermazioni ben definite, cosı̀ da poter

essere comunicate tramite il linguaggio ad altri individui. Secondo questa visione dunque gli strumenti che la scienza ha utilizzato fino ad adesso non sono

sufficienti per abbracciare completamente la realtà, compresa la coscienza e

il pensiero in sé. E mettere in discussione l’idea che la mente possa essere

completamente spiegata sulla base di processi fisici e fenomeni cerebrali a noi

noti apre un notevole vuoto conoscitivo. Ma una posizione coraggiosa come

questa potrebbe anche aprire spazi di possibilità del tutto nuovi. Occorre

dunque riconoscere il ruolo della coscienza nella costituzione della mente e

del pensiero, biologici e artificiali, e valicare i limiti delle attuali prospettive.

La mente presenta caratteristiche assolutamente particolari rispetto a qualunque altra tipologia di eventi che avvengono nell’universo e ciò autorizza

ad avanzare dei dubbi relativamente alla fondatezza della convinzione che le

categorie concettuali di cui oggi disponiamo siano sufficienti per spiegare i

fenomeni della mente.

3.2

Conclusioni

Come si è mostrato, il ventaglio di opinioni riguardo al tema dell’intelligenza

artificiale è molto ampio e vario. Rispondere ad un quesito come “è possibile

il pensiero nelle macchine?” nasconde dunque un sentiero impervio attraverso le concezioni della realtà e della vita più disparate e non sembra possibile

tutt’oggi avvicinarci a risposte e risultati concreti. Il dibattito sull’intelligenza è vivo e attuale, come lo è pure quello sulla coscienza: vi è chi dice che

il pensiero e l’intelligenza non possono prescindere da essa e chi sostiene che

essa non sia che il risultato di meri processi fisici e biologici, di stati cerebrali.

Marvin Minsky, ad esempio, ritiene che il concetto stesso di coscienza venga

male interpretato. Secondo lo studioso, bisogna tenere in considerazione due

punti: il primo è che la coscienza è costituita da numerosi aspetti diversi

7

Riccardo Manzotti e Vincenzo Tagliasco, si può parlare di coscienza artificiale?,

Dicembre 2001, p. 11

3.2. CONCLUSIONI

39

vagamente collegati tra loro e il secondo è che si tende a racchiudere questi

aspetti in un’unica parola, mentre il termine “coscienza” non dovrebbe esistere. Bisognerebbe distinguere tra “reattivo”, “riflessivo” e “autoriflessivo”,

e parlare di cancellazione dei contenuti della memoria a breve termine nel

momento in cui si inseriscono nuovi dati. Secondo Minsky non si comprende

dunque la coscienza perchè essa è solo una parola vuota; il problema non

consiste nel domandarsi allora cosa sia la coscienza ma qual’è il meccanismo

per il quale il cervello costruisce una rappresentazione di se stesso, in che

modo il processo successivo confronta le diverse rappresentazioni e identifica

le differenze.

In sintesi, non è dunque ancora possibile sapere se in futuro riusciremo

ad ottenere forme di intelligenza non umane, che possano essere paragonate

agli uomini in quanto a proprietà, caratteristiche, comportamenti e pensiero.

La ricerca è tuttavia costante e un ruolo di non poca importanza è svolto comunque dalla neurofisiologia; le scoperte nel campo alimentano sempre nuovi

modelli e teorie, come quelli delle reti neurali, e rafforzano l’interconnessione

tra scienze cognitive e ricerca neurologica. Nonostante la scarsità di risposte sicure in questo ambito, per completezza il prossimo capitolo è dedicato

dunque a una esposizione che, senza presunzione di esaustività, delineerà i

caratteri principali dei modelli connessionisti e di reti neurali.

40CAPITOLO 3. LA COSCIENZA E IL RAPPORTO TRA MENTE E CORPO

Capitolo 4

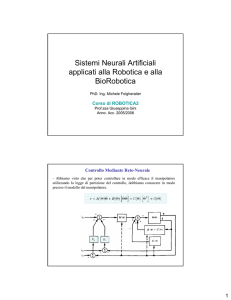

Le reti neurali artificiali

Nel seguente capitolo verranno introdotti in linee generali alcuni modelli artificiali adoperati nel campo delle cosiddette reti neurali artificiali nell’effettuare studi ed esperimenti sulla facoltà del cervello umano di apprendimento