Premessa

La teoria della decisione di Bayes fornisce una delle metodologie

fondamentali per il riconoscimento di forme inteso come “pattern

classification”.

E’ basata sull’ipotesi fondamentale che il problema di

decisione/classificazione possa essere formulato in termini probabilistici.

Le probabilità coinvolte possono essere note o stimate.

La teoria di Bayes consente di tenere in conto sia le probabilità legate

alle diverse decisioni che i loro “costi” (o “rischi”) in modo da prendere

la decisione più “utile” (o meno “costosa/rischiosa”) in senso

probabilistico.

RICONOSCIMENTO DI FORME

Fondamenti di Teoria della Decisione

Inizieremo ad illustrare i fondamenti della teoria della decisione

Bayesiana assumendo che tutte le “probabilità” coinvolte nel

problema di decisione siano note

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

1

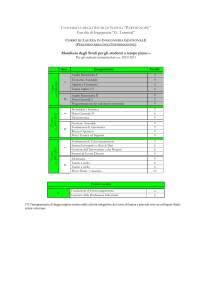

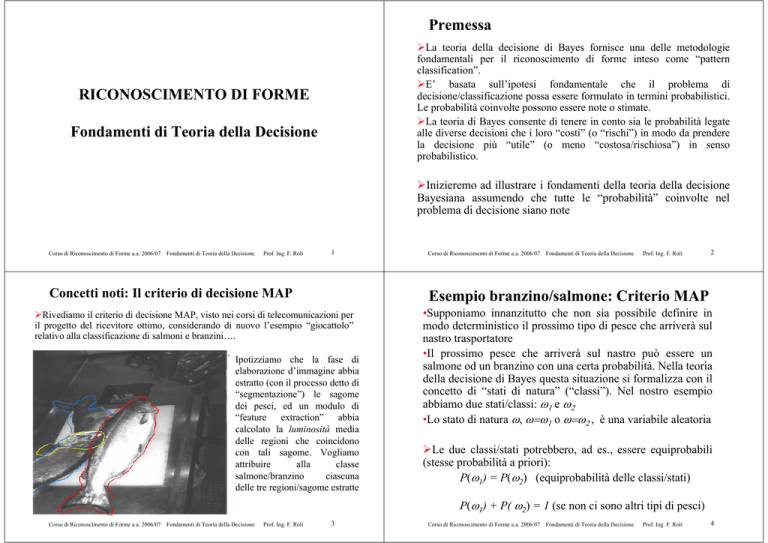

Concetti noti: Il criterio di decisione MAP

Corso di Riconoscimento di Forme a.a. 2006/07

Ipotizziamo che la fase di

elaborazione d’immagine abbia

estratto (con il processo detto di

“segmentazione”) le sagome

dei pesci, ed un modulo di

“feature extraction” abbia

calcolato la luminosità media

delle regioni che coincidono

con tali sagome. Vogliamo

attribuire

alla

classe

salmone/branzino

ciascuna

delle tre regioni/sagome estratte

Prof. Ing. F. Roli

2

•Supponiamo innanzitutto che non sia possibile definire in

modo deterministico il prossimo tipo di pesce che arriverà sul

nastro trasportatore

•Il prossimo pesce che arriverà sul nastro può essere un

salmone od un branzino con una certa probabilità. Nella teoria

della decisione di Bayes questa situazione si formalizza con il

concetto di “stati di natura” (“classi”). Nel nostro esempio

abbiamo due stati/classi: 1 e 2

•Lo stato di natura , = 1 o = 2 , è una variabile aleatoria

Le due classi/stati potrebbero, ad es., essere equiprobabili

(stesse probabilità a priori):

P( 1) = P( 2) (equiprobabilità delle classi/stati)

P(

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

Esempio branzino/salmone: Criterio MAP

Rivediamo il criterio di decisione MAP, visto nei corsi di telecomunicazioni per

il progetto del ricevitore ottimo, considerando di nuovo l’esempio “giocattolo”

relativo alla classificazione di salmoni e branzini….

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

3

1)

+ P(

2)

= 1 (se non ci sono altri tipi di pesci)

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

4

Esempio branzino/salmone

Esempio di p(x |

•Supponiamo di dover decidere senza poter esaminare il

pesce che arriva sul nastro. L’unica regola di decisione

razionale è:

Decidi per 1 se P( 1) > P( 2), altrimenti decidi per 2

•Ovviamente questa regola di decisione “cieca” può

funzionare solo se P( 1) >> P( 2), o viceversa, e le

decisioni/classi hanno gli stessi “costi”

Nella maggioranza dei casi dobbiamo esaminare l’oggetto

(“pattern”) prima di classificarlo

•Possiamo acquisire delle “misure” (“feature”) per descrivere

il “pattern”

•Ad es. una misura continua x (riflettanza luminosa del

pesce).

• Poichè diversi esemplari avranno diversi valori di riflettanza

luminosa, descriveremo x come una variabile aleatoria la cui

distribuzione p(x | i) dipende dal tipo del pesce

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

5

i)

monodimensionale

•p(x | i) è la funzione di densità di probabilità di x dato lo

stato/classe (class-conditional probability density function)

Se x è la “luminosità” media della regione d’immagine associata

all’oggetto di classe i, allora la differenza fra le p(x | i) descrive le

differenze “attese” di luminosità fra i due tipi di pesce

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

Regola di Bayes

Esempio di P( i| x) monodimensionale

•Supponiamo di conoscere sia le probabilità a priori P( j) dei

due tipi di pesce che le loro funzioni di densità condizionale

p(x | j), j=1,2

•Se misuriamo la luminosità x di un pesce, per “classificarlo”

possiamo usare la naturale regola probabilistica:

p( j , x) = P( j | x) p(x) = p(x | j) P( j)

•Che possiamo riscrivere come regola di Bayes:

Esempio di P( i| x) per cui P(

P(

j

| x) = p(x |

j)

1)=2/3

e P(

6

2)=1/3

P ( j) / p(x)

Probabilità a Posteriori = (Verosimiglianza * Probabilità a

Priori) / Evidenza

Notare che: p ( x ) =

2

j =1

Corso di Riconoscimento di Forme a.a. 2006/07

p(x |

j

)P (

j

Fondamenti di Teoria della Decisione

)

Prof. Ing. F. Roli

7

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

8

Criterio MAP

•Se le funzioni di densità condizionale sono note, la regola di

decisione più razionale è quella a Massima Probabilità a

Posteriori (MAP, maximum a posteriori probability):

Se P(

Se P(

| x) > P(

1 | x) < P(

1

| x) allora è più razionale scegliere

2 | x) allora è più razionale scegliere

2

1

•Altra formulazione del criterio MAP:

Se p(x | 1) P( 1) > p(x | 2) P( 2) allora la classe vera è

altrimenti la classe vera è 2

p( x /

l ( x) =

p( x /

Test di

verosimiglianza

2

Confronto il rapporto di

verosimiglianza l(x) con una

soglia che non dipende da x

Criterio MAP e ML

1

>

<

)

2)

1

1

P( 2 )

=

P( 1 )

2

•Questa regola è razionale nel senso che minimizza l’errore per

un certo x:

P(errore | x) = P( 1 | x) se decidiamo per 2

P(errore | x) = P( 2 | x) se decidiamo per 1

•Notare che l’ “evidenza” p(x) non conta.

Casi particolari:

•Se p(x| 1)=p(x| 2), allora decido solo sulla base delle

probabilità a priori delle classi

•Se P( 1)=P( 2), allora decido solo sulla base delle

verosimiglianze (Criterio ML, Maximum Likelihood)

•E si dimostra che minimizza anche l’errore medio:

P(errore) =

+

+

P(errore, x )dx = P(errore x) p( x)dx

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

9

Corso di Riconoscimento di Forme a.a. 2006/07

Interpretazione geometrica: regioni di decisione

R1 = {x R: l(x) > } e R2 = {x R: l(x) < } (un campione x

tale che l(x) = può essere inserito arbitrariamente in R1 o in R2).

2),

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

10

MAP e ML con più classi

Un test di verosimiglianza è definito non appena siano noti il rapporto di

verosimiglianza l(x) e la soglia . Fissato il test di verosimiglianza sono

univocamente definite le regioni di decisione R1 e R2 nello spazio R del

parametro x.

–Fissate le densità di probabilità p(x| 1) e p(x|

pertanto univocamente determinate dalla soglia

N.B. Confronto il rapporto di

verosimiglianza con il rapporto fra i

“priors”

R

le regioni R1 e R2 sono

Esempio con Gaussiane

Ovviamente la regola di decisione MAP a più classi è:

x

i

P(

i

| x) > P (

j

| x)

i

j, i=1,...,c

E la regola ML viene di conseguenza

Dal punto di vista della soglia di decisione , è ovvio che ci saranno più

soglie. Definite, di volta in volta, fra le due classi s e t tali che:

P(

s

| x) > P(

i

| x)

P(

t

| x) > P (

i

| x)

s, t

i, s

t i=1,...,c

Nell’esempio riportato, le soglie di decisione saranno in corrispondenza di

x12 e x23

R1 = R 1( )

R2 = R2( )

R1

Corso di Riconoscimento di Forme a.a. 2006/07

R2

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

11

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

12

Elementi di calcolo della probabilità di errore

Elementi di calcolo della probabilità di errore

•Nel caso semplice a due classi:

P(errore) = P{x R2 , 1} + P{x R1 , 2 } =

= P ( 1 ) P{x R2 | 1} + P( 2 ) P{x R1 | 2 } =

= P ( 1 ) p ( x | 1 )dx + P ( 2 ) p( x | 2 )dx

R2

•Nel caso a più classi è più semplice passare attraverso il calcolo

della probabilità di classificazione corretta:

R1

Nella pratica si ha spesso un errore

aggiuntivo (“reducible error”) perché

la soglia ottimale è difficile da stimare

Fondamenti di Teoria della Decisione

13

Prof. Ing. F. Roli

i

| x) > P (

i=1

j

| x)

i

j, i=1,...,c

P ( errore /

Ri

)P(

i

14

Prof. Ing. F. Roli

Pertanto possiamo scrivere la probabilità di errore come:

=

i

Fondamenti di Teoria della Decisione

c

p( x /

i

i = 1 C [ Ri ]

c

i =1

Corso di Riconoscimento di Forme a.a. 2006/07

P ( errore ) =

La probabilità di errore si può scrivere come:

P ( errore ) =

i=1

MAP e minimizzazione della probabilità di errore

Vediamo ora in dettaglio perché la regola MAP seguente garantisce di

minimizzare la probabilità di errore.

P(

i=1

Fattibile solo per Gaussiane monodimensionali con stessa varianza !

MAP e minimizzazione della probabilità di errore

i

c

E’ chiaro che il calcolo della probabilità di errore richiede di calcolare

degli integrali multipli (in generale in Rd) estesi alle regioni di decisione,

Provare a fare i conti !

il che è un problema analiticamente complesso.

=x* è subottima, e infatti genera un

errore “aggiuntivo”

x

c

P(errore) = 1 P(corretto)

La soglia ottimale è =xB (soglia

ottima Bayesiana, per cui ho l’errore

minimo, detto Bayes error)

Corso di Riconoscimento di Forme a.a. 2006/07

c

P(corretto) = P{x Ri , i } = PP

i {x Ri / i } = Pi p(x| i )dx

c

P(

i =1

)

i) 1

)P(

i

)dx =

c

i ) dx = 1

p( x /

P(

i =1

Ri

i

)

p( x /

i

) dx

Ri

Da cui si vede che minimizzare la probabilità di errore è equivalente a

massimizzare la probabilità di corretta classificazione:

Dove: P ( errore /

i

)=

p( x /

i )dx

c

P(

C [ Ri ]

C [Ri] è l’insieme delle regioni “complemento” di Ri, cioè C[ Ri ] =

i =1

c

UR

j

j =1, j i

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

15

i

)

p(x /

i

) dx

Ri

Ma questo significa che le regioni di decisione Ri vanno definite in modo tale

che P( j | x) = p(x | j)P ( j) sia massima, il che dimostra che la regola MAP

minimizza la probabilità di errore.

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

16

Cenno alla maggiorazione della probabilità di errore

•Date le difficoltà di calcolo, esistono dei metodi, calcolabili più semplicemente,

per avere una maggiorazione della probabilità di errore

•Chernoff bound

Ora generalizzeremo i concetti visti in corsi precedenti:

•Bhattacharyya bound

1. Consentendo l’uso di più di una misura (“feature space”): x =

(x1, x2,…., xd) vettore a “d” elementi

Per chi è interessato si veda il Capitolo 2.8 del libro Pattern Classification, di R. O.

Duda, P. E. Hart, e D. G. Stork, John Wiley & Sons, 2000

•Anche se più semplici si tratta comunque di formule calcolabili analiticamente

solo nel caso Gaussiano, che comunque danno delle maggiorazioni spesso poco

precise; quindi poco utili nella pratica, a meno che la maggiorazione non mi dia

un errore già accettabile per la mia applicazione. Inoltre se le distribuzioni non

sono Gaussiane la maggiorazione può risultare inaffidabile.

Per tali motivi nel seguito del corso vedremo alcuni metodi

sperimentali che si utilizzano per stimare la probabilità di errore di un

algoritmo di classificazione.

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

17

Dall’errore al rischio

P ( errore / x

i

c

)=

P(

j =1, j i

j

| x) = 1

P(

i

| x)

In certe applicazioni gli errori possono avere costi diversi, e quindi le relative

probabilità vanno pesate diversamente. Se i costi possono essere diversi la

sommatoria di cui sopra non è più definibile come una “probabilità”. Si parla

pertanto di rischio R( i / x)

i

| x) =

c

j =1

w ij P (

Corso di Riconoscimento di Forme a.a. 2006/07

2. Consentendo la presenza di più di due classi

3. Introducendo il concetto di “rischio”, come generalizzazione

del concetto di errore

4. Consentendo di “non decidere”, se decidere è troppo

costoso/rischioso ed è fattibile rinviare la decisione o farla

prendere da un “altro” (opzione di “rigetto”)

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

18

Teoria del Minimo Rischio

Dalla formula dell’errore per un generico pattern x è facile vedere che stiamo

assumendo che tutti gli errori, o meglio le probabilità di commettere un errore

perché j i , abbiano lo stesso “costo” unitario.

R(

Teoria della Decisione di Bayes

j

| x)

I pesi wij rappresentano i

costi degli errori. In seguito li

indicheremo come ( i / j)

Notare che wii può essere

diverso da zero (“guadagno”)

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

19

•Il criterio MAP non tiene conto degli eventuali “rischi/costi” associati ai

diversi errori di classificazione

•In molte applicazioni questo criterio di decisione è del tutto

inappropriato, perché le decisioni/“azioni” relative a diverse

classificazioni possono avere costi molto diversi

•La teoria del minimo rischio (detta anche teoria dell’utilità in campo

economico) tiene conto sia delle probabilità degli eventi che dei costi

associati alle diverse decisioni/azioni

Formulazione del problema:

–insieme delle classi:

= { 1, 2, ..., c};

–insieme delle azioni/decisioni possibili

classificazione: A = { 1, 2, ..., a};

in

funzione

della

Per noi l’azione/decisione sarà quasi sempre una classificazione

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

20

Teoria del Minimo Rischio

Esempio di matrice dei costi per Intrusion Detection Systems

I costi delle azioni che è possibile intraprendere dipendono dalle

classificazioni e sono definiti da una matrice dei costi :

! ( 1 | 1)

# ( | )

2

1

=#

# M

# ( | )

% a 1

( 1 | 2 ) L ( 1 | c )"

( 2 | 2 ) L ( 2 | c )$

$

M

O

M

$

( a | 1) L ( a | c )$&

La

funzione

( i| j )

indica la “perdita/costo”

che si avrebbe compiendo

l’azione i quando lo stato

di natura/classe è j

Esempio di matrice dei costi per l’intrusione in un sistema informatico

={ 1= intrusione in atto,

2=

2=traffico

normale}; A= {

1=

continuo a erogare servizio};

! 0

= #

% 21

12

0

"

$

&

blocco il “server”,

Sistema informatico bancario:

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

12

<<

21

Prof. Ing. F. Roli

21

Criterio di decisione a rischio minimo

c

j =1

( i|

j )P(

x

i

R(

R( j| x) ' R( i| x) i = 1, 2, ..., R

i

| x) < R (

j

| x)

i

j, i=1,...,a

Fondamenti di Teoria della Decisione

0

2

2

1

2

Attacco

3

User to

Root

0

2

2

2

Attacco

Remote

to Local

4

2

0

2

2

Attacco

Probing

1

2

2

0

2

Denial of

Service

3

2

2

1

0

Traffico

Normale

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

22

Prof. Ing. F. Roli

Prof. Ing. F. Roli

Esaminiamo il caso

azione=classificazione

•Sia

i

particolare

di

due

sole

l’azione di decidere che la classe corretta è

ij=

(

i

| j) il costo di scegliere

i

classi

R(

1

x) =

11

P(

1

x) +

R(

2

x) =

21

P(

1

x) +

12

se il vero stato di natura

P(

22

23

decidere

1

se R(

Corso di Riconoscimento di Forme a.a. 2006/07

1

|x) < R(

2

e

i

2

P(

2

x)

x)

•La regola di decisione fondamentale è:

Dato il pattern x si sceglie l’azione i a rischio minimo. Abbiamo

così una regola di decisione per ogni pattern x.

Corso di Riconoscimento di Forme a.a. 2006/07

Denial of

Service

•Possiamo riscrivere il rischio condizionato come:

Criterio di decisione a rischio minimo:

j

Attacco

Probing

•Sia

è j

j | x) = E { ( i | )| x}

Il rischio condizionato può essere visto come un costo medio

xa

Attacco

Attacco

User to Remote

Root

to Local

Rischio minimo per classificazione binaria

•Supponiamo di voler eseguire l’azione

seguito

i in

all’osservazione di un pattern x. Dato che non sappiamo quale è il

vero stato di natura, ma conosciamo P( j|x), possiamo dire che il

rischio condizionato associato all’azione i è

R( i |x) =

Traffico

Normale

|x), e viceversa per

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

2

24

Rischio minimo per classificazione binaria

Classificazione a minimo errore e matrice dei costi 0-1

•In termini di probabilità a posteriori:

Nella classificazione l’azione i viene interpretata come

l’assegnazione del “pattern” x alla classe i.

decido

se

1

(

21

11

)P(

1

x) > (

12

)P(

22

x)

2

Una funzione di costo semplice e naturale in questi casi è:

•Applicando la regola di Bayes otteniamo:

decido

1 se

(

11 ) p ( x

21

1) > (

1 ) P(

22 ) p ( x

12

2 ) P(

(

2)

•Inoltre è ragionevole assumere che 21> 11. Mettendo in

p ( x 1 ) p ( x 2 ) la

evidenza il rapporto di verosimiglianza

regola di Bayes può essere interpretata come segue:

1

p( x

p( x

se l (x) =

Corso di Riconoscimento di Forme a.a. 2006/07

1)

2)

>

(

(

) P(

11 ) P (

12

2)

22

21

Fondamenti di Teoria della Decisione

1)

R (

1

i

| x) =

i

i , j = 1, ..., c

j

Matrice dei costi 0-1 o

“zero-one loss function”

c

(

j=1

=

=

|

j

)P (

| x)

j

| x) = 1

j

P(

Fondamenti di Teoria della Decisione

i

se P(

i

| x) > P(

j

| x)

Classificazione a minimo errore e “regioni” di decisione

j

=

12

22

21

11

Se

Esempi

Se

.

P( 2 )

=

P( 1 )

=

=

allora x

0

1

1

0

0

1

Corso di Riconoscimento di Forme a.a. 2006/07

2

0

a llo r a

a llo ra

12

21

i

Se gli errori su 1 costano di

più allora la soglia diventa

più

restrittiva

e

di

conseguenza si riduce R1

In termini di rapporto di verosimiglianza:

Se

26

Prof. Ing. F. Roli

Con la matrice dei costi 0-1 la regola di decisione è la classica

MAP (maximum a posteriori probability):

Assegno x a

| x)

i

i

Corso di Riconoscimento di Forme a.a. 2006/07

Classificazione a minimo errore

i

P (

j

25

Prof. Ing. F. Roli

0 i = j

Tutti gli errori hanno lo stesso costo unitario. Il rischio con questa

funzione di costo è esattamente la probabilità media di errore:

Decido per 1 se il rapporto di verosimiglianza eccede una

soglia che è indipendente dall’osservabile x

decido

j) =

i,

se:

1

=

=

Fondamenti di Teoria della Decisione

p( x |

p( x |

P (

P (

2

1

2P (

P (

Prof. Ing. F. Roli

1)

2)

>

)

=

)

2

1

)

)

La classe 1 deve essere tanto

più “verosimile” quanto più

12 > 21

a

=

b

In Figura

a

è la soglia per il caso di P(

La soglia

b

è relativa al caso

12

>

Corso di Riconoscimento di Forme a.a. 2006/07

2)

e

12

=

21

=1

21

La regione R1 ovviamente si riduce se

27

1)=P(

12

>

Fondamenti di Teoria della Decisione

21

Prof. Ing. F. Roli

28

Nota su “test” di verosimiglianza e “regioni” di decisione

Un test di verosimiglianza riporta il problema della decisione in

uno spazio delle “feature” d-dimensionale ad un test mono

dimensionale sulla singola grandezza scalare , senza bisogno di

conoscere esplicitamente le regioni di decisione.

Esempio di problemi nell’uso del minimo rischio nella rivelazione attacchi

informatici

={ 1= intrusione in atto,

2=

2=traffico

normale}; A= {

continuo a erogare servizio};

! 0

Matrice dei costi:

= #

% 21

12

0

1=

blocco il “server”,

"

$

&

La regola di decisione a minimo rischio è:

–Le regioni di decisione possono essere anche sottoinsiemi molto

complessi dello spazio delle “feature” (anche non connessi,

vedremo degli esempi in seguito), ma un loro calcolo esplicito non

è essenziale per la classificazione di un dato campione x.

–Per classificare x è sufficiente calcolare l(x) e confrontarne il

valore con la soglia .

blocco il "server" se l (x) =

p ( x attacco)

>

p ( x normale)

E’ ovviamente ragionevole che sia:

12

<<

12

21

P( normale)

=

P (attacco)

21

Come fissare i costi ?

Come fissare le probabilità priori ?

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

29

Problemi nell’uso del minimo rischio nella rivelazione attacchi informatici

Come fissare i costi ?

Corso di Riconoscimento di Forme a.a. 2006/07

21

l ( x) =

R = R ( ( x ) x ) p ( x ) dx

1

P (normale)

= * P*

P (attacco)

R=

•E mi accorgo che poter stimare P* mi aiuta a decidere i costi

12

<<

21

per avere un

Prof. Ing. F. Roli

( i|

j ) p(x /

j )P(

j )dx

•Questa verifica ci consentirà anche di introdurre alcuni concetti importanti nelle

applicazioni (probabilità di falso e mancato allarme), e di vedere un problema di

classificazione binaria come un problema di “test di ipotesi” (“hypothesis testing”)

Per vedere la teoria in un caso concreto, consideriamo il problema della

verifica d’identità mediante riconoscimento di impronte

•Se non posso stimare P* ? Vedremo il criterio del Minimax

Fondamenti di Teoria della Decisione

c

•E’ interessante verificare che il criterio di decisione “locale” (cioè applicato per ogni

pattern x) a minimo rischio minimizza il rischio globale su tutto lo spazio delle

“feature”

•Metto bene in evidenza la relazione fra le probabilità a priori ed i costi

Corso di Riconoscimento di Forme a.a. 2006/07

a

i =1 j =1

p ( x / attacco)

1

> * P* =

p( x / normale)

•Tanto più P* è grande, tanto più dovrò scegliere

algoritmo sensibile agli attacchi

30

Minimizzazione del rischio globale

Se riscrivo le cose nel seguente modo:

12

Prof. Ing. F. Roli

•Dato che l’azione intrapresa dipende dall’osservazione del pattern x

attraverso la funzione (x), il Rischio Globale è

Come fissare le probabilità priori ?

=

Fondamenti di Teoria della Decisione

31

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

32

Verifica d’ipotesi nel riconoscimento d’impronte

•La verifica

dell’ipotesi

d’identità viene

fatta sulla base di d

misure, dette

minuzie, estratte

dall’immagine

dell’impronta

Si deve decidere fra due ipotesi (classi):

Dante Rossi

•Genuino

•Impostore

Sono

Dante Rossi !

A. Neri

B. Verdi

C. Bianchi D. Rossi E. Gialli

Database di impronte digitali

MINUTIAE

EXTRACTION

Regioni di decisione

Verification

Score

MINUTIAE

VERIFICATION

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

+ 21P( genuino/ impostore) Pim

( postore)+ 22P( genuino/ genuino) P(genuino)

R1

R1

Pgenuino

(

|impostore) = ps

( |impostore)ds =PMA, Pgenuino

(

|genuino) = ps

( |genuinods

) =1 PMA

PFA) Pimp + 12PFAPgen + 21PMAPimp + 22(1 PMA)Pgen

R2

R1) l’utente è un impostore

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

34

Prof. Ing. F. Roli

Riscrivendo il rischio in forma integrale:

R=

p(s|impostore)ds Pimp +

11

+

R1

p(s|impostore)ds Pimp +

21

p(s|genuino)ds Pgen

22

R2

poichè p(s|impostore)ds = 1

R2

R=

p(s|genuino)ds Pgen +

12

R1

R1

p(s|impostore)ds Pimp +

11

R1

R2

p(s|genuino)ds

R1

p(s|genuino)ds Pgen +

12

R1

p(s|impostore)ds +

21Pimp

21Pimp + 22Pgen +

22Pgen

p(s|genuino)ds =

22Pgen

R1

Pimp(

11

21)p(s|impostore) + Pgen( 12

22 )p(s|genuino)ds

R1

Per minimizzare il rischio l’integrando deve essere negativo

Pgen=P(genuino); Pimp=P(impostore);

Prof. Ing. F. Roli

p(s|genuino)ds = 1

p(s|impostore)ds

R1

PMA: Probabilità di Mancato Allarme (o False Acceptance Rate, FAR)

Fondamenti di Teoria della Decisione

Altrimenti (s

+ 21Pimp

PFA: Probabilità di Falso Allarme (o False Reject Rate, FRR)

Corso di Riconoscimento di Forme a.a. 2006/07

Se s appartiene a R2 allora l’identità è verificata (genuino)

R2

Pim

( postore|impostore) = ps

( |impostore)ds =1 PFA, Pim

( postore|genuino) = ps

( |genuinods

) =PFA

(1

Ora ipotizziamo che

p(s/genuino) e

p(s/impostore) siano

perfettamente note

Minimizzazione rischio globale

( postore)+ 12P( impostore/ genuino) P(genuino)+

R = E{rischio} = 11P( impostore/ impostore) Pim

11

Impostori

33

Il decisore ottimale deve definire le regioni R1 e R2 in modo tale da

minimizzare il rischio globale atteso:

R=

•Sulla base di queste

distribuzioni vengono

definite le regioni di

decisione R1 e R2

Ipotizziamo che lo spazio S degli “score” d’identità sia suddiviso in due regioni R1 e R2 tali

che:

Probabilità di falso e mancato allarme

R2

Genuini

•Si confrontano le

minuzie delle

impronte

La decisione è presa sulla base dello “score”,

numero reale fra 0 ed 1

Corso di Riconoscimento di Forme a.a. 2006/07

•Esempio di

distribuzioni

campionarie degli

“score” dei genuini e

degli impostori

35

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

36

Minimizzazione rischio globale

Pimp (

Criterio di decisione Minimax

21 )p(s|impostore) + Pgen ( 12

11

Pimp (

11 )p(s|impostore) > Pgen ( 12

21

p(s|impostore) Pgen (

>

p(s|genuino) Pimp (

12

22 )

21

11 )

•In alcuni casi reali le probabilità a priori possono variare nel

tempo, od essere difficilmente stimabili (attacchi informatici,

spamming, ecc.). Serve allora una strategia di classificazione che

possa funzionare anche in assenza della conoscenza delle

probabilità a priori

22 )p(s|genuino) < 0

22 )p(s|genuino)

Ma l’ultima è la regola di decisione “locale” a minimo rischio da applicare

ad ogni “pattern” “s”

Abbiamo quindi dimostrato che tale regola, se applicata ad ogni pattern s,

minimizza il rischio globale

•Un approccio (utilizzato in molti problemi dell’ingegneria) è

quello di dimensionare la soluzione sul “caso peggiore”

•Progettiamo il classificatore in modo da minimizzare il rischio

nel caso peggiore al variare delle probabilità a priori

•Minimax: Minimizzo il rischio Massimo

•E’ chiaro che si tratta di un progetto sul caso “peggiore”. Sarà

sovradimensionato, e quindi con prestazioni peggiori delle

migliori ottenibili, quando non mi trovo nel caso peggiore

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

37

Prof. Ing. F. Roli

Criterio di decisione Minimax

Consideriamo un problema a due classi e le regioni di decisione

(inizialmente non note) R1 e R2. Il rischio globale si può scrivere come:

(

R=

11

* P1 * p ( x

1

)+

12

* P2 * p ( x

2

) )dx +

P2 = P(

(

21

* P1 * p ( x

1

)+

22

* P2 * p ( x

2

) )dx

2

)

)2

Sapendo che P2=1- P1 e che

R (P1 ) =

22

+(

12

22

)

p( x

p(x

11

22

)+ (

21

11

)

=1

)1

2

p( x

) dx +

1 )d x

1

N.B. obiettivo dei passaggi

algebrici è esprimere R in funzione

di P1 e ridurre il numero di integrali

)dx + (

22

)2

Corso di Riconoscimento di Forme a.a. 2006/07

p(x

)2

)1

!

+ P1 #(

%#

1 )d x

Fondamenti di Teoria della Decisione

12

)

p( x

)1

Prof. Ing. F. Roli

"

)

dx

$

2

&$

39

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

38

Criterio di decisione Minimax

R ( P1 ) =

22

+(

12

22

)

!

"

... + ...$

2 ) dx + P1 * #... +

#%

)2

)1 $

&

p( x

)1

P1 = P( 1 )

)1

+

Corso di Riconoscimento di Forme a.a. 2006/07

Ricordiamo che i costi e le probabilità a priori definiscono univocamente la soglia

, che assieme alle densità definisce le regioni di decisione R1 e R2 ed il rischio.

p( x /

l ( x) =

p( x /

1

1) >

2) <

2

R1 = { x : l ( x ) >

(

(

12

21

) P(

11 ) P (

22

)

=

)

1

2

} , R2 = { x : l ( x ) < }

•Nel caso in esame al variare di P1 varierà la soglia (P1), le relative regioni di

decisione, e quindi il rischio. Questo non mi consente di controllare il rischio.

Problema: poiché P1 è incognita vorrei controllare il rischio a cui

vado incontro, nel senso di poterlo valutare una volta per tutte

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

40

Criterio di classificazione Minimax

R (P1 ) =

Minimax: Rischio in funzione di P(

!

"

+

*

+

+

)

dx

P

...

...

...

#

$

12

2

1

#

$&

)1

)

)

2

1

%

14444

4244444

3

22 + (

22 )

p( x

-

Rmm , minimax risk

Questa equazione mostra che una volta definite le regioni di

decisione (R1 e R2), il rischio globale è lineare in P1.

Se R1 e R2 sono tali che il termine in parentesi quadre è nullo, allora

il rischio è indipendente dalle probabilità a priori.

Questa è la soluzione minimax, ed il rischio minimax, Rmm, è:

R mm =

22

+

(

12

22

)

p(x

2

11

+

(

11 )

21

)

p(x

11

Nei casi pratici di

classificazione si ha

22= 11=0

22

0

0,2

0,4

0,6

0,8

1

P1

Dalla formula precedente di R(P1) è facile vedere che:

) dx =

)1

=

1)

1 ) dx

P1 = 0 implica che la regione R1 è vuota, e quindi R=

22

P1 = 1 implica che la regione R2 è vuota, e quindi R=

11

2

Verificate per esercizio questa uguaglianza

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

41

Prof. Ing. F. Roli

Minimax: Retta di Rischio

-

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

Minimax: retta a rischio massimo

-

R(P*1)

-

max

-

11

0,2

0,4

0,6

max

11

P1*

22

P1 *

22

0

42

P1

0,8

1

0

P1

0,2

0,4

0,6

0,8

1

Supponiamo che in un certo istante si abbia P( 1)=P1*=0.6 , e

quindi il rischio associato alle regioni di decisione R1(P1*) e

R2(P1*) sia R(P1*)

A questo punto è chiaro che per evitare di avere variazioni incontrollate del

rischio conviene scegliere il valore di P1* che determina la retta a pendenza nulla

Se poi nel tempo P1 varia, dalla formula precedente si vede che il

rischio varierà linearmente, essendo le regioni di decisione

determinate sulla base di P1*=0.6

In questo modo minimizzo il massimo rischio che si ha al variare delle

probabilità a priori delle classi (Minimax). Qualsiasi altra scelta produce infatti

una retta di rischio che può dare dei valori di rischio superiori al variare di P1*

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

43

Le relative regioni di decisione R1(P1*) e R2(P1*) danno il rischio massimo Rmax

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

44

Minimax: retta a rischio massimo

-

-

Calcolo empirico della retta a rischio massimo

!

#( 11 22 ) + ( 21 11 ) p(x 1)dx + ( 22 12 ) p(x

#%

)2

)1

max

11

P1 *

22

P1

0

0,2

0,4

0,6

0,8

1

Per trovare le regioni di decisione R1( ) e R2( ) della retta Minimax:

!

#(

#%

11

22

) +(

21

11

)

p(x

1 )dx +

(

"

12 ) p( x 2 )dx$ = 0

$&

)1

22

)2

E’ quindi necessario determinare le regioni di decisione che soddisfano questa

equazione

Cosa fattibile in alcuni casi trattabili analiticamente, ma difficile in molti casi

pratici

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

)2

1 ) dx

p( x

2 ) dx

=0

)1

p( x

1 ) dx

)2

=

p( x

2 ) dx

)1

La soglia . è quella che rende uguali le due probabilità di errore (PFA=PMA).

Nel riconoscimento di impronte viene detta soglia EER (Equal Error Rate)

Genuini

Impostori

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Notare che la soglia

. che rende uguali le

due probabilità di

errore (PFA=PMA) non

coincide

necessariamente con

la soglia ottima

Bayesiana. Sto infatti

usando il criterio

Minimax, e non il

criterio “puro” del

minimo rischio

Prof. Ing. F. Roli

R1 = { x : l ( x ) >

*} , R 2 = { x : l ( x ) <

*}

Notare che:

*

(

(

12

21

) P(

11 ) P (

22

E’ come se cercassimo la soglia ottima .

senza usare la conoscenza della probabilità

a priori e dei costi !

2)

1)

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

46

Calcolo empirico della retta a rischio massimo: Caso generale

Per matrici di costo 0-1

p( x

Se notiamo che i due integrali sono gli errori commessi su ciascuna delle due

classi (come abbiamo visto in alcune applicazioni tali errori sono detti PFA e

PMA), allora è chiaro che questi errori sono controllabili mediante la scelta della

soglia . Ed in linea di principio posso cercare un valore . che soddisfi

l’equazione precedente. Tale valore identificherà le regioni R1( .) e R2( .).

45

Calcolo empirico retta a rischio massimo per costi 0-1

"

2 )dx$ = 0

$&

47

!

#(

#%

11

22 ) + (

21

11

)

1 )dx + (

p(x

22

)2

12

)

p(x

)1

"

)

dx

$ =0

2

$&

In generale per poter effettuare il calcolo empirico ho bisogno di un

“classificatore” del quale posso controllare le regioni di decisione R1 e R2.

Cosa non sempre fattibile facilmente

Nel caso di costi 0-1 posso cercare di variare i “parametri” del classificatore in

modo da ottenere:

p( x

)2

1 ) dx

=

p( x

2 ) dx

)1

Praticamente significa che vario i parametri e poi stimo le due probabilità

d’errore per cercare di renderle uguali

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

48

Criterio di decisione di Neyman-Pearson

Quando non sono noti nè le probabilità a priori nè i valori da attribuire alle

componenti della matrice di rischio, si può utilizzare il criterio di decisione di

Neyman-Pearson.

Questo criterio è anche utilizzato nelle applicazioni dove si vuole fissare una

certa probabilità di falso allarme e minimizzare poi la probabilità di mancato

allarme (es. nelle applicazioni radar o nel riconoscimento biometrico)

– Si fissa una certa PFA (prob. di falso allarme) desiderata, PFA = .

– Il criterio di Neyman-Pearson minimizza la PMA sotto il vincolo PFA = .

– A tal fine si introduce un moltiplicatore di Lagrange / 0, minimizzando

il seguente funzionale per il caso a due classi:

!

"

F = PMA + ( PFA

) = p ( x | 1 ) d x + # p( x | 2 ) d x

$=

#% R1

$&

R2

!

"

p( x | 2 ) d x

= p( x | 1 ) d x + #1

$=

#% R2

$&

R2

= (1

)+

[ p( x |

1)

p( x |

2 )]d x

Criterio di Neyman-Pearson nel caso a due classi

Il problema è quello di definire il dominio R2 che risolve il problema di minimo

vincolato.

– Trascurando il termine costante nel funzionale, il problema di

minimizzazione è pertanto:

min [ p( x |

11 R2 0 R R2

1 PFA = p( x |

1

R1

1)

p( x |

2 )dx

2 )]dx

=

– Entrambi i termini integrandi in parentesi quadra sono positivi: si ha

quindi il minimo quando la funzione integranda è negativa per ogni x

R2. Pertanto R2 = {x R: p(x| 1) < p(x| 2)} = {x R: l(x) < }.

– Ne consegue il seguente criterio di decisione:

l( x ) =

p( x |

p( x |

1)

2

)

¤

1

2

R2

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

49

Criterio di Neyman-Pearson: calcolo della soglia

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

50

Neyman-Pearson: esempio nel caso biometrico

Il metodo di Neyman-Pearson genera nuovamente un test di verosimiglianza.

La soglia del test coincide col moltiplicatore

e si calcola imponendo la

condizione di vincolo.

– Poiché PFA = PFA( ), l’equazione PFA = identifica implicitamente i

valori ammissibili di .

– Più esplicitamente, introducendo la variabile aleatoria l= l(x) (funzione

di x), si ha:

Genuini

Impostori

+

PFA = P{l ( x) > | 2 } = pl (l| 2 )dl = 2 =

dove

+

pl (l |

2

*

) dl =

*

Non è detto che variando PFA vari con continuità (soprattutto quando si

usano distribuzioni “stimate” dai dati). Nella pratica si cerca di soddisfare

“sperimentalmente” il vincolo PFA '

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

51

In questo caso è semplice trovare una soglia

calcolata sulle distribuzioni

stimate che mi dia una PFA ' . Non faccio altro che provare sperimentalmente

tante soglie fino a che non trovo quella che rispetta il vincolo.

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

52

Neyman-Pearson e curva ROC

Criterio di decisione con opzione di rigetto

Per analizzare le prestazioni al variare della soglia si utilizza la curva ROC

(Receiver Operating Characteristic).

•Anche nel caso ottimale di

classificatore che mi fornisce l’errore

minimo di Bayes (soglia xB in figura),

non è detto che questo livello di errore

sia applicativamente accettabile.

La curva ROC rappresenta l’andamento della PD in funzione della PFA al variare

della soglia.

PD

Consente di analizzare come può

•Esempio: “screening” per diagnosi

medica. Voglio che il numero di “falsi

negativi” sia pari a zero

variare il compromesso fra le

probabilità di falso e mancato allarme

•E’ abbastanza intuitivo che questo

implica

Con il criterio di Neyman-Pearson al variare della soglia ottengo diverse PFA e

diversi valori della probabilità PD di corretta rilevazione (PD=1- PMA).

1

La curva ROC è tanto migliore

quanto più posso ottenere una PFA

piccola ed una PD grande.

La ROC ideale è la funzione

“rettangolo”

Esempi di ROC

Corso di Riconoscimento di Forme a.a. 2006/07

Modo “ovvio” di non sbagliare

è “non decidere”

PFA

1

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

53

Classificazione con opzione di rigetto

x

d

x R

CLASSIFICATORE

o,

Corso di Riconoscimento di Forme a.a. 2006/07

La matrice

i

! ( 0 | 1)

# ( | )

1

1

=#

# M

# ( | )

% c 1

Rigetto

classe che contiene i “rigetti”

Fondamenti di Teoria della Decisione

E’ chiaro che questo implica che sia

razionale “astenersi”, e che ci sia una

ulteriore fase di decisione (manuale od

automatica)

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

54

dei costi, di dimensione (c+1) c, sarà pertanto:

Prof. Ing. F. Roli

55

( 0 | 2 ) L ( 0 | c )"

( 1 | 2 ) L ( 1 | c )$

$

M

O

M $

( c | 1) L ( c | c )$&

Il criterio di decisione è sempre quello a minimo rischio:

x

i

R(

i

| x) < R (

j

| x)

i

j, i=0,1,..,c

La differenza sostanziale è che in alcuni casi può essere meno rischioso non

decidere, cioè rigettare, quando:

R(

Corso di Riconoscimento di Forme a.a. 2006/07

Per ridurre la probabilità di errore si

può decidere di astenersi dalla decisione

(opzione di rigetto)

Matrice dei costi e minimo rischio con rigetto

E’ intuitivo che l’opzione di rigetto implica che si debba aggiungere una

decisione/classificazione in più rispetto alla precedente formulazione del

problema di classificazione:

–insieme delle classi:

= { 1, 2, ..., c};

–insieme delle azioni/decisioni possibili in funzione della

classificazione: A = { o, 1, 2, ..., a};

–nel caso della pura classificazione: A = { o, 1, 2, ..., c};

Ho quindi una classe in più :

che sbagliare è molto costoso

(almeno oltre un certo livello di

errore), e quindi è necessario

cautelarsi

0

| x) < R (

Corso di Riconoscimento di Forme a.a. 2006/07

j

| x)

j

Fondamenti di Teoria della Decisione

0

Prof. Ing. F. Roli

56

Classificazione binaria con costi uguali

Classificazione binaria con costi uguali

Vediamo il caso con due sole classi e costi uguali rispetto alle classi:

=

Costo rigetto =

r

Il rischio totale R si può scrivere come:

R =

r

r

( 0 | 1)

( 0 | 2)

c

e

= ( 1 | 1)

+

( 1| 2)

+

c

e

( 2 | 2)

( 2 | 1)

Costo errore =

e

Costo classificazione corretta =

=

c (spesso

{

R1 = { x

R2 = { x

R : R(

0

R : R(

1

R : R(

Corso di Riconoscimento di Forme a.a. 2006/07

2

| x) < R (

| x) < R (

| x) < R(

j

j

j

| x)

j

| x)

j

| x)

j

Fondamenti di Teoria della Decisione

+

}

1}

2}

0

Prof. Ing. F. Roli

+

57

Il compromesso errore-rigetto

r P ( rigetto ) +

e P (errore) +

c P (corretto )

poichè P ( rigetto) + P (errore) + P (corretto) = 1 possiamo scrivere

R=(

r

c ) P ( rigetto ) + ( e

[P (erro re, x

c [ P ( c o r r e tto , x

r

e

c

!

#P(

#%

1)

c ) P (errore)

!

#P(

%#

1)

) + P (erro re, x

1

1 )dx + P (

p(x /

!

#P(

#%

1)

2

2

) + P ( c o r r e tto , x

2 )

p(x /

R0

p(x /

1 )dx + P (

2 )

R2

p(x /

1 )dx + P (

2 )

2

)] =

"

)

d

x

+$ +

2

$&

"

)

d

x

+

$+

2

&$

p(x /

"

$

)

d

x

+

2

$&

R2

Corso di Riconoscimento di Forme a.a. 2006/07

)]+

)]+

p(x /

R1

R1

Fondamenti di Teoria della Decisione

58

Prof. Ing. F. Roli

Nelle applicazioni le specifiche di progetto sono spesso del tipo: minimizzare la

probabilità di errore con P(rigetto) minore of uguale a “r” (es. errore<1% con

rigetto<15%)

Questi requisiti possono essere soddisfatti dalla regola di decisione, con

opzione di rigetto, di Chow (C.K. Chow, 1957, 1970):

i

Si parla di compromesso errore-rigetto (error-reject trade-off)

Il compromesso è anche chiaro da P(corretto)=1-P(rigetto)-P(errore)

Praticamente questo significa che posso ridurre l’errore aumentando il rigetto,

e viceversa. Come è ovvio intuitivamente.

Fondamenti di Teoria della Decisione

1

) + P ( r ig e tto , x

R0

se m ax P (

Da quest’ultima formulazione del rischio globale risulta chiaro che ogni valore

del rischio può essere ottenuto fissando il “rigetto” o l’“errore”, e facendo variare

l’altra quantità

Corso di Riconoscimento di Forme a.a. 2006/07

1

Compromesso errore-rigetto e regola di Chow

E quindi, dall’equazione precedente:

R=

[ P ( r ig e tto , x

e

c=0)

Applicando il criterio del minimo rischio si avranno tre regioni di decisione:

R0 = x

r

Prof. Ing. F. Roli

59

i

/ x) / T

altrim enti rigetta x

con T =

e

r

e

c

x

i

•T è la soglia di rigetto

•T varia fra 0 e 1perchè

c

'

r

•Per T=0 ( e= r) ho la classica regola

MAP

Si dimostra (C.K. Chow, 1957) che questa regola di decisione minimizza l’errore

(o massimizza l’accuratezza) per ogni ogni valore della probabilità di rigetto

Intuitivamente si capisce che la regola di Chow minimizza l’errore rigettando i

pattern la cui classificazione non è abbastanza “affidabile”

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

60

Esempio di uso regola di Chow

Esempi compromesso errore-rigetto

Errore

P( 1|x)

•Curva ideale

P( 2|x)

•Al crescere della soglia T cresce

il rigetto e diminuisce l’errore

(compromesso errore-rigetto)

T

Rigetto

x

R

R0

1

R2

Esempi

di

compromesso

accuratezza-rigetto per diversi

algoritmi di riconoscimento di

caratteri (OCR)

•Due classi Gaussiane

•Soglia di rigetto T definisce la regione di rigetto R0

•L’esempio fa capire che si può ridurre a zero l’errore pur di aumentare la soglia T

fino a che la regione R0 non contiene tutti i pattern errati. Cioè rigetto tutti gli errori

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

61

Corso di Riconoscimento di Forme a.a. 2006/07

Funzioni discriminanti e superfici/regioni di decisione

x

i

R( i | x) < R(

j

i

| x) i j, i=1,...,c

i

•Per il caso generale possiamo porre gi(x)=-R( i|x) ; la massima

funzione discriminante corrisponde al minimo rischio.

•Per il caso ad errore minimo: gi(x)=P(

1/x)

•In particolare per la classificazione a minimo errore le seguenti

scelte sono equivalenti:

g i ( x) = P (

i

x) =

p(x

p(x

g i ( x) = p ( x

i

g i ( x) = ln ( p ( x

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

63

Corso di Riconoscimento di Forme a.a. 2006/07

) P(

i

i

) P(

i

)

c

j =1

se

Corso di Riconoscimento di Forme a.a. 2006/07

62

•La scelta di gi(x) non è univoca; possiamo sostituire ogni gi(x)

con f(gi(x)), dove f( ) è una funzione monotona crescente.

•Un modo alternativo di

rappresentare i classificatori è

basato sull’uso di un insieme

di funzioni discriminanti

gi(x), i=1,..,c.

•Assegnamo x alla classe

gi(x)> gj(x) per ogni j i

Prof. Ing. F. Roli

Funzioni discriminanti e superfici/regioni di decisione

Allo stato attuale un “classificatore” è per noi una “macchina” che prende in

ingresso il pattern x e lo classifica secondo l’algoritmo del minimo rischio:

x

Fondamenti di Teoria della Decisione

i

j

) P(

i

))

)

) ) + ln (P (

Fondamenti di Teoria della Decisione

j

)

Prof. Ing. F. Roli

64

Funzioni discriminanti e superfici/regioni di decisione

•Nel caso di due sole classi è possibile definire un’unica funzione

discriminante g(x)5 g1(x)- g2(x)

•Le funzioni discriminanti

dividono lo spazio delle

“feature” in c regioni di

decisione R1 … Rc.

•Se g(x)>0 si decide per

•I confini di separazione fra le

regioni (“decision boundaries”)

sono definiti dall’equazione

gi(x)=gj(x) fra le due funzioni

discriminati a valore massimo

g ( x) = P (

g (x) = ln

•Esempio in due dimensioni, due classi con distribuzioni Gaussiane delle classi. Le

superfici di decisione sono iperboli. La regione R2 non è semplicemente connessa.

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

65

Principali fonti bibliografiche

Capitoli 2.1, 2.2, 2.3, 2.4, 2.5, 2.6, del libro Pattern Classification, di R. O. Duda,

P. E. Hart, e D. G. Stork, John Wiley & Sons, 2000

Cap. 1 del libro Statistical Pattern Recognition di Andrew Webb, John Wiley &

Sons, 2002

C.K. Chow, On optimum error and reject trade-off, IEEE Trans. on Information

Theory 16 (1970) 41-46

Fonti varie rielaborate dal docente

Corso di Riconoscimento di Forme a.a. 2006/07

1,

altrimenti per

2

•Fra le varie forme in cui possiamo esprimere la g(x), per un

problema a due classi le seguenti sono le più convenenti:

•Se gi(x)> gj(x) per ogni j i,

allora x Ri, e viene assegnato

alla classe i.

Corso di Riconoscimento di Forme a.a. 2006/07

Funzione discriminante per due classi

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

67

1

x) P (

p(x

p (x

2

x)

)

P(

+ ln

P(

2)

1

)

2)

1

•Un classificatore che lavora su un problema a due classi viene

anche detto classificatore dicotomico

Corso di Riconoscimento di Forme a.a. 2006/07

Fondamenti di Teoria della Decisione

Prof. Ing. F. Roli

66