Università degli Studi Mediterranea di Reggio Calabria

Dipartimento di Ingegneria dell’Informazione, delle Infrastrutture e dell’Energia Sostenibile

Corso di Laurea in Ingegneria delle Telecomunicazioni

Tesi di Laurea

Analisi del fenomeno dei Big Data e comparazione di

DBMS NoSQL a loro supporto

1

Relatore

Candidato

Prof. Domenico Ursino

Francesco Romeo

Anno Accademico 2013-2014

Alla mia famiglia, ai miei amici e a

tutte le splendide persone che mi sono

state vicine durante questo cammino.

1

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

INTRODUZIONE

La rivoluzione digitale, la diffusione degli open data e l'accelerazione senza precedenti

dello sviluppo tecnologico hanno causato una vera e propria esplosione dei dati. Questo

fenomeno risulta in continua crescita e tale crescita sembra destinata a mantenersi anche per il futuro. I dati vengono generati attraverso qualsiasi mezzo: dai sensori per la

raccolta di informazioni sul clima ai post sui social network, passando per video e immagini digitali, dati GPS raccolti attraverso smartphone e tablet, trascrizione delle transazioni di acquisto, e tanti altri mezzi.

Gli strumenti di analisi aiutano i ricercatori a trasformare i dati in conoscenza. La capacità

di analizzare un'elevata mole di informazioni, spesso non strutturate, rappresenta, per le

aziende operanti in alcuni settori, una chiara fonte di vantaggio competitivo e di differenziazione. I Big Data, combinati con sofisticate analisi di business, hanno il potenziale per

dare alle imprese intuizioni, senza precedenti, sul comportamento dei clienti e sulle condizioni di mercato, permettendo di prendere decisioni più velocemente e più efficacemente rispetto alla concorrenza.

1

Per far fronte a tali esigenze le aziende fanno uso di nuove soluzioni ICT, sia a livello infrastrutturale che applicativo, in tutte le fasi del processo, dall'acquisizione, passando per la

fase di analisi, fino ad arrivare alla visualizzazione dei risultati ottenuti.

Uno dei problemi che sta dietro ai Big Data è che, nella maggior parte dei casi, questi dati

non sono strutturati, quindi non sono facilmente riconducibili a modelli di dati o a metodi

classici di archiviazione. Cambiare in corsa una determinata tabella, magari introducendo

nuovi attributi, è problematico e, spesso, sconsigliato proprio per evitare problemi di

corruzione al DBMS. Questa limitazione rende i DBMS relazionali molto poco adatti alle

trasformazioni dei Big Data. La nascita e il recente sviluppo dei DBMS NoSQL si sono

rivelati di importanza fondamentale per garantire la crescita di tutta una serie di applicazioni ricche di contenuti e spesso distribuite agli utenti tramite Internet.

Francesco Romeo | 1

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Di soluzioni per affrontare la problematica dei Big Data ne esistono di diversi tipi, ma quella che

va per la maggiore è sicuramente basata su Hadoop. Questa tecnologia, open source, ha rivoluzionato la percezione delle aziende su cosa può essere fatto con i propri dati. La crescita esplosiva dei dati, associata al crollo dei costi dei server e alla crescita delle infrastrutture cloud, ha

fatto diventare Hadoop il punto di riferimento per le medie e grandi aziende.

Esistono varie tipologie di DBMS NoSQL, ciascuna delle quali presenta caratteristiche differenti. La scelta su quale DBMS usare va fatta accuratamente dal progettista software in base alle

caratteristiche del sistema da gestire. All’interno della tesi si è scelto di dare maggiore importanza a tre dei DBMS più utilizzati: Cassandra, MongoDB e HBase.

In questa tesi presenteremo una panoramica sui Big Data e, più in particolare, su quanto precedentemente specificato.

La tesi è strutturata come di seguito specificato:

Nel primo capitolo sarà descritto il fenomeno dei Big Data. Verrà presentato il tema della

Social Business Intelligence e i vantaggi che ne derivano. Inoltre, verranno presentati i più

diffusi contesti di utilizzo.

Il secondo capitolo si concentrerà sul processo di analisi dei Big Data, partendo dal processo di estrazione della conoscenza dai database (KDD) e dando maggiore rilievo alla

fase di Data Mining. Verrà presentata la figura del data scientist e sarà affrontato il tema

della Privacy By Design.

Nel terzo capitolo sarà introdotto il concetto di NoSQL e verrà fatto un confronto con i

DBMS relazionali. Inoltre, verranno elencate le varie tipologie di DBMS NoSQL.

Nel quarto capitolo si parlerà dell’utilità del framework Hadoop per l’analisi distribuita di

grandi insiemi di dati. Verranno, inoltre, presentati i sottoprogetti fondamentali, MapReduce e HDFS, e l’innovativo YARN.

Nel quinto capitolo verranno trattati tre dei più utilizzati DBMS NoSQL: Cassandra, MongoDB e HBase. Inoltre, verranno presentate, e poi confrontate le caratteristiche, di ognuno di essi.

Infine, nell’ ultimo capitolo, verranno tratte le conclusioni e verranno esaminati alcuni

possibili sviluppi futuri.

2 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1. INTRODUZIONE AI BIG DATA

In questo capitolo verrà descritto il concetto di Big Data. Partendo dal significato del termine verranno delineate le caratteristiche generali di questo fenomeno. Successivamente,

verrà affrontato il tema della Social Business Intelligence con i vantaggi che ne derivano. Il capitolo si concluderà con una presentazione dei più diffusi contesti di utilizzo,

appunto, dei Big Data.

1

Cosa si intende per

Big Data

2

La Social Business

Intelligence

3

Contesti di utilizzo

dei Big Data

1

Francesco Romeo | 3

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.1 COSA SI INTENDE PER BIG DATA

“What is Big Data? A meme and a marketing term, for sure, but also shorthand for advancing

trends in technology that open the door to a new approach to understanding the world and

making decisions .”

Il termine Big Data, sicuramente abusato nelle moderne strategie di mercato, indica grandi

aggregazioni di dati che non possono essere processati o analizzati con i tradizionali processi e

strumenti di analisi. I Big Data aprono le porte verso nuovi modi di percepire il mondo e di prendere decisioni.

I Big Data sono ovunque, e ogni giorno sempre più applicazioni vengono create per trarne

valore e arricchire la vita personale e professionale degli utenti. I nostri desideri, opinioni, sentimenti lasciano traccia nei social media a cui partecipiamo, nelle domande che facciamo ai

motori di ricerca, nei tweet che inviamo e riceviamo, così come i nostri stili di vita lasciano

traccia nei record dei nostri acquisti. I nostri movimenti lasciano traccia nelle traiettorie disegnate dai nostri smartphone e dai sistemi di navigazione delle nostre auto. Anche le nostre

relazioni sociali lasciano traccia nella rete dei

nostri contatti telefonici, delle email e nei link di

amicizia del nostro social network preferito.

Da un lato, alcuni fattori, quali la crescita dei dati

scientifici, hanno fortemente contribuito all'accelerazione della produzione di questi dati. Dall'altro, questa crescita esponenziale è il risultato di

alcuni mutamenti sociali ed economici estremamente positivi avvenuti nella nostra società. Si

consideri, ad esempio, la rapida diffusione dei

dispositivi mobili, ricchi di contenuti multimediali e compatibili con i sistemi GPS, e dei social

network, che hanno consentito a miliardi di persone in tutto il mondo di tenersi in contatto in

modo digitale.

4 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

I Big Data sono il nuovo strumento che rende “misurabile” la società. Ci indirizzano verso una

nuova scienza dei dati in grado di misurare e, in prospettiva, prevedere crisi economiche,

epidemie e pandemie, diffusione di opinioni, distribuzione delle risorse economiche o energetiche, bisogni di mobilità.

Molti analisti, per poter definire il concetto di Big Data, utilizzano le tre caratteristiche descritte di seguito:

Velocità;

Varietà;

Volume;

Un equivoco molto diffuso è la convinzione che il

concetto di Big Data riguardi esclusivamente le dimensioni dei dati. Per quanto le dimensioni rappresentino sicuramente un elemento della questione, esistono anche altri aspetti o altre proprietà dei Big Data che non sono necessariamente associati a esse. Si prendano in considerazione, ad esempio, la velocità di generazione dei Big Data da un lato e, dall'altro, il numero e la

varietà di origini da cui i dati vengono generati contemporaneamente.

Per stabilire quando effettivamente i vari tipi di dati rientrano nella categoria dei Big Data è

necessario analizzare gli elementi sopra citati. È fuor di dubbio che una presentazione di

PowerPoint da 40 MB, un'immagine medica da 1 TB o un filmato da 1 PB hanno tutti dimensioni elevate, ma dobbiamo capire se si tratti di Big Data. Si potrebbe sostenere che non si

possono definire Big Data solo in virtù delle dimensioni, poiché il concetto di dimensioni

elevate, così come inteso oggigiorno, potrebbe cambiare in futuro. Si potrebbe, invece, asserire che si tratta oggi di Big Data perché ognuno di essi sfrutta al massimo la comune tecnologia disponibile per il loro utilizzo. Si può considerare Big Data una presentazione di PowerPoint da 40 MB se non è possibile condividerla via email con colleghi o aziende. Analogamente, si può considerare Big Data un'immagine medica da 1 TB se non è possibile visualizzarla in

tempo reale su uno schermo remoto in modo semplice e accurato e consentire al medico di

utilizzarla durante le visite dei pazienti. Un filmato da 1 PB rientra fra i Big Data se non è

possibile eseguire il rendering dell'editing entro l'orario di attività aziendale.

È chiaro, quindi, che qualunque attributo, comprese le dimensioni, riguarda i Big Data nel

momento in cui mette alla prova i limiti delle funzionalità dei sistemi o incide sulle esigenze

Francesco Romeo | 5

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

aziendali. In merito agli altri attributi che

possono rientrare nella definizione precedentemente esposta, quali la velocità di

generazione dei dati o il numero e la varietà

di origini da cui provengono, in questo caso è

possibile applicare la classificazione di Big

Data a quei dati che, di per sé, non sono

affatto “GRANDI”.

Un altro aspetto interessante dei Big Data è la loro diversità dal punto di vista della struttura.

Alcuni hanno un formato ben definito, ad esempio nel caso delle transazioni di un database, in

cui ogni voce può essere divisa in campi, ciascuno dei quali contenente un tipo di dati ben chiaro e definito. Altri possono essere, semplicemente, una raccolta di interventi su blog con testo,

tabelle, immagini, audio e video, tutti memorizzati all'interno dello stesso storage di dati.

Possiamo affermare che i Big Data sono intorno a noi e che noi stessi siamo tra i principali generatori. L'aggiornamento dei Big Data avviene, inoltre, in modo estremamente iterativo e

incrementale con una frequenza elevata.

I dati vengono costantemente modificati e divengono più accurati e precisi con il passare del

tempo e con l'aumentare dei dati relativi ai dati creati, calcolati o desunti.

L'esecuzione di analisi con la maggiore granularità possibile, che producano allo stesso tempo

una quantità di dati sufficiente affinché il risultato sia significativo e accurato, richiede iniziative

più precise e, in compenso, porta maggiori profitti o guadagni per l'azienda e i clienti.

Tenendo conto della qualità dei dati e della loro rappresentatività, dobbiamo essere consapevoli delle grandi opportunità, così come dei nuovi rischi. Occorrono tecnologie a sostegno della

privacy, occorre un “new deal” sui temi della privacy, della trasparenza e della fiducia necessario per creare e accedere alla conoscenza dei Big Data come un bene pubblico per tutti. Certo, i

problemi relativi alla qualità, alla privacy e alla proprietà dei Big Data risultato essere decisivi.

6 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.2 LA SOCIAL BUSINESS INTELLIGENCE

La Business Intelligence (nel seguito, BI) può

essere definita come l’insieme delle metodologie, dei modelli, delle tecnologie e delle

applicazioni rivolte alla raccolta sistematica

del patrimonio di informazioni generate e

acquisite da un’azienda, alla loro aggregazione, analisi, presentazione e al loro utilizzo.

Le tecniche di BI nascono, come dice il nome, nel settore economico-finanziario, con

applicazioni oggi prevalentemente di

marketing, e hanno nomi evocativi come:

benchmarking, data mining, business performance management, etc.

Big Data Analytics è un concetto nuovo, che in realtà è l’unione di due concetti dei quali si

parla ormai da molti anni e che, quindi, nuovi non sono. Da un lato Big Data, con tutte le

problematiche connesse, come abbiamo visto. Dall’altro lato la Business Analytics.

Di modello dimensionale dei dati e applicazioni OLAP (On-Line Analytical Processing) si parla

da più di 20 anni; la Business Intelligence e il Performance Management sono tra le aree IT

che, negli ultimi anni, hanno avuto più attenzione ed investimenti; il Data Mining e le analisi

predittive sono stata l’ultima frontiera che

ha portato verso la Business Analytics.

Oggi è difficile trovare un’azienda che non

abbia affrontato almeno uno dei temi

appena citati.

Ciò che è inedito, invece, è il concetto di

Big Data Analytics. Unione che non è il

semplice accostamento dei due concetti

sopra descritti. Big Data Analytics non

significa semplicemente, o non solo, potere fare analisi su grossi volumi di dati. Anche gli altri

due fattori che caratterizzano i Big Data, ovvero la varietà dei dati e la necessità di trasformare i dati in informazioni il più velocemente possibile, sono intervenuti a determinare la definizione di questa nuova categoria di applicazioni.

Vediamo quale può essere la chiave di successo per sfruttare i grandi dati e per estrarre da

essi informazione e conoscenza. Secondo il McKinsey Global Institute, è possibile identificare cinque fattori largamente applicabili per poter sfruttare i Big Data come fonte di valore.

Questi saranno esaminati in dettaglio nel prossimo paragrafo.

Francesco Romeo | 7

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.2.1 BIG DATA COME FONTE DI VALORE

I cinque fattori capaci di dare valore ai

Big Data sono i seguenti:

La creazione della trasparenza: si

può ottenere la trasparenza

semplicemente rendendo accessibili e disponibili i dati e le informazioni a tutti gli “stakeholder”

in modo tempestivo e in modo

da creare un valore straordinario;

nel settore pubblico è in atto da

tempo una tendenza (Open Data), in particolare nel mondo anglosassone, di apertura del

patrimonio informativo a tutte le organizzazioni private e/o ai cittadini. Per quanto le

prime iniziative abbiano messo in luce elementi di criticità, si tratta di una tendenza che

prosegue e che, anche in Italia, ha messo in moto alcune interessanti iniziative sia a livello

regionale che nazionale.

Miglioramento delle prestazioni: tutte le organizzazioni, sia pubbliche che private, con una

maggiore analisi ed elaborazione dei dati e delle informazioni disponibili possono migliorare le loro prestazioni ed i loro processi. Particolarmente significativi a questo riguardo

sono le esperienze di analisi dei dati di vendita ed, in generale, di relazione con la clientela. Una più attenta elaborazione dei dati relativi alle vendite può incrementare in modo

significativo la capacità di segmentare l’offerta e

di personalizzarla sulle specifiche esigenze del

cliente. Analizzare i dati sul venduto può dare

origine ad una più precisa previsione dell’andamento futuro delle vendite con evidenti vantaggi

nella gestione logistica. Nel settore pubblico, il

processo di digitalizzazione in atto nell’area della

salute, può consentire oltre ad una analisi accurata della efficienza ed efficacia delle strutture sanitarie una disponibilità di informazioni

cliniche che contribuisce ad aumentare la qualità e la personalizzazione dei trattamenti

sanitari. Sempre nel settore pubblico, un’analisi delle tendenze e dei dati relativi al mercato del lavoro può aiutare in modo decisivo la definizione di politiche attive di supporto ai

non-occupati e l’impostazione di adeguati processi formativi.

Segmentazione dei clienti e personalizzazione delle azioni: i Big Data consentono alle orga-

8 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

nizzazioni di creare segmentazioni altamente specifiche e di

adattare i prodotti e i servizi alle esigenze dei consumatori.

Questo approccio è ben noto in marketing e nella gestione del

rischio.

Supporto alle decisioni: i processi decisionali, in tutte le organizzazioni, possono diventare sempre più data-driven e fact-based. Le decisioni prese con

il supporto di strumenti analitici possono diventare la regola e non l’eccezione. Fino ad

ora queste tecniche erano diffuse solo nelle grandi organizzazioni, anche per il costo

elevato dei sistemi e degli strumenti informatici per l’elaborazione e l’analisi dei dati. Le

attuali evoluzioni tecnologiche, come il diffondersi del “cloud-computing” e degli strumenti di analisi “open-source”, rendono molto meno costoso e più flessibile l’adozione

di queste tecniche da parte anche delle organizzazioni medio-piccole.

Innovare i prodotti, i servizi e i modelli di business. La possibilità, tramite l’analisi dei dati,

di rispondere in tempo reale alle domande:

“Cosa è successo?”, “Perché è successo?”, “Che

cosa sta succedendo?” e “Che cosa succederà?” consentono alle organizzazioni di innovare

i prodotti, i processi e i modelli di business per

cogliere le sfide di un ambiente in continuo

cambiamento.

Per cogliere al meglio le opportunità elencate è,

però, necessario rispondere efficacemente ad alcune

sfide che possono essere cosi sintetizzate:

Sfide tecniche: il tema della qualità, dell’accessibilità e della fruibilità dei dati rimane un

aspetto critico che molte organizzazioni non hanno ancora adeguatamente affrontato.

Come citato in una ricerca, IBM stima che oltre il 50% dei manager, non consideri affidabile il dataset sul quale si basano i processi decisionali.

Mancanza di talenti: la crescita esponenziale dei “big data” ha messo in evidenza la

necessità, sempre maggiore, di persone con competenza adeguate per elaborare, analizzare e visualizzare grandi dataset ed estrarre da essi le informazioni essenziali per il

supporto delle decisioni. Si valuta che nel 2018, solo in USA, vi sarà una carenza di personale con competenze di analisi stimabile in 150-190 mila unità e saranno mancanti

oltre 1,5 milioni di manager con competenze adeguate all’utilizzo dei “big data”. Emergeranno, inoltre, nuove figure professionali come quella del “data scientist”, dotate di

Francesco Romeo | 9

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

competenze multidisciplinari (statistica, informatica, economia, organizzazione), necessarie per creare valore ai “big data”.

Sfide legali: il tema della sicurezza, della

tutela della privacy e della protezione

della proprietà dei dati e delle informazioni, in molti settori (come ad esempio

quello della sanità), costituisce un’elemento forte di criticità e, talora, un

freno all’innovazione.

Sfide culturali: la cultura delle decisioni data-driven e fact-based non è ancora sufficientemente diffusa nelle organizzazioni, sia pubbliche che private (soprattutto in Italia). È

indispensabile, dunque, dedicare adeguata attenzione alle politiche formative ed alla

gestione del cambiamento.

Questa grande complessità e quantità dei dati può essere gestita solo attraverso soluzioni

tecnologiche nuove. È stata sviluppata e adattata un'ampia varietà di tecniche e tecnologie per

aggregare, manipolare, analizzare e visualizzare i Big Data. L'insieme di tecniche e tecnologie

attingono da settori diversi, quali la statistica, l’informatica, la matematica applicata e l'economia: questo significa che un'azienda, la quale intende trarre valore dai Big Data, dovrebbe

adottare un approccio flessibile e multidisciplinare. Le tecniche e le tecnologie per aggregare,

manipolare, analizzare e visualizzare i Big Data sono in continuo sviluppo per ottenere , sempre, un miglioramento delle prestazioni.

10 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.2.2 VARIETA’ DELLE INFORMAZIONI

Probabilmente esistono due distinte categorie di Big Data. La prima è relativa alle tipologie

tradizionali di dati. La seconda è relativa ai dati generati dalla rete. Se prestiamo attenzione a

quest’ultima categoria, proviamo ad elencare alcune importanti fonti di dati per la Big Data

Analytics:

Dati strutturati in tabelle (relazionali). Sono i dati sui quali si basa la tradizionale Business

Intelligence e la sua recente evoluzione, la Business Analytics. I volumi sempre crescenti

di dati memorizzabili e le architetture sempre più “performanti” rendono ancora oggi le

tabelle relazionali la principale fonte di dati per la Big Data Analytics. Tutti i sistemi

gestionali esistenti producono dati strutturati o strutturabili in tabelle relazionali. Queste restano il modello di dati preferenziale per le principali piattaforme di Data Analytics.

Dati semistrutturati (XML e standard simili). E’ il tipo di dati che sta sfidando l’egemonia

dei dati strutturati. Applicazioni transazionali e non, forniscono nativamente output di

dati in formato XML o in formati tipici di specifici settori (SWIFT, ACORD, etc. ). Si tratta, perlopiù, di dati Business-to-Business organizzabili gerarchicamente.

Dati di eventi e macchinari (messaggi, batch o real time, sensori, RFID e periferiche).

Sono i tipici dati definibili “Big Data” che, sino a pochi anni fa, venivano memorizzati

solo con profondità temporali molto brevi (massimo un mese) per problemi di storage.

Dati non strutturati (linguaggio umano, audio, video). Sono enormi quantità di metadati, perlopiù memorizzati sul web, dai quali è possibile estrarre informazioni strutturate

attraverso tecniche avanzate di analisi semantica.

Dati non strutturati da social

media (social network, blog,

tweet). Sono l’ultima frontiera

delle fonti di dati non strutturate. Crawling, parsing ed

entity extraction sono tra le

tecniche per l’estrazione di

dati strutturati e analizzabili. I

volumi aumentano esponenzialmente nel tempo. Il loro

utilizzo può aprire nuovi paradigmi di analisi prima impensabili.

Francesco Romeo | 11

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Dati relativi alla navigazione Web (Clickstream): Web Logs, Tag Javascript, Packet sniffing

per ottenere Web Analytics. Si tratta di enormi quantità di dati che portano informazioni

sui consumi e sulle propensioni di milioni di utenti. Anche per questi dati, i volumi aumentano esponenzialmente nel tempo.

Dati GIS (Geospatial, GPS). I dati geospaziali sono generati da applicazioni sempre più diffuse. La loro memorizzazione è ormai uno standard e i volumi sono in crescente aumento. I dati geospaziali, analizzati statisticamente e visualizzati cartograficamente, integrano i dati

strutturati fornendo, ad esempio, informazioni di business, informazione sulla sicurezza o informazioni sociali.

Dati scientifici (astronomici, genetica, fisica). Come i dati relativi agli eventi, sono per

definizione dei Big Data. Per il loro trattamento e la loro analisi si sono sperimentate tutte

le più innovative tecniche computazionali nella storia recente dell’Informatica. Per essi

sono stati progettati, nel tempo, tutti i più potenti calcolatori elettronici. I loro volumi

sono enormi e in costante aumento.

Dopo questa elencazione, comunque

non esaustiva, sarà risultato chiaro

quale sia la potenziale varietà di dati

da trattare in un’applicazione sviluppata per trasformare i dati in informazioni di business.

12 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.2.3 LA VELOCITA’ NEI FENOMENI AZIENDALI

Introduciamo l’ultimo fattore che ha determinato la nascita delle Big Data Analytics, ovvero

la Velocità che, per molti fenomeni aziendali, è

diventata una caratteristica sempre più determinante. Essa è fondamentale per:

Svolgere i processi e le attività aziendali

(ad esempio, un processo commerciale, la

creazione di un nuovo concept di prodotto, la comunicazione di marketing con

media digitali).

Trattare in modo integrato grandi volumi di dati eterogenei (ad esempio, i dati di vendita, i reclami a un customer care e i commenti sui blog o nei social network, dati di geolocalizzazione) e ottenere un’informazione rilevante (ad esempio, di insight nel comportamento di acquisto di un segmento di clientela e delle sue percezioni di qualità verso il

prodotto).

Rilevare, archiviare, elaborare, distribuire e presentare i dati generati utilizzando i sistemi ICT.

Gestire le relazioni digitali tra le persone, le imprese e le istituzioni in modo da permettere la “ubiquità” dei dati e degli individui.

La velocità oggi a disposizione delle aziende si concretizza nella capacità potenziale di ridurre

il tempo necessario non solo per l’esecuzione di un’attività, ma anche per la sua finalizzazione, per il cambiamento repentino e “in corsa” dei suoi obiettivi o delle sue relazioni con altri

processi; questa è la vera e rivoluzionaria novità

per la gestione d’azienda. Muoversi in un contesto dove si hanno tutti i dati a disposizione

consente di affrontare un problema con un

margine di errore ridotto e accettabile.

La complessità crescente della gestione aziendale di cui si parla spesso, è, di fatto, generata

da due fattori prevalenti: la crescente velocità

dei cambiamenti necessari, e la crescente incertezza degli scenari e dei risultati generabili dalle

scelte possibili.

I seguenti punti possono aiutare a riassumere i

Francesco Romeo | 13

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

principali cambiamenti già in atto e basati

sull’ICT, che prospettano alcuni nuovi orizzonti

del management aziendale:

Trasformare il modo in cui le persone pensano, analizzano i fatti, pianificano e agiscono:

sono necessari nuovi atteggiamenti nei

confronti dell’ICT, passando da molti fenomeni di moda e di “consumerization” (ad

esempio, riguardo i dispositivi mobili o il

social Web) ad un reale impiego nella gestione aziendale.

Velocizzare i processi di Innovation Management, sia di prodotto/servizio (dall’idea generation al concept, al testing e allo sviluppo),

sia di processo (interno esterno, operativo o manageriale), generati dall’ICT.

Far funzionare in modo sincrono elevati volumi di transazioni e operazioni aziendali con

veloci ed evolute attività di analisi dei dati strutturati e non strutturati generati da questi

processi operativi online e offline.

Velocizzare le decisioni aziendali con un numero maggiore di informazioni rilevanti e con

sistemi di comunicazione e collaborazione ad alta velocità, in tempo reale, tra persone,

tra team di lavoro, e tra imprese.

Aumentare i cicli/ritmi di misurazione, monitoraggio e analisi dei fatti aziendali per innescare veloci attività di “trial and error”, veloci cicli di “Analyze, Plan, Act and Control”, piuttosto che profondi e lenti processi di decisione analitica.

Essere coscienti che il sogno della “real time enterprise” deve avvenire attraverso azioni

innovative, fattibili, veloci, economicamente convenienti (nel marketing, nel business

development, nella finanza, etc.), altrimenti resta un potenziale inespresso e fine a se

stesso.

Questa grande complessità e questa grande

quantità dei dati possono

essere gestite solo attraverso soluzioni tecnolo-

14 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

giche nuove.

È stata sviluppata e adattata un'ampia varietà

di tecniche e tecnologie per aggregare, manipolare, analizzare e visualizzare i Big Data.

L'insieme di tecniche e tecnologie attingono da

settori diversi, quali la statistica, l’informatica,

la matematica applicata e l'economia: questo

significa che un'azienda, la quale intende trarre

valore dai Big Data, dovrebbe adottare un

approccio flessibile e multidisciplinare.

Francesco Romeo | 15

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.3 CONTESTI DI UTILIZZO DEI BIG DATA

I Big Data si configurano come un'importante risorsa per l'innovazione, la competizione e la

produttività tra le aziende e vengono considerati come dati che potrebbero generare un grande

valore al pari addirittura del petrolio, come già affermava nel 2006 il ricercatore di mercato

Clive Humby.

Allo stato attuale i dati digitali sono ovunque, in ogni settore, in ogni economia e in ogni organizzazione; l'abilità di generare, comunicare, condividere e accedere ai dati è stata rivoluzionata ulteriormente dall'aumento del numero di persone che fanno uso di dispositivi mobili e dai

sensori che sono connessi con le reti digitali.

Si pensi che più di 30 milioni di nodi sensori

collegati in rete sono presenti nel settore

dei trasporti, dell'automotive, dei servizi e

nel retail e che questi stanno crescendo

sempre di più a un tasso superiore al 30%

annuo. La qualità dei dati trasversali alle reti

continuerà ad aumentare vertiginosamente:

infatti, si pensa che entro il 2020 saranno

connessi alla rete e a Internet 50 miliardi di

dispositivi. Dunque anche la rete gioca un

ruolo chiave ai fini dello sviluppo del potenziale dei Big Data. Innanzitutto, essa può raccogliere dati a velocità elevata; i dati raccolti consentono alla rete di determinare il contesto, ad esempio abbinando ai dati le informazioni sull'identità o sulla presenza. Inoltre, la rete consente alle imprese di intervenire immediatamente

sulle informazioni ricavate dai dati.

Secondo un sondaggio di Gartner, il 64% delle organizzazioni globali sta investendo, o ha intenzione di investire, in tecnologie per i Big Data contro il 54% che già lo faceva o pensava di

farlo nel 2012. È anche vero che solo l'8% delle imprese ha implementato tali tecnologie. I settori che guidano gli investimenti in Big Data sono quelli dei media e delle comunicazioni, le

banche e i servizi, ma nel giro dei prossimi due anni si aggiungeranno molte altre aziende,

come quelle nel settore dei trasporti, nella sanità e nel benessere.

Ci sono notevoli esempi di aziende in tutto il mondo che sono bene conosciute per il vasto ed

efficace utilizzo dei dati. Di seguito menzioniamo brevemente le best practices delle aziende

mondiali che hanno sfruttato il valore dei Big Data:

Il programma di fidelizzazione di Tesco genera un ammontare di dati sui clienti, da cui

16 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

l'azienda estrae informazioni, per costruire campagne promozionali sino ad arrivare alle

strategie di segmentazione della clientela.

Harrah's ha aumentato il ricavo dell'8 - 10% analizzando i dati sulla segmentazione dei

clienti.

Amazon utilizza i dati sui consumatori per gestire il suo motore di raccomandazioni che

conosciamo con l'espressione “you may also like. . .”; questo è basato su un tipo di tecnica di modellazione predittiva chiamata “collaborative filter”. Inoltre, Amazon ha dichiarato che il 30% dei propri ricavi era riconducibile al suo motore analitico per i consigli ai consumatori.

Fedex, la società di trasporto espresso più grande al mondo, ha ottenuto in tempo reale

i dati su spedizioni e consumatori provenienti da più di 46000 centri di distribuzione e

supply chain.

WalMart, il gigante americano della grande distribuzione, ha implementato la tecnologia RFID (Radio Frequency Identication) per scambiare informazioni in tempo reale tra i

fornitori e il Data Warehouse Retail Link. In questo modo ha ottenuto la riduzione del

16% della frequenza di esaurimento delle scorte. Quest' ultima azienda merita delle

considerazioni in quanto ha agevolato la strada alle altre aziende garantendone la competitività nel settore del retail. Walmart ha facilitato l'espansione di un sistema di scambio elettronico di dati per collegare la propria catena di fornitura elettronica. Inoltre, ha

sviluppato un Retail Link, ovvero uno strumento che offre ai suoi fornitori una visione

della domanda nei suoi negozi in modo da prevedere quando questi ultimi debbano

essere riforniti senza attendere

l'ordine da Walmart. L'uso diffuso

dei dati dei clienti sempre più granulari può consentire ai retailer di migliorare l'efficacia del loro marketing

e del loro merchandising.

Le applicazioni possono essere suddivise in due grandi settori: applicazioni analitiche e applicazioni relative a determinati settori. Questi verranno esaminati in dettaglio nelle prossime

sottosezioni.

Francesco Romeo | 17

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.3.1 APPLICAZIONI ANALITICHE

Le applicazioni analitiche si possono suddividere come di seguito specificato:

Applicazioni basate su attribuzioni. Queste devono recuperare e analizzare le serie di attività, prendendo in considerazione fattori quali la frequenza, la sequenza, l’attualità, le

soglie e la perdita di efficacia nel tempo trascorso; l’obiettivo finale è quello di accreditare

un valore a ciascuna attività. Ecco alcuni esempi basati su attribuzioni:

applicazioni per l’ efficacia del marketing multicanale, grazie alle quali gli

esperti del settore tentano di attribuire credito per una vendita su canali di

marketing;

applicazioni di attribuzione relative ai partner, grazie alle quali le società commerciali tentano di quantificare il contributo dei vari partner;

applicazioni di attribuzione relative al trattamento medico, grazie alle quali le

organizzazioni di assistenza sanitarie tentano di valutare l’incidenza di varie

cure e medicinali sull’esito della terapia.

Applicazioni basate su suggerimenti. Le applicazioni basate su suggerimenti individuano e

generano serie di utenti e prodotti simili in base a comportamenti, dati demografici o altri

attributi percepibili. A partire dalle tendenze rilevate, le applicazioni riescono a fornire

suggerimenti su prodotti (come nel caso Amazon e Netfix) o persone (come accade con

Linkedln e Facebook). Ecco alcuni esempi di applicazioni basate su suggerimenti:

applicazioni per l’individuazione di pubblicità mirate ai clienti, che

suggeriscono segmenti di audience di riferimento “simili” in base a comportamenti e prodotti acquistati in passato;

applicazioni che consigliano prodotti complementari sulla base degli

acquistati effettuati da utenti simili in un determinato periodo di tempo .

Applicazioni basate su predizioni e previsione. Le applicazioni basate su predizioni e previsione acquisiscono un’ampia gamma di variabili a supporto dei processi decisionali in

svariati scenari di mercato. Esse utilizzano al meglio le tecniche statistiche e di data mining per estrarre dalla moltitudine di variabili solo quelle più efficaci per prevedere le

prestazioni in particolari situazioni. Le applicazioni predittive avanzate integrano valutazioni su rischi e dati sensibili affinché i responsabili delle decisioni possano determinare le

variabili più importanti nel processo decisionale. Ad esempio, se si ritiene che una certa

18 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

variabile sia cruciale per una decisione, è possibile investire maggiori risorse per assicurarsi che

essa venga valutata in modo preciso e completo . Ecco alcuni esempi di applicazioni basate su

predizione e/o previsione :

applicazioni per il calcolo del tasso di

abbandono dei clienti che prevedono

la possibilità di contrasti con questi

ultimi in base a fattori come attività di utilizzo, richieste di supporto e influenza sociale degli amici;

applicazioni per la manutenzione dei prodotti, che prevedono guasti delle

apparecchiature in base a informazioni sull’utilizzo dei prodotti (in particolare, informazioni attualmente fornite dai dispositivi dati integrati), registrazione degli interventi di manutenzione e informazioni generali sulle prestazioni;

applicazioni relative alle prestazioni dei dipendenti, che prevedono le prestazioni di un potenziale collaboratore in base a fattori quali formazione, posizione socio-economica, ruoli professionali precedenti, stato civile e determinate risposte psico-comportamentali;

applicazioni relative alle prestazioni degli studi clinici, che modellano i risultati di vari medicinali in base alla sperimentazione clinica, consentendo ad

un’azienda di comprendere l’efficacia di determinate terapie ed evitare conseguenze catastrofiche in caso di utilizzo di particolari farmaci; ciò assume

un’importanza ancora maggiore quando si tenta di attribuire i risultati per

più trattamenti e medicinali;

applicazioni per la gestione del rendimento, del ribasso dei prezzi e del merchandising e per l’ottimizzazione dei prezzi, in grado di creare modelli utilizzati dai responsabili delle decisioni per comprendere come e quando aumentare o ridurre i prezzi tenendo conto delle condizioni attuali della domanda e dell’offerta; questi tipi di applicazioni sono particolarmente comuni

nel caso dei prodotti di base (quali merci deperibili, biglietti aerei, camere di

alberghi, capi di abbigliamento e biglietto per eventi sportivi), il cui valore si

azzera in un determinato momento.

Applicazioni basate su approfondimenti. Le applicazioni basate su approfondimenti

Francesco Romeo | 19

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

fanno leva su tecniche statistiche e di data mining per identificare situazioni o comportamenti ”insoliti”. La crescente importanza di queste applicazioni è legata al volume in

continuo aumento dei dati dettagliati provenienti da fonti quali clic nelle pagine web e

sensori RFID. Ecco alcuni esempi di applicazioni basate su approfondimenti:

applicazioni relative alla riduzione e alla distribuzione dei prodotti, che monitorano costantemente sensori e dati RFID per individuare differenze tra la

posizione del prodotto ipotetica e quella reale;

applicazioni contro le frodi, che monitorano costantemente le transazioni

finanziarie per individuare comportamenti “insoliti” che possono essere indice

di attività fraudolente;

applicazioni antiriciclaggio, che monitorano costantemente il flusso di contante per individuare comportamenti “insoliti” associati a potenziali attività di

riciclaggio, ad esempio un numero eccessivo di transazioni di scarso valore

realizzate in contanti.

Applicazioni basate su benchmark. Le applicazioni basate su benchmark utilizzano al meglio

l’analitica che confronta le prestazioni di un’entità rispetto a uno standard di settore, un periodo o un evento precedente. Ecco alcuni esempi

di applicazioni basate su benchmark:

applicazioni relative alle quote di

mercato, che forniscono dati su quote di mercato e portafoglio; ad esempio, le aziende che creano siti web

possono fornire dati e analisi sugli

investimenti pubblicitari per consentire a inserzionisti e agenzie di confrontare

le spese sostenute nel campo del marketing con quelle della concorrenza;

applicazioni basate su benchmark competitivo, che mettono a confronto le

prestazioni di un’azienda con un’ aggregato di concorrenti o con la media del

settore;

applicazioni basate su benchmark, che confrontano le prestazioni di una campagna di marketing in corso con quelle di una campagna o di un evento di

marketing precedente e/o simile.

20 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.3.2 OPEN BIG DATA

“Chi riceve un'idea da me, ricava conoscenza senza diminuire la mia; come chi accende la

sua candela con la mia ha luce senza lasciarmi al buio” Cit. Thomas Jefferson in una lettera a

Isaac Mac Pherson nel 1813.

In realtà, i dati non sono solo big ma possono essere anche open. Gli Open Big Data, cioè la

liberazione dei dati delle amministrazioni, rispettano il

principio, secondo il quale i dati prodotti dalle istituzioni

pubbliche appartengono alla collettività e, pertanto, devono essere resi disponibili, fruibili e riutilizzabili. Alcuni

esempi di dati pubblici la cui fruibilità migliorerebbe sensibilmente la vita della comunità sono citati nel rapporto

Open Data, Open Society. Da esso deriviamo alcuni ambiti di applicazione:

La Geografia: la geografia dei luoghi porta in mente suggestioni di vastità, ricchezza e

diversità. Le istituzioni locali avrebbero l'opportunità di pianificare in modo più efficiente le proprie politiche di sviluppo territoriale e urbanistico se, oltre a disporre dei dati

che i singoli organi e enti già possiedono, li condividessero fornendo un quadro più esaustivo del

territorio, incrociandoli con mappe e visualizzazioni che rilevino aree protette o di interesse artisticoculturale, risorse idriche o forestali, etc. Inoltre, il

singolo cittadino potrebbe trarre beneficio dal

sapere, per esempio, che la casa che vorrebbe

comprare sorge in un'area a rischio idrogeologico.

I Trasporti: la conoscenza della disponibilità dei

dati sul traffico (la viabilità, il numero stimato di vetture, i lavori in corso, la mobilità

etc.) potrebbe recare un miglioramento al traffico urbano e alla progettazione dei trasporti pubblici. Si potrebbe pensare di far dialogare in real time i sistemi di rilevazione

installati ai semafori, il sistema GPS sulle vetture piuttosto che su un cellulare, con i

database dei vigili urbani, della polizia stradale rendendo i semafori intelligenti, consentendo di facilitare la viabilità al cittadino e favorendo l'azione tempestiva delle forze

dell'ordine e del pronto intervento. Allo stesso tempo si potrebbe incentivare il trasporto pubblico fornendo informazioni accurate e costantemente aggiornate, oppure si

potrebbero analizzare meglio le fasce orarie in cui è maggiore la domanda del servizio

del trasporto pubblico; altre ipotesi e scenari potrebbero emergere dalla condivisione

dei dati e dalla comunicazione intelligente tra le istituzioni.

Francesco Romeo | 21

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

La Demografia: i dati sulla composizione demografica di una precisa area (la scolarizzazione, la popolazione, l'età, il sesso, il tasso di natalità e di mortalità, etc.) si configurano

come una risorsa di una certa importanza e rappresentano il centro propulsore di qualsiasi

iniziativa di carattere sociale, ma anche politico. Per

esempio, basti pensare quali vantaggi potremmo

avere se incrociassimo solo pochi dei tanti indicatori

demografici di cui siamo in possesso. Una qualsiasi

impresa potrebbe stabilire con maggiore precisione

l'opportunità di avviare o meno una determinata attività; un'area con un alto tasso di natalità, la cui popolazione è giovane e in salute, è un luogo maggiormente

indicato per la costruzione di una struttura polisportiva con piscine attrezzate anche per il

parto in acqua o parchi giochi, piuttosto che di un servizio di riabilitazione per anziani.

La Sanità: la salute di un Paese è influenzata anche dallo stato della sanità pubblica e

privata. La fruibilità di dati in questo settore permetterebbe di individuare gli sprechi e di

ottimizzare le spese e le politiche di gestione del sistema sanitario.

La Sicurezza: la vita delle persone spesso dipende anche dalla sicurezza dell'area urbana in

cui vivono. Si tratta di un ambito particolarmente sensibile.

L'Energia: è importante conoscere i dati ufficiali sul consumo e sulla produzione energetica (così come quelli sull'inquinamento atmosferico, sul diffondersi di malattie, etc.) perché ciò recherebbe un notevole vantaggio per i cittadini e permetterebbe di ridurre gli

sprechi.

Quasi per ciascuno degli ambiti di applicazione precedentemente analizzati esiste nel mondo

un'iniziativa di Open Data. Si tratta di un patrimonio pubblico, un bacino di dati e applicazioni

che si accresce ogni giorno grazie alla volontà delle istituzioni e dei governi, ma anche per merito del contributo dei singoli cittadini. Nell'ambito istituzionale la prima iniziativa in materia di

Open Data nasce negli Stati Uniti e si chiama data.gov. Questo progetto ha l'obiettivo di accrescere l'accesso pubblico alle banche dati aperte e ad alto valore aggiunto prodotte dal ramo

esecutivo del governo federale degli Stati Uniti. Inoltre, data.gov mira a portare il governo a

livello di trasparenza senza precedenti nella convinzione che la chiarezza e l'apertura derivanti

da una simile iniziativa rafforzino la democrazia e favoriscano l'efficienza del governo. data.gov

è un progetto che vuole crescere e basa le sue prospettive di crescita sulla partecipazione e

collaborazione del pubblico, sui suoi feedback o sui suggerimenti relativamente ai settori per i

quali vorrebbe che il governo pubblicasse e rendesse accessibili i suoi dati.

22 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

1.3.3 BIG DATA NELLA STATISTICA UFFICIALE

I vantaggi apportati dai Big Data agli istituiti di statistica ufficiale sono:

produzione di nuove variabili, ad esempio (le online sales) non misurate finora;

fornitura dati in tempo reale;

possibilità di costruire informazioni che aiutano a capire i fenomeni (social data mining),

a correggere e validare le informazioni e ad aumentare l'efficienza campionaria;

aggiunta di nuova conoscenza attraverso alcuni pattern/cluster (modelli che permettono di raccontare storie e migliorare l'efficienza di certi percorsi);

produzione di variabili ausiliarie per stimare meglio e predire certi fenomeni

(nowcasting).

Alcuni esempi possono essere l'indice di disoccupazione inferito dai profili di attività ottenuti per data

mining dei record di telefonia mobile, oppure il

calcolo o il monitoraggio di nuovi indicatori di benessere/performance sociale a partire da fonti di

Big Data non standard (come social network, telefonia e navigazione satellitare, social media) e dagli

acquisti della grande distribuzione (tramite carte di

fedeltà). I Big Data, tuttavia, sono suscettibili di

problemi di qualità a vari livelli, soprattutto in termini di correttezza, aggiornamento e completezza,

affidabilità o reputazione della sorgente. Essi, inoltre, possono presentare problemi legati ai metadati. Un fattore importante in questo contesto è rappresentato dalla convalida dell'affidabilità dei dati. Per esempio, si parla di “fail profile”, un profilo falso raccontato dai social network: questo è un elemento su cui fare attenzione per quanto riguarda la qualità del dato di provenienza e il risultato che si ottiene a valle. I

Big Data possono configurarsi come un'opportunità per risolvere i problemi legati alla qualità

del dato ovvero:

possono risolvere problemi di dati mancanti attingendo all'elevato numero di fonti;

possono risolvere problemi di inconsistenza sfruttando la ridondanza delle fonti.

Francesco Romeo | 23

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

2. IL PROCESSO DI ANALISI DEI BIG DATA

In questo capitolo verrà descritto il processo di analisi dei Big Data. Si mostrerà una panoramica generale del processo di estrazione di conoscenza dai database (KDD) dando maggiore rilievo alla fase di Data Mining. In seguito verrà presentata la nuova figura

professionale del data scientist; il capitolo si concluderà affrontando il tema della Privacy

by Design.

1

Il Processo KDD

2

Data Mining

3

La nuova figura del

Data Scientist

1

4

Privacy by Design nei

Big Data

Francesco Romeo | 25

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

2.1 IL PROCESSO KDD

Tutte le grandi organizzazioni, durante lo svolgimento delle proprie

attività, accumulano una gran quantità di dati. Questi grazie al progredire delle tecniche di cattura e immagazzinamento di informazioni, contengono delle risorse, delle informazioni sfruttabili, evidenti o nascoste, con differenti gradi di utilità.

Inizialmente l'analisi dei dati era un processo “manuale” e l’analista doveva avere familiarità sia

con i dati sia con i metodi della statistica: egli stesso agiva come un sofisticato processore di

query, mentre l’ elaboratore elettronico era solo un sostegno per il calcolo. Di fronte alla crescita dimensionale degli archivi di dati ed alla sempre più crescente necessità di elaborarne i contenuti, questo tipo di analisi è risultata lenta, costosa e altamente soggettiva. Di conseguenza,

si è costituita ed è cresciuta costantemente una comunità di ricercatori e professionisti interessati al problema dell’analisi automatica di grandi quantità di dati, nota come "Knowledge Discovery in Databases (KDD)”.

Gli archivi digitali sono presenti dovunque: banche,

industrie, supermercati, attività commerciali etc., e

molti processi generano flussi di record che vengono

memorizzati in enormi database, talvolta detti Data

Warehouse (magazzini di dati). Più propriamente, un

Data Warehouse è un database costruito per agevolare l’accesso alle informazioni; tipicamente è alimentato da uno o più database di transazioni e i dati devono

essere ripuliti e strutturati per facilitare le query, i

sommari e le analisi. Da ciò segue che il problema dell'estrazione di conoscenza da database

enormi andrà risolto tramite un processo di elaborazione più complesso, formato da molti

passi, che possono andare dalla semplice manipolazione dei dati a sofisticate tecniche di inferenza statistica, di ricerca e di Artificial Intelligence. La tecnologia più recente per affrontare tali

26 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

problematiche è il Data Mining. Il Data Mining sfrutta raffinate analisi statistiche e tecniche di

modellazione per scoprire pattern e relazioni nascoste nei database, che i metodi ordinari

spesso non individuano. I dati comprendono un insieme di fatti, e il pattern è un’espressione,

in qualche linguaggio, che descrive un sottoinsieme di dati (o un modello applicabile a questo

sottoinsieme), le associazioni tra essi, le sequenze ripetute o le regolarità nascoste. In definitiva, un pattern indica una struttura o, in generale, una rappresentazione sintetica dei dati.

Con il termine “Knowlegde Discovery in Databases”, si indica l’intero processo di scoperta di

conoscenza dai dati dei database. Il processo KDD prevede come input i dati grezzi e fornisce

come output le informazioni utili ottenute. Le fasi del KDD sono le seguenti:

Selezione: i dati grezzi vengono segmentati e selezionati secondo alcuni criteri al fine di

pervenire ad un sottoinsieme di dati che rappresentano il nostro target data o dati

obiettivo. Risulta abbastanza chiaro come un database possa contenere diverse informazioni che, per il problema in esame, possono risultare inutili; per fare un esempio, se

l’obiettivo è lo studio delle associazioni tra i prodotti di una catena di supermercati, non

ha senso conservare i dati relativi alla professione dei clienti; è, invece, assolutamente

errato non considerare tale variabile, che potrebbe invece fornire utili informazioni

relative al comportamento di determinate fasce di clienti, nel caso in cui si voglia effettuare un’analisi discriminante.

Francesco Romeo | 27

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Preelaborazione: spesso, pur avendo a disposizione il target data, non è conveniente nè,

d’altra parte, necessario analizzarne l’intero contenuto; può essere più adeguato dapprima campionare le tabelle e, in seguito, esplorare tale campione effettuando, in tal modo,

un’analisi su base campionaria. Fanno, inoltre, parte di questo stadio del KDD la fase di

pulizia dei dati (data cleaning), che prevede l’eliminazione dei possibili errori, e la decisione dei meccanismi di comportamento in caso di dati mancanti.

Trasformazioni: effettuata la fase precedente, i dati, per essere utilizzabili, devono essere

trasformati. Si possono convertire tipi di dati in altri o definire nuovi dati ottenuti attraverso l’uso di operazioni matematiche e logiche sulle variabili. Inoltre, soprattutto quando

i dati provengono da fonti diverse, è necessario effettuare una loro riconfigurazione al fine

di garantirne la consistenza.

Data Mining: ai dati trasformati vengono applicate una serie di tecniche in modo da poterne ricavare informazione non banale o scontata, bensì interessante e utile. I tipi di dati

che si hanno a disposizione e gli obiettivi che si vogliono raggiungere possono fornire

un’indicazione circa il tipo di metodo/algoritmo da scegliere per la ricerca di informazioni

dai dati. Un fatto è certo: l’intero processo di KDD è un processo interattivo tra l’utente, il

software utilizzato e gli obiettivi, che devono essere costantemente inquadrati, ed iterativo nel senso che la fase di Data Mining può prevedere un’ulteriore trasformazione dei dati

originali o un’ulteriore pulizia dei dati, ritornando, di fatto, alle fasi precedenti.

Interpretazioni e Valutazioni: il Data Mining crea dei pattern, ovvero dei modelli, che possono costituire un valido supporto alle decisioni. Non basta, però, interpretare i risultati

attraverso dei grafici che visualizzano l’output del Data Mining, ma occorre valutare

questi modelli per capire in che misura questi possono essere utili. E’, dunque, possibile,

alla luce di risultati non perfettamente soddisfacenti, rivedere una o più fasi dell’intero

processo KDD.

28 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

2.2 DATA MINING

La maggior parte delle aziende utilizza strumenti OLAP (On Line Analytic Processing) per

eseguire interrogazioni specifiche sui database aziendali. Il Data Mining consente, agli utenti

che sfruttano gli strumenti OLAP, di andare oltre i report

riassuntivi. Il Data Mining dice perché si sta verificando un

certo fenomeno, mentre l'OLAP si limita a dire cosa sta

accadendo (si limita a descrivere il fenomeno stesso).

Il Data Mining è un processo atto a scoprire correlazioni, relazioni e tendenze nuove e significative, setacciando grandi quantità di dati immagazzinati nei repository, usando tecniche di

riconoscimento delle relazioni e tecniche statistiche e matematiche.

Occorre tenere presente la grande differenza esistente tra statistica e Data Mining: per le

analisi statistiche la fase della trasformazione dei dati è critica poiché alcune metodologie

statistiche richiedono che i dati siano linearmente collegati ad una variabile obiettivo, normalmente distribuiti e liberi dagli outlier. I metodi dell'intelligenza artificiale e del machine

learning, invece, non richiedono rigorosamente che i dati siano normalmente distribuiti o

lineari e alcuni metodi non richiedono neppure che gli outlier siano trattati preventivamente.

Gli algoritmi del machine learning hanno la capacità di trattare automaticamente distribuzioni non lineari e non normali, anche se, in molti casi, gli algoritmi lavorano meglio se questi

criteri sono verificati.

Tuttavia, si può effettuare Data Warehousing

anche senza l’applicazione di tecniche di Data

Mining. A questo proposito l’uso di tali tecniche

si sta diffondendo sempre di più, in quanto abbiamo:

un miglior accesso ai dati, oltre che molti

più dati a cui accedere;

un grande incremento delle capacità di

elaborazione;

una migliore educazione statistica;

grandi cambiamenti nei software, ora più facili e intuitivi da utilizzare.

Francesco Romeo | 29

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Il Data Mining trova delle relazioni nei dati, ma non prende decisioni; esso fornisce ai

decision-maker le informazioni necessarie a fronteggiare le difficoltà dei mercati competitivi. I

fattori critici di successo in un progetto di Data Mining sono la conoscenza del business e l’esperienza maturata nel tempo. Questi fattori si combinano alle migliori informazioni ottenute

con il Data Mining creando un processo sinergico che porta a decisioni brillanti e veloci. Il miglior software di Data Mining gestisce autonomamente i dettagli tecnici in modo tale che gli

utenti possano concentrarsi sulle decisioni .

CRISP è l’acronimo di Cross Industry Standard Process for Data Mining. E' un approccio standard alle analisi di Data Mining che fornisce una struttura per tale processo indipendente dalla

tipologia di business nonché una guida ai potenziali problemi aziendali e alle loro soluzioni. Ciò

avviene perché lo scopo del modello è quello di rendere l'implementazione di grandi progetti di

Data Mining sempre più veloce, più

efficiente, più sicura e meno costosa.

Una delle peculiarità del modello

CRISP-DM è quella di non aver l’obbligo di seguire sistematicamente

tutte le fasi e sottofasi che esso

propone; infatti, gli analisti possono decidere di osservare un insieme di dati, che presentano

tendenze relative o circostanze eccezionali, nell’arco di settimane, mesi e anni, seguendo due

politiche di analisi alternative, ovvero le tecniche di Data Mining oppure la completa comprensione dei dati.

Il modello si snoda in sei fasi comprendenti sotto-fasi e aspetti elencati di seguito:

Business Understanding: letteralmente tradotto “Comprensione del Business”, prevede la determinazione

degli obiettivi di Business, attraverso

Background, Obiettivi di business e

Criteri di successo del business, per

poi passare alla valutazione della

situazione con inventario delle risorse, requisiti, assunzioni e vincoli,

rischi e contingenze, terminologia,

30 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

costi e benefici. Si prosegue con la determinazione degli obiettivi di Data Mining, con

obiettivi di Data Mining e criteri di successo del Data Mining. Infine troviamo la produzione del piano di progetto con piano di

progetto, valutazione iniziale di strumenti

e tecniche.

Data Understanding: letteralmente tradotto “Comprensione dei Dati”, prevede

la raccolta dei dati iniziali, la loro descrizione, la loro esplorazione e la verifica

della loro qualità, tutti opportunamente

inseriti in report appositi.

Data Preprocessing: letteralmente tradotto “Preparazione dei Dati”, prevede la descrizione della base di dati, la selezione dei dati con annessi i criteri per inclusione ed esclusione, la pulizia dei dati con report, la costruzione dei dati con attributi derivati e record

generati, l’integrazione dei dati e, infine, impostazione dati.

Modeling: letteralmente tradotto “Modellazione”, prevede la scelta della tecnica di

modellizzazione, la generazione del progetto di test e, infine, il progetto di test, la costruzione del modello, con l’impostazione dei parametri, e la descrizione del modello

stesso, la valutazione del modello, con una possibile reimpostazione dei parametri.

Evaluation: letteralmente

tradotto “Valutazione”; in

questa sotto fase si valutano i

risultati di Data Mining in

relazione ai criteri di successo

del business e ai modelli approvati, si revisiona il processo

e si determinano i passi successivi elencando le possibili

azioni e decisioni.

Deployment: letteralmente

tradotto “Utilizzo”, prevede la

Francesco Romeo | 31

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

formazione del piano di utilizzo, del

piano di monitoraggio e mantenimento, della produzione del report finale e

la presentazione finale, nonché la

recensione del progetto, con la presentazione della documentazione

dell’esperienza.

32 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

2.3 LA NUOVA FIGURA DEL DATA SCIENTIST

Quella del data scientist è stata definita dall'economista Hal Ronald Varian «la professione

più sexy del futuro», laddove l'aggettivo “sexy” assume l'accezione di «interessante».

La continua crescita dei dati in formato digitale, disponibili nelle moderne organizzazioni, ha

fatto emergere il ruolo strategico di una nuova figura professionale che deve avere più competenze. La prima è sapere gestire, acquisire, organizzare ed elaborare dati. La seconda è di

tipo statistico, ovvero il sapere come e quali dati estrarre. La terza è il sapere comunicare a

tutti, con diverse forme di rappresentazione, cosa suggeriscono i dati.

La caratteristica principale di questa figura deve essere la “curiosità”, cioè l’attitudine, tipica

di chi utilizza il metodo scientifico, di analizzare in profondità i fenomeni, non fermandosi alla

apparenza, e di identificare un insieme di ipotesi da verificare ed esplorare con l’analisi e lo

studio dei dati. Da questo punto di vista si può paragonare il lavoro del data scientist a quello del fisico sperimentale che, spesso, deve progettare gli strumenti,

condurre gli esperimenti, analizzare i dati ottenuti e

presentare i risultati a tutta la comunità scientifica,

oltre che ai responsabili delle ricerche.

Il data scientist deve avere tre set di skill, ovvero una

preparazione informatica molto solida, una buona

comprensione degli aspetti tecnologici e, allo stesso

tempo, una conoscenza degli aspetti aziendali. Inoltre, ma non di poco conto, il data scientist

deve possedere la conoscenza delle problematiche e delle sfide del dominio settoriale

(industria, finanza, telecomunicazioni, settore pubblico, etc.) di interesse.

Ci sono decine tra atenei e centri studio che offrono formazione specifica. I poli mondiali sono

USA e UK, dove nei primi anni del Duemila si erano già create metodologie e procedure. Alle

nostre latitudini le aziende cominciano a concepire la necessità di una simile figura e cercano

di formarla al proprio interno. Il data scientist lavora con i big data ed è in questa direzione

che bisogna muoversi; le anagrafiche sono il primo patrimonio di un'azienda; questo concetto non è ancora del tutto consolidato in Italia, e questo, da solo, spiega già gran parte

dell'handicap che abbiamo in materia di scienza dei dati.

Francesco Romeo | 33

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

2.4 PRIVACY BY DESIGN NEI BIG DATA

La quantità dei dati digitali, come abbiamo visto, cresce a ritmi esponenziali. La gestione dei

Big Data pone alcune riflessioni da fare per garantire il rispetto della riservatezza e la protezione dei dati personali.

Archivi informatizzati contenenti dati personali sono posseduti dalle Pubbliche Amministrazioni, dalle aziende private, dai media, dai professionisti, dalle associazioni e dalle organizzazioni

di vario tipo.

La Dr. Ann Cavoukian (Information & Privacy Commissioner Ontario, Canada) presenta così il

tema della Privacy by Design:

“La Privacy by Design è un

concetto che ho sviluppato

negli anni ‘90 per far fronte

agli effetti sempre crescenti e

sistematici delle Tecnologie

dell’Informazione e della Comunicazione e dei sistemi di

dati delle reti su larga scala.

La Privacy by Design anticipa

la visione che il futuro della

privacy non può essere assicurato unicamente dal processo

di conformità con il sistema

normativo; piuttosto, la garanzia della privacy deve costituire idealmente un modo di operare

di default di un’organizzazione. Inizialmente, l’attuazione delle tecnologie per rafforzare la

privacy (Privacy-Enhancing Technologies - PETs) era vista come la soluzione. Oggi, realizziamo che è richiesto un approccio più sostanziale – che estende l’uso delle PET alle PETS Plus –

con un approccio di valore aggiunto (di massima funzionalità), e non di valore zero. Questo è

il Plus nelle PET Plus: valore aggiunto, non se/o di valore zero (una falsa dicotomia).”

La Privacy by Design, quindi, propone qualcosa veramente interessante ed innovativo: il processo di conformità relativo alla

sicurezza della privacy non può essere assicurato unicamente

tramite il sistema normativo; piuttosto, la garanzia della privacy

34 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

deve costituire idealmente il modo di operare di default di un’organizzazione. Privacy by

Design si riferisce alla filosofia e all'approccio di considerare la privacy nelle specifiche di

progettazione delle varie tecnologie.

La Privacy by Design trova spazio nella trilogia di applicazioni:

Tecnologia dell’informazione;

Pratiche commerciali responsabili;

Progettazione strutturale e infrastrutture di rete.

In particolare, con riferimento alla tecnologia dell’informazione, si afferma, come già evidenziato, che la tecnologia non può costituire una minaccia per la privacy, ma un ausilio per la

riduzione dei rischi. Per le pratiche commerciali responsabili, viene evidenziato come la privacy non va interpretata come un onere, ovvero un costo che appesantisce l'attività imprenditoriale, ma, al contrario, come un vantaggio per una migliore competitività. Infine, l’elemento

della progettazione delle strutture assume rilevanza poiché molto spesso siamo costretti a

vedere esposti i dati personali in aree pubbliche mal progettate come, ad esempio, le sale

d’attesa degli ospedali o degli uffici, ove è possibile che vengano, illecitamente, divulgate le

informazioni personali.

Fermo il contesto rappresentato dai tre punti precedenti, la

Privacy by Design si fonda su

sette principi:

Proattivo non reattivo (prevenire non correggere): l’approccio alla Privacy by Design

(PbD) è caratterizzato da interventi di tipo proattivo piuttosto che reattivo. Esso anticipa e previene gli eventi invasivi della privacy prima che essi accadano. La PbD non attende che i rischi della privacy si concretizzano né offre rimedi per risolvere le violazioni

della privacy una volta occorse: essa ha lo scopo di prevenirli prima che questi si verifichino. In breve, la Privacy by Design viene prima del fatto e non dopo.

Privacy come impostazione di default: possiamo tutti essere certi di una cosa - la regola

di base! La Privacy by Design cerca di realizzare il massimo livello di privacy assicurando

che i dati personali siano automaticamente protetti in un qualunque sistema IT o di

pratica commerciale. Se un individuo non fa nulla, la sua privacy rimane ancora intatta.

Francesco Romeo | 35

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Non è richiesta alcuna azione da parte dell’individuo per proteggere la propria privacy:

essa è incorporata nel sistema per default.

Privacy incorporata nella progettazione: la PbD è incorporata nella progettazione e nell’architettura dei sistemi IT e delle pratiche commerciali. Non è agganciata come un’aggiunta, dopo il fatto. Il risultato è che la privacy diventa un componente essenziale per la realizzazione del nucleo funzionale. La privacy è integrata nel sistema, senza diminuirne la

funzionalità.

Massima funzionalità − Valore positivo, non valore zero: la Privacy by Design mira a conciliare tutti gli interessi legittimi e gli obiettivi con modalità di valore positivo

“vantaggioso per tutti”, non attraverso un approccio datato di valore zero, dove sono

inutili i compromessi. La Privacy by Design evita la pretesa di false dicotomie, come la

privacy contro la sicurezza, dimostrando che è possibile avere entrambi.

Sicurezza fino alla fine − Piena protezione del ciclo vitale: la Privacy by Design, essendo

stata incorporata nel sistema prioritariamente rispetto all’acquisizione del primo elemento di informazione, si estende in modo sicuro attraverso l’intero ciclo vitale dei dati - solidi

interventi di sicurezza sono essenziali per la privacy, dall’inizio alla fine. Questo assicura

che tutti i dati siano conservati con cura, e poi distrutti in modo sicuro alla fine del processo, in maniera opportuna. Pertanto, la Privacy by Design garantisce un’intera e sicura

gestione delle informazioni, fino alla fine.

Visibilità e trasparenza − Mantenere la trasparenza: la Privacy by Design cerca di assicurare

che tutti i soggetti interessati, qualunque sia la prassi aziendale o tecnologia utilizzata, è,

di fatto, operativa secondo promesse ed obiettivi stabiliti, soggetti a verifica indipendente. I suoi componenti e le sue operazioni restano visibili e trasparenti sia agli utenti sia ai

fornitori. Si ricorda di fidarsi ma di verificare.

Rispetto per la privacy dell’utente − Centralità dell’utente: al di là di tutto, la Privacy by

Design richiede ai progettisti e agli operatori di considerare prioritari gli interessi degli

individui offrendo efficaci interventi di default della privacy e informazioni appropriate,

nonché potenziando opzioni di facile utilizzo per l’utente. Si raccomanda la centralità

dell’utente.

Come si può notare, si tratta di una vera e propria rivoluzione della privacy che non concerne

36 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

soltanto le misure tecniche per assicurare adeguata sicurezza ai dati personali, ma una serie

di concetti innovativi che prescindono dall’assolutizzare la protezione dei dati personali per

giungere alla considerazione che la sicurezza delle informazioni è insita nel concetto stesso di

privacy.

La 32 ma Conferenza Internazionale dei Garanti della Privacy (Gerusalemme, 27-29 Ottobre

2010) ha definito il concetto di Privacy by Design proposta dalla Dr. Ann Cavoukian come una

pietra miliare.

L’articolo 23 della proposta di regolamento del Parlamento Europeo e del Consiglio, concernente la tutela delle persone fisiche con riguardo al trattamento dei dati personali e alla libera

circolazione di tali dati (Gennaio 2012), prende spunto da quanto sostenuto dalla Dr. Ann

Cavoukian.

Nello specifico :

“Al momento di determinare i mezzi del trattamento e all’atto del trattamento stesso, il

titolare mette in atto adeguate misure e procedure tecniche e organizzative tali da assicurare la conformità al presente regolamento nonché la tutela dei diritti dell’interessato”,

e ancora:

“Il titolare del trattamento mette in atto meccanismi per garantire che siano trattati, di

default, solo i dati personali necessari per ciascuna finalità specifica del trattamento e che,

in particolare, la quantità di dati e la durata della loro conservazione non vadano oltre il

minimo necessario per le finalità perseguite. In particolare, detti meccanismi garantiscono

che, di default, non siano resi accessibili dati personali a un numero indefinito di persone”.

Francesco Romeo | 37

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

Si chiede , quindi , che vengano rispettati due principi:

principio della “privacy by

design”, cioè protezione fin

dalla progettazione, che si

sostanzia nell’attuare, fin

dal principio, tutte le necessarie misure tecnicoorganizzative al fine di

scongiurare i rischi cui sono

esposti i dati personali;

il collegato principio della

“privacy by default”, cioè

protezione a prescindere, che si realizza attraverso l’essenzialità del trattamento sotto

ogni punto di vista.

38 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

3. NOSQL

In questo capitolo si parlerà del movimento NoSQL e verranno mostrati i principi fondanti

di questo tipo di tecnologia. Verrà fatto un confronto tra i database tradizionali

(RDBMS), che utilizzano il modello relazionale, e i database che sfruttano il modello

NoSQL. Si concluderà presentando le varie tipologie di DBMS NoSQL che sono state

sviluppate.

1

Cosa si intende per

NoSQL

2

RDBMS vs. NoSQL

3

I Principi Fondanti del

NoSQL

1

4

Tipologie di DBMS

NoSQL

Francesco Romeo | 39

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

3.1 COSA SI INTENDE PER NOSQL

Negli anni novanta Internet ha permesso a molte aziende di ampliare il proprio bacino di utenza portando online

un’enorme quantità di contenuti e

servizi; di conseguenza, la quantità dei

dati presenti in rete è aumentata esponenzialmente. Per questo motivo i

sistemi informatici, per poter elaborare

le informazioni, hanno avuto bisogno

di una maggiore potenza di calcolo,

mentre per i dati , sempre più numerosi, è stata necessaria una migliore organizzazione.

Negli ultimi anni sono aumentate le

aziende operanti esclusivamente online fornendo contenuti sempre più numerosi e strutturati. Dunque, la disponibilità e affidabilità

dei servizi, insieme alla capacità di gestire una grande mole di contenuti, fortemente correlati,

sono diventati punti di estrema importanza. Infatti, capita sempre più spesso che le aziende

rendono più stringenti gli SLA (Service Level Agreement) traducendo, a livello contrattuale, le

aspettative dell’utente finale, ovvero che il servizio sia sempre disponibile, facilmente accessibile (sia come tempi di risposta che come usabilità) e possibilmente attendibile. La tendenza è

diventata quella di garantire maggiormente il servizio o il contenuto rispetto alla correttezza

delle informazioni o alla consistenza dei dati, fatta eccezione nei casi di servizi sotto protocollo

sicuro (ad esempio il settore bancario, l’e-governance o alcune fasi di sicurezza dei dati nell’ecommerce). I sostenitori di questo nuovo approccio sono stati Google e Amazon, con i loro

sistemi proprietari (rispettivamente, BigTable e Dynamo) ma da subito, soprattutto nell’ambito

dei social network, si sono sviluppati sistemi di gestione equiparabili e diversi dai database

40 |Francesco Romeo

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

relazionali (RDBMS). A questi nuovi sistemi è stato dato il nome di DBMS NoSQL (NoSQL).

Con il termine NoSQL si raggruppano varie tecnologie di persistenza dei dati, anche molto

diverse fra loro. L'acronimo stesso è piuttosto vago e soggetto a varie interpretazioni, di cui

la più rilevante e accettata sembra essere “Not Only SQL”.

Per stabilire un punto di partenza, considereremo l'interpretazione fornita da Pramod e Fowler in NoSQL Distilled:

“Un insieme poco definito di database principalmente open-source, principalmente sviluppati nel XXI secolo, principalmente che non fanno uso di SQL”

Per completare questa occorre aggiungere che:

non utilizzano il modello relazionale;

non hanno (solitamente) uno schema

esplicito, ovvero specificato utilizzando

un qualsiasi linguaggio formale;

la maggior parte di essi e stata progettata da subito per funzionare “bene" in

cluster.

Francesco Romeo | 41

Analisi del fenomeno dei Big Data e comparazione di DBMS NoSQL a loro supporto

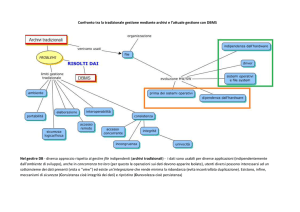

3.2 RDBMS VS. NOSQL

Mentre la caratteristica principale dei sistemi relazionali è quella di mantenere una forte consistenza fra i dati, i database NoSQL garantiscono, in ogni circostanza, alti livelli di disponibilità