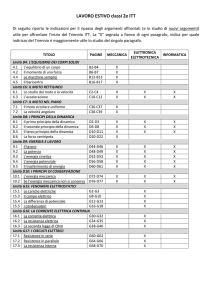

SEZIONE 1

LA VISIONE DEL MONDO DELLA FISICA CLASSICA DAL PUNTO DI VISTA STORICO-CRITICO:

PRESENTAZIONI MECCANICA, TERMODINAMICA ED ELETTRODINAMICA.

LE RAP-

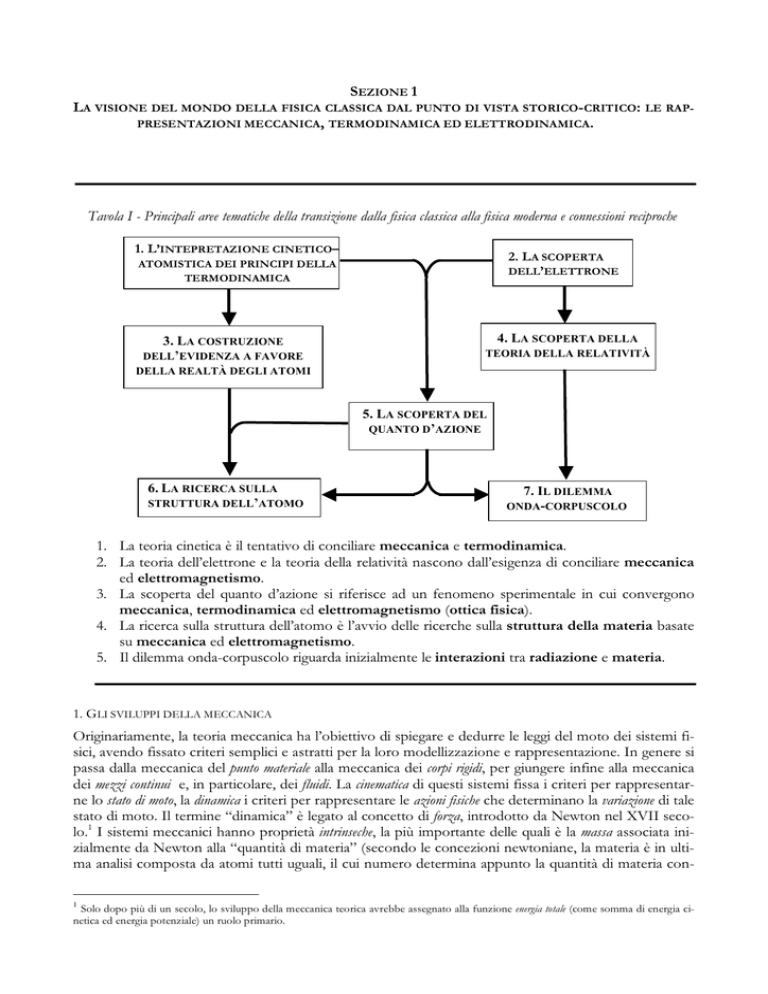

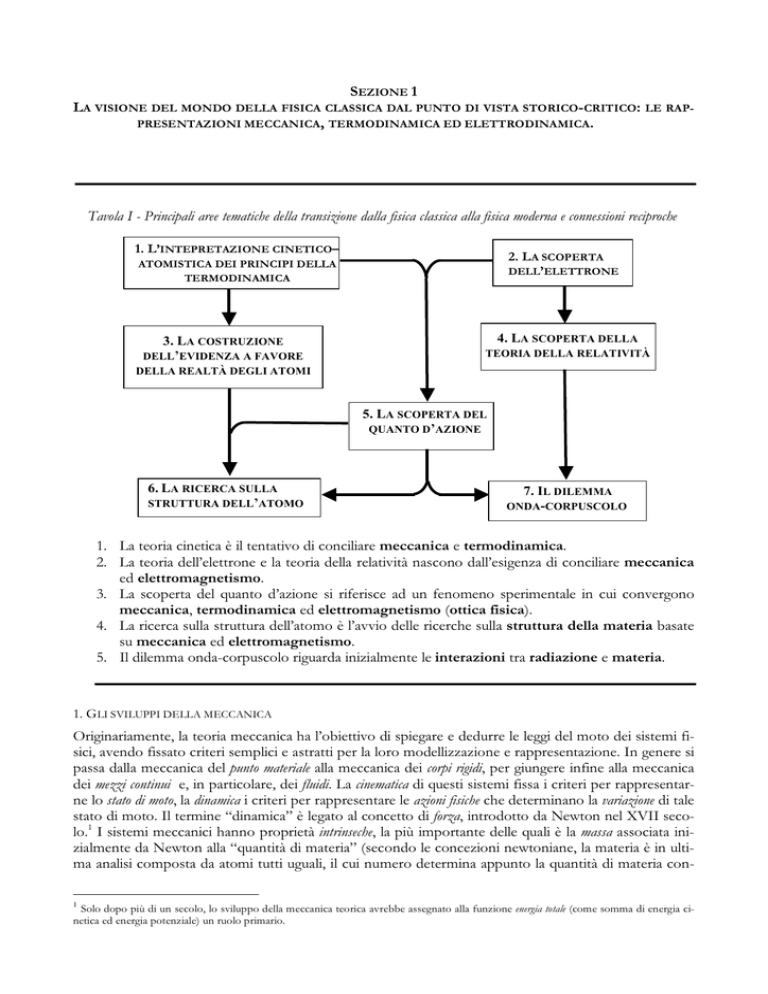

Tavola I - Principali aree tematiche della transizione dalla fisica classica alla fisica moderna e connessioni reciproche

1. L’INTEPRETAZIONE CINETICO–

2. L A SCOPERTA

DELL’ELETTRONE

ATOMISTICA DEI PRINCIPI DELLA

TERMODINAMICA

3. LA COSTRUZIONE

DELL’EVIDENZA A FAVORE

4. LA SCOPERTA DELLA

TEORIA DELLA RELATIVITÀ

DELLA REALTÀ DEGLI ATOMI

5. LA SCOPERTA DEL

QUANTO D’AZIONE

6. LA RICERCA SULLA

STRUTTURA DELL’ATOMO

7. IL DILEMMA

ONDA-CORPUSCOLO

1. La teoria cinetica è il tentativo di conciliare meccanica e termodinamica.

2. La teoria dell’elettrone e la teoria della relatività nascono dall’esigenza di conciliare meccanica

ed elettromagnetismo.

3. La scoperta del quanto d’azione si riferisce ad un fenomeno sperimentale in cui convergono

meccanica, termodinamica ed elettromagnetismo (ottica fisica).

4. La ricerca sulla struttura dell’atomo è l’avvio delle ricerche sulla struttura della materia basate

su meccanica ed elettromagnetismo.

5. Il dilemma onda-corpuscolo riguarda inizialmente le interazioni tra radiazione e materia.

1. GLI SVILUPPI DELLA MECCANICA

Originariamente, la teoria meccanica ha l’obiettivo di spiegare e dedurre le leggi del moto dei sistemi fisici, avendo fissato criteri semplici e astratti per la loro modellizzazione e rappresentazione. In genere si

passa dalla meccanica del punto materiale alla meccanica dei corpi rigidi, per giungere infine alla meccanica

dei mezzi continui e, in particolare, dei fluidi. La cinematica di questi sistemi fissa i criteri per rappresentarne lo stato di moto, la dinamica i criteri per rappresentare le azioni fisiche che determinano la variazione di tale

stato di moto. Il termine “dinamica” è legato al concetto di forza, introdotto da Newton nel XVII secolo.1 I sistemi meccanici hanno proprietà intrinseche, la più importante delle quali è la massa associata inizialmente da Newton alla “quantità di materia” (secondo le concezioni newtoniane, la materia è in ultima analisi composta da atomi tutti uguali, il cui numero determina appunto la quantità di materia con1

Solo dopo più di un secolo, lo sviluppo della meccanica teorica avrebbe assegnato alla funzione energia totale (come somma di energia cinetica ed energia potenziale) un ruolo primario.

tenuta in un corpo).2 Le proprietà cinematiche riguardano la configurazione del sistema e il suo stato di moto,

le proprietà d’interazione possono essere molto varie e sono rappresentate o da funzioni-forza o dalla funzione-energia, che dipendono ovviamente dalla configurazione, dallo stato di moto, dai parametri fisici introdotti dal modello di interazione e, talvolta, dal tempo.

La soluzione di un problema meccanico è facilitata nei casi in cui si conoscono alcune costanti del moto, ossia grandezze che sono soggette a principi di conservazione; in particolare la quantità di moto o “impulso”,

il momento della quantità di moto o “momento angolare” e, naturalmente, l’energia. Lo sviluppo della meccanica

porta a scoprire che i suddetti principi di conservazione sono intimamente connessi a proprietà di invarianza e di simmetria, che costituiscono una sorta di “superleggi” a cui tutti i sistemi devono sottostare.3

Se il sistema è conservativo, in generale la funzione energia potenziale dipende solo dalle coordinate di posizione e non dalle loro derivate. Per i sistemi non conservativi (o dissipativi) l’energia non si conserva: ciò è

causato dalla presenza di forze d’attrito, che ostacolano il moto dei corpi (nei fluidi si parla di “attrito interno”, riconducibile alla viscosità).

In generale si distingue una meccanica del punto materiale, da una meccanica dei sistemi (in generale riferita

ai corpi rigidi) e una meccanica dei fluidi (o dei mezzi continui): queste branche della meccanica adottano modelli rappresentativi (sia cinematici, sia dinamici) che differiscono tra loro, anche se si ammette in genere la loro compatibilità. I sistemi trattati sono in genere schematizzati da costrutti mentali (corpo rigido,

solido elastico, ecc.), i quali comportano altrettante idealizzazioni più o meno spinte dei corpi reali e del

loro comportamento (non a caso si parla di “molla ideale”, “fluido ideale”, “pendolo semplice”, ecc.).

La trattazione dei sistemi “continui” si basa su criteri formali diversi da quelli adottati per sistemi “discreti”. Le grandezze (per esempio la densità) sono rappresentate da funzioni continue, definite punto

per punto nello spazio occupato dal sistema. Si tratta dunque di funzioni a più variabili: ne consegue

che le equazioni del moto sono ricavate in generale da equazioni differenziali alle derivate parziali. Alla

rappresentazione “corpuscolare” (sistemi che possono avere anche un numero enorme di gradi di libertà, ma i cui costituenti elementari sono oggetti relativamente semplici, con pochi gradi di libertà ciascuno) si affianca dunque la rappresentazione “di campo” in cui le grandezze significative sono rappresentate da funzioni continue delle coordinate spaziali e temporali, definite in un’intera zona di spazio (come, ad esempio, la densità, la velocità e la pressione di un fluido). La dinamica dei mezzi continui porta,

tra l’altro ad introdurre una forma di movimento non riconducibile a uno spostamento complessivo di

materia, ma solo di energia e impulso: stiamo parlando della propagazione ondulatoria, che possiede una

propria cinematica e una propria dinamica, anche se non è in contraddizione con le leggi meccaniche

fondamentali, almeno finché si parla di onde che si propagano in mezzi materiali (non è così, come vedremo, per le onde elettromagnetiche).

Utilizzando una visione retrospettiva, possiamo dire che gran parte della fisica ottocentesca si sviluppa all’interno di una visione “meccanicista” della realtà fisica. Ciò non vuol dire che tale sviluppo sia

privo di cambiamenti e di scoperte importanti. Possiamo subito dire che le difficoltà incontrate dai fisici

fedeli a tale visione furono, già verso la fine del XIX secolo, come dimostrazione di una “crisi del meccanicismo”, anche se questo modo di dire è, di fatto, piuttosto ambiguo. In realtà, verso la fine del XIX

secolo si assiste a una differenziazione di approcci e di modelli dei sistemi fisici, che produce, all’inizio del

XX secolo, cambiamenti nei concetti fondamentali della meccanica, anche se le teorizzazioni di un

comportamento meccanico dei sistemi fisici diverso da quello newtoniano continuano ad avere un ruolo fondamentale per l’intera fisica.

Limitandoci ad una sintesi schematica dello sviluppo della meccanica nel corso del XIX secolo,

dobbiamo citare soprattutto i contributi più significativi dei fisici matematici: quelli riguardanti la meccanica analitica e quelli riguardanti la meccanica dei mezzi continui. Tra i primi vanno segnalati i contributi di grande rilevanza di Hamilton, Poisson, e Jacobi. In particolare la nuova formulazione data da

Hamilton al “nucleo” teorico della meccanica classica, basata su due equazioni differenziali del

prim’ordine, ha un’importanza fondamentale anche per quanto riguarda la fisica moderna. Essa consente di racchiudere tutte le proprietà del sistema e delle sue interazioni nella cosiddetta “funzione hamiltoniana” (che poi verrà messa in relazione con l’energia totale del sistema stessa). Rispetto alla meccani2

3

Per i fluidi si parla ovviamente di densità.

Espressi in forma più generale, i principi di conservazione continuano a valere anche nella fisica moderna.

ca tradizionale, la meccanica analitica di Hamilton consente di rendere esplicite relazioni tra le coordinate che non erano chiaramente visibili in precedenza. Per esempio, la relazione tra alcune variabili e la loro definizione più astratta e generale (per esempio tra le variabili di configurazione q e le variabili di impulso p) consente di chiarire che si tratta di variabili “coniugate”, ossia legate da una particolare relazione reciproca. Non solo, ma lo sviluppo della teoria di Hamilton-Jacobi consente di porre in relazione i

principi variazionali della meccanica con il principio di Fermat (o di tempo minimo) che riguardava

l’ottica geometrica. Hamilton arrivò ad indicare la strada per una formulazione ancor più generale della

meccanica, tale da avere un rapporto con la meccanica ordinaria paragonabile al rapporto tra ottica ondulatoria e ottica geometrica. Non c’è bisogno di sottolineare l’importanza di questi sviluppi per le prime formulazioni della meccanica ondulatoria, avvenute quasi un secolo dopo.4

La meccanica dei mezzi continui, il cui sviluppo fu sicuramente sollecitato non solo dagli interessi,

anche applicativi, riguardanti la fluidodinamica, ma anche dall’affermazione della concezione della luce

come propagazione ondulatoria in un mezzo elastico (il cosiddetto “etere”), poté usufruire, tra gli altri,

dei contributi fondamentali dei fisici britannici Green e Stokes, che fornirono le basi matematiche per il

successivo fondamentale contributo alla teoria del “campo elettromagnetico” dato da Maxwell.

2. LA TERMODINAMICA E LA TEORIA CINETICA

La termodinamica appare sulla scena della fisica classica subito dopo il 1850. Nel 1824, Sadi Carnot, aveva formulato una teoria fenomenologica generale del funzionamento delle macchine termiche. Questa teoria rivelava il fatto fondamentale che, indipendentemente dal particolare meccanismo di funzionamento, per produrre “potenza motrice” (lavoro meccanico utilizzabile), ogni macchina deve disporre

di una sorgente “calda” e di una sorgente “fredda”. In altri termini, la possibilità di produrre lavoro utilizzabile si presenta solo se si ha disposizione una differenza di temperatura. Queste acquisizioni, riscoperte

vent’anni dopo da William Thomson (il futuro Lord Kelvin), dovettero essere conciliate con le scoperte

effettuate nel frattempo da James Prescott Joule sulla produzione di calore per attrito (o viscosità interna nei liquidi). L’importanza delle scoperte di Joule è legata all’affermazione del principio universale di conservazione dell’energia.

Sappiamo che nei processi direttamente osservabili su scala umana, l’energia meccanica inizialmente

visibile e utilizzabile per produrre effetti, tende a diminuire fino ad annullarsi a causa degli inevitabili attriti. In seguito alle ricerche di Joule, diventava evidente che l’energia meccanica tendeva ad annullarsi

solo apparentemente. In realtà, l’energia meccanica macroscopica si trasferisce a gradi di libertà “invisibili”

(ossia assume la forma di agitazione termica di atomi e molecole). Joule chiamava questo trasferimento

“conversione di energia meccanica in calore”, pochi anni più tardi Clausius avrebbe chiarito che essa assumeva la forma di “energia interna”, concepita come “funzione di stato” del sistema considerato. Prima,

alludendo alla diminuzione dell’energia meccanica totale, si parlava di sistemi e/o processi non conservativi

(o “dissipativi”). Con la scoperta della termodinamica, il concetto d’energia interna (associato ai concetti di

temperatura, lavoro e calore) consente quindi di affermare la conservazione dell’energia in ogni processo fisico possibile. La prima legge della termodinamica assume allora la nota forma

!U = Q – L

(1)

Restava però il problema di stabilire con chiarezza la differenza essenziale fra processi conservativi e

processi dissipativi. Si capì allora che, per chiarire questa differenza, non bastava la prima legge della termodinamica, ma occorreva ammettere la validità di una seconda legge della termodinamica: la sua formulazione si sarebbe presto rivelata una delle scoperte più importanti dell’intera storia della fisica.

Occorre a questo punto notare come la termodinamica di Clausius e Kelvin cambia, rispetto alla

meccanica, l’intero modo di rappresentare un processo fisico. In effetti, la “cinematica” della termodinamica è completamente diversa da quella della meccanica. Un concetto d’importanza primaria è il concetto di equilibrio termodinamico, di cui l’equilibrio meccanico è solo un caso molto particolare. In termodinamica classica il sistema subisce “cambiamenti” dei quali non interessa l’andamento temporale: si

parla in genere di “trasformazioni” mediante le quali il sistema passa da uno stato iniziale di equilibrio a

uno stato finale di equilibrio, in seguito alla rimozione di un “vincolo” (o di una “parete”).

Non possiamo ovviamente entrare nei dettagli. Chi intendesse approfondire queste nozioni dovrebbe consultare un testo

di meccanica teorica, come ad esempio il classico trattato di H. Goldstein, Meccanica Classica, Zanichelli, Bologna, 1971.

4

Ora, l’evidenza fenomenologica mostra che, nel mondo macroscopico, tutti i processi che avvengono spontaneamente (senza intervento esterno)

a) non possono che partire da uno stato di non equilibrio;

b) tendono naturalmente ad raggiungere uno stato di equilibirio;

c) non possono tornare spontaneamente allo stato iniziale.

Si presenta quindi quella normale irreversibilità dei processi naturali spontanei. La scoperta che Carnot

aveva fatto già nel 1824 poteva quindi essere interpretata come scoperta del fatto che, mentre la dissipazione dell’energia meccanica con il conseguente riscaldamento dei sistemi implicati è un processo

spontaneo che non richiede alcun intervento esterno, il processo che si muove nella direzione opposta,

ossia che estrae energia interna da un sistema riscaldato e la trasforma in energia meccanica concretamente utilizzabile, non avviene mai spontaneamente. In altri termini, la conversione di energia meccanica (cinetica o potenziale) in energia interna nei processi dissipativi è naturale e inevitabile, la conversione opposta richiede l’uso di macchine termiche il cui funzionamento si muove nella direzione opposta a quella “naturale” e richiede l’intervento e l’ingegno umano.

Clausius chiarì il significato di questa differenza nel modo seguente. Un processo irreversibile rappresenta un cambiamento reale e definitivo in natura: esso non può essere invertito riportando il sistema nel suo stato iniziale solo se si produce un cambiamento “equivalente” in un secondo sistema fatto

interagire col primo. Ecco spiegato il funzionamento delle macchine termiche: la produzione di energia

meccanica utilizzabile a spese dell’energia interna di una massa di vapore (o d’aria) precedentemente riscaldata, non può avvenire se al contempo non si verifica un processo spontaneo “equivalente”. Questo

processo non è che il passaggio di una certa quantità di energia interna dal sistema “caldo” ad un qualsiasi sistema “freddo” sotto forma di “calore”. Analogamente non si può trasferire energia da un sistema “freddo” a un sistema “caldo” se non facendo avvenire contemporaneamente un processo “equivalente” in cui una certa quantità di energia meccanica utilizzabile si disperde in energia interna del sistema “caldo” stesso.

Il significato essenziale della seconda legge è quindi che un processo irreversibile, una volta avvenuto, non può tornare indietro da solo. Occorre che da qualche altra parte avvenga un altro processo irreversibile almeno “equivalente”. Ma come stabilire l’equivalenza tra processi diversi? Clausius dimostrò

che, oltre all’energia interna, esiste un’altra funzione dello stato del sistema la cui variazione “misura” la

quantità di cambiamento irreversibile che il sistema ha subito. Questa funzione si chiama entropia (termine preso dal greco che significa appunto “contenuto di cambiamento”). In base alla seconda legge risulta allora che, presi in considerazione tutti i sistemi che partecipano ad un processo fisico, l’entropia

totale non può che aumentare. In altri termini, la seconda legge della termodinamica è esprimibile nella sua

essenza concettuale e matematica come legge dell’aumento di entropia. Quando l’entropia ha raggiunto il valore massimo, compatibile con i vincoli cui il sistema complessivo è soggetto, vuol dire che ci si trova in

una situazione di equilibrio dalla quale il sistema non può allontanarsi “spontaneamente”. Da questo

punto di vista la seconda legge non è altro che l’espressione della tendenza universale di tutti i sistemi

fisici a raggiungere una situazione di equilibrio. È questa tendenza, detto in parole semplici, che fa muovere il mondo.

La dissipazione dell’energia appare intimamente legata all’irreversibilità dei processi naturali spontanei,

che a sua volta costituisce il significato essenziale della validità della seconda legge. Un processo irreversibile è quindi un processo in cui avviene una produzione di entropia. La seconda legge della termodinamica esprime essenzialmente il fatto che, una volta che è avvenuta una trasformazione irreversibile, non è più possibile

che il “mondo” torni allo stato iniziale. Questo vuol dire che la termodinamica incorpora nei suoi presupposti la distinzione tra passato e futuro e consente quindi di definire una “freccia del tempo”.5

La teoria cinetica dei gas non è inizialmente rivolta alla comprensione delle leggi (o principi) della termodinamica fenomenologica. Essa nasce come tentativo di costruire un modello microscopico del

comportamento macroscopico del gas perfetto, tale da render conto della sua equazione di stato. Qualche

anno dopo la formulazione della termodinamica fenomenologica, grazie ai contributi di Clausius e di

Maxwell, la teoria cinetica si è data obiettivi sempre più generali ed ambiziosi, fino a cercare di trovare

Per una storia sufficientemente dettagliata della storia della termodinamica “macroscopica” si rimanda al volume a più autori Calore, energia, entropia (a cura di C. Tarsitani & M. Vicentini), Franco Angeli, Milano, 1991.

5

una spiegazione basata sul modello atomistico e sui principi della meccanica degli stessi principi della

termodinamica e, in particolare, del secondo principio.

Essendo i sistemi materiali macroscopici costituiti da un numero enorme di atomi e molecole, il

nuovo schema teorico, pur basandosi essenzialmente su concetti e modelli meccanici, è costretto a far

ricorso a nuove ipotesi fondamentali richieste appunto dall’impossibilità di descrivere il moto di ciascuna molecola. Queste ipotesi riguardano in genere comportamenti “medi” di grandi numeri di molecole

e si basano sull’assunto che le medie fatte su un numero enorme d’eventi individuali soggetti a variazioni casuali devono avere una notevole stabilità. Partendo da ipotesi statistiche piuttosto rozze, i modelli

cinetici evolvono rapidamente e consentono a Maxwell, già nel 1859, di stabilire la funzione di distribuzione

della velocità molecolare in un gas perfetto.

Egli stesso ne dà la definizione:

Se un grande numero di particelle sferiche identiche sono in moto in un recipiente perfettamente elastico, tra le particelle si verificheranno collisioni e le loro velocità saranno alterate ad ogni collisione; ne segue che dopo un certo

tempo la vis viva [l’energia cinetica] sarà ripartita tra le particelle secondo una legge regolare, che deriva dal calcolo del

numero medio di particelle la cui velocità è compresa entro determinati limiti, anche se la velocità di ciascuna particella cambia ad ogni urto.

Seguiamo ora la sua dimostrazione. Se N è il numero totale di molecole, occorre dunque trovare una

funzione di distribuzione delle velocità molecolari f(v) tale che Nf(v) rappresenta il numero di molecole che

hanno una velocità compresa tra v e v + dv. Per ottenere questo risultato, bastano alcune semplici ipotesi:

(1) non c’è alcuna correlazione tra le tre componenti della velocità:

f(v) = f(vx) f(vy) f(vz);

(2) valori della velocità di segno opposto hanno la stessa probabilità:

f(v) = f(v2) = f(vx2 + vy2 + vz2).

Il problema si riduce allora a quello di trovare la funzione matematica che ha la seguente proprietà:

f(vx) f(vy) f(vz) = f(vx2 + vy2 + vz2)

Si tratta evidentemente della funzione esponenziale. Quindi:

f(v2) = Cexp(– Av2)

ossia, come conclude Maxwell,: «le velocità sono distribuite tra le particelle secondo la stessa legge di

distribuzione degli errori di misura».

Generalizzando il problema ai casi in cui le molecole abbiano anche energia potenziale, considerando l’energia totale E della singola molecola, la legge di Maxwell diviene la ben nota legge di distribuzione di Maxwell-Boltzmann per l’energia di ciascun elemento del sistema:

fMB(E) = Aexp( – E/kT)

Occorre a questo punto notare che le ipotesi (1) e (2) sono ipotesi probabilistiche che non possono

essere in alcun modo dedotta dalla teoria meccanica. Il modello di Maxwell introduce assunzioni supplementari che lo rendono un modello essenzialmente statistico. La generalizzazione e formulazione rigorosa di queste ipotesi porta quindi a un nuovo schema teorico che prende il nome di “meccanica statistica” e che ha postulati indipendenti rispetto a quelli della meccanica classica.

La funzione di distribuzione della velocità molecolare è un ottimo risultato che trova riscontro

nell’osservazione sperimentale. Tuttavia, sia Maxwell sia, soprattutto, Boltzmann non si accontentano di

questo risultato. Avendo riconosciuto che la funzione di distribuzione delle energie molecolari caratterizza lo stato di equilibrio del sistema, essi pongono l’ambizioso obiettivo di dimostrare che, in virtù

della dinamica interna delle molecole, qualsiasi altra funzione di distribuzione (di non equilibrio) avrebbe dovuto prima o poi trasformarsi spontaneamente in quella di equilibrio. In questo modo si sarebbe

ottenuta una spiegazione microscopico-statistica della seconda legge della termodinamica, ossia si sarebbe spiegata la natura dell’irreversibilità osservabile a livello macroscopico.

Ma le difficoltà concettuali e formali sono certamente non banali e l’obiettivo è raggiunto solo

ammettendo ipotesi supplementari che non rientrano nel quadro meccanico classico.6 Resta comunque

il fatto che non si può considerare la meccanica statistica come una semplice “applicazione” della

6

Su questo punto torneremo più avanti nel corso.

fatto che non si può considerare la meccanica statistica come una semplice “applicazione” della meccanica classica. Infatti, come si è detto, essa si basa su alcune ipotesi sulle caratteristiche del moto “collettivo” del sistema che, avendo un carattere essenzialmente probabilistico, non possono essere ricondotte

ai soli principi della meccanica.

Analogamente a quanto avviene per i principi della termodinamica, alcuni principi fondamentali della meccanica statistica, come il famoso principio di Boltzmann S = klogW, che lega l'entropia S e la probabilità dello stato macroscopico W, hanno dimostrato una grande fecondità e un campo di validità che si

è esteso anche alle nuove idee del XX secolo. L’ipotesi di Planck del 1900 nasce appunto

dall’applicazione, a un sistema costituito da materia interagente con la radiazione, del principio di Boltzmann. Va però osservato che il problema dell’irreversibilità dei processi “reali” macroscopici resta un

problema di fondo anche per la meccanica statistica. Non esiste infatti ancora una teoria completa e coerente dei sistemi lontani dall’equilibrio.

Dal punto di vista dei legami con la termodinamica, con la meccanica statistica si ottiene una visione

più ampia degli stessi concetti fondamentali energia, entropia e temperatura. In particolare, essendo

l’entropia interpretata come grandezza che rappresenta la probabilità di uno stato macroscopico, la seconda legge della termodinamica diviene una legge essenzialmente statistica. Ciò consente di introdurre

in modo naturale il concetto di fluttuazione (una grandezza il cui valore osservabile è un “valor medio”,

non mantiene costantemente questo valore, ma “fluttua”, anche se di poco, attorno ad esso) e di passare, tramite quella che viene normalmente chiamata “termodinamica statistica”, a un punto di vista che si

colloca ad un livello intermedio tra quello macroscopico e quello microscopico e che, per questo, viene

chiamato punto di vista mesoscopico.7 L’uso della termodinamica statistica, soprattutto da parte di Einstein, ha per altro consentito di stabilire univocamente la struttura molecolare della materia (lo studio

del cosiddetto “moto browniano”) e di introdurre alcune delle principali ipotesi quantistiche.

3. LA TEORIA DEI FENOMENI ELETTROMAGNETICI E L’OTTICA FISICA

Sviluppata inizialmente come settore della meccanica dei mezzi continui, la teoria del campo elettromagnetico ha assunto la propria fisionomia definitiva quando Maxwell ha formulato le sue quattro equazioni

fondamentali.8 La teoria è stata poi accettata come teoria fondamentale dall’intera comunità dei fisici

quando, nel 1887, Hertz ha dimostrato sperimentalmente la propagazione, con la velocità della luce,

delle onde elettromagnetiche che erano previste dallo stesso sistema di equazioni. Le equazioni di Maxwell costituiscono dunque il “nucleo” dell’intero schema esplicativo, che non appare più come un sistema deduttivo fondato su alcuni “principi” primi enunciabili separatamente in modo esplicito. È il

primo caso, nella storia della fisica, che si giunge a una struttura formale, in sé coerente, della quale si

possono fornire diverse “interpretazioni fisiche”.

Il processo storico che ha portato alla sistemazione teorica dell’elettromagnetismo classico nasce e si

sviluppa essenzialmente nell’ambiente britannico, basandosi sul presupposto che la natura delle interazioni elettromagnetiche non potesse consistere in azioni esercitate direttamente e istantaneamente a distanza. Queste azioni dovevano invece essere “trasportate” da un mezzo materiale che occupava

l’intero spazio, e che per la sua imponderabilità e invisibilità fu chiamato “etere”. Inizialmente, quindi,

le equazioni di Maxwell intendevano rappresentare la “dinamica” dell’etere, in quanto mezzo continuo

che “occupava” il cosiddetto “campo” elettromagnetico, ossia la zona di spazio in sui si trovavano i

corpi che manifestavano interazioni elettromagnetiche. Dal momento che l’azione di un corpo sull’altro

non era istantanea, l’energia ad essa associata doveva per brevissimi istanti essere trasferita all’etere che

poi la comunicava al corpo distante. In generale, l’energia di un sistema in cui si verificavano interazioni

elettromagnetiche doveva essere distribuita in un’intera zona di spazio: era appunto l’energia del “campo”.

Come si è detto, una delle conseguenze più importanti della teoria di Maxwell è che nel campo elettromagnetico possono crearsi forme di propagazione ondulatoria, come del resto avviene per altri si7 Non si guarda più agli ipotetici costituenti molecolari del sistema, bensì, partendo dalle leggi fenomenologiche, si ricavano informazioni sulle proprietà delle piccolissime fluttuazioni delle grandezze termodinamiche e si fanno ipotesi sulla natura dei costituenti “microscopici” del sistema che diano luogo, dal punto di vista statistico, a quelle proprietà.

8

Le equazioni di Maxwell sono formulate nel linguaggio dell’analisi vettoriale. Sono pertanto inaccessibili, nella loro formulazione rigorosa, agli studenti della scuola superiore.

stemi materiali elastici continui. La principale caratteristica di tale propagazione è, come sappiamo,

che la sua velocità dipende solo dalle caratteristiche del mezzo e non per esempio dalla velocità della

sorgente (anche per questo non si poteva ammettere che avvenisse in uno spazio vuoto). Su questa

base, Maxwell giunse a congetturare che la luce non fosse altro che un processo di propagazione ondulatoria nello stesso etere che era responsabile delle interazioni elettromagnetiche. Nasceva così la

“teoria elettromagnetica della luce”, che si basava anche sulla concordanza tra i valori della velocità

di propagazione delle onde elettromagnetiche, calcolati teoricamente in base alle equazioni, e i valori

della velocità della luce misurati sperimentalmente. D’altra parte, ormai da tempo, la concezione ondulatoria della luce aveva soppiantato quella corpuscolare ed era facile interpretare la cosiddetta “ottica geometrica” come “caso limite” dell’ottica ondulatoria. Inoltre, con la teoria elettromagnetica,

diventava possibile collegare i processi d’interazione della luce con la materia alle proprietà elettriche

e magnetiche di quest’ultima. Si apriva un nuovo campo d’indagine che avrebbe dato luogo allo sviluppo di quel settore disciplinare che sarebbe stato chiamato “ottica fisica”.

onde elettriche

vite micrometrica

Circuito primario

Circuito secondario

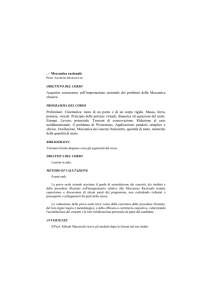

Fig. 1

Fig. 1 - Lo schema dell’apparato sperimentale utilizzato da Hertz. Il circuito primario era costituito da un

grosso condensatore che era caricato fino al punto di produrre una scarica elettrica nell’aria tra il suo polo

positivo e il suo polo negativo. Hertz sapeva che tale scarica era prodotta da una corrente oscillante, che

quindi avrebbe dovuto produrre onde elettriche che si propagavano a distanza. Il “rivelatore” del campo

elettrico era costituito da un piccolo circuito secondario aperto, i cui poli potevano essere avvicinati o allontanati con una vite micrometrica. Se il circuito era investito da un campo elettromagnetico variabile,

l’effetto induttivo sul circuito secondario doveva far scoccare tra i suoi poli una piccola scintilla. Questa

scintilla era tanto più lunga, quanto maggiore era l’ampiezza del campo in quella zona di spazio. In questo

modo Hertz fu capace di rivelare i nodi e i ventri delle onde elettriche che si formavano nello spazio circostante al circuito primario.

È molto interessante notare che, nel compiere queste misure, Hertz si accorse che spesso si produceva un fenomeno che disturbava l’esperimento in questione, fenomeno che egli chiamò immediatamente “effetto fotoelettrico”. Succedeva che, quando i poli del circuito rivelatore erano esposti alla luce

proveniente dalla scintilla principale, la scintilla “secondaria” si produceva con facilità molto maggiore,

disturbando quindi il funzionamento corretto del rivelatore. Hertz fu comunque incuriosito dal fenomeno, dato che esso rivelava un’altra connessione (sia pure misteriosa) tra luce ed elettricità, e quindi

decise di approfondirne l’esame. Usando vari filtri ottici egli riuscì a rivelare che la parte più efficace

dello spettro emesso dalla scarica principale era quella corrispondente alla regione violetta e ultravioletta. C’era quindi una connessione tra l’intensità dell’effetto e lunghezza d’onda della luce che lo provocava.

Quando Hertz progettò i suoi esperimenti – storicamente “cruciali” – non era ancora stata messa a

punto una teoria che proponesse ipotesi chiare sulla natura della carica (e quindi della corrente) elettrica. Pochi anni dopo, nella ricerca di un’interpretazione elettromagnetica dei fenomeni di riflessione, rifrazione, emissione e assorbimento della luce, il fisico teorico olandese Hendrik Anton Lorentz elaborò

una teoria pressoché esauriente delle interazioni tra materia e radiazione sulla base di un ipotesi che,

quando fu formulata, aveva solo qualche supporto sperimentale indiretto nell’ambito dei fenomeni elettrochimici. Si tratta della cosiddetta “teoria degli elettroni”, basata su un modello “quantizzato” della

carica elettrica. L’elettricità era appunto concepita da Lorentz come una “sostanza” costituita da microscopiche “particelle”, dotate di massa, aventi tutte la stessa carica negativa o positiva.

v

Tubo catodico

H

Fig. 2 – Schema dell’esperimento di J.J.Thomson

Poiché la teoria degli elettroni di Lorentz è sostanzialmente quella che ci è tramandata dagli odierni

libri di testo di elettromagnetismo, non c’è bisogno di soffermarsi su di essa. Occorre solo ricordare che

essa ricevette una consacrazione definitiva quando J. J. Thomson, nel 1897, eseguì la misura del rapporto e/m delle particelle ipotizzate da Lorentz, dimostrando la natura “corpuscolare” di quelli che allora

erano chiamati “raggi catodici” (fig. 2). Si noti che, nell’esperimento di J.J. Thomson, ogni singolo elettrone, che viaggia con la velocità v, subisce una deviazione nella zona in cui è presente un campo magnetico uniforme H. Questo fenomeno trovava una spiegazione nell’ambito della teoria elettromagnetica solo se si ipotizzava che una carica in moto, immersa in un campo magnetico uniforme subisse una

“forza” – detta appunto “forza di Lorentz” – proporzionale al prodotto vettoriale tra la velocità della

carica e il campo magnetico. La forza di Lorentz FL aveva dunque la forma:

FL = – e(v!H)

La forma stessa di questa forza ci rimanda ad un problema che assume un’importanza cruciale, il

problema dell’elettrodinamica dei corpi in movimento. Questo problema era già noto in un’altra forma,

più strettamente legata ai fenomeni ottici. Se le onde elettriche hanno una velocità di propagazione che

dipende solo dalle caratteristiche del mezzo etereo, avremmo potuto osservare effetti dell’eventuale

moto attraverso il mezzo suddetto del sistema di riferimento in cui facciamo le nostre osservazioni?9

Tra le ipotesi a confronto c’era quella che sosteneva che l’etere fosse completamente trascinato dal

moto della Terra e quindi fosse sempre in uno stato di quiete relativa rispetto al sistema di riferimento

del laboratorio. Il problema sembrava completamente eliminato per quanto riguarda i fenomeni che si

verificavano nei laboratori terrestri, ma l’ipotesi non era compatibile con le osservazioni astronomiche

(per es., con il fenomeno dell’aberrazione stellare). Per questo Lorentz ipotizzava la completa permeabilità dell’etere da parte della materia che si muoveva attraverso di esso. L’etere, imperturbato dai moti dei

corpi materiali, occupava quindi per Lorentz una posizione fissa nello spazio. Avrebbero quindi dovuto

essere osservabili alcuni effetti del moto dei sistemi fisici, in particolare del nostro pianeta, attraverso

l’etere.

Come sappiamo, nel giro di pochi anni, il giovane Albert Einstein avrebbe risolto la questione partendo da presupposti del tutto diversi che incidevano sui fondamenti della cinematica e della dinamica

classiche, eliminando l’incompatibilità di fondo tra formulazione classica del principio della relatività e

le equazioni di Maxwell. Quella di Einstein era una “elettrodinamica dei corpi in movimento”, poiché le

sue argomentazioni, pur accennando ai fenomeni ottici, si riferivano soprattutto ai fenomeni come

quello che abbiamo discusso in precedenza riferendoci alla scoperta “sperimentale” dell’elettrone.

Il celebre articolo del 1905, in cui si formulano i presupposti della teoria della relatività speciale comincia

infatti con la seguente affermazione: «L’elettrodinamica di Maxwell – come viene ordinariamente intesa

– conduce, quando è applicata ai corpi in movimento, ad asimmetrie non inerenti ai fenomeni».

L’esempio discusso da Einstein è semplice e fondamentale al tempo stesso. Nell’interpretare

l’interazione elettrodinamica reciproca tra un magnete e un conduttore in moto relativo con velocità uniforme l’uno rispetto all’altro, la teoria di Lorentz è costretta a distinguere nettamente tra il caso in cui

9 È importante sottolineare come, a differenza delle onde elastiche, le onde elettromagnetiche, proprio perché derivanti dalle equazioni di

Maxwell e non dalle equazioni della meccanica, non possono essere “inseguite” e raggiunte da un osservatore: non si può viaggiare “accanto” alle onde elettromagnetiche con la loro stessa velocità ed osservare una configurazione “ondulatoria” stazionaria dei campi elettrici

e magnetici.

troviamo nel sistema di riferimento del conduttore e il caso in cui ci troviamo nel sistema di riferimento

del magnete. Nel primo caso, infatti, il moto del magnete produce un’azione induttiva sul conduttore,

generando un campo elettrico in grado di produrre una corrente elettrica. Nel secondo caso invece, con

un effetto analogo a quello illustrato in fig. 2, la stessa corrente elettrica è prodotta dalla “forza di Lorentz”. È quindi evidente, per Einstein, che questa “asimmetria” nasce solo dall’incompatibilità

dell’elettrodinamica ordinaria col principio di relatività espresso in forma galileiana. Non ci può essere

differenza tra i due casi poiché tutti i sistemi di riferimento inerziali sono “equivalenti”. La forza di Lorentz non è quindi altro che un campo elettrico che si osserva nel riferimento in moto rispetto al magnete. Ciò significa che occorre riformulare le leggi di trasformazione dei campi nel passaggio da un sistema di riferimento inerziale ad un altro sistema di riferimento inerziale. Si scopre quindi facilmente

che tali leggi di trasformazione derivano direttamente da leggi di trasformazione delle coordinate e dei

tempi diverse da quelle galileiane.

Con la formulazione della teoria della relatività speciale, e la conseguente eliminazione dell’etere, scompare ogni distinzione rigida tra campo elettrico e campo magnetico e il campo elettromagnetico acquista

una realtà autonoma, assimilabile a quella di ogni altro sistema fisico. La teoria della relatività speciale

può essere considerata un coronamento di FC per sistemi che si muovono con velocità non trascurabile

rispetto a quella della luce. Tuttavia, la meccanica relativistica impone alcuni cambiamenti sostanziali al

modo di considerare e applicare i principi dinamici fondamentali. Non a caso, con la relatività speciale il

concetto classico di “forza” perde il suo rilievo centrale.

La teoria degli elettroni di Lorentz ha un’importanza rivoluzionaria. In particolare, essa indica una

nuova visione della materia, ora concepita come costituita da cariche elettriche, libere o legate. Possono

così cominciare a svilupparsi su nuove basi le ricerche di ottica fisica e, parallelamente, le ricerche sulla

struttura microscopica della materia. Come è noto sono proprio gli sviluppi di queste ricerche che determinano la “crisi” definitiva della fisica classica. Non solo, con la scoperta dell’elettrone, la natura della carica elettrica trova un modello interpretativo capace di affrontare e spiegare numerosi fenomeni (che si

estendono alle proprietà chimiche, elettriche, magnetiche e ottiche della materia). Gli sviluppi di questa

concezione, assieme alla scoperta di varie forme di radiazione e dei fenomeni radioattivi, portano, negli

anni intorno al 1900, all’affermazione definitiva della concezione atomistica della materia e ai primi tentativi

di costruire modelli teorici della struttura interna degli atomi e delle molecole. Soprattutto, i primi “modelli atomici”, che si basano appunto su ipotesi riguardanti la configurazione e il moto di sistemi di particelle

cariche, cominciano a rendere sempre più evidenti le difficoltà insormontabili della rappresentazione

classica degli oggetti fisici. Sarà infatti proprio il fallimento dei tentativi di arrivare a una concezione coerente della struttura intima della materia e di unificare in un quadro unitario meccanica, elettrodinamica e termodinamica che porterà, all’inizio del XX secolo, a mettere in evidenza i limiti strutturali di FC e

a produrre ipotesi alternative a partire dalle quali saranno costruite le teorie “moderne” che sono alla

base della fisica contemporanea.