L’INFORMATICA NELL’ERA DEL PERSONAL

6

Un personal su ogni scrivania

6

Struttura logica e fisica dell’informazione

7

L’INTERPRETAZIONE BINARIA

8

Bit e byte

9

Byte, Kilobyte e Megabyte

10

La rappresentazione esadecimale

11

IL PERSONAL COMPUTER

12

Desktop

12

Portatili

13

Notebook

14

Pen book

14

Palmtop

14

Gli altri computer

15

Hardware e software

16

COME SCEGLIERE UN PERSONAL COMPUTER

17

L'ORGANIZZAZIONE DELLE INFORMAZIONI

21

Una strategia per l'organizzazione

22

GUASTI, ASSISTENZA E CRIMINI

25

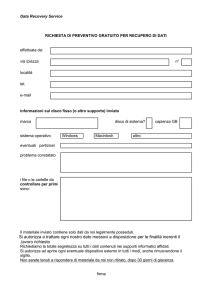

L'assistenza

26

L'origine dei guasti

26

Le precauzioni

28

In caso di guasto

28

I virus

29

Il crimine informatico

30

Il backup

31

1

Programmi di protezione

33

Le controindicazioni alla protezione

33

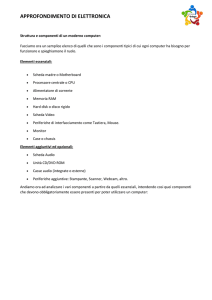

ASSEMBLARE IL PROPRIO PERSONAL

35

CPU

38

Mother board

38

RAM

39

Costi

39

IL MICROPROCESSORE

40

Caratteristiche tecniche

40

Microprocessori RISC

41

Considerazioni finali

42

Clock

43

LA MEMORIA

44

Memoria ROM

44

Memoria RAM

44

Volatilità della RAM

45

Dimensione della RAM

45

Memoria virtuale

46

LA SCHEDA MADRE

47

Processore DMA

50

Porte Esterne

50

USB

52

FireWire

52

Firmware e BIOS

52

Flash-ROM e Boot-ROM

53

LA SCHEDA VIDEO

54

2

Il Processore Grafico (GPU)

54

LA Video RAM

54

Il RAMDAC

55

LA SCHEDA AUDIO

56

LE UNITÀ DI MEMORIA DI MASSA

58

Caratteristiche tecniche

58

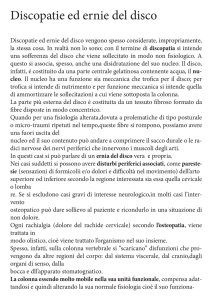

Dischi rigidi

59

I controller IDE e SCSI

59

I dischi fissi

61

Compact Disc

63

Supporti di memoria a registrazione ottica

65

Masterizzatori CD-R

66

Masterizzatori CD-RW

68

Digital Versatile Disk (DVD)

69

Considerazioni finali

70

La standard SCSI

71

MODEM E TELECOMUNICAZIONI

73

Modulazione e demodulazione

73

Protocolli

73

Commutata e ISDN

74

Linee dedicate

74

Caratteristiche tecniche

75

Indipendenti ed a schede

75

Modem/telefax

76

Considerazioni finali

76

Collegamenti a grande distanza

77

SCHEDA DI RETE

79

3

IL MONITOR

80

Monitor CRT

80

Monitor LCD

81

Considerazioni finali

82

Le radiazioni

84

Schermi touch screen

85

Data show

85

Videoregistratore

85

LA TASTIERA

86

Caratteristiche tecniche

86

Considerazioni finali

88

IL MOUSE

90

Mouse senza filo

91

La track ball

92

La touch pad

92

La tavoletta grafica

92

Il joystick

92

LE STAMPANTI

93

Evoluzione delle stampanti

93

Stampanti a matrice di punti

95

Stampanti a caratteri

96

Stampanti a getto di inchiostro (ink-jet)

97

Stampanti laser

98

Altre stampanti a colori

99

La compatibilità

99

Postscript

99

Costi accessori

100

4

Plotter

101

SCANNER E FOTOCAMERE DIGITALI

102

Scanner a ripresa in piano

102

Scanner a rullo

103

Scanner a tamburo

103

Scanner su stativo

104

Scanner manuale

104

Caratteristiche tecniche degli scanner

104

Consigli per l’uso degli scanner

106

La fotocamere digitali

108

I dorsi digitali

110

LA RETE LOCALE

111

Software di rete

112

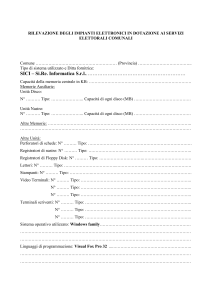

Caratteristiche tecniche

112

Localizzazione delle postazioni

113

Topologia

114

Metodologia

114

Tecnologia

115

Protocollo

115

Sistema operativo di rete

115

Componenti della rete

116

Considerazioni finali

119

5

L’informatica nell’era del personal

L’informatica è la scienza dell’informazione. Ma nessuna definizione è, oggi, più

lontana ed insieme più vicina di questa.

Più vicina perché al suo centro si trova effettivamente l’informazione, non più

concentrata in grosse quantità e dispersa in pochi grandi elaboratori, ma diffusa in

centinaia di milioni di piccoli computer. Ogni personal ha la sua quantità di

informazioni locali, quelle che il suo utilizzatore vi introduce, e può attingere al

complesso delle informazioni, siano esse a livello aziendale tramite la rete locale che

connette i singoli personal fino a formare una entità unica, siano esse a livello

mondiale grazie ai servizi telematici disponibili sempre ed ovunque.

Più lontana perché della scienza ha perso tutta la struttura complessa e da iniziati che

l’aveva permeata sin dall’inizio. Grazie ai nuovi sistemi operativi, chiunque può

avvicinarsi ad un personal ed iniziare ad usarlo senza dover assistere a corsi

introduttivi o seminari di informatica, senza imparare linguaggi di programmazione,

senza dover ricorrere a manuali di centinaia di pagine.

E’ sufficiente il manuale che è a corredo della macchina e quello a corredo di

ciascun programma. Spesso, nel caso di sistemi operativi di tipo grafico, anche quelli

sono quasi superflui, a meno che non si tratti di programmi altamente specializzati.

La gran parte dei programmi attualmente commercializzati per i personal è stata

realizzata con una filosofia “user friendly”, cioè amichevole per l’utilizzatore. Tutti i

comandi disponibili vengono visualizzati sullo schermo, con evidenziati i tasti che li

mettono in opera. I comandi, la loro struttura e, soprattutto, la loro logica di

funzionamento sono comuni fra i diversi programmi. Passare da uno all’altro, per

scrivere una lettera o per aggiornare una situazione fiscale, non provoca più il

disorientamento e gli errori di una volta.

Un personal su ogni scrivania

“Un personal su ogni scrivania”: è questo un sogno che solo 15 anni fa apparteneva

ad uno sparuto gruppo di programmatori statunitensi. Si riunivano in club per

discuterne, dopo il lavoro o dopo lo studio, e per scambiarsi le ultime esperienze.

Alcuni di loro lavoravano in grandi aziende ai progetti per grandi elaboratori per

centri calcolo, mentre a casa armeggiavano intorno ad un piccolo computer costruito

da loro stessi con materiale trovato nei negozi di componenti elettronici di seconda

mano. Alcune volte il piccolo elaboratore, senza alcuna possibilità di utilizzazione

pratica, veniva costruito in qualche diecina di esemplari e venduto agli amici per

pochi dollari.

Nel giro di pochi anni, alcuni di questi appassionati sono diventati proprietari di

aziende informatiche che hanno succursali, stabilimenti di produzione ed uffici

commerciali in tutto il mondo. Il personal computer si è rivelato uno dei settori

industriali più vitali, in più rapida espansione ed evoluzione, in eccezionale

rinnovamento tecnologico.

Tuttavia nella visione di questi giovani appassionati non c’era solamente una

prospettiva commerciale. Anzi, nella maggior parte dei casi l’idea di diventare ricchi

era del tutto impensabile: la loro spinta ideale non era inferiore a quella di tanti loro

coetanei dell’epoca che cercavano di cambiare il mondo.

Era però una visione molto particolare. “Un personal su ogni scrivania” era uno

slogan che non si collegava al fatturato industriale di una azienda produttrice di

6

computer, bensì alla possibilità, per ciascuno, di utilizzare la potenza eccezionale di

un computer nell’archiviare, rintracciare, elaborare le informazioni. In un mondo nel

quale chiunque avrebbe potuto accedere a tutti i dati, a tutte le notizie, a tutte le

informazioni esistenti, scambiarle via telefono con chiunque altro al mondo, far

circolare istantaneamente ed in modo inarrestabile idee ed opinioni, nessun governo

avrebbe potuto opprimere o ridurre le libertà.

Il pericolo che questi appassionati vivevano come ossessione, era costituito dalle

grandi aziende che, in poche, avevano il monopolio dell’informatica. L’incubo era lo

spettro di grossi elaboratori, contenenti informazioni riguardanti la vita privata dei

cittadini, gestiti dai servizi segreti. Avevano capito che l’informazione, nel mondo

moderno, è potere. Lasciarla concentrata in mano ad industriali, politici e militari,

voleva dire lasciargli un immenso potere.

Dopo pochi anni il sogno si è avverato, e si è trasformato in un grande affare da

migliaia di miliardi di dollari.

Ironia della sorte, ne hanno tratto un grandissimo vantaggio quelle stesse grandi

aziende informatiche costruttrici dei grandi elaboratori elettronici che facevano così

tanta paura. Gli stessi piccoli laboratori, impiantati nei garage, sono diventati aziende

multinazionali. Molti di quegli idealisti di 20 anni fa, ora sono multimiliardari e

dedicano parte del loro tempo, o vi hanno dedicato la vita abbandonando il lavoro, ad

attività benefiche ed a fondazioni a scopi sociali.

Struttura logica e fisica dell’informazione

Esistono, tuttavia, alcuni concetti base, in comune con la tradizionale scienza

informatica, da chiarire innanzi tutto.

Nei computer abbiamo due tipi di informazione: il programma (o applicativo) e

l’archivio di dati (o file).

Il programma è costituito da una serie di codici di comando, scritti in un linguaggio

che il computer sia in grado di comprendere. Il linguaggio di programmazione è

altamente sintetico e complesso, ed utilizza le capacità elaborative del computer.

Questo, da parte sua, deve poter comprendere il linguaggio, interpretare ed eseguire i

codici di comando, quindi proseguire nel programma.

Un file è il risultato del lavoro compiuto dall’utente con un programma. L’unità più

piccola dell’archivio è il singolo carattere, lettera, numero e segno che sia.

L’archivio, con tutto l’insieme dei dati che contiene, non è utilizzabile di per se

stesso, se non tramite la presenza di un programma. L’archivio può essere di grosse

dimensioni, come la banca dati fiscale sui contribuenti italiani, oppure piccola, come

la lettera scritta ad un amico.

Questa è la struttura logica dell’informazione, la struttura fisica è invece ben diversa

e si basa sulla natura dell’elettromagnetismo.

Lo stato elettromagnetico della materia può essere solamente positivo o negativo. In

certe sostanze questo stato può essere facilmente alterato, ma una volta stabilito

viene conservato inalterato finché non viene di nuovo mutato da una forza esterna.

L’esistenza dell’informatica è dovuta alla concezione della matematica binaria, per

la quale non esistono dieci numeri, ma due soli: lo zero e l’uno.

Prendiamo alcune porzioni di materia magnetizzabile ed in alcune ne cambiamo lo

stato elettromagnetico in positivo, mentre altre le rendiamo negative. Accettiamo di

definire lo stato positivo come un 1, e quello negativo con uno 0. Ecco che possiamo

esaminare la materia e ricavare degli 1, da quelle porzioni che abbiamo risultano

positive, e degli 0, da quelle che risultano negative.

7

L’informatica degli albori era proprio così: i computer erano costituiti da gigantesche

griglie di anelli metallici collegati da fili. Alcuni erano magnetizzati ed altri no, e la

diversa successione di polarizzazioni dava origine a lunghe sequenze di 0 ed 1 che

rappresentavano i dati.

La forza che magnetizzava gli anelli metallici era il flusso di elettroni dell’energia

elettrica; le diverse polarizzazioni degli anelli erano rivelati dal flusso di elettroni che

la polarizzazione negativa emette e quella negativa no. Tuttavia la polarizzazione

degli anelli non era permanente: esistevano apposite schede, in cartone, nelle quali

venivano praticati dei fori che rappresentavano gli anelli da magnetizzare, chiamate

schede perforate.

La grande rivoluzione dell’informatica, che ha portato alla potenza attuale degli

elaboratori, è dovuta al rapido progresso tecnologico.

Da una parte gli anelli metallici sono stati sostituiti da speciali sostanze chiamate

semiconduttori, che permettono di realizzare con le singole molecole quel

meccanismo di cariche negative e positive che era realizzato con gli anelli.

I vecchi giganteschi circuiti sono ora diventati sottili lamine visibili solo al

microscopio, aumentando in proporzione la quantità di dati che è possibile elaborare.

Questi componenti sono chiamati chip, proprio per essere composti di sottili sfoglie

di semiconduttori.

Dall’altra parte la messa a punto della registrazione magnetica ha permesso di

conservare i dati direttamente in forma magnetica, consentendo una maggiore

capacità di archiviazione e soprattutto l’immediatezza nella fasi di registrazione e di

lettura. Una speciale sostanza, le cui molecole conservano la polarizzazione, è stesa

su una superficie costituita da un nastro o da un disco. In fase di registrazione una

testina elettromagnetica emette un campo elettromagnetico per modificarne la

polarizzazione, in fase di lettura è la stessa testina che ne percepisce la

polarizzazione.

Tuttavia, anche se sono cambiate le dimensioni e le capacità di elaborazione, la

struttura fisica delle informazioni è sempre costituita da cariche negative e positive,

da 0 ed 1.

L’interpretazione binaria

Se le informazioni sono composte da tanti 0 ed 1, manca ancora un passo per arrivare

ai programmi ed agli archivi di dati.

E’ stata una convenzione accettata da tutti quella di attribuire un segno di 0 od 1 alla

carica magnetica di polarizzazione, un’altra convenzione è necessaria perché queste

serie di 0 ed 1 acquistino un senso.

Nella matematica binaria, ad esempio, gli 0 ed 1 hanno una volare non in se stessi,

ma in corrispondenza della loro posto nella serie.

Prendiamo una serie di otto cifre binarie. Gli 0 valgono sempre 0. Gli 1 hanno un

valore a seconda della loro posizione. Al primo posto ha valore 1, al secondo 2, al

terzo 4, al quarto 8, al quinto 16, al sesto 32, al settimo 64 ed all’ottavo 128. Se sono

presenti più 1 in posizioni diverse, i loro valori si sommano.

Se la serie vede un solo 1 al primo posto, il valore totale è 1. Se c’è un 1 al secondo

ed al terzo posto, il valore è 6 (2+4). Se c’è un uno al primo, al secondo ed al terzo

posto, il valore è 7 (1+2+4). Se la serie è composta da tutti 1, il suo valore è 255

(1+2+4+8+16+32+64+128). Se comprendiamo anche il valore 0 di una serie senza

alcun 1, abbiamo un totale di 256 valori.

La convenzione che dobbiamo accettare è la rappresentazione, per ciascuna dei 256

valori, di una lettera, di una cifra, di un simbolo o di un codice. Le attribuzioni dei

8

primi 128 valori sono stabilite da un codice valido per tutti i computer, l’American

Standard Code for Information Interchange, chiamato ASCII, mentre i

successivi 128 sono lasciati alla definizione del singolo sistema operativo.

Nel codice ASCII, ad esempio, la lettera A maiuscola è rappresentata dal valore 65

(cifra binaria 10000010=1+64), la B dal valore 66 (01000010), la C dal valore 67

(11000010). Il numero 0 è attribuito al valore 48 (00001100), il numero 2 al valore

49 (10001100). La virgola è rappresentata dal valore binario 44, il punto dal valore

46 e così via.

I valori superiori al 128 rappresentano lettere o simboli speciali, come le lettere

accentate o i caratteri grafici. Le attribuzioni di questi valori cambiano anche per

permettere alle diverse entità linguistiche di inserire le proprie particolarità.

Bit e byte

Nel gergo informatico la singola cifra binaria, di valore 0 od 1, viene chiamata bit.

La serie di otto cifre binarie, quindi di otto bit, che da origine ai 256 valori, viene

chiamata byte. Un bit può valere 0 od 1, mentre un byte può valere da 0 a 255.

Come si è visto dal codice ASCII, ogni lettera, numero o simbolo viene

rappresentata da un singolo byte.

Tutte le informazioni, sia i dati che i programmi, vengono registrati, letti ed

elaborati, sotto forma di byte. E’ questa la più piccola entità informatica, pur essendo

anch’essa suddivisa in otto bit, cioè in otto impulsi magnetici.

Ma la complicazione si espande ulteriormente quando si legge che alcuni computer

lavorano a 8 bit, altri a 16, altri a 32. Si vuole semplicemente dire che il computer

può considerare sia dati formati dal singolo byte, sia dati più grandi.

In molti campi la limitazione a 256 valori non era sufficiente. Ad esempio nella

grafica a colori. Assegnando un colore a ciascun byte si ottengono solo 256 colori,

molto al di sotto delle esigenze grafiche professionali. Un computer che lavori con

una scheda grafica a 24 bit è in grado di considerare gruppi di 24 bit come se fossero

un valore unico, ottenendo così 16’777’216 colori diversi. In realtà i 24 bit formano

tre byte, ma ciò vale solo per la struttura dell’archivio nel quale i dati vengono

conservati. I tre byte, una volta letti dalla testina, diventano un solo valore ed un solo

colore.

9

Ecco le definizioni di bit e byte:

elemento base binario: è uno 0 od un 1

otto bit formano un byte, quindi otto elementi binari: da 00000000 a

11111111, valori binari che esprimono 256 numeri decimali

due byte, quindi 16 bit, formano una word. Composta da 16 elementi

word

binari, rappresenta 65’536 numeri decimali

address tre byte, quindi 24 bit, formano un address. Composto da 24 elementi

binari, rappresenta 16’777’216 numeri decimali

quattro byte, quindi 32 bit, formano una long word. Composta da 32

long

elementi binari, rappresenta 4’294’967’296 numeri decimali

word

Bit

Byte

Tutte queste definizioni possono essere immediatamente dimenticate, visto che

nessun utilizzatore di personal dovrà mai effettuare calcoli binari. Sono state qui

riportate solo per comprendere la struttura fisica delle informazioni e per evidenziare

la differenza fra 8 bit e 32 bit.

Essendo quella binaria una matematica che opera in modo diverso dalla normale

matematica decimale, 32 bit non sono quattro volte più di 8 bit, bensì 16’777’216

volte di più.

Byte, Kilobyte e Megabyte

Questo per quanto riguarda la composizione dei dati. La dimensione degli archivi

viene, invece, misurata con altre unità di misura.

Si parte sempre dal singolo byte, formato da otto bit. Il multiplo superiore, nella

scala di misura, è il Kilobyte, ovvero un byte moltiplicato per mille. Ma poiché i dati

devono sempre essere registrati, letti ed elaborati per multipli di otto, un Kilobyte è

composto da 1.024 bytes. Si abbrevia in Kb.

Il multiplo ancora superiore è il Megabyte, pari a 1.024Kb. Si abbrevia in Mb ed

equivale ad un milione di byte, anzi a 1.048.576 byte.

Si sale poi al Gigabyte, pari a 1.024Mb, cioè a 1.048.576Kb, oltre un miliardo di

byte, abbreviato in Gb.

Questa scala di misura serve a definire la capacità di memoria di un computer, di

archiviazione di un disco, di lunghezza di un documento o di un archivio.

La memoria attuale dei personal computer oscilla fra 1 ed 8 Megabyte, con

possibilità di ulteriore espansione. La capacità di un dischetto si misura in qualche

centinaia di Kilobyte, quella di un disco rigido in decine o centinaia di Megabyte.

byte

Kilobyte

Megabyte

Gigabyte

Kb

Mb

Gb

Kb

1.024

1.048.576

1.073.741.824

Mb

1

1.024

1.048.576

1

1.024

10

La rappresentazione esadecimale

Vengono citati spesso, nell’informatica, i numeri esadecimali. In realtà i computer

lavorano esclusivamente in numeri binari. Per comodità i programmatori usano

rappresentare sia i numeri decimali (con 10 cifre) che i numeri binari (con due cifre)

con numeri esadecimali.

Questi hanno sedici cifre: le dieci cifre da 0 a 9 e quindi le sei lettere da A a F. Lo 0

esadecimale equivale al valore decimale 1 mentre la F esadecimale equivale al valore

decimale 16.

L’avere inventato una rappresentazione dei numeri usando 16 cifre, rende i numeri

più compatti. Già il numero decimale 100, rappresentato dal binario 0010110, in

esadecimale è 64.

Dal punto di vista dell’utente, ciò non ha alcuna rilevanza.

L’informatica nell’era del personal è molto più semplice e pratica. Del resto, lo

scopo degli inventori del personal non era di portare l’informatica a tutti, ma di

portare le informazioni a tutti.

11

Il personal computer

Esistono tipi diversi di personal computer, ed ognuno risponde ad una diversa

esigenza di lavoro:

desktop

portatili

notebook

penbook

palmtop

Desktop

I computer desktop sono i classici personal, che trovano posto sopra una scrivania e

che sono utilizzati nell’ordinario lavoro. Sono formati da una unità centrale, delle

periferiche aggiuntive, solitamente tastiera, mouse e monitor, e da una serie di

dispositivi come stampanti, lettori di Compact Disc, plotter, modem. Queste ultime

sono attrezzature addizionali, aggiungibili secondo le esigenze. Sono periferiche di

Input e di Output.

Le periferiche di Input sono quelle periferiche che permettono di inserire dei dati

all’interno del computer (tastiera e mouse, ma anche scanner, webcam, fotocamere,

microfoni).

Le periferiche di output sono quelle periferiche che permettono di ottenere i risultati

dell’elaborazione del computer, cioè monitor, stampanti, casse audio, proiettori…

L’unità centrale si presenta quasi sempre come un parallelepipedo di colore chiaro,

con qualche lucetta di segnalazione e tante fessure per la scambio dell’aria. Sul retro,

in genere, vi sono delle viti o dei ganci che permettono di sollevarne il coperchio.

A patto che la spina, per prudenza, sia staccata, possiamo aprire l’unità centrale. Il

parallelepipedo si rivela essere vuoto almeno per metà del volume. Esaminiamo gli

elementi che vi troviamo.

In un angolo, in corrispondenza con la presa di alimentazione, c’è il trasformatore. Il

computer consuma pochissima energia elettrica, ed a basso voltaggio. Il

trasformatore è racchiuso in una gabbia di metallo.

Accanto troviamo il drive per i dischetti rimovibili in corrispondenza della fessura

per inserirli e, sotto o di fianco, il disco rigido. Anche essi sono spesso rivestiti da un

guscio di metallo.

Sotto a tutto, coprendone l’intera estensione, un circuito stampato con numerosi

componenti elettronici: è l’elemento più importante del computer e si chiama scheda

madre.

Direttamente saldati sulla scheda madre, oppure inseriti in essa, troviamo:

microprocessore

12

clock

memoria RAM

interfaccia grafica per il video

una o più interfacce per il collegamento delle periferiche

connettori, chiamati slot, per l’inserimento di schede aggiuntive

Sul retro dell’unità centrale abbiamo una serie di connettori, per il video, la tastiera,

per periferiche come stampanti o mouse. Abbiamo anche alcuni spazi vuoti per

inserire altri connettori.

All’unità centrale vengono collegati tutti gli altri elementi del computer, comprese

tutte le periferiche successivamente aggiunte.

Il desktop è il computer ideale per il quotidiano lavoro d’ufficio. Lo rendono tale la

grandezza e la leggibilità del monitor, la capacità di espansione di memoria fino a

molti Megabyte e la possibilità di ospitare unità di registrazione dalle capacità

ingenti. La presenza di numerosi connettori lo rende disponibile al lavoro con

apparecchiature periferiche esterne sia come gestore delle stesse che come

raccoglitore dei dati.

Portatili

I computer portatili sono molto più compatti. La caratteristica essenziale è quella di

riunire in un solo corpo sia la scheda madre che l’unità a dischi, sia la tastiera che il

video. Quest’ultimo è di tipo speciale, generalmente a cristalli liquidi, ma comunque

di ridottissimo ingombro.

Altra particolarità del computer portatile è quella di avere un accumulatore interno

che consente di lavorare in modo autonomo, senza necessità di allacciarsi alla rete

elettrica. Naturalmente questo accumulatore ha una durata limitata, il cui periodo di

tempo è determinato, più che dall’accumulatore stesso, dai risparmi di consumo che i

circuiti del personal consentono. Una buona ingegnerizzazione dei circuiti e l’uso di

componenti a basso consumo, possono consentire un uso anche di alcune ore.

Il computer è dotato di un coperchio, aprendo il quale appaiono lo schermo, sul retro

del coperchio, e la tastiera. Anch’essa è sacrificata, spesso i tasti sono piccoli e

manca il tastierino numerico.

All’interno del computer, la scheda madre è affollatissima, e lo spazio per schede

aggiuntive è limitato o inesistente. I connettori esterni sono limitati a quelli

strettamente necessari, anche se alcuni portatili sono dotati di una presa del segnale

video per poter collegare un monitor normale esterno.

Esternamente, chiuso, un computer portatile somiglia ad una macchina da scrivere

portatile, compresa la maniglia estraibile. Il suo peso si aggira sui 6 chili.

Ha rappresentato una svolta nel personal, in quanto l’ha reso effettivamente

trasportabile. Dotato di disco rigido, il portatile può realmente costituire un pezzo di

ufficio che ci segue. L’autonomia, pure se limitata nel tempo, rende possibile il

lavoro in qualsiasi ambiente. E’ frequente vedere computer portatili nelle sale di

attesa degli aeroporti, sia nazionali che internazionali, anche se in realtà l’uso a

bordo sarebbe vietato dalle norme internazionali di volo e, comunque, nessun

portatile è in grado di lavorare per tutta la durata di un volo dall’Italia agli USA.

I portatili sono utili anche per chi, professionalmente, deve svolgere parte del lavoro

13

fuori del proprio ufficio. Grazie al portatile ingegneri, giornalisti, avvocati e

rappresentanti di commercio possono utilizzare il computer in ogni occasione.

Notebook

Come dice il nome, questi computer hanno la stessa grandezza di un blocco note: 21

centimetri per 30. Ma non la stessa funzione, infatti sono computer personal a tutti

gli effetti e sono in grado di eseguire tutti i programmi dei computer desktop o

portatili.

Alcuni modelli sono privi del disk drive per dischetti, e lo scambio di dati con un

altro computer può essere effettuato esclusivamente tramite cavo.

Lo schermo è identico a quello dei portatili, ma tutto il resto è di dimensioni ancora

più ridotte. La tastiera è priva del tastierino numerico: questo può essere attivato

all’interno della stessa tastiera tramite uno speciale tasto.

Nel lavorare con un notebook si devono accettare dei compromessi con la comodità,

ma in cambio la praticità di questi computer è eccezionale. Piccoli, dal peso di circa

3 chili, possono essere portati comodamente in una valigetta 24 ore od anche in una

cartella portadocumenti.

Pen book

Un penbook è un notebook senza tastiera. E’ dotato di speciali programmi che ne

permettono l’uso grazie ad un apposito stilo a forma di penna.

La penna non è utilizzata solamente per impartire comandi ai programmi, a

somiglianza di quanto si può fare con il mouse dei desktop, ma anche per inserire

dati. Sullo schermo del penbook si può scrivere, esattamente come su un foglio di

carta, ed il computer interpreta la scrittura e la converte in caratteri di testo come se

fossero digitati con la tastiera.

Si tratta di un tipo di computer ancora in evoluzione. I sistemi operativi sono in via

sperimentale, così come i programmi. La fase di interpretazione della scrittura

manuale è ancora alquanto lenta e soggetta ad errori, mentre altri aspetti del

funzionamento sono più avanzati.

Ad esempio, la correzione e la modifica del testo già inserito avviene con modalità

molto innovative e molto simili al comportamento istintivo dell’utilizzatore. Se una

parola deve essere cancellata, basta tracciarvi sopra una croce con la penna. Per

inserire una parola od un carattere, basta tracciare una barra nel punto esatto. Per

cambiare “male” in “mele” si deve tracciare una croce sulla “a” e quindi scrivervi

sopra la “e”.

Palmtop

Il palmtop è un computer grande quanto una videocassetta.

Non bisogna confondere il palmtop con le agende o le calcolatrici tascabili. Sia le

prime che le seconde possono, in alcuni casi, scambiare dati con un personal, ma non

sono dotati né di sistema operativo né di programmi standard.

Il palmtop è un computer a tutti gli effetti. Non effettua calcoli o gestisce agende se

non con un programma apposito, mentre può elaborare o modificare documenti

esattamente come una desktop.

Le dimensioni ridottissime si ripercuotono su tutte le parti del computer. Lo schermo

14

a cristalli liquidi è ridottissimo, così anche la tastiera, i cui tasti sono minuscoli. Il

disco rigido è del tutto assente, e la registrazione dei dati avviene grazie a memorie

contenute in schedine autoalimentate. Lo scambio di dati con un desktop è possibile

solamente attraverso un cavo.

Il palmtop non serve certo come strumento principale di lavoro. Può essere utilizzato

per la consultazione di dati, o l’aggiornamento degli stessi. Si possono stilare alcune

annotazioni, ma scrivere una lettera diventa quasi impossibile e molto faticoso a

causa delle dimensioni dei tasti.

Gli altri computer

Il personal computer ha anche dei fratelli maggiori:

workstation

minicomputer

mainframe

supercomputer

Le workstation sono computer di uso individuale, dalle dimensioni e dell’aspetto di

un desktop o poco più grandi. Sono dotati di processori più evoluti, di maggiore

capacità di memoria e di archiviazione .

Le workstation sono adatte a svolgere compiti specializzati, spesso nel campo della

grafica, della progettazione, del disegno tecnico, dell’ingegneria. Si tratta di

applicazioni complesse, che richiedono una potenza ed una velocità che sarebbero

sproporzionate per il normale lavoro d’ufficio. Il costo di queste macchine,

d’altronde, è molto superiore a quello dei personal.

I minicomputer sono elaboratori ancora più potenti. Essi sono posti al centro di una

rete di terminali, ognuno dei quali lavora con il minicomputer come se fosse un

computer isolato, ma condividendo sia i dati che le apparecchiature di stampa, che

gli stessi programmi.

Tipica dei minicomputer, infatti, è la possibilità di avere un solo programma che

viene utilizzato in contemporanea da più terminali. Sono elaboratori particolarmente

utilizzati in ambito amministrativo aziendale, dove la condivisione dei programmi e

dei dati è un fattore essenziale: tutti possono lavorare con le stesse procedure ed i

dati possono essere aggiornati in tempo reale.

I mainframe sono su un gradino ancora superiore. Questi elaboratori possono essere

utilizzati da moltissimi terminali, anche a distanza tramite collegamenti telematici.

Possono conservare numerosi archivi di dati e mandare in esecuzione molti

programmi contemporaneamente.

Sono utilizzati nell’ambito di grosse aziende per la gestione industriale vera e propria

od in organismi statali per l’elaborazioni di grossi archivi di dati sempre in

evoluzione. Costituiscono il nucleo centrale dei servizi informativi delle banche,

degli istituti finanziari e delle borse. Sono anche impiegati dai servizi telematici

pubblici e privati perché permettono il collegamento contemporaneo di molti

terminali o computer e l’esecuzione veloce delle rispettive transazioni.

I supercomputer sono abbastanza rari. Il loro costo è molto alto e vengono utilizzati

nella progettazione industriale e nell’elaborazione di dati ad altissimo livello. Oltre

alle multinazionali, i supercomputer sono impiegati da organismi statali ed

15

organizzazioni militari.

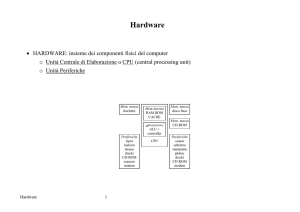

Hardware e software

Altre definizioni sono molto comuni:

hardware

software

L’hardware è costituito da tutte le componenti materiali del computer. E’ la parte

fisicamente esistente, dall’unità centrale al monitor, dalla tastiera all’alimentatore, al

disco, ai microprocessori, ai chip di memoria.

Il software è composto dai programmi che fanno lavorare il computer. Una piccola

parte di questo è già compreso in alcune memorie all’interno del computer, e viene

chiamato firmware. Tutto il restante è registrato su disco e viene letto e caricato in

memoria dal computer per essere eseguito.

16

Come scegliere un personal computer

Quello che il computer deve fare, è di risolvere i vostri problemi, soddisfare le vostre

necessità e migliorare i vostri risultati. Il che vuol dire, in sintesi, rendere più piacevole la

vita e lo stesso lavoro.

Il computer non deve essere una complicazione in più in un lavoro già complicato. Deve

sciogliere i nodi organizzativi, deve rendere migliore lo scambio di informazioni, più veloce

il disbrigo della routine. Il computer è la soluzione ideale dove vi sia una grande quantità di

dati da gestire, dove il lavoro debba essere veloce ed accurato, dove le procedure sono

ripetitive.

Esaminiamo la situazione:

pensate che il vostro lavoro migliorerebbe con un computer?

quello che vi farà guadagnare è superiore alla spesa che affronterete?

Ammettiamo che abbiate dato una doppia risposta positiva, considerando anche che

vi sono guadagni non immediatamente percepibili, come una maggiore efficienza ed

accuratezza nel lavoro o il tempo risparmiato. Nei costi, però, vanno considerati i

materiali di consumo come i dischi, i nastri od i toner per le stampanti.

Passiamo a porci altri interrogativi:

- il computer deve svolgere un compito ben preciso oppure deve essere adatto a

più applicazioni?

Di solito un computer viene acquistato già con un obiettivo ben preciso, come tenere

la contabilità, oppure in sostituzione della macchina da scrivere. In questo caso è

necessario commisurare bene le caratteristiche del computer da acquistare alle reali

necessità. Inutile farsi affascinare dalle possibilità grafiche di una potente scheda

video quando il lavoro principale consiste nell’immettere i dati di fatturazione.

Oppure il contrario: acquistare, per realizzare comunicati stampa, un computer che è

incapace di lavorare con complesse impaginazioni di testo ed immagini.

Questo interrogativo coinvolge la scelta di un computer secondo il suo

microprocessore, la scheda video, la velocità.

- quali sono le necessità di elaborazione e di archiviazione?

In parole povere: qual’è la dimensione dell’archivio di dati che volete gestire e, dato

ben diverso, quanti di questi dati devono essere elaborati con una stessa operazione?

La grandezza totale dell’archivio coinvolge la scelta delle dimensioni del disco

rigido interno al computer, la quantità di dati da elaborare coinvolge il

microprocessore, la velocità, la configurazione di memoria.

Archivio totale e dati da elaborare sono due entità differenti. E’ ben più semplice

cercare il nome “Baldovinetti” fra diecimila nominativi, che selezionare fra

cinquemila ragioni sociali tutte le ditte che abbiano fatturato superiore a 100 milioni,

che producano estintori, che siano in provincia di Milano e quindi disporle in ordine

di Codice di Avviamento Postale. Nel primo caso l’archivio è più grande, ma la

ricerca richiede meno elaborazione; nel secondo l’archivio è più piccolo, ma la

ricerca coinvolge molti parametri da considerare contemporaneamente. Nel secondo

caso la richiesta di memoria e di velocità sarà molto maggiore.

17

- quali sono le necessità di accesso ai dati?

Si deve stabilire se i dati possono risiedere in archivi separati o devono essere

sempre facilmente accessibili. Certi dati hanno una scadenza determinata, come le

registrazioni fiscali, che possono essere conservare a parte anno per anno e ben

raramente dovranno essere consultate.

Questo interrogativo coinvolge il tipo e la dimensione del disco rigido, oltre al tipo

di dispositivo utilizzato per la registrazione delle copie degli archivi. Può rendersi

necessario l’installazione di un dispositivo di memoria di massa di grandi

dimensioni, come un lettore di dischi ottici.

- quali sono le necessità di uscita dei dati?

Potrebbe essere necessaria la stampa in modo accurato, oppure semplicemente delle

stampe di bassa qualità. Può essere necessario elaborare i dati in forma grafica, a

colori, e realizzare diapositive o lucidi per proiezioni. Queste esigenze influiscono

sulla scelta delle periferiche di stampa e sulla capacità del computer di gestirle

correttamente.

- è necessaria la condivisione di dati con altri computer?

Se le postazioni di lavoro sono più di una, potrebbe agevolare molto il lavoro di tutti

se l’archivio principale fosse in comune, accessibile e modificabile

contemporaneamente.

Questa scelta coinvolge la creazione di una struttura in rete, con consequenti scelte

sulla configurazione di memoria e sulla velocità dei computer.

- come avviene l’introduzione dei dati?

I dati possono essere introdotti tramite tastiera, oppure tramite penna ottica, tramite

collegamento telematico, tramite Compact Disc, tramite dischetti. La tastiera è in

dotazione ad ogni computer, ma gli altri dispositivi richiedono installazioni

particolari. Sono sufficienti i connettori interni per le schede di interfaccia? La

velocità del computer è sufficiente? Nel caso che ci si aspetti un ingresso di dati

tramite dischetti, sarà necessario procurarci il giusto disk drive per tutti i formati di

disco più comuni.

- chi è l’utilizzatore del computer?

Possiamo distinguere fra utilizzatore esperto, regolare o casuale. Mentre il primo può

essere in grado di usare qualsiasi tipo di computer, il secondo ma soprattutto il terzo

hanno bisogno di un computer che abbia un sistema operativo e dei programmi che

richiedano un minimo addestramento. Acquista maggiore importanza il servizio che

il rivenditore è in grado di fornire. Può effettuare tutta l’installazione ed il collaudo?

Può tenere un breve corso? Può seguire il lavoro nei primi mesi? Può effettuare

rapidamente la diagnosi dei malfunzionamenti ed identificare le cause in modo da

evitare lunghi immobilizzi della macchina non dovuti a veri e propri guasti?

Qualora non vi sia un utente esperto, questo tipo di servizi devono diventare parte

essenziale nella scelte di un computer.

- cosa succederebbe se il lavoro del computer venisse improvvisamente

interrotto?

Pur senza essere pessimisti ad oltranza, bisogna sempre considerare l’eventualità di

un guasto od un incidente al computer, al disco, al monitor o ad una periferica. Se il

lavoro che il computer svolge è di importanza vitale, è necessario che i dati non

risiedano in un solo disco ma che si effettuino regolari e frequenti copie di riserva e

che queste vengano conservate in un luogo sicuro.

Ciò coinvolge l’acquisto di apposite unità di registrazione a nastro, di eventuali

18

doppie periferiche o di un secondo computer dalle prestazioni inferiori a quello

principale ma in grado di sostituirlo per breve tempo.

- cosa succederebbe se i dati dell’archivio fossero distrutti, alterati o rubati?

Si profila qui l’ipotesi di un intervento doloso. Esistono strumenti per evitarlo, anche

se non del tutto. La perdita dell’archivio, ad esempio, può essere evitata

dall’installazione di una particolare scheda che effettua una copia compressa di tutti i

documenti su un disco rigido supplementare.

Questo interrogativo può interessare pochi casi, ma in quelli è importantissimo. E’

anche importante non sopravvalutare questa minaccia, per evitare rallentamenti ed

ostacoli nel lavoro quotidiano o che le stesse precauzioni si rivelino

controproducenti.

Ora, avendo elencato una serie di necessità, è possibile recarsi in un negozio e

chiedere un computer con caratteristiche ben precise. Non è per cattiva volontà o per

malizia da parte del negoziante se a volte l’acquirente è scontento dell’investimento

effettuato. Spesso ciò si verifica perché l’acquirente stesso non sapeva quello di cui

aveva bisogno.

19

La casistica degli acquisti errati vede:

computer sottodimensionato rispetto al lavoro da svolgere e quindi

nell’impossibilità di portarlo a termine;

computer sovradimensionato e quindi sottoutilizzato;

computer in configurazione errata, che rende impossibile o disagevole il

lavoro;

periferiche inadeguate alle necessità, che ostacolano il lavoro;

computer inutilizzato, perché non ve ne era l’effettiva esigenza.

Oltre alla necessità di provvedere ad un nuovo acquisto, devono essere considerati i

danni diretti ed indiretti che che l’errato acquisto ha provocato. La perdita di tempo,

ad esempio, ma soprattutto l’eventuale discredito procurato dai ritardi e dalle

inadempienze.

20

L'organizzazione delle informazioni

Dopo i primi anni del personal computer, nel quale scarseggiava sia la memoria che

lo spazio su disco, con l'avvento dei dischi rigidi ad alta capacità e delle memorie

RAM a prezzi contenuti, la quantità delle informazioni che un computer può

archiviare ed elaborare è cresciuta a dismisura.

I primi personal professionali venivano venduti con una RAM di 128Kb ed

utilizzavano dischetti da 160Kb, ma fra le macchine hobbystiche non erano rari i

32Kb od i 64Kb di RAM e l'archiviazione su audiocassette. Oggi in campo aziendale

si parla comunemente di macchine con 4Mb, 8Mb o 32Mb di RAM, di dischi rigidi

di 160Mb, 320Mb o 640Mb. Ma anche un ordinario disco rigido da 40Mb contiene

tanti dati quanti ne potrebbero contenere 250 dischetti da 160Kb.

Ecco che si pone il problema di come fare in modo che un nostro documento, magari

vecchio di qualche mese, all'improvviso diventato importante, urgente da

rintracciare, sia disperso in mezzo ad una mole di migliaia di altri documenti. I primi

sistemi operativi registravano i file tutti insieme. Dando il comando che elencava il

contenuto del disco, ecco che apparivano sullo schermo dieci, venti, trenta...

cinquanta o sessanta file.

Fin qui niente di male, a patto di avere un po' di pazienza. Ma quando sono arrivati i

dischetti da 720Kb o da 800Kb e la tecnologia ha permesso di costruire dischi rigidi

da 10Mb che costavano le metà di quelli da 5Mb, i sistemi operativi sono stati

aggiornati con quello che venne chiamato Hierarchical File System, cioè un sistema

gerarchico che permettesse di creare una struttura dei dati registrati su disco, di

organizzarli in modo logico e, soprattutto, di poterli rintracciare facilmente.

Facciamo un salto indietro di qualche anno. Dobbiamo immaginare il disco rigido

del nostro computer come uno di quei vecchi armadi che fungevano da archivio negli

scantinati degli uffici pubblici. Decine e decine di metri di scaffalature alte fino al

soffitto. Su ogni scaffalatura una serie di cartelle con il laccio, all'interno delle quali

sono strette un certo numero di cartelline in cartoncino e dentro a queste ultime sono

conservati i documenti.

Come fare per ritrovare la lettera inviata al signor Gualtiero Rossi della omonima

ditta? Semplice. L'usciere consulta il suo schedario e vi da le indicazioni giuste:

andare alla fila M, trovare il settore 13, salire al ripiano 5, aprire la cartella

"M/13/5/10", prendere la cartellina con sopra scritto "Pratica Ditta Rossi Gualtiero",

aprirla e leggere la lettera siglata "M/13/5/10/prot. Rossi/75A".

Senza l'usciere e senza il suo schedario, l'esito della ricerca sarebbe stato

probabilmente negativo, oltre a farci sprecare un considerevole periodo di tempo a

cercare su scaffali impolveratissimi. Se poi non si fosse nemmeno usato un sistema

di numerazione per le file, i settori, i ripiani e le cartelle, sarebbe stata certamente

un'impresa vana.

Il sistema operativo è un usciere sempre efficiente, mentre lo schedario infallibile è ll

nostro stesso disco il quale contiene, non solo i dati, ma anche il loro elenco.

I diversi sistemi operativi, pur con lo stesso fine e con lo stesso risultati, hanno scelto

similitudini differenti per descrivere il proprio sistema di archiviazione. Nel DOS

viene chiamato ad albero, nel MacOS si parla di cartelline.

Il DOS crea un archivio centrale e principale del disco, detto root directory. In questa

radice sono depositati i file principali del sistema, e da qui dipartono le diversi

componenti dell'albero, ognuna dei quali chiamato subdirectory. Ciascuna

21

subdirectory può contenere files di dati o programmi, ma soprattutto può dare origini

ad altre ramificazioni, ad altre subdirectory.

Le subdirectory rappresentano i settori, i livelli, le cartelle e le cartelline del nostro

immaginario archivio. Si possono creare fino a 512 subdirectory nella root directory,

e fino 512 subdirectory in ciascuna subdirectory. Riandando al nostro esempio,

l'archivio può avere 512 scaffalature, ognuna suddivisa in 512 settori, ciascuno con

512 livelli, ognuno dei quali con 512 cartelle che contengono 512 cartelline che

contengono 512 cartelline che contengono 512... un bel po' di spazio!

Il Mac/Os mostra visivamente, all'interno del disco rigido, oltre ai file di dati ed ai

programmi, della cartelline. All'interno di queste cartelline, una volta aperte,

troviamo altre cartelline, insieme ai file, ed ancora altre cartelline. La suddivisione

consentita dal Mac/Os in cartelline non ha limite, se non quello fisico del disco.

Con tutte queste scaffalature, cartelle e cartelline, se l'usciere non è in gamba,

schedario fatto con cura e l'organizzazione delle scaffalature ben fatta, abbiamo

buone probabilità di non riuscire più a trovare la lettera alla ditta Gualtiero Rossi.

L'usciere, non c'è dubbio, è abile e sveglio: è il sistema operativo; e sullo schedario

non abbiamo problemi: lo gestisce il sistema direttamente sul disco. I guai iniziano

per l'organizzazione delle scaffalature.

Si, perché qui dovete provvedere voi.

Una strategia per l'organizzazione

La migliore organizzazione del disco è quella che corrisponde ad una suddivisione

logica. Se esiste uno schema ben chiaro, la ricerca di un file sarà facilitata. Non sarà

necessario ricordare a memoria esattamente la path, ma basterà ricostruirla secondo

logica.

Sono due le alternative. Possiamo suddividere i file secondo la natura del programma

con cui abbiamo creati, oppure possiamo raggrupparli per argomento.

Nel primo caso avremo tante subdirectory quanti programmi utilizziamo, ed al suo

interno altre eventuali subdirectory più specifiche. Ecco un esempio:

Disco rigido

|

|-- WORDPROC

| |

| |-- LETTERE

| |-- BOZZE

| |-- RELAZIONI

| |-- CIRCOLARI

| |-- APPUNTI

|

|-- DATABASE

| |

| |-- IND CLIENTI

| |-- IND FORNITO

| |-- MAGAZCARIC

| |-- MAGAZSCARIC

| |-- MAGAINVENTA

|

|-- SPREADSH

| |

22

|

|

|

|

|

|

|

|-- FATTURE

|-- PRIMA NOTA

|-- CONTOCORREN

|-- REGIRPEG

|-- REG.IVA

|-- RIT.INPS

|-- RIT.IRPEF

Questo tipo di struttura prevede una subdirectory per i file di word processing, una

per gli archivi del data base ed una terza per i fogli di calcolo dello spreadsheet.

All'inizio questo tipo di gerarchia funziona bene. E' facile trovare un documento,

basta ricordarsi con quale programma è stato realizzato e cercare nell'apposita

subdirectory.

Ci sono però due controindicazioni.

I documenti correlati sono distanti fa loro. Le lettere ai clienti, i listini di vendita, il

data base con le etichette, il conto delle vendite sono sparsi per tutto il disco.

Alcuni documenti vengono elaborati con più programmi. Bisognerà decidere e poi

ricordarsi quale dei due è preminente.

Ed ecco un esempio di organizzazione per argomento:

Disco rigido

|

|-- CLIENTI

| |

| |-- LETTERE

| |-- FATTURE

| |-- AVVISI

| |-- SOLLECITI

| |-- ETICHETTE

|

|-- FORNITORI

| |

| |-- LETTERE

| |-- PAGAMENTI

| |-- AVVISI

| |-- ORDINI

| |-- ETICHETTE

|

|-- CONTABILITA

| |

| |-- FATTURE

| |-- PRIMNOTA

| |-- CONTOCORREN

| |

| |-- RITENUTE

| | |-- INPS

| | |-- IRPEF

| | |-- DICHIARAZIO

| |

| |-- REGISTRI

| | |-- IRPEG

23

| | |-- IVA

|

|-- MAGAZZINO

| |

| |-- CARICO

| |-- SCARICO

| |-- INVENTARIO

Con questa impostazione è più facile rintracciare documenti correlati, come una

lettera ed il listino che vi abbiamo allegato, ma è più complessa la struttura che

diamo al disco, e quindi più complicata la ricerca.

Non esiste una organizzazione ideale dei file. L'importante è che corrisponda al

vostro modo di lavorare, alla vostra logica. Immaginatevi di ritornare, dopo un mese

di vacanze, davanti al vostro computer. Dovreste essere in grado di orizzontarvi

perfettamente tra le subdirectory come farete fra le stanze di casa vostra.

Può anche capitare che, in vostra assenza, un vostro collega abbia la necessità di

lavorare con il vostro computer. La vostra organizzazione non deve essere troppo

astrusa, quindi, ed il vostro modo di denominare le subdirectory ed i documenti deve

essere il meno criptica possibile.

E' necessario fare molta attenzione alla denominazione dei file, al loro spostamento

ed alle copie, per evitare che un nuovo file ne cancelli uno vecchio perché ne ha lo

stesso nome. Una caratteristica di tutti i sistemi operativi, infatti, è quella di non

consentire che due file, all'interno della stessa subdirectory, o cartellina, abbiano lo

stesso nome. Ed è logico, visto che il sistema operativo non ha alcun sistema per

distinguerli se non con il nome.

Tuttavia i sistemi operativi etichettano il file, alla creazione od alla modifica, con la

data e l'ora corrente. Quasi sempre è lo stesso sistema operativo che informa l'utente

di queste date quando viene chiesto l'elenco dei file, oppure quando si effettua una

spostamento di un file in una cartellina che già contiene un file con lo stesso nome.

Ma se questo può servirci per identificare un file, o per sapere quale delle due

versioni di uno stesso documento sia la più recente, non può permettere la

coesistenza di due file con lo stesso nome, anche se creati o modificati in data

diversa. Si tratta di una scelta fondamentale e strategica, perché altrimenti il

computer continuerebbe a registrare senza mai sostituire. Tutte le versioni che

registriamo di una lettera via via che la scriviamo, la correggiamo, la modifichiamo,

esisterebbero ancora tutte insieme provocando confusione e riempendo in breve

tempo anche il disco rigido più capace.

Il suggerimento che ci da il sistema operativo è il più banale. Se vogliamo avere

versioni diverse di uno stesso documento, basta registrarle con nomi diversi. Basta

aggiungere un "1" od un "2", un "bis", o proprio un altro nome.

In ogni caso dovremo attribuire un nome ad un file in modo che possa essere

facilmente identificato, che non possa creare equivoci sulla sua identità o con altri

documenti. Chiamare "Giovanni" una relazione al vostro capoufficio può anche

andare bene, ma non se lui si chiama Vittorio. Registrare come "Lettera" una lettera,

"Bozza" una bozza ed "Appunto" un appunto, vuol non sapere più di cosa si tratta,

ma soprattutto cancellarlo al primo documento dello stesso tipo (e con lo stesso

nome) che si crea.

Purtroppo alcuni sistemi operativi, come il DOS, hanno delle limitazioni di

lunghezza nel nome dei file. Il DOS permette solo undici lettere. Solo otto, però,

24

costituiscono il nome vero e proprio, mentre le altre tre, chiamate estensione e

separate dalla prima parte da un punto, vengono spesso riservati al programma con il

quale avete generato il documento.

Eccoci allora tentati di sintetizzare. Nascono nomi come "LettaMil", come

"RelazCap", come "DicIrpMi", che possono portare ad equivoci se non si sono

precedentemente organizzati in una buona struttura gerarchica. "LettaMil" potrebbe

essere una lettera alla filiale di Milano se nella subdirectory "FiliaMilano", ma anche

una lettera a Milena se nella subdirectory "Personale".

L'organizzazione delle informazioni nel vostro disco rigido deve:

consentire l'immediata catalogazione di un documento, senza nutrire dubbi su

quale subdirectory lo debba ospitare;

facilitare la ricerca di un documento anche a distanza di tempo e fra

documenti simili;

corrispondere al modo personale di organizzarsi l'ambiente di lavoro, per una

maggiore efficienza;

permettere anche ad altri utenti di lavorare;

evitare equivoci fra documenti dal nome uguale o simile.

I nomi dei file devono:

esprimerne sinteticamente il contenuto;

impedirne la cancellazione durante la copia o gli spostamenti;

essere ben specifici ed il meno possibile generici;

prevedere un espediente per distinguere diverse versioni dello stesso

documento.

Guasti, assistenza e crimini

La vita tecnologica di un computer è breve. Nel giro di due o tre anni il computer che

avete acquistato potrebbe essere fuori produzione, rimpiazzato da un modello più

potente e di minor costo. Non è un buon motivo per buttarlo via al primo guasto. Il

costo del computer, delle sue periferiche e dei programmi, rappresenta spesso un

notevole investimento, e deve essere tutelato il più possibile.

Come ogni altro prodotto, i computer godono di una garanzia di un anno

dall'acquisto, garanzia che spesso comprende i pezzi di ricambio ma non l'intervento

del tecnico ed il trasporto del computer. Molto spesso le periferiche, soprattutto le

più delicate come gli scanner, vengono garantite solo per pochi mesi, spesso sei, a

volte tre ma anche uno solo.

I costi di riparazione di questo tipo di apparecchiature sono molto alti: spesso due o

tre interventi superano il costo della stessa macchina. Il che è giustificato da una

parte dal fatto che si tratta di interventi che richiedono l'opera di specialisti, e

dall'altra che i pezzi di ricambio hanno spesso un unico fornitore.

Inoltre le tecnologie costruttive odierne, di tipo modulare, impediscono il piccolo

25

intervento che, con una sciocchezza, risolve il guasto. I componenti sono spesso

montati in modo inscindibile l'uno dall'altro ed il tecnico sostituisce l'intero modulo.

Se si considera che un computer è costituito da una sola scheda madre, un

trasformatore, un disco rigido ed un floppy, bastano quattro guasti per sostituire

l'intero computer, con un costo più che proporzionato.

Nell'acquistare un computer od una qualsiasi altra apparecchiatura accessoria è

indispensabile pretendere la garanzia di un anno. In caso contrario, è preferibile

scegliere un altro modello.

L'assistenza

Bisogna distinguere fra garanzia ed assistenza. Il computer ha la regolare garanzia di

un anno, ma se il produttore, il distributore ed il rivenditore non sono in grado di

garantire un servizio tecnico di assistenza efficiente, la garanzia è inutile.

I guasti che avvengono in un computer sono bene individuabili e velocemente

riparabili, ma anche il più piccolo può paralizzare il lavoro. Un'automobile può

viaggiare anche se il tergicristalli non funziona od il riscaldamento è fuori uso, ma i

componenti di un computer devono essere assolutamente tutti in piena salute. Basta

che si rompa un tasto della tastiera, od un piedino della porta seriale, oppure che il

connettore della porta video faccia un falso contatto, per rendere il computer

inutilizzabile. Spesso il malfunzionamento viene identificato dagli autotest che

avvengo all'accensione, ed il computer rifiuta addirittura di entrare in funzione.

Una riparazione può essere questione di ore, se il laboratorio di assistenza è

efficiente e se i componenti sono disponibili, oppure mesi, se il laboratorio è

inefficiente o semplicemente non esiste ed il rivenditore è costretto a spedire il

computer guasto al produttore.

Acquistando un computer, bisogna accertarsi che il rivenditore disponga di un

laboratorio di riparazione ben fornito di componenti e di tecnici, oppure che sia in

grado di fornire un elenco di laboratori presso cui sia possibile recarsi per le

riparazioni in garanzia.

All'atto dell'acquisto è possibile, in alcuni casi, sottoscrivere un contratto di

assistenza che copre da ogni costo, compreso quello di intervento, e che prevede la

riparazione a domicilio o con il trasporto gratuito. Questo tipo di garanzia prevede

anche che l'intervento del tecnico venga effettuato entro un tempo limite. Nel caso

che l'apparecchiatura non possa essere subito riparata, alcuni di questi contratti

garantiscono il noleggio gratuito di una apparecchiatura equivalente per tutto il

periodo in cui la vostra sarà inutilizzabile.

Un contratto di assistenza a pagamento può essere stipulato sia durante il corso della

garanzia gratuita che alla sua scadenza. Il suo costo sarà proporzionale al valore a

nuovo della macchina e dipenderà dal tipo di copertura prevista.

L'origine dei guasti

Tranne difetti di fabbricazione, che in genere si rivelano subito, sin dai primi attimi

di lavoro, un computer non è molto soggetto a guasti. Le parti meccaniche sono

molto limitate e non sono soggette a logoramento. La parte elettronica, se non viene

26

sottoposta a traumi come cadute, eccessivo calore o sbalzi di corrente, ha un periodo

di vita praticamente illimitato.

L'eccesso di calore è una causa frequente di malfunzionamenti temporanei o di

guasti di componenti elettronici. Il manuale riporta sempre un arco di temperatura

adatta al computer, ma è necessario distinguere fra la temperatura ambientale della

stanza nella quale si trova l'apparecchiatura e la temperatura all'interno del computer.

Mentre la prima è ben al di sotto dei limiti previsti, la seconda può facilmente

innalzarsi oltre la soglia per tutta una serie di fattori:

- sul computer sono presenti delle fessure che servono da prese di aerazione per i

componenti interni. Appoggiare libri al computer, od altri oggetti, può provocare la

chiusura di queste prese bloccando il ricambio d'aria;

- il monitor produce una notevole quantità di calore: è sempre consigliabile

utilizzarlo con un piedistallo non solo per comodità, ma perché si crea uno spazio fra

computer e monitor nel quale il calore si disperde;

- polvere, cenere, fumo ed altri sporchi penetrano all'interno del computer attraverso

le fessure di aerazione: a computer spento, è consigliabile aprire il coperchio e pulire

delicatamente la scheda madre e tutti i componenti almeno una volta l'anno o pim

frequentemente, se necessario, con gli stessi strumenti che si utilizzano per pulire le

macchine fotografiche;

- l'interno del computer, quasi vuoto al momento dell'acquisto, può rapidamente

affollarsi di schede: ciò non solo blocca la normale convezione dell'aria, ma provoca

calore sia per i componenti stessi che per l'alimentatore/trasformatore, sottoposto a

superlavoro: può essere installata una ventola interna di raffreddamento, oltre ad un

alimentatore/trasformatore con maggiore capacità.

Gli sbalzi di corrente che provocano guasti non sono quelli che provengono dalla

linea elettrica, che viene regolata dall'alimentatore/trasformatore, ma dagli altri

collegamenti con schede e periferiche.

Negli slot in cui vengono inserite le schede e nei connettori seriali e paralleli, nonché

in quelli per il monitor e la tastiera, sono spesso presenti dei contatti che portano

corrente elettrica. L'intensità è bassa, ma l'inserire una scheda od un cavo mentre il

computer è acceso, e quindi è presente la corrente nei contatti, può provocare seri

danni sia ai componenti della scheda madre sia a quelli della scheda.

Oltre allo sbalzo di corrente, il danno può essere provocato anche dal falso contatto

che si può provocare, con un maldestro inserimento, fra parti dedicate al traffico dei

dati. Portare una corrente di 12 volts in una linea dati significa danneggiare

definitivamente i componenti elettronici. Nel gergo dei riparatori, si dice che la

scheda è stata "fritta", o "bruciata". Allegoria che non è molto distante dal vero.

Ogni inserimento o sconnesione di schede o cavi deve sempre avvenire a computer

spento, così come devono essere sempre spente anche le apparecchiature collegate.

L'inserimento di schede nella scheda madre o la loro estrazione sono spesso causa di

danni se non effettuate con ogni cura.

La prima precauzione da prendere, dopo aver spento il computer, è quella di

scaricare l'energia statica che potrebbe essere presente sul corpo. Se venisse

trasmessa ai componenti della scheda, attraverso le mani, la piccola scarica elettrica

danneggerebbe i delicati circuiti interni delle memorie ROM e RAM. Ogni volta che

si tocca una scheda è necessario toccare prima il contenitore in ferro

dell'alimentatore/trasformatore per scaricarsi.

La seconda precauzione è quella di usare sempre molta delicatezza. Una inserzione

27

forzata od una estrazione violenta possono provocare rotture o incrinature nella

sottile superficie delle schede, con la conseguente irrimediabile interruzione dei

circuiti stampati.

Le precauzioni

Infine alcune indicazioni per una corretta sistemazione ambientale del computer:

- non deve mai trovarsi in vicinanza di fonti di calore, come termosifoni o stufe;

- non deve mai essere direttamente esposto alla luce del sole;

- non deve mai essere in vicinanza di zone umide o con possibilità si schizzi d'acqua;

- i cavi devono essere raggruppati e fissati al tavolo, non devono rimanere penzolanti

o arrotolati sul pavimento in zone di passaggio;

- intorno ai lati del computer non devono esserci oggetti, il computer deve essere ad

almeno dieci centimetri da pareti o scaffalature;

- nel raggio di mezzo metro dal computer non dovrebbero esserci altre

apparecchiature elettriche come fotocopiatrici, televisori, elettrodomestici;

- la linea elettrica che alimenta il computer non dovrebbe essere in comune con

apparecchiature che provochino grossi consumi improvvisi come luci al neon,

fotocopiatrici, elettrodomestici.

In caso di guasto

Innanzi tutto è molto probabile che non si tratti di un guasto vero e proprio, bensì di

un cattivo funzionamento per cause hardware o software.

Una periferica che abbia bisogno di una particolare procedura di installazione non

può funzionare se non la si effettua correttamente, o se in seguiti si cancellano i file

di cui ha bisogno per funzionare. Un tentativo da fare è di effettuare una nuova

installazione del software richiesto dalla periferica.

Una periferica che funziona con un programma, non è detto che funzioni con un

programma che è simile, ma differisce nella gestione delle periferiche. Se

l'apparecchiatura con alcuni programmi funziona e con altri no, si tratta di un

evidente caso di incompatibilità.

Un cavo male collegato o con dei contatti instabili può provocare il

malfunzionamento saltuario o permanente della periferica in uno od in entrambi i

sensi della trasmissione dei dati. Il computer può trasmettere alla periferica, ma non

può ricevere. E' necessario controllare l'inserimento corretto dei cavi e se non siano

rotti in qualche punto.

Lo stesso inconveniente può essere dovuto allo spostamento di una scheda nello slot

a causa di un urto al computer.

Gli aggiornamenti del software, sotto questo punto di vista, sono pericolosissimi. Un

programma può smettere di funzionare perché è stato aggiornato il sistema operativo,

ma non ancora il programma. Stessa situazione quando è il programma ad essere

stato aggiornato, ma la versione del sistema operativo è vecchia.

Il verificarsi di malfunzionamenti subito dopo l'aggiunta di una scheda nuova, pone

un grave dubbio sull'efficienza della stessa. La scheda può essere innocente, e la

colpa derivare da un programma vecchio ed incompatibile.

L'abitudine di munire il computer di piccole utilità che occupano piccole porzioni di

memoria e che visualizzano l'ora sul monitor, ne cambiano lo schermo durante i

momenti di pausa, esamino i dischi alla ricerca di virus, e così via, può essere la

28

causa di molti malfunzionamenti altrimenti inesplicabili. In questo caso è necessario

eliminare queste utilità una per una, fino ad individuare la colpevole. Spesso non è il

programmino in sé ad essere la causa dell'apparente guasto, ma semplicemente

l'abbinamento di due o più che si ritrovano così in conflitto.

In caso di guasti o malfunzionamenti è sempre consigliabile, prima di chiamare il

tecnico, verificare queste possibilità, compreso il corretto inserimento della spina

nella presa della corrente elettrica. Non sono rari gli utenti che chiamano il tecnico

senza accorgersi che è andata via la luce all'intero quartiere.

E' comunque necessario cercare di comprendere bene in quale circostanze si verifica

il malfunzionamento. In particolare:

- quale sistema operativo è presente e con quale versione;

- quale programma è in esecuzione;

- quale programma abbiamo utilizzato prima di questo;

- se vi sono programmi di utilità residenti in memoria, e quali;

- quali sono le periferiche accese e quali quelle spente;

- quali sono le schede presenti negli slot del computer;

- da quanto tempo è acceso il computer, da quanto tempo vi stiamo lavorando o per

quanto tempo è rimasto inattivo.

La fonte del guaio potrebbe essere individuata cercando di replicare il

malfunzionamento variando una per volta le circostanze originarie.

Tenete comunque presente che i tecnici addetti all'assistenza ed alla riparazione di

computer diffidano della capacità di un utente ad usare un personal. La prima ipotesi

che viene fatta è sempre quella di un errore dell'utente, e l'ultima è sempre quella di

un guasto dell'hardware.

I virus

I virus del computer sono programmi realizzati per divertimento, il cui unico scopo è

quello di danneggiare o rendere inefficiente un computer. Dopo i molti articoli

pubblicati sui giornali, un utente inesperto, che si trovi davanti ad un

malfunzionamento per lui incomprensibile, pensa immediatamente all'esistenza di un

virus.

Niente di più errato. Un virus può avere come obiettivo la distruzione di tutto quanto

sia registrato sul disco rigido, oppure di rallentare tutte le attività del computer.

Quello che è sicuro è che un virus non lascia palesare la sua presenza con molta

facilità.

Il danno che egli provoca deve essere immediato e totale, oppure graduale ed

inavvertibile. Un virus che provocasse un malfunzionamento evidente, ma parziale,

tradirebbe la sua presenza senza raggiungere nessun obiettivo definitivo.

Non è facile identificare la presenza di un virus, a meno che non si tratti di un virus

"dimostrativo" che si limita a far rimbalzare una pallina sullo schermo. I virus "seri"

possono essere rintracciati solamente con appositi programmi, chiamati antivirus,

che esaminano i codici di ogni programma presente nel disco alla ricerca di

particolari sequenze di dati.

I virus conosciuti si possono dividere in categorie:

- bombe logiche: si installano nel sistema ed attendono una particolare situazione, ad

esempio la cancellazione di un nome dal programma degli stipendi per cancellare

29

tutti i dati amministrativi e fiscali (tipica ritorsione di programmatori che sospettano

un imminente licenziamento);

- bombe a tempo: la distruzione degli archivi avviene allo scadere di un determinato

periodo od in una data precisa (alcuni di questi virus sono stati utilizzati a scopi

politici);

- cavalli di troia: piccoli programmi che sembrano svolgere una attività utile, ma che

di nascosto ostacolano e rallentano le attività del computer, oppure ne alterano i dati;

- infestanti: si diffondono da computer a computer, attraverso i collegamenti in rete,

non avendo lo scopo diretto di danneggiare i computer, ma solo di riprodursi con la

maggiore velocità possibile, rendendo ben presto impossibile il normale lavoro;

- back door: cioè porta di servizio, che permettono l'aggiramento delle normali

procedure di sicurezza e l'ingresso senza autorizzazione in archivi di dati riservati

importanti per l'azienda;

- virus: propriamente detti, che consistono in una sequenza di codici che si

autoinstallano in determinati programmi al posto del codice originale e che, alla

prima occasione, infettano altri programmi.

Alcuni di questi virus hanno semplicemente una origine dolosa, ed i danni che

provocano non apportano alcun vantaggio al programmatore che lo ha creato. Altri,

soprattutto i back door, hanno una utilizzazione esclusivamente criminale a fini di

spionaggio, di ricatto, di furto di informazioni, o di manipolazione delle stesse per

trarne vantaggio.

Le principali precauzioni che possono essere prese per prevenire l'attacco da parte di

un virus sono:

- proteggere il computer con un programma antivirus che esamina tutte le attività

cercando e segnalando quelle "sospette";

- esaminare periodicamente il disco ed i dischetti con un programma antivirus che

rintracci i dati caratteristici dei virus conosciuti;

- impedire che persone estranee lavorino con il nostro computer utilizzando loro

dischetti e loro programmi;

- non utilizzare mai nessun programma, originale o meno, acquistato o preso in

visione, senza averlo fatto esaminare dal programma antivirus;

- ricevendo un dischetto da un amico o da un collaboratore, inserirlo nel drive del

computer solamente se è attiva la protezione antivirus ed esaminando

immediatamente il dischetto;

- portando propri dischetti per lavorare con il computer di un altro utente, avere cura

di tenerli costantemente protetti dalla scrittura.

Con questo tipo di precauzioni è molto difficile che un virus riesca ad entrare nel

vostro computer per danneggiarlo.

Il crimine informatico

Un capitolo a parte meriterebbe la sicurezza informatica, problema particolarmente

sentito nel mondo aziendale. Possiamo così dividere gli atti dolosi che hanno a che

vedere con i computer:

- furto delle informazioni contenute nel computer;

- abuso del computer per trarre profitto da operazioni del lavoro ordinario;

- intrusione in sistemi informativi per utilizzarne i servizi;

30

- sabotaggio del computer o delle informazioni contenute;

- furto di dispositivi hardware.

Un esempio del primo tipo di crimine informatico è quello dell'impiegato che,

avendo la possibilità di accedere ad un nuovo progetto industriale, ne vende una

copia alla concorrenza.

Nel secondo caso cade il bancario che detrae poche lire per ognuna delle centinaia di

operazioni bancarie che avvengono ogni giorno in un centro di calcolo di un istituto

finanziario, immettendole sul proprio conto.

L'utilizzo di password trafugate è all'origine del terzo tipo di azione dolosa. Un

individuo accede, tramite la parola d'ordine di un ignaro utente regolare, ad un

servizio telematico a pagamento, come il Videotel, e ne utilizza i servizi facendone

addebitare i costi sul nominativo legale. In questo caso il criminale non trae vantaggi

concreti dalla sua azione, per lo meno non in termini monetari.

Ugualmente poco redditivo è il quarto caso di crimine informatico, usualmente

praticato da impiegati scontenti o sul punto di essere licenziati. I danni provocati

possono essere diretti, come il guasto provocato a qualche apparecchiatura, o

indiretti. E' di questa specie l'immissione di un virus nei computer aziendali, oppure

una attività di danneggiamento delle informazioni cancellando o alterando quelle

esistenti o creandone una certa quantità di false.

Meno raro di quello che si possa pensare, il terzo tipo di crimine. Certo è ben

difficile che un impiegato possa uscire dall'ufficio con un personal sotto il braccio,

ma la gran parte delle schede è comodamente occultabile in una cartellina per

documenti. Per non parlare dei dischetti, dei mouse o dei cavi, tutti abbastanza

piccoli da entrare in una tasca di soprabito.

In quest'ultimo tipo di crimine rientra anche la copiatura del software originale.

L'azienda non ne risente un danno diretto, ma l'impiegato che copia un software

originale per utilizzarlo a casa può provocarne uno anche più grave.

All'atto dell'installazione dei programmi viene richiesta la digitazione del numero di

serie, che viene così registrato nel codice stesso del programma. Lo stesso numero è

a conoscenza del produttore o del distributore ufficiale tramite la fatturazione o

l'invio della scheda per la garanzia, l'assistenza e le future offerte di aggiornamento a

prezzo scontato. Se il dipendente copia il programma in ufficio e poi, come spesso

capita, lo scambia con altri che a loro volta lo scambiano di nuovo, il programma

potrebbe finire nella mani "sbagliate" e, tramite l'individuazione del numero di serie,

portare a perquisizioni e cause per danni.

Il backup

Quale che sia l'origine del nostro problema, guasto di hardware, malfunzionamento

di un software, caduta dell'energia elettrica, virus o sabotaggio, la conclusione è che

il computer è inutilizzabile e molti giorni di lavoro sono ormai persi. A meno che

non sia stato fatto un backup, cioè una copia dell'intero archivio o delle parti più

importanti.

L'abitudine di effettuare backup frequenti dell'hard disk presente all'interno del

computer può essere noiosa, ma è l'unico stratagemma che ci consente di recuperare

il nostro lavoro nel caso che il computer si guastasse in modo drastico.

Esistono programmi per effettuare il backup in modo completamente automatico, su

un singolo computer o su una rete di personal, in ore non lavorative oppure

parallelamente al lavoro ordinario. L'effettuazione di una copia di tutti i documenti, o

almeno di quelli importanti o di quelli nuovi o modificati, può essere un impegno

31

noioso e, al 99 per cento delle volte inutile. Ma quando si verifica un "incidente",

come il guasto di un disco rigido, la cancellazione fortuita di alcuni documenti o

l'infezione da parte di un virus, non avere una copia dei programmi e dei documenti

vuol dire averli persi definitivamente.

Il backup deve essere studiato in modo strategico, tale da intralciare il lavoro

ordinario il meno possibile, ma da essere realmente efficace in caso di necessità.

Esistono due tipi di backup:

- backup completo, quando si effettua una copia totale di un disco rigido;

- backup incrementale, quando si copiano esclusivamente i documenti nuovi e quelli

modificati.

Quello completo richiede molto più tempo di quello incrementale, ma effettua una